Die falschen Klimathesen des Professors Mojib Latif

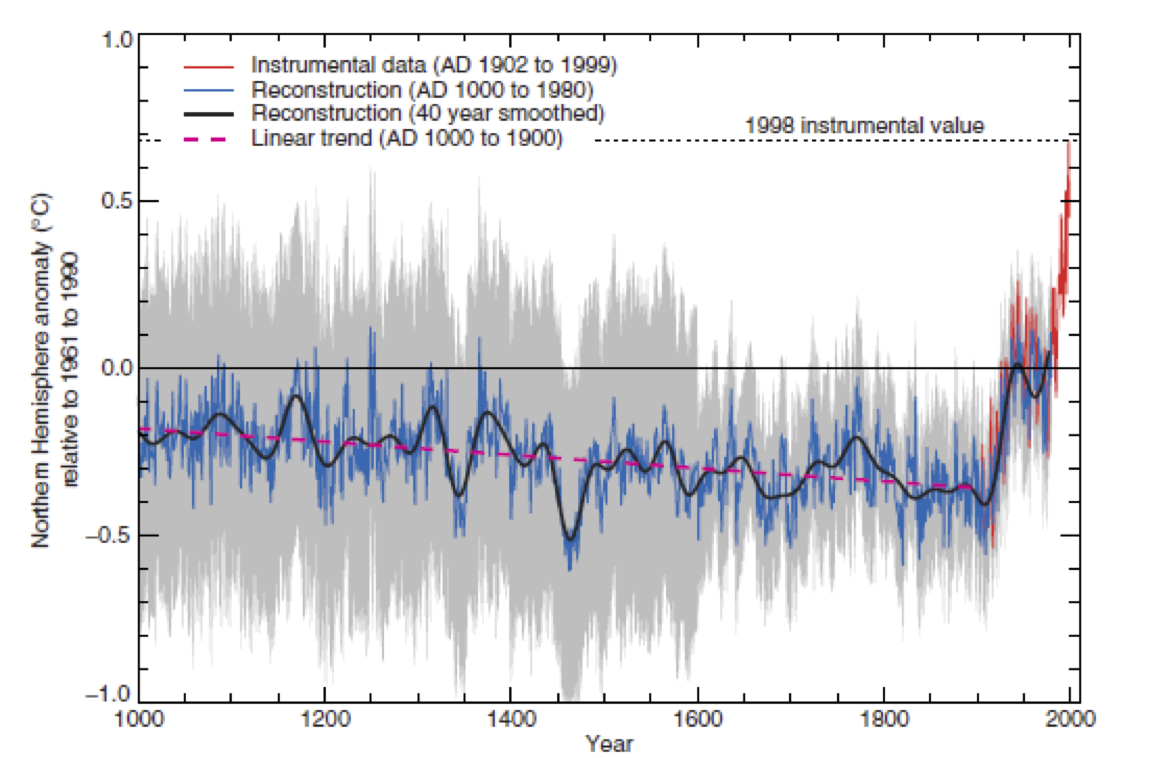

Wenn man schon nach einem Leugner des Klimawandels suchen sollte, dann findet man diesen bei den AGW-Vertretern. Für einige hundert Jahre hat Michael Mann mit seiner berühmt-berüchtigten gleich mehrfach manipulierten Hockeyschlägerkurve[1] ein nahezu konstantes Klima erfunden.

Von 1000 bis 1900 ändert sich die Temperaturanomalie um knappe 0.2°C. Hierzu mussten aber durch statistische Tricks die kleine Eiszeit und das mittelalterliche Temperaturoptimum abhanden kommen.

These 1: Der Mensch ist unschuldig. Klimaschwankungen gab es immer schon.

Falsch. Es gab zwar immer schon natürliche Klimaschwankungen. Aber wenn wir so weitermachen wie bisher, bekommen wir eine Klimaerwärmung, die es in der Geschichte der Menschheit noch nicht gegeben hat.

Da es nicht eindeutig ist, was Prof. Latif (PL) meint, schauen wir uns sowohl die absolute Temperatur und die Temperaturanomalie an.

1. Absolute Temperatur

Der IPCC nimmt hierfür 288K oder 15°C an. Dieser Wert ist aus zwei Gründen von geringer Aussage, da man mittels der Thermodynamik zeigen kann, dass es keinen Mittelwert geben kann und weil er (trotzdem) vom IPCC mittels des Stefan-Boltzmann-Gesetzes, ![]() , mit ε = 1, als ob die Erde ein schwarzer Körper sei, berechnet wird.

, mit ε = 1, als ob die Erde ein schwarzer Körper sei, berechnet wird.

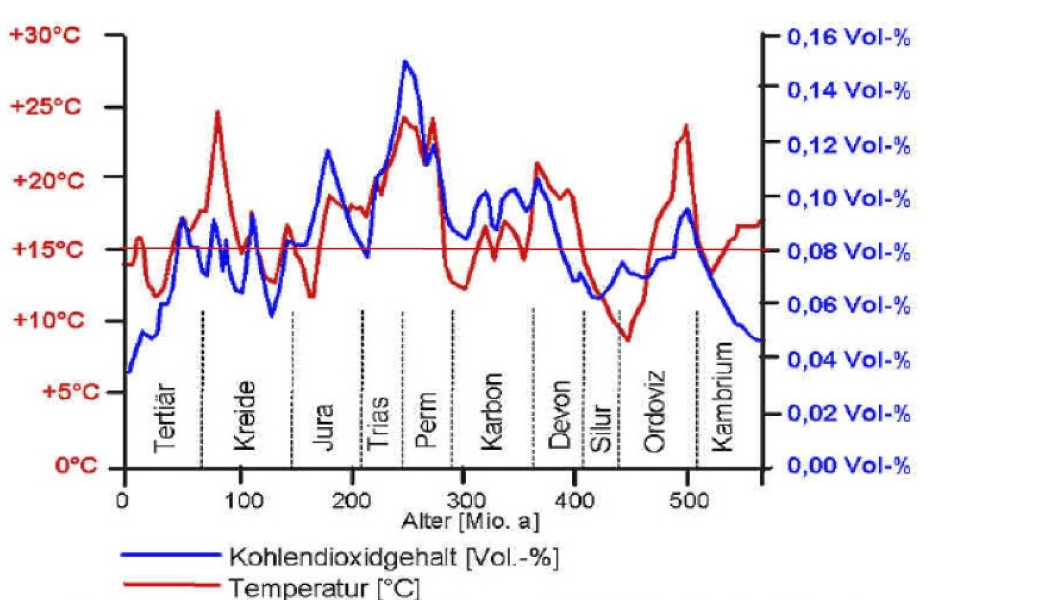

Um einen Vergleich zu ermöglichen, nehmen wir temporär trotzdem an, dass eine mittlere Temperatur gemessen werden kann. Die folgende Graphik zeigt die CO2-Konzentration und die Temperatur im Verlauf der Erdgeschichte.

Man erkennt drei wichtige Fakten. Erstens war es schon des Öfteren viel wärmer als heute und es gab durchaus Zeiten, wo die Temperatur stieg, aber die CO2-Konzentration abnahm. Und drittens, wir leben in einer Zeit der minimalen CO2-Konzentration und Konzentrationen die 3- bis 5mal so hoch waren wie derzeit führten zu keinem Klimakollaps. Die absolute Temperatur kann PL also nicht gemeint haben.

2. Der Temperaturanstieg

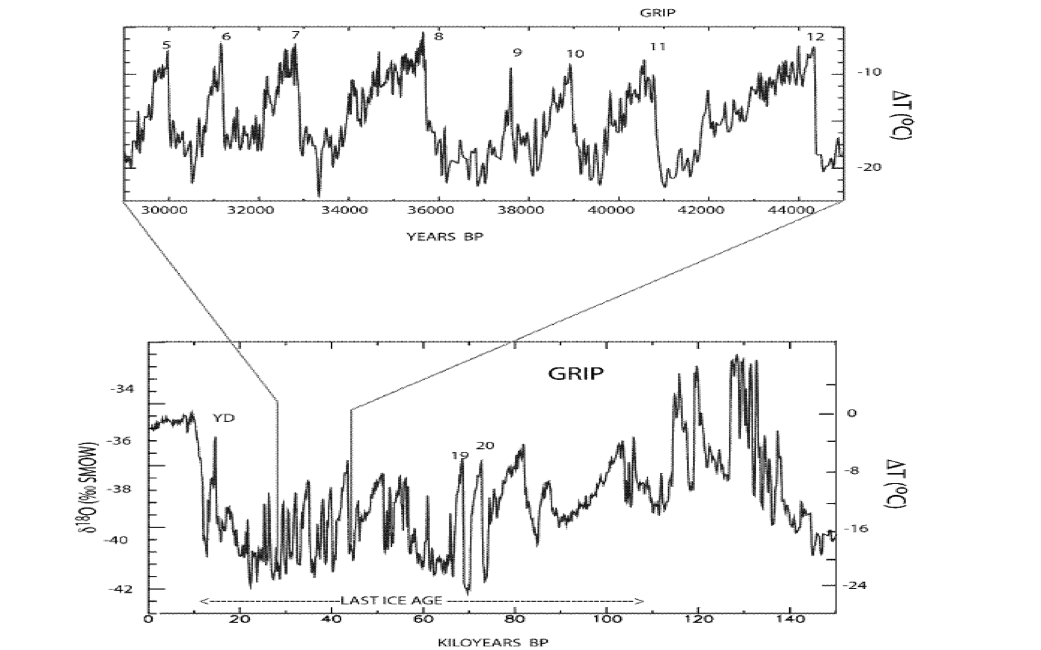

Im 20. Jahrhundert stieg die mittlere Temperatur um 0.7-0.8°C an. Dass es selbst daran beträchtliche Zweifel gibt wegen der permanenten Manipulationen der Messreihen, sei einmal übersehen (Details dazu im Bericht „Das Temperaturdilemma“). Die nächste Graphik zeigt die Dansgaard-Oeschger-Oszillationen. Eine detaillierte Inspektion offenbart Schwankungen von mehr als Grad 10°C innerhalb weniger Jahrzehnte. Also war der Anstieg mindestens zehnmal stärker als der so dramatisierte im letzten Jahrhundert.

Man könnte noch spitzfindig bemerken, dass von der Geschichte der Menschheit gesprochen wurde. Wenn es aber erstens dramatischere Änderungen ohne von den Menschen erzeugtes CO2 gab, warum soll er für einen sehr moderaten Wandel in der Neuzeit „schuldig“ sein. Zweitens lebten und überlebten unsere Vorfahren während der extremen Dansgaard-Oeschger-Oszillationen. Oder zählen sie nicht mehr zur Menschheit?

These 2: Die Erwärmung wird nur von der Sonne bewirkt.

Falsch. Drei Viertel der Erwärmung ist vom Menschen gemacht, nur ein Viertel geht auf natürliche Ursachen zurück, insbesondere die Sonne. Aber der Sonneneinfluss passierte in der ersten Hälfte des 20. Jahrhunderts.

Die These suggeriert die Antwort, aber diesmal ist der Fragesteller in die eigene Falle getappt, denn die Antwort lautet ganz klar Ja. Die Sonne ist nun einmal die einzige uns zur Verfügung stehende Energiequelle, wenn man von dem vernachlässigbaren Beitrag der Erdwärme absieht.

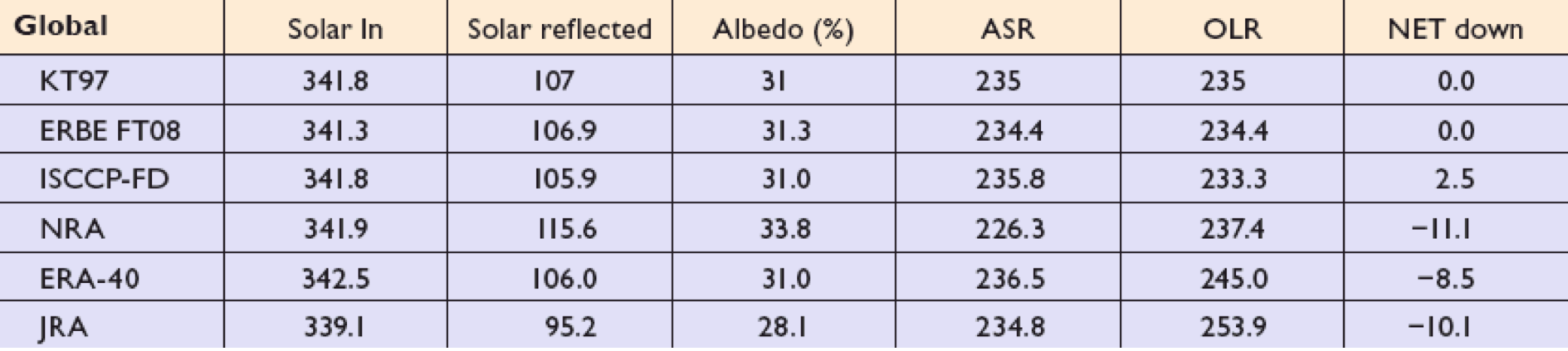

Die Verteilung der eingestrahlten und abgestrahlten Energie auf der Erde und die dadurch bewirkten lokalen Temperaturen hängen auch von anderen Größen ab.

Nehmen wir an, dass dies in der These gemeint sei.

Die Behauptung „drei Viertel der Erwärmung ist vom Menschen gemacht“ erscheint nach der Diskussion der ersten These schon etwas abstrus, denn wie konnten unsere zahlenmäßig geringen Vorfahren solch drastische Temperaturänderungen produzieren, da sie ja nicht einmal Autos hatten.

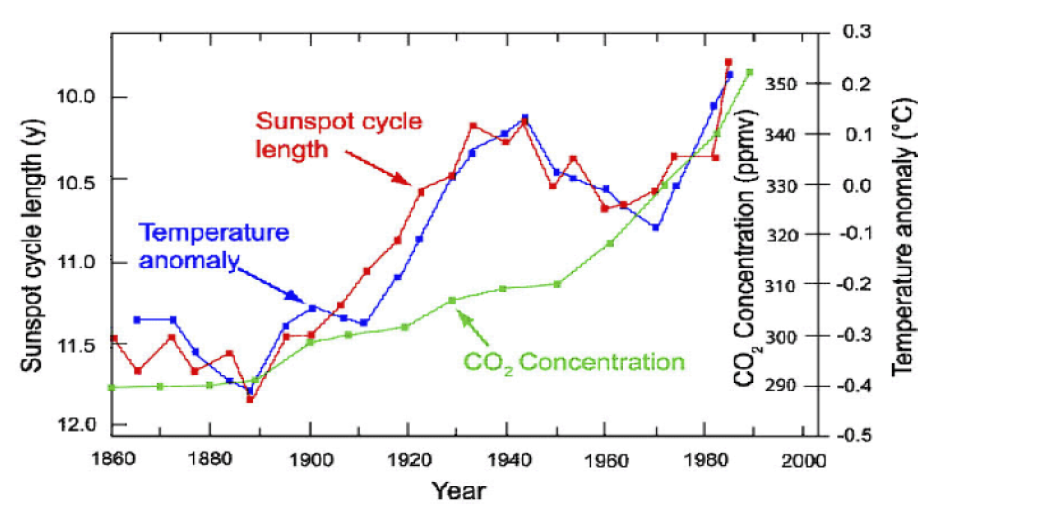

Die nächste Graphik vergleicht die Temperaturanomalie mit der Länge des Sonnenzyklus und der Änderung der CO2-Konzentration.

Wenn es nach PL eine Korrelation zwischen der Sonnenaktivität und der Temperaturanomalie vor 1950 gab, dann ist es anhand der Graphik schwer verständlich, warum dies danach nicht mehr gelten soll. Richtig würde PL liegen, wenn er die Korrelation zwischen der Temperaturanomalie und der CO2-Konzentration in Frage stellen würde, denn die ist erbärmlich. Der Standardeinwand lautet hier, dass die Schwankung der solaren Einstrahlung zu gering ist. Dies mag für den integralen Wert richtig sein, aber im UV-Bereich liegt die Variation z. B. im Bereich von 10%. Des Weiteren hat das Cloud-Experiment in CERN eindeutig gezeigt, dass eine Verstärkung der kosmischen Strahlung die Wolkenbildung fördert, wie Svensmark[2] zuerst postuliert hat. Die Intensität der in die Atmosphäre eintretenden kosmischen Strahlung ist aber von der magnetischen Aktivität der Sonne abhängig. Ein Maß für diese Aktivität ist der ap-Index und für die kosmische Strahlung sind dies die gemessene Anzahl der Neutronen auf der Oberfläche der Erde. Umso mehr Neutronen gemessen werden umso stärker ist die kosmische Strahlung und umso geringer das solare Magnetfeld.

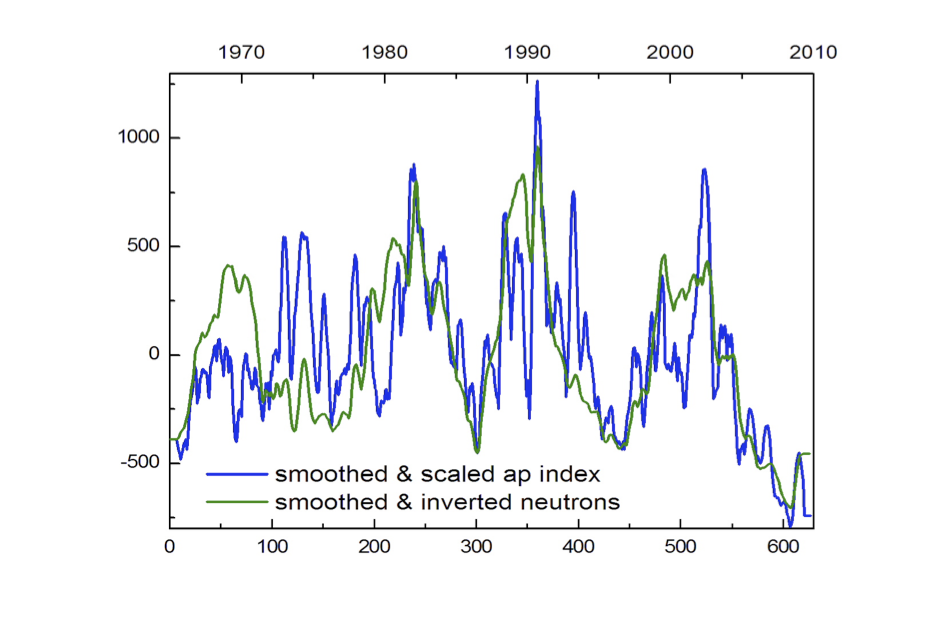

Dieser Zusammenhang wird durch die nächste Graphik, die die Variation des ap-Indexes mit der invertierten Änderung des Neutronenflusses vergleicht, eindrucksvoll belegt.

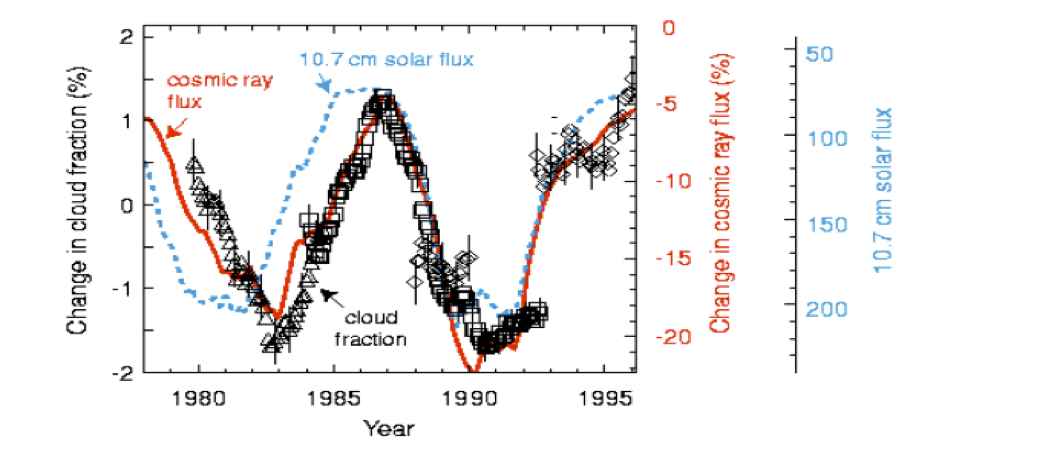

Die folgende Graphik zeigt zweifelsfrei, dass es eine enge Korrelation zwischen der kosmischen Strahlung und der Wolkenbildung gibt. Mehr Wolken bedeuten geringere Einstrahlung und sinkende Temperaturen und vice versa.

Die folgende Graphik zeigt zweifelsfrei, dass es eine enge Korrelation zwischen der kosmischen Strahlung und der Wolkenbildung gibt. Mehr Wolken bedeuten geringere Einstrahlung und sinkende Temperaturen und vice versa.

Fazit: Die Behauptung, dass der Einfluss der Sonne nur für die erste Hälfte des Jahrhunderts verantwortlich ist, steht auf sehr tönernen Füßen.

Aber lassen wir doch PL selbst zu Worte kommen. Am 16.11.09 stand in der „Bild“:

Jetzt macht der Klimawandel Pause. Ausgerechnet vor dem Klimagipfel der Vereinten Nationen in Kopenhagen, bei dem Forschung und Wirtschaft im Dezember über milliardenschwere Programme zum Schutz unserer Erde beraten wollen. Wie passt das zusammen?

Meteorologe Mojib Latif vom Kieler Leibniz-Institut für Meereswissenschaften: „Derzeit hat die Erdwärmung Pause.“

WAS SIND DIE GRÜNDE?

Unklar! Der Klimawandel stellt die Wissenschaftler mal wieder vor ein Rätsel. Jedoch nennen sie im „Spiegel“ zwei mögliche Gründe.

• Die Sonne schwächelt. (Endete nicht der Einfluss der Sonne 1950?) Weltraum-Forschern der Nasa fiel die geringe Zahl der Sonnenflecken auf, ein Zeichen für geringe Strahlungsaktivität. Das gab es so ausgeprägt seit Hunderten Jahren nicht.

• Im Pazifik steigt am Äquator kaltes Tiefenwasser nach oben („Pazifische Dekaden-Oszillation“). Mojib Latif meint, dass die Erdatmosphäre dadurch abgekühlt werde.

Beides sind Phänomene, die nur einige Jahre andauern. Danach gehe der Klimawandel weiter, sagt Latif: „Tatsächlich sind Phasen der Stagnation oder gar Abkühlung normal.“

Richtig Herr Prof. Latif ist, dass sich das Klima immer änderte und ändern wird. Erklären müssten Sie uns aber, warum eine Stagnation und eine Abkühlung normal sind, aber eine Erwärmung ungewöhnlich und menschengemacht ist.

These 3: CO2 hat keinen Anteil an der Erderwärmung, Wasserdampf ist schuld.

Falsch. Wer das behauptet, verwechselt den natürlichen mit dem vom Menschen gemachten Treibhauseffekt. Wasserdampf hat einen Anteil von gut 60 Prozent am natürlichen Treibhauseffekt, der unsere Erdoberfläche warm (15 Grad) hält. Hätten wir ihn nicht, wäre unser Planet eine Eiswüste mit minus 18 Grad. Wir pusten gigantische Mengen CO2 in die Luft, das verstärkt den Treibhauseffekt.

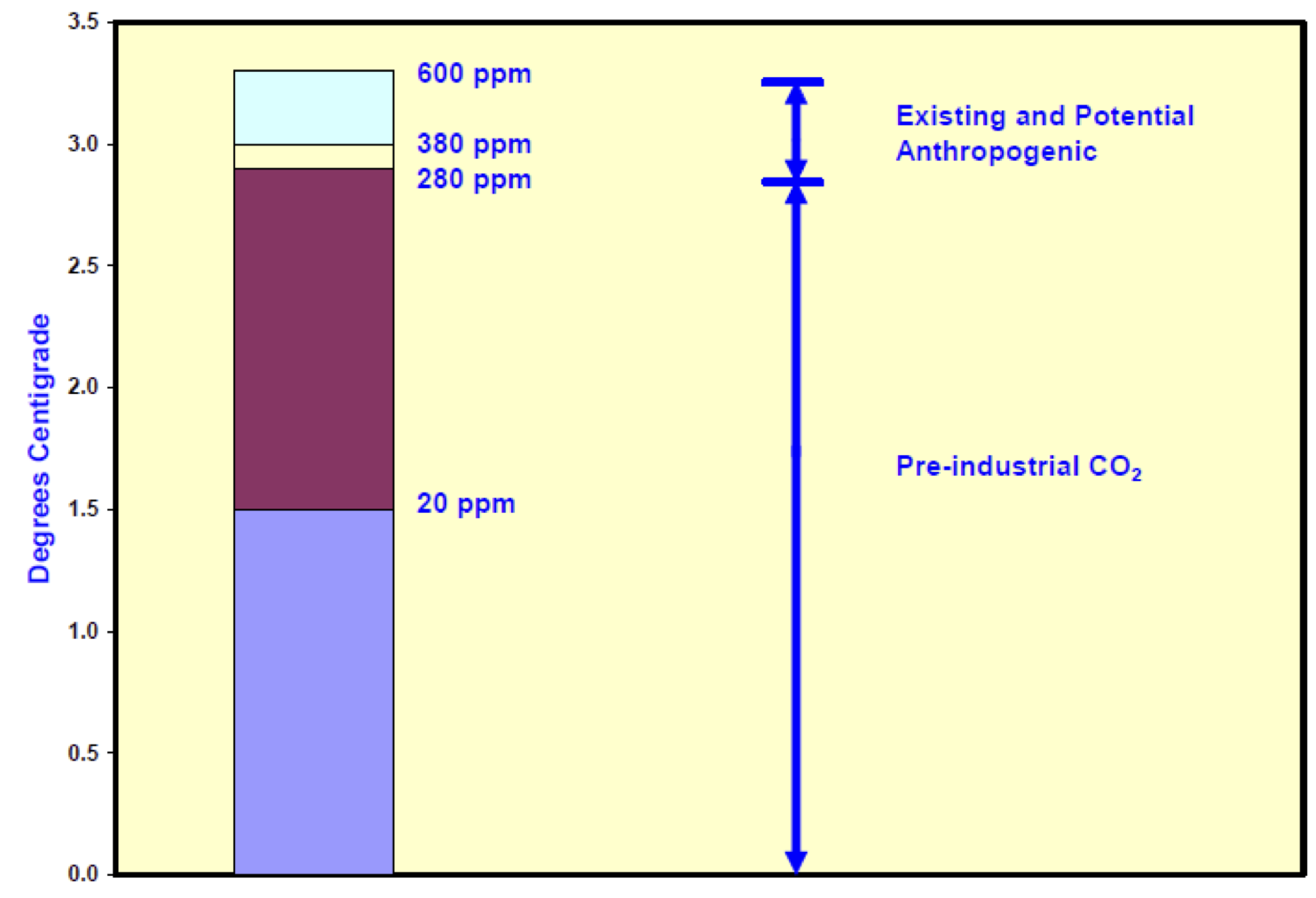

Richtig ist dass der Wasserdampf den überwiegenden Beitrag liefert. Der vom CO2 kann aus der folgenden Graphik abgelesen werden inklusive des Effektes einer Steigerung des CO2-Gehaltes in der Atmosphäre.

Prof. R S Lindzen[3] vom MIT hat abgeschätzt, dass die Temperatur um 0.3-0.5°C steigt bei einer Verdopplung des CO2-Gehaltes. Dies ist die relevante Zahl! Die vom IPCC und von PL prognostizierten Anstiege von einigen Grad implizieren eine positive Rückkopplung des Temperaturanstieges mit dem ausgehenden Strahlungsfluss. Dies ist ein charakteristisches Merkmal aller Klimamodelle. Satellitenmessungen zeigen aber exakt das Gegenteil. Es gibt eine negative Rückkopplung. Alarmistische Meldungen beruhen demnach auf falschen Prämissen.

Wenn also der gigantische Effekt des CO2 mickrige 0.3-0.5°C Temperaturanstieg, bei einer nach Prof. T V Segalstadt (Geologe) aus Mangel an fossilen Rohstoffen nicht möglichen Verdopplung des CO2-Gehaltes, bedeutet, dann braucht sich niemand darüber zu sorgen. Im Gegenteil, es wäre sogar gut so, da diese sehr moderate Änderung zusammen mit einem höheren CO2-Gehalt die Produktion der Biomasse deutlich erhöhen würde.

These 4: Zusätzliches CO2 in der Atmosphäre hat keinen Einfluss aufs Klima.

Falsch. Die Skeptiker verstehen nicht, warum CO2 überhaupt klimawirksam ist. Die Atmosphäre ist wie ein riesiges Treibhaus, wobei das CO2 die Rolle des Glases übernimmt – es lässt die Wärme nicht entweichen. Je mehr CO2, desto dichter oder dicker das Glas und umso größer die Erwärmung.

Den Skeptikern Unverständnis zu unterstellen und dabei selbst solch physikalischen Unsinn zu erzählen ist die schiere Unverschämtheit. Die Atmosphäre, ein System mit freier Teilchenkonvektion, mit einem Treibhaus, bei dem gerade diese Konvektion durch das Glas unterbrochen wird, zu vergleichen, zeugt von nicht verstandener Physik. Schon vor mehr als hundert Jahren hat Prof. R W Wood experimentell gezeigt, dass die Temperatur in einem Treibhaus steigt, weil die Luftzirkulation unterbunden und nicht weil die IR-Strahlung von dem Glas absorbiert wird. Das Experiment wurde kürzlich von E Loock (2008) und N S Nahle (2011) verifiziert. Selbst jeder Laie kennt diesen Effekt von dem Auto in der Sonne. Obwohl viel weniger Strahlung in das Auto eintritt als die Umgebung erhält, ist es im Wagen viel wärmer, weil die Konvektion sowohl durch die steigende Temperatur als auch durch das beschränkte Luftvolumen unterdrückt wird. Die Situation wird sofort verbessert, wenn man die Fenster einen Spalt weit öffnet, obwohl dies fast nichts am Strahlungsaustausch ändert.

Noch eine Frage an PL und die AGW-Sympathisanten: Die Marsatmosphäre besteht zu 95% aus CO2. Warum gibt es trotzdem auf dem Mars keinen Treibhauseffekt?

Übrigens ist auf dem Mars in den letzten Dekaden des 20. Jahrhundert die Temperatur gestiegen[4]. Dies geschah gerade in dem Zeitraum in dem die Sonne nach PL keinen Einfluss auf den Temperaturanstieg auf der Erde hatte. Also auf der Erde bewirkte die Sonnenaktivität nichts, während sie gleichzeitig die Temperatur auf dem Mars steigen ließ.

These 5: Das CO2 produzieren nicht wir Menschen, sondern die Weltmeere.

Falsch. Das von uns Menschen produzierte CO2 hat ganz bestimmte Merkmale, die sich vom natürlichen CO2 eindeutig unterscheiden. Dieses kann man messen.

Unsinn, die Ozeane produzieren kein CO2. Sie binden es und zwar mehr mit abnehmender Temperatur.

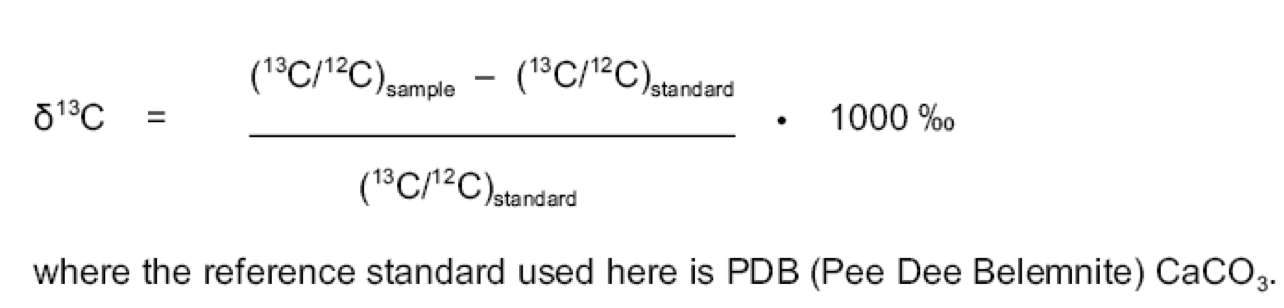

Richtig ist, dass es Kohlenstoff als 12C und 13C gibt. Das Mischungsverhältnis ist fix in CaCO3 (Referenzsystem), wogegen durch die Photosynthese in organischen Materialien 13C verringert wird. Das Isotopenverhältnis bestimmt man mit der folgenden Formel

Es ist bekannt, dass dieser Wert für fossile Brennstoffe und biologisches Material

δ13C = -26‰ beträgt. Der natürliche Gehalt in der Atmosphäre ist δ13C =-7‰. Gemäß dem IPCC wurden 27% des CO2 (350ppm 1990) durch die Menschheit hinzugefügt. Demnach muss das Isotopenverhältnis δ13C =-12‰ betragen (-[27·26 + 73·7]/100).

Keeling et al.[5] haben 1978 für das Verhältnis -7.489‰ gemessen und 1988 -7.801‰, was weit entfernt von dem vom IPCC und dessen Jüngern angegeben Wert von -12‰ ist.

These 6: Die Klimamodelle der Forscher stimmen nicht.

Falsch. Die Erwärmung entwickelt sich genau wie vorhergesagt. Die Modelle wurden auch an vergangenen Klimaänderungen getestet. Es gibt keinen Grund, den Modellen zu misstrauen.

Falsch, es gibt keinen Grund den Modellen zu trauen. Ausführlich wurde dies in dem Bericht „Klimamodelle – wie verlässlich sind sie?“ untersucht.

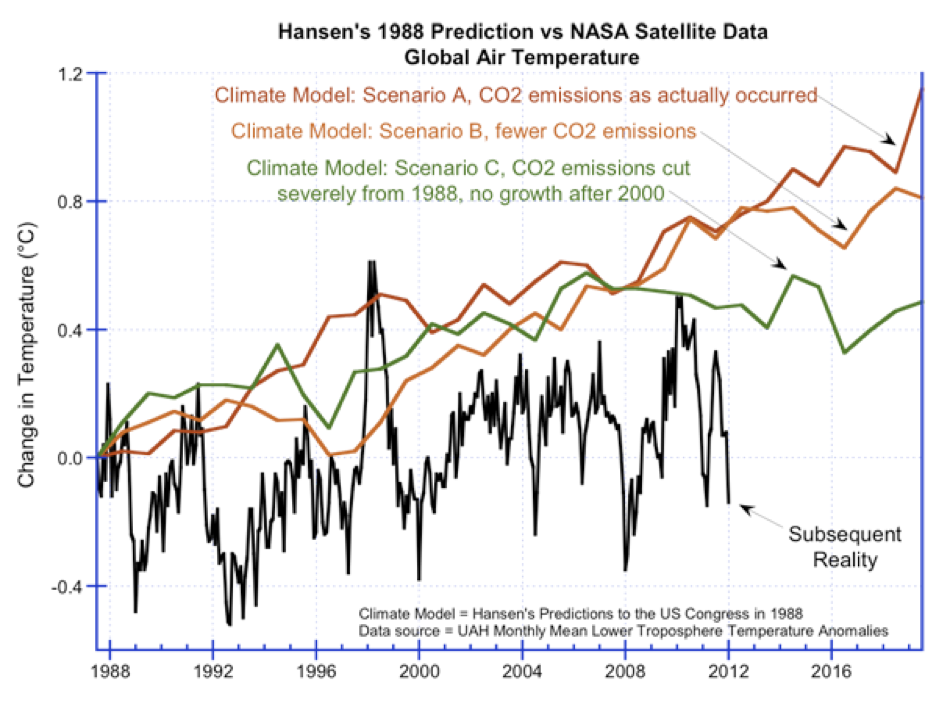

Wer dies trotzdem anhand der folgenden Graphik behauptet leidet entweder unter Realitätsverlust oder betrachtet die Menschen als beschränkt.

Nun noch ein paar Aussagen von namhaften Wissenschaftlern:

Prof. Freeman Dyson–one of the world’s most eminent physicists says the models used to justify global warming alarmism are "full of fudge factors" and "do not begin to describe the real world."

Prof. Antonino Zichichi–one of the world’s foremost physicists, former president of the European Physical Society, who discovered nuclear antimatter–calls global warming models "incoherent and invalid."

Prof. Richard Lindzen–Professor of Meteorology at M.I.T., member of the National Research Council Board on Atmospheric Sciences and Climate, says

”It isn’t just that the alarmists are trumpeting model results that we know must be wrong. It is that they are trumpeting catastrophes that couldn’t happen even if models were right.”

Dr. Kanya Kusano is Program Director and Group Leader for the Earth Simulator at the Japan Agency for Marine-Earth Science & Technology (JAMSTEC)

Climate science is ‘ancient astrology’.

Zum Schluss noch ein erstaunliches Zitat vom “Godfather” der AGW-Jünger, James Hansen:

„In my opinion, the IPCC calculations, epitomized by the Wild et al. result, omit the most important physics, especially the nonlinear effects of meltwater and secondarily the effects of black carbon”

Was bewegte Hansen alles in Grund und Boden zu stampfen?

Nun Wild et al. hatten mit einem „ausgeklügelten“ Klimamodell berechnet, dass das Eis von Grönland und der Antarktis bei Verdoppelung des CO2 wächst.

Solcher Frevel verdient natürlich die Schelte des Herrn.

Fassen wir zusammen:

These 1: Klimaerwärmung, die es in der Geschichte der Menschheit noch nicht gegeben hat.

Im letzten Jahrhundert betrug die Temperaturanomalie 0.7-0.8°C. Bei den Dansgaard-Oeschger-Oszillationen gab es Sprünge von mehr als 10°C in weniger als 100 Jahre.

These 2: Der Sonneneinfluss passierte in der ersten Hälfte des 20. Jahrhunderts.

Das Ende der Erwärmung im 21. Jahrhundert wird von NASA-Forschern durch das Schwächeln der Sonne erklärt. Die Überaktivität der Sonne im 20. Jahrhundert hatte dagegen keinen Einfluss. Was für eine Logik!

These 3: Wir pusten gigantische Mengen CO2 in die Luft, das verstärkt den Treibhauseffekt.

Einer theoretischen Verdopplung des CO2 steht ein möglicher Anstieg von 0.3-0.5°C gegenüber. Höhere Werte stammen von unglaubwürdigen Klimamodellen (siehe letzte These).

These 4: Die Atmosphäre ist wie ein riesiges Treibhaus, wobei das CO2 die Rolle des Glases übernimmt.

Purer Unsinn.

These 5: Das von uns Menschen produzierte CO2 hat ganz bestimmte Merkmal, die man messen kann.

Richtig, das Ergebnis der Messung verschweigt aber PL aus gutem Grund.

These 6: Es gibt keinen Grund, den Modellen zu misstrauen.

Im Gegenteil es gibt keinen Grund ihnen und den Aussagen von Prof. Latif zu trauen.

Dr. B. Hüttner für EIKE

[1] Dies ist detailliert dargelegt und bewiesen von A W Montford in “The Hockey Stick Illusion”

[2] H Svensmark – PHYSICAL REVIEW LETTERS 81 (1998) 5027

[3] Lindzen – Proc. Natl. Acad. Sci. USA 94 (1997)

[4] Fenton et al. – NATURE online April (2007)

[5] In: Peterson, D.H. (Ed.): Aspects of climate variability in the Pacific and the Western Americas. American Geophysical Union, Geophysical Monograph 55, 165-236