Globale mittlere Temperatur: bedeutungslos & irreführend

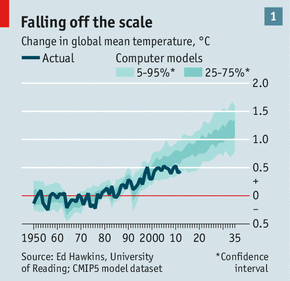

Bild rechts: Was bedeutet eine Änderung der globalen Temperatur um +2°C, falls es überhaupt irgendetwas bedeutet?

Parallel mit dem Klimaclown-Festival in Paris (COP21) schwafeln die Leute ständig darüber, den Klimawandel aufzuhalten und eine Erwärmung bis höchstens 2°C zuzulassen. Die Frage, die der gesunde Menschenverstand sofort stellen sollte, lautet: „2°C höher als was?“ Denn es ist doch so: falls man im Death Valley in Kalifornien lebt, würde man eine weitere Erwärmung um ein paar Gran vermutlich gar nicht bemerken. Die mittlere jährliche Temperatur im Death Valley beträgt der Wetterstation Furnace Creek zufolge 25,1°C, mit einem mittleren Maximum im Januar um 19°C und im Juli von 47°C. Von 1934 bis 1961 zeichnete die Wetterstation Cow Creek eine mittlere jährliche Temperatur von 25,1°C auf. Glaubt jemand wirklich, dass ein paar Grad mehr einen merklichen Unterschied machen?

Genauso gibt es natürlich andere Orte auf der Erde, wo es extrem heiß oder extrem kalt wird. Die kälteste gemessene Temperatur trat im Jahre 1983 mit -89,6°C an der Antarktis-Station Wostok auf. Die mittlere Wintertemperatur am Südpol beträgt etwa -49°C, und selbst im Sommer steigt die Temperatur kaum jemals über den Gefrierpunkt. Würden ein paar Grad mehr einen Unterschied hinsichtlich der Bewohnbarkeit dieser Orte ausmachen? Die Kaiserpinguine könnten eine solche Erwärmung vielleicht schön finden, doch dürfte dies kaum ein Game Changer sein.

Wo ist die Erwärmung um 2°C, die man uns versprochen hat?

Die höchste jemals auf der Erde gemessene Temperatur schlägt mit 70,7°C zu Buche, und zwar in der Wüste Lut in Iran. Würde der Unterschied zwischen 71 und 73 Grad so gewaltige Auswirkungen haben? Und nicht vergessen, es geht hier um einen Anstieg der mittleren Temperatur. Würde der gleiche Anstieg bzgl. der extremen Höchst- bzw. Tiefstwerte gelten? Ziehen wir noch einmal das Death Valley als Beispiel heran. Dort sind die Wintertemperaturen tagsüber mild in in tiefen Lagen, während in kühlen Nächten gelegentlich sogar der Gefrierpunkt erreicht wird. In höheren Lagen ist es kühler als im tief gelegenen Tal. Die Temperatur nimmt alle 300 m jeweils um 2 bis 3°C ab. Wäre es eine Katastrophe, wenn die Temperaturen in der hoch gelegenen Wüste nicht so stark zurückgingen?

Dies bringt jetzt das Thema Seehöhe allgemein ins Spiel.

Sind die Auswirkungen jener so gefürchteten 2°C auf Höhe des Meeresspiegels genauso gefährlich wie auf den Bergen? Schließlich kann die Seehöhe bedeutende Auswirkungen auf die Temperatur haben. Patrick Moore drückt es so aus: „2°C ist wie das Herabsteigen vom Eiffelturm oder wenn man von San Francisco über die Bucht nach Berkeley fährt. Lächerlich!“

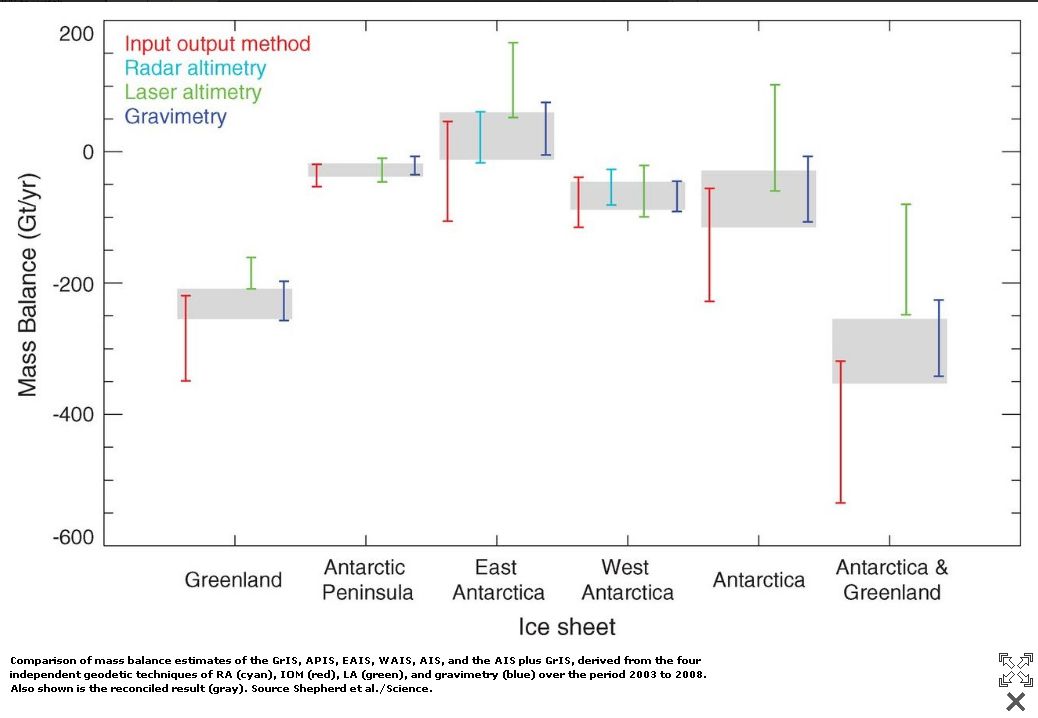

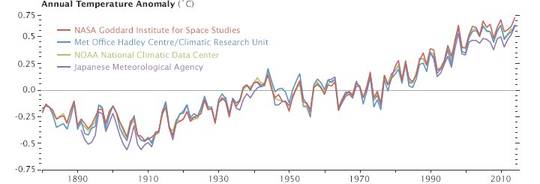

Wie in der ersten Abbildung gezeigt, stimmen die anerkanntesten wissenschaftlichen Organisationen selbst noch nicht einmal überein hinsichtlich der Historie der magischen globalen mittleren Temperatur. Wenn sie von einer Temperatur-„Anomalie“ reden – ein Terminus, den Klimawissenschaftler gerne verwenden, weil er wissenschaftlicher und gelehrter klingt als Differenz oder Variabilität – gelten dann die hinzugefügten 2°C für alle Temperatur-Regimes, egal ob hoch, niedrig oder alles dazwischen an allen Stellen der Erde?

Was die meisten Menschen nicht wahrhaben wollen ist, dass die Verwendung von Mittelwerten Informationen vernichtet. Wenn verschiedene Zahlen addiert werden und auf eine einzelne Zahl reduziert werden, kann man diesen Prozess nicht umkehren und die individuellen Messungen aus ihrem Mittelwert extrahieren. Beispiel: Nehmen wir die Zahlenfolge (2, 7, 1, 8, 7). Deren Mittelwert ist 5, aber es gibt noch viele andere Zahlenfolgen, deren Mittelwert ebenfalls 5 ist: (5,5,5,5,5), (1,9,5,9,1) usw. Die einfache Kenntnis des Mittelwertes reflektiert eine Zahlenfolge nur ungenau. Man beachte auch, dass ein einzelner Ausreißer die Zahlenfolge verzerren kann: (4, 4, 4, 9, 4) mittelt sich genauso zu 5 wie (1, 9, 5, 9, 1). Folglich geht nicht nur die Variabilität verloren, sondern auch mögliche Extreme werden hinweg gemittelt. Jetzt stellen wir uns mal vor, alle diese Zahlen seien Temperaturwerte.

Am 6. Dezember beträgt die mittlere Höchsttemperatur in Conway in Arizona 9,7°C, die mittlere Tiefsttemperatur -2,6°C und die Mitteltemperatur +3,6°C. Gerade in diesem Moment zeigt mir mein Computer eine Außentemperatur von 17,2°C an (verflucht sei die globale Erwärmung!), was aus den gegebenen Mittelwerten keineswegs vorhersagbar ist. Ist das also normal? Oder ist es für diesen Tag des Jahres besonders warm? Noch einmal, es ist einfach zu viel Information verloren gegangen. Statistiker würden sagen, dass wir die Standardabweichung mit erwähnen müssen oder einige höhere statistische Angaben wie Neigung und Amplitude [skew and kurtosis], aber auch dies würde uns nicht zurückführen zu den Originaldaten dieses Tages, geschweige denn, dass man damit die tatsächliche Temperaturkurve des Tages vorhersagen kann.

Genauso ist es mit der Jahresmitteltemperatur für meinen Heimatort. Der Mittelwert der Höchsttemperatur beträgt 22,1°C, derjenige der Tiefsttemperatur 9,4°C, die gesamt-Mitteltemperatur 15,8°C. Also liegt die Temperatur draußen derzeit über dem Mittelwert. Aber ich kann aus Erfahrung sagen, dass es bei uns oftmals Tage gibt, an denen die Temperatur nicht über den Gefrierpunkt steigt und auch Tage, an denen die Höchsttemperatur bis fast 38°C steigt. Würde man dies aus der Angabe der mittleren jährlichen Temperatur erwarten?

Jetzt stelle man sich vor, dass Temperaturdaten von Tausenden Orten auf der ganzen Welt für jeden Tag des Jahres kombiniert werden und daraus eine globale mittlere Temperatur gebildet wird – was würde diese Zahl bedeuten? Not a damned thing!

[Kursiv vom Übersetzer. Das muss man nicht übersetzen!]

Jetzt stelle man sich vor, man addiere 2°C zu unserer nutzlosen globalen mittleren Temperatur, was würde dies bedeuten? Werden 2°C alle Gebiete des Globus‘ in gleichem Maße betreffen? Natürlich nicht, und es gibt keine mathematische Macht in der Zahl der globalen mittleren Temperatur, die uns die wahre Auswirkung einer solchen Änderung vermitteln kann. In Wahrheit können wir mit jener erbärmlichen Einzelzahl nicht sagen, wie heiß oder kalt es auf unserem Planeten ist oder sein könnte. An einigen Orten ist es heiß, an anderen kalt, und doch leben Menschen an allen solchen Stellen. Vom gefrorenen Norden bis zu den dampfenden Tropen wohnen Menschen und andere Lebensformen.

Weitere 2°C werden keine Stelle auf der Erde unbewohnbar machen, die auch jetzt schon unbewohnbar ist. Tatsächlich wird es an vielen Stellen attraktiver und komfortabler, dort zu wohnen. Die Menschen fliehen aus kalten Orten wie Nordeuropa und Kanada. Sie begeben sich an heiße Orte wie Mallorca und Cancun. Die involvierten Temperaturunterschiede sind viel größer als 2°C, und doch scheinen Urlauber in sonnigen, warmen Klimaten nicht tot umzufallen. Die globale mittlere Temperatur ist nicht nur eine bedeutungslose Statistik, sondern ist auch irreführend, weil die zu deren Berechnung herangezogenen Daten von Forschern im Namen von „Wissenschaft“ verfälscht worden sind.

Als Erstes müssen wir also fragen, woher diese Zahl kommt. Der NOAA zufolge, einer Agentur der US-Regierung, wird eine Reihe von Datensätzen herangezogen, um die globale mittlere Temperatur zu berechnen:

Temperaturdaten vom Festland sind verfügbar aus dem Global Historical Climate Network-Monthly (GHCN-M). Wassertemperaturen werden berechnet mittels einer Analyse der erweiterten rekonstruierten Ozean-Wassertemperatur (ERSST). Für ERSST werden der jüngste verfügbare International Comprehensive Ocean-Atmosphere-Datensatz (ICOADS) herangezogen sowie statistische Verfahren, die auch bei dünner Datenlage stabile Rekonstruktionen ermöglichen. Die monatliche Analyse fängt im Januar 1854 an, aber wegen der nur sehr spärlich vorhandenen Daten werden vor dem Jahr 1880 keine globalen Mittelwerte berechnet. Mit mehr Beobachtungen nach 1880 ist das Signal stärker und mit der Zeit konsistent.

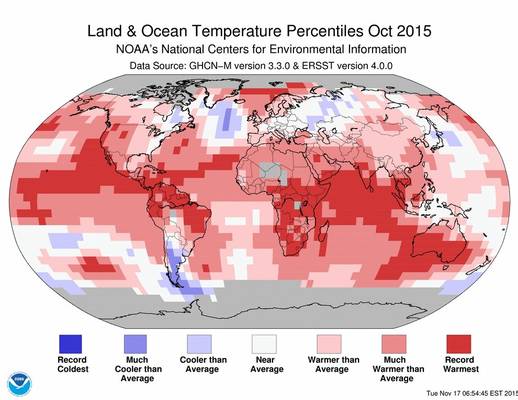

Man beachte die Erwähnung sowohl von Festlands- als auch von Wassertemperaturen (SST). Diese werden auf ziemlich unterschiedliche Art und Weise ermittelt. Dann werden sie mittels statistischer Verfahren „korrigiert“, das ist der wissenschaftliche Ausdruck für manipuliert. Das Ergebnis sieht so ähnlich aus wie das hier:

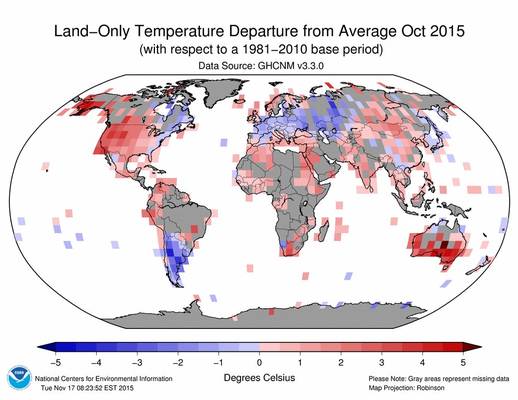

Jetzt beachte man den Bezug auf „dünne Datenlage“, was bedeutet, dass in vielen Gebieten tatsächliche Messungen nur an wenigen, weit auseinander liegenden Stellen durchgeführt werden. Dies gilt sowohl für das Festland als auch für die Ozeane. Man beachte beispielsweise den gewaltig breiten Streifen vor Südamerika, der als der „rekordwärmste“ apostrophiert worden ist. Und worauf basiert diese Aussage? Hier folgt eine Graphik der NOAA selbst, die den Datenmengen in manchen Gebieten zeigt:

Es fällt auf, dass das gleiche Gebiet in dieser Darstellung zeigt, dass es keine Daten für jenes Gebiet aus Brasilien gibt! Im Grunde sind die „rekordwärmsten“ Temperaturen in Brasilien und benachbarten Ländern fabriziert. Die Tatsache, dass sie durch ein Computerprogramm fabriziert worden sind, macht sie nicht weniger schwindlerisch. Das Gleiche gilt für andere Gebiete wie z. B. die warme Blase über Grönland, die von anderen NOAA-Daten diskreditiert wird. Mehr dazu schreibt Paul Homewood hier.

Also können wir nicht einmal dieser bedeutungslosen Historie bedeutungsloser Zahlen vertrauen, um auf irgendetwas hinzuweisen, das mit Klimawandel zu tun hat. Und doch fahren Wissenschaftler mit Eigeninteresse daran, dass der Klimawandel eine herauf dämmernde Krise ist, fort, Daten zu manipulieren, um es so aussehen zu lassen, als ob die globalen Temperaturen weiterhin steigen. Erst jüngst haben NOAA-Forscher unter Führung von Thomas R. Karl eine neue Studie veröffentlicht mit dem ziemlich cleveren Titel „Possible artifacts of data biases in the recent global surface warming hiatus.” Darin geben sie vor zu beweisen, dass der gut dokumentierte Stillstand von über 18 Jahren lediglich eine Folge schlechter Daten ist und dass sie in der Lage waren, dies zu bereinigen. Aus dem Abstract:

Viele Studien wurden bzgl. der möglichen Gründe einer augenscheinlichen Abnahme des Anstiegs der globalen Temperatur seit 1998 durchgeführt, ein Phänomen, dass als „Stillstand“ der globalen Erwärmung bezeichnet wurde. Hier präsentieren wir eine aktualisierte Analyse der globalen Temperatur, die enthüllt, dass die globalen Trends höher sind als jene, die das IPCC nennt, vor allem während der letzten Jahrzehnte, und dass die zentrale Schätzung der Erwärmungsrate während der ersten 15 Jahre des 21. Jahrhunderts mindestens genauso stark war wie in der zweiten Hälfte des 20. Jahrhunderts. Diese Ergebnisse stützen nicht die Präsenz einer „Verlangsamung“ der Zunahme der globalen Temperatur.

Viel wiederum wurde auch geschrieben zu diesem jüngsten Versuch der Temperatur-Taschenspielerei, und das möchte ich hier nicht alles wiederholen. Jene, die das interessiert, können hier schauen in einem exzellenten Artikel auf dem Blog von Judith Curry. Hier folgt der Kern dessen, was Zeke Hausfather und Kevin Cowtan über Karls Reanalyse zu sagen haben:

Beträchtliche mediale und politische Aufmerksamkeit konzentrierte sich auf die neue NOAA-Aufzeichnung der Temperatur, welche deutlich mehr Erwärmung zeigt als deren Aufzeichnung zuvor im Zeitraum von 1998 bis zur Gegenwart. Der Hauptfaktor hinter diesen Änderungen ist die Korrektur der Ozean-Wassertemperaturen, die vorgenommen wurde anlässlich des Übergangs von Messungen von in Schiffsmaschinen einströmendem Kühlwasser zu Messungen durch Bojen. Es ergab sich eine Differenz zwischen beiden. Hier wollen wir die Änderungen an den NOAA-Wassertemperatur-Aufzeichnungen evaluieren, indem wir eine neue, nur auf Bojenmessungen basierende Aufzeichnung dieser Temperaturen konstruieren. Wir kommen zu dem Ergebnis (ohne irgendwelche Adjustierungen vornehmen zu müssen), dass eine Aufzeichnung ausschließlich durch Bojen effektiv identisch ist hinsichtlich des Trends zur neuen NOAA-Aufzeichnung und deutlich höher als in der alten Aufzeichnung.

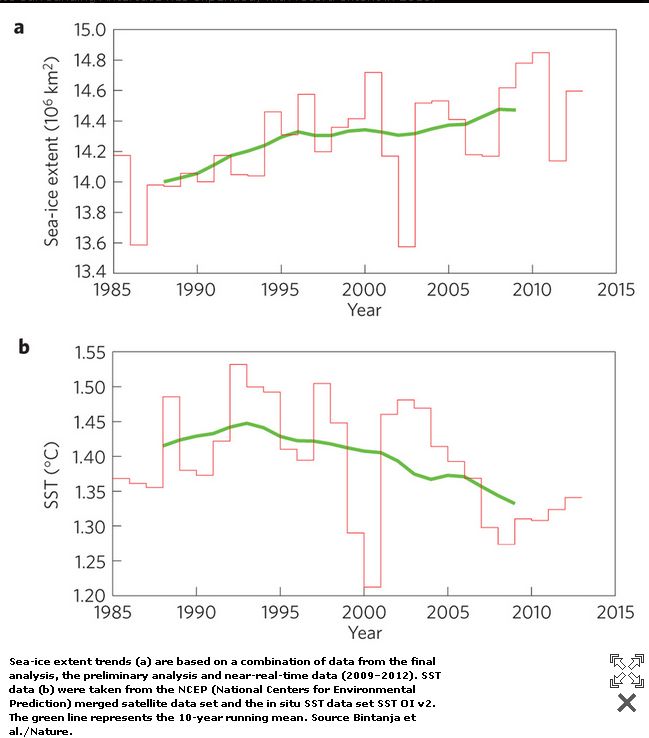

Interessant ist hier, dass Hausfather und Cowtan behaupten, dass die Temperatur des in Schiffe einströmenden Kühlwassers hinsichtlich der viel neueren Bojendaten verzerrt ist. Unglücklicherweise reichen die Schiffsdaten viel weiter zurück als die Daten von Bojen, die den größten Teil historischer Aufzeichnungen ausmachen. Außerdem weist Dr. Curry darauf hin, dass es einen weiteren SST-Datensatz gibt – OISSTv2 – für den Zeitraum seit den achtziger Jahren. Dieser Datensatz hat eine höhere horizontale Auflösung dank der Verwendung von Satellitendaten sowie des Vergleichs zwischen Satelliten- und Schiffsbeobachtungen einerseits zu den Bojendaten andererseits. Curry schreibt: „Unter dem Strich scheint zu stehen, dass der Trend im NOAA ERSSTv4-Datensatz von 1998 bis 2014 etwa doppelt so hoch ist wie der Trend in den Datensätzen HADSST3 und OISSTv2.” Welcher ist korrekt? An diesem Punkt schreit jemand „die Wissenschaft ist settled!“

Dr. Curry und ihre Mitarbeiter stehen nicht allen, wenn sie die überarbeiteten NOAA GISS-Daten hinterfragen. Der Geologe und Berechnungs-Experte Prof. Dr. Friedrich Karl Ewert hat angefangen, sich näher mit den Daten hinter den Behauptungen der globalen Erwärmung zu befassen, und besonders die Datensätze von NOAA GISS erregten sein Interesse. Er kam ebenfalls zu der Schlussfolgerung, dass die Temperaturaufzeichnung entwertet worden war. „Massiv verändert“, hieß es in einem Online-Report.

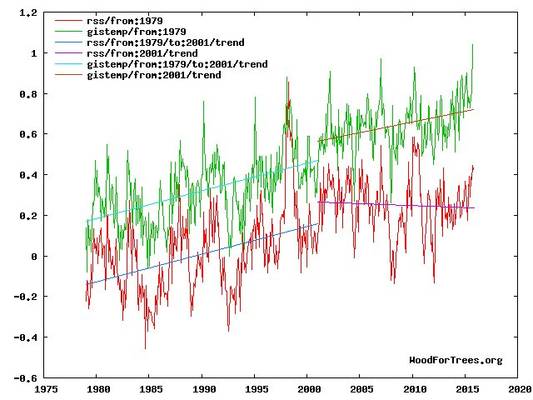

Am aussagekräftigsten von all dem ist vielleicht, dass es andere Datensätze gibt, die nicht auf räumlich sehr spärlichen Daten von weit auseinander liegenden Temperaturstationen oder umstrittenen Daten von fahrenden Schiffen basieren. Jene Daten stammen von Infrarot-Satellitenmessungen. Hier folgt ein Vergleich der RSS-Satellitendaten und GISS:

Man erkennt, dass die Temperaturen den RSS-Satellitendaten zufolge im Zeitraum 1979 bis 2001 mit praktisch der gleichen Rate wie bei GISS gestiegen sind. Seitdem zeigt sich eine bedeutende Divergenz, wobei GISS eine Rate zeigt, die praktisch genauso hoch ist wie im Zeitraum zuvor. Im Kontrast dazu bestätigt RSS (und auch UAH, eine weitere, auf Satelliten basierende Historie) dass, wenn überhaupt, die Temperaturen eher zurückgegangen sind.

Zweitens, wir müssen nachfragen, woher diese Zahl von 2°C kommt, falls Wissenschaftler nicht nur die Gewässer vermanschen, aus denen diese bedeutungslose Temperaturzahl stammt, und sie darüber hinaus auch die Bücher fälschen. Welche mögliche Rechtfertigung haben sie für ihre Behauptung, dass diese 2°C unsere Welt unbewohnbar machen werden? Es gibt keine! Einem Artikel in der Huffington Post zufolge ist der Hintergrund dieser 2°C-Zahl Folgender:

Zusammen mit den Nachrichten über COP21 hören wir immer wieder von der Notwendigkeit, den globalen Klimawandel unter dem 2°C-Ziel zu halten. Allerdings wissen nur wenige Menschen, woher dieses 2°C-Ziel kommt. Der Grund dafür ist, dass das 2°C-Ziel eines der am meisten freiwillig verschlammten Themen in der Debatte um den Klimawandel ist. Warum ist das so? Weil dieses spezielle Ziel keine wissenschaftliche, sondern eine politische Zahl ist.

Dazu muss man wissen, dass die HuffPo eine Sammlung wahrer grüner Gläubiger und Klimaalarmisten allererster Güte ist.

Da also haben wir es. Die mittlere globale Temperatur ist eine vermanschte, bedeutungslose Zahl, die nur für Nachrichten-Artikel, Presseerklärungen und Forderungen nach Geldern von Regierungsseite nützlich ist. Sachkundige Wissenschaftler wie Roger Pielke Sr. werden sagen, dass keinerlei prophetische Macht dahinter steckt. Die gefürchtete 2°C-Barriere ist kein wissenschaftlich etablierter Kipp-Punkt, der das Ende der Welt einläutet, sondern politischer Unsinn.

Hier steht im Original eine Karikatur, deren Copyright eine Wiedergabe hier verbietet. Anm. d. Übers.]

Während also wissenschaftliche Dunkel-Lichter [dim bulbs] wie Präsident Obama, John Kerry und Prinz Charles ernste Warnungen ausgeben, dass die Apokalypse unmittelbar bevorsteht [wobei diesen die Medien zumindest bei uns in D tatkräftig unter die Arme greifen! A. d. Übers.], räumen selbst Klimaalarmisten mit Wurzeln in realer Wissenschaft wie James Hansen ein, dass das 2°C-Erwärmungslimit „crazy“ ist und „nicht auf Wissenschaft basiert“. All das Klima-Sturm-und-Drang*, das von der COP21-Konferenz in Paris nach außen dringt, ist viel Lärm um nichts. Mein Rat an alle da draußen lautet, alles Gefasel von Apokalypse seitens der Klimaalarmisten zu ignorieren und sich an der Holiday Season zu erfreuen, welche Temperatur auch immer dort herrscht, wo Sie gerade sind.

Bleiben Sie sicher, erfreuen Sie sich des Interglazials und bleiben Sie kritisch.

[*Im Original steht: All the climate change sturm und drang…]

Link: http://theresilientearth.com/?q=content/global-average-temperature-meaningless-misleading

Übersetzt von Chris Frey EIKE