Klimachaos-Behauptungen lösen weiterhin Betroffenheit aus

Die Vorwürfe lesen sich phasenweise, als ob sie von einem Monty Python Comedy Team und ein paar Jurastudenten im ersten Semester geschrieben worden sind. Die beklagten Unternehmen sollen „konspiriert“ haben, um gefährliche Treibstoffe herzustellen, heißt es in der Klageschrift, und sie sollen dabei „dem Drehbuch von Big Tobacco“ gefolgt sein, während sie „Leugner-Gruppen“ finanzieren, damit diese die „etablierte“ Klimawissenschaft in Frage stellen, die „beispiellosen“ Risiken der vom Menschen verursachten globalen Erwärmung „herunterspielen“ sowie „unbegründete Angriffe gegen die Integrität“ führender „Konsens“-Wissenschaftler führen.

Und weiter: „Farbige Personen“ und andere „sozial verwundbare“ Individuen werden am stärksten betroffen sein. (Dabei dürften diese Personen viel mehr durch die Klimapolitik geschädigt werden, treibt diese doch die Preise von Energie und Nahrungsmitteln hoch).

Die Anwälte von Oakland greifen scharf den Astrophysiker Wei Hock „Willie“ Soon an, weil er die unverzeihliche Sünde begangen hat zu fragen, ob nicht die Sonne irgendetwas mit Klimawandel zu tun hat. Sie bekamen nicht einmal seinen Ph.D. richtig hin. Sie nennen ihn „Raumfahrt-Ingenieur“ und behaupteten, dass er persönlich der Empfänger von 1,2 Millionen Dollar sei, die in Wirklichkeit an die Harvard University geflossen sind (dies geht eindeutig aus vielen, leicht zugänglichen Dokumenten hervor).

Sie erwähnen nicht einmal ansatzweise die Milliarden Dollars der Steuerzahler, welche Jahr für Jahr unter Forscher und Aktivisten aufgeteilt worden sind, welche die alarmistischen Standpunkte bzgl. globale Erwärmung und erneuerbare Energie vorantreiben.

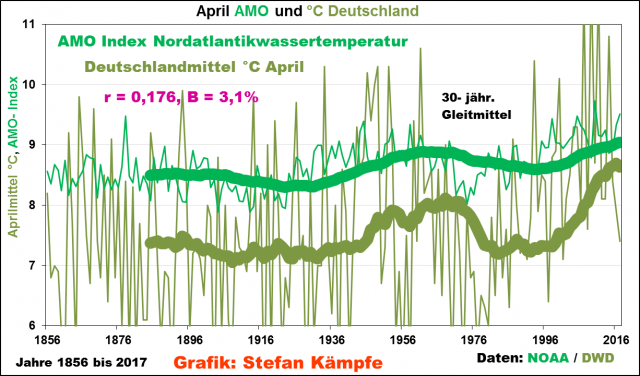

Oakland und seine Mitstreiter erwarten, dass der Gerichtshof ihre Behauptungen eins zu eins akzeptiert als „etablierte“ Wissenschaft. Es bestehe ihnen zufolge kein Bedarf, Beweise aus der realen Welt als Stützung dieser Behauptungen zu präsentieren. Sie betonen allen Ernstes besonders, dass steigende Meeresspiegel und die daraus folgende „unmittelbare Bedrohung durch katastrophale Flutwellen“, welche von Computermodellen „projiziert“ werden, jetzt via fossile Treibstoffe der primäre oder alleinige Treiber des Klimawandels sind, welche die Sonne, kosmische Strahlen, Meeresströme und andere mächtige Naturkräfte ersetzt haben, welche „zuvor“ für Klimawandel verantwortlich waren.

In ihrer Klage gegen fünf große Ölunternehmen ignorieren sie die Tatsache, dass die Unternehmen nur sehr wenig des Treibstoffes verbrennen, den sie erzeugen. Es sind die Stadtregierungen der Kläger und deren Wähler, welche nur zu glücklich waren, seit über einem Jahrhundert Öl und Erdgas zu verbrennen, um ihre Autos zu fahren, um zu heizen, kühlen, beleuchten sowie ihre Büros und Wohnungen zu erleuchten und zu elektrifizieren – und überhaupt erst ihre Industrie, ihre Kommunikation, Gesundheit und Lebensstandards ermöglichten.

In dem Prozess sind sie es, die das Pflanzen düngende CO2 erzeugt haben, welches vermeintlich die Ursache der beispiellosen globalen Erwärmung sein soll, die Ursache schmelzender Eiskappen und steigender Meeresspiegel. Kohlenwasserstoffe befeuern auch die unabdingbaren Stromgeneratoren der Wind- und Solareinrichtungen in Kalifornien – und liefern Rohmaterialien für Stoffe, Plastik, Gemälde, Pharmaprodukte und zahlreiche andere Erzeugnisse, welche die Kläger jeden Tag nutzen.

Genauso problematisch für die Kläger ist, dass die „etablierte Konsens“-Wissenschaft, die sich wie ein roter Faden durch die gesamte Klageschrift und die Aussagen vor Gericht zieht, immer unsicherer und immer hitziger debattiert wird. Der Wissenschaftler am Heartland Institute Joe Bast weist darauf hin, dass selbst das IPCC höchstselbst inzwischen zahlreiche Zweifel und Unsicherheiten einräumt hinsichtlich der Rate des Meeresspiegel-Anstiegs, der Rolle von CO2, den Ursachen und der Dauer des „Stillstands“ der globalen Erwärmung, welcher inzwischen schon 23 Jahre andauert. Tatsächlich ist die Temperaturspitze des starken El Nino 2015/16 weitgehend wieder verschwunden, und Ozean und Atmosphäre kühlen sich wieder fortgesetzt ab.

Die Ölunternehmen haben sich entschlossen, gar nicht so viel Klimawissenschaft in dem Verfahren heranzuziehen. Allerdings haben Lord Christopher Monckton, Will Happer, Richard Lindzen und deren Kollegen Fragen angesprochen über Gleichgewichts-Klimasensitivität [auf Deutsch beim EIKE hier] und damit zusammenhängende Dinge, und zwar in Sachverständigen-Gutachten für das Gericht.

Die Behauptung von Oakland, der zufolge die Ölunternehmen „konspirierten“, um „die Wissenschaft“ zu globaler Erwärmung und Klimawandel zu verstecken und falsch darzustellen, steht auf sehr dünnem Eis. In einigen Berichten heißt es, dass Richter Alsup diese Behauptungen zurückwies oder urteilte, dass die Kläger keinen Beweis dafür erbringen konnten, dass es eine Konspiration gab. In jedem Falle wird es eine Entscheidung zu all dem geben, die verlierende Partei wird Revision einlegen, und der ganze Fall wird wahrscheinlich vor dem obersten US-Gerichtshof landen.

Inzwischen verursachen Klimachaos-Behauptungen in einigen Kreisen weiterhin Betroffenheit. Zu viel Geld, Macht, Prestige, Kontrolle und Wohlstands-Umverteilung steht auf dem Spiel, so dass kaum ein anderer Weg denkbar ist.

Tatsächlich nutzen Viele in dem Klima-industriellen Komplex im Wert von 1,5 Billionen Dollar pro Jahr diesen Fall (und gleichermaßen dehnbare Mantras von „Nachhaltigkeit“), um den Kapitalismus freier Märkte durch eine totalitäre Eine-Welt-Regierung zu ersetzen; fossile Energie und Kernkraft (welche zur Zeit 85% der verbrauchten Energie in den USA und global ausmachen) durch teure, Land fressende Wind-, Solar- und Bioenergie zu ersetzen sowie die Hoffnungen und Träume armer Menschen auf der ganzen Welt durch eine Politik zu zerschlagen, die es nur in sehr geringem Umfang gestattet, dass sich deren Lebensstandard verbessert.

Tatsächlich versteigen sich die Klimawandel-Chaoten dazu, nicht nur Kohlendioxid und Methan für eine runaway-globale Erwärmung verantwortlich zu machen, sondern auch Asthma-Inhalatoren und Fleischdiäten. Die Folgen hiervon sind nicht nur steigender Meeresspiegel, wärmeres und kälteres Wetter, nassere und trockenere Zeiten, Waldbrände, nicht existierendes Massenaussterben und anderen oftmals erwähnte Pseudo-Kataklysmen. Auch kleiner werdende Tiere, eine immer schlimmere Drogenkrise sind enthalten, ebenso wie die endlose Litanei oftmals erheiternder Beschwerden und Katastrophen, gelistet in The Warmlist und deren video counterpart.

Die „Lösung“ besteht nicht darin, die fossile Treibstoffe einfach im Boden zu lassen. Sie besteht auch in der Akzeptanz ausgeprägter Änderungen des Lebensstils sowie des Verzehrs klimafreundlicher Insekten (gilt nicht für die herrschenden Eliten, sondern nur für uns Normalverbraucher).

Und die wirklichen Auswirkungen der Furcht vor dem Klima-Kataklysmus sind nicht nur immer höhere Preise für immer weniger, unzuverlässigeren, das Netz destabilisierenden „grünen“ Strom. Darunter sind auch die Notwendigkeit Abenteurer zu retten, welche versuchen, über das vermeintlich schmelzende Eis in Arktis und Antarktis zu segeln, mit Motorschlitten zu fahren oder zu wandern – nur um dann gerettet werden zu müssen, weil sie gestrandet sind, Frostbeulen davontragen und ihre Schiffe in rapide gefrierendem Eis festsitzen.

Was also sollen die strammen Statthalter der Klimakatastrophe tun, wenn Temperaturen und Meeresspiegel es ablehnen, den Reden Al Gores sowie „Projektionen“ von Computermodellen und „Szenarien“ zu folgen? Oder wenn Vorhersagen über immer mehr Hurrikane eine rekordlange Zeit von 12 Jahren folgt, ohne dass irgendein Sturm der Kategorie 3 bis 5 auf das US-Festland übergreift?

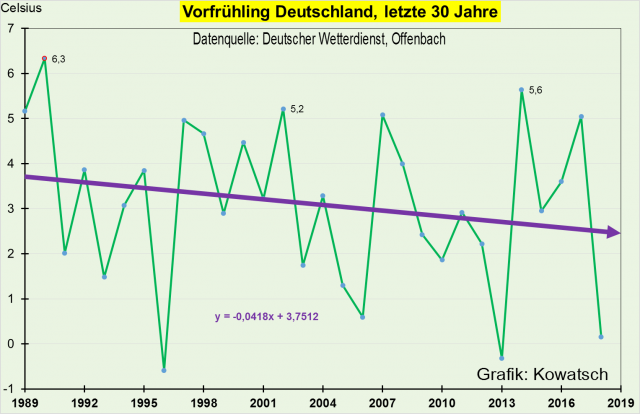

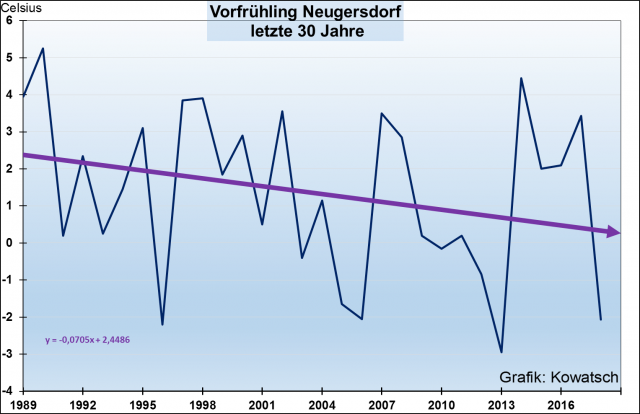

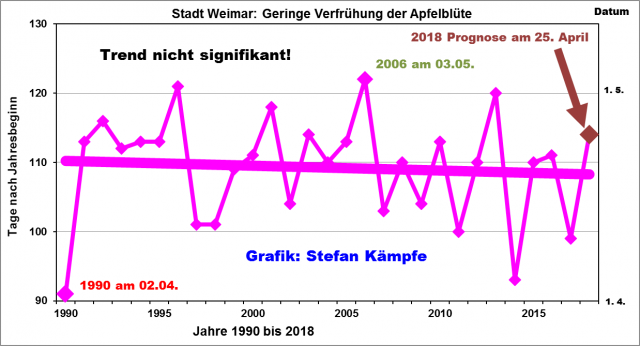

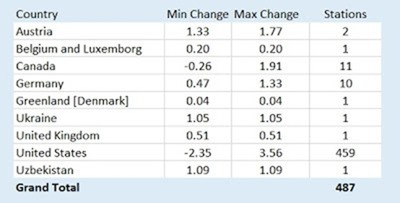

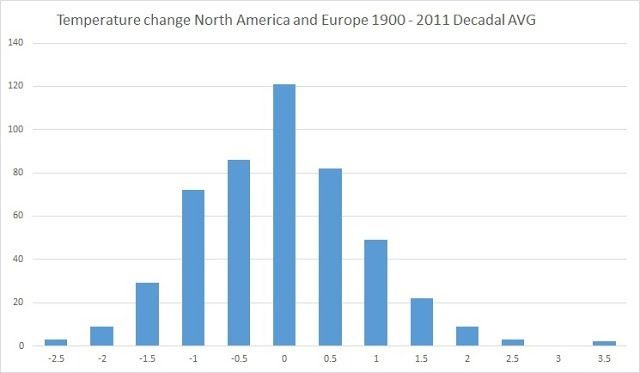

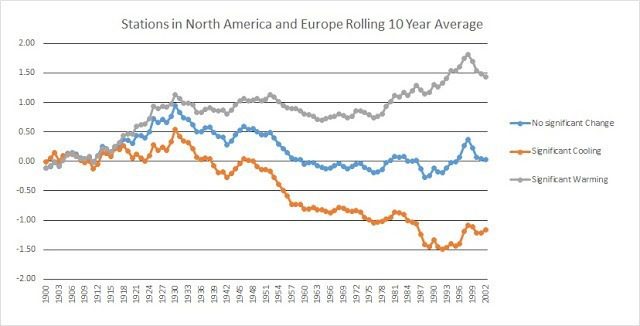

Eine Strategie besteht darin, Diskussionen mit allen abzulehnen, welche die düsteren Hypothesen, Daten oder Schlussfolgerungen hinterfragen. Eine andere Strategie ist es, Originaldaten zu „homogenisieren“, zu „korrigieren“ und zu manipulieren, damit die Temperaturen der Dust Bowl-Ära [= die dreißiger Jahre im vorigen Jahrhundert in den USA, Anm. d. Übers.] nicht so warm daherkommen – und damit die langen und bitterkalten Winter der letzten Jahre nicht so kalt erscheinen. Zu diesem Zweck wurden Aufzeichnungen lokaler Temperatur-Messpunkte um bis zu 1,7 Grad Celsius adjustiert (hier).

Was die zahlreichen Artikel und Studien betrifft, welche bei WattsUpWithThat.com, DrRoySpencer.com, ClimateDepot.com, ClimateChangeReconsidered.org und anderen Sites veröffentlicht werden, welche sich auf Klimastudien und Forschungen auf der Grundlage von beweisen konzentrieren und welche Behauptungen wie jene in Frage stellen, auf welche sich die Klage von Oakland stützt – die immer häufiger ergriffene Strategie besteht darin, Algorithmen und andere Taktiken anzuwenden, um entsprechende Arbeiten ganz an das Ende von Suchmaschinen-Anfragen zu stellen. Lange Listen alarmistischer Behauptungen, Artikel und Perspektiven erscheinen zuerst, es sei denn, ein Student oder ein anderer Forscher gibt sehr spezifische Suchbegriffe ein. Selbst die großen Schwachpunkte von Windenergie [auf Deutsch beim EIKE hier] sind schwer zu finden, wenn man nicht ganz genau weiß, wonach man sucht.

Google, Facebook, You Tube und andere Such- und Sozialmedien scheinen sich zu Schiedsrichtern aufgeschwungen zu haben, zu welchen Fakten und Realitäten wir Zugang haben dürfen, was unsere Kinder lernen sollen. Sie helfen dabei, Wissenschaftler zu stigmatisieren und zu schikanieren, deren Forschungen oder Standpunkte nicht zu akzeptierten linken Perspektiven passen. Sie haben sogar professionelle Werbeträger engagiert, um die Reden politischer Gegner zu kontrollieren.

Und all das seitens der Champions der freien Rede, von Toleranz, Diversität und Inklusion. Nicht vergessen:

Es geht nicht darum, ob sich unser Planet erwärmt oder ob sich Wetter und Klima ändern. Es geht darum, welche Ursachen diese Fluktuationen haben, wie viel davon auf fossile Treibstoffe und wie viel auf natürliche Kräfte zurückgeht, und darum, ob irgendwelche kommenden Änderungen genauso katastrophal sind, wie es durch natürliche Kräfte in der Vergangenheit schon oft vorgekommen ist (man stelle sich einmal vor, wie es unseren Städten, Bauernhöfen und der Menschheit gehen würde, falls es zu einer weiteren Pleistozän-Eiszeit kommen sollte).

All dies unterstreicht wieder einmal, warum Amerika und die ganze Klimawissenschaft ein „Red Teams“ braucht, mehr Klima-Bildung auf der Grundlage von Beweisen und eine Umkehr der willkürlichen, von Obamas EPA in den Raum gestellten Behauptung, wonach Kohlendioxid-Emissionen irgendwie das menschliche Wohlergehen und den Wohlstand gefährden.

Paul Driessen is senior policy analyst for the Committee For A Constructive Tomorrow (www.CFACT.org) and author of books and articles on energy and environmental policy.

Link: https://www.iceagenow.info/climate-chaos-claims-continue-causing-consternation/

Übersetzt von Chris Frey EIKE