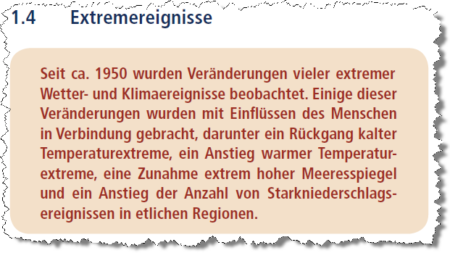

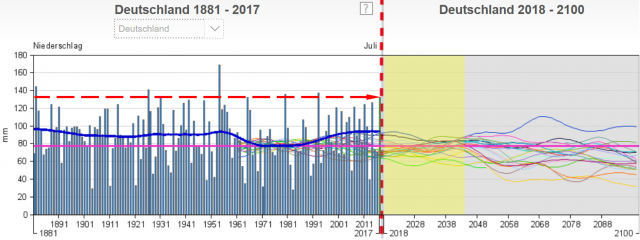

Wenn also wie im Bild 5 vom Lügendetektor behauptet wird, man könnte durch Analysen seit 1950 bei Extremereignissen verlässliche Trendaussagen ableiten, ist dies bereits der erste, ganz grobe Fehler des Autor*in vom Lügendetektor (und des IPCC).

Wären diese „Verbindungen“ auch nur entfernt belegfähig, hätte man diese stolz präsentiert.

Nun empfiehlt der „Lügendetektor“, in den IPCC-Reports selbst weiterzulesen, was hiermit erfolgt.

Die IPCC-Aussagen zu Extremereignissen und seine „Sicherheiten“

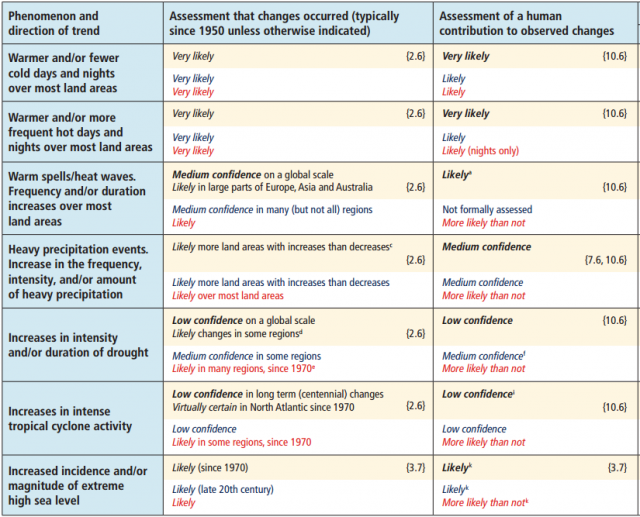

Die im Bild 6 vom Lügendetektor auszugsweise angezogene Fundstelle im IPCC-Report sagt:

Dies führt zu der Erklärung: Man fand keinen wirklichen Beleg, dass es mehr Landgebiete mit gestiegenem Starkniederschlag gibt, sondern musste sich auf Vermutungen beschränken. Und dort, wo man es vermutet, würfelte man sprichwörtlich, ob das böse CO2 Ursache sein könnte:

die Aussage ist in etwa 5 von 10 Fällen richtig“ [13]

Das ist ganz einfach die „Sicherheit“, welche ein Münzwurf erzeugt und nicht eine Spur mehr. Also auch dazu wieder der Beleg, dass man nichts belegen konnte.

Liest man wie empfohlen weiter, steht alles direkt da, was die Aussage: Extremereignisse nehmen Klimawandel-bedingt nicht zu, bestätigt:

IPCC-Report:

-Es besteht geringes Vertrauen, dass der anthropogene Klimawandel die Häufigkeit und das Ausmaß von Flusshochwassern auf globaler Ebene beeinflusst hat.

-Es besteht geringes Vertrauen in beobachtete globale Trends von Dürren

-Aufgrund derselben Beobachtungsunsicherheiten sowie von Schwierigkeiten bei der Abgrenzung dekadischer Schwankungen der Dürren von langfristigen Trends besteht ebenfalls geringes Vertrauen in die Zuordnung von Veränderungen von Dürren über globalen Landflächen seit Mitte des 20. Jahrhunderts

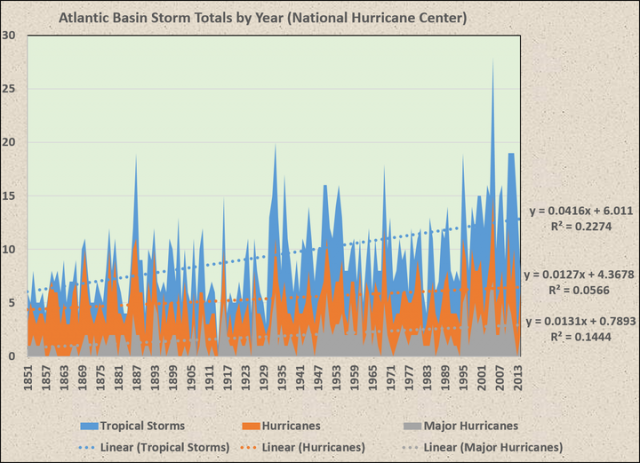

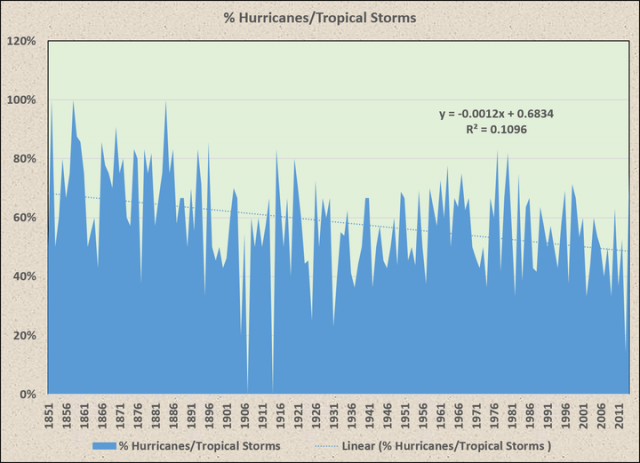

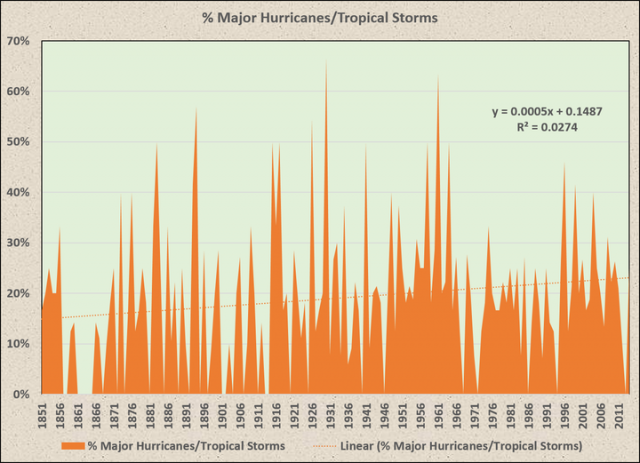

-Es besteht geringes Vertrauen, dass langfristige Veränderungen in tropischen Wirbelsturmaktivitäten robust sind, und es besteht geringes Vertrauen in die Zuordnung globaler Veränderungen zu einer bestimmten Ursache

Deutlicher, als es der IPCC hier vorführt, kann man doch nicht mehr darauf hinweisen, dass Extremereignisse nicht mit einem AGW-Klimawandel in Verbindung gebracht werden konnten. Liest das Klimaretter und sein Lügendetektor denn nicht?

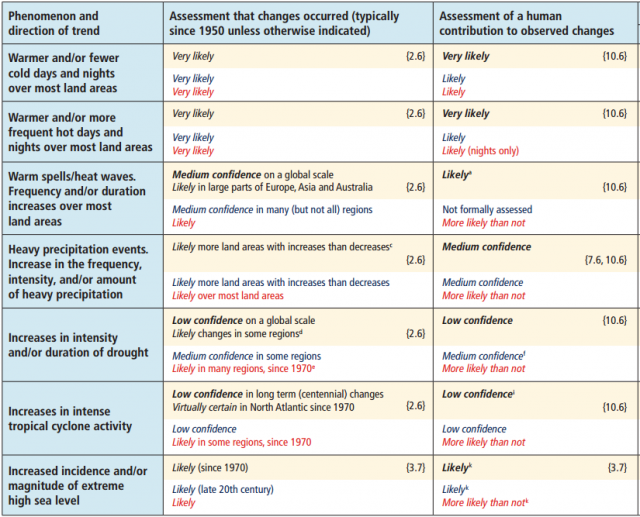

In der Tabelle vom Bild 9 aus dem Report sieht man es in der Übersicht. Das Einzige, bei dem sich der IPCC sicher wähnt, ist der Anstieg der Temperatur.

„Sicherer“ wird sich der IPCC erst in seinen Zukunftsprojektionen. In seinen Simulationsvorhersagen wird aus dem Würfelspiel auf einmal öfters „hohes Vertrauen“. Warum die Zukunft genauer werden soll, wenn man die Gegenwart schon nicht bewerten kann, muss man ja nicht verstehen.

Bild 9 Der relevante Ausschnitt der Tabelle SPM.1 im AR5 Langbericht

Und noch etwas fällt auf. Im IPCC AR5 werden zur Bewertung von Starkregenereignissen (heay precipitation events) Studien angezogen, welche aus 30 Jahren Testzeitraum signifikante Trends ableiten wollen [10]. Das ist nach den Erfahrungen des Autors schlichtweg unmöglich, da es (fast möchte man sagen: bewusst) zu falschen Ergebnissen führt, nicht überprüft werden kann und damit unzulässig ist [6] [8] [9]. Die aktuelle Studie [7] bestätigt ihn darin (siehe auch das vorhergehende Kapitel).

Aktuelle Erkenntnisse zu Extremereignissen

Zuerst das Einfache: Auch neueste Analysen finden keinen AGW-Einfluss.

EIKE 5. September 2017: Nehmen Überschwemmungen in den letzten Jahrzehnten zu?

„Anzeichen für signifikante Trends in Gruppen, aufgeteilt nach Größe, Ort, Klima, Überflutungshöhe und zeitliche Periode von Ereignissen sind nicht aufzufinden. Die Anzahl singnifikanter Trends in großen Überschwemmungsereignissen entspricht dem, was man aus reinem Zufall erwarten muss …. Es wurden dreimal mehr signifikante Abhängigkeiten zwischen großen Überflutungsereignissen und der Atlantischen Multidekadalen Oszillation (hier) gefunden als signifikante Langzeit-Trends.“

Diese Studie bestätigt damit wieder, was die in [6] bereits ermittelte. Anmerkung: Nachdem diese Studie [6] in Europa keinen Trend feststellen konnte, reduzierte sie sich auf die Ermittlung einer Zeitverschiebung.

Bedeutungsvolle an diesen neuen Studien ist, dass sie Nordamerika und Europa analysierten, ausgerechnet die Gegenden, in denen die IPCC-Analysten noch die signifikantesten Trends meinten berechnen zu können.

Das Wetter war um 1900 extremer als heute

Geht man noch etwas weiter in der angeblich idealen Klimazeit zurück, findet sich Erschreckendes. Damals wütete das Wetter noch fürchterlicher als aktuell. In der Namib-Wüste kann man den Unterschied (die Wüste wurde in historischer Zeit von extremen Flutereignissen getroffen) heute noch sehen:

EIKE 14.10.2015: Der Klimawandel bedroht die Wüste Namib – glaubt Deutschlandradio Kultur,

in Europa sichte man dazu die Daten und sehe sich die Hochwassermarken unserer Flüsse an.

EIKE 31.07.2017: G20 Klimafakten ohne Hysterie betrachtet Teil 4 (4)

EIKE 10.05.2017: Die Volkshochschule Hannover und ihre Ausstellung: Wir alle sind Zeugen – Menschen im Klimawandel

Kelly MJ 2016: [7] Trends in Extreme Weather Events since 1900 – An Enduring Conundrum for Wise Policy Advice

Abstract

It is widely promulgated and believed that human-caused global warming comes with increases in both the intensity and frequency of extreme weather events. A survey of official weather sites and the scientific literature provides strong evidence that the first half of the 20th century had more extreme weather than the second half, when anthropogenic global warming is claimed to have been mainly responsible for observed climate change. The disconnect between real-world historical data on the 100 years’ time scale and the current predictions provides a real conundrum when any engineer tries to make a professional assessment of the real future value of any infrastructure project which aims to mitigate or adapt to climate change. What is the appropriate basis on which to make judgements when theory and data are in such disagreement?

Ganz grob übersetzt:

Es wird verkündet und geglaubt, dass die von Menschen verursachte globale Erwärmung eine zunehmender Intensität und Häufigkeit von extremen Wetterereignissen bewirkt. Eine Sichtung der Standortdaten und der wissenschaftlichen Literatur liefert jedoch starke Beweise dafür, dass die erste Hälfte des 20. Jahrhunderts extremeres Wetter als die zweite Hälfte hatte, in der die anthropogene globale Erwärmung für negative Einflüsse verantwortlich gemacht wurde. Der nicht vorhandene Zusammenhang zwischen den wirklichen, historischen Daten über 100 Jahre und den aktuellen Vorhersagen geben Rätsel auf, wenn man als Ingenieur versucht, eine professionelle Bewertung der realen mit den zukünftigen Anforderungen eines Infrastrukturprojekts durchzuführen, um es dem Klimawandel anzupassen.

Was soll die geeignete Grundlage für eine Entscheidungsfindung sein, wenn Theorie und wirkliche Daten so weit auseinanderklaffen?

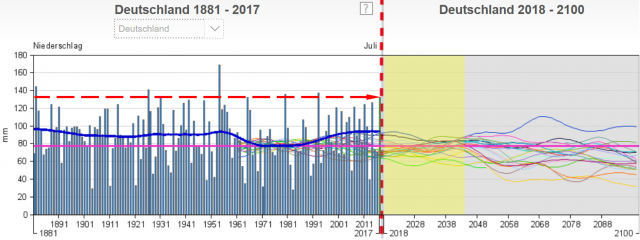

Kann man den Klimawandel und seine Extreme in Deutschland täglich spüren

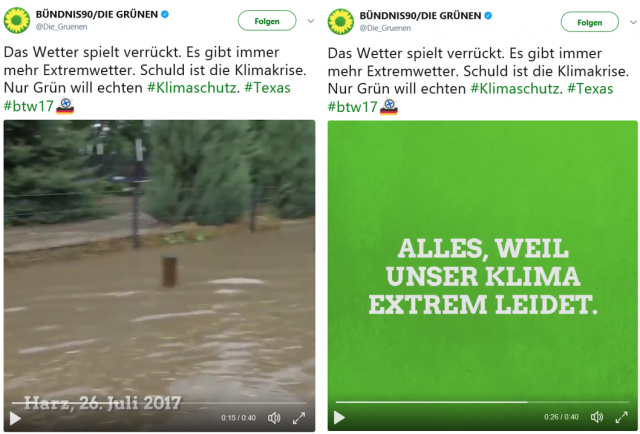

Bild 10 Screenshot vom beim Lügendetektor angesprochenen Videoclip der GRÜNEN [2]

Anbei kurze Ausschnitte:

Umweltbundesamt: [16] CLIMATE CHANGE 24/2015

Entsprechend den Niederschlägen ist auch bei der zukünftigen Entwicklung der Trockentage kein klarer Trend bei den Prognosen zu erkennen. Die Szenarien reichen von einer Abnahme der trockenen Tage hin zu einer Zunahme.

… Auch bezüglich anderer Extremwetterereignisse ist kein einheitlicher Trend auszumachen. Die Anzahl der Starkregentage könnte insbesondere in den deutschen Alpen und im Alpenvorland abnehmen. Sie könnte dort jedoch auch zunehmen. Einen ähnlich uneinheitlichen Trend zeigen die Projektionen für Starkwindereignisse.

Ergebnisse für die Gegenwart

In der Gegenwart sind Biotope und Habitate durch den Klimawandel und Klimaextreme gering betroffen. Der überwiegende Druck auf Biotope und Habitate kommt durch die Nutzung (überwiegend durch die Landwirtschaft), Versiegelung und Zersiedelung der Landschaft und Fragmentierung durch Verkehrswege zustande.

… Hagelschäden sind derzeit mit Abstand die relevantesten Folgen von Extremwetterlagen … In den letzten Jahrzehnten haben die versicherten Schadenssummen zugenommen, was aber weniger eine Folge der Zunahme von Hagelschäden ist, sondern durch den zunehmenden Versicherungsgrad und eine Steigerung der Preise erklärt werden kann.

Die Wirkung der Klimaextreme Hagel und Sturm in der fernen Zukunft kann zurzeit nicht mit ausreichender Gewissheit abgeschätzt werden, da Klimaszenarien darüber keine trendsicheren Aussagen erlauben und auch die Klimabeobachtungen der Vergangenheit keinen signifikanten Trend ergeben.

Die langfristigen Wetterphänomene können von den Klimaszenarien teilweise nur sehr begrenzt und mit großen Unsicherheiten abgebildet werden.

Erst für die Zukunft wagt es das UBA in dieser Analyse, Klimawandeleinfluss vorherzusagen. Allerdings nur auf Grundlage der „mit großen Unsicherheiten“ behafteten Klimasimulationen.

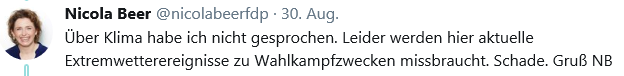

Aufruf an Frau Beer, Generalsekretärin der FDP

Sehr geehrte Frau Beer: Im Gegensatz zu ihrem Bundesvorsitzenden haben Sie den Mut, schon einmal kritisch zu den angeblich als sicher geltenden AGW-Klimawandel verursachten Extremereignissen zu stehen und es auch zu verkünden.

Bild 11

Leider fehlt Ihnen dieser Mut noch beim Basisthema.

EIKE: Klimavertrag von Paris im Bundestag erreicht 100 % Zustimmung

BUNDESUMWELTPORTAL: BEER 30. November 2015: Erwartungen an ein Signal zum Klimaschutz / Zum bevorstehenden Pariser Klimagipfel erklärt FDP-Generalsekretärin NICOLA BEER

(BUP) „Paris muss ein deutliches Zeichen setzen: Wir alle haben verstanden. Denn ausnahmslos alle Industrie- und Schwellenländer müssen ihren Beitrag zum Klimaschutz leisten, schließlich sind sie für 80 Prozent der schädlichen Emissionen verantwortlich. Länder, die sich beim Klimaschutz weiterhin heraus- oder zurückhalten wollen, handeln verantwortungslos unfair.

Wenn Sie nun doch den kleinen Schritt weiter gehen und sich fragen: Wenn „Belege“ so unsicher sind, könnte dann für die Theorie des CO2-Klimawandels und dessen Kipppunkttheorie nicht auch eine so große Unsicherheit gelten? Und wäre dann ein vernünftiger Umgang mit Extremwetter und dem sich seit Urzeiten laufend veränderndem Klima nicht weit sinnvoller, als eine teure, Länder ruinierende CO2-Verhinderung, die dazu noch allen Grünpflanzen dieses Planeten ihres lebensnotwendigen Atmosphärendüngers beraubt – haben Sie es geschafft.

Dann würden Sie den Welt-Klimavertrag wahrscheinlich auch neu bewerten, nachdem Sie feststellen können, dass dieser Vertrag außer Zahlungsverpflichtungen vorzubereiten, bezüglich des Fachinhaltes (bewusst) desaströs ungenau formuliert wurdet.

EIKE 04.10.2016: Klimavertrag von Paris im Bundestag erreicht 100 % Zustimmung

Mehr zufällig habe ich in letzter Zeit mehrere, sogenannten Studien der GRÜNEN zu Klima und EEG analysiert [11] und war entsetzt von dem sprichwörtlichen Brett vor deren Köpfen, welches jede rationale Behandlung eines Themas schon im Ansatz verhindert. Siehe dazu auch den Videoclip der GRÜNEN, Bild 10, der Propaganda in Reinkultur darstellt. Dem Lügendetektor fällt dazu nur die Anmerkung ein: „Klar, man muss den Stil des Grünen-Clips nicht mögen“. Dabei ist dieser Clip eine bewusste Desinformation und fällt eindeutig unter die neuen „Maas-Regeln“ – welche aber nur für das gemeine Volk gelten.

Das Gleiche „Brett“ befindet sich auch vor dem Kopf der Professorin, welche die Regierung angeblich berät und stolz darauf ist, einen „Lügendetektor“ zu unterstützen, in dem anonym Aussagen angeprangert werden und wie bei der Inquisition im Mittelalter keine Gegenargumentation möglich ist.

Nehmen Sie die Kritik dieses „Lügendetektors“ also positiv, denn sie zeigt, dass sie eine politische Stimme haben, welche Klimahysterikern- und agitatoren in der Politik und ihren Berater*innen Angst um ihre Pfründe macht. Und seien Sie versichert:

Wenn Sie nun noch ihren Parteivorsitzenden davon überzeugen können, gäbe es in Kürze wohl zwei Parteien im Bundestag, welche diesen CO2-AGW-Wahnsinn nicht mehr bedingungslos glauben und unterstützen. So etwas würde sich Parteiprofil nennen.

Mal sehen, ob der DER KLIMA-LÜGENDETEKTOR entweder eine Gegenargumentation oder eine Entschuldigung bringt, oder einfach seinen „Verriss“ löscht. Warten wir drauf.

Als Abschluss noch die Sammlung der IPCC-Aussagen aus dem Langbericht.

IPCC Aussagen Zusammenfassung

Tropische Stürme und Hurrikane

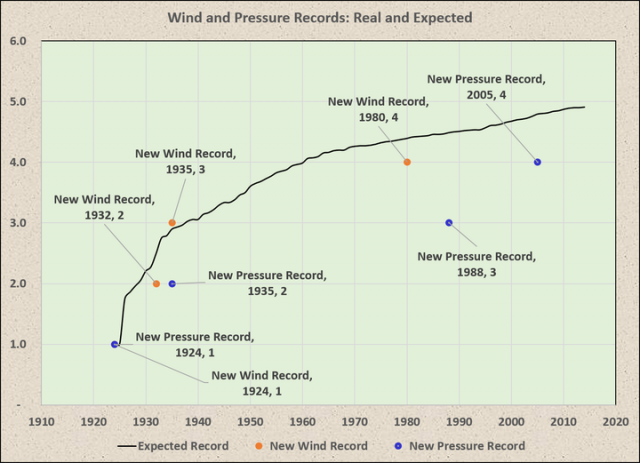

IPCC 2013, AR5, WGI, Kapitel 2, Seite 216: “No robust trends in annual numbers of tropical storms, hurricanes and major hurricanes counts have been identified over the past 100 years in the North Atlantic basin.”

Übersetzung: “Keine robusten Trends bei den jährlichen Zahlen von tropischen Stürmen, Hurrikans und Stark-Hurrikans konnten in den letzten 100 Jahren im Nordatlantischen Becken ausgemacht werden.

Tropische Zyklone

IPCC 2013, AR5, WGI, Kapitel 2, Seite 216: “Current datasets indicate no significant observed trends in global tropical cyclone frequency over the past century and it remains uncertain whether any reported long-term increases in tropical cyclone frequency are robust, after accounting for past changes in observing capabilities.”

Übersetzung: “Aktuelle Datensätze zeigen keine signifikanten beobachteten Trends bei der weltweiten tropischen Wirbelsturmfrequenz während des letzten Jahrhunderts und es ist ungewiss, ob ein berichteter langfristiger Anstieg der tropischen Wirbelsturm-Frequenz robust ist, nach Berücksichtigung der letzten Änderungen in den Beobachtungs-Möglichkeiten.“

Außertropische Zyklonen

IPCC 2013, AR5, WGI, Kapitel 2, Seite 220: “In summary, confidence in large scale changes in the intensity of extreme extratropical cyclones since 1900 is low. There is also low confidence for a clear trend in storminess proxies over the last century due to inconsistencies between studies or lack of long-term data in some parts of the world (particularly in the SH). Likewise, confidence in trends in extreme winds is low, owing to quality and consistency issues with analysed data.”

Übersetzung: “Zusammenfassend ist das Vertrauen in große Änderungen in der Intensität extremer aussertropischer Zyklone seit 1900 gering. Es gibt auch [nur] ein geringes Vertrauen für einen klaren Trend bei Sturm-Proxies wegen Inkonsistenzen zwischen den Studien oder wegen dem Fehlen von Langzeitdaten des letzten Jahrhunderts in einigen Teilen der Welt (vor allem auf der Südhemnisphäre). Ebenso ist das Vertrauen in Trends in extreme Winde niedrig, wegen der Qualität und wegen Konsistenz-Problemen mit den analysierten Daten.“

Dürren

IPCC 2013, AR5, WGI, Technical Summery, Seite 50: ”There is low confidence in a global-scale observed trend in drought or dryness (lack of rainfall), owing to lack of direct observations, dependencies of inferred trends on the index choice and geographical inconsistencies in the trends.”

Übersetzung: “Es besteht ein geringes Vertrauen im globalen Maßstab beobachteten Trend an Dürre oder Trockenheit (Mangel an Niederschlag), aus Mangel an direkten Beobachtungen, Abhängigkeiten von abgeleiteten Trends auf der Indexauswahl und wegen geographischer Unstimmigkeiten in den Trends.“

sowie

IPCC 2013, AR5, WGI, Kapitel 2, Seite 215: “In summary, the current assessment concludes that there is not enough evidence at present to suggest more than low confidence in a global scale observed trend in drought ordryness (lack of rainfall) since the middle of the 20th century, owing to lack of direct observations, geographical inconsistencies in the trends, and dependencies of inferred trends on the index choice. Based on updated studies, AR4 conclusions regarding global increasing trends in drought since the 1970s were probably overstated. However, it is likely that the frequency and intensity of drought has increased in the Mediterranean and West Africa and decreased in central North America and north-west Australia since 1950.”

Überflutungen

IPCC 2013, AR5, WGI, Technical Summery, Seite 112: ”There continues to be a lack of evidence and thus low confidence regarding the sign of trend in the magnitude and/or frequency of floods on a global scale over the instrumental record.”

Übersetzung: “Es besteht weiterhin ein Mangel an Beweisen und deshalb ein geringes Vertrauen in Bezug auf Trend-Anzeichen in Bezug auf Größe und / oder Häufigkeit von Überschwemmungen auf globaler Ebene der Instrumenten-Aufzeichnungen.“

Hagel und Gewitter

IPCC 2013, AR5, WGI, Kapitel 2, Seite 216: “In summary, there is low confidence in observed trends in small-scale severe weather phenomena such as hail and thunderstorms because of historical data inhomogeneities and inadequacies in monitoring systems.”

IPCC Zusammenfassung

IPCC 2013, AR5, WGI, Kapitel 2, Seite 219: “There is limited evidence of changes in extremes associated with other climate variables since the mid-20th century.”

Übersetzung: “Es gibt [nur] begrenzte Anhaltspunkte zu Änderungen bei Extremereignissen, die mit anderen Klimavariablen seit der Mitte des 20. Jahrhunderts verbunden sind.“

Anlage

Definition der Wahrscheinlichkeiten in den IPCC-Berichten.

IPCC Klimaänderung 2014 Synthesebericht:

Das Vertrauensniveau wird unter Verwendung von fünf Stufen – sehr gering, gering, mittel, hoch und sehr hoch – und kursiv gedruckt dargestellt, z.B. mittleres Vertrauen: (die Aussage ist in etwa 5 von 10 Fällen richtig [13]).

Die folgenden Begriffe wurden verwendet, um die mit einem Ergebnis oder einer Aussage verbundene Wahrscheinlichkeit zu beschreiben: praktisch sicher 99–100 % Wahrscheinlichkeit,

sehr wahrscheinlich 90–100 %,

wahrscheinlich 66–100 %,

Quellen

[1] EIKE 11.10.2016: C. Kemfert, Professorin und Politik-Beraterin für Umwelt und Energie, bekommt Ehrenpreise für Agitation

KLIMARETTER.INFO, 1. September 2017: Klimaschutz ist kein Unrecht

[2] KLIMARETTER.INFO, 4. September 2017: FDP Fake-News zu Unwetter

[3] DER KLIMA-LÜGENDETEKTOR 4. September 2017: Nicola Beer (FDP): „Fake News“ zu Extremwetter

[4] EIKE, 1. September 2017: Rundbrief der GWPF vom 28. August 2017

[5] EIKE 21. August 2017: POLITISCHE BILANZ: Nicht „ob“, sondern „wie schnell“

[6] EIKE 22.08.2017: Verschiebt der Klimawandel Europas Hochwässer dramatisch

[7] Kelly MJ (2016) Trends in Extreme Weather Events since 1900 – An Enduring Conundrum for Wise Policy Advice. J Geogr Nat Disast 6:155. doi:10.4172/2167-0587.1000155

[8] EIKE 12.08.2017: Die Starkregen vom Juli 2017 in Deutschland sind (keine) Menetekel eines Klimawandels

[9] EIKE 18.06.2016: Die Niederschlagsentwicklung in Deutschland und weltweit zeigt keinen Klimawandel-Einfluss

[10] Jascha Lehmann, Dim Coumou, Katja Frieler: Increased record-breaking precipitation events under global warming

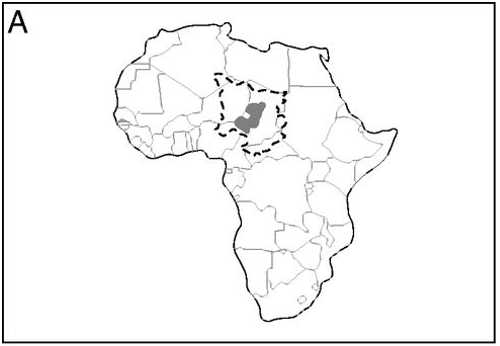

[11] EIKE: Immer wieder muss der Tschad-See unter dem Klimawandel leiden, oder: Warum steht in Studien der GRÜNEN immer so viel Falsches drin?

EIKE: Die GRÜNEN: Es mangelt weder an erneuerbaren Energien noch an der Entwicklung von Speichern und Netzen

EIKE: Welcher EEG-Ausbau wird benötigt, wenn man – wie es die GRÜNEN fordern – alle Energie aus EEG-Erzeugern generiert

EIKE 26.08.2017: Holen sich die GRÜNEN ihre „Kernkompetenz“ zum Klimawandel von der Bundesregierung?

EIKE 15.08.2017: Cem Özdemir versucht sich in Energie

EIKE 01.07.2017: K. G. Eckardt versucht sich auf dem GRÜNEN Parteitag mit „Klimawandel“ und zeigt dabei:…

– zur „Klimastudie“ von Bündnis 90/Die Grünen

EIKE 22.08.2015: Grüne Abgeordnete Barbara Höhn durch Fakten widerlegt: Der Hopfenertrag steigt trotz Klimawandel

[12] Donna Laframboise: Von einem Jugendstraftäter, der mit dem besten Klimaexperten der Welt verwechselt wurde Ein IPCC-Exposé (deutsche Übersetzung)

[13] Umweltbundesamt: Weltklimarat (IPCC)

[14] BMUB: Der Weltklimarat IPCC

[15] EIKE 07.02.2016: Der Himmel fällt uns auf den Kopf und ohne die Glaskugel im Computer würden wir es nie erfahren

[16] Umweltbundesamt: CLIMATE CHANGE 24/2015 Vulnerabilität Deutschlands gegenüber dem Klimawandel

[17] EIKE 29.10.2015: Kann man den Klimawandel in Deutschland wirklich täglich spüren? Eine Suche mit überraschendem Ergebnis