Dies führt dazu, dass die natürliche Klimazyklus-Variabilität als ängstigend und emotional erdrückend wahrgenommen wird. Die Fähigkeit zu kritischem Denken ist schwer beeinträchtigt. Die von der Öko-Linken-Aktivisten-Elite bewohnte Welt der Täuschung wird verkörpert durch die wissenschaftsbasierte Fiktion von Naomi Oreskes bei Harvard: „Der Kollaps der westlichen Zivilisation: Eine Sicht aus der Zukunft“.

Oreskes und Conway stellen sich eine vom Klimawandel zerstörte Welt vor. Intellektuelle Hybris, Voreingenommenheit, Eigeninteresse und die Notwendigkeit, sich sofort mächtig und gleichzeitig moralisch rechtschaffen zu finden, brachte all jene der am schlimmsten Betroffenen, also Politiker, Regierungen, die politisch sich korrekt äußernden Klassen und fast sämtliche Medien in den USA und UK dazu, davon überzeugt zu sein, dass anthropogenes CO2 der Haupt-Klimatreiber ist. Dies ließ Regierungen Maßnahmen ergreifen, durch welche Billionen Dollar verschwendet worden sind in dem weltfremden und vergeblichen Versuch, die Temperatur der Erde mittels Reduktion von CO2-Emissionen zu kontrollieren.

Die Ursprünge dieser Krankheit können auf das Buch von Paul Ehrlich aus dem Jahr 1968 zurückgeführt werden mit dem Titel „The Population Bomb“. Dort schrieb er:

„Während der siebziger Jahre werden Millionen Menschen verhungern, ungeachtet jedweder sofort eingeführter Notfallprogramme. Zu diesem späten Zeitpunkt kann nichts mehr eine substantielle Zunahme der Todesrate in der Welt verhindern“.

Derartige apokalyptische Prophezeiungen sind ein primärer Indikator des CO2 Derangement Syndrome. Dem „Die Grenzen des Wachstums“ betitelten Buch aus dem Jahr 1972 zufolge äußerte sich die Krankheit zunächst in Gestalt einer Suche nach „Nachhaltigkeit“ und wandelte sich dann rasch zu einem Krieg gegen CO2 um. Dies ist eine sehr bizarre Wendung, ist doch CO2 die Grundlage allen organischen Lebens, und die CO2-Zunahme allein ist Ursache einer Zunahme der Welt-Nahrungsmittel-Produktion im 20. Jahrhundert um 25%.

Die UN und Schweden organisierten im Jahre 1972 ein Treffen in Stockholm, um über Wechselwirkungen zwischen Mensch und Umwelt zu diskutieren. Maurice Strong wurde von seinem Freund bei den UN U Thant zum Generalsekretär der Tagung ernannt. Strong entwarf einen unglaublich detaillierten 109-Punkte-Plan, um den UN die Macht zu geben, weltweit Einfluss auf die Umweltpolitik individueller Regierungen auszuüben und diese sogar zu kontrollieren. Als Grundlage dieses Programms wurde im Jahre 1973 das United Nations Environmental Program (UNEP) ins Leben gerufen mit Strong selbst als geschäftsführendem Direktor.

Zehn Jahre später wurde offensichtlich, dass die Prophezeiungen sofortiger Todesfälle und Katastrophen falsch waren. Aber Hansen et al. bei der NASA ließen im Jahre 1981 viele dieser Untergangs-Prophezeiungen wieder auferstehen, und zwar in einem Traktat mit dem Titel „Climate Impact of Increasing Carbon Dioxide”:

„Ein Anstieg des Meeresspiegels um 5 Meter würde 25% der Landfläche von Florida und Louisiana überfluten, 10% von New Jersey sowie viele andere Tieflandgebiete auf der ganzen Welt. Klimamodelle zeigen, dass eine Erwärmung um 2°C nötig ist, um auf dem Westantarktischen Eisschild eine Erwärmung um 5°C zu verursachen. Eine globale Erwärmung von 2°C wird in allen von uns untersuchten CO2-Szenarien im 21. Jahrhundert überschritten außer unter der Annahme des Auslaufens von Kohle und Null-Wachstum.

Die für das nächste [21.] Jahrhundert projizierte globale Erwärmung ist von fast beispielloser Größenordnung. Auf der Grundlage unserer Modellrechnungen schätzen wir, dass sie 2,5°C betragen wird in einem Szenario mit geringem Energie-Zuwachs und einer Mischung aus fossilen und nicht fossilen Treibstoffen. Dies würde noch über die Temperatur der Minoischen Warmzeit (vor 3500 Jahren) und des Eemian vor 125.000 Jahren hinausgehen und würde sich der Temperatur während des Zeitalters der Dinosaurier annähern. … Die Kohle zu Kraftwerken transportierenden Züge sind Todeszüge. Kohlekraftwerke sind Fabriken des Todes.

…falls wir alle fossilen Treibstoffe verbrennen, werden wir den Planeten, so wie wir ihn kennen, zerstören. Der Kohlendioxid-Gehalt würde auf 500 ppm und mehr steigen. Wir würden den Planeten auf den Weg in einen eisfreien Zustand bringen, wobei der Meeresspiegel 75 Meter höher liegt“.

Für politische und eigensüchtige Ziele wollen die UNEP-Bürokraten die Kontrolle über die globale Ökonomie übernehmen. Sie erkannten, dass die UN (und sie selbst) die Kontrolle über die Ökonomie der Welt übernehmen könnten via Kontrolle über die Art der verwendeten Energie und deren Preis, falls sie Hansens Prophezeiungen dazu heranziehen könnten zu zeigen, dass das durch Verbrennung von Kohle und Öl erzeugte CO2 zur Stromerzeugung und zum Auto fahren Regierungen und Menschen derart verängstigt, dass diese die entsprechenden Gesetze auf den Weg bringen.

Um dies in die Wege zu leiten, organisierte das UNEP im Jahre 1985 eine Tagung von Wissenschaftlern in Villach in Österreich um auszuloten, ob es möglich war aufzuzeigen, dass CO2 gefährlich ist. In dem wissenschaftlichen Report liest man:

„Obwohl die beobachtete globale Erwärmung während der letzten ~100 Jahre kompatibel ist mit Modellschätzungen der Größenordnung des Treibhauseffektes, ist eine eindeutige, statistisch überzeugende Erkennung der Auswirkung einer Änderung des CO2-Gehaltes und anderer Spurengase auf das Klima noch nicht möglich. Ein bedeutendes Problem der positiven Identifikation des Treibhausgas-Effektes auf das Klima besteht darin, die mittel- und langzeitlichen (d. h. über Jahrzehnte oder mehr) Fluktuationen in den Aufzeichnungen der Vergangenheit zu erklären. Versuche, derartige Änderungen zu modellieren, leiden bis heute unter einer ganzen Reihe von Schwächen.

In der offiziellen Verlautbarung dazu steht jedoch etwas ganz anderes:

„Als Folge der zunehmenden Konzentration von Treibhausgasen glaubt man jetzt, dass ein Anstieg der globalen mittleren Temperatur während der ersten Hälfte des nächsten Jahrhunderts stärker ausfallen könnte denn je in der Historie der Menschheit“.

Der Villach-Report gab zwei bedeutende Empfehlungen. Als eine davon wurde das IPCC ins Leben gerufen, welches die passenden Beweise heraussuchen und von Zeit zu Zeit Berichte erstellen sollte, in welchen gezeigt werden würde, dass CO2 der Haupttreiber eines gefährlichen Klimawandels war. Eine zweite Empfehlung führte zu einer Tagung in Rio im Jahre 1992 unter Vorsitz von Maurice Strong selbst, der das United Nations Framework Convention on Climate Change (UNFCCC) erstellte, welches nachfolgend von 196 Regierungen unterzeichnet worden ist.

Das Ziel der Convention ist es, die CO2-Konzentrationen in der Atmosphäre auf einem Niveau zu halten, welches ihrer Ansicht nach verhindern kann, dass der Mensch auf gefährliche Weise das Klimasystem beeinflusst.

Dieser Vertrag ist ein umfassender, politisch getriebener politischer Aktionsplan namens Agenda 21 – darauf ausgelegt, eine zentral gesteuerte globale Gesellschaft zu schaffen, welche jeden Aspekt des Lebens eines jeden Einzelnen auf der Erde kontrollieren würde.

Es heißt darin:

„Die Teilnehmer sollten vorsorglich Maßnahmen ergreifen, um den Ursachen des Klimawandels zu begegnen, diese zu verhindern oder zu minimieren sowie dessen negative Auswirkungen abzuschwächen. Wo die Gefahr ernster oder irreparabler Schäden besteht, sollte das Fehlen voller wissenschaftlicher Gewissheit nicht als Grund herangezogen werden, derartige Maßnahmen zu verschieben“.

Apokalyptische Prophezeiungen werden herangezogen als Haupttreiber für Maßnahmen und für enorme Investitionen wie in jene des neuen IPCC SR1.5-Reports und in die Arbeit von William Nordhaus, welcher sich für eine Kohlenstoff-Steuer einsetzt. Die NYT zitiert Nordhaus mit den Worten:

„Falls wir während der nächsten 20 Jahre sehr schnell vorgehen, könnten wir in der Lage sein, diese 2 Grad zu vermeiden, aber wenn wir das nicht tun, stehen uns Änderungen im System Erde bevor, die in aller Tiefe zu verstehen wir nicht beginnen können. Eine Erwärmung um 4, 5, 6 Grad wird Änderungen nach sich ziehen, die wir nicht verstehen können, weil sie außerhalb jeder menschlichen Erfahrung liegen während der letzten 100.000 bis 200.000 Jahre“.

Nordhaus‘ wissenschaftliche und ökonomische Grundlage wird diskutiert in „Projections and Uncertainties about Climate Change in an Era of Minimal Climate Policies” (hier), worin zu lesen ist:

„Die Klima-Komponenten wurden durchforstet, um jüngste Modelle des Systems Erde zu reflektieren. Die Gleichgewichts-Klimasensitivität (ECS) beruht auf der Analyse von Olsen et al. (2012). Grundlage für dieses Verfahren ist die Arbeit von Gillingham et al. (2018). Die finale Schätzung ist eine mittlere Erwärmung um 3,1°C bei einer CO2-Verdoppelung. Die kurzzeitige Klimasensitivität oder TCS wird adjustiert, damit sie zu den Modellen mit einem ECS von 3,1°C passt, was eine TCS von 1,7°C erzeugt“.

Im IPCC SR1.5 heißt es:

„C2: Die globale Erwärmung auf 1,5°C zu begrenzen ohne oder mit nur einem geringfügigen Überschreiten würde rasche und weit reichende Transitionen bzgl. Energie, Landfläche, Städte und Infrastruktur erfordern (einschließlich Transportwesen und Gebäude) sowie industrielle Systeme (hohes Vertrauen). Diese System-Transitionen sind beispiellos hinsichtlich der Größenordnung, aber nicht notwendigerweise hinsichtlich der Geschwindigkeit; und sie implizieren drastische Emissions-Reduktionen in allen Bereichen, ein breites Portfolio von Abschwächungs-Optionen und eine signifikante Aufwertung von Investitionen in jene Optionen (mittleres Vertrauen).

…

C2.6: [Zusammengefasst vom Übersetzer] Eine Begrenzung der Erwärmung auf 1,5°C bis zum Jahr 2050 würde Investitionen zwischen 180 bis 1800 Milliarden Dollar erfordern, nach anderen Modellen bis zu 3800 Milliarden Dollar. …

Diejenigen, welche das Erwärmungs-Szenario missionieren, folgen eng den Vorgaben des politischen Maßnahmen-Plans Agenda 21 des UNFCCC. Bernie Sanders sagt dazu:

„Der Klimawandel ist die größte Bedrohung, vor der unser Planet steht. Die Debatte ist vorüber, und die wissenschaftliche Beurteilung steht: globaler Klimawandel ist real, wird hauptsächlich verursacht durch Emissionen aus der Verbrennung fossiler Treibstoffe und stellt eine katastrophale Bedrohung dar für das langfristige Überleben unseres Planeten. Falls wir nichts tun, wird sich der Planet bis zum Ende dieses Jahrhunderts um 2,5°C aufheizen. Dies würde ausreichen, um den Meeresspiegel infolge schmelzender Gletscher so stark steigen zu lassen, dass Städte wie New York oder Miami unter Wasser stehen werden – begleitet von häufigeren Asthma-Anfällen, höheren Preisen für Nahrungsmittel, unzureichender Versorgung mit Trinkwasser und mehr Infektionskrankheiten“.

Die Abgeordnete der Demokraten Alexandria Ocasio-Cortez schlug vor, den Reichen eine Steuer bis zu 70% aufzuerlegen, um einen Klimawandel-Plan zu finanzieren, den sie den „New Green Deal“ nennt. Sie sagt außerdem, dass die Welt in 12 Jahren aufhören wird zu existieren, falls wir dem Klimawandel nicht begegnen“ (hier).

Glücklicherweise beginnt aber schließlich die Realität in das Memo der gefährlichen globalen Erwärmung einzudringen. Judith Curry schreibt in ihrem Beitrag 2017 mit dem Titel [übersetzt] „Klimamodelle für Laien“:

„GCMs sind nicht geeignet, die Ursachen für die Erwärmung während des 20. Jahrhunderts zu ergründen oder globale oder regionale Klimaänderungen in Zeitmaßstäben von Jahrzehnten und Jahrhunderten mit irgendeinem Vertrauensniveau abzubilden. Dies bedeutet, dass GCMs nicht geeignet sind, um politische Maßnahmen auszulösen oder zu rechtfertigen, welche die Sozial-, Wirtschafts- und Energiesysteme der Erde fundamental verändern würden …“

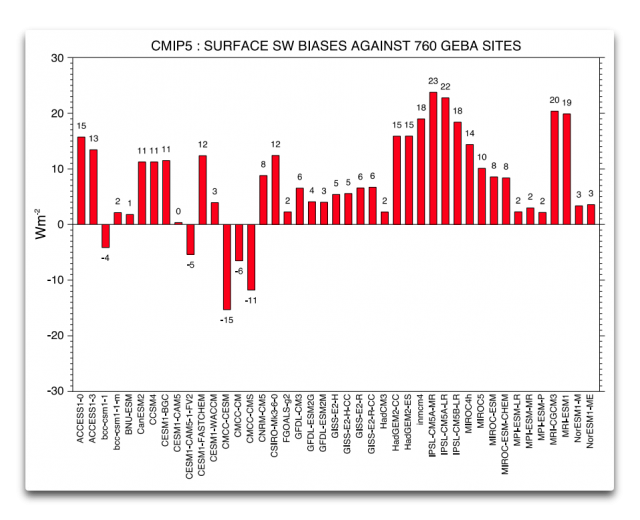

Scafetta et al. (2017) schreiben:

„Die erhebliche Diskrepanz zwischen Beobachtungen und modellierten Prophezeiungen … bestätigt einmal mehr …, dass die derzeitigen Klimamodelle den anthropogenen Treibhaus-Erwärmungseffekt erheblich übertrieben haben“.

Hansen et al. (2018) schreiben in ihrem Beitrag „Global Temperature in 2017“:

„Allerdings ist die solare Variabilität im Vergleich mit dem Energie-Gleichgewicht nicht vernachlässigbar, wenn es um die globale Temperaturänderung geht. Wegen der Kombination des starken El Nino 2016 und der Phase des Sonnenzyklus‘ ist es möglich, wenn nicht wahrscheinlich, dass die nächsten 10 Jahre der Temperaturänderung den Eindruck eines Stillstands hinterlassen“.

Page (2017) sagte in seiner Studie „The coming cooling: usefully accurate climate forecasting for policy makers“:

„Diese Studie zeigt auf, dass die von der etablierten Klimawissenschaft angewendeten Verfahren nicht geeignet sind, um darauf Vorhersagen zu erstellen, und dass ein neues Vorhersage-Paradigma übernommen werden sollte“.

Die Realität ist, dass das Klima der Erde die Folge von Resonanz und Überlagerung ist zwischen verschiedenen quasi-zyklischen Prozessen verschiedener Wellenlängen.

Die Zukunft vorherzusagen ist unmöglich, solange wir nicht verstehen, wo sich die Erde derzeit befindet relativ zu den gegenwärtigen Phasen dieser unterschiedlichen, in Wechselwirkung stehenden Quasi-Periodizitäten, welche sich in zwei Hauptkategorien gliedern:

● Die orbitalen langwelligen Milankovitch-Zyklen bzgl. Exzentrizität, Schiefe und Präzession.

● Zyklen der Sonnen-„Aktivität“ mit möglichen Zeitmaßstäben von Jahrzehnten bis Jahrzehntausenden.

Wenn man komplexe Systeme mit zahlreichen, miteinander in Wechselwirkungen stehenden Variablen analysiert, ist es nützlich, dem Rat von Enrico Fermi zu folgen, welcher dem Vernehmen nach gesagt hat: „Man mache niemals etwas genauer als absolut nötig“. Die Studie aus dem Jahr 2017 stellte der Klimawissenschaft ein einfaches heuristisches Konzept vor, welches plausibel klärt, dass ein Millenial Turning Point [etwa ein Milleniums-Wendepunkt] und ein Maximum der Sonnenaktivität im Jahre 1991 aufgetreten waren und dass dieser Wendepunkt mit einem Temperatur-Wendepunkt korreliert während der Jahre 2003/4, und dass jetzt ein allgemeiner Abkühlungstrend folgt bis etwa zum Jahr 2650 [?].

Das Memo einer gefährlichen globalen Erwärmung seitens des Establishments, die damit verbundene Reihe von IPCC-Berichten, der gesamte UNFCCC-Zirkus, die jüngsten hysterischen Vorschläge im IPCC SR1.5 und der jüngste Nobelpreis von Nordhaus beruhen auf zwei grundlegenden Fehlern der wissenschaftlichen Beurteilung. Erstens – der Umfang der Stichprobe ist zu gering. Die meisten IPCC-Modellstudien ziehen Rückschlüsse von der Gegenwart nur etwa 100 bis 150 Jahre zurück, obwohl doch die wichtigsten Klimafaktoren, die größte Amplitude der Sonnenaktivitäts-Zyklen im Zeitmaßstab von Jahrtausenden ablaufen.

Dies bedeutet, dass alle Temperatur-Simulationen von Klimamodellen zu warm ausfallen und wahrscheinlich außerhalb der realen zukünftigen Welt liegen. Zweitens, die Modelle machen den fundamentalen wissenschaftlichen Fehler einer direkten Vorhersage über den Milleniums-Wendepunkt und den Höhepunkt der Sonnenaktivität im Jahre 1991 hinaus. Diese Fehler werden verschlimmert durch verzerrte Darstellungen und einen akademischen Gruppendenken-Konsens.

Dr. Norman Page holds a PhD. in Geology and works from Houston, TX.

References:

See the Energy and Environment paper The coming cooling: usefully accurate climate forecasting for policy makers. http://journals.sagepub.com/doi/full/10.1177/0958305X16686488

And an earlier accessible blog version at http://climatesense-norpag.blogspot.com/2017/02/the-coming-cooling-usefully-accurate_17.html

See also https://climatesense-norpag.blogspot.com/2018/10/the-millennial-turning-point-solar.html

and the discussion with Professor William Happer at http://climatesense-norpag.blogspot.com/2018/02/exchange-with-professor-happer-princeton.html

striche

Link: https://wattsupwiththat.com/2019/01/23/the-co2-derangement-syndrome-a-historical-overview/

Übersetzt von Chris Frey EIKE