Und wir nehmen uns die Behauptung vor, dass der vom Menschen verursachte Klimawandel einen starken Zufluss von Süßwasser aus den schmelzenden Gletschern in Grönland in Gang setzen wird. Dies soll zum Zusammenbruch der thermohalinen Zirkulation und/oder des Golfstromes im Nordatlantik führen. Das wiederum soll eine starke Abkühlung mit sich bringen ähnlich der wie vor 818 bis 8340 Jahren, als ein Eisdamm in Kanada brach und gewaltige Mengen Süßwasser in den Atlantik strömten.

Globale Erwärmung führt zu einem „großen Aussterben“

Unabhängig von den potentiellen finanziellen Kosten der globalen Erwärmung behaupten Einige, dass die moderate Erwärmung seit Mitte des 19. Jahrhunderts um 0,8°C immer mehr Spezies aussterben lässt. Anderen zufolge soll dies durch den Bevölkerungszuwachs verursacht werden. Tatsächlich hat sich National Geographic zu der Behauptung verstiegen, dass wir uns inmitten des „sechsten großen Aussterbe-Ereignisses der Erdgeschichte“ befinden. Nadia Drake proklamiert, dass die gegenwärtige Aussterberate 100 mal größer sein könnte als die normale Rate. Dies ist auch Gegenstand eines Buches mit dem Titel The Sixth Extinction von Elizabeth Kolbert. Falls das stimmen sollte, wären dies beachtliche Kosten entweder der globalen Erwärmung oder des Bevölkerungszuwachses.

Experten hinsichtlich der fünf derartigen Ereignisse in der Vergangenheit stehen nicht hinter diesem Gedanken. Der Paläontologe am Smithonian Doug Erwin, Experte hinsichtlich der Aussterbewelle im Perm, bei welcher durchaus etwa 90% aller damals lebenden Spezies ausgestorben sein können, sagt, dass all jene, die uns in einer ähnlichen Lage befindlich behaupten, einfach nicht wissen, was Massenaussterben eigentlich ist (hier). Erwin weist darauf hin, dass während der jüngeren menschlichen Historie zwischen 0 und 1% aller Spezies ausgestorben sind. Man beachte, was er The Atlantic in einem Interview gesagt hat:

Man kann also fragen „nun gut, wie viele geographisch weit verbreitete und reichlich vorhandene Meeres-Lebewesen [durably skeletonized marine taxa] sind bisher ausgestorben?“ Die Antwort lautet: „Die Zahl liegt nahe Null!“. Tatsächlich sind in den am besten überwachten Tierarten heutiger Tiere – Steinkorallen, Amphibien, Vögel und Säugetiere – irgendwo zwischen 0 und 1% aller Spezies ausgestorben. Zum Vergleich, das Massenaussterben zum Ende des Perm raffte über 90% aller Spezies auf der Erde dahin.

einer Spezies pro Jahr liegt. Das ist keine alarmierende Rate und sehr weit entfernt von einem „Massenaussterben“.

In der dänischen Presse habe ich darauf hingewiesen, dass wir schon lange mit viel zu hohen Zahlen bzgl. des Aussterbens von Spezies auf der Erde konfrontiert werden – dass wir etwa die Hälfte aller Spezies innerhalb einer Generation verlieren werden. Die richtigere Zahl liegt näher an 0,7% innerhalb von 50 Jahren. Dies führte zum Greenpeace-Chef von Dänemark Niels Bredsdorff, der darauf verwies, dass Greenpeace lange Zeit die Zahl 0,7% akzeptiert habe. – Lomborg, Bjørn. The Skeptical Environmentalist: Measuring the Real State of the World (p. 17).

Spezies sterben immer aus. Die meisten Spezies, die jemals auf der Erde gelebt haben, sind ausgestorben. Die mittlere Rate für Tiere und Pflanzen liegt etwa bei 1 pro Jahr (obwohl in einigen jüngeren wissenschaftlichen Studien von einer viel höheren mittleren Rate die Rede war, nämlich bis zu 6 pro Jahr). Die Aussterbe-Anzahl variierte mit der Zeit. Darunter waren 5 „Mega-Aussterbe“-Ereignisse seit der Bildung mehrzelliger Lebensformen vor etwa 550 Millionen Jahren. Während jedes einzelnen dieser Ereignisse scheint die Mehrheit der Spezies (nach geologischem Zeitmaßstab) innerhalb kurzer Zeit verschwunden zu sein. Zum stärksten derartigen Ereignis war es vor etwa 250 Millionen Jahren im Perm-Trias gekommen, als schätzungsweise 80% bis 90% aller damals lebenden Spezies ausstarben. – Botkin, Daniel B. 25 Myths That Are Destroying the Environment: What Many Environmentalists Believe and Why They Are Wrong (Kindle Locations 645-650).

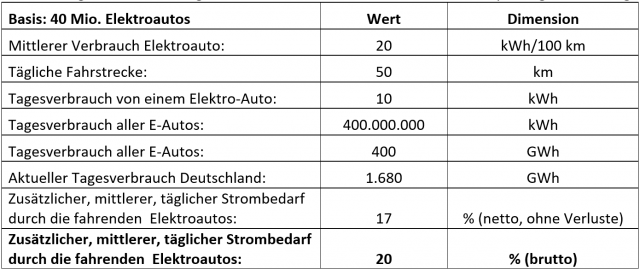

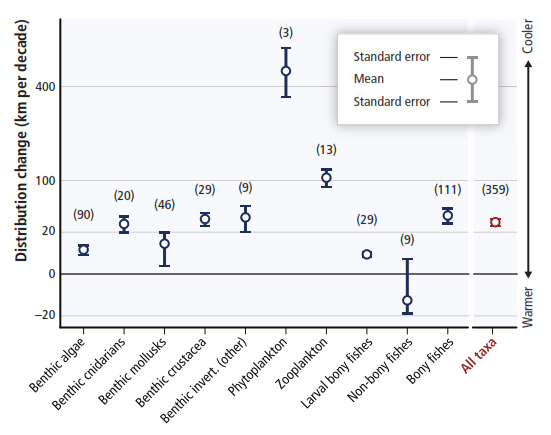

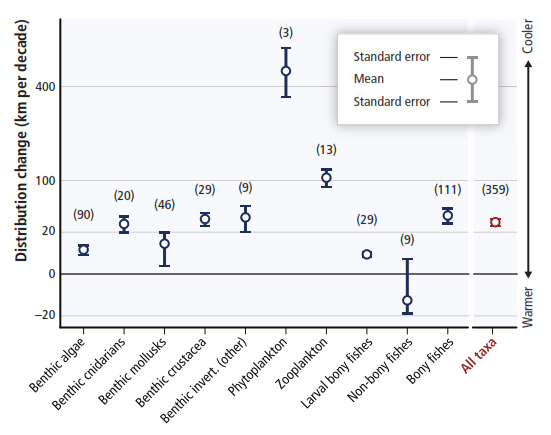

Im IPCC-Bericht AR 5 (WG II) werden Lomborg und Botkin ein wenig verschwurbelt unterstützt. Auf Seite 43 der Technical Summary findet sich die folgende Graphik:

Abbildung 1: Raten der Änderungen der Verteilung verschiedener maritimer Lebensformen von 1900 bis 2000 (km pro Jahrzehnt). Positive Änderung bedeutet, dass sich diese Lebensformen ausgebreitet und allgemein in Richtung der Pole bewegt haben.

Das „große“ quaternäre Megafauna-Aussterben

Von Barnosky, 2008 gibt es eine Studie zum quaternären Megafauna-Aussterben (QME). Die Studie wird so eingeleitet:

Die jüngste Aussterbe-Episode, das Quaternäre Megafauna-Aussterben, raffte zwei Drittel aller Säugetierarten und die Hälfte aller Spezies mit einem Gewicht über 44 kg dahin, und zwar von vor 50.000 bis 3000 Jahren.

Nachdem er seine Stichprobe auf clevere Weise reduziert hatte, um zu der Angabe zwei Drittel zu kommen, proklamiert er:

Das „große“ QME-Ereignis soll also etwa 178 Spezies der weltgrößten Säugetiere dahingerafft haben, nämlich all jene mit einem Gewicht über 44 kg (in etwa die Größe von Schafen bis zu Elefanten). Mora 2011 zufolge gibt es heutzutage 1,2 Millionen katalogisierte Spezies, und die Gesamtzahl könnte 8,7 Millionen lebende Spezies umfassen. Während also das Aussterben von 178 Spezies vor ~50.000 Jahren infolge eines rapiden Klimawandels bedauernswert ist, weil die Geschöpfe so interessant waren, war es geologisch kein signifikantes Ereignis. Es ist nicht einmal ansatzweise vergleichbar mit den fünf großen Aussterbe-Ereignissen. Ein „großes Aussterben“ wird vom American Museum of Natural History als ein Ereignis definiert, bei dem über die Hälfte aller Spezies innerhalb kurzer Zeit ausstirbt. Auf der Website des Museums liest man dazu:

Vor rund 65 Millionen Jahren, … vielfach in früheren Felsformationen vorhandene Fossilien sind in späteren Formationen einfach nicht mehr da. Eine Vielzahl von Tieren und Pflanzen starb plötzlich aus, von kleinen Meeres-Lebewesen bis zu großen Dinosauriern.

Spezies sterben zu jeder Zeit aus. Wissenschaftler schätzen, dass 99,9% aller Spezies, Tiere und Pflanzen, die je gelebt haben, inzwischen ausgestorben sind. Daher wäre das Verschwinden von Dinosauriern wie T. Rex und Triceratops vor rund 65 Millionen Jahren kein Aufhebens wert – außer bzgl. der Tatsache, dass mit ihnen rund 50% aller damals lebenden Tiere und Pflanzen ausgestorben sind. Wissenschaftler sprechen hierbei von einem Massen-Aussterben.

Also ist das quaternäre Megafauna-Aussterben um etwa drei Größenordnungen zu klein, um als „Großes Aussterben“ bezeichnet werden zu können, wie es Barnosky getan hat.

Daniel Botkin, siehe oben). Offensichtlich ist das Aussterben der Säbelzahntiger, von Riesenwölfen [dire wolves], Mammuts und anderer Megafauna in der geologischen Historie kein außerordentliches Ereignis. Aber diese Tiere sind ihrer Größe wegen faszinierend, und wir messen ihnen viel mehr Gewicht zu als einer ausgestorbenen Kröte oder einem Insekt. Dies ist jedoch eine Werte-Beurteilung und kein geologisches Ereignis.

Barnosky verweist darauf, dass Menschen zur großen Gattung der Säugetiere gehören, doch haben sie trotzdem überlebt und sind gediehen. Sie behaupten außerdem, dass die Zunahme der menschlichen Biomasse weitgehend den Verlust großer Mengen nichtmenschlicher Biomasse bis vor 12.000 Jahren ausgleicht. Dann kam es zum Zusammenbruch von Megafauna-Biomasse, sind doch viele Megafauna-Spezies ausgestorben. Das klingt mir sehr nach „survivor guilt”. Vor 12.000 Jahren begann in etwa die menschliche Zivilisation. In China wurde bereits Reis kultiviert, in der Levante (heute das Gebiet der Staaten Israel und Syrien) gab es Ackerbau. Der Bau der großen Steinmonumente bei Gobekli Tepe in der heutigen Türkei begann ebenfalls um diese Zeit. Die Menschen begannen sesshaft zu werden und Landwirtschaft zu betreiben. Die Menschen haben sich ziemlich gut an die Bedingungen während des Younger Dryas und danach angepasst, was anderen Megafauna-Spezies nicht gelungen ist.

Vor 12.000 Jahren stand das Ende des Younger Dryas kurz bevor. Dies war eine 1000 Jahre lange Rückkehr zu Eiszeit-Bedingungen nach einer kurzem Warmphase von vor 15.200 bis 13.000 Jahren. Diese Zeiträume sind in Abbildung 2 dargestellt. Die Graphik zeigt den Temperaturverlauf, wie er sich aus dem Grönland-Eisbohrkern GISP2 ergab, untersucht von Alley 2004.

Zumindest in Grönland, aber vermutlich auch auf der ganzen Nordhemisphäre war es vor 12.000 Jahren sehr kalt. Eine Detailliertere zeitliche Aufschlüsselung gibt es hier. Abbildung 3 zeigt eine globale Rekonstruktion, hauptsächlich aufgrund maritimer Temperatur-Proxys, welche ziemlich genau das Gleiche zeigen, obwohl diese Reihe nur bis vor 12.000 Jahren zurück reicht:

Nachdem es vor 12.000 Jahren sehr kalt gewesen war, kam es danach zu einer rapiden weltweiten Erwärmung, besonders auf der Nordhemisphäre. Dies setzte viele Spezies unter Stress, zweifellos sind einige Spezies auch ausgestorben. Aber die Spezies, von denen wir besonders Notiz nehmen, sind die größeren Tiere. Einigen Schätzungen zufolge ist die Temperatur auf der Nordhemisphäre um 5°C bis 10°C innerhalb weniger Jahrzehnte gestiegen (Severinghaus et al., 1998). Diese extrem rasche Erwärmung dürfte auch auf viele andere Spezies Auswirkungen gehabt haben. Heutzutage gibt es einige Leute, die sich bzgl. eines Temperaturanstiegs um 0,8°C innerhalb von 137 Jahren Sorgen machen – aber man stelle sich eine Erwärmung von 5°C seit 1990 vor! Genau das hat auf der Erde am Ende des Youger Dryas stattgefunden.

Vor 12.000 Jahren hatte sich die Menschheit bereits in Afrika, Eurasien und den beiden Amerikas ausgebreitet. Der Aufstieg der Zivilisation und die Entwicklung neuer Jagdverfahren (Pfeil und Bogen, Speere und Speerwerfer – alles bereits vor mehr als 30.000 Jahren erfunden), machte die Jäger des Jungpaläolithikum sehr gefürchtet. Wir wissen, dass die Menschen zu jener Zeit auf die Jagd nach Megafauna-Spezies gegangen waren, und auch in Gegenden präsent waren, in denen die Megafauna ausstarb. In Australien verschwand die Megafauna innerhalb nur weniger tausend Jahre nach der Besiedelung des Kontinents durch Menschen und während einer Zeit mit stabilem Klima. Aber anderswo, wie in Eurasien, kam es zu Aussterbe-Ereignissen während Zeiten einer dramatischen Klimaänderung. Wahrscheinlich spielten sowohl die Jagd der Menschen jener Zeit als auch Klimawandel zusammen eine Rolle beim Aussterben der Megafauna. Eine Zusammenfassung der geologischen Beweise für beide Theorien gibt es aus dem Jahr 2014 hier sowie bei Barnosky 2008. Außerdem scheint klar zu sein, dass von der heute noch existierenden Megafauna vor 12.000 Jahren der Mensch am ehesten in der Lage war, sich an eine sich ändernde Welt anzupassen. Bis zu einem erheblichen Ausmaß haben die Menschen ihre Mit-Konkurrenten einfach überflügelt – Evolution im Vormarsch.

Barnosky erwähnt, dass heute einige Megafauna-Spezies heute vor dem Aussterben stehen. Viele dieser Spezies haben nur in Afrika überlebt. Das ist keine Überraschung. Afrika liegt beiderseits des Äquators und ist weniger verwundbar durch starken Klimawandel. Wegen ihrer Größe benötigt die Megafauna große Landgebiete, um in der Wildnis zu überleben. Sie werden in Nationalparks, auf privaten Ländereien und in Zoos geschützt. Aber mit dem Aufblühen der Menschheit ist der Mensch mehr am Erhalt dieser Spezies interessiert, und deren Aussterben ist unwahrscheinlich. Die Menschen des Jungpaläolithikums waren lediglich daran interessiert zu überleben. Die heutigen Menschen leben im Überfluss und sicher, und sie wenden Energie und andere Ressourcen auf, um das Überleben von Megafauna sicherzustellen – und nicht, um diese zu bedrohen.

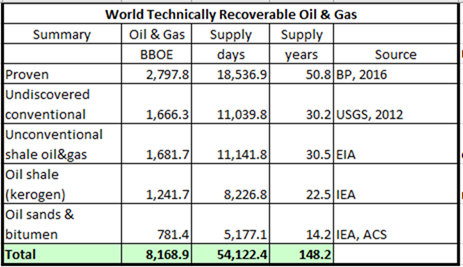

Barnosky spekuliert, dass unser gegenwärtig hohes Niveau von „Biomasse“ großer Tiere nur durch fossile Treibstoffe erhalten werden kann und von der menschlichen „Biomasse“ dominiert wird. Das ist eine seltsame Art der Beschreibung des Tatbestandes, aber es könnte stimmen. Seine nächste Prophezeiung lautet, dass ein weiterer großer „Biomasse-Zusammenbruch“ unmittelbar bevorsteht, weil uns die fossilen Treibstoffe ausgehen. Dies jedoch ist unwahrscheinlich, weil seine Prophezeiung einer Versorgung mit Öl und Gas für nur noch 83 Jahre viel zu pessimistisch ist. In der Studie wird festgestellt, dass wir noch Ölvorräte für 50 Jahre und Gasvorräte für 200 Jahre haben. Ich habe die Gasversorgung in Ölversorgung umgerechnet mittels der USGS conversion von 6 MCF* Erdgas in 1 Barrel Öl-Äquivalent.

[*MCF = Mille (thousand) Cubic Feet. Früheres britisches Hohlmaß. Anm. d. Übers.]

Tabelle 1 (Quelle) zeigt eine wesentlich realistischere Schätzung bekannter Ressourcen von Kohlenwasserstoffen, die technisch förderbar sind. Sie ist sehr konservativ und enthält nicht alle bekannten Kohlenwasserstoffe. Alle in Tabelle 1 gelisteten Kohlenwasserstoffe können ökonomisch erzeugt werden zu Preisen, wie sie während der letzten 20 Jahre üblich waren. Es scheint, dass Barnosky nur „nachgewiesene“ oder „mögliche“ konventionelle Öl- und Gas-Lagerstätten gezählt hat. Die meisten der heute bekannten Öl- und Gasreserven werden jedoch als „unkonventionell“ klassifiziert (darunter Schiefer-Öl und Ölsande). Während die Produktion von unkonventionellem Öl und Gas teurer ist als die konventionelle Produktion, ist auch diese immer noch um eine Größenordnung billiger als die Erzeugung mittels Solar und Wind. . Kernkraft ist sogar noch billiger als Kohle und Erdgas, siehe hier. Unter dem Strich: Die verfügbare Energieversorgung ist nicht das Problem.

Zwar spielte der Mensch im Paläolithikum (von vor etwa 40.000 bis 10.000 Jahren) eine gewisse Rolle beim quaternären Megafauna-Aussterben, doch war das eine sehr viel andere Menschheit als wir heute. Sie waren damals auf der Jagd für ihren Lebensunterhalt in einer sehr schwierigen Zeit. Dies führte zu physiologischen Änderungen, mussten sie sich doch an ein sehr kaltes Klima anpassen. Während dieser Periode konnten sie kaum Erfahrungen im Ackerbau sammeln, und wenn doch, dann nur in sehr primitiver Weise. Wenn die Nahrung vorbei spazierte, töteten und aßen sie das Wild. Wir haben schon früher gesehen, dass man sich nur dann um die Umwelt kümmern kann, wenn unser Einkommen stimmt und unseren Bedürfnissen Rechnung getragen wird (siehe den 1. Beitrag hier, auf Deutsch beim EIKE hier, Abbildung 2). Heute, wo das BIP in PPP$ über 2000 PPP$ pro Person hinausgeht, verbessert sich die Umwelt in jenem Land rapide.

Barnosky zufolge soll der Aufstieg des Menschen und weitere Aussterbe-Ereignisse von Megafauna einfach ein Ausgleich der Biomasse darstellen mit der Folge, dass mit dem Wachstum der Bevölkerung mehr bestehende Megafauna-Spezies aussterben. Ich finde diesen Ansatz hoch spekulativ, wenn ich an unseren Wohlstand denke und an unser Interesse, gefährdete Arten zu schützen. Es gibt einen Ausgleich der verfügbaren Landflächen, aber Biomasse? Mit moderner Landwirtschaft können wir viel mehr Menschen ernähren als früher. Außerdem können wir nahezu unbegrenzt Frischwasser verbrauchen. Und der Mensch hat ein offensichtliches Interesse, bestehende Megafauna-Spezies aus ästhetischen und humanitären Gründen zu erhalten und zu schützen. Sie laufen wohl nicht mehr in freier Wildbahn frei herum, aber ich bezweifle, dass wir es zulassen, dass große Tierarten aussterben. Das beste Mittel zum Erhalt von Megafauna ist eine wohlhabende und sichere menschliche Population.

[Jetzt folgt ein längerer Abschnitt zur Problematik der Eisbären. Hierzu sind jedoch auf der EIKE-Website jüngst ausführliche Beiträge veröffentlicht worden (am ausführlichsten hier), so dass dieser Abschnitt bei der Übersetzung übersprungen wird. Anm. d. Übers.]

Globale Erwärmung wird den Golfstrom zum Erliegen bringen und eine Mini-Eiszeit verursachen

Diesem hypothetischen Szenario zufolge soll schmelzendes Grönland-Eis den Salzgehalt im Atlantik zwischen Grönland und Norwegen verringern, was die Nordatlantische Thermohaline Zirkulation zum Erliegen bringt mit der Folge einer Kleinen Eiszeit wie vor 8200 Jahren. Aber dass es so kommt, ist sehr unwahrscheinlich. Vor 8200 Jahren ist ein gewaltiger Süßwassersee (Lake Agassiz) im Grenzgebiet zwischen den USA und Kanada, welcher ein Überbleibsel der letzten großen Vereisung war, nach dem Bruch eines Eisdammes in den Atlantik ausgelaufen. Dieses Ereignis verringerte den Salzgehalt des Oberflächenwassers und brachte die thermohaline Zirkulation zum Stillstand, was den Planeten über hunderte von Jahren abkühlte (siehe hier von Michael Michalek). Wir verweisen oft der Einfachheit halber auf eine Abkühlungsperiode vor 8200 Jahren, aber in Wirklichkeit gab es deren zwei, nämlich vor 8490 Jahren und dann wieder von vor 8340 bis 8180 Jahren. Lomborg schreibt dazu in Cool It:

Der Golfstrom ist vor 8200 Jahren zum letzten Mal zum Erliegen gekommen, als die letzten glazialen Eisschilde in Nordamerika schmolzen und einen gigantischen Süßwassersee um das Gebiet der heutigen Großen Seen entstanden ist. Eines Tages brach der Eisdamm, und eine beispiellose Masse Frischwasser ergoss sich in den Nordatlantik. Dadurch wurde das Absinken salzhaltigen Wassers aus dem atlantischen Strömungssystem unterbunden. Dies führte in Europa zu einer kleinen, fast 1000 Jahre langen Eiszeit …

Aus diesem Grunde auch äußert sich das IPCC in seinem Bericht aus dem Jahr 2007 sehr eindeutig zum Golfstrom: „Keines der gegenwärtigen Modelle simuliert eine abrupte Reduktion oder gar einen Stillstand des Golfstromes“. Den IPCC-Modellen zufolge reicht die Bandbreite von überhaupt keiner Änderung bis zu einer Reduktion um 50%, aber kein einziges Modell zeigt einen vollständigen Zusammenbruch. – Lomborg, Bjorn. Cool It (Kindle Locations 1334-1394).

Schlussfolgerungen

Unter dem Strich gibt es keinen erkennbaren Trend hinsichtlich aussterben. Aber wir befinden uns mit Sicherheit nicht in einem „großen Aussterbe-Ereignis“. Der Golfstrom und das thermohaline Zirkulationssystem sind unverändert, und es gibt keinen „Lake Agassiz“, der darauf wartet, in den Atlantik auszulaufen. Das Eis in Grönland kann nicht schnell genug schmelzen, um den Salzgehalt bis zu einem Grad zu verdünnen, dass sich die Kaltphase von vor 8200 Jahren wiederholen kann.

Das Aussterben der quaternären Megafauna war sicher ein sehr trauriges Ereignis. Sowohl die Menschen der damaligen Zeit als auch radikale natürliche Klimaänderung spielten dabei eine Rolle, wie eindeutig aus den uns zur Verfügung stehenden Daten hervorgeht. Wenn man allerdings dieses sehr geringe Aussterbe-Ereignis mit den fünf großen Aussterbe-Ereignissen vergleicht, wie es Barnosky tut, legt man ein vollständiges Fehlen jeglicher Kenntnis der Verhältnismäßigkeit an den Tag sowie eine Ignoranz der geologischen Vergangenheit. Die wahren großen Aussterbe-Ereignisse waren entsetzliche Ereignisse, und der Verlust von 178 Spezies großer Tiere ist viele Größenordnungen zu klein, um dabei mithalten zu können. Um zu einer solchen Klassifizierung heutzutage zu kommen, müssten über eine halbe Million Spezies aussterben, und nichts dergleichen ist derzeit im Gange oder in absehbarer Zukunft zu erwarten.

Dr. Susan Crockford hat die Saga der Eisbären gut dokumentiert, welche fälschlich als „verwundbar“ bezeichnet werden, und man kann Einiges aus diesen Fiasko lernen. Man kann grundlegende politische Maßnahmen nicht auf die Grundlage nicht validierter Modelle und Prophezeiungen stellen. Der jüngste Trend, den Modellergebnissen ohne jedes Nachfragen zu glauben – oder noch schlimmer, die Modellergebnisse als reale Daten zu behandeln, muss aufhören. Sonst wird uns dieser Glaube an einem bestimmten Punkt über die Klippe springen lassen.

Link: https://wattsupwiththat.com/2017/12/16/extinctions-and-shutting-down-the-gulf-stream/

Übersetzt von Chris Frey EIKE