Wie die NOAA und schlechte Modellierung eine „Ozean-Versauerung“ erfunden haben: Teil 2 – schlechte Modelle

Versauern die oberen Schichten der Ozeane wirklich?

Im Teil 1 ordnete ein Herr Bednarsek von der NOAA den Zerfall von Schalen der Flügelschnecken [Thecosomata; mehr dazu hier bei Wikipedia. Anm. d. Übers.] anthropogenem CO2 zu, obwohl die Beweise eindeutig sind, dass aufwallendes Tiefenwasser mit geringeren pH-Werten dafür verantwortlich war. Auf der Grundlage von Modellen, die Mitarbeiter der NOAA herangezogen hatten, behauptete Bednarsek, dass die oberen Ozeanschichten saurer werden und weniger geeignet sind als Habitat für Thecosomata im Vergleich zu vorindustriellen Zeiten. Allerdings ist das Auffinden des Ortes und der Tiefe, in der sich anthropogenes CO2 derzeit befindet, eine sehr, sehr schwierige Sache. Weil der Ozean ein großes Reservoir anorganischen Kohlenstoffes enthält, 50 mal größer als das atmosphärische Reservoir, ist der anthropogene Beitrag ziemlich gering. Außerdem umfasst anthropogener Kohlenstoff weniger als 2% der CO2-Menge, die jedes Jahr kombiniert von Ozean aufgenommen und wieder ausgegast wird. Folglich gibt es nur ein sehr schwaches Signal im Verhältnis zu Rauschen, was eine genaue Erkennung von anthropogenem CO2 verhindert. Trotz zugegebenermaßen großer Unsicherheiten versuchen die Modellierer stur zu folgern, welche Schichten des Ozeans versauern.

(To clarifying terminology, an organic carbon molecule is a molecule that is joined to one or more other carbons, such as carbohydrates and hydrocarbons. CO2 with a lone carbon is considered inorganic, and when dissolved can take 3 forms (or “species”) collectively referred to as Dissolved Inorganic Carbon (henceforth DIC): 1) Carbonic acid (H2CO3), 2) Bicarbonate ion (HCO3–) after losing one H+ 3) Carbonate ion (CO3-2) after losing a second H+ )

[Diesen Absatz lasse ich mangels Fachkenntnis in Chemie lieber unübersetzt, bevor ich falsche deutsche Begriffe verwende. Anm. d. Übers.]

Die Modellergebnisse basieren jedoch auf drei sehr dubiosen Annahmen:

1) Die Modelle nehmen an, dass die Oberflächenschichten anthropogenes CO2 absorbieren, indem sie ein Gleichgewicht mit der atmosphärischen Konzentration erreichen. Mit kleineren Adjustierungen berechnen die Modelle einfach, wie viel anorganischer Kohlenstoff (DIC) dem Ozean hinzugefügt wird auf der Grundlage eines gestiegenen CO2-Gehaltes der Atmosphäre seit vorindustrieller Zeit.

2) Die Modelle nehmen an, dass CO2 in den oberen Ozeanschichten diffundiert und durch den Ozean transportiert wird ähnlich wie Indikatoren wie CFCs. Weil sich CFCs unverhältnismäßig nahe der Oberfläche akkumulieren, nehmen die Modelle an, dass dies auch bei DIC der Fall ist.

3) Die Modelle nehmen an, dass sich die Biosphäre in einem stationären Zustand [steady state] befindet. Folglich tragen sie nicht einer gestiegenen Primärerzeugung und dem rapiden Export von Kohlenstoff in die Tiefe Rechnung.

Obwohl es keinerlei Zweifel daran gibt, dass die Ozeane anthropogenes CO2 aufnehmen, sind die Behauptungen, dass die oberen Schichten der Ozeane versauern, das Ergebnis falscher Modellhypothesen.

Welches Gleichgewicht?

Ein CO2-Gleichgewicht [equilibrium] zwischen Ozean und Atmosphäre wird sehr selten erreicht. Der pH-Wert an der Ozeanoberfläche und folglich die Sättigung mit Kalziumkarbonat [Kalk] werden bestimmt durch die Effizienz der biologischen Pumpe. Mit anderen Worten, wann wo wie viel CO2 in die Ozeanoberfläche eintritt, muss die CO2-Konzentration an der Oberfläche geringer sein als die atmosphärische Konzentration. Diese Differenz ist davon abhängig, wie viel CO2 in organischem Kohlenstoff gebunden ist mittels Photosynthese und nachfolgend in die Tiefe transportiert wird, oder wie viel CO2 nach oben wallt. Die Photosynthese zieht willkürlich alle CO2-Moleküle hinab, die in die Oberflächengewässer eingedrungen sind, entweder durch Aufwallen aus der Tiefe oder durch Diffusion aus der Atmosphäre. Trotz gegenwirkender Effekte wie Durchmischung und Diffusion erhält die biologische Pumpe einen starken vertikalen Gradienten aufrecht eines hohen pH-Wertes an der Oberfläche und geringem DIC, wobei pH-Werte mit der Tiefe abnehmen und DIC zunimmt. In Regionen, in denen ein starkes Aufwallen von DIC aus der Tiefe die Fähigkeit photosynthetisierender Organismen überkompensiert, Kohlenstoff abzuscheiden, fällt der pH-Wert an der Oberfläche und das CO2 wird in die Atmosphäre ausgegast. Viele Modelle schätzen, dass ohne die biologische Pumpe das atmosphärische CO2 um 200 bis 300 ppm über das derzeitige Niveau hinaus zunehmen wird.

Die Effizienz der biologischen Pumpe bestimmt, bis zu welchen Tiefen anthropogener Kohlenstoff vordringt. Allerdings modelliert Sabine [gemeint: Christopher L. Sabine, Pacific Marine Environmental Laboratory/NOAA, Seattle, Washington 98115-6349, siehe Link] nicht die Auswirkungen der biologischen Pumpe, wobei er komischerweise feststellt: „Obwohl die Ozean-Biologie eine integrale Rolle spielt bei der natürlichen Verteilung von Kohlenstoff im Ozean, gibt es keine endgültigen [conclusive] Beweise, dass die Aufnahme durch den Ozean und die Speicherung anthropogenen Kohlenstoffs bisher irgendetwas anderes involviert hat als eine chemische und physikalische Reaktion auf steigendes atmosphärisches CO2“.

Glaubt Sabine wirklich, dass die unleugbare biologische Pumpe unterscheidet zwischen anthropogenem und natürlichem Kohlenstoff? Oder glaubt er, dass es keinerlei Änderungen hinsichtlich der Primärerzeugung und dem Kohlestofftransport gegeben hatte? Nimmt die Primärerzeugung zu, nimmt auch der Transport von Kohlenstoff in die Tiefe zu. Die jährliche Primärerzeugung in der Arktis hat seit 1998 um 30% zugenommen. Wir können auf der Grundlage einer Zunahme von 61% von Mesoplankton zwischen 1994 und 2006 in der Sargasso-See die Primärerzeugung ableiten. Coccolithophores [hier] im Nordatlantik haben zwischen 1990 und 2012 um 37% zugenommen. Und Primärerzeugung und Kohlenstoff-Transport im Peru-Strom hat seit Ende der Kleinen Eiszeit dramatisch zugenommen. Der zunehmende Trend der Primärproduktion und der begleitende Kohlenstoff-Export sind potente Beweise, die eine alternative Hypothese stützen, der zufolge die biologische Pumpe den zunehmenden Eintrag anthropogenen Kohlenstoffs sequestriert hat.

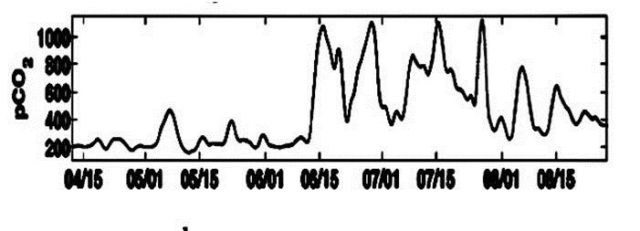

Eine Untersuchung saisonaler Änderungen der oberflächennahen CO2-Konzentration illustriert, wie die biologische Pumpe bestimmt, wann und wie viel CO2 in den Ozean eintritt und wie viel DIC sich nahe der Oberfläche akkumuliert. Wie die folgende Graphik mit Bojen-Daten vor der Küste von Newport aus dem Jahr 2008 veranschaulicht (Evans 2011), erniedrigt jede Frühjahrs-Photosynthese das CO2 an der Ozeanoberfläche auf 200 ppm, weit unter den gegenwärtigen atmosphärischen Konzentrationen und viel niedriger als das, was aus dem Gleichgewicht einer vorindustriellen Atmosphäre zu erwarten ist. Frühjahrs-Oberflächengewässer sind übersättigt, und jedwedes Abtauchen oder Durchmischung dieser übersättigten Gewässer kann nicht aufwallendes Wasser oder Schichten unter der Oberfläche versauern. Außerdem sorgt der Abwärtstransport des Wassers im Frühjahr schlüssig für die Entfernung irgendwelchen anthropogenen CO2, welches in sonnendurchfluteten Gewässern noch übrig ist. Weitere Experimente zeigen, dass CO2 oftmals ein begrenzter Nährstoff ist, und das zusätzliches atmosphärisches CO2 die Photosynthese stimuliert. Mikrokosmos-Experimente zeigten: wenn der atmosphärische CO2-Gehalt höher war, verbrauchte die Plankton-Gemeinschaft 39% mehr DIC.

Die Saison der Aufwallung beginnt im Sommer und dauert bis zum Herbst. Wie oben dargestellt lassen Aufwall-Ereignisse die Oberflächen-Konzentration von CO2 rapide steigen, bis 1000 ppm. Die Physik schreibt vor, dass es keine Diffusion aus der Atmosphäre in den Ozean geben kann, wenn die ozeanische Konzentration höher ist als die atmosphärische Konzentration. Folglich gibt es praktisch keine anthropogenen Hinzufügungen während der Aufwall-Saison. Hier muss jedwede Abnahme des pH-Wertes oder der Karbonat-Sättigung an der Oberfläche auf Aufwallen zurückgehen.

Und schließlich, im Winter (nicht illustriert) zeigen die Oberflächengewässer eine stetige CO2-Konzentration von 340 ppm. Obwohl die Photosynthese herabgesetzt ist und die winterliche Durchmischung mehr unter der Oberfläche befindlichen Kohlenstoff und Nährstoffe an die Oberfläche bringt, bleibt die Atmosphäre unter dem Gleichgewicht mit der Atmosphäre. Obwohl die Oberflächen-Konzentrationen niedrig genug sind, um die Aufnahme atmosphärischen CO2 zuzulassen, sorgt die biologische Pumpe weiterhin dafür, dass Kohlenstoff in die Tiefe transportiert wird, so dass die Oberflächenschichten den ganzen Winter über übersättigt bleiben.

Die Diffusion von CO2 in den Ozean ist ein langsamer Prozess. Man glaubt, dass es etwa 1 Jahr dauert, bis die Ozeane mit einer atmosphärischen Störung ins Gleichgewicht kommen. Aber mit der Annäherung des Frühjahres verstärkt das zunehmende Sonnenlicht die Photosynthese. Wie viel anthropogenes CO2 auch immer in die Ozeanoberfläche im Verlauf des Jahres eingedrungen ist – es ist wieder einmal vollständig sequestriert und in die Tiefe gepumpt worden, was die CO2-Konzentrationen an der Oberfläche auf 200 ppm erniedrigt. Bednarseks Behauptung, dass anthropogenes CO2 das aufwallende Wasser entlang der Küste von Oregon und Kalifornien versauert, wird also wieder nicht gestützt.

Indikatoren simulieren den Transport anthropogenen Kohlenstoffes nicht korrekt

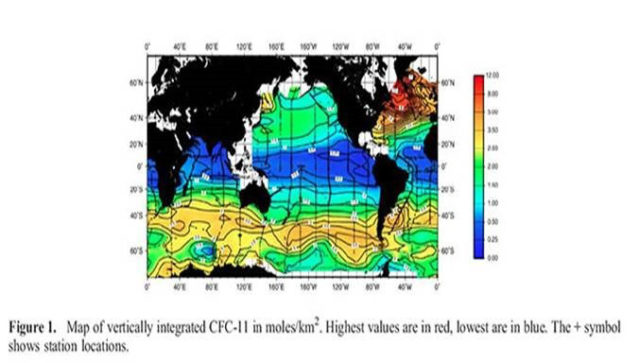

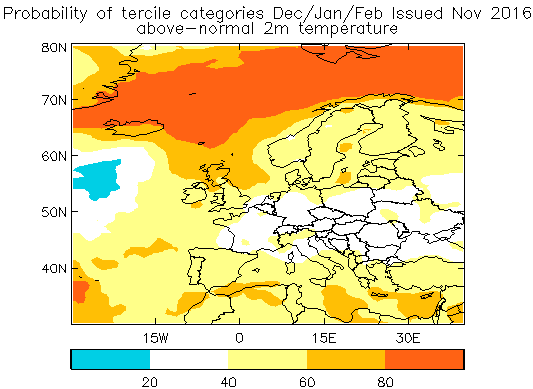

Indikatoren wie chlorofluorocarbons (CFCs) sind synthetische Gase, die biologisch inaktiv sind. Sie kamen während der zwanziger Jahre des vorigen Jahrhunderts in die Welt, hauptsächlich als Kühlmittel. Klimawissenschaftler haben vermutet, dass der physikalische Transport und die Akkumulation von CFCs sowie zunehmender anthropogener Kohlenstoff ähnlich sind. Unten in der Abbildung zeigt der rote Bereich unmittelbar südlich von Grönland ein Gebiet, in dem sich die meisten CFCs akkumuliert haben. Zu dieser lokalen Konzentration kommt es, wenn Wasser aus dem Atlantik mit hohem Salzgehalt sich abkühlt und das Oberflächenwasser zusammen mit den darin gelösten Gasen in die Tiefe sinkt und das Nordatlantische Tiefenwasser bildet. Man schätzt, dass dieses Absinken 18% aller CFCs unter 1000 m tief transportiert hat; was impliziert, dass gelöster anthropogener Kohlenstoff ähnlich transportiert und abgeschieden worden ist. Anderswo jedoch akkumulieren CFCs unverhältnismäßig in Oberflächengewässern, so dass die Modelle annehmen, dass sich gelöstes anthropogenes CO2 ähnlich näher an der Oberfläche akkumuliert.

Sowohl CFCs als auch CO2 sind Gase, und deren Löslichkeit wird von der Temperatur gleichlaufend moduliert. Warmes Wasser in den Tropen absorbiert die geringste Menge von CFCs und CO2, wie die dunkelblauen Bereiche in der folgenden Abbildung zeigen (aus Willey 2004). Folglich haben Äquator-Gewässer, welche die Kalifornische Tiefenströmung füttern, deren Wasser an der Westküste aufsteigt, ebenfalls die geringsten Mengen anthropogenen Kohlenstoffs absorbiert, wenn überhaupt welches. (Das extrem geringe Niveau der CO2-Diffusion in den tropischen Ozean plus die Übersättigung tropischer Gewässer widerspricht sehr jedweden Behauptungen, dass Korallenriffe signifikant beeinträchtigt sind durch anthropogene Versauerung).

Allerdings wird jedwedes in sonnendurchflutetes Wasser eindringende CO2 durch Photosynthese rasch in viel organische Materie umgewandelt, anders als bei den inerten CFCs. Obwohl gelöste CFCs und gelöster Kohlenstoff auf die gleiche Weise passiv transportiert werden, verhält sich organischer Kohlenstoff (lebend oder tot) sehr viel anders. Partikulärer Kohlenstoff sinkt rasch und bringt so Kohlenstoff von der Oberfläche in die Tiefe. CFC-Spurengase können dies nicht simulieren. Eine Durchsicht der Literatur zeigt: „Verschiedene Verfahren und Messungen haben Schätzungen erzeugt von Sink-Geschwindigkeiten für organische Partikel. Dieses Sinken weist eine riesige Bandbreite auf, nämlich von 5 bis 2700 m pro Tag. Allgemein liegt die Geschwindigkeit aber zwischen zehner und hunderten Metern pro Tag“. Niedrige Schätzungen sind verzerrt durch suspended Partikel, die mit den sinkenden Partikeln gemittelt werden. Schnellere Sinkraten werden bei pteropod shells, Foraminiferen, Diatomeen, Flügelschnecken, Panzer von Zooplankton und Anhäufungen von Abfallstoffen beobachtet, die alle in der Lage sind, 500 bis 1000 Meter pro Tag zu sinken. Diese Sinkraten sind viel zu schnell um zu gestatten, dass aufgenommenes CO2 aus deren Zerfall entweder das aufwallende Wasser versauert wie entlang der Küsten von Oregon bis Kalifornien, oder das Wasser an der Oberfläche.

Frühere Experimente hatten gezeigt, dass Einzelzellen sehr langsam sinken mit Raten von nur 1 Meter pro Tag und folglich erheblich unterschätztem Kohlenstoff-Export. Aus Einzelzellen bestehende Organismen werden sich jedoch zu Klumpen zusammenfügen, was die Sinkrate erhöht. Neue Studien zeigten die „allgegenwärtige Präsenz gesunder photosynthetischer Zellen, dominiert von Diatomeen, bis hinab zu 4000 m“. Je nach Länge der Zeit, mit der photosynthetische Zellen in der Dunkelheit bestehen, wurden Sinkraten berechnet mit einer Bandbreite von 124 bis 732 Meter pro Tag, was konsistent ist mit einer hoch effizienten biologischen Pumpe. Obwohl die Wissenschaftler der NOAA Bedenken geäußert haben, dass die globale Erwärmung die Effizienz der biologischen Pumpe verringern würde, indem Bestandteile der Phytoplankton-Gemeinschaften zu kleinen, langsam sinkenden Bakterien geschoben werden, zeigen neue Forschungen, dass sich auch Bakterien zu Clustern zusammenfinden, mit raschen Sinkraten von 440 bis 660 Meter pro Tag.

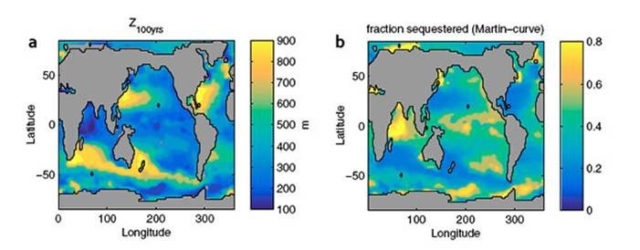

Die Abscheidung von Kohlenstoff ist abhängig von der Sinkgeschwindigkeit und wie schnell organisches Material abgelagert wird. Die Abscheidung variiert teilweise infolge Variationen in den Phytoplankton-Kolonien. In Tiefen um 1000 m wird angenommen, dass Kohlenstoff relativ permanent abgeschieden wird, wird Wasser aus dieser Tiefe doch 1000 Jahre lang nicht mit der Oberfläche ausgetauscht. Weber 2016 zeigt, dass 25% der organischen Partikel in hohen Breiten bis auf 1000 m sinken, während dies in niedrigen Breiten nur zu 5% der Fall ist. Aber langfristige Abscheidung erfordert keine Absinktiefe bis 1000 Meter. Es erfordert Absinken bis unter die Pycnocline-Schicht [hier bei Wikipedia steht, was das ist. Anm. d. Übers.], eine Region, in der sich die Dichte rapide ändert. Dichtes Wasser kann sich nicht so ohne Weiteres über die Pycnocline-Schicht hinauf bewegen, so dass der vertikale Transport von Nährstoffen und Kohlenstoff behindert wird, was zu langfristiger Abscheidung führt. Weil die Pycnocline-Schicht über den Globus variiert, ist das auch bei der Tiefe der Abscheidung der Fall.

Unten links (a) ist eine Graphik von Weber 2016, in der abgeschätzt wird, bis zu welcher Tiefe Partikel sinken müssen, um 100 Jahre lang abgeschieden zu werden. Im größten Teil des Pazifiks müssen die Partikel dazu nur auf Tiefen zwischen 200 und 500 Metern absinken. Im Gegensatz dazu müssen sie in den goldenen Gebieten um den Golfstrom, Neuseeland und Südafrika bis auf 900 Meter sinken.

Die Karte rechts (b) zeigt Schätzungen, welcher Anteil organischer Materie, welche die sonnendurchfluteten Gewässer verlässt, sequestriert wird. Das Gold im Indischen Ozean schätzt, dass 80% davon die 100-Jahre-Abscheidungstiefe erreichen werden. Entlang der Küste von Oregon bis Kalifornien ist das nur bei 60% der Fall. Auch dies weckt Zweifel an Bednareks Behauptung, dass kürzlich versauertes Wasser die Flügelschnecken beeinträchtigt. Anderswo in Graphik (b) erreichen nur 20% oder weniger des exportierten Kohlenstoffes die zur Abscheidung erforderliche Tiefe.

Die Kombination von Sinkgeschwindigkeiten und Abscheidungs-Tiefen zeigt, dass bedeutende Anteile der Primärproduktion im Zeitmaßstab von Tagen bis Wochen abgeschieden werden. Dies ist konsistent mit dem Erhalt des vertikalen DIC- und pH-Gradienten, der in unseren Ozeanen gefunden worden ist. Es steht jedoch im Widerspruch zu Behauptungen der NOAA-Wissenschaftler.

Verzerrt durch CFC-Beobachtungen schrieb Sabine: „Weil anthropogenes CO2 in die Ozeane eindringt mittels Gasaustausch an der Grenzschicht Wasser-Luft, finden sich die höchsten Konzentrationen anthropogenen CO2 nahe der Wasseroberfläche. Außerhalb von Tiefwassergebieten kann der Zeitmaßstab der Durchmischung von Wasser nahe der Oberfläche mit Tiefenwasser Jahrhunderte betragen, und bis Mitte der neunziger Jahre blieb die Konzentration athropogenen CO2 in der Tiefsee unter dem Erkennungshorizont mit der Delta-C*-Technik.

Wenn die NOAA-Wissenschaftler die Tatsache außer acht lassen, dass Kohlenstoff in Partikelform bis zu harmlosen Tiefen im Zeitmaßstab von Tagen bis Wochen anstatt von „Jahrhunderten“ abgeschieden werden kann, scheint dies der Grund für ihre katastrophalen Fehleinschätzungen der Ozean-Versauerung zu sein. Außerdem, weil sich CFCs nahe der Oberfläche akkumuliert haben mit nur minimalen Anteilen in tieferen Ozeanbereichen, bietet das Spurengas absolut keinen Hinweis, wie Aufsteigen historisches DIV an die Oberfläche bringen kann. Verlässt man sich daher auf ein CFC-Spurengas, werden ihre Modelle fälschlich annehmen, dass gesteigerte Konzentrationen von DIC nahe der Oberfläche auf sich akkumulierenden anthropogenen Kohlenstoff zurückgehen müssen und nicht auf aufgestiegenen historischen Kohlenstoff.

Der Steady State der Biosphäre im Ozean?

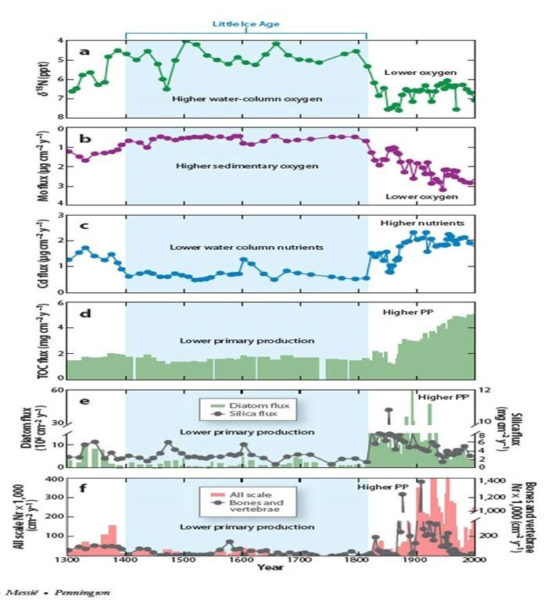

Bei einem gegebenen stetigen Prozentanteil von Primärproduktion werden zunehmende Mengen Kohlenstoff im Verhältnis zu gesteigerter Produktivität exportiert. Folglich ist es vernünftig zu hypothetisieren, dass falls die maritime Produktivität seit dem Ende der Kleinen Eiszeit, also seit vorindustrieller Zeit, zugenommen hat, die gesteigerte Produktion die gesteigerten Mengen anthropogenen Kohlenstoffs abgeschieden hat. Obwohl es nur wenige Ozeanbecken ohne Sauerstoff gibt, wo sich organische Sedimente gut erhalten können, zeigen alle diese Becken, dass seit der Kleinen Eiszeit die maritime Produktivität und der Kohlenstoffexport tatsächlich mit der Erwärmung der Ozeane zugenommen haben.

Hier folgen Forschungen von Chavez 2011, die zeigen, dass während der Kleinen Eiszeit die maritime Primärproduktion (d) niedrig war, aber um das 2- bis 3-fache zugenommen hat während der letzten 150 Jahre. Sedimente zeigen, dass rasch sinkende Diatomeen um das 10-fache am Ende der Kleinen Eiszeit zugenommen haben, aber wahrscheinlich aufgrund limitierten Siliziums reduzierte sich der Fluss von Diatomeen in Ozean-Sedimente auf eine etwa 2-fache Zunahme über die Kleine Eiszeit. Nichtsdestotrotz finden zahlreiche Studien, dass Schätzungen der Diatomeen-Vielfalt repräsentativ sind für die Kohlenstoffexport-Erzeugung in küstennahen Aufstiegsgebieten.

Die gesteigerte Primärproduktion fällt zusammen mit einer über 100-fachen Zunahme von Fischschuppen und Gräten (f). Und konsistent mit einer Notwendigkeit für mehr Nährstoffe, um die gesteigerte Primärproduktion zu stützen, zeigen Proxy-Beweise eine 2-fache Zunahme von Nährstoffen in der Wassersäule (c). Es sind diese Beweise, welche die Forscher dazu bringen anzunehmen, dass die beobachteten dekadischen Zunahmen aufgestiegenen DIC und Nährstoffe Teil eines viel längeren Trends sein können. Und schließlich, im Gegensatz dazu, dass die globale Erwärmung zur Erklärung für den aufgebrauchten Sauerstoff herangezogen wird, ist die Ablagerung gesteigerten organischen Kohlenstoffes eine viel bessere Erklärung für Beobachtungen gesunkener Sauerstoff-Konzentrationen in der Wassersäule (a) und in Sedimenten (b). Weil sich die Primärproduktion bis 1900 verdoppelt hatte, lange bevor globale Erwärmung oder bevor anthropogenes CO2 signifikante Konzentrationen erreicht hatte, ist es unwahrscheinlich, dass anthropogenes CO2 zu gesteigertem Aufstieg beigetragen hat, zu gesteigerter Primärproduktion oder irgendwelchen anderen Trends in diesem Gebiet.

Gesteigerte Primärproduktion allein garantiert jedoch nicht, dass absinkender partikulärer Kohlenstoff genügend Kohlenstoff entfernt, um anthropogenen Hinzufügungen entgegen zu wirken. Es gibt jedoch eine Dynamik, die nahelegt, dass dies der Fall sein muss. Erstens betrachte man, dass bei einer Untersuchung der Elemente einer Phytoplankton-Kolonie ein allgemeines Verhältnis von 106 Kohlenstoff-Atomen auf 16 Stickstoff-Atome entdeckt worden ist (d. h. Redfield-Verhältnis). Angesichts des Umstandes, dass Stickstoff typischerweise photosynthetische Produktion begrenzt, falls Kohlenstoff und Stickstoff im gleichen Redfield-Verhältnis aufsteigen, solange nicht andere Prozesse für einen Stickstoff-Überschuss sorgen, könnte die Photosynthese lediglich aufgestiegenen Kohlenstoff assimilieren, aber nicht genug, um dem gesamten zusätzlichen anthropogenen Kohlenstoff Rechnung zu tragen.

Kalk bildende Organismen exportieren jedoch größere Anteile anorganischen Kohlenstoffs, weil ihren sinkenden Schalen aus Kalziumkarbonat Stickstoff fehlt. Dies kann zu einem Überschuss an Stickstoff beitragen relativ zu bis in Oberflächengewässer aufgestiegenem Kohlenstoff. Zweitens, Diazotrophen [noch einmal bei Wikipedia] sind Organismen, die atmosphärischen Stickstoff in biologisch nutzbare Formen konvertieren. Freilebende Diazotrophen wie das Cyanobakterium Trichodesmium können so üppig auftreten, dass ihr Erblühen beobachtet werden kann. (Die Blüten einer Spezies sind primär verantwortlich für die Färbung des Roten Meeres). Einige Diazotrophen bilden symbiotische Beziehungen, um sowohl aufgestiegenen als auch anthropogenen Kohlenstoff zu assimilieren. Außerdem, wie bei Mackey 2015 (sowie deren Literaturhinweisen) diskutiert, zeigen bis heute fast alle Studien, dass die Stickstoff-Bindung aufgrund gesteigerten CO2 zunehmen wird“.

Berücksichtigt man all dies, zeigen die Beweise, dass die NOAA-Wissenschaftler eine Charakterisierung des „Steady State“ des Ozeans haben, die verkehrt herum steht. Es gibt keine starre Rate von Primärproduktion und Export, welche die Assimilation anthropogenen Kohlenstoffes und deren Pumpen in die Tiefe verhindert. Im Gegenteil, die kombinierte Dynamik der Stickstoff-Bindung und der biologischen Pumpe zeigen, dass die oberen Schichten des Ozeans wahrscheinlich ein pH-Gleichgewicht [pH homeostasis] oder einen pH-Steady-State erhalten haben, zumindest seit vorindustrieller Zeit. Eine Zunahme atmosphärischen Kohlenstoffs, ob nun aus natürlichem Aufsteigen oder aus anthropogenen Quellen, wird höchst wahrscheinlich rasch assimiliert und in Ozeantiefen transportiert, wo sie für Jahrhunderte und Jahrtausende sicher abgelagert sind. Behauptungen, denen zufolge der obere Ozean seit vorindustrieller Zeit versauert sind, beruhen nicht auf Messungen, sondern sind lediglich das Ergebnis der Modellierung eines „toten“ Ozeans unter Ignoranz entscheidender biologischer Prozesse (mehr dazu hier).

Jim Steele is Director emeritus Sierra Nevada Field Campus, San Francisco State University and author of Landscapes & Cycles: An Environmentalist’s Journey to Climate Skepticism

Übersetzt von Chris Frey EIKE, der inhaltlich aber nicht immer ganz folgen konnte.