Wie hoch sind die Kosten des Verbrauchs erneuerbarer Energie? Sonne und Wind gibt es umsonst, aber ist Energie aus Sonne und Wind auch umsonst? Biotreibstoffe erfordern Energie für die Pflanzenzucht, zur Herstellung und Ausbringung von Dünger, die Ernte, Herstellung und Transport von Äthanol. Sonne und Wind brauchen Energie, diese zu erzeugen, zu transportieren und die Ausrüstung zu installieren. Alle erneuerbaren Energiequellen verbrauchen sehr viel Land pro Megawatt erzeugten Stromes. Wir werden mit diesem Beitrag nicht in der Lage sein, die Kosten für erneuerbare Energie zu berechnen, aber wir können über die Komponenten diskutieren, die in diese Berechnung eingehen, und einige Zusammenhänge herstellen.

Energy return of investment (EROI)

[etwa: Eine Investitionen-Energieausbeute-Berechnung]

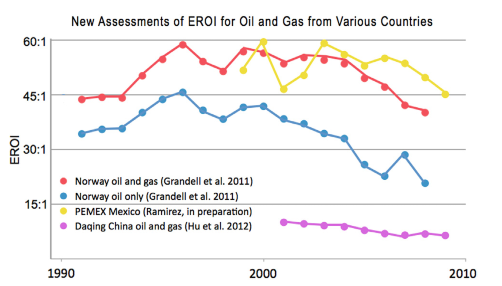

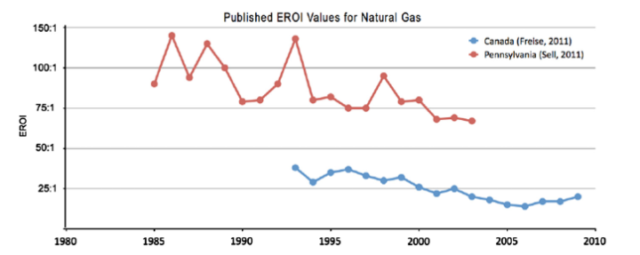

Die zur Herstellung eines Treibstoffes wie Biodiesel verbrauchte Energie muss wesentlich niedriger sein als die Energieausbeute aus dem hergestellten Treibstoff, damit dieser Treibstoff von Nutzen ist. Der allgemein gebräuchliche Terminus hierfür ist „energy return of investment“ oder EROI. Sie wird berechnet mittels Division der nutzbaren Energie in einem Treibstoff durch die zur Herstellung des Treibstoffes verbrauchte Energie. Folglich bedeutet ein EROI von eins, dass genauso viel Energie aufgewendet werde musste wie man danach aus diesem Treibstoff wieder herausholen kann. Diese Berechnung ist komplex, und als Folge davon können Schätzungen bzgl. irgendeines Treibstoffes erheblich variieren. Oftmals bestimmen lokale Faktoren die Berechnung, so dass der Vergleich zwischen verschiedenen Treibstoffen mittels dieses Verfahrens schwierig ist (Siehe die Abbildungen 1 und 2). Man beachte die Bandbreite der Werte für Öl und Gas, die Werte hängen stark ab von der Stelle, dem Typ von Rohöl oder Gas, dem herangezogenen Zeitraum, lokalen Vorschriften und Infrastruktur. Es ist sehr schwierig, einen Wert für einen Treibstoff festzumachen, weil die lokale Ökonomie, Qualität und Timing so große Auswirkungen haben.

Hall, et al., 2014 beschreiben vier verschiedene EROI-Berechnungen. Der Standard-EROI wird am Ursprungspunkt berechnet, dem Bohrkopf, dem Äthanol-Werk oder in der Fabrik, welche die Windmühlen oder Solarpaneele herstellt. Dabei kann aber viel Energie außen vor bleiben, die erforderlich ist, um den Treibstoff nutzbar zu machen, etwa für Wartung, Reibungsverluste usw., und schließlich beschreiben sie den gesellschaftlichen EROI, worunter der tatsächliche Gewinn aus einem Treibstoff für die Gesellschaft fällt. Letzteres ist aber wegen dessen Komplexität noch nicht erfasst. Keine der Berechnungen enthält die Kosten von fossilen Backup-Treibstoffen für Wind- und Solarerzeugung (außer vielleicht der zuletzt genannte Faktor). Oftmals enthalten die berechneten Werte nicht Kapazitäts-Korrekturen, um Ausfallzeiten Rechnung zu tragen.

EROI-Berechnungen sind also nicht Standard oder vollständig. Sie sind nur schwer untereinander zu vergleichen. Besonders schwierig ist es, Technologien untereinander zu vergleichen, beispielsweise Erdgas mit Solar oder Wind. Aber trotzdem zeigen die meisten Berechnungen, dass auf Mais basierendes Äthanol einen EROI von lediglich 1,25:1 aufweist (Kiefer, 2013). Wenn wir den Energieverlust berücksichtigen, wenn man Äthanol in einem Fahrzeug verbraucht, ist dies eine negative Ausbeute. Autos und Lastwagen sind nicht perfekt effizient, darum ist die von Hall, et al. (2009) geschätzte Kostendeckung etwa 3:1. Kiefer zufolge ist es selbst dem antiken Rom besser ergangen mit Getreide für Sklaven, Ochsen und Pferde. Deren Maximum-EROI betrug etwa 4,2:1. Beim Bau des Colosseums war der EROI 1,8:1. Kiefer schreibt auch, dass wenn der Gesamt-EROI unter 6:1 zurückgeht, die Wirtschaft wegen des hohen Energieverbrauchs der modernen Gesellschaft schrumpft und wir vor dem Risiko einer Rezession stehen.

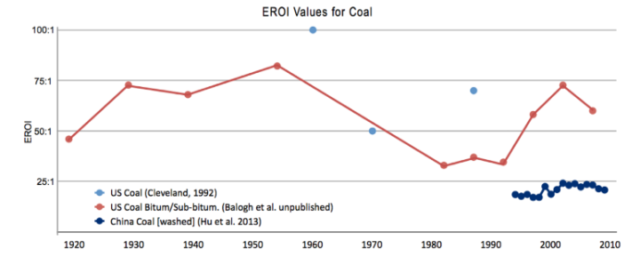

Sehr viel später traten mit Kohle befeuerte Dampfmaschinen auf den Plan mit einem EROI von 10:1 oder mehr. Zu Anfang des Kohlebergbaus war die Ausbeutung von Kohle sehr einfach, lag sie doch an oder sehr nahe der Oberfläche. Das war eine gute Sache, weil frühe Dampfmaschinen sehr ineffizient waren. Allerdings wurde die Sklavenarbeit durch kohlebetriebene Dampfmaschinen ersetzt, als diese sich immer weiter verbesserten und sich ausgebreitet haben. Die sozialen und ökonomischen Vorteile waren also erheblich. Einige veröffentlichte historische EROI-Werte für Kohle sind in Abbildung 3 dargestellt (nach Hall et al. 2014).

Unsere Zivilisation ist sehr stark abhängig von EROI, definiert doch der Energiegewinn unseren Wohlstand (Energiegewinn: Energie, die nicht zur Herstellung und dem Verbrauch von Treibstoffen aufgewendet wird). Weil wir uns gegenwärtig an einem großen Energiegewinn erfreuen, können wir unsere Zeit mit anderen Dingen zubringen als einfach nur Getreide anzubauen und Holz für Unterkünfte, zum Heizen oder Kochen wachsen zu lassen.

Energieverbrauch oder Energieeffizienz?

Gut dokumentiert ist, dass Wohlstand und Lebensstandard eng mit dem Energieverbrauch korreliert sind [eine Tatsache, die unsere werten Politiker, vor allem die Grünen, aber auch die „Süddeutsche Zeitung“, beharrlich leugnen! Anm. d. Übers.]. Dies muss immer wieder betont und unterstrichen werden: es ist der Energieverbrauch, mit dem unser Wohlstand und unser Lebensstandard sehr stark in Relation steht. Offensichtlich steht der Energieverbrauch in Relation zu dessen Preis: Je billiger Energie ist, umso mehr verbrauchen wir und umso besser geht es uns. Aber der Preis ist relativ zum Verbrauch sekundär. Timothy Garrett (2011) hat gezeigt, dass mit jeden zusätzlich verbrauchten 9,7 Milliwatt unser globaler Wohlstand um einen US-Dollar zunimmt (1990). Andere Dokumentationen der engen Beziehung zwischen Energieverbrauch und Wohlstand gibt es hier und hier . Der schnellste Weg, Menschen aus der Armut zu holen ist es, sie mit Energie zu versorgen, und der schnellste Weg, sie noch ärmer zu machen ist es, ihnen die Energie zu nehmen oder sie unbezahlbar zu machen. Siehe diesen Beitrag auf Spiegel Online mit weiteren Details [weiß jemand, ob dies auch auf der deutschen Site von Spiegel Online stand? Anm. d. Übers.]

Während Stephen Chu und die IEA glauben mögen, dass Energieeffizienz insgesamt Energie einsparen wird, sagt die Historie, dass dem nicht so ist. Der Energieverbrauch ist Gegenstand von „Jevons Paradox ”, welches besagt, dass bessere Energieeffizienz zu niedrigeren Energiekosten und damit zu höherem Energieverbrauch führt. Dies wiegt die meisten Effizienz-Verbesserungen auf, verbessert die Wirtschaft, unseren Lebensstandard und führt zu einem sogar noch höheren Energieverbrauch. Heute werden wegen des Energieverbrauchs weniger Menschen gebraucht, um Nahrungsmittel anzubauen und unsere Häuser zu bauen. Man könnte denken, dass in einem Land mit Überfluss wie etwa die USA ein Markt irgendwann gesättigt ist mit Energie verbrauchenden Gütern wie Autos, Air Conditions und Kühlschränken. Dies ist auf längere Sicht unwahrscheinlich, da neue Produkte, die allesamt Energie verbrauchen, erfunden, gekauft und gebraucht werden, falls sie attraktiv sind. Als ich ein kleines Kind war, gab es bei uns keinen Fernseher. Heute sind meine Frau und ich empty-nesters*, und wir haben drei Fernseher, vier Computer, zwei Tablets und zwei Smartphones. Sie alle verbrauchen Energie. Es ist wirklich ziemlich einfach: der Verbrauch wächst schneller als die Effizienz zunimmt.

[*Diesen Begriff fand ich so ansprechend, dass ich ihn ungern übersetzen möchte. Anm. d. Übers.].

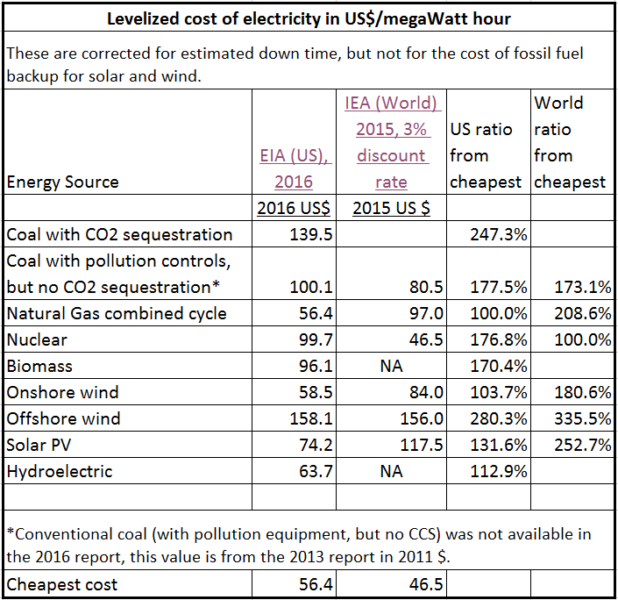

Während der EROI ideal ist für den Vergleich der Qualität von Treibstoffen und Energiequellen, ist die Berechnung komplex und mit Problemen befrachtet. Ein anderer Weg der Betrachtung von Energiequellen sind die durchschnittlichen Stromkosten. Sowohl die US EIA als auch die International IEA haben sich an diesen Berechnungen versucht, und obgleich sie mit verschiedenen Zahlen aufwarten, stimmen sie qualitativ doch weitgehend überein. Die EIA berechnet die Kosten für die USA und die IEA die Kosten für die Welt. Dies ist einer der Gründe für die Unterschiede. Die Ergebnisse zeigt zusammengefasst Tabelle 1 in US-Dollar pro MWh. Beide Zahlenreihen sind korrigiert nach Ausfallzeiten. Das heißt bei Wind für Zeiten der Windstille, für Sonne nachts und an wolkigen Tagen, und Kohle und Erdgas für Wartungszeiten. Allerdings sind die Ausfallzeiten für Sonne und Wind anders als bei der regulären Wartung nicht planbar oder korrigierbar, und diese Zahlen reflektieren nicht die Kosten des erforderlichen (fast) 100%, ansonsten im Leerlauf stehenden Backups fossiler Treibstoffe in windstillen Nächten. Folglich sind die Schätzungen für Solar und Wind niedriger als in Wirklichkeit. Angesichts des Umstandes, wie stark Wind und Solar vom Wetter abhängig sind, können wir uns den Boom in der Meteorologie nur imaginär vorstellen, zu dem es kommen müsste!

Zum größten Teil sind die Erneuerbaren-Technologien in allen Ländern etwa die Gleichen. Die Unterschiede hinsichtlich der Kosten reflektieren unterschiedliche Preise (z. B. Preise für Kohle oder Erdgas), die Qualität der Treibstoffe oder die Kosten unterschiedlicher Vorschriften. Moderne Kohlekraftwerke in den USA und Europa haben allesamt seit Jahrzehnten Verschmutzungs-Kontrollsysteme installiert, und wie die Tabelle zeigt, erzeugen diese Kraftwerke Strom zu einem Preis von 80 bis 100 Dollar pro MWh. Aber „CCS“ (Kohlenstoff-Abscheidung), um ungiftiges Kohlendioxid aus einem Kohlekraftwerk zu sequestrieren, ist sehr teuer. Kohlendioxid ist inert und kein giftiges Gas wie Schwefeldioxid oder Quecksilber, und das Verfahren ist sehr schwierig und teuer. Dies lässt die Kosten für Kohlestrom in den USA auf 140 Dollar pro MWh steigen.

Kosten erneuerbarer Energiequellen

Erneuerbare Energiequellen mögen Vorteile haben, aber sie neigen zu niedrigen EROI-Werten, und ihr Verbrauch lässt die Strompreise steigen. Aus Tabelle 1 wird ersichtlich, dass erneuerbare Energie im Mittel doppelt so teuer ist wie die billigste Alternative. Diese Schätzungen enthalten nicht die Backup-Kosten fossiler Treibstoffe für Wind und Solar. Kernkraft ist die billigste Energiequelle in Europa und Erdgas die billigste Energiequelle in den USA infolge der Erzeugung von Schiefergas.

Das Wall Street Journal hat berichtet, das die Stromkosten in Deutschland um 60% gestiegen seien, und zwar aufgrund der Subventionen des Landes für erneuerbare Energie. Dies hat das BIP, den Lebensstandard und die Wettbewerbsfähigkeit verringert [was man offiziell hierzulande natürlich nie wahrhaben will. Anm. d. Übers.]. Die Firmen BASF, SGL Carbon, Basi Schöberl GmbH und Siemens haben allesamt Operationen aus Deutschland ausgelagert oder planen, dies zu tun infolge der hohen Energiekosten [dabei müssen diese Firmen noch nicht einmal die EEG-Umlage berappen. Anm. d. Übers.]

Wind- und Solarenergie

Wind und Solar sind nur zeitweilig verfügbare Quellen, weil der Wind nicht immer mit der richtigen Geschwindigkeit weht und die Sonne nicht immer scheint. Hall et al. 2014 zufolge sind gute EROI-Berechnungen für Solar und Wind zu diesen Zeiten nicht verfügbar. Dies liegt zum allergrößten Teil daran, dass Wind und Solar hoch abhängig sind vom Backup fossiler Treibstoffe und im Grunde „subventioniert“ werden durch höhere EROI-Werte fossiler Treibstoffe. Wie genau dies in Betracht zu ziehen ist, ist unbekannt. Hall et al. 2014 schreiben:

Alternativen wie Photovoltaik und Windturbinen sind nicht einmal ansatzweise energetisch oder ökonomisch so billig wie Öl und Gas in der Vergangenheit, wenn man die Backup-Kosten mit einbezieht. … Jedweder Übergang zu Solarenergie würde massive Investitionen in fossile Treibstoffe erfordern. Trotz zahlreicher Behauptungen des Gegenteils – von Öl- und Gas-Befürwortern einerseits und Solar-Befürwortern andererseits – sehen wir keine einfache Lösung dieser Probleme, wenn man den EROI betrachtet.

Ein klares Beispiel des Problems kann in Deutschland beobachtet werden, wo etwa 32% der installierten Energie-Kapazität Wind und Solar ausmachen. Nur weil Wind und Solar installiert sind und 32% des erforderlichen Stromes erzeugen können, heißt das noch lange nicht, dass sie das auch tun. Die Nachfrage schwankt ebenso wie die Windgeschwindigkeit und die einfallende Solarstrahlung. Im Jahre 2016 kostete der Strom in Deutschland 39 Cents pro KWh im Vergleich zu 27 Cent im übrigen Europa und etwa 11 Cent für Amerikaner. Dies hat in Deutschland zu Verlusten von Arbeitsplätzen und zur Abwanderung von Industrien geführt. Weil aufgrund der Gesetzeslage die gesamte erneuerbare Energie gekauft werden muss, gibt es Zeiten, in denen die Strompreise negativ sind (d. h. man gibt den Leuten noch Geld dazu, damit sie den Strom abnehmen). Weil ein Backup aus fossilen Treibstoffen zu 100% erforderlich ist, müssen die Regierungen Deutschlands und von UK für brach liegende Kapazitäten fossiler Treibstoffe zahlen, weil Backup im Notfall unabdingbar ist für die Netzstabilität. Diese Zahlungen nennt man „Kapazitäts-Zahlungen“, und man kann sie getrost als Subventionen für Kohlekraftwerke betrachten. Diese Zahlungen liegen über und jenseits der normalen Überschusserzeugungs-Kapazität, die erforderlich ist beim Fehlen von Vorschriften zum Kauf erneuerbarer Energien.

Ein Faktor, der bei der Energieerzeugung durch Wind oft übersehen wird, ist der erforderliche Landverbrauch. In Tabelle 1 sieht man, dass die Offshore-Winderzeugung 2 bis 3 mal so teuer ist wie die Erzeugung an Land. Und doch erzeugen Windmühlen an Land weniger als 2 W/m². Das bedeutet, dass eine riesige Landfläche herhalten muss, wenn ein signifikanter Beitrag in das Stromnetz gespeist werden soll. Zum Vergleich, Mais-Äthanol erzeugt 0,315 W/m² pro Einheit Landfläche, was sogar noch schlechter ist. Ein modernes Ölfeld erzeugt 90 W/m² pro Landfläche*. In seinem E-Buch mit dem Titel „Sustainable Energy“ schätzt David Mackay, dass selbst bei einem Landverbrauch von 10% der Gesamtfläche von UK die Windmühlen nicht genug Energie für das Land erzeugen können.

[*Original: For comparison, corn-based ethanol produces 0.315 W/m2 of land, which is even worse. A modern oil field, on average, produces 90 W/m2 of land. Weiß jemand, wie man das besser übersetzen kann? Ich habe es mit „pro Einheit Landfläche“ versucht. Anm. d. Übers.]

Kommerzielle Solarstrom-Erzeugung hat ein ähnliches Raumproblem (6 W/m²), jedoch nicht bei Solarpaneelen auf Dächern. Aber Solar hat ein sehr ernstes Kapazitäts-Nutzungs-Problem. Im Jahre 2012 war in Deutschland eine Solarerzeugungs-Kapazität von 254 TWh installiert, jedoch wurden lediglich 19,3 TWh Strom erzeugt, das sind 11% der Kapazität. In anderen Teilen der Welt ist der nutzbare Strom aus Solar höher, geht aber niemals über 30% [der installierten Kapazität] hinaus. Die nutzbare Windenergie in Deutschland macht etwa 17% der Kapazität aus. Zum Vergleich, die meisten fossil betriebenen Kraftwerke erreichen Kapazitäts-Faktoren über 80% und Kernkraft über 94%. Es sind die unkontrollierte und nicht planbare Unberechenbarkeit sowie die verschwenderische Energieerzeugung, die zu den hohen Kosten führen. Außerdem ist es eine Tatsache, dass die CO2-Emissionen in Deutschland gestiegen sind, obwohl es doch das festgelegte Ziel der Nutzung von Erneuerbaren ist, diese Emissionen zu senken. Das Backup des Landes beruht auf Kohle, weil die Kernkraftwerke vom Netz genommen worden sind.

Biotreibstoffe

Die US-Vorschriften zum Gebrauch von Biotreibstoffen, hauptsächlich aus Mais und Zellulose-Äthanol, waren eine einzige Katastrophe. Als der Renewable Fuel Standard (RFS) im Jahre 2005 in Kraft gesetzt worden war, wurde dies als ein Schritt in Richtung Energie-Unabhängigkeit gepriesen. Aber schon bald zeigte sich eine Fülle unbeabsichtigter Konsequenzen. Äthanol hat eine geringere Energiedichte als Benzin, und wenn es beigemischt wird, kann man weniger Kilometer weit mit einer Gallone Benzin fahren als mit reinem Benzin. Die Verarbeitung von Mais zu Treibstoff lässt die Preise für Nahrungsmittel weltweit steigen, was besonders die Armen zu spüren bekommen. Und weil Mais auch Dünger braucht, kann der verstärkte Maisanbau zu einem Umweltdesaster führen. Außerdem verbraucht die Herstellung von Äthanol, egal ob aus Mais, Zuckerrohr oder Zellulose, so viel Energie, dass der EROI höchstens erreicht wird oder negativ ist; das heißt, die Herstellung von Äthanol verbraucht mehr Energie als das Äthanol später liefern kann.

Captain Ike Kiefer schreibt in „Twenty-First Century Snake Oil“:

Einige prominente Individuen und Experten argumentieren, dass Biotreibstoffe unsere heimische Versorgung mit Treibstoff für Transporte verbessern und unsere Abhängigkeit von Ölimporten beenden, die militärische Verwundbarkeit abnehmen lassen und allgemein die nationale Sicherheit verbessern. Außerdem verspricht man sich von Biotreibstoffen eine Reduktion der Preisschwankungen, von Verschmutzungs-Emissionen, von Treibhausgasen – und dass sie sogar unsere Wirtschaft beflügeln. All diese Argumente zerfallen jedoch bei näherem Hinsehen … unbegrenzte Biomasse erzeugt Biotreibstoff-Mengen, die viel zu gering, diffus oder knapp sind, um jedwedem Anteil an den Primärbedürfnissen an Energie der USA zu genügen. Die Erhöhung der Vorräte durch Kultivierung verbraucht mehr zusätzliche Energie als der Biomasse hinzugefügt wird. Außerdem erfordert die geerntete Biomasse große Mengen Energie, um sie in die kompakte, energiereiche, flüssige Form von Kohlenwasserstoff zu bringen, die notwendig ist, um mit der Treibstoff-Infrastruktur der Nation, dem Transportwesen und besonders des Militärs kompatibel zu sein. Vergleicht man den Energiegehalt des Endproduktes Biotreibstoff mit der verbrauchten Gesamtmenge an Energie zu dessen Herstellung, verspricht dies ein sehr schlechter Deal zu sein hinsichtlich Investitionen, besonders hinsichtlich anderer Alternativen. In vielen Fällen kommt es insgesamt zu einem Energieverlust.

Äthanol ist corrosiv, es enthält Sauerstoff, ist hygroskopisch und kann Stahl brechen. Dies bedeutet, dass man es nicht einfach durch normale Pipelines pumpen kann, sondern dass es sich nur mit Lastwagen transportieren lässt. Maschinen, Pipelines und Speichertanks müssen für Äthanol besonders präpariert werden, was zu weiteren Kostensteigerungen und einem geringeren EROI führt.

Einige sagen, dass die Verbrennung von Holz „gutes“ CO2 erzeugt, weil die zur Treibstoffgewinnung gefällten Bäume durch neue Bäume ersetzt werden, die dann das CO2 absorbieren. Das kann so sein oder auch nicht, aber in jedem Falle sind die Kosten der Fällung der Bäume und neue zu pflanzen, des Präparierens und Transportes des Holzes zu einem Kraftwerk so hoch, das der EROI der Holzverbrennung sehr klein wird – und zwar viel kleiner als der EROI der Verbrennung von Kohle, auch dann noch, wenn ein kompletter Filtersatz auf dem Kohlekraftwerk installiert ist.

Senator Roger Wicker sagte im vorigen Jahr:

Ein Ende des RFS würde den Verbrauchern Geld sparen. Beispiel: Biotreibstoffe wie Äthanol bei der Treibstoffversorgung bedeuten, dass Fahrer pro Gallone Benzin mehr bezahlen für weniger Meilen. Das Institute for Energy Research sagt, dass der RFS die Verbraucher seit dem Jahr 2007 zusätzlich mir 83 Milliarden Dollar belastet hat.

Im vorigen Kongress habe ich eine Gesetzesvorlage eingebracht, der zufolge es verboten wird, Benzin mit 15 Prozent Äthanol anzureichern, hat sich dies doch als sehr schädlich für Motoren herausgestellt.

Nicolas Loris von der Heritage Foundation schrieb :

In Kraft getreten 2005 und erweitert 2007 schreibt der RFS – die ,Äthanol-Verordnung‘ – vor, dass die amerikanischen Öl-Raffinierer jedes Jahr ein Minimum an Biotreibstoff verarbeiten müssen, was sich bis zum Jahr 2022 auf 36 Gallonen summiert [1 Gallone = ca. 4 Liter]. 15 Milliarden Gallonen davon können aus Mais-Äthanol kommen, das Übrige muss von anderen Biotreibstoffen kommen“.

Bis Juli 2014 wurden lediglich 15.000 Gallonen Zellulose-Äthanol für das Jahr erzeugt, obwohl das Ziel der EPA 17 Millionen war. Die EPA hat wiederholt die Verpflichtung zur Äthanol-Anreicherung gekürzt, aber die tatsächliche Produktion blieb sehr gering. Die Verbraucher (also die Raffinierer und die Öffentlichkeit) können nicht etwas kaufen, das gar nicht existiert, werden aber dafür bestraft, wenn sie es nicht kaufen. Dazu hat Nicolas Loris gesagt:

Bis zum Jahr 2012 wurde kein Zellulose-Äthanol erzeugt, weil es sich kommerziell nicht gerechnet hat. Im Jahre 2012 wurden lediglich 20.000 Gallonen erzeugt – weit weniger als das anvisierte Ziel von 8,65 Millionen Gallonen. Als Konsequenz mussten die Raffinierer Millionen Dollar waiver credits oder Abgaben zahlen, um den Minimum-Vorschriften der EPA zu genügen. Die Raffinierer haben diese Kosten an die Verbraucher durchgereicht. Dies führte zu weiteren ökonomischen Schäden durch den RFS. Im Januar 2013 hat ein Berufungsgericht in Washington D. C. geurteilt, dass das von der EPA gesetzte Ziel „eine unvernünftige Ausführung amtlicher Befugnisse war“, und die Vorschrift bzgl. des RFS annulliert.

Nicht nur, dass die Herstellung von Zellulose-Äthanol weit hinter der Verordnung der Regierung zurückgeblieben war, hat dies außerdem fruchtbaren Boden bereitet für Abzocker und Profitgeier aller Art. [Die Firma] KiOR sollte Zellulose-Äthanol in Mississippi herstellen und wurde mit Millionen Dollar an Subventionen versorgt, damit die Firma in die Gänge kommt. Im November 2014 meldete sie dann Bankrott an und schloss ihre Türen, nachdem man eine sehr geringe Menge Äthanol hergestellt hatte. Der Generalstaatsanwalt von Mississippi Jim Hood sagte damals:

„KiOR war einer der größten Betrugsfälle, mit denen es der Staat Mississippi je zu tun hatte“.

Die Gründe hinter dem Scheitern von KiOR waren einfach: sie konnten ihr Verfahren lange nicht zum Einsatz bringen, und als das dann doch der Fall war, war die Ausbeute weitaus geringer al KiOR behauptet hatte. Das Werk sollte 13 Millionen Gallonen Biotreibstoffe jedes Jahr erzeugen. Tatsächlich waren es im Jahr 2013 133.000; Anfang 2014 nochmals 97.000 Gallonen, dann kam der Bankrott.

Ein anderes Zellulose-Äthanol-Werk wurde jüngst von Ineos Bio an Alliance BioEnergy verkauft. Man hatte den Prozess einfach nicht in den Griff bekommen. Alliance BioEnergy hat gerade sein neues CTS-Verfahren getestet, Zellulose in Äthanol umzuwandeln. Mit der Zeit wird sich zeigen, ob sich das als kommerziell möglich herausstellt. Andere Unternehmen, welche Zellulose in Äthanol umzuwandeln versucht haben, sind ebenfalls dem Pleitegeier zum Opfer gefallen, darunter KL-Energy, Range Fuels und Codexis biofuels. Codexis stellt immer noch Enzyme für die Pharmaindustrie her, hat aber seine Zellulose-Äthanol-Fabrik geschlossen.

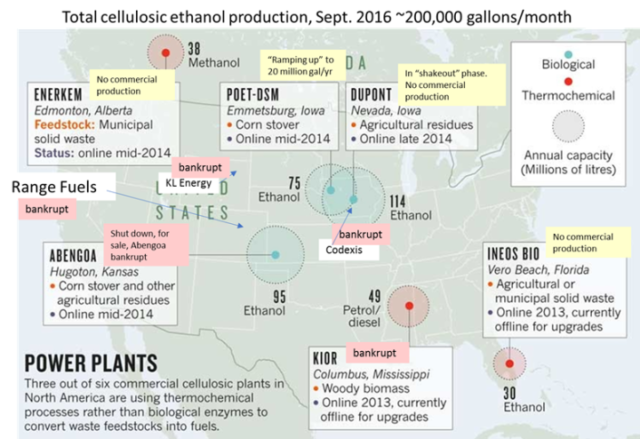

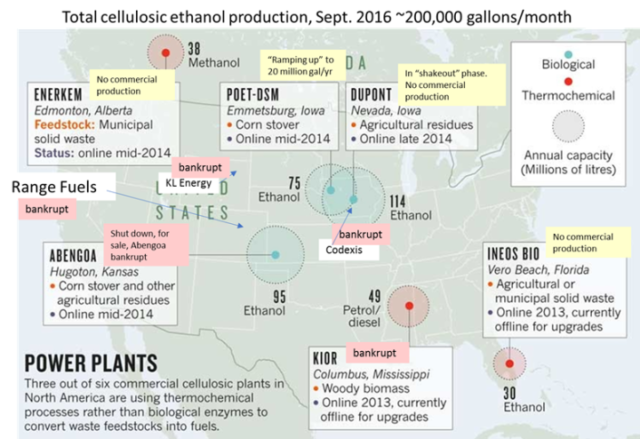

Im März 2014 schrieb Mark Peplow einen Artikel über Zellulose-Äthanol im Magazin Nature. Darin zeigte er eine Karte mit Anlagen in Nordamerika. Diese Karte zeigt Abbildung 4, aktualisiert vom Autor:

Abbildung 4 (Quelle Nature, modifiziert und aktualisiert vom Autor)

Während der Nature-Artikel 2014 sehr euphorisch und optimistisch war, wurde Abengoa geschlossen, welche „mit der kommerziellen Produktion während der nächsten paar Monate beginnen“ sollte. Abengoa hat nach Artikel 15 Bankrott gemeldet. Im Mai 2016 veröffentlichte der Scientific American einen aktuelleren Artikel zum Thema Zellulose-Äthanol mit der Schlagzeile „Whatever Happened to Advanced Biofuels?” Darin wurde die Lage so zusammengefasst:

Das Haupthindernis für „Zellulose-Treibstoffe‘ scheint ökonomischer Natur zu sein. Im April 2012 stellte die Firma Blue Sugars Corp. Of South Dakota die erste Marge brauchbaren Zellulose-Äthanols her, etwas mehr als 75.500 Liter – um gleich danach den Betrieb einzustellen. Im Jahre 2013 wurde kein Zellulose-Äthanol hergestellt, aber im vorigen Jahr – nachdem viele vom Energieministerium unterstützte Werke errichtet wurden – erzeugten alle fünf Bioraffinerien insgesamt 8,3 Millionen Liter Zellulose-Äthanol. Schon jetzt steht das Zellulose-Werk des spanischen multinationalen Unternehmens Abengoa – welches 2014 in Hugoton in Kansas eröffnet worden war – nutzlos in der Gegend herum, und zwar weil man es wegen Schwierigkeiten mit der Technologie nicht nutzen konnte und wegen des Bankrotts von Abengoa. Jenes Werk verbrannte eine Kreditbürgschaft in Höhe von 132 Millionen Dollar ebenso wie eine Zuwendung in Höhe von 97 Millionen Dollar vom Energieministerium, bevor es stillgelegt wurde.

Die EPA fordert jetzt 1,2 Milliarden Liter Zellulose-Äthanol für das Jahr 2017, was niemals geschehen wird. Im Jahre 2015 wurden lediglich 8,3 Millionen Liter verkauft, im vorigen Jahr waren es wohl weniger als 10 Millionen Liter. Die Äthanol-Vorschrift ist jetzt 12 Jahre alt, und immer noch befindet sich auch nur ein einziges kommerzielles Werk für Zellulose-Äthanol nicht in der Produktionsphase. Es ist sehr unwahrscheinlich, dass dies bald doch gesehen wird.

Captain Ike Kiefer fasste die Lage ziemlich gut in diesem Kommentar vom 1. März 2017 bei WUWT zusammen:

Die technologische Machbarkeit von Zellulose-Äthanol ist leicht erkennbar für alle, die willens sind zu sehen und zu denken. Es ist im Wesentlichen die gleiche Herausforderung wie bei einer Papierfabrik, die aus Bäumen Papier herstellt, außer dass man nach der Extraktion der Zellulose versucht, eine sehr kostspielige zusätzliche Konversion von fest zu flüssig durchzuführen, was die Schritte Besiedelung und Düngung, Fermentierung, Destillation und Dehydrierung erfordert. Und das flüssige Endprodukt (Äthanol) hat einen geringeren Marktwert als das feste Endprodukt (Papier). Das ist ein ziemlich übles Geschäftsmodell, vor allem, wenn bekannt ist, dass Papierwerke kaum vor Pleiten stehen. Außerdem, wenn der EROI von Mais-Äthanol weniger als 2:1 ist … und es ist 5 mal schwieriger, Zellulose zu verflüssigen als Maisstärke, dann kann es gut sein, dass der EROI für Zellulose-Äthanol auf dem Kopf steht.

Und schließlich müssen wir die Ergebnisse zahlreicher Studien berücksichtigen, die zeigen, dass über 70% der Preissteigerungen für Nahrungsmittel weltweit der Herstellung von Biotreibstoffen geschuldet sind, wie aus der Studie von Kiefer hervorgeht. Sowohl das World Food Program als auch die Food and Agriculture Organization der UN haben alle G20-Nationen aufgefordert, ihre Subventionen für Biotreibstoffe zu senken. Getreidepreise sind für die ärmsten Verbraucher um bis zu 50% gestiegen, was unter den Armen der Welt zu Hunger und Unterernährung zunehmen lassen.

Schlussfolgerungen

Während eindeutig fossile Treibstoffe und Kernenergie billiger sind und außerdem flexibler und zuverlässiger als Erneuerbare, ist es nicht so eindeutig, um wie viel sie billiger sind. Kiefer berichtet, dass seit 2007 das Militär 68 Millionen Dollar für 1,35 Millionen Gallonen Biotreibstoff ausgegeben hat, das sind über 50 Dollar pro Gallone. Darin sind nicht enthalten die Kosten der Subventionen, welche Staaten und die [US-]Bundesregierung aufgebracht haben. Konventioneller Treibstoff hätte das Militär nur 8 Millionen Dollar gekostet. Hall, et al. (2014) folgerten daraus, dass Solar und Wind nicht verbraucht werden können ohne fossile Treibstoffe oder Kernkraft mit niedrigerem EROI als Backup; sie sind nicht die „Grundlast“-Technologien. Mais-Äthanol erfordert eine große Menge fossiler Energie, um den Mais wachsen zu lassen, ihn zu transportieren und zu Äthanol zu machen. Zellulose-Äthanol ist gegenwärtig nicht ökonomisch und wird es auch niemals sein. Wie in der Studie von Kiefer und anderen Studien diskutiert, ersetzen Erneuerbare keine fossilen Treibstoffe, sondern steigern stattdessen deren Verbrauch. Der einzige Weg, fossile Treibstoffe und Kernkraft zu ersetzen ist es, Erneuerbare herzustellen mit einem höheren EROI als entweder fossile Treibstoffe oder Kernenergie. Dies kann geschehen, wenn entweder der EROI der Fossilen sinkt oder der EROI Erneuerbarer steigt, aber das muss geschehen! Anderenfalls sind Erneuerbare einfach nur Parasiten konventioneller Energie, und wenn der Verbrauch Erneuerbarer zunimmt, ist dies auch bei Fossilen und Kernenergie der Fall, genau wie es heute in Deutschland und Dänemark beobachtet wird.

Gegenwärtig sind die wahren Kosten und der EROI von Erneuerbaren unbekannt. Der einzige Weg, diese Kosten genauer zu berechnen wäre es, einen erneuerbaren Treibstoff zu finden, dessen Energie allein als Energiequelle dienen kann. Dies würde zum Beispiel bedeuten, dass ein mit Solarenergie versorgtes Werk für Solarzellen und -paneele, Solarfahrzeuge und Ausrüstung für Transport und Konstruktion diese ausschließlich mit Energie aus einem Solarkraftwerk herstellt. Wäre eine solche Einrichtung ökonomisch? Was ist mit den analogen Einrichtungen für Äthanol und Wind? Aber derartige Einrichtungen existieren nicht, also wissen wir es nicht. Nur wenn die Abhängigkeit Erneuerbarer von fossilen Treibstoffen und Kernkraft vollständig erforscht ist, wird eine Berechnung möglich sein. Um die wirklichen EROI von Solar, Biotreibstoffen und Wind inkl. Backup zu berechnen, ist es erforderlich zu entscheiden, wo man die Linie zieht zwischen Kosten, die in die EROI-Berechnung fossiler Treibstoffe eingehen sollen, und Kosten, welche in die EROI-Berechnung Erneuerbarer eingehen. Das ist kein triviales Problem. Aber der finale EROI für Erneuerbare, ist er einmal berechnet, dürfte wahrscheinlich weniger als 3:1 betragen, was in der Praxis die Untergrenze ist und eindeutig im Bereich einer Rezession liegt.

Link: https://wattsupwiththat.com/2017/03/13/renewable-energy-what-is-the-cost/

Übersetzt von Chris Frey EIKE