Klimawandel – FakeNews in SRF1 RUNDSCHAU am 26. April 2017

und hier:

Es ist an den beiden Screenshots zur Sendung bereits zu erkennen, wie die SRF RUNDSCHAU „Klima(schutz)“ mit „Umweltschutz“ gleichsetzt, obwohl beides nur sehr wenig miteinander zu tun hat. Aber das ist nicht der einzige Kritikpunkt, der in dem nun folgenden Blogtext thematisiert wird:

Dieser Bericht „Klimalügner: Trumps Kampf gegen den Umweltschutz„ (Länge: 8 min 38sek, inkl. Anmoderation) wurde am 26. April 2017, ab 20:55 als letzter von drei TV-Beiträgen in dieser gebühren-finanzierten, investigativen Schweizer TV-Sendung auf SRF1 ausgestrahlt. Es ist auch die Anmoderation durch den Moderator und Redakteur Sandro Brotz kritisch zu erwähnen …

RUNDSCHAU Frontmann Sandro Brotz

… weil Sandro Brotz durch seine Anmoderation eine irreführende Suggestion beim Zuschauer aufgebaut hat, die in dem dann nachfolgenden TV-Beitrag von Peter Düggeli nicht bestätigt worden ist. Denn Sandro Brotz behauptete in seiner Anmoderation folgendes:

… Mit Trump als [US-]Präsident ist nun auch den Wissenschaftlern das Lachen im Hals stecken geblieben. Hunderttausende haben sich am Wochenende weltweit an einem Marsch für die Freiheit der Forschung beteiligt. Trump glaubt nicht daran, dass der Mensch für die globale Erwärmung verantwortlich ist. Vielleicht sollte er mal zu den Everglades in Florida hinfahren, wie es unser Korrespondent Peter Düggeli getan hat. Alternative Fakten hin oder her. Dort zeigt sich wie real der Klimawandel schon ist.

Mit dieser Anmoderation hat Sandro Brotz eine Erwartungshaltung aufgebaut, die beim Zuschauer den Eindruck vermittelte, der dann nachfolgende Bericht von Peter Düggeli aus den Everglades in Florida würde eindeutige Beweise für die menschliche Schuld am Klimawandel bzw. die menschliche Schuld an der angeblich globalen Erwärmung liefern.

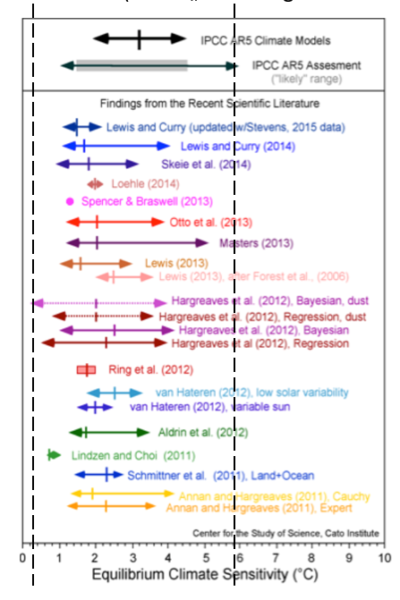

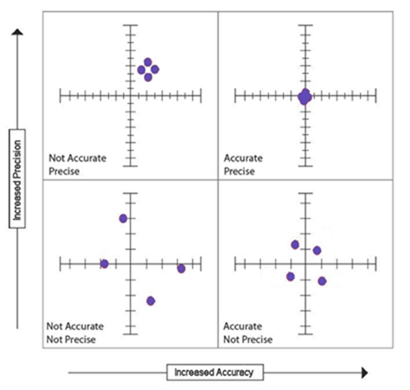

Es ist zusätzlich zu kritisieren, dass Sandro Brotz nur den verkürzten Begriff „Klimawandel“ in seiner Anmoderation verwendet hat, aber damit die angeblich „menschliche Schuld am Klimawandel“ gemeint hat, für die es aber bis heute keinen einzigen wissenschaftlichen Beweis gibt, sondern lediglich ein CO2-Anstieg als Parameter für eine angebliche Erwärmungs-Ursache in linear-mathematisch-programmierte Computerklimamodelle eingegeben worden ist. Einzig und allein auf dieser zweifelhaften Grundlage existiert die Hypothese vom angeblich CO2-bedingten Klimawandel. Und diese sachlich-korrekte Information ist kein „Alternativer Fakt“.

Dieser fehlende wissenschaftliche Beweis für die menschliche Schuld am angeblich CO2-Klimawandel zeigte sich dann auch konkret in dem knapp 8-minütigen SRF1 „RUNDSCHAU“ TV-Beitrag von Peter Düggeli:

Nachdem in den ersten Sekunden im TV-Beitrag von Peter Düggeli schöne Landschafts- und Tier-Aufnahmen aus den Everglades gezeigt wurden, mit einer weiblichen Offstimme und beruhigender Chillout-Musik untermalt wurden, wurde ca. bei Minute 00:57 des TV-Beitrags vom 26.04.2017 folgendes durch eine weibliche Offstimme wörtlich behauptet:

Doch was heute noch Idylle ist, könnte schon morgen nicht mehr da sein.

Aha, plötzlich wird behauptet: „…könnte schon morgen nicht mehr da sein.“

Aus der propagierten Tatsache, die Sandro Brotz in seiner Anmoderation dem Zuschauer vermittelt hatte, wird nun dem Zuschauer erstmalig durch einen Konjunktiv

…könnte schon morgen…

klar, dass die angeblichen Fakten, die Sandro Brotz in der Anmoderation suggestiv behauptet hatte, in Wirklichkeit alternative Fakten, besser: gar keine Fakten sind, sondern in Wahrheit fiktive Zukunftsszenarien sind, von denen niemand wirklich weiß, ob diese Szenarien auch wirklich eintreffen werden.

Als nächstes wurde dann der O-Ton eines Bob Johnson, Direktor des Wissenschaftszentrum Süd-Florida, gesendet:

der bei Minute 01:06 dann im amerikanischen Originalton mit einer deutschen Übersetzung behauptete:

Diese Zone am südlichen Ende von Florida wird verschwinden, weil die Meeresspiegel steigen. Tiere, wie Alligatoren werden nicht mehr da sein.

Auch diese Behauptung von Bob Johnson ist keine Tatsache, sondern eindeutig ein subjektives Zukunftsszenario des Bob Johnson, denn er sagt:

…wird verschwinden…

und

…werden nicht mehr da sein…

Das heisst mit anderen Worten: Aktuell ist aber noch alles vorhanden. Es ist also bis heute nix in den Everglades verschwunden und/oder zerstört !!

An dieser Stelle ist bereits nach den ersten Sekunden zu Beginn des Beitrags von Peter Düggeli jedem halbwegs-intelligenten Zuschauer klar geworden, dass Sandro Brotz mit seiner Anmoderation mit einer falschen Suggestion den TV-Zuschauer in die Irre geführt hatte. Denn Sandro Brotz hatte ja in seiner Anmoderation dem US-Präsidenten Donald Trump empfohlen – und damit suggestiv auch jedem SRF1 RUNDSCHAU-TV-Zuschauer, er solle doch zu den Everglades fahren, denn dort könne man die Auswirkung des Klimawandels bereits sehen, so Sandro Brotz.

Stattdessen aber stellt sich nun bereits in den ersten Sekunden im Beitrag von Peter Düggeli heraus: Wenn ein TV-Zuschauer in die Everglades fährt, und dort die angeblich schon sichtbaren Auswirkungen des (angeblich menschgemachten) Klimawandels sehen will, dann sieht der Zuschauer dort nix dergleichen. Denn in Wirklichkeit/Wahrheit spielen sich die von Sandro Brotz propagierten „Tatsachen“ nur als Zukunftsszenarien in den Köpfen der von Peter Düggeli interviewten Protagonisten ab, in diesem Fall im Kopf eines Bob Johnson.

Und die weibliche Off-Stimme im RUNDSCHAU-Betrag bestätigt dann sogar auch dieses Zukunftszenario im Kopf des Bob Johnson, ab Minute 01:19:

Bob Johnson der Direktor des Wissenschaftszentrum Süd-Floridas warnt seit Jahren, dass der Klimawandel die Everglades zerstören könnte.

Auch an dieser Stelle wieder keine Tatsache, kein Fakt, sondern nur ein fiktiver Konjunktiv „könnte“ als subjektives Zukunftsszenario im Kopf einer einzelnen Person mit Namen Bob Johnson:

…zerstören könnte…

Und die weibliche Rundschau-Offstimme behauptet bei Minute 01:27 sogar weiter:

Deshalb fahren wir dorthin, wo sich die Bedrohung zeigt.

Oh ja, bitte, denkt sich jeder kritische und halbwegs-intelligente TV-Zuschauer, vielleicht wird ja jetzt in den nächsten Sekunden endlich ein „Beweis“ für die propagierte „Bedrohung“ gezeigt, dass menschlicher Einfluss den CO2-Klimawandel bewirkt.

01:37: Mit Peter Düggeli (rechts) und Bob Johnson fahren mit einem Schnellboot durch die Seen-und Mangroven-Landschaft der Everglades in Florida.

Der Rundschau-Zuschauer sieht nun, wie SRF Autor Peter Düggeli mit Bob Johnson in einem Schnellboot durch die Seenlandschaft der Everglades fährt …

….und die weibliche Offstimme behauptet nun bei Minute 01:37:

Florida Bay, das Mündungsgebiet zwischen den Everglades und dem Atlantik. Viele kleine Inseln mit Mangroven-Bäumen. Matt [der Fahrer des Schnellbootes] zeigt uns, wo das Meer jetzt schon bei Ebbe die Inseln anfrisst.

01:51: Bob Johnson zeigt eine in Zukunft überflutete Insel (was aber der TV-Zuschauer nicht wirklich sieht)

Dann kommt – angeblich unmittelbar vor einer solchen „angefressenen Insel“ – bei Minute 1:51 wieder Bob Johnson zu Wort und er behauptet in amerikanisch mit deutscher Off-Stimmen-Übersetzung:

Es braucht nicht viel und die Insel ist überflutet. Laut Prognosen wird das Wasser bis 2100 um ein Meter ansteigen. Dann ist DAS offenes Meer. Die Inseln werden verschwunden sein.

Dem TV-Zuschauer wurde mit diesem O-Ton von Bob Johnson suggeriert, dass das, was er auf dem TV-Bildschirm gesehen hat, durch angeblich „menschgemachten Klimawandel“ verursacht sei.

Aber es war auf dem TV- Bildschirm in diesem SRF1 RUNDSCHAU-TV-Beitrag in Wahrheit garnichts zu sehen, was die Behauptungen von Bob Johnson und der Offstimme belegen würde. Es wurde stattdessen dem TV-Zuschauer die bildliche und sprachliche Behauptung eines Gezeiten-Wechsels von Ebbe und Flut als angeblich „menschverursacht“ eingeredet. Mehr war an angeblichen „Beweisen“ in dieser Film-Sequenz nicht auszumachen. Oder sehen Sie, lieber Blog-Leser, das anders?

Zur Erinnerung:

Im Herbst 2013 hatte das Schweizer Fernsehen in einer TV-Dokumentation in ähnlicher Weise wörtlich behauptet, ein Dorf auf einer Südsee-Insel von Kiribati sei angeblich durch den Klimawandel zerstört worden. Unsere Beschwerde beim SRF-Ombudsmann hatte damals die korrekten Zusammenhänge und Ursachen ans Licht gebracht.

Hinzu kommt, dass die aktuelle Behauptung vom 26.04.2017 in der SRF1 RUNDSCHAU,

das Wasser würde bis [zum Jahr] 2100 um einen Meter ansteigen

KEINE PROGNOSE ist, sondern faktisch (!) ein Computerszenario in Form einer szenarienbedingte Projektion, die in einem linear-mathematisch-programmiertem Computerklimamodell eingegeben worden ist, in dem CO2 ein maßgeblicher Parameter (Variable) ist. In der Realität, d.h. auf der Erde, konnte ein solcher Temperaturanstieg bedingt durch CO2 noch nicht nachgewiesen werden. Der angebliche „Temperaturanstieg“ durch CO2 findet nur in Computerklimamodellen statt.

Und: Wir haben in unseren zahlreichen Videos schon mehrfach durch einschlägige Zitate der Klima(folgen)forschung belegt und dokumentiert, dass auch die offizielle Klima(folgen)forschung bestätigt und zugibt, dass KEINE KLIMAPROGNOSEN erstellt werden. Das gilt auch für ein Szenario (= Computerspiel) eines angeblichen Meeresspiegelanstiegs bis zum Jahr 2100.

Und die „Krönung“ der #FakeNews:

Bei Minute 02:09 behauptet dann die weibliche Offstimme:

Die beiden sind immer wieder perplex, wie viele Leute nicht an die Mitschuld des Menschen am Klimawandel glauben. Dass sie z.B. die Werte von Messstationen ignorieren. Als Beamter muss Bob sich aber vorsichtig äußern.

Und Bob Johnson behauptet dann noch ab Minute 02:25 mit der Messstation im Hintergrund:

Wir müssen es halt immer wieder erklären. Wenn jemand DAS HIER sieht, ist es schwierig alles zu leugnen.

Frage von einem kritischen, halbwegs-intelligenten Zuschauer:

Wann und wo wurden denn am 26.04. im TV-Bericht von Peter Düggeli die angeblichen „Messwerte der Messstationen“ gezeigt, die von der weibliche Offstimme ab Minute 2:09 erwähnt wurden?

Der TV-Beitrag zeigt stattdessen parallel zu diesem obigen Zitat „Messwerte der Messstationen“ nur eine im Wasser stehende Messstation, ohne aber zusätzlich statistische Datenreihen von dieser Messstation dem Zuschauer zu zeigen, die eindeutig belegen können, dass der Meeresspiegel in den letzten Jahren und Jahrzehnten an dieser Stelle oder in den gesamten Everglades bzw. an den Küsten Floridas angestiegen ist.

Die Einblendung eines solchen Belegs mit einer glaubwürdigen Messreihe wäre die elementarste journalistische Pflicht und Aufgabe des TV-Journalisten Peter Düggeli und letztendlich auch der verantwortlichen SRF1 RUNDSCHAU-Redaktion rund um Sandro Brotz gewesen, anstatt dem Zuschauer lediglich das Standbild einer in den Everglades stehenden Messstation zu zeigen und dem Zuschauer zu suggerieren, damit wäre der Beweis erbracht, dass der Mensch eine angebliche (Mit-)schuld am CO2-Klimawandel hätte.

Hallo?

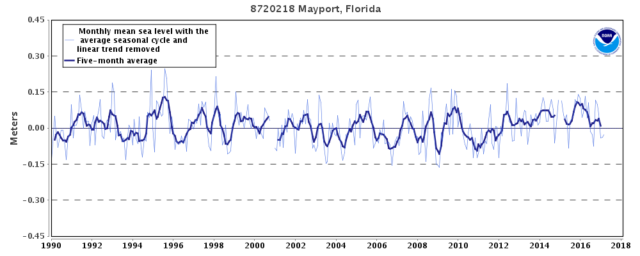

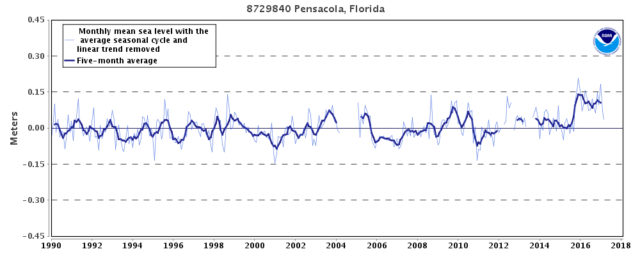

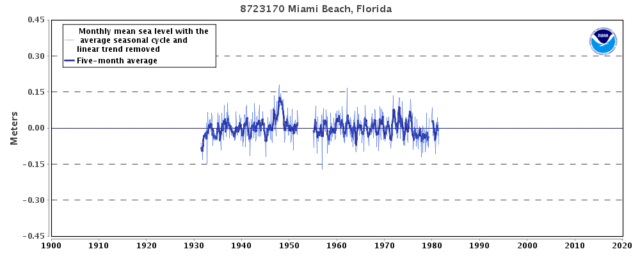

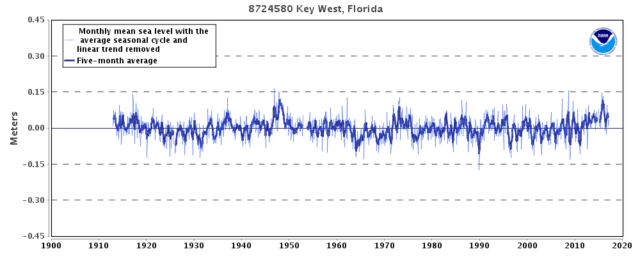

Wir haben haben daraufhin selbst im Internet Messreihen über die Pegelstände in Florida in den letzten 27 Jahren recherchiert und haben festgestellt, dass definitiv seit mindestens 27 Jahren, seit 1990, kein Meeresspiegelanstieg an Floridas Messstationen festzustellen ist:

Recherchieren Sie selbst: Weitere Messstations-Grafiken aus Florida bei dieser Quelle (Aber Achtung: Lassen Sie sich dort nicht durch die Trendgrafiken täuschen).

Die SRF „RUNDSCHAU“-Redaktion würde gut daran tun, wenn sie eine mindestens 30-jährigen Messreihe mit Messwerten der im TV-Beitrag eingeblendeten Messstation vorlegen könnte…

… ähnlich der drei Grafiken, wie sie – oben zu sehen – von drei Orten in Florida (Mayport, Pensacola, Key West) von unserer Seite ohne großen Aufwand im Internet recherchiert werden konnten.

Danach folgt im SRF1 RUNDSCHAU TV-Beitrag ein sekundenlanges „Trump-Bashing“, wo US-Präsident Donald Trump mit seinen altbekannten Zitaten als angeblicher „Klimaleugner“ dargestellt wird, mit dem abschließenden Zitat der weiblichen Offstimme bei Minute 03:13:

Trump verhöhnt die Wissenschaft, schürt Unglauben und Verwirrung

Danach kommt ein Ken Kimmell von der HARVARD-Universität zu Wort:

Er ist wohl parallel in der „Gewerkschaft für besorgte Wissenschaftler“ und sein O-Ton wird ab Minute 03:24 von der deutschen Offstimmen-Übersetzungen wie folgt übersetzt:

Was ist, wenn die US-Regierung eine Kehrtwende macht und nur die verrückten Wissenschaftler unterstützt, die den Klimawandel anzweifeln und versuchen andere Gründe dafür zu finden? Was, wenn die [US-] Regierung eine Propaganda-Maschine gegen den Klimawandel wird und nichts mehr dagegen unternimmt?

Zu beachten ist, dass Ken Kimmell zu Beginn seines Statements wörtlich gesagt hatte:

The fear I have that the United States government…

und diese Eingangsworte von Ken Kimmell ins DEUTSCHE wie folgt übersetzt wurden:

Was ist, wenn die US-Regierung…

Wollte man von Seiten der SRF RUNDSCHAU-Redaktion die „Angst“ der Wissenschaftler in dieser deutschen Übersetzung ausblenden, dass diese Wissenschaftler, wie Ken Kimmell, „Angst“ um ihre Forschungsgelder haben, wenn nur noch „die Wissenschaftler der Gegenseite“ mit Forschungsgeldern unterstützt werden?

Es wäre noch zusätzlich interessant zu erfahren, was Ken Kimmell im US-amerikanischen Original-Interview anstelle der Begriffe

…verrückte Wissenschaftler…

und

…Propaganda-Maschine…

gesagt hatte. Aber leider sind die amerikanischen Original-Worte aus dem Interview nicht deutlich genug herauszuhören.

Ab Minute 03:50 wurden dann in der SRF1 RUNDSCHAU vom 26.04.2017 Ausschnitte vom sog. „March for Science“ vom 22.04.2017 in Washington DC gezeigt, wo angeblich 40’000 Wissenschaftler „für ihre Glaubwürdigkeit“ und „gegen Trump“ auf die Straße gegangen sind:

Das folgende Zitat bei Minute 04:18 dieses angeblichen Wissenschaftlers ist als „Hohn schlechthin“ zu bewerten, wenn Sie sich in Erinnerung rufen, was wir in den obigen Zeilen über diese aktuelle SRF1 RUNDSCHAU-Berichterstattung vom 26.04.2017 recherchiert haben:

Trump fehlen die Berater, die ihm helfen, wissenschaftliche Fakten zu verstehen. Er bildet sich seine Meinung nur von dem, was er im TV sieht.

Interessant, „was er im TV sieht„: Es wird Trump unterstellt, er würde sich seine Informationen nur aus dem TV holen. Jeder soll sich mal fragen, wie viele „dumme“ Menschen durch diesen grob-fehlerhaften und suggestiven SRF1 RUNDSCHAU-TV-Beitrag vom 26.04.2017 wieder „glauben“ werden, die Everglades würden versinken, wenn wir diese perfiden medialen Suggestionen, „Halbwahrheiten“ und Falschbehauptungen nicht durch diesen Blogtext hier offenlegen und entlarven würden?

Oder auch dieses Zitat dieser angeblichen Wissenschaftlerin beschreibt genau das Gegenteil, was als wissenschaftliche Wahrnehmung festzustellen ist:

Er versetzt den Planeten in Angst und Schrecken. Dagegen kämpfe ich an.

Dabei sind es die Klimawissenschaftler, die seit über 30 Jahren das Horrorszenario einer drohenden Klimakatastrophe heraufbeschwören.

Danach setzt der SRF RUNDSCHAU TV-Beitrag die Berichterstattung in den Everglades fort und die weibliche Offstimme behauptet bei Minute 04:42:

Bob [Johnson] zeigt uns, wie sich die Landschaft wegen des Klimawandels verändert.

Kritische und intelligente TV-Zuschauer werden daraufhin wieder gespannt auf „Beweise“ warten, die den [menschgemachten] Klimawandel belegen. Sie warten vergeblich, denn Bob Johnson zeigt bei Minute 04:50 in die Mangroven- und Sumpf-Landschaft und behauptet:

Dahinten sehen wir Mangroven-Bäume, die mehr ins Landesinnere wandern. Wegen der steigenden Meeresspiegel durchdringt das Salzwasser die Böden. Aus Everglades wird so marines Mündungsgebiet.

Und erinnern Sie sich noch: Die Offstimme behauptete bei Minute 04:42 doch

Bob Johnson zeigt uns …

Außer dem Zeigen von „Mangroven-Bäumen dahinten“ wurde dem Zuschauer nix „Faktisches“ gezeigt, was objektiv einen menschgemachten Klimawandel wissenschaftlich belegen würde. Stattdessen „zeigte“ die SRF RUNDSCHAU wieder nur einen Behauptungs-Monolog eines Bob Johnson.

Und der Autor Peter Düggeli schlug dann bei Minute 05:10 journalistisch geschickt den Bogen nach Miami, in dem er die Frage stellte:

Und was passiert in der Stadt Miami, wenn das Meer steigt?

Bob Johnson antwortete daraufhin:

Wir müssen die Stadt [Miami] verändern. Straßen erhöhen und Wasser zurück ins Meer pumpen.

Daraufhin zeigt die SRF RUNDSCHAU Bilder und Stimmen aus Miami, die die angebliche Bedrohung durch den angeblich steigenden Meeresspiegel belegen würden.

Die weibliche Offstimme behauptet dann bei Minute 06:02 als Zusammenfassung auf diese angebliche „Bedrohung“, zusammen mit Luftbildern auf die Kernstadt Miami:

Miami, allein die Kernstadt hat 500.000 Einwohner. Das Gebiet ist durch den Wasseranstieg bedroht.

Bemerkenswert: Die weibliche Offstimme behauptet „Wasseranstieg“ und eben nicht „Meeresspiegelanstieg“.

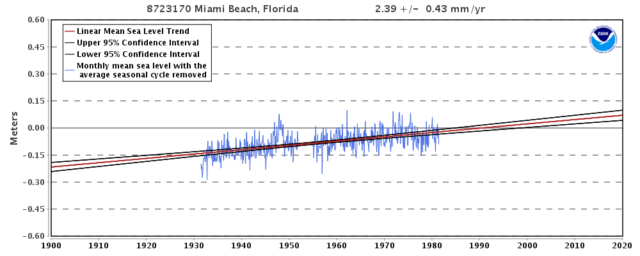

Denn die recherchierbaren Pegelstände über den Meeresspiegelanstieg weisen ebenfalls seit 27 Jahren in Miami Beach keinen Meerespiegelanstieg aus, schauen Sie selbst:

Wohl deshalb hat man dann bereits seit ca. 1983 die Pegel-Messungen in Miami Beach eingestellt. Denn es ist ja auch wohl auch „einfacher“, einen fiktiven Trend durch eine Linie einzutragen und damit zu behaupten, es gäbe angeblich einen Meeresspiegelanstieg, schauen Sie mal:

Kein Witz: Auch diese Grafik mit den Trendlinien können Sie so – mit den von der NOAA eingezeichneten Trendlinien – auf der Webseite der NOAA abrufen. So wird offenkundig durch eine „gewünschte“ Trendlinie ein angeblicher Meeresspiegelanstieg „konstruiert“.

Unglaublich !!

Dieser Sachverhalt war in diesen Tagen ohne viel Mühe im Internet zu recherchieren. In der SRF RUNDSCHAU vom 26.04.2017, die mit Gebührengeldern finanziert wird, erfährt der TV-Zuschauer darüber nix.

Verstehen Sie jetzt, warum Donald Trump auch zurecht darüber nachdenkt, diese merkwürdige Ozean-Behörde NOAA abzuschaffen?

Stattdessen setzt die SRF Rundschau am 26.04. das Klimawandel-Leugner-Bashing gegen die US-Regierung fort und kritisiert nun den neuen Chef der US-amerikanischen Umweltbehörde EPA, Scott Pruitt. Die Offstimme behauptet bei Minute 06:13:

Aber ausgerechnet der Chef der US-Umweltschutzbehörde zweifelt an der maßgeblichen Schuld des Menschen am Klimawandel.

Scott Pruitt wird dann in einem Fernsehinterview – journalistisch ausgewogen – mit seiner kritischen Auffassung ab Minute 06:22 zitiert:

Der Einfluss des Menschen aufs Klima nachzuweisen ist sehr schwierig. Ich glaube nicht, dass er [der Mensch] ein Haupttreiber der globalen Erwärmung ist.

Danach kommen im SRF RUNDSCHAU TV-Beitrag erneut Wissenschaftler, diesesmal aus Chicago, zu Wort, die Trinkwasser analysieren und die angeblich von den 30%-Kürzungen in der US-Umweltbehörde EPA betroffen sein werden. Merkwürdig: Die SRF RUNDSCHAU lässt nun Umweltwissenschaftler (!), die Trinkwasser analysieren, zu Wort kommen, obwohl Trumps Kritik an der EPA sich vornehmlich gegen überbordende Klimaschutz-Maßnahmen richtete. Die SRF RUNDSCHAU wirft also „Umweltschutz“ und „Klimaschutz“ fälschlich in einem Topf. Das gipfelte dann in der Erwähnung eines Trinkwasser-Skandals in der US-amerikanischen Stadt Flint, wo vor Jahren Trinkwasser durch Blei vergiftet worden war. Der intelligente TV-Zuschauer fragt sich zurecht:

Was hat so ein Umweltskandal um verseuchtes Trinkwasser mit „Global Warming“ zu tun?

06:56 Peter Düggeli (Mitte) mit den beiden EPA-Umweltwissenschaftlern Wayne Wipple (rechts) und Frank Lagunas (links)

Es ist dadurch deutlich erkennbar, wie die SRF RUNDSCHAU dem TV-Zuschauer zu suggerieren versuchte, die Klima(folgen)forscher würden in der gleichen löblichen Art und Weise agieren, wie die beiden Trinkwasser-Analytiker aus Chicago, die den Trinkwasserskandal in der Stadt Flint aufgedeckt haben.

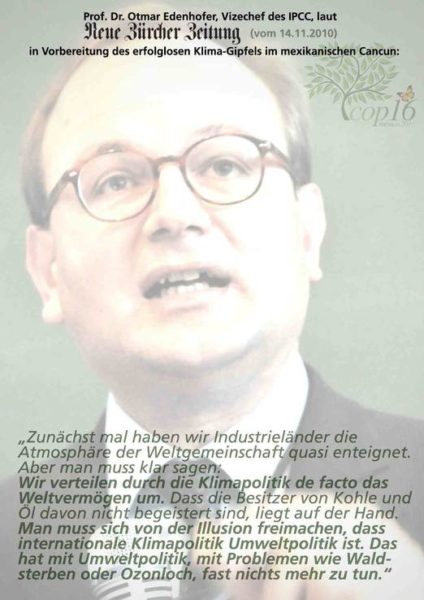

Die Realität und die „Aufgabe“ der Klima(folgen)forschung sieht aber vollkommen anders aus, was auch schon Ottmar Edenhofer vom PIK in Potsdam bereits vor Jahren zugegeben und bestätigt hatte:

Ottmar Edenhofer wiederholte seine obige These über das „Umverteilen von Weltvermögen per Klimaschutz“ auch noch einmal im Februar 2011.

Die SRF RUNDSCHAU ließ dann am 26.04.2017 durch einen O-Ton die Behauptung verbreiten, die von Donald Trump geplanten Kürzungen bei der EPA würden in Zukunft die Aufdeckung solcher Umweltskandale nahezu unmöglich machen.

Frank Lagunas von der EPA, Chicago behauptet bei Minute 07:55:

Zu wissen, dass Leute krank werden können, oder sogar sterben, nur weil Budgetkürzungen unsere Mittel einschränken, das ist herzzerreißend.

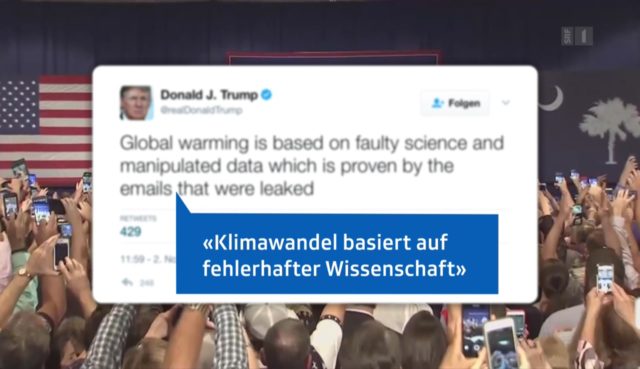

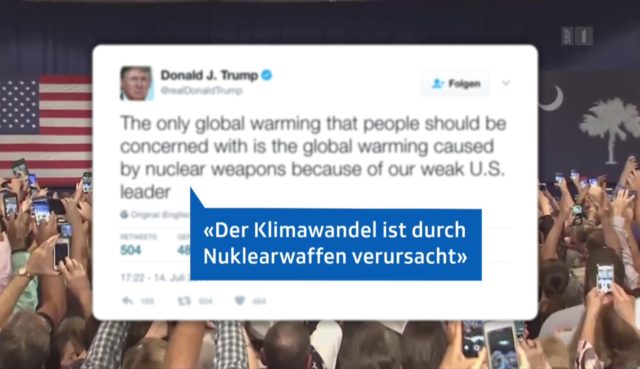

Dann werden von SRF RUNDSCHAU drei ehemalige Twitter-Behauptungen von Donald Trump eingeblendet, die sich aber in Gänze auf Kritik an der Klimawissenschaft beziehen:

Beachten Sie:

„Global Warming“ in den Twitter-Meldungen von Donald Trump wurde von der SRF RUNDSCHAU-Redaktion durchweg fälschlich ins Deutsche mit „Klimawandel“ übersetzt.

Die Behauptung/These, die US-amerikanischen Atomwaffentests nach dem 2. Weltkrieg hätten Einfluss auf das Klima gehabt, gab es wirklich. Und es wurde von „Klimapapst“ Schellnhuber auch schon mit dem 2. Weltkrieg als mögliche Erklärung für die globale Abkühlung von 1945 bis 1965 spekuliert:

Die weibliche Offstimme behauptet dann zum Ende des sehr beanstandungswürdigen SRF RUNDSCHAU-Beitrages von Peter Düggeli, während die Kamera über die schöne Sumpf-Landschaft der Everglades fährt:

Umwelt und Natur in den Everglades. In Amerika. In dem ganzen Globus. Sie sind jetzt auch dem Klimaskeptiker Trump ausgeliefert.

Fazit:

Übelste Klimawandel-Propaganda in der SRF RUNDSCHAU am 26.04.2017

Fassen wir noch einmal die oben im Detail geschilderten Kritikpunkte in Kurzform zusammen:

-

Fälschliche Suggestion in der Anmoderation durch Sandro Brotz, es gäbe in den Everglades (Florida) angeblich Beweise für den menschgemachten Klimawandel. Denn die von Sandro Brotz suggerierten „Fakten“ entpuppen sich im TV-Bericht von Peter Düggeli dann als „Konjunktive“ und subjektive „Zukunftsszenarien“.

-

Behauptungen (Szenarien) über einen angeblichen Meeresspiegelanstieg bis zum Jahr 2100 werden fälschlich als „Prognosen“ bezeichnet.

-

Küstenerosionsvorgänge, die nur als natürliche Ebbe- und- Flut-Vorgänge auszumachen sind, werden suggestiv als „vom Klimawandel verursacht“ ausgewiesen.

-

Anstatt glaubwürdige Pegelstatistiken über einen angeblichen Meeresspiegelanstieg vorzulegen, wird nur ein Standbild einer Everglades-Messstation gezeigt.

-

„Klimaschutz“ wird fälschlicherweise mit „Umweltschutz“ gleichgesetzt.

-

Mehrere (bewusst?) falsche Übersetzungen aus dem Amerikanischen ins Deutsche.

Wir informieren über diesen Blogtext auch Sandro Brotz und die RUNDSCHAU-Redaktion. Wir erwarten bis zum 7. Mai 2017 eine dezidierte Stellungnahme durch die SRF RUNDSCHAU Redaktion, bevor wir über weitere Schritte (Beschwerde beim SRF OMBUDSMANN) entscheiden werden. Die 20-Tagesfrist für eine solche Ombudsmann-Beschwerde läuft am 16. Mai 2017 ab.

Sollten wir eine Stellungnahme der SRF RUNDSCHAU REDAKTION erhalten, werden wir hier in unserem Blog darüber informieren.

Es steht jedem Leser dieses Blogtextes frei, ebenfalls jederzeit eine Beschwerde beim Schweizer Ombudsmann einzureichen.

————————————————–

Dieser Beitrag wurde übernommen von: https://www.klimamanifest-von-heiligenroth.de/wp/klimawandel-fakenews-in-der-srf-rundschau-am-26-april-2017/