Die Eisheiligen werden immer kälter, Vorschau auf 2017

So behauptete DWD-Vorstand Friedrich noch all die Jahre davor, dass

1) Die Eisheiligen in jüngster Zeit immer wärmer würden, sie seien bald zu Heißheiligen geworden, was die Presse dann gern zum Anlass nahm, um gleich von Schweißheiligen zu reden und

2) Überhaupt seien die Eisheiligen wegen der Klimaerwärmung bald gänzlich verschwunden.

Um diese Aussagen zu unterstreichen, wird meist auf das umfangreiche Archiv des Deutschen Wetterdienstes verwiesen. Das erweckt natürlich bei unseren unkritischen Medien Eindruck. Aber niemals wird irgendeine Temperaturgrafik gezeigt und schon gar nicht die Aussagen überprüft.

Wir wollen das im Voraus tun, damit der Leser weiß, worum es gehen wird ab dem 11.Mai und was wahr und falsch ist.

Wir wählen zur Betrachtung möglichst wärmeinselarme Stationen, also nicht Frankfurt-Land, denn die Station steht bekanntermaßen an den Landebahnen des Großflughafens im Strahle der 600 C heißen Abgase. In den Heizräumen unserer Häuser ist am Thermometer bekanntermaßen auch kein Eisheiliger feststellbar.

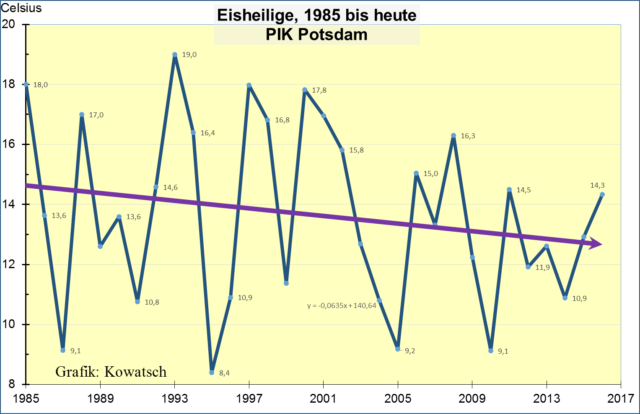

Die ersten beiden Grafiken beginnen 1985 und wir lassen Platz für den 2017er-Wert, damit der Leser die neuen Werte einordnen kann.

Grafik 1: Die fünf Eisheiligentage in Potsdam wurden seit 1985 eindeutig kälter. Das ist genau das Gegenteil dessen, was als Ankündigung der Eisheiligen in den Medien steht.

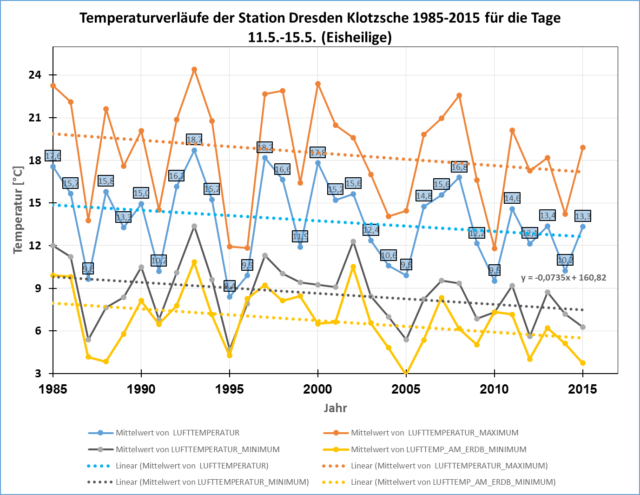

Die zweite Grafik kommt aus Dresden Klotzsche, genauso wie Potsdam eine offizielle Messstation des Deutschen Wetterdienstes. Herr Samuel Hochauf hat neben dem Temperaturmittel der fünf Tage in Blau auch noch die Maximaltemperaturen, die Minimumtemperaturen und auch die Minimumtemperaturen in Bodennähe (5cm) seit 1985 dargestellt bis 2015. Der fünf Tagesmittel der Eisheiligen für 2016 betrugen 12,88C, genau auf der Fortsetzung der blauen Linie. Die Grafik scheint zunächst etwas unübersichtlich, dem ungeübtem Betrachtet sei empfohlen, zunächst mit der blauen Betrachtung zu beginnen, das sind die üblichen Durchschnittstemperaturen der Eisheiligen seit 1985

Grafik 2: DWD-Station Dresden Klotzsche. Man betrachte zunächst Blau: In Blau sind die fünf Eisheiligentagesmittel dargestellt. In Braun die Tages-Maximaltemperaturen, in Grau die Minimaltemperaturen und in Gelb die Minimumtemperaturen in 5 cm-Bodennähe.

Auswertung: Die Minimumtemperaturen (gelb) in Bodennähe sind die kältesten und die Maximumtemperaturen (braun) die wärmsten. Wichtiger ist der Blick auf die Trendlinien: Die Trendlinien sind sich sehr ähnlich, sie sind nur parallel verschoben. Im Gegensatz zu manchen Vermutungen scheint es unwesentlich zu sein, welche Temperatur der Eisheiligen dargestellt werden. Alle vier Trendlinien zeigen, dass die Eisheiligen seit 1985 kälter und nicht wärmer wurden. Alle vier Trendlinien zeigen, dass die Aussagen der DWD-Führungsriege falsch sind. Die Eisheiligen werden kälter in Deutschland.

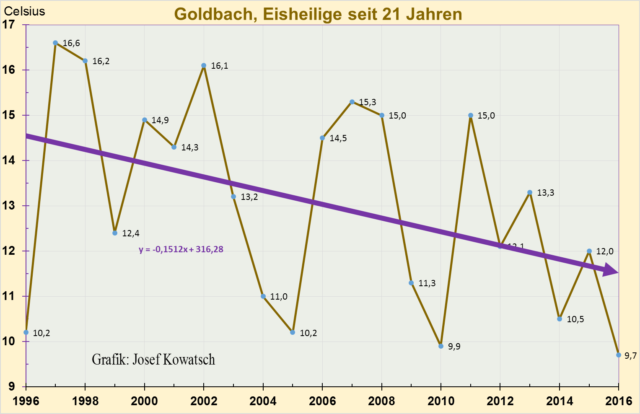

Und schließlich Goldbach bei Bischofswerda, die Klimastation gibt es erst seit 1996, aber auch dort werden die Eisheiligen kälter. Die ungenauen Angaben der DWD-Vorstände mit „in jüngster Zeit“ oder „in der „Gegenwart“, könnte man vielleicht die letzten 20 Jahre meinen. Aber auch in jüngster Zeit ist das Ergebnis eindeutig, die Eisheiligen werden kälter. Je kürzer der Betrachtungszeitraum, desto fallender die Trendlinien. Fallende Temperaturtrendlinien sind das genaue Gegenteil von Erwärmung. Und damit können die Eisheiligen in jüngster Zeit auch nicht zu Heißheiligen geworden sein. Wir bitten die Leser, bei entsprechenden Falschmeldungen sofort bei ihren Tageszeitungen aktiv zu werden.

Grafik 3: Auch in dem kleinen Ort Goldbach werden die Eisheiligen in der Gegenwart kälter. Man darf gespannt sein, wo sich 2017 einordnet.

Dieses Jahr erwarten wir von DWD Vorstand Friedrich vor dem 11. Mai folgende Eisheiligen-Pressemitteilungen: „ Der Monat Mai wird kälter, aber die Eisheiligen werden noch kälter.“ Und als Ergänzung: Die Eisheiligen werden bald wieder so kalt sein wie um die Jahrhundertmitte als die damaligen Klimaforscher eine neue Eiszeit befürchteten. Das war vor 60 Jahren.

Was könnten die Gründe sein für das Kälter werden der Eisheiligen seit über 20 Jahren?

Wir wissen, dass unter anderem die Sonnenaktivität die Häufigkeitsverhältnisse der Großwetterlagen (GWL) beeinflusst; auch die AMO könnte hierbei eine Rolle spielen. Die seit 2 Jahrzehnten nachlassende Sonnenaktivität mit der (noch) bestehenden AMO- Warmphase scheint zu Witterungsextremen neigende Meridionallagen, welche im Frühling ohnehin besonders häufig auftreten, zu begünstigen, während die ausgleichend wirkenden Zonallagen (Westwetterlagen) seltener werden. Im „Horror- Frühling“ 2017 mussten wir das schon reichlich erleben – erst die angenehme Wärme bei Südwetter Ende März/Anfang April; dann die Nordlagen mit Horrorkälte, Schnee und schweren Spätfrostschäden ab Mitte April. Bei einer typischen „Eisheiligen-Lage“ befindet sich ein Hochdruckgebiet über den Britischen Inseln, der Nordsee und/oder dem Nordmeer; manchmal dehnt es sich bis nach Skandinavien aus. Zwischen ihm und tieferem Luftdruck über Ost- und Südeuropa fließt dann arktische Luft nach Deutschland, die bei nächtlichem Aufklaren oft noch Fröste verursacht. Auch 2017 besteht diese Gefahr; zum Zeitpunkt der Fertigstellung dieses Beitrages am 3.Mai war die Sicherheit der Mittelfrist-Prognosen aber noch ungenügend. Eine typische Eisheiligen-Lage erlebten wir 2016:

Abbildung 1: Nordlage am 14. Mai 2016. Tagsüber wurden kaum mehr als 10 bis 13 Grad erreicht; in den Mittelgebirgen gab es Schnee- und im Flachland Graupelschauer. Größere Frostschäden blieben aber aus, weil die Luftmasse (Arktische Meeresluft) relativ wolkenreich und der Wind stark war, so dass die nächtliche Abkühlung moderat ausfiel.

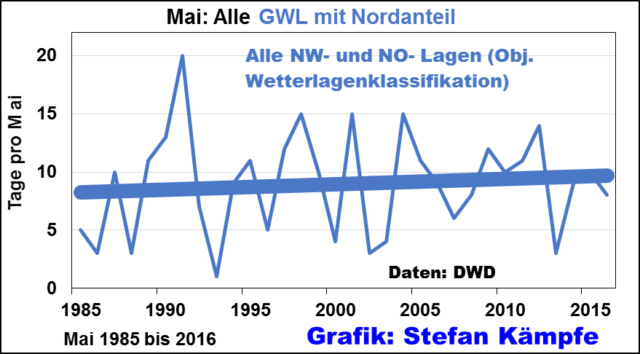

In dem hier gewählten kurzen Untersuchungszeitraum ab 1985, welcher wegen der starken Streuung der Häufigkeiten der Großwetterlagen keine signifikanten Aussagen zulässt, nahm die Häufigkeit der Nordlagen im Mai leicht zu, was eine höhere Wahrscheinlichkeit für deren Auftreten auch im Mai bedeutet:

Grafik 4: Seit 1985 nahm die Häufigkeit der Nordwetterlagen (hier die Objektive Wetterlagenklassifikation des DWD) im Mai leicht (nicht signifikant) zu. Im ungemütlichen Mai 1991 herrschte an 20 Tagen „Nordwetter“, was „Dauer- Eisheilige“ zur Folge hatte; es musste den ganzen Monat hindurch geheizt werden.

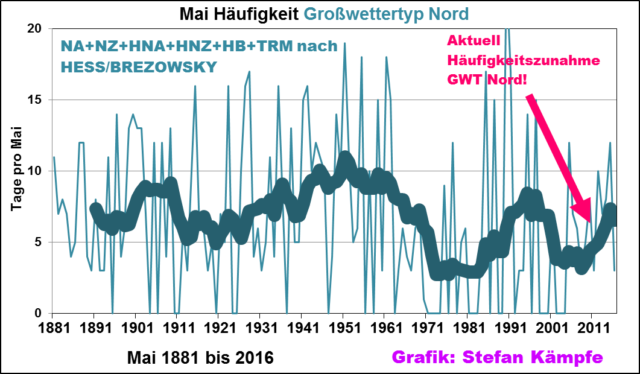

Für längerfristige Betrachtungen stehen seit 1881 nur die GWL nach HESS/BREZOWSKY zur Verfügung:

Grafik 5: Die Häufigkeit des „Nordwetters“ im Mai schwankte enorm; doch auch bei dieser langfristigen Betrachtung erkennt man eine Häufigkeitszunahme ab etwa 2010, was auch die Wahrscheinlichkeit für „Eisheiligen- Ereignisse“ wieder erhöht; ob diese unerfreuliche Entwicklung anhält, muss aber noch abgewartet werden.

Und am Ende zeigt sich: Die stetig steigende CO2- Konzentration vermag unser Klima auch im Mai nicht zu erwärmen und kann die Plage der „Eisheiligen“, den Horror aller Gärtner und Landwirte, nicht verhindern.

Fazit: Kaltluftvorstöße im Mai, welche bevorzugt (aber nicht immer) um die Eisheiligen auftreten, werden immer kälter.

Josef Kowatsch, unabhängiger, weil unbezahlter Natur- und Klimaforscher

Stefan Kämpfe, Diplom- Agrar- Ingenieur, unabhängiger Natur- und Klimaforscher