Aus Paris-Abkommen aussteigen ist richtige Entscheidung für die USA und die Welt

Das Paris-Abkommen und die damit verbundenen Prozesse müssen vollständig aufgegeben werden. Stattdessen muss ein neuer Prozess gestartet werden, welcher frei ist vom Stigma der Korruption, welche das bestehende Pariser Abkommen und dessen Auswirkungen durchzieht.

Das Pariser Abkommen ist ein Programm auf der Grundlage einer vollkommen ungeeigneten Wissenschaft, wie das IPCC inzwischen auch eindeutig eingeräumt hat. Der Prozess des Abkommens ist ausschließlich getrieben von der Politik des Klima-Alarmismus‘.

Im AR3 des IPCC aus dem Jahr 2001 wurde festgestellt, dass es unmöglich ist, Klimamodelle zu erschaffen, welche das globale Klima akkurat abbilden, kam es doch zu dem Ergebnis „Bei der Klimaforschung und -modellierung sollten wir erkennen, dass wir es mit einem gekoppelten, nicht linearen und chaotischen System zu tun haben und dass daher die Vorhersage zukünftiger Klimazustände nicht möglich ist“.

Der jüngste Zustandsbericht AR5 stützt sich auf diese ungeeigneten Klimamodelle und versucht, die Unzulänglichkeit zu verstecken, indem man sich eines Taschenspielertricks bedient, nämlich einer „geschätzten Wahrscheinlichkeit“ [assessed likelihood] sowie Vermutungen und Spekulationen, um einen falschen Grad an Gewissheit bzgl. erwarteter Klimaereignisse vorzugaukeln, welche von wissenschaftlich etablierten und mathematisch abgeleiteten Wahrscheinlichkeiten nicht gestützt werden.

Die Provisionen des Paris-Abkommens, welche sich auf Klima-„Modelle“ stützen, sind eindeutig ungeeignet. Wissenschaftliche Vermutungen werden fälschlich zu Gewissheiten gemacht, obwohl auch sie eindeutig als falsch und gescheitert erkannt worden sind. Dokumentiert wird dies durch eine Anhörung vor dem Kongress im März 2017.

Curry: Computer-Prophezeiungen bzgl. Klima-Alarm sind betrügerisch

Neue Studie erklärt inhärenten Betrug von Computermodellen, welche den zukünftigen Klimawandel prophezeien.

London, 21. Februar: Behauptungen, denen zufolge der Planet durch eine vom Menschen verursachte globale Erwärmung bedroht ist, basieren auf einer Wissenschaft, welche ungeeignete Computer-Modellierungen zur Grundlage hat. Das ist die Schlussfolgerung einer neuen Informationsschrift, welche die GWPF heute veröffentlicht hat.

Die Autorin der Schrift, die bekannte amerikanische Klimatologin Prof. Judith Curry erklärt, dass sich der Klima-Alarm auf hoch komplexe Computer-Simulationen des Klimas der Erde stützt.

Aber obwohl Wissenschaftler Jahrzehnte lang Zeit und Mühe aufgewendet haben, müssen diese Simulationen immer noch „frisiert“ werden, um zum ralen Klima zu passen. Dies macht sie im Wesentlichen nutzlos für den Versuch, welche Ursachen Änderungen des Klimas haben, und unzuverlässig zur Ausgabe von Vorhersagen, was in Zukunft geschehen wird.

Die Klimawissenschaftlerin Dr. Judith Curry führte bei ihrer Anhörung vor dem Wissenschaftskomitee des Weißen Hauses im März 2017 aus, wo sie die fundamentalen Fehler in den Klimamodellen sieht:

Einschätzung von Klimamodellen

Im kürzlich erschienenen Report [übersetzt] ,Klimamodelle für Laien‘ beschrieb ich, wie Klimamodelle nützlich sein können für Forschungen zum besseren Verständnis des Klimasystems.

Allerdings argumentierte ich, dass gegenwärtige globale Klimamodelle nicht geeignet sind für das Ziel, die Gründe der jüngsten Erwärmung einzuordnen oder für die Vorhersage globaler und regionaler Klimaänderungen in Zeitskalen von Jahrzehnten und Jahrhunderten. Zu den Bedenken der Brauchbarkeit von Klimamodellen gehören:

● Vorhersagen der Auswirkungen eines zunehmenden CO2-Gehaltes auf das Klima können nicht für Jahrhunderte im Voraus sicher evaluiert werden.

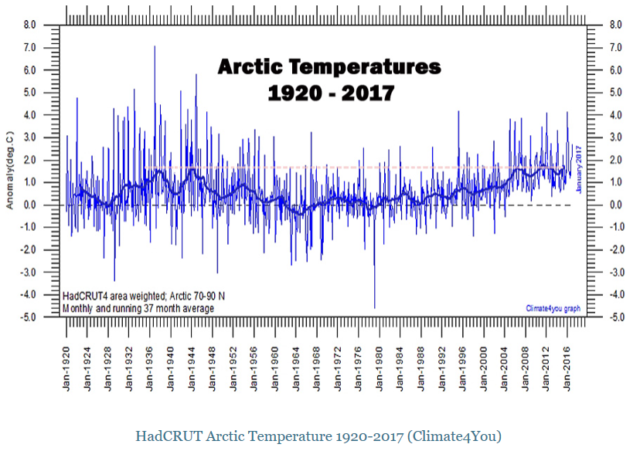

● Der Fehlschlag der Klimamodelle hinsichtlich einer konsistenten Erklärung der Erwärmung zum Beginn des 20. Jahrhunderts und die nachfolgende Abkühlung zur Mitte des Jahrhunderts.

● Unfähigkeit der Klimamodelle, Größenordnung und Phase der großräumigen Ozean-Oszillationen im Zeitmaßstab von Jahrzehnten und Jahrhunderten zu simulieren.

● Unzureichende Erkundung der Unsicherheiten in den Klimamodellen.

● Die extrem große Anzahl willkürlicher Auswahl von Modellparametern und Parametrisierungen.

● Evaluierung der Klimamodelle gegenüber den gleichen Beobachtungen, die für die Feinabstimmung der Modelle herangezogen worden sind.

● Bedenken hinsichtlich eines fundamentalen Fehlens der Vorhersagbarkeit in einem komplexen, nicht linearen System.

Und weiter:

Die Ergebnisse der Klimamodell-Simulationen für das 21. Jahrhundert, welche das IPCC bekannt gemacht hatte, enthalten keine Grundlagen-Elemente der Klima-Variabilität und sind daher nicht brauchbar als Projektionen, wie sich das 21. Jahrhundert entwickelt.

…sie sind nicht nicht geeignet für das Ziel, die Gründe der jüngsten Erwärmung einzuordnen oder für die Vorhersage globaler und regionaler Klimaänderungen in Zeitskalen von Jahrzehnten und Jahrhunderten mit irgendeinem hohen Niveau der Sicherheit.

…sie sind nicht fit für das Ziel, politische Entscheidungen zu rechtfertigen, welche soziale, ökonomische und Energie-Systeme fundamental verändern.

Dr. Curry schließt mit drei Kernaussagen zu den Fähigkeiten der Klimamodelle:

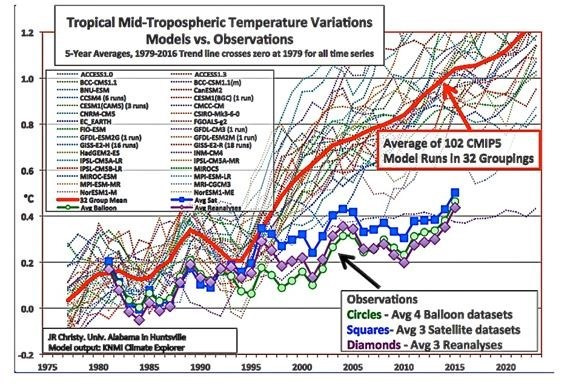

Wenn das „wissenschaftliche Verfahren“ auf den Output von Klimamodellen wie im AR5 des IPCC dargestellt angewendet wird, vor allem hinsichtlich der großen atmosphärischen Temperaturtrends seit 1979 (eine Grundsatz-Variable mit einer starken und offensichtlichen Reaktion auf zunehmende Treibhausgase während dieses Zeitraumes) zeige ich, dass der Konsens der Modelle bei dem Test gegenüber den Beobachtungen in der realen Welt auf signifikante Weise durchfällt.

Der Klimawissenschaftler Dr. John Christy sagte ebenfalls bei der Anhörung vor dem Wissenschaftskomitee aus. Er stellte das wissenschaftliche Verfahren vor, die Glaubwürdigkeit der Temperaturprojektionen der Klimamodelle gegenüber tatsächlich gemessenen globalen Temperaturen zu evaluieren. Er kam zu dem Ergebnis:

Die Temperaturprojektionen der Klimamodelle zeigten im Vergleich zu den tatsächlich gemessenen globalen Temperaturen, dass die Modelltheorie nach Strich und Faden gescheitert ist, und zwar mit einem Vertrauensniveau über 99%.

Die Aussage von Dr. Curry vor dem Komitee hinsichtlich der extensiven Fehlschläge der Klimamodelle passte zu den Ausführungen von Dr. Christy hinsichtlich der außerordentlich schlechten Performance dieser Klimamodelle in Übereinstimmung mit dem eigenen Eingeständnis des IPCC, dass es unfähig sei, Klimamodelle zu konstruieren, welche das globale Klima vertrauenswürdig repräsentieren. Dies diktiert eindeutig, dass derartige Modelle als Entscheidungsgrundlage für globale politische Klima-Maßnahmen vollkommen ungeeignet und ungerechtfertigt sind.

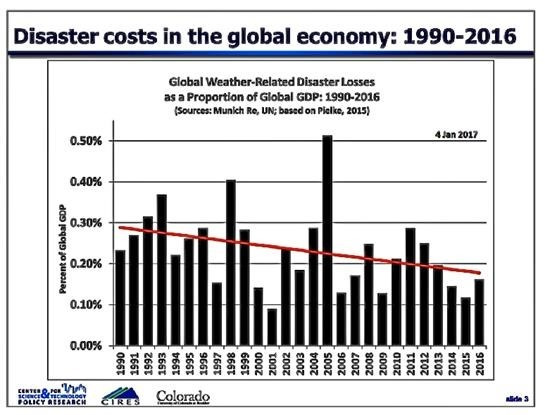

Dr. Roger Pielke, Jr. sprach bei der Anhörung Behauptungen von Klima-Alarmisten an, denen zufolge anthropogene CO2-Emissionen mehr Extremwetter mit sich brächten. In seiner Aussage porträtierte Dr. Pielke folgende Ergebnisse:

Die wissenschaftlichen Beweise als Unterstützung für meine im Jahre 2013 diesem Komitee vorgestellten Schlussfolgerungen sind heute sogar noch stärker. Es gibt kaum eine wissenschaftliche Grundlage für Behauptungen, dass Extremwetter-Ereignisse – im Einzelnen Hurrikane, Überschwemmungen, Dürren, Tornados – nebst deren ökonomischen Schäden während der letzten Jahrzehnte zugenommen haben aufgrund von Treibhausgasen. Tatsächlich verzeichnete man in den USA und auf der ganzen Welt seit dem Jahr 2013 eine bemerkenswert gute Phase, gab es doch weit weniger Extremwetter im Vergleich zur Vergangenheit.

Das Fehlen von Beweisen zur Stützung von Behauptungen über eine Zunahme von Häufigkeit oder Stärke dieser Extremwetter-Ereignisse wird auch vom IPCC beschrieben sowie in noch größerem Umfang von der begutachteten wissenschaftlichen Literatur, auf die sich das IPCC stützt.

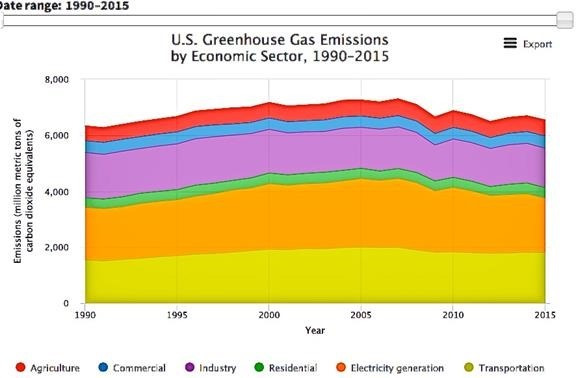

Die USA waren extrem erfolgreich hinsichtlich der Reduktion von Treibhausgasen und CO2-Emissionen. Erreichten diese im Jahre 2007 noch ihr höchstes Niveau, sind sie danach deutlich zurückgegangen dank der Marktvorteile durch Erdgas-Fracking.

EPA-Daten zufolge haben die US-Emissionen im Laufe des Jahres 2015 um über 10% abgenommen und liegen jetzt auf dem Niveau des Jahres 1994. Diese Reduktion ergibt insgesamt 763 Millionen Tonnen weniger Treibhausgas-Emissionen.

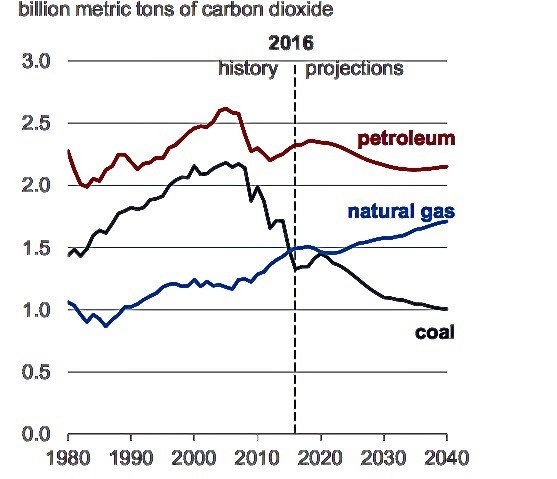

Der gerade veröffentlichte EIA – AEO-Bericht aktualisiert die CO2-Emissionen der USA über das Jahr 2016 und zeigt, dass die Emissionen im Vergleich zu 2015 noch weiter zurückgegangen sind. Er enthält auch die Vorhersage, dass es stabile CO2-Emissionen mindestens bis zum Jahr 2030 geben werde, ohne dass die Vorschriften von Präsident Obama bzgl. seines Krieges gegen die Kohle überhaupt in Kraft sind.

Der Bericht zeigt, dass die Reduktionen des Jahres 2016 sowie zukünftige Emissionen erreicht wurden als Konsequenz der zunehmenden Zuwendung zu billigem, auf dem Energiemarkt erhältlichen Erdgas. Dies lässt den Verbrauch von Kohle-Treibstoff abnehmen mit der weiteren Auswirkung geringerer CO2-Emissionen.

Folglich treiben und kontrollieren die Kräfte des Energiemarktes die Reduktion mittels Fracking von Erdgas, ohne dass die Regierung der Öffentlichkeit unnötige, kostspielige und bürokratisch sehr aufwändige Vorschriften aufbürdet.

Im Jahre 2030 werden die CO2-Emissionen der USA einer Vorhersage der EIA zufolge 5210 Millionen Tonnen betragen (ohne Obamas Clean Power Plan). Dies bedeutet eine Reduktion von 790 Tonnen und liegt um über 14% unter dem Spitzenniveau des Jahres 2007.

Die signifikanten Reduktionen von Treibhausgasen und CO2-Emissionen der USA wurden der Öffentlichkeit seitens der klima-alarmistischen Main Stream Medien und klimaaktivistischen Wissenschaftlern vorenthalten.

Während des gleichen Zeitraumes, also von 2007 bis 2030, als die USA ihre CO2-Emissionen um fast 800 Millionen Tonnen pro Jahr reduzieren, zeigen Daten der EIA IEO der Jahre 2011 und 2016, dass in den Entwicklungsländern der Welt die CO2-Emissionen um über 9900 Millionen Tonnen zunahmen, wobei China und Indien über 5700 Millionen Tonnen zu dieser Zunahme beitrugen.

Die massiven zunehmenden CO2-Emissionen der Entwicklungsländer einschließlich Chinas und Indiens sind laut Präsident Obama nach dem Paris-Abkommen 2015 akzeptabel.

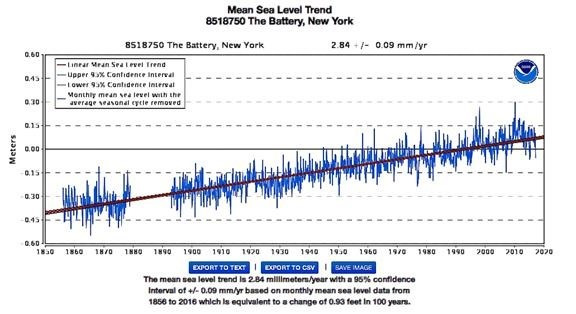

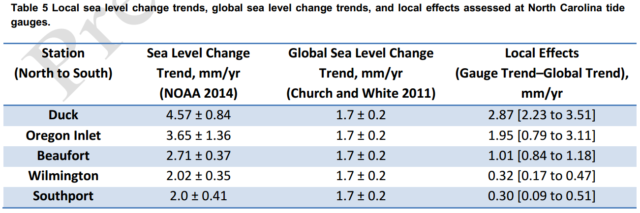

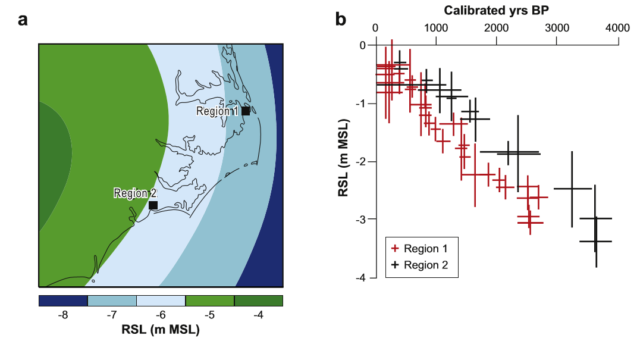

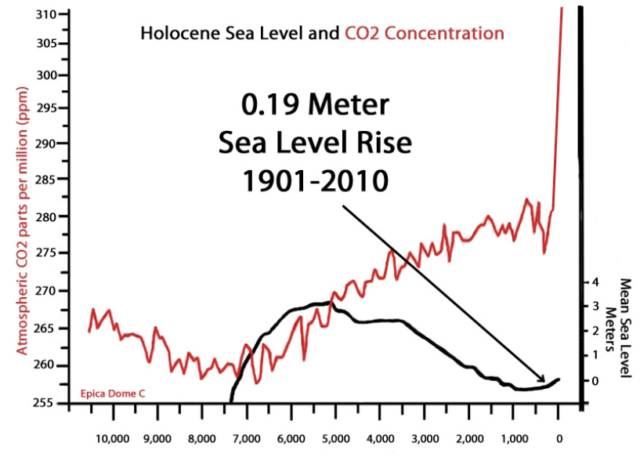

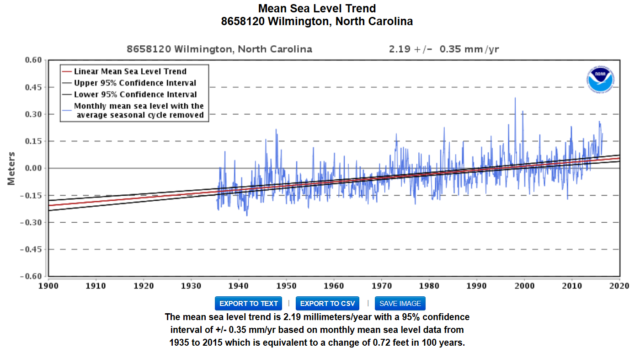

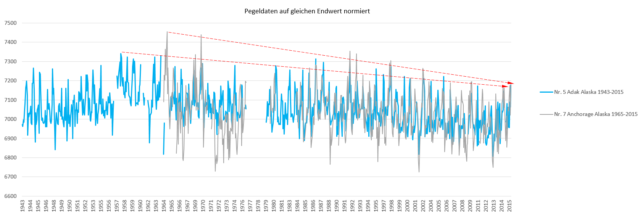

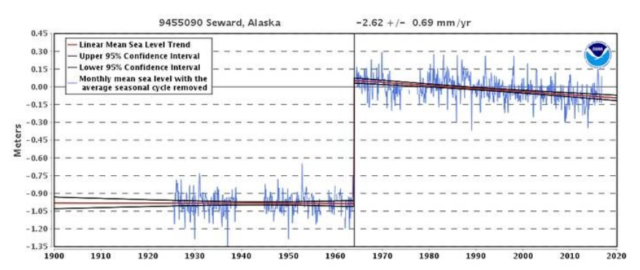

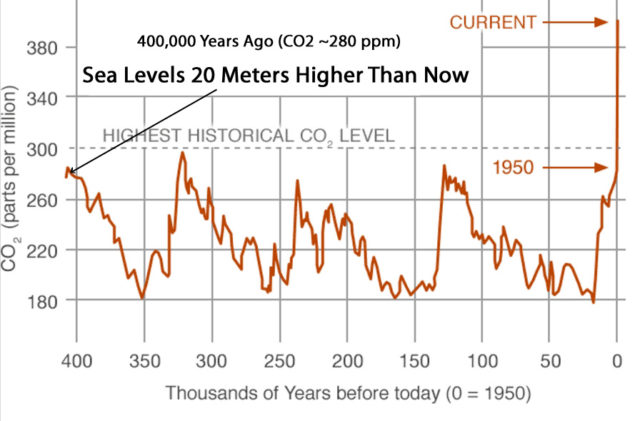

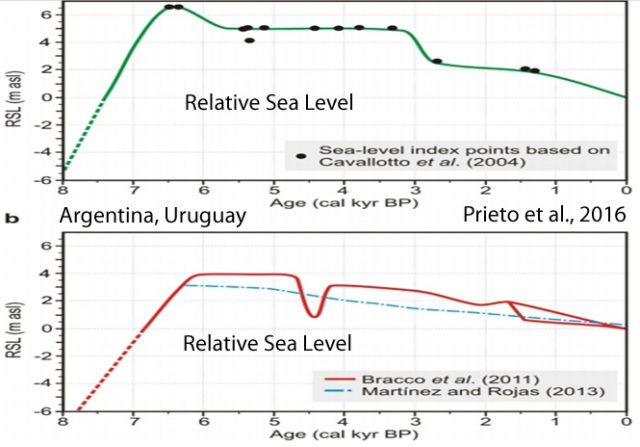

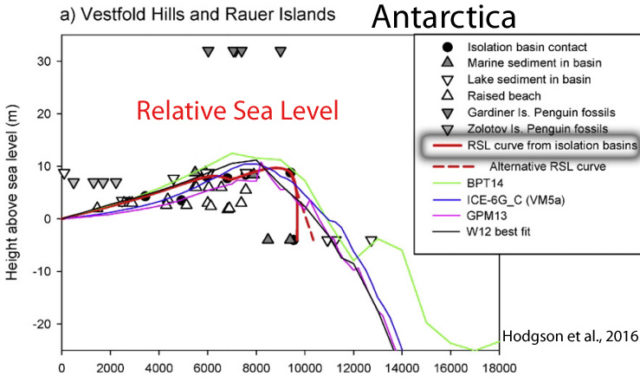

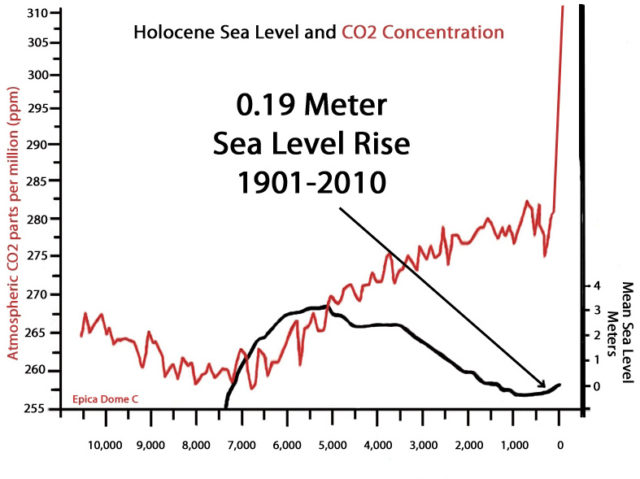

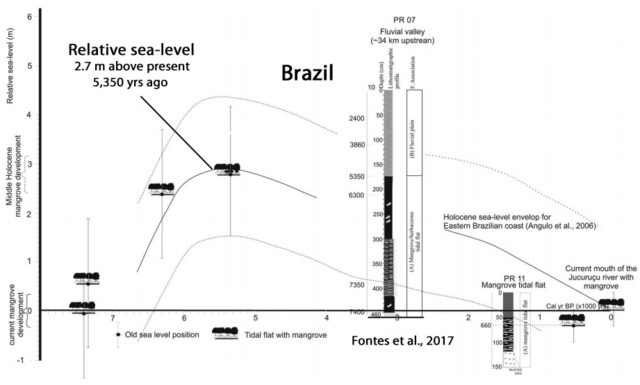

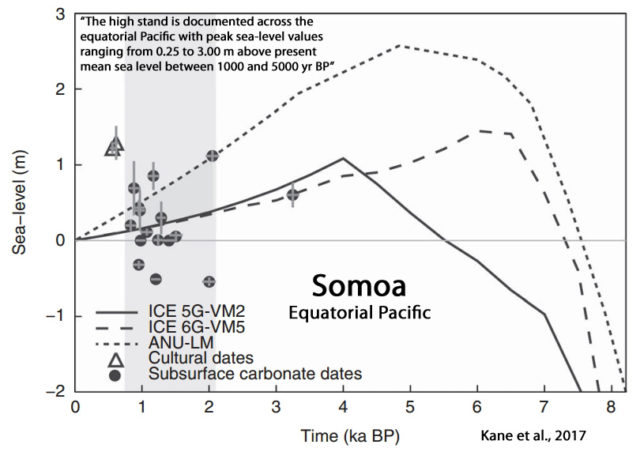

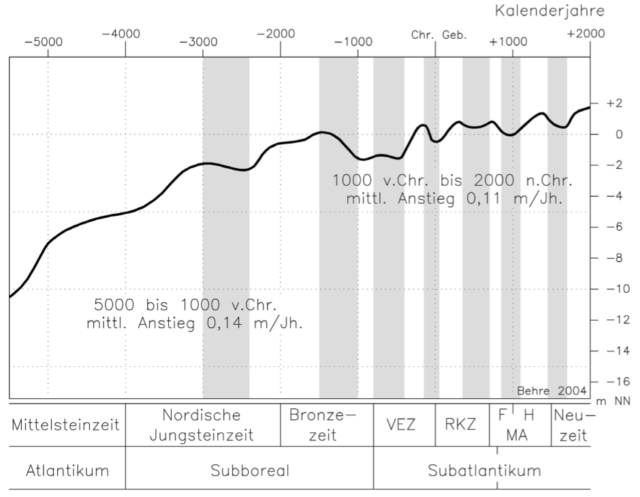

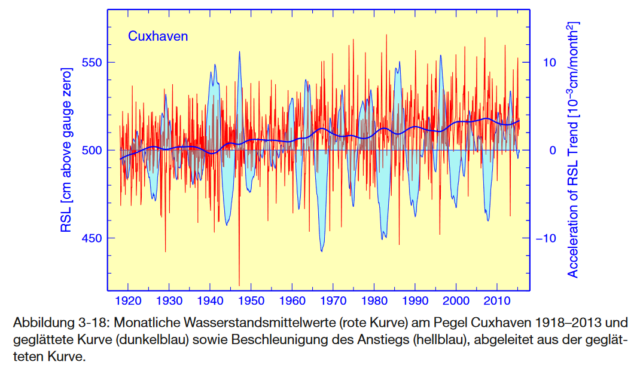

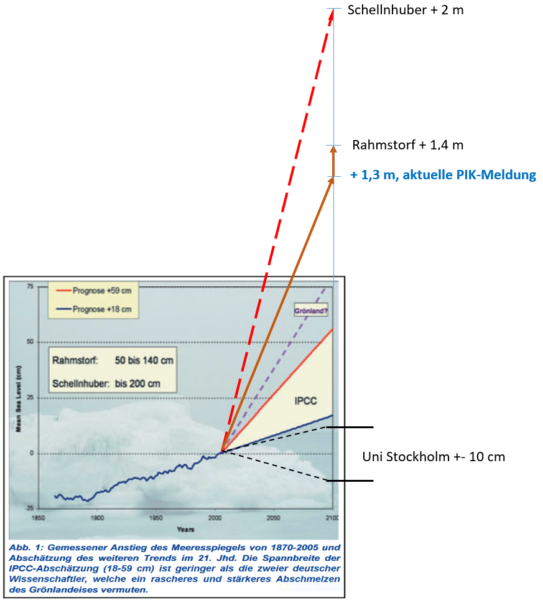

Die NOAA hat jüngst ihre Daten von Tidenmesspunkten bzgl. küstennahem Anstieg des Meeresspiegels einschließlich aktueller Messungen durch das Jahr 2016 aktualisiert. Daraus ergeben sich nach wie vor keinerlei Anhaltspunkte für eine Beschleunigung des Meeresspiegel-Anstiegs an den Küsten.

Diese Messungen enthalten Daten von Tidenmesspunkten an 25 Stellen der Westküste, der Golf-Küste und der Ostküste entlang des Pazifischen, des Atlantischen Ozeans und es Golfes von Mexiko. Außerdem sind Daten von 7 Inselgruppen im Pazifik und 6 im Atlantik enthalten. Insgesamt sind es über 200 Messpunkte.

Die längste Reihe von Tidendaten des küstennahen Meeresspiegels stammt aus The Battery in New York und ist 160 Jahre lang. Die Daten zeigen eine stetige Rate des Anstiegs von etwa 11 Inches [ca. 28 cm] pro Jahrhundert.

Es ist sehr wahrscheinlich, dass es einen substantiellen anthropogenen Beitrag zum mittleren globalen Anstieg des Meeresspiegels während der siebziger Jahre gab. Dies basiert auf dem hohen Vertrauen in einen anthropogenen Einfluss auf die beiden größten Komponenten des Anstiegs, nämlich thermische Ausdehnung und Verlust von Gletschermasse.

In der ,Summary for Policymakers‘ des IPCC-Berichtes AR5 schreibt das IPCC:

„Die NOAA-Messungen an Tidenmesspunkten der Küste umfassen den 46-jährigen Zeitraum von 1970 bis einschließlich 2016. Sie stützen nicht, ja widersprechen sogar, der Schlussfolgerung im IPCC-Bericht AR1 hinsichtlich vermeintlicher Beiträge des Menschen zum Anstieg des Meeresspiegels seit Anfang der siebziger Jahre“.

Zusammenfassung:

Die Klimamodelle zur Stützung des Paris-Abkommens haben sich eindeutig als falsch und gescheitert herausgestellt, was selbst das PCC einräumt.

Behauptungen, wonach menschliche Treibhausgas-Emissionen Extremwetter verursachen (Hurrikane, Dürren, Überschwemmungen, Tornados) werden durch tatsächliche Klimadaten einschließlich der IPCC-eigenen Daten nicht gestützt.

Die USA haben bedeutende Reduktionen von Treibhausgas- und CO2-Emissionen erreicht mittels Hinwendung zur Erdgas-Fracking-Technologie auf dem Energiemarkt und Abkehr von kostspieligen, belastenden und unnötigen Vorschriften der Regierung.

Emissionen der Entwicklungsländer übersteigen bei weitem jene der USA und werden sogar aufgrund des Paris-Abkommens noch weiter steigen.

Die jüngsten verfügbaren Daten der NOAA von Tidenmesspunkten bis einschließlich 2016 zeigen keine Beschleunigung des küstennahen Meeresspiegelanstiegs, was den IPCC-Behauptungen bzgl. anthropogener Einflüsse auf steigende Raten seit den siebziger Jahren diametral widerspricht.

Schlussfolgerung:

Die Wissenschaft im Pariser Klimaabkommen wird von Politik bestimmt und nicht durch eine eindeutig etablierte und verifizierbare Klimawissenschaft.

Die Klimawissenschaftlerin Dr. Judith Curry führte bei der Anhörung vor dem Kongress bzgl. des Jahrzehnte langen Frusts hinsichtlich die Politisierung der Klimawissenschaft sowohl seitens des IPCC als auch der Obama-Regierung aus:

Die Klima-Gemeinde hat seit über zwei Jahrzehnten daran gearbeitet, einen wissenschaftlichen Konsens bzgl. eines vom Menschen verursachten Klimawandels zu fabrizieren, hauptsächlich dadurch, dass sie eine Hypothese zu einer vorherrschenden, absolut richtigen Theorie erhoben hat.

Der nach Konsens trachtende Prozess und deren Verbindungen zur Politik der Reduktion von Emissionen seitens des UNFCCC hatten die unbeabsichtigte Konsequenz einer Hyper-Politisierung der Wissenschaft und der Einbringung eines Bias‘ sowohl in die Wissenschaft als auch in damit in Verbindung stehende Entscheidungsprozesse.

Das Ergebnis dieser grob vereinfachten Darstellung eines verzwickten Problems ist, dass uns die Arten von Informationen fehlen, welche zu einem größeren Verständnis der Klimavariabilität und der gesellschaftlichen Verwundbarkeit beitragen.

Die Politisierung der Klimawissenschaft hat die akademische Klimaforschung und diejenigen Institutionen kontaminiert, welche die Klimaforschung stützen. Deshalb sind individuelle Wissenschaftler und Institutionen zu Aktivisten und zu Befürwortern einer Politik zur Reduktion von Emissionen geworden.

Wissenschaftler mit einer Perspektive, dass dies nicht konsistent mit dem Konsens ist, werden im besten Falle marginalisiert (d. h. sie haben Schwierigkeiten, zu Ergebnissen zu kommen und Studien zu veröffentlichen, die nicht an ,Pförtner‘-Herausgebern der Journale vorbeikommen) und im schlimmsten Falle mit Schimpfwörtern wie ,Leugner‘ oder ,Häretiker‘ belegt.

Dann hat Dr. Curry glasklar den „Krieg gegen die Wissenschaft“ angesprochen, welcher von der klimawissenschaftlich alarmistischen Politik der Regierung während der letzten Jahre vollführt worden ist:

Der ,Krieg gegen die Wissenschaft‘, der mich am meisten besorgt, ist der Krieg von innerhalb der Wissenschaft – von Wissenschaftlern und den Organisationen, welche eine Wissenschaft stützen, die Machtpolitik betreibt mit ihrer Expertise, und welche ihre naiven Prämissen von Risiko und politischen Meinungen als Wissenschaft verkaufen.

Wird der IPCC-Konsens in Frage gestellt oder die Autorität der Klimawissenschaft hinsichtlich der Steuerung der Klimapolitik angezweifelt, nennen diese aktivistischen Wissenschaftler und Organisationen die Zweifler ,Leugner‘ und erklären den Zweifel zum ,Krieg gegen die Wissenschaft‘.

Diese aktivistischen Wissenschaftler scheinen sich weniger Gedanken zu machen hinsichtlich der Integrität des wissenschaftlichen Prozesses als vielmehr um ihre privilegierte Position und ihren Einfluss in der öffentlichen Debatte um Klima- und Energiepolitik.

Sie verweigern sich der wissenschaftlichen Diskussion – und verleumden Wissenschaftler, die nicht mit ihnen übereinstimmen.

Diese aktivistischen Wissenschaftler und Organisationen pervertieren den politischen Prozess und versuchen, die Klimawissenschaft von genauer Überprüfung abzuhalten. Das ist der wirkliche Krieg gegen die Wissenschaft.

Die freiwillig eingegangenen Verpflichtungen bzgl. des Paris-Abkommens 2015 werden Billionen Dollar kosten, um kaum etwas zu tatsächlichen Temperatur-Reduktionen und damit zusammenhängenden Auswirkungen beizutragen.

Es ist absurd seitens der globalen Nationen, Billionen Dollar auszugeben für von der Regierung verordnete Klimamaßnahmen, welche auf falschen und gescheiterten Klimamodell-Projektionen beruhen, welche wiederum die Erzeugnisse von Vermutungen und Spekulationen sind, gekoppelt mit mit einem korrupten politischen Prozess, welcher einen künstlichen „Konsens“ erschaffen hat, um die Wahrheit bzgl. der betrügerischen klimawissenschaftlichen Fähigkeiten zu verstecken.

Die Tatsache, dass all jene, die nach so massiven Ausgaben schreien, so hart daran gearbeitet haben, die außerordentlichen Schwächen der globalen Klimamodell-Simulationen zu verstecken und zu leugnen, zeigt, dass ein massives globales Zusammenspiel der Regierungen von der klimaalarmistischen Gemeinschaft durchdrungen wird, wenn es um die Öffentlichkeit geht.

Klimamodelle mögen nützlich sein für akademische und wissenschaftliche Studien, aber sie sind vollkommen ungeeignet für Zwecke durch Vorschriften getriebener Verpflichtungen, welche Ausgaben in Höhe von Billionen Dollar globalen Kapitals erfordern. Diese Gelder können mit erheblich größerem Nutzen zum Kampf gegen bekannte schwere globale Probleme eingesetzt werden, als da wären Armut, Gesundheitsvorsorge, Bildung usw.

Präsident Trump muss die richtige Entscheidung für die USA und die Welt reffen, indem er das politisch und wissenschaftlich korrupte Paris-Abkommen in die Tonne tritt. Er sollte eine zukünftige Klimapolitik auf etwas richten, was hoffentlich ein neuer Anfang sein wird, frei von monumentalen Stigmen einer „Politisierung der Klimawissenschaft“, welche so schwer das gegenwärtige Paris-Abkommen und damit in Verbindung stehende Prozesse durchdrungen hat.

Link: https://wattsupwiththat.com/2017/05/10/dumping-paris-agreement-right-decision-for-u-s-and-the-world/

Übersetzt von Chris Frey EIKE