Früher war es schlimmes Wetter, heute macht das Gleiche mit Sicherheit der Klimawandel

Wir erleben den Klimawandel …

Mit dieser Meldung setzte die deutsche Wahrheitsagentur dpa wieder ein schlimmes Ereignis des allgegenwärtigen Klimawandels in Szene, pflichtgemäß verbreitet durch unsere Medien wie msn und BERLINER KURIER [3] (sowie vielen anderen Zeitungen).

Dabei geht es um ein Starkregenereignis mit anschließenden Überschwemmungen am 24. Mai in Bad Elster im sächsischen Vogtland, welches von einem berühmten – zumindest wenn man seine Medienpräsenz betrachtet – Meteorologen kommentiert wurde.

msn wetter, Berliner Kurier: [3] Klimawandel-Schock: Rekord-Hitze und heftige Unwetter

… Südlich von Brandenburg haben die Menschen im sächsischen Vogtland … eine wahre Sintflut erlebt: Schier unglaubliche 152 Liter Regen pro Quadratmeter innerhalb von nur zwölf Stunden fielen beispielsweise in Bald Elster, berichtet Diplom-Meteorologe Dominik Jung (wetter.net). Das sind Mengen, die zum einen an die katastrophalen Regenfluten vom vergangenen Sommer in Berlin erinnern – dies war allerdings ein örtlich eingegrenztes …

Wir erleben den Klimawandel

Diplom-Meteorologe Dominik Jung sieht … vor allem aber auch einen klaren Zusammenhang mit dem weltweiten Klimawandel: „In den vergangenen Jahren hat sich die Temperatur vor allen Dingen global erhöht. Warme Luft kann mehr Feuchtigkeit aufnehmen als kühle Luft, ergo kann es auch mehr abregnen und zukünftig zu heftigeren Starkniederschlägen kommen. Genau das erleben wir in diesen Tagen wieder sehr eindrucksvoll.“

Starkregenereignisse taugen nicht als Klimawandelbeleg

Wer bisher die vielen Ausarbeitungen des Autors zu Starkregen in Deutschland verfolgt (wenigstens überflogen) hat, weiß, dass sich anhand von Unwetter und Starkregen in Deutschland kein Einfluss eines Klimawandels belegen lässt. Vor allem gibt es im Sommer keinen Anstieg durch die „stetig steigenden Temperaturen“, wie es überall berichtet (und simuliert) wird. Es zeigt sich bei jeder Analyse nur immer wieder die unglaubliche Variabilität unseres „schlechten Wetters“ und dass es zu den „natürlichen“ (kälteren), vorindustriellen Zeiten noch schlimmer war.

Das hat das Umweltbundesamt ermittelt:

Umweltbundesamt: [8] Monitoringbericht 2015

… Hinsichtlich der Anzahl der Tage mit einer Niederschlagsmenge von mehr als 20 mm im Sommer sind hingegen – in guter Übereinstimmung mit der Entwicklung der mittleren Niederschlagsmengen zu dieser Jahreszeit – über eine auch nur regional und sehr schwach ausgeprägte dekadische Variabilität hinaus bislang keine Änderungen auszumachen …

Und sogar der IPCC gibt es zu und teilt dazu mit:

IPCC 2013, AR5, WGI, Technical Summery, Seite 112: ”There continues to be a lack of evidence and thus low confidence regarding the sign of trend in the magnitude and/or frequency of floods on a global scale over the instrumental record.”

Übersetzung: “Es besteht weiterhin ein Mangel an Beweisen und deshalb ein geringes Vertrauen in Bezug auf Trend-Anzeichen in Bezug auf Größe und / oder Häufigkeit von Überschwemmungen auf globaler Ebene der Instrumenten-Aufzeichnungen.“

Hagel und Gewitter

IPCC 2013, AR5, WGI, Kapitel 2, Seite 216: “In summary, there is low confidence in observed trends in small-scale severe weather phenomena such as hail and thunderstorms because of historical data inhomogeneities and inadequacies in monitoring systems.”

Übersetzung: „Zusammenfassend gibt es [nur] ein geringes Vertrauen in beobachtete Trends bei den Unwetter-Erscheinungen wie Hagel und Gewitter wegen historischen Daten-Inhomogenitäten und Unzulänglichkeiten bei der Systemüberwachung.“

IPCC Zusammenfassung

IPCC 2013, AR5, WGI, Kapitel 2, Seite 219: “There is limited evidence of changes in extremes associated with other climate variables since the mid-20th century.”

Übersetzung: “Es gibt [nur] begrenzte Anhaltspunkte zu Änderungen bei Extremereignissen, die mit anderen Klimavariablen seit der Mitte des 20. Jahrhunderts verbunden sind.“

Ausgewiesene „Fachpersonen“ stört das allerdings nicht. Der Klimawandel muss in Deutschland „angekommen“ sein. Und da es sich mit Messdaten nicht belegen lässt, müssen Zuweisungen von „Klimaexperten“ einfach reichen. Wer als „Experte“ auf öffentliche Gelder oder Medienpräsenz angewiesen ist [4], dem gelingt es problemlos, jedes Unwetter trotz fehlender Vergleichsdaten dem sich wandelnden Klima zuzuschreiben.

EIKE 24.01.2017: [5] Jahrtausendhochwasser am 01.06.2016 in Simbach – so entstehen Menetekel des Klimawandels

EIKE 18.04.2018: Beeinflussungen durch Starkregen nehmen in Deutschland nicht zu. Mit schlecht angewandter Statistik lässt sich aber das Gegenteil „zeigen“ (Teil 2)

In Deutschland bleibt das dann folgenlos. Denn niemand an wichtigen, gar exponierten Stellen unseres Staates oder einer Kommune würde es heute noch wagen, an solchen Aussagen (öffentlich) zu zweifeln, oder nach Belegen zu fragen.

EIKE 25.05.2018: Zu jedem Parteitag eine Freifahrt in der Klima-Geisterbahn

Der Starkregen am 25. Mai bei Bad Elster war ein Extremereignis

Nun war das Ereignis in Bad Elster unbestritten außergewöhnlich. Es ist also nicht uninteressant, nachzuspüren, ob sich darin nicht doch der Klimawandel zeigen könnte.

Das Bild des Tage-Niederschlagsverlaufs von Bad Elster beeindruckt (Bild 1). Seit 1951 bleiben die Maimalpegel in etwa gleich und seit ca. 1971 fallen die Tages-Maximalpegel sogar leicht. Und von einem Tag zum anderen – ohne die geringste Vorwarnung – gibt es am 24.Mai 2018 ein Niederschlags-Tagesextrem, wie noch nie in der bisherigen Aufzeichnungsgeschichte. Für den Meteorologen Herrn Jung, ein Zeichen, dass der Klimawandel zugeschlagen hat.

Bild 1 Bad Elster (DWD-Station 1207), Tagesniederschlag seit 1948. Grafik vom Autor aus den DWD-Daten erstellt

Man möchte es fast glauben – auch wenn die Verlaufsstatistik vollkommen dagegen spricht. Doch die Informationen vieler „Klimaexperten“ verkündeten den Klimawandel-Beleg durch zunehmenden Starkregen bereits vor diesem Tag. Und bis zu diesem einen Tag gab der Verlauf nicht entfernt dazu Anlass. Auch wäre die Frage zu klären, wer aus diesem Verlauf ein erhöhtes Wiederauftreten eines solchen Extremniederschlages vorhersagen könnte. Die Statistik könnte es nicht und die Simulationen ach nicht.

Besser kann man es an der Auswertung der Tage mit Starkregen im Folgebild erkennen. Es zeigt sich über die gesamte Aufzeichnungszeit keine Zunahme, nur die für Starkregenereignisse ganz typische, hohe Variabilität.

Bild 2 Bad Elster (DWD-Station 1207), Starkregentage (>30 mm) seit 1948. Ereignistage (Datum) und gleitender Jahreswert der Anzahl. Grafik vom Autor aus den DWD-Daten erstellt

Was war der Grund dafür? Zufällig stand unter der Wassersäule eine Messstation!

Googelt man zum Thema und Vogtland, wird schnell ersichtlich, dass Extremniederschlag und Überschwemmungen dort über die Jahrhunderte (wie im bayerischen Pedant Simbach) ein „tägliches Geschäft“ sind. Denn Expertisen, Studien und Maßnahmenpakete zu historischen und aktuellen Hochwassern und seinen Gefahren sprudeln von dieser Gegend aus google nur so heraus.

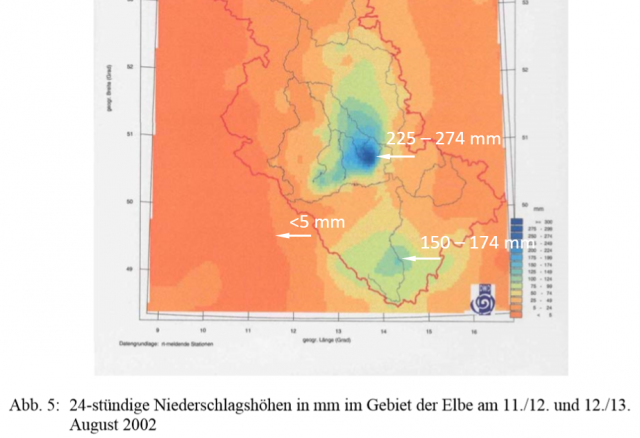

Unter anderem eine Karte, welche die maximierten Gebietsniederschläge (MGN) dazu zeigt [6]. Es wird erkennbar, dass das Vogtland – und der Einzugsbereich der bekannt „überschmemmungsreichen“ Flüsse Elster, Mulde und Elbe bis zur Neise – mehrere Zonen mit Extremniederschlag hat. Und die dort möglichen Niederschläge können wirklich extrem werden, wie die MGN-Werte von Bild 3 (aus einer Dissertation) zeigen.

Bild 3 Bad Elster und das betroffene Gebiet im Vogtland im Einzugsbereich der „weissen Elster“. Links eine Karte mit den maximierten Gebietsniederschlägen (MGN) [6]

[6] … Die statistisch gesehen extremsten Niederschlagssummen fielen in Sachsen im oberen Einzugsgebiet der Lausitzer Neiße mit Wiederkehrintervallen von >100 Jahren (Station Bertsdorf-Hörnitz: … 145,6 mm/24h) … Auch auf tschechischem Gebiet fielen die extremsten Niederschläge mit Wiederkehrintervallen von >100 Jahren im Einzugsgebiet der Lausitzer Neiße, vor allem im Bereich des Isergebirges im Kreis Liberec (Station Bedrˇichov – Olivetská hora: 289,6 mm/24h; Bedrˇichov – Tomšovka: 287,2 mm/24h)

Allerdings sind solche Extremereignisse lokal eng begrenzt. Während eine Stelle sprichwörtlich mit bis zu 274 mm/24 h absäuft, sind es wenige Kilometer daneben weniger als 5 mm, wie es das Bild 4 von einem solchen Ereignis zeigt.

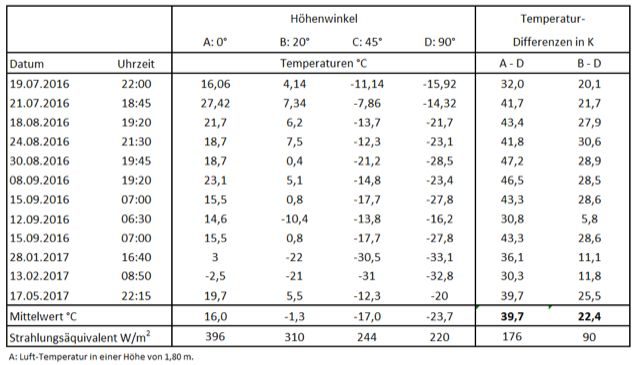

So war es auch am 25. Mai. Nur eine Station zeigte den hohen Niederschlag (Bild 5), daneben war es wesentlich niedriger und am Unterlauf der Elster fiel nicht einmal mehr Regen, die Werte bei einzelnen Stationen zeigen null Niederschlag.

Es ist damit nicht erklärbar, wie Herr Jung in seiner Interpretation darauf kommt, dass das Starkregenereignis diesmal nicht örtlich eingegrenzt wäre.

Als Konsequenz führt es dazu, dass die Detektion eines solchen Extremereignisses vom Vorhandensein einer Messstation an der lokalen Ereignisstelle abhängt. Und das ist ein wesentlicher Grund, warum ein Vergleich mit historischen Daten nicht möglich ist. Denn es liegen vor dem Jahr 1951 dazu schlichtweg keine mit ausreichender Abdeckung vor. Wobei selbst die heutige Abdeckung zur flächendeckenden Detektion nicht ausreicht, weshalb der DWD beginnt, mit Radar zu messen.

Als Fazit ergibt sich daraus: Ein „Beleg“ des „angekommenen“ Klimawandels durch vermehrte Starkniederschlags-Ereignisse entsteht vorwiegend aufgrund neuerdings flächenabdeckenderer Messmethodik.

Bei Entscheidern kommt diese Kenntnis weiterhin nicht an:

dpa Artikel vom 25. Mai 2018: Die EU-Kommission will „grüne“ Investments stärken und damit den Klimawandel bekämpfen. Entsprechende Gesetzesvorschläge hat sie jetzt vorgestellt …

EU-Kommissar Valdis Dombrovkis: Außerdem nehmen die Kosten von durch die Erderwärmung verstärkten Naturkatastrophen – etwa Überflutungen und Dürren – nach Angaben der Brüsseler Behörde immer mehr zu …

Bild 5 Niederschläge im oberen (links) und unteren (rechts) Flussgebiet der Elster im Zeitraum des 24. Mai. Quelle: Sachsen.de Wasser, Wasserwirtschaft Flussgebiete. Abfragezeitpunkt: 25.05., 22h

Man erkennt, dass die direkte, historische Messung solch extremer Starkregenereignisse vor allem davon abhängt, ob sich die eng begrenzte Wassersäule gerade über einer Messstation entlädt. Und dann muss diese für solche Mengen auch noch geeignet sein. Beim Starkregenereignis von Simbach am 01. Juni 2016 fiel als erstes die DWD-Messstation aus. Weshalb in deren Niederschlagsverlauf (und wegen der lokalen Begrenzung des Ereignisses in keiner der umliegenden Stationendas wichtige Ereignis nicht zu finden ist. Das mag früher nicht anders gewesen sen.

Niederschlagsverläufe

Wieder ist es interessant, weitere Niederschlagsverläufe und deren Aussagen zum Klimawandel zu sichten.

Bild 7 Hof, Tagesniederschlag 1947 – 25.05.2018. Quelle: DWD Daten Station 2261. Grafik vom Autor erstellt

Bild 8 Hof, 2-Tagesniederschlag 1947 – 25.05.2018. Quelle: DWD Daten Station 2261. Grafik vom Autor erstellt

Bild 9 Plauen, Tagesniederschlag 1882 – 25.05.2018. Quelle: DWD Daten Station 3946. Grafik vom Autor erstellt

Bild 10 Plauen 1882 – 25.05.2018. Datum Starkregentage >30 mm und gleitender Jahreswert der Anzahl. Grafik vom Autor aus den DWD-Daten (Station 1207) erstellt

Bild 11 Selb, Tagesniederschlag 1882 – 25.05.2018. Quelle: DWD Daten Station 4548. Grafik vom Autor erstellt

Bild 12 Selb 1931 – 25.05.2018. Datum Starkregentage >30 mm und gleitender Jahreswert der Anzahl. Grafik vom Autor aus den DWD-Daten (Station 4548) erstellt

Bild 13 Fichtelberg, Tagesniederschlag 1890 – 25.05.2018. Quelle: DWD Daten Station 1358. Grafik vom Autor erstellt

Bild 14 Fichtelberg 1931 – 25.05.2018. Datum Starkregentage >30 mm und gleitender Jahreswert der Anzahl. Grafik vom Autor aus den DWD-Daten (Station 4548) erstellt

Bild 15 Magdeburg, Tagesniederschlag 1881 – 25.05.2018. Quelle: DWD Daten Station 3126. Grafik vom Autor erstellt

Bild 16 Magdeburg 1881 – 25.05.2018. Datum Starkregentage >30 mm und gleitender Jahreswert der Anzahl. Grafik vom Autor aus den DWD-Daten (Station 3126) erstellt

Fazit

Nirgends lässt sich ein die Tagesniederschläge stetig verstärkender Einfluss eines Klimawandels finden. Einzelne – extreme – Tageswerte geschehen immer aus heiterem Himmel und teils mit vielen, vielen Jahrzehnten Abstand, ohne die geringste „Vorwarnung“ im Verlauf. Beim Sichten der (wenigen) Langzeitreihen erkennt man auch, dass alleine mit dem Betrachten der Zeit ab ca. 1950 (ab der dann mehr Messreihen vorliegen) keine Trendaussage möglich ist.

Dafür gibt es einen einfachen Grund: Starkregenereignisse hängen nicht von der globalen Temperatur, und damit auch nicht vom CO2-Eintrag in die Atmosphäre ab (Bild 17).

Womit nur wieder bestätigt wurde, was schon frühere Sichtungen zeigten:

[9] EIKE 18.04.2018: Beeinflussungen durch Starkregen nehmen in Deutschland nicht zu. Mit schlecht angewandter Statistik lässt sich aber das Gegenteil „zeigen“ (Teil 2)

[10] EIKE 12.08.2017: Die Starkregen vom Juli 2017 in Deutschland sind (keine) Menetekel eines Klimawandels

[11] EIKE 22.08.2017: Verschiebt der Klimawandel Europas Hochwässer dramatisch

Aussagen von „Fachpersonen“, welche in der Lage scheinen, Extremereignisse spontan einem Klimawandel zuordnen zu können, darf man als mindestens unseriös bezeichnen. Anhand der Daten ist es zumindest nicht möglich.

Allerdings bekommt eine seriöse Berichterstattung nicht die gewünschte Medienpräsenz. Dazu muss man schon etwas „powern“:

Stern 22. Juli 2011: [4] Kachelmann gegen Jung Der Zwist der Wetterfrösche

Anmerkung: Es „gelingt“ natürlich durch Rücksimulation des damaligen Wetters. Leider sind diese Simulationen mit den schlechten Daten kalibriert.

Historische Daten

Richtig interessant wird es immer, wenn sich zum betrachteten Gebiet auch historische Daten finden. Solche liegen zum Fluss Mulden, der im Vogtland der Elster gegenüber liegt und genau so hochwasserträchtig ist, vor [7]. Und daran ist gezeigt, dass die Hochwasser dieser Gegend nicht mit der Temperatur oder den Niederschlag, sondern mit Trendumkehrungen des Klimas korrelieren.

[7] Landesamt für Umwelt und Hydrologie, Uwe Büttner: Die größten Hochwasser im Gebiet der Mulden

… Im Zusammenhang mit den Untersuchungen von Glaser (2001) zur mitteleuropäischen Klimageschichte in den letzten 1000 Jahren wird deutlich, dass die Zeitpunkte des Eintretens großer Hochwasser am Beispield es Muldengebietes mit markanten Änderungen und mit Trendumkehrungen in den Temperatur- und Niederschlagsverläufen korrespondieren. Sie treten außerdem in Zeiten sowohl der Über- als auch der Unterschreitung der Temperatur- und Niederschlagsmittelwerte auf (Abb. 20 und 11) …

Bild 17 [7] Temperaturverlauf Mitteleuropa seit dem Jahr 1000 mit Hochwasserereignissen der Mulden (Vogtland)

Bild 18 [7] Niederschlagsverlauf Mitteleuropa seit dem Jahr 1000 mit Hochwasserereignissen der Mulden (Vogtland)

[1] EIKE 27. Mai 2018: Roda Verheyen schlägt wieder zu: EUGH wird angerufen weil die EU Klimaziele nicht streng genug verfolgt werden!

[2] EIKE 24.05.2018: Das „natürliche“ Wetter einzuklagen, wird weltweit immer beliebter

[3] msn wetter, Berliner Kurier: Klimawandel-Schock: Rekord-Hitze und heftige Unwetter

[4] Stern 22. Juli 2011: Kachelmann gegen Jung Der Zwist der Wetterfrösche

[5] EIKE 24.01.2017: Jahrtausendhochwasser am 01.06.2016 in Simbach – so entstehen Menetekel des Klimawandels

[6] TU Dresden Institut für Hydrologie und Meteorologie 2012, Dissertation: Regionalisierung von Hochwasserscheiteln auf Basis einer gekoppelten Niederschlag-Abfluss-Statistik mit besonderer Beachtung von Extremereignissen

[7] Landesamt für Umwelt und Hydrologie, Uwe Büttner: Die größten Hochwasser im Gebiet der Mulden

[8] Umweltbundesamt: Monitoringbericht 2015 zur Deutschen Anpassungsstrategie an den Klimawandel Bericht der Interministeriellen Arbeitsgruppe Anpassungsstrategie der Bundesregierung

[9] EIKE 18.04.2018: Beeinflussungen durch Starkregen nehmen in Deutschland nicht zu. Mit schlecht angewandter Statistik lässt sich aber das Gegenteil „zeigen“ (Teil 2)

[10] EIKE 12.08.2017: Die Starkregen vom Juli 2017 in Deutschland sind (keine) Menetekel eines Klimawandels

[11] EIKE 22.08.2017: Verschiebt der Klimawandel Europas Hochwässer dramatisch