2020 zum wiederholten Mal sehr ungünstiger Frühling in Teilen Deutschlands – häuft sich Extremwetter? Teil 2

Teil 2: Einige aktuelle Besonderheiten und Folgen der Witterungsanomalien

Niederschlag: Wird es wirklich immer trockener?

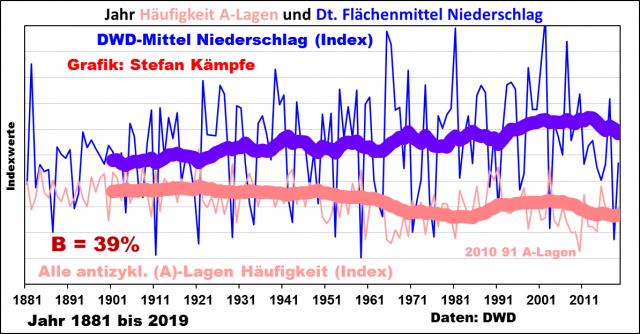

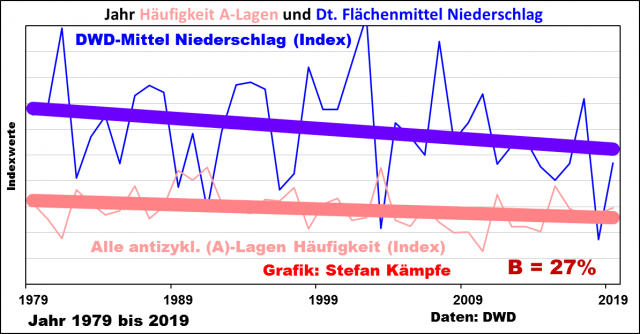

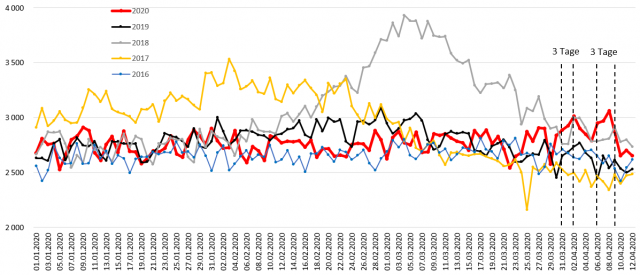

Zwischen Mitte März und Ende April 2020 erlebten weite Teile Deutschlands zum wiederholten Male eine sehr regenarme Periode – Anlass genug, ähnlich wie in Teil1, einmal das lang- und kurzfristige Niederschlagsverhalten (das DWD-Flächenmittel ist ab 1881 verfügbar) zu betrachten:

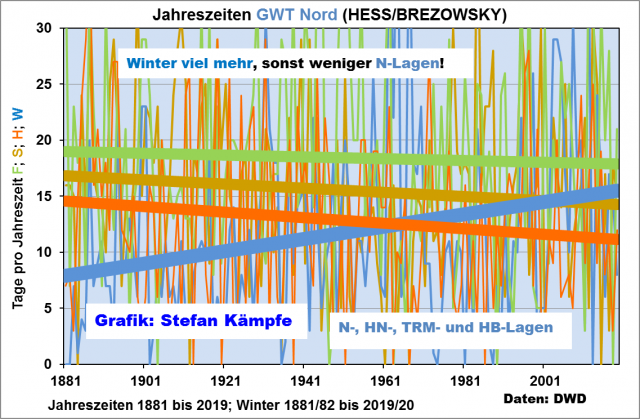

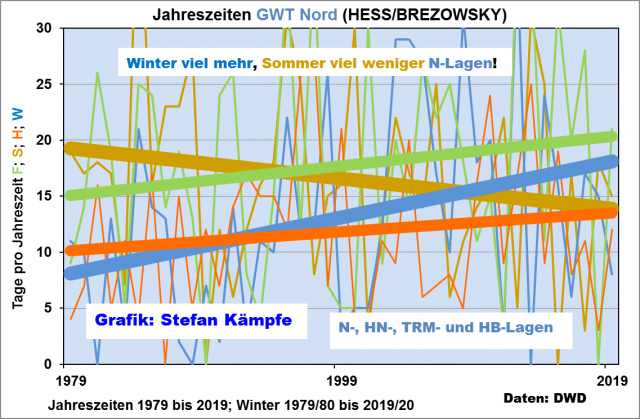

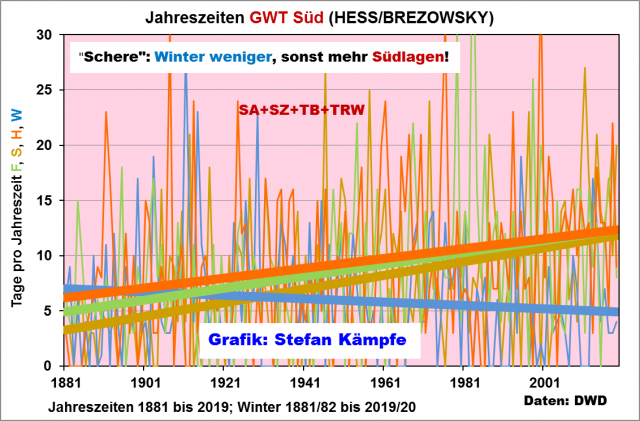

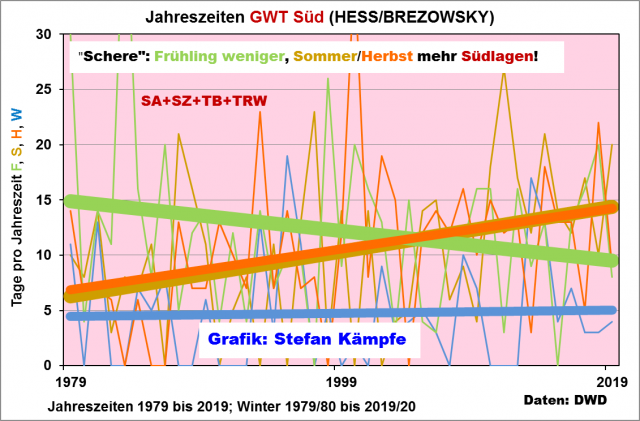

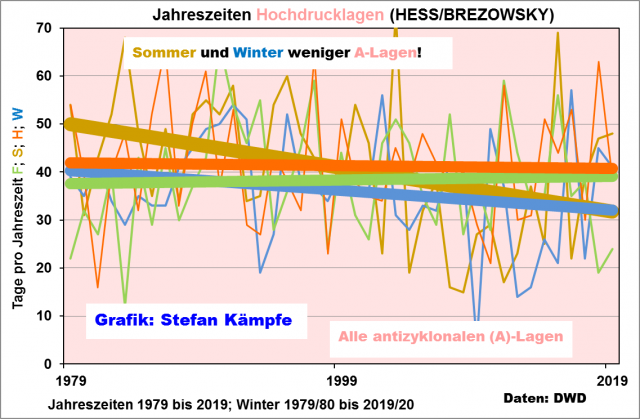

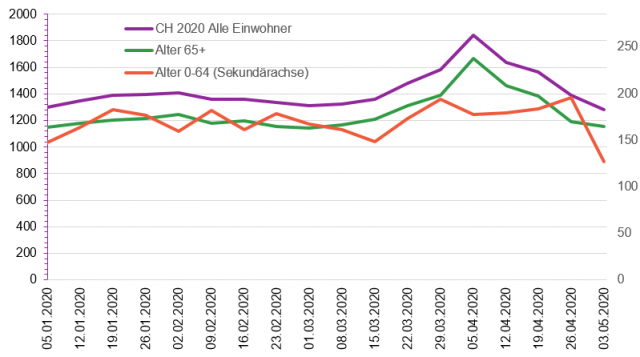

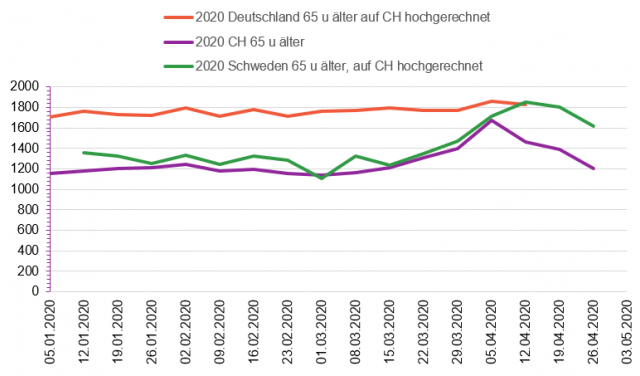

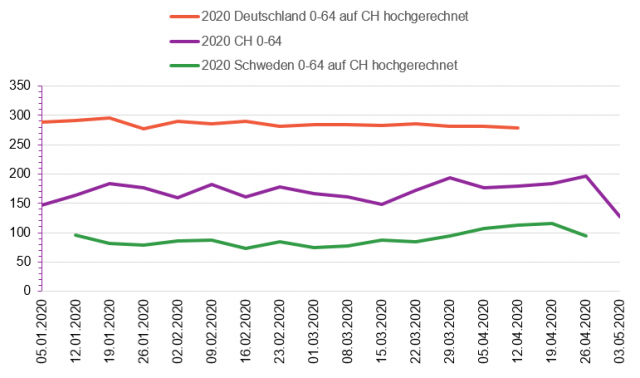

Abbildungen 1a und 1b: Niederschlagsentwicklung aller meteorologischen Jahreszeiten im Deutschland-Mittel langfristig (ab 1881) und seit 1979. Nach einer Zunahme, die bis etwa zur Jahrtausendwende außer dem Sommer alle Jahreszeiten betraf, wurde es kurzfristig bislang nur im Frühjahr merklich trockener, was aus agrarwirtschaftlicher Sicht ungünstig ist, denn im April/Mai benötigen die meisten Kulturen besonders viel Wasser.

Wenngleich es also neuerdings im Frühling trockener wurde, ist das alleine noch kein Grund zur Besorgnis, denn der Trend ist nur mäßig und muss sich zukünftig nicht zwangsläufig fortsetzen; das gilt übrigens für alle Trends. Problematischer wird es aber, wenn man die Entwicklung der relativen Luftfeuchte, der Temperaturen und der Sonnenscheindauer in die Betrachtungen mit einbezieht.

Weniger Luftfeuchtigkeit – Menetekel der Austrocknung Deutschlands?

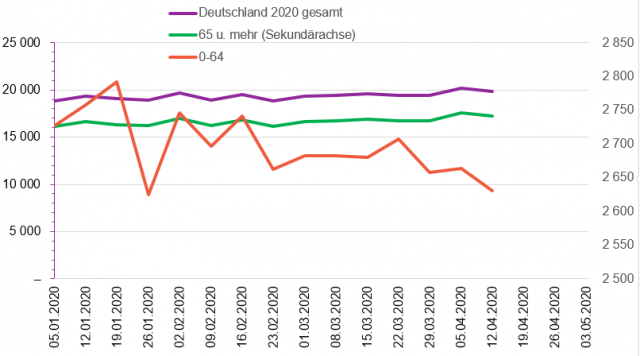

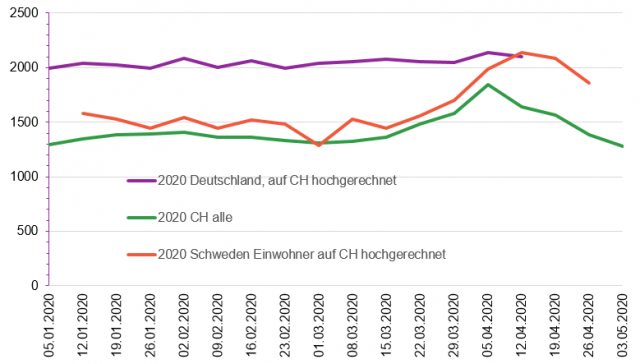

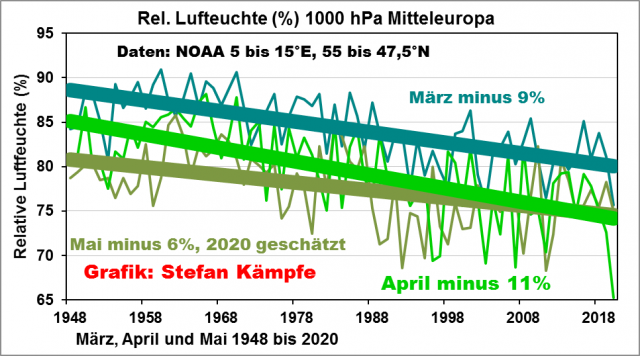

Leider konnten die Deutschland-Flächenmittel der relativen Luftfeuchte nur näherungsweise aus den aerologischen Daten der NOAA (amerikan. Wetterdienst) bis 1948 zurück ermittelt werden; sie zeigen für die drei Frühlingsmonate folgendes Bild:

Abbildung 2: Merkliche Abnahme der relativen Feuchte in allen Frühlingsmonaten. Im LJM 1948 bis 2020 betrug diese im März gut 84, im April knappe 80 und im Mai knappe 78%. Momentan sind es im April nur noch etwa 69%; kein anderer Monat zeigte einen derartigen Rückgang; doch auch von Juni bis September wurde die Luft merklich trockener.

Aber während sich die Rückgänge im März und Mai seit etwa 30 Jahren verlangsamten; beim Mai gar in leichte Zunahme verkehrten, setzte sich der April-Trend fast ungebremst fort; doch gilt für diese Trends das schon beim Niederschlag Gesagte.

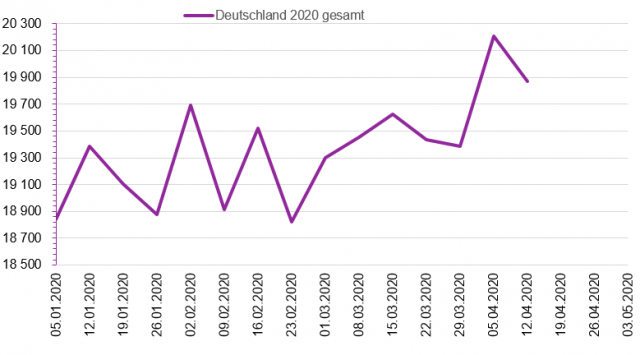

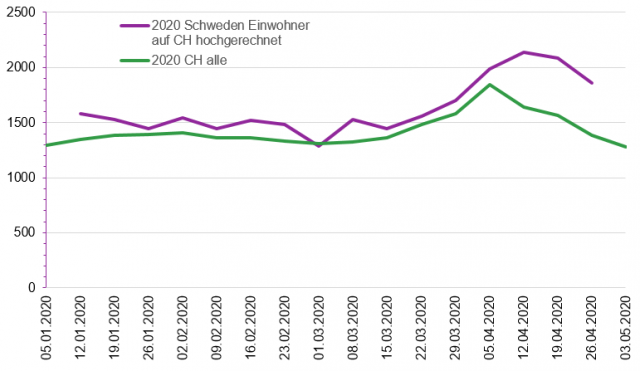

Mehr Sonnenschein bedeutet mehr Wärme

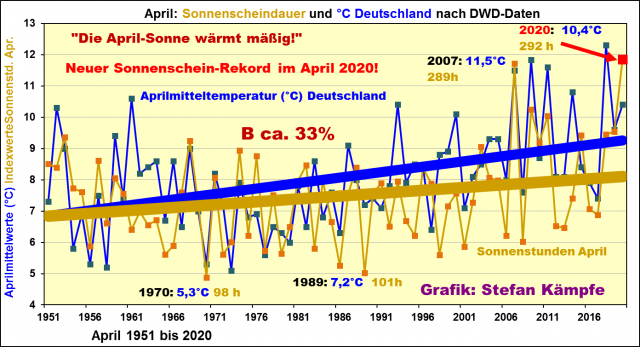

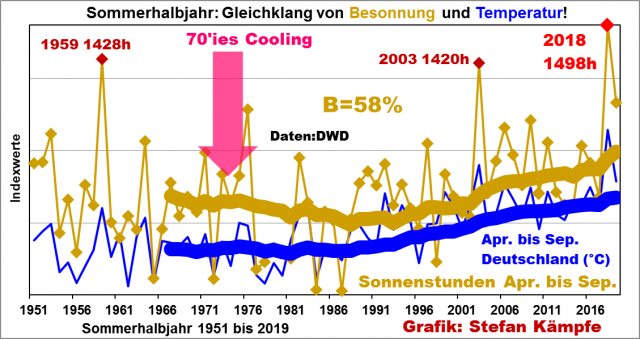

Im gesamten Sommerhalbjahr, besonders aber im April, nahm die Besonnung über Deutschland merklich zu, was zweierlei förderte: Merkliche Erwärmung (die Temperaturvariabilität lässt sich, je nach Monat des Sommerhalbjahres, zu etwa 33 bis 73% mit der Sonnenscheindauer erklären) und die Austrocknung. Im April 2020 wurde mit etwa 292 Sonnenstunden im Deutschland-Mittel ein neuer Rekord verzeichnet; es genügt also, diesen und das ganze Sommerhalbjahr darzustellen; auch der Frühling 2020 wird wieder sehr sonnig ausfallen.

Abbildungen 3a und 3b: Merkliche Zunahme der April-Besonnung (oben) und auch im gesamten Sommerhalbjahr (April bis September) über Deutschland. Wegen der sehr unterschiedlichen Größen mussten beide in Indexwerte umgerechnet werden, um sie gemeinsam in einer Grafik zeigen zu können.

Mehr zu den Ursachen und Hintergründen dieser für Landwirte und Gärtner ungünstigen Entwicklung hier.

Mehr oder weniger Spätfröste im Frühling?

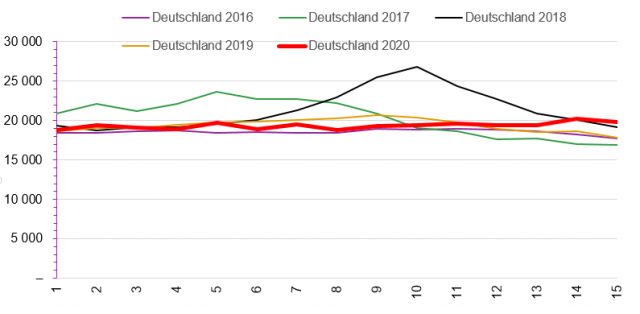

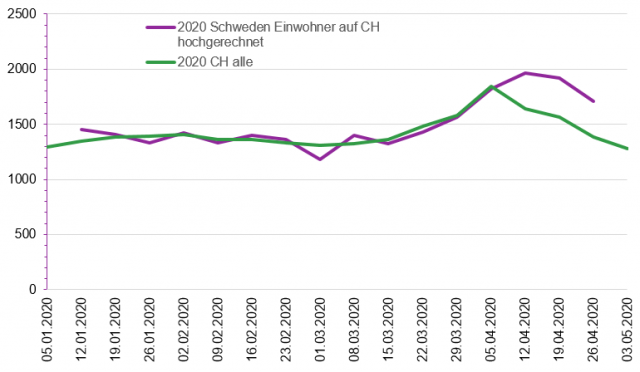

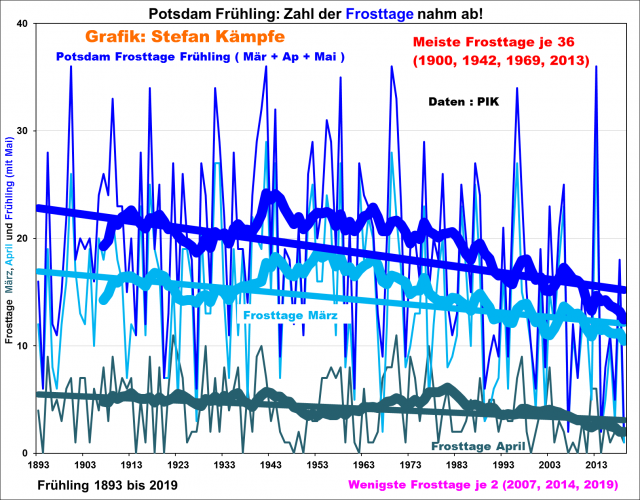

In den letzten Frühjahren gab es immer wieder Kälterückfälle mit Frösten in zumindest einem, 2020 in allen drei Frühlingsmonaten. Doch ein Blick auf die zumindest grob für Deutschland repräsentativen Daten von Potsdam zeigt folgende Entwicklung:

Abbildung 4: Deutliche, langfristige Abnahme der Zahl der Frosttage (Minimum in 2 Metern Höhe unter 0,0°C) im gesamten Frühling, im März (mittlere Kurve) und im April in Potsdam. Die Mai-Entwicklung wurde, weil nur ganz selten Frost auftrat, nicht dargestellt. Besonders viele Frostnächte gab es um die Mitte des 20. Jahrhunderts; ganz am Anfang und besonders am Ende traten sie seltener auf.

Ob also die ungünstigen, letzten Frühjahre schon einen Trend zum Schlechteren anzeigen, lässt sich (noch) nicht sagen.

Das Extremwetter und die Versäumnisse der Politik – ist die Lage hoffnungslos?

Unsere grünverbrämte Politik scheute seit 1990 weder Kosten noch Mühen, um mittels „CO2-Vermeidung“ den Klimawandel zu bekämpfen. Ob Öko-Steuern und Energiewende, ob Förderung der E-Mobilität oder von Bio-Kraftstoffen, ein Flop und Fehlschlag folgte dem andern; alles zu Lasten der Bürger und ohne Entlastung für die Umwelt. Einher ging dieser ganze Unfug mit einem Bauern-Bashing ohnegleichen – die Berufsbezeichnung Landwirt geriet zum Schimpfwort. Insektensterben und Klimawandel, Gift im Grundwasser, Feinstaub, Nitrate und alle möglichen Übel dieser Welt wurden und werden einem Berufsstand in die Schuhe geschoben, welcher durch überlange Arbeitszeiten, Preisverfall und EU-Bürokratie schon mehr als genug gestraft ist (Pharma- und Kosmetikindustrie oder der völlig überdimensionierte Dienstleistungssektor, besonders Freizeit- und Tourismusbranche, sind natürlich völlig unschuldig – und an den von den Gutmenschen bejubelten Windrädern verenden auch keine Insekten, Vögel oder Fledermäuse). Aber das Klima wandelt sich, völlig unbeeindruckt von Pamphleten oder Beschlüssen und diesem ganzen Polit-Zirkus, unbeirrt weiter. Unseren Politikern und Bürokraten ist wohl vor lauter Übereifer entgangen, dass Klimawandel als natürlicher Prozess schon immer markant in die Menschheitsgeschichte eingegriffen hat, wogegen nur intelligente Anpassung hilft. Was also wäre zu tun? Vielleicht hilft ja ein Blick nach Israel weiter – ein kleines, von arabischen Terroristen und Dürren stets bedrohtes Land hat es mit viel Fleiß und Intelligenz geschafft, sogar Obst und Gemüse von bester Qualität zu exportieren. Wir in Deutschland hätten da ungleich bessere Voraussetzungen – trotz der momentanen Dürren bleiben wir ein vergleichsweise regenreiches Land. Aber es kommt noch besser: Es wäre in Teilen Deutschlands, nämlich in Ostdeutschland, sogar schon eine Infrastruktur in Form vieler Kleinspeicher und Stauseen vorhanden, die zur Bewässerung genutzt werden könnten; außerdem ließe sich Talsperren-Wasser aus den regenreichen Gebirgen in trockenere Regionen leiten.

Abbildung 5: Kleinspeicher unweit von Kromsdorf bei Weimar; angelegt zu DDR-Zeiten und zur Bewässerung bis etwa 1990 genutzt. Nebenbei entstand ganz ohne grüne Ideologie ein Biotop mit Libellen und anderen Wasserinsekten, Fischen, Amphibien und Wasservögeln. Links im Bild die Staumauer. Foto: Stefan Kämpfe

Leider hat man im Globalisierungs- und Öko-Wahn der 1990er und 2000er Jahre die Bewässerungsanlagen abgebaut oder verfallen lassen. Zugegeben – eine Reaktivierung wäre nicht ganz billig und auch nur bei flankierenden Anpassungsmaßnahmen sinnvoll. Neben bezahlbarer Energie müsste der völlig unsinnige Energiepflanzen-Anbau, besonders der von Raps und Mais, zugunsten anspruchsloserer und nur wirklich benötigter Nahrungsmittel- und Futterpflanzen aufgegeben werden. Besonders der Anbau von mehr Leguminosen kann die Bodenfruchtbarkeit erhöhen und die Speicherfähigkeit der Böden verbessern; hinzu kommt wassersparende Bodenbearbeitung. Zur Senkung der Verdunstung müssen mehr Windschutzstreifen angelegt und die Kulturpflanzen selbst durch Nutzung der Gentechnik, wie etwa der neuen CRISPR/Cas-Methode, dürreresistenter gemacht werden. Satellitengestütztes Präzisions-Farming, das momentan in immer mehr Agrarbetriebe Einzug hält, wird den sparsamen Umgang mit Wasser, Dünger und Chemikalien weiter befördern. Die Lage ist also nicht hoffnungslos – nur müsste es irgendwie gelingen, die Politik endlich zur Vernunft zu bringen.

Große Temperatursprünge im Frühling 2020 – Auflösung des Rätsels aus Teil 1 und warum Totgesagte länger leben

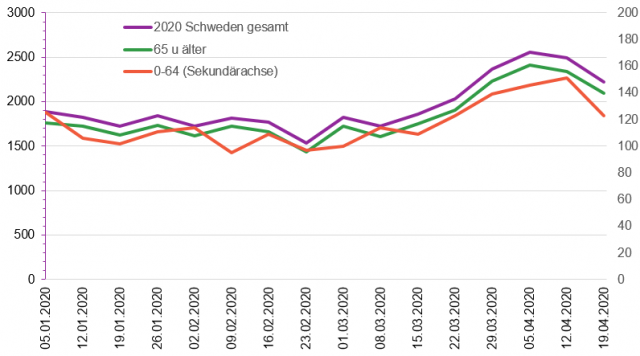

Für das von den Poeten besungene milde, wonnige Frühlingswetter war, wie schon in den Vorjahren, auch 2020 fast kein Platz, statt dessen klirrend kalte Nächte, sonnig-staubige, heiße, windige Tage und kaum einmal ein warmer Frühlingsregen. Vergleicht man nur den Verlauf der Tiefsttemperaturen aus dem Winter mit denen im Frühling, so zeigt sich kaum eine Erwärmung; und die Zahl der Frostnächte war im Winter nur unwesentlich höher:

Abbildungen 6a und 6b: Temperatur-Minima am Flughafen Erfurt/Weimar in zwei gleich langen Zeiträumen 2020 – oben jeweils die 8 Wochen im Winter vom 5. Januar bis zum 1. März, unten im Frühling vom 17. März bis zum 12. Mai. Immer wieder kam es in diesem schlechten Frühling zu Einbrüchen trockener Polar- und Arktikluft; auch die seit Jahrzehnten fast vergessenen Eisheiligen meldeten sich mit etwa minus 3 Grad in Erfurt zurück. Bildquellen wetteronline.de, ergänzt.

Totgesagte leben offenbar länger – die Eisheiligen waren ja längst von den CO2-Gläubigen der Klimakirche entweiht worden – nun sind sie zurück; mit einem jähen Wettersturz von fast 22 auf knapp über 6 Grad in Erfurt und Schneefällen bis ins untere Bergland zogen sie ein.

Abbildung 7: Verlauf der Maximum-Temperaturen in Erfurt/Weimar vom 16. März bis zum 11. Mai 2020. Immer wieder kam es zu jähen Wetterstürzen, meist ohne oder mit nur wenig Regen; am drastischsten vom 10. auf den 11. Mai; darauf folgte dann die bitterkalte Frostnacht zum 12. Mai mit etwa minus 3 Grad bei einer Tageslänge wie Anfang August!

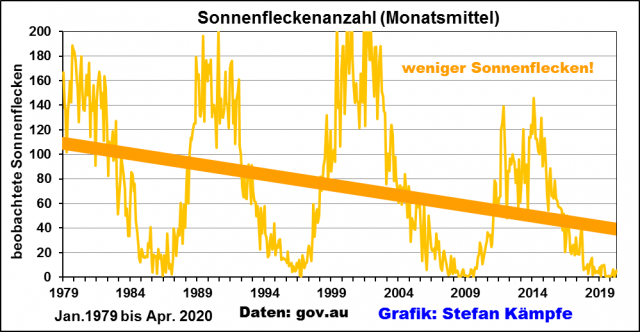

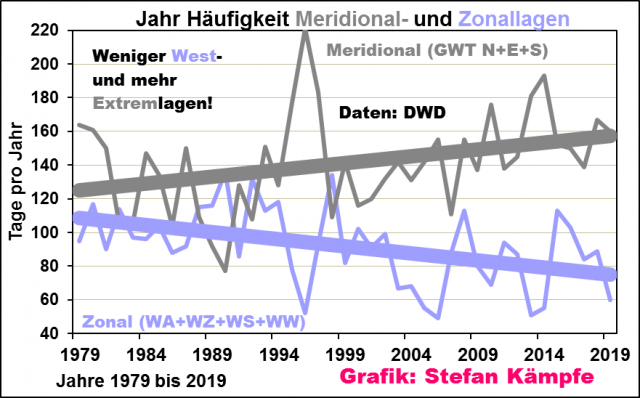

Ergebnisse: Das 21. Jahrhundert scheint wettermäßig deutlich rauer, extremer und ungünstiger zu verlaufen, als das vorherige Gunst-Jahrhundert. Unter anderem solar bedingt, aber auch durch menschliche Fehler wie Landschaftsverbrauch, Zersiedlung und falsche Energienutzung (Windkraft!) verstärkt, häufen sich Extremwetterereignisse. Klima lässt sich (leider!) nicht schützen – an Stelle unsinniger, teurer CO2-Einsparungsmaßnahmen müssen Anpassungsstrategien an diese neue Lage entwickelt werden, welche die negativen Auswirkungen zwar nicht kompensieren, aber deutlich abmildern können.