Ein Inselstaat gegen die Welt

SZ 23.05.2020: [1] Ein Inselstaat gegen die Welt

Vanuatu leidet wie kaum ein anderes Land unter den Folgen des Klimawandels. Jetzt will der kleine Inselstaat die Länder mit dem größten CO₂-Ausstoß zur Verantwortung ziehen. Über einen ungleichen Kampf.

So beginnt der SZ-Artikel, welcher nur eine Intention hat: Alle Übel, welche eine kleine Inselgruppe im Pazifischen Ozean trifft, können als Ursache nur die Klimagift-Emissionen der reichen, westlichen Staaten haben. Und dafür haben diese zu bezahlen.

Um dies zu belegen, durfte dank Unterstützung von diversen Organisationen [6] eine als Redakteurin „getarnte“ Aktivistin [2] vor Ort reisen und dort (angeblich) besonders Klima-sachkundige Personen interviewen [3]. Aufgrund deren herzzerreissender Schilderungen setzte sie sich hin und schrieb für die SZ-Leser eine drei volle Seiten lange Geschichte um die edlen, im Einklang mit der Natur lebenden Einwohner vor Ort und die bösen Mächte im reichen Westen, welche diesen mit ihrer CO2-Emission buchstäblich das Leben zur Hölle und die Zukunft kaputt machen.

Doch, das ist der Kern dieser Wochenendgeschichte: Die Inselregierung ist aktiv und weiß sich zu wehren, indem sie diese bösen (reichen) Mächte verklagen will. Natürlich nicht, damit diese nur Buse tun, sondern damit ihnen gutes (und viel) Geld als Wiedergutmachung überwiesen werde.

Die SZ-Leser, welche – sofern solche Prozesse gewonnen werden -, indirekt mit zu den Zahlenden gehören, sollen dies als einen gerechten – und vor allem selbstverständlichen – Ausgleich für die Schäden der durch ihre Emission losgetretenen Naturgewalten begreifen. Und unterstützen, dass NGOs und Anwaltskanzleien im eigenen Land die Prozesse für solche Staaten vorantreiben.

Die Natur meint es nicht gut mit den Inselbewohnern im Pazifik

Die Pazifikatolle waren von der Natur nicht unbedingt für eine menschliche Besiedelung „vorgesehen“. Ein Paradies sind sie nur außerhalb der Taifunsaison und seitdem es Technik-bedingt medizinischen Fortschritt gibt (waren Malariagegend), etwas Komfort und vor allem genügend nahrhafte Lebensmittel von außerhalb.

Für einen höheren Bevölkerungsanteil reicht der Bodenertrag nicht und die Fische direkt um die Atolle sind häufig durch eine dort verbreitete, tödliche Algenart-giftig, so dass oft nur – schwierig zu fangende – Hochseefische gegessen werden können.

Der dadurch hervorgerufene Proteinmangel war so schlimm, dass auf den Inseln Kannibalismus herrschte und regelmäßig auch Einwohner anderer Inseln gefangen und gegessen wurden.

Gegen solche Tatsachen mögen die GRÜNEN noch so idiotische Aufrufe erstellen. Diese zeigen ausschließlich deren (von ihren Wählern so geliebte, da keinerlei sonstigen Ansprüche stellende) oft bodenlose Unkenntnis in verblüffend vielen Dingen, welche die Welt so wünschenswert, kindgerecht „einfach“ erscheinen lassen.

Als zum Thema passendes Beispiel eine ehemaligen Wahlwerbung der GRÜNEN an die Bewohner der Carteret-Inseln vor Neuguinea (Auszug, mehr Text daraus siehe Anlage):

[4] … Ihre Heimat ist ein Ort, von dem wir Deutschen träumen … Sie leben in diesem Paradies seit vielen Jahrhunderten. Doch nach der Landung der Europäer begann der Niedergang Ihres Landes … Wir tragen die Verantwortung für diese Katastrophe. Nicht nur bei Ihnen, überall auf der Welt sind die Vorboten der Klimakatastrophe sichtbar … Wir, der Norden, sind in der Pflicht, endlich zu handeln … Wir Grüne versprechen Ihnen: Egal ob wir nach dieser Wahl regieren oder in der Opposition landen; wir werden mit allen uns zur Verfügung stehenden Mitteln dafür kämpfen, dass unser Land wieder Vorreiter beim Klimaschutz wird.

Dieses angebliche, GRÜNE Paradies haben Missionare – als vorteilhaft geldbringender Tourismus noch in weiter Ferne war –, öfters nicht überlebt:

Bild 1 Das „ … Leben im Paradies“ wie es wirklich war. Quelle: Vortragsfoliensatz [8]

Was in dem Folienblatt noch fehlt, sind die sehr häufigen Erdbeben mit darauf oft folgenden Tsunamis, welche die Südseeatolle den Pazifischen Feuerring bis hinauf nach Japan regelmäßig und teils extrem beeinträchtigen. Dazu noch hochaktive Vulkane. Ein Vulkanausbruch hat jüngst in Vanuatu zur Evakuierung einer ganzen Insel mit 10.000 Einwohnern geführt. War aber eben nicht der Klimawandel und für unsere Medien deshalb unwichtig.

Seit Urzeiten mussten die Inselbewohner damit umgehen und versuchen zu überleben. Waren Atolle überbevölkert, mussten welche weiterziehen und versuchen, neue Flächen zum Leben zu finden.

Doch dann tauchte die Theorie des alleine vom Menschen verursachten Klimawandels auf. Und es entstand die Sage, dass alle – bisher als natürlich geltenden – Wetterprobleme alleine von den schlimmen, CO

2-Emittierenden, reichen westlichen Ländern verursacht würden. Zumindest stellt es der SZ-Artikel so dar.

Ein „Erweckungserlebnis“

Fast den gesamten SZ-Artikel „bestreitet“ ein örtlicher Aktivist namens Willy Kenneth. Googelt man nach ihm, erscheint eine Person, welche unbestreitbar auf seiner Insel viel Sinnvolles veranlasst, für das man ihn loben kann. Doch gleichzeitig ist er auch Klimaaktivist. Und fast ausschließlich in dieser Position findet er im Artikel Gehör.

„Zum Klima“ kam dieser Herr wohl durch so etwas wie ein Erweckungserlebnis. Da macht die Ökokirche zur realen keinen Unterschied:

SZ: [1] (Willy Kenneth) „ … US-Amerikaner, die in seinem Dorf Freiwilligenarbeit machen, erzählten davon (Anm.: vom Klimawandel). Ihm wurde klar, warum sich das Wetter auf der Insel so stark verändert hat … „

Und seitdem weiß er zu jedem Problem auf „seinem“ Eiland sofort die Ursache. Denn schließlich kann es ja nur immer die Eine sein ….

SZ: [1] … Früher, als er mit den anderen Kindern am Friedhof spielte, war das Meer zwanzig Meter weg, sagt Willy Kenneth und deutet auf die Linie, wo die Wellen auf den Strand rauschen. Heute sind es zwei Meter … Das Land erodiert, sagen die Wissenschaftler, die aus aller Welt in das kleine Dorf Worasifiu kommen …

Das folgende Bild zeigt das Dorf auf der Insel Pele. Ein „richtiger“ Untergang wie im Artikel geschildert, ist zumindest aus der Satellitenentfernung nicht erkennbar.

Bild 1a Vanuatu, Insel Pele, Ort Warasifiu. Quelle: googl maps.Screenshot vom Autor

Dass Strand nicht wegen dem Wasserspiegel erodiert, sondern wegen Strömungen und/oder Zerstörung von Schutzzonen, was solls. Einer deutschen Journalistin (auch *en) kann man wirklich alles erzählen, wenn dabei nur „Klimawandel“ genügend oft vorkommt. Trotzdem darf man solche noch lange nicht mit so etwas wie vielleicht „dumm“ titulieren. Denn eine hochrangige Bundestags-Klimawandel-Recherchekommission unter Leitung einer GRÜNEN Fachfrau agierten genauso:

EIKE 30. April 2019:

Claudia Roth auf Forschungsreise zum Klimawandel

Jedenfalls stellt sich diese einheimische, „klimaerweckte“ Fachperson als der idealer Gesprächspartner heraus:

SZ:

[1] …

Kenneth sagt: „Alles hängt zusammen“. Alles, das heißt in Vanuatu: Dürre, Starkregen, Tropenstürme, Korallenbleiche, Meeresspiegelanstieg. Kein Land auf der Welt ist der UN-University zufolge stärker von Naturkatastrophen betroffen …

…

Es ist Januar, die tropischen Wirbelstürme haben Saison. Er warte nur auf den nächsten Zyklon der Kategorie fünf, sagt Kenneth. … Ob sein Haus und das seiner Nachbarn dann noch stehen werden? … Er habe keine andere Wahl als zu warten: Wir wissen, dass es den Klimawandel gibt und dass wir nichts tun können ...

Warum kann man „nichts tun“? Sogar im Artikel selbst wird es gesagt:

Die traditionellen Hütten der Einwohner halten den Zyklonen kaum stand. Man war es bisher eben gewohnt, diese (bewusste) Leichtbauweise danach erneuern zu müssen. Will man es besser haben (und die inzwischen größere Menge an Eigentum schützen), muss man wie überall auf der Welt mehr tun. Das geht aber nur mit Geld aus den reichen Ländern, denn guter Hausbau kostet auch auf Atollen mehr:

SZ:

[1] …

Wer sich ein Haus mit Betonfundament und einem Dach leisten will, das den Stürmen standhält, arbeitet als Erntehelfer in Australien und Neuseeland …

Aber die Redakteurin versteht Herrn Kenneth voll und ganz:

SZ:

[1] …

Da ist auf der einen Seite ein Staat, im Osten von Australien gelegen, der so wenig CO2 ausstößt wie kaum ein anderer auf der Welt … Ein Staat, der gleichzeitig kaum wie ein anderer unter den Folgen des menschengemachten Klimawandels leidet …

…

Und da sind auf der anderen Seite die vielen großen Industrienationen, die für diese Katastrophen zu Verantwortung gezogen werden sollen, in Den Haag, vor dem internationalen Gerichtshof ...

Die Redakteurin ist mit der erzählenden Belegführung des Herrn Kenneth voll und ganz zufrieden. Einheimische wissen schließlich genau, wie das Wetter im Vergleich zu früher war und warum es heute anders ist. Beim Klimawandel ist solches Befragen deshalb eine übliche – und als völlig ausreichend erachtete – Vorgehensweise:

[9] EIKE 17. Oktober 2018: SAMOAS Premier: Wir wollen Klimareparationszahlungen sehen. Wer deshalb nach Betroffenheitsbelegen fragt, gehört weggesperrt

[10] EIKE 10.05.2017: Die Volkshochschule Hannover und ihre Ausstellung: Wir alle sind Zeugen – Menschen im Klimawandel

Hätte sie nachgefragt, wäre folgendes herausgekommen:

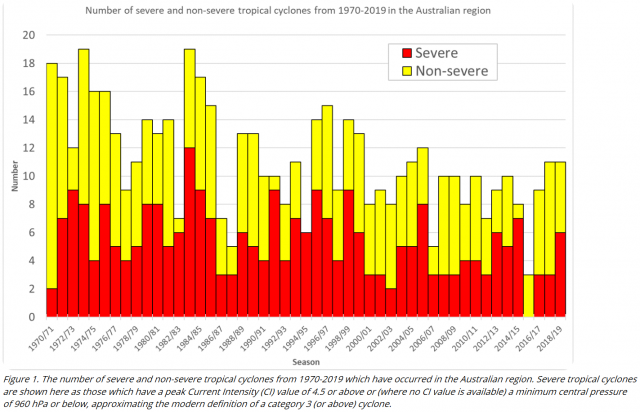

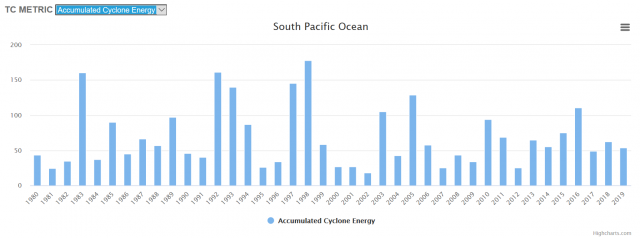

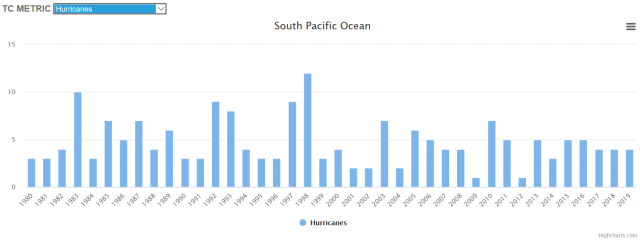

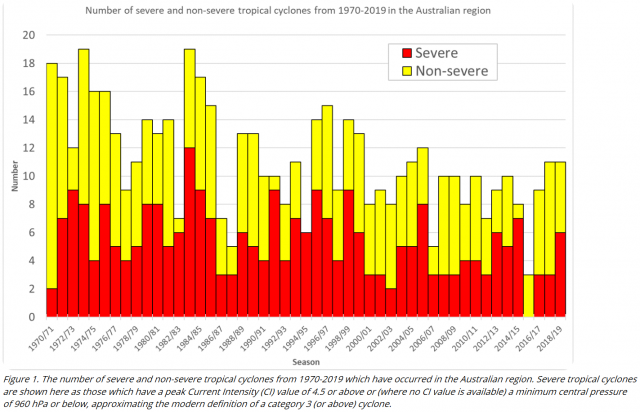

Zyklone, eine ständige Geißel im Inselparadies, dank Klimawandel zum Glück abnehmend

Vanuatu wurde auch in letzter Zeit von extremen Zyklonen getroffen. Wer solche erlebt, dem bleiben sie in Erinnerung. Allerdings erschwert es den Blick auf die klimatische Extremwetter-Vergangenheit. Denn diese besagt:

[7] WELT 30.01.2014: Zyklone Langzeit-Vergleich offenbart Flaute um Australien

… Tropische Stürme haben gar nicht zugenommen, sondern sind in Australien weniger aktiv als sonst – zumindest im Vergleich über Hunderte von Jahren. Zu diesem Ergebnis kommt eine aktuelle Studie.

„Die Aktivität tropischer Zyklone in Australien ist derzeit niedriger als zu irgendeiner anderen Zeit in den vergangenen 550 bis 1500 Jahren“,

Laut der Studie begann die Zyklon-Aktivität im langjährig betrachteten Durchschnitt etwa seit dem Jahr 1700, stetig abzunehmen.

Sie verweisen auf andere Forschungsarbeiten, die eine weitere Abnahme der Wirbelsturm-Ereignisse rund um Australien zum Ende des 21. Jahrhunderts prognostizieren. „Unsere Resultate deuten an, dass dies weit früher geschehen könnte.“

„Die dramatische Abnahme der Aktivitäten seit der industriellen Revolution lässt darauf schließen, dass der Klimawandel als Ursachenfaktor nicht ausgeschlossen werden kann.“

… In dem im vergangenen September vorgelegten fünften Sachstandsbericht des Weltklimarates IPCC wurden die Wahrscheinlichkeiten von größeren Aktivitäten gegenüber früheren Prognosen zurückgenommen …

Ein eigener Absatz über die Gefahr jener Extremereignisse, wie er noch im vorherigen vierten Bericht Platz fand, wurde nun gestrichen.

Was steht im letzten IPCC-Sachstandsbericht: Tropische Zyklone

IPCC 2013, AR5, WGI, Kapitel 2, Seite 216: “Current datasets indicate no significant observed trends in global tropical cyclone frequency over the past century and it remains uncertain whether any reported long-term increases in tropical cyclone frequency are robust, after accounting for past changes in observing capabilities.”

Übersetzung: “Aktuelle Datensätze zeigen keine signifikanten beobachteten Trends bei der weltweiten tropischen Wirbelsturmfrequenz während des letzten Jahrhunderts und es ist ungewiss, ob ein berichteter langfristiger Anstieg der tropischen Wirbelsturm-Frequenz robust ist, nach Berücksichtigung der letzten Änderungen in den Beobachtungs-Möglichkeiten.“

Sogar der sonst jederzeit zu Klimaalarmismus „aufgelegte“ M. Latif hat manchmal lichte Momente und plaudert dann auch mal aus seinem Nähkästchen:

[Link] kaltesonne 07.05.2017: Mojib Latif: Klimamodelle bekommen tropischen Pazifik nicht in den Griff. Bisher kein anthropogener Einfluss erkennbar

Und was sagt die Australische Regierung, die am nächsten vor Ort ist und ein Überwachungsprogram für viele dieser Atolle führt? Die Grafik ist eindeutig.

Bild 2 Anzahl starker und weniger starker Zyklone seit 1970 in der Region Australien. Quelle: Australian Government, Bureau of Meteorology

Auch ein technischer Report der Australischen Regierung sagt es:

© CSIRO 2015 CLIMATE CHANGE IN AUSTRALIA TECHNICAL REPORT PROJECTIONS FOR AUSTRALIA´S NRM REGIONS

4 .2 .7

TROPICAL CYCLONES

The relatively short time span of consistent records, combined with high year to year variability, makes it difficult to discern any clear trends in tropical cyclone frequency or intensity for the Australian region. For the period 1981 to 2007, no statistically significant trends in the total numbers of cyclones, or in the proportion of the most intense cyclones, have been found in the Australian region, South Indian Ocean or South Pacific Ocean (Kuleshov et al. 2010). However, observations of tropical cyclone numbers from 1981–82 to 2012–13 in the Australian region show a decreasing trend that is significant at the 93-98 % confidence level when variability associated with ENSO is accounted for (Dowdy, 2014). Only limited conclusions can be drawn regarding tropical cyclone frequency and intensity in the Australian region prior to 1981, due to a lack of data. However, a long-term decline in numbers on the Queensland coast has been suggested (Callaghan and Power, 2010).

Sowie andere Einheimische, und weiter Studien:

kaltesonne 9.4.2015:

Schwerer Wirbelsturm verwüstet Vanuatu. Premierminister sieht es realistisch: “Stürme sind kein neues Phänomen, wir Insulaner leider darunter seit Besiedelung Vanuatus vor 5000 Jahren”

kaltesonne 3.4.2014:

Neue Arbeit in Nature: Noch nie waren die australischen Wirbelstürme in den letzten 1500 Jahren schwächer als heute

Wie auch Grafiken der COLORADO STATE UNIVERSITY:

Tropical Meteorology Project

Anstatt solcher Messdaten und aktuellerer Studien reicht der Redakteurin eine (mangels Detaillierung nicht recherchierbare) Aussage eines lokalen Ministers:

SZ:

[1] …

Hier befindet sich das Ministerium für Klimawandel und Katastrophenmanagement … Allan Rarei, der Bereichsleiter … während er in einer australischen Studie aus dem Jahr 2011 blättert … Zyklone werden immer Stärker, zitiert er eines der Ergebnisse …

Korallenriffe leiden

Geht es um die Südsee, wäre jeder Bericht ohne Einbeziehung der unter dem Klimawandel leidenden Korallen unvollständig. Die Redakteurin macht da keine Ausnahme:

SZ: [1] … Vor vier Jahren hätten sie 90 % des Korallenriffs verloren, erzählt Willy Kenneth. Wenn sich das Meer erhitzt, oxidieren die Korallen … ganze Strandabschnitte verschwinden, vor allem wenn es stürmt …

Dabei ist gerade dieses Thema wohl eines der heiß umstrittensten:

kaltesonne 12.01.2015: Verweis auf Klimawandel lenkt von den wahren Gefahren für die Korallenriffe ab: Dynamit-Fischerei, Killer-Mikroorganismen, Seesterne, Abwassereinleitung und Rodung der Küstenwälder

kaltesonne 29.06.2016: University of Santa Barbara sieht Zukunft der Korallen hoffnungsfroh

kaltesonne 06.01.2015: Unerwartete Wendung: Korallen sind viel Wärmestress-resistenter als vormals befürchtet

New GBR Study: 400% Coral Recovery Since 2014 – With 2017 Growth Rates Comparable To The 1970s

Coral Mortality Rates Higher During Cold Periods – And There’s Been Recent Cooling In Coral Environments

Der Autor hat selbst Reportagevideos im Fernsehen gesehen, in denen Forscher Korallenriffe weltweit untersuchten. Dabei stellten solche fest, dass in der Südsee in einem Atoll Korallen stark geschädigt waren, in Atollen daneben jedoch bei gleicher Wassertemperatur beste Korallengesundheit herrschte.

Eine Reportage ist besonders haften geblieben. Piccard (der Sohn des berühmten Forschers) reist für ein alarmistisches Video rund um die Welt, um auf das Klimawandel-bedingte Korallensterben hinzuweisen. Mit einem einheimischen Meeresbiologen taucht er vor der Küste von Somalia. Dort ist das Wasser sehr warm und Piccard erklärte spontan in die laufende Kamera, dass darunter alle Korallen bestimmt in einem höchst bedauerlichem Zustand sein müssen.

Der Biologe sagte dazu, dass die Korallen keinerlei Problem mit der hohen Wassertemperatur haben …

Und bei der gemeinsamen Nachschau im folgenden Tauchgang zeigte sich überdeutlich: Alle Korallen gediehen prächtig …

Der nächste Fall war bei Chile. Dort gibt es eine Bucht, in der das Wasser für Korallen „viel zu sauer“ ist, nur nehmen die Korallen keine Notiz davon …. Deutsche Forscher waren dabei, dieses Phänomen zu untersuchen (welches auch im Pazifischen Raum in weit größerem Umfang zu beobachten ist).

„Unserer“ Redakteurin ist das wohl vollkommen unbekannt, denn sie hatte keine Nachfrage. Unkommentiert übermittelte sie dann allerdings eine verblüffende Erklärung:

[5] … „Nach Pam haben wir den Küstengemeinden gezeigt, wie sie den invasiven Dornenkronenseestern von ihren Riffen entfernen“, nennt der Mittvierziger ein Beispiel eines solchen Trainings. Schließlich sind die Erhöhung der Wassertemperatur, die zunehmende Versäuerung der Meere und andere Auswirkungen des Klimawandels nicht die einzigen Gefahren für dieses sensible Ökosystem. In Worasiviu hatte die Dorfgemeinschaft 2013 durch die invasive Spezies, die sich von Steinkorallen ernährt, 90 Prozent eben dieser verloren.

Um nicht noch größeren Schaden zu erleiden, spuckten Willie und seine Leute in die Hände. In einer groß angelegten Sammelaktion holten sie 250.000 Dornenkronenseesterne aus dem Wasser … Dieser Einsatz hat sich als genauso erfolgreich herausgestellt wie die Entfernaktion selbst: Mittlerweile gibt es in Worasiviu keine Dornenkronenseesterne mehr – und die Steinkorallen sind wieder nachgewachsen.

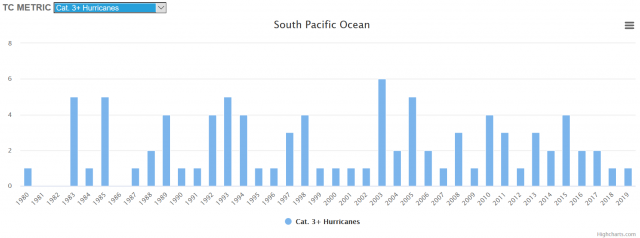

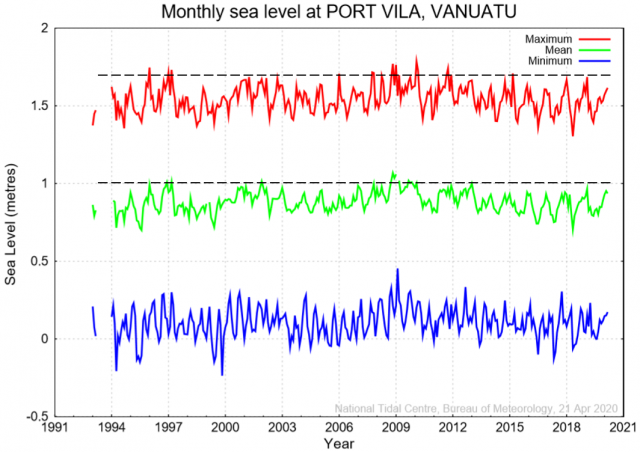

Immer wieder steigt der Meeresspiegel (nicht)

Man kann kaum noch glauben, mit welcher Unverfrorenheit Aktivisten und Regierungsvertreter vor Ort über durch den Klimawandel bereits gefährlich gestiegene Meerespegel fabulieren und wie bereitwillig dies im Westen aufgenommen – man muss schon fast sagen, „begrüßt“ – und sofort zustimmend bestätigt und publiziert wird.

Obwohl man mit wenigen Mausklicken tagesgenaue, gemessene Pegelinformation erhalten kann, die allen diesen Erzählungen – die wiederum von Erzählungen aus dem Westen, die wiederum von Simulationen, dass das antarktische Festlandseis spontan ins Meer stürzt- ableiten, eindeutig widersprechen.

SZ: [1] … Früher, als er mit den anderen Kindern am Friedhof spielte, war das Meer zwanzig Meter weg, sagt Willy Kenneth und deutet auf die Linie, wo die Wellen auf den Strand rauschen. Heute sind es zwei Meter …

… Würde der Meeresspiegel um fünfzig Zentimeter ansteigen, wäre Worasifiu verloren …

… Kenneth sagt: „Alles hängt zusammen“. Alles, das heißt in Vanuatu: Dürre, Starkregen, Tropenstürme, Korallenbleiche, Meeresspiegelanstieg …

Das Australische Pegel-Monitoringprojekt weist an der Pegel-Messstation von Vanuatu ganz aktuell den folgenden Verlauf aus. Man sieht, dass nicht die Spur eines stetig, vielleicht sogar unnatürlich ansteigenden, Meeresspiegels vorliegt.

Bild 6 Vanuatu, Pegelverlauf seit 1991. Quelle: Australien Government, Pacific Sea Level and Geodetic Monitoring Project Monthly Sea Level and Meteorological Statistics. Screenshot vom Viewer, vom Autor ergänzt

Es wäre wirklich interessant, solche Pegel-Märchenerzähler damit zu konfrontieren und die Antwort zu erfahren. Leider bleibt das eine Illusion. Selbst unter den extra zur „Klima-Fachdiskussion“ anreisenden ca. 25 – 30.000 „Klima-Fachpersonen“ auf den jährlichen Klimagipfeln findet sich niemand, der danach fragt. Im Gegenteil, Regierungsvertreter und eingeflogene, teils blutjunge, örtliche Aktivisten die davon auf den Podien erzählen, werden beklatscht:

[Link] EIKE 03.11.2017:

Das Wochenende, an dem die Welt (wieder) begann unterzugehen

[Link] EIKE 15.04.2017:

Im Klimawandel-Unterricht bitte üben, wie man unsere Regierung zum Bezahlen von Schutzgeldern auffordert

Und nicht nur das. Eine höchste, politische Vertretung vertrat Deutschland nicht gegen solche fabulierten Anschuldigungen, sondern verbrüderte sich mit einem Verband solcher Märchenerzähler, um deren Forderung nach Zahlungen aus Deutschland zu unterstützen! Einer der Unterschiede zwischen Trump und der deutschen Regierung.

[Link] EIKE

13. Juli 2017:

Wie viele Unterschriften zum Klimavertrag wurden mit Geldversprechungen gekauft?

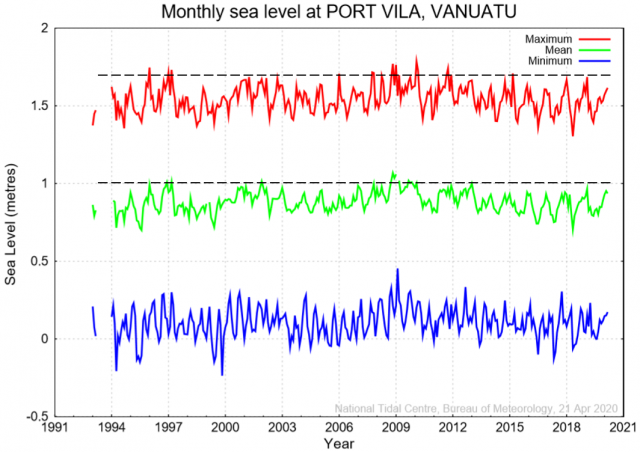

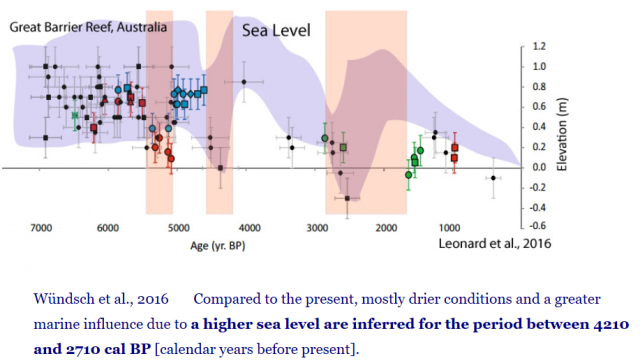

Dabei haben diese Atolle überhaupt keinen Grund, den Westen für Meerespegel verantwortlich zu machen. Als der CO

2-Gehalt „natürlich“ war, gab es bereits gewaltige Pegeländerungen und der aktuelle ist davon fast der niedrigste.

Bild 7 Nordost-Australien, Meerespegel seit 7000 Jahren

Zum Nachlesen etwas Literatur dazu:

[Link] kaltesonne 13.7.2017

: Südsee-Meeresspiegel: Enorme natürliche Schwankungen der letzten Jahrtausende geben Rätsel auf

[Link] kaltesonne 2.2.2016:

Bremer Leibniz-Zentrum für Marine Tropenökologie: „Unsere Daten lassen keine Rückschlüsse darauf zu, dass sich der Anstieg des Meeresspiegels bei den Takuu-Inseln in den letzten 70 Jahren negativ bemerkbar gemacht hat“

[Link] kaltesonne 23.06.2015:

Spektrum der Wissenschaft über angeblich vom Untergang bedrohte Südseeatolle: “Noch keine der betroffenen Inseln ist in nächster Zeit von Überflutung bedroht. Einige vergrößern sich sogar auf Grund natürlicher ökologischer Vorgänge”

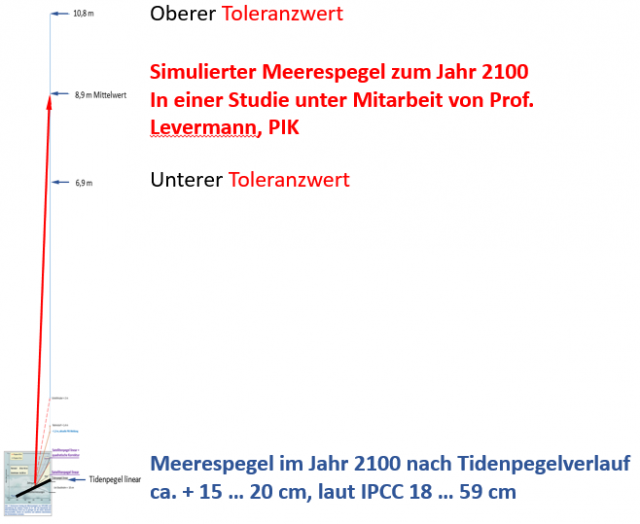

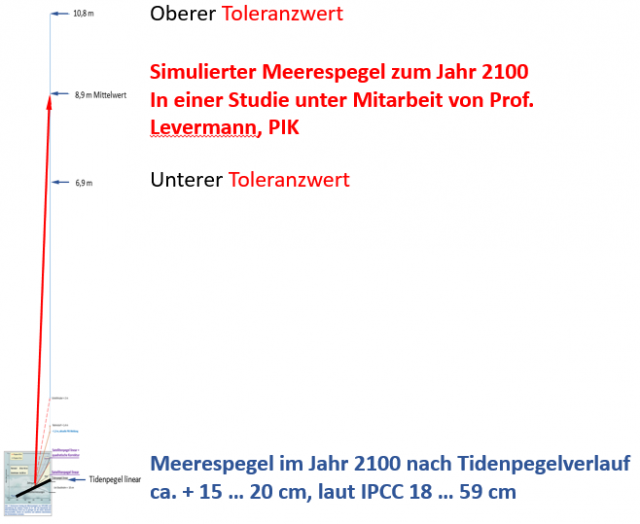

Unsere Politik lässt sich wohl ausschließlich von Personen beraten (und finanziert nur solche, wie das PIK), welche extrem seltene Horrorszenarien simulieren und als Angst und Möglichkeit „verkaufen.

[Link] EIKE 19. Mai 2020:

Das Ende der Menschheit ist in 30 Jahren

Dabei kommen dann Ergebnisse zustande, welche zwar nie eintreten (rein physikalisch auch nicht können), doch trotzdem für bare Münze genommen werden.

Bild 8 Pegel-Verlaufssimulationen unter Mitarbeit des PIK. Daten [11]. Grafik vom Autor erstellt

Man bekommt damit aber auch Verständnis. Ein Atollbewohner*in, der von einer explizit als Fachinstitut ausgewiesenen Quelle eine solche Grafik vorgesetzt bekommt und erfährt, dass diese Quelle in allen Gremien sitzt – teils vorsitzt – welche die deutsche Politik zum Klimawandel berät, muss annehmen (dürfen) dass dies Wirklichkeit und ihm dabei nur noch Angst und Bange wird.

Für ein „Steigen“ der Meerespegel gibt es auch ganz andere Ursachen

Zumindest regelmäßigen EIKE-Lesern sind die Darstellungen bekannt, mit denen bewusst Einwohner-verursachte Landsenkungen dem Klimawandel zugeschrieben werden:

[Link] EIKE 18.06.2019: Küstenstädte versinken, (auch) weil das Geld stattdessen zur CO2-Reduktion hinausgeworfen wird

Ein ganz eklatantes Betrugsbeispiel ist Manila:

[Link] EIKE 13.08.2017: Manila versinkt durch Wasserentnahme im austrocknenden Untergrund. Der (reiche) Westen mit seinem CO2 soll daran schuld sein – und zahlen

Die Atolle haben diese Probleme mit Landsenkung (dafür andere) durch Grundwasserentnahmen weniger, dafür aber andere – sich ähnlich äußernde – Probleme. Keines davon wird im SZ-Artikel auch nur erwähnt.

Man muss heute wirklich froh sein, wenn Forscher (aufgrund sprudelnder Fördermittel) ganz Banales und längst Bekanntes neu „entdecken“ und darauf so stolz sind, dass sie es auch noch publizieren. Zum Beispiel, dass der Grund des Pazifischen Feuerrings die Plattentektonik ist und wo solche vorliegt, Vulkanismus und extreme Erdbeben seit vielen, vielen Jahrtausenden zum Alltag gehören. Und wo starke bis stärkste Erdbeben häufig sind, weil die Erdplatten sich bewegen, hebt und senkt sich auch die Erdoberfläche.

Moderne Redakteure scheinen das aber nicht mehr zu wissen, sonst wären sie über diese früher in der Schule gelernte Banalität nicht so überrascht gewesen:

ntv Dienstag, 26. Juli 2011: Umsiedlung im Pazifik Klimawandel nicht allein schuld

… Das Wasser rückte immer näher. Deswegen verließen die Einwohner den Hauptort der pazifischen Insel Tegua. Lange Zeit wurde für den Anstieg des Meeresspiegels der Klimawandel alleine verantwortlich gemacht. Forscher stellen jetzt aber auch noch eine andere Ursache fest.

Das zum Inselstaat Vanuatu gehörende Eiland sinkt aufgrund der Plattentektonik nach unten. Damit erscheint der beobachtete Wasseranstieg dramatischer, als er ist …

Sie kommen zu dem Schluss, dass die kleine Inselgruppe Torres Island, zu der auch Tegua gehört, durch die geologischen Prozesse etwa einen Zentimeter im Jahr tiefer rutscht (-0,94 Zentimeter +/- 0,25 Zentimeter). Hinzu kommt ein Meeresspiegel-Anstieg von etwa 1,2 Zentimetern (+/- 0,15 Zentimeter). Beides zusammengenommen ergibt den beobachteten schnellen Anstieg. Die Resultate seien auch für die Analyse des steigenden Meeresspiegels in anderen Regionen der Welt von Bedeutung.

In der Darstellung von ntv ist zudem ein gravierender Fehler. Wahrscheinlich aufgrund der mangelnden Kenntnis der Redaktion fiel nicht auf, dass wohl eine Kommastelle verschoben wurde:

Der Tidenpegel-Anstieg beträgt nicht „etwa 1,2 Zentimeter“, sondern je nach Lage 1 … 2,5 mm pro Jahr. Wenn die Plattentektonik dann wirklich „-0,94 Zentimeter“ Senkung pro Jahr verursacht, übersteigt diese Wirkung die des Pegelanstiegs um das 5 … 10-Fache. Nur, gibt es dafür keine Reparationszahlungen des reichen Westens.

Anbei nochmals eine Quelle, die Ähnliches berichtet:

[Link] SPEKTRUM.DE 17.05.2019: Tektonik: Erdbeben lässt Insel schneller versinken

Die Pazifikinsel Samoa muss sich schneller auf den steigenden Meeresspiegel einstellen. Ein schweres Erdbeben sorgte dafür, dass das Eiland weiter absinkt.

Am 29. September 2009 ereignete sich knapp 1809 Kilometer vor den Inseln von Amerikanisch-Samoa ein gewaltiges Erdbeben. Mit einer Stärke von 8,1 löste es bis zu 14 Meter hohe Tsunamis aus, die mehrere Dörfer wegrissen und 200 Menschen töteten.

Durch das Beben soll es vor Ort bis zum Ende des Jahrhunderts zu einem zusätzlichen Anstieg des Pazifiks um 30 bis 40 Zentimeter kommen, schreiben die Autoren. Die gegenwärtige Rate, in der der Meeresspiegel hier ansteigt, liege fünfmal höher als im globalen Mittel, was Siedlungen an der Küste zusätzlich gefährde, so Han und Co. Vor dem Ereignis stieg der Meeresspiegel in der Region um zwei bis drei Millimeter jährlich – vo50r allem wegen der Eisschmelze an den Polen und der thermisch bedingten Ausdehnung des Wassers durch die Erderwärmung –, doch habe sich dies nun drastisch beschleunigt, erzählt Han in einer Mitteilung.

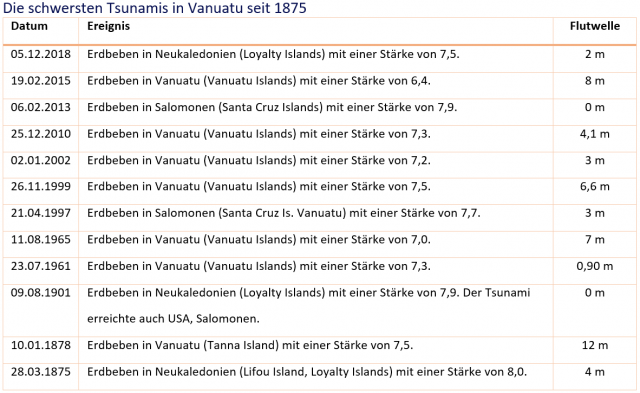

Doch regelmäßig steigt er extrem

Im gesamten Artikel wird bezüglich des Meeresspiegels alleine über die Probleme durch natürlichen Anstieg referiert, wie er seit dem Ende der letzten Eiszeit ganz natürlich geschieht. Dabei handelt es sich selbst in offiziellen Projektionen bis zum Jahr 2100 um wenige Zentimeter (zwischen 10 … 50 cm), Größenordnungen, welche in der Vergangenheit bereits ohne anthropogen emittiertes CO2 vorkamen. Trotzdem stellt der Artikel dies als „das Horrorszenario“ dar:

SZ: [1] … Würde der Meeresspiegel um fünfzig Zentimeter ansteigen, wäre Worasifiu verloren …

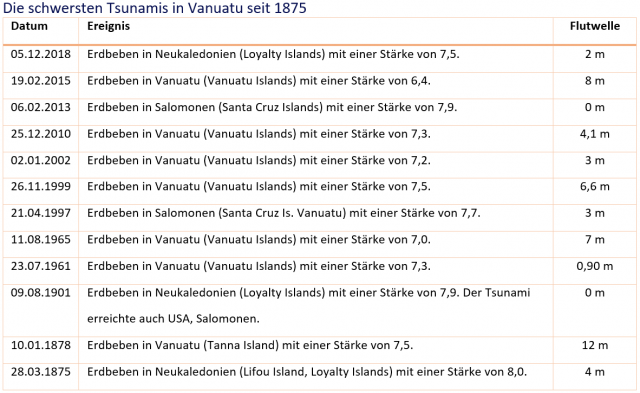

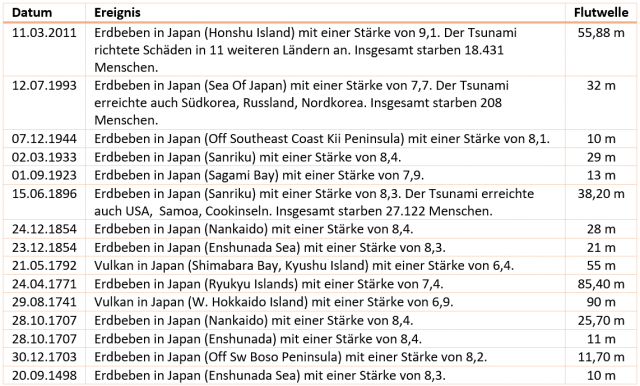

Dabei werden die Inseln rund um den Pazifischen Feuerring regelmäßig mit ganz anderen Pegelhöhen konfrontiert. Vanuatu macht da keine Ausnahme, auch wenn die extremen Flutwellen an der Küste Japans nicht entfernt erreicht werden.

Bild 9 Vanuatu, die schwersten Tsumamis seit 1875 mit Höhe der Flutwelle. Quelle: Laenderdaten.info Tsunamis in Vanuatu

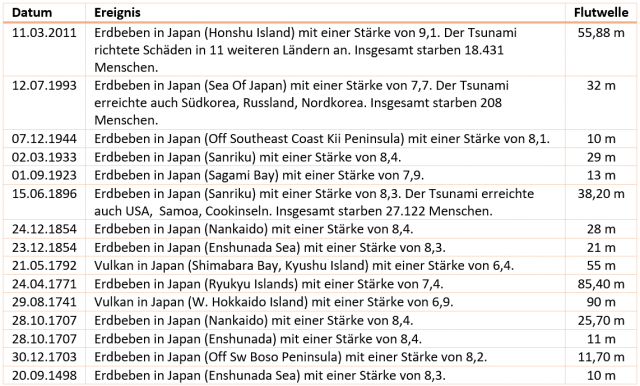

Um sich ein Bild zu machen, noch ganz andere Höhen solcher Flutwellen, wie sie Japan regelmäßig erleiden muss:

Bild 10 Japan, die schwersten Tsumamis Japan seit 1498 mit Höhe der Flutwelle. Quelle: Laenderdaten.info Tsunamis in Japan

Hilft deshalb irgend ein westliches Land Japan bei der Bewältigung solcher Naturkatastrophen?

Ergänzend noch, dass alleine beim Tsunami 2004 im Indischen Ozean ca. 228.000 Menschen starben.

Aber wegen „erwarteter“ 10 … 50 cm Pegelerhöhung zum Jahr 2100 in einem Land, welches davon praktisch überhaupt nicht wesentlich beeinträchtigt ist, da die Vanuatu-Inselgruppe nur die Strände auf Meereshöhe hat, hinter denen in der Regel sofort Anhöhen beginnen, soll gehaftet werden? Dabei ist die Besiedlung dieser durch Tsunamis hoch gefährdeten, direkten Strandabschnitte oft reiner „Faulheit“ geschuldet, um es mit dem Gang zu den Fischerbooten nicht weit zu haben.

Man muss sich einmal vorstellen, die Deutsche Nordseeküste wäre wie Vanuatu oder gar Japan von Tsunami-Ereignissen betroffen. Was würde unsere fürsorgliche Regierung dann machen, die rein „vorsichtshalber“ einfach alle Kernkraftwerke abschalten lässt?

Das Recht auf ein unversehrtes Leben …

Der Anspruch mancher Leute geht heutzutage so weit, zu fordern, dass sie ohne Einflüsse der Natur leben „dürften“ und sofern ein Ereignis davon abweicht, die Ursache zu finden und diese zu Regress genommen werden kann. Der Klimawandel ist dafür prädestiniert, denn er ist wohl die einzige (Pseudo-)Wissenschaft, in der zu jedem Ereignis nur eine einzige Ursache denkbar und damit automatisch verantwortlich ist. Sogar als Analphabet lassen sich mittels Googeln die (Haupt-)Verursacher finden und damit als Zahlmeister für Regressansprüche dingfest machen:

SZ: [1] … Ein Land leidet unter der Entwicklung, für die es nichts kann. Wer also soll dafür haften? Geht es nach Ralph Regenvanu, dem Außenminister Vanuatus, ist die Antwort einfach … Meine Regierung untersucht nun alle Möglichkeiten, das Justizsystem in verschiedenen Ländern zu nutzten … um die Kosten des Klimaschutzes wieder auf die verantwortlichen Länder zu verlagern, die am meisten fossile Brennstoffe nutzen …

SZ: [1] … Könnte sich Vanuatu auf das Recht auf ein unversehrtes Leben berufen? … demnach wäre Hitze eine Art der Umweltverschmutzung. Oder auch der Menschenrechtsgrundlage, zum Beispiel das Recht auf ein unversehrtes Leben. Und wären die Angeklagten dann etwa Europa, oder die USA? Also Kontinente und Länder, die den Unternehmen keine Grenzen setzen? …

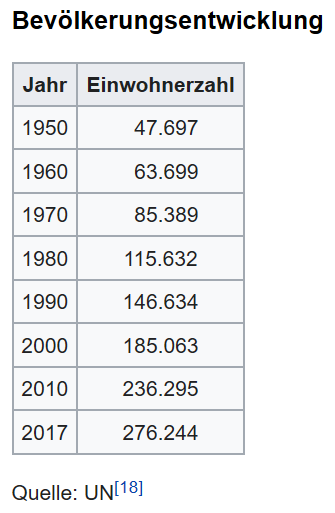

… kollidiert mit dem „Recht“ auf unbeschränkte Überbevölkerung

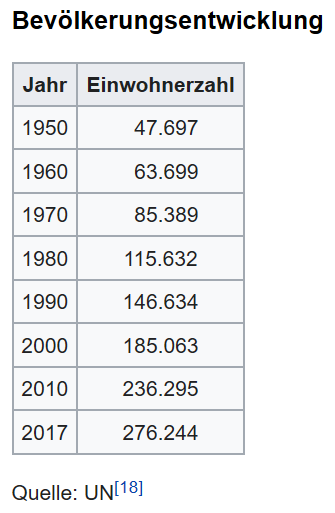

In fast keinem Artikel, der schlimme Verhältnisse vor Ort anprangert und dafür den reichen Westen verantwortlich macht, – sei es über den Pazifik oder sei es über Afrika, wird eine Hauptursache vieler der geschilderten Probleme erwähnt: Der teils extreme Populationszuwachs. Der Bericht macht darin keine Ausnahme:

Bild 11 Bevölkerungsentwicklung Vanuatu. Quelle: WIKIPEDIA

Und es wird darin auch nicht erwähnt, dass ausgerechnet die Technik und Mittel, welche die reichen Länder bereitstellen (können), solchen Bevölkerungszuwächsen dort ein angenehmes Leben erst ermöglichen. Und sei es auch nur, indem man bei ihnen das zum dortigen Leben erforderliche Geld verdienen kann.

Inzwischen hat man jedoch gelernt, dass man beides ohne eigenes Zutun haben kann, wenn man nur forsch genug auftritt:

kaltesonne 21.06.2014:

Allianz der kleinen Inselstaaten will ans Klimageld ran

Und so lange es eine Frau Merkel schafft, immer neu dafür zu sorgen, dass das Umweltministerium von den ahnungslosesten, aber Klimawandel-gläubigsten und ihr absolut kritiklos hörigen Umweltminster*innen „besetzt“ wird, gelingt es solchen Allianzen auch, ihre durch nichts zu rechtfertigenden Wünsche durchzusetzen.

Anmerkung: Das gilt nicht nur für Umweltminister*innen. Beim aktuellen Entwicklungsminister ist es nicht anders (rein persönliche Ansicht des Autors, die durch keine Studie oder offizielle Hintergrundinformation belegt ist).

Fazit

Da ein privater Autor keine Falschnachrichten verbreiten darf, als Ersatz eine offizielle einer Fachperson:

Gastbeitrag Wetterexperte Jörg Kachelmann im Bayernkurier vom 20.11.2019: „Weil es besser knallt“

Lügen, dass sich die Balken biegen

… Zum Bösen gehört, dass zum Klimathema gelogen wird, dass sich die Balken biegen, weil es gerade ins persönliche oder politische Süppchen passt.

… Die gesammelten desinformierenden Unwissenschaftlichkeiten treffen auf eine traurige Mediensituation, in der klickschlampesker Erfolg wichtiger ist als geringste Restwassermengen von Seriosität. Dumm klickt gut. Weshalb wir nur noch wahlweise lesen dürfen, dass der Winter rekordwarm oder rekordkalt würde und beide Varianten werden natürlich dem Klimawandel zugeschrieben, was genauso völliger Blödsinn ist wie die Aussage selbst. Aber das ist dem „Focus“, dem „Merkur“ oder der „Süddeutschen“ völlig wurscht. Geschrieben wird’s trotzdem, weil’s gut läuft mit dem Schwachsinn ...

Propaganda heißt im deutschen Neusprech Qualitätsjournalismus

SZ: [1] Die Recherche wurde unterstützt vom Verein Netzwerk Recherche, Der Mercator-Stiftung, der Otto-Brenner-Stiftung

Die rein persönliche Meinung des Autors (durch keine Studie und Aussage von wirklichen Fachpersonen zum Beispiel vom PIK belegt) zum SZ-Artikel lautet: Ein schlimmerer, vollkommen substanzloser Propagandaartikel ist selten zu finden, spiegelt aber das Niveau „modernen“ Journalismus in Deutschland exemplarisch wieder.

Bei diesem Artikel kommt dazu, dass ein Verein in der Sponsorenlistung steht, der angeblich genau das Gegenteil bewirken will. Womit sich die Frage stellt: Wurde der Verein ebenfalls (wie die Leser) bezüglich des Inhaltes betrogen oder fand er den Artikel gar gut?

Netzwerk Recherche e.V. … ist ein eingetragener, gemeinnütziger Verein, der 2001 von Journalistinnen und Journalisten gegründet wurde, um die journalistische Recherche und den Qualitätsjournalismus in Deutschland zu stärken.

Der Zweck des Vereins ist gemäß Satzung die Förderung der Bildung, insbesondere durch

-die Vermittlung von Recherchetechniken im Rahmen der journalistischen Ausbildung,

-die Vermittlung von Wissen über professionelle Recherche zur Qualitätssteigerung der Medienberichterstattung,

-die Information über Maßnahmen zur Wahrung der Medienkultur sowie

-die Vermittlung von Wissen und den Erfahrungsaustausch über investigativen Journalismus.

Anlage

Wahlbrief von Bündnis 90/ Die Grünen „an die Bewohner der Carteret Inseln“ (Auszüge):

[4] … Ihre Heimat ist ein Ort, von dem wir Deutschen träumen. Eine Südseeidylle mit weißen Palmenstränden, umgeben von türkisfarbenem Wasser, das funkelnde Unterwasserlandschaften birgt. Welche Wunder die Natur schaffen kann, das wussten Sie schon, als Sie Kinder waren.

Sie leben in diesem Paradies seit vielen Jahrhunderten. Doch nach der Landung der Europäer begann der Niedergang Ihres Landes. Hungersnöte, Übervölkerung und monokulturelle Landwirtschaft zwangen viele Ihrer Landsleute schon vor Jahren zur Flucht.

… Wir tragen die Verantwortung für diese Katastrophe. Nicht nur bei Ihnen, überall auf der Welt sind die Vorboten der Klimakatastrophe sichtbar: Eisberge schmelzen, der Meeresspiegel steigt, die Unwetter werden schwerer, ganze Landstriche werden verwüstet. Am schlimmsten trifft es die Menschen in den Ländern, die am wenigsten zum Klimawandel beitragen. Wie Sie.

Wir, der Norden, sind in der Pflicht, endlich zu handeln.

…. Ob Sie es glauben oder nicht: Während bei Ihnen der Meeresspiegel steigt, wollen eben diese beiden bei uns regierenden Parteien neue Kohlekraftwerke bauen – obwohl jeder weiß, dass nichts klimaschädlicher ist.

Nun wird bei uns ein neues Parlament gewählt. Wir Grüne versprechen Ihnen: Egal ob wir nach dieser Wahl regieren oder in der Opposition landen; wir werden mit allen uns zur Verfügung stehenden Mitteln dafür kämpfen, dass unser Land wieder Vorreiter beim Klimaschutz wird.

Quellen

[1] SZ 23.05.2020 (Printausgabe): Das Ende der Welt

[2] Zeit Online: Ann Esswein

[3] Linkedin: Ann Esswein (Bachelor’s degreeSpecialist) Journalismarbeitet als freischaffende Journalistin, Autorin und Filmemacherin über die Themen Außenpolitik, Entwicklungszusammenarbeit, Flucht und Migration, Menschenrechte und humanitäre Hilfe.

[4] Briefe zur Wahl: BÜNDNIS 90/DIE GRÜNEN an die Bewohnerinnen und Bewohner der Carteret-Inseln (mittlerweile auf der Homepage der GRÜNEN gelöscht)

[5] Wiener Zeitung 08.09.2018: Klimawandel Waldhüter und Korallengärtner

[6] SZ: [1] Die Recherche wurde unterstützt vom Verein Netzwerk Recherche, Der Mercator-Stiftung, der Otto-Brenner-Stiftung

[7] WELT 30.01.2014: Zyklone Langzeit-Vergleich offenbart Flaute um Australien

[8] Publikation Missionsgeschichte Vallendar, WS 2008/2009

[9] EIKE 17. Oktober 2018: SAMOAS Premier: Wir wollen Klimareparationszahlungen sehen. Wer deshalb nach Betroffenheitsbelegen fragt, gehört weggesperrt

[10] EIKE 10.05.2017: Die Volkshochschule Hannover und ihre Ausstellung: Wir alle sind Zeugen – Menschen im Klimawandel

[11] Climate Central, November 2015: MAPPING CHOICES CARBON, CLIMATE, AND RISING SEAS OUR GLOBAL LEGACY