Wolkenrückkopplung – falls es sie überhaupt gibt – ist negativ

Ich habe bei einem begutachteten Journal eine Studie eingereicht, und bemerkenswerterweise hat sich das Journal dankbar geäußert und sie ins Netz gestellt, während die Begutachtung läuft. Hier folgt diese Studie. Aber es war nicht einfach, bis zum folgenden Punkt zu kommen: Ich denke, dass das in der Studie von mir Beschriebene von großer Bedeutung für die Klimawissenschaft ist, wie vielleicht aus einigen Formulierungen darin hervorgeht. Darum war ich erpicht darauf, sie in einem begutachteten Journal veröffentlicht zu sehen – dem IPCC zufolge sollten nur begutachtete Studien herangezogen werden. Das erste Journal, bei dem ich die Arbeit eingereicht hatte (November 2019) brauchte zwei Monate, um mir mitzuteilen, dass die Studie außerhalb der von dem Journal umfassten Thematik liege – eine seltsame Behauptung. Das zweite Journal brauchte vier Monate, um mich zu benachrichtigen, das man bisher keinen Begutachter gefunden hätte und dass die Studie eines anderen Formats für Quellenangaben sowie einiger kleiner anderer Formatänderungen bedarf. Also zog ich die Studie zurück. Ich habe ein paar Verbesserungen an der Studie vorgenommen während dieses Zeitraumes, aber ich bezweifle, ob das hinsichtlich der Begutachtungen ins Gewicht fällt.

Die Studie: Wolkenrückkopplung – so es sie überhaupt gibt – ist negativ

Autor: M. Jonas

ABSTRACT

Nahezu alle vom IPCC herangezogenen Klimamodelle zeigen eine starke positive Wolken-Rückkopplung. Hierbei handelt es sich um den Prozess, bei dem eine sich ändernde Temperatur an der Erdoberfläche die Wolkenbedeckung beeinflusst, was wiederum die Temperatur beeinflusst. In dieser Studie werden alle monatlichen Satellitendaten im Zeitraum Juli 1986 bis Juni 2017 analysiert, um die Klimamodelle auf diesen Punkt hin abzuklopfen. Wie erwartet zeigten sich über diesen Zeitraum steigende Trends der Wassertemperatur und zurückgehender Wolkenbedeckung. Aber die Analyse zeigte auch eine unerwartete Relation zwischen Wassertemperatur und Wolkenbedeckung: steigende Wassertemperaturen sind verbunden mit zunehmender – und nicht abnehmender – Wolkenbedeckung während der folgenden paar Monate. Außerdem neigt die Zunahme der Bewölkung dazu, einen größeren Anteil der Sonneneinstrahlung abzuhalten als sie die Ausstrahlung von den Ozeanen behindern. Die unvermeidliche Schlussfolgerung daraus lautet, dass die Wolken-Rückkopplung negativ ist. In jedem Falle kann die beobachtete Abnahme der Bewölkung über den Ozeanen im Zeitraum 1986 bis 2017 nicht einer Rückkopplung durch steigende Temperaturen geschuldet sein. Die Implikationen für Klimamodelle sind verheerend.

1. INTRODUCTION

Die Ozeane bedecken etwa 70% der Erdoberfläche und speichern in den obersten 3 Metern mehr Wärme als die gesamte Atmosphäre. Folglich liegt der Schlüssel zum Verständnis eines globalen Klimawandels untrennbar in den Ozeanen.

Spencer und Braswell (13), welche Satellitendaten und Modelle ausgewertet hatten, berichteten, dass die Diagnose der atmosphärischen Rückkopplung im Klimasystem ein nach wie vor ungelöstes Problem darstellt. Sie schreiben: „Die Größenordnung der Reaktion der Temperatur im Klimasystem auf ein aufgedrücktes Energie-Ungleichgewicht ist heute noch genauso unbekannt wie vor Jahrzehnten schon“. Zieht man jedoch ausschließlich Satellitendaten über einen längeren Zeitraum heran, löst diese Studie eines der großen Aspekte bzgl. Rückkopplungen, nämlich das Signal der Wolken-Rückkopplung. In die Studie gehen ausschließlich empirische Daten ein. Genauer, sie verwendet Daten aus dem gesamten Zeitraum, von der gesamten Ozeanfläche – und es gehen keinerlei Modellwerte ein.

Das IPCC (5) definiert Klima-Rückkopplung als eine Wechselwirkung zwischen Prozessen, wenn „ein initaler Prozess Änderungen bei einem zweiten Prozess bewirkt, welche wiederum den ersten Prozess beeinflussen“. Und es stellt fest, dass eine Möglichkeit, dies zu quantifizieren, darin besteht, „es als Reaktion des Klimasystems auf eine globale Temperaturänderung“ zu betrachten. Wolken-Rückkopplung ist also der Prozess, durch welchen die Bewölkungsmenge durch eine sich ändernde Temperatur beeinflusst wird, was wiederum die Temperatur beeinflusst. Man beachte, dass die Wolken-Rückkopplung nicht abhängig ist von der ursprünglichen Ursache der Temperaturänderung.

Rückkopplungen aufgrund der Temperatur waren schwierig von anderen Auswirkungen auf die Temperatur zu trennen, läuft doch der initiale Prozess „fast simultan mit der Temperaturänderung“, aber für den zweiten Prozess gilt, dass es „eine substantielle zeitliche Verzögerung zwischen Antrieb und der Reaktion der Temperatur gibt infolge der Wärmekapazität der Ozeane“ (13).

Ziel dieser Studie ist es zu erkennen, ob die Auswirkungen der Wassertemperatur (SST) auf die Bewölkung erkannt werden können. Hierzu werden SST-Änderungen verglichen mit späteren Änderungen der Bewölkungsmenge.

2. Verfahren

Monatliche Gitterpunkts-SST-Daten [gridded monthly SST data] wurden heruntergeladen vom NOAA/OAR/ESRL PSD in Boulder. Jedes Gitterquadrat ist 1 Längengrad mal 1 Breitengrad groß.

In gleichem Umfang wurden monatliche Wolken-Daten (Wolkenbedeckung in % und optische IR-Daten) vom International Satellite Cloud Climatology Project (ISCCP) im NASA Goddard Institute for Space Studies (GISS) heruntergeladen. Nur Ozean-Daten wurden verwendet ohne Daten vom Festland und an den Küsten.

Daten der beiden Datensätze wurden nur für die Monate und die Gebiete verwendet, in denen sowohl die Wolken- als auch die SST-Daten vollständig waren. SST-Daten in Gebieten und Monaten fehlten aufgrund der Bedeckung mit Meereis.

Für jeden Monat wurden die SST und die Wolkenbedeckung über die gesamte Ozeanfläche gemittelt. Für die SST wurden die einzelnen Temperaturwerte in Kelvin umgerechnet, vor der Mittelwertbildung auf die 4. Potenz angehoben und dann wieder in Grad C umgerechnet. Dadurch wurde sichergestellt, dass sich die berechneten durchschnittlichen SSTs korrekt auf die von der Meeresoberfläche ausgehende Strahlung bezogen.

Für jeden Monat nach dem ersten Jahr wurde die globale Veränderung der SST gegenüber dem Vorjahr berechnet (hier als „dSST“ bezeichnet). Diese wurden dann über eine unterschiedliche Anzahl von Monaten gemittelt, und jeder Durchschnitt wurde im Vergleich zum Endmonat des gemittelten Zeitraums aufgezeichnet. Die globale jährliche Veränderung der Wolkenbedeckung („dCloud“) wurde für die gleiche Anzahl von Monaten gemittelt, aber für spätere Perioden, die sich nicht mit dem für den dSST verwendeten Zeitraum überschneiden. Zu Vergleichszwecken wurde dCloud für den gleichen Monat wie die zugehörige dSST aufgezeichnet, und zwar für jede Kombination aus der Anzahl der gemittelten Monate und der Anzahl der Monate später. Der lineare Trend von dCloud gegen dSST wurde dann für jede Kombination unter Verwendung der Standardtabellenfunktion Trend berechnet (NB der Trend war von dCloud gegen dSST, nicht gegen die Zeit).

3. Grundgedanken

Wie Spencer und Braswell feststellten (13), ist die Rückkopplungs-Reaktion auf die Temperatur „fast simultan mit der Temperaturänderung“. Eine Änderung der SST sollte daher sehr bald danach zu einer Änderung der Wolkenbedeckung (d.h. Wolkenrückkopplung) führen. Es besteht daher die Möglichkeit, dass eine Wolken-Rückkopplung in den monatlichen Daten festgestellt werden kann. Der relevante Vergleich, der vorgenommen werden muss, ist der zwischen einer Änderung der SST und einer Änderung der Wolkenbedeckung im folgenden Monat oder in den folgenden Monaten.

Diese Studie verwendet Veränderungen von Jahr zu Jahr und behandelt alle Kalendermonate gleich, um jegliche Möglichkeit saisonaler Effekte zu vermeiden. Sie vermeidet sich überschneidende Zeiträume für dSST und dCloud, um die Möglichkeit zu minimieren, dass der Einfluss von Wolken auf die SST die Ergebnisse beeinflusst. Und weil nach einem schnellen Effekt gesucht wird, begrenzt sie jeden betrachteten Gesamtzeitraum (vom ersten dSST-Monat bis zum letzten dCloud-Monat) auf nicht mehr als 12 Monate.

Es ist unwahrscheinlich, dass sich der Effekt einer Änderung der Wolkendecke innerhalb eines Monats oder innerhalb weniger Monate in den SST-Daten niederschlägt [13], so dass ein Vergleich der Daten in umgekehrter Richtung – Änderung der Wolkendecke im Vergleich zur SST-Änderung im folgenden Monat oder in den folgenden Monaten – wahrscheinlich nicht zielführend ist. Es ist jedoch bekannt, dass Wolken einen kühlenden Effekt auf das Klima haben, siehe zum Beispiel Pokrovsky (8), der einen (globalen) Erwärmungseffekt von 0,07°C pro Abnahme der Bewölkung um 1% berechnet.

4. Ergebnisse

4.1 Wolkendecke

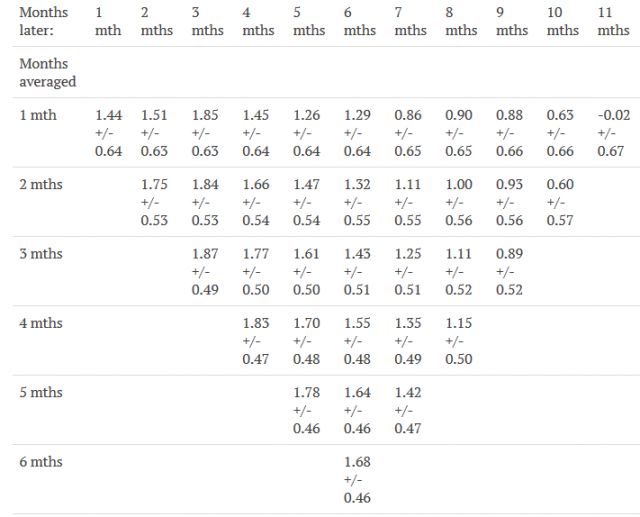

In allen Fällen mit dCloud bis zu 9 Monate später als dSST, war der lineare Trend von dCloud gegen dSST positiv, und dies war ein starkes und konsistentes Muster. Mit anderen Worten, den Monaten mit höherem dSST folgten tendenziell Monate mit höherer dCloud, und niedrigerem dSST folgten tendenziell niedrigere dCloud.

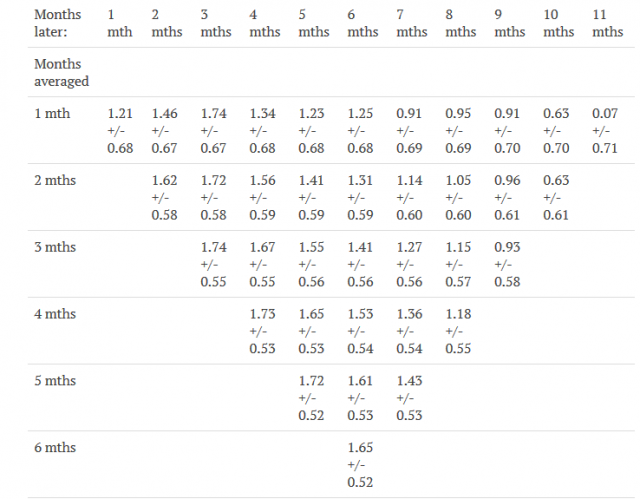

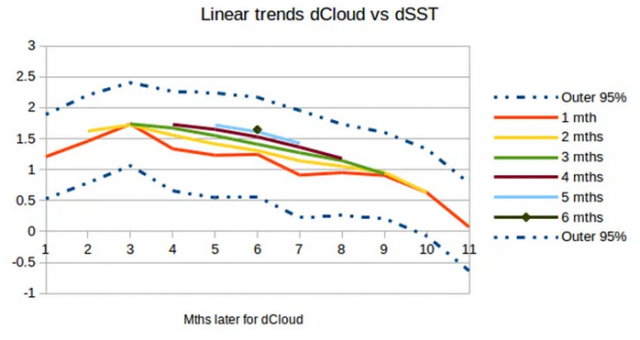

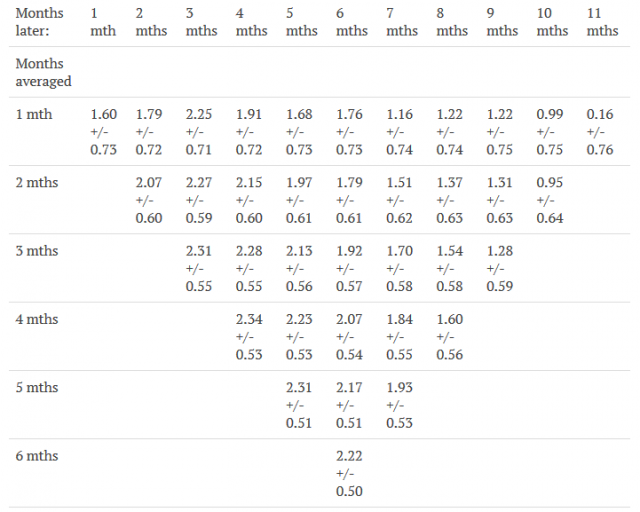

Die linearen Trends von dCloud gegenüber dSST sind in Abbildung 1 und grafisch in Abbildung 2 dargestellt.

Lineare Trends der globalen mittleren dCloud vs. dSST – ungewichtet (d. h. in gleich großen Gebieten) +/- 2*Sigma

Abbildung 1. Lineare Trends der globalen durchschnittlichen dCloud im Vergleich zu dSST, mit 95% Vertrauensniveau. Jeder Monat wird über die unter „Monate gemittelt“ angegebene Anzahl von Monaten gemittelt. Die dCloud-Werte gelten für die angegebene Anzahl von Monaten später.

Abbildung 2: Wie Abbildung 1, nur graphisch. Die Grenzen des 95% Vertrauensniveaus sind eingezeichnet.

Man beachte, dass von den Trends erwartet werden kann abzufallen mit zunehmenden „Monate später“ infolge des Einflusses der dazwischen liegenden Monate.

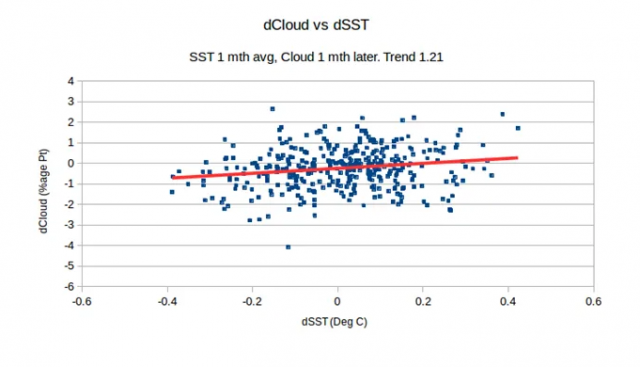

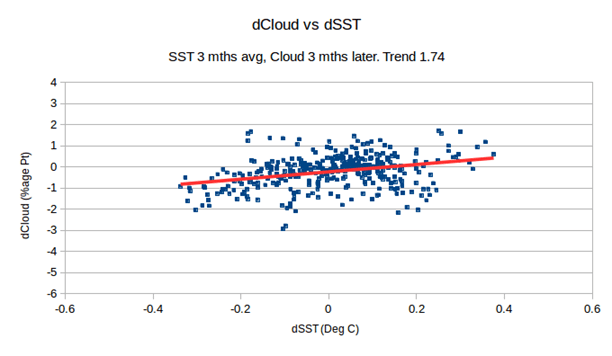

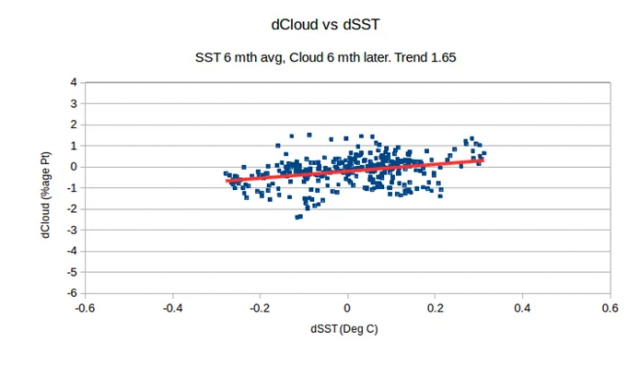

Die Trends sind eindeutig erkennbar in Graphiken mit dem Vergleich von dCloud und dSST und reflektieren die Daten als Ganzes und nicht nur einige Ausreißer. Einige Beispiele zeigen die Abbildungen 3, 4 und 5.

Abbilung 3: dSST für 1 Monat im Vergleich zu dSST im folgenden Monat

Abbildung 4: dSST gemittelt über 3 Monate im Vergleich zu dSST während der folgenden drei Monate

Abbildung 5: dSST gemittelt über 6 Monate im Vergleich zu dCloud über die folgenden 6 Monate.

Die Graphiken der Abbildungen 3, 4 und 5 sind alle im gleichen Maßstab.

4.2 Licht-Undurchlässigkeit von Wolken

Wolken größerer optischer Dichte unterbinden mehr Strahlung – sowohl was die Sonneneinstrahlung als auch die Ausstrahlung der Ozeane betrifft. Obige Analyse wurde neu berechnet, wobei Wolken gewichtet nach Lichtundurchlässigkeit einbezogen wurden. Die Lichtundurchlässigkeit, so wie sie in dieser Studie betrachtet wird, leitet sich folgendermaßen aus der optischen Dichte [optical depth] ab:

Die optische Dichte d wird gegeben durch

d = ln(Fr/Ft)

wobei

d = die optische Dichte,

Fr = flux received,

Ft = flux transmitted.

Das Verhältnis q der von den Wolken beeinflussten Strahlung –

q = (Fr–Ft)/Fr

wird hier als „Licht-Undurchlässigkeit“ [opacity] genommen. q kann aus der Formel von d abgeleitet werden als

q = 1 – e(-d)

Die Lichtundurchlässigkeit q kann legitimerweise arithmetisch gemittelt werden über Wolkenanteile.

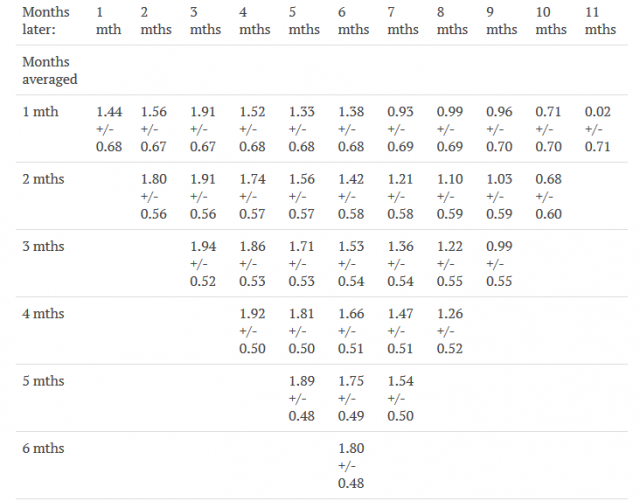

Wenn die Wolkendaten nach Lichtundurchlässigkeit gewichtet werde, ergibt sich die Tabelle dCloud vs. dSST so:

Lineare Trends des globalen Mittels von dCloud vs. dSST – gewichtet nach Lichtundurchlässigkeit +/- 2*Sigma

Abbildung 6. Lineare Trends der globalen durchschnittlichen dCloud gegen dSST mit 95% Vertrauensniveau, wie in Abbildung 1, aber mit nach Lichtundurchlässigkeit gewichteter Wolkendecke.

Wie aus den Abbildungen 1 und 6 ersichtlich, tendiert die erhöhte Bewölkung in Verbindung mit erhöhter SST auch dazu, für mehrere Monate eine größere Lichtundurchlässigkeit zu haben. Es gibt also nicht nur eine erhöhte Wolkenfläche, sondern auch eine erhöhte Wolkenmenge (gemessen an ihrer Fähigkeit, Strahlung abzufangen).

4.3 Auswirkung auf einfallende und ausgehende Strahlung

Um den relativen Einfluss der Wolkenveränderungen auf die ein- und ausgehende Strahlung zu bestimmen, wurde die Analyse neu berechnet, wobei die Wolken gewichtet wurden (a) mit der Opazität multipliziert mit der einfallenden Sonnenstrahlung (monatliche Sonnenstrahlungsdaten aus [2]) und (b) mit der Opazität multipliziert mit der ausgehenden Meeresstrahlung (aus SST). Es ist zu beachten, dass ein Unterschied zwischen (a) und (b) in erster Linie aus den unterschiedlichen Verteilungen der einfallenden Sonnenstrahlung und der ausgehenden Meeresstrahlung nach Breitengraden resultieren würde, nicht aus Variationen der Sonnenleistung.

Die Tabelle von dCloud vs. dSST würde dann das Aussehen wie in den Abbildungen 7 und 8 bekommen.

Lineare Trends der globalen durchschnittlichen dCloud vs. dSST – gewichtet nach Opazität der Wolken und Sonneneinstrahlung +/- 2*Sigma

Abbildung 7. Lineare Trends der globalen durchschnittlichen dCloud vs. dSST mit 95% Vertrauensniveau, wie in Abbildung 1, aber mit Wolkendecke gewichtet mit der Opazität multipliziert mit der einfallenden Sonnenstrahlung.

Lineare Trends der globalen durchschnittlichen dCloud im Vergleich zum dSST – gewichtet nach Wolkendecke und Meeresstrahlung +/- 2*Sigma

Abbildung 8. Lineare Trends der globalen durchschnittlichen dCloud vs. dSST mit 95% Vertrauensniveau, wie in Abbildung 1, aber mit Wolkendecke gewichtet mit Opazität multipliziert mit ausgehender Meeresstrahlung.

In den ersten Monaten sind alle mit der einfallenden Sonnenstrahlung gewichteten Trends höher als die mit der ausgehenden Meeresstrahlung gewichteten Trends. Dies zeigt, dass die Zunahme der Wolkendecke in Verbindung mit der Zunahme der SST eine größere Auswirkung auf die einfallende Strahlung hat als auf die ausgehende Strahlung. Mit anderen Worten, sie sind eine Nettoabkühlung.

5. CONCLUSION

Die Daten zeigen, dass es eine positive Korrelation zwischen Veränderungen des SST und späteren Veränderungen der Wolkendecke gibt. Wie oben erwähnt, ist bekannt, dass Wolken einen globalen Kühleffekt haben, und die Analyse hat gezeigt, dass Änderungen der Wolkendecke in Verbindung mit Änderungen des SST-Anstiegs die Wolken tatsächlich einen stärkeren Kühleffekt haben. Die unausweichliche Schlussfolgerung ist, dass jede Rückkopplung von Wolken negativ ist.

Diese Schlussfolgerung hat tiefgreifende Auswirkungen auf die Klimamodelle. Alle Modelle, auf die sich der IPCC bezieht, sind mit positiver Wolkenrückkopplung parametrisiert – „die GCMs sagen alle eine positive Wolkenrückkopplung voraus“ – und sie schreiben fast die Hälfte der gesamten anthropogenen globalen Erwärmung der Wolkenrückkopplung zu [9]. Dies ist ein möglicher Grund dafür, dass die meisten Klimamodelle die globale Erwärmung überschätzen [4] [12], obwohl Anagnostopoulos [1] sagt, dass es viel bedeutendere Probleme gibt.

Eine weitere Schlussfolgerung mit tiefgreifenden Auswirkungen auf die Klimamodelle ist, dass die beobachtete Abnahme der Bewölkung zwischen 1986 und 2017 keine Rückkopplung durch steigende Temperaturen war und dass sie stark genug war, um schließlich jede negative Wolkenrückkopplung aufzuheben. Der IPCC-Bericht [9] legt nahe, dass die Modelle nicht die Möglichkeit erkennen, dass Wolken ein anderes Verhalten als eine Rückkopplung haben können: in den Key Uncertainties sagen sie von Wolken nur: „Es bestehen weiterhin große Unsicherheiten darüber, wie Wolken auf den globalen Klimawandel reagieren könnten“. Diese Studie zeigt, dass Wolken ein bedeutendes Verhalten zeigen, welches in den Modellen nicht berücksichtigt wird.

Die Auswirkungen auf die Klimamodelle sind verheerend. Es muss hinterfragt werden, ob sie für ihren Zweck geeignet sind.

6. DISKUSSION

6.1 Interpretation

1. Die Änderungen der Wolkendecke wie in Abbildung 1 werden verursacht durch Änderungen der Wassertemperatur (SST). Falls das wirklich so ist, dann ist die Wolken-Rückkopplung negativ.

2. Die Änderungen der Bewölkung und die SST-Änderungen werden beide durch einen unbekannten Faktor ausgelöst (d. h. Korrelation ist nicht Kausalität). Falls das der Fall ist, dann ist die Wolken-Rückkopplung Null, oder

3. Es kommt eine Kombination der Punkte 1 und 2 in Betracht. Falls das der Fall ist, dann ist die Wolken-Rückkopplung nicht so negativ wie nach Punkt 1, aber immer noch negativ.

6.2 Andere Interpretationen

Jede andere Interpretation als die oben genannten erscheinen außerordentlich unwahrscheinlich und würden in jedem Fall die vom IPCC herangezogenen Klimamodelle völlig außer Kraft setzen. Zum Beispiel:

(a) Wenn eine Zunahme der SST tatsächlich zu weniger Wolken führt, dann müssten ein oder mehrere unbekannte Faktoren mit größerer Wirkung in die entgegengesetzte Richtung wirken, d.h. ein oder mehrere unbekannte Faktoren müssten nach einer Zunahme der SST mehr Wolken erzeugen, obwohl eine Zunahme des SST dazu führt, dass es weniger Wolken gibt.

(b) Falls eine Zunahme der SST zwar mehr Wolken verursacht, Wolken aber tatsächlich eine erwärmende und nicht eine abkühlende Wirkung haben, dann müssten ein oder mehrere unbekannte Faktoren längerfristig wirken, um sowohl die Wolkendecke zu verringern als auch die SST zu erhöhen.

Wie bereits erwähnt, sind diese beiden Möglichkeiten äußerst unwahrscheinlich und können mit Sicherheit ausgeschlossen werden. Insbesondere die Alternative (b) scheint durch die obige Analyse unter Verwendung von Gewichtungen der ein- und ausgehenden Strahlung ohnehin ausgeschlossen zu sein.

6.3 Quantifizierung

Es wäre verlockend, die negative Wolken-Rückkopplung zu quantifizieren, indem man die linearen Trends zwischen dCloud und dSST, wie oben berichtet, und die linearen Trends von SST und Wolkenbedeckung über den analysierten Zeitraum verwendet.

Eine solche Quantifizierung wäre zum jetzigen Zeitpunkt nicht zu rechtfertigen, denn solange die beteiligten Prozesse nicht einigermaßen gut verstanden sind, wären sie viel zu unzuverlässig. Es gibt einen offensichtlichen möglichen Prozess für eine negative Rückkopplung von Wolken: Wenn sich die Ozeane erwärmen, geben sie mehr Wasserdampf in die Atmosphäre ab, der dann in den nächsten Monaten weitere Wolken bildet. Dieses Konzept wird durch die Beobachtung eines erhöhten Wasserkreislaufs durch Durack [3] gestützt. Der Prozess muss jedoch erst anhand der hier gewonnenen Erkenntnisse bewertet werden, bevor er als der relevante Prozess angenommen werden kann.

6.4 Was kommt als Nächstes?

Eine Quantifizierung des Cloud-Feedbacks ist eindeutig erforderlich, wie in 6.3 Quantifizierung.

Aber es sind auch weitere Untersuchungen zum Verhalten von Wolken erforderlich:

Diese Studie zeigt, dass die beobachtete Abnahme der Bewölkung zwischen 1986 und 2017 keine Rückkopplung durch steigende Temperaturen war. Daraus folgt, dass ein Teil der Zunahme des SST in diesem Zeitraum durch eine davon unabhängige Verringerung der Wolkendecke verursacht worden sein könnte. Herauszufinden, was die Ursache für die Verringerung der Bewölkung war, wäre ein großer Fortschritt für die Klimawissenschaft. Einige Arbeiten sind bereits durchgeführt worden, z.B. [6] [14].

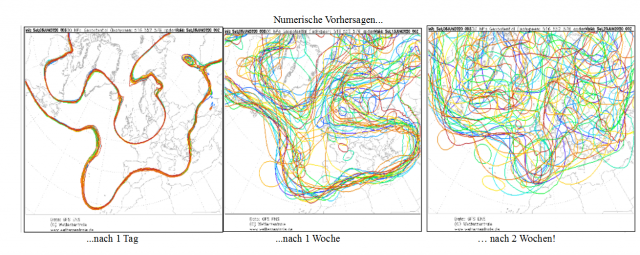

Auf einer allgemeineren Ebene: Es ist überdeutlich, dass die Klimamodelle das Verhalten von Wolken nicht abbilden können. Es muss daher ernsthaft in Frage gestellt werden, ob die Modelle, so wie sie derzeit aufgebaut sind, jemals überhaupt einen Wert für die Vorhersage des zukünftigen Klimas haben werden. Es wäre vernünftig, den Rat von Anagnostopoulos [1] zu berücksichtigen, dass ein Paradigmenwechsel notwendig ist.

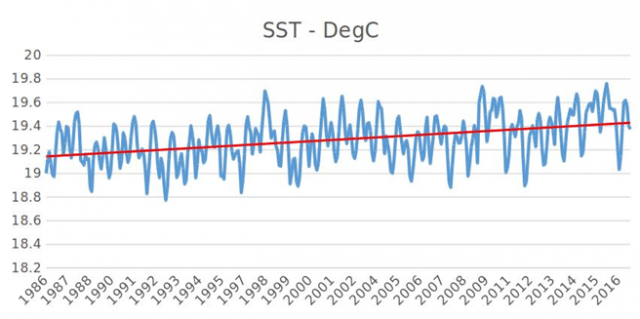

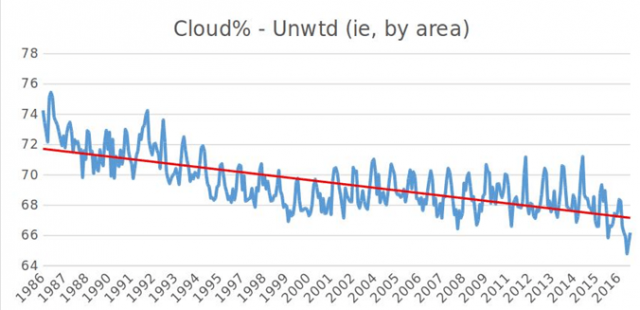

6.5 Allgemeine Trends

Graphiken der SST (Grad Celsius) und Bewölkung (%) zeigen die Abbildungen 9 und 10. Diese stützen die Aussagen im Abstract: „Wie erwartet: die Trends für den gesamten Zeitraum sind steigende SST und abnehmende Bewölkung“.

Abbildung 9: SST-Daten über den untersuchten Zeitraum mit linearem Trend

Abbildung 10: Bewölkungs-Daten über den untersuchten Zeitraum mit linearem Trend.

Die Datenquellen für die SST und die Bewölkung werden in Abschnitt „2. Verfahren“ genannt.

References

1. Anagnostopoulos GG et al 2010: A comparison of local and aggregated climate model outputs with observed data. Hydrological Sciences Journal 55(7), 1094–1110.

https://doi.org/10.1080/02626667.2010.513518

2. Coddington et al 2015: NOAA Climate Data Record (CDR) of Total Solar Irradiance (TSI), NRLTSI Version 2 [monthly TSI]. NOAA National Centers for Environmental Information doi:10.7289/V55B00C1. Data downloaded Jan 2020 from https://www.ncei.noaa.gov/data/total-solar-irradiance/access/monthly/

3. Durack et al 2012: Ocean Salinities Reveal Strong Global Water Cycle Intensification During 1950 to 2000. Science 27 Apr 2012 Vol. 336, Issue 6080, pp. 455-458 DOI: 10.1126/science.1212222

4. Fyfe J et al 2013: Overestimated global warming over the past 20 years. Nature Climate Change 3,767–769 (2013) doi:10.1038/nclimate1972

5. IPCC 2007: Annex I, Glossary, in Climate Change 2007: Synthesis Report. Contribution of Working Groups I, II and III to the Fourth Assessment Report of the Intergovernmental Panel on Climate Change [Core Writing Team, Pachauri, R.K and Reisinger, A. (eds.)]. IPCC, Geneva, Switzerland, 104 pp.

6. Kamide Y 2007: Effects of the Solar Cycle on the Earth’s Atmosphere (in Handbook of the Solar-Terrestrial Environment). Springer, Berlin, Heidelberg.

https://doi.org/10.1007/978-3-540-46315-3_18

7. Nagaraja MP 2019: Climate Variability. NASA Science. Accessed 18 Nov 2019 at https://science.nasa.gov/earth-science/oceanography/ocean-earth-system/climate-variability/

8. Pokrovsky OM 2019: Cloud Changes in the Period of Global Warming: the Results of the International Satellite Project. Russian Academy of Sciences;

https://doi.org/10.31857/S0205-9614201913-13

9. Randall DA et al 2007: [Climate] Models and Their Evaluation. In: Climate Change 2007: The Physical Science Basis. Contribution of Working Group I to the Fourth Assessment Report of the Intergovernmental Panel on Climate Change [Solomon S et al (editors.)]. Cambridge University Press, Cambridge, United Kingdom and New York, NY, USA.

10. Reynolds RW et al 2002: An improved in situ and satellite SST analysis for climate. Journal of Climate, 15, 1609-1625. Data accessed 26-30 Aug 2019 at https://www.esrl.noaa.gov/psd/data/gridded/data.noaa.oisst.v2.html

11. Rossow WB and Schiffer RA 1999: Advances in understanding clouds from ISCCP. Bulletin of the American Meteorological Society, 80, 2261-2288, doi:10.1175/1520-0477(1999)080<2261:AIUCFI>2.0.CO;2. Data accessed 26 Aug 2019 at https://www.ncei.noaa.gov/data/international-satellite-cloud-climate-project-isccp-h-series-data/access/isccp/hgm/

12. Spencer RW 2013: STILL Epic Fail: 73 Climate Models vs. Measurements, Running 5-Year Means. (hier)

13. Spencer RW and Braswell WD 2011: On the Misdiagnosis of Surface Temperature Feedbacks from Variations in Earth’s Radiant Energy Balance. Remote Sensing 2011, 3(8), 1603-1613; https://doi.org/10.3390/rs3081603

14. Svensmark J et al 2016: The response of clouds and aerosols to cosmic ray decreases, Journal of Geophysical Research – Space Physics, 2016, DOI: 10.1002/2016JA022689.

ENDE DER STUDIE

Die Studie kann verändert werden müssen, um dem Begutachtungs-Verfahren zu genügen. Aber in der Zwischenzeit handelt es sich bei der oben vorgestellten Studie um genau diejenige, welche dem Journal eingereicht worden war.

Die „Iris”-Theorie

Richard Lindzen et al. stellten im September 2000 die Hypothese auf, dass die Erde eine „adaptive Infrarot-Iris“ haben könnte, die eine signifikante negative Rückkopplung auf Änderungen der Oberflächentemperatur liefert – die „Iris“-Theorie. Wenn ich diese Arbeit richtig verstanden habe, dann unterstützt meine obige Arbeit die „Iris“-Theorie nicht, denn die „Iris“-Theorie basiert auf der Oberflächenerwärmung, die in den Tropen zu weniger Wolken eines bestimmten Typs führt, während ich festgestellt habe, dass die Daten mit der Zunahme der Oberflächentemperatur eine Wolkenzunahme assoziieren.

Nebenbei: Meine Ergebnisse widerlegen auch nicht die „Iris“-Theorie, denn die „Iris“-Theorie basiert auf einer spezifischen Wolkenreduktion in einem begrenzten Gebiet, während meine Analyse nur globale SST- und Wolkendaten verwendet.

Im Januar 2002 argumentierten Bing Lin et al. gegen die „Iris“-Theorie, indem sie sagten, dass die Änderungen der Bewölkung in Wirklichkeit eine Erwärmung und nicht eine Abkühlung darstellten und dass daher die Rückkopplung, auf welche Bezug genommen wurde, positiv und nicht negativ war.

Mein Beitrag unterstützt das Argument von Bing Lin nicht mehr als das von Richard Lindzen, und zwar aus dem gleichen Grund: Bing Lin bezieht sich auf die gleiche Wolkenreduktion.

Übrigens: Argumente, die auf verschiedenen Wolkentypen basieren, werden nicht funktionieren, wenn jemand sie zu benutzen versucht, um meine Ergebnisse zu widerlegen. Das liegt daran, dass auf eine Erwärmung die Bewölkung zunimmt. Wenn der betreffende Wolkentyp es irgendwie schafft, dies zu einer positiven RückKopplung zu machen – trotz meiner Feststellung einer erneuten Wolken-Opazität – dann wird die positive Rückkopplung noch mehr Wolken erzeugen, die noch mehr positive Rückkopplungen ergeben werden, usw., usw. Aber … auf längere Sicht, wenn die Oberflächentemperatur steigt, gibt es weniger Wolken, nicht mehr, so dass mein Argument in 6.2 (b) zutrifft.

Und eine letzte Bemerkung: Alles, was ich getan habe war, die Daten zu analysieren. Ich stelle keine Theorien auf, ich verwende keine Modelle, und ich verwende keine ausgeklügelten statistischen Tricks oder Rosinenpickerei, um die Daten zu einem zweifelhaften Ergebnis zu manipulieren. Es werden alle verfügbaren Daten verwendet, und das einzige angewandte Verfahren ist die einfache gewichtete (und ungewichtete) Mittelung. Das Diagramm der Wolkenänderung gegen die Temperaturänderung geht in die „falsche“ Richtung. Punkt.

Link: https://wattsupwiththat.com/2020/06/05/cloud-feedback-if-there-is-any-is-negative/

Übersetzt von Chris Frey EIKE