Der Meeresspiegel über die Jahrtausende

Wie immer zuerst Informationen, welche uns Klimafachpersonen (und Gremien) darüber bieten.

[3] WIKI Bildungsserver: Meeresspiegeländerungen

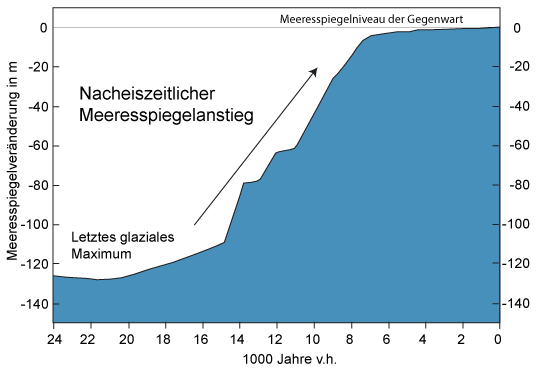

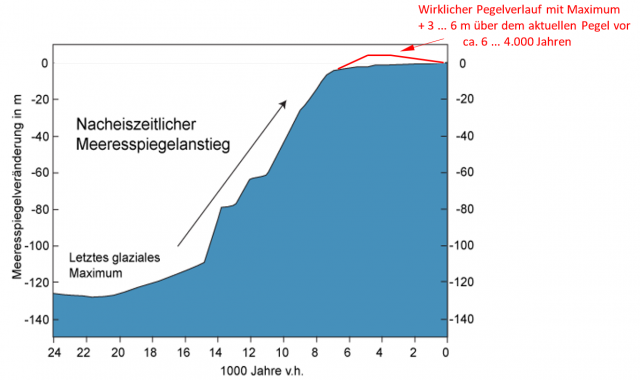

… In der späteren Nacheiszeit stieg der Meeresspiegel über mehrere Jahrtausende deutlich an. So ist er zwischen 7000 und 3000 Jahren v.h. um 2-3 m gestiegen. In den letzten 2000 Jahren gab es dann nur noch geringe Schwankungen, die unter 25 cm über mehrere Jahrhunderte lagen …

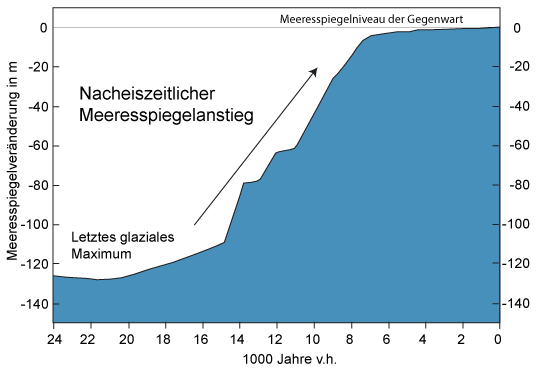

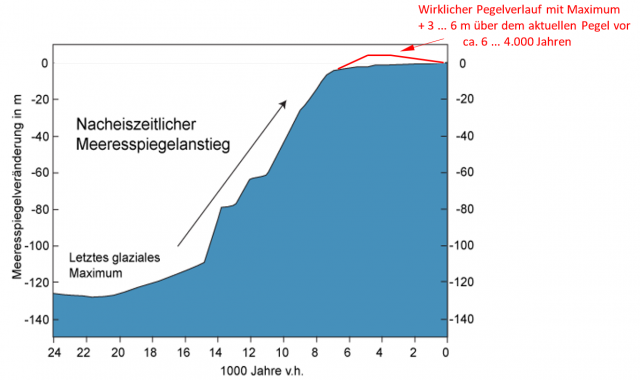

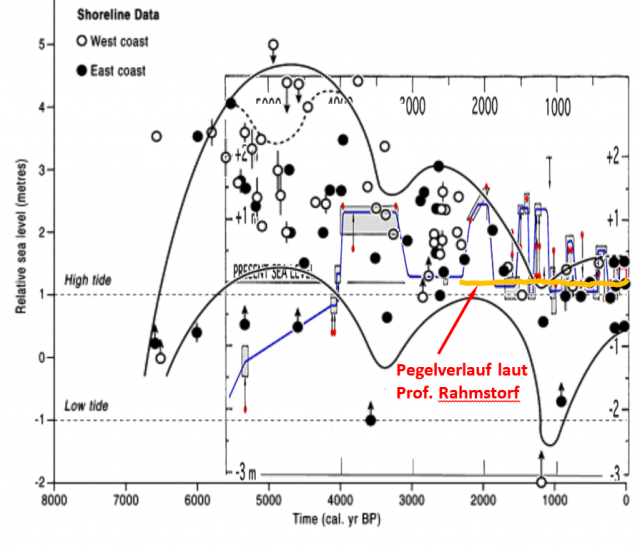

Dazu eine Grafik, in welcher man von den 2-3 m Anstieg zwischen den „7000 und 3000 Jahren v.h.“ nichts erkennen kann.

Bild 1 [3] Meerespegelanstieg seit dem Ende der letzten Eiszeit

DKK Deutsches Klima-Konsortium KLIMA-FAQ 5.2:

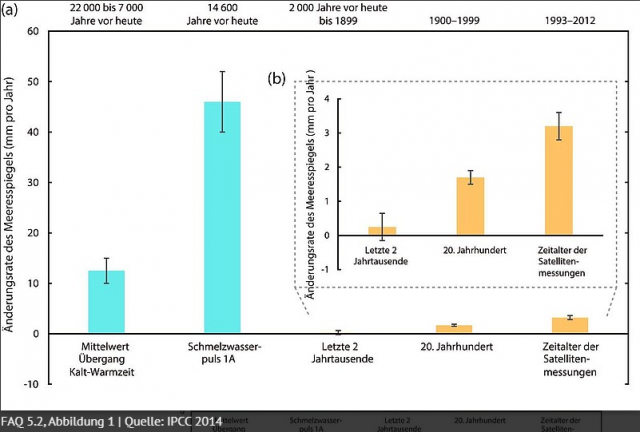

MEERESSPIEGEL Wie ungewöhnlich ist die aktuelle Änderungsgeschwindigkeit des Meeresspiegels?

… belegen sie eine mittlere Änderungsgeschwindigkeit des Meeresspiegels seit dem späten 19. Jahrhundert von 2,1 ± 0,2 mm pro Jahr. Dieser jahrhundertlange Anstieg übersteigt jede andere 100-Jahres-Änderungsrate in der gesamten 2000-jährigen Aufzeichnung für denselben Küstenbereich.

… instrumentelle Messungen und geologische Daten stützen die Schlussfolgerung, dass die aktuelle Änderungsgeschwindigkeit des mittleren globalen Meeresspiegels im Verhältnis zu den beobachteten und/oder geschätzten Änderungen während der letzten zwei Jahrtausende ungewöhnlich ist …

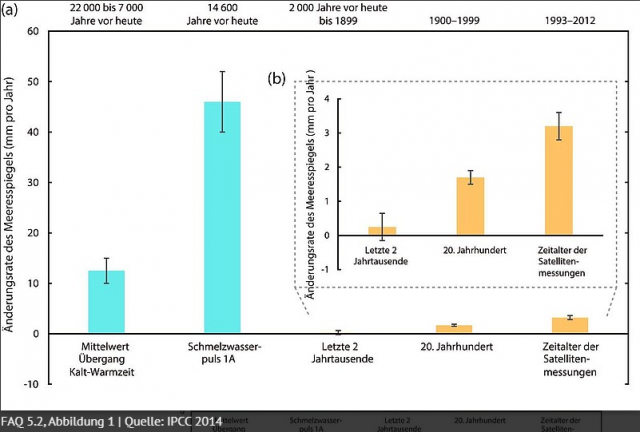

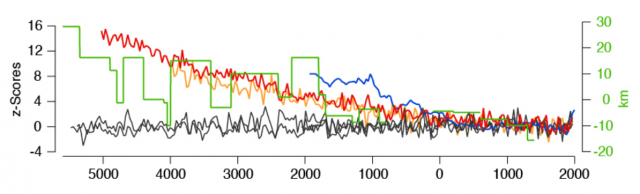

Dazu eine Grafik, in welcher gezeigt wird, dass die Änderungsrate seit ca. 2000 Jahren fast Null beträgt, doch seit der Satellitenmessung mit über 3 mm/pa die durchschnittliche Rate der letzten 2 Jahrtausende um Größenordnungen übersteigt.

Bild 2 [4] Änderungsraten des Meerespegelanstiegs seit 22.000 Jahren

Professor Rahmstorf (PIK) informiert auf seinem Blog detailliert mit Text und vielen Grafiken.

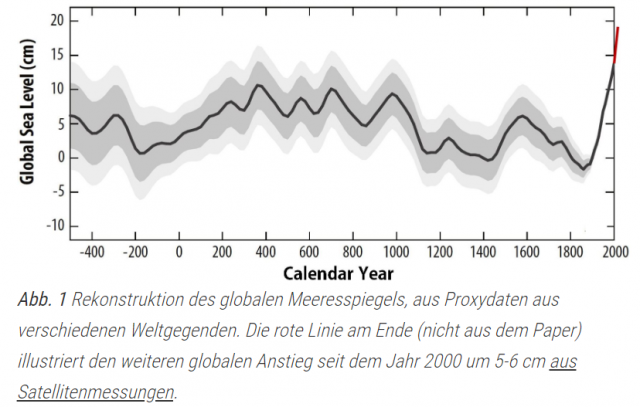

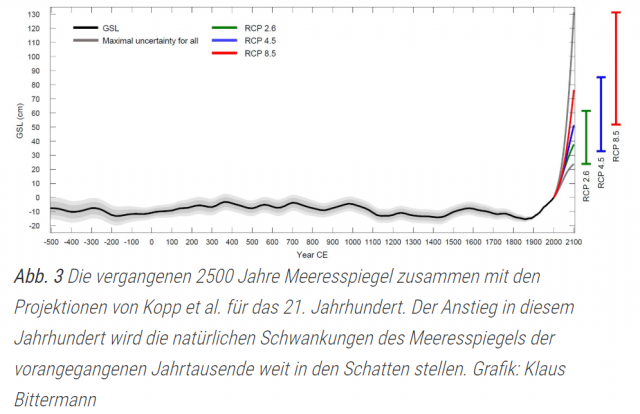

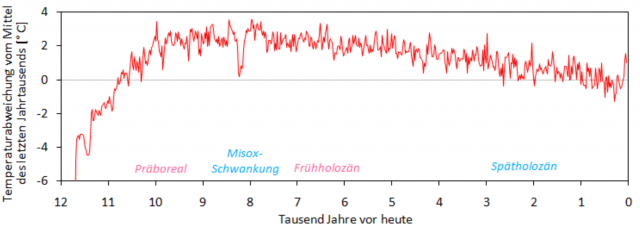

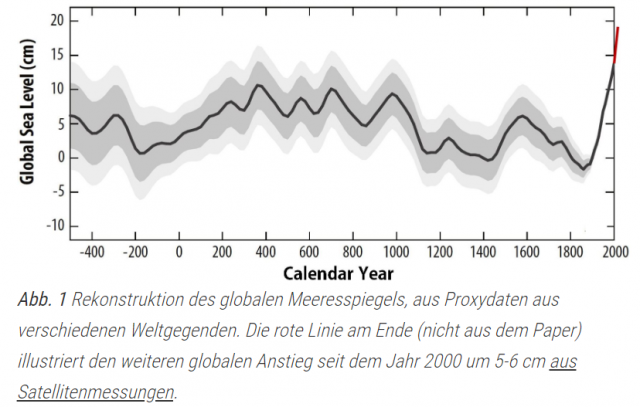

Darin erfährt man, dass der Meerespegel die letzten ca. 2500 Jahre um maximal 10 … 15 cm schwankte und aktuell am höchsten ist (Bild 3). Gleiches gilt für die Pegel- Änderungsgeschwindigkeit.

[5] Stefan Rahmstorf, SCILOGS 22. Feb 2016:

Meeresspiegel über die Jahrtausende

… Schauen wir sofort das Hauptresultat an. Der globale Meeresspiegelverlauf sieht folgendermaßen aus (Anm.: Bild 3)

:

Bild 3 [5] Pegelrekonstruktion der letzten 2.500 Jahre nach Rahmstorf

Stefan Rahmstorf:

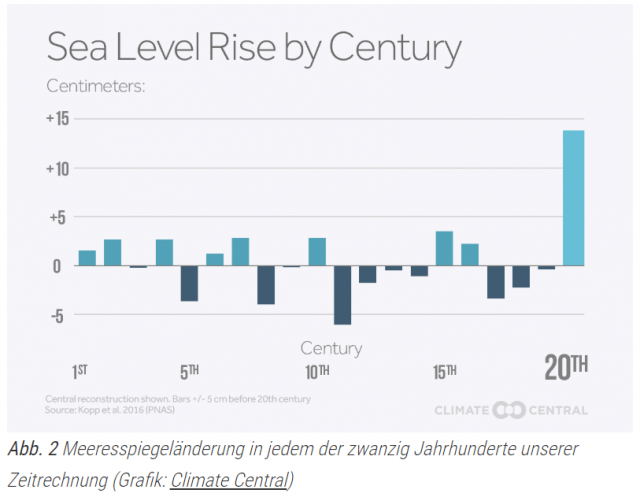

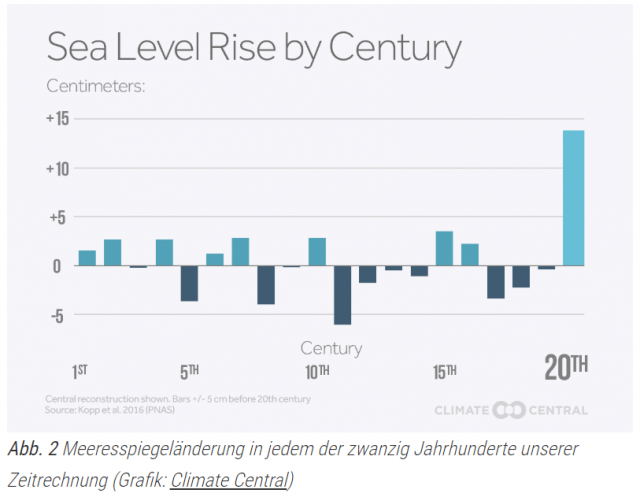

… Ein robustes Resultat ist dagegen die Tatsache, dass der Meeresspiegel im Verlauf des 20. Jahrhunderts wesentlich stärker gestiegen ist als in jedem Jahrhundert davor. (Diese Aussage gilt unabhängig von einem additiven Trend.) Eine gute Art dies darzustellen ist die folgende Grafik.

Bild 4 [5] Pegel-Anstiegsgeschwindigkeiten/Jahrhundert seit dem Jahr Null

Wenn Herr Rahmstorf irgendetwas zum Klimawandel von sich gibt, dürfen Apokalypsen, – immer resultierend aus irgendwelchen Irrsinns-Simulationen des PIK – niemals fehlen:

[5] Stefan Rahmstorf:

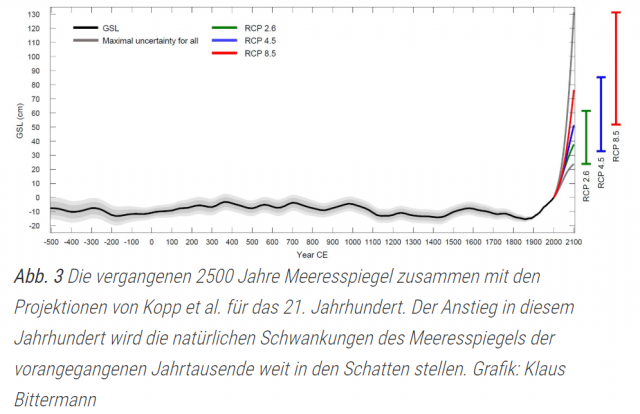

… Die schlechte Nachricht ist, dass nach diesem Eismodell das Antarktiseis rascher zerfallen kann als bislang gedacht.

Bild 5 [5] Pegelverlauf aus Bild 3 mit Zukunftsprojektionen (des PIK)

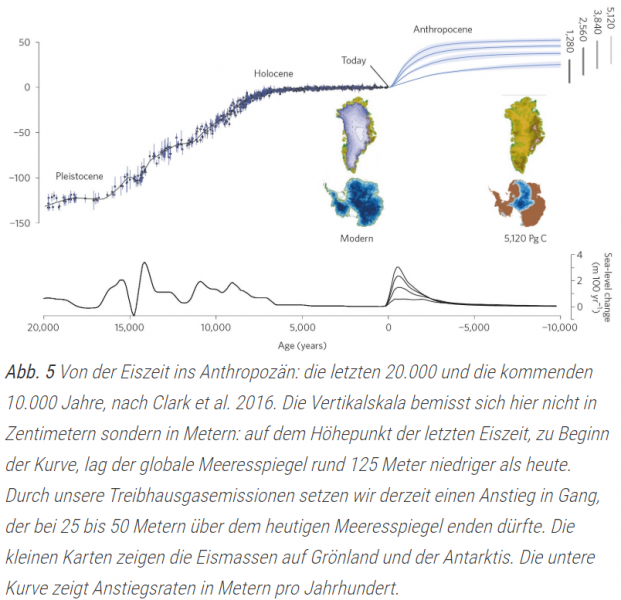

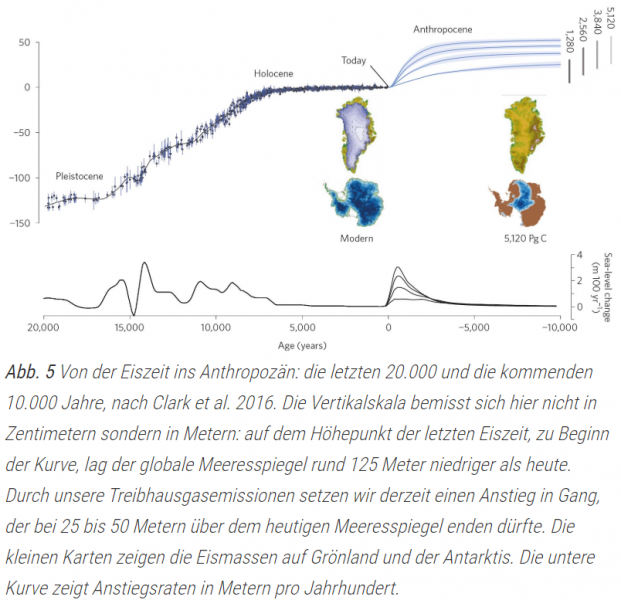

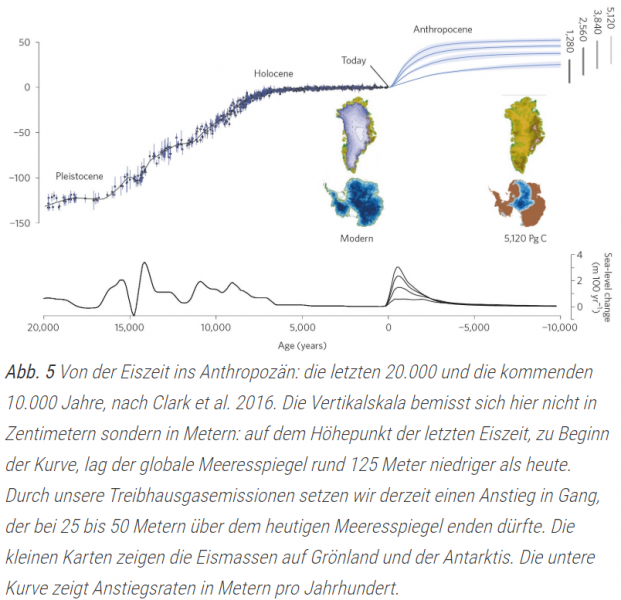

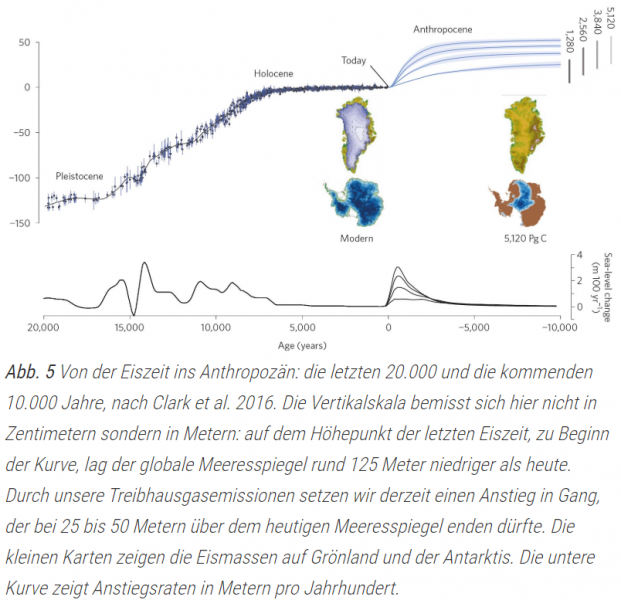

„Seine“ Simulationen erlauben es, den Meerespegel für 10.000 Jahre im Voraus zu bestimmen:

[5] Stefan Rahmstorf:

… Zehntausend Jahre Meeresspiegelanstieg voraus

… Durch unsere Treibhausgasemissionen setzen wir derzeit einen Anstieg in Gang, der bei 25 bis 50 Metern über dem heutigen Meeresspiegel enden dürfte.

Bild 6 [5] Pegelverlauf der letzten 20.000 Jahre mit Zukunftsprojektionen für die kommenden 10.000 Jahre

Voller Stolz deshalb die Information von Herrn Rahmstorf, dass auch ausländische Medien darauf hereinfallen:

Bild 7 [5] Artikel der New York Times aus Anlass einer PIK-Studie zum Meerespegel

Was sagt der letzte IPCC-Bericht AR5?

Zuerst ein Blick in den letzten IPCC-Bericht AR5 (Langfassung). Darin findet sich zu diesem wichtigen Zeitraum recht wenig, schon gar keine aussagefähigen Grafiken. Das IPCC interessiert sich erkennbar nur für die ganz kurze Vergangenheit, alleine, um den AGW-Klimawandel zu belegen. Der kompromittierende Vergleich mit der relevanten Klimahistorie ist (wohl bewusst) weggelassen.

Von dem Wenigen an Information, Auszüge anbei. „Zugegeben“ – aber nur mit „likely“ – wird, dass der Meerespegel vor 7 … 3.000 Jahren 2 … 3 m höher war. Für die letzten 2.000 Jahre soll er dann nur noch um maximal +-25 cm geschwankt haben:

[6] AR5 Langfassung: Chapter 13 Sea Level Change

… Since the AR4, there has been signifiant progress in resolving the sea level history of the last 7000 years. RSL records indicate that from ~7 to 3 ka, GMSL likely rose 2 to 3 m to near present-day levels (Chapter 5). Based on local sea level records spanning the last 2000 years, there is medium confience that flctuations in GMSL during this interval have not exceeded ~ ±0.25 m on time scales of a few hundred years (Section 5.6.3, Figure 13.3a). The most robust signal captured in salt marsh records from both Northern and Southern Hemispheres supports the AR4 conclusion for a transition from relatively low rates of change during the late Holocene (order tenths of mm yr–1) to modern rates (order mm yr–1) (Section 5.6.3, Figure 13.3b). However, there is variability in the magnitude and the timing (1840–1920) of this increase in both paleo and instrumental (tide gauge) records (Section 3.7). By combining paleo sea level records with tide gauge records at the same localities, Gehrels and Woodworth (2013) concluded that sea level began to rise above the late Holocene background rate between 1905 and 1945, consistent with the conclusions by Lambeck et al. (2004).

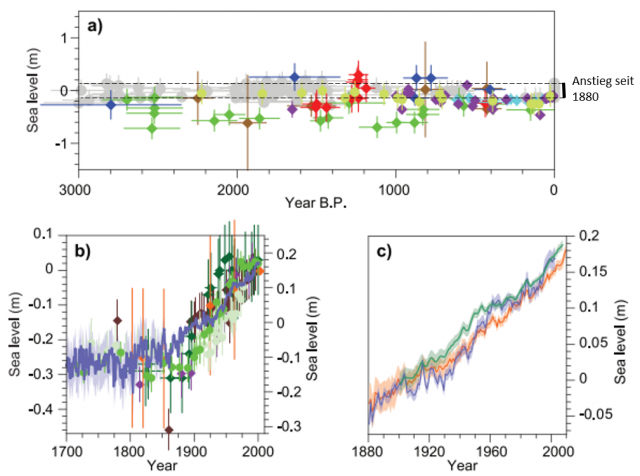

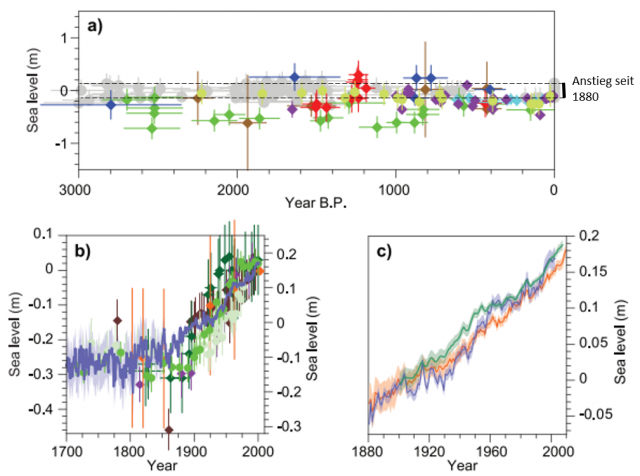

Im Bild 7 aus dem Bericht sieht man zumindest, dass der „schlimme“ Pegelanstieg seit 1880 von ca. 25 cm in den letzten 3.000 Jahren eigentlich der „Normalfall“ war und bezüglich Größe und Geschwindigkeit im regelmäßigen „Änderungsrauschen“ verschwindet.

Bild 8 Pegelgrafiken (Anm.: Vom Autor ergänzt) [6] AR5 (Teilbild)

Zu der Abbildung: Figure 13.3 | (a) Paleo sea level data for the last 3000 years from Northern and Southern Hemisphere sites. The effects of glacial isostatic adjustment (GIA) have been removed from these records. Light green = Iceland (Gehrels et al., 2006), purple = Nova Scotia (Gehrels et al., 2005), bright blue = Connecticut (Donnelly et al., 2004), blue = Nova Scotia (Gehrels et al., 2005), red = United Kingdom (Gehrels et al., 2011), green = North Carolina (Kemp et al., 2011), brown = New Zealand (Gehrels et al., 2008), grey = mid-Pacifi Ocean (Woodroffe et al., 2012) (b) Paleo sea level data from salt marshes since 1700 from Northern and Southern Hemisphere sites compared to sea level reconstruction from tide gauges (blue time series with uncertainty) (Jevrejeva et al., 2008). The effects of GIA have been removed from these records by subtracting the long-term trend (Gehrels and Woodworth, 2013). Ordinate axis on the left corresponds to the paleo sea level data. Ordinate axis on the right corresponds to tide gauge data. Green and light green = North Carolina (Kemp et al., 2011), orange = Iceland (Gehrels et al., 2006), purple = New Zealand (Gehrels et al., 2008), dark green = Tasmania (Gehrels et al., 2012), brown = Nova Scotia (Gehrels et al., 2005). (c) Yearly average global mean sea level (GMSL) reconstructed from tide gauges by three different approaches. Orange from Church and White (2011), blue from Jevrejeva et al. (2008), green from Ray and Douglas (2011) (see Section 3.7)…

Weil man im IPCC-Bericht gerade im Kapitel zum Meerespegel „ist“, noch ein Beispiel zur (Des-)Information darin gezeigter Grafiken.

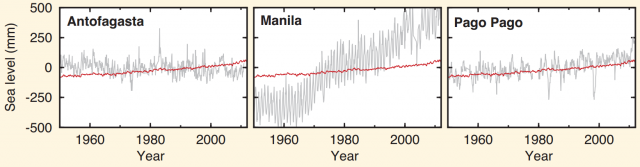

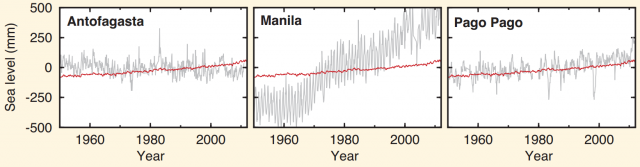

Parallel mit anderen Pegeln wird auch der von Manila gezeigt:

Bild 9 [6] AR5 (Teilbild) FAQ13.1, Figure 1 | Map of rates of change in sea surface height (geocentric sea level) for the period 1993–2012 from satellite altimetry.

Nun weiß jeder „gute“ EIKE-Leser, dass Manila ein „Vorzeige“- weil Extrembeispiel — für selbst verursachte Landsenkung ist und der „Tidenpegelverlauf“ damit eine vollkommen falsche Aussage vermittelt:

EIKE 13.08.2017:

Manila versinkt durch Wasserentnahme im austrocknenden Untergrund. Der (reiche) Westen mit seinem CO2 soll daran schuld sein – und zahlen

Man dürfte die Pegelgrafik von Manila – die nicht Pegeländerung, sondern ausschließlich eine extreme Landsenkung zeigt – deshalb grundsätzlich nicht mit anderen Pegelgrafiken in der gleichen Reihe zeigen, da Leser, welche den Sachverhalt nicht kennen, eine vollkommen falsche Information ableiten.

Erst im Text findet sich dann ein etwas „lapidarer“ Hinweis, dass mit dem Pegelbild etwas nicht stimmt „

the greater rate of rise relative to the global mean at Manila (FAQ 13.1, Figure 1) is dominated by land subsidence caused by intensive groundwater pumping“. Aber auch da fehlen Daten, sodass man dieses häufige Problem, „

is common in many coastal regions“ selbst anhand des Langeberichtes nicht entfernt quantifizieren kann:

AR5:

… In addition to regional inflences of vertical land motion on relative sea level change, some processes lead to land motion that is rapid but highly localized. For example, the greater rate of rise relative to the global mean at Manila (FAQ 13.1, Figure 1) is dominated by land subsidence caused by intensive groundwater pumping. Land subsidence due to natural and anthropogenic processes, such as the extraction of groundwater or hydrocarbons, is common in many coastal regions, particularly in large river deltas.

Dass deshalb selbst Klimawandel-Fachpersonen unseres Bundestages, welche als ausgesuchte Fachmannschaft extra auf eine lange und teure Recherchereise ging, um dieses Problem persönlich vor Ort zu analysieren, deshalb mit völliger Unkenntnis hin – und mit noch mehr zurück kamen, lässt sich nachlesen:

EIKE 30. April 2019:

Claudia Roth auf Forschungsreise zum Klimawandel

„Offizielle“ Darstellung

Nach diesen Hinterlegungen der „Wissenschaft“ zum Klimawandel war der Meerespegel vor ca. 7 … 3.000 Jahren 2 bis 3 m höher [6], seitdem bewegte er sich dann nur noch in einer Spanne von ca. +-25 cm [6], laut Herrn Rahmstorf seit den letzten Zweitausend Jahren nur um ca. +-5 cm (Bild 3).

Zum Meerespegel gibt es jedoch auch detailliertere Informationen

Dazu der Hinweis, dass ein erheblicher Teil dieses „Wissens“ aus Hinterlegungen der Plattform NoTricksZone entnommen wurde [7].

Selbst wenn man nur oberflächlich sucht, finden sich viele –vor allem auch neuere – Pegelstudien, die der „wissenschaftlichen“ Angabe zum seit ca. 3.000 Jahren angeblich flachen, sich nur um wenige Zentimeter veränderndem Meerespegel eklatant widersprechen. Anbei solche Beispiele

Langfristdarstellungen (seit etwa Ende der letzten Eiszeit)

Hinweis: Diese Studien geben nicht den globalen Meerespegel an (das Pegelbild von Herrn Rahmstorf weist ihn allerdings auch nicht global aus, er leitet den globalen jedoch daraus ab).

Es dürfte jedoch unwahrscheinlich sein, dass länger andauernde, große lokale Pegeländerungen sich nicht ausgleichen und damit auch global vorhanden sind. Dass die Proxis rund um den Globus ähnliche Verläufe zeigen, erhärtet diese Annahme. Mit Sicherheit sind sie deshalb eine brauchbare Orientierung auch über den globalen Pegelverlauf.

Leider „lieben“ es die Studienautor*innen, die Zeitachse beliebig mal nach Links, dann nach Rechts zu drehen. Deshalb bei jedem Bild neu darauf achten, in welcher Richtung das aktuelle Jahrtausend liegt.

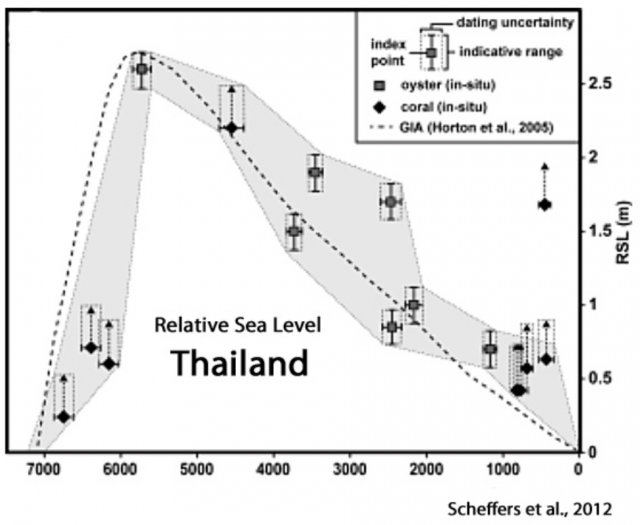

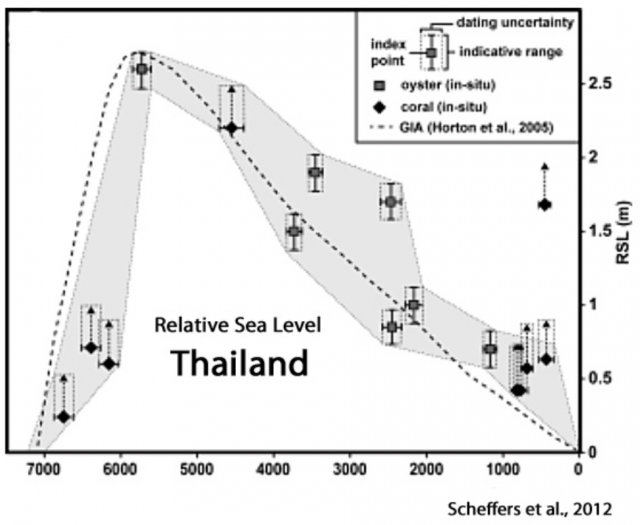

Bild 10a Anja Scheffers, Dominik Brill, Dieter Kelletat, April 11, 2012: Holocene sea levels along the Andaman Sea coast of Thailand

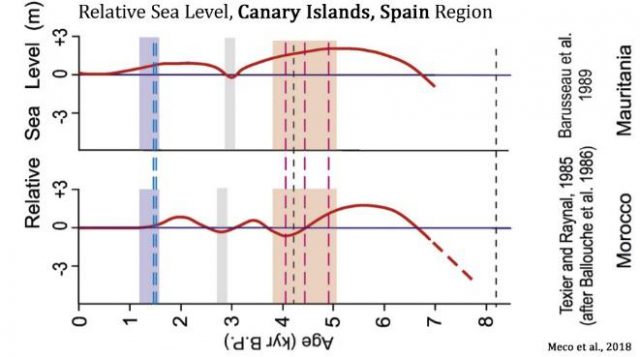

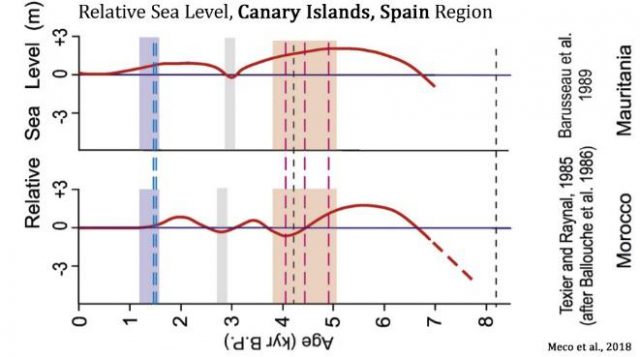

Bild 10b Meco et al., 2018 Canary Islands, Spain, + 3.5 to +4 m higher than present

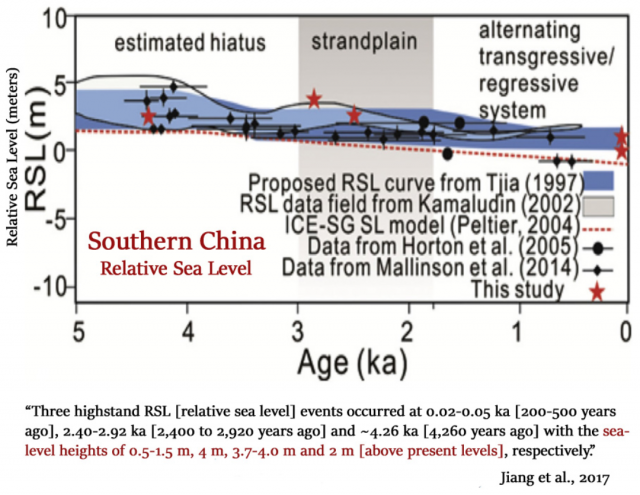

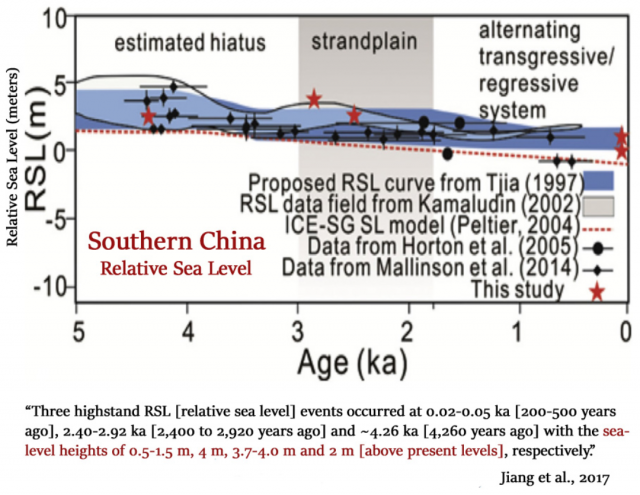

Bild 11 Jiang et al., 2017 Southern China, +2.4 to +4.26 m higher than present

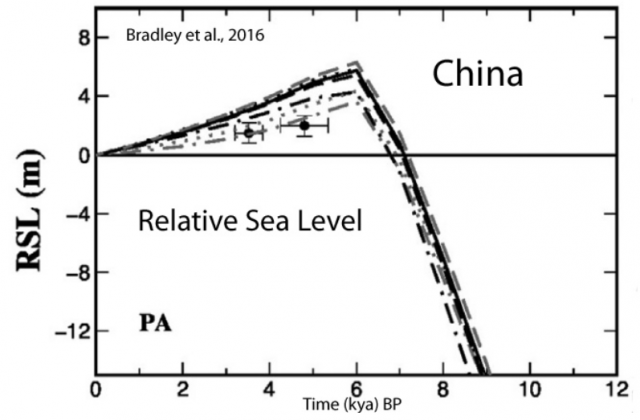

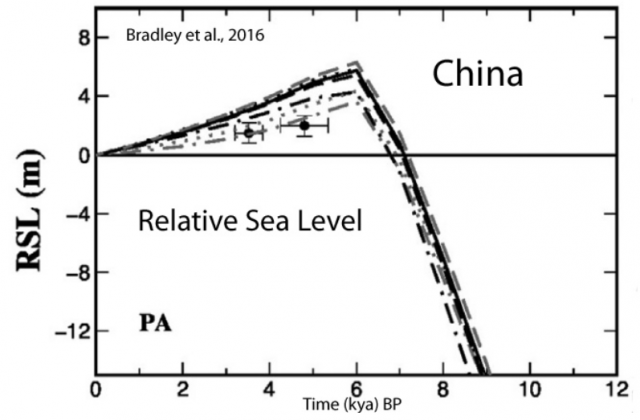

Bild 11b Bradley et al., 2016 China, +2 to +4 m higher than present

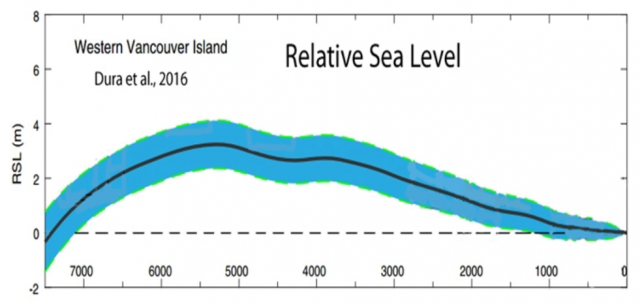

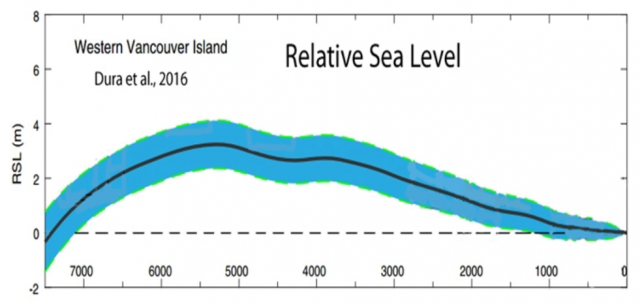

Bild 12 Dura et al., 2016 Vancouver, < +1 to +3 m higher than present

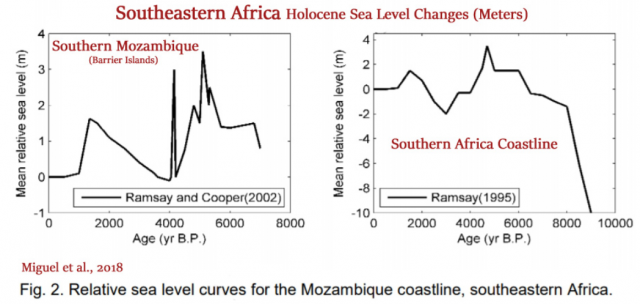

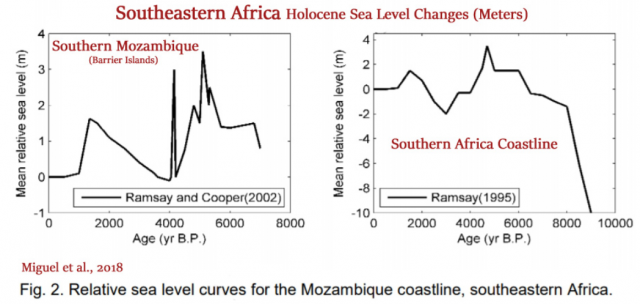

Bild 13 Miguel et al., 2018 Southeastern Africa, ~ +2 to +3 m higher than present

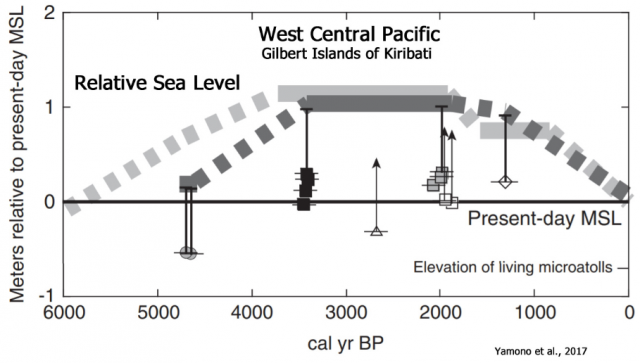

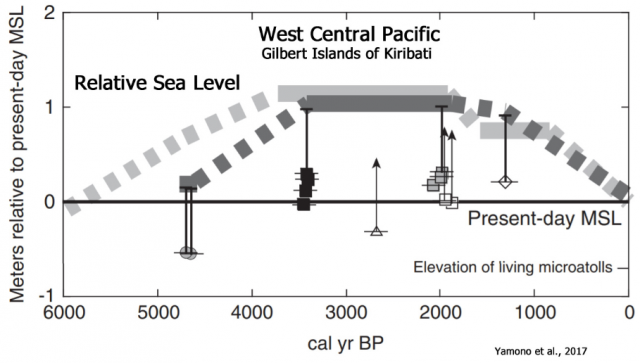

Bild 14 Yamono et al., 2017 Kiribati (Central Pacific), +2.4 m higher than present

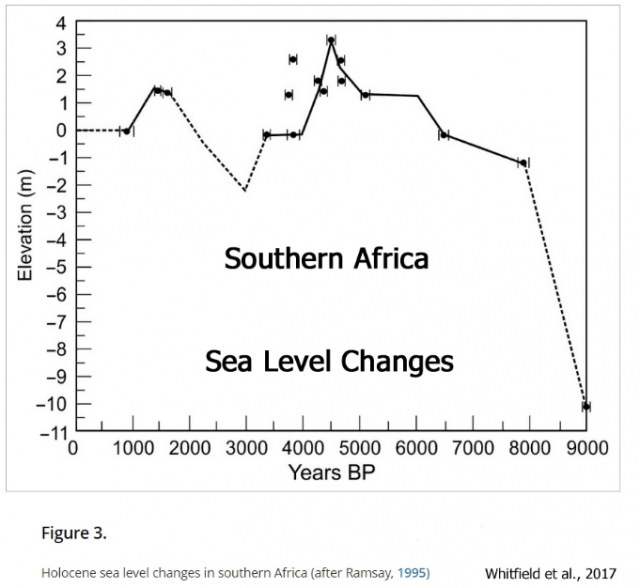

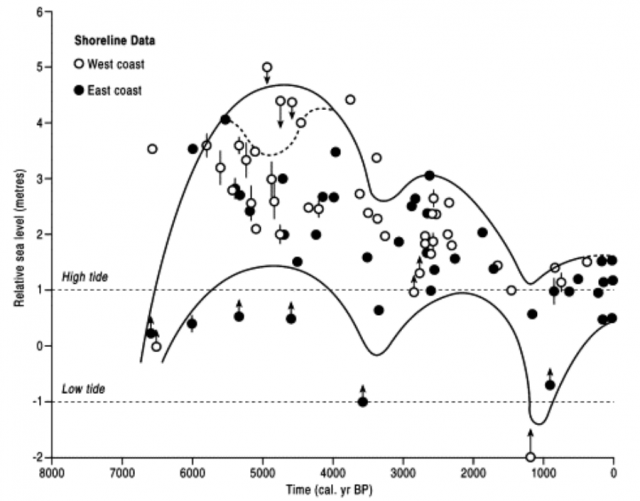

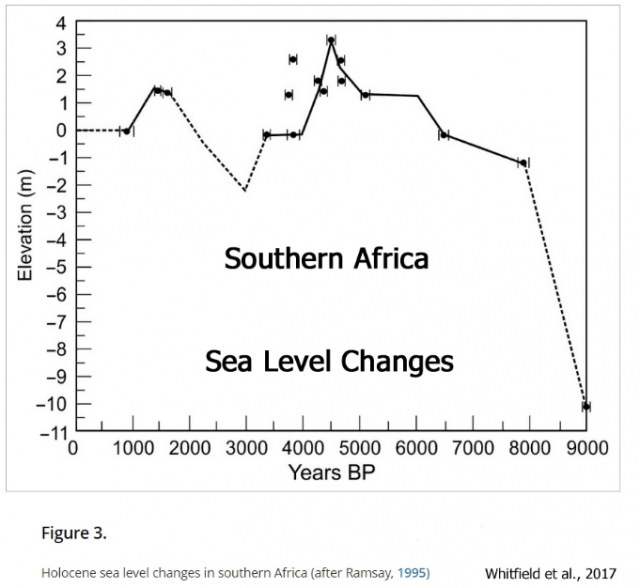

Bild 15 Whitfield et al., 2017 Southern Africa, +1.5 to +3.5 m higher than present

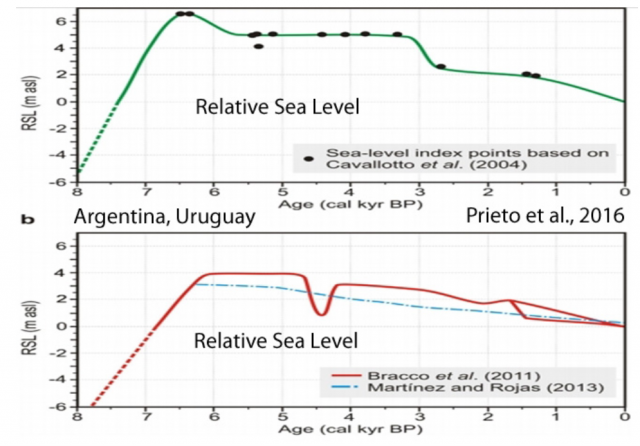

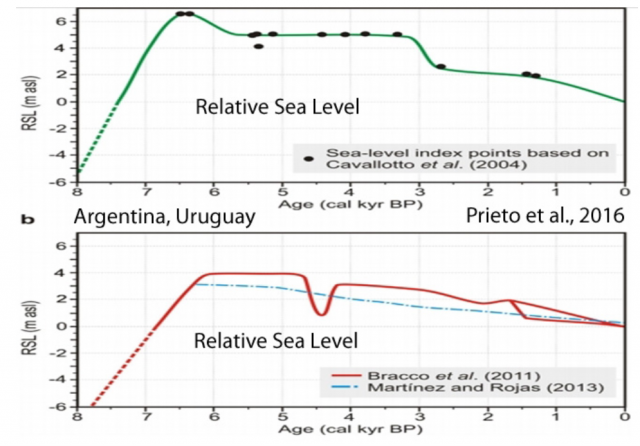

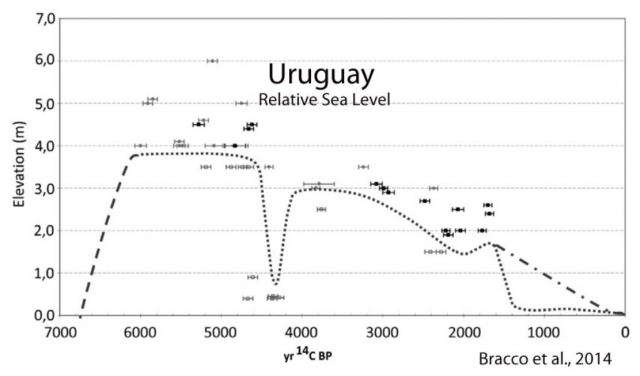

Bild 16 Prieto et al., 2016 Argentina, Uruguay, +4 to +6.5 m higher than present

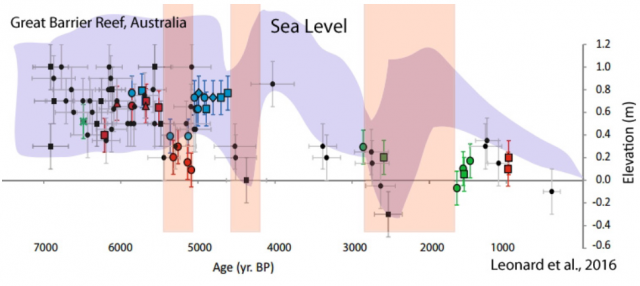

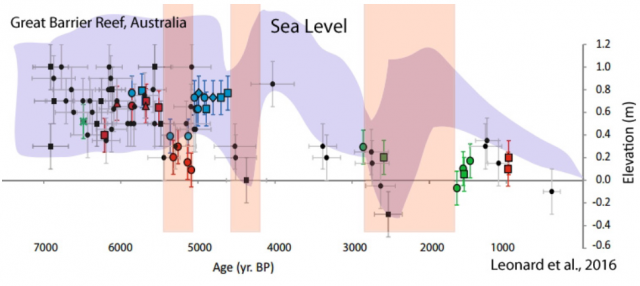

Bild 17 Leonard et al., 2016 Great Barrier Reef, Australia, +0.75 m higher than present

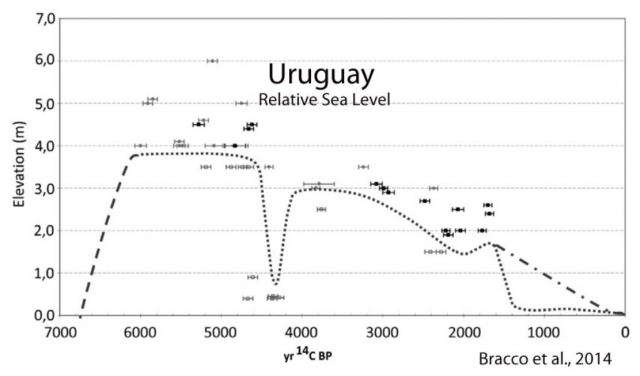

Bild 18 Bracco et al., 2014 Uruguay, +3 to +4 m higher than present

Bild 19 Fig. 7. Holocene sea-level envelope for Peninsula Malaysia (modified from Tija, 1996). Data points with arrows indicate directional (limiting) index points. Some index points have vertical error bars, where the vertical range of the sea-level indicator is understood. No age errors are considered, radiocarbon ages are plotted. The boundaries of the envelope are drawn midway between the extreme data points and the neighbouring points within the envelope ( Tija, 1996).

Fazit

Es ist überraschend, wie stark die Pegelrekonstruktionen bezüglich des Verlaufs rund um den Globus übereinstimmen. Auch interessant allerdings, wie extrem die Auflösungen und natürlich auch die Absolutwerte variieren.

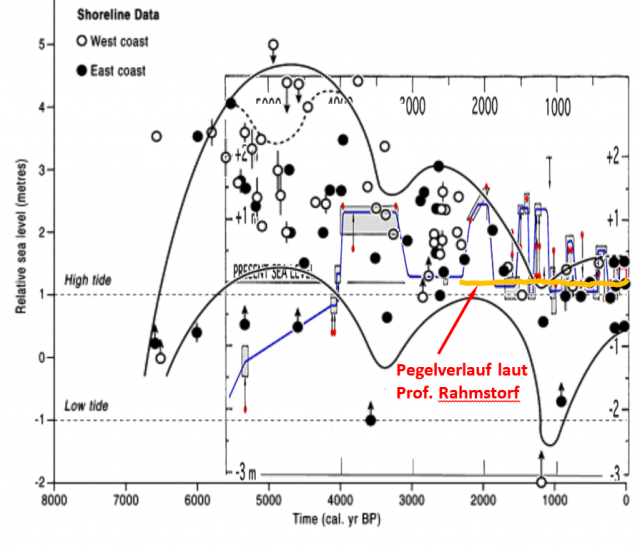

Doch eines lässt sich mit Sicherheit sagen: Die von Herrn Rahmstorf gezeigte Pegelrekonstruktion der letzten 2.500 Jahre (Bild 3) stimmt nicht. Sie zeigt bei Weitem nicht die wirklichen Pegel-Variabilitäten und erinnert damit an die „Hockeystick-Kurve, wo genau das gleiche (Verschleiern der hohen, wirklichen Variabilität durch Mittelwertbildungen) gemacht wurde.

Der Autor traut sich auch zu behaupten, dass zu seiner weiteren Aussage problemlos Gegenbelege möglich sind:

[5] Stefan Rahmstorf: … Ein robustes Resultat ist dagegen die Tatsache, dass der Meeresspiegel im Verlauf des 20. Jahrhunderts wesentlich stärker gestiegen ist als in jedem Jahrhundert davor. (Diese Aussage gilt unabhängig von einem additiven Trend.) Eine gute Art dies darzustellen ist die folgende Grafik …

Bild 20 (Wiederholung Bild 6) [5] Pegelverlauf der letzten 20.000 Jahre mit Zukunftsprojektionen

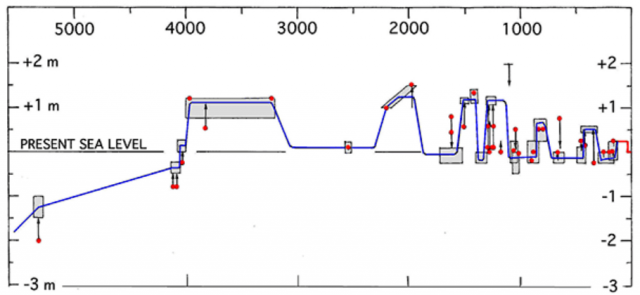

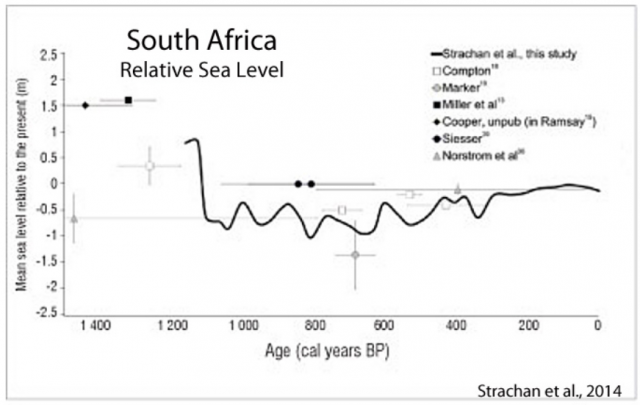

Um das zu zeigen, ist der Zeitraum der letzten 3000 Jahre wichtig. Leider nehmen die Studien darauf keine „Rücksicht“, deshalb anbei weitere Grafiken aus Studien, welche diesen Zeitraum etwas detaillieren.

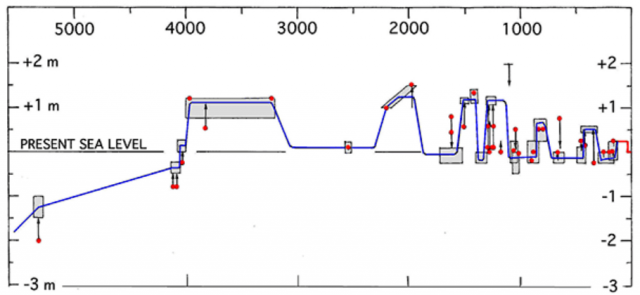

Pegel im Zeitraum seit etwa 3.000 Jahren

Bild 21 Fig. 2. The Late Holocene sea level changes in the Maldives (Mörner, 2007) including 7 transgression peaks in the last 4000 years with 3 peaks in the last millennium.

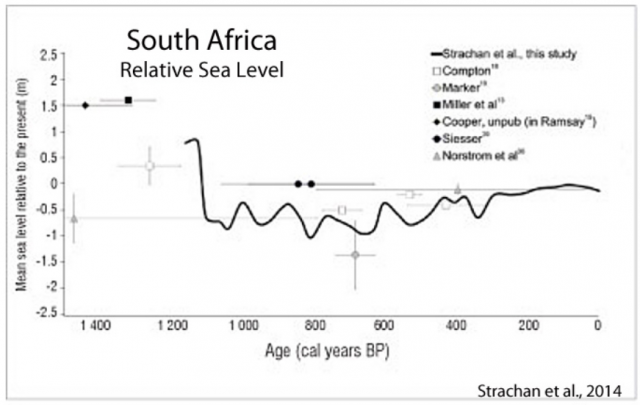

Bild 22 Strachan et al., 2014 South Africa, +3 m higher than present

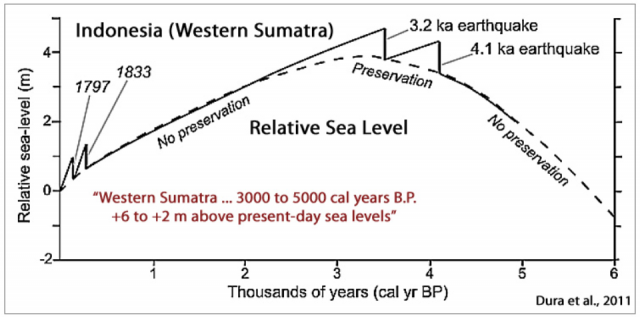

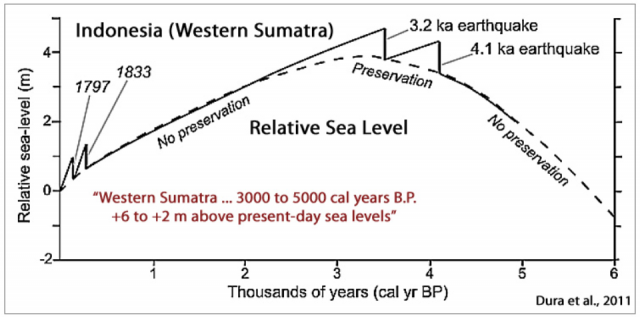

Bild 23 Dura et al., 2011 West Sumatra, Indonesia, +2 to +6 m higher than present

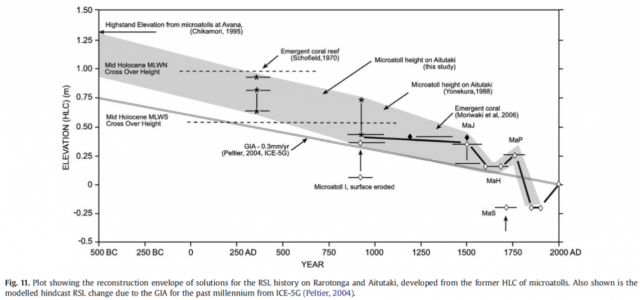

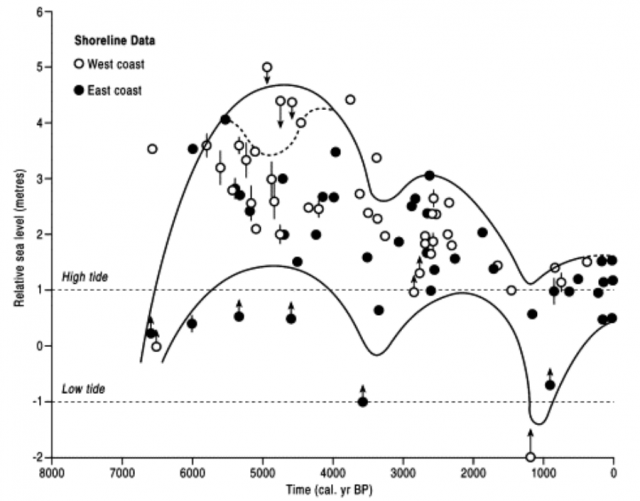

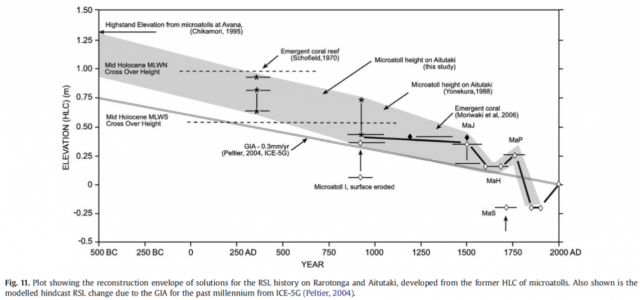

Bild 24 Meerespegelentwicklung der Southern Cook Islands während der vergangenen 2500 Jahre. Quelle: Goodwin & Harvey 2008

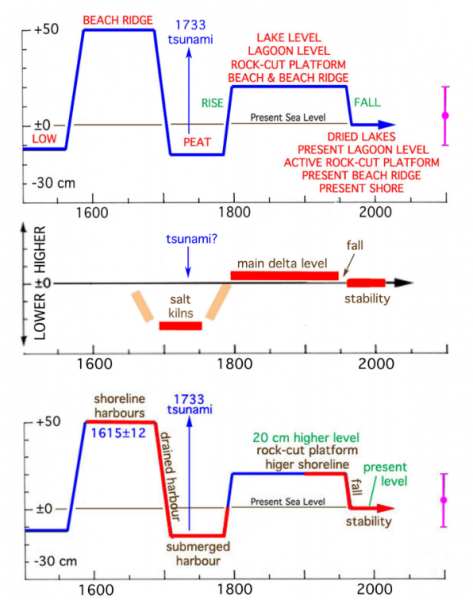

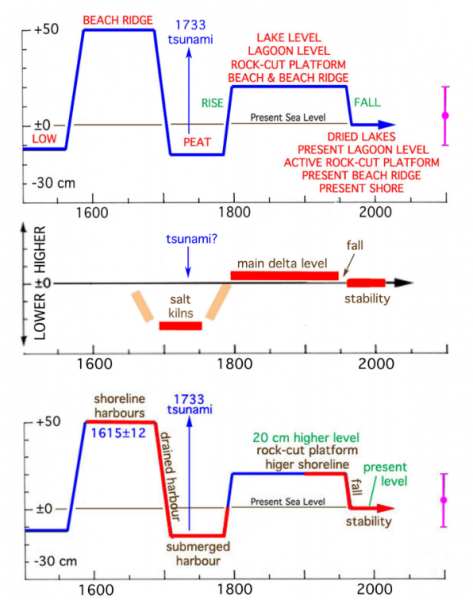

Bild 25 [9] Fig. 4. Observed, documented and dated sea level changes during the last 500 years in the Indian Ocean. Top: the Maldives (Mörner, 2007). Middle: Bangladesh (Mörner, 2010c). Bottom: Goa, India (Mörner, 201 6). The agreement is striking

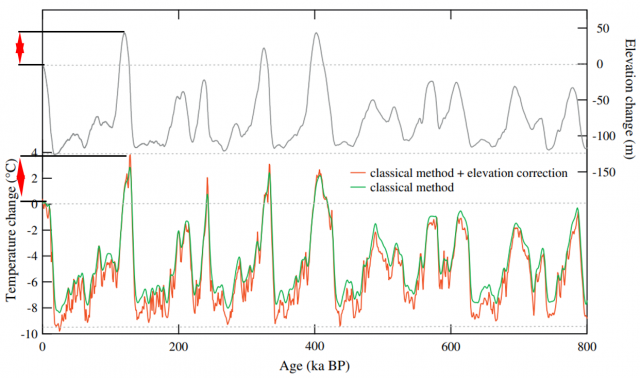

Zeigt sich der „Pegelverlauf“ auch in den Temperaturverläufen?

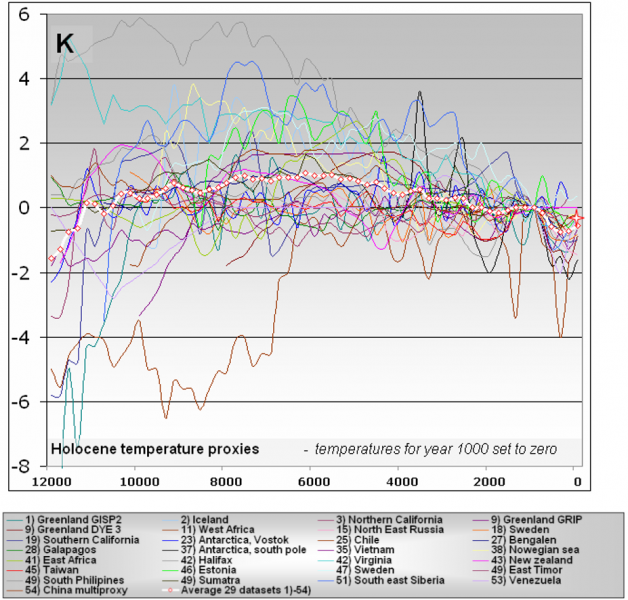

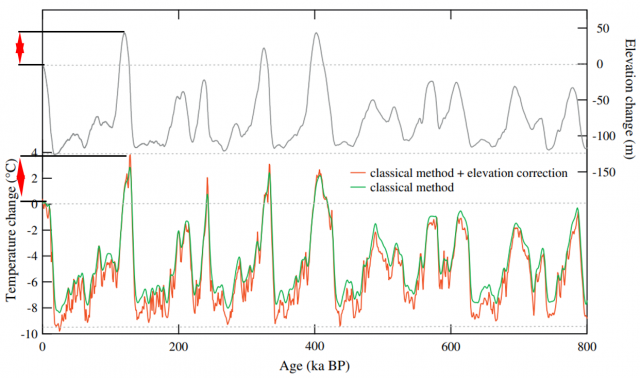

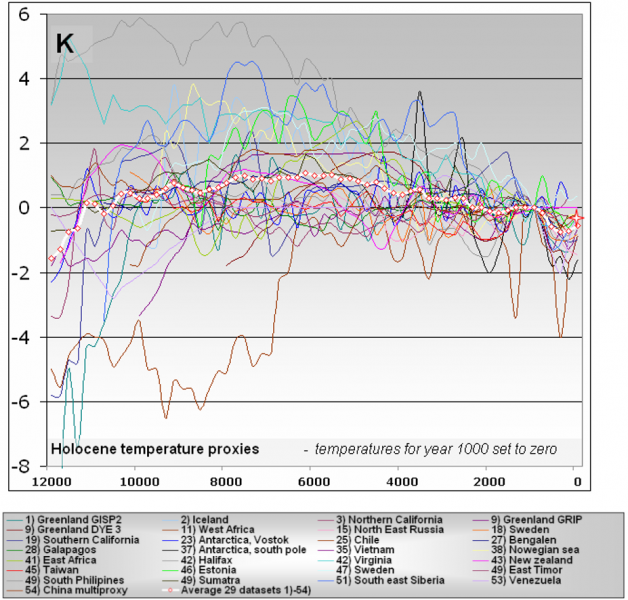

Anbei Proxydaten zur Temperatur seit der letzten Eiszeit (Bild 26). Würde man „Pegelverläufe“ darunter schreiben, würde es jeder sofort glauben, so ähnlich sind die Verläufe (und vielen Abweichungen).

Auffällig ist die enorme Spanne der Proxytemperaturen, aber vor allem die darin ausgewiesenen, enormen und schnellen Schwankungen (die es angeblich nicht gegeben hat).

Manchem Leser wir verblüffen, warum aktuell das „Verbrennen“ der Erde verkündet wird. Sofern die Proxis die Temperaturverläufe auch nur im Ansatz richtig abbilden, müsste eher von einer „Erkältung“ gesprochen werden. Aber wenn man die Vergangenheit weglässt, lässt sich eben alles fabulieren.

Bild 26 Proxyrekonstruktionen der Temperatur der letzten 12.000 Jahre. Quelle: Frank Lansner: Holocene, historic and recent global temperatures from temperature proxies

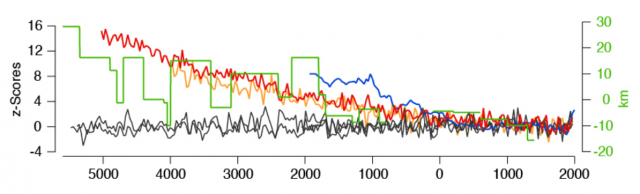

Bild 27 Temperaturtrend seit ca. 7000 Jahren in nördlichen Breitengraden. [8]

Originaltext zur Abbildung:

Figure S1. Temperature trends recorded over the past 4000-7000 years in high latitude proxy and CGCM data. Multi-millennial TRW records from Sweden 1, Finland2, and Russia3 (all in grey) together with reconstructions of the glacier equilibrium line in Norway4,5 (blue), northern treeline in Russia3,6 (green), and JJA temperatures in the 60-70 °N European/Siberian sector from orbitally forced ECHO-G7,8 (red) and ECHAM5/MPIOM9 (orange) CGCM runs10. All records, except for the treeline data (in km) were normalized relative to the AD 1500-2000 period. Resolution of model and TRW data were reduced (to ~ 30 years) to match the glacier data.

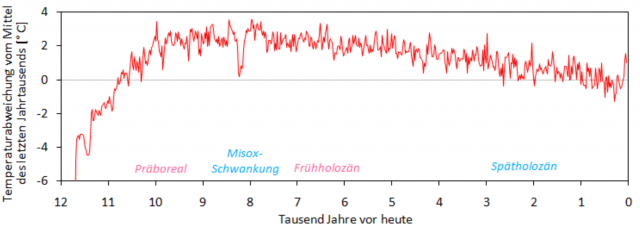

In die folgenden Grafik ist eine Verlaufskurve aus anderer Quelle kopiert. Die zwei „Mittelwertlinien“ lasse erkennen, wie man durch Mitteln alle „kompromittierenden“ Variabilitäten der Vergangenheit „wissenschaftlich“, da „statistisch fundiert“, verschwinden lassen kann.

Bild 28 Vom Autor in Bild 26 eine Verlaufsrekonstruktion der Zentralanstalt für Meteorologie und Geodynamik ZAMG kopiert. Anm.: Die Achsendimensionen sind gleich. Da die Nullpunkte nicht übereinstimmen, wurden diese optisch gro korrigiert

Vermutung: Vom IPCC und von Prof. Rahmstorf angegebene Pegelverläufe können nicht stimmen

Alleine das Vergleichen der Angaben von „Klimafachpersonen“ mit den Verläufen aus Pegelrekonstruktionen führt zu dem einzig möglichen Schluss: Die „offiziellen“ Angaben:

-IPCC AR5: Die letzten 2.000 Jahre soll der Meerespegel nur noch um maximal +-25 cm geschwankt haben

-laut Rahmstorf die letzten 2.500 Jahre um maximal 10 … 15 cm

und dazu gezeichnete Bilder (typisch auch Bild 1) – , wie auch die Angabe, der aktuelle Anstieg wäre die letzten 2.500 Jahre noch nie dagewesen, sind genau so falsch, wie es der Hockeystick zur Temperatur ist (rein persönliche Überzeugung des Autors anhand vieler Studiensichtungen allerdings durch keine „Klimafachperson“ belegt).

Um zu zeigen, wie bewusst „Klimawissenschaft“ in ihren Darstellungen lügt Information weglässt um nur das „Gewünschte“ auszusagen, anbei oft zu findende Pegelgrafiken, ergänzt um die darin weggelassenen Zusatzinformationen, die sich zwangsläufig aus den Proxis ergeben.

Bild 29 Bild 1 mit grobem Eintrag des wahrscheinlicheren, wirklichen Pegelverlaufs durch den Autor

Anhand der folgen Proxyüberlagerungen zeigt sich die unglaubliche Pegelvarianz seit dem Ende der letzten Eiszeit, aber auch der laut Prof. Rahmstorf im Pegel fast nicht schwankenden, letzten 2.500 Jahre.

Bild 30 Rekonstruktionsversuch Pegelverlauf der letzten 3000 Jahre. Bilder 3; 7; 21 im gleichen Zeit- und Höhenmaßstab vom Autor übereinander kopiert. Hinweis: Die 0-Linien der Proxy-Y-Achsen sind versetzt. Die Pegelspannen aber im Maßstab

Entweder ist Prof. Rahmstorf genial und alle anderen Klimawissenschaftler mehr als blöde (da im Gegensatz zu Prof. Rahmstorf nicht entfernt in der Lage, Pegelproxys zu generieren), oder etwas anderes trifft zu.

Der Autor vermutet es mehr als stark (rein persönliche Meinung, durch keine Aussage eines renommierten Klimawissenschaftlers belegt).

Fazit

Anhand von – mit Sicherheit die Vergangenheit nicht richtig darstellenden – Pegelverläufen der offiziellen „Klimawissenschaft“ werden die Klimasimulationen „kalibriert“, welche dann wie es Prof. Rahmstorf behauptet, die nächsten 10.000 Jahre Klimageschehen vorhersagen können …

Jetzt kann sich jeder Leser fragen:

– was darf man von den Angaben der „Klimawissenschaftler*innen“ glauben

– wie konnten solche gewaltigen Variabilitäten geschehen, obwohl das angeblich fast alleine die Temperatur treibende CO2 sich während dieser Zeiträume kaum verändert hat?

Mit Sicherheit ist es kein Zufall, dass diese „kompromittierenden“ Variabilitäten in offiziellen Grafiken (und Texten) regelmäßig fehlen durch geeignetes Mitteln „statistisch fundiert“ entfernt sind.

Entweder hat die Klimawissenschaft das Klima noch gar nicht verstanden, oder sie verheimlicht Wichtiges dazu

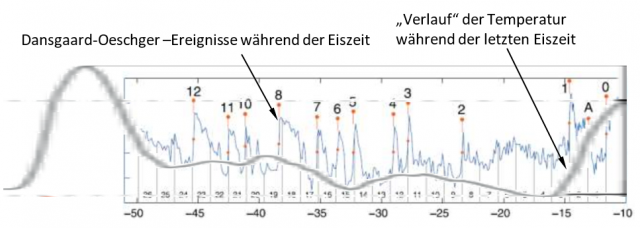

Anmerkung: Der Autor vermutet das Erste. Ergänzend zur bisherigen Betrachtung der letzten ca. 8.000 Jahre, soll nun auch die letzte Eiszeit gesichtet werden. Ein Ergebnis ist, dass nicht nur während der letzten 2.500 und 8.000 Jahre kein plausibler Zusammenhang zwischen CO2-Konzentrationsveränderungen und Meerespegel besteht, das „Verhalten“ der Temperatur während der Eiszeit „verbietet“ eigentlich jeden Gedanken daran.

Auch mit schlimmsten „ökotheologischen“ Tatsachenverdrehungen, lässt sich der Verlauf wirklich nicht mehr mit CO2-Konzentrationen in Verbindung bringen.

Bild 31 (Aktuelle Zeit links) Verlauf Meerespegel und Temperatur während der Eiszeiten [10] Fig. 1. Comparison of two methods to assess past EDC temperature based on EDC ice core dD. Green, conventional approach taking into account past changes in sea water isotopic composition and a constant isotope–temperature slope. Red (Jouzel et al., 2007), same as green but also including a correction for ice sheet elevation changes derived from the glaciological model used for the age scale, displayed in grey on the top panel (Parrenin et al., 2007b). Horizontal dashed lines show the average Holocene and Last Glacial Maximum levels. Vom Autor ergänzt

Zur abschließenden Veranschaulichung, wie die „offiziellen“ Klimagrafiken

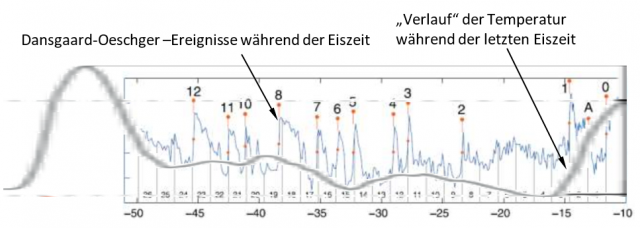

betrügen durch gezieltes Weglassen das Gegenteil der Wirklichkeit vermitteln (sollen), noch der Temperaturverlauf der letzten Eiszeit als „offizielle“ Darstellung (Ausschnitt aus Bild 31) und mit den damals stattgefunden Dansgaard-Oeschger –Ereignissen, die gewaltige und extrem schnelle Temperatursprünge waren.

Nach der AGW-Klimawandeltheorie kann das was damals mit der Temperatur passierte, in der wahren Natur überhaupt nicht möglich sein (weil die angeblich alleine die Temperatur treibende CO

2– Konzentration sich während dieser Zeit fast nicht veränderte). Trotzdem ist es regelmäßig und in gewaltigen Ausmaßen geschehen.

Bild 32 Typische Darstellung der Temperatur während der letzten Eiszeit (Ausschnitt von Bild 31) und darüber kopiert die Oeschger-Ereignisse. Grafik vom Autor erstellt

Manchmal kommen auch Klimaforscher dank umfangreicher Fördermittel auf Erkenntnisse, die einem Laien alleine aufgrund einfacher Datensichtungen auffallen:

EIKE 21.02.2018: Und plötzlich wird die Zukunft glücklicher

AWI:

[11] …

Als zukünftige Aufgabe formulieren die AWI-Forscher: „Wir wollen die Veränderungen der kurzfristigen Schwankungen in der Vergangenheit und deren Zusammenhang mit langfristigen Klimaänderungen detailliert untersuchen. Dazu brauchen wir zuverlässige Klimaarchive und ein detaillierteres Verständnis darüber, wie diese zu interpretieren sind.“ Die Trennschärfe so zu erhöhen, dass damit zukünftig auch Extremereignisse in Paläo-Archiven abgebildet werden können, wie wir sie heute erleben, sei eine der großen Herausforderungen für die kommenden Jahre.

Quellen

[1] EIKE 29. Juni 2020:

Wie schnell steigt eigentlich der Meeresspiegel?

[2] EIKE 27. Juni 2020:

Wo ist die „Klimakrise“?

[3] WIKI Bildungsserver: Meeresspiegeländerungen

[4] DKK Deutsches Klima-Konsortium KLIMA-FAQ 5.2:

MEERESSPIEGEL Wie ungewöhnlich ist die aktuelle Änderungsgeschwindigkeit des Meeresspiegels?

[5] Stefan Rahmstorf, SCILOGS

22. Feb 2016: Meeresspiegel über die Jahrtausende

[6] AR5 Langfassung:

Chapter 13 Sea Level Change

[7] NoTricksZone:

2m higher Holocene Sea-Levels

[8] Johannes Gutenberg University, 55099 Mainz, Jan Esper at al, 8 JULY 2012: Orbital forcing of tree-ring data

es on the last 8000 years.

[9] Mörner August 2016:

Sea level changes in the real world Models vs observational facts

[10] V. Masson-Delmotte at al. 2010: EPICA Dome C record of glacial and interglacial intensities

[11] AWI 05.02.2018: Klimaschwankungen in Vergangenheit und Zukunft

[12] ZAMG: 12.000 Jahre Die aktuelle Warmzeit