40 Länder diskutieren darüber, wie man der Welt am besten billige, sichere Energie vorenthalten kann.

Am Donnerstag, dem 9. Juli, berief die Internationale Energieagentur (IEA) eine riesige Online-Veranstaltung ein, wie oben abgebildet, die fälschlicherweise den Titel „Clean Energy Transitions Summit“ trug. Sie brachte Regierungsvertreter von 40 der größten Volkswirtschaften der Welt sowie von Entwicklungsländern zusammen, die für 80% der globalen Treibhausgasemissionen verantwortlich sind. Obwohl der Exekutivdirektor der IEA, Dr. Fatih Birol, den Gipfel als „die wichtigste globale Veranstaltung zu Energie- und Klimafragen im Jahr 2020“ bezeichnete, ging es in Wirklichkeit nur um politisch korrekte Propaganda, bei der die Politiker damit prahlten, wie viel „saubere Energie“ ihre Nationen ins Netz bringen.

Wind- und Sonnenenergie waren die Quellen, die von den Rednern des Aufrufs am häufigsten genannt wurden. Wir wissen jetzt, dass sie alles andere als sauber sind. Sie gehören zu den schmutzigsten und umweltschädlichsten Energiequellen des Planeten, die in dem neuen Dokumentarfilm Planet For The Humans gezeigt wurden.

Die IEA teilte uns im Vorfeld der Telefonkonferenz mit, dass „die Diskussionen auf der Grundlage des Berichtes mit dem Titel World Energy Outlook Sustainable Recovery der IEA erfolgen“. Und was wurde in diesem Dokument empfohlen? Wir müssen „das Wachstum der Wind- und Solar-PV [Photovoltaik] beschleunigen“.

Ein Redner nach dem anderen lobte die Vorzüge der Energiepolitik ihrer jeweiligen Nationen, die sich darauf konzentrieren, große Fortschritte bei der Förderung von Wind und Sonne zu machen. Es schien ihnen nicht in den Sinn zu kommen, dass die Ermöglichung einer wirtschaftlichen Erholung nach der COVID-19-induzierten Abschaltung schwierig und teuer genug sein wird, ohne dass sie versuchen, die weltweite Energieinfrastruktur neu zu gestalten. Es wurde uns gesagt, dass wir zu einer „neuen Normalität“ zurückkehren müssen, in der Maßnahmen gegen den Klimawandel im Mittelpunkt stehen.

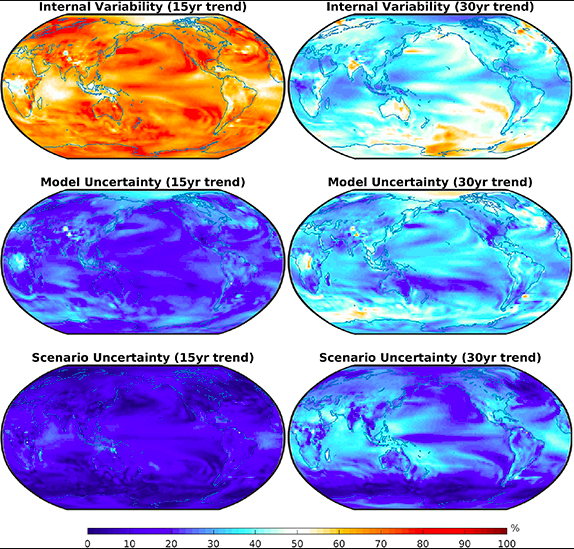

Keiner dieser Leute hat darauf geachtet, was in der Welt außerhalb dieses Online-Videotheaters geschieht. Wind- und Sonnenenergie konnten den Anteil der durch fossile Brennstoffe erzeugten Weltenergie kein bisschen verringern. Die eigenen Daten der IEA (siehe unten) zeigen, dass der Anteil von Kohle, Erdgas und Öl an der weltweiten Primärenergieversorgung trotz endloser Klimaabkommen und der Installation von 300.000 industriellen Windturbinen in der ganzen Welt seit Jahrzehnten konstant bei etwa 80% liegt.

Das liegt daran, dass keine moderne Industriegesellschaft mit Wind- und Sonnenenergie arbeiten kann, egal, wie sehr sich Regierungen etwas anderes wünschen und egal, wie viele vom Steuerzahler finanzierte Subventionen sie in die Wind- und Sonnenenergie fließen lassen. Sie sind einfach zu teuer und unzuverlässig.

Planet For The Humans, der von Michael Moore produzierte Film, wurde am diesjährigen Tag der Erde, dem 22. April, kostenlos für die breite Öffentlichkeit freigegeben. Er enthüllt die umfangreichen Schäden, die den Biosystemen der Natur zugefügt werden, wenn riesige Regionen in Wind- und Sonnenkraftwerke umgewandelt werden. Der Film zeigt Tagebauminen, die tief in die Erde gegraben wurden, um Eisen, Aluminium, Kupfer und andere Mineralien zu gewinnen, die für diese Ungetüme benötigt werden. Hunderte Tonnen Zement werden benötigt, um die Basis der 90 bis 150 Meter hohen industriellen Windturbinen zu verankern, die jedes Jahr Millionen von Vögeln und Fledermäusen abschlachten. Und dann gibt es noch unzählige Tonnen Erde und Felsen, die mit Tausenden Pfund Dynamit gesprengt werden, um relativ kleine Mengen an Seltenerdmetallen zu gewinnen, die in China oft mit wenigen Umweltkontrollen produziert werden. Dies ist die Forderung des Gipfels für den Übergang zu sauberer Energie.

Und was gibt es im Hintergrund, um die Lücke zu füllen, wenn der Wind nicht weht oder die Sonne nicht scheint? Fossile Kraftwerke natürlich. Solaranlagen sind in Wirklichkeit nur eine Fassade für mehr, nicht weniger fossile Kraftwerke. Deshalb findet man kaum Stromversorgungsunternehmen, die gegen Wind und Sonne stehen, da sie wissen, dass wenn sie ein neues Reservekraftwerk für fossile Brennstoffe bauen, ihre Energiepreise erhöhen dürfen.

Diese sozialistisch orientierten Länder werden sich nun in der Telefonkonferenz mit einem der Ihren auseinandersetzen müssen, nämlich mit Michael Shellenberger, der sich nach fast einem Vierteljahrhundert falsch verstandenem Umweltaktivismus‘ gegen sie wendet.

Shellenbergers Artikel aus dem Forbes-Magazin vom 20. Juni 2020 mit dem Titel [übersetzt] „Der neue Klimaplan der Demokraten wird gefährdete Arten töten, fürchten Umweltschützer“ relativiert die Umweltschäden durch industrielle Windturbinen. Er sagt: „Es ist bemerkenswert, dass viele der Umweltschützer, die Wildtiere vor industriellen Windturbinen und Hochspannungsleitungen schützen, den erneuerten Green New Deal der Demokraten und ihre Forderung nach einer schnellen Einführung von Windmühlen und Hochspannungsleitungen nicht als Klimatraum, sondern eher als ökologischen Alptraum betrachten“.

Und jetzt hat Shellenberger mit seinem neuen Buch „APOCALYPSE NEVER: Why Environmental Alarmism Hurts Us All“ einen Pfahl ins Herz des Umwelt-Establishments geschlagen, veröffentlicht am 30. Juni. Er schreibt:

„100% erneuerbare Energie würden eine Erhöhung der für Energie genutzten Fläche von heute 0,5% auf 50% erfordern. Wir sollten danach trachten, dass Städte, Bauernhöfe und Kraftwerke höhere und nicht niedrigere Energiedichten haben … Die Beweise sind überwältigend, dass unsere Hochenergie-Zivilisation besser für Mensch und Natur ist als die Niedrigenergie-Zivilisation, zu der uns die Klima-Alarmisten zurückbringen wollen“.

Ich bin davon überzeugt, dass der Schuss des Energiegipfels am 9. Juli 2020 in 40 Ländern nach hinten losgehen wird, um eine vernünftige Energieproduktion in der ganzen Welt zu fördern. Er hat sich offen auf die Seite irrationaler, unproduktiver Bemühungen gestellt, die Notlage von mehr als einer Milliarde Menschen in der Welt zu verschlimmern, die ohne Strom bleiben.

Link: https://www.cfact.org/2020/07/17/40-countries-discuss-depriving-world-of-inexpensive-safe-energy/

Übersetzt von Chris Frey EIKE