Die Medien befleißigen sich jetzt der Meinungskontrolle!

Heute sind die Universitäten Schauplatz einer neuen, bedauerlicherweise fehlgeleiteten Bewegung, der Anti-Freie-Rede-Bewegung. Einige bezeichnen sie als „Cancel Culture“, was unklar ist, aber im Wesentlichen ist es eine Bewegung, die von der verhängnisvollen Idee angetrieben wird, dass eine Gruppe von Menschen in der Lage sein sollte, anderen Menschen zu diktieren, was sie sagen dürfen, welche Meinungen sie ausdrücken dürfen, was sie schreiben und welche Worte sie sprechen dürfen. Schriftsteller und Redner, die nicht in ein sehr enges Fenster dessen passen, was von den Twitter-Mobs als „akzeptabel“ erachtet wird, werden niedergeschrieen, ausgeladen, verleumdet, mit Kündigungsforderungen konfrontiert und in ihrem Leben bedroht.

Bari Weiss, die gerade nach einer dreijährigen Amtszeit als Redakteurin und Autorin über Kultur und Politik bei der New York Times zurückgetreten ist, drückte es so aus:

„Twitter steht nicht auf dem Impressum der New York Times. Aber Twitter ist ihr letzter Redakteur geworden. Da die Ethik und die Sitten dieser Plattform zu denen der Zeitung geworden sind, ist die Zeitung selbst zunehmend zu einer Art Plattform für Vorstellungen geworden. Die Geschichten werden so ausgewählt und erzählt, dass sie auch das kleinste Publikum zufrieden stellen, anstatt einem neugierigen Publikum zu erlauben, über die Welt zu lesen und dann seine eigenen Schlussfolgerungen zu ziehen. Mir wurde immer beigebracht, dass Journalisten damit beauftragt werden, den ersten groben Entwurf der Geschichte zu schreiben. Nun ist die Geschichte selbst eine weitere vergängliche Sache, die so gestaltet ist, dass sie den Bedürfnissen einer vorgegebenen Erzählung entspricht“.

Und, mein persönlicher Lieblingssatz:

„Das Papier der Aufzeichnungen ist mehr und mehr die Aufzeichnung derer, die in einer weit entfernten Galaxie leben, eine, deren Sorgen aus dem Leben der meisten Menschen zutiefst entfernt sind“.

(Lesen Sie das gesamte Rücktrittsschreiben auf der Website von Bari hier. Es ist die zehn Minuten, die dafür erforderlich sind, durchaus wert. Vielleser bei WUWT werden feststellen, dass ich auf diesen Seiten seit Jahren dasselbe über die NY Times sage).

Die Free Speech Movement führte dazu, dass die Universitäten bestimmte Bereiche benannten, in denen jeder kommen und sprechen, Broschüren und Flugblätter verteilen und die von ihm gewählten Meinungen und politischen Ansichten zum Ausdruck bringen konnte. Jede Meinung – jede Rede – alles schriftliche Material. Es spielte keine Rolle, wie beleidigend es für einige war; wie verrückt, abgedreht oder antiamerikanisch es war. Sie konnten es sagen, schreiben und verteilen. Die meisten dieser freien Reden und Pamphlete wurden einfach im Vorbeigehen angenommen und in den Papierkorb geworfen. Aber sie wurden nicht verboten und nicht aus dem Leben gerissen.

Traurigerweise ist das heute nicht mehr der Fall.

Das heutige öffentliche Forum, die heutige Free Speech Zone, ist das Internet. Persönliche und organisatorische Websites, Facebook-Seiten, Twitter-Feeds. Das Schöne am Internet war, dass man sagen konnte, was immer man wollte, und solange man nicht gegen bestimmte Gesetze (Pornographie, Morddrohungen usw.) verstieß, konnte man seine Ansichten veröffentlichen, und wenn andere Leute sich dafür entschieden, sie zu lesen, konnten sie dies frei tun.

Sie lesen gerade eine dieser Bemühungen um freie Meinungsäußerung: Watts Up With That. Es hat Versuche gegeben, diese Website zu schließen, es hat persönliche Drohungen gegen ihren Gründer und einige der Autoren hier gegeben. Es gibt ideologische Gegner, die diese Website fälschlicherweise als Fehlinformation und Desinformation bezeichnen und diejenigen, die hier schreiben, verleumden und verleumden. Diese Opposition hat das Recht, ihre Meinung zu äußern – genau wie wir. Sie haben nicht das Recht, sich zu bemühen, ihre Ansichten anderen gegenüber durchzusetzen, indem sie versuchen, diese Website zu schließen oder den Verkehr von dieser Website wegzuleiten. Google hat WUWT in seiner Suchmaschine delegitimiert und gleichzeitig verleumderische Sites legitimiert. (Einige meiner früheren Arbeiten über Google hier, hier und hier).

Jetzt ist ein neues Übel aufgetaucht, und zwar auf dem größten öffentlichen Forum der Welt, Facebook. Der Angriff von Facebook auf die Redefreiheit wird als „Faktenprüfung“ bezeichnet – und ein ähnlicher Angriff wurde in vielen Zeitungen reflektiert.

FACT-CHECKING oder OPINION-CHECKING?

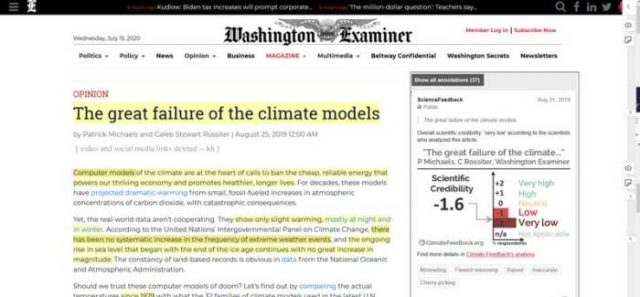

Der „Vorfall“ ereignete sich im vergangenen August – die Veröffentlichung eines Meinungsbeitrags im Washington Examiner von Pat Michaels und Caleb Rossiter von der CO2-Koalition. Der Beitrag wurde anschließend auf die Facebook-Seite der Koalition kopiert.

Die Kopie der Facebook-Seite der CO2-Koalition wurde prompt als „falsch“ bezeichnet. Hier ist die Geschichte unklar, und verschiedene Medien berichten unterschiedlich. Eine Version besagt, dass ein aufgeklärter Facebook-Mitarbeiter (die Presse bezeichnet ihn als „konservativen“ Mitarbeiter, der noch nicht identifiziert wurde) das „falsche“ Etikett mit der Begründung entfernte, dass es sich bei der Arbeit des Washingtoner Prüfers eindeutig um eine Stellungnahme handelte. Andere Nachrichtenagenturen geben an, dass Facebook auf einen Protest der CO2-Koalition reagierte und das Etikett entfernte.

Diese Geschichte hätte damals sterben müssen – es war ein „Sturm in der Teekanne“ – aber seltsamerweise tauchte sie letzte Woche an mehreren Stellen wieder auf (hier, hier und noch überraschender hier (als PDF), als Brief von Elizabeth Warren und drei anderen US-Senatoren an Mark Zuckerberg).

Es scheint mir, dass jemand diese Geschichte an wohlwollende Medien mit einer Kopie an das Büro von Elizabeth Warren weitergeleitet hat.

Was wirklich passiert ist, wird in der Presse verschleiert, aber wenn man tief genug gräbt und die gesamte Presseberichterstattung liest, stellt man fest, dass Facebook niemanden gebeten hat, den fraglichen Artikel einem „Fact-Check“ zu unterziehen. Eine private Klimaschutzgruppe initiierte die Aktion auf eigene Faust und nutzte ihre Position als „anerkannte“ Facebook-Organisation außerhalb einer dritten Organisation zur Faktenüberprüfung, um den Artikel (auf der Facebook-Seite einer privaten Organisation) als falsch zu kennzeichnen. Dazu mussten sie lediglich einen Eintrag in eine Facebook-Datenbank vornehmen.

Wer hat das getan? Climate Feedback. Sie sind nicht auf der Facebook-Liste der anerkannten Faktenprüfer aufgeführt (siehe diese Site, unten, wählen Sie, um die Liste der US-amerikanischen Faktenprüfer zu sehen), aber sie sind offenbar eine Untergruppe von Science Feedback, die aufgeführt ist.

Man erhält sofortiges „Feedback“ zu ihren Meinungen über das Klima durch dieses Bild auf der Startseite der Science Feedback-Website:

Facebook verfolgt den Grundsatz, dass Meinungsartikel in der Regel nicht auf Fakten überprüft werden, basierend auf der offensichtlichen Tatsache, dass:

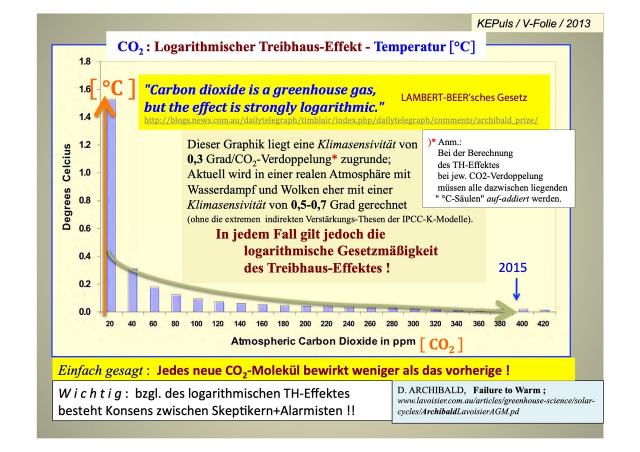

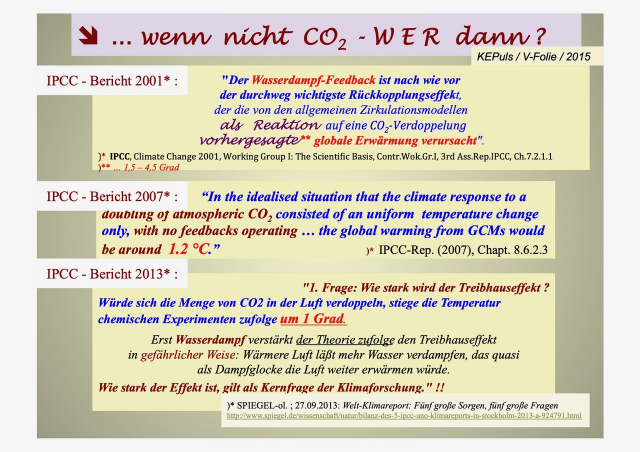

und zu kontroversen Themen wie dem Klimawandel decken sie ein sehr breites Spektrum von Standpunkten ab, von „wegen der CO2-Verschmutzung sind wir alle dem Untergang geweiht und werden alle sterben“ (mit verschiedenen Zeitrahmen von 5 bis 30 Jahren) bis hin zu dem Standpunkt von Michaels, Rossiter (und Will Happer) bei der CO2-Koalition, dass höhere „Kohlendioxidwerte allen helfen werden, auch zukünftigen Generationen unserer Familien“.

Die offizielle Haltung von Facebook zu Meinungen und Fact-Checking ist Folgende:

„Meinung:

Der Inhalt von Meinungen kann im Allgemeinen nicht bewertet werden. Dazu gehören Inhalte, die für Ideen eintreten und Schlussfolgerungen auf der Grundlage der Interpretation von Fakten und Daten ziehen und der Öffentlichkeit mitteilen, was der Autor oder Beitragende über ein Ereignis oder ein Thema denkt. Meinungsbeiträge können berichtete Fakten oder Zitate enthalten, betonen jedoch die eigenen Gedanken, persönlichen Vorlieben und Schlussfolgerungen des Autors. Dazu können auch Leitartikel, Befürwortungen oder Inhalte gehören, die in der Überschrift mit „Meinung“ gekennzeichnet sind, von einem identifizierten Meinungskolumnisten verfasst wurden oder von einer Website oder Seite mit dem Hauptzweck verbreitet werden, die Meinungen oder Tagesordnungen von Persönlichkeiten des öffentlichen Lebens, Think Tanks, NGOs und Unternehmen zum Ausdruck zu bringen. Inhalte, die als Meinung präsentiert werden, aber auf zugrundeliegenden falschen Informationen basieren, können dennoch für eine Bewertung in Frage kommen“.

Facebook ist der Ansicht, dass Menschen ein Recht darauf haben, ihre Meinung frei zu äußern (und nicht irgendein fleißiger Körper, Twitter-Mob oder eine Issue-Advokat oder Advocacy-Gruppe, die ihre Meinung unabhängig voneinander als falsch, Fehlinformation, Desinformation, Falschdarstellung usw. abstempelt). Jemand – und ich vermute, es handelt sich dabei um die gleichen Personen, die an Science/Climate Feedback beteiligt sind – erzeugt wieder eine Menge neuen Lärm über die Politik von Facebook. Diese Ausgabe teleportierte sich nicht einfach durch die Zeit vom letzten August zur Abteilung Klima der NY Times, zu ClimateWire, zur Website Heated oder zum Schreibtisch von Elizabeth Warren. Offenbar hat jemand beschlossen, die laufenden Bemühungen, Facebook dazu zu bringen, Inhalte anderer sozialer und politischer Themen [Rassismus, Trump, Impfstoffe, Polizei] zu zensieren oder zu kontrollieren, auch versucht, die Plattform dazu zu bringen, auch Meinungen zum Klima zu zensieren.

Das nennt man Fact-Check?

Es ist eine interessante Lektüre, die „Anmerkungen“ zu sehen – die Details der „Fakten“-Überprüfung, die Climate Feedback dazu veranlasst hat, den Artikel der CO2-Koalition fälschlicherweise als „falsch“ zu bezeichnen – ClimateFeedback hat die „Faktenüberprüfung“ des Meinungsartikels selbst initiiert – Man denke daran, dass Facebook keine Faktenüberprüfung dieses Artikels verlangt hat.

Man schaue hier.

Das Kästchen auf der rechten Seite erscheint, wenn man auf die Überschrift der Geschichte klickt. Wenn man auf einen anderen hervorgehobenen Text klickt, wird deutlich, dass es sich bei den „Faktenprüfern“ nicht um eine Faktenprüfung, sondern um eine Meinungsprüfung handelt. Ich empfehle den Lesern, sich die Seite anzusehen und auf die einzelnen Anmerkungen zu klicken, um die „Faktenprüfung“ für den jeweiligen Artikel zu sehen. ALLE sind Meinungsfragen, die von der Gesamtsicht auf die Klimafrage abhängen. Einer der „Faktenprüfer“, Stephen Po-Chedley, verlinkt gerne auf einige seiner eigenen Artikel als Beweis dafür, dass die Koalition in dem einen oder anderen Punkt falsch liegt.

E&E-News stellt fest:

„Facebook hat es einfacher gemacht, die Öffentlichkeit in die Irre zu führen, weil es ungenaue Klima-Behauptungen einem Publikum aufbürdet, das nur an parteiischen Erzählungen interessiert und nicht bereit ist, die tatsächliche Wissenschaft zu untersuchen, sagte Andrew Dessler, ein Klimawissenschaftler an der Texas A&M University und Mitglied des Teams, das den ursprünglichen Beitrag der CO2-Coalition auf Fakten überprüft hat. Er sagte, dass Facebook, wie auch andere soziale Medienunternehmen, es den Menschen erlaube, „in den Blasen zu leben, wo sie nur die Informationen hören, die sie hören wollen“.

[NB: Keine der Anmerkungen zum Artikel des Washington Examiner wurde von Andrew Dessler gepostet. Dessler ist weder auf der Climate Feedback-Website noch auf der Science Feedback-Website als Gutachter aufgeführt].

Hier ist die Abfolge der Ereignisse:

1. Pat Michaels und Caleb Rossiter veröffentlichen am 25. August 2019 im Washington Examiner ein Op-Ed-Stück, in dem sie die Meinungen ihrer Gruppe, der CO2-Koalition, zum Thema Klimawandel und CO2 darlegen.

2. Das Climate Team, einschließlich derer, die mit dem sogenannten Klima-Feedback befasst sind, und Andrew Dessler (der nicht offiziell mit der Science/Climate Feedback Group verbunden ist), mögen diese Meinungen nicht.

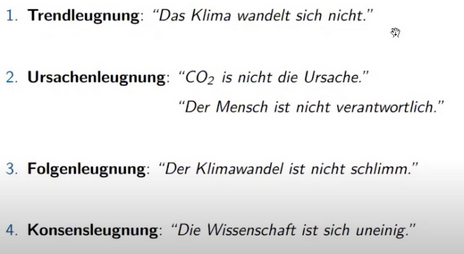

3. Anscheinend können sie den Washington Examiner nicht unter Druck setzen, also gehen sie dem wiederveröffentlichten Artikel auf der Facebook-Seite der Koalition nach, führen ihre unabhängige und unaufgeforderte „Faktenprüfung“ durch und bezeichnen den Meinungsartikel auf Facebook als „irreführend, fehlerhaft argumentiert, voreingenommen, ungenau und als Rosinenpickerei“. Man beachte, dass alle ihre Einwände selbst Meinungen und ihr eigenes Verständnis komplexer Daten sind – wenn auch in Übereinstimmung mit dem, was als „Klimakonsens“ bezeichnet wird.

4. Im September 2019, etwa drei Wochen später, nach einer Beschwerde der Koalition, stimmt Facebook zu, dass die Überprüfung von Fakten eine Verletzung der eigenen Richtlinien darstellt und ent-kennzeichnet den Artikel.

5. Nun, Ende Juni 2020, beginnt jemand, der nicht bereit ist, diesen Angriff auf die Redefreiheit erfolglos bleiben zu lassen,, „Empörung“ zu schüren, nachdem er zehn Monate gewartet hat, indem er den Artikel erneut an Nachrichtenagenturen (und, wie es scheint, an Elizabeth Warren im US-Senat) herausgibt.

Diejenigen, die das nicht ganz verstehen, sollten das Rücktrittsschreiben von Bari Weiss, das weit oben verlinkt ist, noch einmal lesen. Sie sagt es über der NY Times, aber es trifft auf fast alle Massenmedien in den Vereinigten Staaten (und sicherlich auch in Großbritannien) zu:

„Stattdessen hat sich in der Presse, aber vielleicht besonders bei dieser Zeitung, ein neuer Konsens herauskristallisiert: dass die Wahrheit kein Prozess der kollektiven Entdeckung ist, sondern eine Orthodoxie, die bereits einigen wenigen Aufgeklärten bekannt ist, deren Aufgabe es ist, alle anderen zu informieren“.

Wir sehen dies jetzt bei Google, Twitter, YouTube und anderen sozialen Medien und internetbasierten Plattformen. Diejenigen, die sich selbst für die „aufgeklärten Wenigen“ halten – die glauben, dass nur sie die Wahrheit kennen und dass „Wahrheit = Orthodoxie, Wahrheit = Konsens, Wahrheit = der Wille der Mafia“ ist – und die Macht ergreifen, um alle Ansichten zu blockieren, die ihren eigenen widersprechen.

Dies gilt in der Klimawissenschaft seit Jahrzehnten. Es überrascht jedoch diejenigen, die den Blick gesenkt und weggeschaut haben, froh, dass sie sich auf einem anderen Gebiet befanden. Nun, da der Konsens-Mob seine Aufmerksamkeit auf Historiker, Ärzte, Philosophen, Psychologen, Professoren und Juristen gelenkt hat, sehen wir ein paar weitere Stimmen, die sich gegen diese zerstörerische Flut stemmen. Diese Stimmen werden wiederum bösartig angegriffen, weil sie die Redefreiheit verteidigen – schließlich „passen sie nicht in das anerkannte Twitter-Narrativ“.

# # # # #

Kommentar des Autors dieses Beitrags:

Dies ist ein Meinungsartikel. Wenn Sie damit nicht einverstanden sind, hinterlassen Sie bitte Ihre gegenteilige Meinung in den Kommentaren.

Beispiele sind im Alltag so weit verbreitet, dass wir eine rekordverdächtige Anzahl von Kommentaren hätten, wenn jeder Leser einen Link zu einer lokalen Geschichte hinterlassen würde, die dieses Problem veranschaulicht.

Am 15. Juli 2020 gab Caleb Rossiter hier seine Version dieser Episode wieder.

Ich nenne in diesem Aufsatz keine Beispiele für eine reine Zweiparteienpolitik. Diejenigen Leser, die sehen möchten, wie schlimm dieses Problem ist, wenn es die Zwei-Parteien-Politik in den Vereinigten Staaten betrifft, können sich einen der folgenden Sites ansehen, einen beliebigen Link auswählen und selbst bestimmen, ob die Medien Fakten oder Meinungen prüfen. Meiner Ansicht nach prüfen sie meist anhand ihrer etablierten redaktionellen Vorgaben und nicht anhand von Fakten. (Nochmals, man lese Bari Weiss).

AP News: https://apnews.com/APFactCheck

CNN Fact-Check Politics: https://www.cnn.com/specials/politics/fact-check-politics

NPR Fact-Checks Politics: https://www.npr.org/sections/politics-fact-check

MSN Fact-Check: https://www.msn.com/en-us/news/factcheck

USA Today Fact-Check: https://www.usatoday.com/news/factcheck/

NY Times Fact-Checks: https://www.nytimes.com/spotlight/fact-checks

Dies ist ein schwerwiegendes Problem – wir alle müssen uns klarmachen, wo wir stehen. Verlangen Sie von Ihren lokalen Nachrichtenagenturen, dass sie echten Journalismus praktizieren – und dass sie nicht nur nachplappern, worum es bei den Twitter-Mobs geht. Verlangen Sie eine wirklich unvoreingenommene Berichterstattung über Themen.

Und um Himmels willen, wenn Sie sich versucht fühlen, „mitzumachen, um miteinander auszukommen“ – hören Sie auf! Hören Sie einfach auf! (h/t Bob Newhart)

Lesen Sie viel, denken Sie selbst nach und denken Sie kritisch.

Link: https://wattsupwiththat.com/2020/07/23/the-media-is-now-opinion-checking/

Übersetzt von Chris Frey EIKE