Eine weitere Klima-Propaganda-Story, welche das Normale als anomal propagiert

Das jedoch rechtfertigt nicht, dass sich die Medien dieser Praxis bedienen. Alles, was damit erreicht wird, ist die Illustrierung, warum das ein bequemes Verfahren war, den betrügerischen Eindruck zu erwecken darüber, was normal ist. Zum Beispiel posaunte eine Schlagzeile der BBC im Jahre 2017 „Heißester Junitag seit der Hitzewelle im Sommer 1976“. Das sind 41 Jahre, was zwar statistisch, aber nicht klimatologisch relevant ist. In einer Youtube story heißt es: „Sydney verzeichnete den nassesten Novembertag seit 1984“. Bei CBS Pittsburgh hörte man: „2018 ist das zweitnasseste Jahr jemals in Pittsburgh“. Die Aufzeichnungen begannen im Jahre 1871 oder vor 147 Jahren, aber nicht einmal das ist klimatologisch signifikant. Schlagzeilen nach meinem Geschmack sind von der Art wie die Folgende aus North Carolina, in der es heißt: „Ein Blick zurück auf den kältesten Tag jemals in North Carolina“. „Jemals“ heißt etwa 4,5 Milliarden Jahre.

Andere Artikel konzentrieren sich auf eine bestimmte Lage oder die Änderung einer Lage, wieder mit dem Gedanken im Hinterkopf, dass das alles neu oder anomal ist. Beispielhaft steht hierfür die Schlagzeile aus dem Jahr 2012 „Warum gab es in diesem Jahr mehr Tornados als normal?“ Oft sind diese Schlagzeilen auch suggestiv wie etwa bei der New York Times im Jahre 2017: „Die Hurrikan-Saison 2017 ist wirklich stärker als normal“. Liest man den ganzen Beitrag, erkennt man wie üblich, dass die ganzen Vorbehalte am Ende zeigen, dass es keineswegs ungewöhnlich ist. Das Problem ist die Schlagzeile selbst, welche sich in den Köpfen der Öffentlichkeit festsetzt.

Eine Schlagzeile lautet: „Der Autor schreibt über eine Reihe von Stürmen, die Kurs auf die Westküste von Nordamerika nehmen“. In dem Artikel heißt es dann:

Während El Nino-Jahren beruhigen sich die Dinge nach dem 1. Januar oftmals … aber nicht in diesem Jahr … wird doch die Westküste der USA vom zentralen Kalifornien bis nach Washington State durch eine Reihe von Stürmen geschlagen. Regen, Schnee, Wind? Vieles für jedermann. Ein Blick auf das jüngste Infrarot-Satellitenbild zeigt eine erstaunliche Kette von Stürmen, die sich bis weit auf den Pazifik hinaus erstreckt. Ein Verkehrsstau von Stürmen.

Die Termini „geschlagen“ [pummeled] und „Verkehrsstau“ [traffic jam] sind aufrüttelnd und implizieren, dass diese Lage ungewöhnlich ist. Tatsache ist aber, dass die Lage absolut normal ist bis zu dem Punkt, dass es dafür einen treffenden Begriff gibt, den ,Ananas Express‘ [Pineapple Express]. Dieser Begriff bezieht sich auf die Lage der Polarfront entlang der Nordwestküste von Alaska und dem nördlichen British Columbia. An dieser Polarfront bilden sich das ganze Jahr über Tiefdruckgebiete. Die von diesen Vorgängen betroffenen Gebiete ändern sich mit der Verlagerung der Polarfront von einer nördlicheren Position im Sommer und einer südlicheren Lage im Winter. Der Terminus ,Ananas Express‘ bezieht sich auf die Lage im Winter, wenn sich diese Tiefdruckgebiete im Gebiet von Hawaii bilden und sich entlang der Polarfront verlagern, bis sie schließlich einer nach dem anderen die Nordwestküste erreichen. Diese Lage hört nicht auf während eines El Nino-Jahres, doch schlagen die Stürme in diesen Jahren einen anderen Weg ein.

Diese Tiefdrucksysteme stehen auch im Mittelpunkt der Darstellung normaler Wetterereignisse als anomal in Europa. Die Südverlagerung der Polarfront erfolgt auf der gesamten Nordhemisphäre. Zwei wesentliche Faktoren beeinflussen die Wetterlage, nämlich die Wassertemperatur, welche im Zuge der Meeresströme fluktuiert, und die Verteilung von Rossby-Wellen. Diese Wetterlage von Tiefdruckgebieten, welche im Winter auf Westeuropa übergreifen, wurde der Propaganda-Liste hinzugefügt, als man begann, die Tiefdruckgebiete mit Namen zu versehen*. Das stellte in den Gehirnen der Öffentlichkeit einen Link zu Hurrikanen her und impliziert, dass es ein neues Phänomen sei.

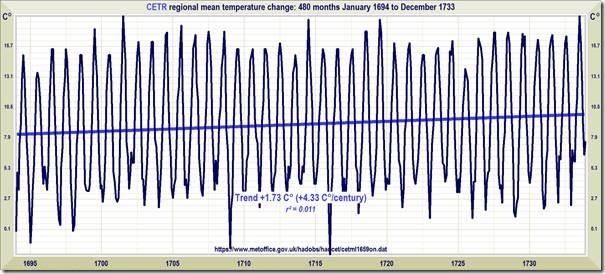

Es ist nicht neu und auch nicht von stärkerer Intensität, wie der Ausschnitt im Bild oben aus dem Jahr 1704 (!) zeigt.

[*Einschub des Übersetzers hierzu: Ursache der Namensgebung von Hoch- und Tiefdruckgebieten ist eine andere. Man begann damit in den fünfziger Jahren, also lange vor der heutigen Hysterie, am Meteorologischen Institut der Freien Universität Berlin auf eine Initiative von Frau Dr. Karla Wege. Damit sollte in Begleittexten eindeutiger hervortreten, von welchem Tiefdruckgebiet auf der Wetterkarte gerade die Rede ist. Dem Autor Dr. Ball kann aber keineswegs aus dem Mangel dieses Detailwissens ein Vorwurf gemacht werden!

Außerdem bezeichnet Dr. Ball die Tiefdruckgebiete der Polarfront durchweg als ,anti-cyclones‚, was aber als Tiefdruckgebiet übersetzt worden ist, denn nur um solche handelt es sich.

Ende Einschub]

Ein bedeutender Teil der grundlegenden und monumentalen Arbeit von Prof. Hubert Lamb zur Historie der Klimatologie war eine langzeitliche Rekonstruktion der Verteilung dieser Tiefdruckgebiete. Es passt zu folgender Behauptung, warum er die Climate Research Unit CRU an der University of East Anglia ins Leben rief:

„… es war klar, dass es das Erste und Wichtigste war, die Fakten der Aufzeichnungen des natürlichen Klimas in der Vergangenheit zu etablieren, während einer Zeit also, bevor irgendwelche Auswirkungen menschlicher Aktivitäten Bedeutung erlangen konnten“.

Als er erst einmal eine langzeitliche Reihe dieser Tiefdrucksysteme erstellt hatte, war es einfacher, die zugrunde liegenden Vorgänge zu erkennen. Daraus konnte er dann sein Endziel einer besseren Vorhersage erreichen. Die Fähigkeit zur Vorhersage definiert Wissenschaft. Falls das nicht das Endziel sein soll, ist die Arbeit zumeist irrelevant.

Man erinnere sich einmal an die destruktive und den Lauf der Geschichte verändernde Rolle von Stürmen von der Art, wie sie die spanische Armada trafen, als diese versuchte, im Jahre 1588 in England einzufallen. Phil Jones, der den Ruf der CRU unter seiner Leitung in Grund und Boden stampfte, schrieb eine gute Zusammenfassung von Lambs Arbeit. Sehr detailliert wird auch der Sturm des Jahres 1703 in dem Buch The Storm des berühmten Schriftstellers Daniel Defoe beschrieben.

Marcel Leroux war ein früher bedeutender Skeptiker hinsichtlich der Behauptung von AGW. Sein Buch Global Warming: Myth or Reality war wirkungsvoll, weil Leroux eindeutig qualifiziert war. In einer Begutachtung seines Buches liest man:

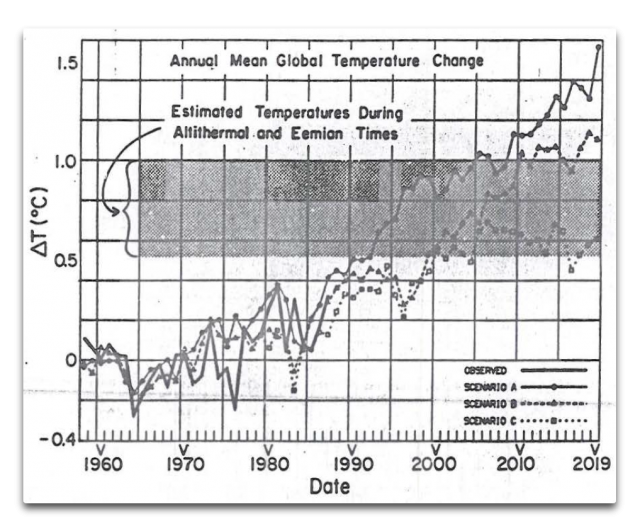

In der Debatte um die globale Erwärmung bleiben Antworten auf Fragen nach den ultimativen Ursachen und Auswirkungen vage. In seinem Buch trachtet Marcel Leroux danach, Fakten von Fiktivem zu trennen in dieser entscheidenden Debatte aus einer klimatologischen Perspektive. Er beginnt mit einer Bewertung der düsteren Hypothesen für Klimatrends und beschreibt dann die Historie des 1998 gegründeten IPCC und vieler nachfolgender Konferenzen. Er diskutiert die Haupt-Schlussfolgerungen der drei IPCC-Berichte und die prophezeiten Auswirkungen auf globale Temperaturen, Regenmenge, Wetter und Klima, während er die steigende Konfusion und den Sensationalismus von Berichten in den Medien hervorhob.

Die Bemerkung über den Sensationalismus in den Medien ist relevant für diesen Beitrag, weil Leroux genau wie Lamb an einer Rekonstruktion der Tiefdrucksysteme im Nordatlantik arbeitete. Leroux arbeitete später auch an einer Ausbeutung des Normalen seitens John Holdren, dem Wissenschaftsberater von Präsident Obama bzgl. des so genannten „Polarwirbels“. Die Arbeit von Leroux aus dem Jahr 1993 mit dem Titel [übersetzt] „Das mobile Polarhoch: ein neues Konzept zur Erklärung gegenwärtiger Prozesse des meridionalen Austausches von Luftmassen und Energie sowie globale Fortpflanzung paläoklimatischer Änderungen“ (hier) zeigte, dass diese Ausbrüche von Polarluft ein ganz normales Wetterereignis sind, die in die Klimaaufzeichnungen eingehen wegen ihres regelmäßigen, jedoch variablen zeitlichen Auftretens und deren Auswirkungen.

Wir sind hier Konfrontiert mit einer unheiligen Allianz des politischen Missbrauchs von Wissenschaft seitens des IPCC, den Tatsachenverdrehern oder, wie ich lieber sage, den professionellen Lügnern, sowie der Mainstream-Medien, welche Fake News fabrizieren, indem sie das Normale als anomal darstellen. Wie wahr ist das jüdische Sprichwort „Wahrheit stirbt niemals, führt aber eine armselige Existenz“. Das gilt vor allem für einen solchen absichtlichen Angriff.