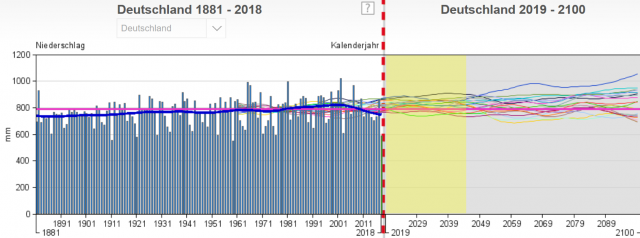

Wieviel „weiß“ das Wetter von der Vergangenheit?

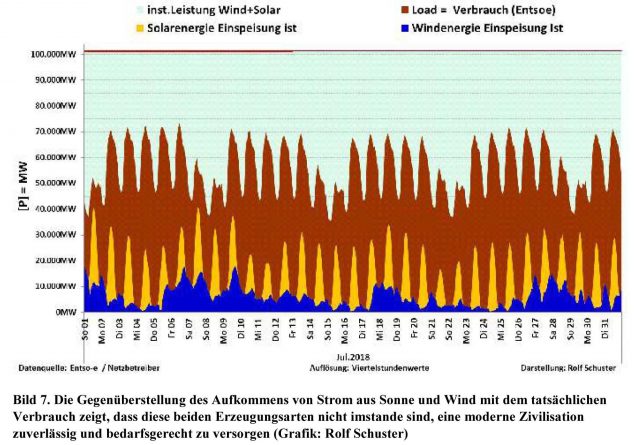

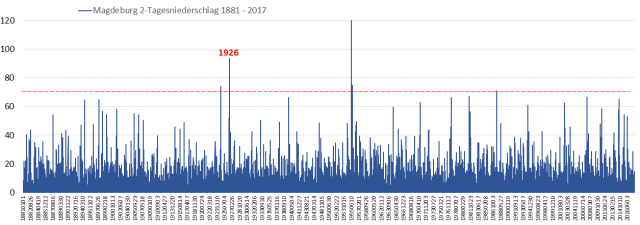

Wer sich nur etwas mit Niederschlag beschäftigt, merkt schnell: Niederschlag hat wenig „Gedächtnis“, aber eine unglaubliche Varianz. Vor allem „entsetzt“ immer neu, wie oft Extremwerte ohne jegliche „Vorwarnung“ – also ohne den geringsten Trend oder Vorankündigung auftreten. Manchmal meint oder ahnt man, Zyklen zu erkennen, doch auch das ist selbst in über 100 Jahre langen Verläufen schwierig. Anbei zum Niederschlag Beispielverläufe deutscher Messstationen:

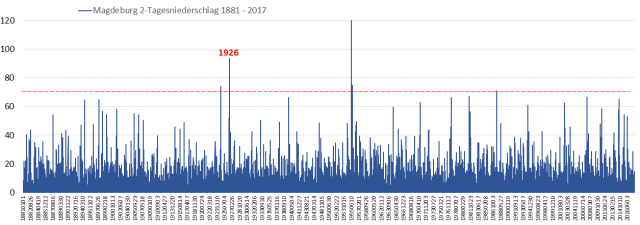

Bild 1 [2] Zwei-Tagesniederschlag Magdeburg (DWD-Station 3126). Grafik vom Autor anhand der Daten erstellt

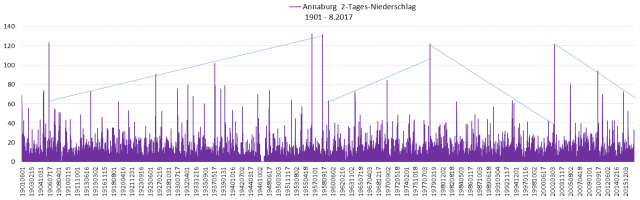

Bild 2 [3] Annaburg, Sachsen-Anhalt, 2-Tagesniederschlag 1901 – 8.2017. Quelle: DWD Daten, Station 170. Grafik vom Autor anhand der Daten erstellt

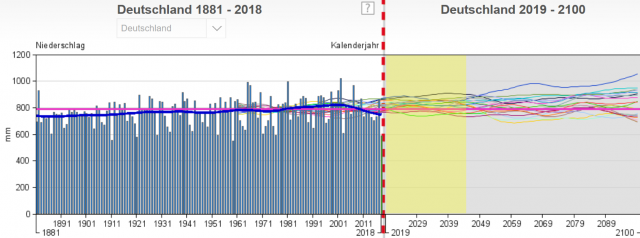

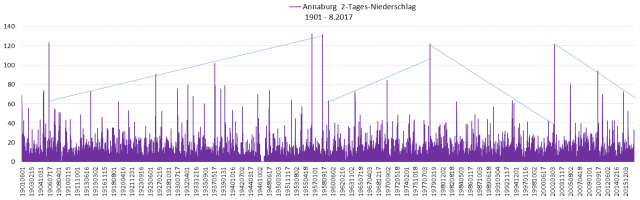

Der Gesamtniederschlag Deutschland zeigt, dass nach einem leichten Anstieg der 30jahre Mittelwert wieder den Wert von 1881 erreicht hat und die Projektionen zeigen an, dass bis zum Jahr 2100 nichts Spektakuläres zu erwarten ist, allerdings auch keine Projektion den aktuellen Mittelwert „vorhersagen“ konnte. All das wundert, denn mit der zunehmenden Wärme soll es doch viel mehr regnen und dieser auch noch zunehmen.

Bild 2.1 Gesamtniederschlag Deutschland seit 1881 mit Projektionen bis 2100. Quelle: DWD Klimaatlas Viewer

Nun hat es in den Alpen stark geschneit. Und Schnee ist nichts anderes als gefrorener Niederschlag. Und alle „Welt“ wundert sich, wie das passiert, wo sich doch niemand der Alpenbewohner an „so viel Schnee“ erinnern kann:

Hannoversche Allgemeine: [1] … Schulfrei wegen Schneefalls ist in der Region nicht normal. „Das habe ich in meinen 38 Jahren noch nicht erlebt. Auch meine Mutter kann sich nicht an eine solche Situation erinnern“, sagt die 38-Jährige …

Da mag diese 38jährige mit viel Klimaerfahrung Recht haben: Früher wurde nicht so schnell der Katastrophenfall ausgerufen. Und es gab auch nicht so viele (zu flache) Dächer im Alpenraum, die bei Schneefall erst einmal mühselig geräumt werden müssen, weil die Schneelastfähigkeit schon vorsorglich für die simulierte Klimawandel-Minderbelastung ausgelegt wurde.

Neutrale Fachpersonen befragt man vorsichtshalber nicht, um nicht versehentlich eine andere Auskunft zu bekommen, die nicht in den notwendigen Mainstream passt:

AIGNER, Günther; GATTERMAYR, Wolfgang; ZENKL, Christian (201 8): Die Winter in Tirol seit 1895. Eine Analyse amtlicher Temperatur- und Schneemessreihen. www.zukunft-skisport.at.

Darin wurde festgestellt (Zitierung aus dem Abstrakt):

… Bei Betrachtung der amtlichen Messdaten sind die klimatologischen Rahmenbedingungen für den alpinen Wintersport in Tirol nach wie vor sehr günstig. Über die letzten 50 Jahre sind die Wintertemperaturen auf Tirols Bergen statistisch unverändert. Betrachtet man lediglich die letzten 30 Jahre, so sind die Winter in diesem Zeitraum sogar deutlich kälter geworden – um 1,3 Grad Celsius.

Die längsten Schneemessreihen aus den Tiroler Wintersportorten zeigen über die vergangenen 100 Jahre insgesamt keine signifikanten Trends. Weder die jährlich größten Schneehöhen noch die jährliche Anzahl der Tage mit Schneebedeckung zeigen markante Veränderungen. Bei isolierter Betrachtung der letzten 30 Jahre bleiben die jährlich größten Schneehöhen und die Neuschneesummen relativ stabil, während die Anzahl der Tage mit Schneebedeckung leicht abgenommen hat.

Auffallend ist die hohe Variabilität der einzelnen Winter. Die Spannweiten in den Messreihen sind beachtlich – vor allem bei den jährlich größten Schneehöhen. Insgesamt zeigt sich, dass die winterlichen Schneeverhältnisse primär vom Auftreten der entscheidenden Großwetterlagen abhängen und nur mäßig mit dem Temperaturniveau korrelieren. Auch relativ milde Winter können sehr schneereich sein. Diese unvorhersehbare Dynamik der Großwetterlagen dominiert das Wetter und Klima im Alpenraum.

… Ein klimabedingtes Ende des alpinen Wintersports ist nach der Auswertung der amtlichen Messdaten nicht in Sicht …

.

„Klimareporter“, die berühmte Alarmistenseite der Regierungsberaterin wusste aber sofort:

Klimareporter, 11. Januar 2019: Klimawandel könnte Schneechaos begünstigen

Klimaexperten schließen einen Zusammenhang zwischen dem Schneechaos in Bayern und den globalen Klimaveränderungen nicht aus.

Eine Fachperson vom PIK (und Mojib Latif) wusste auch, warum das so ist:

Hannoversche Allgemeine: [1] … Doch wieso kommt plötzlich so viel Schnee auf einmal? Peter Hoffmann, Meteorologe am Potsdam-Institut für Klimafolgenforschung (PIK), spricht von „ungewöhnlich massiven Niederschlagsmengen“. „Die Niederschläge, die uns im Sommer gefehlt haben, werden jetzt im Winter ausgeglichen.“ Weil die Meere aufgrund des langen heißen Sommers noch verhältnismäßig milde Temperaturen aufwiesen, käme es darüber zu einer starken Verdunstung, so Hoffmann. Die derzeitige Wind- und Strömungslage transportiere die Feuchtigkeit in Richtung Süden.

Doch „die (wetterrelevanten) Meere“ haben derzeit gar keine verhältnismäßig milden Temperaturen

Sagt Herr Hoffmann vom PIK. Auch hierzu eine ergänzende Nachschau, ob der Winter „weiß“, wenn es im Sommer zu wenig Niederschlag gab und diesen Niederschlagsmangel dann, wie es das PIK „weiß“ pflichtgemäß ausgleicht.

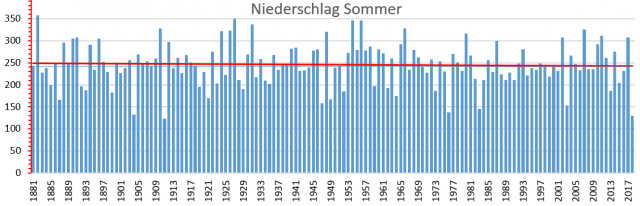

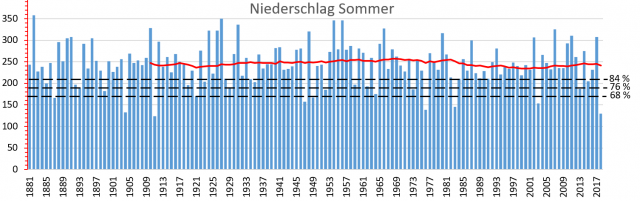

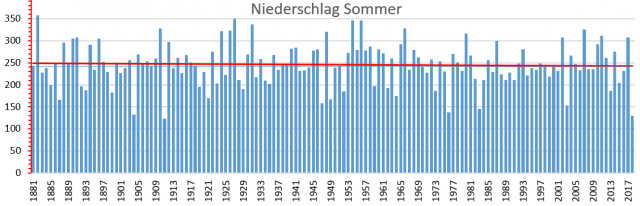

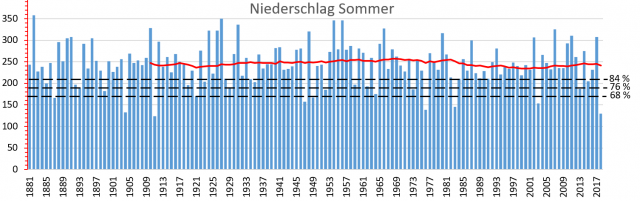

Zuerst einmal der Niederschlag Sommer betrachtet. Es wird einige überraschen, dass der Sommerniederschlag deutlich höher ist als der Winterniederschlag und keinen signifikanten Trend, aber Zyklen ausweist:

-Die lineare Regression von 1882 bis 2018 zeigt eine kaum erkennbare – innerhalb der Messungenauigkeit liegende – Verringerung des Sommerniederschlags von 250 auf 240 mm (ohne das Trockenjahr 2018 ist es noch weniger)

-Der 30-Jahre Mittelwert traf 2018 genau den Normalwert (Mittelwert des kalten Zeitraums 1961-1990)

-Die lineare Regression von 1976 bis 2018 zeigt eine deutlichere Erhöhung des Sommerniederschlags von 230 auf 247 mm (trotz dem letzten Trockenjahr)

Keine Spur davon, dass die Sommerniederschläge weniger würden, sondern über den letzten, meteorologisch wichtigen 30jahre-Zeitraum hinaus sogar ein Anstieg.

Macht nichts, simulieren lässt sich das Gegenteil:

Bildungsserver wiki: Klimaprojektionen Deutschland

… Bei den Jahreszeiten zeigen jedoch besonders die Sommer- und Wintermonate deutliche Veränderungen. Die Sommer werden in Zukunft deutlich trockener, die Winter feuchter.

Bild 3 Deutschland, Sommerniederschlag von 1881 – 2018. Rote Linie: Regressionsgerade. Daten: DWD Zeitreihen und Trends. Grafik vom Autor erstellt

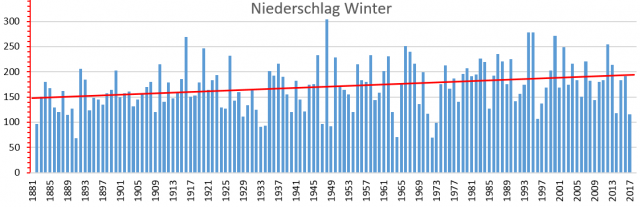

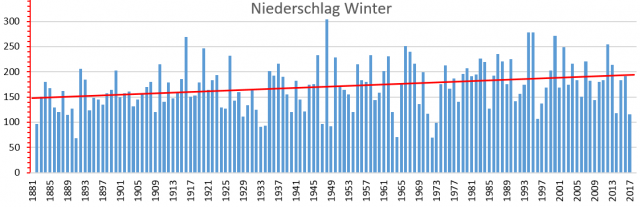

Beim Winter sieht man im Langfristverlauf einen Anstieg des Niederschlags. Allerdings nimmt der Winterniederschlag ausgerechnet seit dem „ganz schlimmen“ Klimawandeleinfluss nach 1950 ab!

-Die lineare Regression von 1882 bis 2017 zeigt eine Erhöhung des Winterniederschlags von 150 mm auf 190 mm

-Die lineare Regression von 1976 bis 2017 zeigt eine Verringerung des Winterniederschlags von 198 mm auf 185 mm

Und damit zeigt die Natur wieder das Gegenteil der berichteten Simulationsergebnisse!

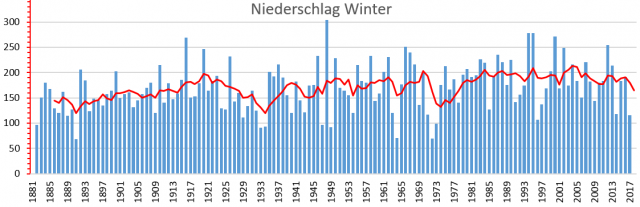

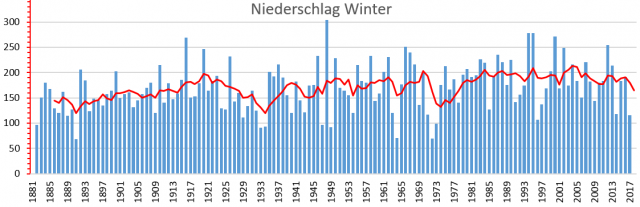

Bild 4 Deutschland, Winterniederschlag von 1881 – 2017. Rote Linie: Regressionsgerade. Daten: DWD Zeitreihen und Trends. Grafik vom Autor erstellt Nimmt man anstelle der Regressionsgeraden eine Mittelwert-Verlaufskurve, erkennt man ohne Klimawissenschaft den Grund: Da steckt ein Zyklus (nicht zufällig mit ca. 60 Jahren) dahinter.

Bild 5 Deutschland, Winterniederschlag von 1881 – 2017. Rote Linie: 6jähriger, gleitender Mittelwert. Daten: DWD Zeitreihen und Trends. Grafik vom Autor erstellt

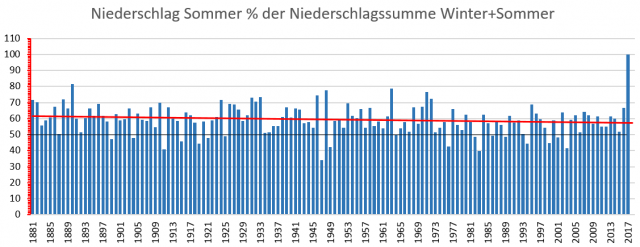

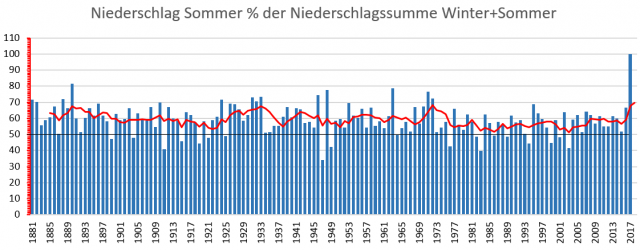

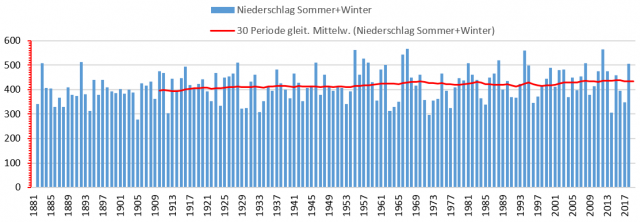

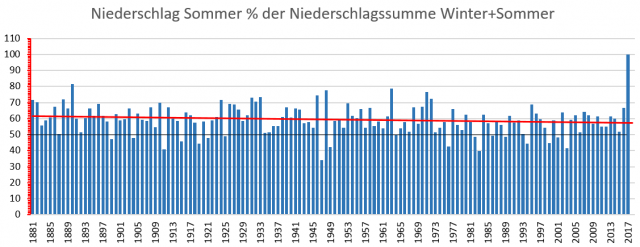

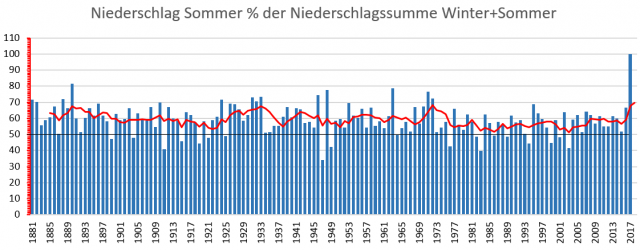

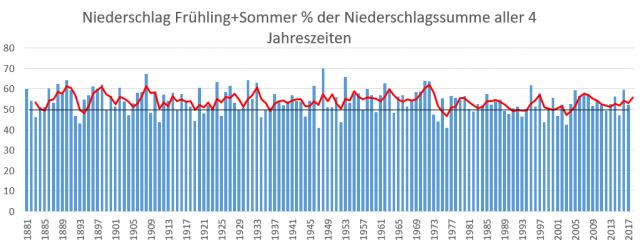

Nun melden die Klimawandelfachpersonen, dass es im Sommer trocken wird, wie es der letzte Sommer (angeblich) bewiesen hat. Deshalb der direkte Vergleich vom Niederschlag Sommer zum Niederschlag Winter.

– Die lineare Regression von 1882 bis 2017 zeigt eine Verringerung des anteiligen Sommerniederschlags von 61 auf 57 %

– Die lineare Regression von 1976 bis 2017 zeigt eine Erhöhung des anteiligen Sommerniederschlags von 52 auf 62 %

Keine Spur davon, dass die Sommerniederschläge weniger werden oder sich überhaupt signifikant verändern würden.

Bild 6 Deutschland, Anteil des Sommerniederschlags am Gesamtniederschlag Sommer + Winter. Rote Linie: Regressionsgerade. Daten: DWD Zeitreihen und Trends. Grafik vom Autor erstellt

Bild 7 Deutschland, Anteil des Sommerniederschlags am Gesamtniederschlag Sommer + Winter. Rote Linie: 5-Jahre gleitender MW. Daten: DWD Zeitreihen und Trends. Grafik vom Autor erstellt

Zur Fragestellung, ob der Winter „weiß“, dass der Sommer regenarm war

Bisher wissen wir, dass es im Sommer mehr Niederschlag hat als im Winter. Daraus könnte man folgern, dass der Winter „weiß“, wenn es im Sommer viel geregnet hat und seinen Niederschlag „zurückdreht“. Es wäre eine logische Kausalität, die allerdings nicht stimmen muss, denn es könnte ja sein, dass es im Winter einfach generell weniger regnet.

Nun erfuhr man vom Klima(Alarm)allwissenden PIK, dass es im Winter zusätzlich regnet, wenn es im Sommer besonders wenig geregnet hat.

Wie erfährt man nun vom Winter, ob er das wirklich macht?

Die Ermittlung über den Gesamtniederschlag bringt nichts, denn der ist immer 100 %. Rein mathematisch bedingt muss auf wenig Sommerniederschlag der Rest zu 100 % folgen. Deshalb der Versuch mit den folgenden Kriterien:

Ein niederschlagsarmer Sommer ist einer mit deutlich weniger als seinem 30jährigen, gleitenden Mittelwert. Der Winter „reagiert“ darauf, wenn er danach überproportionalen Niederschlag im Verhältnis zum 30jahre, gleitenden Mittelwert vom Sommer+Winterniederschlag generiert.

Anbei eine darauf aufgebaute Test-Versuchsreihe:

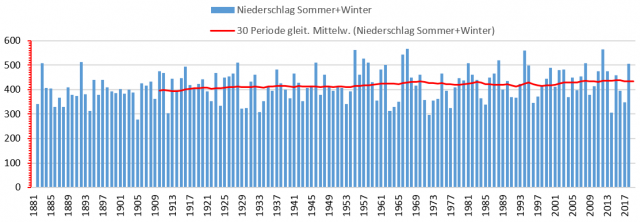

Zuerst die Datenbilder für den Sommer- und den Winterniederschlag:

Bild 8 Niederschlagsverlauf Sommer mit 30jahre gleitendem Mittelwert und Werten für „niedrigen Niederschlag“: 68; 76; 84 % vom MW. Datenquelle: DWD, Grafik vom Autor erstellt

Bild 9 Niederschlagsverlauf Sommer+Winter mit 30jahre gleitendem Mittelwert. Datenquelle: DWD, Grafik vom Autor erstellt

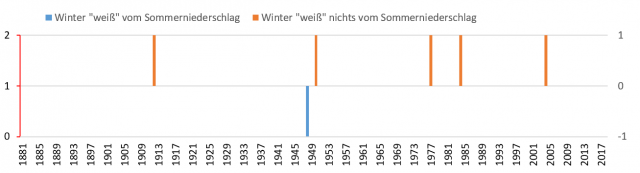

Test A

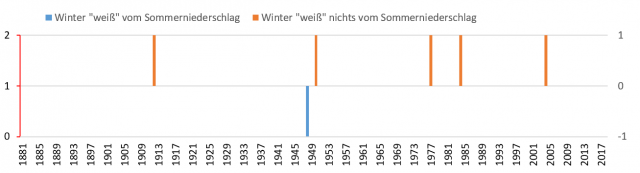

Nach sehr regenarmen Sommern wie etwa 2018 soll der Winterniederschlag besonders aktiv sein.Dazu die Testannahmen:

– Der Sommerniederschlag erreicht maximal 68 % von seinem Mittelwert (Bild 8).

– Ein „Wintergedächtnis“ wird angenommen, wenn der folgende Winterniederschlag mindestens den 30jahre gleitenden Mittelwert vom Niederschlag Sommer+Winter erreicht.

Testergebnis A:

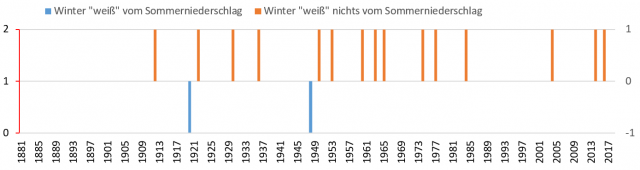

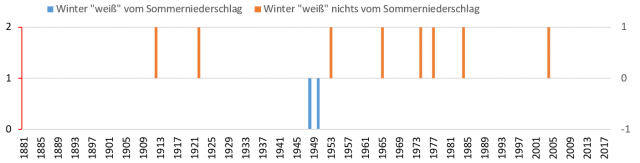

Bild 10 Ergebnis Test A. Blau: Der Winterniederschlag „weiß“ vom niedrigen Sommerniederschlag und ist relativ hoch (1 x), Braun: Der Sommerniederschlag war unter 68 %, der folgende Winterniederschlag erreicht aber nicht mindestens den Mittelwert Sommer+Winter (5 x)

Die Auswertung von Test A zeigt ein stark negatives Ergebnis. Nach sehr geringem Sommerniederschlag folgt nur in einem von 6 Ereignissen ein Winterniederschlag, der wenigstens den Mittelwert Sommer+Winter erreicht.

Nun eine Wiederholung mit erleichterten Bedingungen (ohne Bild):

– Der folgende Winterniederschlag muss nur noch wenigstens 90 % vom Mittelwert erreichen.

– Das Testergebnis zeigt mit zwei positiven von insgesamt 6 Ereignissen immer noch ein stark negatives Ergebnis

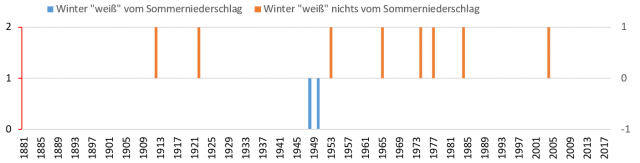

Test B

Das gleiche mit nochmals erleichterten Bedingungen:

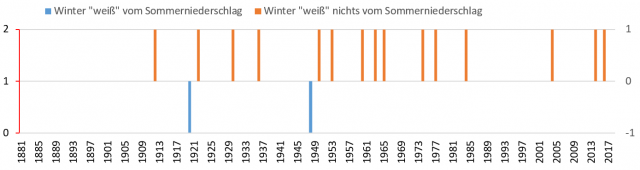

– Der Sommerniederschlag erreicht maximal 76 % von seinem Mittelwert. Ein „Wintergedächtnis“ wird angenommen, wenn der folgende Winterniederschlag wieder mindestens den Mittelwert Sommer+Winter erreicht.

Bild 11 Ergebnis Test B. Blau: Der Winterniederschlag „weiß“ vom niedrigen Sommerniederschlag und ist relativ hoch (2 x), Braun: Der Sommerniederschlag war maximal 76 % von seinem Mittelwert, der folgende Winterniederschlag erreicht aber nicht mindestens den Mittelwert Sommer+Winter (8 x)

Die Auswertung von Test B zeigt wieder ein stark negatives Ergebnis. Nach geringem Sommerniederschlag folgt nur in zwei von 10 Ereignissen ein Winterniederschlag, der wenigstens den Mittelwert erreicht.

Nun mit nochmals erleichterten Bedingungen:

Test C

– Der Sommerniederschlag erreicht maximal 84 % von seinem Mittelwert. Ein „Wintergedächtnis“ wird wieder angenommen, wenn der folgende Winterniederschlag mindestens den Mittelwert Sommer+Winter erreicht.

Bild 12 Ergebnis Test C. Blau: Der Winterniederschlag „weiß“ vom Sommerniederschlag (2 x), Braun: Der Sommerniederschlag erreichte maximal 84 %, der folgende Winterniederschlag erreicht aber nicht mindestens den Mittelwert Sommer+Winter (15 x)

Wieder ist das Ergebnis negativ und zwar sehr drastisch.

Fazit:

In der wahren Natur „weiß“ der Winter in Deutschland nicht, wenn der Sommer wenig Niederschlag hatte.

Letzter Versuch, ob das PIK doch noch (irgendwo) Recht haben könnte

Vielleicht war die bisherige Sichtung zu engstirnig und die Angabe der PIK-Mitarbeiter bezogen auf die Jahreszeiten Sommer und Winter nur unpräzise. Als Laie denkt man ja nicht immer so wissend, wie Fachpersonen. Deshalb noch eine Sichtung unter der Einbeziehung von Frühling und Herbst.

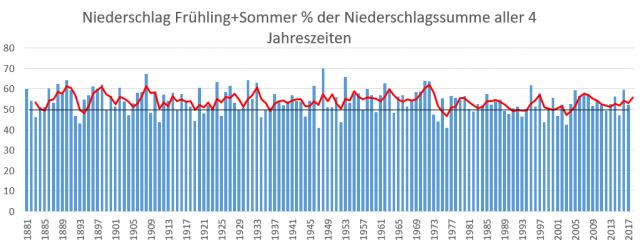

Zuerst wieder die Gesamtsicht auf das Niederschlagsverhältnis. Und wieder stellt man fest, dass die Sommerhälfte keinesfalls austrocknet und auch kein Trend dazu erkennbar ist. Wieder widersprechen die Messwerte den Simulationen!

Bild 13 Anteil des Niederschlags Frühling+Sommer zum Niederschlag aller 4 Jahreszeiten. Datenquelle: DWD, Grafik vom Autor erstellt

Test D:

Die Testannahmen:

– Die Niederschlagssumme von Frühling und Sommer erreichen maximal 68 % vom ihrem 30jahre Mittelwert.

– Ein „Herbst+Wintergedächtnis“ wird angenommen, wenn deren folgender Niederschlag mindestens den 30jahre-Mittelwert aller 4 Jahreszeiten erreicht.

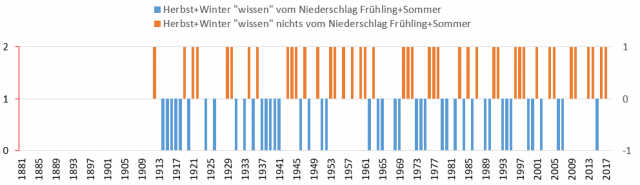

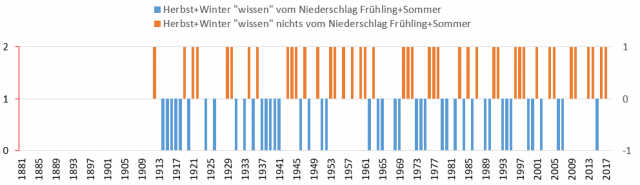

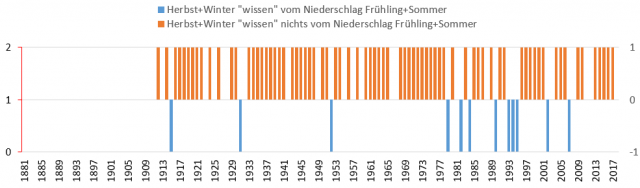

Testergebnis D:

– 44 mal positiv,

– 43 mal negativ

Ein positives Ergebnis ist zwar wesentlich häufiger geworden, bleibt statistisch aber ein reiner Zufall, da die Genauigkeit eines Würfelwurfs von 50 % nicht überschritten wird..

Bild 14 Ergebnis Test D. Blau: Der Summenniederschlag Herbst+Winter „weiß“ von der geringen Niederschlagssumme Frühling+Sommer (44 mal). Braun: Der Summenniederschlag Frühling+Sommer erreichte maximal 68 % vom 30jahre Mittelwert, der folgende Niederschlag Herbst+Winter reicht aber nicht über den 30jahre Mittelwert aller 4 Jahreszeiten (43 mal)

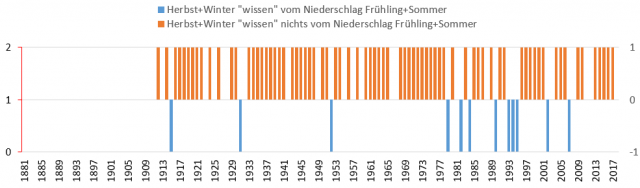

Viel schlechter wird das Ergebnis, wenn man den Anspruch geringfügig erhöht und beispielsweise für Herbst+Winter das 1,1fache fordert. Dann ist das Ergebnis nur noch 12 mal positiv, aber 75 mal negativ.

Bild 15 Ergebnis Test D. Blau: Der Summenniederschlag Herbst+Winter „weiß“ von der geringen Niederschlagssumme Frühling+Sommer (12 mal). Braun: Der Summenniederschlag Frühling+Herbst erreicht maximal68 % von seinem 30jahre Mittelwert, der folgende Niederschlag Herbst+Winter reicht aber nicht über das 1,1fache des 30jahre Mittelwertes aller 4 Jahreszeiten (43 mal)

Fazit

Nach diesen orientierenden Analysen muss man nicht nur anhand der vorhergehenden Meeres-Temperatur-Sichtungen, sondern ergänzend auch anhand der Ereignisauswertungen ganz stark bezweifeln, dass die Angabe von Herrn Hofmann und von Herrn Rahmstorf (beide PIK) über das „Niederschlags-Wintergedächtnis“ zutreffen.

So viel zu den schnellen Erklärungen von oft abgefragten „Standardexperten“, die zwar plausibel klingen, nur leider nicht den in der Natur gemessenen Vorgängen entsprechen.

Nun kann man zur Belegung des „Wintergedächtnisses“ noch viele andere und „wissenschaftlich fundiertere“ Kriterien ansetzen. Vielleicht macht es das PIK noch und belegt seine These wirklich anhand von Messergebnissen. Der Autor ist gespannt.

Man würde sich wünschen, dass die aktuell in Deutschland medial in allen Medien hochgehypten, klimademonstrierenden Schüler*innen – welche teils sogar von ihren Schulen dazu animiert werden – statt stolz darauf zu sein, auf Wissen zu verzichten, angeleitet würden, sich erst einmal das fehlende anzueignen, um nicht jeder Agitation blind hinterherzulaufen.

In dem Fall hätten die Schüler*innen – und deren agitativen Vorbilder – aus der Geschichte wirklich etwas gelernt.

Quellen

[1] Hannoversche Allgemeine 08.01.2019: Schneechaos: „Das habe ich in 38 Jahren nicht erlebt“

[2] EIKE 18.04.2018: Beeinflussungen durch Starkregen nehmen in Deutschland nicht zu. Mit schlecht angewandter Statistik lässt sich aber das Gegenteil „zeigen“ (Teil 2)

[3] EIKE 18.04.2018: Beeinflussungen durch Starkregen nehmen in Deutschland nicht zu. Mit schlecht angewandter Statistik lässt sich aber das Gegenteil „zeigen“ (Teil 1)

[4] ScienceScepticalBlog, 16. Januar 2019: Stefan Rahmstorf: Die Nordsee war um 1-2°C wegen des Klimawandels zu warm, deshalb brachten Nordwinde Schneerekorde!

[5] EIKE 30.12.2017: Ohne den Klimawandel hätte das gleiche Wetter nicht so schlimme Folgen…

[6] EIKE 07.08.2017: Meerespegelanstieg: Europa kann nicht alle (vor Klimawandel-Desinformation) schützen T1 (2)