Hintergrund bzgl. Meereis:

Sommerliches Eis-Minimum 2018 (Quelle: NSIDC):

Winterliches Meereis-Maximum 2019:

Meereis am 7. Juli 2019: Ausdehnung im Frühsommer:

Trotz der Tatsache, dass im Jahre 2019 die zweitgeringste Ausdehnung im Juni seit 1979 verzeichnet wurde (hier), gab es Anfang Juli immer noch genügend Eis in allen Eisbären-Gebieten der Arktis (hier). In vielen Gebieten kommen Eisbärinnen, die im Dezember ihre Jungen geboren haben, im Sommer auf das Festland, bis ihre Jungen alt genug sind, um im folgenden Frühjahr wieder auf das Eis zurückzukehren. Mehr dazu: Andersen et al. 2012; Ferguson et al. 2000; Garner et al. 1994; Jonkel et al. 1978; Harington 1968; Kochnev 2018; Kolenosky and Prevett 1983; Larsen 1985; Olson et al. 2017; Richardson et al. 2005; Stirling and Andriashek 1992.

Zehn Irrtümer und Falschinformationen über Meereis:

1. Meereis ist für die Arktis das, was Erde für einen Wald ist (hier). Falsch: Diese Alles-oder-nichts-Analogie ist ein trügerischer Vergleich. Tatsächlich gleicht das arktische Meereis einem großen See in einem Feuchtgebiet, welcher jeden Sommer etwas austrocknet. Damit wird die Größe des Habitats zum Erhalt von Wasserpflanzen, Amphibien und Insekten etwas verkleinert, ohne aber vollständig zu verschwinden. Lebewesen in diesen Feuchtgebieten sind an dieses Habitat angepasst: Sie sind in der Lage, das reduzierte Wasserangebot in der trockenen Jahreszeit zu überleben, weil es in jedem Jahr auftritt. Genauso wird sich auch immer Meereis im Winter neu bilden und bis zum Frühjahr erhalten bleiben. Während der etwa 2 Millionen Jahre, in denen sich Meereis in der Arktis bildet, gab es immer Eis im Winter und Frühjahr (sogar in noch wärmeren Interglazialen als heute). Außerdem weiß ich nichts von auch nur einem einzigen Klimamodell, welches prophezeit, dass sich während der nächsten 80 jahre oder so kein neues Wintereis bildet. Mehr dazu hier: Amstrup et al. 2007; Durner et al. 2009; Gibbard et al. 2007; Polak et al. 2010; Stroeve et al. 2007.

2. Eisbären brauchen sommerliches Meereis um zu überleben (hier). Falsch: Eisbären, die im Vorfrühling ausreichend Nahrung in Gestalt junger Seelöwen zu sich genommen haben, können von ihrem Fett fünf Monate oder länger zehren (hier) bis zum Herbst, egal ob sie den Sommer auf dem Festland oder im arktischen Packeis verbringen. Eisbären fangen nur sehr selten Seelöwen im Sommer (hier), weil nur erwachsene Seelöwen mit viel Erfahrung, Raubtieren auszuweichen, vorhanden sind. Außerdem bieten die vielen Löcher im sommerlichen Packeis den Seelöwen viele Fluchtmöglichkeiten (siehe BBC-Video unten). Eisbären und die Seelöwen der Arktis brauchen das Eis nur vom Spätherbst bis zum Vorfrühling (hier). Mehr dazu: Crockford 2017, 2019; Hammill and Smith 1991:132; Obbard et al. 2016; Pilfold et al. 2016; Stirling 1974; Stirling and Øritsland 1995; Whiteman et al. 2015.

3. Eis-Algen sind die Grundlage allen Lebens in der Arktis (hier). Nur teilweise richtig: Plankton gedeiht während des arktischen Sommers auch im offenen Wasser und bildet dort die Nahrungsgrundlage für die Fisch-Spezies, von denen Ringel- und Bartrobben abhängig sind, um sich für den langen arktischen Winter ausreichend Fettreserven anzufressen. Jüngere Forschungen haben nachgewiesen, dass weniger Eis im Sommer Gesundheit und Überlebenschancen von Ringel- und Bartrobben verbessert hat (hier) im Vergleich zu den Bedingungen während der achtziger Jahre (mit einer kürzeren eisfreien Saison und weniger Fischen als Nahrungsgrundlage): Als Folge davon waren üppige Robben-Bestände ein Segen für die Eisbären, sind diese doch von den Robben als Nahrung im Vorfrühling abhängig. Zum Beispiel prosperieren Eisbären in der Barents-See um Spitzbergen (hier), ebenso wie die Eisbären der Tschuktschen-See – und das trotz eines ausgeprägten Rückgangs des sommerlichen Eises in der Arktis. Beides steht im Widerspruch zu Prophezeiungen aus dem Jahr 2007, was dazu führte, die Eisbären als ,gefährdet‘ einzustufen. Mehr dazu: Aars 2018; Aars et al. 2017; Amstrup et al. 2007; Arrigo and van Dijken 2015; Crawford and Quadenbush 2013; Crawford et al. 2015; Crockford 2017, 2019; Frey et al. 2018; Kovacs et al. 2016; Lowry 2016; Regehr et al. 2018; Rode and Regehr 2010; Rode et al. 2013, 2014, 2015, 2018.

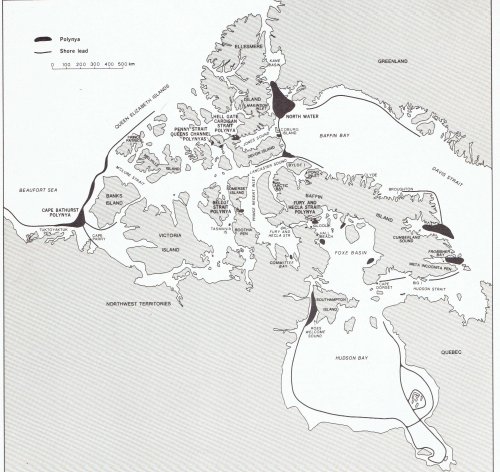

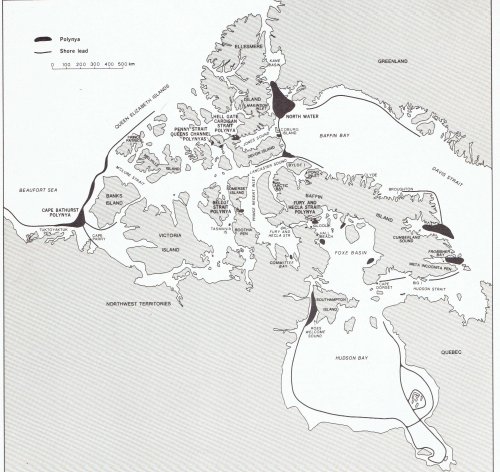

4. Offenes Wasser im Vorfrühling ist ebenso wie die sommerliche Eisschmelze seit 1979 unnatürlich und dem Überleben der Eisbären abträglich (hier). Falsch: Schmelzendes Eis ist eine ganz normale Phase jahreszeitlicher Änderungen in der Arktis. Im Winter und Frühjahr erscheinen ein paar Flächen offenen Wassers, weil Wind und Strömungen das Packeis umverteilen – das ist kein Abschmelzen, sondern die ziemlich normale Bildung von Polynyas* sowie deren Ausweitung. Polynyas sowie sich verbreiternde Streifen an Küsten (hier) sind eine vorteilhafte Mischung von Eis-Plattformen und offenem Wasser mit reichlich Nährstoffen (hier). Dies zieht die Robben der Arktis an und bietet exzellente Jagdmöglichkeiten für Eisbären. Die folgende Karte zeigt kanadische Polynyas und küstennahe Streifen offenen Wassers während der siebziger Jahre. Ähnliche Flächen offenen Wassers bilden sich im Frühjahr regelmäßig vor der Küste Ostgrönlands und entlang der russischen Küsten des arktischen Ozeans (hier). Mehr dazu: Dunbar 1981; Grenfell and Maykut 1977; Hare and Montgomery 1949; Smith and Rigby 1981; Stirling and Cleator 1981; Stirling et al. 1981, 1993.

[*Polynyas = Als Polynja (auch Polynya, Polynia) bezeichnet man eine große offene Wasserfläche oder dünne Meereisschicht im arktischen oder antarktischen Meereis, die eine Fläche von mehreren Tausend Quadratkilometern erreichen kann. Quelle]

Periodisch auftretende Polynyas und offene Wasserflächen während der 70-ger Jahre. Nach Smith and Rigby 1981.

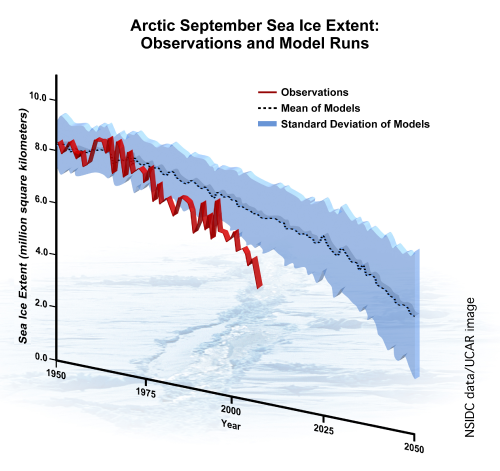

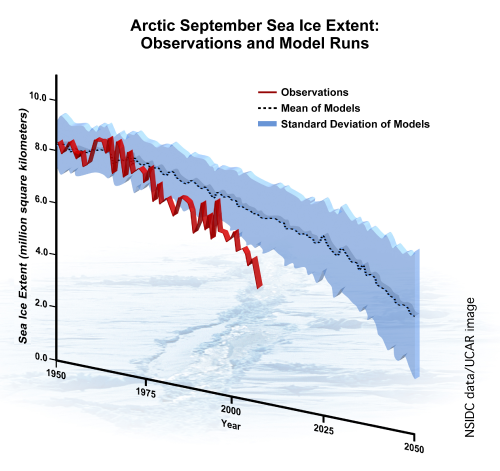

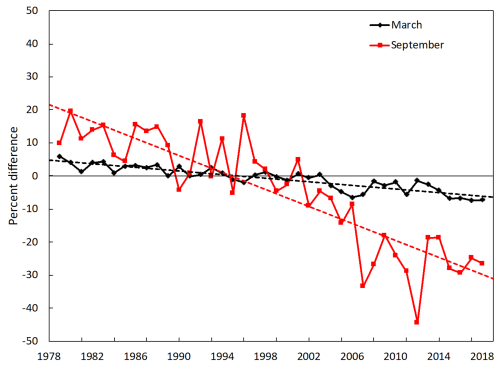

5. Klimamodelle sind für Prognosen von Eisbär-Habitaten gut geeignet (hier). Falsch: In meinem jüngsten Buch The Polar Bear Catastrophe That Never Happened erkläre ich, dass der Rückgang sommerlichen Meereises um fast 50%, der nicht vor dem Jahr 2050 erwartet worden war, bereits 2007 aufgetreten und seitdem konstant geblieben ist (und trotzdem gedeihen die Eisbären). Das ist eine außerordentlich schlechte Leistung der Vorhersage von Meereis. Außerdem hat erstjähriges Eis bereits eine Menge vieljährigen Eises in den südlichen und östlichen Gebieten des kanadischen Arktis-Archipels ersetzt (hier) – zum Vorteil der Eisbären. Mehr dazu: ACIA 2005; Crockford 2017, 2019; Durner et al. 2009; Hamilton et al. 2014; Heide-Jorgensen et al. 2012; Perovich et al. 2018; Stern and Laidre 2016; Stroeve et al. 2007; SWG 2016; Wang and Overland 2012.

Vereinfachte Prophezeiungen im Vergleich zu Beobachtungen bis zum Jahr 2007 (nach Stroeve et al. 2007). Im Jahre 2012 war das Meereis sogar noch geringer ausgedehnt und lag in allen Folgejahren unter dem prophezeiten Niveau.

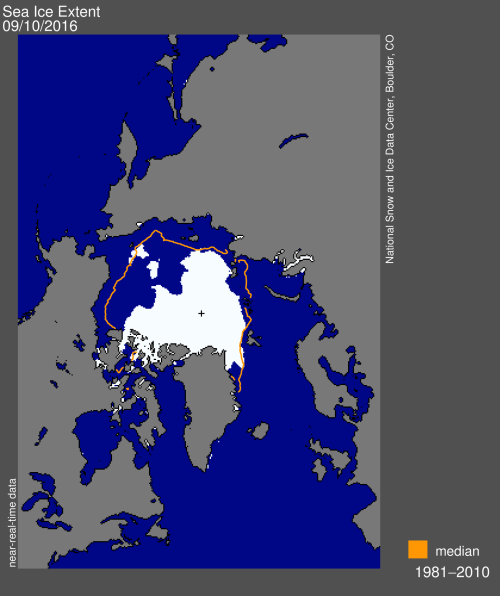

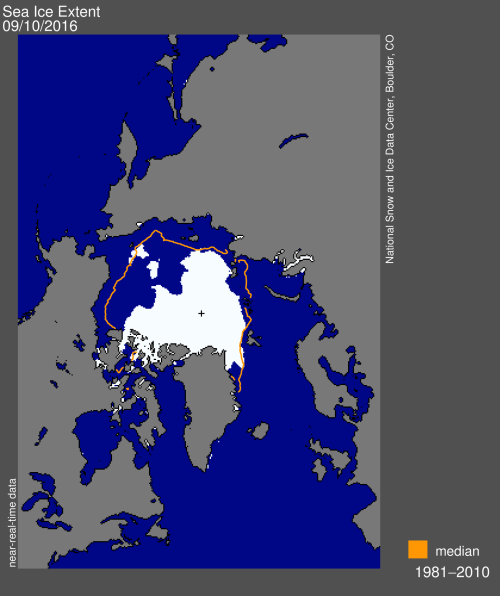

6. Das Meereis wird immer dünner, was für die Eisbären ein Problem ist (hier). Falsch: Einjähriges Eis (weniger als 2 Meter dick) ist das beste Habitat für Eisbären, weil es auch das beste Habitat für die Robben ist. Sehr dickes vieljähriges Eis, welches durch erstjähriges Eis ersetzt worden ist und das in jedem Sommer vollständig abtaut, bietet noch bessere Lebensbedingungen für Robben und Eisbären im Frühjahr, wenn beide es am dringendsten brauchen. Dies ging besonders in den südlichen und östlichen Gebieten des kanadischen arktischen Archipels vor sich (Karte der Meereis-Verteilung im September 2016 unten). Infolge derartiger Änderungen der Eisdicke hat sich die Eisbär-Population im Kane-Becken vor Nordwest-Grönland seit Ende der neunziger Jahre mehr als verdoppelt. Mehr dazu: Atwood et al. 2016; Durner et al. 2009; Lang et al. 2017; Stirling et al. 1993; SWG 2016.

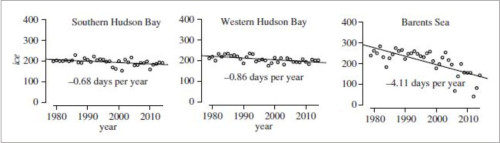

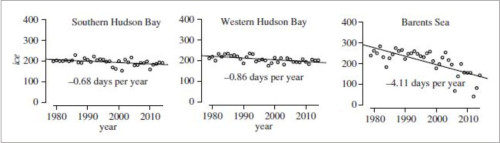

7. Eisbären in der westlichen und südlichen Hudson-Bay haben das größte Risiko, infolge der globalen Erwärmung auszusterben (hier). Falsch: Der Eisrückgang in der Hudson Bay war in der gesamten Arktis der Geringste. Die Meereis-Abnahme in der Hudson Bay (siehe die Graphiken unten) erfolgte an weniger als einem Tag pro Jahr seit 1979 im Vergleich zu über 4 Tagen pro Jahr in der Barents-See (hier). Außerdem war es zu dem Rückgang in der Hudson Bay einmalig als plötzlicher Sprung im Jahre 1998 gekommen: es gab keinen langsamen und stetigen Rückgang. Seit dem Jahr 1998 ist die eisfreie Saison in der westlichen Hudson-Bay insgesamt etwa drei Wochen länger als es während der achtziger Jahre der Fall war. Während der letzten 20 Jahre jedoch gab es keine darüber hinaus gehende Verlängerung (hier) trotz der Abnahme des arktischen Meereises insgesamt und trotz gestiegener Kohlendioxid-Emissionen (hier). Mehr dazu: Castro de la Guardia et al. 2017; Regehr et al. 2016.

Verlust sommerlichen Meereises pro Jahr von 1979 bis 2014. Nach Regehr et al. 2016

8. Das Aufbrechen von Meereis in der westlichen Hudson Bay erfolgt jetzt drei Wochen früher als während der achtziger Jahre (hier). Falsch: Das Aufbrechen erfolgt jetzt 2 Wochen früher im Sommer als während der achtziger Jahre. Die Gesamtlänge der eisfreien Saison ist jetzt etwa 3 Wochen länger (mit sehr großer Variation von Jahr zu Jahr). Mehr dazu: Castro de la Guardia et al. 2017; Cherry et al. 2013; Lunn et al. 2016 sowie im folgenden Video. Dieses zeigt den ersten entdeckten Bär außerhalb des Eises in Cape Churchill, westliche Hudson Bay am 5. juli 2019 – fett und gesund nach guter Ernährung im Frühjahr:

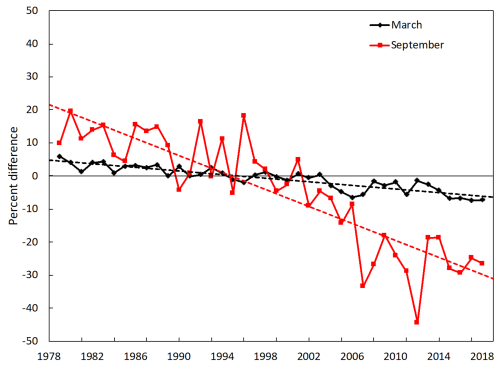

9. Winterliches Meereis hat seit 1979 abgenommen, was das Überleben der Eisbären gefährdet (hier). Nur teilweise richtig: Während das winterliche Meereis (März) graduell seit 1979 abgenommen hat (siehe die Graphik der NOAA unten), gibt es keine Hinweise darauf, dass dies negative Auswirkungen auf Gesundheit und Überleben der Eisbären hat, war doch der Rückgang ziemlich minimal. Die Graphik mit der Meereis-Verteilung zu Beginn dieses Beitrags zeigt, dass im Jahre 2019 immer noch sehr viel Eis vorhanden war – mehr als genug, um den Bedürfnissen der Eisbären und deren primärer Beute (Ringel- und Bartrobben) zu genügen. Und das, obwohl die Ausdehnung die siebt-niedrigste war seit 1979.

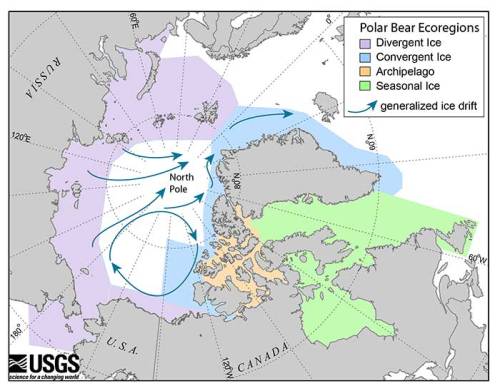

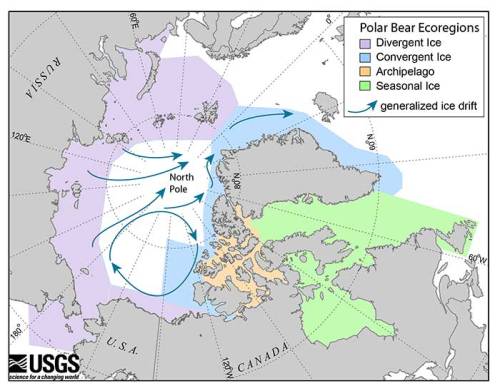

10. Experten sagen, dass es mit 19 verschiedenen Unter-Populationen von Eisbären in der Arktis 19 Szenarien bzgl. des Meereises gibt (hier und hier), was impliziert, dass dies genau das ist, was sie die ganze Zeit prophezeit hatten. Falsch: Um das zukünftige Überleben von Eisbären vorherzusagen, ordneten Biologen des US Geological Survey im Jahre 2007 Eisbär-Untergruppen verschiedenen Meereis-Arten zu (was sie dann ,Eisbär-Ökoregionen‘ nannten; siehe folgende Graphik). Ihre Prognosen bzgl. Überleben der Eisbären basierten auf Vermutungen, wie sich die Eisverhältnisse in diesen vier Meereis-Gebieten mit der Zeit verändern würden (wobei violett und grün gefärbte Gebiete gleichermaßen extrem verwundbar sind durch die Auswirkungen des Klimawandels). Allerdings zeigt sich, dass die Variationen viel größer sind als erwartet: Im Gegensatz zu den Prognosen gab es in der Barents-See einen viel stärkeren Rückgang sommerlichen Meereises als in jeder anderen Region. In der westlichen und südlichen Hudson Bay war der Rükgang relativ gering (siehe auch Punkt 7). Mehr dazu: Amstrup et al. 2007; Crockford 2017, 2019; Durner et al. 2009; Atwood et al. 2016; Regehr et al. 2016.

References

Aars, J. 2018. Population changes in polar bears: protected, but quickly losing habitat. Fram Forum Newsletter 2018. Fram Centre, Tromso. Download pdf here (32 mb).

Aars, J., Marques,T.A, Lone, K., Anderson, M., Wiig, Ø., Fløystad, I.M.B., Hagen, S.B. and Buckland, S.T. 2017. The number and distribution of polar bears in the western Barents Sea. Polar Research 36:1. 1374125. doi:10.1080/17518369.2017.1374125

ACIA 2005. Arctic Climate Impact Assessment: Scientific Report. Cambridge University Press. See their graphics package of sea ice projections here.

AMAP 2017. [ACIA 2005 update]. Snow, Water, Ice, and Permafrost in the Arctic Summary for Policy Makers (Second Impact Assessment). Arctic Monitoring and Assessment Programme, Oslo. pdf here.

Amstrup, S.C. 2003. Polar bear (Ursus maritimus). In Wild Mammals of North America, G.A. Feldhamer, B.C. Thompson and J.A. Chapman (eds), pg. 587-610. Johns Hopkins University Press, Baltimore.

Amstrup, S.C., Marcot, B.G. & Douglas, D.C. 2007. Forecasting the rangewide status of polar bears at selected times in the 21st century. US Geological Survey. Reston, VA. Pdf here

Andersen, M., Derocher, A.E., Wiig, Ø. and Aars, J. 2012. Polar bear (Ursus maritimus) maternity den distribution in Svalbard, Norway. Polar Biology 35:499-508.

Arrigo, K.R. and van Dijken, G.L. 2015. Continued increases in Arctic Ocean primary production. Progress in Oceanography 136: 60-70. http://dx.doi.org/10.1016/j.pocean.2015.05.002

Atwood, T.C., Marcot, B.G., Douglas, D.C., Amstrup, S.C., Rode, K.D., Durner, G.M. et al. 2016. Forecasting the relative influence of environmental and anthropogenic stressors on polar bears. Ecosphere 7(6): e01370.

Castro de la Guardia, L., Myers, P.G., Derocher, A.E., Lunn, N.J., Terwisscha van Scheltinga, A.D. 2017. Sea ice cycle in western Hudson Bay, Canada, from a polar bear perspective. Marine Ecology Progress Series 564: 225–233. http://www.int-res.com/abstracts/meps/v564/p225-233/

Cherry, S.G., Derocher, A.E., Thiemann, G.W., Lunn, N.J. 2013. Migration phenology and seasonal fidelity of an Arctic marine predator in relation to sea ice dynamics. Journal of Animal Ecology 82:912-921. http://onlinelibrary.wiley.com/doi/10.1111/1365-2656.12050/abstract

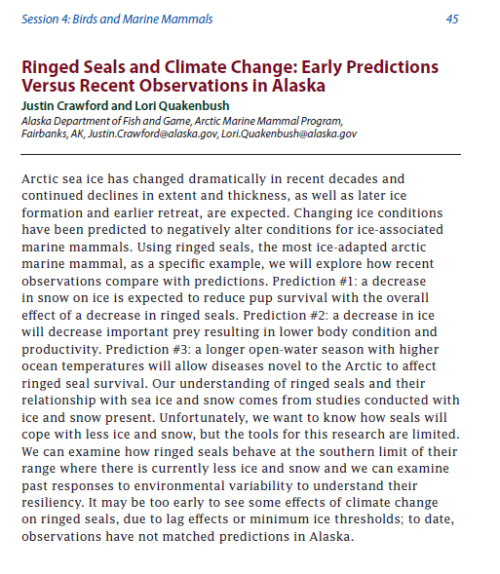

Crawford, J. and Quakenbush, L. 2013. Ringed seals and climate change: early predictions versus recent observations in Alaska. Oral presentation by Justin Crawfort, 28th Lowell Wakefield Fisheries Symposium, March 26-29. Anchorage, AK. Abstract below, find pdf here:http://seagrant.uaf.edu/conferences/2013/wakefield-arctic-ecosystems/program.php

Übersetzung der Tafel:

Ringelrobben und Klimawandel: Frühe Prognosen vs. jüngste Beobachtungen in Alaska.

Das arktische Meereis hat sich während der letzten Jahrzehnte dramatisch verändert und nimmt weiterhin an Ausdehnung und Dicke ab. Auch spätere Eisbildung und früherer Rückzug werden erwartet. Es wurde prophezeit, dass sich ändernde Eisverhältnisse die Lebensbedingungen für Meeressäugetiere mit Abhängigkeit von den Eisverhältnissen verschlechtern. Am Beispiel der Ringelrobben, den am meisten an das Eis angepassten Meeressäugern, werden wir erkunden, wie sich jüngste Beobachtungen im Vergleich zu den Prognosen machen. Prognose Nr. 1: Es wird erwartet, dass eine Abnahme des Schnees auf dem Eis das Überleben von Jungen reduziert mit der Folge einer insgesamten Abnahme der Ringelrobben. Prognose Nr. 2: Ein Eisrückgang wird wichtige Beutetiere abnehmen lassen mit der Folge einer schlechteren körperlichen Verfassung. Prognose Nr. 3: Eine längere Saison mit offenem Wasser und höheren Wassertemperaturen wird neue Krankheiten mit sich bringen, die das Überleben der Ringelrobben ebenfalls gefährden. Unser Verständnis des Verhältnisses von Ringelrobben zu Meereis und Schnee stammt von Studien mit den derzeitigen Schnee- und Eisverhältnissen. Unglücklicherweise wollen wir aber wissen, wie es den Robben mit weniger Eis und Schnee geht, aber die Möglichkeiten für diese Forschungen sind begrenzt. Wir können untersuchen, wie sich Ringelrobben verhalten am südlichen Ende ihres Verbreitungsgebietes, wo es gegenwärtig weniger Eis und Schnee gibt, und wir können die Reaktionen auf die umweltliche Variabilität in der Vergangenheit untersuchen. Um erste Auswirkungen des Klimawandels auf Ringelrobben zu erkennen, mag es noch zu früh sein. Bis heute jedenfalls passen die Beobachtungen in Alaska nicht zu den Prognosen.

Ende Übersetzung der Tafel

Crawford, J.A., Quakenbush, L.T. and Citta, J.J. 2015. A comparison of ringed and bearded seal diet, condition and productivity between historical (1975–1984) and recent (2003–2012) periods in the Alaskan Bering and Chukchi seas. Progress in Oceanography 136:133-150.

Crockford, S.J. 2017. Testing the hypothesis that routine sea ice coverage of 3-5 mkm2 results in a greater than 30% decline in population size of polar bears (Ursus maritimus). PeerJ Preprints 19 January 2017. Doi: 10.7287/peerj.preprints.2737v1 Open access. https://peerj.com/preprints/2737/

Crockford, S.J. 2019. The Polar Bear Catastrophe That Never Happened. Global Warming Policy Foundation, London. Available in paperback and ebook formats.

Derocher, A.E., Wiig, Ø., and Andersen, M. 2002. Diet composition of polar bears in Svalbard and the western Barents Sea. Polar Biology 25 (6): 448-452. http://link.springer.com/article/10.1007/s00300-002-0364-0

Dunbar, M.J. 1981. Physical causes and biological significance of polynyas and other open water in sea ice. In: Polynyas in the Canadian Arctic, Stirling, I. and Cleator, H. (eds), pg. 29-43. Canadian Wildlife Service, Occasional Paper No. 45. Ottawa.

Durner, G.M. and Amstrup, S.C. 1996. Mass and body-dimension relationships of polar bears in northern Alaska. Wildlife Society Bulletin 24(3):480-484.

Durner, G.M., Douglas, D.C., Nielson, R.M., Amstrup, S.C., McDonald, T.L., et al. 2009. Predicting 21st-century polar bear habitat distribution from global climate models. Ecology Monographs 79: 25–58.

Ferguson, S. H., Taylor, M. K., Rosing-Asvid, A., Born, E.W. and Messier, F. 2000. Relationships between denning of polar bears and conditions of sea ice. Journal of Mammalogy 81: 1118-1127.

Frey, K.E., Comiso, J.C., Cooper, L.W., Grebmeier, J.M., and Stock, L.V. 2018. Arctic Ocean primary productivity: the response of marine algae to climate warming and sea ice decline. NOAA Arctic Report Card: Update for 2018. https://arctic.noaa.gov/Report-Card/Report-Card-2018/ArtMID/7878/ArticleID/778/Arctic-Ocean-Primary-Productivity-The-Response-of-Marine-Algae-to-Climate-Warming-and-Sea-Ice-Decline

Garner, G.W., Belikov, S.E., Stishov, M.S., Barnes, V.G., and Arthur, S.M. 1994. Dispersal patterns of maternal polar bears from the denning concentration on Wrangel Island. International Conference on Bear Research and Management 9(1):401-410.

Gibbard, P. L., Boreham, S., Cohen, K. M. and Moscariello, A. 2005. Global chronostratigraphical correlation table for the last 2.7 million years, modified/updated 2007. Boreas 34(1) unpaginated and University of Cambridge, Cambridge Quaternary http://www.qpg.geog.cam.ac.uk/

Grenfell, T.C. and Maykut, G. A. 1977. The optical properties of ice and snow in the Arctic Basin. Journal of Glaciology 18 (80):445-463. http://www.ingentaconnect.com/contentone/igsoc/jog/1977/00000018/00000080/art00008

Hamilton, S.G., Castro de la Guardia, L., Derocher, A.E., Sahanatien, V., Tremblay, B. and Huard, D. 2014. Projected polar bear sea ice habitat in the Canadian Arctic Archipelago. PLoS One 9(11):e113746.

Hammill, M.O. and Smith T.G. 1991. The role of predation in the ecology of the ringed seal in Barrow Strait, Northwest Territories, Canada. Marine Mammal Science 7:123–135.

Hare, F.K. and Montgomery, M.R. 1949. Ice, Open Water, and Winter Climate in the Eastern Arctic of North America: Part II. Arctic 2(3):149-164. http://arctic.journalhosting.ucalgary.ca/arctic/index.php/arctic/article/view/3985 Pdf here.

[see also: Hare, F.K. and Montgomery, M.R. 1949. Ice, Open Water, and Winter Climate in the Eastern Arctic of North America: Part I. Arctic 2(2):79-89. http://arctic.journalhosting.ucalgary.ca/arctic/index.php/arctic/article/view/3976 ]

Harington, C. R. 1968. Denning habits of the polar bear (Ursus maritimus Phipps). Canadian Wildlife Service Report Series 5.

Heide-Jorgensen, M.P., Laidre, K.L., Quakenbush, L.T. and Citta, J.J. 2012. The Northwest Passage opens for bowhead whales. Biology Letters 8(2):270-273. doi:10.1098/rsbl.2011.0731

Jonkel, C., Land, E. and Redhead, R. 1978. The productivity of polar bears () in the southeastern Baffin Island area, Northwest Territories. Canadian Wildlife Service Progress Notes 91.

Kochnev, A.A. 2018. Distribution and abundance of polar bear (Ursus maritimus) dens in Chukotka (based on inquiries of representatives of native peoples). Biology Bulletin 45 (8):839-846.

Kolenosky, G.B. and Prevett, J.P. 1983. Productivity and maternity denning of polar bears in Ontario. Bears: Their Biology and Management 5:238-245.

Kovacs, K.M. 2016. Erignathus barbatus. The IUCN Red List of Threatened Species 2016: e.T8010A45225428. http://www.iucnredlist.org/details/full/8010/0

Lang, A., Yang, S. and Kaas, E. 2017. Sea ice thickness and recent Arctic warming Geophysical Research Letters. DOI: 10.1002/2016GL071274

Larsen, T. 1985. Polar bear denning and cub production in Svalbard, Norway. Journal of Wildlife Management 49:320-326.

Lowry, L. 2016. Pusa hispida. The IUCN Red List of Threatened Species 2016: e.T41672A45231341. http://www.iucnredlist.org/details/41672/0

Lunn, N.J., Servanty, S., Regehr, E.V., Converse, S.J., Richardson, E. and Stirling, I. 2016. Demography of an apex predator at the edge of its range – impacts of changing sea ice on polar bears in Hudson Bay. Ecological Applications 26(5):1302-1320. DOI: 10.1890/15-1256

Morrison, A. and Kay, J. 2014. “Short-term Sea Ice Gains Don’t Eliminate Long-term Threats.” Polar Bears International, “Scientists & Explorers Blog” posted 22 September 2014. https://web.archive.org/web/20150509003221/http://www.polarbearsinternational.org/news-room/scientists-and-explorers-blog/short-term-sea-ice-gains-dont-eliminate-long-term-threats

Obbard, M.E., Cattet, M.R.I., Howe, E.J., Middel, K.R., Newton, E.J., Kolenosky, G.B., Abraham, K.F. and Greenwood, C.J. 2016. Trends in body condition in polar bears (Ursus maritimus) from the Southern Hudson Bay subpopulation in relation to changes in sea ice. Arctic Science 2:15-32. 10.1139/AS-2015-0027 http://www.nrcresearchpress.com/doi/abs/10.1139/AS-2015-0027#.VvFtlXpUq50

Overland, J.E. and Wang, M. 2013. When will the summer Arctic be nearly sea ice free? Geophysical Research Letters 40: 2097-2101.

Perovich, D., Meier, W., Tschudi, M.,Farrell, S., Hendricks, S., Gerland, S., Haas, C., Krumpen, T., Polashenski, C., Ricker, R. and Webster, M. 2018. Sea ice. Arctic Report Card 2018, NOAA. https://www.arctic.noaa.gov/Report-Card/Report-Card-2018

Pilfold, N. W., Derocher, A. E., Stirling, I. and Richardson, E. 2015 in press. Multi-temporal factors influence predation for polar bears in a changing climate. Oikos. http://onlinelibrary.wiley.com/doi/10.1111/oik.02000/abstract

Polyak, L., Alley, R.B., Andrews, J.T., Brigham-Grette, J., Cronin, T.M., Darby, D.A., Dyke, A.S., Fitzpatrick, J.J., Funder, S., Holland, M., Jennings, A.E., Miller, G.H., O’Regan, M., Savelle, J., Serreze, M., St. John, K., White, J.W.C. and Wolff, E. 2010. History of sea ice in the Arctic. Quaternary Science Reviews 29:1757-1778.

Regehr, E.V., Laidre, K.L, Akçakaya, H.R., Amstrup, S.C., Atwood, T.C., Lunn, N.J., Obbard, M., Stern, H., Thiemann, G.W., & Wiig, Ø. 2016. Conservation status of polar bears (Ursus maritimus) in relation to projected sea-ice declines. Biology Letters 12: 20160556. http://rsbl.royalsocietypublishing.org/content/12/12/20160556 Supplementary data here.

Regehr, E.V., Hostetter, N.J., Wilson, R.R., Rode, K.D., St. Martin, M., Converse, S.J. 2018. Integrated population modeling provides the first empirical estimates of vital rates and abundance for polar bears in the Chukchi Sea. Scientific Reports 8 (1) DOI: 10.1038/s41598-018-34824-7 https://www.nature.com/articles/s41598-018-34824-7

Richardson, E., Stirling, I. and Hik, D.S. 2005. Polar bear (Ursus maritimus) maternity denning habitat in western Hudson Bay: a bottoms-up approach to resource selection functions. Canadian Journal of Zoology 83: 860-870.

Rode, K. and Regehr, E.V. 2010. Polar bear research in the Chukchi and Bering Seas: A synopsis of 2010 field work. Unpublished report to the US Fish and Wildlife Service, Department of the Interior, Anchorage. pdf here.

Rode, K.D., Douglas, D., Durner, G., Derocher, A.E., Thiemann, G.W., and Budge, S. 2013. Variation in the response of an Arctic top predator experiencing habitat loss: feeding and reproductive ecology of two polar bear populations. Oral presentation by Karyn Rode, 28th Lowell Wakefield Fisheries Symposium, March 26-29. Anchorage, AK.

Rode, K.D., Regehr, E.V., Douglas, D., Durner, G., Derocher, A.E., Thiemann, G.W., and Budge, S. 2014. Variation in the response of an Arctic top predator experiencing habitat loss: feeding and reproductive ecology of two polar bear populations. Global Change Biology 20(1):76-88. http://onlinelibrary.wiley.com/doi/10.1111/gcb.12339/abstract

Rode, K. D., R. R. Wilson, D. C. Douglas, V. Muhlenbruch, T.C. Atwood, E. V. Regehr, E.S. Richardson, N.W. Pilfold, A.E. Derocher, G.M Durner, I. Stirling, S.C. Amstrup, M. S. Martin, A.M. Pagano, and K. Simac. 2018. Spring fasting behavior in a marine apex predator provides an index of ecosystem productivity. Global Change Biology http://onlinelibrary.wiley.com/doi/10.1111/gcb.13933/full

Rode, K.D., Wilson, R.R., Regehr, E.V., St. Martin, M., Douglas, D.C. & Olson, J. 2015. Increased land use by Chukchi Sea polar bears in relation to changing sea ice conditions. PLoS One 10 e0142213.

Smith, M. and Rigby, B. 1981. Distribution of polynyas in the Canadian Arctic. In: Polynyas in the Canadian Arctic, Stirling, I. and Cleator, H. (eds), pg. 7-28. Canadian Wildlife Service, Occasional Paper No. 45. Ottawa.

Stern, H.L. and Laidre, K.L. 2016. Sea-ice indicators of polar bear habitat. Cryosphere 10: 2027-2041.

Stirling, I. 1974. Midsummer observations on the behavior of wild polar bears (Ursus maritimus). Canadian Journal of Zoology 52: 1191-1198. http://www.nrcresearchpress.com/doi/abs/10.1139/z74-157#.VR2zaOFmwS4

Stirling, I. 2002. Polar bears and seals in the eastern Beaufort Sea and Amundsen Gulf: a synthesis of population trends and ecological relationships over three decades. Arctic 55 (Suppl. 1):59-76. http://arctic.synergiesprairies.ca/arctic/index.php/arctic/issue/view/42

Stirling, I. and Andriashek, D. 1992. Terrestrial maternity denning of polar bears in the eastern Beaufort Sea area. Arctic 45:363-366.

Stirling, I., Andriashek, D., and Calvert, W. 1993. Habitat preferences of polar bears in the western Canadian Arctic in late winter and spring. Polar Record 29:13-24. http://tinyurl.com/qxt33wj

Stirling, I., Calvert, W., and Andriashek, D. 1984. Polar bear ecology and environmental considerations in the Canadian High Arctic. Pg. 201-222. In Olson, R., Geddes, F. and Hastings, R. (eds.). Northern Ecology and Resource Management. University of Alberta Press, Edmonton.

Stirling, I. and Cleator, H. (eds). 1981. Polynyas in the Canadian Arctic. Canadian Wildlife Service, Occasional Paper No. 45. Ottawa.

Stirling, I, Cleator, H. and Smith, T.G. 1981. Marine mammals. In: Polynyas in the Canadian Arctic, Stirling, I. and Cleator, H. (eds), pg. 45-58. Canadian Wildlife Service Occasional Paper No. 45. Ottawa. Pdf of pertinent excerpts from the Stirling and Cleator volume here.

Stirling, I, Kingsley, M. and Calvert, W. 1982. The distribution and abundance of seals in the eastern Beaufort Sea, 1974–79. Canadian Wildlife Service Occasional Paper 47. Edmonton.

Stirling, I. and Derocher, A.E. 2012. Effects of climate warming on polar bears: a review of the evidence. Global Change Biology 18:2694-2706 http://onlinelibrary.wiley.com/doi/10.1111/j.1365-2486.2012.02753.x/abstract

Stirling, I. and Øritsland, N. A. 1995. Relationships between estimates of ringed seal (Phoca hispida) and polar bear (Ursus maritimus) populations in the Canadian Arctic. Canadian Journal of Fisheries and Aquatic Sciences 52: 2594 – 2612. http://www.nrcresearchpress.com/doi/abs/10.1139/f95-849#.VNep0y5v_gU

Stroeve, J., Holland, M.M., Meier, W., Scambos, T. and Serreze, M. 2007. Arctic sea ice decline: Faster than forecast. Geophysical Research Letters 34:L09501. https://agupubs.onlinelibrary.wiley.com/doi/10.1029/2007GL029703

SWG [Scientific Working Group to the Canada-Greenland Joint Commission on Polar Bear]. 2016. Re-Assessment of the Baffin Bay and Kane Basin Polar Bear Subpopulations: Final Report to the Canada-Greenland Joint Commission on Polar Bear. +636 pp. http://www.gov.nu.ca/documents-publications/349

Walsh, J.E., Fetterer, F., Stewart, J.S. and Chapman, W.L. 2017. A database for depicting Arctic sea ice variations back to 1850. Geographical Review 107(1):89-107. https://onlinelibrary.wiley.com/doi/abs/10.1111/j.1931-0846.2016.12195.x

Wang, M. and Overland, J. E. 2012. A sea ice free summer Arctic within 30 years: An update from CMIP5 models. Geophysical Research Letters 39: L18501. doi:10.1029/2012GL052868

Wang, M. and Overland, J.E. 2015. Projected future duration of the sea-ice-free season in the Alaskan Arctic. Progress in Oceanography 136:50-59.

Whiteman, J.P., Harlow, H.J., Durner, G.M., Anderson-Sprecher, R., Albeke, S.E., Regehr, E.V., Amstrup, S.C., and Ben-David, M. 2015. Summer declines in activity and body temperature offer polar bears limited energy savings. Science 349:295-298.

Link: https://wattsupwiththat.com/2019/07/15/10-fallacies-about-arctic-sea-ice-polar-bear-survival-teachers-parents-take-note/

Übersetzt von Chris Frey EIKE