AGW: Ein verworrenes Netz stranguliert seine Schöpfer und Befürworter

Die Herausgeber des Journals Nature haben das Journal ins Leben gerufen. Jenes Journal veröffentlichte alles, was es in die Finger bekam, um die betrügerische Wissenschaft zu verbreiten, welche die Grundlage der nicht überprüften AGW-Hypothese ist. Allerdings war man auch dort den Regeln und Verfahren unterworfen, welche für akademische Forschung und Veröffentlichungen verpflichtend waren. Das ist kein Problem, falls das Thema globale Erwärmung ein rein wissenschaftliches Thema wäre, aber das war es ja niemals. Es war von Anfang an eine politische Inanspruchnahme der Wissenschaft für eine politische Agenda. Der ursprüngliche Artikel stammte von einer Gruppe unter Leitung von Ben Santer, also von jemandem mit einer langen Historie inmitten des AGW-Betrugs.

Ein Artikel unter der Überschrift „Evidence that humans are responsible for global warming hits ‘gold standard’ certainty level“ gibt darüber Aufschluss, enthält aber auch den Kommentar von Santer, dass „das Narrativ, dass Wissenschaftler die Ursache des Klimawandels nicht kennen, falsch ist. Wir kennen die Ursache“. Es ist eine Fortsetzung seiner Arbeit, den Betrug immer weiterzutreiben. Er stellte seinen Kommentar auf die Grundlage, dass wir den Grund für Klimawandel kennen, und zwar aufgrund der Arbeit des IPCC. Dort betrachtete man ausschließlich menschliche Ursachen, und es ist unmöglich, das zu bestimmen, solange man den natürlichen Klimawandel nebst dessen Ursachen nicht kennt und versteht. Falls das der Fall wäre, wären Vorhersagen immer korrekt. Falls das der Fall wäre, bräuchte man Santer und all die anderen Forscher sowie Millionen Dollar nicht mehr

Warum also stellt Santer eine solche Behauptung auf? Aus dem gleichen Grunde wie alle Aktionen im AGW-Betrug: um einen Ansturm zu treiben, erzeugt durch die Dringlichkeit, die politische Agenda zu übernehmen. Es ist der klassische „Der Himmel fällt uns auf den Kopf“-Alarmismus. Santers Arbeit folgt dem jüngsten „Notfall“-Report des IPCC, welcher bei der COP 24 in Polen vorgestellt worden ist und dem zufolge uns noch 12 Jahre bleiben.

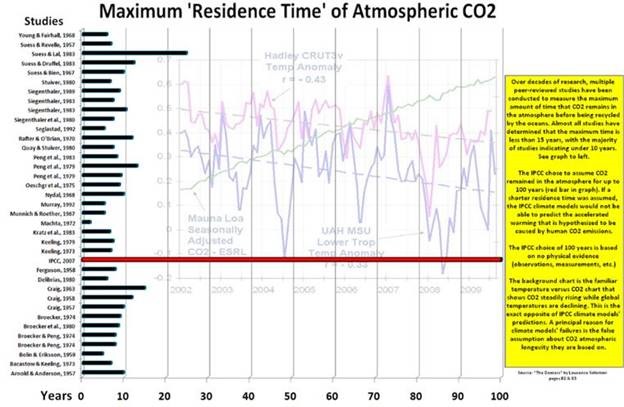

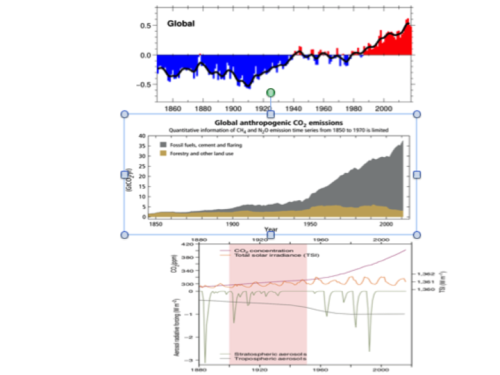

Eines der ersten Beispiele dieser Schöpfung einer ungenauen Wissenschaft zur verstärkten Betonung der Dringlichkeit war die Verweildauer von CO2 in der Atmosphäre. In einer Reaktion auf die Behauptung der Erfordernis dringender Maßnahmen haben viele Forscher darauf hingewiesen, dass das Niveau und die Steigerung desselben nicht hinreichend sei, um dringende Maßnahmen zu ergreifen. Mit anderen Worten, man lasse sich nicht vorschnell zu etwas hinreißen. Das IPCC reagierte darauf mit der Behauptung, dass selbst wenn jede Erzeugung von CO2 aufhören würde, das Problem noch Jahrzehnte lang bestehen würde wegen der Verweildauer von 100 Jahren von CO2 in der Atmosphäre. Aus einer von Lawrence Solomon erstellten Graphik geht jedoch hervor, dass die Verweildauer in Wirklichkeit 4 bis 6 Jahre betragen würde (Abbildung 1).

Dieses Muster der Betonung der Dringlichkeit durchzieht die gesamte Historie des AGW-Betrugs.

Lord Walter Scott sagte: „What a tangled web we weave when first we practice to deceive“ [etwa: „Was für ein verworrenes Netz wir weben, wenn wir zum ersten Mal Betrug praktizieren“]. Ein anderer großer Autor baute auf diesem Gedanken auf, jedoch aus einem anderen Blickwinkel. Mark Twain sagte: „Falls man die Wahrheit sagt, braucht man sich nicht zu erinnern“. In eigenartiger Weise widersprechen sie oder erklären zumindest, wie sich der Betrug ausbreiten, bestehen bleiben und sein verheerendes Ziel erreichen konnte. Das Netz wurde inzwischen so verworren und die Verbindungen der Netzfäden so kompliziert, dass die Menschen nie mehr sehen können, was passiert. Dies gilt besonders, wenn es bei dem Betrug um ein geheimnisvolles Thema geht, von dem die meisten Menschen gar nichts verstehen.

All diese Beobachtungen sind auf den größten Betrug aller Zeiten anwendbar, nämlich der Behauptung, dass menschlich erzeugtes CO2 globale Erwärmung verursacht. Das Ganze ist den meisten Menschen selbst heute noch unbekannt, und das ist ein Garant für den Erfolg des Betrugs. Das wirkliche Ziel war es zu beweisen, dass Überbevölkerung in Kombination mit industrieller Entwicklung die Ressourcen auf nicht nachhaltige Weise ausschöpfen würde. Maurice Strong erklärte, dass das Problem für den Planeten die industrialisierten Nationen sind, und warf die Frage auf, ob es nicht in unserer Verantwortung liege, diese loszuwerden. Die zugrundeliegende Hypothese war, dass CO2, ein Abfallprodukt bei der Verbrennung fossiler Treibstoffe, globae Erwärmung verursacht und die Erde zerstört. Sie mussten diese Verteufelung des CO2 unbedingt aufrecht erhalten, koste es, was es wolle, und hier beginnt das Weben des verworrenen Netzes.

Zu Beginn kontrollierten das IPCC und angeschlossene Agenturen die zwei maßgeblichen Variablen, nämlich Temperatur und CO2. Phil Jones verlieh dem Ausmaß der Kontrolle über die Temperatur Ausdruck in einer Antwort auf eine Anfrage von Warwick Hughes, welche Stationen herangezogen und wie diese in seiner Graphik adjustiert worden waren. Am 21. Februar 2005 erhielt er folgende Antwort:

„Wir haben rund 25 Jahre in die Arbeit investiert. Warum sollte ich Ihnen die Daten zur Verfügung stellen, wenn es doch Ihr Ziel ist herauszufinden, ob mit den Daten etwas nicht stimmt?“

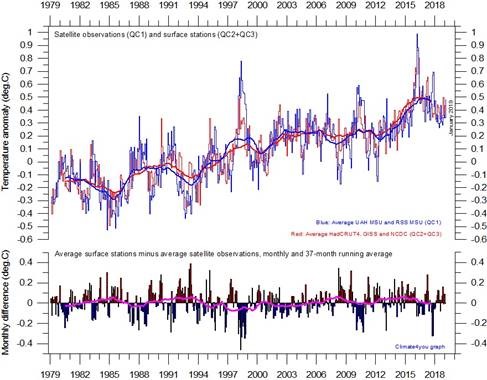

Die Kontrolle über die globalen Temperaturdaten setzte sich fort bis zum Eintreffen der ersten Satellitendaten im Jahre 1978. Trotz aller Limitierungen ergab sich damit eine viel vollständigere Abdeckung, nämlich etwa 97% bis 98%. Dies steht im Vergleich zu den etwa 15% Abdeckung von Oberflächen-Daten.

Unabhängig von der Abdeckung mussten die Oberflächen-Daten zu den Satellitendaten passen, wie Abbildung 2 zeigt:

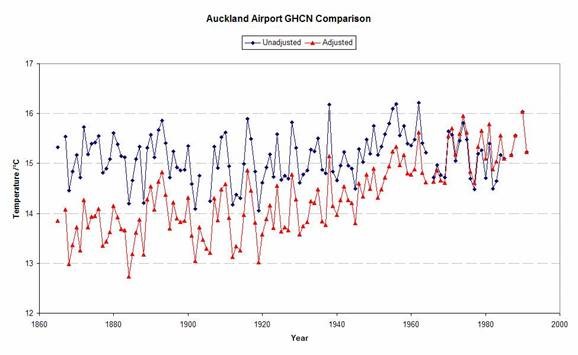

Dies verhinderte jedoch nur die Veränderung der letzten 41 Jahre der Aufzeichnung, nicht jedoch die Veränderung historischer Aufzeichnungen. Der Artikel von Dr. Marohasy ist lediglich eine weitere Illustration des Musters. Tony Heller führte die vollständigste Analyse der zugefügten Adjustierungen durch. Jene, welche die Veränderungen vorgenommen haben behaupten, wie sie es auch auf die Herausforderung von Marohasy getan haben, dass die Korrekturen notwendig und Instrumentenfehlern, Aufstellungsorten und Änderungen der Umgebung geschuldet waren wie etwa dem UHI-Effekt. Das Problem ist jedoch, dass diese Änderungen ausnahmslos nur in eine Richtung gingen, nämlich die historischen Aufzeichnungen niedriger darzustellen. Dies verändert den zeitlichen Gradienten der Temperaturänderung dahingehend, dass die Stärke und die Rate der Erwärmung verstärkt wird. Eines der ersten Beispiele derartiger Adjustierungen ist die Aufzeichnung von Auckland in Neuseeland (Abbildung 3). Man beachte die Überlappung während der letzten Jahrzehnte:

Das IPCC übte die Kontrolle auf die CO2-Aufzeichnungen von Anfang an aus, und das ist auch heute noch so. Sie ziehen die Aufzeichnung vom Mauna Loa heran sowie Daten von anderen Messpunkten mit ähnlicher Instrumentierung und Verfahren als Grundlage für ihre Behauptungen. Charles Keeling, einer der frühesten Befürworter von AGW, wurde von Roger Revelle entdeckt und an das Scripps-Institut berufen. Jawohl, das ist das gleiche Heiligtum, welches Al Gore in seinem Film An Inconvenient Truth glorifiziert hat. Keeling etablierte eine CO2-Messstation, welcher der Standard für das IPCC ist. Das Problem ist, dass der Mauna Loa ein Vulkan aus ozeanischer Kruste ist, dass die Lava nicht so zähflüssig und gasreicher ist als bei kontinentalen Vulkanen wie etwa dem Ätna. Eine Dokumentation mit dem Titel Future Frontiers: Mission Galapagos erinnerte mich an Studien vom Ätna vor Jahren, welche zeigten, wie sehr CO2 aus dem Boden stieg – Hunderte von Kilometern rund um den Krater. Die Dokumentation ist zwar der übliche „Die Menschen zerstören den Planeten“-Unsinn. Aber an einer Stelle tauchen sie in das Wasser rund um eine massive Vulkaninsel und waren erstaunt, wie deutlich sichtbar CO2 von überall aus dem Ozeangrund drang.

Charles Keeling ließ sich seine Instrumente und die angewendeten Verfahren patentieren. Sein Sohn Ralph setzte seine Arbeit am Scripps Institute fort und ist Mitglied im IPCC. Sein jüngster Auftritt in den Medien involvierte eine alarmistische Studie mit einem kapitalen Fehler – einer Überschätzung um 60%. Abbildung 4 zeigt ihn mit der PR-Meisterin des IPCC-Narrativs Naomi Oreskes:

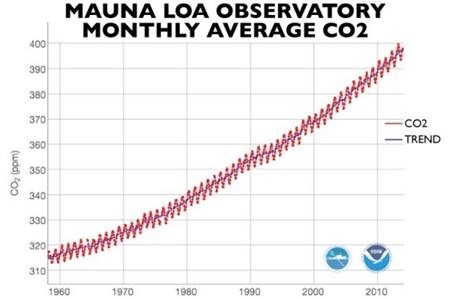

Abbildung 5 zeigt das gegenwärtige CO2-Niveau am Mauna Loa. Es zeigt sich eine stetige Zunahme seit 1958 mit der jahreszeitlichen Variation:

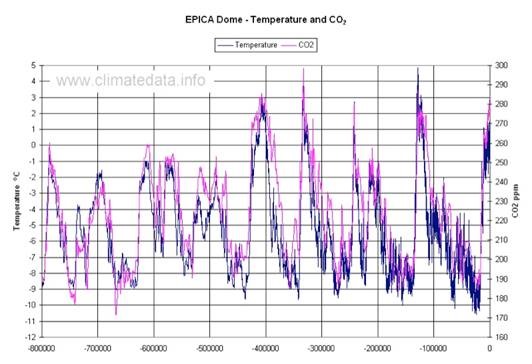

Diese Zunahme erfolgt kontinuierlich 41 Jahre lang, was bemerkenswert ist, wenn man längerfristigere Aufzeichnungen betrachtet. Zum Beispiel zeigt der Eisbohrkern aus der Antarktis eine bemerkenswerte Variabilität (Abbildung 6):

Die Eisbohrkern-Aufzeichnung stammt aus Bläschen, deren Entstehung mindestens 70 Jahre dauert. Dann wird ein geglättetes 70-Jahre-Mittel angebracht. Die Kombination entfernt den größten Teil der Variabilität, und das eliminiert jede Chance, das Ergebnis zu verstehen und einzuordnen.

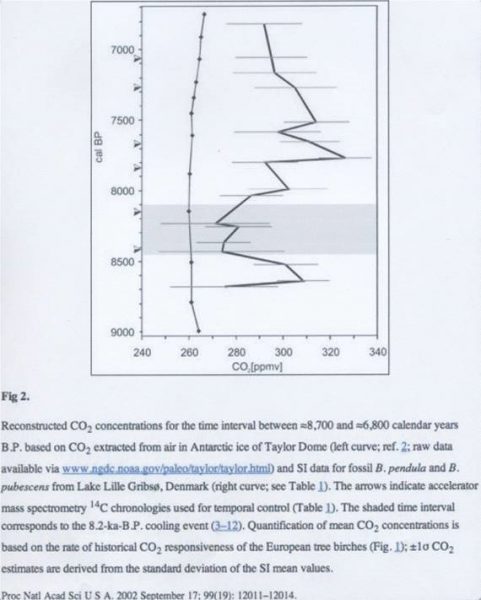

Abbildung 7 zeigt das Ausmaß der Glättung. Sie enthält einen Vergleich über 2000 Jahre Messungen von CO2 mittels zwei unterschiedlichen Messverfahren. Man erkennt den Unterschied in der Variabilität, aber auch den Unterschied des Gesamtniveaus in der Atmosphäre, der zwischen etwa 260 und 320 ppm schwankt:

Allerdings gibt es auch eine Aufzeichnung aus jüngerer Zeit, welche ähnliche Differenzen zeigt hinsichtlich Variation und Gesamtmenge (Abbildung 8). Daraus geht klar hervor, dass das IPCC die Aufzeichnung so geglättet hat, dass es die CO2-Aufzeichnung kontrolliert. Die gepunktete Linie zeigt die Eisbohrkern-Aufzeichnung aus der Antarktis und wie die Mauna-Loa-Kurve erzeugt worden war, um den geglätteten, aber ungenauen Verlauf fortzusetzen. Zbigniew Jaworowski, ein Atmosphären-Chemiker und Eisbohrkern-Spezialist erklärt, was mit den CO2-Messungen in Eisbohrkernen nicht stimmt. Sein entsprechender Artikel ist betitelt mit „CO2: The Greatest Scientific Scandal of Our Time“. Natürlich griff man ihn an, aber dennoch hielten die UN seine Qualifikationen und Fähigkeiten für so gut, dass sie ihn zum Leiter der Untersuchungsgruppe beriefen, welche die Tschernobyl-Katastrophe untersuchen sollte.

Überlagert ist in der Abbildung die Graphik von über 90.000 Atmosphären-Messungen von CO2, welche im Jahre 1812 begonnen hatten. Die Veröffentlichung des Sauerstoffniveaus in der Atmosphäre löste die Sammlung von CO2-Daten aus. Die Wissenschaft wollte den prozentualen Anteil aller Gase in der Atmosphäre erfassen. Man war nicht interessiert an globaler Erwärmung oder irgendwelcher anderen Auswirkungen jener Gase – man wollte einfach genaue Daten haben, was das IPCC niemals vorhatte.

[Anmerkung von Blogbetreiber Anthony Watts: Ich ordne der Arbeit von Ernst Georg Beck in Abbildung 8 keine Genauigkeit zu, weil das chemische Verfahren fehleranfällig ist und die Messpunkte der Datengewinnung (zumeist im Bodenniveau von Städten) hoch variable CO2-Gehalte aufweisen. Man beachte die hohe Variabilität der Daten. – Anthony Watts.

Bemerkung des Übersetzers dazu: Diese Graphik von E. G. Beck hat er selbst später als fehlerhaft im Sinne von zu lokal beurteilt. Anm. d. Übers.]

Man wusste um diese Aufzeichnungen schon vor Jahrzehnten. Es war der Eisenbahn-Ingenieur Guy Callendar, der diese Aufzeichnung in Zusammenarbeit mit bekannten Namen der wissenschaftlichen Gemeinschaft vorgestellt hatte. Ernst-Georg Beck schrieb dazu:

„Die moderne Treibhausgas-Hypothese basiert auf der Arbeit von G. S. Callendar und C. D. Keeling. Sie folgt S. Arrhenius, wie später vom IPCC popularisiert“.

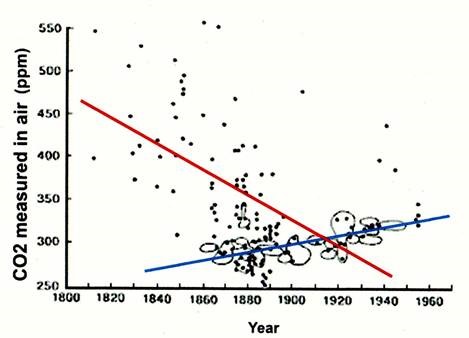

Callendar wählte willkürlich einen einheitlichen Datensatz aus, um zu behaupten, dass das mittlere Niveau bei 270 ppm lag. Er änderte die Steigung des Graphen von einer Zunahme in eine Abnahme (Abbildung 9). Jaworowski kreiste die von ihm gewählten Daten ein, aber ich habe die Trendlinien für alle Daten (rot) und Callendars Datenauswahl (blau) hinzugefügt:

Tom Wigley, Direktor der Climatic Research Unit (CRU) und einer der Väter von AGW, führte die Aufzeichnung 1983 in die Klima-Gemeinschaft ein, und zwar mit einem Beitrag in der Zeitschrift Climate Change mit dem Titel „The Pre-Industrial Carbon Dioxide Level“. Er behauptete auch, dass die Aufzeichnung ein vorindustrielles CO2-Niveau von 270 ppm ergeben. Man betrachte die Daten!

Das IPCC und dessen Unterstützer etablierten das vorindustrielle CO2-Niveau mittels Rosinenpickerei und Manipulation. Sie halten weiterhin den Finger auf die Angaben zum atmosphärischen Niveau mittels Kontrolle der Mauna Loa-Aufzeichnung, und sie kontrollieren die Daten der jährlichen menschlichen Erzeugung. Sie erklären das so:

„Das IPCC hat die Task Force on Inventories (TFI) ins Leben gerufen, um das National Greenhouse Gas Inventory Programme (NGGIP) zu betreiben, welches diese Verfahren entwickeln soll. Die Parteien im UNFCCC sind überein gekommen, die IPCC-Leitlinien anzuwenden bei der Berichterstattung vor der Konvention.

Wie entwickelt das IPCC seine inventarisierten Leitlinien? Ernannte Experten aus der ganzen Welt entwerfen die Berichte unter Anwendung der IPCC-Verfahren, die dann zweimal extensiv begutachtet werden, bevor sie vom IPCC genehmigt werden. Dieses Verfahren stellt sicher, dass die größtmögliche Bandbreite von Standpunkten in die Dokumente einfließt.

Mit anderen Worten, sie behalten sich die letztendliche Entscheidung vor, welche Daten für ihre Berichte und als Input für ihre Computermodelle verwendet werden.

Das hat alles lange Zeit funktioniert. Allerdings, wie es mit allen Betrügereien der Fall ist, enthüllt selbst das verworrenste Netz irgendwann seine wahre Natur. Sie fahren fort, dass atmosphärische CO2-Niveau zunehmen zu lassen und dieses dann der Welt vorzuführen als bestätigt durch die Messungen am Mauna Loa. Allerdings ist ihnen durch die Ankunft von Satellitenmessungen die Kontrolle über die jüngsten Temperaturdaten entglitten. Sie können die CO2-Daten jetzt nicht mehr niedriger machen, weil dies ihren gesamten Betrug offensichtlich machen würde, und sie sind dazu verdammt, alles, was noch übrig ist von ihrem Betrug und ihren Manipulationen zu verewigen. Alles, was ihnen blieb, ist u. A. die Abwärts-Korrektur historischer Aufzeichnungen, die Bezeichnung globale Erwärmung in Klimawandel zu ändern und immer schärfere Bedrohungs-Szenarien zu erzeugen wie etwa die genannten 12 Jahre bis zum von Santer prophezeiten sicheren Untergang.*

[*Ross McKittrick hat die entsprechende Studie von Santer in einem eigenen Beitrag widerlegt. Dieser folgt demnächst hier beim EIKE in deutscher Übersetzung. Anm. d. Übers.]

Übersetzt von Chris Frey EIKE