„Wenn der Klimawandel nicht gestoppt wird, liegen irgendwann alle Menschen tot auf dem Boden … „

Eine Demonstration der Unfähigkeit unserer „Eliten“

Immer mehr zeigt die von dem Kind aus Schweden – beziehungsweise ihren aktivistischen Einflüsterern – medial wirkungsvoll in Szene gesetzte Klimawandel-Demonstration, dass es jederzeit möglich ist, auch bei uns eine Massenbewegung zu initiieren, deren Basis aus Emotion, Wissen aus „Hörensagen“ und Abstinenz jeglichen Ansatzes von rationalem Denken besteht.

Wer erwartet hätte, dass wenigstens irgendwann eine Opposition entstehen würde, welche die Fragwürdigkeit deren Thesen erkennt und publiziert, wird inzwischen vollkommen enttäuscht. Im Gegenteil: Die Zustimmung wird anscheinend immer größer.

Als Folge lässt sich wieder ein soziologisches Lehrbeispiel erleben, wie es in einem angeblich rationalen, „wissensdurchtränktem“ Land jederzeit möglich ist, Massen mit rein plakativen Thesen zu beeinflussen, wenn der richtige Zeitpunkt getroffen wird – und dass Geschichte zwar gelernt, aber eben nicht durchdacht wird.

Wer sind „die Nackten“

Der Schriftsteller Christian Andersen hat im Jahr 1837 mit seinem „Lehrstück“, der Geschichte: „Des Kaisers neue Kleider“, unbewusst ein Grundlagenwerk der Massenpsychologie geschaffen.

Allerdings ist – wie praktisch immer beim Thema Klimawandel -, die Interpretation gegensätzlich.

Die Süddeutsche Zeitung – nach Bekenntnis eines ihrer ehemaligen Leitredakteure [10] bewusst als Propagandainstrument eingesetzt -, verortet „die Nackten“ bei der Politik.

Eine Barbara Vorsamer (Journalistin, M.A. Politikwissenschaft, Publizistik, Themenschwerpunkte: Familie, Feminismus, soziale Gerechtigkeit und Nachhaltigkeit), verortet bei der Aktion der Schüler die „Nackten“ bei der Politik:

SZ: „ … Es geht den Jugendlichen nicht darum, über den Klimawandel zu diskutieren. Sie wollen Veränderungen, sofort. … Greta Thunberg und ihr Gefolde sagen ganz deutlich: Ihr seid nackt. Wir streiken, bis ihr handelt ... „

und outet dabei genau das Problem: Es geht den streikenden Schülern nicht darum, mehr über den sogenannten, Menschen-gemachten Klimawandel wissen zu wollen, sondern alleine um die Umsetzung einer ihnen vorgegebenen Agenda, der sie geradezu blind folgen, ohne auch nur im Ansatz daran zu denken, was die Geschichte über solche blinde Gefolgsameit lehrt.

Im Gegensatz zur SZ, verortet der Autor „die Nackten“ deshalb weiterhin bei den streikenden Schülern.

Je länger die Aktion läuft, desto abstruser und weltfremder die Thesen. Doch niemandem will es auffallen

Belegen lässt sich dies inzwischen immer deutlicher anhand der Aktionen. Bei der letzten (die der Autor „mitbekam“), war es die Aussage: [3] „Wenn nichts passiert, lägen irgendann alle Menschen tot auf dem Boden … “.

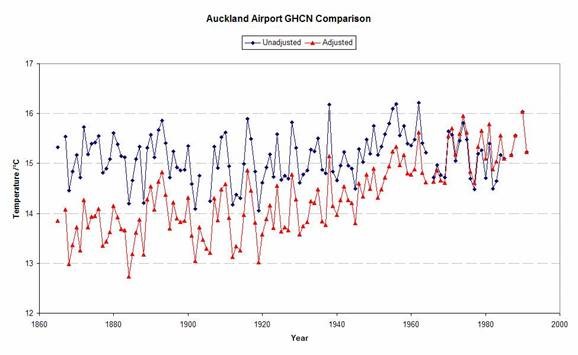

Bild 1 [3] Zeitungsfoto einer Schüler-Freitagsdemonstration in Nürnberg. Bildtext: „Wenn der Klimawandel nicht gestoppt wird, liegen irgendwann alle Menschen tot am Boden“. Nürnberger Schüler demonstrieren vor der Lorenzkirche drastisch die folgen der derzeitigen Politik. Anmerkung: um kein Copyright zu verletzen, wurde das Bild angegraut

Bild 2 Information über die Schülerstreiks zum Klimawandel einer Printausgabe der „nordbayerischen Nachrichten“ für Kinder. Fotoaussschnitt vom Autor

Selbstverständlich findet eine Redaktion auch wirkliche Fachleute zum Thema. In einer Printausgabe vom 04.03. durfte ein leibhaftiger Siemens-Ingenieur aus Erlangen – der den Freitagsstreik seiner Kinder natürlich voll unterstützt – sein Wissen darüber in der Zeitung berichten:

Lokale Printausgabe der „nordbayerischen Nachrichten“: Schule schwänzen ist ein absolut legitimes Mittel

„ … schon als ich ein Kind war, ist mir klargeworden, dass unser Einfluss auf das Klima drastisch ist und dass wir schnell etwas tun müssen. Damals dachte ich noch: Gefahr erkannt, Gefahr gebannt, aber Jahrzehnte später stelle ich fest, dass der negatitive Einfluss von uns auf das Klima immer größer und nicht kleiner wird …

Wie immer, erwartete die Redaktion dafür keinerlei Belege. Schließlich ist sie derselben Überzeugung. Dass der (laut Artikel 37-jährige) „Siemens-Ingenieur mit persönlicher Klimafolgenerfahrung“ seit seinem Kindesalter einen Klimawandeleinfluss rein altersbedingt gar nicht erlebt, geschweige durchlebt haben kann (da dafür nicht einmal 100 Jahre reichen), wen kümmert es, wenn sein persönliches „Klimaerlebnis“ alarmistisch ausfällt [18]. Es ist, als ob jemand Geschichte ausschließlich aus seinen persönlichen Erlebnissen verifiziert, die gesamte, vorgeburtliche Historie ignoriert, aber selbstbewusst erzählt, ein Geschichtsfachmann zu sein.

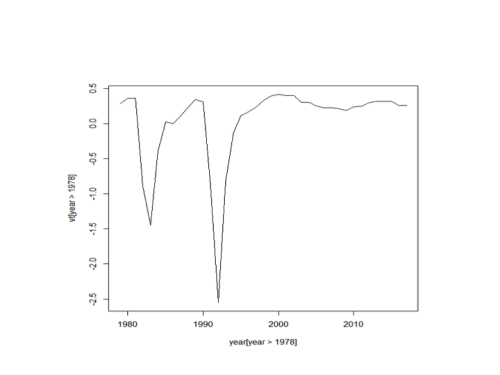

Der (wesentlich ältere) Autor merkt natürlich ebenfalls, wie verblüffend variabel das Wetter auch in unseren Breiten sein kann [17]. Er hat den zugefrorenen Bodensee erlebt und „Sommertage“ im Winter. Also einen gewaltigen Wandel in der Natur. Er sucht aber den Vergleich mit Wetterdaten in der Vergangenheit und kann dabei keine negativen Veränderungen finden [16] [17]. Und nicht nur ihm geht es so:

notrickszone, 31. Januay 2019: [23] 265 Papers Published Since 2017 Subvert The Claim That Post-1850s Warmth Has Been Unusual, Global

Dass die Abstrusitäten der „Argumente“ dieser fremdgesteuerten Kinder-Bewegung einfach nur himmelschreiend sind, merkt niemand in der Redaktion. Ca. eine Woche zuvor wurde enthustiastisch über den Schulstreik in Hamburg berichtet: [4] „We love Greta“: Junge Schwedin begeistert Hamburg

In diesem (dpa) Artikel wurde über folgendes „Argument“ informiert: ... Auf Plakaten und Transparenten fordern die Schüler „ … Make earth cool again … „

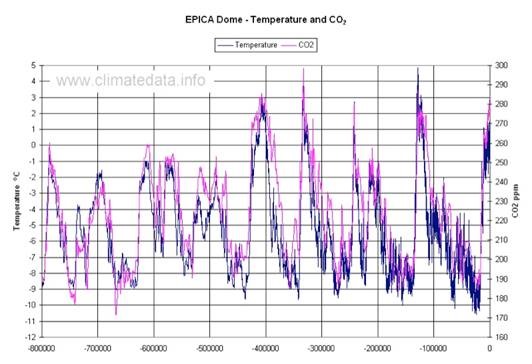

und belegt, dass den Veranstaltern – und den Berichtenden – wirklich kein Blödsinn zu blöd ist, um nicht noch positiv aufgenommen zu werden. Wer einen Rückzug des Erdklimas in die grausame, von Hungersnöten und extrem kalten Wintern geprägte, nachmittelalterliche Zwischeneiszeit „fordert“, während der das Wetter auch noch extremer als heutzutage war und den Segen der zwischenzeitlichen Erwärmung und des CO2-(Pflanzendünger-) Anstiegs für die Ernteerträge weltweit nicht kennt [13], zeigt einfach nur die vollständige Abwesenheit von Ahnung über das Thema und der Geschichte dazu, welche mit der (Ver-)Hungervorhersage von Malthus vor über 200 Jahren beginnt.

Bild 3 Quelle: BR24

Es sind die vielen kleinen Bilder, welche die Unkenntnis der Protestierenden (und Publizierenden) ausweisen. Weil es so schön aussieht, „schwitzt“ ein Pinguin. Dass diese nur um den Südpol leben und die Antarktis von einem Kälterekord zun nächsten eilt, am Klimawandel bis auf einen ganz kleinen Bereich gar nicht „teilnimmt“ [14] [15], ist ihnen entgangen:

EIKE 21.03.2018: Königspinguine sind die Eisbären der Antarktis

Unsere „Eliten“ versagen wieder, beziehungsweise eifern dem Erfolgsmodell der Kirche nach

Einmal sind das die „wissenschaftlichen Heilsprediger“, wie Professor Rahmstorf und Mojib Latif [5]. Latif erzählte den streikenden Schülern in Hamburg, dass die erste Klimakonferenz vor 40 Jahren stattgefunden hat [5]. Was er ihnen nicht erzählte war, dass zu dieser Zeit die Klimawissenschaftler weltweit unseren Planeten nicht vor zu viel Hitze, sondern dem genauen Gegenteil, der „mit Sicherheit“ kommenden Eiszeit retten wollten (wobei diese Angst viel berechtigter, als die vor einem Hitzekollaps ist [25] ).

[6] Der Spiegel, 12.08.1974: Katastrophe auf Raten

(Auszug)… Die sich in den letzten Jahren häufenden Meldungen über Naturkatastrophen und extreme Wetteränderungen in aller Welt glichen anfangs eher den Bruchstücken eines Puzzle-Spiels: Ein Orkan, der heftigste seit einem Jahrhundert, verwüstete im November 1972 weite Teile Niedersachsens. Im selben Jahr richtete im Osten der USA der Hurrikan „Agnes“ für mehr als drei Milliarden Dollar Schäden an; 122 Menschen kamen ums Leben. Es war das folgenschwerste Unwetter, das jemals in Nordamerika registriert worden war.

Ein Schneesturm ruinierte im August 1973 große Getreideanbaugebiete im Weizengürtel Kanadas. Und im November und Dezember letzten Jahres brandeten innerhalb von fünf Wochen sechs schwere Sturmfluten gegen die norddeutschen Küsten — die dichteste Sturmflut-Folge seit rund 50 Jahren.

Weit dramatischer kündigte sich unterdes der globale Klima-Umschwung in Südostasien, Afrika oder auf dem südamerikanischen Kontinent an. Sintflutartige Regenfälle überschwemmten in jüngster Zeit immer öfter Teile Japans oder Perus. In Argentinien, in Indien und Südafrika sanken im letzten Winter die Temperaturen auf Werte. wie sie seit Beginn der wissenschaftlichen Wetterbeobachtung vor etwa 300 Jahren noch nie registriert wurden.

Ungewöhnlich ergiebige Regengüsse — und im Winter Schneeschauer — gingen auch im Nahen Osten nieder, etwa im Libanon, in der Türkei und in Israel, aber auch in Italien und in manchen Regionen der USA: In San Francisco beispielsweise wurden in diesem Sommer schon die stärksten Niederschläge seit 125 Jahren gemessen.

Und während im Osten Afrikas und im Norden der USA die Wasserspiegel der großen Binnenseen stetig steigen, herrscht in den Ländern südlich der Sahara seit nunmehr sieben Jahren Dürre …

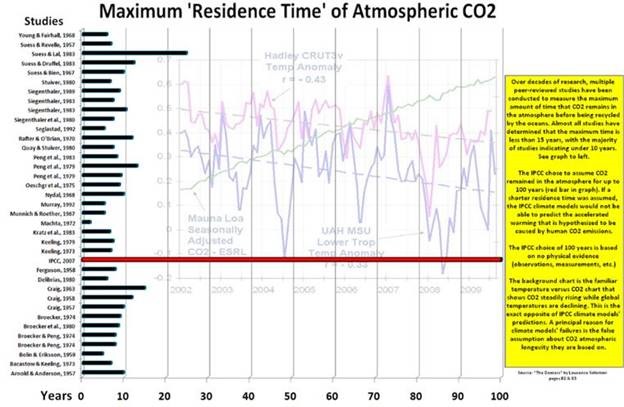

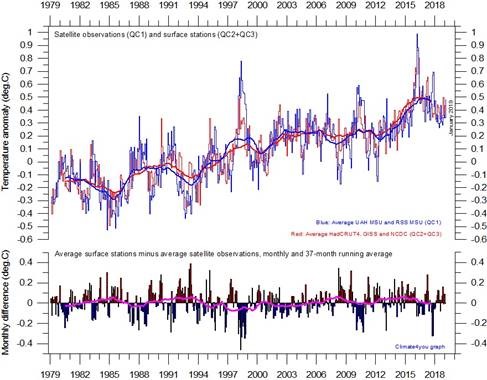

M. Latif erzählte ihnen auch nicht, wie oft er sich schon geirrt hat und dass die von ihm vertretenen Klimawandelhypothesen (wie auch die von Herrn Rahmstorf) von neueren Studien immer mehr angezweifelt werden, von den (geringen) Auswirkungen eines realistisch angenommenen Forcings (die angeblich stetig zunehmende Erderhitzung aufgrund des anthropogenen CO2 kann abgesagt werden) gar nicht zu reden [24] [7].

Er erzählte von gefährlich „schmelzenden Polkappen“, natürlich ohne auf die Ungereimtheiten zwischen angeblicher Eisschmelze und Meerespegel hinzuweisen [20] und darauf, dass alle unnatürlichen Pegelerhöhungen ausschließlich in Computersimulationen passieren [21] [22].

Den wahren Vogel schießen aber unsere Politiker*innen ab. Unsere „große, unfehlbare“ Vorsitzende zögerte anfänlich noch – fand sogar Kritik daran – und erzählte dies auf dem G20-Gipfel in Davos. Dann bemerkte sie, dass sie damit so etwas wie eine eigene Meinung hätte, etwas, das ihr im Innersten absolut zuwider ist. Auch wird sie bedacht haben, dass diese Meinung zukünftige Koalitions-Wunschpartner „stört“.

Und sofort „vergaß“ sie ihre vorherige „Meinung“ und begrüßt nun die Schülerproteste [5]. Frau Barley (SPD) ging weiter und fordert, das Wahlalter auf 16 Jahre herabzusetzen [19], vertritt damit allerdings nur GRÜNE und Linke Positionen. Die Begründung muss ähnlich vermutet werden, wie es Renate Schmidt – ehemalige SPD-Familienministerin-, einst in einem Interview äußerte: (Gedächtnisprotokoll) Meine Enkelkinder haben die gleiche politische Meinung wie ich. Das belegt, wie gut sich Kinder bereits mit Politik auskennen …

Bei der Verleihung des Ordens „Wider den tierischen Ernst“ hielt Frau Barley eine Rede, in welcher sie Protest deutlich als falsch darstellte, sofern er gegen ihre – einzig richtige – Meinung gerichtet sei [11] [12].

Frau Bundesforschungsministerin Karliczek (Diplom-Kauffrau) ließ gar über die dpa mitteilen, dass Zweifel am Klimawandel nicht erwünscht ist. Ihrer Überzeugung nach wissen Politiker genau, welche Wissenschaft im Volk nicht mehr diskutiert zu werden braucht:

[25] „Bundesforschungsministerin Anja Karliczek tritt verbreiteter Skepsis gegenüber wissenschaftlichen Erkenntnissen, etwa zu Klimawandel und Luftverschmutzung, entgegen … Wenn Klimawandel angezweifelt wird … dann ist das auch für die Politik ein ernstes Thema … die Politik beziehe sich schließlich auf den Stand der Wissenschaft …„

Alle orientieren sich damit an Institutionen, welche über tausende von Jahren belegen, wie man „Überlebenspolitik“ macht. Man übernimmt – sobald diese sicher sind – die Meinung der staatswichtigen Eliten und erklärt diese als gottgewollt:

EIKE 18.04.2016: [8] Kirche und Klimawandel Viel „Mensch“, viele Bibelsprüche, die Orientierung vom PIK, von kritischer Reflexion keine Spur

Als logische Folge „rannte“ die Kirche bedenkenlos jedem Zeitgeist hinterher (der ihr Vorteile brachte und sicherte). Erkenntnisse, dass er falsch sein könnte, kamen ihr immer erst, nachdem Machtveränderungen es geboten schienen:

[9] … die spektakulären Erfolge Hitlers zu Beginn der dreißiger Jahre, konnte für das stets opportunistische Papsttum, das durch Anpassung an die Stärksten lebt und überlebt, die Entscheidung nicht anders ausfallen, als sie ausfiel. Nichts betet der Vatikan mehr an als den Erfolg …

Unsere „Intelligenz“ ist nicht mehr besser. Leider auch in bisher leidlich davon verschonten Flecken. In Bayern ist das Klimaschutzgesetz kürzlich im Landtag gescheitert. Nicht entfernt wegen so etwas wie Vernunft, sondern nur, weil SPD und GRÜNE noch mehr forderten. Die bayerischen Parteien haben auch kein Problem damit, denn im Bund wird dieser Wahnsinn mit Sicherheit kommen.

Eike 01. März 2019: Dokument des Grauens: Der Entwurf des neuen Klimaschutzgesetzes aus dem Hause Svenja Schulze (SPD)

Es erinnert langsam an eine Politik, wie sie Mao in China mit den „Roten Garden“ schon praktizierte: Wenn das Volk gegen den angeordneten, politischen Wahnsinn opportunistisch wird, indoktriniere die Kinder und Jugendlichen und hetze diese auf die renitenten „Alten“.

Quellen

[1] EIKE 01. März 2019: Dokument des Grauens: Der Entwurf des neuen Klimaschutzgesetzes aus dem Hause Svenja Schulze (SPD)

[2] Süddeutsche Zeitung, Wochenendausgabe vom 02./03.2019, Barbara Vorsamer: Klimastreiks Schüler an die Macht

[3] Lokalausgabe (Printversion) der „nordbayerischen Nachrichten“: Kritik auch an der Stadtpolitik

[4] Lokalausgabe (Printversion) der „nordbayerischen Nachrichten“: „We love Greta“: Junge Schwedin begeistert Hamburg

[5] ScienceScepticalBlog, 02. März 2019: Mojib Latif bei Fridays for Future Schülerstreik in Hamburg

[6] Der Spiegel, 12.08.1974: Katastrophe auf Raten

[7] EIKE, 26. Februar 2019: Traue keiner Darstellung, die du nicht selberstatistisch „aufbereitet“ hast. Alternativ: Wie Klimaalarme erzeugt werden Teil 2 (2)

[8] EIKE 18.04.2016: Kirche und Klimawandel Viel „Mensch“, viele Bibelsprüche, die Orientierung vom PIK, von kritischer Reflexion keine Spur

[9] Karlhein Deschner, Buch: Mit Gott und dem Führer

[10] Achgut 01.03.2019: Aloa, Aloa: Prantl geht als Relotius

[11] Achgut 27.02.2019: Im freien Fall und trotzdem bester Laune

[12] The European, 03.03.2019: Die lauten und die stummen Jugendlichen

[13] EIKE 26.11.2016: Forscher des Weltklimarates IPCC rechnen, dass die globale Erwärmung 10 bis 50 % der jährlichen Ernte bedroht – Was steckt dahinter?

[14] NoTricksZone, By P Gosselin on 28. December 2018: Arctic Ice Volume Shames Climate Experts …Antarctic Stations Show Cooling, Not Warming

[15] NoTricksZone, By Kenneth Richard on 18. October 2018: New Science: Arctic AND Antarctic Sea Ice More Extensive Today Than Nearly All Of The Last 10,000 Years

[16] EIKE 21.11.2015: Die bayerische Umweltministerin Frau Scharf: Extremwetter, Extrem-Hochwasser und die Unberechenbarkeit des Wetters nehmen zu. Doch stimmt das wirklich?

[17] EIKE 03.06.2018: Früher war es schlimmes Wetter, heute macht das Gleiche mit Sicherheit der Klimawandel

[18] EIKE 10.05.2017: Die Volkshochschule Hannover und ihre Ausstellung: Wir alle sind Zeugen – Menschen im Klimawandel

[19] Achgut: Wahlrecht ab 16: Lotto verboten, Wählen ok

[20] EIKE 4. März 2019: 12. IKEK am 23. und 24.11.18 Nils-Axel Mörner Das Kattegat u.a. als Testgebiete für die Höhe des Meeresspiegels

[21] EIKE 03.11.2017: Das Wochenende, an dem die Welt (wieder) begann unterzugehen

[22] EIKE 08.08.2017: Meerespegelanstieg: Europa kann nicht alle (vor Klimawandel-Desinformation) schützen T2 (2)

[23] notrickszone, 31. Januay 2019: 265 Papers Published Since 2017 Subvert The Claim That Post-1850s Warmth Has Been Unusual, Global

[24] EIKE 22. Februar 2019: Weltklimarat IPCC zum CO2 : „Alles halb so schlimm!“

[25] Nordbayerische Nachrichten, lokale Printausgabe, 06.03.2019: (dpa) Kampfansage an Klimaleugner

[25] EIKE 25.12.2016: Man sollte schon langsam an die nächste Eiszeit denken, denn wenn die neuesten Hypothesen sich als falsch erweisen, kann sie schnell da sein