Wetterabhängige „erneuerbare“ Energie: wie machte sie sich 2020 in DE, UK und FR?

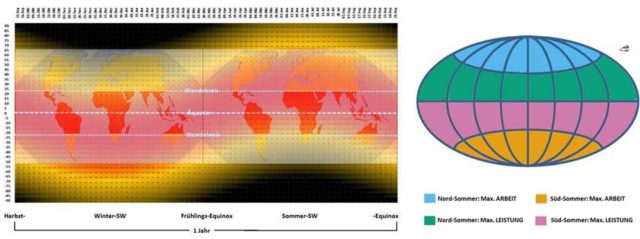

Diese drei großen Nationen: Deutschland, das Vereinigte Königreich und Frankreich (DE UK FR), stellen mehr als die Hälfte der wetterabhängigen, erneuerbaren Energieerzeugungsanlagen in Europa. Diese Nationen bedecken eine Fläche von etwa 1,1 Millionen Quadratkilometern, etwa ein Viertel der Landfläche der EU(27). Es erstreckt sich von 43°N bis 58°N und 6°W bis 13°E.

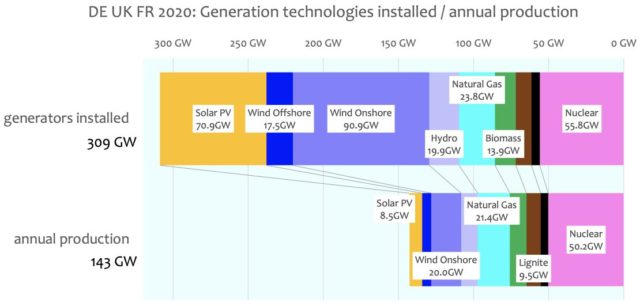

Ein Datensatz, der ihre stündliche und tägliche Stromerzeugung vom 1.12.2019 bis zum 31.11.2020 berücksichtigt, wird verwendet, um die vergleichende Leistung der Stromerzeugung in diesen drei Nationen zu untersuchen. Der Gesamtvergleich zwischen den kombinierten Erzeugungsanlagen und der von ihnen erzielten Stromleistung ist unten dargestellt.

Bemerkenswerte Punkte aus diesen Grafiken:

● Die wetterabhängigen erneuerbaren Anlagen machten im Jahr 2020 etwa 60 % aller Erzeugungskapazitäten in DE UK FR aus und trugen nominell ~24 % der DE UK FR-Stromerzeugung bei.

● 17 % der installierten DE UK FR-Erzeugungstechnologien produzieren immer noch erhebliche CO2-Emissionen aus Kohle, Braunkohle, Biomasse und Erdgas, und diese CO2-emittierenden Erzeugungstechnologien sind weiterhin für ~33 % der DE UK FR-Stromerzeugung verantwortlich.

● Der Einsatz dieser Kombination von CO2-emittierenden Technologien erzeugt mehr als das ~2,5-fache der CO2-Emissionen, die bei der alleinigen Verbrennung von Erdgas für die gleiche Stromleistung emittiert worden wären.

● Die Kernenergie in DE UK FR produziert immer noch 35% des Stroms, auch wenn die 8GW dieser Kernenergie in Deutschland Anfang dieses Jahrzehnts endgültig abgeschaltet werden sollen.

● Frankreich ist die vorherrschende Atomenergie und exportiert ~6GW seiner überschüssigen Energie in andere europäische Nationen. Diese Empfängerländer sind zur Aufrechterhaltung ihrer Netzversorgung vollständig auf diese Energiezufuhr angewiesen. Nichtsdestotrotz beabsichtigt Frankreich anscheinend, seine Kernenergieerzeugung zu reduzieren und durch wetterabhängige erneuerbare Energien zu ersetzen.

Gegenüberstellung der Stromerzeugung in diesen drei Nationen (DE, UK, FR):

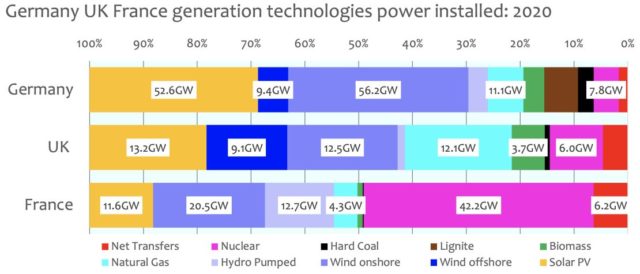

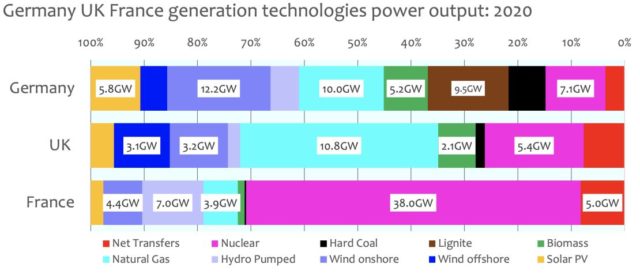

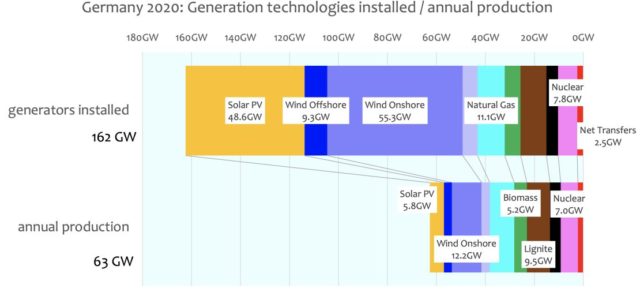

Die folgenden Graphiken zeigen das Ausmaß der installierten Erzeugungs-Technologien und deren Niveau des produktiven Ergebnisses:

Bemerkenswerte Punkte aus diesen Graphiken:

Deutschland

Im Jahre 2020 machten wetterabhängige „Erneuerbare“ (Wind und Solar) 69,8% aller Installationen zur Stromerzeugung in Deutschland aus:

● In Deutschland haben die wetterabhängigen erneuerbaren Energien als Ergebnis der Energiewende-Politik inzwischen ~70% der gesamten installierten Erzeugungskapazität erreicht, aber diese wetterabhängigen erneuerbaren Energien tragen nur ~33% des jährlichen Stroms bei:

● Onshore-Windkraftproduktivität/Kapazität durchschnittlich seit 2008 18,9%

● Offshore-Windkraft Produktivität/Kapazität im Durchschnitt seit 2008 33,6%

● Solar-Photovoltaik Produktivität/Kapazität im Durchschnitt seit 2008 10,3%

● Kombinierte wetterabhängige erneuerbare Produktivität/Kapazität durchschnittlich seit 2008 15,3%.

● Die Stromerzeugung in Deutschland wird zu ~20% von CO2-emittierenden Anlagen getragen, die Steinkohle, Braunkohle, Biomasse und Erdgas verwenden, aber diese Technologien sind für 45% des erzeugten Stroms verantwortlich.

● Die CO2-Emissionen aus dieser Brennstoffkombination hätten auf mehr als ein Drittel reduziert werden können, wenn stattdessen ausschließlich Erdgas eingesetzt worden wäre.

● Deutschland verfügt immer noch über einen beträchtlichen Bestand an Kernkraftwerken, aber aufgrund einer politischen Entscheidung nach dem Reaktorunfall in Fukushima 2011 soll die Kernkrafterzeugung in Deutschland innerhalb weniger Jahre vollständig eingestellt werden.

● Deutschland hat seine Kohle- und Braunkohleverstromung in Erwartung der Schließung dieser nicht CO2-emittierenden Kernkraftwerke erhöht. Es hat einige stillgelegte Kohlekraftwerke wieder in Betrieb genommen, da es erkannt hat, dass die Schließung dieser Grundlaststromerzeuger die Instabilität des Stromnetzes weiter erhöhen würde.

● 5% des deutschen Stroms wird durch Wasserkraft mit begrenzter Pumpspeicherung erzeugt.

● Deutschland hat trotz seiner Energiewende-Politik“ immer noch die höchsten CO2-Emissionen/Kopf in Europa mit ~8,38 Tonnen/Kopf.

● Deutschland ist für ~4% seines Stroms auf Transfers aus Frankreich und anderen europäischen Ländern angewiesen. Gelegentlich produzieren Deutschlands Erneuerbare Energien im Vergleich zum Bedarf zu viel und dieser überschüssige Strom muss abgenommen oder zu negativen Preisen ins Ausland verkauft werden.

● Deutschland hat neben Dänemark (das ebenfalls stark auf Windenergie setzt) die höchsten Strompreise in der entwickelten Welt.

[Eine deutsch-sprachige Website, in welcher der gesamte gefährliche Unsinn aller Aspekte bzgl. „Energiewende“ angesprochen wird, ist diese hier. Die Lektüre wird DRINGEND EMPFOHLEN! Schon Pierre Gosselin hat auf seiner Website am 13. April hier darauf hingewiesen. Titel seines Beitrags {übersetzt}: „Deutschlands Kohle-Ausstieg … dauerte nur 8 Tage“. A. d. Übers.]

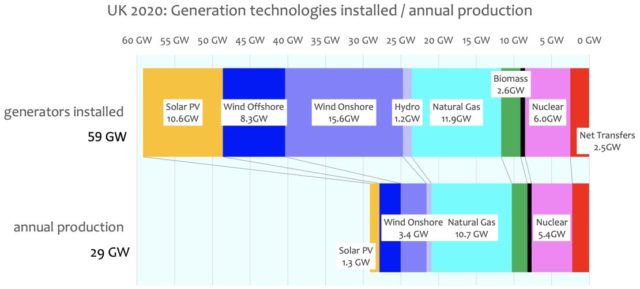

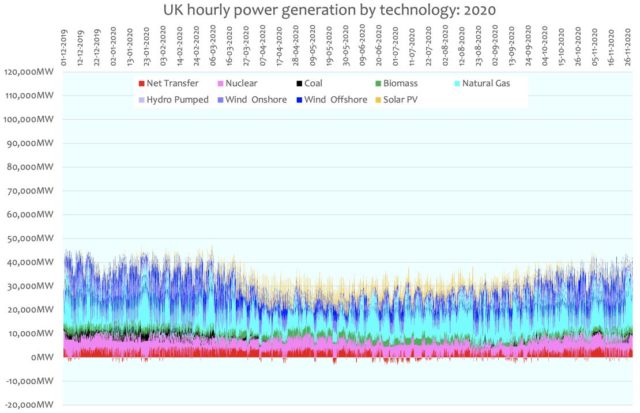

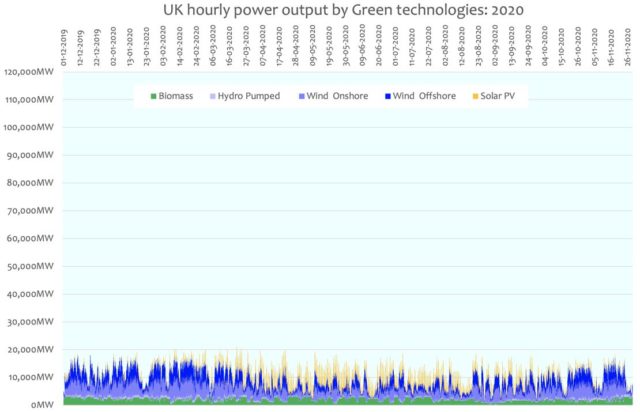

UK

Im Jahr 2020 machen die wetterabhängigen erneuerbaren Energien (Wind- und Solarenergie) 58 % aller Stromerzeugungsanlagen in Großbritannien aus.

● Die wetterabhängigen erneuerbaren Anlagen in Großbritannien machen jetzt ~58% der gesamten installierten Erzeugungskapazität aus, produzieren aber nur 26% des Stroms:

– Onshore-Windkraftproduktivität/Kapazität im Durchschnitt seit 2008 25,6%

– Offshore-Windkraft Produktivität/Kapazität im Durchschnitt seit 2008 32,2

– Solar-Photovoltaik Produktivität/Kapazität im Durchschnitt seit 2008 9,6%

– Kombinierte wetterabhängige erneuerbare Energien Produktivität/Kapazität im Durchschnitt seit 2008 21,9%.

● Großbritannien hat sich stark für die Offshore-Windenergie engagiert und stößt auf erheblichen lokalen Widerstand gegen weitere Onshore-Windanlagen.

● Die Stromerzeugung in Großbritannien wird zu ~46% von CO2-emittierender Erzeugung aus Erdgas und Biomasse getragen: Die britischen CO2-Emissionen aus Biomasse, hauptsächlich aus den Drax-Kraftwerken (die hauptsächlich aus Amerika importierte Holzspäne verbrennen), heben diese CO2-Emissionen effektiv alle CO2-Einsparungen aus der Nutzung aller anderen wetterabhängigen erneuerbaren Energien auf.

Die widersprüchliche Grün-Politik zur Begrenzung von CO2-Emissionen

● Großbritannien hat immer noch eine alternde Flotte von Kernkraftwerken, von denen die meisten in diesem Jahrzehnt geschlossen werden. Einige Ersatzanlagen sind in Vorbereitung, wobei Hinkley Point im Jahr 2023 in Betrieb genommen werden soll: Es gibt immer noch keine britische Verpflichtung zur Installation von lokalen kleinen modularen Reaktoren, die in Großbritannien hergestellt werden könnten.

● Aufgrund der geografischen Beschränkungen in Großbritannien werden nur ~5% des britischen Stroms durch Wasserkraft erzeugt, es gibt einige begrenzte Pumpspeicher.

● Als Ergebnis der früheren britischen „Dash for Gas“-Politik hat Großbritannien seine CO2-Emissionen / Kopf seit den 1990er Jahren auf unter den europäischen Durchschnitt von 5,46 Tonnen/Kopf im Jahr 2019 gesenkt.

● Großbritannien ist für ~8% seines Stroms von anderen europäischen Ländern, hauptsächlich Frankreich, abhängig.

● Das Vereinigte Königreich hat praktisch keine Arbeitsspanne für die gesamte Stromerzeugung.

● Die Abhängigkeit Großbritanniens von Stromimporten sollte als existenzieller nationaler Notstand betrachtet werden.

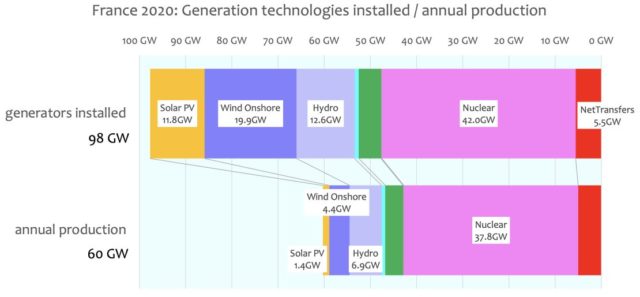

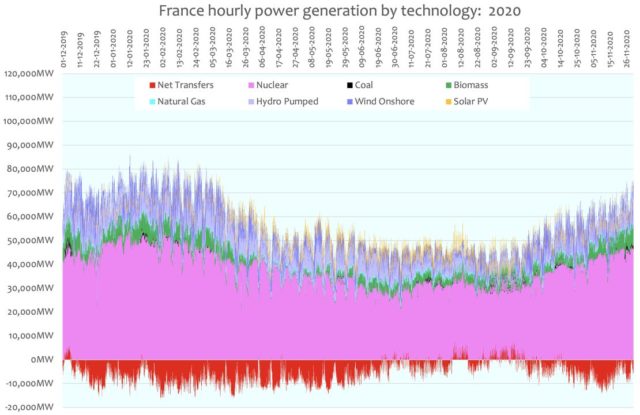

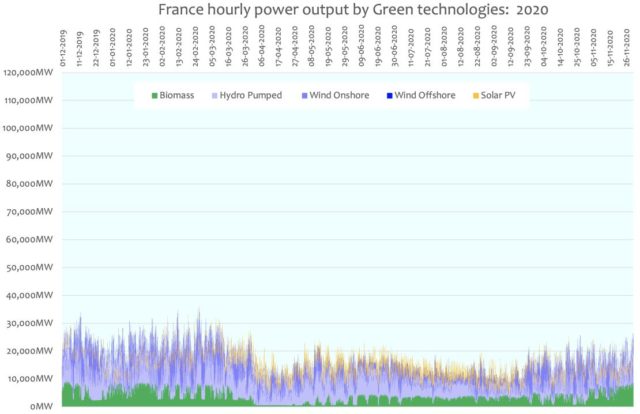

Frankreich

Im Jahr 2020 machten die wetterabhängigen erneuerbaren Energien (Wind- und Sonnenenergie) 31,7 % aller Stromerzeugungsanlagen in Frankreich aus. Zusammen trugen sie etwa 9,6 % der erzeugten Energie bei einem Produktivitäts-/Kapazitätsanteil von 18,3 % bei.

● die französischen wetterabhängigen erneuerbaren Anlagen machen jetzt 37% der installierten Erzeugungskapazität aus, aber sie tragen nur ~11% zur Stromerzeugung bei:

– Onshore-Windkraft Produktivität/Kapazität seit 2008 21,5%

– Produktivität/Kapazität der Solar-Photovoltaik seit 2008 12,2%

– Kombinierte wetterabhängige erneuerbare Produktivität/Kapazität seit 2008 18,2%

● Frankreich hat keine Offshore-Windkraftanlagen installiert.

● Die französische Stromerzeugung hat eine begrenzte CO2-emittierende Erzeugung aus Biomasse und Erdgas, die nur etwa 6 % der Stromerzeugung ausmacht.

● Frankreich verfügt immer noch über eine große, aber inzwischen veraltete Flotte von Kernkraftwerken, die als Reaktion auf den Ölpreisschock der 1970er Jahre nach und nach installiert wurden.

● Es gibt immer noch keine große Verpflichtung, sie zu ersetzen, aber die aktuelle Politik scheint zu sein, die erfolgreiche französische Kernkraftwerksflotte von derzeit 75%+ auf ~50% der französischen Stromerzeugung zu reduzieren.

● Diese Flottenreduzierung würde natürlich die derzeitige Fähigkeit Frankreichs einschränken, seine überschüssige Energie nach Übersee zu liefern, insbesondere nach Großbritannien und Deutschland.

● Großbritannien ist für ~8% seines Stroms von Frankreich und anderen europäischen Ländern abhängig.

● Das Vereinigte Königreich hat praktisch keine Betriebsmarge für die Stromerzeugung insgesamt diese Importabhängigkeit sollte als existenzieller nationaler Notfall betrachtet werden, insbesondere seit dem Brexit.

[Hervorhebung im Original]

● Darüber hinaus stammen ~14 % des französischen Stroms aus Wasserkraft mit einigen begrenzten Pumpspeichern.

● Als Ergebnis der früheren langfristigen französischen Kernenergiepolitik hat Frankreich seit dem Ölpreisschock in den 1970er Jahren seine CO2-Emissionen / Kopf auf unter den globalen Durchschnitt von 4,26 Tonnen/Kopf gesenkt: Frankreich hat damit die niedrigsten Emissionen/Kopf aller entwickelten Nationen.

● Frankreich hat jetzt die niedrigsten Strompreise in Europa.

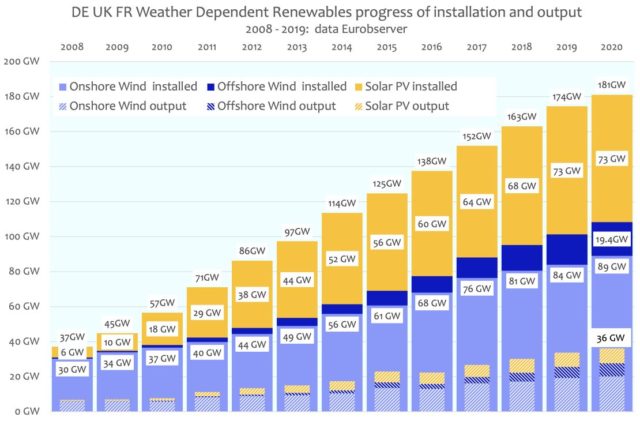

DE UK FR: Wetterabhängige Erneuerbare Energien Fortschritt und Produktivität / Kapazität

Der Installations- und Leistungsfortschritt der wetterabhängigen erneuerbaren Energien in DE UK FR seit 2008 ist unten dargestellt:

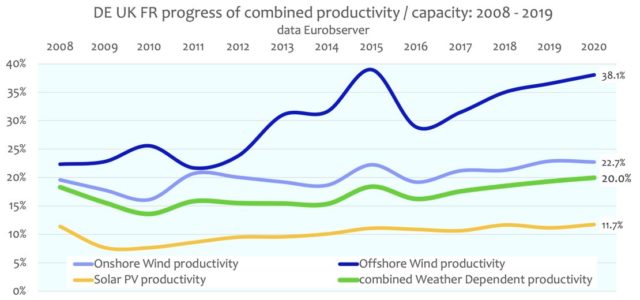

Die konsequente Historie der wetterabhängigen Produktivität/Kapazität von DE UK FR ist unten dargestellt: Im Wesentlichen gab es seit 2008 nur einen marginalen Produktivitätsfortschritt und insgesamt bleibt sie in der Größenordnung von 20%, (1 Tag von 5 insgesamt).

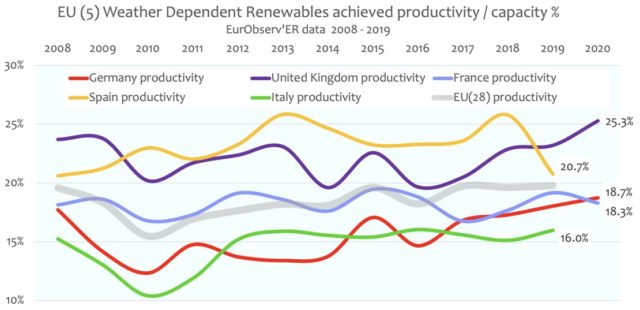

Die gemessenen jährlichen wetterabhängigen erneuerbaren Produktivitäts-/Kapazitätsprozentsätze für die wichtigsten europäischen Befürworter von sind unten dargestellt:

Mit anderen Worten: Die wetterabhängigen erneuerbaren Energien produzieren im Laufe eines Jahres etwa ein Fünftel ihrer Nennleistung, und dieses Produktivitäts-/Kapazitätsniveau hat sich seit 2008 nur wenig verbessert.

Die konstant schlechte Leistung ist in Italien zu finden, wo es ein Übergewicht an Solar-PV-Anlagen gibt. Spanien (wo zuvor in betrügerischer Absicht Solarstrom in der Nacht erzeugt wurde) verfügte größtenteils über Onshore-Windkraftanlagen, aber Spanien hat kürzlich ein weiteres großes Solarstrom-Engagement hinzugefügt, und dementsprechend ist die zuvor hohe Produktivität Spaniens abrupt gesunken. Die Produktivität Großbritanniens wird durch den hohen Anteil an Offshore-Windkraft gestützt. Der hohe Anteil an Solarenergie in Deutschland hat deren schlechte Produktivität aufrechterhalten: Deutschland und UK sind die dunkelsten und wolkenreichsten Nationen in Europa.

Dieser Beitrag ist eine Aktualisierung der Informationen aus diesem Beitrag von 2019.

Die Leistung wetterabhängiger „Erneuerbarer“ in DE, UK, FR

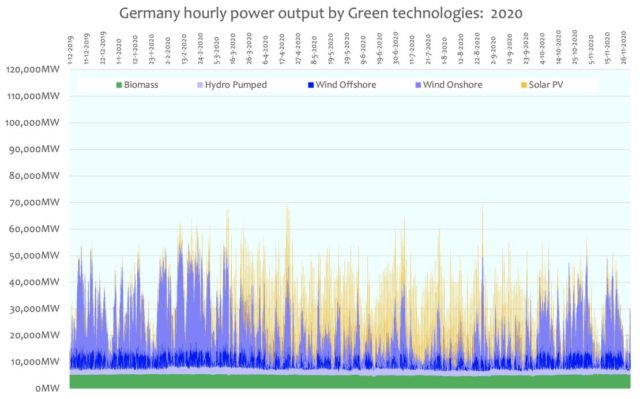

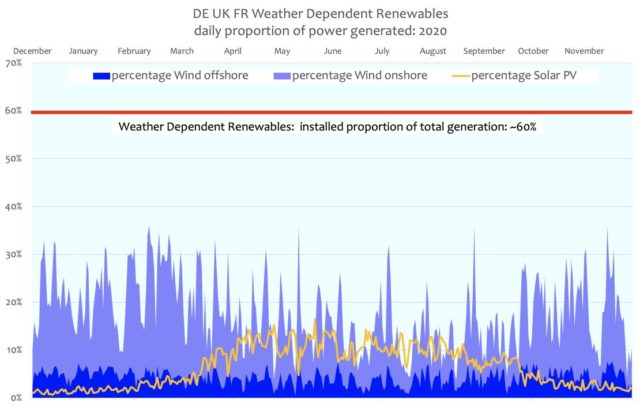

Das obige Diagramm zeigt die Brutto-Variabilität auf Tagesbasis der Leistung aus wetterabhängigen erneuerbaren Energien in den DE UK FR Nationen. Es zeigt umfassend:

● dass die Variabilität der kombinierten Windleistung, die durch wechselnde Wettermuster im Laufe des Jahres beeinflusst wird und von ~5 % der täglichen Erzeugung bis zu mehr als 30 % reicht.

● Obwohl die Gebiete geografisch unterschiedlich sind, gibt es das ganze Jahr über eine tägliche Koordination zwischen Onshore- und Offshore-Winderzeugung.

● In den Wintermonaten von Oktober bis März ist die Solar-PV-Produktion minimal.

● Auch in den produktiveren Sommermonaten kann es zu erheblichen Leistungsschwankungen der PV-Leistung von einem Tag auf den anderen kommen.

● Es gibt eine sinnvolle Abstimmung zwischen der Windkraft mit geringerer Produktivität in den Sommermonaten und der höheren Solar-PV-Produktivität im Sommer. Dabei wird natürlich die Tatsache ignoriert, dass die PV-Produktivität in den Abendstunden zu Zeiten höherer Nachfrage schnell abfällt.

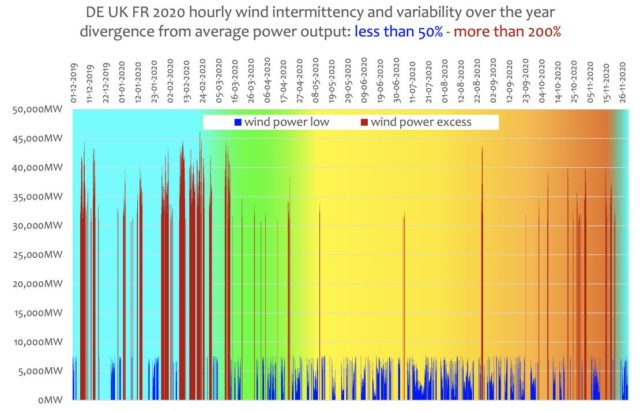

Allerdings wird das wahre Ausmaß der Intermittenz und der Variabilität der wetterabhängigen erneuerbaren Energien erst dann deutlich, wenn die Leistung auf Stundenbasis oder mikt noch größerer Auflösung bewertet wird.

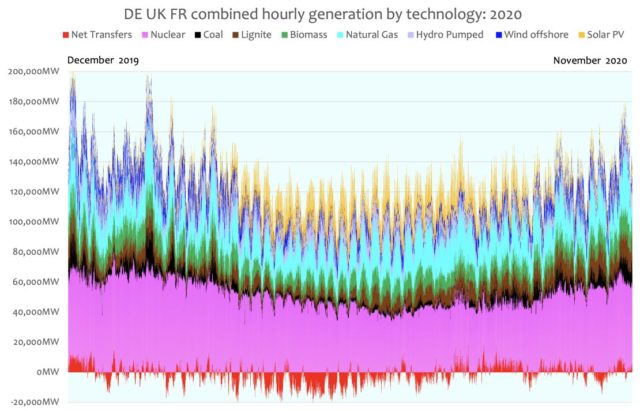

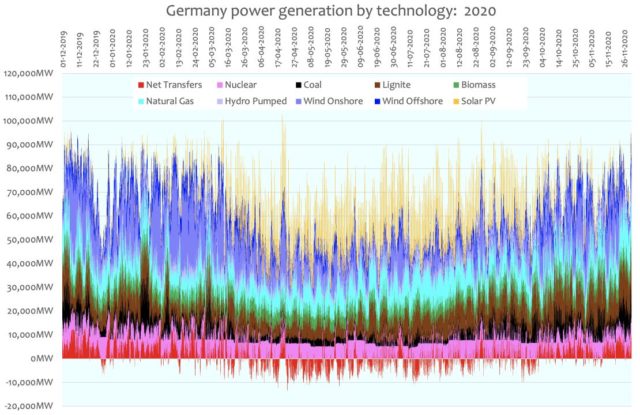

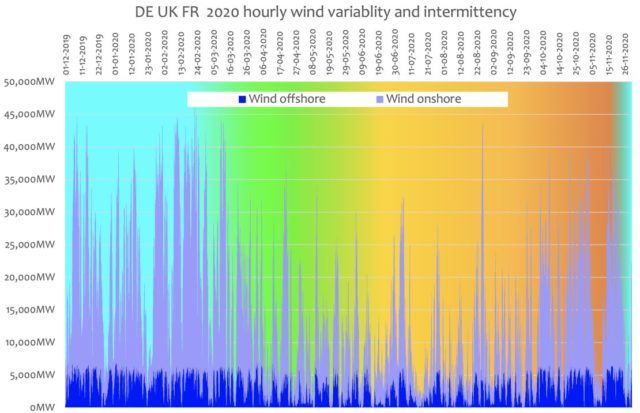

Kombinierte stündliche Stromleistung Deutschland, Großbritannien und Frankreich

Der große Bereich der wetterabhängigen Leistungsabgabe ist unten deutlich zu erkennen. Darüber hinaus ist auch die sprunghafte Natur der Leistungsänderungen offensichtlich. Im Allgemeinen gibt es eine konsistente Koordination zwischen Onshore- und Offshore-Windleistung. Die rasante Änderungsgeschwindigkeit der Leistungsabgabe schafft massive Steuerungsprobleme für diejenigen, die für die Aufrechterhaltung der notwendigen gleichbleibenden Qualität des elektrischen Netzes verantwortlich sind. Europaweite Windflauten sind im Jahresverlauf in unterschiedlichem Ausmaß zu beobachten.

Man könnte meinen, dass die Kombination der Windkraftleistung in den drei Nationen DE UK FR die Variabilität der wetterabhängigen erneuerbaren Energien glättet, aber die Daten einiger ausgewählter Monate im Jahr 2020 zeigen, dass die Behauptung, dass „der Wind immer irgendwo weht“, ein Trugschluss ist. Ein statisches windarmes Hochdruckgebiet kann durchaus Großbritannien und den nahen Kontinent für längere Zeiträume zu jeder Jahreszeit umfassen.

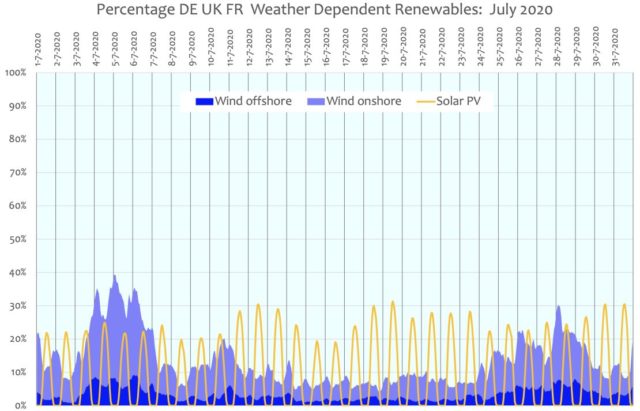

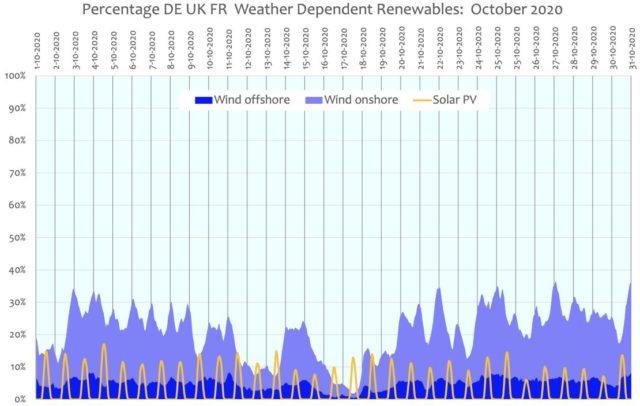

Die folgenden Diagramme für die ausgewählten Monate Januar, April, Juli und Oktober zeigen die wetterabhängige erneuerbare Energieerzeugung als Prozentsatz der Gesamtstromerzeugung für diese Monate. Sie verdeutlichen die der Wetterabhängigkeit innewohnende Unbeständigkeit und Variabilität.

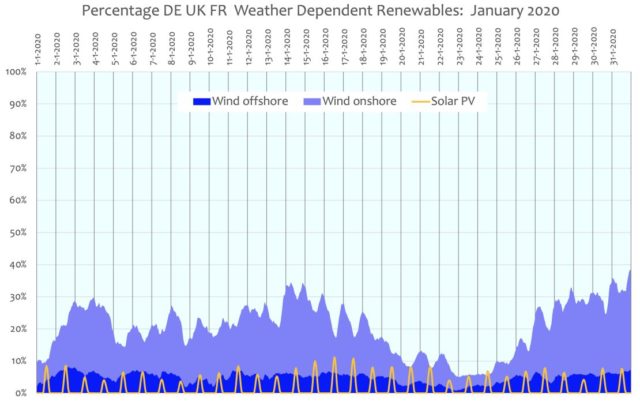

Januar 2020

In diesem Wintermonat mit der höchsten Nachfrage gab es eine schlechte Windkraftleistung, besonders vom 20. bis 25. Januar. Die PV-Solarenergie lieferte nur sehr wenig und sehr unregelmäßig Strom, mit schlechter Solarversorgung in den Abendstunden, der Zeit des Spitzenbedarfs:

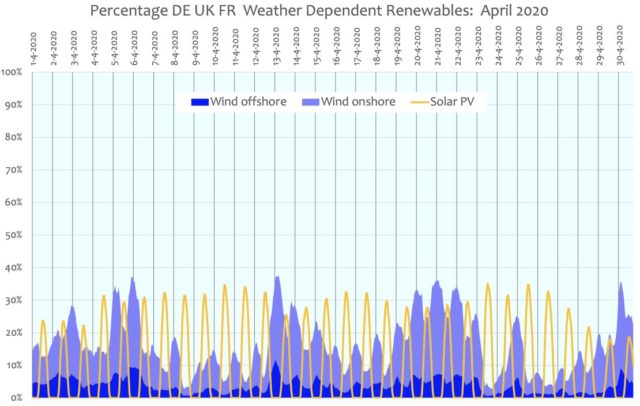

April 2020

Der Beitrag der Photovoltaik steigt zu Beginn des Monats an, aber es gab bemerkenswerte Einbrüche bei der Windkraft vom 7. bis 12. April und vom 23. bis 28. April:

Juli 2020

Der Beitrag der Photovoltaik war signifikant, wenn auch unregelmäßig, und lieferte in Spitzenzeiten mehr als 30 % der gesamten Stromerzeugung. Zu den Spitzenlastzeiten am Abend fällt er jedoch auf Null ab.

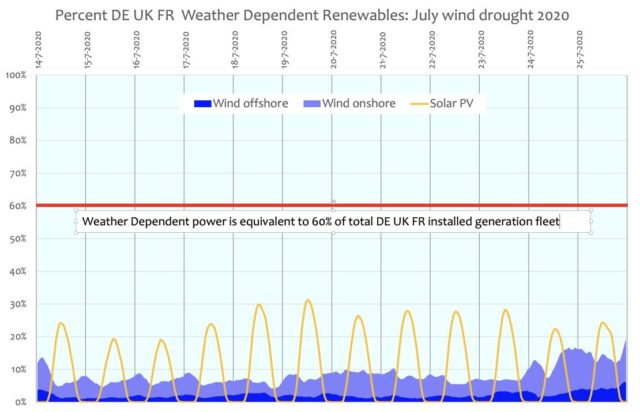

Im Juli 2020 gab es eine lange Periode mit einem signifikanten Mangel an Windenergie vom 7. bis 24. Juli. An 16 Tagen im Juli 2020 fiel die installierte Windkraftleistung, die 40 % der Stromerzeugung von DE UK FR ausmacht, auf unter 10 % der gesamten Stromerzeugung in der Region.

Oktober 2020

Die Abnahme der Solar-PV-Leistung ist mit dem Fortschreiten des Herbstes zu erkennen. Die Windkraft ist produktiver, aber auch hier gab es zwei kürzere Zeiträume von jeweils zwei Tagen, in denen die Leistung auf weniger als 10 % der gesamten DE UK FR-Erzeugung fiel

Die Wetterabhängigkeit führt zu Intermittenz und Variabilität

Windenergie

Bei starkem Starkwind muss die Windleistung gedrosselt werden, um die Anlagen vor Schäden zu schützen. Das Ausmaß der sehr ausgeprägten Windschwäche in allen Gebieten von DE UK FR im Juli 2020 ist in den unten aufgezeichneten stündlichen Daten dargestellt:

Die Windkraftleistung wird häufig auch durch geringe Windgeschwindigkeiten begrenzt. Unter Verwendung der Leistungsabgabe von Windgeneratoren als Stellvertreter für die Windgeschwindigkeit und damit die wahrscheinliche Einschränkung der Leistung erneuerbarer Energien zeigt die folgende Grafik die Zeiten wahrscheinlicher Übergeschwindigkeits-Einschränkungen und Perioden geringer Produktivität aufgrund niedriger Windgeschwindigkeiten auf stündlicher Basis.

Obwohl Speicherlösungen wie z. B. Batterien in der Lage sein könnten, solche Unterbrechungen zu bekämpfen, sollte beachtet werden, dass die anscheinend massive Batteriespeicherkapazität, die in Südaustralien zu Kosten von ~US$130 Millionen installiert wurde, das südaustralische Netz für seine 1,7 Millionen Einwohner für etwa 10 Minuten aufrechterhalten kann. Eine Batteriespeicherung in einer Größenordnung, die notwendig ist, um den Stromverbraucher von DE UK FR zu unterstützen, egal zu welchen Kosten, könnte also eine Winschwäche von etwa 10 Tagen, wie sie im Juli 2020 auftrat, nicht ausgleichen.

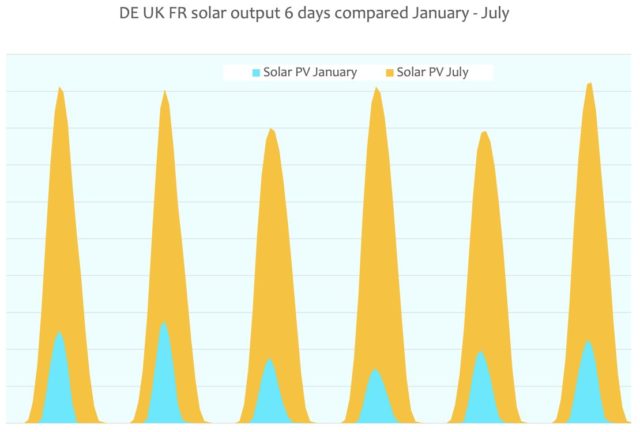

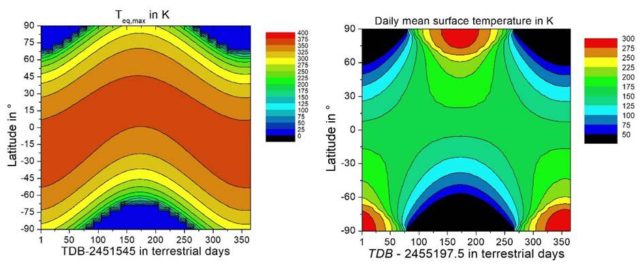

Solarenergie

Ein direkter Solar-PV-Vergleich für einige Wintertage mit einer äquivalenten Sommer-Sechs-Tage-Leistung zeigt, dass die Solar-PV-Energie im Winter etwa 1/6 der Leistung des Sommers liefert und wie groß die Dunkelperioden im nördlichen Winter sind. Entscheidend ist auch, dass selbst im Sommer der Abfall der Solarenergie in den Abendstunden erheblich ist und dass nachts überhaupt keine Produktion stattfindet. Außerdem kann es im Sommer um die Mittagszeit zu einer erheblichen Überproduktion kommen, die gedrosselt oder zu einem negativen Preis an die Nachbarländer verkauft wird und somit verloren geht, wenn sie den Strombedarf übersteigt.

● Es scheint, dass die Befürworter und die staatlichen Auftraggeber von Subventionen für erneuerbare Energien, insbesondere für die Photovoltaik in Europa, Folgendes ignorieren:

● Die jährliche Produktivität/Kapazitätsprozent von Solar-PV in Europa bleibt hartnäckig bei nur etwa 10%.

● Die „Entenkurve“ der Solar-PV-Produktion bedeutet, dass die Solar-PV-Produktion normalerweise am Abend abfällt, genau zu der Zeit, in der die Nachfrage wahrscheinlich am höchsten ist.

● Die Solar-PV-Energieproduktion nimmt vom Sommer zum Winter mindestens um das 6-fache ab. Der Winter ist die Zeit der höheren Nachfrage

● Nordeuropa, insbesondere Großbritannien und Deutschland, sind wolkenreiche Regionen. An anderen Standorten, wie z. B. in Kalifornien, kann die Solarproduktivität um weitere 50 % gesteigert werden, um bis zu 15 % jährliche Produktivität/Kapazitätsanteil zu erreichen.

Conclusions

Ein hervorragender Weg, die westlichen Volkswirtschaften zu untergraben, ist es, ihre Energieerzeugung unzuverlässig und teuer zu machen. Dieses Ziel des grünen Denkens wird nach und nach durch die Regierungspolitik in der gesamten westlichen Welt erreicht, allerdings ohne Auftrag der Bevölkerung.

● Der Anteil der wetterabhängigen erneuerbaren Energien an der Stromerzeugungsflotte der drei Länder beträgt jetzt ~60 %, in Deutschland jedoch 70 % und in Frankreich deutlich weniger.

● Diese DE UK FR wetterabhängigen erneuerbaren Energien haben eine Gesamtproduktivität/Kapazitätsanteil von weniger als 20%.

● Mit einem so hohen Anteil an wetterabhängigen erneuerbaren Energien und der fortschreitenden Eliminierung von Grundlaststromerzeugern geraten sowohl Großbritannien als auch Deutschland in Gefahr, da ihre Stromnetze aufgrund des Mangels an Grundlaststrom zunehmend anfällig werden.

Wenn die Ziele der Verwendung von wetterabhängigen erneuerbaren Energien nicht mit möglicherweise „Rettung des Planeten“ vermengt würden und der Anteil der CO2-Emissionen (für die Stromerzeugung, weniger als 25% von 1,1%, das Vereinigte Königreich 2019 Anteil der anthropogenen globalen CO2-Emissionen), so gering wäre, würden wetterabhängige erneuerbare Energien hinsichtlich ihrer tatsächlichen Kosten, In-Effektivität und ihrer inhärente Unzuverlässigkeit immer von jeder technischen Berücksichtigung als Mittel der nationalen Maßstab Stromerzeugung ausgeschlossen werden.

Der jährliche Ausstoß von CO2-Emissionen in Großbritannien wird allein durch das jährliche Wachstum der CO2-Emissionen in China und den Entwicklungsländern weit übertroffen. Es ist wichtig, sich die Frage zu stellen, welchen tatsächlichen Wert diese von der westlichen Regierung angeordneten Mehrausgaben für die Verbesserung der Umwelt und für die Möglichkeit haben, einen praktisch nicht nachweisbaren Temperaturanstieg bis zum Ende des Jahrhunderts zu verhindern, insbesondere in einem Kontext, in dem die Entwicklungsländer ihre CO2-Emissionen erhöhen werden, um ihren Lebensstandard in den kommenden Jahrzehnten weiter zu verbessern.

(Hier)

(Hier. Es gibt keinen Klima-Notstand)

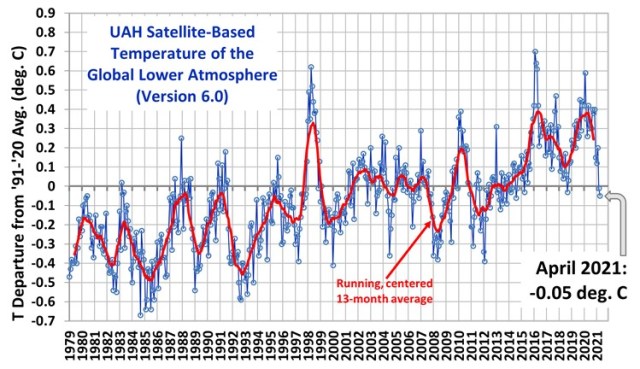

Der Zusammenhang der Jahre 2020 – 2021

Trotz all der lauten Klimapropaganda der letzten 30 Jahre stand die Welt im Frühjahr 2020 vor einem anderen, aber sehr realen wirtschaftlichen Notfall als den Reaktionen auf die COVID-19-Viruspandemie.

Dieser Notfall, bei dem die Welt mit dem Verlust vieler Bürger sowie einem globalen wirtschaftlichen Zusammenbruch konfrontiert ist, sollte die vergeblichen, selbstschädigenden und kostspieligen, von der Regierung verordneten Versuche, das zukünftige Klima zu kontrollieren, in eine starke Perspektive rücken. Dieser reale Notfall zeigt deutlich, wie irrelevant Sorgen über einen wahrscheinlich folgenlosen „Klimawandel“ in einer fernen Zukunft wirklich sind.

Datenquellen:

- German Renewables and generation data provided at hourly intervals https://www.agora-energiewende.de/en/

- United Kingdom Renewables and generation data at 5 minute intervals, condensed to hourly intervals https://www.gridwatch.templar.co.uk

- France Renewables and generation data at 15 minute intervals, condensed to hourly intervals https://www.gridwatch.templar.co.uk/france

- For the progress and scale of EU(28) installations by the end of 2019, EurObserver’ER publish their Renewable Energy “Barometers” for each type of Renewable generation annually, as yet unavailable for 2020, for an example see: www.EurObservER-Wind-Energy-Barometer-2020.pdf

Übersetzt von Chris Frey EIKE