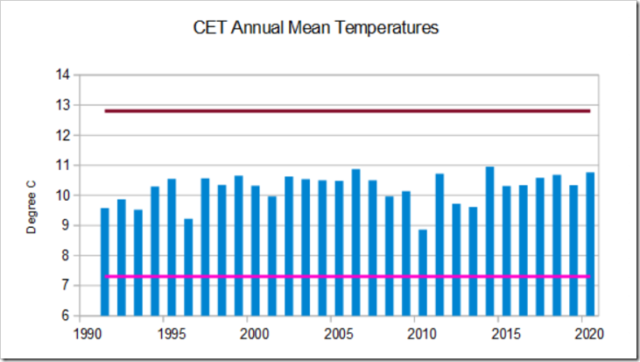

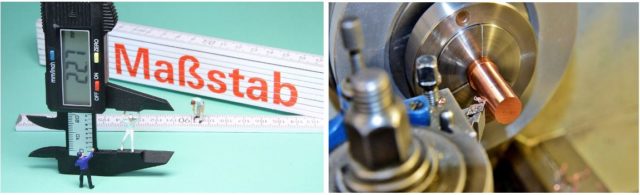

Abb 1: Links: Zollstock und digitaler Mess-Schieber. Unterschied der Genauigkeit Rechts: Bearbeitung einer Welle an einer Drehbank. Quelle: Jeweils Pixabay

Zur Verdeutlichung dieser Diskrepanz ein Vergleich aus einem Bereich der Technik, der leicht verständlich ist. Um die Kupfer-Welle (Abb.1, rechts) auf der Drehbank exakt zu messen bzw. zu bearbeiten, benötigt der Arbeiter einen Mess-Schieber. Ein Zollstock ist für ihn unbrauchbar. Genau diesen Widerspruch sehen wir jedoch in der Welt der Klimaforscher. Sie verwenden sprichwörtlich den Zollstock, um die Bauteile einer hoch präzisen Maschine zu fertigen. Die ungenauen Temperatur-Daten dienen als Basis für die komplizierten Simulationen auf Groß-Computern. Zu allem Überfluss postulieren die Klimaforscher ihre Methodik als die einzig gültige Wahrheit (IPCC). Welch eine unglaubliche Farce. Der Autor hat Erfahrung im Bereich „Computational Chemistry“, ein Hilfsmittel zur theoretischen Voraussage bzw. Bestätigung von Eigenschaften unterschiedlichster Moleküle, z. B. die 3D-Struktur, Reaktivität oder innere Beweglichkeit. Bei den Anwendern von Computer-Simulationen gibt es den geflügelten Satz für eine Ausgangs-Basis mit schlechten Anfangsdaten: „Shit in, shit out.“

- GLOBAL TEMPERATURE REPORT (GTR)

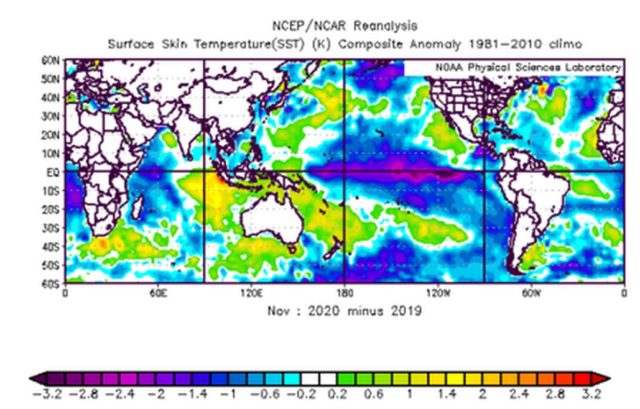

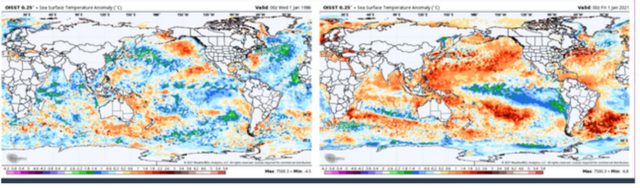

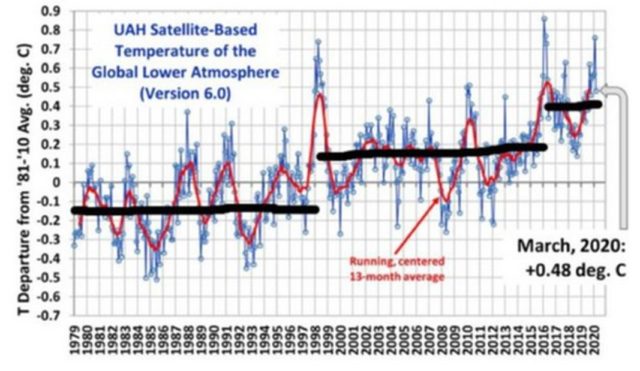

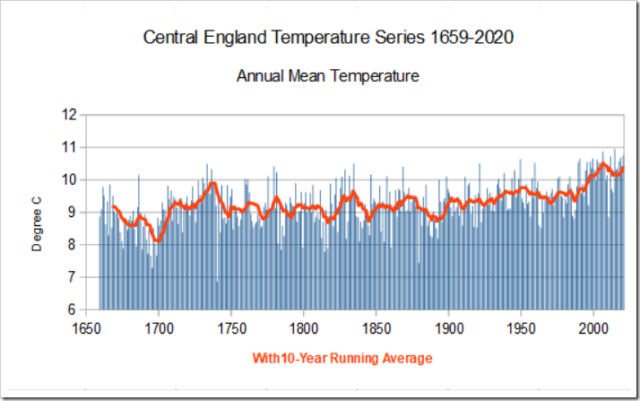

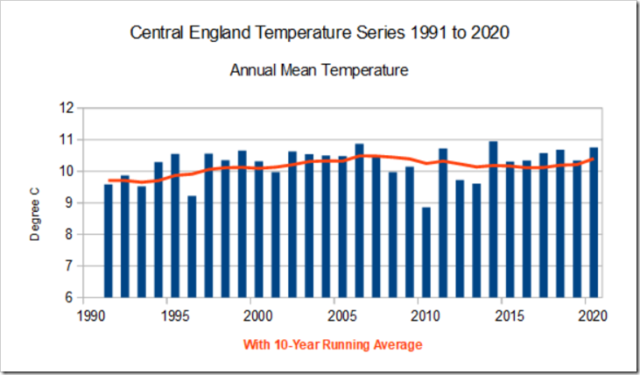

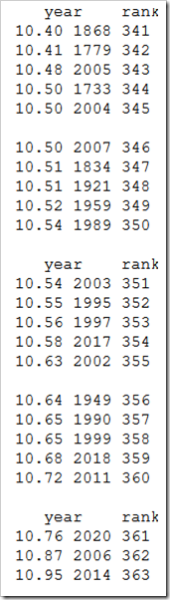

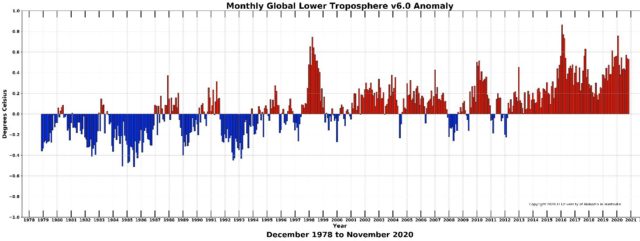

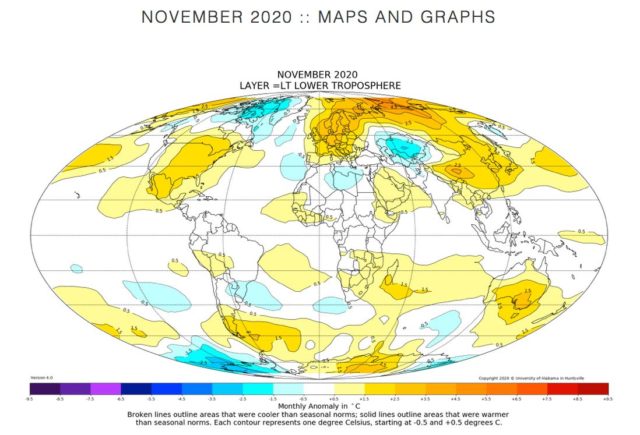

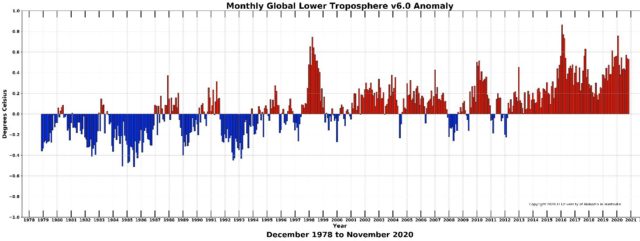

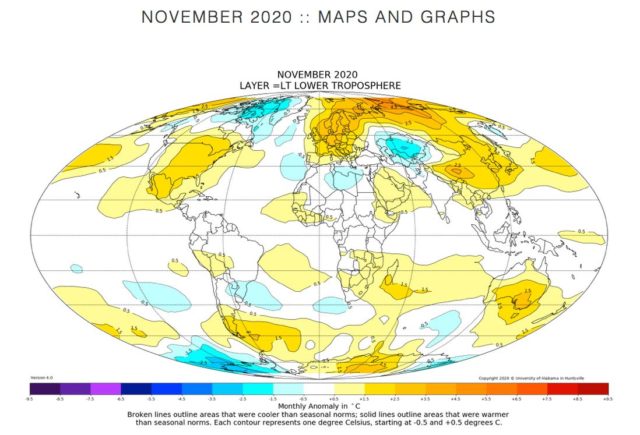

Der GLOBAL TEMPERATURE REPORT [2] zeigt in monatlicher Abfolge die berechnete globale Temperatur der unteren Atmosphäre (s. Abb.2). Verantwortlicher Wissenschaftler hinter diesen Daten ist der bekannte Klimatologe Dr. John R. Christy von der University of Alabama in Huntsville. Seit 2013 werden satelliten-basierende Temperatur-Messungen zusammengeführt, verarbeitet und auf der Homepage veröffentlicht. Christy hat zusätzlich die ab 1979 verfügbaren Satelliten-Messungen nachträglich verarbeitet. Ergebnis ist ein Säulen-Diagramm (Abb.2) mit den monatlichen Temperatur Abweichungen zur Referenz-Linie (0-Linie). Diese wird als Durchschnitts-Temperatur von 1981 bis 2010 3 errechnet. Zusätzlich wird auch eine Karten-Darstellung der Erde mit farblich gekennzeichneten Bereichen zur Verfügung gestellt. Auch für den November 2020 schön zu erkennen, die leichte Erderwärmung findet tendenziell mehr auf der Nordhalbkugel statt. Besonders in Antarktis-Nähe kühlt es eher ab. Diese These ist in vielen Veröffentlichungen bestätigt worden.

Abb 2: GLOBAL TEMPERATURE REPORT von November 2020 [2]

Abb 3: GLOBAL TEMPERATURE REPORT von November 2020. Darstellung als Karte [2]

- Vorteile der Satelliten-Daten

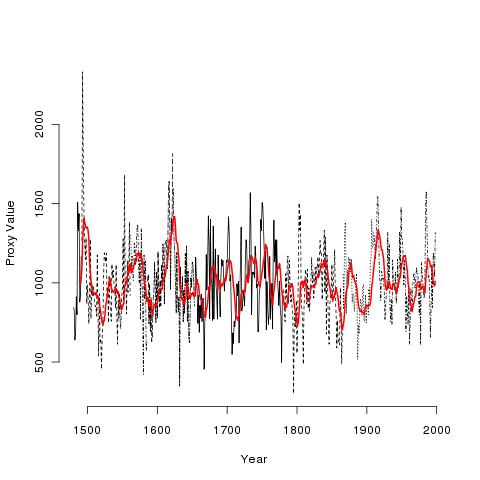

Im bereits erwähnten Vorgänger-Artikel [1] zu diesem Aufsatz wird im Kapitel 5.1.) Zuverlässigkeit der Proxy-Daten auf die Vorteile von in sich konsistenten Datensätzen eingegangen. Die GTR-Daten wurden im gesamten Erfassungs-Zeitraum vom gleichen Messgerät ermittelt, die Methodik und die Randbedingungen bleiben konstant. Systematische Fehler können daher nahezu ausgeschlossen werden. Wie auch bei den Proxy-Daten liegt in der guten Genauigkeit der relativen Änderungen innerhalb der Messreihen. Wie oft in der Naturwissenschaft ist es nicht nötig, die absoluten Daten, hier die Temperaturen, zu ermitteln. Ob zum Beispiel die mittlere Temperatur für Deutschland im Jahr 2017 14,2 °C betrug, spielt für eine mathematisch physikalische Auswertung keine Rolle. Entscheidend ist die in sich geschlossene und verlässliche Messreihe und deren korrekte Auswertung.

- Bearbeitung der GTR-Daten und erster Überblick

4.1.) Erster Überblick und Erkenntnisse aus den GTR-Daten

Das von Dr. Christy veröffentlichte Balken-Diagramm (Abb.2) ist extrem detailreich und folglich wenig übersichtlich. Was ist relativ schnell zu ermitteln? Die relativen Temperatur-Daten sind in den 80er und 90er Jahren überwiegend blau (negative Abweichung) und in den 2000er Jahren überwiegend rot (positive Abweichung). Im Betrachtungs-Zeitraum von 40 Jahren wurde es grob geschätzt 0,7 K wärmer. Auffallend sind die beiden extremen Temperatur-Spitzen um die Jahre 1998 und 2016. Dazu später noch mehr. Wegen der starken Schwankungen fällt es schwer, noch weitere Erkenntnisse aus dem Diagramm zu ermitteln.

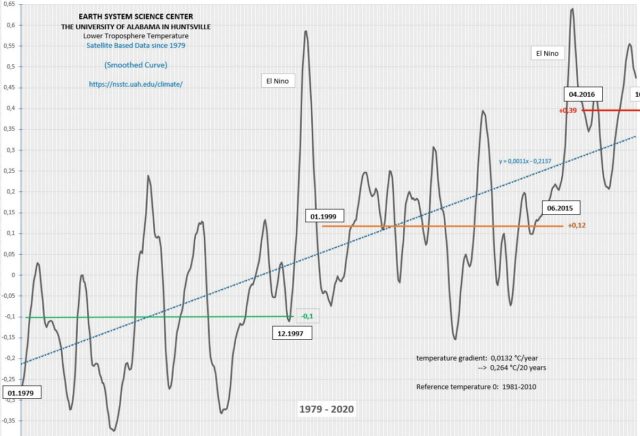

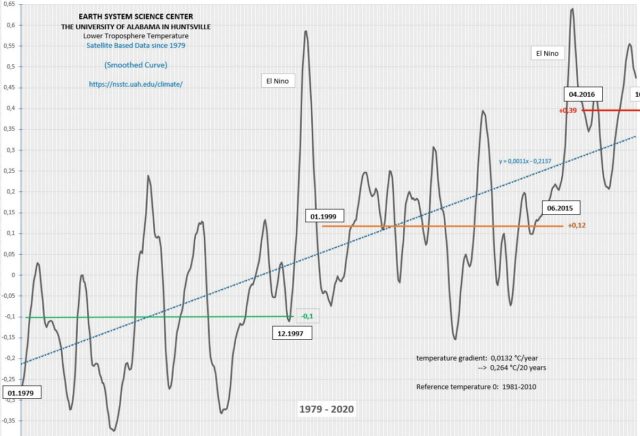

4.2.) Glättung und Bearbeitung der Koordinaten-Achsen

Die monatliche Auflösung auf der X-Achse und die Darstellung des betrachteten Zeitraums von 40 Jahren sind nicht optimal. Andererseits ist die Y-Achse mit Y(min.)= -1,0K und Y(max.) = +1,0K zu wenig aufgelöst. Als besten Kompromiss fand der Autor eine Darstellung, bei der die X-Achse gestaucht, die Y-Achse gestreckt und die „zappelnden“ Messwerte geglättet sind. Das Ergebnis ist in Abb.4 dargestellt. Tatsächlich ist es nun leichter möglich, zusätzliche Erkenntnisse aus dem Graphen zu erhalten.

4.3.) El Nino und langzeit-konstante Temperaturen

Beginnen wir mit den bereits erwähnten Warm-Peaks von 1998 und 2016. Klimatologen und andere Fachleute kennen die Ursache der beiden Temperatur-Spitzen. Beide Male ist ein extrem starker „El Nino“ schuld, eine Meeresströmungs-Umkehr im Pazifik. Dieses Phänomen tritt unregelmäßig in einem Durchschnitts-Abstand von 4 Jahren auf und hat Auswirkung auf die Temperaturen der gesamten Erde. Von Anfang 1979 bis Ende 1997 (19 Jahre) blieb die mittlere Erdtemperatur erstaunlich konstant. Ausgehend von einem Mittelwert -0,1 K schwankte die Temperatur nur ca. 0,2 K nach oben oder unten. Das gleiche Bild im Zeitraum von Anfang 1999 bis Mitte 2015 (16,5 Jahre). Nach dem El Nino von 1998 ist der Level der konstanten Temperatur um ca. 0,2K angestiegen. Schließlich begann nach dem

El Nino von 2016 eine 3. Phase konstanter Temperatur, die bis heute (4,5 Jahre) anhält. Der Anstieg des Levels beträgt diesmal knapp 0,4K.

Abb 4: Bearbeitete GTR-Daten. X-Achse gestaucht, Y-Achse gestreckt, Werte geglättet.

Schließlich hilft eine lineare Regression, die Temperaturanstiegs-Tendenz grob abzuschätzen. Die Gerade hat eine Steigung von 0,0132 K/Jahr, oder etwas greifbarer 0,26 K auf 20Jahre. Noch einfacher: Ein Temperatur-Anstieg von etwa einem Kelvin auf 80 Jahre, d. h. 1 K bis zum Jahr 2100!

4.4.) Interpretation der Ergebnisse

Es darf nicht außer Acht gelassen werden, dass der Betrachtungszeitraum von 40 Jahren für die Klimatologie ein sehr kurzer Zeitraum ist. Nach Definition handelt es sich nur um 1 1/3 aufeinander folgende 30-jährige Klima-Zeiträume. Deshalb muss bei der Interpretation der Ergebnisse eine vorsichtige und kritische halbquantitative Herangehensweise im Vordergrund stehen, nicht die blanken Zahlen-Werte.

Erstaunlich sind die relativ konstanten Temperaturen in den 3 angegebenen Zeiträumen. Der Autor sieht sich nicht in der Lage, dazu eine fundierte Interpretation abzugeben. Ein Vergleich kann trotzdem angestellt werden. Die Klimaforscher (IPCC) vertreten seit 2016 die These, das anthropogen verursachte CO2 sei die alleinige Ursache des Temperatur-Anstiegs der letzten 170 Jahre. Wie erklären diese Leute die Zeiträume von 16,5 Jahren und 19 Jahren, in denen das anthropogene CO2 einerseits massiv angestiegen ist, andererseits die Temperatur nahezu konstant blieb? Kaum zu beantworten für die Klima-Alarmisten. Nun zur ermittelten Steigung von etwa einem Kelvin auf 80 Jahre. Bitte unbedingt beachten! Dieser großzügig geschätzte Anstieg von 1 K ermittelt sich unter der Annahme eines unge-bremsten anthropogenen CO2-Ausstoßes bis zum Jahr 2100! Selbst ohne CO2-Reduzierungs-Maßnahmen, ohne regenerativen Strom und ohne Elektro-Autos entsteht daraus kein Weltuntergangs-Szenario.

- Abschätzung der CO2-Klimasensivität mit Hilfe bearbeiteten GTR-Daten

Durch die erstaunlichen Ergebnisse bei der Auswertung der GTR-Daten war es nahezu die zwangsmäßige Folgerung, auch die CO2-Klimasensivität aus den Rohdaten zu ermitteln. Wie bereits unter 4.4.) deutlich gemacht, soll hier keine exakte Berechnung durchgeführt werden. Vielmehr eine Abschätzung der Größenordnung der CO2-Klimasensivität.

5.1.) Was ist die CO2-Klimasensivität?

Die CO2-Klimasensivität ist einfach definiert: Der Anstieg der mittleren Erdtemperatur bei Verdoppelung der CO2-Konzentration in der Atmosphäre.

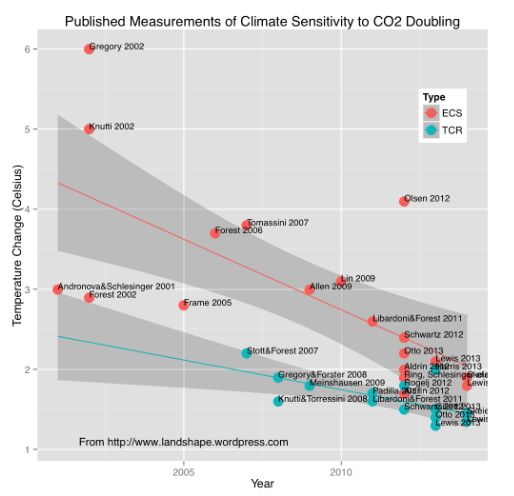

Das IPCC behauptet seit ca. 30 Jahren, die CO2-Klimasensivität liegt mit 95% Wahrscheinlichkeit zwischen 1,5 K und 4,5 K, mit größerer Wahrscheinlichkeit im Bereich zwischen 3 K und 4,5 K. Inzwischen tauchen im Umfeld des IPCC Computer-Modelle auf, die von einer CO2-Klimasensivität über 6 K ausgehen. Warten wir auf den neuen IPCC-Bericht, der für das Jahr 2021 angekündigt ist.

5.2.) CO2-Klimasensivität, die zentrale Größe im Klima-Streit

Seit Greta Thunberg und „Fridays For Future“ ist die Klima-Diskussion im Bewusstsein der breiten Öffentlichkeit angekommen. Vereinfacht ausgedrückt, der angenommene Wert der CO2-Klimasensivität ist der zentrale und wichtigste Punkt der gesamten Diskussion und Auseinandersetzung zwischen den Klima-Alarmisten und Klima-Skeptikern. Sollte der wahre Wert der CO2-Klimasensivität bei 2 K oder darunter sein, erübrigt sich jeglicher Streit. Die Auswirkung des anthropogenen CO2 auf die mittlere Erdtemperatur wäre zu gering, um katastrophale Auswirkungen zu erwarten (siehe 4.4.).

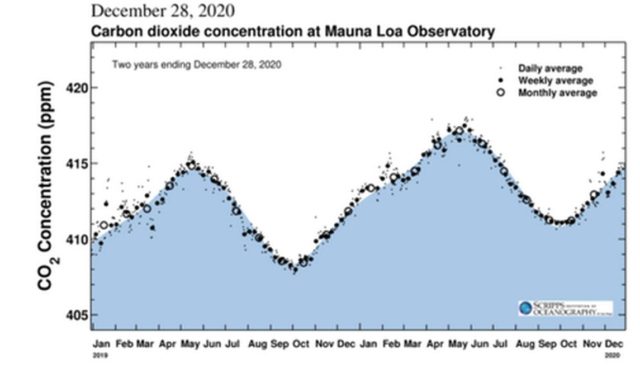

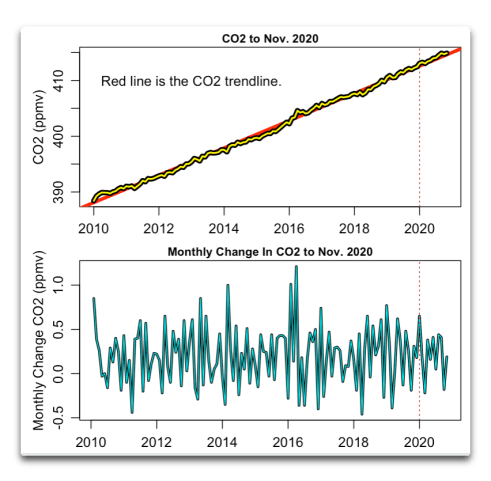

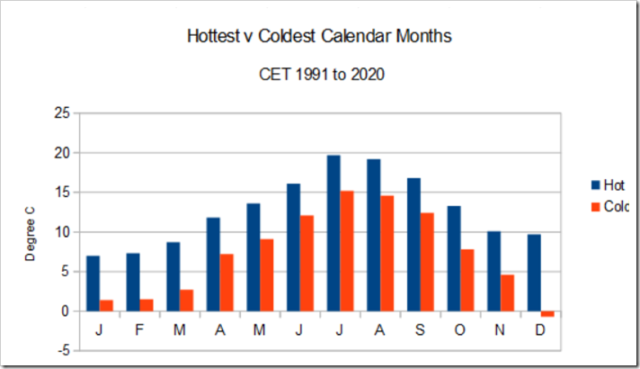

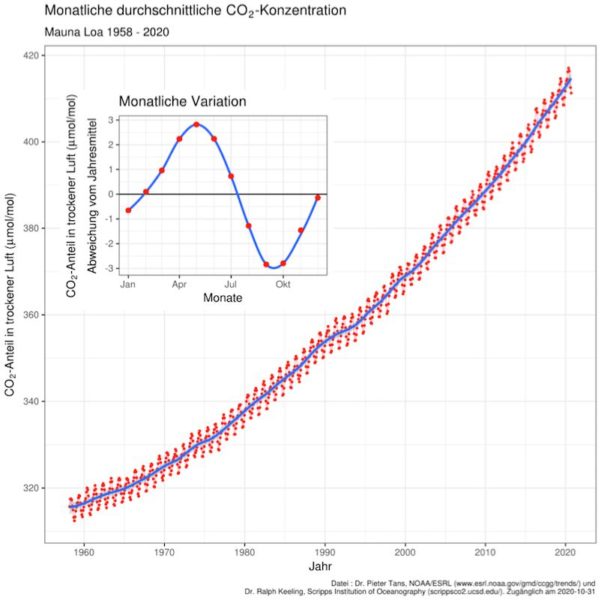

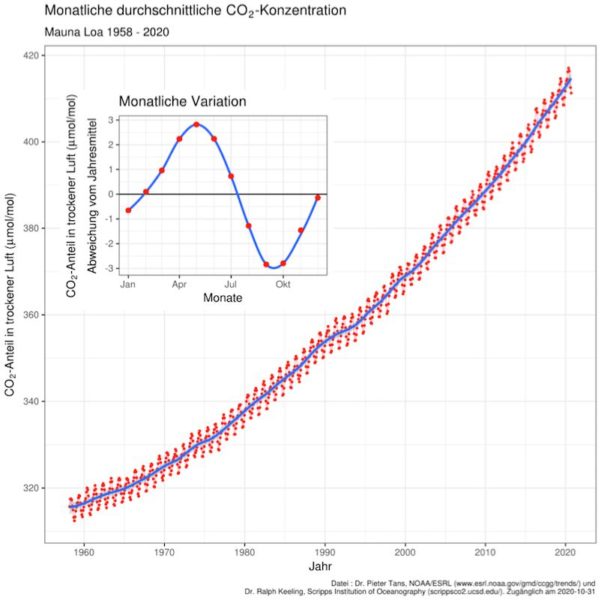

5.3.) Keeling-Kurve: CO2-Konzentration der Atmosphäre seit 1958

Dr. Ralph Keeling hat 1958 begonnen an der meteorologischen Wetterstation auf dem hawaiianischen Vulkan Mauna Loa kontinuierlich die CO2-Konzentration der Atmosphäre zu messen. Deshalb wurde das Diagramm in Abb.5 auch nach ihm als Keeling-Kurve benannt. Seit 1958 steigt die CO2-Konzentration in der Atmosphäre an, hauptsächlich verursacht durch anthropogenen Ausstoß. Hauptverursacher sind Industrie (Prozess-Wärme), Heizen und Verkehr.

5.4.) Zusammenhang von CO2-Konzentration und Temperatur

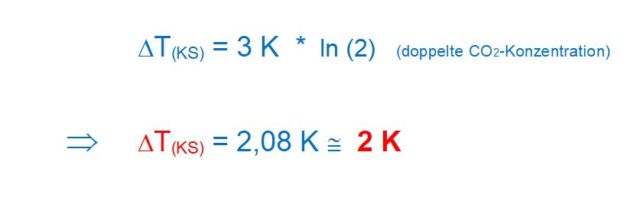

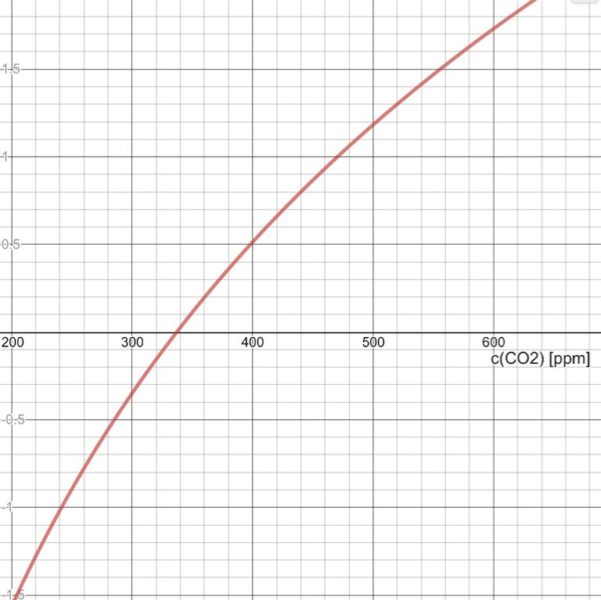

Der mathematische Zusammenhang zwischen CO2-Konzentration und der Temperatur ist den Physikern und Meteorologen bereits lange bekannt. Deshalb wurde auch der Terminus „CO2-Klimasensivität“ eingeführt. Nur bei einer logarithmischen Funktion vergrößert sich der Y-Wert um einen festen Betrag, wenn der X-Wert jeweils verdoppelt wird. Der große Vorteil einer logarithmischen Funktion ist die Unabhängigkeit der Betrachtung, egal wo ein Referenzpunkt auf der X-Achse gesetzt wird. Die ideale Voraussetzung zur Auswertung der relativen GTR-Werte.

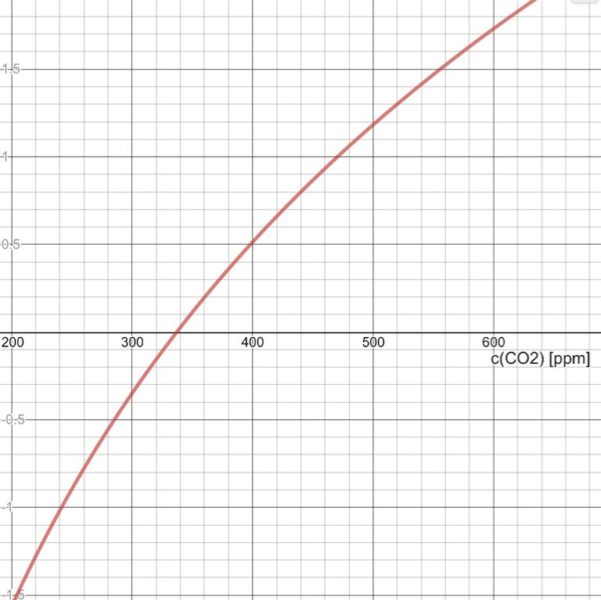

Der Zusammenhang zwischen CO2-Konzentration und Relativ-Temperatur ist somit eine

Logarithmische CO2-Funktion F(GTR) *

Abb 5: Keeling-Kurve. CO2-Konzentration der Atmosphäre seit 1958

Dabei ist die Temperatur-Änderung, F(GTR) ein Proportionalitäts-Faktor, im vorliegenden Fall die Konstante für die GTR-Daten, die CO2-Konzentration und eine Bezugs-CO2-Konzentration.

Die Keeling-Kurve weist für das Jahr 1980 eine CO2-Konzentration von ca. 337 ppm und für das Jahr 2020 eine CO2-Konzentration von 410 ppm aus. Die Temperatur-Differenz zwischen diesen Jahren beträgt ca. 0,60 Kelvin. Somit folgt:

Mit dem ermittelten Proportionalitäts-Faktor lässt sich nun sehr einfach die zugehörige CO2-Klimasensivität berechnen.

Mit dem ermittelten Proportionalitäts-Faktor lässt sich nun sehr einfach die zugehörige CO2-Klimasensivität berechnen.

Abb 6: Ermittelte logarithmische Funktion der CO2-Konzentration anhand der GTR-Daten Y-Achse: in Kelvin

- Abschätzung der CO2-Klimasensivität

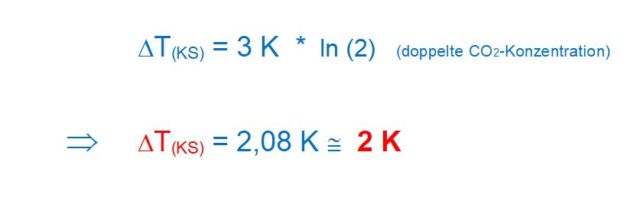

Die aus den GTR-Daten ermittelte rechnerische CO2-Klimasensivität beträgt somit

2 Kelvin. Was sagt dieser Wert aus? Die Voraussetzungen für die gerade ausgeführte Berechnung müssen unbedingt beachtet und angewendet werden.

Der logarithmische Graph, der sich aus der Berechnung ergibt, ist nur dann richtig, wenn ausschließlich das anthropogene CO2 die Erderwärmung bewirkt.

Unter Klimatologen wird weltweit diskutiert und spekuliert. Realistisch betrachtet, sollten maximal 50% der Erderwärmung 4 durch Einbringung großer Mengen an anthropogenem CO2 in die Atmosphäre mit der Erwärmung in Zusammenhang stehen. Die meisten Klimatologen und Klimaskeptiker postulieren niedrigere Werte (10-40%). Somit wird basierend auf den GTR-Daten die CO2-Klimasensivität auf einen Maximal-Wert von etwa 1 Kelvin geschätzt.

7.) Schlussfolgerungen

Die Abschätzung der CO2-Klimasensivität auf Basis der satellitengestützten GTR-Daten liefert ein Ergebnis in einer sinnvollen Größenordnung. Schwäche dieser Untersuchung ist der für Klimatologen kurze Betrachtungszeitraum von 40 Jahren. Der Autor hat sich bewusst darauf beschränkt, nur die in sich konsistenten Messdaten einer einzigen Mess-Quelle zu verwenden, um den im Vorgänger-Artikel [1] ausgearbeiteten Unwägbarkeiten der konventionell gewonnenen Global-Temperaturen aus dem Weg zu gehen.

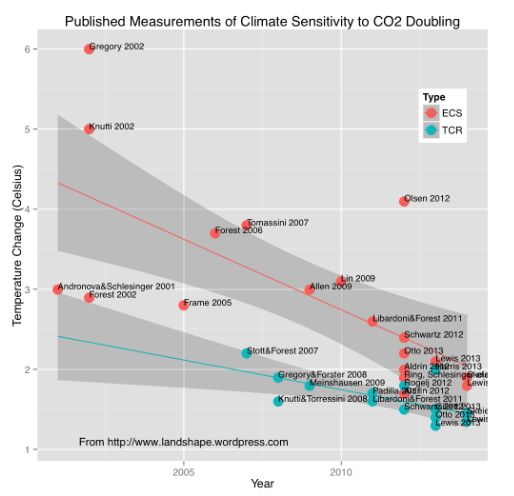

Im Vergleich zu neuen Fach-Publikationen über das Thema CO2-Klimasensivität, die 2017 von Hans Penner 6 in einem Übersichts-Artikel zusammengefasst wurden, bewegt sich das Resultat in guter Gesellschaft. Abgesehen von den Verweisen auf die Werte des IPCC und des PIK-Mitarbeiters Stefan Rahmstorff liegen die Ergebnisse für die CO2-Klimasensivität im Bereich von 0,2 Kelvin bis 1,0 Kelvin. Die vorliegende Arbeit kommt auf einen Maximalwert von etwa 1 Kelvin.

Bereits 2014 veröffentlichte Koelle eine Übersicht der Forschungs-Ergebnisse zur

CO2-Klimasensivität und den zeitlich immer kleiner werdenden Ergebnissen [7].

Abb 7: Übersicht zur Entwicklung der ermittelten CO2-Klimasensivität. Scafetta 2017 [7]

Literatur-Verzeichnis

[1] https://kaltesonne.de/wie-zuverlaessig-sind-die-ermittelten-globaltemperaturen-der-letzten-170-jahre/

[2] https://www.nsstc.uah.edu/climate/

[3] https://www.nsstc.uah.edu/data/msu/v6.0beta/tlt/uahncdc_lt_6.0beta5.txt

[4] https://kaltesonne.de/schweizer-klimaszenarien-ch2018-bis-zur-halfte-der-beobachteten-erwarmung-der-letzte-50-100-jahre-hat-naturliche-ursachen/

[5] https://kaltesonne.de/zwei-weitere-studien-finden-eine-stark-reduzierte-co2-klimawirkung-von-13-grad-pro-co2-verdopplung/

[6] https://www.fachinfo.eu/fi036.pdf (Dr. Hans Penner)

[7] Scafetta et al., International Journal of Heat and Technology, Sept. 2017, Vol. 35, S.18-26