Ich bedanke mich bei der EIKE-Redaktion dafür, dass sie einem breiten Spektrum von konträren wissenschaftlichen Positionen jenseits des wissenschaftlichen „97%“-Mainstreams ein öffentliches Forum bietet. Sehr eigenartig finde ich dagegen die wiederkehrende Kritik einzelner Leser, EIKE würde keine einheitliche Realisten-Position abbilden. Denn eine solche einheitliche Realisten-Position gibt es gar nicht; aber alle diese Positionen konvergieren auf einer Meta-Ebene mit einem „natürlichen atmosphärischen Treibhauseffekt“ als einem „NON-PROBLEM“ und gar keinem oder einem sehr geringem Einfluss des Menschen auf das globale Klimageschehen.

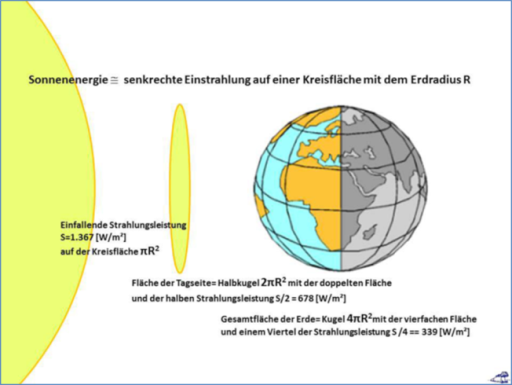

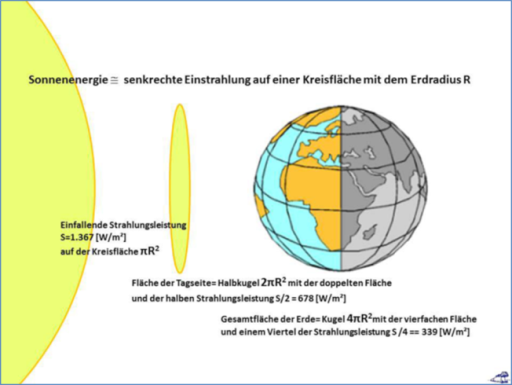

Die wesentlichen Thesen zum sogenannten „natürlichen“ atmosphärischen Treibhauseffekt hatte ich bereits ausführlich diskutiert (Darstellung, Diskussion, Ergebnis). Allein mein hemisphärischer S-B-Ansatz kann die Widersprüche des konventionellen 24h-Tag=Nacht-THE-Ansatzes auflösen. Das THE-Paradigma behandelt Tag und Nacht völlig gleich und tut so, als würde überall auf der Welt zu jeder Zeit eine halbe Sonne mit einer temperaturwirksamen spezifischen Strahlungsleistung von 235W/m² senkrecht einstrahlen. Nun hat aber noch kein THE-Anhänger erklären können, wie aus einer planaren solaren Einstrahlung eine terrestrische radiale Abstrahlung entsteht. Und, was noch viel offensichtlicher ist, eine atmosphärische „Gegenstrahlung“ von ca. 300 W/m²würde verhindern, dass es irgendwo auf unserer Erde jemals kälter als 270K (-3°C) wird. Das konventionelle THE-Modell für unsere Erde mit den globalen Eckwerten von (33°C und 155W/m²) ist also streng eindimensional und beinhaltet keinerlei Abhängigkeit von der Tages- oder Jahreszeit und von der geographischen Breite. Mein hemisphärisches S-B-Modell kann dagegen die „gemessene“ Realität von etwa 15°C widerspruchsfrei abbilden und stimmt mit den tatsächlichen Beobachtungen überein (hier Tabelle 1).

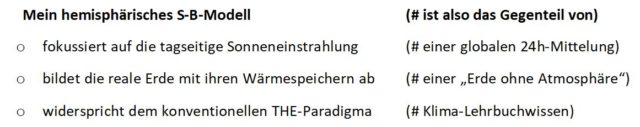

Abbildung 1: Das hemisphärische S-B-Modell für die Temperaturgenese auf unserer Erde

Das 24h=Faktor4-THE-Paradigma benötigt dagegen eine zweite Sonne für die 235W/m² der Nachtseite

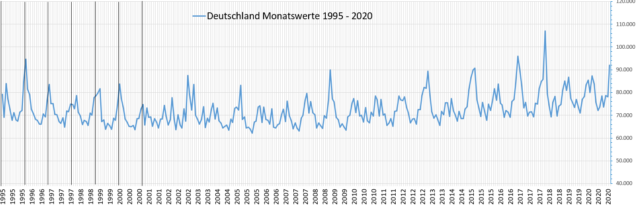

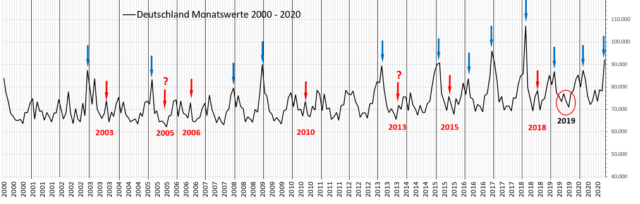

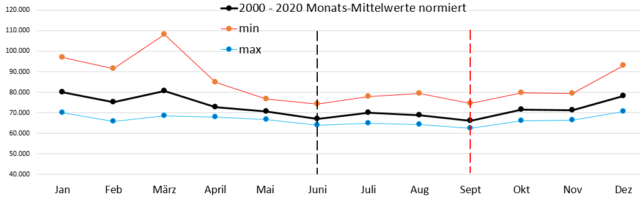

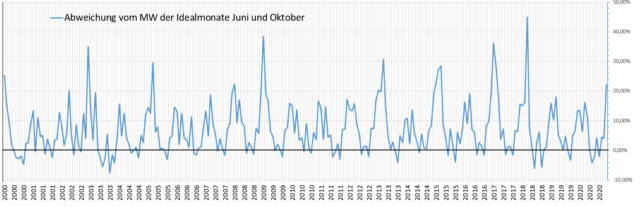

Das hemisphärische S-B-Modell kann als vieljährige Durchschnittsbetrachtung unserer realen Erde die oben genannten räumlichen und zeitlichen Abhängigkeiten der solaren Einstrahlung sehr wohl abbilden und erfasst damit alle drei räumlichen Dimensionen und die Tages-/Jahreszeit bei der Beschreibung der Temperaturgenese auf unserer Erde. Nehmen wir mal ein ganz einfaches Beispiel, die Erzeugung von Solarstrom in Deutschland:

Abbildung 2: Realisierte Erzeugungsleistung und tatsächlicher Stromverbrauch im Zeitraum 14.-25. September 2020 (Quelle: SMARD)

Aus dieser Abbildung wird unmittelbar der natürliche Tag&Nacht-Rhythmus bei der Erzeugung von Solarstrom deutlich. Im Umkehrschluss liefert also der Verlauf der Solarstromerzeugung den Beweis, dass der Wechsel von Tag und Nacht wesentliche physikalische Unterschied beinhaltet, ganz wie es mein hemisphärisches S-B-Modell beschreibt. Und dieser Tag&Nacht-Wechsel sollte sich eigentlich auch korrekt in den Klimamodellen abbilden, die sich aber lediglich auf einen 24h-Tag&Nacht-Durchschnitt stützen. Weiterhin wird die hemisphärische Tag&Nacht-Ungleichheit auf der realen Erde durch das Land-Seewind-System und dessen gegenläufigen Tag#Nacht-Verlauf nachgewiesen. Und auch die sogenannte oberflächennahe „Skin“-Schicht der Ozeane schwankt zwischen bis zu 10 Metern am Tage und weniger als einem Millimeter in der Nacht (hier, erster Absatz).

Kann ein globaler 24h-Durchschnitt solche Tag&Nacht-Unterschiede abbilden? – Nein, das kann er natürlich nicht: Es fängt schon damit an, dass die 24h-Tag&Nacht-Gleichheit des THE-Paradoxons im natürlichen Ablauf von Tag und Nacht gar nicht beobachtet werden kann. Und auch die besten mathematischen Ableitungen verlieren ihre physikalische Aussagekraft, wenn vorher die planare solare Einstrahlung auf der Tageshemisphäre der Erde in einen skalaren globalen Durchschnitt umgewandelt wird. Die Strahlungstransferberechnung leitet also aus der Differenz einer physikalisch fehlerhaften globalen 24h-S-B-Inversion als „Gleichgewichtstemperatur“ für die solare Einstrahlungsleistung (-18°C) und der sogenannten „gemessenen“ globalen Durchschnittstemperatur (NST=14,8°C) den ominösen THE (33°) her. Und auch das immer wieder vorgebrachte Argument, die ominöse „atmosphärische Gegenstrahlung“ würde den 2.HS der Thermodynamik erfüllen, entbehrt jeder physikalischen Beweiskraft.

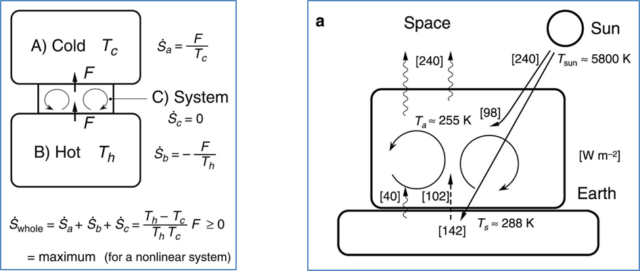

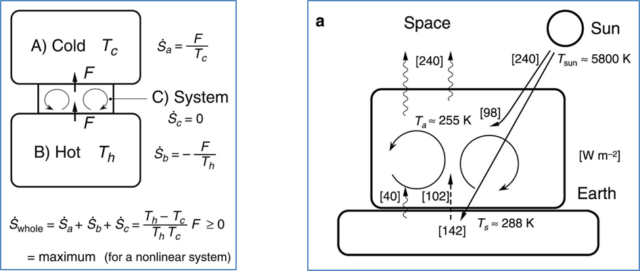

So stellen Ozawa et al. (2003) in einer Veröffentlichung über das Prinzip der maximalen Entropie im globalen Klimasystem ein Berechnungsschema für die Entropie vor und wenden es auf die Erde an:

Abbildung 3: Fig.3 und 5a aus Ozawa et al. (2003) zur Entropie. Links Fig. 3: “A schematic of heat transport through a small system (C) between two thermal reservoirs with different temperatures (A, cold and B, hot). By the heat transport from hot to cold, entropy of the whole system increases…” Übersetzung: Ein Schema des Wärmetransports durch ein kleines System (C) zwischen zwei Wärmespeichern mit unterschiedlichen Temperaturen (A, kalt und B, heiß). Durch den Wärmetransport von heiß zu kalt nimmt die Entropie des gesamten Systems zu… Rechts Fig. 5a: “Energy and entropy budgets for the Earth. (a) Global-mean (surface-area mean) energy flux components (i.e., shortwave radiation, longwave radiation, vertical turbulent heat transport), in W/m². Übersetzung: Energie- und Entropiebudgets für die Erde. (a) Global-mittlere (Oberflächenmittelwert) Energieflusskomponenten (d. h. kurzwellige Strahlung, langwellige Strahlung, vertikaler turbulenter Wärmetransport) in W/m²

Einmal vorausgesetzt, das Schema von Ozawa et al. (2003) zur Ermittlung der Entropie in deren Fig.3 sei korrekt, dann ist es insofern auf die reale Erde adaptiert worden, als dass in deren Fig.5a die allgemein bekannten Durchschnittstemperaturen korrekt aufgeführt worden sind. Allerdings ist deren jeweilige Entsprechung als spezifisches S-B-Strahlungsäquivalent quantitativ nicht nachzuvollziehen. Zunächst fehlt in Fig.5a schon einmal die Solarkonstante von 1.367W/m², die schließlich das maximal mögliche S-B-Temperaturäquivalent von ca. 120°C auf unserer Erde bestimmt. Vielmehr wird dort der temperaturwirksame Anteil der solaren Einstrahlung nach dem Faktor4-Tag=Nacht-THE-Flacherdeansatz mit 240W/m² entsprechend einem S-B-Temperaturäquivalent von (-18°C=255K) beziffert. Und erstaunlicherweise taucht die ominöse „atmosphärische Gegenstrahlung“ im Betrag von 300-333W/m² ebenfalls nicht auf, sodass diese Abbildung aus sich heraus gar nicht erklären kann, wie sich aus einer Einstrahlung von 142W/m² an der Erdoberfläche die angegebenen 288K herleiten sollen; denn die (vernachlässigbare) natürliche mittlere Wärmestromdichte aus dem Erdinneren beträgt an der Erdoberfläche lediglich 0,065W/m².

Anmerkungen: Eine wissenschaftliche Abbildung sollte insoweit vollständig sein, als dass sie alle wesentlichen Komponenten zum Verständnis des beschriebenen Vorgangs enthält. Die näheren Erläuterungen können dann im Fließtext erfolgen. Eine unvollständige Abbildung, die ausgerechnet strittige Komponenten wie die ominöse „atmosphärische Gegenstrahlung“ ausschließt, ist völlig inakzeptabel und wahrscheinlich nicht einmal für THE-Gläubige verständlich.

Erklärung für den Begriff „Entropie“, Zitat Wikipedia: „In einem sich selbst überlassenen System in einem beliebigen Anfangszustand bewirken dann die spontan ablaufenden inneren Vorgänge, dass der Zustand des Systems sich mit größter Wahrscheinlichkeit demjenigen Makrozustand annähert, der bei gleicher Energie durch die größte Anzahl verschiedener Mikrozustände realisiert sein kann, also die höchstmögliche Entropie hat.“ Das ist schwerer Tobak, eine recht gute Ableitung findet man hier auf EIKE.

Und hier noch ein ganz einfaches Beispiel aus dem vollen Leben: Das Kinderzimmer war eben noch aufgeräumt, dann haben die lieben Kleinen den ganzen Nachmittag gespielt und am Ende herrscht dort Chaos. Im Kinderzimmer hat sich damit die Entropie als Maß für dessen Unordnungszustand erhöht. Und um diese Unordnung dann wieder zu beseitigen, müssen Sie Arbeit (=Leistung*Zeit) verrichten. Denn jedes System, auch das Kinderzimmer, kann seine Entropie nicht ohne zusätzlich eingebrachte Arbeit wieder verringern.

Ergebnis: Der 2. Hauptsatz der Thermodynamik macht auch vor dem Kinderzimmer nicht halt, denn die Aufräumungsarbeiten im Kinderzimmer machen sich nun mal nicht von alleine…

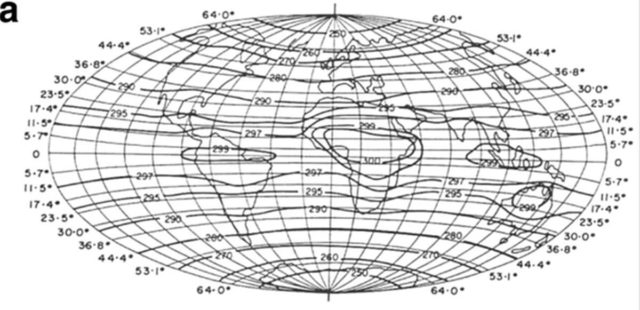

Fassen wir zusammen: Die von Ozawa et al. (2003) in Fig. 5a angegebenen Werte für die spezifische Strahlungsleistung entstammen einem unvollständigen Faktor4-Tag=Nacht-THE Flacherdeansatz und treffen daher nicht auf die reale Erde mit Tag und Nacht zu. Aber die dort angegebenen Temperaturen stimmen dann erstaunlicherweise trotzdem mit den realen Werten überein, Oberflächentemperatur gleich 288K (~+15°C) und Temperatur auf der „Abstrahlungshöhe“ von ca. 5.000 Metern gleich 255K (~-18°C). Ozawa et al. (2003) sagen nun, die theoretischen Abschätzungen von Paltridge (1978) würden in annehmbarer Übereinstimmung mit den tatsächlichen Beobachtungen stehen:

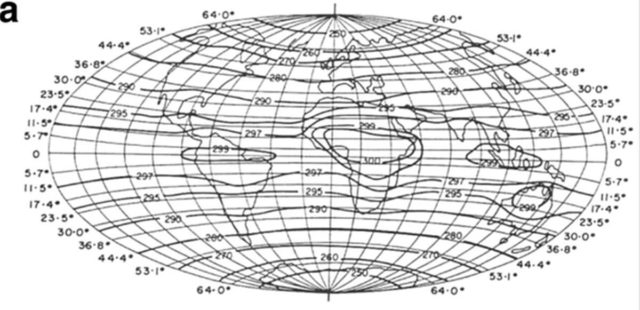

Abbildung 4: “Global distribution[s] of (a) mean air temperature, …, predicted with the constraint of maximum entropy production (equation (9)). Reprinted from Paltridge [1978]” aus Ozawa et al. (2003, Figure 4) Übersetzung: Globale Verteilung(en) von (a) mittlerer Lufttemperatur,…, vorhergesagt unter der Bedingung der maximalen Entropieproduktion (Gleichung (9)). Nachdruck aus Paltridge [1978]

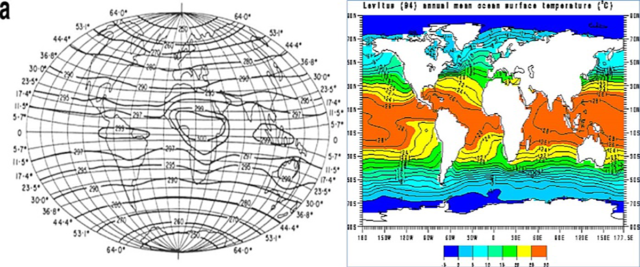

Deutlich wird hier allerdings, dass die 273K (~0°C) Isotherme bei Paltridge (1978) deutlich polferner (um 50° N und S) verläuft, als die durchschnittliche Oberflächentemperatur der Ozeane in der NASA-Abbildung (um 70° N und S):

Abbildung 5: Globale Durchschnittstemperaturen (Abbildungen in E-W-Richtung gestaucht) Links: Paltridge [1978] aus Ozawa et al. (2003, Figure 4) “Global distribution[s] of (a) mean air temperature, …, predicted with the constraint of maximum entropy production (equation (9)).” Rechts: NASA “Annual Mean Ocean Surface Temperature” based on observed data up until 1994

Wir können also feststellen, dass der Faktor4-Tag=Nacht-THE-Flacherdeansatz trotz unklarer/fehlender Zwischenschritte von einer fehlerhaften „Gleichgewichtstemperatur“ (-18°C) zu einem vergleichbaren Ergebnis wie die tatsächlich gemessenen Daten (+15°C) kommt, sich also in der Zielsetzung streng an der gemessenen Realität orientiert. Ergebnis ist eine MATHEMATISCHE Strahlungstransfer-Berechnung zwischen einer PHYSIKALISCH fehlerhaften „Gleichgewichtstemperatur“ und der sogenannten „gemessenen globalen Durchschnittstemperatur“. Diese Lücke zwischen fehlerhafter Theorie und gemessener Realität wird dann mathematisch durch eine willkürliche „atmosphärische Gegenstrahlung“ als imaginärer Antrieb eines „natürlichen atmosphärischen Treibhauseffektes“ von 33° geschlossen, die dem 2.HS der Thermodynamik widerspricht. Denn ein Übergang von Wärme von einem kalten zu einem wärmeren Körper ist PHYSIKALISCH nach dem 2.HS der Thermodynamik ohne zusätzlich aufgebrachte Arbeit völlig unmöglich, wie eben auch das Aufräumen eines Kinderzimmers.

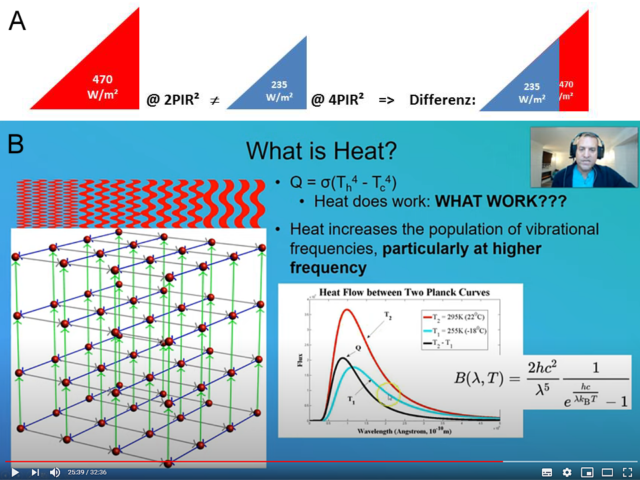

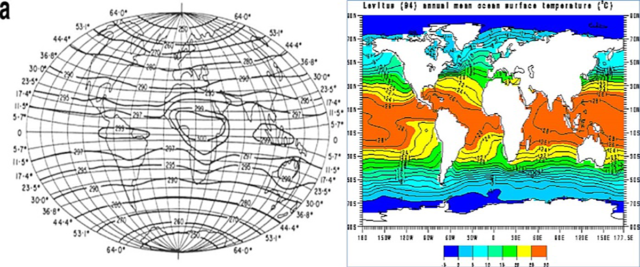

In der nachfolgenden Abbildung wird ein älteres Beispiel aus meinem hemisphärischen Modell, das die Entropie der solaren Strahlungsleistung beschreibt (A), durch eine aktuelle Abbildung von Joe Postma (B) nochmals bestätigt:

Abbildungen 6 A&B zum Wärmetransport nach dem 2.HS der Thermodynamik

A – Abbildung Weber: Der Strahlungsdurchschnitt von 470 W/m² (korrekt: 940W/m²*cosPHIi) umfasst einen Strahlungsbereich von 0-940W/m² für die tagseitige Hemisphäre mit einem maximalen S-B-Temperaturäquivalent von 85,7°C @ 940W/m². Bei der globalen Mittelung der tagseitigen solaren Einstrahlung (235W/m²) fällt also genau derjenige Teil der spezifischen solaren Strahlungsleistung (größer 235W/m²) weg, der Temperaturen oberhalb von (-18°C) erzeugen kann.

B – Abbildung Postma: Die schwarze Kurve zeigt die Differenz der IR-Spektren von (22°C=rot) und (-18°C=blau). Es wird deutlich, dass das (-18°C)-Spektrum diese Differenz, insbesondere zu den hohen IR-Frequenzen hin, gar nicht im erforderlichen Umfang enthält.

ERGO: Beide Abbildungen 6 A und B beweisen, dass ein kalter Körper (=hohe Entropie) gar nicht die notwendige physikalische Ordnung besitzt, um einen wärmeren Körper (=geringe Entropie) noch weiter zu erwärmen. Die Entropie erklärt übrigens auch die allgemein bekannten Vorgänge in der unbelebten Natur, beispielsweise die geologische Erosion. Denn während die inneren Kräfte der Erde gerade neue Gebirge auftürmen, beginnt an der Oberfläche bereits deren Erosion. Und das Ergebnis dieser Erosion landet zunächst als Erosionsschutt an der tiefsten topographischen Stelle mit der geringsten potentiellen Energie, also in irgendeinem Tal. Um diesen Schutt dann weiter zu bewegen, sind erneut Kräfte erforderlich, diesmal die Kräfte des gravitativ abfließenden Wassers.

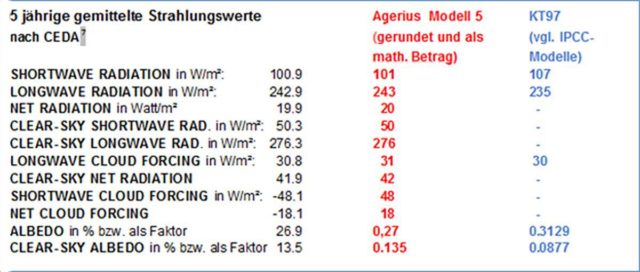

Und die Entropie würde selbstverständlich auch „zerstreuend“ auf einen äquatorialen Hotspot wirken. Und deshalb kann sich ein solcher Hotspot nur in einem Computerprogramm entwickeln, das nach dem 24hTag=Nacht-THE-Ansatz entwickelt worden ist. Nach 10, 100, 1000 oder noch mehr 24h-Tag=Nacht-Zyklen entsteht dann eine solche digitale Wissenschaftsschimäre aus einem physikalischen Ansatz, der nicht mit der alltäglichen Tag#Nacht-Beobachtung in der realen Welt übereinstimmt. Und deshalb konnte dieser theoretische Hotspot bisher auch noch nirgendwo nachgewiesen werden, wie die nachstehende Abbildung aus Henney & Monckton zeigt:

Abbildung 7: (a) prophezeites und (b) gemessenes vertikales Temperaturprofil der Atmosphäre – links: IPCC (2007, Abb. 9.1c), rechts: Lanzante et al. (2006) (Abbildung 15 aus Henney & Monckton)

Denn ein solcher äquatorialer Hotspot würde eine ständige solare Energiezufuhr erfordern, wie sie nur rein rechnerisch in einem 24h-Tag=Nacht-Modell vorhanden ist. Die Realität des täglichen 24h-Zykus wird dagegen regelmäßig durch die hemisphärische Nacht unterbrochen. Und in dieser hemisphärischen Nacht wirkt die Entropie zerstreuend auf die geringste herausgehobene Energiekonzentration, sodass sich ein solcher vorhergesagter Hotspot aus 24h-durchschnittlichen Computerberechnungen in der Realität niemals aufbauen kann. Joe Postma fasst eine solche Situation mit den Worten zusammen, „Kann man Laufen speichern, um schneller zu laufen?“.

Die menschengemachte Klimakatastrophe ist auf eine Physik-Wende zurückzuführen

Highspeed-Computerspekulationen sind die Astrologie unserer Tage. Aufgebaut auf undurchsichtigen und/oder unzureichenden Algorithmen verbreiten sie Zukunftsvisionen, ohne je den Beweis für die physikalische Richtigkeit ihrer Algorithmen an historischen Daten nachgewiesen haben zu müssen. Und solange die Freiheit der Wissenschaft darin besteht, voll alimentiert gesellschaftspolitisch erwünschte Ergebnisse liefern zu dürfen, wird sich daran auch nichts ändern; den Plot dazu finden Sie hier. Das politisch und medial allgegenwärtige „Hört auf DIE Wissenschaft!“ müsste nämlich eigentlich heißen, „Hört auf UNSERE Wissenschaft!“.

Das hemisphärische S-B-Modell definiert den THEORETISCHEN GRENZWERT der terrestrischen Temperaturgenese aus sich selbst heraus zu (+15°C) und stimmt ohne einen sogenannten THE mit der „gemessenen globalen Durchschnittstemperatur“ von (+15°C) überein. Diese (+15°C) sind übrigens nur abhängig von der Solarkonstanten und der terrestrischen Albedo. Das THE-Paradigma definiert dagegen den fehlerhaften ANFANGSWERT („Gleichgewichtstemperatur“ von -18°C) seiner atmosphärischen Resonanzfunktion (-18°C=>Gegenstrahlung=>THE=>+15°C), kann aber einen konkreten Endpunkt dieser Resonanz aus sich selbst heraus gar nicht bestimmen. Es rekurriert mit seiner „Gegenstrahlung“ vielmehr direkt auf die „gemessene globale Durchschnittstemperatur“, und das könnten dann auch (-5°C), (+20°C) oder (+45°C) sein. So würden beispielsweise die Schwankungen des Paläoklimas allein durch eine veränderte „Gegenstrahlung“ erklärt werden können, man muss dort einfach nur die erforderlichen Zahlenwerte einsetzen.

Also noch einmal in aller Kürze: Es gibt keinen „natürlichen atmosphärischen Treibhauseffekt“, weil die Sonne nur am Tage scheint. Denn Photonen wandeln sich nun mal nicht freiwillig von kurzwellig (solar=niedrige Entropie) zu langwellig (terrestrisch=hohe Entropie) um; dazu bedarf es vielmehr in einem Zwischenschritt der Erwärmung von Materie, und das ist nur auf der Tagseite der Erde möglich:

(Solare HF-Einstrahlung) => (Erwärmung von Materie @2PIR²) => (IR-Abstrahlung @4PIR²)

Solange aber der Klimamainstream den längst widerlegten Hockeystick, der ein konstantes Paläoklima in den IPCC-Bericht AR3 hinein gezaubert hatte, weiterhin als Vorhersagekrücke benutzt, liefert eine Physik-Wende die für einen anthropogenen Klimawandel zwingend erforderliche sogenannte „Klimasensitivität“ des CO2-Moleküls. Und schon hat man sich durch eine solche Physik-Wende in den Klimawissenschaften einen schönen neuen CO2-Motor für das Paläoklima gebastelt, der dann eine Energie-Wende erfordert – und eine Agrar-Wende – und eine Verkehrs-Wende – und eine Industrie-Wende – und schließlich auch noch den Großen Reset mit einer anthropogenen Existenz-Wende zurück in ein ökologisches, ökonomisches und intellektuelles Mittelalter. Diesem Wahnsinn steht nicht nur mein hemisphärisches S-B-Modell entgegen, sondern auch das Aktualitätsprinzip der Geologie – aber wer kennt das nach der Bildungs-Wende überhaupt noch…

Es folgen drei Beispiele für den Fußabdruck meines hemisphärischen S-B-Modells in den real existierenden Klimawissenschaften: Das hemisphärische S-B-Modell ermöglicht in Form von einfachsten Plausibilitäten einen qualitativen Blick auf die räumlichen und zeitlichen Abhängigkeiten des Klimageschehens auf unserer realen Erde und entzaubert damit die supercomputer-gestützten Weissagungen der modernen Klimaforschung.

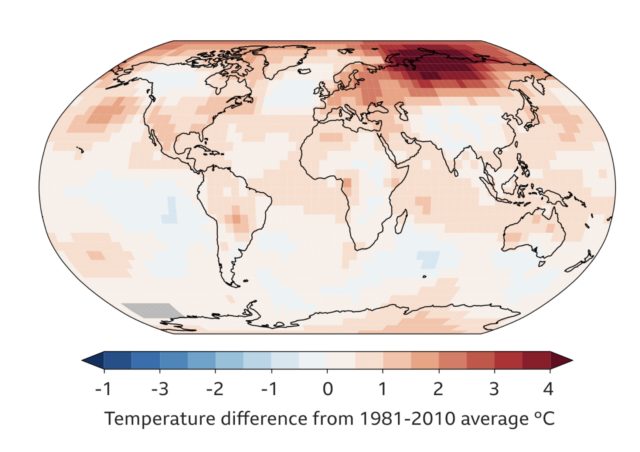

1. Beispiel: Die Sommerpole unserer Erde sind gar keine Temperatur-Hotspots.

Klimamodelle sind nicht in der Lage, die von jedermann zu beobachtende Realität in Form des natürlichen Wechsels von Tag und Nacht abzubilden. Und wenn dort auch noch auf die Polarzonen fokussiert wird, dann kommt es zu ganz eigenartigen klimawissenschaftlichen Stilblüten, die sich wiederum jeder realen Beobachtung entziehen. Eine der Kernerzählungen der Klimareligion ist das Abschmelzen der Polkappen durch den „menschengemachten Klimawandel“, wodurch weite Teile der heute besiedelten Tiefländer der Welt unbewohnbar werden sollen. Manche Klimarealisten sehen in dem Spiegel-Titel „Die Klima-Katastrophe“ Nr. 33/1986 mit dem versinkenden Kölner Dom den Beginn der medialen Klimahysterie.

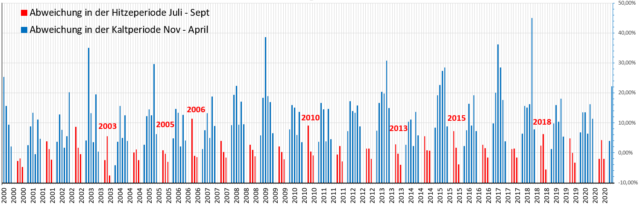

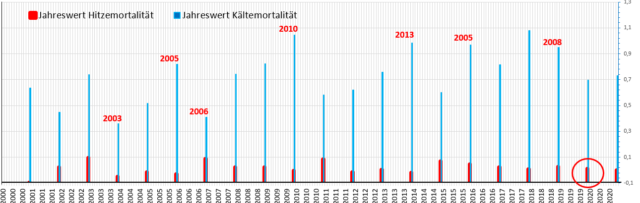

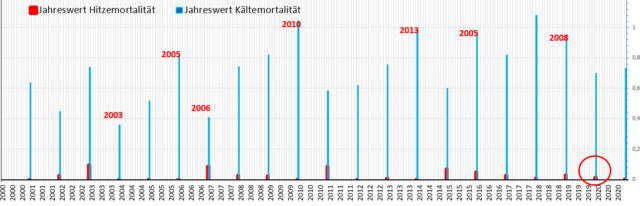

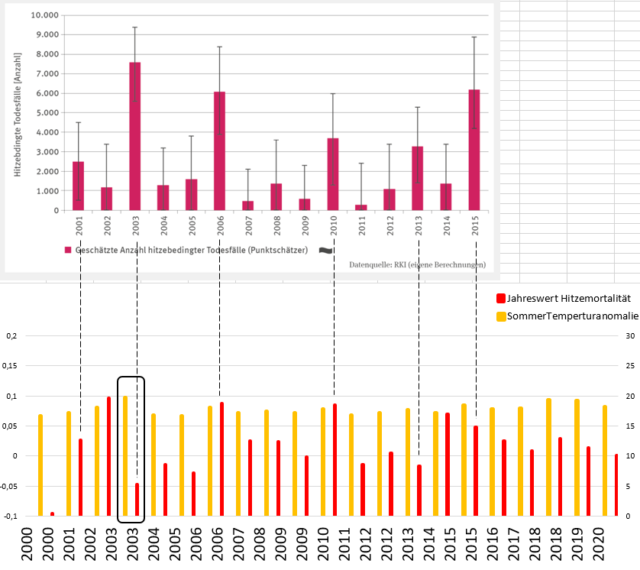

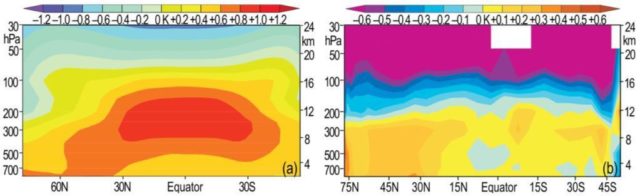

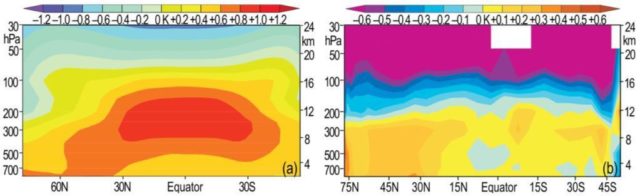

In der Mainstream-Klimawissenschaft ist es üblich, die physikalischen Einheiten „Leistung (WATT)“ und „Arbeit (JOULE = WATT x ZEIT)“ über die ZEIT, meist den 24h-Tag, nach Belieben aus der jeweils anderen Größe abzuleiten. Der sogenannte „natürliche atmosphärische Treibhauseffekt“ leitet sich nun wiederum aus einer globalen 24-Stunden Mittelung der solaren Einstrahlung her, bei der ein gemeinsamer Mittelwert der Sonneneinstrahlung für Tag und Nacht für die Weiterverwendung in Klimamodellen berechnet wird. Das bedeutet, die tagseitige Sonneneinstrahlung (Solarkonstante S0=1.367W/m²) wird rechnerisch so verteilt, als würde überall auf der Welt zu jeder Zeit eine halbe Sonne mit einer temperaturwirksamen spezifischen Strahlungsleistung von lediglich 235W/m² (=S0*(1-Albedo)/4) senkrecht einstrahlen. Und um diesen physikalisch fehlerhaften Ansatz etwas zu verbessern, führen manche Wissenschaftler nun eine breitenabhängige (zonale) Mittelung der globalen Sonneneinstrahlung ein. So wird, wie bereits gezeigt wurde, aus 24h-Zeitintegralen der solaren Strahlungsleistung ein physikalisch sinnfreier breitenabhängiger spezifischer Leistungsdurchschnitt abgeleitet, der am Ende zu rein rechnerischen Temperaturen jenseits jeglicher realer Beobachtungen führt, wie die nachstehende linke Abbildung mit dem jeweiligen Sommerpol als globaler Temperatur-Hotspot beweist:

Abbildung 8: Vergleich der „Daily mean values of (a) slab temperature” von Kramm et al. (2017) – Creative Commons License CC BY 4.0 (links) mit dem Jahresverlauf des örtlichen Maximums der breitenabhängigen temperaturwirksamen spezifischen Strahlungsleistung der Sonne (rechts)

Die tatsächliche Maximaltemperatur auf unserer Erde wird zwischen den Wendekreisen und bis in mittlere Breiten der Sommerhemisphäre erreicht. Die Sommerpole unserer Erde sind nämlich gar keine Temperatur-Hotspots, sondern dort ist lediglich die aus einer 24h-durchschnittlichen ARBEIT in JOULE abgeleitete 24h-Durchschnittsleistung ((Leistung @ 24h)/24h) aufgrund der polaren Tageslängen um die jeweilige Sommersonnenwende global gesehen am größten („Max. Arbeit“ in der nachfolgenden Abbildung 9 rechts). Und aus solchen 24h-Durchschnittswerten sollte man tunlichst keine Ortstemperaturen ableiten, sonst kommt es halt zu wissenschaftlichen Verwerfungen…

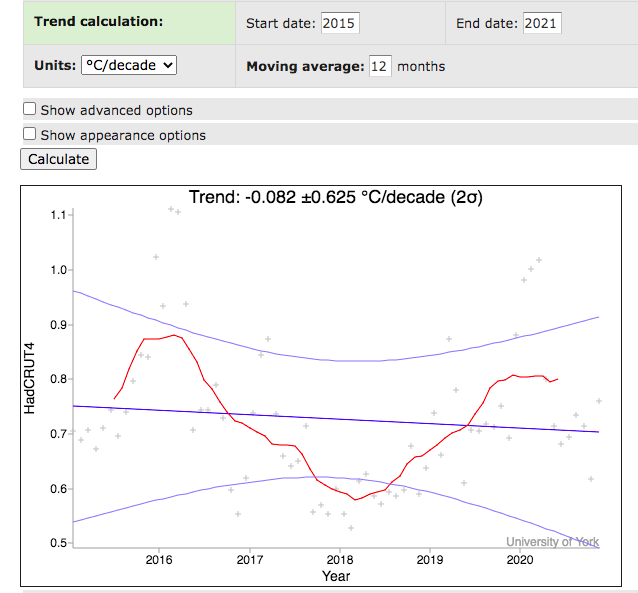

2. Beispiel: Die „menschengemachten“ IPCC-Temperaturdifferenzen bilden lediglich das chaotische globale Wettergeschehen ab.

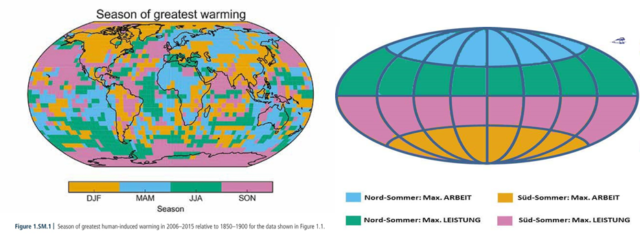

Der sogenannte „natürliche atmosphärische Treibhauseffekt“ soll durch eine „atmosphärische Gegenstrahlung“ verursacht werden, die wiederum aus der IR-Abstrahlung unserer Erde gespeist wird. Die beiden ursächlichen Steuergrößen für eine solche „atmosphärische Gegenstrahlung“, nämlich die aus den solaren Primärantrieben „tägliches solares Strahlungsmaximum“ und „örtliche Tageslängen“ induzierte Gesamtwärmemenge, lassen sich sekundär unter „jahreszeitlich maximale örtliche IR-Abstrahlung der Erde“ subsummieren. Der nachfolgende graphische Vergleich zeigt, dass die erforderliche Übereinstimmung zwischen den „menschengemachten“ IPCC-Temperaturdifferenzen und der maximalen örtlichen IR-Abstrahlung unserer Erde in der Farbgebung der IPCC-„Figure 1.SM.1“ jahreszeitlich nicht prägnant hervortritt:

Abbildung 9: Vergleich der IPCC-„Figure 1.SM.1“ (links) mit den tentativen jahreszeitlichen Auswirkungen von maximaler spezifischer solarer Strahlungsleistung und/oder maximaler örtlicher Tageslänge auf den sogenannten THE (rechts)

Anmerkung: Die jeweils zweistufige Farbskala für die Sommerhemisphäre in der Abb. links (Beispiel MAM und JJA für den Nordsommer) wurde im rechten Bild willkürlich in zwei einstufige Skalen für LEISTUNG (~JJA) und ARBEIT (~MAM) auf der jeweiligen Sommerhemisphäre aufgespalten und (nicht flächentreu) der tatsächlichen geographischen Lage zugeordnet. Deshalb können Farbsignaturen für Leistung/Arbeit (~JJA/MAM) in der jeweiligen geographischen Lage auch in umgekehrter Signatur (~MAM/JJA) auftreten; beispielsweise blau für LEISTUNG zwischen Äquator und mittleren Breiten.

Eigentlich müsste sich in der IPCC-Abbildung „Jahreszeit der größten menschen-induzierten Erwärmung für den Zeitraum 2006-2015“ der zusätzliche THE-Anteil aus dem „menschengemachten“ CO2 aufgrund seiner vorgeblichen IR-Abhängigkeit als Temperaturanomalie proportional zur jahreszeitlich maximalen örtlichen IR-Abstrahlung unserer Erde abbilden. Das ist aber ganz offensichtlich nicht der Fall, denn insgesamt finden wir in „Figure 1.SM.1“ lediglich eine globale und unspezifische jahreszeitliche Durchmischung und sogar jahreszeitlich stark gegenläufige Anomalien. Der vorstehende Vergleich von „Figure 1.SM.1“ (links) mit den tentativen Auswirkungen der jahreszeitlich maximalen örtlichen IR-Abstrahlung aus meinem hemisphärischen S-B-Modell (rechts) verdeutlicht vielmehr, dass sich die erratisch verteilten Temperaturanomalien nicht mit den jahreszeitlichen Schwankungen erklären lassen, sondern viel eher mit deren zeitlicher Veränderung (also der 1. Ableitung), wobei das Maximum dieser Veränderung um die Äquinoktien liegt und jeweils beide jahreszeitlichen Hemisphären betrifft. Die „menschengemachten“ IPCC-Temperaturdifferenzen bilden also lediglich das chaotische globale Wettergeschehen ab.

3. Beispiel: Der experimentelle Nachweis für den hemisphärischen S-B-Ansatz ist anhand von Satellitenmessungen gelungen.

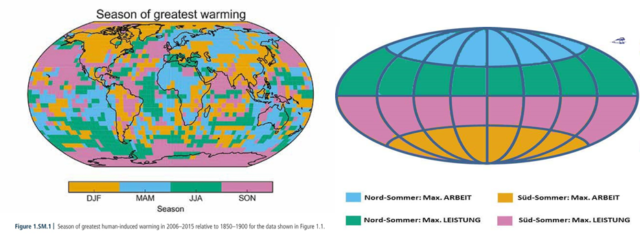

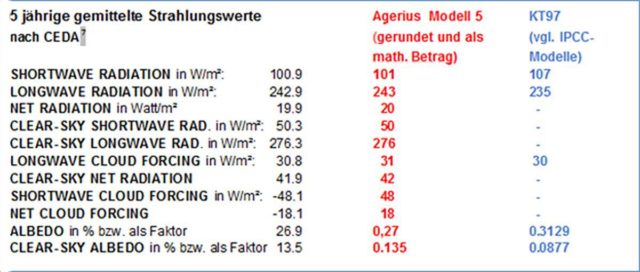

Das IPCC-Modell KT97 gilt als Grundlage für alle computergestützten Klimamodelle. Herr Albert (Aulus) Agerius hatte auf Grundlage meines hemisphärischen Strahlungsmodells ein alternatives Klimamodell erstellt. In seinem Buch „Kritische Analyse zur globalen Klimatheorie: Widerlegung der Basisstudie KT97 des IPCC mit den Messwerten des ERBS Satelliten an einem neuen Modell“ deckt er erhebliche Widersprüche in der IPCC-Basisstudie KT97 auf:

Tabelle 1: Satellitenmesswerte des ERBS Satelliten in einem Modellvergleich (Quelle: A. Agerius)

Dem IPCC-Modell KT97 gelingt es also lediglich, 5 von 11 Messreihen abzubilden. Diesem IPCC-Modell KT97 stellt Agerius nun sein „Modell 5“ entgegen, das alle 11 Messreihen ohne einen atmosphärischen Treibhauseffekt abbildet und damit meinen hemisphärischen S-B-Ansatz voll betätigt.

Zum besseren Verständnis können Sie einmal die Perspektive eines Satelliten einnehmen: Die planare solare Einstrahlung erfolgt auf einer Kreisfläche (PIR²) und die jeweiligen Messwerte beziehen sich auf Schnittpunkte solcher Einstrahlungsflächen mit der entsprechenden Satellitenbahn (@4PIR²). Die Satellitenmesswerte für die Solarkonstante können die Erdkrümmung also gar nicht abbilden.

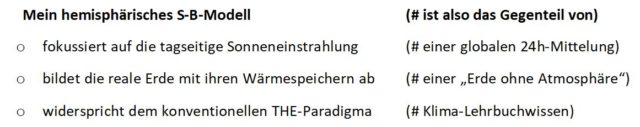

Nachtrag: Ich bitte höflich darum, im Interesse der objektiv interessierten Leser auf kreative Designerzitate und daraus abgeleitete sophistische Skandalisierungen zu verzichten. Das Stilmittel der sophistischen Skandalisierung einer ausschließenden gegenteiligen Eigenschaft (Disjunktion) fällt sofort auf, wenn es sich um Alltagswissen handelt. Ein Beispiel für den offensichtlichen Widersinn eines solchen skandalisierenden Sophismus‘ wäre die Aussage: „Der Dieselmotor widerspricht dem Prinzip der Elektromobilität“. Bei wissenschaftlichen Zusammenhängen, die zur Beurteilung einer Aussage zumindest die inhaltliche Abgrenzung zwischen Fachbegriffen erfordern, ist eine solche sophistische Skandalisierung für den interessierten Leser dagegen sehr viel schwerer zu erkennen, wie die nachfolgende Aussage beweist: „Ausgehend von dem Begriff des ‚solaren Klimas‘ wird nachgewiesen, dass die von Herrn WEBER (2019) in seinem Beitrag aufgestellten Behauptungen zur Ermittlung der global gemittelten Oberflächentemperatur einer Erde ohne Atmosphäre mit den theoretischen Grundlagen unvereinbar sind.“ Solche sophistischen Gegenargumente lassen sich nämlich für mein hemisphärisches S-B-Modell mittels einer oder mehrerer ausschließender gegenteiliger Eigenschaften jederzeit zurechtbiegen:

Sie können jetzt also sehr einfach mein hemisphärisches S-B-Modell skandalisieren, indem Sie ihm die Nichterfüllung seiner rechts aufgeführten ausschließenden Gegensätze vorhalten, also: Das hemisphärische S-B-Modell von Weber ist Mist, weil es

- dem Prinzip der globalen Mittelung widerspricht,

- dem Prinzip einer „Erde ohne Atmosphäre“ widerspricht,

- dem anerkannten Lehrbuchwissen nach (Professor Dr. Beliebig) widerspricht.

Vielleicht erkennen Sie in diesen Aussagen ja den einen oder anderen Kommentar zu meinem hemisphärischen S-B-Modell wieder; sachlich korrekt oder gar verständnisfördernd sind solche Sophismen jedenfalls nicht. Für seriöse Verständnisfragen verweise ich gerne nochmals auf den Vergleich meines hemisphärischen Modells mit den wesentlichen Thesen zum sogenannten „natürlichen“ atmosphärischen Treibhauseffekt (Darstellung, Diskussion, Ergebnis) oder dessen direkten Abgleich mit dem sogenannten THE (hier Tabelle 1).

Einer physikalischen (nicht mathematischen) Beweisführung über eine Übereinstimmung der ominösen Faktor4-Tag=Nacht-Flacherde mit der tatsächlich beobachteten Tag#Nacht-Realität sehe ich mit Interesse entgegen.