Grönländische Eisdecke schmilzt aufgrund geothermischer Aktivitäten von unten her

Der Gakkelrücken [2] ist eine gigantische Kette von Unterwasservulkanen, die sich 1.800 Kilometer unterhalb des arktischen Ozeans von der Nordspitze Grönlands bis nach Sibirien zieht. Mit seinen tiefen Tälern und seinen Gipfeln (5.000 Metern über dem Meeresboden) ist er mächtiger als die Alpen.

Ins Deutsche übersetzt schreibt Kamis [1]: „Klimaforscher, die die Theorie der vom Menschen verursachten globalen Erwärmung befürworten, behaupten seit vielen Jahren, dass die beschleunigte Schmelzrate des arktischen Meereises im Zeitraum 1999-2007 ausschließlich auf vom Menschen verursachte CO2-Emissionen zurückzuführen ist, die die Atmosphäre schnell erwärmten. Dieses ungewöhnliche Schmelzen der Arktis war größer als die Schmelzrate, die mit der anhaltenden und sehr normalen Schmelzrate der Erde nach der Eiszeit von 11.500 Jahren verbunden ist. Viele Klimaforscher haben sich widerwillig an diese vom Menschen verursachte Erwärmung der Atmosphäre gehalten, obwohl verschiedene und überzeugende Datenmengen diese Hypothese jetzt ernsthaft in Frage stellen.

Den meisten Wissenschaftlern ist klar, dass nicht-atmosphärische Naturkräfte die dominierende Rolle bei der Ausdehnung und Dicke des Meereises spielen, wie bekannte Variationen der astronomischen Umlaufbahnmuster der Erde, langfristige zyklische Änderungen der Strömungsmuster der Tiefsee und vor allem Variationen in geologisch induzierter Wärme und chemisch verursachtem Flüssigkeitsstrom aus Tiefseefeldern und Vulkanen.

Das kleine geologisch induzierte Wärme- und Flüssigkeitsströmungsereignis in der Tiefsee vom 12. Oktober zeigt auf überzeugende Weise, dass geologische Kräfte immer noch aktiv sind und die Energie haben, das arktische Klima zu verändern und Meereis zu schmelzen.

Denken Sie daran, dass dieses jüngste Ereignis vom 12. Oktober nicht mit Erdbeben und Vulkanausbrüchen verbunden war, wie dies während des Ereignisses von 1999 bis 2007 der Fall war. Dieses frühere Ereignis war gewaltig, aber für diejenigen, die seine wahre Natur nicht verstanden hatten, nicht maßgeblich. Obwohl es mit einer Folge ausgedehnter Erdbeben geringer Intensität, einer enormen Methanfreisetzung und einer bedeutenden Reihe von Vulkanausbrüchen entlang des Gakkelrückens verbunden war, wurde und wird es von den meisten Klimaforschern, die die Theorie der vom Menschen verursachten Erderwärmung befürworten, als unbedeutend für die Erwärmung abgetan.

Viele andere Wissenschaftler erkennen jedoch jetzt, dass das Gakkel Ridge-Ereignis von 1999 bis 2007 und der chemisch verursachte Flüssigkeitsstrom die Hauptursache für die Beschleunigung der Schmelzrate des arktischen Meereises waren. Diese Erkenntnis passt gut zur Theorie der Plattenklimatologie, dass geologische Kräfte das Klima stark beeinflussen.“ (Ende des Zitats)

Eine am 7. Dezember 2020 veröffentlichte Studie der Tohoku Universität [3] kommt ebenso zu dem Ergebnis, dass das Grönländische Eisschild von unten her durch geothermische Aktivitäten geschmolzen wird. Im Bericht ist die Rede von einer heißen „Mantel-Wolke“ (mantle plume).

Im Lexikon der Geowissenschaften wird mit Mantelwolke das diapirartige Aufdringen von heißem Material durch den Erdmantel. Eine Wolke hat seinen Ursprung an der Grenze zwischen dem Erdkern und Erdmantel. Hot spots werden als vulkanischer Ausdrucks dieser schlauchartig den Erdmantel durchsetzenden Strömungskörper angesehen. Aus der seismologischen Tomographie zeigt sich, dass sie im Erdmantel im allgemeinen eine Breite von 100-200 km haben. Während des Aufstiegs verstärkt sich insbesondere der positive Temperaturkontrast zum umgebenden Mantelgestein. Soweit zur Aufklärung der Mantel-Wolke.

„Das Wissen über die grönländische Wolke wird unser Verständnis der vulkanischen Aktivitäten in diesen Regionen und die Frage des globalen Anstiegs des Meeresspiegels, der durch das Schmelzen der grönländischen Eisdecke verursacht wird, verbessern “, sagte Dr. Genti Toyokuni, Mitautor der Studien.

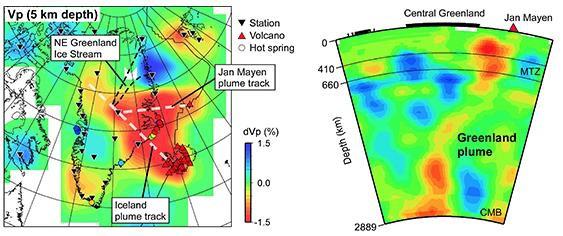

Eine Kartenansicht der P-Wellengeschwindigkeitstomographie in 5 km Tiefe unter Grönland und den umliegenden Regionen (links). Blaue und rote Farben bezeichnen Störungen mit hoher bzw. niedriger Geschwindigkeit, deren Maßstab (in%) neben der Karte angezeigt wird. Die weiß gepunkteten Linien sind die Wärmespuren der Island- und Jan Mayen-Federn, die von der grönländischen Wolke betroffen sind. In dem von den schwarz gepunkteten Linien umgebenen Bereich befindet sich die Strömung, die durch Schmelzen am Boden der Eisdecke verursacht wird (Nordostgrönland-Eisstrom). Die Wasserquelle befindet sich am Schnittpunkt der beiden Wärmespuren. Ein vertikaler Querschnitt der Ganzmanteltomographie durch Zentralgrönland und Jan Mayen (rechts). Wir können sehen, dass die grönländische Wolke die Wärmequelle für den Jan Mayen-Vulkan ist. Bildnachweis: Tohoku University

Die Nordatlantikregion ist voller geothermischer Aktivitäten. Island und Jan Mayen enthalten aktive Vulkane mit eigenen Mantelwolken, während Spitzbergen – ein norwegischer Archipel im Arktischen Ozean – ein geothermisches Gebiet ist. Der Ursprung dieser Aktivitäten und ihre Vernetzung sind jedoch weitgehend unerforscht.

Das Forscherteam entdeckte, dass die grönländische Wolke von der Kern-Mantel-Grenze zur Mantelübergangszone unter Grönland aufstieg. Die Wolke hat auch zwei Zweige im unteren Mantel, die in anderen „Zweigen“ der Region münden und die aktiven Regionen in Island und Jan Mayen sowie das geothermische Gebiet in Spitzbergen mit Wärme versorgen.

Ein schematisches Diagramm, das die wichtigsten tektonischen Merkmale und Mantelwolken unter Grönland und den umliegenden Regionen zeigt. Vp = P Wellengeschwindigkeit; MAR = der mittelatlantische Rücken; MTZ = Mantelübergangszone (410-660 km Tiefe); CMB = die Kern-Mantel-Grenze in 2889 km Tiefe. Bildnachweis: Tohoku University

Die Ergebnisse basieren auf Messungen der seismischen 3D-Geschwindigkeitsstruktur der Kruste und des gesamten Mantels unter diesen Regionen. Um die Messungen zu erhalten, verwendeten sie eine seismische Topographie. Zahlreiche Ankunftszeiten seismischer Wellen wurden invertiert, um 3DBilder der unterirdischen Struktur zu erhalten. Die Methode funktioniert ähnlich wie ein CT-Scan des menschlichen Körpers, heißt es im Bericht.

Das 2009 ins Leben gerufene Projekt sieht die Zusammenarbeit von Forschern aus 11 Ländern vor. Das gemeinsame Team zwischen den USA und Japan ist hauptsächlich für den Bau und die Wartung der drei seismischen Stationen auf dem Eisschild verantwortlich

- Kamis, James Edward, „Heat from deep ocean fault punches hole in arctic ice sheet”, Plate Climatology, 6.

Nov. 2015 http://www.plateclimatology.com/heat–from–deep–ocean–fault–punches–hole–in–arctic–ice–sheet/

[3] http://www.tohoku.ac.jp/en/press/greenland_plume_drive_thermal_activities.html?mc_cid= fb29760038&mc_eid=2560bc397b

Link: http://www.ageu-die-realisten.com/