Ähnlich schrieb die Huffington Post im Jahre 2017: „Es verschwindet. Schnell. Als eines der offensichtlichsten und schockierendsten Beispiele für die Küstenerosion könnte Kivalina bis 2025 unbewohnbar sein, alles dank des Klimawandels.“ The Guardian und Mother Jones schrieben: „31 Gemeinden in Alaska stehen vor einer ‚unmittelbaren‘ existenziellen Bedrohung durch Küstenerosion, Überschwemmungen und andere Folgen der Temperaturen, die in diesem Bundesstaat doppelt so schnell steigen wie im globalen Durchschnitt.“ Traurigerweise ignorierten Medien und Politiker die objektive Wissenschaft, aber deren Wahrheit ist immer noch da draußen.

Das wirkliche Problem für Alaskas Ureinwohner-Gemeinschaften sind die fehlgeleiteten Versuche der vergangenen Regierungen, „Beständigkeit“ in einer sich ständig verändernden Landschaft zu erzwingen. Die „Siedlungen, denen die Zerstörung droht“, sind keine Orte, die die Ureinwohner aus freien Stücken gewählt haben, um sich niederzulassen. Da ihr Überleben auf dem Spiel stand, waren sich die Ureinwohner Alaskas der sich ständig verändernden Umwelt sehr bewusst, lange bevor die Theorie der CO2-induzierten Klimaveränderung aufgestellt wurde. Und so entschieden sie sich, halbnomadisch zu leben. Kivalina war ein gutes saisonales Jagdlager, beherbergte aber nie eine permanente Siedlung. Nichtsdestotrotz machte das Bureau of Indian Affairs (BIA) des US-Innenministeriums den Ort im Jahre 1905 zu einer dauerhaften Siedlung.

REVEAL berichtet, „verbrachten die Inuit den Sommer in Zelten am Strand von Kivalina. Zum Wintereinbruch zogen sie ins Landesinnere, um Karibus zu jagen. Sie waren halbnomadisch, aber 1905 baute die Bundesregierung eine Schule auf der Insel. Den Eltern drohten Gefängnisstrafen oder der Verlust ihrer Kinder, falls sie sie nicht zur Schule schickten.“ Nur 6 Jahre nach der Gründung warnte Kivalinas Lehrer Clinton Replogle 1911 vor Überschwemmungen durch Meeresstürme und empfahl, dass Kivalina umgesiedelt werden sollte.

Man führe sich die Art und Weise vor Augen, wie die meisten Barriereinseln gebildet werden. Die Insel Kivalina entstand aus einer locker verfestigten Sandbank und wurde durch reichlich Sedimente erhalten, die von den lokalen Flüssen geliefert wurden. Ozeanwellen schieben erodierten Sand und Kies zurück zur Küste, wo er sich in flachen Gewässern zu einer Sandbank ansammelt. Auf der landwärtigen Seite der Sandbank erodieren Flussströmungen den Sand, wodurch eine Lagune und die geringe Breite der Inseln erhalten bleiben. Inseln entstehen dann dort, wo kilometerlange Sandbänke von Küstenflüssen zerschnitten werden, die einen Abfluss zum Ozean suchen. Der Singauk-Eingang (siehe unten), wo der Wulik-Fluss an Kivalina vorbei in die Tschuktschen-See fließt, ist ein Beispiel für die instabile Dynamik der Insel. In manchen Jahren ist der Singauk-Eingang durch von Winterstürmen aufgeschütteten Sand blockiert, wird aber später durch Flusserosion wieder geöffnet. Wie Stammesverwalterin Millie Hawley kürzlich sagte, erodierte Kivalina immer. „Wir befinden uns auf einer kleinen Landzunge, die sich im Laufe des letzten Jahrhunderts verkleinert hat.“

Die Bildung von Barriereinseln erfordert auch einen flach abfallenden Meeresboden, der den unwiederbringlichen Verlust von Sand minimiert, der in den tieferen Ozean gespült werden könnte. Allerdings verstärken solche flachen Meeresböden auch die Wellenhöhen von herannahenden Stürmen. Die endgültige Höhe einer Barriereinsel wird durch die Menge an Sedimenten bestimmt, die von den überlaufenden Wellen eines Sturms abgetragen werden. Der höchste Punkt von Kivalina ist nur ca. 4 Meter hoch, und vor Jahrzehnten kam die Hochwassermarke bis auf 0,3 bis 0,6 m an die Stadt heran. Aber die Stürme des Spätsommers und des eisfreien Herbstes können Wellen von 3 Meter oder höher bringen. Kein Wunder, dass Clinton Replogle die Gefahr einer Sturmflut so klar war. Tatsächlich haben geologische Untersuchungen jetzt ergeben, dass es zwischen 1905 und 1990 mindestens zweimal zu Überschwemmungen durch Wellen kam, die Kivalina überflutet hatten.

Der Sand der Insel kann kein Süßwasser aufnehmen. Daher muss der Wassertank der Stadt von einem 3 Meilen langen Feuerwehrschlauch gespeist werden, der vom Wulik River kommt. Das Abwassersystem von Kivalina besteht aus einzelnen „Honigeimern“, die von jedem Bewohner in zwei festgelegte „Bunker“ entleert werden. Schlechte sanitäre Verhältnisse und Überbevölkerung waren schon immer ein Problem, was zu einer extrem hohen Inzidenz von übertragbaren Krankheiten in der Stadt Kivalina geführt hat. Im Jahr 2021 kam es zu einem großen Ausbruch von COVID.

Da die negativen Aspekte überwiegen und die jährliche Gefahr der Zerstörung durch Sturmfluten überwiegt, initiierten die Bewohner der Inupiaq 1994 eine Studie zur Umsiedlung, obwohl es in diesem Jahrzehnt nur wenige große Stürme gab. Anhand von Fotografien, die bis ins Jahr 1952 zurückreichen, fand die Studie überraschenderweise keine schlüssigen Beweise für eine Erosion auf der Meeresseite der Insel. Allerdings zeigte die Studie eine erhebliche Erosion auf der Lagunenseite von Kivalina durch die Flüsse Wulik und Kivalina. Dennoch warnten die Forscher: „Obwohl es nur sehr begrenzte Informationen gibt, sind wir der Meinung, dass es nur eine Frage der Zeit ist, bis die richtige Kombination von Naturereignissen eintritt, die zu einer Überflutung der Stadt führen wird. Wenn dies geschieht, wird die Wellenbewegung zu Schäden an den Strukturen führen, und falls Eis mit der Sturmflut einhergeht, könnten die Folgen katastrophal sein.“

Dennoch wuchs Kivalinas Bevölkerung seit 1970 von 188 auf über 400. Obwohl die Bewohner in den letzten drei Jahrzehnten fünfmal für eine Umsiedlung in die Sicherheit stimmten, blieben eine Flugzeuglandebahn, die benötigte Güter bringt, und eine medizinische Klinik, die von der gemeinnützigen Maniilaq Association betrieben wird, eine Attraktion. Außerdem waren die finanziellen Mittel für die Umsiedlung knapp, da die Wirtschaft hauptsächlich auf der Subsistenzernte von Robben, Walrossen, Walen, Lachsen und Karibus basiert. Außerdem boten die Landes- und Bundesregierungen wenig Unterstützung an. Als Regierungsberichte begannen, die globale Erwärmung dafür verantwortlich zu machen, entschieden sich die Bewohner im Jahr 2011, die großen Ölgesellschaften zu verklagen mit dem Argument, dass „Kivalina aufgrund der globalen Erwärmung umgesiedelt werden muss“, und forderten Gelder, um die geschätzten Kosten von 95 bis 400 Millionen Dollar zu decken. Obwohl ihre Klage scheiterte, wurde Kivalinas „David gegen Goliath“-Klage von Befürwortern des katastrophalen Klimawandels sowie von Gegnern von Big Oil unterstützt und rückte das zuvor wenig beachtete Kivalina als Symbol der „Klimakrise“ ins Rampenlicht.

Ignoriert wurde der Zwang der Inupiaq zu einer dauerhaften Ansiedlung auf einer sich dynamisch verändernden Barriereinsel. Das war das eigentliche Problem. In ähnlicher Weise machte das Bureau of Indian Affairs die saisonal wandernden Yupik zu Bewohnern einer permanenten Gemeinschaft. Schlimmer noch, das BIA wählte einen Standort am Ninglick River im Yukon-Delta, um ihre Schule zu bauen und das permanente Dorf Newtok zu gründen. Aber Flussdeltas sind notorisch instabil (wie New Orleans während seiner 300-jährigen Existenz immer wieder schmerzlich feststellen musste). Die Schule von Newtok wurde 1958 gebaut, aber die Ignoranz der BIA gegenüber der Umwelt wurde schnell wieder aufgedeckt. In den 1980er Jahren gab das US Army Corp of Engineers über eine Million Dollar aus, um zu verhindern, dass die natürliche Erosion des Flusses die Ortschaft Newtok zerstörte. Nur 26 Jahre nach seiner Gründung gaben die Bewohner von Newtok die erste Studie für eine Umsiedlung in Auftrag. Die Kosten für die laufende Umsiedlung von Newtok werden 100 Millionen Dollar übersteigen. Trotzdem bleibt es einfacher, die Schuld auf den Klimawandel zu schieben, ob natürlich oder vom Menschen verursacht, um die schlecht konzipierte „erzwungene Permanenz“ der Regierung zu verschleiern.

Im Jahre 2005 posaunte der Guardian die skandalöse, gescheiterte Vorhersage der Vereinten Nationen, dass es „50 Millionen Umweltflüchtlinge bis zum Ende des Jahrzehnts“ geben würde, und die Notlage von Kivalina war eine Gelegenheit, diesen imaginären „Klimaflüchtlingen“ ein Gesicht zu geben. Falls man eine große Lüge oft genug erzählt, werden die Naiven sie unkritisch glauben. Also gründeten gleichgesinnte Medien „Climate Desk“, um mehr Alarmismus zu verbreiten (Mitgliedsorganisationen sind unten abgebildet). Im Jahr 2019 verstärkte der Guardian erneut den Klimahype und wies seine Journalisten an, Wetterereignisse nicht mehr als globale Erwärmung oder Klimawandel zu bezeichnen. Stattdessen sollten sie raues Wetter als „Klimakrise“ oder „Klimanotstand“ anpreisen. Jetzt wiederholt eine unheilige Allianz (zwischen „if it bleeds it leads“-Medien, Wissenschaftlern aus der „chicken little school of thought“ und Politikern, die jede Krise nutzen, um politische Kontrolle zu erlangen) täglich, dass wir alle von einer „existenziellen Klimakrise“ bedroht sind. Aber für diejenigen von uns, die die tatsächliche Wissenschaft studieren, gibt es eine ganze Armee von objektiven Klimawissenschaftlern, die Beweise liefern, um solche Klima-Angstmacherei ad absurdum zu führen.

Die großen Teilhaber an Climate Desk

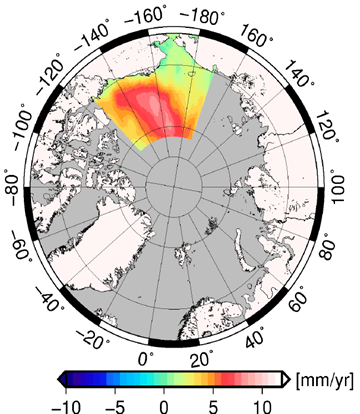

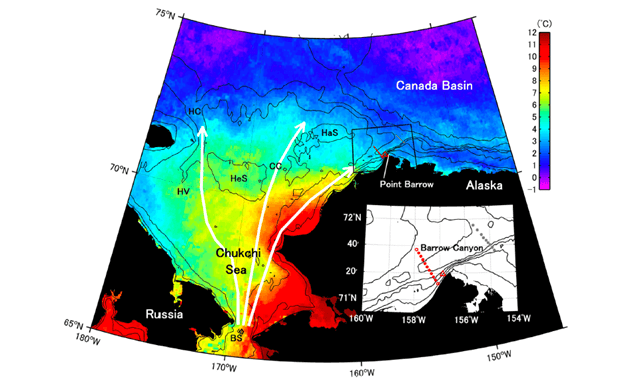

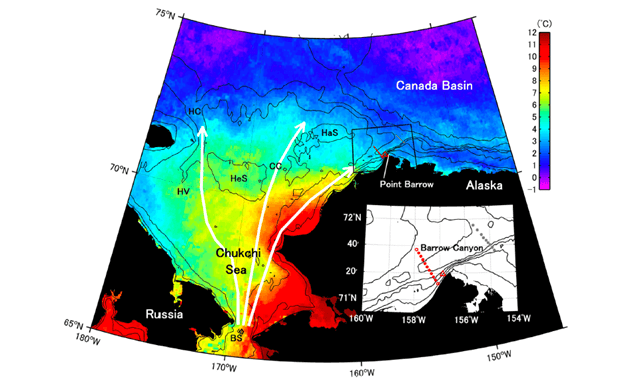

Im Jahre 2013 schrieb der Weather Channel von Climate Desk: „Das Meer verschluckt allmählich Städte in Alaska“ und stellte fest: „Die Folgen des Klimawandels werden für die Städte an der Küste Alaskas zur schmerzhaften Realität, da der steigende Meeresspiegel Hektar um Hektar von einst trockenem Land einnimmt. Die Bedrohung scheint in Kivalina unmittelbar zu sein.“ Aber objektive Wissenschaft zeigt etwas anderes. Wie in der von Experten begutachteten Arbeit Arctic Ocean Sea Level Record from the Complete Radar Altimetry Era: 1991-2018 festgestellt wurde, variiert der Meeresspiegel in der Arktis, weil Winde Wasser aus einer Region abtransportieren und in einer anderen auftürmen. Entlang der sibirisch-russischen Küsten und der südlichen Tschuktschensee, die an Kivalina grenzt (grüne Fläche), ist der Meeresspiegel nicht angestiegen, obwohl der Meeresspiegel entlang der Beaufortsee (rot) stark ansteigt.

In einem Dokument der Regierung zur Umsiedlung Kivalinas kolportierte eine Klimakrise und schrieb: „Die Temperaturen in der Arktis steigen mehr als doppelt so schnell wie der globale Durchschnitt, was zu heftigen Meeresstürmen, Überschwemmungen und Erosion unter den Häusern von Kivalina führt – Auswirkungen, die für die Inupiaq-Gemeinschaft der Barriereinsel in Alaska traumatisch sind.“ Aber sie informierten die Öffentlichkeit nicht über die ganze Wissenschaft, die damit verbunden ist. Zum Beispiel sanken viele permanente Häuser, die auf Permafrost gebaut waren, in den Boden ein, weil das Heizen ihrer Häuser auch den darunter liegenden Permafrost auftaute.

Außerdem sind es die Sommerwinde, die wärmeres Pazifikwasser durch die Beringstraße schieben und die Meereisschmelze und die Erwärmung in der gefrorenen Tschuktschensee einleiten. In den letzten Jahrzehnten hat sich die Menge des durch die Beringstraße einströmenden warmen Pazifikwassers fast verdoppelt, wodurch mehr Meereis schmilzt und sich die offenen Gewässer ausweiten. Fast die Hälfte dieser eindringenden Ozeanwärme wird an die Atmosphäre abgegeben und erhöht die Lufttemperatur. Obwohl offenere Gewässer auch die Photosynthese verbessert und das arktische maritime Nahrungsnetz um 30 % vergrößert haben, wird der damit verbundene Temperaturanstieg seltsamerweise als Krise gebrandmarkt. Es ist wahr, dass sich ausdehnende offene Gewässer mehr Sonnenlicht absorbieren und diese Rückkopplung die Temperaturen noch weiter ansteigen lässt, was als „Arktische Verstärkung“ bezeichnet wird. In der Tat sind die Lufttemperaturen in der Arktis doppelt so schnell gestiegen wie in den zusammen hängenden 48 US-Staaten. Aber dieser Anstieg erhöht nicht die globale Durchschnittstemperatur und wurde fälschlicherweise dem CO2 angelastet. Aber die meisten Klimamodelle sind sich jetzt einig, dass es das eindringende warme Pazifikwasser ist, das durch die Beringstraße drängt und die arktische Verstärkung erzwingt.

Studien zeigen, dass der größte Meereisverlust in der Tschuktschen-See mit den drei Hauptwegen des eindringenden warmen Wassers verbunden ist. Der wärmste Weg führt an der Küste Westalaskas entlang und betrifft Kivalina, wie unten von Itoh (2015) dargestellt. Wichtig ist, dass das Volumen des Beringstraßen-Durchflusses das Ausmaß der jährlichen offenen Gewässer bestimmt, und dieses Durchflussvolumen wird durch natürliche Variationen der atmosphärischen Zirkulation moduliert. Mithilfe des allgemeinen Zirkulationsmodells des Massachusetts Institute of Technology MIT stellten die Forscher fest, dass der Zustrom von warmem Wasser durch die Beringstraße in erster Linie durch Winddruck gesteuert wird, wobei wechselnde Winde 90 % oder mehr der Veränderungen erklären. Andere Faktoren (Niederschlag, Strahlungsflüsse [Sonne oder Treibhaus], Wasserdampf und Lufttemperatur) hatten einen vernachlässigbaren Einfluss. Leider hat die zunehmende Ausdünnung und der Verlust des Meereises die Saison der Inupiaq für die Jagd auf Robben und Wale verkürzt und sie gezwungen, woanders zu jagen und zu fischen.

Die drei Hauptpfade und Temperaturen des wärmeren Pazifikwassers, das durch die Beringstraße in die Arktis fließt. Aus Itoh 2015

Die wissenschaftliche Studie „Mechanisms Driving the Interannual Variability of the Bering Strait Throughflow“ aus dem Jahr 2020 beschreibt detailliert die Ursachen für diese wechselnden Winde. Auf der Seite des Arktischen Ozeans der Beringstraße, wenn das Beaufort-Hochdrucksystem stärker ist, transportieren die Winde Ozeanwasser ablandig und senken den Meeresspiegel entlang der Küste, was einen größeren Durchfluss durch die Beringstraße ermöglicht. Auf der pazifischen Seite der Meerenge, wenn sich das semi-permanente Aleuten-Tiefdrucksystem über dem Aleutenbecken befindet, türmen die Winde das Wasser entlang des östlichen Beringmeer-Schelfs auf. Der daraus resultierende höhere Meeresspiegel drückt mehr warmes Wasser durch die Beringstraße. Umgekehrt, wenn sich das Aleuten-Tief südwärts über den Golf von Alaska verlagert, herrschen nordöstliche Winde vor, die den Meeresspiegel senken und den Durchfluss durch die Beringstraße abschwächen. Bezeichnenderweise wird das Aleutentief von natürlichen El-Nino-Ereignissen und der Pazifischen Dekadischen Oszillation (PDO) beeinflusst. Mehrere Studien haben gezeigt, dass ein Wechsel in die negative PDO-Phase auch das Aleuten-Tief veranlasst, mehr warme Luft aus dem Süden nach Alaska zu pumpen.

Wechselnde Winde und Warmwasserzuflüsse erhöhen die offene Wasserfläche in der Tschuktschen-See auch während kälterer Klimaphasen. Meeresgeologen, die Sedimente aus der Tschuktschensee untersuchen, haben festgestellt, dass in den vergangenen Jahrtausenden eine eisfreie Tschuktschensee unabhängig vom globalen Klima vorkam, wobei eisfreie Bedingungen sogar während der jüngsten Kleinen Eiszeit auftraten. Nach dem heutigen Stand der Wissenschaft lassen sich die wechselnden Bedingungen in der Arktis am besten durch natürlich schwankende Winde und Meeresströmungen erklären.

Im Jahre 2015 schickte die Obama/Biden-Regierung die US-Innenministerin Sally Jewell nach Kivalina, die versprach – ohne sich für die Zwangsansiedlung in Kivalina zu entschuldigen – an Lösungen für das vom Klima bedrohte Dorf zu arbeiten. Mit der Wiederholung des Climate Desk-Märchens bzgl. „Klimaflüchtling“ stellte Jewell ihr Mitgefühl zur Schau: „Hunderte von Dorfbewohnern in Kivalina stehen vor der schrecklichen Aussicht, ihr Land und ihre Häuser durch den steigenden Meeresspiegel und die Küstenerosion zu verlieren, was ihre persönliche Sicherheit bedroht und sie dem Risiko aussetzt, innerhalb eines Jahrzehnts zu Klimaflüchtlingen zu werden“. Aber es war wenig mehr als politisches Getue.

Kivalina und Newtok sind keine Beispiele für Klimakrisen. Vielmehr stehen sie als ikonische Beispiele dafür, wie die Medien und Regierungen die Ungerechtigkeiten, die die Ureinwohner erlitten hatten, ignoriert haben und ihre Probleme nur dann nutzen, wenn es ihre Krisenagenda fördert. Kivalina und Newtok sind klare Beispiele für die Unangemessenheit der Regierung, die einer indigenen Kultur, die an eine sich ständig verändernde natürliche Umgebung angepasst ist, „Beständigkeit“ aufzwingt; in einer Umgebung, in der sich das regionale Klima ständig verändert. Ich schlage vor, der BIA ihre Finanzierung zu entziehen und das dadurch frei werdende 1,9-Milliarden-Dollar-Jahresbudget zu verwenden, um die Menschen von Kivalina, Newtok und anderen sicher an einen Ort ihrer Wahl umzusiedeln.

Jim Steele is Director emeritus of San Francisco State University’s Sierra Nevada Field Campus, authored Landscapes and Cycles: An Environmentalist’s Journey to Climate Skepticism, and a member of the CO2 Coalition

Link: https://wattsupwiththat.com/2021/02/09/kivalina-a-case-study-of-how-media-politics-mangle-objective-climate-science/

Übersetzt von Chris Frey EIKE