Doch Deutschland möchte als erstes Land komplett aus der Kohle aussteigen und begründet dies mit dem Anspruch, als Vorreiter der Welt zeigen zu müssen, dass ein solcher Ausstieg technisch und ökonomisch realisierbar sei. Darüber hinaus sollen auch die Kernkraftwerke in Deutschland stillgelegt werden, die Strom nahezu CO2-emissionsfrei erzeugen können. Das Ziel ist es, Strom zu hundert Prozent aus regenerativen Energiequellen bereitzustellen. Professor Sigismund Kobe erklärt im EIFELON-Gespräch, dass dies in Deutschland aus physikalischen Gründen nicht möglich ist, solange es noch keine Speicher mit gigantisch großen Speicherkapazitäten gibt. Grundvoraussetzung für ein hochindustrialisiertes Land ist eine sichere stabile Stromversorgung, die auf Abruf jederzeit die Energie liefern kann, die gerade benötigt wird. Dr. Sigismund Kobe, Jahrgang 1940, ist emeritierter Physik-Professor an der Technischen Universität Dresden. Sein Forschungsschwerpunkt ist die Optimierung komplexer Systeme (magnetische Festkörper, neuronale Netze, Proteine, Windenergie).

„Einer der Fehler, den die meisten Befürworter der Energiewende machen, ist es, alle erneuerbaren Energiequellen in einen Topf zu werfen, anstatt sie differenziert zu betrachten“, sagt Kobe. Aber erneuerbar sei nicht gleich erneuerbar. Mit Wasserkraft- und Biogasanlagen lasse sich Strom weitgehend nach den Bedürfnissen der Verbraucher bereitstellen, Windkraft- und Solaranlagen dagegen seien aus physikalischen Gründen dazu nicht in der Lage. Ein weiterer Zubau von Wasserkraftwerken ist geologisch und meteorologisch begrenzt: Deutschland hat anders als z.B. Norwegen und die Schweiz aufgrund seiner Topologie nicht genügend Regionen mit den erforderlichen Höhenunterschieden. Zudem reicht die jährliche Regenmenge für diesen Zweck nicht aus. Auch die landwirtschaftlich nutzbaren Flächen in Deutschland seien bereits hinreichend aufgeteilt in solche für die Lebensmittel- und Futtermittelproduktion und solche für bioenergetische Nutzung. „Diese beiden erneuerbaren Energiequellen haben in Deutschland kein größeres Ausbaupotenzial mehr“, lautet das Fazit von Professor Kobe.

Windräder liefern zu einem Drittel der Zeit kaum bis gar keinen Strom

Für einen gedachten weiteren Zubau erneuerbarer Energiequellen in Deutschland verbleiben also nur Wind und Sonne. Diese haben allerdings die unangenehme Eigenschaft, dass der damit erzeugte Strom volatil sei, d.h. zeitlich schwanke, so Kobe weiter. Mal weht der Wind und dann drehen sich die Räder, mal weht er nicht und dann drehen sie sich nicht. Der letztgenannte Zustand ist sogar häufiger als allgemein bekannt. Statistisch gesehen ist der Beitrag aller Windenergieanlagen an der Stromerzeugung in Deutschland an einem Drittel der 8.760 Stunden eines Jahres gering bzw. sogar vernachlässigbar. Bei den Solaranlagen sieht es nicht besser aus. Der weitaus überwiegende Teil des jährlichen Anteils von Strom aus Photovoltaik-Anlagen an der Stromproduktion wird im Sommer und dann wiederum vor allem in wenigen Stunden um die Mittagszeit eingespeist, vorher und nachher ist der Anteil gering und nachts scheint die Sonne nie.

Seit jeher ist das Netz auf das Auftreten von Schwankungen ausgelegt, muss doch die Anpassung an den unregelmäßigen Bedarf durch die Verbraucher sichergestellt werden. Nun waren in der Vergangenheit bei geringem Anteil von Wind- und Sonnenstrom die dadurch bedingten zusätzlichen Schwankungen auch kein besonderes Problem. Professor Kobe:

„Quantitativ sind wir allerdings an eine Grenze gelangt, an der das Netz diese zusätzlichen Erzeugungsschwankungen nicht mehr verkraften kann.“

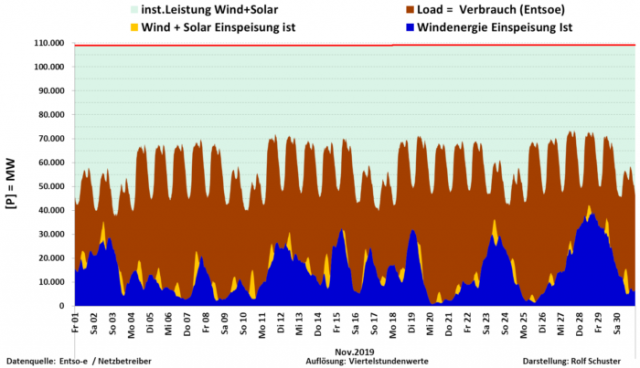

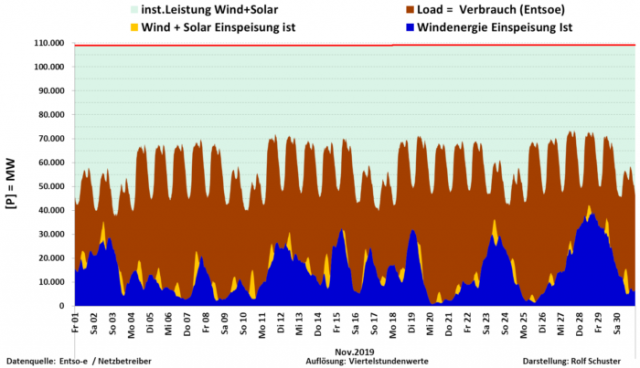

Die aktuelle Grafik des Energiedaten-Sammlers Rolf Schuster zeigt die Situation für November 2019: Sonnenstrom (gelb) spielt fast keine Rolle. Zeiten mit geringer Einspeisung der volatilen Erzeuger, die sogenannten „Dunkelflauten“, und Zeiten mit hohem Windaufkommen (blau), in denen dieses einen großen Teil des Bedarfs der Verbraucher (Last, braun) abdeckt, wechseln sich ab.

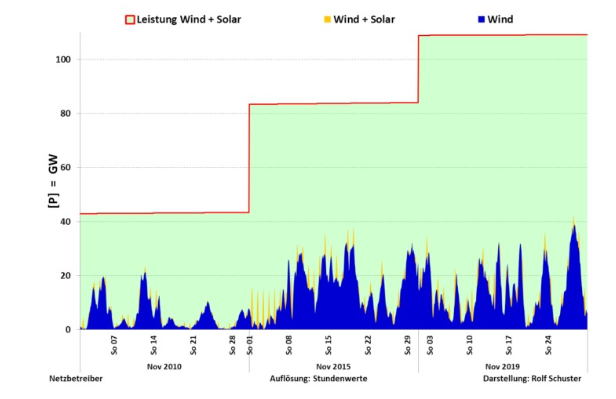

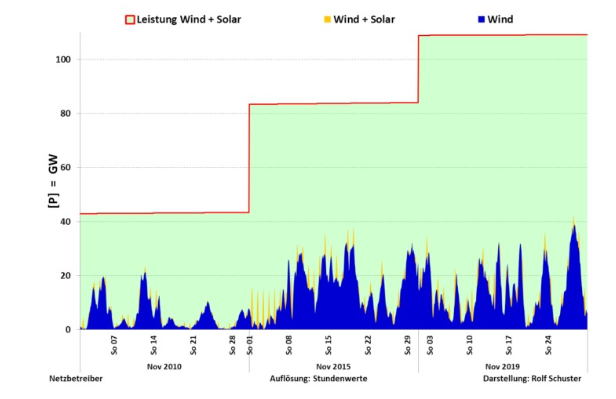

Die folgende Grafik, die jeweils die Einspeisung von Wind- und Sonnenstrom im Monat November in verschiedenen Jahren zeigt, macht deutlich, dass trotz starkem Zubau, charakterisiert durch die installierte Leistung (hellblaue Fläche, rote Linie), die tatsächlich erbrachte Leistung vergleichsweise gering geblieben ist.

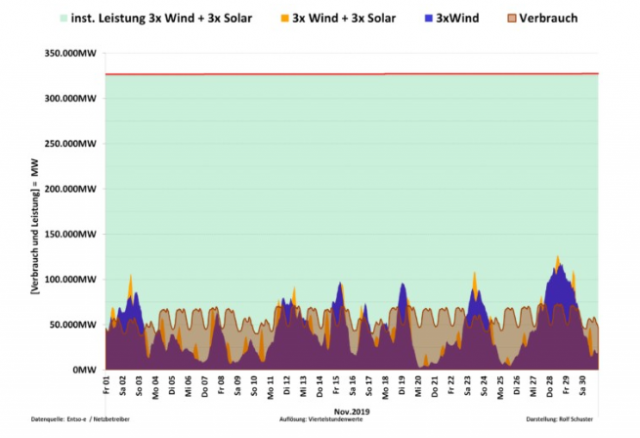

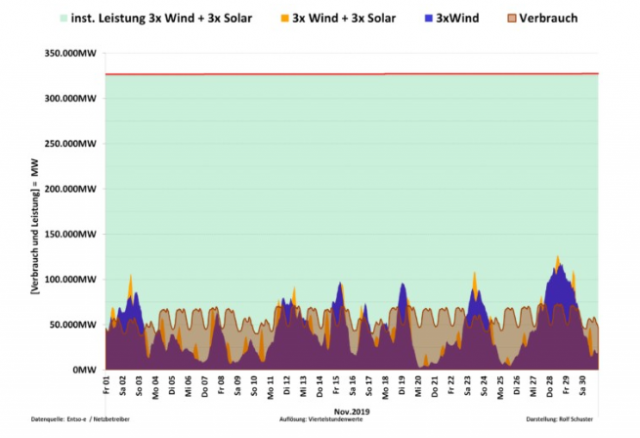

Professor Kobe fragt daher: „Was passiert, wenn, wie aktuell vielfach gefordert wird, noch mehr Wind- und Solaranlagen zugebaut werden? Lassen sich dadurch die Probleme bei Dunkelflaute und bei den Spitzenwerten der Einspeisung beheben?“ und liefert die Antwort gleich selbst: Null bleibe Null, d.h. die Probleme bei Dunkelflaute werden nicht dadurch gelöst, dass z.B. 10.000 statt 10 Windanlagen neu aufgestellt werden. Das zeigt auch die nachfolgende Grafik der Einspeisung für November, bei der simuliert wurde, dass jede einzelne Anlage in Deutschland am selben Ort durch drei gleichwertige ersetzt wird:

Wenn in ganz Deutschland kein Wind weht, bewegt sich kein einziges Windrad. Wenn andererseits zu viel Sonne scheint und zu viel Wind weht, die Anlagen also mehr produzieren als alle Verbraucher in Deutschland abnehmen können (in der letzten Grafik kommt dies mehrmals im Monat vor), dann ist die Versorgungssicherheit ebenfalls gefährdet. In einem solchen Fall müssten Sofortmaßnahmen getroffen werden, um zusätzliche Lasten zuzuschalten bzw. Erzeuger abzuschalten. Nur so kann das ganze System stabil gehalten werden.

Die Einbindung von volatilem Strom aus Wind- und Sonnenanlagen in das öffentliche Netz ist eine hoch komplexe Aufgabe. Die in jedem Moment durch die Verbraucher benötigte und abgerufene Leistung – die Last – ist zeitlich schwankend, aber natürlich folgen diese Schwankungen überwiegend nicht dem zur gleichen Zeit eingespeisten Energie-Angebot der Windräder und Solarpaneele. Für die Differenz zwischen momentaner Last, die von den Verbrauchern abgefordert wird, und der Leistung, die Wind- und Sonnenstrom liefern, wird der Begriff „Residuallast“ als verbleibende Lücke der Versorgung verwendet. Sie muss durch andere, insbesondere konventionelle Kraftwerke erbracht werden.

Lobbyisten täuschen Bürger

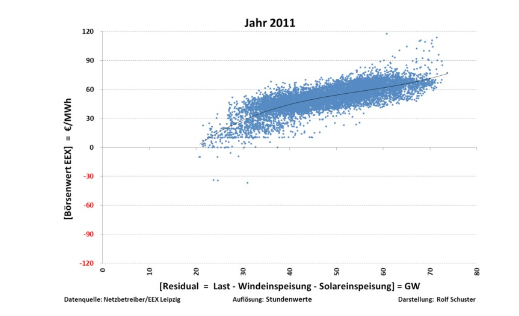

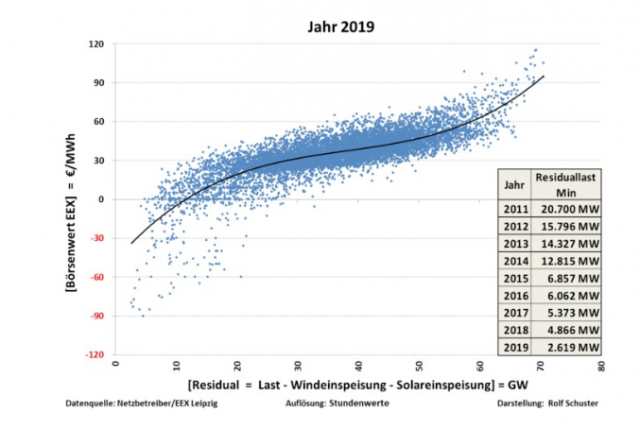

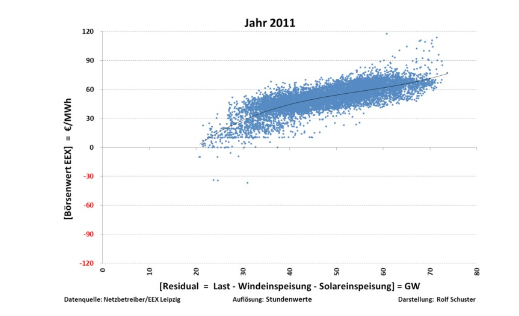

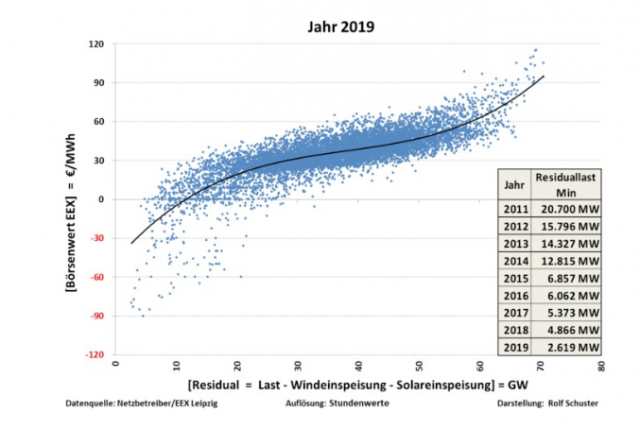

Die Residuallast in der Einheit Gigawatt ist eine Schlüsselgröße, wenn die Energiewende analysiert werden soll. Deshalb hat Rolf Schuster für jede Stunde des Jahres 2011 diese Größe als Punkt in einer Grafik eingetragen. Auf der zweiten Achse der Grafik wird der Börsenpreis des Stroms zur gleichen Zeit markiert. Dadurch entsteht für jedes Jahr eine „Punktwolke“ mit 8.760 Stunden-Punkten. Je mehr Wind- und Sonnenstrom in das Netz drängt, umso geringer ist die Residuallast und umso niedriger ist auch der Börsenpreis. „Dieser Sachverhalt wird von den Lobbyisten zur Täuschung der Öffentlichkeit verwendet und als Beweis dafür angeführt, dass Strom aus Wind und Sonne zu einer Verringerung des Strompreises führen würde“, meint Kobe. „Verschwiegen wird geflissentlich, dass Strom aus den Erneuerbaren überhaupt nicht am Marktgeschehen und somit auch nicht an der direkten Preisbildung an der Strombörse beteiligt ist, da dieser ja gemäß EEG mit einem subventionierten Festpreis vergütet wird.“

Die ganze Dramatik der aktuellen Situation wird deutlich, wenn die Schuster’sche Analyse für das Jahr 2019 wiederholt wird:

Der im Laufe eines Jahres auftretende Minimalwert der Residuallast ist seit 2011 von Jahr zu Jahr immer kleiner geworden und betrug 2019 nur noch 3 Gigawatt. Wind und Sonne können demnach zu einigen Stunden des Jahres bereits fast den gesamten Strombedarf Deutschlands decken. Wenn manche Befürworter der Energiewende dies als Zeichen für eine bald bevorstehende Vollversorgung mit Erneuerbaren werten, so ist das leider ein Trugschluss. Es wird dabei „vergessen“, dass zu anderen Zeiten kein Beitrag von Wind und Sonne kommt und diese Situation sich nicht im Geringsten dadurch ändert, dass immer mehr volatile Erzeuger zugebaut werden.

Ausland macht Reibach – Deutsche Stromkunden zahlen

Mit der Zunahme von Wind- und Sonnenstrom im Netz nehmen die Börsenpreise immer häufiger negative Werte an: „2019 musste an 232 Stunden überflüssiger Strom durch Zuzahlung einer Entsorgungsgebühr verklappt werden“, so Kobe. Immer dann, wenn zu viel Wind- und Solarstrom ins Netz drängt und dieser im Land nicht verbraucht werden kann, verkauft ihn Deutschland zu „negativen Preisen“ an das Ausland. So verdienen z.B. die Betreiber österreichischer Pumpspeicherwerke doppelt am deutschen Strom: Bei negativem Börsenpreis pumpen sie mit diesem Strom Wasser in die Oberbecken und werden für die Abnahme des Stroms auch noch von Deutschland bezahlt. Später, wenn bei uns Dunkelflaute herrscht, werfen sie die Turbinen an und verkaufen uns Strom zu höheren Preisen zurück. Verlierer sind die Stromkunden, denn sie müssen für die EEG-Umlage aufkommen, einer für die Dauer von 20 Jahren staatlich zugesicherter Festvergütung für die Betreiber von erneuerbaren Energiequellen.

Beim Betrachten dieser Schuster-Grafik werde Professor Kobe stets an den Fisch erinnert, der bekanntlich ‚zuerst vom Kopf und vom Schwanz her stinke‘. Sowohl die immer weiter ansteigende Zahl von Stunden mit negativen Börsenpreisen, als auch die anwachsenden Kosten für den Zukauf von teurem Regelstrom zum Kompensieren fehlender Erzeugerleistung bei Dunkelflauten werde letztlich das gesamte System kollabieren lassen.

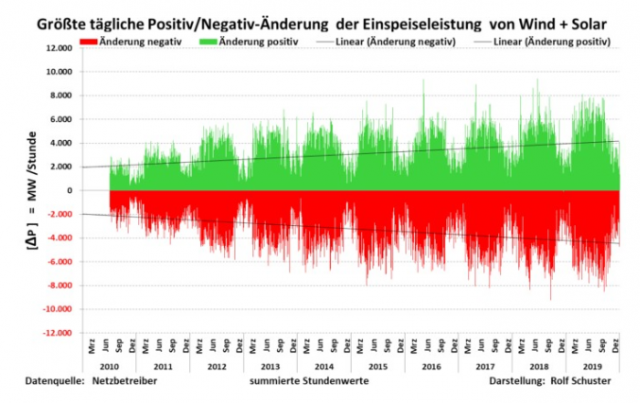

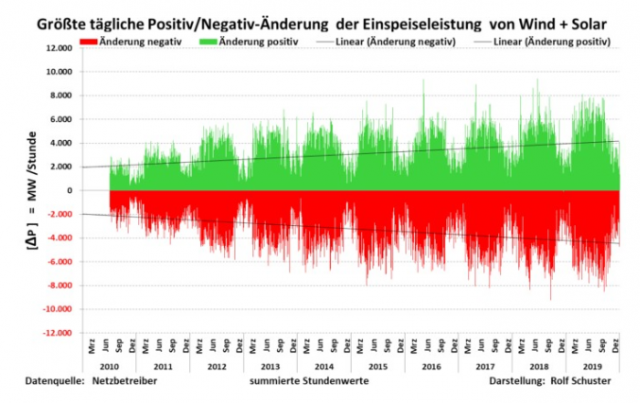

„Als profunder Kenner und tiefgründiger Analyst der Energiewende“ weise Rolf Schuster in der folgenden Grafik auf ein weiteres ernstes Problem hin, fährt Kobe fort. Hierbei gehe es um die sogenannten Leistungsgradienten, d.h. die Änderung der Einspeiseleistung pro Zeiteinheit. Untersucht wurde die größte stündliche Zunahme (grün) bzw. Abnahme (rot) eines jeden Tages seit 2010. Beide sind sowohl in den Extremwerten, als auch im Mittel stetig angestiegen, so dass es immer schwieriger wird, die notwendige Kompensation durch konventionelle Erzeugung in immer kürzerer Zeit zu realisieren.

„Strom sei nun einmal die verderblichste Handelsware der Welt“, so Kobe. Im selben Moment, in dem der Strom erzeugt wird, muss er auch verbraucht werden. Da die Ausbreitungsgeschwindigkeit von Elektroenergie gleich der Lichtgeschwindigkeit ist, können Erzeuger und Verbraucher durchaus weit voneinander entfernt sein, wenn eine Verknüpfung durch das Stromnetz besteht. Allerdings können Stromüberschüsse im Netz selbst nicht gespeichert werden.

Deutschland hat nicht die benötigten Stromspeicher

Eine Lösung bestünde darin, den momentan zu viel erzeugten Strom zu speichern. Oft wird jedoch verschwiegen, dass Deutschland solche Speicher mit der notwendigen gigantischen Speicherkapazität weder jetzt zur Verfügung stehen, noch in absehbarer Zeit zur Verfügung stehen werden. „In den Medien werden manchmal große zusammengeschaltete Akkumulatoren als Beispiele für Großspeicher vorgeführt. Diese dienten in Wirklichkeit aber nicht der Stromspeicherung, sondern der Feinregulierung der Netzfrequenz“, erklärt der Physiker. Und was ist mit der Idee, die Akkus der Elektroautos als Stromspeicher einzusetzen? Unterstelle man eine maximal mögliche Speicherkapazität aller PkWs in Deutschland (vorausgesetzt alle diese 47 Millionen Autos wären bereits Stromer) von maximal 2.000 GWh und vergleiche diese mit dem Bedarf bei einer Dunkelflaute von z.B. zehn Tagen, komme man schnell zu dem Ergebnis, dass sie bei weitem nicht als Speicher ausreichten. Dazu komme, dass niemand ohne Entschädigung bereit sei, die Kosten für die Zwischenspeicherung von öffentlich benötigter Elektroenergie zu tragen, denn jeder Lade-Entlade-Vorgang lasse die Akkus altern. Kobe nennt Kosten von derzeit 3 bis 10 ct/kWh, die dabei zusätzlich entstehen. Der Autobesitzer müsse dann früher als geplant einen teuren neuen Akku kaufen.

Auch das Argument, die Akkus der E-Autos seien ja nicht als Langzeitspeicher gedacht, sondern sollten Regelenergie bereitstellen, lässt der Professor nicht gelten. Für diesen Zweck würde die Gesamtspeicherkapazität zwar reichen. Trotzdem sei die Idee unsinnig, weil Regelenergie im Bedarfsfall innerhalb von Minuten bereitstehen müsse. „Wie soll das realisiert werden? Vielleicht mit einem Alarm: ´Sofort alle E-Autos an die nächste Ladesäule zum Entladen!‘, fragt Kobe. Bevor in Deutschland die Speicherfrage nicht gelöst sei, nütze auch eine Nord-Südtrasse nichts. Der Flatterstrom aus dem Norden würde über diese Verbindung augenblicklich im Süden ankommen, aber natürlich wieder als Flatterstrom. Die Probleme würden damit nur verlagert, aber nicht gelöst.

Bliebe schließlich noch die Möglichkeit, volatile Stromerzeuger notfalls abzuregeln. Dass wir auch dabei längst an der Grenze des noch Vertretbaren angekommen sind, zeigt die Situation bei den zahlreichen Windenergieanlagen in Schleswig-Holstein. Diese allein sind bereits jetzt von mehr als der Hälfte aller Abschaltungen in Deutschland betroffen. Allein im ersten Quartal 2019 hätten in diesem Bundesland 1.800 GWh Strom mehr in das Netz eingespeist werden können. Aber auch dieser „Geisterstrom“ muss laut EEG den Anlagebetreibern vergütet werden. Nach Schätzungen der Bundesnetzagentur summieren sich die Entschädigungszahlungen für sogenannte Einspeisemanagement-Maßnahmen im ersten Quartal 2019 in Deutschland auf 394 Millionen Euro. Sie sind demnach gegenüber dem gleichen Vorjahreszeitraum um 60 Prozent gestiegen. Professor Kobe:

Welche Volkswirtschaft der Welt kann es sich auf Dauer leisten, mehr als eine Million Euro pro Tag zum Fenster hinaus zu werfen?“

Monitoringberichte sind Augenwischerei

Die größte Sorge bereite Professor Kobe die Versorgungssicherheit. Wenn Politiker den angeblichen Erfolg der Energiewende preisen, dem Bürger einen hohen jahreskumulierten Stromertrag von Wind- und Solaranlagen präsentieren und diesen mit dem von konventioneller Kraftwerke vergleichen, aber die nicht vorhandene sekundengenaue Verfügbarkeit von Wind- und Solarenergie verschweigen, begehen sie Augenwischerei. „Man schaue sich z.B. den Monitoringbericht des Bundesministeriums für Wirtschaft und Energie nach § 63 i.V.m. § 51 EnWG zur Versorgungssicherheit im Bereich der leitungsgebundenen Versorgung mit Elektrizität vom Juni 2019 an. Sofort fällt auf: Dieser Bericht ist anonym, niemand will vermutlich seine Hand für die dort getroffenen Schlussfolgerungen ins Feuer legen. Dort heißt es u.a.: ‚Insgesamt ist die Verfügbarkeit der Energieträger für die Stromerzeugung als gesichert einzuschätzen.‘ Fachkundige sind entsetzt und schlagen Alarm“, sagt Kobe. Das Energiesystem ist sehr komplex, die technologischen Anforderungen unter den Bedingungen von zeitlich schwankender Stromeinspeisung wurden in der Vergangenheit „sträflichst vernachlässigt“. Darin sieht Kobe den Hauptgrund für die aktuell immer deutlicher werdenden Konflikte bei der Umsetzung der Maßnahmen der Energiewende. Die Schuldigen seien eben gerade nicht diejenigen Bürger, sich gegen einen weiteren Ausbau von Windenergieanlagen organisieren und die sich deshalb auch schon mal mit dem Begriff „Anti-Windkraft-Taliban“ beschimpfen lassen müssen. Professor Kobe:

Wenn weiterhin wie bisher natur- und ingenieurwissenschaftlichen Prinzipien ausgeblendet werden, wird das gesamte bisherige Konzept der Energiewende platzen wie eine bunte Seifenblase. Die Energiewende hat nur einen einzigen Feind, die Unwissenheit über die physikalischen Gesetze, die ihr zugrunde liegen.“

Von 2000 bis 2019 betrug laut Bundesnetzagentur die durch das Erneuerbare-Energien-Gesetz (EEG) vergütbare Strommenge 1.926.676 GWh. Die Betreiber der durch das EEG subventionierten Wind- und Solaranlagen erhielten für diese produzierte Strommenge 296,257 Milliarden Euro. Tatsächlich war dieser Strom am Markt nur 68,024 Milliarden Euro wert. Die Mehrbelastung der Stromkunden betrug 228,233 Milliarden Euro. Ein Ende ist nicht in Sicht. Zum Vergleich: Die Ausgaben im Bundeshaushalt für das Jahr 2019 betrugen etwa 356 Milliarden Euro.

Dieser Beitrag war zuerst hier erschienen: https://eifelon.de/umland/physik-professor-sigismund-kobe-deutsche-energiewende-wird-wie-seifenblase-platzen.html