Nun haben wir eine neue Pandemie

Am 22.03. wurden die neuen Coronamaßnahmen verkündet [2] und der Bayerische Lokalfürst Söder (Jurist) klärte seine Untertanen wieder auf, warum diese leider, aber unvermeidbar, immer härter erforderlich werden; dpa 23.03.2021 [3]: Söder: Die Lage ist ernst und wird sehr viel ernster werden … «Die dritte Welle rollt durch Bayern», sagte er. Und diese sei deutlich gefährlicher, es handle sich quasi um eine komplett neue Pandemie. Sechs Wochen sei es bei den Corona-Zahlen abwärts gegangen, seit vier Wochen gehe es wieder nach oben …

Der selbsternannte Chef-Epidemiologe Söder korrigierte sich inzwischen und verschärfte seine Aussage (Zitierung aus einer Tageszeitung): „Es ist eine neue Pandemie“, sagte der CSU-Politiker. „Es ist nicht einfach der dritte Aufguss“.

Irgendwelche Hemmungen hat er dabei nicht. Denn seine Untertanen sind daran ja selbst schuld, weil sie sich nicht strengstens an seine Regeln halten.

Wenn unsere Staats-Orakel sprechen

Unsere unfehlbare Merkel soll am 22.03. in der Kanzlerrunde mit einem ihrer typischen Schwurbelsätze gesagt haben (Zitierung aus einer Tageszeitung): „Insgesamt verhehle ich nicht, dass wir eigentlich den Reisehinweis geben, dass man dieses Jahr eben nicht reisen sollte“.

Einst berichtete die gleiche Zeitung, dass Informationen mit Grammatikfehlern von guten Bürgern nicht gelesen werden sollen, da solche grundsätzlich räääääächts sind und damit nur Unwahrheiten enthalten können …

Doch Ironie beiseite. Wie schon damals bei der griechischen Variante, können ausschließlich „Eingeweihte“ (damals Priester) Orakelsätze richtig deuten. Regierungssprecher Seibert ist der Priester für unser Staatsorakel und deutete die Aussage wie folgt (Zitierung aus der Tageszeitung): Doch Regierungssprecher Seibert stellte später auf Twitter dar, dass es bei diesen Aussagen Angela Merkels vor allem um die Osterzeit und die kommenden Wochen danach gehen sollte.

Der damit neu geknüpfte, Gordische Knoten lässt sich wohl entwirren, indem man davon ausgeht, dass sich „die kommenden Wochen“ über das gesamte Jahr erstrecken. Ob zur „Vermeidung“ eines Dauer-Lockdown die eben erfundenen Corona-Ruhetage dazu bis zum Jahresende verlängert werden, wird wohl eine der nächsten Nachtsitzungen (inzwischen offiziell als „Geisterstunden“ in die Geschichte eingehend) in kleiner Runde entscheiden …

Es gibt aber noch weitere Orakel. Karin Maag, die gesundheitspolitische Sprecherin der Union im Bundestag (Juristin) sagte in „hart aber fair, Der verschobene Frühling: Dritter Lockdown statt weiter lockern? (ARD)“ am 22.03.2021 allen Ernstes: „Wir hatten nie einen Lockdown“

Berichtet wurde es in [9]. Der Autor hat sich angewöhnt, alles nachzuprüfen. Also hat er das Video auf YouTub angesehen (Link) und wirklich, bei 26:23 kommt diese Aussage von ihr als Einwurf in einer Diskussion.

Da steckt zwar kein Grammatikfehler drin. Doch ist der Unterschied zwischen „Corona leugnen“ und „Lockdown leugnen“ wirklich groß? Jedenfalls bestätigt es das Bild über unseren Politikzirkus in Berlin.

Bisher haben unsere Maßnahmen nichts bewirkt. Deshalb müssen alle verschärft so weiter machen ….

ist im Wesentlichen das Einzige, was denen in Berlin und leider auch den Landesfürsten nach über einem Jahr Corona einfällt:

[2] Tichys Einblick, 23.03.2021: Karwoche mit Merkel – Lockdown total: Lebensmittelgeschäfte zu, kein Urlaub, keine Gottesdienste, „Ansammlungsverbot“

Merkel erreicht bei diesem Corona-Gipfel eine nie dagewesene Radikalität. Sie wollte für fünf Tage alle Geschäfte schließen – wirklich alle. Das konnte noch abgeschwächt werden. Zu den Ergebnissen fehlen einem dennoch die Worte.

… Am Karsamstag soll der Lebensmitteleinzelhandel im engen Sinne geöffnet bleiben dürfen, am Gründonnerstag sollen aber sogar der Lebensmitteleinzelhandel und Supermärkte geschlossen werden. Dazu kommt für fünf Tage ein „Ansammlungsverbot“, bei dem grundsätzlich nur noch Personen aus zwei verschiedenen Haushalten zusammenkommen dürfen. Ostern mit der Familie fällt also genauso aus wie Demonstrationen und Gottesdienste. Man wolle auf die Religionsgemeinschaften zugehen mit einer „Bitte“ – wie freiwillig diese Bitte dann angenommen werden muss, bleibt offen.

… Mitfahrer im Auto, die nicht zum eigenen Haushalt gehören, sind zum Tragen einer medizinischen Maske verpflichtet

Wer den Originalbeschluss lesen will: [5] Videokonferenz der Bundeskanzlerin mit den Regierungschefinnen und Regierungschefs der Länder am 22. März 2021 Beschluss

Warum unseren Politikern weiterhin nichts Sinnvolleres einfällt, brachte Söder vorher im Bayerischen Landtag auf den Punkt: … Söder verteidigt seinen Kurswechsel, erklärt, dass der Inzidenzwert weiter die einzig belastbare Größe sei und dass ihm noch niemand eine tragfähige Alternative genannt hat …

Aber es vermittelt immerhin ein Erwartungs-Gefühl wie vor Weihnachten, nachdem nun auch das Osterfest angeordnet ausfällt.

Bild 1

Die Untertanen müssen endlich erkennen, dass das Grundgesetz nicht für sie, sondern für „die Partei“ zur freien Verfügung geschaffen wurde.

Großzügig lassen wir aber in ganz kleinem Rahmen zu, dass unter strengsten Auflagen „getestet“ wird, ob das, was sich woanders seit Langem bewährt hat, vielleicht bewähren könnte

Nachdem ein kleines Städtchen im Land belegt, dass man mit Überlegen und sinnvollen Maßnahmen wesentlich billiger und vor allem viel erfolgreicher zurechtkommt, was allerdings auch ein ganzes Land im Norden zeigt, dessen Erfolg trotzt aller negativen Stör-Propaganda unserer Medien doch zu bekannt wurde, war es politisch wohl nicht mehr möglich, dies weiterhin vollkommen zu ignorieren.

Und so wurde nun nach über einem Jahr Corona erstmals „erlaubt“ die seit langer Zeit funktionierenden Öffnungsmodelle von Tübingen und Schweden für ganz Wenige unter sturer Einhaltung regulatorischer und technisch noch gar nicht in funktionierende Form verfügbarer Maßnahmen „an-testen“ zu dürfen:

[5] 6. Im Rahmen von zeitlich befristeten Modellprojekten können die Länder in einigen ausgewählten Regionen, mit strengen Schutzmaßnahmen und einem Testkonzept einzelne Bereiche des öffentlichen Lebens öffnen, um die Umsetzbarkeit von Öffnungsschritten unter Nutzung eines konsequenten Testregimes zu untersuchen.

Zentrale Bedingungen dabei sind lückenlose negative Testergebnisse als Zugangskriterium, IT-gestützte Prozesse zur Kontaktverfolgung und ggf. auch zum Testnachweis, räumliche Abgrenzbarkeit auf der kommunalen Ebene, eine enge Rückkopplung an den Öffentlichen Gesundheitsdienst und klare Abbruchkriterien im Misserfolgsfalle.

Nehme man einmal an, das immerwährende Problem nicht funktionierender „IT-gestützter Prozesse“ in öffentlicher Verantwortung würde von unserer zwischenzeitlich von der medialen Bildfläche gänzlich verschwundenen Ministerin für Digitalisierung gelöst werden, stellt sich die Frage, ob schon jemand bedacht hat, wie verblüffend (katastrophal) Schnelltest derzeit funktionieren. Dazu ein aktuelles Beispiel:

Im beschaulichen, fränkischen Städtchen Altdorf wurden 180 Schüler eines Gymnasiums von Fachpersonen (Leitung: BRK, Testpersonal: Mehrere Ärzte, Krankenschwestern und ein Rettungssanitäter) einem Corona-Schnelltest unterzogen [6]. Der Schnelltest meldete davon 29 Schüler als Corona-Positiv. Im Schnelltest positiv gemeldete müssen dann einem weiteren PCR-Test unterzogen werden. Danach blieb nur noch ein!!! positives Ergebnis übrig.

Wenn solche „Testqualitäten“ massenhaft eingesetzt werden, ist das völlige Chaos vorhersehbar.

Beschlossene Maßnahmen und vergleichende Datenbasis

Als Bürger versucht man manchmal, Entscheidungswege unserer „Intelligenz“ Politiker nachzuvollziehen. Obwohl das (nicht nur) bezüglich „Corona“ dem Autor seit Langem nicht mehr gelingt, anbei wieder recherchierte und teils aufbereitete Daten, anhand derer jeder Leser entscheiden mag ob er die Maßnahmen und Verlautbarungen unserer Politiker und deren Hofberaterschranzen für sinnvoll und notwendig hält.

Eine Übersicht lieferte Achgut: [1] Achgut 22.03.2021: Lockdown für die Panikmacher! Oder: Lest doch bitte die RKI-Zahlen

Darin wird der RKI-Coronabericht [7] 2021-03-18-de.pdf (rki.de) rezensiert.

Denn dieser Bericht widerlegt in vielen Details die alarmistischen Aussagen des gleichen Instituts. Das möge aber bitte jeder selbst nachlesen. Anbei nur ein paar „Auszugsplitter“:

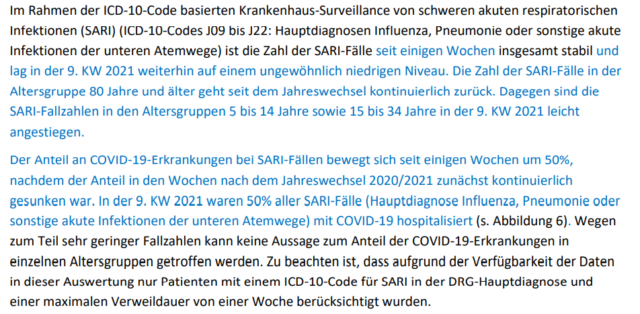

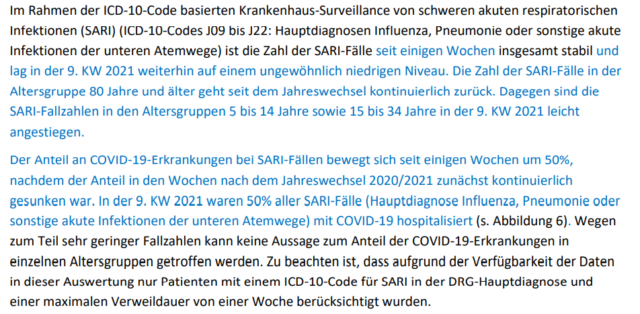

Bild 2 RKI-Bericht Auszug [7]

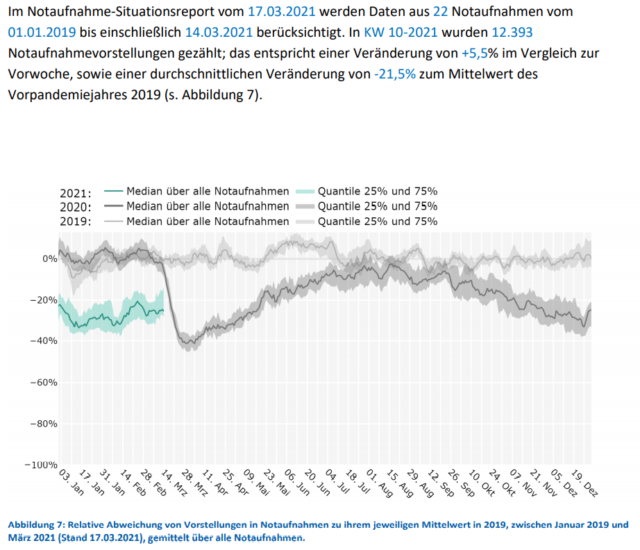

Bild 3 RKI-Bericht Auszug [7]

Anbei wieder lokale Beispiele, weil solche die Diskrepanz zwischen behördlichen Maßnahmen und der (nicht erkennbaren) Gefährdung konkreter aufzeigen.

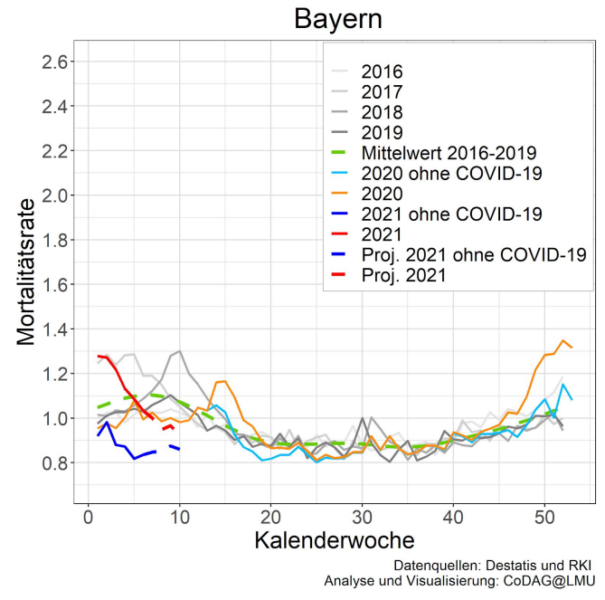

Nürnberg und Fürth

Die direkt nebeneinander liegenden Städte Nürnberg und Fürth haben eine 7-Tage-Inzidenz von deutlich über 100 und deshalb die vorgeschriebenen, vom Landesvater Söder verordneten Einschränkungen unerbittlich umgesetzt.

Nur wenn zum Beispiel durch (den Behörden bekannte) Meldeverzögerungen die Inzidenz doch mal kurzzeitig unter 100 rutscht, wagt es eine der Städte, wieder – teilweise nur für einen Tag – von den verordneten Restriktionen abzuweichen, da es „die Zahl“ erlaubt. Eine perfekte Demonstration, dass die Verantwortlichen in den Behörden jegliches „Wissen“ (so solches vorhanden sein sollte) vergessen und streng nach Zahlenwertvorgaben handeln.

Ansonsten wagen es beide „Städte“ selbst bei der kleinsten Inzidenz-Abweichung partout nicht, von den verordneten Vorgaben abzuweichen, denn eigenständiges Denken und Mut zu entscheiden ist den dafür Zuständigen und den Stadtspitzen vollkommen fremd. Weder die Bayerische SPD, noch die CSU erkennen, wie sinnvoll es sein könnte, für „spätere Zeiten“ einen Märtyrer – wie es die GRÜNEN (notgedrungen) mit (dem renitenten) B. Palmer „machen“ – walten zu lassen, zur Belegung, wie mutig und richtig (jemand von der Partei) schon gehandelt hat, als sich noch alle vehement dagegen stemmten …

Dabei ist weder in Nürnberg, noch im kleinen Städtchen Fürth auch nur entfernt eine Corona-Gefährdung der Bevölkerung erkennbar.

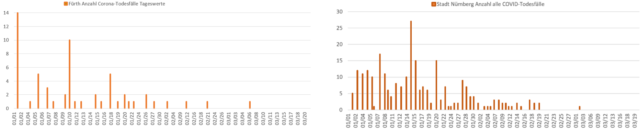

Um das zu „sehen“, muss man sich allerdings die Daten des RKI laden und die Werte mühsam „zusammenfieseln“, um sie grafisch darstellen zu können:

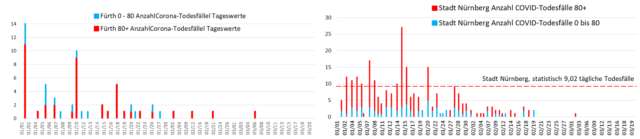

Nürnberg Datenabruf: 21.03.2021; Datenstand: 20.03.2021

Fürth Datenabruf: 22.03.2021; Datenstand: 21.03.2021

Zuerst der überall gemeldete, „exponentielle Anstieg“ der Fallzahlen. Beide Städte verweigern sich vehement, dabei „mitzumachen“. Man gewinnt den Eindruck, dass „exponentiell“ inzwischen als reines Modewort verwendet wird, um „mathematische Kompetenz“ auszuweisen:

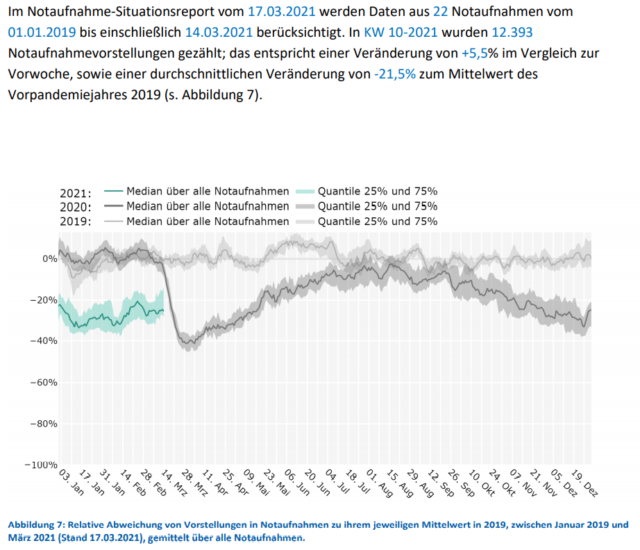

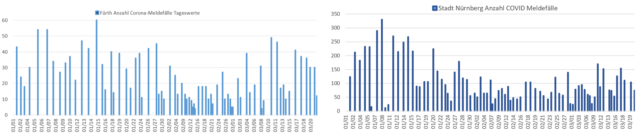

Bild 4 Städte Fürth und Nürnberg, Tageswerte Corona-Meldefälle seit dem 01.01.2021. Grafik vom Autor erstellt. Datenquelle: RKI-Coronadaten

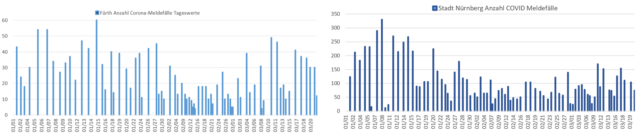

Ein Vergleich der Fallzahlen mit den Corona-Todesfällen zeigt immer neu, dass die Inzidenz keinerlei Aussage über eine Gefährlichkeit liefert (mögen es die unfehlbare Merkel und der heilige Söder auch immer neu behaupten) – und, dass eine solche in beiden Städten auch weiterhin nicht entfernt besteht:

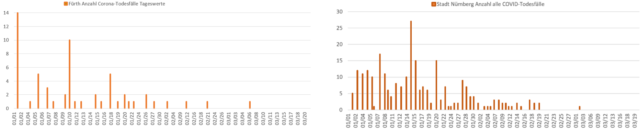

Bild 5 Städte Fürth und Nürnberg, Tageswerte Corona-Todesfälle seit dem 01.01.2021. Grafik vom Autor erstellt. Datenquelle: RKI-Coronadaten

Zum Schluss zeigt ein Vergleich der altersbedingten Coronamortalität, dass alleine schon der Schutz der Hoch-Risikogruppe ab ca. 75+ zur Eindämmung der restlichen Gefährdung ausreicht, weil für die Altersgruppen darunter die Mortalitätsgefahr gering bis sehr gering ist.

Auszug aus [8]: Bisher sind in ganz Deutschland an oder mit Corona gestorben:

10 Kinder und Jugendliche unter 20 Jahren

60 Menschen unter 30 Jahren

193 Menschen unter 40 Jahren

591 Menschen unter 50 Jahren

2.502 Menschen unter 60 sind bisher an oder mit Corona gestorben

8.181 Menschen unter 70 sind bisher an oder mit Corona gestorben

65.264 Menschen, die älter sind als siebzig Jahre, sind bisher an oder mit Corona gestorben

Insgesamt sind über grob ein „Coronajahr“ bisher 73.445 Menschen in Deutschland an oder die Meisten eher mit Corona verstorben. Im Jahr 2018 sind „ohne“ Corona 953.295 Personen verstorben. Der Anteil an- oder vor allem mit Corona-Verstorbenen beträgt also ungefähr 7,7 … 10 %.

Grafik Nürnberg-Fürth:

Bild 6 Städte Fürth und Nürnberg, Tageswerte Corona-Todesfälle unter und über dem Alter 80+ seit dem 01.01.2021. Grafik vom Autor erstellt. Datenquelle: RKI-Coronadaten

Herr Dr. Wagner vom Klinikum Fürth sagte dazu (Zitierung aus einer Lokalausgabe vom 24.03.): „ … ich könnte mir schon vorstellen, dass es weniger Tote gibt ...

Wird die Hysterie so weitergeführt (der Klimawandel ist ein Beispiel, dass es passiert, wenn der „Nutzen“ für Günstlinge eine Kippschwelle überschreitet), dann wird ab jetzt jede Grippewelle zum Problem „Jahrhundert + x“ und eine Goldgrube für Pharmakonzerne.

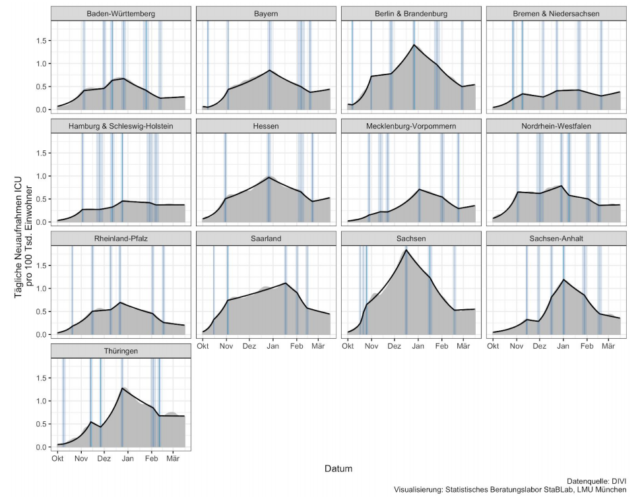

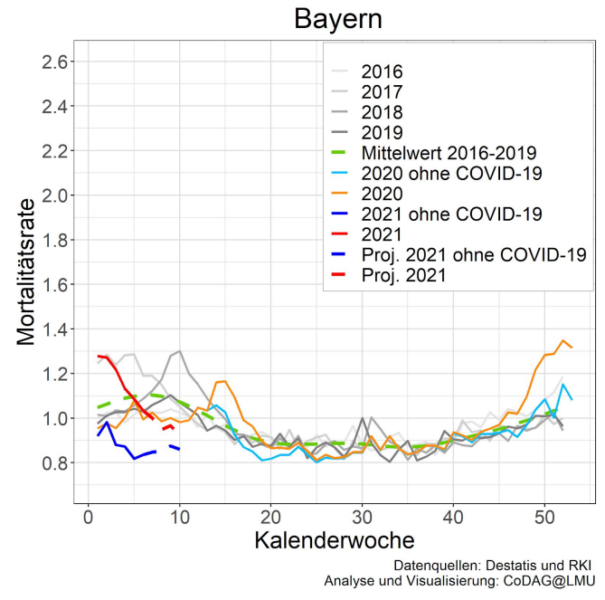

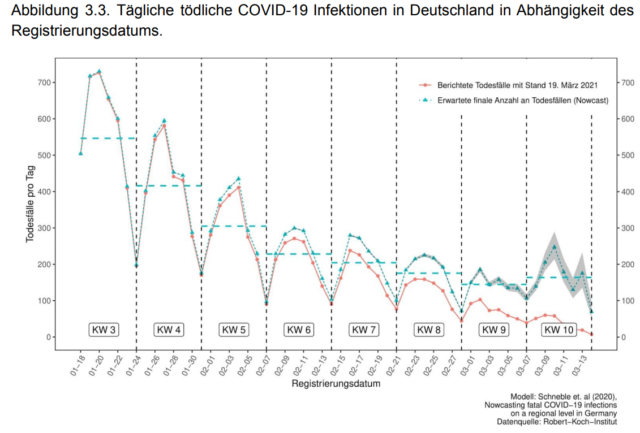

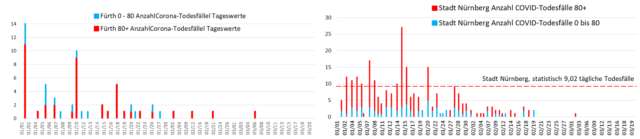

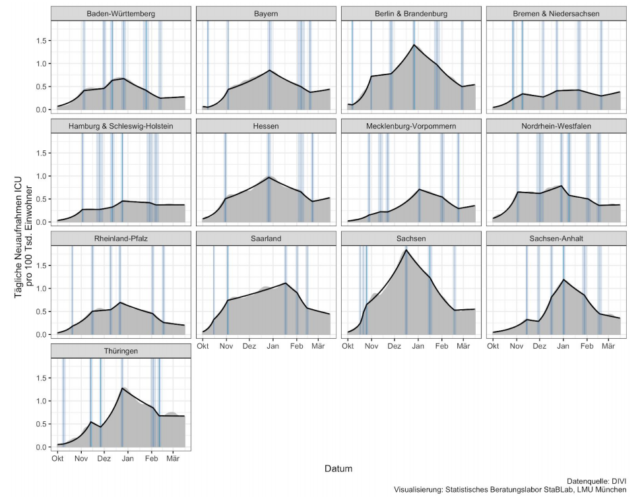

Wöchentlicher „Coronabericht“ des statistischen Instituts der Uni München

Danach hat es weder im Jahr 2020 eine Übersterblichkeit gegeben, noch besteht derzeit eine. Auch eine Überlastung der Intensivstationen ist nicht erkennbar.

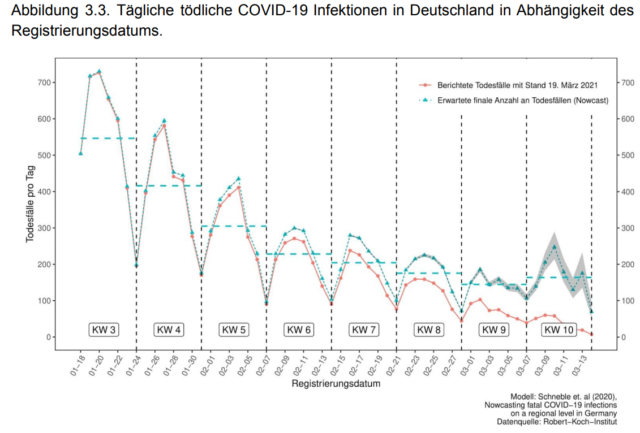

Im aktuellen Bericht „CODAG Bericht Nr. 11 19.03.2021“ steht: … In allen drei Graphiken ist ein Rückgang der tödlichen COVID-19 Fälle bis einschließlich Kalenderwoche 9 zu erkennen. Für ganz Deutschland sind nach unseren Berechnungen weniger als 200 tödliche Todesfälle im Tagesschnitt zu erwarten. Dies ist ca. 75% weniger als noch um den Jahreswechsel. Für Kalenderwoche 10 setzt sich der abfallende Trend der tödlichen COVID-19 Fälle sowohl bei den unter 80-Jährigen als auch bei den über 80-Jährigen nicht fort. Allerdings ist zu beachten, dass die Schätzung mit statistischer Unsicherheit belegt ist, was durch den grauen Hintergrund in Form eines 95% Konfidenzintervall visualisiert ist …

Bild 7 Bundesländer, tägliche Neuaufnahmen ICU/100 Tsd. Einwohner. Bild aus CODAG Bericht Nr. 11 19.03.2021

Bild 8 Bayern Mortalitätsrate. Bild aus CODAG Bericht Nr. 11 19.03.2021

Bild 9 Deutschland, tägliche, tödliche COVID-19 Infektionen. Bild aus CODAG Bericht Nr. 11 19.03.2021

Trotzdem wurde ein noch schlimmererer Lockdown beschlossen.

Wie sehen es unsere Medien

Unsere Medien ereifern sich über die gerade beschlossenen Maßnahmen. Allerdings nicht, weil sie diese für übertrieben halten, sondern, weil sie diese „Härte“ schon längst gesehen haben wollten.

WELT, 23.03.2021: „Deutschlands Regierung kapituliert vor den Grundzügen der Vernunft“

„… Das eigentliche Versagen ist nicht, was gestern beschlossen wurde. Das eigentliche Versagen ist, dass die deutsche Politik gar keine Alternativen mehr zum Shutdown hatte. Weil in den vergangenen Monaten so viel versemmelt wurde, dass Lockerungen in der Tat nun keine Option mehr waren …

Dabei wären die anhaltenden Einschränkungen der Freiheitsrechte vermeidbar gewesen, hätte die Politik in der Vergangenheit konsequenter und entschlossener gehandelt. Das gilt für beide Disziplinen der Pandemiebekämpfung. Für das Shutdown-Management. Und für die Beschaffung von Hilfsmitteln und deren systematischen Einsatz …

So steht die Bundesregierung im März 2021 ähnlich hilflos da wie im März 2020. Damals war das verständlich, heute ist es unverzeihlich.“

Die „Welt“ zitiert hier den „Spiegel“. Nur fragt man sich: Haben die Redaktionen dieser Medien überhaupt schon einmal die wirklichen Zahlen angesehen? Wohl kaum.

Aber es ging wohl um etwas anderes. Die unfehlbare Merkel muss weiterhin gelobt und unfehlbar bleiben:

WELT, 23.03.2021: (Hier zitiert sie aus der taz) … „Dass sich die Länderchef:innen beim letzten Treffen Anfang März mit ihrer Linie gegen Merkel durchgesetzt haben, nicht mehr die Unterschreitung der Schwelle von 35 Neuinfektionen pro 100.000 Einwohner:innen binnen sieben Tagen als Kriterium für mögliche Lockerungen zu definieren, rächt sich inzwischen.

Als ob das nicht reicht, werden schon die nächsten Horrorszenarien vermittelt. Wie beim Klimawandel nun als Simulation:

Tagesspiegel, 22.03.2021: „Notbremse wird daran nichts ändern“: Modellierung zeigt dramatische, dritte Corona-Welle in Deutschland

Berliner Forscher warnen in einer Studie für den Bund-Länder-Gipfel vor stark steigenden Inzidenzen. Sie empfehlen, auf jegliche Kontakte in Räumen zu verzichten.

Die dritte Welle der Covid-19-Pandemie könnte zu deutlich höheren Inzidenzen führen als die zweite. Das ist das Ergebnis einer neuen Modellierung vom Fachgebiet Verkehrssystemplanung und Verkehrstelematik von Kai Nagel an der TU Berlin.

„Daran wird auch eine potenzielle Notbremse, wie sie eventuell am 22. März 2021 in der Bund-Länder-Konferenz entschieden wird, nichts mehr ändern“, schreiben die Forschenden in einer Untersuchung, die am Montag auf dem Corona-Gipfel von Bund und Ländern vorgestellt werden sollte.

“Berater“

„Verlassen“ wir einmal die sattsam bekannten Hofberaterschranzen, welche ausschließlich das liefern – inzwischen sogar auf Bestellung – was die Politikkasperriege in Berlin hören möchte. Auch lokale Fachpersonen scheuen sich nicht, wirklich Sonderbares zu publizieren.

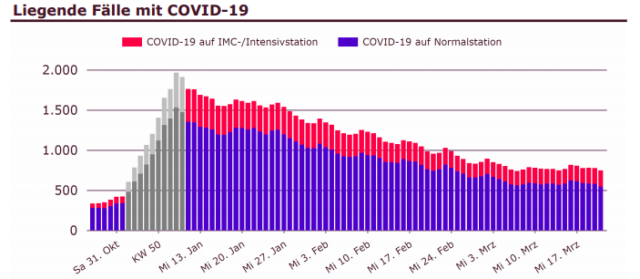

Der Pandemiebeauftragte des Fürther Klinikums „geht“ nun auch ins Fernsehen, um seine Ansicht über erforderliche Coronamaßnahmen in die Breite zu bringen (und vielleicht, um irgendwo zu zeigen, dass man auf ihn zählen kann):

In der lokalen Zeitung führte es Herr Dr. M. Wagner aus und erklärte dazu in einem Artikel: „Wieder harsche Politik-Schelte aus dem Klinikum“, dass er von der Ministerpräsidentenkonferenz bezüglich der Coronaeinschränkungen für die Bevölkerung ein „agileres“ – also härteres Vorgehen – fordert.

Begründet wurde dies mit (Zitierungen aus dem Zeitungsartikel):

… das Aufschieben eines erneuten Lockdowns … dieser ist … aufgrund des exponentiellen Anstiegs der Neuinfektionen … aus medizinischer und epidemiologischer Sicht unausweichlich geworden

… Zum anderen steige die Zahl der Coronatoten … „dieses Mal werden es Jüngere sein“ …

… Bitte passen Sie ihre Entscheidungsprozesse und Strategien dem Virus und den damit verbundenen Herausforderungen an. wir können es uns einfach nicht mehr leisten zu warten …

Dabei hatte dieser Mediziner in der lokalen Tageszeitung am 05.03. noch stolz berichtet, wie erfolgreich man in seinem Klinikum Covid-Infizierte inzwischen behandeln kann:

Herr Dr. Wagner: „Inzwischen gebe es gute Therapiemöglichkeiten bei einer Covid-19-Erkrankung, zum Beispiel mit Antikörpern … sechs Patienten hatten sich mit dem Virus infiziert … kein Einziger ist danach an Covid erkrankt … “.

Wie in solch extremen Fällen von Diskrepanz zwischen Aussagen und Daten (hier den lokalen von Fürth und Nürnberg) „üblich“, fragte der Autor bei dieser Fachperson nach Belegen an:

Corona-Daten Fürth und Nürnberg

Die aktuellen Daten des RKI für Fürth und Nürnberg (sowie alle weiter gelisteten), von mir grafisch aufbereitet, zeigen weder:

einen „exponentiellen Anstieg“ der Fallzahlen,

noch eine erhöhte Sterblichkeit an Corona,

noch eine Erhöhung der Sterblichkeit jüngerer Jahrgänge an Corona

erkennbar ist dazu, dass die Inzidenz keinerlei Aussage zur wirklichen Gefährdung liefert

Daraus würde ich ableiten, dass mit gesichertem Schutz der einzig wirklich gefährdeten Personen über 75 eine „Freigabe“ des öffentlichen- und beruflichen Lebens problemlos durchführbar und damit dringend angebracht wäre …

Eine Antwort wird nicht erwartet. Sollte sie doch noch kommen, wird sie mindestens im Kommentarteil nachgetragen.

„Die Intensivstationen füllen sich wieder“

Aktuell häufen sich Meldungen von Kliniken, dass ihre Intensivstationen durch die „Dritte Welle“ – oder laut Söder „neue Pandemie“ überlastet sind, beziehungsweise es werden könnten.

So meldete eine Lokalzeitung am 24.03., dass die Zahl der Corona-Intensivpatienten in Bayern zwar von 912 auf 428 reduzierte, nun aber wieder auf 519 erhöht hat.

Das Klinikum Fürth meldete, dass es zwar einst einen Höchststand von 68 Covid-Patienten hatte, heute aber schon wieder 25. Ein Problem sei, dass teils bei nur einem Intensivpatienten mehr, eine ganze Intensiveinheit mit 5 Betten für Coronapatienten „umgewidmet“ werden muss.

In den Krankenhäusern des Rettungsdienstbereiches Nürnberg liegt die Zahl der Covid-19-Patienten bei etwa einem Drittel der Behandlungszeiten während der zweiten Welle und bei den Intensivpatienten bei ca. der Hälfte.

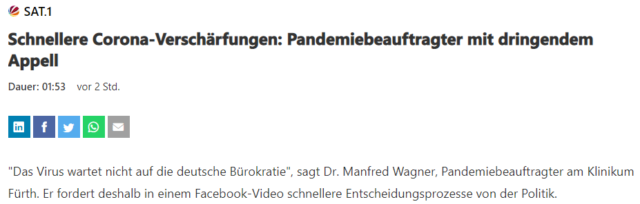

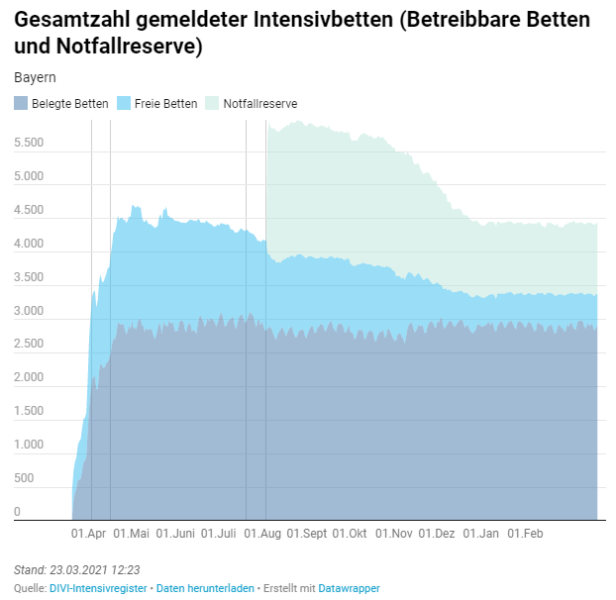

Beim Intensivregister sieht man, dass in Bayern die Anzahl der belegten Notfallbetten seit dem 1. April letzten Jahres gleich geblieben ist (da Corona im Sommer eine längere Pause machte, ist es wohl die Belegung mit allen Fällen), und die Notfallreserve zwischenzeitlich (wohl aus Kostengründen?) erheblich abgebaut wurde.

Bild 11 Angaben des DIVI für Bayern

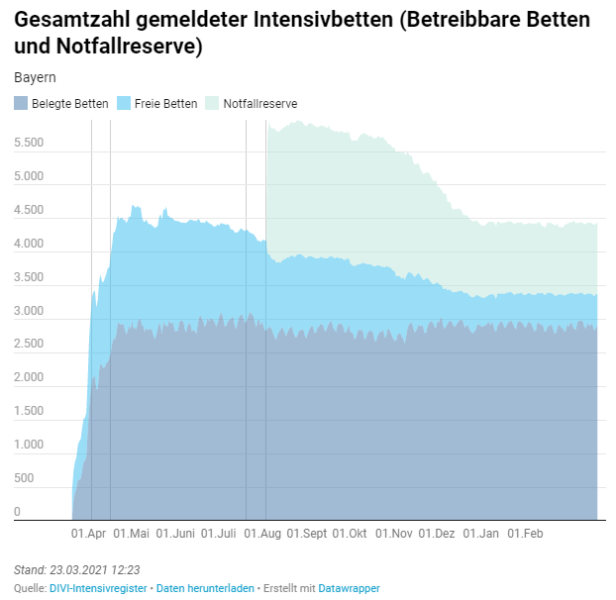

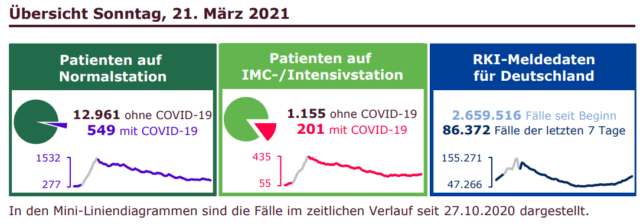

Vergleicht man mit den Angaben der Helios-Klinikgruppe, wird man den Verdacht nicht los, dass bei den Darstellungen auch Geldthemen eine nicht zu unterschätzende Rolle spielen.

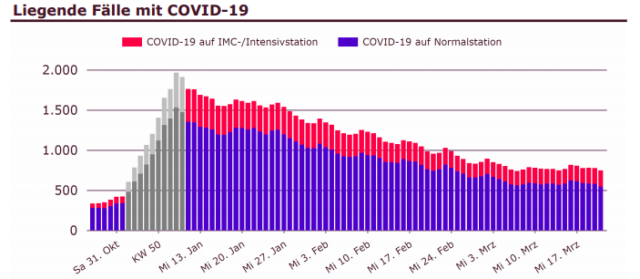

Die Helios-Klinikgruppe gibt wöchentlich Auslastungsdaten zu Corona heraus.

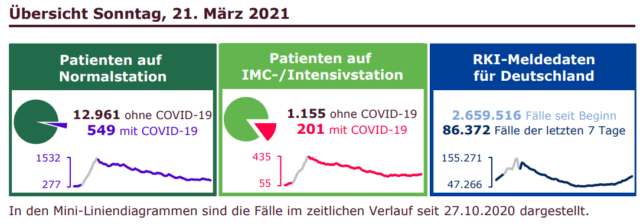

Helios Kliniken Information zu aktuellen COVID-19-Fallzahlen Übersicht Sonntag, 21. März 2021:

Bild 12 Helios Kliniken, Daten ab dem 27.10.2021. Datenstand: 21. März 2021, COVID-19-Daten

Bild 13 Helios Kliniken, Daten ab dem 27.10.2021. Datenstand: 21. März 2021, COVID-19-Daten

Wie beim Klimawandel: Sicher ist nur, dass nichts sicher ist

Nach dem Absenden dieses Artikels kam die Meldung: dpa – Mittwoch, 24. März 2021: Kreise: Osterruhe soll gekippt werden – Kanzlerin Angela Merkel (CDU) hat nach massiver Kritik entschieden, den Bund-Länder-Entscheid zur sogenannten Osterruhe zu stoppen.

Insofern interessant, weil genau solches Vorgehen bei „hart aber fair“ massivst angeprangert wurde. Aber nach über einem Jahr „Corona“ wundert einen wirklich nichts mehr …

Quellen

[1] Achgut 22.03.2021: Lockdown für die Panikmacher! Oder: Lest doch bitte die RKI-Zahlen

[2] Tichys Einblick, 23.03.2021: Karwoche mit Merkel – Lockdown total: Lebensmittelgeschäfte zu, kein Urlaub, keine Gottesdienste, „Ansammlungsverbot“

[3] dpa 23.03.2021: Söder: Die Lage ist ernst und wird sehr viel ernster werden

[4] EIKE 11. März 2021: Wartet Nürnberg nun auf Corona-Auferstehungen…

[5] Videokonferenz der Bundeskanzlerin mit den Regierungschefinnen und Regierungschefs der Länder am 22. März 2021 Beschluss

[6] Lokalausgabe der Nordbayerischen Nachrichten vom 17.03.2021: „Schnelltests werfen Fragen auf“

[7] RKI-Coronabericht 2021-03-18-de.pdf (rki.de)

[8] Achgut, 16. März 2021: Ein Jahr Corona – Die aktuellen Zahlen

[9] Tichys Einblick 23. März 2021: Verzweifeltes Regierungs-Retten bei Hart aber Fair : „Wir hatten nie einen Lockdown“