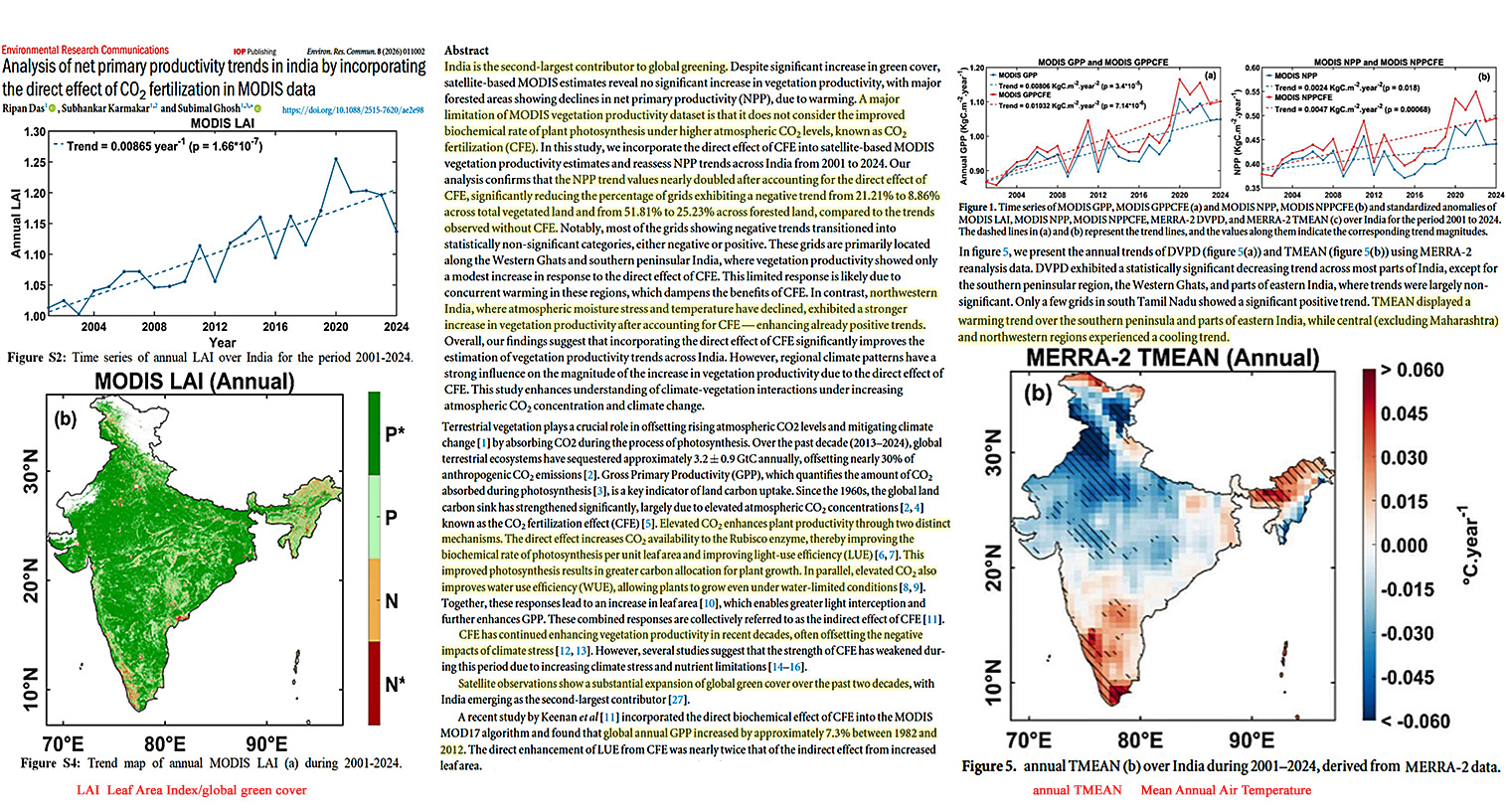

Vorbemerkung: Und wieder hat sich eine längere Reihe von Kälte-Ereignissen angesammelt. Schwerpunkt sind nach wie vor die Osthälfte der USA sowie Mittel- und Ostasien, aber auch das östliche Mitteleuropa. Man könnte ein Wort unseres „Freundes“ Hans-Joachim Schellnhuber anbringen, der mal gesagt hat (Zitat) „Man kann aus einem Einzelereignis noch keinen Trend ableiten. Aber natürlich ergibt die Summe der Einzelereignisse schon einen Trend“.

Meldungen vom 2. Februar 2026:

Japan: Stärkster Schneefall in Aomori seit 80 Jahren

Am Sonntagnachmittag hat sich die Schneedecke in Aomori in Japan über 180 cm erhöht. Dies wurde von der JMA als die höchste Schneemenge in der Stadt seit 80 Jahren bestätigt.

Die Höhe und Dauerhaftigkeit der Schneemassen übertreffen alles, was in der modernen lokalen Geschichte beobachtet wurde, und beeinträchtigen den Verkehr und das tägliche Leben in der gesamten Präfektur Aomori erheblich.

—————————–

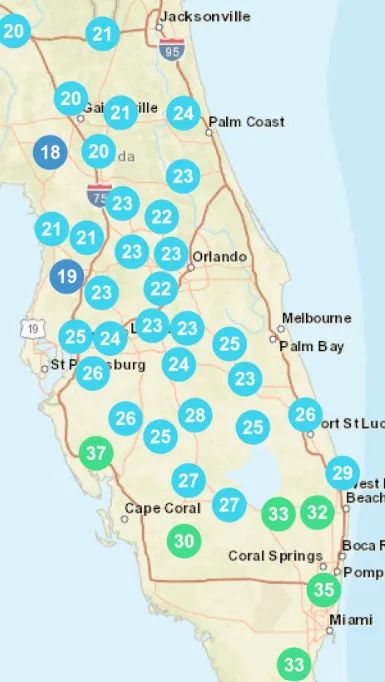

USA: Luft arktischen Ursprungs erreicht Florida

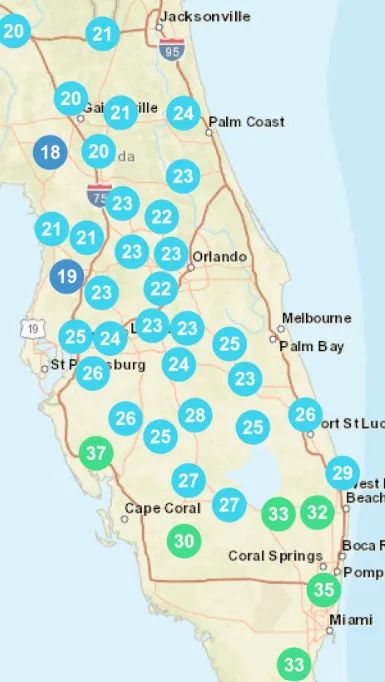

Ein starker Kälteeinbruch brachte am Wochenende Rekordkälte in den Südosten der USA, wodurch Florida von extrem niedrigen Temperaturen heimgesucht wurde und es entlang der Küste von Carolina zu Schneestürmen kam.

Die Küstengebiete von Emerald Isle bis Swansboro waren von Schneestürmen betroffen, was zu gefährlichen Verkehrsbedingungen und weitreichenden Beeinträchtigungen führte.

Hinter dem Sturm drang Luft arktischen Ursprungs fast ungehindert nach Süden vor.

Die Kälte erreichte sogar Südflorida, und für die gesamte Halbinsel wurden Frost- und Vereisungswarnungen ausgegeben. Zentralflorida verzeichnete historische Tiefstwerte.

Blau hinterlegt sind Temperaturen unter 0°C (32°F). A. d. Übers.

Am 1. Februar fiel die Temperatur in Orlando auf -4 °C und brach damit einen seit rund 90 Jahren bestehenden Rekord von -2 °C. Sanford und Leesburg fielen auf etwa -5 °C und stellten ebenfalls neue Rekorde auf. Selbst Küstenorte an der Atlantikküste Floridas fielen weit unter die saisonalen Normwerte.

…

Derartige Tiefsttemperaturen erhöhen das Risiko von Ernteschäden. Zitrusfrüchtebauern warnten, dass der Frost wahrscheinlich die Knospen der nächsten Saison schädigen würde – eine ernsthafte Sorge für eine Branche, die ohnehin schon zu kämpfen hat.

Auch der Schnee erreichte ungewöhnlich weit südlich gelegene Gebiete. Myrtle Beach beispielsweise verzeichnete die stärksten Schneefälle seit Dezember 1989.

…

—————————–

Der strenge Sommer-Frost in der Antarktis

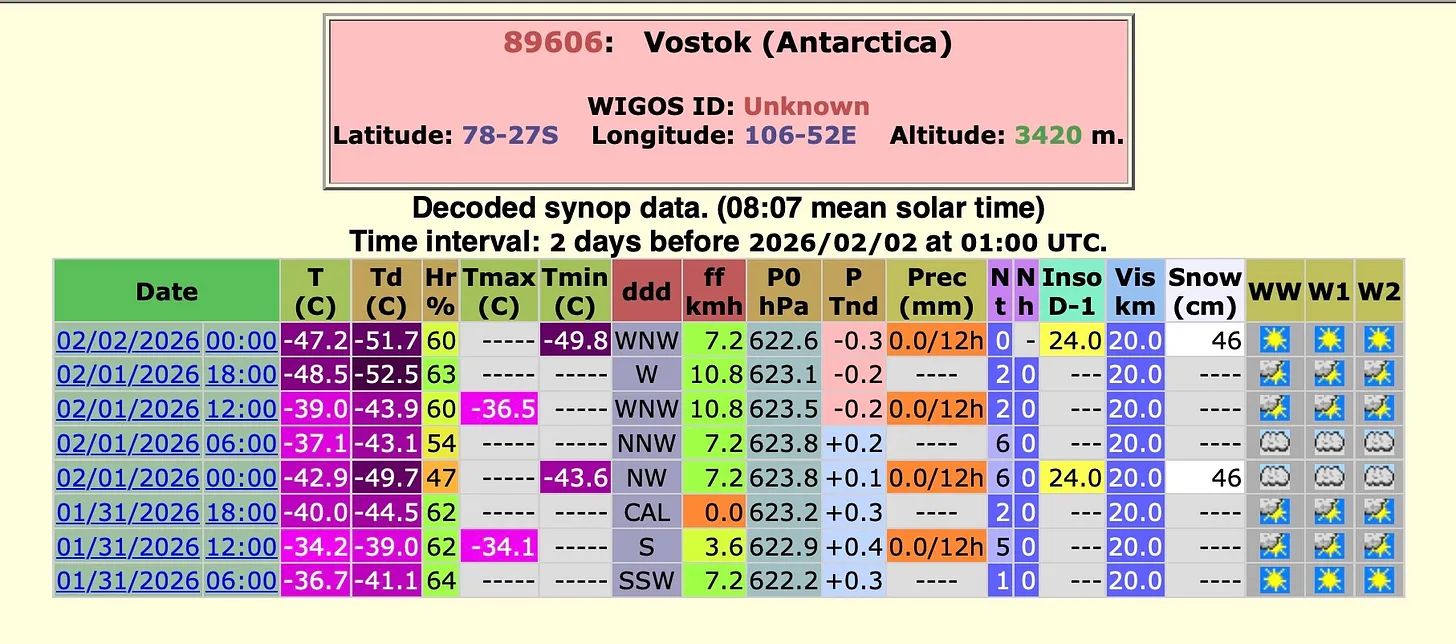

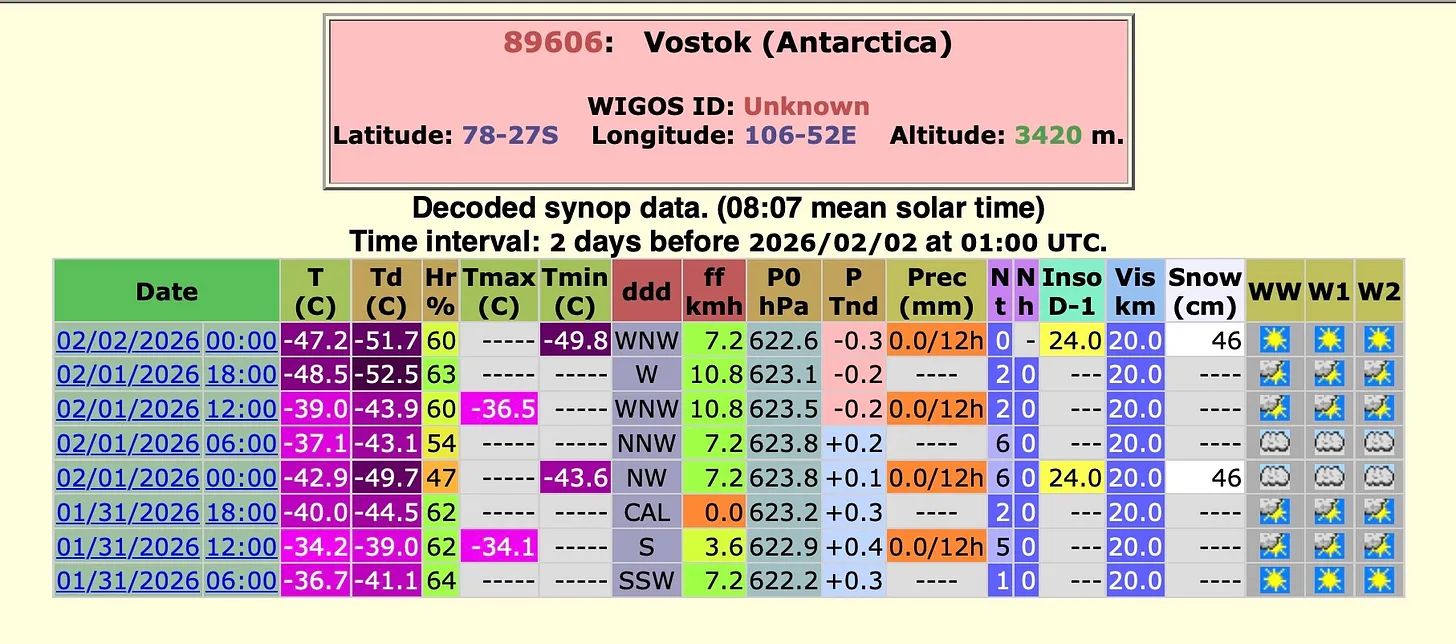

Am 31. Januar verzeichnete die Concordia-Station eine seltene Temperatur von -47,6 °C. Zwei Tage später übertraf Wostok diesen Wert sogar noch und erreichte -49,8 °C.

Dies sind außergewöhnlich niedrige Temperaturen für Anfang Februar während des antarktischen Sommers (wenn die Temperaturen normalerweise ihren jährlichen Höchststand erreichen). Die -49,8 °C in Wostok sind tatsächlich ein Rekord für diese Jahreszeit. Der bisherige Rekord-Tiefstwert für Januar liegt bei -48,7 °C und wurde 2023 gemessen.

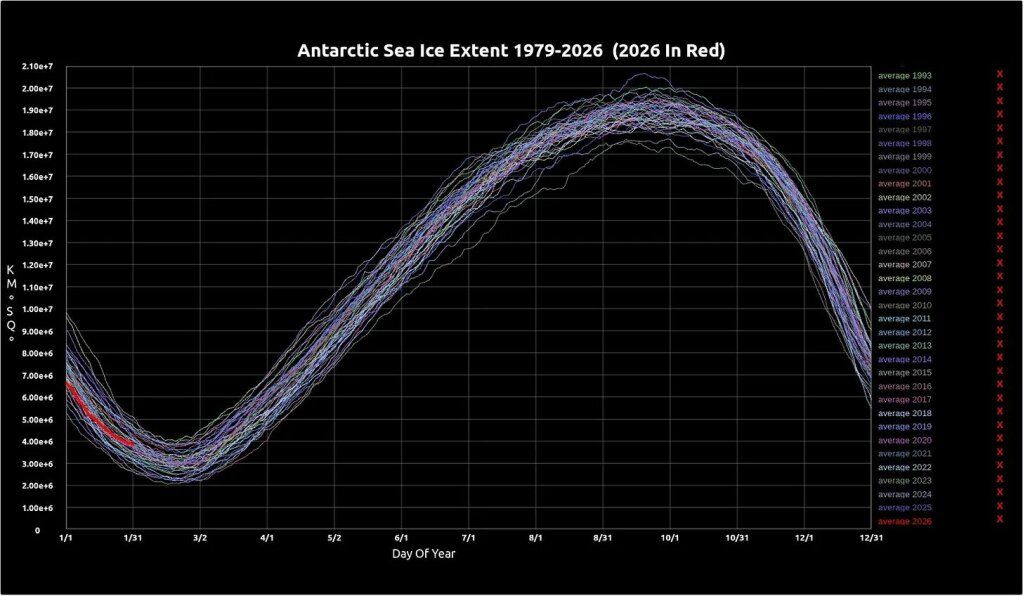

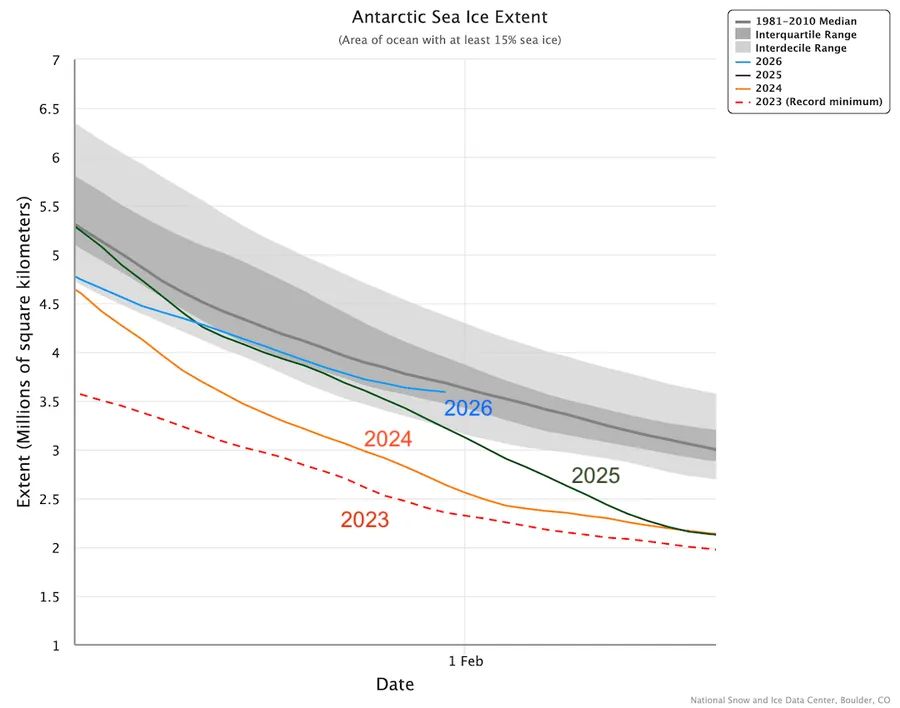

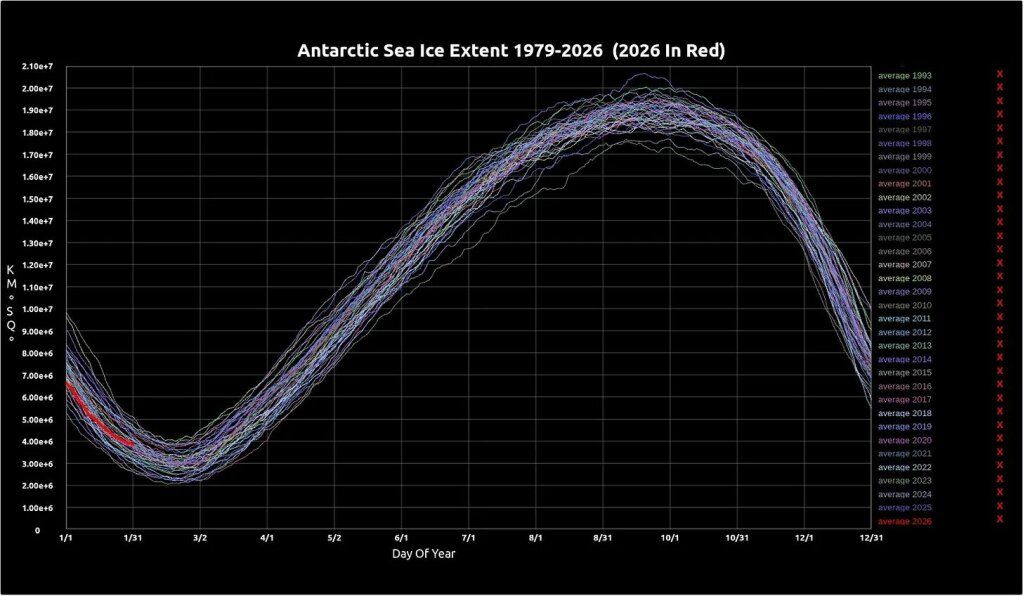

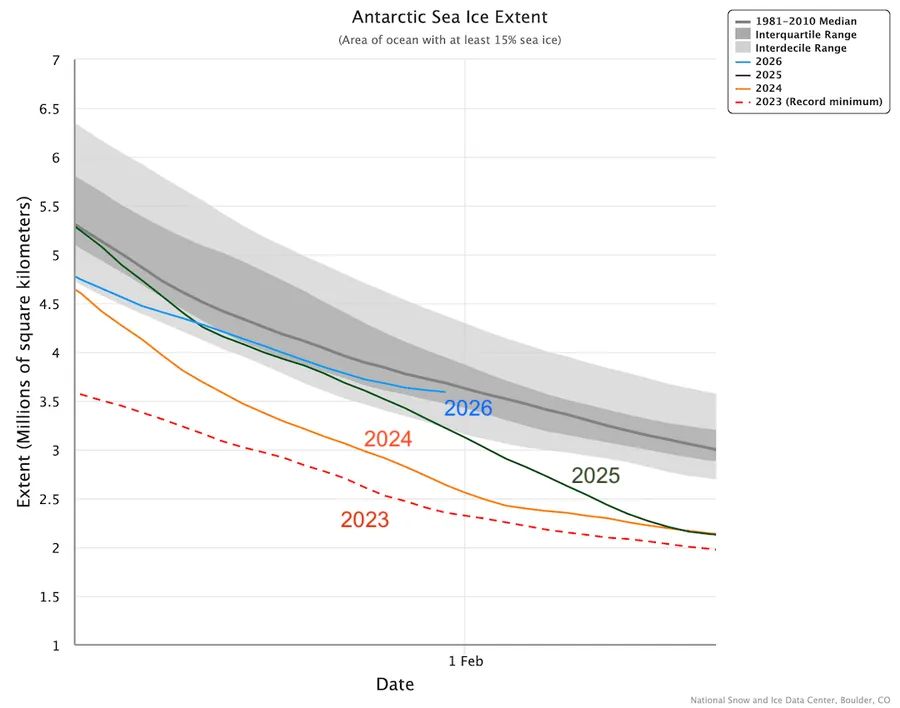

Was die Ausdehnung des Meereises betrifft, so liegt das Jahr 2026 derzeit über dem Durchschnitt seit 1979 (rote Linie) – und schreitet rasch voran:

[Tony Heller]

Link: https://electroverse.substack.com/p/aomoris-heaviest-snowfall-in-80-years?utm_campaign=email-post&r=320l0n&utm_source=substack&utm_medium=email

—————————–

Meldungen vom 3. Februar 2026:

USA: Februar-Frost in Florida

Ein starker arktischer Kälteeinbruch sorgte für eine der kältesten Februarnächte, die Florida seit Jahrzehnten erlebt hat. Die eisige Luft drang bis in die Subtropen vor und stellte eine lange Liste von Monatsrekorden im gesamten Bundesstaat auf oder egalisierte diese.

In Florida fielen die Temperaturen bis -7,8 °C, ein Extremwert für die Halbinsel. Entlang der Zentral- und Ostküste wurden mehrere langjährige Februar-Rekorde gebrochen oder egalisiert.

Sanford und Leesburg fielen jeweils auf -5 °C und erreichten damit die niedrigsten jemals im Februar gemessenen Werte. Daytona Beach fiel auf -5 °C, die tiefste Februar-Temperatur seit Beginn der Wetteraufzeichnungen im Jahr 1923. Melbourne fiel auf -4,4 °C und stellte damit ebenfalls einen neuen Monatsrekord seit Beginn der Aufzeichnungen im Jahr 1937 auf.

Die Kälte drang ohne große Abschwächung nach Süden vor.

Vero Beach verzeichnete -3,3 °C, West Palm Beach fiel auf -1,1 °C und Fort Pierce erreichte -5 °C, was einen neuen Februar-Tiefstwert darstellt und nur wenige Zehntelgrad unter dem Allzeitrekord liegt. Orlando fiel auf -4,4 °C ebenso wie Lakeland – beide gehörten zu den niedrigsten Februarwerten seit Beginn der Aufzeichnungen.

Selbst Südflorida blieb nicht verschont.

Der Miami International Airport verzeichnete 1,7 °C – nur rund 1,5°C unter dem Februar-Rekordtief der Stadt und damit die vierttiefste Februar-Temperatur seit Beginn der Aufzeichnungen im Jahr 1937 und die niedrigste Februar-Temperatur seit 1947.

—————————–

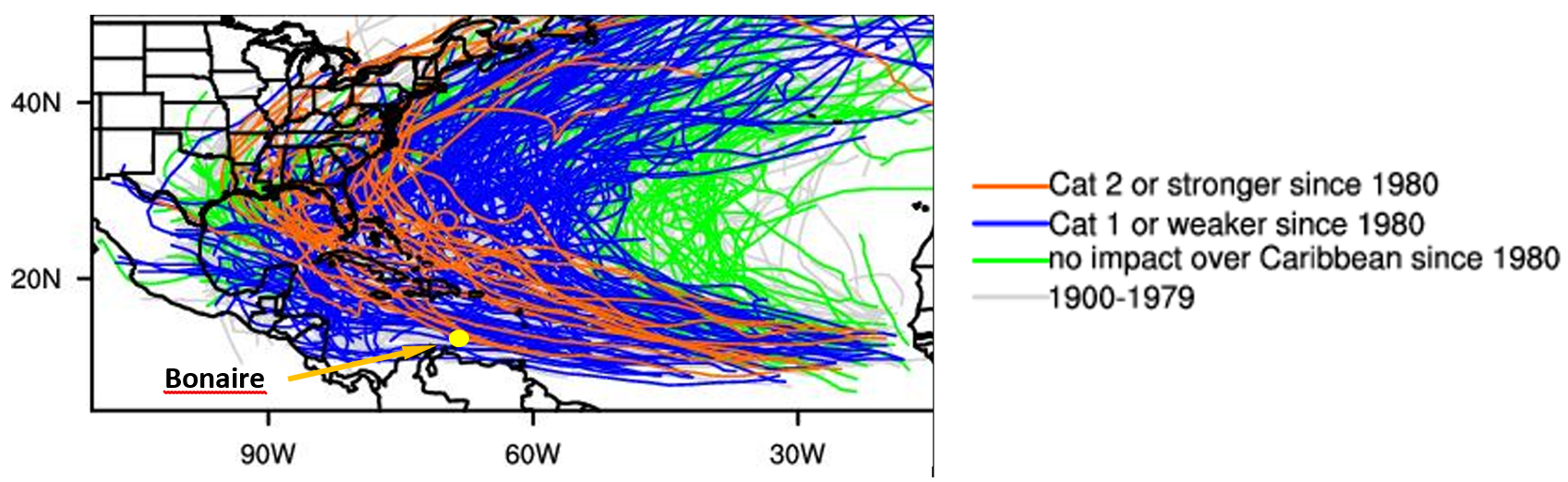

Mittelamerika und Karibik: tropische Kälterekorde gebrochen

Der Kaltluftvorstoß breitete sich sogar noch weiter nach Süden bis in die Tropen hinein aus und brachte in Mittelamerika und der Karibik seltene und in einigen Fällen historische Temperaturen mit sich.

In Belize sank die Temperatur in Gallon Jug auf 5,4 °C. Das ist die niedrigste Temperatur des Landes seit Dezember 1968 und der niedrigste Februar-Wert seit Beginn der Aufzeichnungen im Jahr 1895.

Weiter südlich in El Salvador verschärfte sich die Kälte im Hochland. In Finca Los Andes sank die Temperatur auf 3,5 °C und stellte damit einen neuen Monats-Kälterekord auf.

In Guatemala fiel die Temperatur in Los Altos auf -2 °C, während in Guatemala-Stadt eine seltene Temperatur von 7,2 °C gemessen wurde.

Die Kälte breitete sich auch auf das Karibische Becken aus.

Auf den Bahamas verzeichnete Freeport am Sonntag eine Höchsttemperatur von nur 10,8 °C – die niedrigste Tageshöchsttemperatur, die jemals in diesem Land seit Beginn der Aufzeichnungen im Jahr 1973 gemessen wurde. Im nahe gelegenen Nassau stieg die Temperatur nicht über 15 °C und erreichte damit den niedrigsten jemals dort gemessenen Wert, vergleichbar mit den eisigen Tagen von 1899 und 1977.

Auf dem Marinestützpunkt Guantanamo Bay in Kuba fiel die Temperatur auf 13,9 °C und erreichte damit den niedrigsten Wert seit Beginn der Aufzeichnungen im Jahr 1945. Ebenfalls in Kuba verzeichnete Indio Hatuey in Matanzas 1,4 °C – ein neuer Februar-Rekord, der die alte Bestmarke vom 18. Februar 1996 übertraf.

—————————–

Japan: Allzeit-Schneerekord in Aomori

In der japanischen Stadt Aomori sind in diesem Jahr bisher 183 cm Schnee gefallen, womit der Allzeitrekord von 209 cm aus dem Jahr 1945 bald erreicht sein wird.

Die offiziellen Schneefallaufzeichnungen reichen bis ins späte 19. Jahrhundert zurück, und dieser Winter zählt bereits zu den schneereichsten, die jemals in der Stadt beobachtet wurden. Anhaltende Kälte und Tiefdrucksysteme entlang der Küste des Japanischen Meeres halten den Rekord fest in Reichweite.

Bis zu 1,8 m hohe Schneewände säumen nun die Straßen, überfordern die lokalen Schneeräumkapazitäten und schränken den Zugang zu den Häusern ein.

…

Landesweit hat der anhaltende Schneefall tödliche Folgen.

Seit dem 20. Januar sind laut der Feuerwehr- und Katastrophenschutzbehörde mindestens 30 Menschen bei Unfällen im Zusammenhang mit Schnee in ganz Japan ums Leben gekommen. Viele der Todesopfer sind ältere Menschen, die oft beim Schneeräumen oder durch Dacheinstürze ums Leben kamen.

Angesichts der zunehmenden Schneelast wurde das japanische Militär eingesetzt, um bei der Schneeräumung und der Überprüfung des Wohlergehens der Bevölkerung zu helfen. Die Behörden warnen davor, dass die anhaltende Schneemenge in Verbindung mit periodischen Temperaturschwankungen das Risiko weiterer Dacheinstürze und struktureller Unfälle im Laufe des Winters 2025-26 erhöht.

Link: https://electroverse.substack.com/p/floridas-february-freeze-tropical?utm_campaign=email-post&r=320l0n&utm_source=substack&utm_medium=email

—————————–

Meldungen vom 4. Februar 2026:

Kuba: Erster Frost jemals

Zum ersten Mal seit Beginn der Aufzeichnungen in Kuba wurde eine verifizierte Gefriertemperatur gemessen.

Am Morgen des 3. Februar sank die Temperatur in Indio Hatuey in der Provinz Matanzas auf 0 °C – und stellte damit offiziell einen neuen nationalen Kälterekord für das Land auf. Der bisherige Rekord lag bei 0,6 °C und wurde im Februar 1996 in Bainoa gemessen.

Kuba hatte seit Beginn seiner modernen Wetteraufzeichnungen im Jahr 1909 noch nie zuvor die Gefriergrenze erreicht.

Der Frost war Teil einer größeren Kältewelle, die auf der ganzen Insel Kälterekorde brach.

Diese Meldung hat es sogar in die hiesigen MSM geschafft! A. d. Übers.

In Santi Spiritus sank die Temperatur auf 6 °C, ein Monatsrekord. In Pinar del Rio wurden 6,9 °C gemessen, ein Monatsminimum. Jucarito und Santa Cruz del Sur fielen beide auf 6,8 °C und stellten damit neue Rekordwerte auf. Camaguey erreichte 7,7 °C, ein weiterer Monatsrekord, während Trinidad und Veguitas jeweils 7,8 °C verzeichneten, ebenfalls Monatsrekorde.

Die Kälte machte nicht an Kubas Grenzen Halt.

In Guatemala sank die Temperatur in Flores/Tikal auf 9 °C und erreichte damit den niedrigsten Wert seit Beginn der Aufzeichnungen. In El Salvador fiel die Temperatur in Finca Los Andes auf 3,5 °C, ein weiterer neuer Monatsrekord. Hinzu kommen die Rekorde, die gestern in Belize und auf den Bahamas gebrochen wurden.

Eine wahrhaft historische Kältewelle hat gerade die Tropen heimgesucht.

—————————–

Kälterekorde auch in Europa

In Osteuropa herrscht extreme Kälte, wobei Litauen die niedrigsten Temperaturen seit mindestens 30 Jahren verzeichnet.

In Šeduva sank die Temperatur am 3. Februar auf -34,3 °C, in Ukmergė auf -34 °C und in Joniškis auf -33,9 °C . Dies sind die niedrigsten nationalen Messwerte seit den -35 °C am 8. Februar 1996 in Utena. Viele Stationen brachen langjährige lokale Rekorde, die meist aus den Jahren 1987 und 1980 stammten.

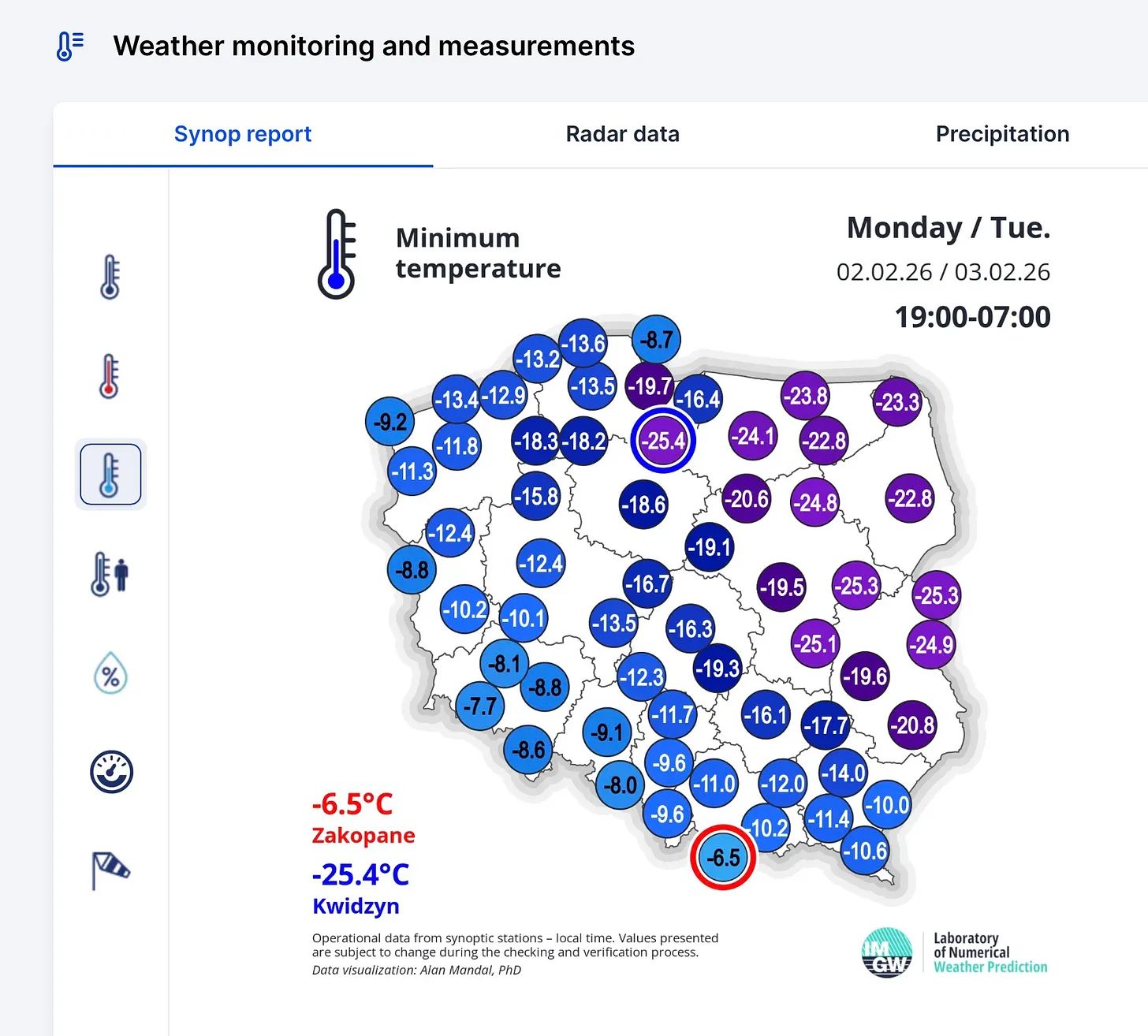

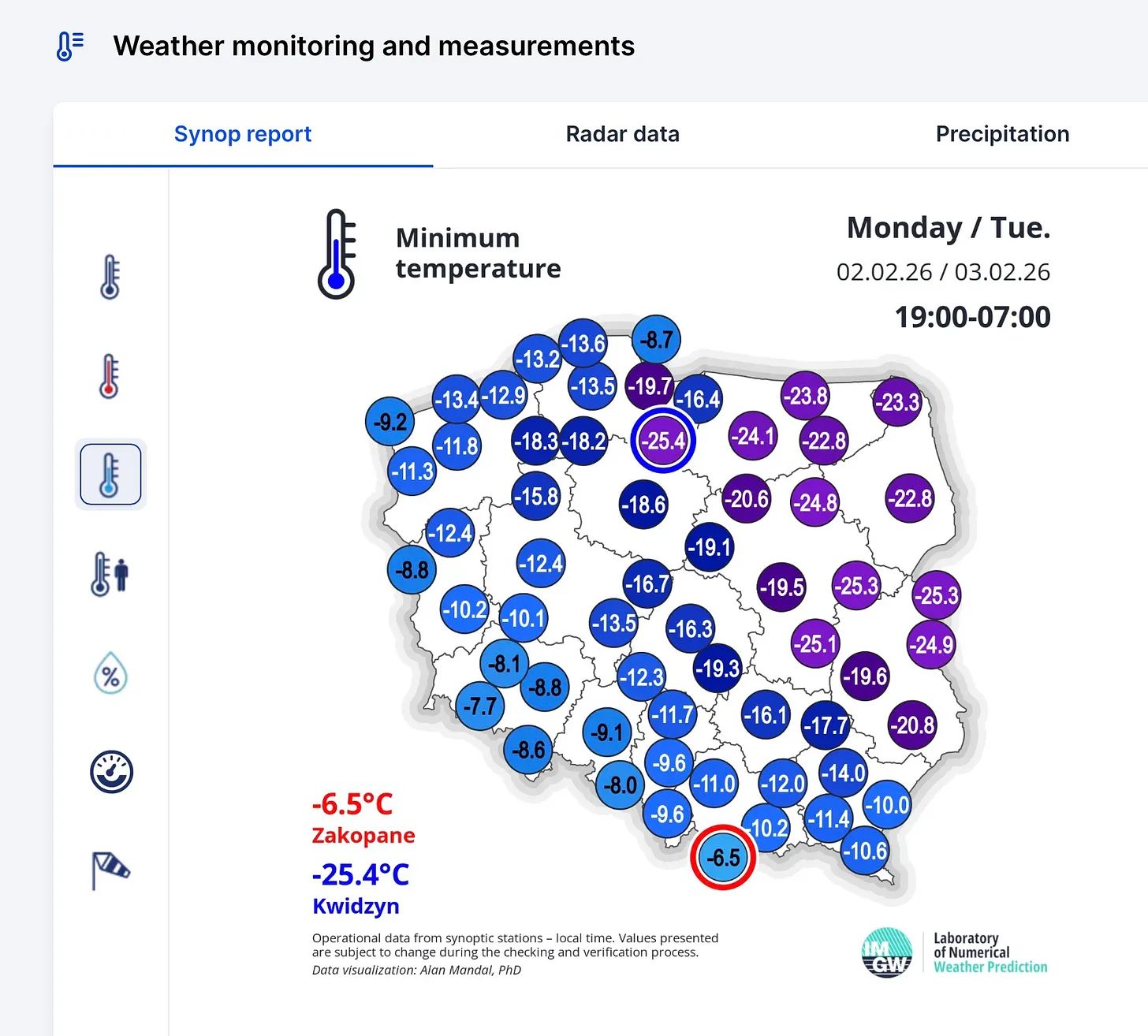

In der nahe gelegenen Ukraine sank die Temperatur auf -27,3 °C – ein außergewöhnlicher Tiefstwert. Polen erreichte -25,4 °C:

Weiter östlich setzt Sibirien den globalen Tiefstwert (außerhalb der Antarktis). Kerbo sank auf -48,5 °C, Komaka auf -47,9 °C und Shelagontsy auf -47,3 °C.

Wendet man sich wieder dem Westen zu, so fällt in den Alpen in höheren Lagen immer mehr Schnee. In Limone Piemonte in den Seealpen in Italien hat starker Schneefall die Schneehöhe bis zum 3. Februar über 170 cm steigen lassen.

Von den jahrzehntelangen Tiefstwerten in Europa über die zunehmende Schneedecke in den Alpen bis hin zu Sibirien, das die kälteste Region der Erde darstellt, bleibt der Winter auf der Nordhalbkugel weiterhin fest verankert.

Ich persönlich finde es bei all dem nicht so schlecht, dass Mittel- und Westeruopa eher auf der milden Seite liegen. In der kommenden Woche wird sich Tauwetter bis zum östlichen Mitteleuropa ausbreiten. A. d. Übers.

—————————–

Antarktis: Abkühlung unter –50°C

Die Antarktis verzeichnet weiterhin außergewöhnlich niedrige Werte für Anfang Februar, wenn die Temperaturen im Inneren des Kontinents normalerweise nahe ihren Jahreshöchstwerten liegen.

Am 3. Februar verzeichnete Concordia um 18:06 UTC -50,9 °C, die erste Temperatur unter -50 °C in dieser Saison auf dem Kontinent.

Die Südpolstation folgte mit der ersten Temperatur unter -40 °C in dieser Saison und einem Tiefstwert von -41,1 °C.

Ein Wert von -50,9 °C Anfang Februar ist höchst ungewöhnlich und wahrscheinlich ein Rekordwert (noch zu bestätigen).

Seit 2023 ist das Meereis in der Antarktis um 1,2 Millionen Quadratkilometer gewachsen, was einem Anstieg von 50 % in nur drei Jahren entspricht. Uns wurde ein anhaltender Rückgang verkauft, wie es die gängigen Modelle vorhersagten. Stattdessen kam es zu einer erstaunlichen Erholung:

Link: https://electroverse.substack.com/p/cuba-records-first-ever-freeze-eastern?utm_campaign=email-post&r=320l0n&utm_source=substack&utm_medium=email

—————————–

Meldungen vom 5. Februar 2026:

China: Bevorstehender massiver Kaltlufteinbruch

Eine starke spätwinterliche Kältewelle wird in den nächsten fünf Tagen über Ostchina hinwegfegen und zu einem starken und schnellen Temperatursturz führen.

Prognosen zufolge werden die Temperaturen im Nordosten und Osten Chinas um 10 bis 20 °C sinken, weil die Polarluft fast ungehindert nach Süden strömt. Der Temperatursturz wird abrupt sein und das Risiko von Verkehrsbeeinträchtigungen und Belastungen für die Infrastruktur erhöhen.

…

—————————–

USA: Neuer Vorstoß arktischer Luft

Eine weitere starke Arktisfront transportiert Freitagabend und über das Wochenende hinweg deutlich kältere Luft in den Nordosten der USA und bringt Schnee und eine weitere Erinnerung daran, dass der Winter noch lange nicht vorbei ist.

Entlang der Frontgrenze wird leichter bis mäßiger Schneefall erwartet, aber das dominierende Merkmal ist die Kälte.

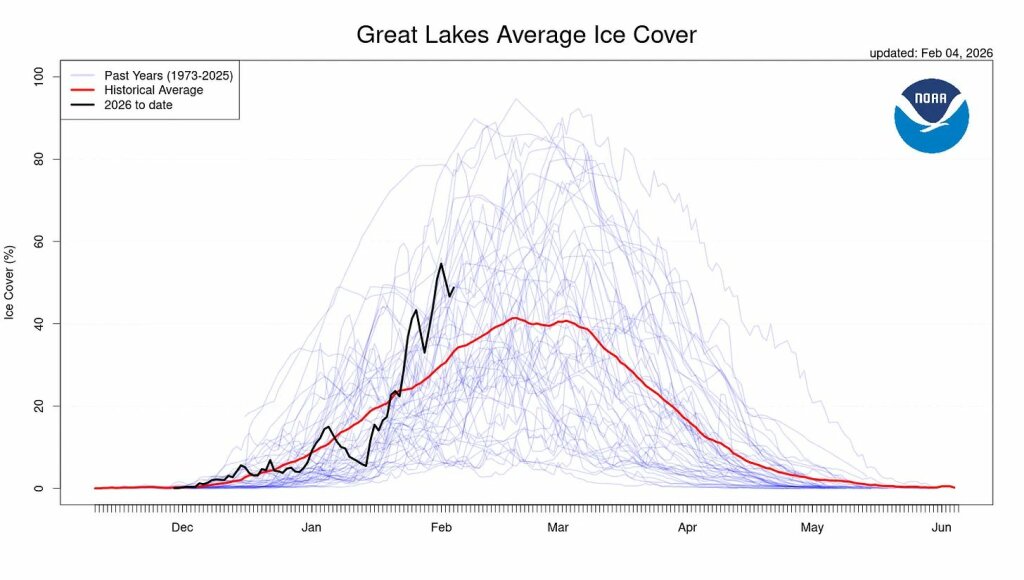

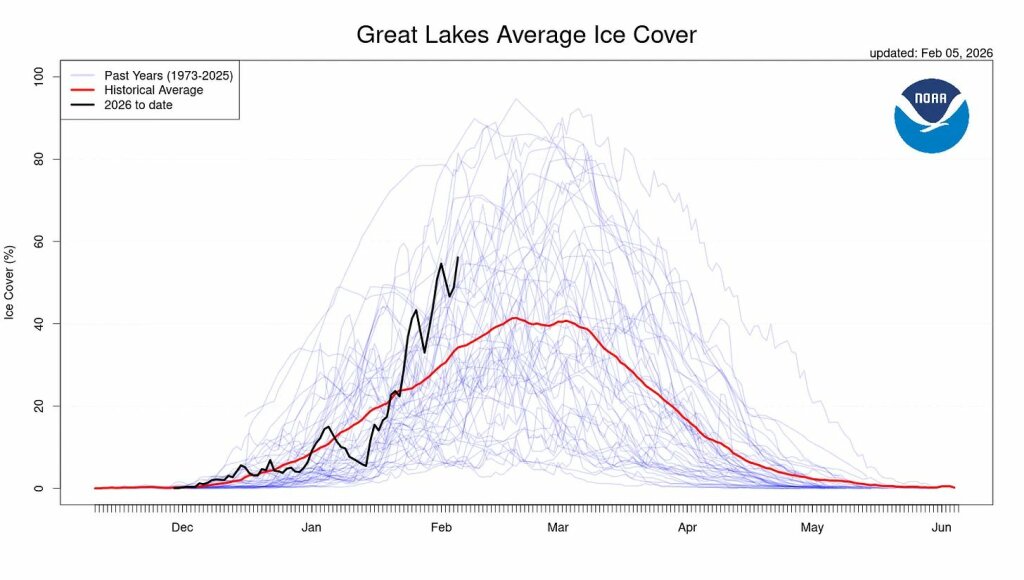

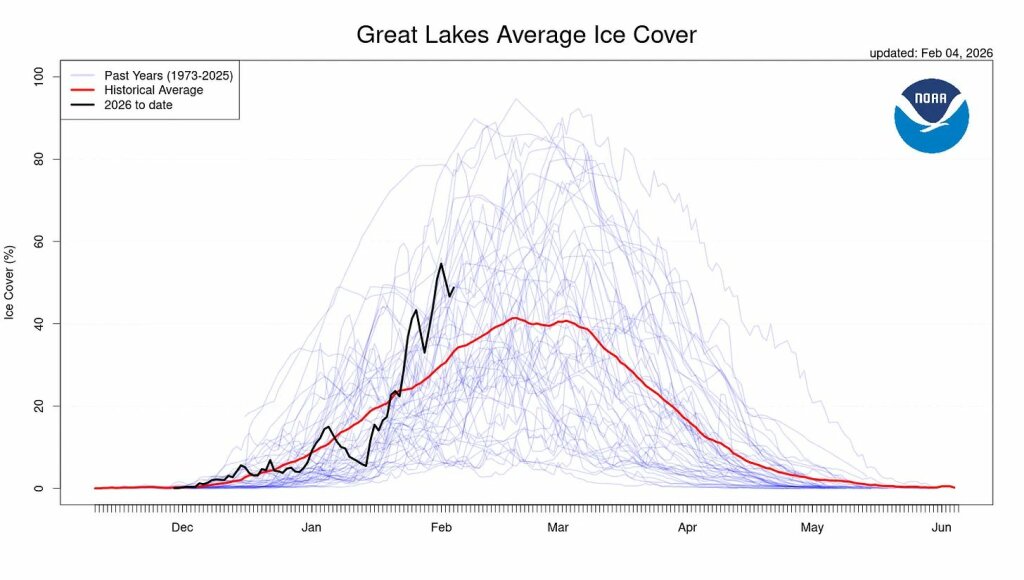

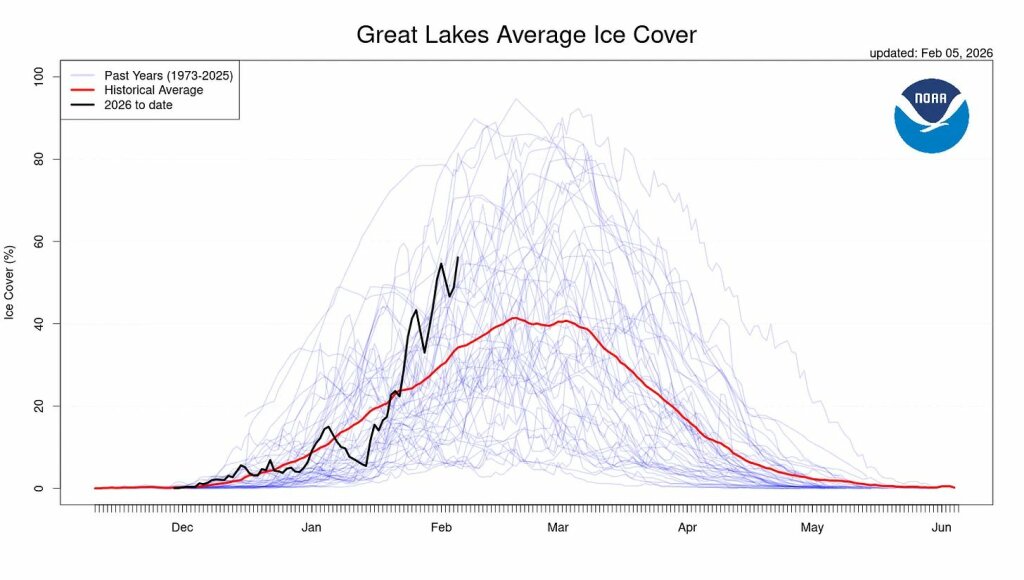

Die Großen Seen werden weiter zufrieren:

Während der Osten friert, richtet sich die Aufmerksamkeit nach Westen. Die nächsten zwei Wochen versprechen zunehmend günstige Bedingungen für weitreichende Schneefälle im Westen der USA.

Eine Reihe von Pazifiksystemen werden für starken Schneefall in den Bergen sorgen und damit die Schneedecke in der Sierra Nevada, den Cascades und Teilen der Rocky Mountains dringend benötigten Auftrieb geben. Nach einem langsamen Saisonstart in einigen Regionen wird sich die Schneedecke im Westen endlich durchsetzen.

Das unterstreicht immer wieder, dass es sich bei all diesen Vorgängen um Wetter und nicht um Klima handelt. Die bislang verhaltene Schneelage in diesen Gebieten steht in krassem Gegensatz zu den Schneeverhältnissen der Vorjahre (siehe die entsprechenden Kältereports). A. d. Übers.

Link: https://electroverse.substack.com/p/major-cold-surge-to-hit-china-arctic?utm_campaign=email-post&r=320l0n&utm_source=substack&utm_medium=email

—————————–

Meldungen vom 6. Februar 2026:

USA: Eriesee erstmals in diesem Jahrhundert fast vollständig zugefroren

Der Eriesee ist derzeit zu etwa 96 % mit Eis bedeckt, Tendenz steigend. Da erneut arktische Luft über den Osten der USA strömt, wird der See voraussichtlich innerhalb weniger Tage zu 100 % mit Eis bedeckt sein – das erste vollständige Zufrieren seit drei Jahrzehnten.

Der Eriesee ist der flachste der Großen Seen und reagiert daher am schnellsten auf anhaltende Kälte. Dennoch ist eine vollständige Vereisung selten, und es bedurfte eines bitterkalten und anhaltenden Winters von Januar bis Februar 2026, um seine Gewässer gefrieren zu lassen.

Weiter südlich hat sich das Eis auch in der Chesapeake Bay zwischen Maryland und Virginia ausgebreitet – eine weitläufige, „begehbare“ Eisfläche, wie sie seit mehr als 35 Jahren nicht mehr gesehen worden ist.

Weiter südlich hat sich das Eis auch in der Chesapeake Bay zwischen Maryland und Virginia ausgebreitet – eine weitläufige, „begehbare“ Eisfläche, wie sie seit mehr als 35 Jahren nicht mehr gesehen worden ist.

Da ein weiteres kaltes Wochenende bevorsteht, wird das Eis eher bestehen bleiben als zurückgehen.

—————————–

Teile Japans versinken im Schnee

Starker Schneefall setzt Nordjapan weiterhin zu, wobei Sapporo und ein Großteil von Hokkaido seit dem 6. Februar 2026 unter einer noch höheren Schneedecke begraben sind.

Aus den nördlichen und westlichen Regionen werden Dacheinstürze, Verkehrsausfälle und weitreichende Schäden gemeldet.

…

Und die Kälte nimmt weiter zu.

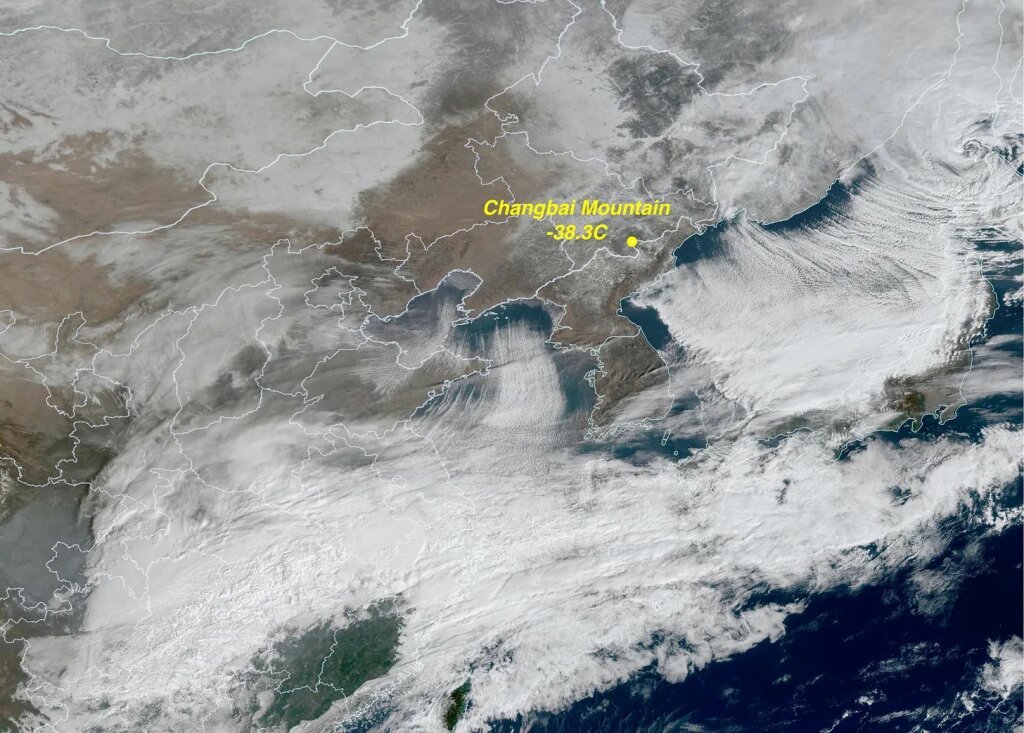

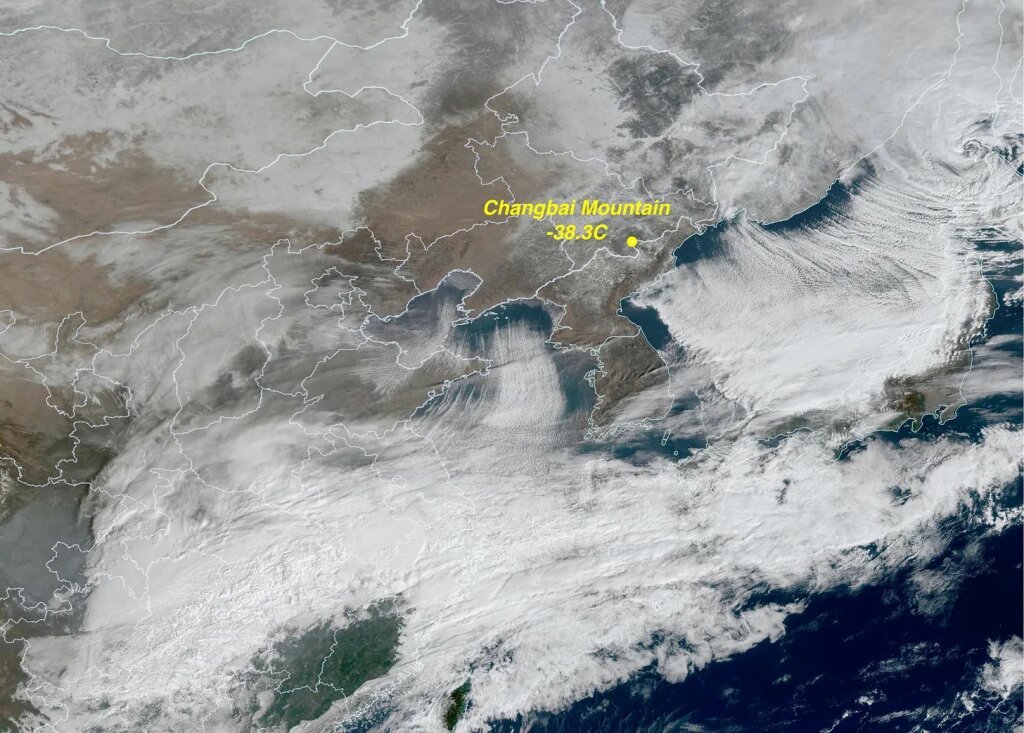

Im Nordosten Chinas hat eine starke Kältewelle gerade die Temperatur an der Changbai-Bergstation auf -38,3 °C sinken lassen, den niedrigsten Wert des Jahres und mindestens 12 °C unter den Normwerten für Anfang Februar.

Der gleiche Kaltluftvorstoß breitet sich nun nach Osten und Süden in Richtung der koreanischen Halbinsel und Japan aus und verstärkt das bestehende Winterwetter. Anstatt sich zu mildern, begünstigen die Bedingungen erneuten Schneefall, gefährliche Windchill-Temperaturen und eskalierende Auswirkungen in ganz Ostasien.

Link: https://electroverse.substack.com/p/lake-erie-nears-first-full-freeze?utm_campaign=email-post&r=320l0n&utm_source=substack&utm_medium=email

Wird fortgesetzt mit Kältereport Nr. 7 / 2026

Redaktionsschluss für diesen Report: 6. Februar 2026

Zusammengestellt und übersetzt von Christian Freuer für das EIKE