Die unerklärte/ignorierte Klima-Verschiebung von 1997

Javier Vinós & Andy May

„Diese Verschiebungen sind mit bedeutenden Veränderungen im globalen Temperaturtrend und in der ENSO-Variabilität verbunden. Das letzte derartige Ereignis ist als die große Klimaverschiebung der 1970er Jahre bekannt“. – Anastasios A. Tsonis, Kyle Swanson & Sergey Kravtsov (2007)

4.1 Einleitung

Während die Erforschung der Wettervariabilität eine lange Tradition hat, ist die Wissenschaft des Klimawandels ein sehr junges wissenschaftliches Thema, wie die Entdeckung der ersten multidekadischen Oszillation, des primären Phänomens der internen Variabilität des globalen Klimas, durch Folland et al. im Jahr 1984 zeigt. Die Auswirkungen dieses grundlegenden Merkmals des globalen Klimasystems wurden zehn Jahre später von Schlesinger und Ramankutty (1994) entdeckt, nachdem die moderne globale Erwärmung bereits auf CO2-Veränderungen zurückgeführt worden war, was das Risiko verdeutlicht, einen Konsens mit unzureichenden Kenntnissen des vorliegenden Themas zu erreichen. Die pazifische (inter-)dekadische Oszillation (PDO) wurde drei Jahre später entdeckt (Mantua et al. 1997; Minobe 1997). Die Atlantische Multidekadische Oszillation (AMO) wurde erst vor knapp zwei Jahrzehnten benannt (Kerr 2000).

Bis in die 1980er Jahre war man allgemein der Meinung, dass sich das Klima so langsam verändert, dass es im Laufe eines Menschenlebens kaum wahrnehmbar ist. Doch dann wurde klar, dass es während der letzten Eiszeit zu abrupten Klimaänderungen kam (Dansgaard et al. 1984), und die Dansgaard-Oeschger-Ereignisse zeigten, dass sich das regionale, hemisphärische und sogar das globale Klima innerhalb weniger Jahrzehnte drastisch verändern konnte. Das Problem bestand darin, dass die moderne Theorie des Klimawandels auf allmählichen Veränderungen des Treibhauseffekts (GHE) beruhte und nicht viel Raum für abrupte, drastische, globale Veränderungen ließ, die nicht durch Veränderungen des Strahlungsantriebs von Treibhausgasen (THG) erklärt werden konnten.

Die ersten Erklärungen für eiszeitliche Dansgaard-Oeschger-Ereignisse betrafen drastische Veränderungen des meridionalen Transports (MT) durch die atlantische meridionale Umwälzzirkulation (AMOC). Die AMOC ist Teil der globalen Förderertheorie, die versucht, den Wärmefluss durch die Ozeane der Erde zu erklären. Die AMOC-Erklärung, besser bekannt als die Salz-Oszillator-Hypothese (Broecker et al. 1990), greift jedoch zu kurz, da es keine Beweise dafür gibt, dass die AMOC die abrupten und drastischen Veränderungen durchlaufen hat, die für die Entstehung der Ereignisse erforderlich sind. Die derzeitige Theorie zur MT basiert auf der so genannten Bjerkness-Kompensationshypothese, nach der Veränderungen in einer der MT-Komponenten (der ozeanischen oder der atmosphärischen) durch ähnliche Veränderungen mit entgegengesetztem Vorzeichen in der anderen kompensiert werden. Aktuelle Interpretationen des Dansgaard-Oeschger-Phänomens beruhen auf raschen Meereisveränderungen in den nordischen Meeren, die abrupt eine große Menge an im Ozean gespeicherter Wärme unter dem Meereis freisetzten (Dokken et al. 2013).

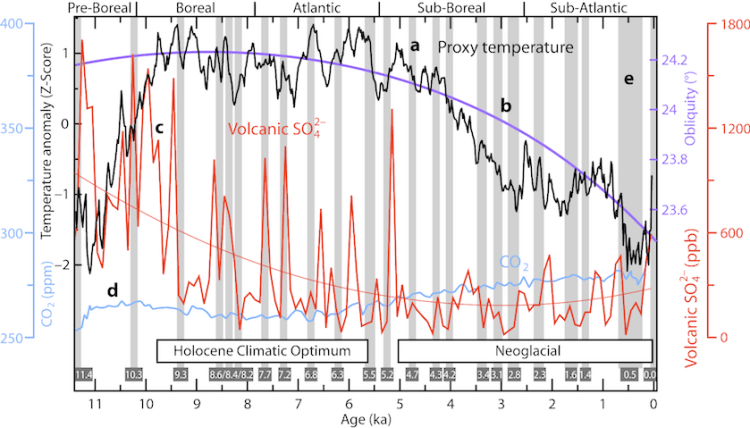

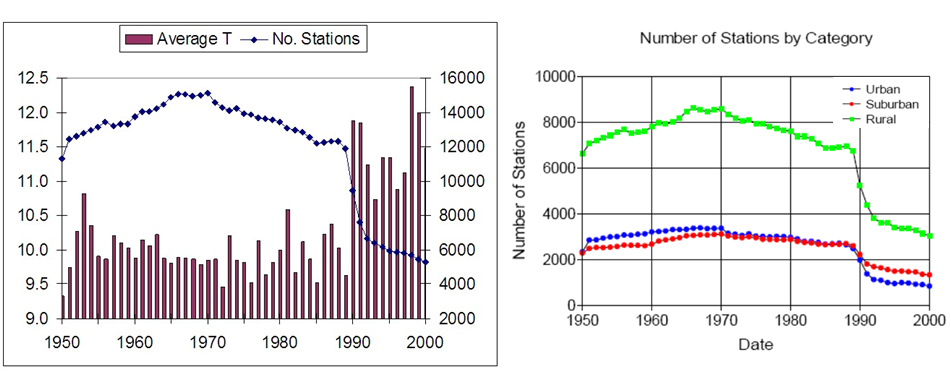

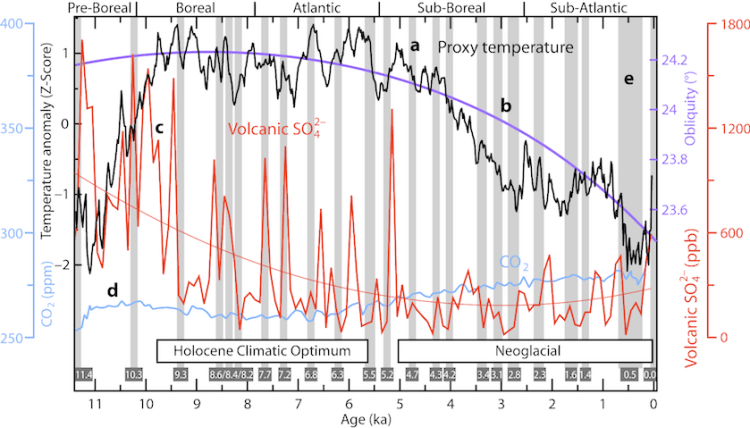

Die Dansgaard-Oeschger-Ereignisse haben sich als eiszeitliches Phänomen erwiesen, das kaum auf die heutigen holozänen Bedingungen übertragbar ist, aber es ist klar, dass abrupte Klimaänderungen eine Realität sind, die einer Erklärung bedarf. Studien zum holozänen Klimawandel haben mindestens 23 abrupte Klimaereignisse (Abb. 4.1e; Vinós 2022) während der letzten 11 700 Jahre (im Durchschnitt etwa zwei pro Jahrtausend) festgestellt. Sie spiegeln sich in mehreren Proxies unterschiedlicher Art wider und sind in der paläoklimatischen Literatur als solche gekennzeichnet. Aus ihren unterschiedlichen klimatischen Signaturen wird deutlich, dass diese Ereignisse nicht auf eine einzige Ursache zurückzuführen sind. Die moderne Klimatheorie lässt uns jedoch nur zwei Möglichkeiten: Änderungen des Strahlungsantriebs durch Veränderungen der Treibhausgase in der Atmosphäre oder vulkanische Aktivitäten. Diese einfachen Prozesse können nicht alles erklären. CO2-Änderungen können als Ursache ausgeschlossen werden, da der CO2-Gehalt von vor 11 000 Jahren bis 1914 zwischen 250 und 300 ppm lag und die dekadischen bis hundertjährigen Schwankungen des CO2-Gehalts den Eisbohrkernen zufolge nur wenige ppm betragen haben. Der vulkanische Antrieb stellt ein Problem dar, weil seine Entwicklung im Holozän der Temperaturentwicklung entgegengesetzt war. Er war stärker, als sich der Planet erwärmte, und schwächer, als er sich abkühlte, und erreichte vor ca. 3.000 Jahren ein Minimum, so dass er keine starke Triebkraft für hundertjährige Temperaturänderungen sein kann. Die Kleine Eiszeit (LIA), das jüngste abrupte Klimaereignis vor der heutigen globalen Erwärmung, lässt sich nicht durch CO2 oder vulkanische Einflüsse erklären. Nach den Aufzeichnungen der GISP2-Eiskerne über vulkanisches Sulfat (Abb. 4.1c; Zielinski et al. 1996) war die vulkanische Aktivität zwischen 1166 und 1345 n. Chr. überdurchschnittlich hoch, lag aber während des größten Teils der LIA unter dem Durchschnitt und stieg erst gegen Ende der LIA, in der Zeit von 1766 bis 1833 n. Chr., wieder an, als sich die Welt zu erwärmen begann.

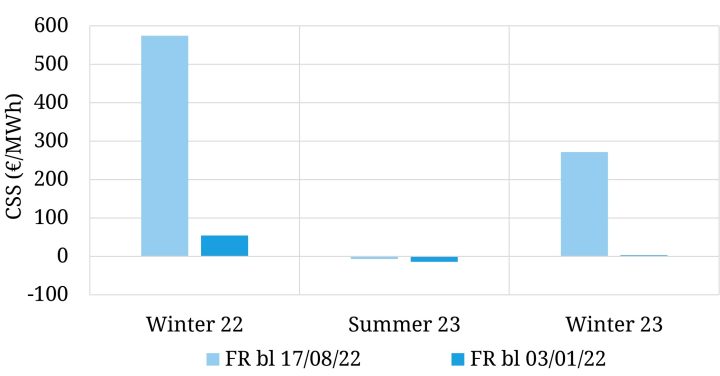

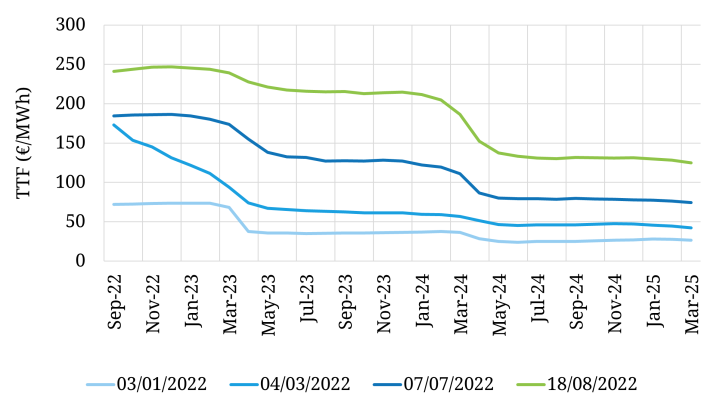

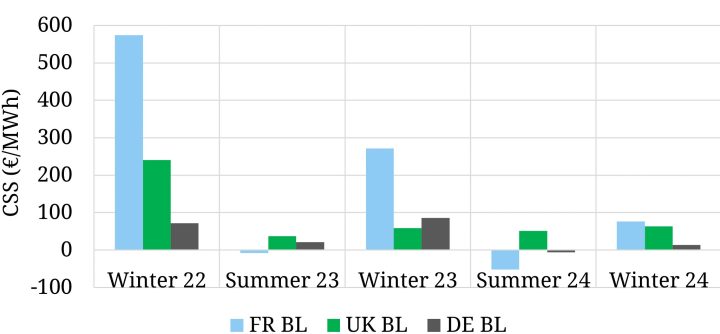

Abb. 4.1 Abrupte Klimaveränderungen während des Holozäns.

In Abb. 4.1 ist (a) die schwarze Kurve eine globale Temperatur-Rekonstruktion aus 73 Proxies (nach Marcott et al. 2013; mit Originaldaten der Proxies und Mittelwert der Differenzierung), ausgedrückt als Abstand zum Mittelwert in Standardabweichungen (Z-Score). Die violette Kurve (b) ist die axiale Neigung (Schiefe) der Erde in Grad. Die rote Kurve (c) ist das holozäne vulkanische Sulfat im GISP2-Eiskern in Teilen pro Milliarde, summiert für jedes Jahrhundert in der BP-Skala (der ganz rechte Punkt ist 0-99 oder 1851-1950), wobei die quadratische Trendlinie als dünne rote Linie dargestellt ist. Die Daten stammen von Zielinski et al. 1996. Kurve (d) ist hellblau und zeigt den CO2-Gehalt, der im Eiskern von Epica Dome C (Antarktis) gemessen wurde. Die Daten stammen von Monnin et al. 2004. Bei den hellgrauen Balken (e) handelt es sich um abrupte Klimaereignisse während des Holozäns, die anhand von petrologischen Tracern aus dem Eis (Bond et al. 2001), Methanveränderungen (Blunier et al. 1995; Kobashi et al. 2007; Chappellaz et al. 2013) und Pegeländerungen im Toten Meer (Migowski et al. 2006), δ18O-Isotopenveränderungen in der Dongge-Höhle (Wang et al. 2005), Niederschlagsveränderungen in der nördlichen Levante (Kaniewski et al. 2015) und Veränderungen der Dolomithäufigkeit in den äolischen Ablagerungen im Golf von Oman (Cullen et al. 2000). Die dunkelgrauen Kästchen am unteren Rand geben deren ungefähre Daten in ka an. Die Abbildung stammt aus Vinós 2022.

Die moderne Klimatheorie hat ein Problem, frühere abrupte Klimaveränderungen zu erklären, und hat eine vage Erklärung entwickelt, die Konzepte aus der Chaostheorie über Schwellenwerte verwendet, welche überschritten werden, und Kipppunkte, die erreicht werden, wenn ein Antrieb allmählich über einen verrauschten chaotischen Hintergrund zunimmt. Das Problem ist, dass es keine Beweise für die Existenz solcher Schwellenwerte und Kipppunkte gibt, außer der Existenz der abrupten Klimaänderungen, die sie zu erklären versuchen. Es werden auch theoretische positive Rückkopplungen angeführt, aber die allgemeine Klimastabilität, die in den letzten 450 Millionen Jahren lebensverträglich war, deutet darauf hin, dass es sich um ein System handelt, das von negativen Rückkopplungen beherrscht wird. Wie bei einem gestörten Paradigma üblich, nimmt es Zuflucht zu den am wenigsten bekannten Aspekten des Klimas, wie der Bedeutung der schlecht gemessenen themohalinen Zirkulation für den Klimawandel, die in allgemeinen Zirkulationsmodellen eine gewisse Unterstützung findet, nicht aber in den Beobachtungsdaten, die darauf hindeuten, dass die AMOC viel stabiler ist als bisher angenommen (Worthington et al. 2021) und offenbar nicht so sehr von der Tiefenwasserbildung abhängt (Lozier 2012).

Neben abrupten Klimaereignissen, die Jahrhunderte oder Jahrtausende zurückliegen, kommt es auch beim heutigen Klima alle paar Jahrzehnte zu schnellen Regimewechseln. Das Konzept der Regimewechsel wurde in der Ökologie entwickelt, um schnelle Übergänge zwischen alternativen stabilen Zuständen zu erklären, vor allem in Weideökosystemen. Lluch-Belda et al. (1989) nutzten das Konzept, um den Wechsel zwischen Sardinen- und Sardellenregimen in mehreren Weltmeeren gleichzeitig zu erklären, möglicherweise als Reaktion auf den Klimawandel. Ihre Daten zeigten, dass im 20. Jahrhundert vor den 1980er Jahren mindestens zwei Wechsel zwischen Sardinen- und Sardellenregimen stattgefunden hatten.

4.2 Die Klimaverschiebung von 1976-77

Auf dem 7. jährlichen Pazifik-Klima-Workshop 1990 stellten Ebbesmeyer et al. (1991) eine Studie vor, die zeigte, dass das pazifische Klima 1976 eine schrittweise Veränderung von 40 Umweltvariablen durchlaufen hatte, darunter Luft- und Wassertemperaturen, die Southern Oscillation, Chlorophyll, Gänse, Lachse, Krebse, Gletscher, atmosphärischer Staub, Korallen, Kohlendioxid, Winde, Eisbedeckung und der Transport durch die Beringstraße. Die Veränderungen deuteten darauf hin, dass eines der größten Ökosysteme der Erde gelegentlich abrupte Veränderungen erfährt. Nicholas Graham (1994) analysierte die abrupten Veränderungen in der borealen Winterzirkulation über der nördlichen Hemisphäre (NH) und im gekoppelten Ozean-Atmosphären-System des tropischen Pazifiks und kam zu dem Schluss, dass diese Veränderungen einem gedämpften, quasi dauerhaften El Niño ähneln, der begann, als sich das gekoppelte Ozean-Atmosphären-System nicht vollständig vom El Niño 1976-77 erholte, und am besten als eine Veränderung des Klimahintergrundes beschrieben werden kann. Darüber hinaus wurde die winterliche boreale Zirkulation in mittleren Breiten kräftiger, mit einer südlichen Ausdehnung der Westwinde, signifikanten Veränderungen der geopotentiellen Höhen und des Meeresspiegeldrucks, begleitet von einer südlichen Wanderung des Tiefdruckgebiets der Aleuten im Winter.

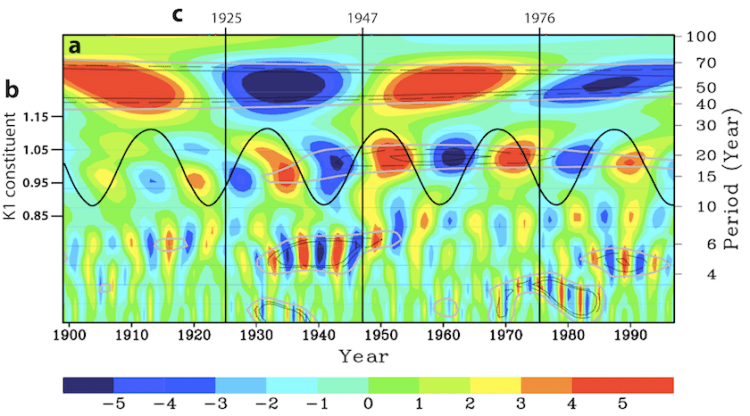

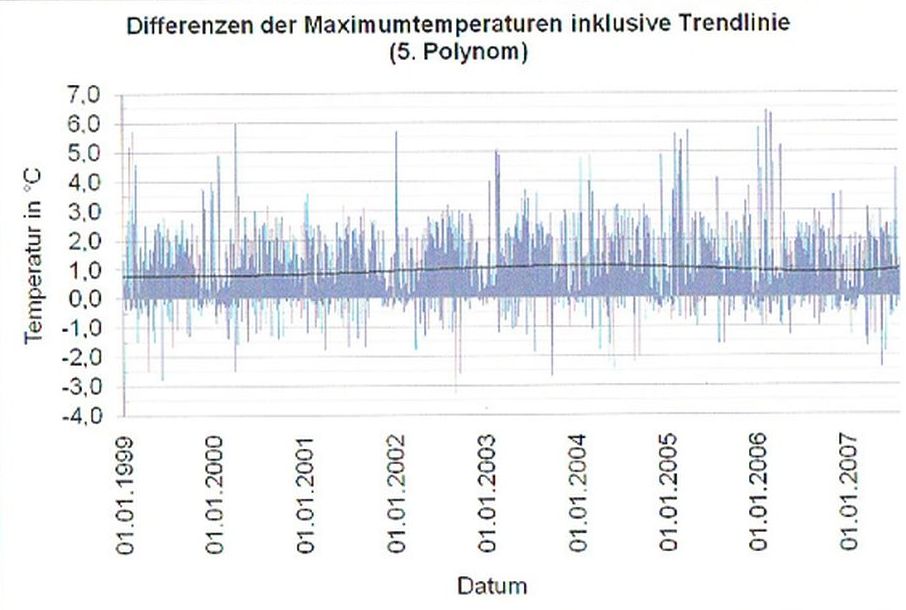

Die Untersuchung vergangener Klima- und Fischereidaten aus dem Nordpazifik durch Mantua et al. (1997) und Minobe (1997) führte zur Identifizierung einer 50-70-jährigen Klimaschwankung, die als Pazifische [inter]dekadische Oszillation (PDO; Mantua et al. 1997) bezeichnet wurde. Regimewechsel in der PDO wurden in beiden Artikeln um 1925, 1947 und 1977 festgestellt. Die auf den gesamten Pazifik abgestimmten Veränderungen der Klima- und Umweltvariablen zeigten sich in vielen Indizes der Meeresoberflächentemperatur (SST) und des Luftdrucks auf der Höhe des Meeresspiegels (SLP), wie dem Southern Oscillation Index, der von Gilbert Walker in den 1920er Jahren definiert wurde und seit den 1960er Jahren bekannt ist, um atmosphärische, mit El Niño verbundene Veränderungen in der Walker-Zirkulation zu verfolgen. Mantua und Hare definierten die PDO als die führende Hauptkomponente einer empirischen orthogonalen Funktion der monatlichen SST-Anomalien über dem Nordpazifik (polwärts von 20°N; Mantua & Hare 2002). Da SLP-Änderungen den SST-Änderungen um etwa zwei Monate vorausgehen, konzentrierte sich Shoshiro Minobe (1999) auf SLP, wobei er den Nordpazifik-Index (Trenberth & Hurrell 1994) verwendete, der die saisonalen SLP-Änderungen in einer ausgedehnten Region des Nordpazifiks mit dem Zentrum des Aleuten-Tiefs verfolgt. Anhand dieses Index‘ zeigte Minobe, dass es zwei Oszillationen gibt, die Klimaverschiebungen verursachen. Die bereits identifizierte Hauptoszillation hatte eine Periode von ca. 55 Jahren. Sie beeinflusste die SLP-Variabilität sowohl während der atmosphärischen Zirkulation im Winter als auch im Frühjahr und zeigte Verschiebungen um 1922/23, 1948/49 und 1975/76 (Minobe 1999). Die kleine Oszillation hatte eine Periode von etwa 18 Jahren und beeinflusste nur die Winterzirkulation. Drei Perioden der kleineren Oszillation (d. h. Verschiebungen um 1923/24, 1946/47 und 1976/77) stimmen in Zeit und Vorzeichen nahezu mit den Druckänderungen der großen Oszillation überein (Abb. 4.2).

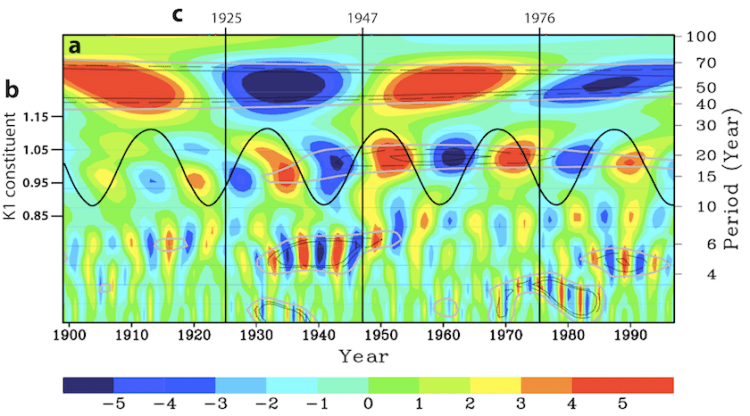

Abb. 4.2 Multidekadische und bidekadische Oszillationen im Nordpazifik.

In Abb. 4.2 ist die zentrale Grafik (a) der Wavelet-Transformationskoeffizient des winterlichen Nordpazifik-Index‘ als flächengemittelte Luftdruckanomalie (hPa) in der Region 160°E-140°W, 30-65°N. Es handelt sich um eine dreidimensionale Darstellung des Zeitbereichs (1899-1997, X-Achse), des Frequenzbereichs (Periodizität, Y-Achse) und der Amplitude der Druckveränderungen (Farbskala, hPa) in einer Region, die im Zentrum des Aleutentiefs liegt. Die blaue Farbe zeigt ein tieferes Aleuten-Tief in Verbindung mit positiven PDO-Phasen an. Die dünnen schwarz-gefüllten, schwarz-gestrichelten und grauen Konturen zeigen die Signifikanz auf den Konfidenzniveaus 95, 90 bzw. 80 % an. Die Darstellung stammt aus Minobe 1999. Die dicke schwarze Linie, linke Skala, (b) ist die Sinuswelle der Phase und Amplitude der Gezeitenkomponente des täglichen Mondknotenzyklus K1. Sie wurde überlagert, um zu zeigen, dass sowohl die Phase als auch die Periode der bidekadischen Komponente in der instrumentellen Aufzeichnung die des 18,6-jährigen Mondknotenzyklus ist. Die Sinuskurve wurde nach McKinnell und Crawford (2007) erstellt. Die Daten der pazifischen Klimaregimeverschiebungen (c) sind als vertikale Linien dargestellt, wie sie von Mantua et al. (1997) ermittelt wurden.

Der Nordatlantik weist außerdem eine multidekadische Oszillation, die AMO, und eine bidekadische Oszillation auf (Frankcombe et al. 2010). Die Beziehung zwischen der bidekadischen und der multidekadischen Oszillation bleibt unklar. Eine subharmonische Beziehung ist trotz ihrer Kopplung unwahrscheinlich. Im Nordpazifik haben sie eine unterschiedliche jahreszeitliche Abhängigkeit, und im Nordatlantik zeigt sich die bidekadische Oszillation am deutlichsten bei den Untergrundtemperaturen, während die multidekadische Oszillation hauptsächlich die Oberflächentemperatur und den arktischen Tiefwasser-Salzgehalt beeinflusst (Frankcombe et al. 2010). McKinnell und Crawford (2007) schlagen vor, dass die bidekadische Oszillation im Nordpazifik eine Manifestation des 18,6-jährigen Mondknoten-Zyklus der Winterluft- und Meerestemperaturen ist. Dieser Mondzyklus wirkt sich stark auf die Größe der Tagesgezeitenkomponente des Mondes (K1) aus und ist in Phase und Periode mit der bidekadischen Oszillation synchronisiert. In Abb. 4.2 ist ein zunehmender K1 (aufwärts gerichtete Sinuskurve) mit einem abnehmenden SLP (blaue Farben) und ein abnehmender K1 mit einem zunehmenden SLP verbunden. Nach McKinnell und Crawford tritt die bidekadische Komponente der Variabilität in Verbindung mit dem 18,6-jährigen Mondknotenzyklus in Proxy-Temperaturen von bis zu 400 Jahren Dauer auf. Eine gezeitenbedingte Ursache für die bidekadische Oszillation bietet sicherlich eine Erklärung für den Effekt der Untergrundtemperatur im Nordatlantik. Die Gezeiten liefern über die Hälfte der Energie für die vertikale Durchmischung des Wassers in den Ozeanen.

Die Arbeit von Schlesinger und Ramankutty (1994) machte deutlich, dass sich die multidekadische Variabilität auf die globale Temperatur auswirkt, die auch eine ca. 55-70-jährige Oszillation aufweist, wenn man sie abtrennt. Interdekadische Schwankungen wurden für die meisten Ozeane, einschließlich der Arktis, beschrieben und beeinflussen eine Vielzahl von Klimaphänomenen wie SST, SLP, Meeresoberflächentemperatur, Salzgehalt, Meereis, Windgeschwindigkeit, Meeresspiegel und atmosphärische Zirkulation. Es war notwendig, eine globale Sichtweise einzunehmen, die all diese natürlichen Schwankungen in eine einzige Hypothese des globalen multidekadischen internen Klimawandels integriert. Dies ist Marcia Wyatt gelungen, als sie in ihrer Dissertation die Hypothese der „Stadionwelle“ entwickelte (Wyatt 2012). Sie identifizierte ein multidekadisches Klimasignal, das sich über die Indizes eines synchronisierten Netzwerks über die Nordhemisphäre ausbreitete (Abb. 4.3). Wyatt konnte zwar weder die Art des Signals noch die Ursache seines Zeitraums von ca. 64 Jahren ermitteln, doch Wyatt und Curry (2014) identifizierten die eurasische arktische Meereisregion als den Ort, an dem das Signal zuerst erzeugt wurde. Wie wir in Teil III gesehen haben, ist dies das Haupteinfallstor für den atmosphärischen meridionalen Wintertransport in die Arktis (siehe z. B. Abb. 3.6 und 3.8b), der sehr empfindlich auf Meereis reagiert.

Abb. 4.3 Die Stadium-Wellen-Hypothese.

Abb. 4.3 zeigt die Signalausbreitung im 20. Jahrhundert durch ein Netzwerk mit 15 Indizes. Ausgewählte Indizes sind eine Teilmenge eines breiteren Netzwerks. Vier Cluster von Indizes sind hervorgehoben (I bis IV, jeder kann positiv oder negativ sein). Jedes Cluster wird als „Zeitliche Gruppe“ bezeichnet. Die Spitzenwerte der Gruppenindizes stehen für Phasen der Entwicklung des Klimaregimes. Die Darstellung stammt aus Wyatt und Curry 2014.

Es wird deutlich, dass eine hemisphärisch synchronisierte multidekadische Variabilität im gekoppelten System Ozean-Atmosphäre im Winter in den NH stattfindet. Der größte Teil der modernen globalen Erwärmung fand seit 1976 ebenfalls in der NH während der Wintermonate statt (Abb. 4.4). Es ist offensichtlich, dass die Klimaverschiebung und die globale Erwärmung, die beide vor allem die NH-Winter seit 1976 beeinflusst haben, kausal zusammenhängen müssen. Zumindest muss die natürliche multidekadische Variabilität für einen großen Teil der globalen Erwärmung im Zeitraum 1976-2000 verantwortlich sein. Doch als die multidekadische Erwärmung und die Verschiebung des Klimaregimes den Klimaforschern bekannt waren (in den 1990er und 2010er Jahren), hatte die moderne Klimatheorie bereits einen Trumpf ausgespielt, indem sie die Klimaverschiebung von 1976 den Aerosolen zuschrieb. Tsonis et al. schreiben:

„Die Standarderklärung für die Erwärmung nach den 1970er Jahren ist, dass der Strahlungseffekt der Treibhausgase die kurzwelligen Reflexionseffekte durch Aerosole überwunden hat. Allerdings … legen die Beobachtungen dieses Ereignisses eine alternative Hypothese nahe, nämlich dass sich das Klima nach dem Ereignis der 1970er Jahre in einen anderen Zustand eines wärmeren Klimas verschoben hat, der möglicherweise von einem anthropogenen Erwärmungstrend überlagert wird.“ – Tsonis et al. (2007)

Obwohl dies bekannt ist, hat sich die moderne Klimatheorie geweigert, die Auswirkungen von Klimaverschiebungen zu berücksichtigen, die von Modellen schlecht reproduziert und nie vorhergesagt werden. Damit ist die Theorie zum Scheitern verurteilt, da derselbe Trumpf bei der nächsten Verschiebung nicht mehr ausgespielt werden kann. Können die Befürworter der modernen Klimatheorie eine neue Verschiebung ignorieren? Oder werden sie die Unzulänglichkeiten der Theorie erkennen, nachdem sie die westlichen Volkswirtschaften zu einer tiefgreifenden Dekarbonisierung verpflichtet haben?

Abb. 4.4 Saisonale Erwärmungsraten der Hemisphäre.

Abb. 4.4 zeigt die durchschnittliche Temperaturanomalie der nördlichen und südlichen Hemisphäre für Dezember-Februar (durchgehend), März-Mai (langer Strich), Juni-August (kurzer Strich) und September-November (gestrichelt) für den Zeitraum 1970-2000. Die Daten stammen von Jones et al. 2016.

4.3 Die Klimaverschiebung von 1997-98 blieb unbemerkt, obwohl sich so viele Menschen mit dem Klima beschäftigen.

Das Versäumnis, Klimaverschiebungen in die moderne Klimatheorie einzubeziehen, ist einer der Gründe, warum die Klimaverschiebung von 1997-98 (97CS) nicht bemerkt und richtig beschrieben wurde. Ein weiterer Grund ist, dass viele seiner Auswirkungen fälschlicherweise dem zunehmenden Strahlungsantrieb durch steigende Treibhausgaskonzentrationen zugeschrieben und dazu benutzt wurden, den Klimaalarm zu erhöhen. Während die Verschiebung von 1976 das NH-Klima in einen wärmeren Zustand versetzte (Tsonis et al. 2007), indem sie die Erwärmungsrate erhöhte (Abb. 4.4), bewirkte die 97CS das Gegenteil und veränderte den Klimazustand durch eine Verringerung der Erwärmungsrate. Peinlicherweise waren es nicht die Klimawissenschaftler, die diese Veränderung bemerkten, da sie nicht zu ihren Vorurteilen in Bezug auf den Anstieg der Treibhausgase passte, sondern ein Geologe und Paläontologe, der der modernen Klimatheorie skeptisch gegenübersteht, meldete sie zuerst:

„Es GIBT ein Problem mit der globalen Erwärmung … sie hat 1998 aufgehört“ – (Carter 2006)

Nachdem die Pause in der globalen Erwärmung festgestellt worden war, wurden Hunderte von Artikeln in wissenschaftlichen Zeitschriften darüber veröffentlicht, und es brach eine große Kontroverse über ihre Realität aus, wobei einige Autoren ihre Existenz leugneten (Lewandowsky et al. 2016) und sogar die offiziellen Datensätze veränderten, um ihre Bedeutung zu verringern (Karl et al. 2015), während andere Autoren behaupteten, es handele sich um ein reales Phänomen, das eine Erklärung erfordere (Fyfe et al. 2016).

Die Pausen-Kontroverse war ein dritter Faktor, der die Anerkennung der 97CS trotz eindeutiger Beweise für deren Existenz verschleierte. Dieser Faktor, zusammen mit dem Fehlen von Klimaverschiebungen in modernen Klimatheorien und -modellen und der unrichtigen Zuschreibung ihrer Auswirkungen an den zunehmenden Treibhausgasantrieb, hielt die offensichtliche Schlussfolgerung aus dem Mainstream heraus. Lluch-Belda et al. (1989) stellten globale Veränderungen der Sardinen- und Sardellenbestände fest, die auf einen Klimawandel hindeuten. Diese Fischereiverschiebungspunkte wurden später als pazifische Klimaverschiebungspunkte identifiziert, die globale Telekonnektionen aufwiesen (Mantua & Hare 2002). Chavez et al. (2003) berichteten in der Zeitschrift Science, dass Mitte der 1990er Jahre ein neuer multidekadischer Regime-Shift in der pazifischen Fischerei stattgefunden hat. Das warme „Sardinenregime“ hatte sich in ein kühles „Sardellenregime“ verwandelt. Die Autoren rieten (offensichtlich ohne Erfolg), dass diese großräumigen, natürlich auftretenden Schwankungen bei der Betrachtung des vom Menschen verursachten Klimawandels berücksichtigt werden sollten. Die 97CS wird von den Klimawissenschaftlern nach wie vor nicht anerkannt. Die nächste Verschiebung wird wahrscheinlich in den späten 2020er bis frühen 2030er Jahren stattfinden. Es wäre beschämend, wenn die Klimawissenschaftler zu diesem Zeitpunkt immer noch nicht auf den Wandel vorbereitet wären und den Beitrag der multidekadischen Schwankungen zur heutigen globalen Erwärmung nicht erkennen würden.

4.4 Wie sich das Klima während der 97CS global veränderte

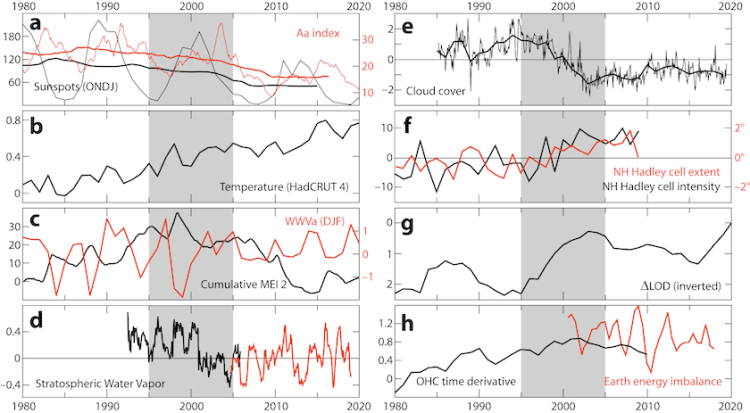

Die Wissenschaft ist heutzutage so spezialisiert und abgeschottet, dass noch niemand alle Beweise zusammengetragen hat, die die globale Klimaverschiebung von 1997-98 bestätigen. Eine Verschiebung, die offensichtlich nicht durch Veränderungen der Treibhausgas-Konzentrationen und die moderne Klimatheorie erklärt werden kann. Die Sonnenaktivität änderte sich von einem hohen Wert im Sonnenzyklus (SC) 22 zu einem niedrigen Wert im SC24 (Abb. 4.5a, schwarze Linie). Diese Veränderung lässt sich besser an der starken Abnahme des magnetischen Index‘ der antipodischen Amplitude (Abb. 4.5a, rote Linie) ablesen, der geomagnetische Störungen misst, die hauptsächlich durch den Sonnenwind verursacht werden, und der auf einen hundertjährigen Tiefstand gesunken ist. Wir haben bereits die berühmte Pause in der globalen Erwärmung (Abb. 4.5b) erwähnt, die besser als eine Verringerung der globalen Erwärmungsrate nach Mitte der 1990er Jahre charakterisiert werden kann und trotz ihrer Unterbrechung durch den starken El Niño 2015-16, nach dem ab Mitte 2022 keine Erwärmung mehr stattgefunden hat, immer noch andauert.

Auf der 97CS ging ein überwiegend Niño-Häufigkeitsmuster in ENSO in ein überwiegend Niña-Muster über, wie aus dem kumulativen multivariaten El-Niño-Index (MEI v.2) hervorgeht. Der kumulierte Index zeigte während des vorangegangenen Klimaregimes eine steigende Tendenz, erreichte 1998 einen Spitzenwert und zeigt danach eine abnehmende Tendenz (Abb. 4.5c, schwarze Linie). Die Variabilität des Warmwasservolumens am Äquator nahm ab (Abb. 4.5c, rote Linie), und stark negative Anomalien im Warmwasservolumen, die früher einmal pro Jahrzehnt auftraten, hörten nach 2000 auf. Eine Westverschiebung der Atmosphäre-Ozean-Variabilität im tropischen Pazifik fand zur 97CS statt, die durch eine Abnahme der ENSO-Variabilität gekennzeichnet ist, die wiederum mit der Unterdrückung der Variabilität der Unterwassertemperatur und einer Schwächung der Atmosphäre-Ozean-Kopplung im tropischen Pazifik zusammenfällt. Die Verschiebung manifestierte sich in mehr zentralpazifischen gegenüber ostpazifischen El-Niño-Ereignissen und einer Zunahme der Häufigkeit von ENSO, die mit einer Westverschiebung der Wind-SST-Interaktionsregion verbunden war (Li et al. 2019). Die Veränderungen in der atmosphärisch-ozeanischen Kopplung im tropischen Pazifik spiegeln sich in der Stratosphäre wider. Der globale (60°N-S) stratosphärische Wasserdampf nahm im Jahr 2001 abrupt ab (Abb. 4.5d). Gleichzeitig kühlte sich die tropische Tropopause ab (Randel & Park 2019), was darauf hindeutet, dass sich auch die Kopplung zwischen Troposphäre und Stratosphäre schrittweise änderte.

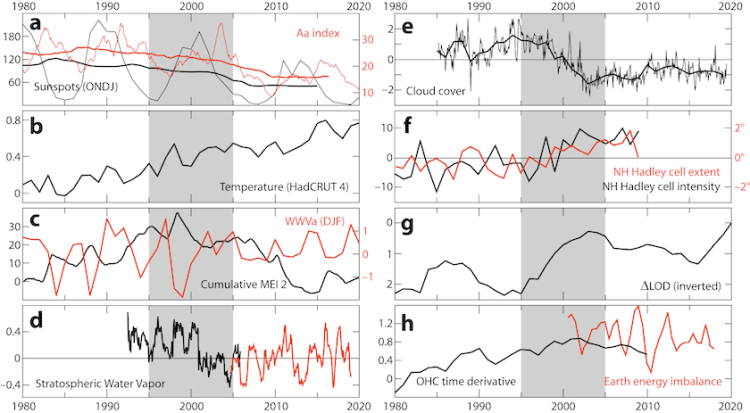

Abb. 4.5 Manifestationen der großen Klimaverschiebung von 1997-98.

Abb. 4.5 zeigt Reihen, die die große Klimaveränderung von 1997-98 veranschaulichen. Zwischen 1995 und 2005 fanden weltweit viele nahezu gleichzeitige Veränderungen bei klimabezogenen Phänomenen statt. Tafel (a) zeigt die Oktober-Jan-Sonnenflecken (dünne schwarze Linie) und den 11-Jahresdurchschnitt der Oktober-Jan-Sonnenflecken (dicke schwarze Linie). Die Sonnenaktivität nahm von einer hohen (108 Sonnenflecken 1980-1995) zu einer niedrigen (54 Sonnenflecken 2005-2015) ab. Die Daten stammen von WDC-SILSO. Der 13-Monats-Durchschnitt des geomagnetischen Index‘ der antipodischen Amplitude (Aa) ist die dünne rote Linie, und der 11-Jahres-Durchschnitt ist die rote dicke Linie. Der geomagnetische Aa-Index misst magnetische Störungen, die hauptsächlich durch den Sonnenwind verursacht werden. Die Daten stammen vom ISGI. In Feld (b) ist die durchschnittliche globale Temperaturanomalie in °C aufgetragen. Sie zeigt die Pause in der Erwärmung zwischen 1998 und 2013. Die Daten stammen von MetOffice HadCRUT 4.6 Jahresdaten. Panel (c) zeigt den kumulativen multivariaten ENSO-Index v.2 als schwarze Linie. Er ist seit 1998 nicht mehr gestiegen, sondern gesunken, was auf eine Verschiebung des ENSO-Musters hinweist. Die Daten stammen von der NOAA. Die Veränderung spiegelt sich auch in einer starken Verringerung der Variabilität der Warmwasser-Volumenanomalie (WWVa, rot dargestellt) am Äquator (5°N-5°S, 120°E-80°W über 20 °C) wider, wo nach 2000 keine negativen Werte von minus eins mehr erreicht werden. Die Daten sind in 10↑14 m³ vom TAO-Projektbüro der NOAA/PMEL aufgetragen. Die monatliche Anomalie des stratosphärischen Wasserdampfs bei 60°N-S, 17,5 km Höhe aus Sonnenbedeckungsdaten (schwarze Linie) und Mikrowellen-Sondendaten (rote Linie) in ppmv sind in Tafel (d) dargestellt. Der starke Rückgang des Wasserdampfs in der Stratosphäre im Jahr 2001 tritt etwa zur gleichen Zeit auf wie ein Rückgang der Temperatur in der tropischen Troposphäre (nicht gezeigt).

In Feld (e) ist die Anomalie der Bewölkung dargestellt, monatlich als dünne Linie und jährlich als dicke Linie. Die Anomalie bezieht sich auf die Bewölkung von 90°S-90°N in Prozent. Die Daten stammen aus dem CM SAF-Datensatz von EUMETSAT, nach Dübal & Vahrenholt (2021). Panel (f) ist die mittlere jährliche Hadley-Zellen-Intensitätsanomalie (in Prozent vom Mittelwert) für die NH aus acht Reanalysen (schwarze Linie), und die mittlere jährliche Hadley-Zellen-Randanomalie (in Breitengraden) für die NH aus acht Reanalysen (rote Linie). Die Darstellung stammt aus Nguyen et al. 2013. Panel (g) ist die durchschnittliche jährliche Änderung der Tageslänge (ΔLOD) in Millisekunden, invertiert (oben ist eine Verkürzung der LOD aufgrund der Beschleunigung der Erddrehung). Die Daten stammen aus IERS LOD C04 IAU2000A. Die Tafel (h) zeigt den jährlichen Anstieg des 10-Jahres-Mittelwerts des Wärmeinhalts der Ozeane (schwarze Linie) und den Jahresmittelwert des Energieungleichgewichts auf der Erde, der sich aus der Differenz zwischen der eingehenden Sonnenstrahlung und der gesamten ausgehenden Strahlung ergibt (rote Linie). Beide Angaben sind in W/m². Die Darstellung ist nach Dewitte et al. 2019. Die Illustration stammt von Vinós 2022.

Am 97CS nahm die niedrige Bewölkung ab (Abb. 4.5e; Veretenenko & Ogurtsov 2016; Dübal & Vahrenholt 2021), und die Albedo-Anomalie der Erde erreichte 1997 ihren Tiefpunkt und begann zu steigen (Goode & Pallé 2007). Dieser Anstieg war auf die zunehmende Bewölkung in hohen und mittleren Höhen zurückzuführen. Im Zeitraum 1995-2005 fand eine Tropisierung des Klimas statt und die Tropen dehnten sich aus, da die Hadley-Zellen ihre Ausdehnung und Intensität erhöhten (Abb. 4.5f; Nguyen et al. 2013). Der atmosphärische Drehimpuls verringerte sich, wodurch die Rotationsgeschwindigkeit der Erde zunahm und sich die Länge des Tages um 2 Millisekunden verkürzte (Abb. 4.5g). All diese Veränderungen veränderten den Energiehaushalt des Klimasystems. Das Energieungleichgewicht der Erde, d. h. die eingehende Sonnenstrahlung abzüglich der gesamten ausgehenden langwelligen Strahlung (OLR), wie vom CERES-System gemessen, begann zu sinken (Abb. 4.5h, rote Linie; Dewitte et al. 2019). Die globale Energieänderung am 97CS führte zu einer Trendänderung in der zeitlichen Ableitung des Wärmeinhalts des Ozeans (OHC) (Abb. 4.5h, schwarze Linie; Dewitte et al. 2019). Diese Änderung deutet darauf hin, dass der OHC langsamer anzusteigen begann, was die Behauptung widerlegt, dass die fehlende Wärme, die aus der Erwärmungspause resultierte, in die Ozeane gelangte (Chen & Tung 2014).

Dies sind einige der globalen Klimavariablen, die eine rasche Änderung zum Zeitpunkt oder kurz nach der Klimaverschiebung aufweisen, die von Chavez et al. (2003) als Übergang von einem „warmen“ Sardinen- zu einem „kühlen“ Sardellenregime identifiziert wurde, dem Gegenteil der Verschiebung von 1976, die in den 1990er Jahren festgestellt wurde. Fünfundzwanzig Jahre nach der Anerkennung von Klimaverschiebungen wird die 97CS von der modernen Klimawissenschaft noch immer nicht anerkannt. Die Tatsache, dass die 76CS anerkannt wurde und die 97CS nicht, ist ein deutliches Zeichen dafür, dass die moderne Klimatheorie dem Verständnis des Klimawandels im Wege steht und die Wissenschaftler dazu veranlasst, Fakten, die mit ihrer Theorie nicht vereinbar sind, zu ignorieren.

4.5 Die arktische Verschiebung und die polare Verstärkung

Als sich das globale Klima 1997-98 änderte, war das arktische Klima stark betroffen. In Teil III haben wir bei der Betrachtung des Wärmetransports im Winter in die Arktis erwähnt, dass bis 1995 trotz zweier Jahrzehnte intensiver Erwärmung nur eine geringe Amplifikation in der Arktis stattgefunden hatte, und damit die Worte von Curry und Kollegen aufgegriffen:

„Das relative Fehlen einer beobachteten Erwärmung und der relativ geringe Eisrückgang könnten darauf hindeuten, dass die GCMs die Empfindlichkeit des Klimas gegenüber Prozessen in den hohen Breitengraden überbetonen.“ – Curry et al. (1996)

Bei der 97CS nahm die arktische Amplifikation stark und plötzlich zu, zeigte aber eine auffällige Saisonalität. Die arktischen Sommertemperaturen steigen nicht an (Abb. 4.6a, schwarze Linie). Jede Zunahme der Nettowärme, die im Sommer in die Arktis transportiert wird, wird zu einem großen Teil gespeichert, indem der Ozean erwärmt wird und Eis und Schnee schmelzen, bis zum Beginn der kalten Jahreszeit, wenn sie durch den umgekehrten Prozess wieder an die Atmosphäre abgegeben wird. Die Oberflächentemperatur im Winter ist seit etwa 1998 sehr stark gestiegen (Abb. 4.6a, rote Linie).

Die Auswirkungen der 97CS auf die arktische Meereisausdehnung waren spektakulär. Zwischen 1996 und 2007 nahm die arktische Meereisausdehnung im September um satte 45 % ab (Abb. 4.6b), was unter Experten zu Befürchtungen führte, dass sie in eine Todesspirale geraten sei (Serreze 2010). Doch nach 11 Jahren des Verlustes passte sich das arktische Meereis an das neue Regime an und 14 Jahre später war die arktische Meereisausdehnung im September höher als 2007. Da der Meereisverlust als Aushängeschild für die verstärkte Erwärmung des Treibhauseffekts und die Verstärkung der Arktis benutzt wurde, um Alarm zu schlagen und Geld zu verdienen, kann er nun nicht mehr ohne Gesichtsverlust auf die 97CS zurückgeführt werden. Der Rückgang des arktischen Meereises wurde bei der 97CS von einem Anstieg des grönländischen Schmelzwasserflusses (Abb. 4.6c, schwarze Linie) und einem Rückgang der Massenbilanz des grönländischen Eisschildes (Abb. 4.6c, rote Linie) begleitet, die dieselbe Dynamik der raschen Veränderung in den Jahren nach dem Klimawandel und der anschließenden Stabilisierung auf das neue Niveau aufweisen.

Abb. 4.6 Manifestationen der großen arktischen Klimaverschiebung von 1997-98.

Abb. 4.6 zeigt die Datenmerkmale der großen arktischen Klimaverschiebung von 1997-98. Tafel (a) zeigt die Temperaturanomalien im Sommer (JJA, schwarze Linie) und im Winter (DJF, rote Linie) bei 80-90°N in °C. Die Daten stammen vom Dänischen Meteorologischen Institut. Tafel (b) zeigt die durchschnittliche arktische Meereisausdehnung im September (106 km²). Die Daten stammen vom NSIDC. Tafel (c) zeigt den grönländischen Süßwasserfluss (schwarze Linie, km³). Die Daten stammen von Dukhovskoy et al. 2019. Die rote Linie ist die Massenbilanz des grönländischen Eisschilds in Gt, nach Mouginot et al. 2019. Panel (d) ist der Index der Arktischen Ozean-Oszillation (AOO). Er spiegelt den Wechsel zwischen antizyklonaler Zirkulation von Meereis und Ozean (blaue Balken) und zyklonaler Zirkulation (rote Balken) wider. Der Index wurde nach Proshutinsky et al. 2015 erstellt. Tafel (e) zeigt die Anzahl der NH-Blocking-Ereignisse pro Jahr, nach Lupo 2020. Feld (f) zeigt den latenten Energietransport im Winter (DJF) über 70°N durch Wellen auf der planetarischen Skala, in PW. Die dünne Linie ist die jährliche Änderung und die dicke Linie ist das gleitende 5-Jahres-Mittel. Die Darstellung ist nach Rydsaa et al. 2021. Die Illustration stammt von Vinós 2022.

Da die 97CS nicht [an]erkannt wird, können Wissenschaftler viele der veränderten Klimaparameter nicht erklären. Dies gilt für den Index der Oszillation des Arktischen Ozeans (AOO; Abb. 4.6d), der von Andrey Proshutinsky (2015) als die Oszillation zwischen zyklonaler (gegen den Uhrzeigersinn) und antizyklonaler (im Uhrzeigersinn) Ozeanzirkulation im arktischen Beaufort-Wirbel mit einer Periode von 10-15 Jahren definiert wurde. Das Problem ist, dass die Oszillation während der 97er Jahre aufhörte und das System im antizyklonalen Regime stecken blieb, was zu einer Süßwasseransammlung in der Arktis führt. 1996 war das letzte zyklonale AOO-Jahr (Stand Ende 2022). Proshutinsky hat keine Erklärung dafür und der Index wird seit 2019 nicht mehr aktualisiert, aber er ist besorgt, dass die zunehmende Süßwasseransammlung im Beaufort-Wirbel eine „tickende Zeitbombe“ für das Klima ist. Die Akkumulation könnte zu einer Salzgehaltsanomalie im Nordatlantik führen, deren Ausmaß mit der großen Salzgehaltsanomalie der 1970er Jahre vergleichbar ist, die die subpolaren Wirbelströme von 1968 bis 1982 durchliefen und möglicherweise zur Abkühlung Anfang der 1970er Jahre beitrugen.

Zu den weiteren unerklärlichen Veränderungen des arktischen Klimas in der 97CS gehört die Zunahme von Blocking-Ereignissen im Winter, insbesondere in der NH (Abb. 4.6e). Wir haben in Teil III auch untersucht, wie Blocking-Bedingungen die normale westliche zonale Zirkulation in mittleren Breiten im Winter aufhalten. Sie haben zwei herausragende Auswirkungen. Sie stabilisieren Wettermuster über Tage hinweg über demselben Ort und führen zu extremen Wetterereignissen in Bezug auf Temperatur und Niederschlag; außerdem erhöhen sie MT in Richtung Arktis erheblich, da sie Wirbelstürme polwärts ablenken. Es ist klar, aber nicht erklärt, dass die MT in Richtung Arktis während des 97CS zunahm, und dies ist die eigentliche Ursache für viele der danach beobachteten Veränderungen im arktischen Klima. Der Beweis für die Zunahme des winterlichen Wärme- und Feuchtigkeitstransports in die Arktis ergibt sich aus der Zunahme des latenten Wärmetransports auf der planetarischen Skala (Abb. 4.6f), während der latente Wärmetransport auf der synoptischen Skala im Winter abnahm, im Sommer jedoch zunahm (Rydsaa et al. 2021). Die Zunahme des winterlichen Wärme- und Feuchtigkeitstransports in die Arktis führt zu einer verstärkten Wolkenbildung, wodurch die stärkste Strahlungskühlung von der Oberfläche auf die Wolkenoberseiten verlagert wird, die im Winter aufgrund von Temperaturinversionen häufig wärmer sind. An der Meereisgrenze verursachen winterliche Wärmeeinbrüche einen vorübergehenden Rückzug des Eisrandes, was zu einem erhöhten Wärmeverlust durch den Ozean führt, bis sich das Eis wieder bildet (Woods & Caballero 2016).

Es hat sich herausgestellt, dass die arktische Amplifikation hauptsächlich ein Phänomen der kalten Jahreszeit ist, das aus Gründen, die den meisten Klimawissenschaftlern und Modellen unbekannt sind, zwischen 1995 und 2000 begann. Die arktische Verstärkung hängt von Änderungen der MT ab, und die Geschwindigkeit der arktischen Verstärkung scheint der Geschwindigkeit der globalen Erwärmung entgegengesetzt zu sein.

4.6 Klimaregime als meridionales Transportphänomen mit Auswirkungen auf die planetarische Energetik

Aus den Auswirkungen von Klimaverschiebungen ist ersichtlich, dass sie das globale MT-System und insbesondere das boreale Winter-MT beeinflussen. Wie wir in Teil III dargelegt haben, ist ENSO eine Möglichkeit, überschüssige Wärme aus den tiefen Tropen abzuführen, die das reguläre ozeanische Transportsystem übersteigt. Im 97CS nimmt dieser Bedarf ab, da die Brewer-Dobson-Zirkulation (BDC, die stratosphärische MT) aktiver wird und mehr Wärme aus den tiefen Tropen abtransportiert, was zu einer Abkühlung an der tropischen Tropopause und damit zu einer stärkeren Austrocknung der Stratosphäre führt. Außerdem wird die meridionale Windzirkulation auf Kosten der zonalen Zirkulation stärker, was zu einer Beschleunigung der Erdrotation und einer Ausdehnung der Hadley-Zellen führt. Da der meridionale Feuchtigkeitstransport zu den Polen durch die Zunahme der meridionalen Windzirkulation verstärkt wird, nimmt die Bewölkung in den niedrigen und mittleren Breiten ab und in der Arktis zu.

In der Arktis sind die Auswirkungen der Klimaverschiebungen durch Veränderungen der MT-Intensität noch deutlicher. Bei der 97CS wurde der MT in die Arktis das ganze Jahr über verstärkt, aber stärker während der kalten Jahreszeit. Die Zunahme der Wärme- und Feuchtigkeitsadvektion aus niedrigeren Breiten führt zu einer Verringerung der Meereisbedeckung, die den Wärmeverlust des Ozeans verstärkt und die Oberflächentemperatur in der kalten Jahreszeit (nicht aber im Sommer) erhöht. Die Hauptwirkung der Wintererwärmung besteht darin, dass der Strahlungsverlust in den Weltraum zunimmt. Wie wir in Teil III gesehen haben, ist die Arktis im Winter in Bezug auf die GHE sehr speziell. Die Atmosphäre ist extrem trocken, so dass es kaum Wasserdampf-GHE gibt. Die Wolkenbedeckung ist im Winter ebenfalls recht gering, und der Anstieg des CO2 hat den Effekt, dass die Strahlung von wärmeren, höheren CO2-Molekülen in den Weltraum zunimmt (van Wijngaarden & Happer 2020).

Wenn im Winter feuchte, warme Luft in die Arktis eindringt, entsteht in der Regel eine Temperaturinversion, und trotz erhöhter langwelliger Strahlung nach unten setzt sich die Abkühlung durch Strahlung von der Spitze der Inversion oder den Wolken aus fort, bis die eingedrungene Feuchtigkeit entweder ausgefallen ist oder in niedrigere Breiten zurückgeführt wird. Im Wesentlichen muss mehr Wärme, die im Winter in die Arktis transportiert wird, zu mehr Wärmeverlusten in den Weltraum führen. Diese Schlussfolgerung widerspricht einem der Grundpfeiler der modernen Klimatheorie, die besagt, dass MT kein Klimaantrieb ist, da der horizontale Transport die Energiemenge im Klimasystem nicht beeinflusst und daher keine Ursache für den Klimawandel ist. Dies ist der grundlegendste der vielen Fehler der modernen Klimatheorie, da sie davon ausgeht, dass sich der obere Teil der Atmosphäre in Bezug auf den GHE überall gleich verhält. Das ist nicht der Fall, da der GHE in den Polarregionen sehr schwach ist, insbesondere während der langen kalten Jahreszeit. Der Transport von mehr Wärme aus einer Region mit hohem GHE in eine Region mit niedrigem GHE führt dazu, dass mehr Wärme an der Oberseite der Atmosphäre verloren geht, ohne dass an anderer Stelle ein Ausgleich geschaffen wird. Eine Änderung der Intensität der MT zum Winterpol hin führt zu einer Änderung des Energiehaushalts des Planeten, wie wir gezeigt haben (Abb. 4.5h).

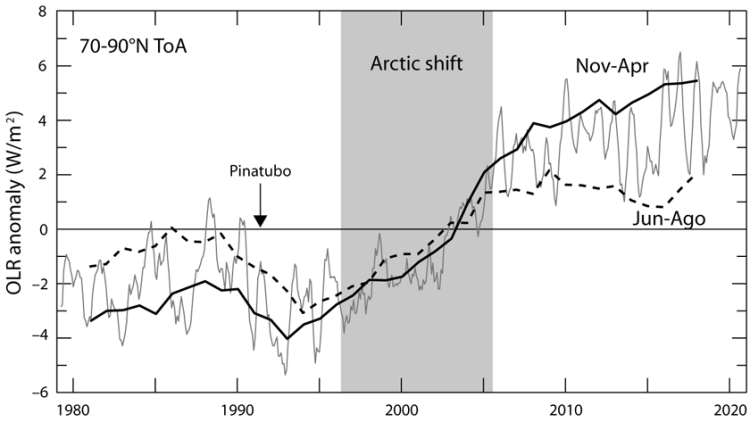

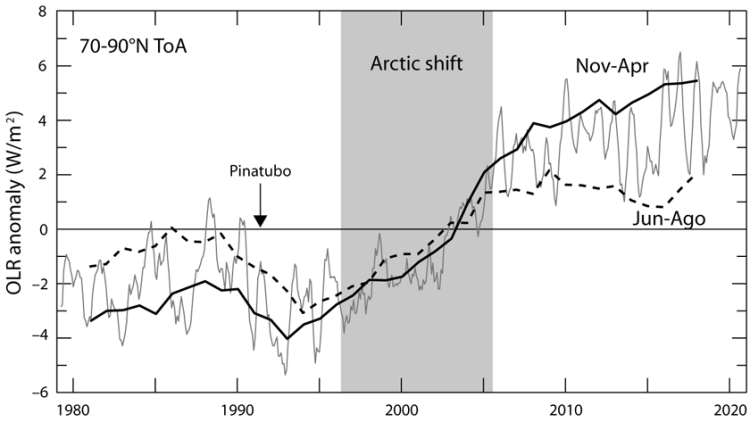

Abb. 4.7 Veränderung der ausgehenden langwelligen Strahlung in der arktischen Region.

In Abb. 4.7 ist die dünne graue Linie der 7-Monats-Durchschnitt der mittleren monatlichen OLR-Anomalie in W/m² aus dem interpolierten OLR-NOAA-Datensatz. Die dicke schwarze Linie ist der 5-Jahres-Durchschnitt des Mittels der kalten Jahreszeit (Nov-Apr). Die dicke schwarze gestrichelte Linie ist der 5-Jahres-Mittelwert für den Sommer (JJA). Der graue Kasten hebt die arktische Verschiebung der OLR zwischen Mitte 1996 und Ende 2005 hervor. Der Zeitpunkt des Pinatubo-Ausbruchs ist gekennzeichnet. Daten von KNMI-Explorer. Die Illustration stammt von Vinós 2022.

Die OLR in der Arktis ist im Sommer höher als in der kalten Jahreszeit, was aufgrund der nahezu permanenten Sonneneinstrahlung im Sommer und der höheren Oberflächentemperatur zu erwarten war. Bei der 97CS stieg die OLR jedoch während der kalten Jahreszeit viel stärker an als im Sommer (Abb. 4.7). MT wurde eindeutig stärker, insbesondere während des borealen Winters. Der verstärkte Sommertransport führte zu einer größeren Energiespeicherung durch verstärkte Sommerschmelze. Durch das Wiedereinfrieren des Schmelzwassers im Winter wird die Energie des Sommers in die Atmosphäre zurückgeführt, um dann durch Strahlungskühlung in den Weltraum zu entweichen. Jetzt verstehen wir, warum die arktische Verstärkung ein Winterphänomen ist, das nichts mit der globalen Erwärmung zu tun hat, und wo die Energie für die „Pause“ hingeht. Die arktische Verstärkung ist kein Treibhauseffekt, sondern ein MT-Effekt, der zu einer Abkühlung des Planeten führt. Die Pause dauert an, weil die arktische Verstärkung anhält. Wenn die Pause endet, sollte sich die Arktis abkühlen und das Meereis wachsen. Wie bereits erwähnt, könnte dies Ende der 2020er bis Anfang der 2030er Jahre geschehen, wenn die nächste Klima-Verschiebung eintritt.

4.7 Meridionale Transportmodulation des globalen Klimas

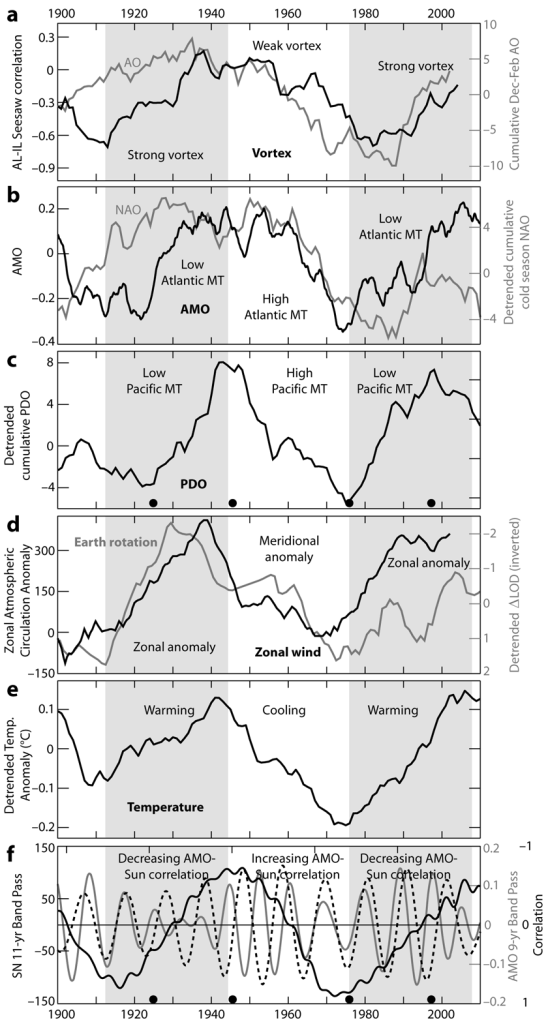

Um die multidekadischen Veränderungen der MT seit 1900 zu analysieren, wurde der Zeitraum 1912-2008 subjektiv in drei Phasen von 32 Jahren unterteilt. Obwohl sich die verschiedenen Modi der Variabilität nicht gleichzeitig verschieben (daher der Name Stadium-Welle), beschreiben die so definierten Phasen gut die Perioden mit wechselnden vorherrschenden Bedingungen in der MT. Ausgehend von der Arktis, wo die PV-Stärke die polare Stratosphären-Troposphären-Kopplung im Winter bestimmt, ist die Arktische Oszillation (AO; Abb. 4.8a, graue Linie) der führende Modus der Variabilität der außertropischen Zirkulation in der NH (Thompson & Wallace 2000). Um als Nord-Süd-Wippe des atmosphärischen Massenaustauschs zwischen der Arktis und den mittleren Breiten zu wirken, benötigt die AO eine Korrelation zwischen ihren drei Wirkungszentren – dem arktischen, atlantischen und pazifischen Sektor. Die arktisch-atlantische Korrelation ist als Nordatlantische Oszillation (NAO) bekannt und stark, die arktisch-pazifische Verbindung ist schwächer, was Zweifel daran aufkommen lässt, dass es sich bei der AO um einen echten ringförmigen Modus handelt. Das Aleuten-Tief und das Island-Tief weisen jedoch seit Mitte der 1970er Jahre eine negative Korrelation von einem Winter zum nächsten auf (Honda & Nakamura 2001). Diese aleutisch-isländische Wippe scheint von der Ausbreitung stationärer Wellen abzuhängen und variiert in ihrer Stärke mit Änderungen der PV-Stärke (Sun & Tan 2013). Anhand der Berechnung der kumulativen Jan-Feb-AO (Abb. 4.8a, graue Linie) können wir sehen, dass bis etwa 1940 positive AO-Werte (d. h. starke Wirbelbedingungen) vorherrschten, aber in der Zeit von 1940 bis 1980 waren negative AO-Werte häufiger, nur um sich danach wieder zu ändern. Die Aleuten-Island-Wippe bestätigt die Veränderungen in der PV-Stärke mit ihrer 25-jährigen gleitenden Korrelation (Li et al. 2018; Abb. 4.8a schwarze Linie). Wenn der PV stark ist, ist der Massen- und Wärmeaustausch zwischen den mittleren Breiten und der Arktis geringer, da der PV als Barriere für die meridionale Zirkulation wirkt.

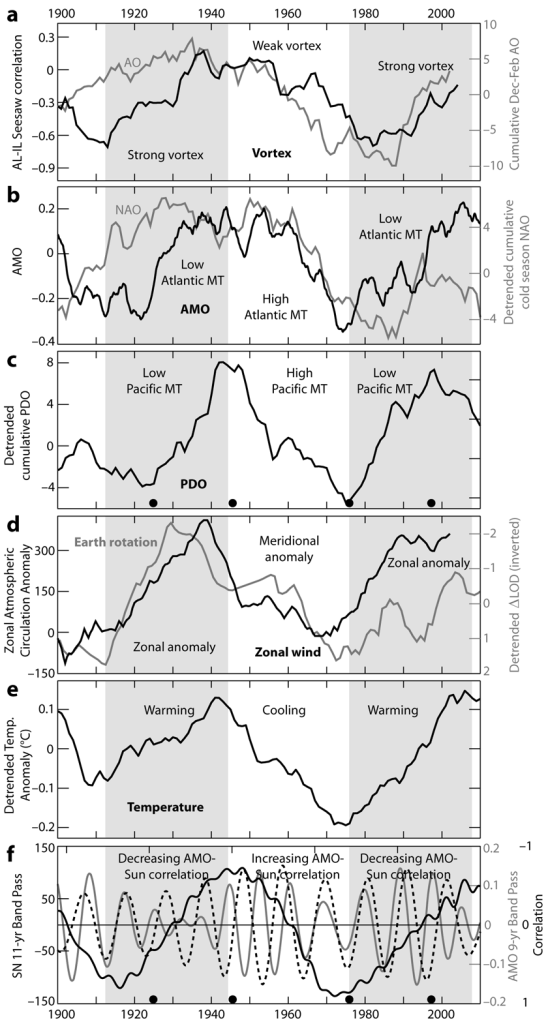

Abb. 4.8 Multidekadische Klimavariabilität und meridionaler Transport.

In Abb. 4.8 ist in Feld (a) die Stärke des Polarwirbels dargestellt. Die schwarze Linie ist die 25-jährige gleitende Korrelation zwischen dem Aleuten-Tief und dem Island-Tief als Proxy für die Stärke des Polarwirbels. Die Darstellung ist nach Li et al. 2018. Die graue Linie ist der kumulative Index der Arktischen Oszillation im Winter (Dez-Feb-Durchschnitt). Die Daten sind der AO-Index 1899-2002 von DW Thompson. Dept. of Atmos. Sci. CSU (Thompson & Wallace 2000). In Feld (b) ist die schwarze Linie der 4,5-Jahres-Durchschnitt des Index der Atlantischen Multidekadischen Oszillation. Die Daten stammen von der NOAA und sind ungeglättet aus der Kaplan SST V2. Die graue Linie ist der kumulative trendbereinigte Index der nordatlantischen Oszillation für die kalte Jahreszeit 1870-2020 (Durchschnitt November-April). Die Daten stammen von CRU, U. East Anglia, Jones et al. 1997. Panel (c) ist die kumulative PDO. Es handelt sich um den trendbereinigten jährlichen durchschnittlichen kumulativen PDO-Index von 1870-2018 aus HadISST 1.1, und die Daten stammen von NOAA. Die schwarzen Punkte markieren die Jahre 1925, 1946, 1976 und 1997, in denen PDO-Regimeverschiebungen stattfanden (Mantua & Hare 2002; siehe Abschnitt 11.4).

Die schwarze Linie in Feld (d) zeigt den zonalen atmosphärischen Zirkulationsindex, kumulative Anomalie nach Klyashtorin & Lyubushin 2007. Die graue Linie in Feld (d) ist die invertierte und trendbereinigte jährliche ∆LOD von 1900-2020. Die Daten sind in Millisekunden von IERS. Tafel (e) ist die trendbereinigte jährliche globale Oberflächentemperatur von 1895-2015, 10-Jahres-Durchschnitt. Die Daten stammen von Met Office HadCRUT 4.6. Die gestrichelte Linie im Feld (f) ist der 8,2-16,6-Jahres-Bandpass der monatlichen mittleren Gesamtsonnenfleckenzahl. Die Daten stammen von WDC-SILSO. Die graue Linie ist der 6,6-11-Jahres-Bandpass des monatlichen AMO-Index. Die schwarze Linie ist die invertierte 20-jährige laufende Korrelation der Bandpass-Sonnenflecken- und AMO-Daten. Die schwarzen Punkte kennzeichnen Klimaverschiebungen, wie in c, und zeigen ihre Position in Bezug auf die solaren Minima. Die Illustration stammt von Vinós 2022.

Die AMO misst SST-Anomalien, die die Stärke des MT über dem Nordatlantik widerspiegeln. Positive AMO-Werte deuten auf eine Ansammlung von warmem Wasser aufgrund eines geringeren MT und starker PV-Bedingungen hin (Abb. 4.8b, schwarze Linie). Die NAO ist der Druckdipol auf Meereshöhe über dem Nordatlantik und Teil der AO. Es überrascht nicht, dass ihr trendbereinigter und kumulierter Wert dem der AO sehr ähnlich ist, aber auch eine gewisse Korrelation mit den AMO-SSTs aufweist (Abb. 4.8b, graue Linie). Die jahrzehntelangen NAO-Trends können nicht mit allgemeinen Zirkulationsmodellen erklärt werden, da diese keine multidekadischen MT-Regimes berücksichtigen. Modelle betrachten NAO-Indizes als weißes Rauschen ohne serielle Korrelation (Eade et al. 2021). Ohne eine korrekte Darstellung des MT können die Klimamodelle den Klimawandel nicht erklären. Im pazifischen Sektor misst die PDO auch SST-Anomalien. Eine positive PDO zeigt an, dass sich warmes Wasser über der äquatorialen und östlichen Seite des Pazifiks ansammelt, was auf einen verringerten MT hindeutet, welcher die Wärme vom Äquator in Richtung der westlichen Pazifikgrenze verschiebt, so dass der Kuroshio-Strom sie nach Norden transportieren und an die Atmosphäre abgeben kann. Die abgeleiteten kumulativen PDO-Werte (Abb. 4.8c) zeigen, dass die Phasen erhöhten oder verringerten pazifischem MT ungefähr mit denen des Atlantiks übereinstimmen. Die 1925, 1946, 1976 und 1997 festgestellten klimatischen und ökologischen Veränderungen im Pazifik (Mantua & Hare 2002) fallen mit Zeiten zusammen, in denen sich die PDO von überwiegend positiv zu negativ oder zurück bewegt (Abb. 4.8c schwarze Punkte).

Die meridionale Windzirkulation ist für den größten Teil des troposphärischen MT verantwortlich, und eine Zunahme des MT bedeutet eine Zunahme der meridionalen Zirkulation und eine entsprechende Abnahme der zonalen Zirkulation. Der atmosphärische Zirkulationsindex ist eine kumulative Darstellung der jährlichen Anomalie der zonalen (E-W) gegenüber der meridionalen (N-S) Luftmassenübertragung in Eurasien (Klyashtorin & Lyubushin 2007). Perioden, in denen der NH-PV stärker und der MT über dem Nordatlantik und dem Nordpazifik geringer war (graue Bereiche in Abb. 4.8), fallen mit Perioden zusammen, in denen Anomalien vom zonalen Typ vorherrschen, während Perioden mit schwächerem PV und höherem MT Anomalien vom meridionalen Typ aufweisen (Abb. 4.8d, schwarze Linie). Diese anhaltenden Veränderungen in den vorherrschenden atmosphärischen Zirkulationsmustern führen zu Veränderungen in der Impulsübertragung zwischen der Atmosphäre und dem festen Erdozean, die sich auf die Rotationsgeschwindigkeit der Erde auswirken, gemessen als Veränderungen der Tageslänge. Perioden mit zunehmender zonaler Zirkulation korrelieren mit einer Beschleunigung der Erde und einer Abnahme von ∆LOD (invertiert in Abb. 4.8d, graue Linie), während Perioden mit abnehmender zonaler Zirkulation mit einer Verlangsamung der Erde und einer Zunahme von ∆LOD korrelieren (Lambeck & Cazenave 1976). Änderungen der Erdrotationsrate integrieren globale Änderungen der atmosphärischen Zirkulation, die die globalen Auswirkungen der MT-Änderungen unterstützen. Wir müssen uns an dieser Stelle daran erinnern, dass Änderungen der Erdrotationsrate auf Änderungen der Sonnenaktivität reagieren (siehe Abb. 2.5).

Multidekadische Veränderungen des MT sind die Ursache für die als Stadium-Welle bekannte multidekadische Oszillation und alle ihre Erscheinungsformen. SST-Änderungen in der AMO und PDO sind eine Reaktion auf Veränderungen in der globalen atmosphärischen Zirkulation. Eine Verringerung der meridionalen atmosphärischen Zirkulation und die entsprechende Zunahme der zonalen Zirkulation bedeuten einen geringeren polwärts gerichteten Energietransport, und da die jährlich eintreffende Energie nahezu konstant ist und der Wärmetransport im Ozean nur teilweise von der windgetriebenen Zirkulation abhängt, sammelt sich in jedem Breitenband mehr Wärme an, besonders aber in den mittleren Breiten der NH. Dies liegt daran, dass der Energie- und Feuchtigkeitstransfer von der Meeresoberfläche in die Atmosphäre an den westlichen Grenzen der mittleren Breiten am höchsten ist (Yu & Weller 2007). Die aus einer Verringerung des MT resultierende Wärmeakkumulation an der Land- und Meeresoberfläche führt zu den Stadium-Welleneffekten und einem Anstieg der globalen Temperatur. Wenn man die Anomalie der globalen durchschnittlichen Oberflächentemperatur als Trend abträgt, entsprechen Perioden mit verringertem (erhöhtem) MT einer Erwärmung (Abkühlung) in Bezug auf den Trend (Abb. 4.8e). Die moderne Klimatheorie erklärt den Hiatus von 1940-1975 mit einem Anstieg der Aerosole und die Erwärmung von 1976-2000 mit dem Anstieg der anthropogenen Emissionen. Diese Erklärungen, die in die Klimamodelle einfließen, sind angesichts der Beweise unhaltbar (Tsonis et al. 2007). Obwohl ein anthropogener Erwärmungstrend unbestritten ist, ist es offensichtlich, dass die Verschiebungen in den MT-Regimen die Reaktion der Oberflächentemperatur dominieren.

Die Ursachen für die multidekadischen Veränderungen des MT sind unbekannt. Die ca. 65-jährige Oszillation ist nicht stationär. Proxy-Rekonstruktionen deuten darauf hin, dass die AMO während der LIA eine kürzere Periodizität hatte und schwächer war und während der mittelalterlichen Warmzeit eine längere Periodizität hatte und stärker war (Chylek et al. 2012; Wang et al. 2017). Die Modulation der Sonnenaktivität auf ENSO und die Änderungen der Erdrotation wurden in Teil II gezeigt (Abb. 2.4 & 2.5). Da beide eine Manifestation der MT-Stärke sind, ist es möglich, dass interne Variabilität und externe solare Antriebe für die aktuelle Periodizität und Stärke der Stadium-Welle verantwortlich sind. Alternativ dazu könnte die interne Variabilität des MT eine Reaktion auf den Erwärmungstrend sein, der durch anthropogene und natürliche Ursachen verursacht wird, vor allem durch die Zunahme der Sonnenaktivität im Zusammenhang mit dem modernen Sonnenmaximum. Die vier im 20. Jahrhundert im Pazifik festgestellten Klimaverschiebungen (Mantua & Hare 2002) fanden 1-3 Jahre nach einem solaren Minimum statt (Abb. 4.8c & f, Punkte; Solarzyklus, Abb. 4.8f gestrichelte Linie), und die beiden grauen Bereiche und der mittlere weiße Bereich in Abbildung 4.8, die wechselnde MT-Regime darstellen, umfassen drei solare Zyklen zwischen solaren Minima. Es wurde gezeigt, dass der Holton-Tan-Effekt (siehe Teil I), der die tropische QBO-Phase über die Ausbreitung planetarer Wellen mit der Stärke des PV in Beziehung setzt, bei solaren Minima stärker ist (Labitzke et al. 2006) und dass sich der Holton-Tan-Effekt während der Periode von 1977-1997 mit reduziertem MT erheblich abgeschwächt hat (Lu et al. 2008). Dies bedeutet, dass die stratosphärische tropisch-polare Kopplung und die stratosphärisch-troposphärische Kopplung während des Winters bei solaren Minima stärker sind und einen geeigneten Zeitpunkt für eine koordinierte Verschiebung der MT-Stärke darstellen könnten, die während des darauf folgenden Sonnenzyklus‘ wirksam wird. Wir werden sehen, ob künftige Klimaverschiebungen auch unmittelbar nach solaren Minima stattfinden. Dies ist die Grundlage für unsere Projektion, dass die nächste Klimaverschiebung um 2031-34 stattfinden könnte.

Wenn solare Minima die Zeiten sind, in denen MT-Verschiebungen auftreten, könnte eine interessante Korrelation eine Erklärung für die Ursache des etwa 65-jährigen Oszillationstempos liefern. Die AMO hat eine 9,1-jährige starke Frequenzspitze, die auch in der PDO zu finden ist (Muller et al. 2013). Diese Frequenz ist in einem über 4,5 Jahre gemittelten AMO-Index als dekadischer Buckel gut zu erkennen (Abb. 4.8b, schwarze Kurve). Der Ursprung dieses auffälligen AMO-Merkmals ist noch nicht ausreichend erforscht, aber Scafetta (2010) schlägt überzeugend einen lunisolaren Gezeitenursprung vor. Der Frequenzunterschied zwischen diesem berichteten 9,1-Jahres-Gezeitenzyklus und dem 11-Jahres-Sonnenzyklus ist so groß, dass sie von korreliert zu antikorreliert (d. h. von konstruktiver zu destruktiver Interferenz) wechseln, und zwar mit einer Periodizität, die nicht nur mit der AMO übereinstimmt, sondern auch exakt mit ihr synchronisiert ist (vgl. schwarze Kurven in Abb. 4.8b & f). Man kann spekulieren, dass eine konstruktive oder destruktive Interferenz zwischen der Wirkung der ozeanischen und atmosphärischen Gezeiten auf die troposphärische Komponente des MT und der Wirkung des Sonnenzyklus‘ auf die stratosphärische Komponente des MT zu der periodischen Veränderung der MT-Stärke führen könnte, die die beobachteten klimatischen Verschiebungen hervorruft. Zur Unterstützung dieser Hypothese wurden in der Fourier-Analyse der täglichen NAO-Autokorrelationsreihen zwei intrinsische Komponenten von ca. 4,5 und 11 Jahren gefunden (Álvarez-Ramírez et al. 2011). Die 11-Jahres-Komponente ist mit dem Sonnenzyklus phasensynchronisiert, außer während Sonnenminima, was darauf hindeutet, dass die Vorhersagbarkeit der NAO mit der Sonnenaktivität zunimmt und während des Sonnenminimums 1997, als die 97CS stattfand, stark antikorreliert wurde. Eine etwa 65 Jahre dauernde Klimaschwingung, die von der Sonnenaktivität abhängt, würde sowohl die Veränderungen der Intensität als auch der Periodizität in den letzten Jahrhunderten erklären, da sich die Sonnenaktivität verändert hat. Die Intensität und Periodizität der Klimaschwingung im 20. Jahrhundert sind das Ergebnis des modernen Sonnenmaximums, und die Nicht-Stationarität der natürlichen multidekadischen Oszillation würde mit der multidekadischen Variabilität der Sonnenaktivität zusammenhängen.

Man kann argumentieren, dass die multidekadischen Oszillationen im Klimasystem über mehrere Zeiträume hinweg auf Null gemittelt werden sollten. Auch andere Faktoren, von denen bekannt ist, dass sie sich auf den MT auswirken, wie die QBO und die ENSO, gehen in ähnlichen oder kürzeren Zeiträumen im Durchschnitt gegen Null. Die Rekonstruktionen der AMO zeigen jedoch, dass ihre Werte und Amplitude in den letzten beiden Zyklen seit etwa 1850 stark zugenommen haben (Moore et al. 2017). Diese Veränderung der ca. 65-jährigen Oszillation deutet darauf hin, dass der MT bei der modernen globalen Erwärmung eine wichtige Rolle spielt, da er mit dem starken Abschmelzen der Gletscher und dem Anstieg des Meeresspiegels zusammenfällt, der um 1850 begann und dem starken Anstieg der CO2-Emissionen nach 1945 vorausging (Boden et al. 2009). Die Sonnenaktivität wirkt sich auf den MT aus und ist selbst in sehr langen Zeiträumen nicht gleich Null, da sie hundert- und tausendjährige Zyklen aufweist (Vinós 2022). Es gibt seit langem eine wissenschaftliche Debatte darüber, ob die Sonnenaktivität einen wichtigen Einfluss auf das Klima hat. Die Aufzeichnungen über die Sonnenflecken zeigen, dass die durchschnittliche Anzahl der Sonnenflecken von 1700-1843 bis 1844-1996 um 24 % zugenommen hat (siehe Abb. 1.6). Die Sonnenvariabilität ist eindeutig an der Variabilität des MT beteiligt (siehe Teil II). Die Auswirkung der Sonnenvariabilität auf den MT und die Auswirkung des MT auf das Energiegleichgewicht des Planeten (Abb. 4.5h & 4.7) klärt die Kontroverse über die Auswirkung der Sonnenaktivität auf das Klima.

Im nächsten Teil dieser Serie wird die Hypothese vorgestellt, wie die Sonnenvariabilität den MT beeinflusst. Diese Hypothese wird als Winter-Gatekeeper-Hypothese bezeichnet, weil die Sonnenaktivität die Wärmemenge moduliert, die im Winter zu den Polen transportiert wird, und damit den Energiehaushalt des Planeten, der auf hundert- bis tausendjährigen Zeitskalen der Hauptmodulator des Klimawandels ist, wie paläoklimatologische Belege zeigen.

References

Glossary/abbreviations

Link: https://andymaypetrophysicist.com/2022/08/22/the-sun-climate-effect-the-winter-gatekeeper-hypothesis-iv-the-unexplained-ignored-climate-shift-of-1997/

Übersetzt von Christian Freuer für das EIKE