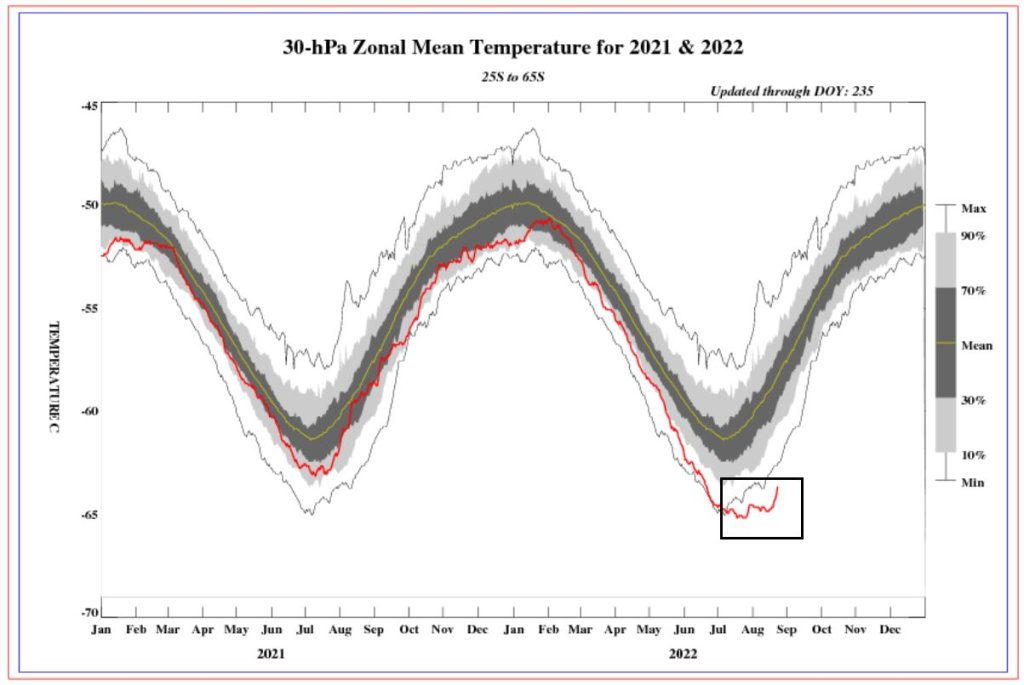

Die neue Pause hält an*

Christopher Monckton of Brenchley

[*Schwer übersetzbares Wortspiel: The New Pause Pauses]

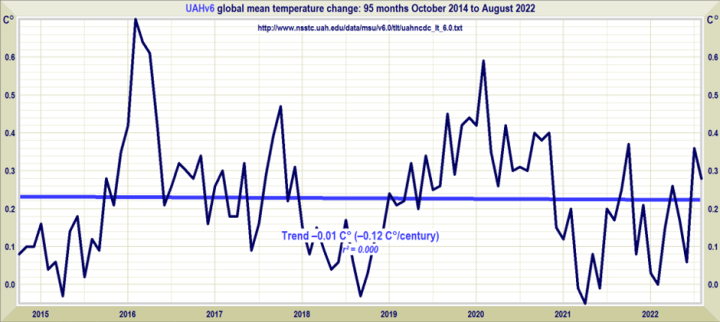

Die neue Pause hat eine Pause eingelegt. Wie im Juli, so im August, gibt es laut UAH-Satellitendaten für die untere Troposphäre seit 7 Jahren und 11 Monaten einen Nulltrend bei der globalen Erwärmung:

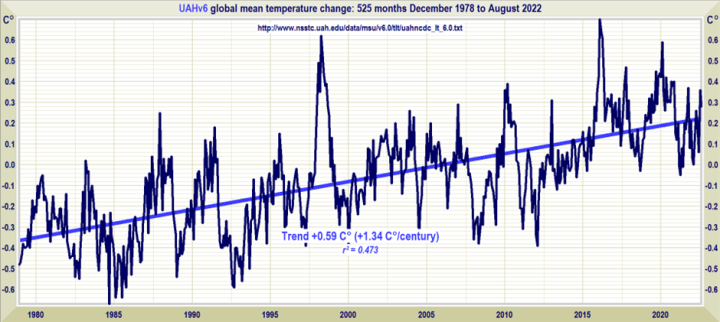

Der Vollständigkeit halber hier der gesamte Datensatz seit seiner Veröffentlichung im Dezember 1978:

Dazu verfasst Lord Monckton einen Abschnitt, den man in seiner Art kaum passend übersetzen kann. Es geht darin im Prinzip darum, dass das Wetter in UK eben „Sommer“ ist und dass nichts passiert ist, was es nicht früher auch schon gab – und dass von dem ganzen Klima-Theater nur Herr Putin profitiert:

Woe, woe and thrice woe! [Britain has had Mediterranean weather, and we like it, which is why we holiday there: I am about to give a piano recital in Malta]. Lake Mead is drying up!! [through over-extraction, not global warming]. The whole of Europe, including the customarily rain-sodden United Kingdom, is in the worst drought evaaah!!! [since the medieval warm period]. Rivers are running dry!!!! [nothing new there: it’s called summer]. Temperatures are higher than climate scientists ever done thunk!!!!! [warming is little more than a third of the originally-predicted rate]. To keep the lights on in London during a recent heatwave, the British grid authority had to pay more than $11,300 per MWh to Putin’s profit!!!!!! [compared with $30 per MWh at the coal-fired power stations wastefully and needlessly torn down to “Save The Planet”]. And it’s all because global heating!!!!!!! [actually weather]. And it’s a mast year for oaks!!!!!!!! [such heavy crops of acorns occur every few years]. Even the trees are alarmed!!!!!!!!! [Nope].

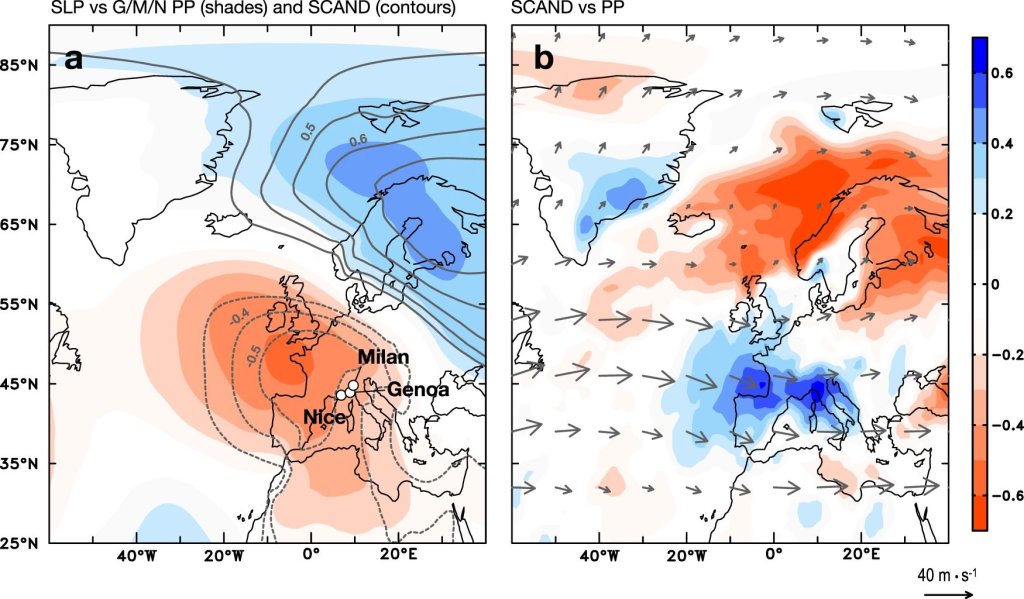

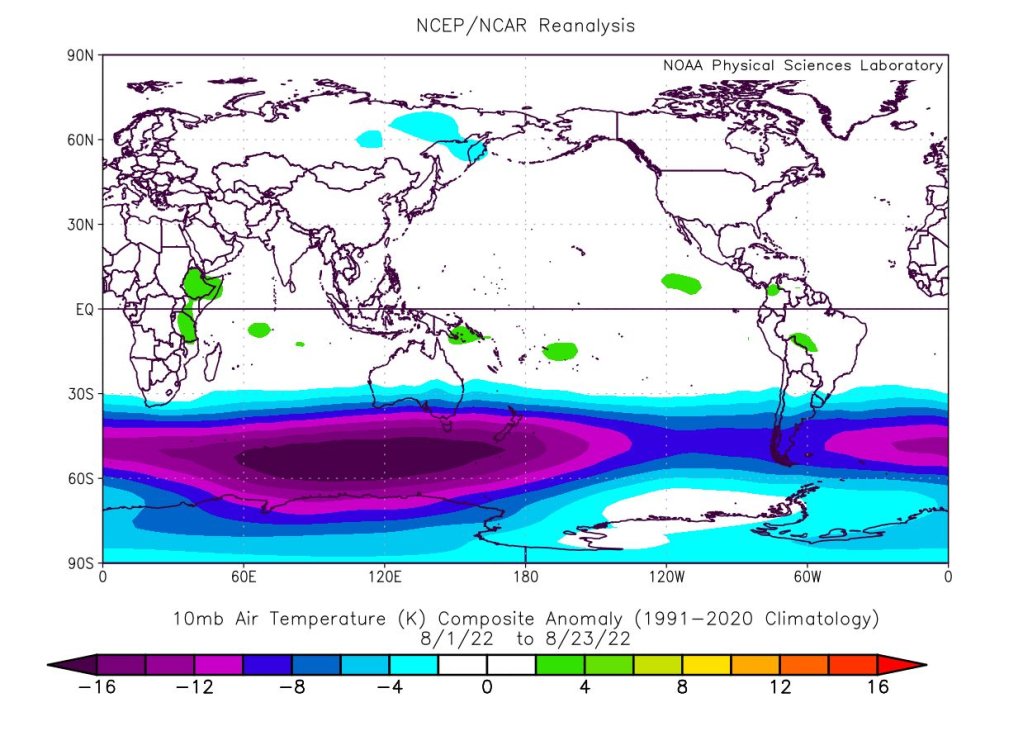

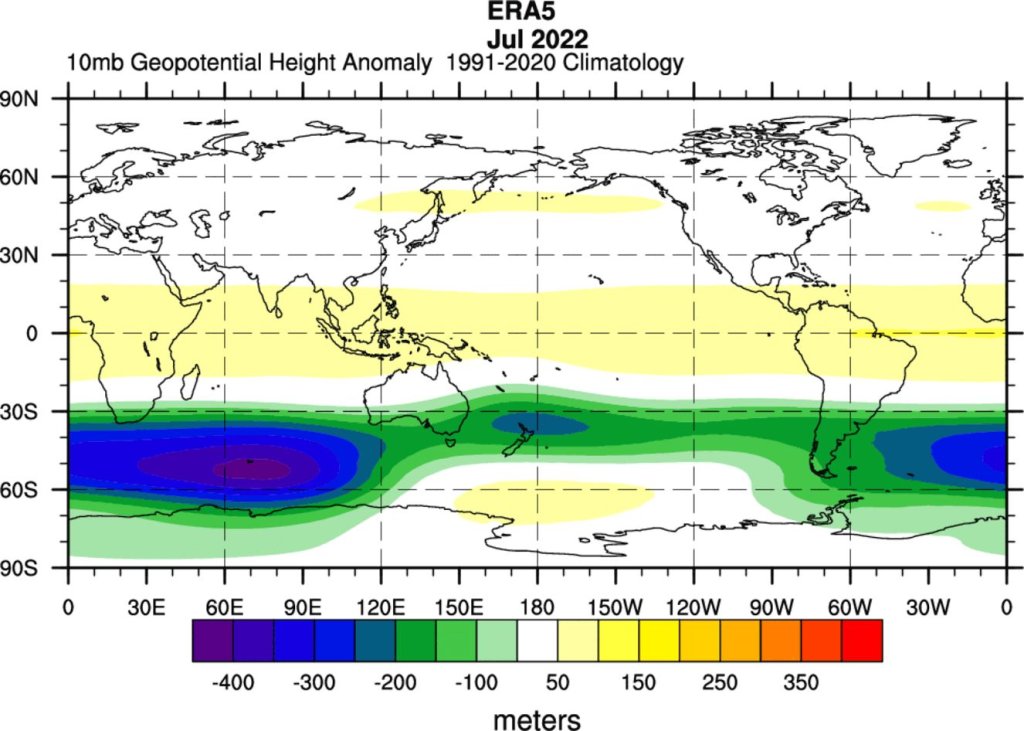

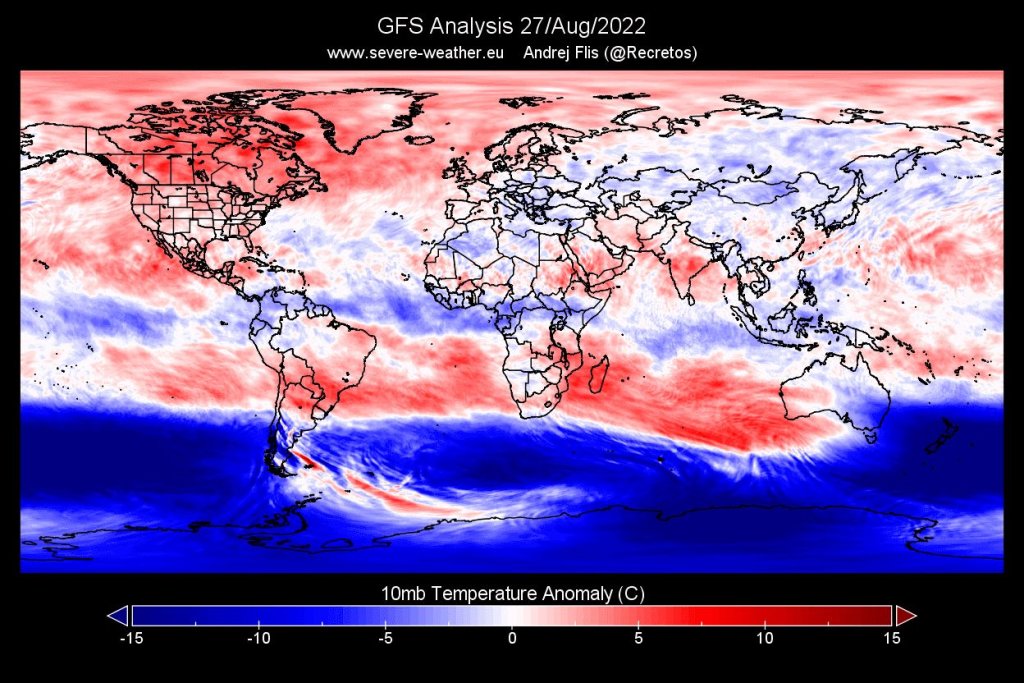

Es ist nicht die globale Erwärmung. Es handelt sich um regionales Wetter, das vor allem auf die lang anhaltende La Niña zurückzuführen ist, die nicht unwesentlich zur neuen Pause der globalen Erwärmung in den letzten acht Jahren beigetragen hat, sowie auf eine plötzliche südliche Luftströmung aus der Sahara.

Die Marxstream-Medien* machten unkritisch die globale Erwärmung für die Dürre verantwortlich, genauso wie sie vor einigen Jahren die Überschwemmungen dafür verantwortlich machten. Kommt schon, Genossen – es ist das eine oder das andere, aber nicht beides. In Wirklichkeit sind Überschwemmungen wahrscheinlicher als Dürren, wenn es wärmer wird, weil durch das wärmere Wetter mehr Wasser aus den Ozeanen verdunstet, woraufhin nach der Clausius-Clapeyron-Beziehung die Kapazität des atmosphärischen Raums zur Aufnahme von Wasserdampf mit der Temperatur zunimmt und die Luft befeuchtet wird. Bereits 1981 wurde berichtet (Nicholson et al.), dass die Sahara um 300.000 km² geschrumpft ist, da die feuchtere Luft das Aufblühen von Wüstenrändern in Gebieten ermöglichte, die der Mensch seit Menschengedenken nicht besiedeln konnte.

[*Monckton-Wortspiel. Gemeint sind natürlich die Mainstream-Medien. A. d. Übers.]

Ein weiterer Grund für die anhaltenden Überschwemmungen und Dürren ist, dass die sehr hohen Offshore-Windmühlen, die jetzt zu lähmenden Kosten für die Steuerzahler in Form von Subventionen installiert werden, die laminare Strömung des Windes in Höhen stören, die inzwischen die Höhe der Turmspitze der Kathedrale von Salisbury, der höchsten Großbritanniens, übersteigen, was sowohl Hoch- als auch Tiefdrucksysteme abbremst und zu länger anhaltendem und intensiverem Wetter aller Art führt.

Wie lässt sich also am einfachsten nachweisen, dass die globale Erwärmung gering, langsam, harmlos und insgesamt vorteilhaft war, ist und bleiben wird? Alles, was kompliziert ist, wird entweder die 99 % der Bevölkerung verwirren, die sich mit Gleichungen nicht anfreunden können, oder es den üblichen Verdächtigen ermöglichen, es noch komplizierter aussehen zu lassen, nur um die Verwirrung sicher zu machen.

Wie die wiederholten langen Pausen andeuten, befindet sich das Klima trotz der anhaltenden Störung durch anthropogene Treibhausgase in nahezu perfekter Thermostase, d. h. im Temperaturgleichgewicht. Die wichtigsten sensibilitätsrelevanten direkten Antriebe durch nicht kondensierende Treibhausgase und die wichtigsten indirekten oder Rückkopplungs-Antriebe, insbesondere durch zusätzlichen Wasserdampf in der Luft, wirken auf Zeitskalen von Stunden, Tagen oder höchstens Jahren. Selbst das IPCC räumt dies ein.

Daher können wir eine einfache Schätzung erster Ordnung für die wahrscheinliche Rate der globalen Erwärmung erhalten, indem wir davon ausgehen, dass aufgrund der Tatsache, dass alle sensiblen Einflüsse auf Zeitskalen von höchstens Jahren wirken, nur eine geringe oder gar keine nicht realisierte globale Erwärmung als Ergebnis unserer vergangenen Emissionssünden in der Pipeline ist. Unter dieser Annahme (die später noch relativiert wird) wird die zu erwartende weitere Erwärmung nicht in erster Linie durch den Einfluss unserer vergangenen Emissionssünden, sondern durch unsere künftigen Emissionen verursacht.

Geht man von einer Sonneneinstrahlung von 1363,5 W/m², einer mittleren Oberflächenalbedo von 0,29, einem mittleren Oberflächenemissionsgrad von 0,94 und der Stefan-Boltzmann-Konstante von 5,6704 x 10-8 W/m² K↑4 aus, so ergibt sich nach der Stefan-Boltzmann-Gleichung eine Emissions- oder Sonnentemperatur von 259,58 K in Oberflächennähe, wenn zu Beginn keine Treibhausgase in der Luft vorhanden wären. Das ist die naive Methode, die von den Klimatologen bevorzugt wird, die sowohl die Tatsache ausklammern, dass die Albedo ohne Treibhausgase nur die Hälfte des derzeitigen Wertes von 0,29 betragen würde (weil es keine Wolken gäbe), als auch die etwas entgegengesetzte Tatsache der Hölderschen Ungleichungen zwischen Integralen, die von den Klimatologen allzu oft vernachlässigt wird.

Basierend auf den Änderungen der Treibhausgaskonzentrationen in Meinshausen (2017) und den Formeln für Treibhausgas-Forcings des IPCC (2007, Tabelle 6.2) betrug die direkt erzwungene Erwärmung durch natürlich vorkommende, nicht kondensierende Treibhausgase bis 1850 7,52 K.

Im Jahr 1850 war die Referenztemperatur von 267,1 K (vor Berücksichtigung der Rückkopplung) die Summe von 259,58 und 7,52 K. Die von HadCRUT5 beobachtete Gleichgewichtstemperatur im Jahr 1850 (es würde 80 Jahre lang keinen Trend in der globalen Erwärmung geben) betrug jedoch 287,5 K. Daher betrug der Systemgewinnfaktor – das Verhältnis der Gleichgewichtstemperatur nach der Rückkopplung zur Referenztemperatur davor – im Jahr 1850 287,5 / 267,1 oder 1,0764.

Vergleichen Sie die Systemgewinnfaktoren von 1850 und heute. Seit 1850 ist der HadCRUT5-Wert um 1,04 K gestiegen. Die anthropogene Erwärmung seit 1850 betrug 3,23 W/m² (NOAA AGGI). Die Referenz-Sensitivität des Zeitraums war dann das Produkt aus diesem anthropogenen Antrieb des Zeitraums und dem Planck-Parameter 0,3 K/Wm², d. h. 0,97 K.

Daher beträgt die heutige Referenztemperatur (die Temperatur vor Berücksichtigung der Rückkopplung) 267,1 + 0,97 = 268,07 K, und die aktuelle Gleichgewichtstemperatur beträgt 287,5 + 1,04 = 288,54 K. Der aktuelle Systemgewinnfaktor beträgt dann 288,54 / 268,07 oder 1,0764, genau wie im Jahr 1850. Nichtlinearitäts-Anhänger aufgepasst: Auf der Grundlage von Mainstream-Daten aus dem mittleren Bereich ist es möglich, dass die Nichtlinearität der Rückkopplung im Industriezeitalter im Laufe der Zeit gleich Null ist.

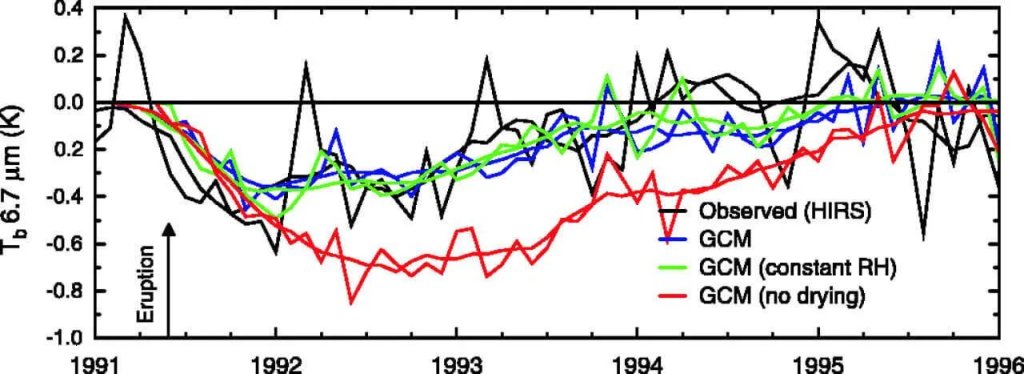

Nun könnte man einwenden, dass die Verzögerung der Erwärmung, die durch die enorme Wärmekapazität und die langsame Umwälzung der Ozeane verursacht wird, nicht berücksichtigt wurde. Diese Verzögerung ist jedoch in den Schätzungen des IPCC bereits weitgehend berücksichtigt, da die wichtigsten Antriebe und Rückkopplungen nur kurzzeitig wirken – über Zeiträume von höchstens Jahren. Tatsächlich hat die wichtigste Rückkopplung – die Wasserdampf-Rückkopplung – nur eine Zeitskala von Stunden.

Außerdem wirkt der Ozean wie jede Wärmesenke als Puffer. Er verzögert die Rückkehr der Erwärmung aus der gemischten Schicht in die Atmosphäre, so dass jede Erwärmung in der Pipeline harmlos über Jahrhunderte bis Jahrtausende verteilt wird.

Die Rückkopplungen im Industriezeitalter werden also nicht mit der Temperatur stärker. Es gilt das Le Chatellier-Prinzip: Es gibt Kontrollen und Gleichgewichte – wie die frühere tropische Nachmittagskonvektion nach Eschenbach mit der Erwärmung oder das Wachstum der antarktischen Eisausdehnung, dito – die dazu führen, dass das Klima nahezu perfekt thermostatisch bleibt.

Selbst wenn also der anthropogene Treibhausgasantrieb in den nächsten 78 Jahren weiterhin nahezu geradlinig mit einer Rate von etwa 0. 033 Watt pro Quadratmeter und Jahr weitergehen würde, die in den letzten drei Jahrzehnten vorherrschte (NOAA AGGI), wäre die Referenztemperatur im Jahr 2100 die heutige Temperatur von 268,07 K plus (78 x 0,033 x 0,3) = 268,85 K. Wendet man den bisher konstanten Systemgewinnfaktor 1,0764 an, so ergibt sich für das Jahr 2100 eine Gleichgewichtstemperatur von 289,4 K.

Die Quintessenz ist, dass wir für den Rest dieses Jahrhunderts bis 2100 vielleicht nur 289,4 – 288,5 = 0,9 K mehr Erwärmung erwarten können. Das ist nicht gerade planetarisch bedrohlich. Und das auf der Grundlage mittlerer Mainstream-Daten, die darauf hindeuten, dass sich – ganz so, wie man es a priori von einem durch die Atmosphäre und den Ozean begrenzten System erwarten würde – der Systemgewinnfaktor, das Maß für die Stärke aller auf das Klimasystem wirkenden Rückkopplungsprozesse, bei einer sehr geringen direkten Erwärmung nicht verändert hat und sich im Industriezeitalter nicht verändern wird.

Die Klimatologie irrt sich in ihrer elementaren Steuerungstheorie, indem sie die Tatsache vernachlässigt – die zwar einige Trolle in den Kommentaren ärgert, aber dennoch objektiv wahr ist – dass die zu einem bestimmten Zeitpunkt bestehenden Rückkopplungsprozesse zwangsläufig auf jedes Kelvin der dann herrschenden Referenztemperatur gleichermaßen reagieren müssen. Rückkopplungen reagieren nicht nur auf den winzigen Bruchteil der Referenztemperatur, der direkt durch Treibhausgase erzwungen wird.

Der Fehler der Klimatologie hat viele schwerwiegende Konsequenzen. Nicht die geringste davon ist die Vorstellung, dass man einzelne Rückkopplungsstärken sinnvollerweise in Watt pro Quadratmeter pro Kelvin der Änderung der Referenztemperatur, d.h. der Referenzsensitivität, ausdrücken kann, und nicht der absoluten Referenztemperatur, die die Summe der Emissionstemperatur und aller natürlichen und anthropogenen Referenzsensitivitäten ist.

Es gibt zwei Probleme mit dem Ansatz der Klimatologen. Das erste ist, dass Rückkopplungsprozesse auf die gesamte Referenztemperatur reagieren, ob sie nun wollen oder nicht. Das zweite ist, dass man für eine erfolgreiche Berechnung entweder die Gleichung des absoluten Systemverstärkungsfaktors kennen muss, woraufhin die Differentialrechnung ihre erste Ableitung liefert, oder die erste Ableitung selbst, woraufhin die Integralrechnung die ursprüngliche Gleichung liefert.

Die Form der potenziell relevanten Gleichungen ist jedoch unbekannt und kann nicht ermittelt werden. Schlimmer noch, die den potenziell relevanten Gleichungen zugrundeliegenden Daten sind weder bekannt noch können sie mit einer Genauigkeit ermittelt werden, die ausreicht, um eine legitime wissenschaftliche Grundlage für die verschiedenen, gewinnbringend übertriebenen Vorhersagen der globalen Erwärmung zu schaffen, die von den Computermodellen des Klimas verbreitet werden.

In einer der wichtigsten Arbeiten, die jemals in der Klimatologie zur globalen Erwärmung veröffentlicht wurden, wies Pat Frank diese Tatsache im Jahr 2019 endgültig nach, nachdem Professor Karl Wunsch die Arbeit überprüft hatte und keinen Fehler darin finden konnte, der eine Veröffentlichung verhindern würde. Die Arbeit ist seitdem in der wissenschaftlichen Literatur unwiderlegt geblieben, obwohl es online einige spektakulär unausgegorene Versuche gab, sie zu stürzen, hauptsächlich von Seiten der Klimakommunisten, aber in ein oder zwei bedauerlichen Fällen auch von Seiten der Skeptiker, die nicht wussten, dass sie mit der relevanten Mathematik nicht vertraut waren.

Dr. Franks bewundernswerte Arbeit, die von den klimakommunistischen Torwächtern der einstmals angesehenen Fachzeitschriften 13 Mal abgelehnt wurde, bevor sie einen ehrlichen und kompetenten Gutachter fand, beweist, dass die veröffentlichte Unsicherheit in einer einzigen der Tausenden von Eingangsvariablen, die in die allgemeinen Zirkulationsmodelle einfließen – der wolkenarme Anteil – so groß ist, dass jede vorhergesagte globale Erwärmung oder Abkühlung von weniger als 15 K im Vergleich zur Gegenwart reine Spekulation ist, wenn man diese Unsicherheit auf dieses Jahrhundert überträgt. Die Arbeit von Dr. Frank beweist dieses Ergebnis formal mit Hilfe von standardmäßigen und gut etablierten statistischen Methoden.

Mit einem anderen Verfahren können wir ebenfalls die Unfähigkeit der allgemeinen Zirkulationsmodelle zur Vorhersage der globalen Erwärmung nachweisen. Wir beginnen mit Tabelle 7.10 des IPCC (2021).

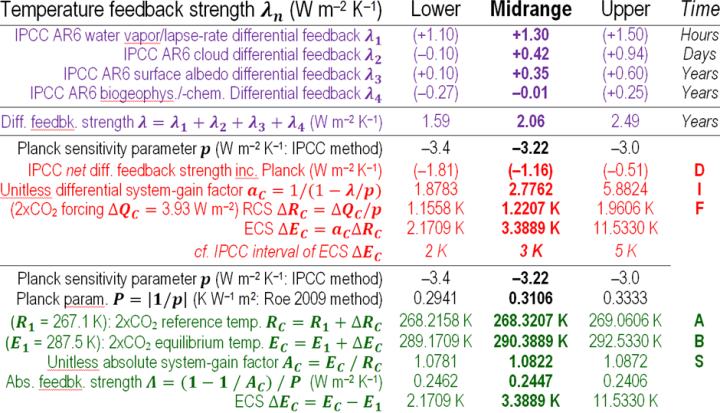

In der Tabelle sind die wichtigsten sensibilitätsrelevanten Temperatur-Rückkopplungen aufgeführt. Das IPCC gibt die Rückkopplungsstärken λ (hier in lila) dank des blödsinnigen Physikfehlers der Klimatologie in Watt pro Quadratmeter pro Kelvin der Referenzsensitivität und nicht der Referenztemperatur an.

Eine solche Wahl wäre vielleicht verzeihlich, wenn, wie es in der Elektronik oft der Fall ist, das Störsignal einen sehr großen Anteil am gesamten Eingangssignal hätte. Heute ist das Störsignal jedoch winzig: Es beträgt nur 7,5 + 0,97 = 8,47 K in 268,07 K, also 3 % des Eingangssignals.

Die Ableitung des ECS über den differentiellen Systemverstärkungsfaktor ist in rot dargestellt, während die Ableitung des ECS auf der Grundlage der IPCC-Daten, aber über den absoluten Systemverstärkungsfaktor, in grün dargestellt ist. Beide Methoden zeigen natürlich identische Werte für ECS. Die IPCC-Methode weist jedoch mehrere Probleme auf, wie die Ableitungen daraus zeigen.

Problem 1: Obwohl im mittleren Bereich die Summe von +2,06 W/m² der einzelnen Rückkopplungsstärken und des Planck-Parameters p, der vom IPCC so ausgedrückt wird, als wäre er eine „Rückkopplung“ in Wm²K, gleich der veröffentlichten Netto-Rückkopplungsstärke von -1,16 W/m²K ist, stimmen seine untere und obere Grenze nicht mit den veröffentlichten Gesamtwerten überein. Zweifellos gibt es dafür gute Gründe, aber die Diskrepanz trägt zu der ohnehin schon enormen Unsicherheit im Intervall der Rückkopplungsstärken bei.

Problem 2: Der Planck-Parameter p ist Teil des Bezugsrahmens für die Ableitung von Gleichgewichtstemperaturen: Er sollte daher besser in K/Wm² der Bezugstemperatur ausgedrückt werden. p ist die erste Ableitung der Stefan-Boltzmann-Gleichung nach der absoluten Oberflächentemperatur (heute 288 K) und der Strahlungsflussdichte über der Atmosphäre (heute 242 W/m²): P = 298 / (4 x 242) = 0,3 K/Wm², was nahe genug am Kehrwert des derzeitigen Mittelwerts des IPCC von p= 3,22 W/m² K liegt.

Problem 3: Der Planck-Parameter ist mit einer weitaus geringeren Unsicherheit bekannt als die vom IPCC angenommenen ±6,5 %, da er aus einem Verhältnis absoluter Größen abgeleitet ist, deren Werte gut gesichert sind. Nehmen wir die heutige Oberflächentemperatur von 288 ± 2 K und den Netto-Antrieb an der Oberseite der Atmosphäre von 242 ± 2 W/m². Dann fällt der Planck-Parameter unter Verwendung der reziproken Form des IPCC auf 3,36 [3,31, 3,41] W/m²K, ein Intervall von weniger als ±1,5 %, und nicht die ±6,5 % des IPCC. Die Korrektur dieses Fehlers würde eine der vielen Ungereimtheiten korrigieren, die in der Tabelle zu finden sind, aus der hervorgeht, dass auf absoluter Basis kleinere Rückkopplungsstärken größere ECS-Werte erzeugen.

Problem 4: Bis zum IPCC (2021) war man lange davon ausgegangen, dass der CO2-Antrieb mit einer Genauigkeit von ±10 % bekannt ist. Er wurde daher als einigermaßen gesichert angesehen. Obwohl Andrews (2012) auf der Grundlage von 15 damaligen Modellen zu dem Schluss kam, dass der CO2-Antrieb im mittleren Bereich bei 3,45 W/m² liegt, sagt das IPCC nun, dass er 3,93 W/m² beträgt, was einem Anstieg von 14 % entspricht und weit außerhalb des Intervalls liegt, das man für den verdoppelten CO2-Antrieb gehalten hatte. Wenn die Unsicherheit in Bezug auf den CO2-Antrieb so groß ist, wie der Anstieg des IPCC im Vergleich zu früheren Berichten andeutet, ist erst recht die Unsicherheit in Bezug auf die Stärke der Rückkopplung größer.

Problem 5: Das IPCC stellt die Wolkenrückkopplung als positiv dar. Der primäre Effekt der erhöhten Wolkenbedeckung, der mit der Erwärmung zu erwarten ist – d.h. eine Erhöhung der Albedo der Erde – ist natürlich ein kühlender Effekt, der mehr als genug ist, um den wärmenden Effekt der Wolken, die die nächtliche Strahlung in den Weltraum hemmen, zu überwinden.

Problem 6: Die absoluten Gesamt-Rückkopplungsstärken, die im ECS-Intervall des IPCC impliziert sind, nehmen tatsächlich ab, wenn die ECS-Schätzung zunimmt. Der Grund dafür ist, dass die absoluten Rückkopplungsstärken sehr viel kleiner sind als die höchst unsicheren und daher bedeutungslosen differentiellen Rückkopplungsstärken und dementsprechend in Bezug auf den Planck-Parameter kleiner sind als die differentiellen Rückkopplungsstärken.

Problem 7: Die Prüfsummenwerte für die untere Grenze und die Mitte des Bereichs von ECS, die aus den Rückkopplungsstärken von IPCC mit der Standardmethode der Kontrolltheorie abgeleitet wurden, bestätigen die von IPCC angegebene untere Grenze von 2 K und die Mitte des Bereichs von 3 K. Die gezeigte Methode ist daher eine angemessene Darstellung der IPCC-Methode. Allerdings ist der so errechnete obere Grenzwert von 11,5 K in der Tabelle mehr als doppelt so hoch wie der vom IPCC angegebene Wert von 5 K. Der Grund dafür ist, dass die Form der Reaktionskurve von ECS bei Vorhandensein von Rückkopplungen rechteckig-hyperbolisch ist, so dass bei imaginären Verstärkungsfaktoren (Rückkopplungsreaktionen als Bruchteile von ECS) von mehr als 0,5 eine unkontrollierte Erwärmung zu erwarten wäre. Zu einer unkontrollierten Erwärmung kommt es jedoch nicht, sonst hätten wir es schon längst bemerkt. Stattdessen gab es eine Abfolge von langen Pausen mit kurzen Ausbrüchen von El-Niño-bedingter Erwärmung dazwischen. Diese Pausen liefern also leicht verständliche Beweise dafür, dass die von den Klimakommunisten vorausgesagte unkontrollierte Erwärmung einfach nicht stattfindet. Daher auch das Geschrei der Kreml-Agenten in den Kommentaren.

Problem 8: Die unkontrollierbare globale Erwärmung, die sich aus der Rechteck-Hyperbolizität der Reaktionskurve in Verbindung mit der überhöhten IPCC-Schätzung der Rückkopplungsstärke an der oberen Grenze ergibt, führt dazu, dass ECS nicht durch Modelle begrenzt werden kann. Die Schätzung der Obergrenze, die viel zu groß ist, um glaubwürdig zu sein, erhöht beispielsweise den impliziten Verstärkungsfaktor hC = 1 – 1 / AC auf 0,83, was bedeutet, dass fünf Sechstel des ECS durch Rückkopplungen und nur ein Sechstel durch die Referenzsensitivität, die direkt durch die nicht kondensierenden Treibhausgase erzwungen wird, erzwungen werden. In einem im Wesentlichen thermostatischen System ist eine solche Schlussfolgerung so unplausibel, dass sie unsinnig ist.

Problem 9: Das Intervall des auf der Differentialbasis abgeleiteten Systemverstärkungsfaktors beträgt 2,7762 [1,8783, 5,8824], aber dieses Intervall ist bedeutungslos. Bei der Ableitung der Unsicherheit der Rückkopplungsstärke und damit des Systemverstärkungsfaktors müssen die Summen auf der Grundlage gebildet werden, dass die Sonne scheint und dass die Rückkopplungen daher auf das gesamte Eingangssignal und nicht nur auf eine Störung darin reagieren. Die Methode der Klimatologie berücksichtigt nicht ausdrücklich die Tatsache, dass Rückkopplungen auf die gesamte Referenztemperatur reagieren. Das Intervall des absoluten Systemverstärkungsfaktors, das in der IPCC-Tabelle implizit enthalten ist, trägt dieser Tatsache Rechnung. Er beträgt 1,0781 [1,0822, 1,0872].

Problem 10: Sehr kleine Änderungen der gesamten Rückkopplungsstärke und damit des Systemgewinnfaktors würden zu dem sehr großen ECS-Intervall führen, das sich das IPCC vorstellt. Die Grenzen unterscheiden sich von den mittleren Schätzungen um kaum mehr als 0,5 %: Dennoch würden sie ausreichen, um das absurd hohe und absurd breite 3,4 [2,2, 11,5] K-Intervall des ECS zu erzeugen, das in den überzogenen Daten des IPCC für die Rückkopplungsstärken enthalten ist. Angesichts der Unsicherheiten in den Daten und der Ausbreitung dieser Unsicherheiten im Laufe der Zeit können die Klimaforscher jedoch weder die Grenzen der Rückkopplungsstärke noch die des Systemverstärkungsfaktors auch nur annähernd auf 0,5 % genau eingrenzen. Dies ist eines der schwerwiegendsten Probleme mit den Vorhersagen der GCMs zur globalen Erwärmung. Es wäre schon vor Jahrzehnten entdeckt worden, wenn die Klimatologie nicht einen physikalischen Fehler begangen hätte.

Betrachtet man das winzige Intervall des implizit vorhergesagten absoluten Systemgewinnfaktors des IPCC (das gesamte Intervall beträgt nur etwa 1 % der mittleren Schätzung) im Lichte des sehr großen (±15 K) ECS-Unsicherheitsbereichs, der in Dr. Franks Studie angegeben ist, wird nur allzu deutlich, dass die allgemeinen Zirkulationsmodelle, welchen Zweck sie auch immer haben mögen, bei dem Versuch, ECS einzuschränken, von keinerlei Wert sind. In dieser Hinsicht sind sie kostspielige Ratespiele, die ohne nennenswerten Verlust an Genauigkeit kostengünstig durch einen Satz Würfel ersetzt werden könnten.

Diese zahlreichen Probleme lassen sich nicht beiseite schieben, indem man behauptet, man könne Rückkopplungsberechnungen mit der Differentialmethode genauso gut durchführen wie mit der Absolutmethode. Wie wir gesehen haben, hat die Durchführung dieser Berechnungen nach der Differenzmethode den Effekt, dass viele der oben kurz beschriebenen Probleme verdeckt werden. Das Verfahren des IPCC bietet also keine zufriedenstellende Grundlage für die Entscheidung wissenschaftlich ungebildeter Regierungen, die aus Angst vor Rufmord durch Klimakommunisten in Panik geraten sind, das wirtschaftliche und politische Harakiri zu begehen, das sich jetzt ereignet.

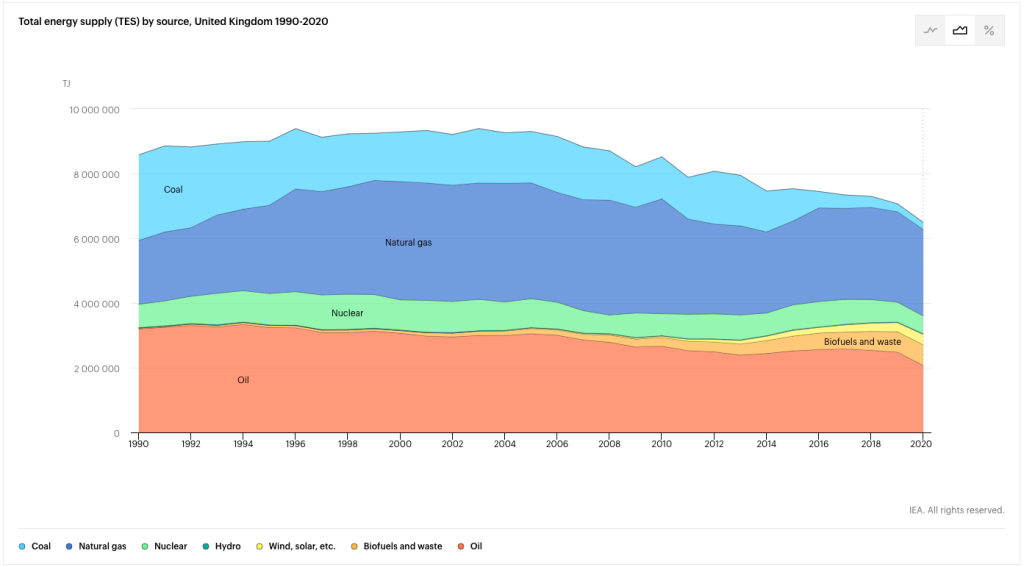

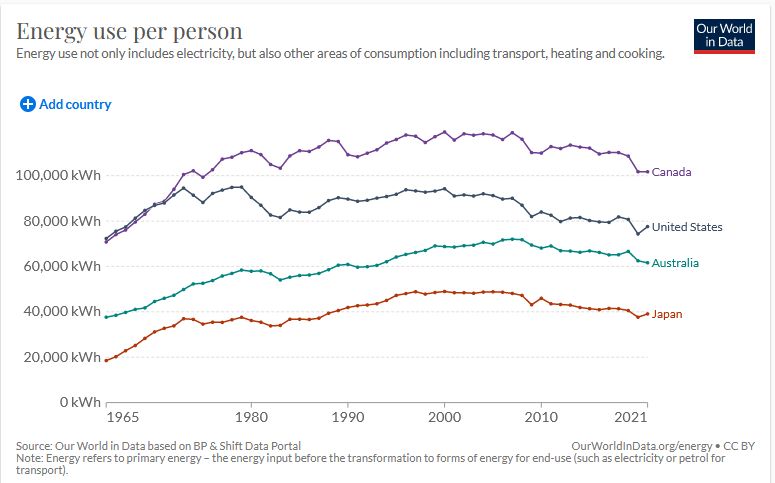

Irgendwann werden die Marxstream-Medien erkennen, dass sie die Tatsache nicht länger verschweigen können, dass die Hauptursache für den Anstieg der sibirischen Gas- und chinesischen Lithiumkarbonatpreise und den daraus resultierenden gefährlichen Anstieg der westlichen Energiepreise die unvorsichtige Aufgabe des freien Energiemarktes und die törichte und verschwenderische Schließung der westlichen Kohlekraftwerke war, die Strom für nur 30 Dollar pro MWh erzeugten. Europa ist nun auf fatale Weise von sibirischem Gas abhängig, ein kostspieliger strategischer Fehler.

Aus Dutzenden von Abhandlungen über die Klimasensitivität und aus Gesprächen mit Klimatologen auf beiden Seiten der Debatte sowie mit den wissenden, unwissenden oder geistlosen Handlangern des Kremls wird deutlich, dass sie nicht erkannt hatten, dass alle zu einem bestimmten Zeitpunkt bestehenden Rückkopplungsprozesse auf das gesamte Eingangssignal reagieren müssen und nicht nur auf eine Störung desselben.

Hätten sie das gewusst, wären sie nicht im Traum auf die Idee gekommen, Vorhersagen auf der Grundlage der differentiellen und nicht der absoluten Rückkopplungsstärken zu machen. Sie hätten erkannt, dass der Versuch, anhand der Modelle überhaupt Rückkopplungen zu diagnostizieren, zwangsläufig zum Scheitern verurteilt ist, da ihre sehr kleinen Unsicherheiten in der Rückkopplungsstärke, wenn sie real sind, zu sehr großen und folglich nicht einschränkbaren Veränderungen der Gleichgewichtsempfindlichkeit führen würden.

Das wirft die Frage auf, welches die solideste Methode zur Ableitung der Klimasensitivitäten ist. Wir bevorzugen die Methode des korrigierten Energiebudgets, von der die sehr einfache, aber recht robuste Version weiter oben in dieser Kolumne gezeigt hat, dass wir bei „business as usual“ nur 0,9 K weitere globale Erwärmung bis zum Jahr 2100 erwarten können. Eine ausgefeiltere Version kommt zum gleichen Ergebnis. Die mittlere Gleichgewichtsempfindlichkeit bei verdoppeltem CO2 beträgt nur 3,45 x 0,3 x 1,0764 = 1,1 K. Das ist doch kaum lebensbedrohlich, oder?

Link: https://wattsupwiththat.com/2022/09/03/the-new-pause-pauses/

Übersetzt von Christian Freuer für das EIKE