Gianluca Alimonti, Luigi Mariani, Franco Prodi & Renato Angelo Ricci

Abstract

In diesem Artikel wird die aktuelle Literatur zu Zeitreihen einiger extremer Wetterereignisse und zugehörigen Reaktionsindikatoren gesichtet, um zu verstehen, ob eine Zunahme der Intensität und/oder Häufigkeit feststellbar ist. Die stärksten globalen Veränderungen bei den Klimaextremen sind bei den Jahreswerten der Hitzewellen (Anzahl der Tage, maximale Dauer und kumulierte Hitze) zu verzeichnen, während die globalen Trends bei der Hitzewellenintensität nicht signifikant sind. Die tägliche Niederschlagsintensität und die Häufigkeit von Extremniederschlägen sind bei den meisten Wetterstationen stationär. Die Trendanalyse der Zeitreihen tropischer Wirbelstürme zeigt eine erhebliche zeitliche Invarianz, und dasselbe gilt für Tornados in den USA. Gleichzeitig bleibt die Auswirkung der Erwärmung auf die Windgeschwindigkeit am Boden unklar. Die Analyse wird dann auf einige globale Reaktionsindikatoren extremer meteorologischer Ereignisse ausgedehnt, nämlich Naturkatastrophen, Überschwemmungen, Dürren, die Produktivität von Ökosystemen und die Erträge der vier wichtigsten Kulturpflanzen (Mais, Reis, Sojabohnen und Weizen). Keiner dieser Reaktionsindikatoren zeigt einen eindeutig positiven Trend bei extremen Ereignissen. Auf der Grundlage der Beobachtungsdaten lässt sich abschließend feststellen, dass die Klimakrise, die wir nach Meinung vieler Quellen heute erleben, noch nicht offensichtlich ist. Dennoch wäre es äußerst wichtig, Abmilderungs- und Anpassungsstrategien zu definieren, die den aktuellen Trends Rechnung tragen.

Einführung

Die durchschnittliche Temperatur unseres Planeten hat sich gegenüber der vorindustriellen Zeit um etwa ein Grad Celsius erhöht, und verschiedene Studien weisen auf Schwankungen bei Bewölkung, Niederschlag, relativer Luftfeuchtigkeit und Windgeschwindigkeit hin. In diesem Artikel wird die aktuelle Literatur zu einigen extremen Wetterereignissen durch einen Vergleich mit Zeitreihen geprüft, um zu verstehen, ob eine Zunahme der Intensität und/oder der Häufigkeit festzustellen ist.

Nach der Definition des IPCC AR5 [1] sind extreme Wetterereignisse Ereignisse, die an einem bestimmten Ort und zu einem bestimmten Zeitpunkt des Jahres selten sind. Die Definitionen für seltene Ereignisse variieren, aber ein extremes Wetterereignis ist normalerweise so selten wie oder seltener als das 10. oder 90. Perzentil einer aus Beobachtungen geschätzten Wahrscheinlichkeitsdichte-Funktion. Wenn ein Muster extremen Wetters über einen längeren Zeitraum, z. B. eine Saison, anhält, kann es als extremes Klimaereignis eingestuft werden, insbesondere wenn es einen Durchschnittswert oder eine Gesamtsumme ergibt, die selbst extrem ist (z. B. Dürre oder starke Regenfälle während einer Saison).

Die extremen Wetterereignisse, um die es hier geht, spielen sich im Klimasystem ab, einem System von großer Komplexität, das fünf Teilsysteme umfasst (Atmosphäre, Kryosphäre, Lithosphäre, Hydrosphäre und Biosphäre) und dessen grundlegende Elemente das Energiegleichgewicht zwischen den von der Sonne eintreffenden Photonen und den in den Weltraum zurückgestrahlten Photonen, der Treibhauseffekt und die atmosphärische und ozeanische Zirkulation sind. Das Klimasystem wird durch das Energieungleichgewicht in Gang gesetzt, das sich aus den Breiten- und Jahreszeitenschwankungen der auf den Boden auftreffenden Sonnenenergie ergibt und die atmosphärischen und ozeanischen Zirkulationen in Gang setzt, die für die Umverteilung der Energie in Breiten- und Zonenrichtung verantwortlich sind. Weitere Einzelheiten stehen im didaktischen Papier und dem Bericht, der auf dem SIF-Kongress 2020 von einem der Autoren vorgestellt wurde [2, 3].

Beobachtungen von Extremwetter-Ereignissen

Im Zusammenhang mit extremen Wetterereignissen ist es wichtig, den Unterschied zwischen dem statistischen Nachweis einer Häufung von Ereignissen mit bestimmten Merkmalen und der probabilistischen Berechnung der anthropogenen Verursachung von Extremereignissen hervorzuheben: beide Aspekte haben einen sehr unterschiedlichen erkenntnistheoretischen Status.

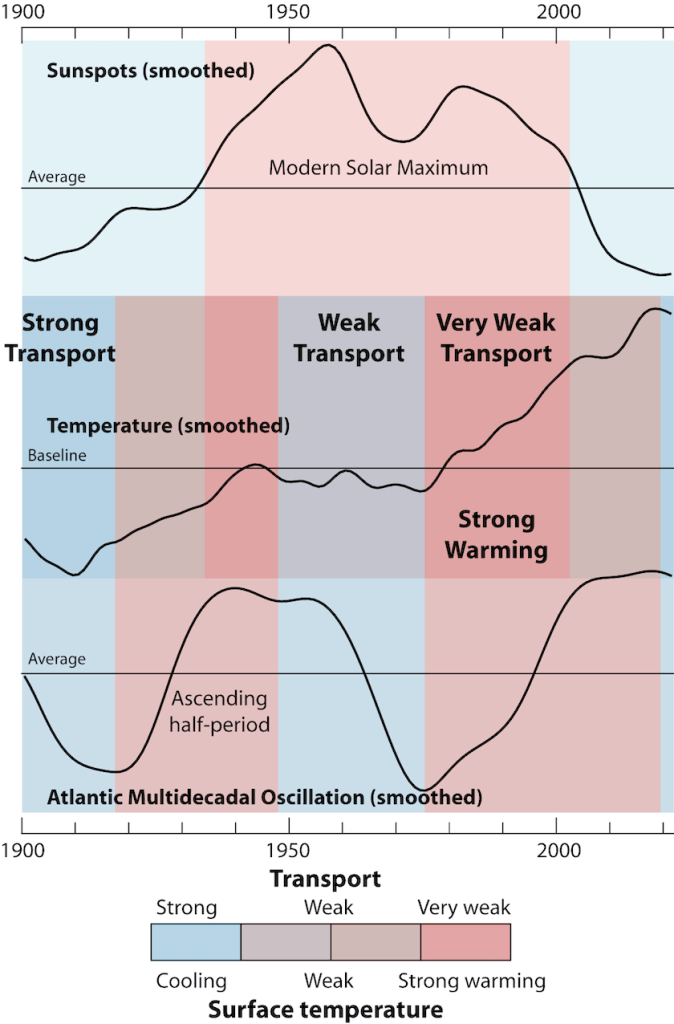

Während die statistischen Nachweise auf historischen Beobachtungen beruhen und versuchen, Unterschiede zwischen diesen und aktuellen Beobachtungen oder möglichen Trends in Abhängigkeit von der Zeit aufzuzeigen, basiert die Zuordnung anthropogener oder natürlicher Ursachen eines Phänomens auf probabilistischen Modellen und stützt sich auf Simulationen, die die beteiligten makro- und mikrophysikalischen Variablen kaum wiedergeben. So zeigt beispielsweise die von Wetterstationen an der Landoberfläche gemessene Windgeschwindigkeit im Zeitraum 1973-2019 für alle Regionen der Welt einen leicht negativen Trend bei der Häufigkeit extremer Winde (Geschwindigkeit > 10 m/s). Zu den möglichen Ursachen gehören Veränderungen in der großräumigen atmosphärischen Zirkulation, die Zunahme der Oberflächenrauhigkeit, Änderungen der Instrumentierung, unterschiedliche Messzeitintervalle, Luftverschmutzung und eine Zunahme der räumlichen Varianz der oberflächennahen Lufttemperatur [4]. Die möglichen Ursachen spielen sich auf verschiedenen Ebenen ab, und die dahinter stehenden Prozesse sind wahrscheinlich räumlich und zeitlich unterschiedlich, so dass die Zuordnung sehr unsicher ist. Darüber hinaus kamen Zeng et al. [5] zu dem Schluss, dass die Beziehung zwischen Ozean-Atmosphären-Oszillationen und der anthropogenen Erwärmung sowie die Auswirkungen auf die Variabilität der Windgeschwindigkeit an der Oberfläche nach wie vor unklar sind und eine große wissenschaftliche Herausforderung darstellen.

Das Vertrauen in die Beobachtungen von Extremereignissen hängt von der Qualität und Quantität der Daten ab, die je nach Weltregion und für verschiedene Arten von Extremereignissen und Wettervariablen unterschiedlich sind. In diesem Zusammenhang muss zunächst auf die Schwierigkeit hingewiesen werden, zuverlässige Zeitreihen globaler Daten zu finden: Oft müssen wir uns auf lokalere Beobachtungen beschränken, die in Gebieten durchgeführt werden, in denen die Phänomene in der Vergangenheit besser beobachtet und aufgezeichnet wurden und deren Daten daher zuverlässiger und repräsentativer sind.

Wie vom IPCC [6] berichtet, sind die robustesten globalen Veränderungen bei den Klimaextremen bei den täglichen Temperaturmessungen zu finden, einschließlich der Hitzewellen. Die von Perkins-Kirkpatrick und Lewis [7] durchgeführte globale Analyse zeigte für den Zeitraum 1951-2017 einen signifikanten Anstieg der jährlichen Werte der Hitzewellentage, der maximalen Hitzewellendauer und der kumulativen Hitze, während die globalen Trends der Hitzewellenintensität nicht signifikant sind. Auch die Niederschlagsextreme scheinen zuzunehmen, doch gibt es große räumliche Schwankungen, und die bei Dürren beobachteten Trends sind außer in einigen Regionen noch ungewiss. Seit den 1970er Jahren ist eine starke Zunahme der Häufigkeit und Aktivität tropischer Wirbelstürme im Nordatlantik zu beobachten. Es gibt nur begrenzte Hinweise auf Veränderungen bei Extremen in Verbindung mit anderen Klimavariablen seit Mitte des zwanzigsten Jahrhunderts.

Während die Zunahme der Häufigkeit und Dauer von Hitzewellen leicht durch den globalen Temperaturanstieg erklärt werden kann, scheint die beobachtete Zunahme der tropischen Wirbelstürme im Nordatlantik ein lokales Phänomen zu sein und im Wesentlichen auf eine bessere Berichterstattung zurückzuführen zu sein, wie sie von der NOAA unterstützt wird und wie wir in dem Abschnitt, der dieser Art von Phänomenen gewidmet ist, genauer sehen werden. In anderen Gebieten des Planeten wird ein Rückgang der gleichen Phänomene beobachtet und in wieder anderen wird kein Trend beobachtet, was die globalen Auswertungen im Wesentlichen auf eine wesentliche zeitliche Invarianz bringt.

Was die offensichtliche Zunahme der durch Extremereignisse verursachten wirtschaftlichen Schäden betrifft, so nimmt der IPCC [8] erneut eine sehr vorsichtige Haltung ein und argumentiert, dass die Zunahme der Exposition von Menschen und wirtschaftlichen Ressourcen die Hauptursache für den langfristigen Anstieg der wirtschaftlichen Verluste durch Wetter- und Klimakatastrophen war. Langfristige Trends bei den Katastrophenverlusten, die unter Berücksichtigung des steigenden Wohlstands und der Bevölkerungszahl normalisiert wurden, wurden bisher nicht auf den Klimawandel zurückgeführt, aber es wurde bisher nicht ausgeschlossen, dass der Klimawandel eine Rolle gespielt haben könnte.

Eine ausführliche Studie über den Zusammenhang zwischen Anfälligkeit und Wohlstand [9] kommt zu folgendem Schluss: „Die Ergebnisse zeigen einen klaren Abwärtstrend sowohl bei der menschlichen als auch bei der wirtschaftlichen Anfälligkeit, wobei die durchschnittlichen Sterblichkeits- und wirtschaftlichen Verlustraten von 1980-1989 bis 2007-2016 um das 6,5- bzw. fast 5-fache gesunken sind. Darüber hinaus zeigen wir eine klare negative Korrelation zwischen Anfälligkeit und Wohlstand, die bei den niedrigsten Einkommensstufen am stärksten ist“.

In den folgenden Abschnitten werden einige der wichtigsten extremen Klimaereignisse betrachtet und ihre Entwicklung im Laufe der Zeit auf globaler Ebene oder in den Gebieten, in denen die Zeitreihen zu solchen Phänomenen als ausreichend zuverlässig gelten, analysiert.

Hurrikane

Ein tropischer Wirbelsturm (im Nordatlantik Hurrikan genannt) ist ein schnell rotierender Sturm, der über tropischen Ozeanen entsteht und von dort die Energie für seine Entwicklung bezieht. Er hat ein Tiefdruckzentrum und Wolken, die sich spiralförmig in Richtung der Augenwand bewegen, die das „Auge“ umgibt, den zentralen Teil des Systems, in dem das Wetter normalerweise ruhig und wolkenfrei ist. Der Durchmesser des Wirbelsturms beträgt in der Regel zwischen 200 und 500 km, kann aber auch 1000 km erreichen. Ein tropischer Wirbelsturm bringt sehr heftige Winde, sintflutartige Regenfälle, hohe Wellen und in einigen Fällen sehr zerstörerische Sturmfluten und Überschwemmungen an den Küsten mit sich. Die Winde wehen in der nördlichen Hemisphäre gegen den Uhrzeigersinn und in der südlichen Hemisphäre im Uhrzeigersinn. Tropische Wirbelstürme ab einer bestimmten Stärke werden im Interesse der öffentlichen Sicherheit mit Namen versehen. In den letzten 50 Jahren wurden fast 2000 Katastrophen auf tropische Wirbelstürme zurückgeführt, bei denen mehrere hunderttausend Menschen ums Leben kamen und wirtschaftliche Schäden in Höhe von mehr als 1400 Milliarden US-Dollar entstanden [10].

Die Auswirkungen von Hurrikanen auf die globale Zirkulation sind von Bedeutung, wie Studien zeigen, die eine erhebliche Verringerung des Golfstromes durch darüber hinwegziehende Hurrikane belegen [11].

Diese Beobachtungen, die sich auf den Nordatlantik im Jahr 2017 beziehen, sind von größter Bedeutung, da jedes Jahr weltweit 80-100 tropische Stürme beobachtet werden, von denen etwa die Hälfte die Stärke eines Hurrikans erreichen und ein kleinerer Prozentsatz, etwa ein Viertel, zu starken Hurrikanen wird.

Der Oberbegriff „tropischer Wirbelsturm“ kann zur Beschreibung von tropischen Stürmen, Hurrikanen und Taifunen verwendet werden. Obwohl die meisten tropischen Wirbelstürme ihren Lebenszyklus beenden, ohne Land zu treffen, verursachen viele von ihnen jedes Jahr katastrophale Schäden und fordern Menschenleben in den Küstenländern, einschließlich der USA.

Historisch gesehen sind rund 60 % aller wirtschaftlichen Schäden, die weltweit durch Katastrophen verursacht werden, auf Hurrikane in den USA zurückzuführen [12], und mehr als 80 % dieser Schäden entstehen durch schwere Hurrikane. Es ist daher nicht verwunderlich, dass Hurrikane Interesse und Aufmerksamkeit erregen. Aufgrund ihres beängstigenden Zerstörungspotenzials ist es auch nicht verwunderlich, dass Hurrikane ein zentrales Element in der Debatte über Maßnahmen zur Eindämmung des Klimawandels und zur Anpassung daran sind.

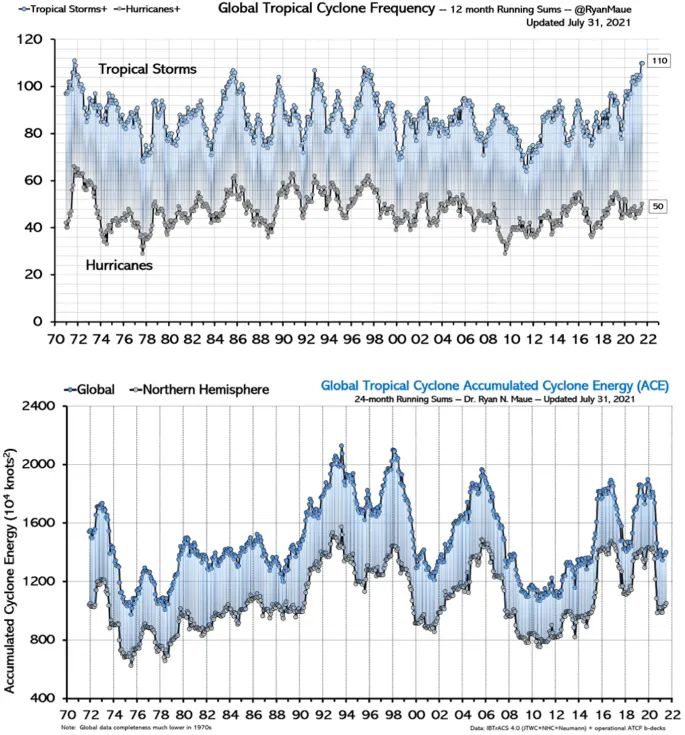

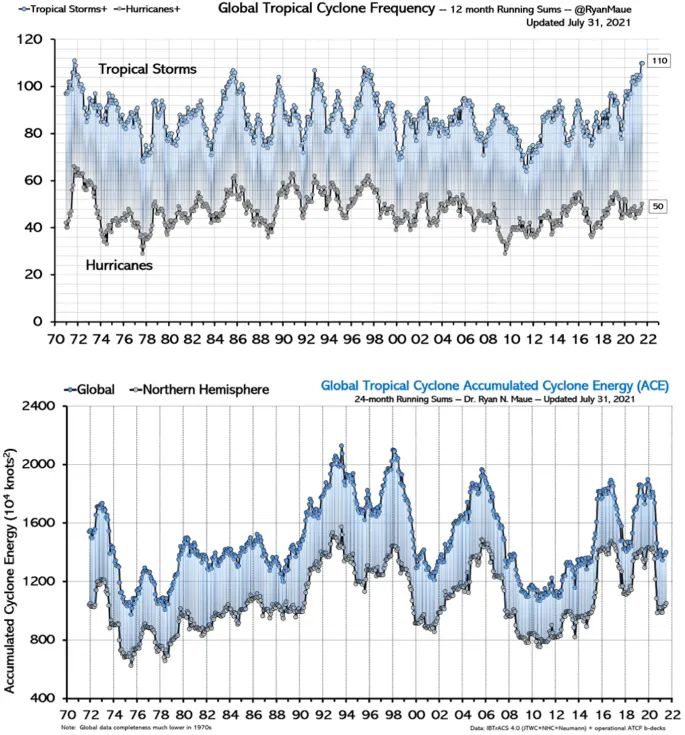

Bislang zeigen globale Beobachtungen keine signifikanten Trends sowohl bei der Anzahl als auch bei der von Hurrikanen akkumulierten Energie, wie in Abb. 1 dargestellt und in mehreren spezifischen Veröffentlichungen [13] für die USA, die den Trend seit mehr als 160 Jahren zurückverfolgen, oder für andere Regionen der Erde [14, 15] behauptet wird.

Abbildung 1

Besondere Aufmerksamkeit sollte der IPCC-Erklärung gewidmet werden, in der von einer starken Zunahme der Häufigkeit und Aktivität tropischer Wirbelstürme im Nordatlantik berichtet wird. Um mehr Informationen zu diesem Thema zu erhalten, hat die NOAA [17] viel längere Zeitreihen (> 100 Jahre) der atlantischen Hurrikan-Aktivität analysiert.

Die vorhandenen Aufzeichnungen über die Zahl der vergangenen atlantischen Tropenstürme oder Hurrikane (von 1878 bis heute) zeigen in der Tat einen ausgeprägten Aufwärtstrend; allerdings war die Meldedichte der Atlantikschifffahrt in den ersten Jahrzehnten dieses Zeitraums relativ gering: Wären die Stürme der Neuzeit (nach 1965) hypothetisch während dieser Jahrzehnte aufgetreten, wäre eine beträchtliche Zahl von Stürmen wahrscheinlich nicht vom Marinebeobachtungsnetz erfasst worden.

Nach Anpassung der Zeitreihen an die geringeren Beobachtungskapazitäten der Vergangenheit bleibt daher nur ein kleiner nominell positiver Aufwärtstrend der Tropenstürme von 1878 bis 2006. Statistische Tests zeigen, dass dieser Trend nicht signifikant von Null zu unterscheiden ist.

Darüber hinaus stellten Landsea et al. [18] fest, dass der steigende Trend bei der Anzahl der Tropenstürme im Atlantik fast ausschließlich auf die Zunahme der kurzlebigen Stürme (< 2 Tage) zurückzuführen ist, die in den ersten Jahren der Aufzeichnungen wahrscheinlich übersehen wurden, da sie weniger Gelegenheit zu zufälligen Begegnungen mit dem Schiffsverkehr hatten.

Betrachtet man nicht alle Tropenstürme, sondern die Hurrikane im Atlantikbecken, so ergibt sich ein ähnliches Bild: Die gemeldete Zahl der Hurrikane war in den 1860er und 1880er Jahren ähnlich hoch wie heute, und auch hier ist kein signifikanter positiver Trend seit dieser Zeit zu erkennen. Bei den Hurrikanen, die auf die Küste der USA treffen, sind die Anzeichen für einen Aufwärtstrend sogar noch schwächer; hier ist seit den 1900er Jahren bzw. dem Ende des 19. Jahrhunderts ein leicht negativer Trend zu verzeichnen.

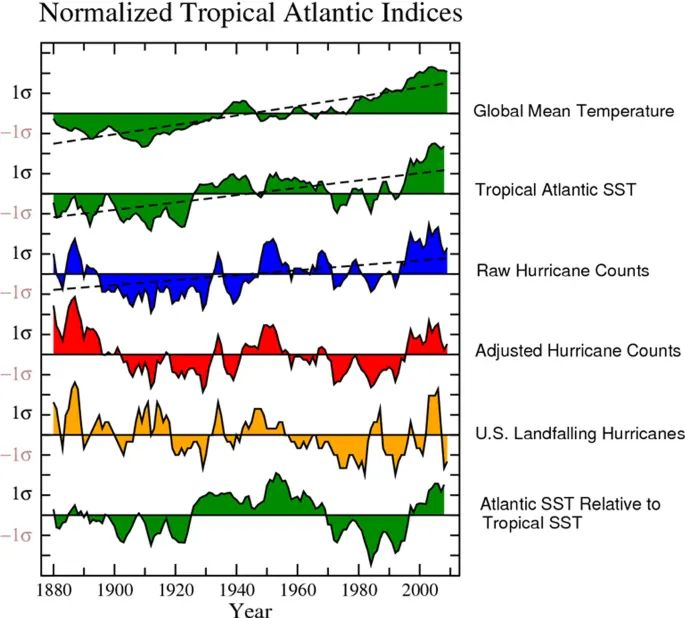

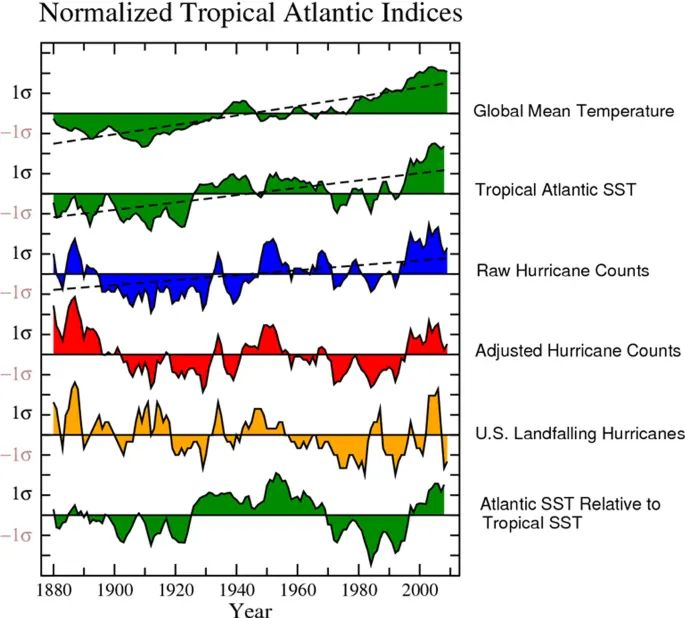

Die Situation für die verschiedenen langfristigen Aufzeichnungen über atlantische Hurrikane und die zugehörigen Indizes ist in Abb. 2 [17] zusammengefasst: Während die mittlere Temperatur des tropischen Atlantiks und die SST einen ausgeprägten und statistisch signifikanten Erwärmungstrend zeigen (grüne Kurven), ist bei den Aufzeichnungen über die Hurrikane, die die Küste der USA treffen (orangefarbene Kurve), kein signifikanter Trend zu erkennen. Die unkorrigierte Aufzeichnung der Hurrikan-Zahlen (blaue Kurve) zeigt eine signifikante Zunahme der atlantischen Hurrikane seit den frühen 1900er Jahren. Bereinigt um die geschätzten Stürme, die auf See geblieben sind und in der Vorsatellitenphase wahrscheinlich „übersehen“ wurden, ist jedoch kein signifikanter Anstieg der atlantischen Hurrikane seit dem Ende des neunzehnten Jahrhunderts festzustellen (rote Kurve).

Abbildung 2

Obwohl die Zahl der Hurrikane, die die Küste der USA treffen, und die Zahl der Hurrikane im atlantischen Becken seit Anfang der 70er Jahre zugenommen haben, zeigt Abb. 2, dass dieser jüngste Anstieg nicht repräsentativ für das in jahrhundertelangen Aufzeichnungen beobachtete Verhalten ist. Kurz gesagt, die historischen Aufzeichnungen über die Häufigkeit atlantischer Hurrikane liefern keine überzeugenden Beweise für eine wesentliche langfristige, durch die Erwärmung verursachte Zunahme.

Die NOAA kommt daher zu dem Schluss, dass „es verfrüht ist, mit großer Sicherheit anzunehmen, dass die zunehmenden Treibhausgas-Konzentrationen in der Atmosphäre, die auf menschliche Aktivitäten zurückzuführen sind, eine nachweisbare Auswirkung auf die Aktivität der Hurrikane im Atlantikbecken haben“ [17].

Unabhängig davon, ob die Wissenschaft in der Lage ist, Schlussfolgerungen über die Auswirkungen des Klimawandels auf Hurrikane zu ziehen, können wir sicher sein, dass es weiterhin Hurrikane geben wird, die die Küstenregionen verwüsten. Der einzige bewährte und praktische Weg, um den Verlust von Menschenleben und Sachschäden zu verhindern, ist die Einführung geeigneter Baunormen und die Aufrechterhaltung eines hohen Maßes an Wachsamkeit gegenüber solchen Phänomenen.

Tornados

Ein Tornado [20] ist ein Wirbel, der sich von der Oberfläche mindestens bis zur Wolkenbasis nach oben erstreckt (wobei die Wolkenbasis mit tiefer feuchter Konvektion, typischerweise einer Cumulonimbuswolke, verbunden ist) und an der Oberfläche intensiv genug ist, um Schäden zu verursachen.

Die erweiterte Fujita-Skala (oder abgekürzt EF-Skala) stuft die Intensität von Tornados in sechs Kategorien von null bis fünf ein [21]. Sowohl mehrzellige als auch superzellige Gewitter sind in der Lage, Tornados zu erzeugen, aber Superzellen sind bei weitem am gefährlichsten: Mehr als 20 % der superzelligen Tornados sind potenziell in der Lage, katastrophale EF-4/EF-5-Schäden zu verursachen [22].

In den USA gibt es eine sehr lange Tornado-Zeitreihe, die sich für Trendanalysen eignet. Wie auf der maßgeblichen NOAA-Website [19, 23] berichtet und auch vom IPCC in seinen Berichten [8] bekräftigt wird, besteht eine der Hauptschwierigkeiten im Zusammenhang mit Tornados darin, dass ein Ereignis nur dann in eine Zeitreihe von Tornados eingefügt werden kann, wenn es direkt beobachtet wurde oder wenn Spuren seines Durchzugs beobachtet wurden (sie hinterlassen beeindruckende Torsionsspuren an Wurzeln und Baumkronen oder Straßenschildern). Tornados haben eine sehr kurze Dauer und sind im Wesentlichen unvorhersehbar; wenn ein Tornado an einem unbewohnten Ort auftritt, ist es daher unwahrscheinlich, dass er dokumentiert wird: Es ist daher wahrscheinlich, dass viele bedeutende Tornados in den USA unentdeckt blieben, da das von ihren Zugbahnen betroffene Gebiet in der ersten Hälfte des Jahrhunderts nur dünn besiedelt war.

Mit zunehmender Dopplerradarabdeckung, Bevölkerungswachstum und erhöhter Aufmerksamkeit für Tornadomeldungen hat die Zahl der Tornadomeldungen in den letzten Jahrzehnten zugenommen. Dies kann den irreführenden Anschein einer zunehmenden Häufigkeit von Tornados erwecken.

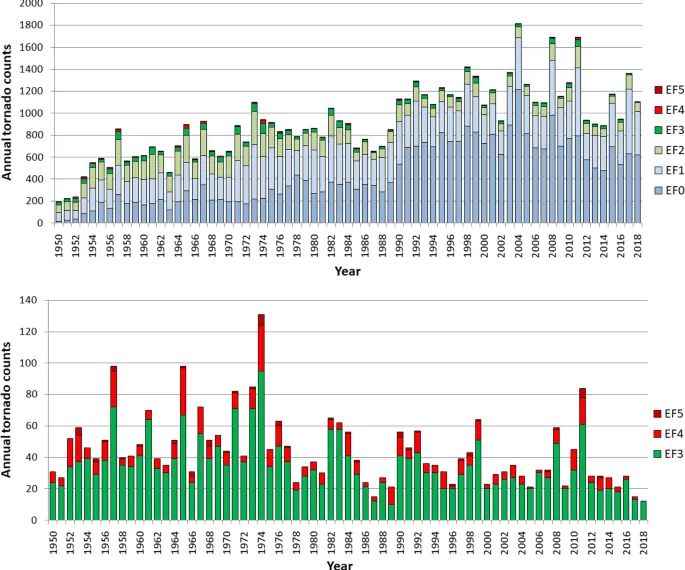

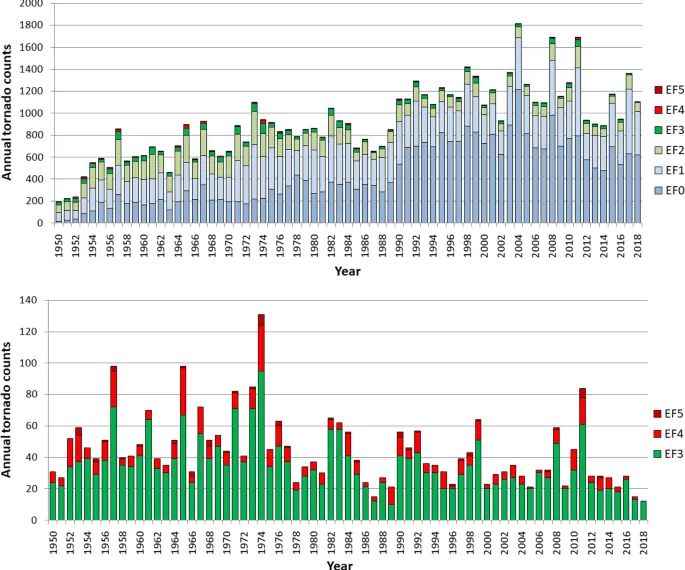

Betrachtet man jedoch die in Abb. 3 [24] dargestellte Zeitreihe, so stellt man fest, dass die Zunahme der Tornados seit 1950 fast ausschließlich auf schwache Ereignisse (EF0-EF1 in der erweiterten Fujita-Skala) zurückzuführen ist, die in der Vergangenheit in vielen Fällen der Beobachtung entgingen und heute dank einer Vielzahl von Systemen, die von Handykameras bis hin zu Satelliten und Dopplerradaren reichen, leichter zu erkennen sind. Im Gegensatz dazu zeigen starke bis heftige Tornados (Kategorien EF-3 bis EF-5 auf der erweiterten Fujita-Skala), die wahrscheinlich auch vor der Dopplerradar-Ära gemeldet wurden, keine Zunahme im Laufe der Zeit.

Abbildung 3

Auf die Frage, ob der Klimawandel das Auftreten von Tornados beeinflusst, antwortet die NOAA, dass es derzeit nicht möglich ist, eine Antwort zu geben, und dass mehr Forschung erforderlich ist, da diese Ereignisse auf sehr kleinen Skalen auftreten, was Beobachtungen und Modellierung schwierig macht.

Die Vorhersage des künftigen Einflusses des Klimawandels auf diese Ereignisse kann auch dadurch erschwert werden, dass einige der Risikofaktoren mit dem Klimawandel zunehmen, während andere abnehmen können.

Dies liegt daran, dass Tornados meteorologische Phänomene von sehr kurzer Dauer sind, die sich auf Zeitskalen von Sekunden und Minuten und auf kleineren räumlichen Skalen abspielen. Im Gegensatz dazu entfalten Klimatrends ihre Wirkung über viel größere Zeitspannen (Jahre, Jahrzehnte oder Jahrtausende) und betreffen große Gebiete auf dem Globus.

Darüber hinaus sind Klimamodelle nicht in der Lage, Tornados oder einzelne Gewitter aufzulösen. Sie können zwar auf großräumige Veränderungen bei drei der vier Faktoren hinweisen, die schwere Gewitter begünstigen (Feuchtigkeit, Instabilität und Windscherung), aber das Vorhandensein einiger günstiger Faktoren ist noch keine Garantie für Tornados. Unser physikalisches Verständnis deutet auf gemischte Signale hin: Einige Bestandteile können in einer wärmeren Welt zunehmen (Instabilität), während andere abnehmen können (Windscherung). Der andere Hauptbestandteil (Sturmauftrieb) und – in unterschiedlichem Maße – Luftfeuchtigkeit, Ausreißer und Windscherung hängen in erster Linie von den Tagesmustern und oft auch vom lokalen Wetter im Minutentakt ab.

Die Clapeyron-Gleichung besagt, dass die mit Thermometern ermittelte globale Erwärmung (Anstieg der globalen Lufttemperatur in zwei Metern Höhe um 7 Zehntelgrad pro Jahrhundert) zu einem höheren Wasserdampfgehalt der Atmosphäre führt, aber es ist schwierig, diesen Anstieg mit den konvektiven Phänomenen oder allgemeiner mit den globalen Karten der Niederschlagsintensität und mit der Entwicklung der Gletscher in Beziehung zu setzen, deren jahrzehntelange Schwankungen die Folge einer Vielzahl von Faktoren sind.

Globaler Niederschlag und extreme Niederschlagsereignisse

Niederschlag ist ein Schlüsselsegment des Energie- und Stoffkreislaufs unseres Planeten [25]. Wasser, das von der Meeresoberfläche und der Landvegetation verdunstet wird, absorbiert große Mengen an Energie in Form von latenter Wärme und ist ein grundlegender Träger für den zonalen und meridionalen Energietransport [26]. Darüber hinaus ist Wasserdampf das wichtigste Treibhausgas, das für 51 % des gesamten Treibhauseffekts auf unserem Planeten verantwortlich ist [27]. In diesem Zusammenhang setzt der Niederschlag die von der Atmosphäre transportierte Energie frei und moduliert gleichzeitig den Treibhauseffekt, indem er die Verweilzeit des Wasserdampfs in der Atmosphäre beeinflusst [28].

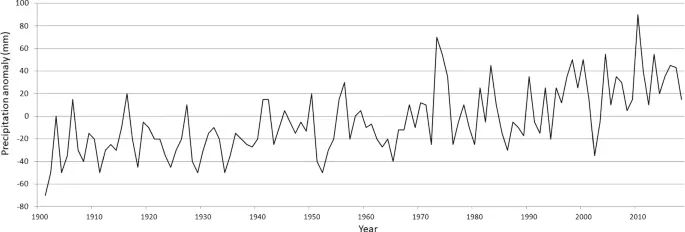

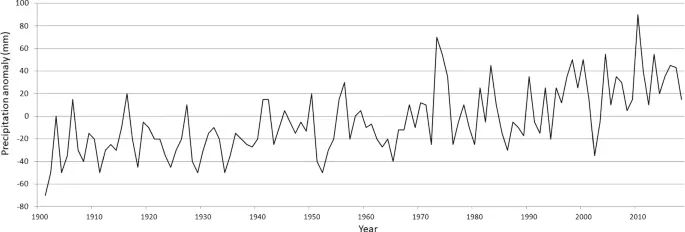

Globale Beobachtungsdaten deuten auf eine Zunahme der jährlichen Gesamtniederschläge hin, die auf den ersten Blick mit dem globalen Temperaturanstieg und der daraus resultierenden Zunahme des in der Atmosphäre gespeicherten Niederschlagswassers im Einklang zu stehen scheint. Um diese Einschätzung zu untermauern, wurden die jährlichen globalen Niederschlagszeitreihen 1901-2018 aus dem gerasterten landgestützten Niederschlagsdatensatz Hadex3 [29] analysiert, der aus täglichen In-situ-Beobachtungen abgeleitet wurde: Das Diagramm in Abb. 4 zeigt, dass die globalen Niederschläge seit etwa 1970 zunehmen:

Abbildung 4

Angesichts dieses Anstiegs der jährlichen Gesamtniederschlagsmenge stellt sich die Frage, ob dies zu einer Zunahme extremer Niederschlagsereignisse geführt hat, die sich ähnlich auswirken wie die Hitzewellen, deren Häufigkeit aufgrund des globalen Temperaturanstiegs zunahm. Zu diesem Zweck ist es wichtig festzustellen, dass es viele mögliche Definitionen für extreme Niederschlagsereignisse gibt, von Wiederkehrperioden und Ansätzen mit Spitzenwerten über dem Schwellenwert bis hin zu Indizes, die die Dauer oder Intensität erfassen. Darüber hinaus können Extreme auch über ein breites Spektrum von räumlichen und zeitlichen Skalen definiert werden [30]. Unsere Analyse wird sich hauptsächlich auf tägliche maximale Niederschlagsmengen für Landstationen auf globaler Ebene und für große Regionen konzentrieren, da (1) stündlichge Daten oft zu kurz oder von unzureichender Qualität sind und (2) Veränderungen in der Größenordnung von stündlichen Extremen langsamer auftreten als bei täglichen Extremen, wie Barbero et al. [31] feststellten, die eine Analyse der Trends von täglichen und stündlichen extremen Niederschlägen in einem großen Stationsnetz in den USA im Zeitraum 1950-2011 durchführten.

Für eine korrekte Interpretation von Extremniederschlagsdaten muss auch berücksichtigt werden, dass ihre genaue Erfassung in hohem Maße von der Genauigkeit der Niederschlagsmessungen abhängt. Eine Analyse der Auswirkungen auf die Genauigkeit der Messungen würde den Rahmen dieser Arbeit sprengen, sollte aber bei der Analyse berücksichtigt werden. Dennoch bleibt die Datenqualität ein Problem, da Niederschlagsmessungen aufgrund ihrer hohen räumlichen und zeitlichen Variabilität schwer zu homogenisieren sind. Die Daten sind dann wahrscheinlich nicht frei von Inhomogenitäten, die von Veränderungen in der Art der zur Niederschlagsmessung verwendeten Instrumente herrühren, da verschiedene Niederschlagsmesser unterschiedliche Windeinflüsse, Befeuchtungs- und Verdunstungsverluste aufweisen [32, 33]. Darüber hinaus besteht der Sensor automatischer (mechanischer oder elektronischer) Regenmesser aus einer Wippe mit zwei Schalen, die abwechselnd mit Wasser gefüllt und ausgegossen werden. Die Wippe kann durch eine Vielzahl von Phänomenen wie die Ansammlung von Schmutz oder das Vorhandensein von Insektennestern gestoppt werden. In diesem Fall wird auch bei Regen ein Wert von 0 angezeigt, was die Instrumente von Natur aus ungenau macht.

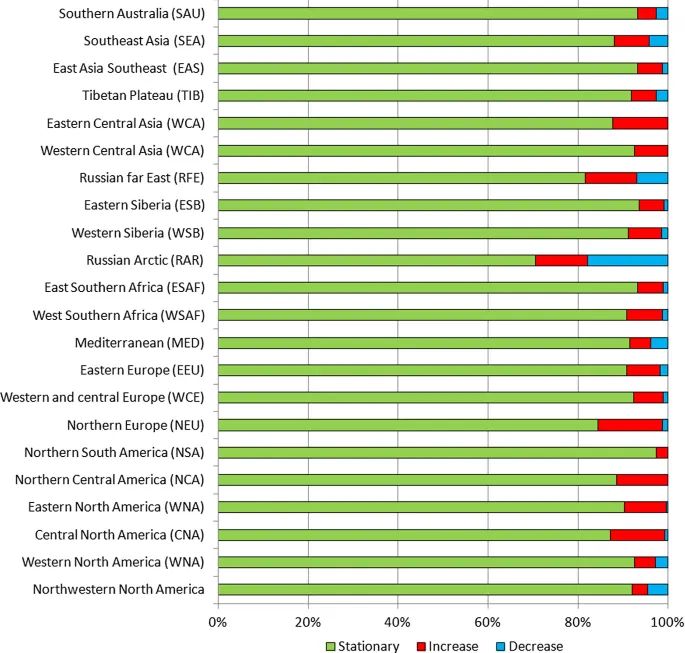

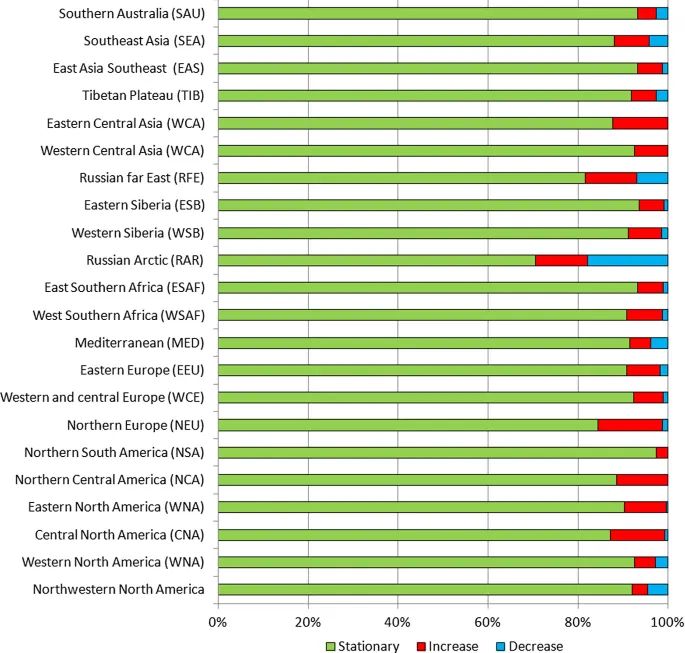

Hinsichtlich der Intensität extremer täglicher Niederschlagsereignisse analysierten Papalexiou und Montanari [34] die extremen Niederschlagsereignisse im Zeitraum 1964-2013 an insgesamt 8730 Stationen. Die Analyse zeigt eine Zunahme der Intensität bei 12,9 % (zwischen 11,7 und 13,9 %) der Stationen weltweit und einen Rückgang bei 9,8 % (zwischen 9 und 11,4 %), während 77,3 % der Stationen keine signifikanten Trends aufweisen.

Diese Daten bestätigen im Wesentlichen die von Westra et al. [35] vorgelegten Daten, die die Entwicklung des globalen maximalen jährlichen Ein-Tages-Niederschlags für den Zeitraum von 1900 bis 2009 (insgesamt 110 Jahre) analysierten. Die Arbeit, die sich auf insgesamt 8326 von den Forschern als hochwertig eingestufte Bodenstationen bezog, führte zu der Schlussfolgerung, dass etwa 2 % der Stationen eine Abnahme der extremen Niederschläge aufweisen, 8 % eine Zunahme und 90 % keinen Trend.

Die Ergebnisse dieser Analyse wurden vor kurzem durch die von derselben Forschergruppe [32] vorgelegten Ergebnisse zum maximalen Jahresniederschlag an einem Tag bestätigt, die sich auf den Zeitraum 1950-2018 beziehen und Folgendes hervorheben:

● Für den Zeitraum 1950-2018 zeigen 9,1 % der Stationen einen statistisch signifikanten Aufwärtstrend, was viel mehr ist, als allein durch Zufall zu erwarten wäre. Im Gegensatz dazu beträgt der Prozentsatz der Stationen, die einen statistisch signifikanten rückläufigen Trend aufweisen, nur etwa 2,1 %, vergleichbar mit dem, was man durch Zufall erwarten würde.

● Für den Mittelmeerraum zeigen nur 4,7 % der Stationen einen statistisch signifikanten Anstiegstrend, während 3,8 % einen signifikanten Rückgangstrend aufweisen (Abb. 5).

● In Nordeuropa ist der Anteil der Stationen mit positiven Trends (14,4 %) im Vergleich zu denen mit negativen Trends (1,2 %) weltweit am höchsten (Abb. 5).

Abbildung 5

Die Ergebnisse für Nordeuropa und den Mittelmeerraum stimmen mit der aktuellen Klimaphase überein, die durch positive NAO-Werte gekennzeichnet ist, die eine Verstärkung der Westwinde bedingen, die Frontensysteme über Nordeuropa bringen [36], während der Mittelmeerraum weniger von Stürmen betroffen sein sollte.

Die von Sun et al. [32] für den Mittelmeerraum hervorgehobenen stationären Ergebnisse werden auch für das italienische Gebiet durch detailliertere Untersuchungen von Libertino et al. [37] bestätigt, bei denen die maximale Niederschlagsmenge für 1-, 3-, 6-, 12- und 24-stündige Zeiträume, die auf den Zeitraum 1928-2014 beschränkt sind und an denen mindestens 50 Stationen gleichzeitig pro Jahr aktiv sind, berücksichtigt wurden. Es wurden nur Zeitreihen mit mindestens 30 Jahren kontinuierlicher oder nicht kontinuierlicher Daten ausgewählt, was zu 1 346 Stationen führte. Die Schlussfolgerungen aus dieser Arbeit lauten: „Hinsichtlich der Häufigkeit zeigen die Ergebnisse, dass alle beobachteten Trends nicht signifikant sind, d. h. sie sind mit der Hypothese eines stationären Klimas vereinbar […]. Was die Intensität der Ereignisse betrifft, so lässt sich auf Länderebene kein klarer Trend bei den extremen Niederschlagsmengen erkennen“.

Die zitierte Arbeit für Italien, das den Autoren am besten bekannte Gebiet, ist besonders interessant, da sie tägliche oder stündliche Datensätze analysierte, die vom Hydrographic Service of the Ministry of Public Works gesammelt wurden, der die Daten einheitlich für das gesamte Staatsgebiet erfasste. Leider wurde dieser Dienst 1998 abgeschafft und seine Zuständigkeiten auf die Regionen übertragen, wodurch 20 regionale Netze mit jeweils eigenen Standards entstanden. Wir führen dieses Beispiel an, weil es uns emblematisch für die Tendenz zu einer Vervielfachung der operativen Messnetze erscheint, die zu einer immer größeren Inhomogenität führt. Dies ist genau das Gegenteil von dem, was man bräuchte, wenn man sich wirklich Sorgen um die aktuellen Klimatrends machen würde, die zu homogenen Netzen auf dem gesamten Weltgebiet führen würden, analog zu dem, was bei der Überwachung der Ozeane mit dem ARGO-Bojensystem geschehen ist.

Unsere Untersuchung zeigt, dass zwar eine Zunahme der jährlichen Gesamtniederschläge auf globaler Ebene zu beobachten ist, eine Zunahme der extremen Niederschläge jedoch nur für eine begrenzte Anzahl von Stationen und mit starken regionalen Unterschieden. Das Fehlen allgemeiner Wachstumstrends bei extremen Niederschlägen lässt sich dadurch erklären, dass die Entstehung extremer Niederschläge (1) das Vorhandensein einer relevanten Feuchtigkeitsquelle in der Grenzschicht, (2) eine Morphologie des Reliefs, Zirkulationsstrukturen auf verschiedenen Ebenen und ein vertikales thermisches Profil, die das Aufsteigen von Luftmassen mit der Entwicklung von Wolken ausreichender Dicke begünstigen (z. B. Cumulonimbus- und Nimbostratuswolken), und (3) mikrophysikalische Merkmale der Wolkenumgebung, die die Vergrößerung von Tröpfchen oder Eiskristallen zu Niederschlägen begünstigen, erfordert.

Überschwemmungen und Dürreperioden

Überschwemmungen und Dürren sind wichtige Indikatoren für die Reaktion auf Veränderungen im Niederschlagsregime.

Zu Überschwemmungen kann gesagt werden, dass, obwohl auf globaler Ebene eine Zunahme der jährlichen Gesamtniederschläge zu beobachten ist, entsprechende Beweise für eine Zunahme von Überschwemmungen schwer zu finden sind, und eine lange Liste von Studien zeigt wenig oder keine Belege für eine Zunahme von Überschwemmungen, wobei einige Studien eher eine Abnahme als eine Zunahme feststellen [38,39,40,41,42,43,44,45,46].

Sharma et al. [47] führen einige Gründe für die Abnahme der Hochwasserausmaße an und nennen als mögliche Ursachen eine Abnahme der vorherrschenden Bodenfeuchtigkeit, eine abnehmende Sturmausdehnung und eine Abnahme der Schneeschmelze.

Es mag interessant sein, sich die Ergebnisse in Erinnerung zu rufen, die im historischen Kontext für den europäischen Raum erzielt wurden, wo verschiedene paläohydrologische Studien zeigen, dass die Häufigkeit von Schwemmlandereignissen in Europa während der warmen Phasen (z.B. römisches Optimum und mittelalterliches Optimum) deutlich geringer war als während der kalten (z.B. Kleine Eiszeit), wie z.B. von Wirth et al. [48], die mit Daten aus den Zentralalpen arbeiteten, bestätigt wird. Dieser Nachweis wird auch durch den von einer großen Gruppe historischer Klimatologen, darunter die Italiener Bertolin und Camuffo [49], unterzeichneten Artikel gestützt, in dem es heißt: „Die jüngsten Veränderungen in der Variabilität der Hochwasserhäufigkeit sind nicht außergewöhnlich, wenn man sie mit der Hochwasserhäufigkeit der letzten 500 Jahre vergleicht, und sie zeigen keinen Gesamttrend, der dem weithin zitierten „Hockeystick“-Trend für die Temperaturen ähnelt. Zu einer ähnlichen Schlussfolgerung kommt das Projekt SPHERE, das für den Nordosten Spaniens gezeigt hat, dass die Abflüsse der letzten 400 Jahre deutlich höher waren als die größten gemessenen Hochwasserereignisse der Neuzeit. Die Untersuchung historischer Hochwasserereignisse ermöglicht daher eine umfassendere Risikoanalyse und die Planung eines angemessenen Hochwasserschutzes.

Die Belege für mehr Hochwasserereignisse während der Kleinen Eiszeit werden auch von Wilhelm et al. [50] bestätigt, die Hochwasser in den französischen Alpen im Mittelmeerraum während der letzten 1400 Jahre untersuchen und feststellen, dass extreme Niederschläge und Überschwemmungen in Warmzeiten seltener und weniger extrem sind als in Kaltzeiten. Genauer gesagt stellen die Autoren eine geringe Häufigkeit von Überschwemmungen während der mittelalterlichen Warmzeit und häufigere und intensivere Ereignisse während der kleinen Eiszeit fest.

[Hervorhebung vom Übersetzer]

Yiou et al. [51] analysierten die Entwicklung von Hochwasserereignissen an Elbe und Moldau in Böhmen und stellten fest, dass sowohl die Häufigkeit als auch die Intensität von Hochwasserereignissen im zwanzigsten Jahrhundert generell rückläufig sind. Das neunzehnte Jahrhundert war diesen Phänomenen weitaus stärker ausgesetzt als das zwanzigste Jahrhundert, und die aufgezeichneten Ereignisse sind im zweiten Jahrtausend unübertroffen. Zu ähnlichen Schlussfolgerungen gelangten Mudelsee et al.[52, 53] für Elba und die Oder in Deutschland.

Diodato et al. [54] rekonstruierten die hydrologischen Schadensereignisse (Damaging Hydrological Events, DHE) in Italien für den Zeitraum Oktober-April und stellten fest, dass während der mittelalterlichen Warmzeit DHE seltener auftraten, während während der kleinen Eiszeit (LIA) häufigere und intensivere Ereignisse vorherrschten. Ab Mitte des 19. Jahrhunderts, mit dem Ende der LIA, wurde ein Rückgang der DHE beobachtet, insbesondere während der letzten Jahrzehnte.

Ebenfalls für Italien rekonstruieren Taricco et al. [55] die Durchflussmengen des Po in den letzten 2200 Jahren und weisen auf sehr niedrige Durchflussmengen bis 1100, sehr hohe Durchflussmengen während der LIA mit einem Maximum um 1500 und einen anschließenden Rückgang der Durchflussmengen nach 1850 hin.

Zusammenfassend lässt sich sagen, dass zwar eine Zunahme der jährlichen Gesamtniederschläge auf globaler Ebene zu beobachten ist, dies aber nicht zu einer Zunahme der Intensität oder Häufigkeit von Überschwemmungen führt. Zu ähnlichen Schlussfolgerungen scheint auch der heute vorliegende Entwurf des AR6 zu kommen.

Dürre ist ein komplexes Phänomen, das schwer zu überwachen und zu definieren ist. Je nach den zu ihrer Charakterisierung verwendeten Variablen und den betroffenen Systemen oder Sektoren kann Dürre in verschiedene Arten eingeteilt werden, z. B. in meteorologische (Niederschlagsdefizite), landwirtschaftliche (z. B. Verringerung der Ernteerträge oder Ernteausfälle im Zusammenhang mit Feuchtigkeitsdefiziten im Boden), ökologische (im Zusammenhang mit Wasserstress bei Pflanzen, der z. B. zum Absterben von Bäumen führt) oder hydrologische Dürren (z. B. Wasserknappheit in Flüssen oder Speichern wie Stauseen, Seen, Lagunen und Grundwasser).

Der IPPC berichtet in seinem AR5 [6] auf Seite 44, dass „Schlussfolgerungen hinsichtlich einer Zunahme der globalen Trockenheitstrends seit den 1970er Jahren nicht mehr gestützt werden“, und mehrere Studien zeigen in der Tat keine Zunahme der wichtigsten Indizes für globale Trockenheit [56, 57].

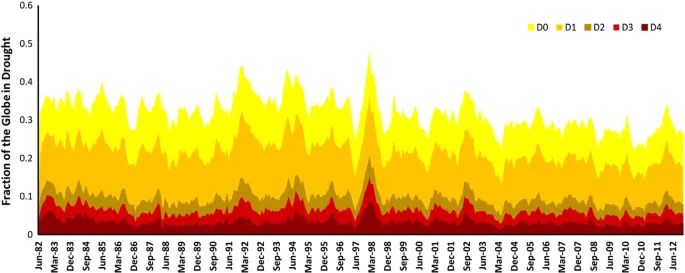

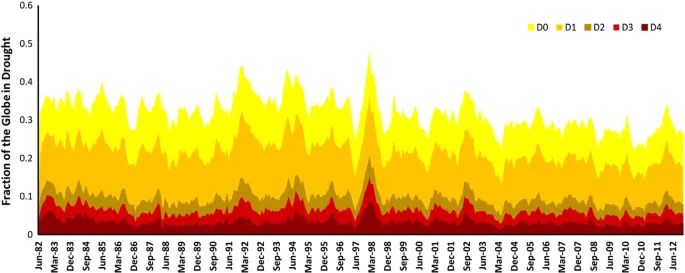

Hao et al. [58] analysierten die Zeitreihen für den Zeitraum 1982-2012 des Global Integrated Drought Monitoring and Prediction System (GIDMaPS), das drei Dürreindikatoren zur Überwachung und Vorhersage verwendet: den Standardized Precipitation Index (SPI), den Standardized Soil Moisture Index (SSI) und den Multivariate Standardized Drought Index (MSDI). SPI und SSI sind Indikatoren für meteorologische bzw. landwirtschaftliche Trockenheit. Die Autoren verweisen auf den rückläufigen Trend beim prozentualen Anteil der von Dürre betroffenen Landfläche, wie in Abb. 6 dargestellt:

Abbildung 6

Der heute vorliegende Entwurf des IPCC AR6 scheint zu ähnlichen Schlussfolgerungen in Bezug auf meteorologische und hydrologische Dürre zu kommen, während die Besorgnis über landwirtschaftliche und ökologische Dürre etwas größer ist.

Kogan et al. [59] analysierten die globalen Trends bei der landwirtschaftlichen Trockenheit mit Hilfe des satellitengestützten Verfahrens Vegetation Health (VH) für den Zeitraum 1981-2018. Ihre Ergebnisse zeigen, dass sich die Dürre für den gesamten Globus, die Hemisphären und die wichtigsten getreideproduzierenden Länder (China, USA und Indien) im Laufe von 38 Jahren nicht verschärft und ausgeweitet hat, während die globale Temperaturanomalie gestiegen ist. Die Autoren kommen zu dem Schluss, dass sich die Dürre während der jüngsten globalen Erwärmung nicht verschärft und ausgeweitet hat und die Ernährungssicherheit in den nächsten Jahren wahrscheinlich auf dem Niveau des letzten Jahrzehnts bleiben wird.

Ein für die landwirtschaftliche Trockenheit wichtiger Faktor, der in den Analysen oft vernachlässigt wird, ist die Tatsache, dass der Wasserverbrauch der Kulturen direkt proportional zur Menge des Endprodukts ist: Mais benötigt 370-910 kg Wasser für jedes produzierte Kilogramm Getreide, Weizen 590-1700 und Reis 635-1700, je nach Sorte [60]. Daraus lässt sich leicht ableiten, dass, da die weltweiten Erträge von Mais, Weizen, Reis, Sojabohnen und Gerste von 1960 bis heute im Durchschnitt um 217-297 % gestiegen sind (siehe nächster Absatz) und die Anbaufläche seit etwa 50 Jahren stabil bei 1,5 Milliarden Hektar liegt, auch der Wasserverbrauch der Kulturen in ähnlicher Weise zugenommen hat.

Was die ökologische Trockenheit betrifft, so sind zwei gegensätzliche Phänomene zu berücksichtigen, die sich auf den Wasserverbrauch der natürlichen Vegetation auswirken:

● Zunahme in mittleren und hohen Breitengraden aufgrund der Verlängerung der Vegetationsperiode infolge des globalen Temperaturanstiegs [61].

● Allgemeiner Rückgang aufgrund höherer CO2-Konzentrationen: Ein Anstieg der atmosphärischen CO2-Konzentration verringert die Anzahl der Spaltöffnungen pro Flächeneinheit der Blätter (Stomata-Index) und führt zur Schließung der Spaltöffnungen, was den Wasserverbrauch der Pflanzen verringert [62].

Zusammenfassend lässt sich sagen, dass es unserer Meinung nach keine Anzeichen dafür gibt, dass die von den verschiedenen Arten von Trockenheit betroffenen Gebiete zunehmen.

Globale Ergrünung und globale landwirtschaftliche Produktivität

Die Produktivität natürlicher Ökosysteme ist ein wichtiger Indikator für die Reaktion auf Veränderungen der meteorologischen Variablen (Temperatur, Niederschlag, globale Sonneneinstrahlung usw.). Unter diesem Gesichtspunkt kann gesagt werden, dass sich die globale Pflanzenbiomasse in den letzten Jahrzehnten erheblich verändert hat, wobei ein Phänomen zu beobachten ist, das als „Global Greening“ bezeichnet wird und auf einen erheblichen Anstieg der Produktivität von (landwirtschaftlichen und natürlichen) Ökosystemen hinweist, der in den letzten Jahrzehnten vor allem durch die Satellitenüberwachung aufgezeigt wurde [63]. In der Übersichtsarbeit von Walker et al. [64] wird festgestellt, dass dieses globale Phänomen auf den Anstieg der atmosphärischen CO2-Konzentration zurückzuführen ist, der die Photosynthese auf Blattebene und die intrinsische Wassernutzungseffizienz erhöht. Die unmittelbare Reaktion auf diese Phänomene ist die Zunahme des Pflanzenwachstums, der Biomasse der Vegetation und der organischen Bodensubstanz. Die letzte Auswirkung ist ein Transfer von Kohlenstoff aus der Atmosphäre in die Kohlenstoffsenke der terrestrischen Ökosysteme, was die Geschwindigkeit des atmosphärischen CO2-Anstiegs verlangsamen kann.

Satellitendaten zeigen „Ergrünungs-Tendenzen“ über weite Teile des Planeten [65, 66], die die Wüsten auf der ganzen Welt zurückdrängen (sowohl heiße Wüsten in tropischen Breiten als auch kalte Wüsten in nördlicheren Breitengraden). Die Relevanz der Begrünung wird von Campbell [67] bestätigt, der unter Verwendung von Carbonylsulfid-Aufzeichnungen als Stellvertreter für die photosynthetische Aktivität einen Anstieg der Bruttoprimärproduktion um 31 % während des zwanzigsten Jahrhunderts feststellte. Darüber hinaus analysierten Wang et al. [68] die globale Ökosystem-Produktivität für den Zeitraum 1982-2016 und zeigten, dass die wichtigsten positiven Anomalien zeitgleich mit reichlichen Niederschlägen auftraten, was die Bedeutung der Wasserbegrenzung für die Ökosystem-Produktivität belegt.

Es sei auch darauf hingewiesen, dass Zeng et al. [69] anhand eines Modells des terrestrischen Kohlenstoffkreislaufs gezeigt haben, dass die Landwirtschaft für etwa 50 % der erhöhten CO2-Absorption verantwortlich ist, was ihre wesentliche Rolle für das Ökosystem zeigt. Tatsächlich emittiert die Landwirtschaft nur einen kleinen Teil dessen, was sie zuvor durch Photosynthese aufgenommen hat. Die Landwirtschaft nimmt jedes Jahr 7,5 GT Kohlenstoff auf, die sich auf 12 GT erhöhen, wenn man auch die Weiden berücksichtigt [70], während sich die Gesamtemissionen des Agrarsektors auf 1,69 ± 0,38 GT belaufen [71]. Folglich emittiert die Landwirtschaft 14,1 ± 0,03 % dessen, was zuvor absorbiert wurde.

Die globale Relevanz der globalen Begrünung wurde durch die von einer australischen Forschergruppe [72] mit dem Modell CABLE (Community Atmosphere Biosphere Land Exchange) durchgeführte Simulation aufgezeigt, die den globalen Trend der Bruttoprimärproduktivität (GPP) von 1900 bis 2020 als Ergebnis (a) der physiologischen Wirkung der direkt durch Kohlendioxid stimulierten Veränderungen des Blattwerks, (b) der mit der allgemeinen Zunahme der Blattmasse verbundenen Wirkung und (c) der Wirkung des Klimawandels veranschaulicht. Insgesamt wird der Anstieg der GPP von 1900 bis 2020 auf 30 % geschätzt, während er bei einer Verdoppelung des CO2 (560 ppmv) schätzungsweise 47 % erreichen wird.

Auch wenn der vorherrschende Gedanke ist, dass wir es mit einem positiven Phänomen zu tun haben, das die große Fähigkeit der Ökosysteme zeigt, sich an die Schwankungen natürlicher und anthropogener Einflüsse anzupassen, dürfen wir nicht übersehen, dass die Reaktionen der Ökosysteme auf CO2 komplex sind oder durch gleichzeitige Veränderungen bei mehreren Faktoren des globalen Wandels beeinträchtigt werden, und die Beweise für eine CO2-bedingte terrestrische Kohlenstoffsenke können manchmal widersprüchlich erscheinen [64]. So wird beispielsweise die sommerliche Bodentrockenheit durch eine frühere Begrünung der Vegetation im Frühjahr verschärft, die die Evapotranspiration erhöht und damit die Bodenfeuchtigkeit im Frühjahr verringert [61].

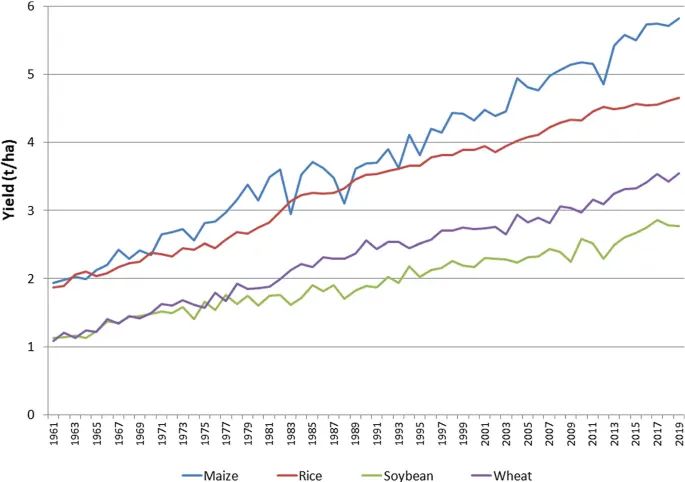

In jedem Fall ist die globale Begrünung eine kulturelle Herausforderung, die uns dazu veranlasst, über die positiven Auswirkungen des Anstiegs des CO2-Gehalts in der Atmosphäre nachzudenken. Nach den Daten von Campbell et al. [67] und Haverd et al. [72] würden wir ohne die CO2-bedingte Ökologisierung einen erheblichen Rückgang der landwirtschaftlichen Produktion mit erheblichen negativen Auswirkungen auf die weltweite Ernährungssicherheit haben. Mariani [73] schätzt, dass die landwirtschaftliche Produktion von Mais, Reis, Weizen und Sojabohnen um 18 % zurückgehen würde, wenn der CO2-Gehalt wieder auf das vorindustrielle Niveau ansteigen würde. Dieses Ergebnis wurde jedoch mit einem Modell erzielt, das die negativen Auswirkungen von Extremereignissen wie Dürren, übermäßigen Regenfällen, Frost und Hitzewellen auf die Ernteerträge nicht berücksichtigt.

Auf der Grundlage des Wiederauftretens von Extremereignissen, Veränderungen im Niederschlagsregime, steigenden Temperaturen und den Auswirkungen von Schadstoffen wie Ozon kommt die Zusammenfassung des AR5 in Kapitel 7 [6] zu dem Schluss, dass „die Auswirkungen des Klimawandels auf die pflanzliche und terrestrische Nahrungsmittelproduktion in mehreren Regionen der Welt offensichtlich sind (hohes Vertrauen). Negative Auswirkungen von Klimatrends waren häufiger als positive“.

Diese Aussage berücksichtigt jedoch die folgenden 2 Faktoren nicht angemessen:

1. Die Anpassungsfähigkeit des globalen Agrarsystems in Verbindung mit seiner extremen Flexibilität, die sich in der Fähigkeit niederschlägt, Innovationen im Bereich der Genetik (neue, besser an die Umwelt angepasste Sorten) und der Anbautechniken (Bewässerung, Düngung, Unkrautbekämpfung, Umgang mit Schädlingen und Krankheiten usw.) rasch zu übernehmen. Diese technologischen Innovationen sind das Ergebnis der großen Fortschritte in der Pflanzenbauwissenschaft, die seit Beginn des 19. Jahrhunderts gemacht wurden und deren Verbreitung nach dem Ende des Zweiten Weltkriegs stark zugenommen hat [74].

2. Den Kompensationseffekt, der damit zusammenhängt, dass die Landwirtschaft auf einem sehr großen Gebiet (alle Kontinente außer der Antarktis) stattfindet, das zwei Hemisphären umfasst und somit zwei Ernten pro Jahr garantiert. Jahrhundert von Adam Smith [75] und Giovanni Targioni Tozzetti [76] hervorgehoben wurde, dass in einem bestimmten Jahr die in einem Gebiet aufgrund von Extremereignissen (Dürre, übermäßiger Regen, Hitzewellen usw.) verzeichneten Ertragseinbußen durch die in anderen Gebieten auftretenden Ertragssteigerungen ausgeglichen werden.

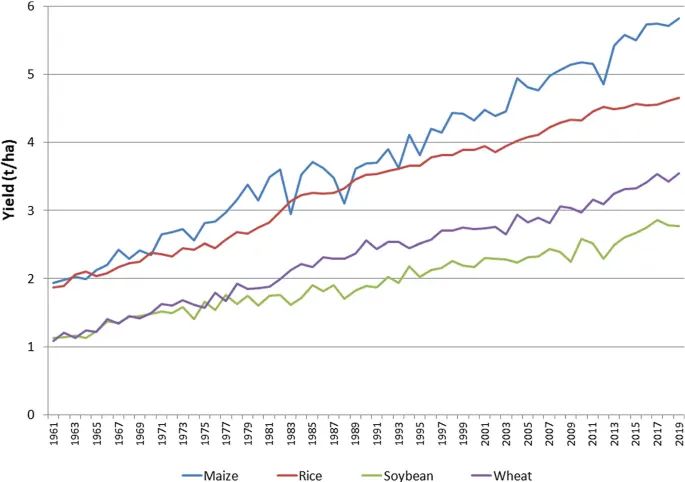

Der erste Punkt wird heute durch unsere technologischen Möglichkeiten erheblich verstärkt, während der zweite Punkt ständig in Kraft ist, wie die Steigerungen der weltweiten landwirtschaftlichen Produktion seit 1870 (Federico [77]) und der weltweiten Erträge seit 1961 (FAO-Zeitreihe) zeigen. Abb. 7 zeigt den Anstieg der Hektarerträge von 1960 bis heute für vier Kulturen (Mais, Reis, Sojabohnen und Weizen), die für 64 % der Kalorienzufuhr der Menschheit verantwortlich sind [78].

Abbildung 7

Wir haben die Zeitreihen der globalen Durchschnittserträge (t/ha) von Mais, Reis, Sojabohnen und Weizen für den Zeitraum 1961-2019 analysiert [79] und einen sehr robusten positiven linearen Trend von 3,3 %, 2,4 %, 2,6 % bzw. 3,8 % pro Jahr für die vier oben genannten Kulturpflanzen festgestellt. Unserer Ansicht nach sind die Hauptfaktoren für diesen Trend der technologische Fortschritt und die CO2-Düngung. Dieser lineare Trend wurde von den Daten subtrahiert, um die Residuen zu erhalten, die Ausdruck von Phänomenen wie extremen meteorologischen oder meteorologisch bedingten Ereignissen (Hitzewellen, Kälteausbrüche, Dürren, Überschwemmungen usw.) sind. Die Analyse der Residuen (ergänzendes Material – Abb. S1) zeigt, dass die Abweichungen vom linearen Trend in den letzten Jahren nicht zugenommen haben, was eine Zunahme der Auswirkungen von Extremereignissen ausschließen würde.

„Im Allgemeinen begünstigt ein Anstieg des Temperaturniveaus das Wachstum und die Verbreitung von Schädlingsarten, indem es für ein warmes und feuchtes Umfeld sorgt und die für ihr Wachstum notwendige Feuchtigkeit bereitstellt“, sagt Tek Sapkota, Wissenschaftler für Agrarsysteme und Klimawandel am International Maize and Wheat Improvement Center (CIMMYT).

Wenn jedoch die Temperaturen und Niederschlagsmengen zu sehr steigen, kann dies das Wachstum und die Vermehrung einiger Schädlingsarten verlangsamen und sie vernichten, indem ihre Eier und Larven von der Wirtspflanze abgewaschen werden“, erklärt er.

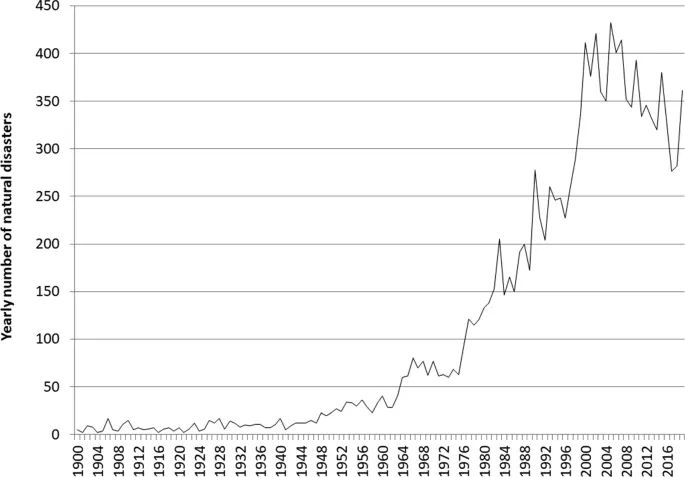

CRED-Daten

Schließlich schlagen wir einen anderen Blickwinkel vor, indem wir die historischen Reihen von Naturkatastrophen berücksichtigen, die im EM-DAT-Datensatz des CRED (Center for Research on the Epidemiology of Disasters) der Katholischen Universität Löwen in Belgien erfasst sind.

Um in diesem Datensatz erfasst zu werden, muss ein Ereignis eines oder mehrere der folgenden Merkmale aufweisen:

● 100 oder mehr Menschen waren von dem Ereignis betroffen

● 10 oder mehr Menschen starben infolge des Ereignisses

● Ausrufung des Ausnahmezustands

● Ersuchen um internationale Hilfe

Natürlich spielen neben der Intensität des Ereignisses auch andere Faktoren eine Rolle, wie z. B. die Fähigkeit, dem Ereignis selbst vorzubeugen oder sich vor ihm zu schützen; dennoch kann ein Blick auf diese Statistik nützliche Informationen über die Entwicklung von Extremereignissen liefern.

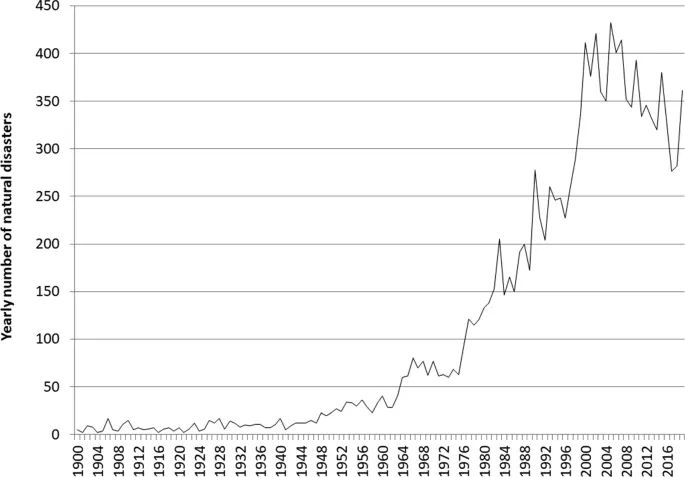

Betrachtet man die in Abb. 8 dargestellten Naturkatastrophen seit 1900, so ist seit Mitte des letzten Jahrhunderts eine sehr geringe Zahl zu beobachten, als ein plötzlicher Anstieg einsetzte, der gegen Ende des zwanzigsten Jahrhunderts zum Stillstand kam, um einem Trend zu weichen, der durch einen leichten Rückgang gekennzeichnet ist. Diese Entwicklung ist sehr merkwürdig: Ist es möglich, dass Naturkatastrophen im Wesentlichen in der Mitte des 20. Jahrhunderts auftraten und dass sie bis zum Ende des Jahrhunderts so stark zunahmen? Es sei auch darauf hingewiesen, dass diese Entwicklung auf den ersten Blick mit dem Anstieg der globalen Temperatur des Planeten „konsistent“ ist.

Abbildung 8

In mehreren Berichten warnte CRED jedoch vor einer ausschließlich klimatologischen Interpretation der bis zum Ende des 20. Jahrhunderts beobachteten Zunahme von Ereignissen: 2004 schrieb CRED [80], ihre Zeitreihe (Abb. 8 mit Daten bis 2003) „könnte zu der Annahme verleiten, dass Katastrophen heute häufiger auftreten als zu Beginn des Jahrhunderts. Eine solche Schlussfolgerung allein auf der Grundlage dieser Grafik zu ziehen, wäre jedoch falsch. Die Abbildung zeigt vielmehr die Entwicklung der Registrierung von Naturkatastrophen im Laufe der Zeit“.

Wiederum im Jahr 2007 [81] „Es wäre in der Tat irreführend, den Aufwärtstrend bei der Häufigkeit und den Auswirkungen von hydrometeorologischen Katastrophen im Wesentlichen mit dem Klimawandel zu begründen. … einer der Hauptgründe für die Zunahme von Katastrophen in den letzten Jahrzehnten ist die ständig zunehmende Verbreitung und Genauigkeit von Informationen über Katastrophen“.

Und dieser Hinweis hat sich über die Jahre gehalten [82] „Aus Sicht der Katastrophenanalyse sind das Bevölkerungswachstum und die Muster der wirtschaftlichen Entwicklung bei der Erklärung dieses Aufwärtstrends wichtiger als der Klimawandel oder zyklische Schwankungen des Wetters. Heute sind nicht nur mehr Menschen in Gefahr als noch vor 50 Jahren, sondern durch die Bebauung von Überschwemmungsgebieten, Erdbebenzonen und anderen Hochrisikogebieten hat sich die Wahrscheinlichkeit erhöht, dass eine alltägliche Naturgefahr zu einer großen Katastrophe wird“.

Für diese Interpretation spricht auch die in Abb. 9 dargestellte Zunahme der Erdbeben, die nichts mit der globalen Erwärmung zu tun haben dürfte und die einen ähnlichen zeitlichen Verlauf wie alle anderen Naturkatastrophen aufweist.

Abbildung 9

Unserer Meinung nach bestätigt dies, dass der Hauptgrund für den Anstieg in der zweiten Hälfte des 20. Jahrhunderts die wachsende Meldekapazität der einzelnen Staaten ist und dass sich die Zahl der Katastrophen seit der Stabilisierung dieser Kapazität auf einem zuverlässigen Niveau eingependelt hat oder sogar zurückgegangen ist. Das gleiche Phänomen wurde bereits bei Hurrikanen und Tornados beobachtet. Darüber hinaus hat sich die Berichterstattung verbessert, weil die Katastrophenschutzsysteme in vielen Teilen der Welt ein höheres organisatorisches Niveau erreicht haben; gleichzeitig hat sich der Grad der Vernetzung mit internationalen Organisationen verbessert, was als positives Element hervorzuheben ist.

Schlussfolgerungen

Seit dem Zweiten Weltkrieg haben unsere Gesellschaften enorme Fortschritte gemacht und ein Wohlstandsniveau erreicht (Gesundheit, Ernährung, Gesundheit der Lebens- und Arbeitsorte usw.), das sich frühere Generationen nicht einmal im Entferntesten vorstellen konnten. Heute sind wir aufgerufen, den Weg des Fortschritts fortzusetzen und dabei die Zwänge der wirtschaftlichen, sozialen und ökologischen Nachhaltigkeit zu respektieren, und zwar mit der Strenge, die durch die Tatsache diktiert wird, dass der Planet im Jahr 2050 10 Milliarden Einwohner haben wird, die zunehmend verstädtert sind.

Seit ihren Anfängen ist die menschliche Spezies mit den negativen Auswirkungen des Klimas konfrontiert; die historische Klimatologie hat wiederholt den Begriff der Klimaverschlechterung verwendet, um die negativen Auswirkungen von Extremereignissen (vor allem Trockenheit, Diluvialphasen und Kälteperioden) auf die Zivilisation zu erklären. Heute stehen wir vor einer Warmzeit [?], und zum ersten Mal verfügen wir über Überwachungsmöglichkeiten, die es uns ermöglichen, ihre Auswirkungen objektiv zu bewerten.

Die Befürchtung eines Klimanotstands, ohne dass dies durch Daten untermauert wird, bedeutet eine Änderung der Prioritäten mit negativen Auswirkungen, die sich als nachteilig für unsere Fähigkeit erweisen könnten, die Herausforderungen der Zukunft zu bewältigen, und die Verschwendung natürlicher und menschlicher Ressourcen in einem wirtschaftlich schwierigen Kontext, der nach dem COVID-Notstand noch negativer ist. Das bedeutet nicht, dass wir nichts gegen den Klimawandel unternehmen sollten: Wir sollten daran arbeiten, unsere Auswirkungen auf den Planeten zu minimieren und die Luft- und Wasserverschmutzung zu verringern. Unabhängig davon, ob es uns gelingt, unsere Kohlendioxidemissionen in den kommenden Jahrzehnten drastisch zu reduzieren, müssen wir unsere Anfälligkeit für extreme Wetter- und Klimaereignisse verringern.

Wenn wir unseren Kindern den Staffelstab überlassen, ohne sie mit der Angst zu belasten, sich in einem Klimanotstand zu befinden, könnten sie die verschiedenen Probleme (Energie, Landwirtschaft, Ernährung, Gesundheit usw.) mit einem objektiveren und konstruktiveren Geist angehen, um zu einer ausgewogenen Bewertung der zu ergreifenden Maßnahmen zu gelangen, ohne die begrenzten Ressourcen, die uns zur Verfügung stehen, für kostspielige und unwirksame Lösungen zu verschwenden. Wie sich das Klima im einundzwanzigsten Jahrhundert entwickeln wird, ist ein Thema mit großer Unsicherheit. Wir müssen unsere Widerstandsfähigkeit gegenüber dem zukünftigen Klima erhöhen.

Wir müssen uns daran erinnern, dass die Bewältigung des Klimawandels kein Selbstzweck ist und dass der Klimawandel nicht das einzige Problem ist, mit dem die Welt konfrontiert ist. Das Ziel sollte sein, das menschliche Wohlergehen im 21. Jahrhundert zu verbessern und gleichzeitig die Umwelt so weit wie möglich zu schützen, und es wäre unsinnig, dies nicht zu tun: Es wäre, als würden wir uns nicht um das Haus kümmern, in dem wir geboren und aufgewachsen sind.

Übersetzt von Christian Freuer für das EIKE

Es folgen eine lange Liste mit Literaturhinweisen und Anmerkungen zu diesem Beitrag:

Data availability

The data that support the findings of this study are publicly available following the links that have been specified in the article.

References

- https://www.ipcc.ch/site/assets/uploads/2018/02/WGIIAR5-AnnexII_FINAL.pdf

- M. Brunetti, F. Prodi. (2015). https://doi.org/10.1051/epjconf/20159802001

- F. Prodi, Esiste un’emergenza climatica? (2020). https://agenda.infn.it/event/23656/contributions/120556/attachments/75192/96202/Video_SIF_2020.mp4?fbclid=IwAR28LcDwQDdhh-86_quIDgYLxOSGb3HMaRge8m_Y1xRRcQCwIf5Mxe3n7XU

- R.J.H. Azorin-Molina, L. Dunn, C. Ricciardulli, A. Mears, T.R. McVicar, J.P. Nicolas, G.P. Compo, C.A. Smith. (2020). https://doi.org/10.1175/2020BAMSStateoftheClimate.1

- Z. Zeng et al. (2019). https://doi.org/10.1038/s41558-019-0622-6

- Climate Change 2013: The Physical Science Basis. Contribution of Working Group I to the Fifth Assessment Report of the Intergovernmental Panel on Climate Change Cambridge University Press, Cambridge, United Kingdom and New York, NY, USA. https://www.ipcc.ch/report/ar5/wg1/

- S.E. Perkins-Kirkpatrick, S.C. Lewis. (2020). https://doi.org/10.1038/s41467-020-16970-7

- Managing the Risks of Extreme Events and Disasters to Advance Climate Change Adaptation. A Special Report of Working Groups I and II of the Intergovernmental Panel on Climate Change Cambridge University Press, Cambridge, UK, and New York, NY, USA. https://www.ipcc.ch/report/managing-the-risks-of-extreme-events-and-disasters-to-advance-climate-change-adaptation/

- G. Formetta, L. Feyen. (2019). https://doi.org/10.1016/j.gloenvcha.2019.05.004

- WMO: Tropical cyclones. https://public.wmo.int/en/our-mandate/focus-areas/natural-hazards-and-disaster-risk-reduction/tropical-cyclones

- R.E. Todd, T.G. Asher, J. Heiderich, J.M. Bane, R.A. Luettich. (2018).https://doi.org/10.1029/2018GL079180

- S. Mohleji, R. Pielke Jr. (2014). https://doi.org/10.1061/(ASCE)NH.1527-6996.0000141

- C. Loehle, E. Staehling. (2020).https://doi.org/10.1007/s11069-020-04219-x

- B. Xiang, X. Dong, Yonghua. (2020). https://doi.org/10.1080/16742834.2020.1752110

- H. Diamond, J., C.J. Schreck. (2020). https://doi.org/10.1175/BAMS-D-21-0080.1Article Google Scholar

- R. Maue. (2011). https://doi.org/10.1029/2011GL047711

- NOAA: Global Warming and Hurricanes. https://www.gfdl.noaa.gov/global-warming-and-hurricanes/

- C.W.Landsea et al. (2010). https://doi.org/10.1175/2009JCLI3034.1

- NOAA: The Tornado FAQ. https://www.spc.noaa.gov/faq/tornado/

- E. Jon, Violent storms, TAB books, pp. 227. (1988)

- WMO: Tornado intensity. https://cloudatlas.wmo.int/en/tornado-intensity.html

- J. Wurman, K. Kosiba, T. White, P. Robinson. (2021). https://doi.org/10.1073/pnas.2021535118

- NOAA: Tornado Historical Records and Trends. https://www.ncdc.noaa.gov/climate-information/extreme-events/us-tornado-climatology/trends

- H. Masoomi, J.W. van de Lindt. (2018). https://doi.org/10.1061/(ASCE)NH.1527-6996.0000295

- C.M. Thomas, B. Dong, K. Haines. (2020). https://doi.org/10.1175/JCLI-D-19-0343.1Article Google Scholar

- J.P. Peixoto, A.H. Oort, Physics of climate (American Institute of Physics, New York, 1992), pp. 270–307 Google Scholar

- A.A. Lacis, G.A. Schmidt, R. Ruedy. (2010). https://doi.org/10.1126/science.1190653

- Ø. Hodnebrog et al. (2019). https://doi.org/10.5194/acp-19-12887-2019

- R.J.H. Dunn, L.V. Alexander, M.G. Donat, X. Zhang, M. Bador, N. Herold, et al. (2020). https://doi.org/10.1029/2019JD032263

- L. Agel, M. Barlow, J. Qian, F. Colby, E. Douglas, Eichler T. (2015). https://doi.org/10.1175/JHM-D-14-0147.1Article Google Scholar

- R. Barbero, H.J. Fowler, G. Lenderink, S. Blenkinsop. (2017). https://doi.org/10.1002/2016GL071917Article Google Scholar

- Q. Sun, X. Zhang, F. Zwiers, S. Westra, L.V. Alexander. (2021). https://doi.org/10.1175/JCLI-D-19-0892.1

- J.R. Metcalfe, B. Routledge, K. Devine. (1997). https://doi.org/10.1175/1520-0442(1997)010%3C0092:RMICCO%3E2.0.CO;2Article Google Scholar

- S.M. Papalexiou, A. Montanari. (2019). https://doi.org/10.1029/2018WR024067Article Google Scholar

- S. Westra et al. (2013). https://doi.org/10.1175/JCLI-D-12-00502.1

- J.I. López-Moreno, S.M. Vicente-Serrano. (2008). https://doi.org/10.1175/2007JCLI1739.1

- A. Libertino, D. Ganora, P. Claps (2019). https://doi.org/10.1029/2019GL083371Article Google Scholar

- S.A. Archfield, R.M. Hirsch, A. Viglione, G. Blöschl. (2016). https://doi.org/10.1002/2016GL070590Article Google Scholar

- G. Blöschl et al. (2017). https://doi.org/10.1126/science.aan2506

- H.X. Do, S. Westra, M. Leonard. (2017). https://doi.org/10.1016/j.jhydrol.2017.06.015Article Google Scholar

- P.Y. Groisman, R.W. Knight, T.R. Karl. (2001). https://doi.org/10.1175/1520-0477(2001)082%3C0219:HPAHSI%3E2.3.CO;2

- J. Hall et al. (2014). https://doi.org/10.5194/hess-18-2735-2014

- G.A. Hodgkins et al. (2017). https://doi.org/10.1016/j.jhydrol.2017.07.027

- H.F. Lins, J.R. Slack. (1999). https://doi.org/10.1029/1998GL900291

- G.J. McCabe, D.M. Wolock. (2002). https://doi.org/10.1029/2002GL015999

- X.S. Zhang et al. (2016). https://doi.org/10.5194/hess-20-3947-2016

- A. Sharma, C. Wasko, D.P. Lettenmaier. (2018). https://doi.org/10.1029/2018WR023749

- S.B. Wirth et al. (2013). https://doi.org/10.1016/j.quascirev.2013.09.002

- R. Glaser, D. Riemann, J. Schönbein, et al. (2010). https://doi.org/10.1007/s10584-010-9816-7

- B. Wilhelm et al. (2012). https://doi.org/10.1016/j.yqres.2012.03.003

- P. Yiou et al. (2006). https://doi.org/10.1623/hysj.51.5.930

- M. Mudelsee, M. Börngen, G. Tetzlaff et al. (2003). https://doi.org/10.1038/nature01928

- M. Mudelsee, M. Börngen, G. Tetzlaff, U. Grünewald. (2004). https://doi.org/10.1029/2004JD005034Article Google Scholar

- N. Diodato, F.C. Ljungqvist, G. Bellocchi. (2019). https://www.nature.com/articles/s41598-019-46207-7

- C. Taricco, S. Alessio, S. Rubinetti et al. (2015). https://doi.org/10.1038/srep12111

- G. Van Der Schrier, J. Barichivich, K.R. Briffa, P. Jones. (2013). https://doi.org/10.1002/jgrd.50355Article Google Scholar

- J. Sheffield, E. Wood, M. Roderick. (2012). https://doi.org/10.1038/nature11575Article Google Scholar

- Z. Hao, A. AghaKouchak, N. Nakhjiri et al. (2014). https://doi.org/10.1038/sdata.2014.1

- F. Kogan, W. Guo, W. Yang. (2020). https://doi.org/10.1080/19475705.2020.1730452Article Google Scholar

- S.J. Zwart, W.G.M. Bastiaanssen. (2004). https://doi.org/10.1016/j.agwat.2004.04.007

- X. Lian, S. Piao, L.Z.X. Li. (2020). https://doi.org/10.1126/sciadv.aax0255

- E. Driesen, W. van den Ende, M. De Proft, W. Saeys. (2020). https://doi.org/10.3390/agronomy10121975Article Google Scholar

- S. Piao, X. Wang, T. Park, et al. (2020). https://doi.org/10.1038/s43017-019-0001-x

- A.P. Walker et al. (2020). https://doi.org/10.1111/nph.16866

- Z. Zhu, S. Piao, R. Myneni et al. (2016). https://doi.org/10.1038/nclimate3004

- J. Mao, A. Ribes, B. Yan et al. (2016). https://doi.org/10.1038/nclimate3056

- J. Campbell, J. Berry, U. Seibt et al. https://doi.org/10.1038/nature22030

- M. Wang, S. Wang, J. Zhao, W. Ju, Z. Hao. (2021). https://doi.org/10.1016/j.scitotenv.2021.145703Article Google Scholar

- N. Zeng, F. Zhao, G. Collatz et al. (2014). https://doi.org/10.1038/nature13893

- F. Krausmann. (2013). https://doi.org/10.1073/pnas.1211349110

- Climate Change and Land: an IPCC special report on climate change, desertification, land degradation, sustainable land management, food security, and greenhouse gas fluxes in terrestrial ecosystems P.R. Shukla, J. Skea, E. Calvo Buendia, V. Masson-Delmotte, H.-O. Pörtner, D. C. Roberts, P. Zhai, R. Slade, S. Connors, R. van Diemen, M. Ferrat, E. Haughey, S. Luz, S. Neogi, M. Pathak, J. Petzold, J. Portugal Pereira, P. Vyas, E. Huntley, K. Kissick, M. Belkacemi, J. Malley, (eds.) In press. https://www.ipcc.ch/srccl/

- Haverd et al. (2020). https://doi.org/10.1111/gcb.14950

- L. Mariani. (2017). https://doi.org/10.1140/epjp/i2017-11337-8

- L. Mariani, A. Ferrero, G. Cola. (2021). https://doi.org/10.1002/agj2.20710Article Google Scholar

- A. Smith, An Inquiry into the Nature and Causes of the Wealth of Nations, (Glasgow edition of works, Vol. 2, 1776)

- G. Targioni Tozzetti, Cronica meteorologica della Toscana per il tratto degli ultimi sei secoli relativa principalmente all’agricoltura (Alimurgia, 1767 ), pt. III

- G. Federico, Feeding the World: An Economic History of Agriculture, 1800–2000. (Princeton and Oxford: Princeton University Press. Cloth) pp 416

- D. Tilman, C. Balzer, J. Hill, B.L. Befort. (2011). https://doi.org/10.1073/pnas.1116437108

- Data from Faostat. http://www.fao.org/faostat/en/

- D. Guha-Sapir et al., Thirty years of natural disasters 1974–2003: The numbers (Presses Universitaires de Louvain: Louvain-La-Neuve, 2004) https://www.emdat.be/thirty-years-natural-disasters-1974-2003-numbers

- J-M. Scheuren et al., Annual Disaster Statistical Review: Numbers and Trends. (2007). https://www.cred.be/node/316

- The human cost of natural disasters: a global perspective. (CRED, 2015) http://www.cred.be/sites/default/files/The_Human_Cost_of_Natural_Disasters_CRED.pdf

Download references

Funding

No funding was received to assist with the preparation of this manuscript.

Author information

Authors and Affiliations

- INFN & Università degli Studi, Milano, ItalyGianluca Alimonti

- Università degli Studi, Milano – DISAA, Milano, ItalyLuigi Mariani

- Accademia Nazionale delle Scienze, Verona, ItalyFranco Prodi

- Laboratori Nazionali di Legnaro, INFN, Università di Padova, Padua, ItalyRenato Angelo Ricci

Corresponding author

Correspondence to Gianluca Alimonti.

Ethics declarations

Conflict of interest

The authors have no conflicts of interest to declare that are relevant to the content of this article.

Supplementary Information

Below is the link to the electronic supplementary material.

Rights and permissions

Open Access This article is licensed under a Creative Commons Attribution 4.0 International License, which permits use, sharing, adaptation, distribution and reproduction in any medium or format, as long as you give appropriate credit to the original author(s) and the source, provide a link to the Creative Commons licence, and indicate if changes were made. The images or other third party material in this article are included in the article’s Creative Commons licence, unless indicated otherwise in a credit line to the material. If material is not included in the article’s Creative Commons licence and your intended use is not permitted by statutory regulation or exceeds the permitted use, you will need to obtain permission directly from the copyright holder. To view a copy of this licence, visit http://creativecommons.org/licenses/by/4.0/.

Reprints and Permissions

About this article

Cite this article

Alimonti, G., Mariani, L., Prodi, F. et al. A critical assessment of extreme events trends in times of global warming. Eur. Phys. J. Plus 137, 112 (2022). https://doi.org/10.1140/epjp/s13360-021-02243-9

Download citation

- Received28 September 2021

- Accepted29 November 2021

- Published13 January 2022

- DOIhttps://doi.org/10.1140/epjp/s13360-021-02243-9

Share this article

Anyone you share the following link with will be able to read this content: Get shareable link

The European Physical Journal Plus volume 137, Article number: 112 (2022) Cite this article

Link: https://wattsupwiththat.com/2022/09/22/a-critical-assessment-of-extreme-events-trends-in-times-of-global-warming/