Andy May

Ich finde es erstaunlich, dass einige Artikel immer noch behaupten:

„Die Lufttemperaturen in der [Arktis oder weltweit] sind derzeit so hoch wie nie zuvor in den letzten 6.800 bis 7.800 Jahren, und die jüngste Geschwindigkeit des Temperaturanstiegs ist im gesamten Holozän beispiellos.“ (Lecavalier et al., 2017)

Es ist zwar theoretisch möglich, dass die aktuelle durchschnittliche Temperatur in der Arktis oder weltweit höher ist als in den letzten 6.800 Jahren, aber es ist sehr unwahrscheinlich und lässt sich mit den uns heute vorliegenden Daten nicht belegen. Es ist fast sicher, dass die in letzter Zeit beobachtete Geschwindigkeit des Temperaturanstiegs weltweit oder in der Arktis im Holozän nicht beispiellos ist. Dieser moderne Mythos wurde in der Literatur gründlich widerlegt, und es ist beunruhigend, dass er in PNAS und anderswo wieder auftaucht. Ich dachte, Begutachtungen (Peer Review) sollten solche Fehler aufdecken.

So hoch wie nie zuvor in den letzten 6.800 bis 7.800 Jahren

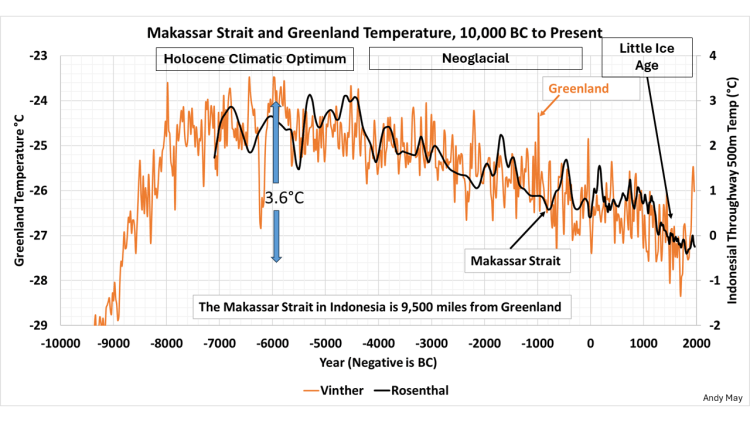

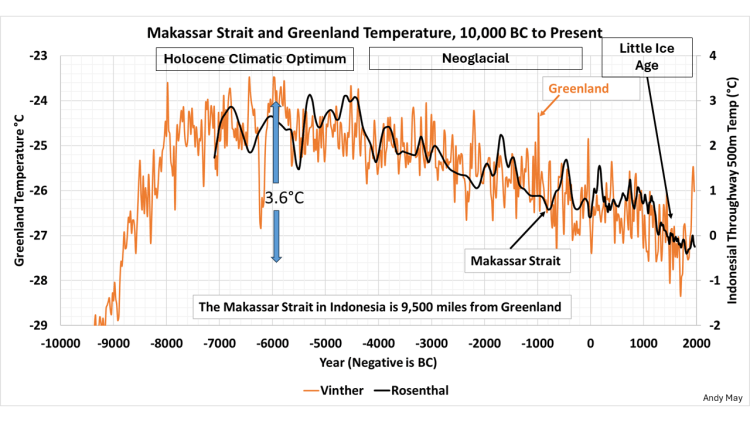

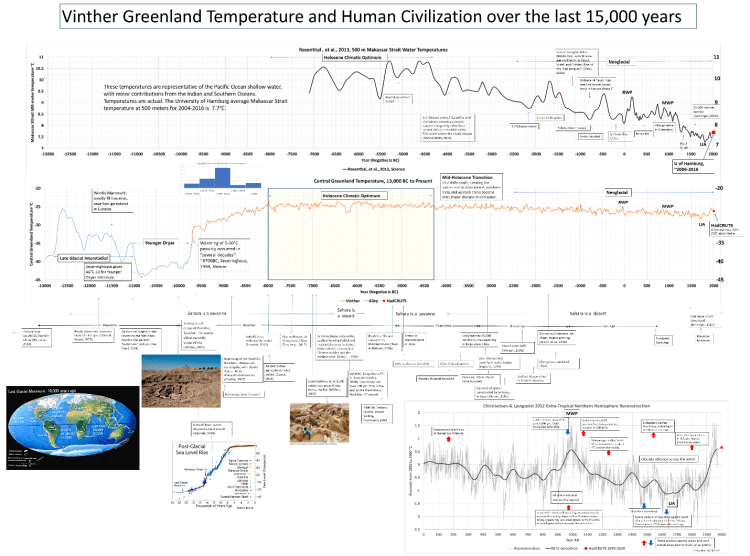

Die erste Behauptung im Beitrag von Lecavalier et al. lautet, dass die Arktis heute wärmer ist als jemals zuvor in den letzten 6.800 bis 7.800 Jahren. Als wärmste Zeit des Holozäns (vor 12.000 Jahren bis heute) wird allgemein das Holozän-Klimoptimum oder das Holozän-Thermalmaximum angesehen, wobei beide Bezeichnungen verwendet werden. Zwei meiner bevorzugten Temperaturproxies für das Holozän der nördlichen Hemisphäre deuten darauf hin, dass es heute nur wärmer ist als in den letzten 1.000 bis 2.000 Jahren, wie in Abbildung 1 dargestellt:

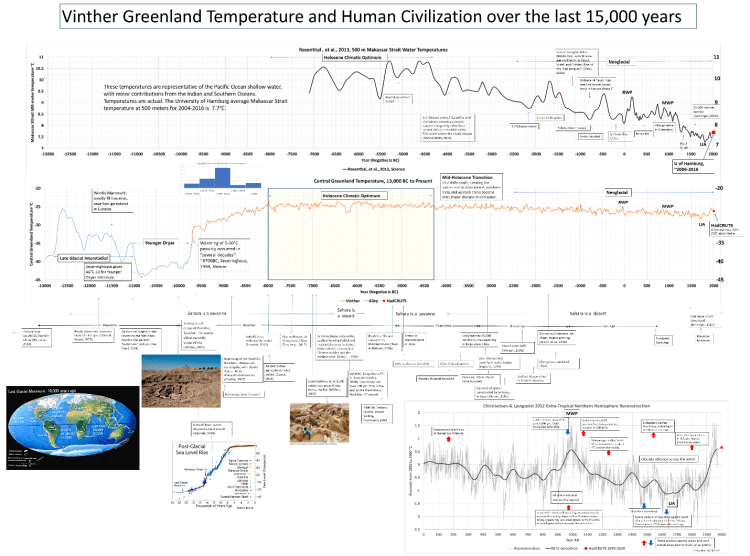

Abbildung 1. Die Temperaturproxies des Vinther-Eiskerns aus Grönland (orange) und der Rosenthal-Proxies aus der Straße von Makassar (schwarz). Quellen: (Vinther et al., 2009) & (Rosenthal et al., 2013).

Die Skalen links und rechts in der Graphik habe ich nicht verstanden, leider gibt May dazu auch keine Erklärung. Vermutlich sind rechts Abweichungen von irgendeinem Mittelwert aufgetragen. Die Information aus der Graphik sind aber eindeutig: Sowohl in Grönland als auch in den Tropen war es lange zuvor viel wärmer als heute. A. d. Übers.

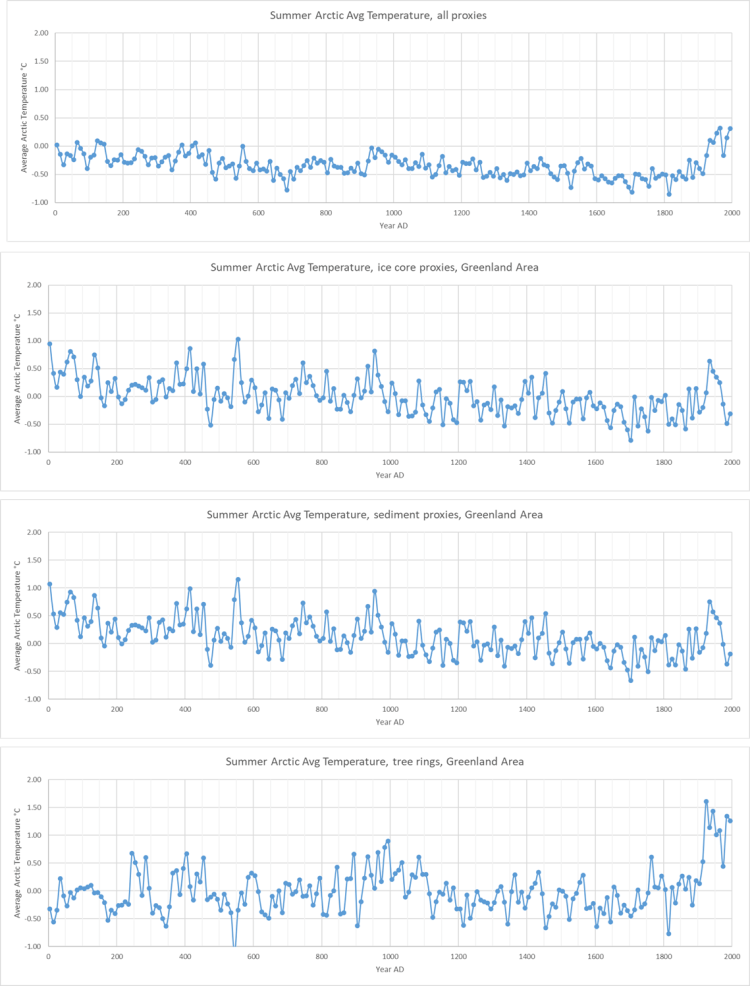

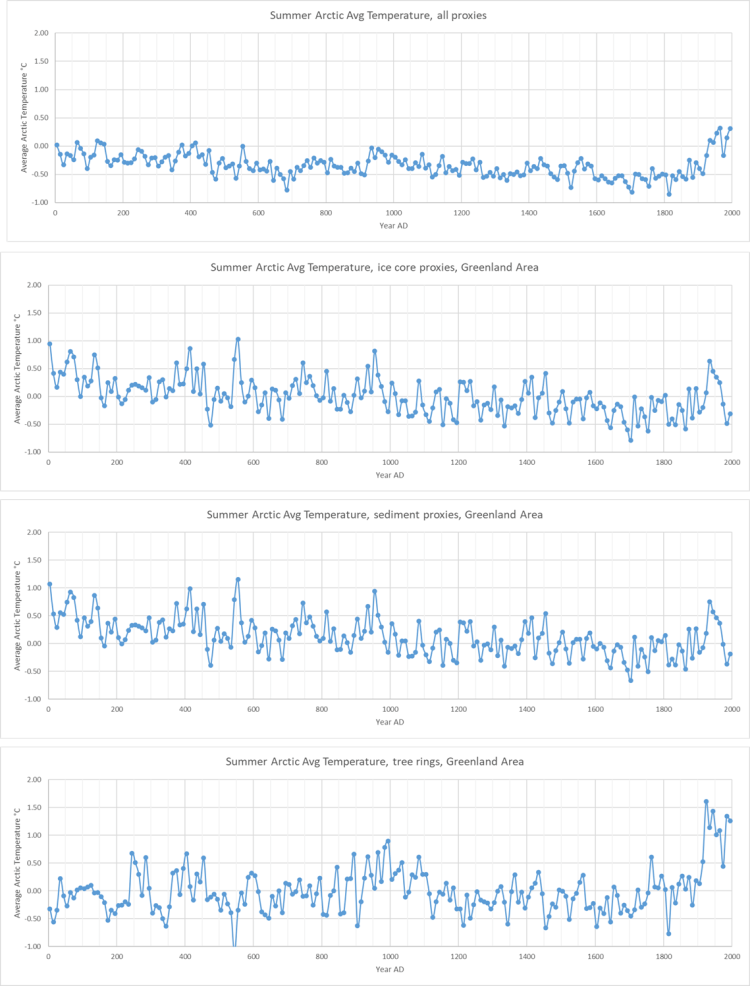

In Abbildung 1 stellt der Proxy für die Makassar-Straße von Rosenthal die Meerestemperatur (SST) im Nordpazifik dar, während der Proxy für Grönland von Vinther ein Proxy für die Lufttemperatur im Norden Grönlands ist (weitere Details zu Vinther und Rosenthal finden Sie hier). Kaufman et al. (2009) zeigen uns eine Reihe von Proxies für die Arktis und stellen sie kombiniert in Abbildung 2 dar, die aus der korrigierten Version der ergänzenden Materialien von Kaufman, 2009, stammt:

Abbildung 2. Kaufmans kombinierte Proxies (oben), Eiskern-Proxies (zweite von oben), Sediment-Proxies (dritte) und Baumring-Proxies (unten). Quelle: (Kaufman et al., 2009) ergänzende Materialien, korrigiert (siehe hier).

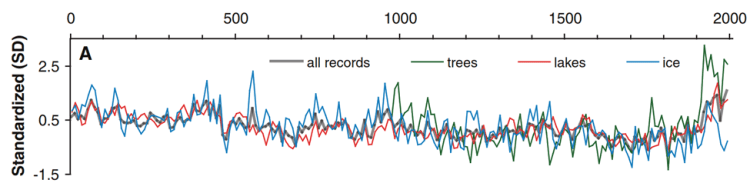

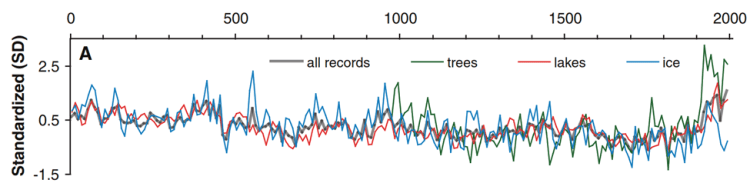

Die gleiche moderne Diskrepanz zwischen den Baumringen und den anderen Proxies ist in Kaufman et al.s Abbildung 3A zu sehen, die als unsere Abbildung 3 unten wiedergegeben ist:

Abbildung 3. Kaufman et al. Abbildung 3A. Überlagerung arktischer Proxies in standardisierten Einheiten. Quelle: (Kaufman et al., 2009). Die Baumring-Proxies sind grün dargestellt und weichen von den anderen ab.

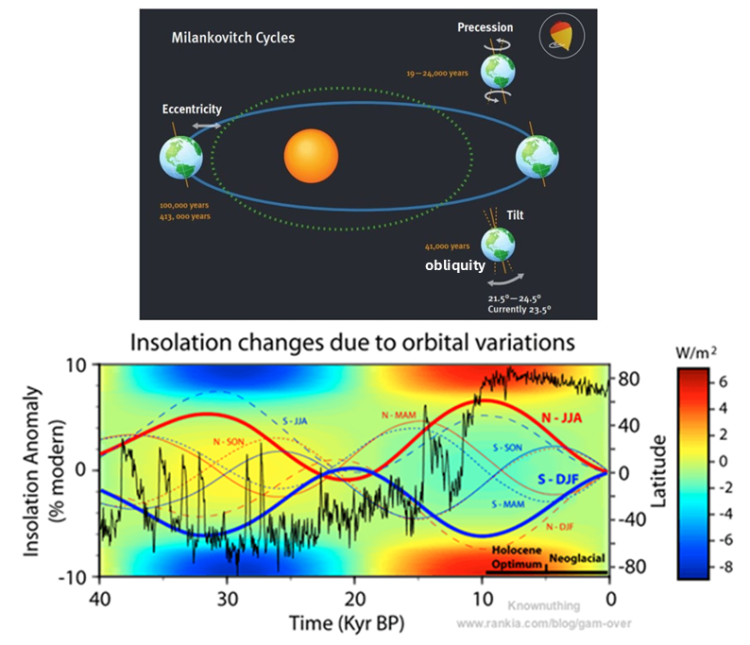

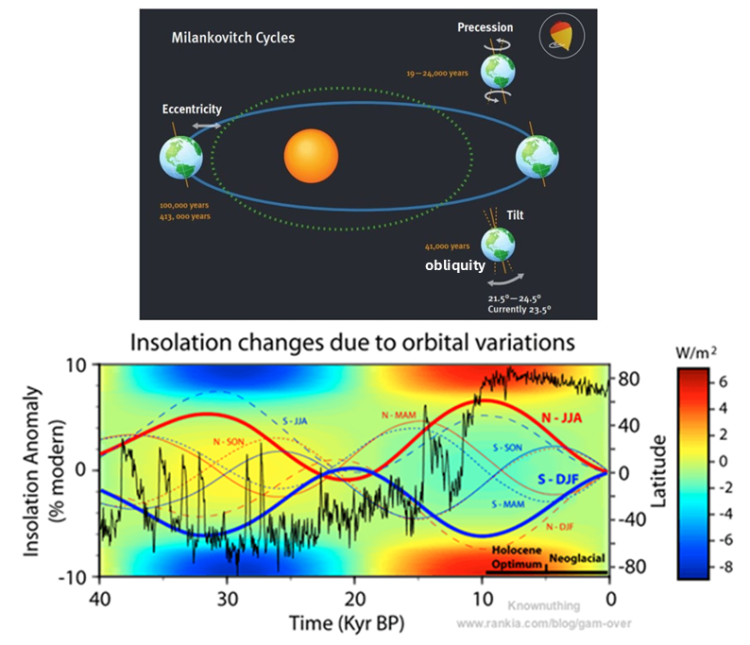

Es besteht allgemeine Einigkeit darüber, dass die Erwärmung der Arktis im Sommer durch die Umlaufbahnen der Erde, insbesondere durch Präzession und Obliquität, verursacht wird (siehe Abbildung 4). Dieser Beitrag wurde durch eine Diskussion zu einem früheren Beitrag inspiriert, die kritische Anmerkung ist hier.

Die Abbildungen 2 und 3 zeigen, dass sowohl die jüngsten Sediment- als auch Eiskern-Proxies für Grönland nach ~1940 zurückgehende Temperaturen zeigen, während die Baumring-Proxies größtenteils auf einem hohen Niveau bleiben. Wir erinnern uns, dass der verstorbene Keith Briffa (Briffa et al., 1998b) uns 1998 davor warnte, dass die Proxies aus Baumringen von anderen Proxies abweichen, und er spekulierte, dass der Anstieg des CO₂-Gehalts wahrscheinlich viel mit dieser Abweichung zu tun habe. Die Abweichung und Michael Manns Versuch, das Problem zu verbergen, führten nach der Veröffentlichung der CRU-E-Mails im Jahr 2009 zu dem mittlerweile berühmten Skandal „Hide the decline” (McIntyre, 2014) & (McIntyre, 2011). Ich habe keine Antwort auf die Abweichung oder die offensichtlichen Zeitverschiebungen zwischen den Proxies in den Abbildungen 2 und 3, aber ich warne den Leser, dass Proxy-Temperaturen nicht mit den Thermometerwerten vergleichbar sind, die wir heute messen, sondern nur Proxies sind und die Daten für die Proxy-Messungen ungewiss sind.

Abbildung 4. Die obere Abbildung aus (Haigh, 2011) zeigt die Elemente der Milankovich-Orbitalzyklen, Exzentrizität, Präzession und Obliquität (oder Achsenneigung). Die untere Abbildung aus (Vinós, 2017) zeigt die klimatischen Auswirkungen seit 40.000 Jahren vor heute.

Die obere Abbildung in Abbildung 4 zeigt die Elemente der Milankovitch-Zyklen (Haigh, 2011). Die saisonalen Kurven in der unteren Abbildung (Vinós, 2017) zeigen die Auswirkungen der Präzession. Die saisonalen Kurven sind mit der Hemisphäre (N oder S) und den Anfangsbuchstaben der Monate gekennzeichnet. Die dicken Kurven stellen die Sommermonate der nördlichen Hemisphäre (rot) und der südlichen Hemisphäre (blau) dar. Die Veränderungen der Sonneneinstrahlung werden durch die Hintergrundfarbe dargestellt (Skala rechts in W/m²). Die schwarze Kurve zeigt die δ¹⁸O-Isotopenveränderungen aus der NGRIP-Grönland-Eiskernanalyse, einem Temperaturproxy (Alley, 2000). Der δ¹⁸O-Temperaturproxy hat keine Skala, aber höhere Temperaturen sind oben und niedrigere Temperaturen unten dargestellt. Die vertikale Skala ist die Breite, und die horizontale Skala ist die Zeit von vor 40.000 Jahren bis zur Gegenwart, wobei Null auf der Hintergrundfarbskala die Sonneneinstrahlung nach Breite heute ist.

Die Veränderungen der Hintergrundfarbe (Sonneneinstrahlung) in der unteren Abbildung in Abbildung 4 sind hauptsächlich auf Veränderungen der Neigung der Erdachse zurückzuführen und in Bezug auf die Hemisphären annähernd symmetrisch. Die durch die Neigung bedingten Veränderungen bestimmen, wie viel Sonneneinstrahlung die Pole im Vergleich zu den Tropen erreicht. Die Präzession hingegen beeinflusst die saisonale Verteilung der Sonnenenergie. Wie man sieht war das Ende der letzten Eiszeit zu Beginn des Holozäns vor 11.700 Jahren der Zeitpunkt, zu dem die Neigung und die Präzession in der nördlichen Hemisphäre am größten waren.

Weitere interessante Aspekte im unteren Teil von Abbildung 4 sind, dass sich die Sonneneinstrahlung während des gesamten Holozäns in den Tropen kaum verändert, an den Polen jedoch stark schwankt. Die N-JJA-Kurve ähnelt stark den Proxies für die Straße von Makassar und Grönland in Abbildung 1. Man beachte die Bezeichnungen „Holozänes Klimaoptimum” und „Neoglazial” in den Abbildungen 4 und 1.

Abbildung 5 zeigt die vollständigen Kurven von Vinther und Rosenthal und setzt sie in Beziehung zu historischen Ereignissen. Man klicke auf die Abbildung oder hier, um sie in voller Auflösung anzuzeigen:

Abbildung 5. Vinther-Rekonstruktion für Grönland (Mitte) und Rosenthal-Rekonstruktion für die Straße von Makassar (oben) im Vergleich zu historischen Ereignissen. Quelle: Abbildung 3 hier.

Die in Abbildung 5 dargestellte Zeitleiste enthält eine Vielzahl historischer Referenzen, auf die wir hier nicht alle eingehen können, da sie in früheren Beiträgen hier und hier bereits ausführlich dokumentiert worden sind. Wir möchten lediglich darauf hinweisen, dass bedeutende lokale Klimaveränderungen historische Ereignisse sind, die von den Historikern der damaligen Zeit oft detailliert beschrieben und genau datiert worden waren. Diese historischen Beschreibungen können wertvoller sein als biologische oder Eiskern-Proxies.

Wie Abbildung 4 zeigt, erreichte die Sonneneinstrahlung in der Arktis zu Beginn des Holozäns 9.700 v. Chr. ihren Höchstwert (Walker et al., 2009). Dies war auch die Zeit der schnellsten Temperaturänderung in der Arktis während des Holozäns. Severinghaus et al. dokumentierten für etwa 9.700 v. Chr. eine Erwärmung um 5–10 °C, die nur wenige Jahrzehnte dauerte und die heute beobachtete Erwärmungsrate weit in den Schatten stellt. Das Erwärmungsereignis ist in der mittleren Grafik in Abbildung 5 dargestellt. Dieses Erwärmungsereignis ist so bedeutend, dass es Teil der offiziellen geologischen Grundlage für den Beginn des Holozäns ist (Walker et al., 2009).

Das obere Diagramm in Abbildung 5 zeigt die Temperatur des 500 Meter tiefen Wassers in der Straße von Makassar, die repräsentativ für die Meerestemperatur im Nordpazifik ist (Rosenthal et al., 2013). Die aktuelle Temperatur in der Straße von Makassar aus der Datenbank für Meerestemperaturen der Universität Hamburg (Gouretski, 2019) ist in diesem Diagramm als roter Kasten dargestellt und liegt deutlich unter den Temperaturen, die in der mittelalterlichen Warmzeit (MWP) und der römischen Warmzeit (RWP) gemessen worden waren. In der mittleren Grafik von Abbildung 5 ist die Vinther-Rekonstruktion (Vinther et al., 2009) als orangefarbene Linie dargestellt. Die frühere blaue Linie ist die Alley-Rekonstruktion (Alley, 2000), die daran angefügt wurde. Der HadCRUT5-Durchschnitt der Temperaturen in Grönland von 2000 bis 2020 ist zum Vergleich mit der Proxy-Temperatur als roter Kasten dargestellt. Die heutigen Temperaturen in Grönland entsprechen in etwa den Temperaturen während der MWP.

Diskussion

Es gibt zahlreiche Belege dafür, dass die heutigen Temperaturen in der Arktis und der nördlichen Hemisphäre deutlich unter denen von vor 6.800 bis 7.800 Jahren liegen. Es gibt auch zahlreiche Belege dafür, dass der Temperaturanstieg im Jahr 9.700 v. Chr. viel schneller verlief als der heute beobachtete Anstieg. Der Vergleich der heutigen Erwärmungsrate, für die uns tägliche Temperaturdaten aus aller Welt vorliegen, mit den Proxies aus der vorindustriellen Zeit ist problematisch. Die hochwertigen Proxies von Rosenthal und Vinther haben eine Auflösung von etwa 20 Jahren über die letzten 2000 Jahre, sodass die modernen Durchschnittswerte, mit denen wir sie in Abbildung 5 vergleichen, 11 Jahre (Universität Hamburg) und 21 Jahre (Grönland) umfassen. Es ist viel einfacher, die moderne Auflösung für Vergleiche mit der Vergangenheit zu reduzieren, als zu versuchen, die Proxy-Auflösung zu erhöhen. Es ist töricht zu versuchen, globale oder hemisphärische Temperaturaufzeichnungen mit Proxies zu rekonstruieren; sie sind sehr grob und der zur Rekonstruktion verwendete Mittelungsprozess zerstört die kritischen Details, die zur Bestimmung einer Erwärmungsrate erforderlich sind.

Neben der schnellen Erwärmung, die in diesen Proxies um 9.700 v. Chr. zu beobachten ist, gab es auch eine schnelle Erwärmung um 6200 v. Chr., 40 v. Chr. und 800 n. Chr. Jede dieser Perioden könnte sich schneller erwärmt haben als heute, wenn sie mit der gleichen Abdeckung und Genauigkeit verglichen werden könnten.

Referenzen

Alley, R. B. (2000). The Younger Dryas cold interval as viewed from Central Greenland. Quaternary Science Reviews, 19, 213-226. Retrieved from http://klimarealistene.com/web-content/Bibliografi/Alley2000%20The%20Younger%20Dryas%20cold%20interval%20as%20viewed%20from%20central%20Greenland%20QSR.pdf

Briffa, K., Schweingruber, F., Jones, P., Osborn, T., & Vaganov, E. (1998b). Reduced Sensitivity of recent tree-growth to temperature at high latitudes. Nature, 678-682. Retrieved from https://www.nature.com/articles/35596

Gouretski, V. (2019). A New Global Ocean Hydrographic Climatology. Atmospheric and Oceanic Science Letters, 12(3), 226-229. Retrieved from https://www.tandfonline.com/doi/full/10.1080/16742834.2019.1588066

Haigh, J. (2011). Solar Influences on Climate. Imperial College, London. Retrieved from https://www.imperial.ac.uk/media/imperial-college/grantham-institute/public/publications/briefing-papers/Solar-Influences-on-Climate—Grantham-BP-5.pdf

Kaufman, D. S., Schneider, D. P., McKay, N. P., Ammann, C. M., Bradley, R. S., Briffa, K. R., . . . Vinther, B. M. (2009). Recent Warming Reverses Long-Term Arctic Cooling. Science, 325(5945). https://doi.org/10.1126/science.1173983

Lecavalier, B., Fisher, D., G.A. Milne, B., Vinther, L., Tarasov, P., Huybrechts, D., . . . Dyke, A. (2017). High Arctic Holocene temperature record from the Agassiz ice cap and Greenland ice sheet evolution. Proc. Natl. Acad. Sci. , 114(23), 5952-5957. https://doi.org/10.1073/pnas.1616287114

McIntyre, S. (2011, Dec. 1). Hide-the-Decline Plus. Retrieved from Climate Audit: https://climateaudit.org/2011/12/01/hide-the-decline-plus/

McIntyre, S. (2014, September 6). The Original Hide-the-Decline. Retrieved from Climate Audit: https://climateaudit.org/2014/09/06/the-original-hide-the-decline/

Rosenthal, Y., Linsley, B., & Oppo, D. (2013, November 1). Pacific Ocean Heat Content During the Past 10,000 years. Science. Retrieved from http://science.sciencemag.org/content/342/6158/617

Vinós, J. (2017, April 30). Nature Unbound III: Holocene climate variability (Part A). Retrieved from Climate Etc.: https://judithcurry.com/2017/04/30/nature-unbound-iii-holocene-climate-variability-part-a/

Vinther, B., Buchardt, S., Clausen, H., Dahl-Jensen, Johnsen, Fisher, . . . Svensson. (2009, September). Holocene thinning of the Greenland ice sheet. Nature, 461. Retrieved from https://www.nature.com/articles/nature08355

Walker, M., Johnsen, S., Rasmussen, U. O., Popp, T., Steffensen, J.-P., Gibbard, P., . . . Newnham, R. (2009). Formal definition and dating of the GSSP (Global Stratotype Section and Point) for the base of the Holocene using the Greenland NGRIP ice core,and selected auxiliary records. Journal Of Quaternary Science, 24, 3-17. https://doi.org/10.1002/jqs.1227

Link: https://andymaypetrophysicist.com/2026/02/04/holocene-warming/

Übersetzt von Christian Freuer für das EIKE