Christopher Monckton of Brenchley

Es ist nun fast zwei Jahre her, dass wir unseren Aufsatz über den zentralen Fehler der Klimaforscher bei ihren Versuchen, die Klimasensitivität auf anthropogene Treibhausgase abzuleiten, vorgelegt haben – nämlich ihr Versagen zu erkennen, dass solche Rückkopplungsprozesse, wie sie zu einem bestimmten Zeitpunkt im Klimasystem vorhanden sind, zu diesem Zeitpunkt notwendigerweise auf jedes Kelvin der gesamten Referenztemperatur gleichermaßen reagieren müssen. Rückkopplungen reagieren nicht – ich wiederhole: nicht – nur auf Störsignale, die Referenzempfindlichkeiten. Sie reagieren auch auf das Basissignal, die Emissionstemperatur, die auch dann herrschen würde, wenn keine Treibhausgase in der Luft wären, weil die Sonne scheint. Doch einer der bedeutendsten Klimatologen der Welt spiegelte den Irrtum wider, der in seiner Branche nahezu allgegenwärtig ist, als er nach einem mehrtägigen Gefecht auf eine direkte Frage von mir zugab, dass er nicht davon ausgeht, dass es eine Rückkopplung auf die Emissionstemperatur gibt.

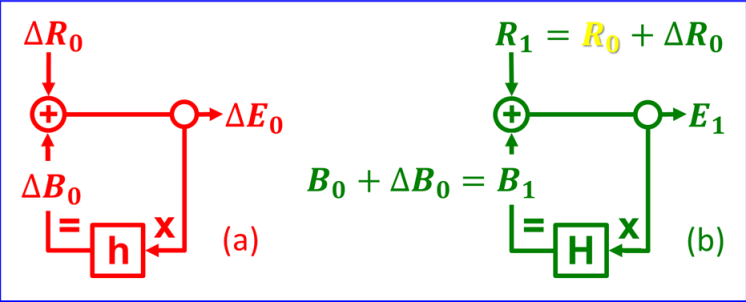

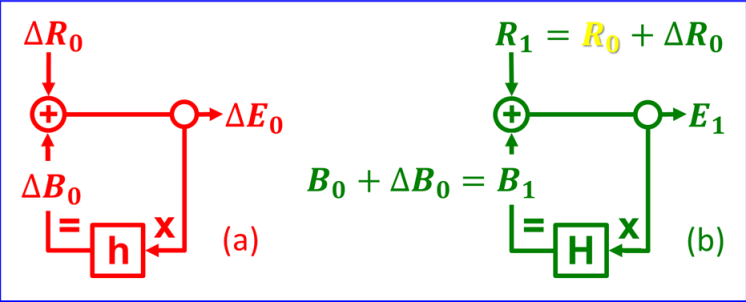

Das folgende Diagramm zeigt die beiden konkurrierenden Verfahren, wie sie für das Jahr 1850 gelten. Verfahren (a) in rot ist das unvollständige Verfahren, das die Klimatologen in die Irre führte. Verfahren (b) in grün ist das vollständige und korrekte Verfahren, das die Tatsache, dass die Sonne scheint, gebührend berücksichtigt.

Die letztgenannte Methode ist notwendig, weil das Basissignal, die 260-K-Emissionstemperatur R0 (im korrigierten Diagramm sonnengelb dargestellt, im fehlerhaften Diagramm jedoch weggelassen), etwa das 30-fache der 8-K-Referenzsensitivität ΔR0 gegenüber den natürlich vorkommenden, nicht kondensierenden Treibhausgasen (oder der direkten Erwärmung durch diese) beträgt, die in der vorindustriellen Atmosphäre von 1850 vorhanden waren. Dann ist R1, die Summe von R0 und ΔR0, das gesamte Eingangs- oder Referenzsignal, wie es 1850 vorlag. Dieses Jahr ist deshalb von Interesse, weil damals ein Temperaturgleichgewicht herrschte: In den folgenden 80 Jahren würde es keinen Temperaturtrend geben.

Die Rückkopplung auf die Emissionstemperatur R0 ist B0. Ebenso ist die Rückkopplungsreaktion auf ΔR0 ΔB0. Die Rückkopplungsreaktion auf das gesamte Eingangssignal R1 im Jahr 1850 ist somit B1. Der differentielle Rückkopplungsanteil oder Regelkreis-Verstärkungsfaktor h ist der Anteil des unkorrigierten Ausgangssignals, der Gleichgewichtsempfindlichkeit ΔE0, der durch die Rückkopplungsantwort ΔB0 dargestellt wird. Ebenso ist die absolute Regelverstärkung H der Bruchteil des korrigierten Ausgangssignals, der Gleichgewichtstemperatur E1, der durch die gesamte Rückkopplungsreaktion B1 dargestellt wird.

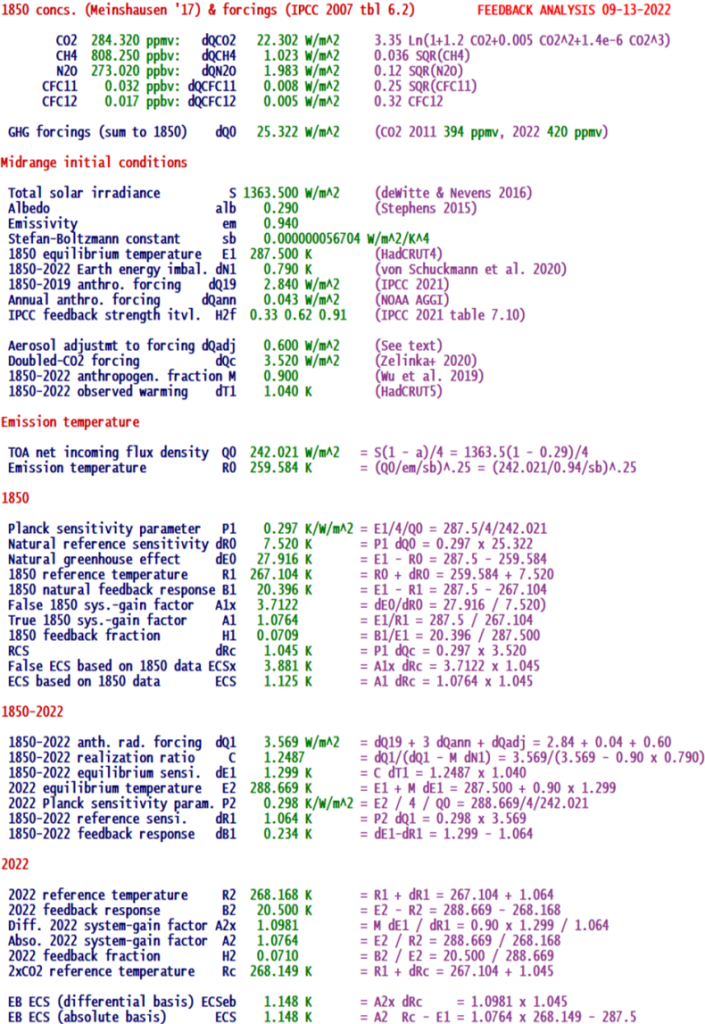

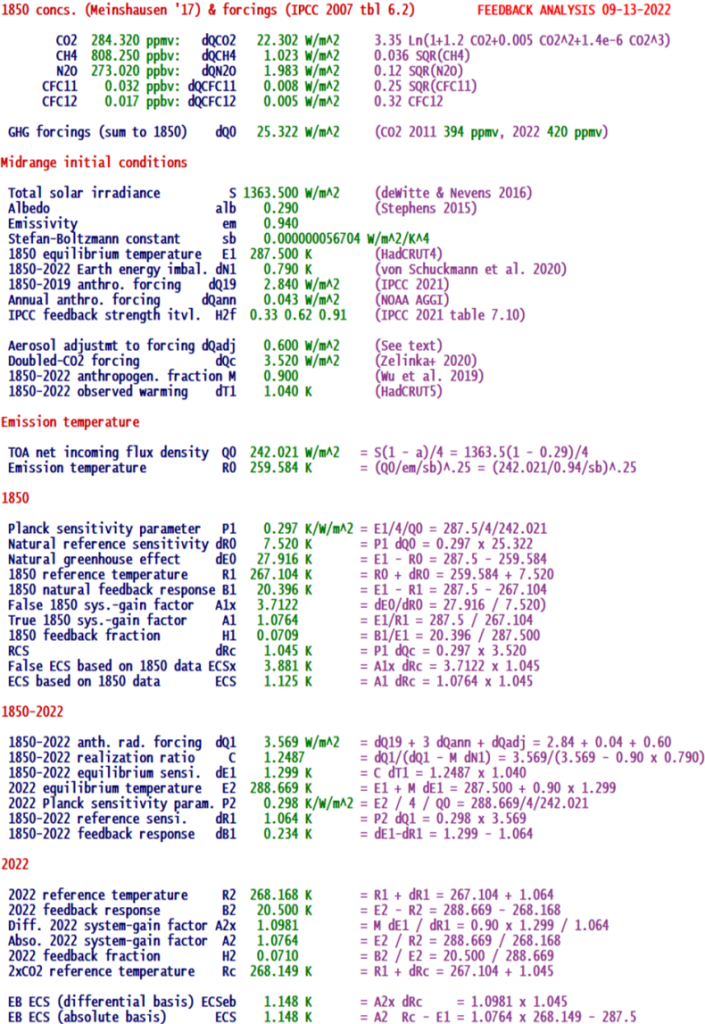

Fordern wir den Computer auf, eine anspruchsvollere Berechnung des Energiebudgets durchzuführen als die stark vereinfachte Version, die ich Anfang des Monats gezeigt habe, und lassen wir ihn seine Arbeit zeigen:

Wir beginnen mit dem Jahr 1850, indem wir die Antriebe durch die wichtigsten natürlich vorkommenden Treibhausgasarten im Jahr 1850 berechnen. Die Daten stammen aus Meinshausen et al. (2017); die Formeln sind aus IPCC (2007, Tabelle 6.2). Der Vorteil dieser speziellen Formeln ist, dass sie so konzipiert wurden, dass sie die Berechnung der Antriebe von Null an ermöglichen und nicht von einer willkürlichen Konzentration größer als Null. Die Antriebe bis 1850 belaufen sich daher auf 25,3 Watt pro Quadratmeter.

Als nächstes werden die mittleren Anfangsbedingungen festgelegt. Bis auf zwei Ausnahmen sind alles Standardbedingungen. Erstens korrigiert die Aerosolanpassung von 0,6 Watt pro Quadratmeter den übermäßig negativen Aerosolantrieb des IPCC, um einer umfangreichen Literatur zu diesem Thema Rechnung zu tragen. Professor Lindzen hat öffentlich erklärt, dass der in den Modellen angenommene stark negative Aerosolantrieb ein künstlich berechneter Korrekturfaktor ist, um die Klimaempfindlichkeit zu übertreiben.

Zweitens wird der anthropogene Anteil M am gesamten Treibhausgas-Antrieb mit 0,9 angenommen. In Wirklichkeit könnte man durch Gewichtung der Einträge in Tabelle 2 in Wu et al. (2019) unter Bezugnahme auf die relevanten Periodenlängen ableiten, dass von dem gesamten Periodenantrieb von 0,96 W/m² 0,71 W/m² anthropogenen und 0,25 W/m² natürlichen Ursprungs waren. Auf dieser Grundlage waren etwa 73,5 % des Antriebs während des Zeitraums anthropogenen Ursprungs. Wir haben jedoch vorsichtig angenommen, dass sogar 90 % des Antriebs anthropogenen Ursprungs waren.

Die Emissionstemperatur wird dann über die Stefan-Boltzmann-Gleichung abgeleitet. Dabei wird jedoch, wie in der Klimatologie leider üblich, nicht berücksichtigt, dass es ohne Treibhausgase in der Luft keine Wolken gäbe, so dass die Albedo die Hälfte des hier verwendeten Standardwerts betragen würde und die Emissionstemperatur – selbst unter Berücksichtigung der Hoelderschen Ungleichungen, die Klimatologen im Allgemeinen ignorieren – weit über 260 K liegen würde.

Es wird dann gezeigt, dass der Systemgewinnfaktor im Jahr 1850, das Verhältnis A1 der Gleichgewichtstemperatur E1 zur Referenztemperatur R1 in diesem Jahr, 1,0764 war, was bedeutet, dass – wenn sich das Rückkopplungsregime seit 1850 nicht geändert hat (was das Le Chatellier-Prinzip und die geringe Erwärmung seither erwarten lassen und wovon die Klimatologen implizit ausgehen) – die Gleichgewichtsempfindlichkeit bei verdoppeltem CO2 nur 1 beträgt. 1 K. Mit dem falschen Verfahren würde der Systemgewinnfaktor, der fälschlicherweise als das Verhältnis a1 zwischen Gleichgewichts- und Referenzsensitivität ausgedrückt wird, 3,712 betragen, was uns 3,9 K ECS erwarten ließe.

Woher wissen wir, dass dies der Fehler ist, den die Klimatologen begangen haben? Der Grund ist einfach. Vor etwa 15 Jahren schrieb ich an Sir John Houghton, den damaligen Vorsitzenden des IPCC-Klima-„Wissenschafts“-Gremiums, und fragte ihn, warum man angesichts der Tatsache, dass die direkte Erwärmung durch die Verdoppelung des CO2-Gehalts der Luft kaum mehr als 1 K beträgt, von einer endgültigen Erwärmung von 3 oder 4 K ausgeht. Sir John antwortete, dass der gesamte natürliche Treibhauseffekt im Jahr 1850 32 K betrug und die Referenzsensitivität gegenüber natürlich vorkommenden Treibhausgasen bei etwa 8 K lag. Daher, so sagte er, liege der Systemgewinnfaktor bei etwa 4 und daher würde der ECS in der Größenordnung von 4 K liegen.

Als nächstes muss ein Energiebudget-Experiment für den Zeitraum 1850-2022 durchgeführt werden. Dabei soll festgestellt werden, ob sich der Systemgewinnfaktor A2 im Jahr 2022 unter Verwendung von Daten aus dem mittleren Bereich und dem Mainstream signifikant von dem Systemgewinnfaktor A1 = 1,0764 unterscheidet, der sich aus den Daten für 1850 ergibt. Auf der Grundlage der gezeigten Mainstream-Daten im mittleren Bereich sind die beiden Werte identisch. Das Rückkopplungssystem hat sich also mit dem Anstieg der globalen mittleren Oberflächentemperatur um lediglich 0,35 % seit 1850 nicht verändert. Das ist keine große Überraschung.

Ein Hinweis zur Vorsicht. Gerade weil – ob es den Klimatologen gefällt oder nicht, ob sie es zugeben oder nicht – die zu einem bestimmten Zeitpunkt vorhandenen Rückkopplungen auf das gesamte Eingangssignal reagieren, einschließlich der enormen Sonnenscheintemperatur von 260 K, würde selbst eine sehr kleine Änderung des Rückkopplungsregimes potenziell zu einer sehr großen Änderung der globalen mittleren Temperatur führen, da die erhöhte Rückkopplungsstärke auf die gesamte Referenztemperatur einschließlich der vorherrschenden Sonnenscheintemperatur wirken muss und nicht nur auf die dürftigen Referenzsensitivitäten.

Ein weiterer Hinweis zur Vorsicht: Die Daten und damit auch die Klimaempfindlichkeiten können leicht in jede gewünschte Richtung verändert werden. So hat das IPCC die mittleren Werte und Grenzen der zugrunde liegenden Daten immer wieder verändert (z. B. hat es die mittlere Schätzung des verdoppelten CO2-Antriebs von den durchschnittlichen 3,52 W/m² in den CMIP6-Modellen auf 3,93 K angehoben, ein Anstieg, der die seit langem etablierten ±10%-Grenzen überschreitet).

Gerade weil kleine Änderungen in den zugrundeliegenden Daten die Stärke der Rückkopplung und damit den Systemgewinnfaktor beeinflussen und weil der Systemgewinnfaktor nicht nur für die anthropogene Referenzsensitivität, sondern für das gesamte Eingangssignal, einschließlich der Emissionstemperatur, gilt, ist es einfach nicht möglich, ECS durch die Diagnose der Rückkopplungsstärken aus den Ergebnissen der Modelle einzuschränken. Daher ist die Behauptung, dass die auf der Grundlage solcher Diagnosen vorhergesagte hohe ECS eine „anerkannte Wissenschaft“ darstellt, noch weniger aussagekräftig als das Zirpen der Grillen vor meinem Fenster hier im steinzeitlichen Gozo.

Selbst die einfache Energiebilanzmethode, die unser Computer verwendet, ist anfällig für diesen Fehler. Warum können wir also ausschließen, dass sich das Rückkopplungssystem seit 1850 stark verändert hat? Der Grund ist ein praktischer. Wenn es tatsächlich eine große Abweichung vom Rückkopplungsregime von 1850 gegeben hätte, wäre die Erwärmung seit 1990 nicht – wie es der Fall ist – zweieinhalb Mal geringer als das, was der IPCC in jenem Jahr zuversichtlich, aber fälschlicherweise vorhergesagt hatte.

Deshalb sind die langen Pausen in der globalen Temperaturentwicklung zu einem Zeitpunkt, zu dem die anthropogenen Einflüsse weiterhin geradlinig ansteigen, so bedeutsam. Sie sind ein sichtbares Zeichen dafür, dass die globale Erwärmung doch nicht in der ursprünglich vorhergesagten Geschwindigkeit stattfindet und dass es daher keine nennenswerte Änderung der Rückkopplung gegeben hat.

Nun haben Kritiker angemerkt, dass sich die Vorhersagen des IPCC als richtig erwiesen hätten, wenn man die tatsächlichen Veränderungen der Treibhausgase seit 1850 auf die Diagramme des IPCC anwendet, die die vorhergesagten Treibhausgase ab 1990 zeigen. Ein offensichtliches Problem dabei: Wenn sich die Entwicklung der Treibhausgase seit 1990 als so viel geringer erwiesen hat als die Vorhersagen des IPCC für das Jahr 1990, warum sagt das IPCC dann weiterhin eine zweieinhalbmal so starke Erwärmung voraus, wie die Entwicklung der Treibhausgase erwarten ließe?

Ein weiterer beliebter Einwand der Kritiker ist, dass wir uns einer unzulässigen „Extrapolation“ schuldig gemacht haben. Aus der obigen Berechnung sollte jedoch ersichtlich sein, dass es sich keineswegs um eine „Extrapolation“ handelt.

Es waren die Klimatologen, nicht wir, die darauf bestanden, dass ECS auf der Grundlage der Daten für 1850 etwa 3-4 K betrug und dass es auf der Grundlage der Daten seit 1850 auch heute noch 3-4 K beträgt. Das von uns verwendete Energiebudget-Verfahren beruht überhaupt nicht auf Extrapolation. Bei einem Anstieg der absoluten globalen mittleren Temperatur um nur 0,35 % würde man keine oder nur geringe Änderungen im Rückkopplungssystem erwarten, und die obige Berechnung zeigt, dass sich der Systemgewinnfaktor zwischen 1850 und 2022 bei Verwendung der üblichen Mittelwerte möglicherweise überhaupt nicht geändert hat, so dass der ECS in der Größenordnung von 1,1 K liegt.

In einem kürzlich erschienenen Beitrag wurden vier Klimatologen zitiert, die anderer Meinung sind als wir. Aber keiner der fraglichen Klimatologen hat unsere Studie gelesen. Keiner von ihnen hat besondere Kenntnisse der Regelungstheorie (genauso wenig wie der Poster). Zwei von ihnen konnten nicht einmal zugeben, dass es überhaupt eine Rückkopplung auf die Emissionstemperatur gibt (Hinweis: Es gibt sie, gewöhnen Sie sich daran). Die beiden anderen haben unser Ergebnis überhaupt nicht kommentiert. Wenn unsere Arbeit so einfach zu widerlegen wäre, wie das Poster suggeriert, würde sie nicht immer noch beim Herausgeber einer führenden Klimazeitschrift liegen, mit dem Vermerk „With Editor“ auf der Website der Redaktion, fast zwei Jahre nachdem sie eingereicht wurde. Wäre sie fehlerhaft, wäre sie einfach zurückgeschickt worden, was aber nicht geschehen ist.

Warum ist das alles wichtig? Es ist wichtig, weil, wenn wir Recht haben, zwei wichtige wissenschaftliche Schlussfolgerungen daraus zu ziehen sind. Erstens ist es mit dem Energiebudget-Verfahren möglich zu zeigen, dass ECS unter Verwendung von Mainstream-Daten mittlerer Reichweite wahrscheinlich nur 1,1 K beträgt und notwendigerweise noch geringer ist, wenn man die eigene, nicht unvernünftige Annahme der Klimatologie (Kritiker würden sie als „Extrapolation“ bezeichnen) annimmt, dass sich das Rückkopplungsregime seit 1850 nicht verändert hat.

Zweitens wird, sobald die extreme Empfindlichkeit des ECS auf sehr kleine Änderungen im Rückkopplungsregime richtig verstanden wird – was in der Klimatologie derzeit nicht der Fall ist – sofort deutlich, dass die Ergebnisse der Modelle keinerlei Grundlage für die Ableitung von ECS-Werten bieten, die besser sind als Vermutungen, weil die Datenunsicherheiten das sehr enge Intervall der Systemgewinnfaktoren überschreiten, welches eine vernünftige Begrenzung des ECS erlauben würde.

Diese Schlussfolgerungen sind von Bedeutung, da das Energiebudget-Verfahren, wie in einer Reihe von Veröffentlichungen gezeigt wurde, darauf hindeutet, dass ECS viel geringer ist, als IPCC und andere es für zweckmäßig halten zuzugeben. Bisher haben Klimatologen die geringen Empfindlichkeiten, die mit dem Energiebudget-Verfahren ermittelt wurden, damit erklärt, dass die Ergebnisse der Modelle ausgefeilter sind und dass daher die Diagnose der Stärke der Rückkopplung und folglich des ECS vorzuziehen ist. Unsere Studie räumt mit dieser Illusion auf. Wie Pat Frank bereits gezeigt hat, sind die Vorhersagen der Modelle über die künftige globale Erwärmung nicht besser als Würfelspiele. Unsere Ergebnisse bestätigen ihn in höchstem Maße, allerdings mit der eindeutigen Methode, die extreme Empfindlichkeit all dieser Vorhersagen gegenüber sehr kleinen Störungen im Rückkopplungsbereich zu demonstrieren.

Lassen Sie uns abschließend die Schätzung aktualisieren, wie wenig die globale Erwärmung verringert würde, selbst wenn die gesamte Welt auf Netto-Null-Emissionen umsteigen würde – was nicht der Fall sein wird, da 70 % aller neuen Emissionen aus so genannten „Entwicklungsländern“ wie China und Indien stammen, die gemäß den verschiedenen Klimaverträgen von jeglicher rechtlichen Verpflichtung zur Reduzierung ihrer Emissionen ausgenommen sind. Tatsächlich hat China vor kurzem vernünftigerweise vorgeschlagen, Hunderte neue Kohlekraftwerke zu bauen.

Aber tun wir einmal so, als ob die Welt bis 2050 tatsächlich Netto-Null-Emissionen erreichen würde. Eine erste Einschätzung der „Vorteile“ und Kosten dieser fragwürdigen Errungenschaft finden Sie auf der Rückseite des nachstehenden Umschlags:

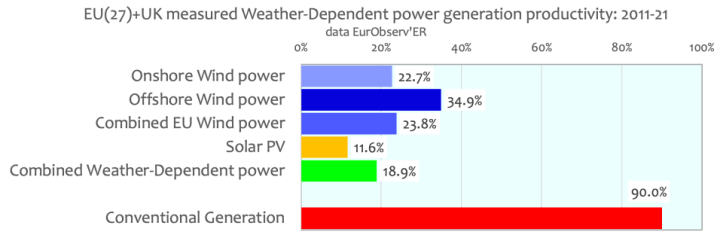

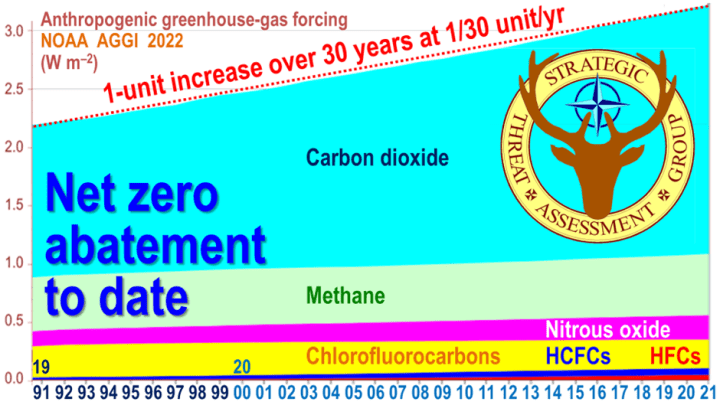

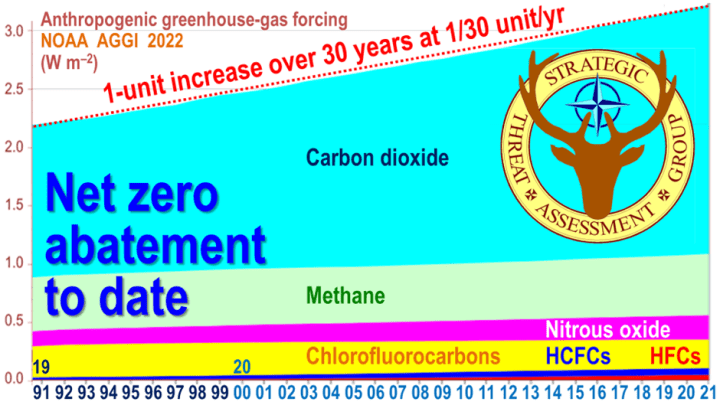

In den letzten drei Jahrzehnten hat es einen anthropogenen Treibhausgasantrieb von 1 W/m² gegeben, der sich fast geradlinig mit 1/30 W/m² pro Jahr entwickelt:

Trotz des ganzen Geschwafels auf den aufeinanderfolgenden Konferenzen der Vertragsparteien des Rahmenübereinkommens über den Klimawandel und trotz der Billionen, die von den westlichen Ländern bereits für die Emissionsreduzierung vergeudet wurden, zeigt diese gerade Linie kein Anzeichen eines Rückgangs. Somit würde bis 2050 nur ein halbes Watt pro Quadratmeter eingespart werden, selbst wenn sich die ganze Welt bis zu diesem Jahr geradlinig von hier auf Netto-Null bewegen würde – was nicht der Fall sein wird, da sich 70 % der Welt geradlinig in die entgegengesetzte Richtung bewegen und die verbleibenden 30 % es sehr viel schwieriger und teurer finden, Netto-Null zu erreichen, als sie ursprünglich vorgaben.

Nehmen wir nun an, dass der IPCC mit seiner mittleren Schätzung richtig liegt, wonach es als Reaktion auf 4 K effektiven CO2-Antrieb eine ECS von 3 K geben würde, und dass es daher seit 1990 eine mindestens doppelt so starke Erwärmung gegeben haben müsste, wie es in der realen Welt, die die Modellierer so verachten, der Fall war. Wenn dies der Fall ist, würde die Verringerung einer halben Einheit des Antriebs, was alles ist, was bis 2050 verringert werden würde, selbst wenn die ganze Welt ernsthaft Netto-Null-Emissionen anstreben würde, die globale Erwärmung bis 2050 um lächerliche 3/8 K verringern. Und das sind kaum mehr als 0,1 % der gegenwärtigen absoluten globalen mittleren Temperatur.

Nach Angaben der Unternehmensberatung McKinsey würden sich allein die Kapitalkosten für die Erreichung des globalen Netto-Nullpunkts auf 275.000 Milliarden Pfund belaufen. Und diese Schätzung wurde vor dem jüngsten Anstieg der Energiepreise vorgenommen, dessen Hauptursache das törichte Beharren des Westens auf der Stilllegung von Kohlekraftwerken war, die Strom für 30 Dollar pro MWh erzeugen, und deren Ersatz durch unzuverlässige Kraftwerke, die ein Vielfaches dieser Kosten pro Einheit verursachen, ganz zu schweigen von der Verzehnfachung der sibirischen Gaspreise, die es dem Kreml ermöglicht, solange er seine militärische Sonderoperation in der Ukraine aufrechterhalten kann, großzügig zu profitieren, Sanktionen hin oder her.

Nach unserer nachrichtendienstlichen Einschätzung wird Moskau, wenn es den Krieg am Laufen halten kann, durch die um Größenordnungen gestiegenen Preise für Gas, Öl, Getreide, Nickel, Kobalt, Kupfer, Lithium und andere Rohstoffe, die seit langem die Haupteinnahmequelle seiner rohstoffbasierten Wirtschaft sind, so viel Geld verdient haben, dass Putin, der eine pathologische (und berechtigte) Angst vor der Staatsverschuldung hat, in der Lage sein wird, die gesamte russische Staatsverschuldung in nur zwei Jahren zu tilgen. Er hat sie bereits auf etwa 25 % des jährlichen BIP gesenkt, eine der niedrigsten Quoten der Welt. Er strebt keine Netto-Null-Emissionen an (seine Akademie der Wissenschaften hat ihm gesagt, dass er sich darüber keine Sorgen machen muss), sondern eine Netto-Null-Staatsverschuldung. Trotz des jüngsten Rückschlags für seine Streitkräfte in der Ukraine ist es keineswegs klar, dass er mit diesem legitimen Ziel scheitern wird.

Bleiben wir bei der mittleren Schätzung des IPCC, wonach jede verringerte Treibhausgasmenge die globale Temperatur um 3/4 K senkt. Dividieren wir die 3/8 K, die bis 2050 durch die halbe Treibhausgasverringerung verringert würden, wenn die Welt tatsächlich auf Netto-Null gehen würde, durch die Kosten von 275.000 Milliarden Dollar für die Erreichung von Netto-Null, so beträgt die Menge der globalen Erwärmung, die durch jede für Netto-Null-Emissionen verschwendete Milliarde Dollar verringert wird, – warten Sie es ab – weniger als 1/700.000 K.

Weniger als ein siebenhunderttausendstel Grad pro 1 Milliarde Dollar, die in den Gully geworfen wird. Nicht gerade ein gutes Preis-Leistungs-Verhältnis – in der Tat wäre es das schlechteste Preis-Leistungs-Verhältnis in der Geschichte der globalen Besteuerung.

Doch nun müssen wir die folgenden Fakten berücksichtigen. Infolge des Ukraine-Krieges, der durch die Idiotie der Regierungen noch verschlimmert wird, die auf grobe und ineffiziente Weise in den freien Markt der Energieversorgung eingreifen, indem sie Kohlekraftwerke zwangsweise stilllegen und durch teure unzuverlässige Anlagen ersetzen, werden die Kapitalkosten für die Erreichung von Netto-Null ein Vielfaches dessen betragen, was McKinseys sich vorgestellt hatte. Hinzu kommt, dass die laufenden Kosten für die Erreichung des Netto-Nullpunkts, die in der Schätzung von McKinseys nicht enthalten waren, nicht geringer sein werden als die Kapitalkosten. Die britische Netzbehörde schätzt, dass die Erreichung von Netto-Null bis 2050 allein für die Umgestaltung des Stromnetzes 3.000 Milliarden Dollar kosten würde.

Man muss auch die Kosten für die Installation einer ausreichenden Anzahl von Ladestationen für Elektrobuggys einkalkulieren, die den Strombedarf allein im Vereinigten Königreich um 70 % erhöhen würden. Und woher sollen das Nickel, Kobalt, Kupfer und Lithium für die Batterien kommen? Ach ja, aus Russland und China, deren Propagandisten die Fähigkeit des Westens zum rationalen Denken in dieser Frage seit Jahrzehnten untergraben. Putin lacht sich bereits ins Fäustchen, bis hin zur Moskauer Narodny Bank. Stellen Sie sich nun vor, wie viel mehr er und sein kommunistischer Seelenverwandter Xi Tsin-Ping zu lachen haben werden, wenn man sich die folgende Tatsache vor Augen hält: Wenn allein Großbritannien all seine echten Autos durch elektrische Buggys ersetzen würde, würden die Batterien das Doppelte der jährlichen Weltproduktion an Kobalt und fast die gesamte Lithiumproduktion verbrauchen. Wenn andere westliche Länder idiotischerweise eine ähnlich verrückte Politik verfolgen, wird der Preis für die seltenen Metalle, aus denen die Batterien der Buggys bestehen, zwangsläufig um eine weitere Größenordnung steigen. Wir wollen etwas Lithiumkarbonat in unserem Schuppen lagern und dann fünf Jahre warten, bevor wir als Milliardäre abkassieren.

Wenn man diese Tatsachen berücksichtigt und bedenkt, dass ECS nicht 3 K, sondern 1,1 K im mittleren Bereich liegt, könnte die tatsächliche Erwärmung, die durch jede Milliarde Dollar, die für die Verfolgung der Schimäre von Netto-Null-Emissionen ausgegeben wird, verringert wird, nur ein Fünfmillionstel bis ein Zehnmillionstel Grad betragen.

Selbst wenn wir tatsächlich mit der nahezu sicheren Tatsache eines ECS bei 3 oder 4 K konfrontiert wären, die sich die Klimatologen gewinnbringend vorstellen (und die laut Professor Lindzen selbst dann, wenn sie einträfe, netto harmlos wäre), ließe sich nicht vernünftig argumentieren, dass so hohe Ausgaben für solch infinitesimale Erträge in irgendeiner Weise zu rechtfertigen sind.

Unser Ergebnis zeigt jedoch, dass die Schlussfolgerungen der offiziellen Klimatologie, die auf den Ergebnissen von allgemeinen Zirkulationsmodellen beruhen, reine Vermutungen sind. Sie rechtfertigen in keiner Weise irgendwelche Maßnahmen zur Eindämmung der globalen Erwärmung.

Auf der Grundlage der impliziten Annahme der Klimatologie, dass die gesamte Rückkopplungsstärke, die in Watt pro Kelvin Referenztemperatur angegeben wird, die 1850 erreicht wurde, auch heute gilt, ist bewiesen, dass ECS nur in der Größenordnung von 1,1 K liegen wird. Die Kritiker, die uns eine falsche „Extrapolation“ vorwerfen, sollten ihre Bedenken daher nicht an uns, sondern an die offizielle Klimatologie richten.

Nimmt man die wissenschaftlichen und die wirtschaftlichen Argumente zusammen, so besteht die richtige politische Option darin, die linksextremen Kritiker zu ignorieren, die Subventionierung unzuverlässiger Energiequellen einzustellen, das IPCC aufzulösen, das UNFCCC abzuschaffen, die kostspieligen Konferenzen der Vertragsparteien zum Schweigen zu bringen, die Kohlekraftwerke am Laufen zu halten und das seit langem geplante und nun unmittelbar bevorstehende wirtschaftliche Harakiri des Westens zu beenden, das die Klimaaktivisten und ihre Hintermänner so lange und auf so unehrliche Weise gefördert haben.

—————————–

Übersetzt von Christian Freuer für das EIKE