Bestätigungsfehler ersetzt Wissenschaft: Wie ein Klimawissenschaftler 23 Zettajoule in Twitter-Fiktion verwandelte

[Alle Hervorhebungen im Original. A. d. Übers.]

Es gibt Fehler, und dann gibt es Fehler, die nur dann auftreten, wenn man die gewünschte Antwort bereits kennt.

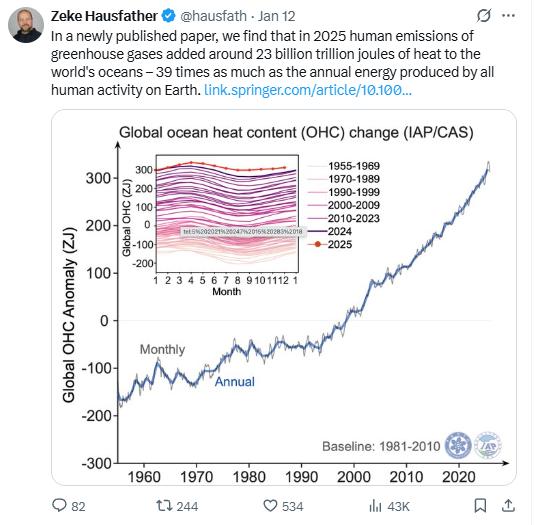

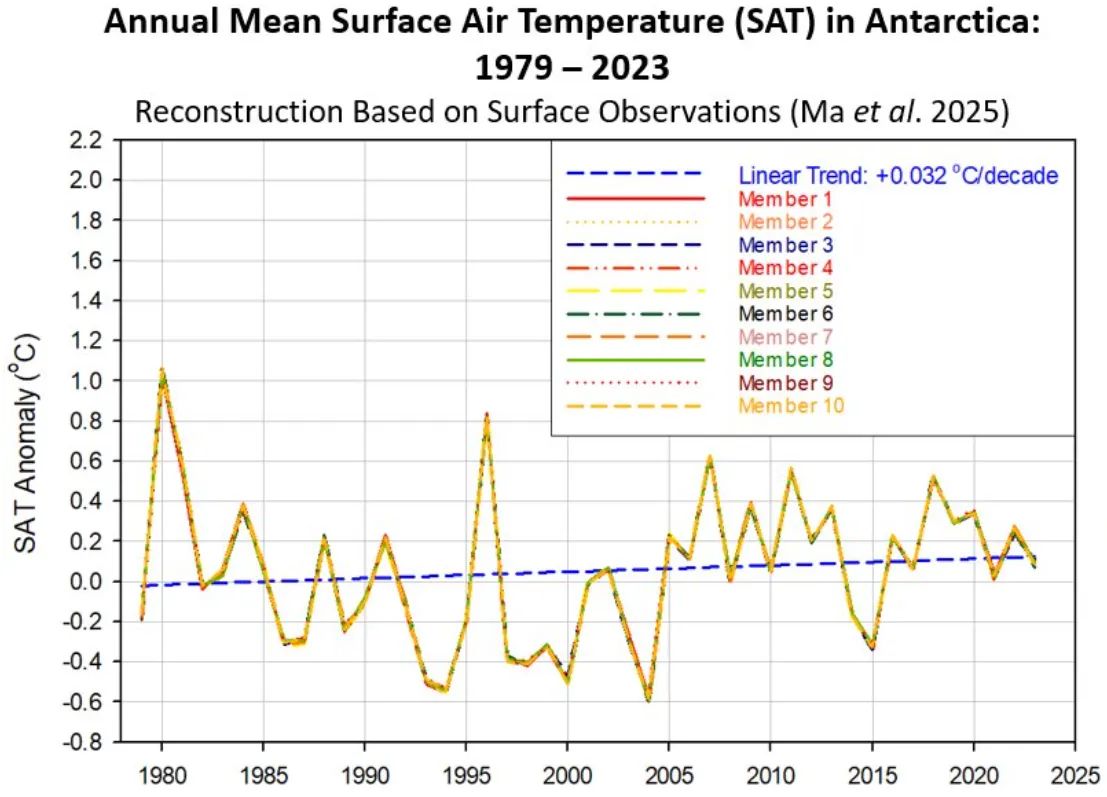

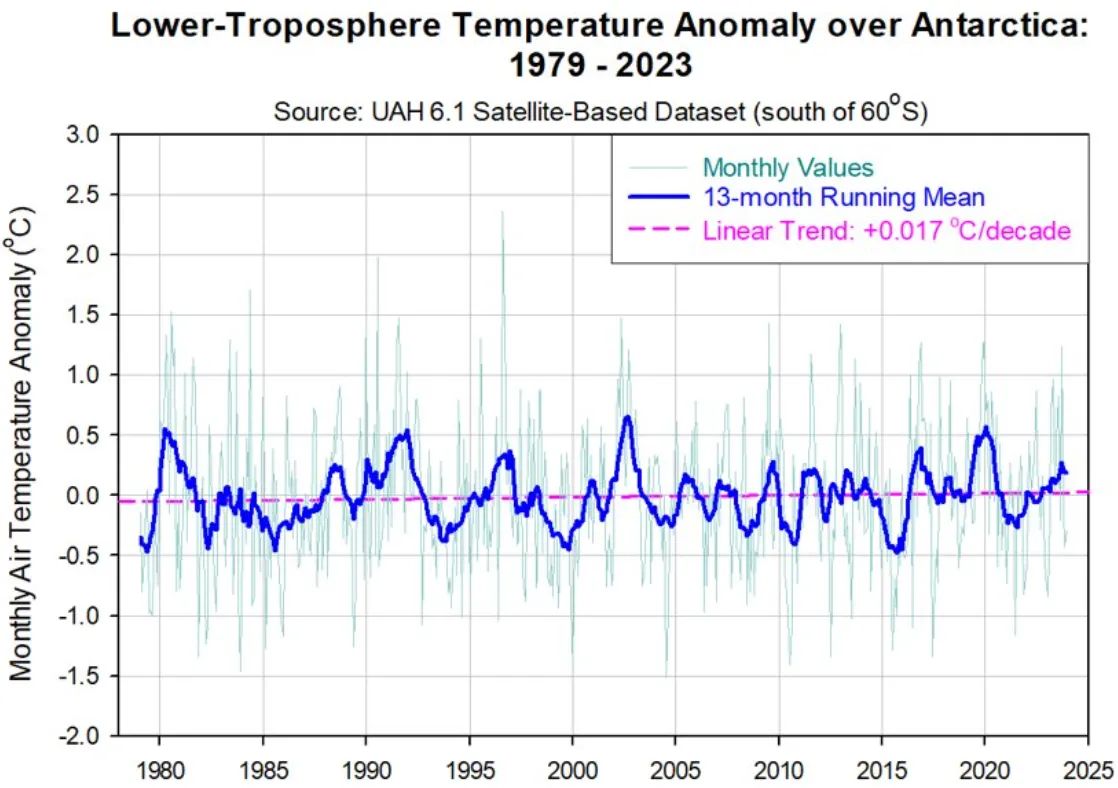

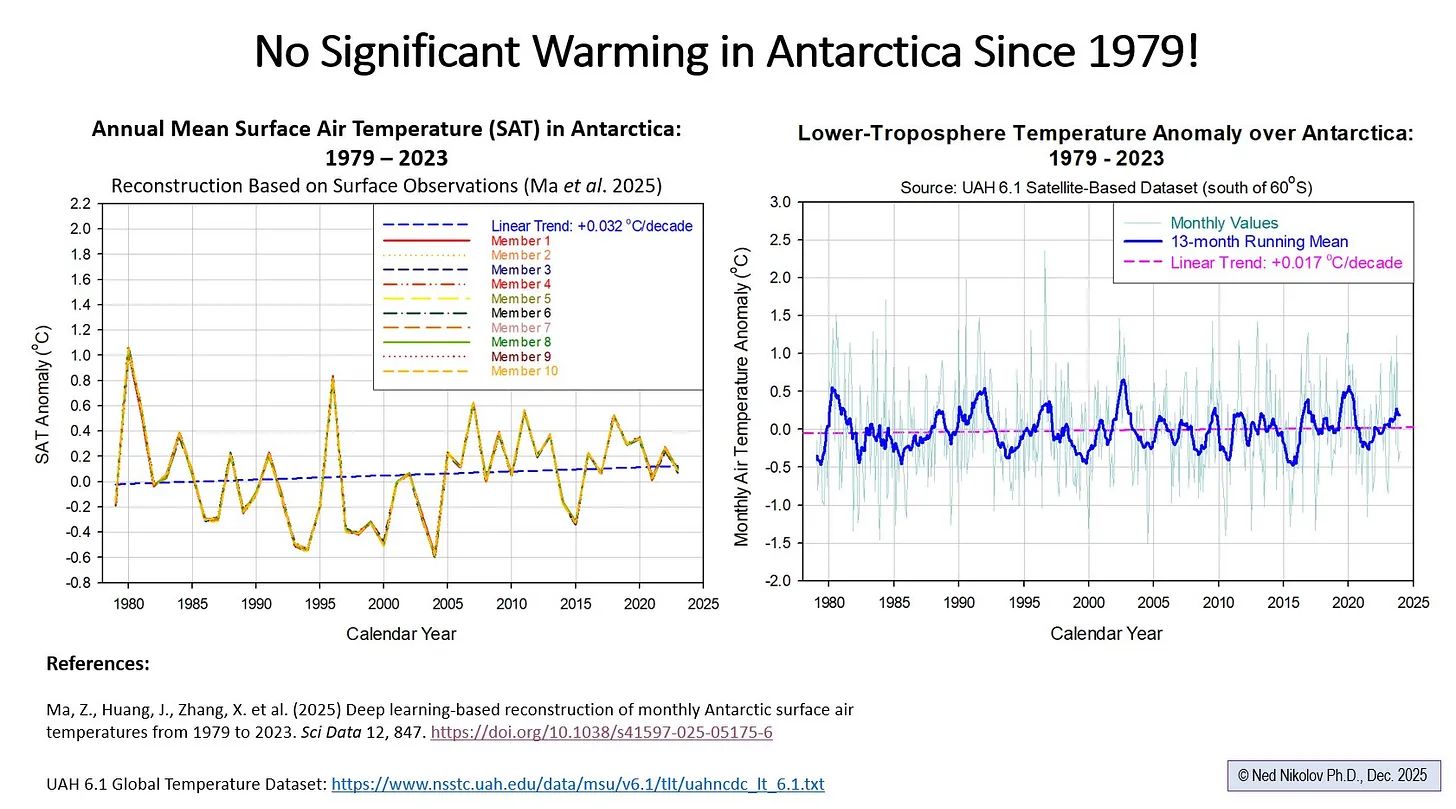

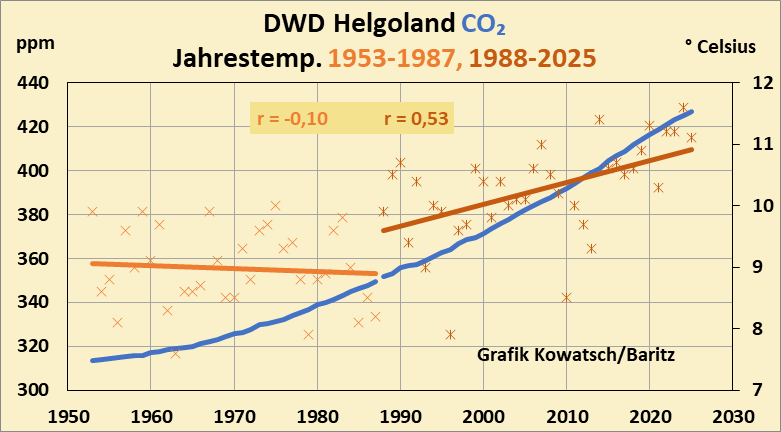

Die kürzlich veröffentlichte Studie „Ocean Heat Content Sets Another Record in 2025” (Der Wärmegehalt der Ozeane erreicht 2025 einen neuen Rekordwert) berichtet von einem jährlichen Anstieg des Wärmegehalts der oberen 2000 Meter der Ozeane um etwa 23 Zettajoule (ZJ), je nach Datensatz. Gut. Der Wärmegehalt der Ozeane (OHC) ist ein möglicher diagnostischer Messwert, und die meisten Menschen, die sich mit den Ozeanen beschäftigen glauben, dass sich die Ozeane seit dem Ende der Kleinen Eiszeit erwärmt haben. Wie wir jedoch kürzlich in dem WUWT-Beitrag „Measuring Climate Change Without a Ruler” (Klimawandel ohne Lineal messen) dargelegt haben, wissen wir aus streng erkenntnistheoretischer Sicht nicht mit hoher Sicherheit, ob die Gesamtenergie des Klimasystems der Erde zunimmt, abnimmt oder in etwa konstant bleibt.

Doch dann kam der Twitter/X-Beitrag – und hier verließ die Physik still und leise den Raum und machte Platz für die Konstruktion eines Narrativs.

Zeke Hausfather, einer der Mitautoren, verkündete triumphierend:

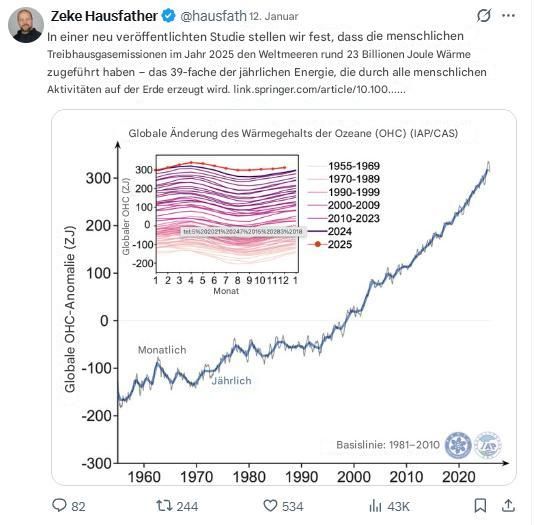

Diese Graphik in deutscher Übersetzung (Google translate):

Dies ist keine harmlose Vereinfachung. Es ist schlichtweg falsch – und zwar in einer Weise, die ein vermeintlich kompetenter „Klimawissenschaftler” unbedingt besser wissen müsste. Er führt die erhöhte Energiespeicherung ausschließlich auf eine einzige Variable zurück – Kohlendioxid. Das Klimasystem der Erde ist jedoch weitaus komplexer.

Was hier passiert ist, ist kein Rechenfehler. Es handelt sich um eine Bestätigungsverzerrung, schlicht und einfach: Man beginnt mit der Schlussfolgerung („Treibhausgase sind schuld”) und füllt dann die Interpretation nach, auch wenn dies gegen grundlegende Regeln der Energie-Bilanzierung verstößt.

Gehen wir das Ganze langsam durch, denn das ist offenbar notwendig:

Was in der Veröffentlichung tatsächlich steht (und was bewusst nicht erwähnt wird). Die Studie findet man hier.

Darin wird berichtet, dass der globale Wärmegehalt der oberen 2000 m des Ozeans von 2024 bis 2025 in einem Datensatz (IAP/CAS) um ~23 ± 8 ZJ gestiegen ist, wobei andere Datensätze geringere Anstiege verzeichnen.

Diese Zahl lautet:

• eine beobachtete Veränderung von Jahr zu Jahr

• eine Netto-Speicherperiode

• der Restwert aller Ereignisse, die sich in jenem Jahr auf das Klimasystem ausgewirkt haben

Es umfasst bereits:

• Treibhausgas-Antrieb (aus allen vorangegangenen Jahren, nicht nur aus dem Jahr 2025),

• Aerosolveränderungen,

• ENSO-Entwicklung (das Papier erwähnt ausdrücklich die La Niña-Entwicklung),

• Wärmeaustausch zwischen Atmosphäre und Ozean,

• interne Variabilität,

• Zirkulation und Vermischung

• und, ja, auch Messunsicherheiten.

Es handelt sich um die gesamte Bilanz, nicht um einen einzelnen Posten. An keiner Stelle der Studie werden folgende Berechnungen angestellt:

• Wärme aus Emissionen ab 2025,

• eine Aufteilung der OHC-Veränderung nach Einflussfaktoren

• oder eine Zuordnung, aus der hervorgeht, dass allein Treibhausgase für 23 ZJ verantwortlich sind.

Weil es das nicht kann – zumindest nicht anhand dieser Analyse.

Wie der großartige Steve McIntyre gerne sagt: „Beobachten Sie die Erbse unter dem Fingerhut.“

Hausfathers Tweet begeht einen klassischen Kategorienfehler.

Es braucht:

• eine Veränderung der gespeicherten Energie (ΔOHC, ein Bestand)

und benennt sie um in:

• durch die Emissionen dieses Jahres hinzugefügte Wärme (ein Fluss).

Das ist Klimawissenschaft für Anfänger. So etwas darf man nicht sagen. Nach dieser Logik könnte man genauso gut behaupten:

• „1998 verursachten CO₂-Emissionen El Niño“

• oder „2023 verursachten SUVs die Pazifische Dekadische Oszillation“.

Correlation plus narrative is not causation — especially when you skip the accounting.

Korrelation plus Erzählung ist keine Kausalität – insbesondere, wenn man die Bilanzierung außer Acht lässt.

Es handelt sich um einen grundlegenden Energieerhaltungstest (den der Tweet nicht besteht).

Nehmen wir die Behauptung einmal wörtlich.

Wenn „die menschlichen Emissionen im Jahr 2025 den Ozeanen 23 ZJ hinzugefügt haben”, dann muss eine der folgenden Aussagen wahr sein:

1. Alle anderen Prozesse, die die Meereswärme in diesem Jahr beeinflusst haben, haben netto keine Energie hinzugefügt, oder

2. Ein anderer Prozess hat eine gleich große und entgegengesetzte Wärmemenge entfernt – und wir können diese quantifizieren.

Beides wird nicht gezeigt. Beides wird nicht einmal versucht. Stattdessen ordnet der Tweet einfach 100 % des beobachteten Netto-Wärmegewinns einer bevorzugten Ursache zu. Das ist keine Zuordnung. Das ist kurzsichtige Erzählkunst. Ob er die kumulativen Emissionen im Laufe der Zeit meinte und sich nur ungeschickt ausgedrückt hat, oder ob er wirklich glaubt, dass der Anstieg des CO₂ all diese zusätzliche Wärme verursacht hat, ist unklar. Klar ist jedoch, dass ein Jahr mit erhöhten Emissionen nicht all diese zusätzliche OHC verursacht haben kann.

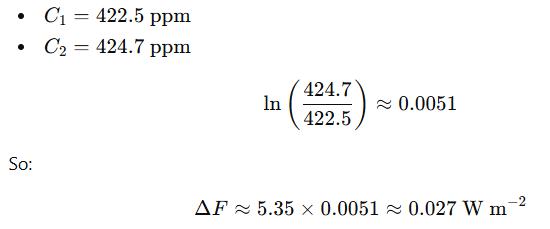

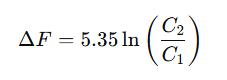

Hier ist das Problem der inkrementellen Antriebskraft mit der gezeigten Mathematik. Dies ist der Teil, der Zekes Behauptung vollständig widerlegt.

Das atmosphärische CO₂ stieg im Jahr 2025 um etwa 2–3 ppm (im Einklang mit den globalen CO₂-Durchschnittswerten).

Die Strahlungsantriebskraft von CO₂ wird üblicherweise wie folgt approximiert:

Nehmen wir einen repräsentativen Fall:

Das ist die in jenem Jahr zusätzlich hinzugekommene Erwärmung.

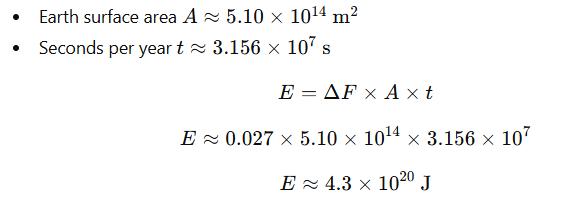

Rechnen wir nun diese Erwärmung in Energie über ein Jahr um:

Ergebnis:

- 0,43 Zettajoules (ZJ)

Und nicht 23 ZJ.

Das ist nicht einmal annähernd richtig, Zeke. Vielleicht sollte Zeke seine eigenen Wärmeeinheiten schaffen. Ich schlage Zekajoule vor – eine fiktive Einheit. Auf diese Weise liegt er nie falsch.

Selbst unter großzügigen Annahmen liegt der inkrementelle Effekt der Emissionen von 2025 deutlich unter 1 ZJ und nicht bei mehreren zehn ZJ. Das Klimasystem reagiert auf die kumulierte Antriebskraft aus Jahrzehnten von Emissionen, nicht auf den zusätzlichen Anstieg durch die Emissionen eines Jahres – genau deshalb ist es Unsinn so zu tun, als hätten „die Emissionen von 2025 23 ZJ hinzugefügt”.

Das ist der Unterschied zwischen Antriebskraft und Speicherung, und diese beiden Begriffe zu verwechseln, ist für einen professionellen „Klimawissenschaftler” unentschuldbar.

ENSO, Zekes unbequemer Elefant im Raum.

Die Studie selbst stellt fest, dass die sich entwickelnden La Niña-Bedingungen wahrscheinlich zur OHC-Veränderung im Jahr 2025 beigetragen haben. ENSO verteilt jährlich mehrere zehn Zettajoule Wärme zwischen den Ozeanschichten und der Atmosphäre um. Das ist unumstritten. So steht es in den Lehrbüchern. In Zekes Version der Ereignisse verschwindet ENSO jedoch auf mysteriöse Weise – weil es für die bevorzugte Erzählung unbequem ist. Das ist eine Bestätigungsverzerrung.

Warum das wichtig ist (und warum es angesprochen werden muss):

Zeke Hausfather ist kein beliebiger Blogger. Er wird regelmäßig als seriöser „Klimawissenschaftler” präsentiert und von den Medien als vertrauenswürdiger Experte zitiert. Das macht die Sache noch schlimmer, nicht besser.

Einem Doktoranden kann man seine Verwirrung noch nachsehen:

Beobachtete OHC-Veränderung durch Wärme, die auf die Emissionen eines bestimmten Jahres zurückzuführen ist.

Ein veröffentlichender „Klimawissenschaftler” sollte das nicht tun. Wenn ein Wissenschaftler zulässt, dass narrative Übereinstimmung die physikalische Bedeutung überlagert – insbesondere in der öffentlichen Kommunikation –, dann ist das keine „Vereinfachung für die Öffentlichkeit”. Das ist eine Senkung der Standards. Und es vermittelt Journalisten, politischen Entscheidungsträgern und der Öffentlichkeit fälschlicherweise, dass die Energiebilanzierung optional ist.

Das ist sie nicht. Aber das ist heutzutage die gängige Erzählung der „Klimawissenschaft”. Seufz.

Was Zeke hätte sagen sollen:

Hier ist eine Version seines Tweets, die technisch korrekt gewesen wäre und weder voreingenommene und mehrdeutige Formulierungen enthält noch die Schuld auf eine einzelne Klimavariable schiebt, die nur eine von vielen in einem komplexen Klimasystem ist:

„Der globale Wärmegehalt der oberen 2000 m des Ozeans stieg von 2024 bis 2025 um ~23 ZJ an, was das anhaltende langfristige planetarische Energieungleichgewicht sowie die jährlichen Schwankungen einschließlich der ENSO-Entwicklung reflektiert.

Das ist korrekt.

Das ist vertretbar.

Das erfordert keinen Missbrauch von Einheiten.

Aber das ergibt keinen guten viralen, beängstigenden Tweet, oder?

Der Öffentlichkeit wird gesagt, sie solle „der Wissenschaft vertrauen”. Aber Wissenschaft verdient nur dann Vertrauen, wenn Wissenschaftler:

• Definitionen respektieren,

• Erhaltungssätze respektieren

• und der Versuchung widerstehen, Diagnosen in Propaganda zu verwandeln.

Wenn ein „Klimawissenschaftler” eine vollkommen gültige Beobachtungszahl nimmt und sie als „durch Emissionen hinzugefügte Wärme” umformuliert – ohne die Zuordnung vorzunehmen – dann ist das keine Wissenschaftskommunikation.

Das ist eine Bias-Bestätigung mit Doktortitel.

Und Nicht-Doktoren wie ich, die diese Unsinn satt haben, bemerken das.

Übersetzt von Christian Freuer für das EIKE