Trends der Lufttemperatur: Klimamodelle vs. Messungen

Roy W. Spencer, Ph. D.

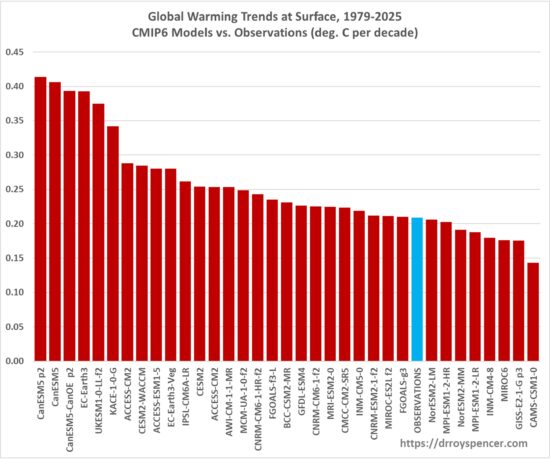

Dies ist nur eine kurze Aktualisierung darüber, wie sich die Trends der globalen Temperatur (Tsfc) in 34 CMIP6-Klimamodellen bis 2025 entwickeln. Die folgende Grafik zeigt die Tsfc-Trends von 1979 bis 2025, gereiht von den wärmsten bis zu den kühlsten.

„Beobachtungen” ist ein Durchschnitt aus vier Datensätzen: HadCRUT5, NOAAGlobalTemp Version 6 (jetzt natürlich mit KI), ERA5 (ein Reanalyse-Datensatz) und dem Berkeley 1×1-Grad-Datensatz, der einen mit HadCRUT5 identischen Trend ergibt (+0,205 °C/Jahrzehnt).

Ich betrachte Reanalysen als Teil der Kategorie „Beobachtungen“, da sie in gewisser Weise mit den Messungen übereinstimmen müssen, die von der Oberfläche, Wetterballons, globalen Verkehrsflugzeugen, Satelliten und der Küchenspüle aus vorgenommen werden.

Die Beobachtungen sind seit meiner letzten Darstellung um einen Platz in der Rangliste nach oben gerückt, was hauptsächlich auf das ungewöhnlich warme Jahr 2024 zurückzuführen ist.

———————————

Dazu postet der Autor diese Ergänzung:

Temperaturtrends in den Tropen 1979-2025: Das epische Scheitern der Klimamodelle setzt sich fort!

Roy W. Spencer, Ph. D. from his Global Warming Blog

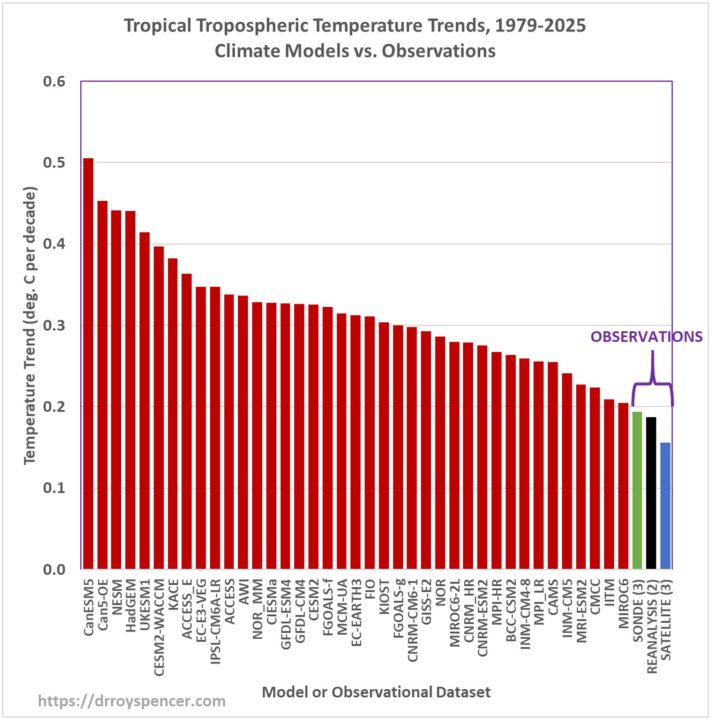

Als Fortsetzung meines letzten Beitrags über globale Trends der Temperatur (1979–2025) und deren Vergleich mit Klimamodellen folgt hier eine Aktualisierung eines ähnlichen Vergleichs für Trends der tropischen Troposphärentemperatur, basierend auf Tabellen von John Christy. Dies ist auch eine Aktualisierung meines beliebten Blogbeitrags „Epic Fail” aus dem Jahr 2013.

Wie die meisten von Ihnen wissen, deuten Klimamodelle darauf hin, dass die stärkste Erwärmungsreaktion des Klimasystems auf steigende anthropogene Treibhausgasemissionen (hauptsächlich CO₂ aus der Verbrennung fossiler Treibstoffe) in der tropischen oberen Troposphäre stattfindet. Dies führt zu dem vom Modell vorhergesagten „tropischen Hotspot”.

Zwar stellen die Ozeane während der Erwärmung das größte Reservoir für die Speicherung von Wärmeenergie im Klimasystem dar, doch ist dieses Signal äußerst gering (einige Hundertstel Grad Celsius pro Jahrzehnt) und daher aus beobachtender Sicht mit einer relativ großen Unsicherheit behaftet. Im Gegensatz dazu weist die tropische obere Troposphäre in Klimamodellen die größte Temperaturreaktion auf (bis zu 0,5 °C pro Jahrzehnt).

Dies zeigt die folgende Grafik der dekadischen Temperaturtrends aus 39 Klimamodellen (rote Balken) im Vergleich zu Beobachtungen, die mit Radiosonden (Wetterballons), Satelliten und globalen Datenreanalysen gesammelt wurden (die alle verfügbaren meteorologischen Daten verwenden):

Der Sonden-Trendbalken im obigen Diagramm (grün) ist der Durchschnitt von 3 Datensätzen (die Radiosondenabdeckung der Tropen ist sehr spärlich); der Reanalyse-Trend (schwarz) stammt aus 2 Datensätzen, und der Satelliten-Trend (blau) ist der Durchschnitt von 3 Datensätzen. Von allen Arten von Beobachtungsdaten bieten nur die Satelliten eine vollständige Abdeckung der Tropen.

Erstaunlicherweise zeigen alle 39 Klimamodelle größere Erwärmungstrends als alle drei Klassen von Beobachtungsdaten.

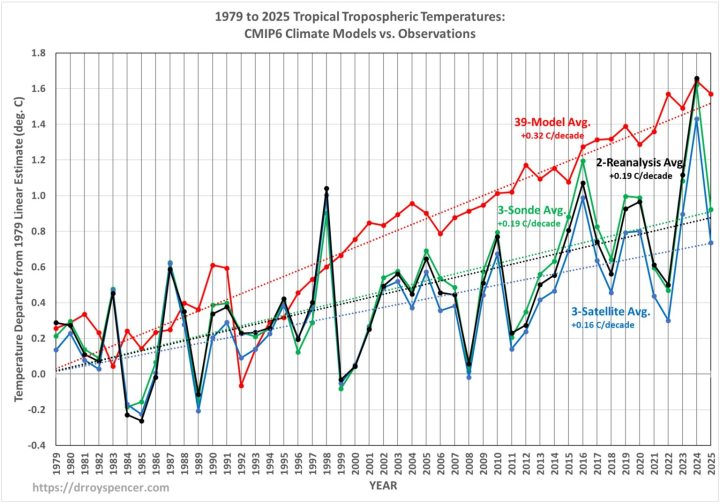

Zeitreihen 1979–2025

Wenn wir die durchschnittliche Erwärmung des Modells mit den Beobachtungen in einzelnen Jahren vergleichen, erhalten wir die folgenden Zeitreihen (beachten Sie, dass vollständige Reanalyse-Daten für 2025 noch nicht verfügbar sind); die Farbcodierung bleibt die gleiche wie in der vorherigen Grafik:

Das ungewöhnlich warme Jahr 2024 sticht besonders hervor (wahrscheinlich aufgrund einer geringeren Wolkendecke, die mehr Sonnenlicht durchlässt), aber im Jahr 2025 zeigen die Satelliten und Radiosonden eine „Rückkehr zum Trend“. Was in Zukunft passieren wird, kann natürlich niemand vorhersagen.

„Na und? Niemand lebt in der tropischen Troposphäre!“

Was könnte diese Diskrepanzen erklären, nicht nur zwischen den Modellen und den Beobachtungen, sondern sogar zwischen den verschiedenen Modellen selbst? Und warum sollte uns das interessieren, da ohnehin niemand in der tropischen Troposphäre lebt?

Nun, das gleiche Argument lässt sich auch für die Tiefsee anführen (dort lebt auch niemand), doch viele Klimaforscher bezeichnen sie als das wichtigste „Barometer“ für das positive globale Energie-Ungleichgewicht des Klimasystems, das durch den Anstieg der Treibhausgase verursacht wird (und vielleicht auch durch natürliche Prozesse … wer weiß?).

Die übermäßige Erwärmung der tropischen Troposphäre hängt zweifellos mit Unzulänglichkeiten in der Art und Weise zusammen, wie die Modelle konvektive Umlagerungen in den Tropen behandeln, d. h. die organisierte Gewitteraktivität, die Wärme von der Oberfläche nach oben transportiert. Diese „hoch reichende Feucht-Konvektion” verteilt nicht nur Wärmeenergie, sondern auch Wolken und Wasserdampf, die beide einen tiefgreifenden Einfluss auf die Temperatur der tropischen Troposphäre haben. Während die Befeuchtung der untersten Schicht der Troposphäre als Reaktion auf die Erwärmung zweifellos zu einer positiven Wasserdampf-Rückkopplung beiträgt, bestimmt die Mikrophysik der Niederschläge, wie viel Wasserdampf sich im Rest der Troposphäre befindet, und wie wir vor fast 30 Jahren gezeigt haben, führt dies zu großen Unsicherheiten in der gesamten Wasserdampf-Rückkopplung.

Meine persönliche Meinung war schon immer, dass das Ausbleiben der tropischen Erwärmung darauf zurückzuführen ist, dass die positive Wasserdampf-Rückkopplung, die wichtigste positive Rückkopplung, welche die Erwärmung in Klimamodellen verstärkt, zu stark ist. Klimamodelle stützen diese Interpretation tatsächlich, ist doch seit langem bekannt, dass Modelle mit dem stärksten „Hotspot” in der oberen Troposphäre tendenziell die größte positive Wasserdampf-Rückkopplung aufweisen.

Werden Klimamodelle jemals „korrigiert” werden?

Ich finde es ironisch, dass Klimamodelle angeblich auf grundlegenden „physikalischen Prinzipien” basieren. Wenn das wahr wäre, hätten alle Modelle die gleiche Klimasensitivität gegenüber steigenden Treibhausgasen.

Das ist jedoch mitnichten der Fall.

Klimamodelle weisen hinsichtlich der Klimasensitivität eine Streuung um den Faktor drei auf, eine Diskrepanz, die seit über 30 Jahren in der Klimamodellierung besteht. Der Hauptgrund für diese Diskrepanz sind Unterschiede zwischen den Modellen hinsichtlich der Konvektionsprozesse (Wolken und Wasserdampf), die in den Modellen positive Rückkopplungen verursachen.

Wenn die Modellierer herausfinden würden, warum ihre Behandlung der Konvektion fehlerhaft ist, würden die Modelle vielleicht eine Erwärmung erzeugen, die besser mit den Beobachtungen übereinstimmt und auch untereinander besser übereinstimmen.

Ein Großteil der Panikmache in Bezug auf die globale Erwärmung geht auf wissenschaftliche Publikationen zurück, die (1) den Modellen, die die stärkste Erwärmung prognostizieren, und (2) den übertriebenen Treibhausgasanstiegen („SSP-Szenarien“) zugeneigt sind, von denen sie für die düstersten Klimaprognosen ausgehen. Diese Szenarien sind heute als übertrieben bekannt, verglichen mit den beobachteten globalen Treibhausgas-Emissionen (und dem Gutachter unseres DOE-Berichts, der diese Schlussfolgerung für falsch hielt, weil ich Landnutzungsänderungen nicht berücksichtigt habe – nein, ich habe Landnutzungsänderungen aus den SSP-Szenarien entfernt … es war ein Vergleich von Äpfeln mit Äpfeln).

Abschließend möchte ich nicht den Eindruck erwecken, dass ich gegen Klimamodelle bin. Das bin ich definitiv nicht. Ich bin nur der Meinung, dass die Modelle als Instrument zur Steuerung der Energiepolitik missbraucht wurden.

Übersetzt von Christian Freuer für das EIKE