Die Fact checking-Sendung der BBC stellt Klimafakten einmal mehr falsch dar

Chris Morrison, THE DAILY SCEPTIC

Die Statistik-Sendung „More or Less” der BBC ist eine der letzten noch hörenswerten Sendungen auf Radio 4 [vergleichbar mit dem Info-Radio bei uns. A. d. Übers.]. Sie versucht, die Daten hinter oft narrativ geprägten und politisierten Behauptungen sachlich zu analysieren. Außer natürlich, wenn es um den Klimawandel und Netto-Null geht. Hier scheint sie an die seltsame Sichtweise der BBC auf „gesicherte” wissenschaftliche Erkenntnisse gebunden zu sein, die Alarmisten und Aktivisten eine freie Sendekarte gibt, um eine Massen-Klimapsychose zu erzeugen. Ein typisches Beispiel dafür ist ein kürzlich ausgestrahltes, peinliches Interview mit der von Green Blob finanzierten Zuordnungs-Königin Professor Friederike Otto, in dem sie gefragt wird, „warum sie so wunderbar“ ist.

Moderator Tim Harford brachte den Ball ins Rollen mit der Bemerkung, dass das britische Wetter „geradezu seltsam” werde. Damit scheint er darauf anzuspielen, dass es manchmal sonnig, manchmal regnerisch sein kann – manchmal sogar am selben Tag. Diese Tatsachen mögen für jeden offensichtlich sein, der mehr als sechs Monate lang tapfer auf den Britischen Inseln gelebt hat. Otto war natürlich begeistert, den Guardianista-Begriff „seltsam“ aufzugreifen, und deutete an, dass einige Kollegen dies tatsächlich als „globale Verrücktheit“ bezeichnen. Insbesondere Kollegen, die wie sie selbst versuchen, die chaotische Atmosphäre mit Computermodellen zu interpretieren, die pseudowissenschaftlichen, für Rechtsstreitigkeiten geeigneten Klimawandel-Unsinn produzieren, könnte man sagen.

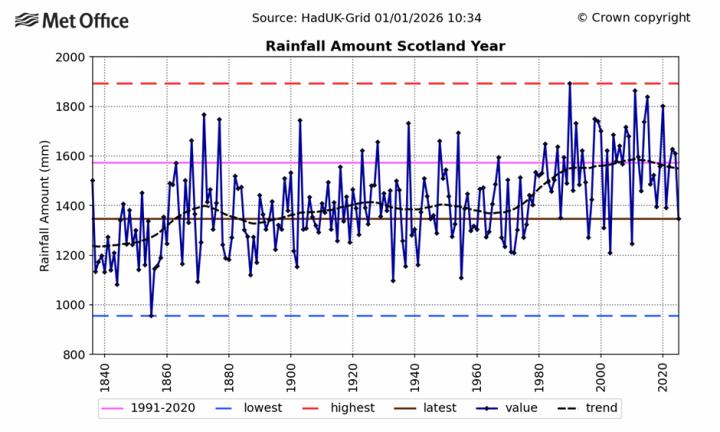

Es wurde kein Versuch unternommen, Ottos unsinnige Behauptung in Frage zu stellen, dass „es jetzt jedes Mal, wenn es regnet, mehr regnet, als es ohne den Klimawandel der Fall wäre”. Nicht in Schottland, hätte Harford anmerken können, dem regenreichsten Land von UK. Wie die Grafik des Met Office unten zeigt, ist die Niederschlagsmenge in Schottland seit etwa 40 Jahren unverändert geblieben:

In Nordirland bleibt die Linie seit 25 Jahren stabil, während sich die zyklischen Niederschlagsmengen in England wieder auf das Niveau der 1870er Jahre erholt haben. Harford wies nicht darauf hin, dass es in diesen Fällen kaum Anzeichen dafür gibt, dass Menschen das Wetter beeinflussen.

Auf globaler Ebene scheinen sich die Niederschlagsmengen nicht wesentlich verändert zu haben. Eine kürzlich veröffentlichte Studie hat ergeben, dass sich die Niederschlagsmenge im Amazonasgebiet in den letzten 300 Jahren insgesamt kaum verändert hat. Im Jahr 2022 hat eine Gruppe italienischer Wissenschaftler unter der Leitung von Professor Gianluca Alimonti allgemein zugängliche Daten ausgewertet und festgestellt, dass die Niederschlagsintensität und -häufigkeit weltweit unverändert geblieben sind und keinerlei Anzeichen für einen signifikanten Anstieg des Ausmaßes von Überschwemmungen vorliegen.

Die Alimonti-Ergebnisse wurden schließlich von Nature zurückgezogen, nachdem eine Bande von Aktivisten – darunter, wie nicht anders zu erwarten, F. Otto – erklärte, dass sie niemals hätten veröffentlicht werden dürfen. Otto behauptete, dass die Wissenschaftler nicht in „gutem Glauben“ gehandelt hätten und „wenn die Zeitschrift sich für die Wissenschaft einsetzt, sollte sie den Artikel lautstark und öffentlich zurückziehen und erklären, dass er niemals hätte veröffentlicht werden dürfen“. Diese berüchtigte, zurückgezogene Arbeit enthält zahlreiche Statistiken, darunter auch solche des IPCC, einer voreingenommenen Einrichtung, die jedoch derzeit kaum Veränderungen bei den meisten extremen Wetterereignissen beobachtet. Aber offenbar interessiert keine dieser Statistiken in irgendeiner Weise.

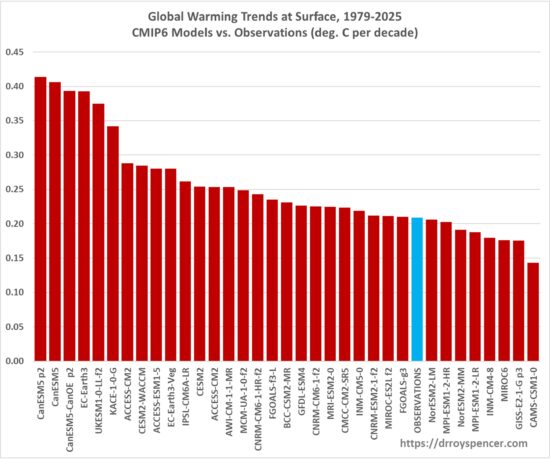

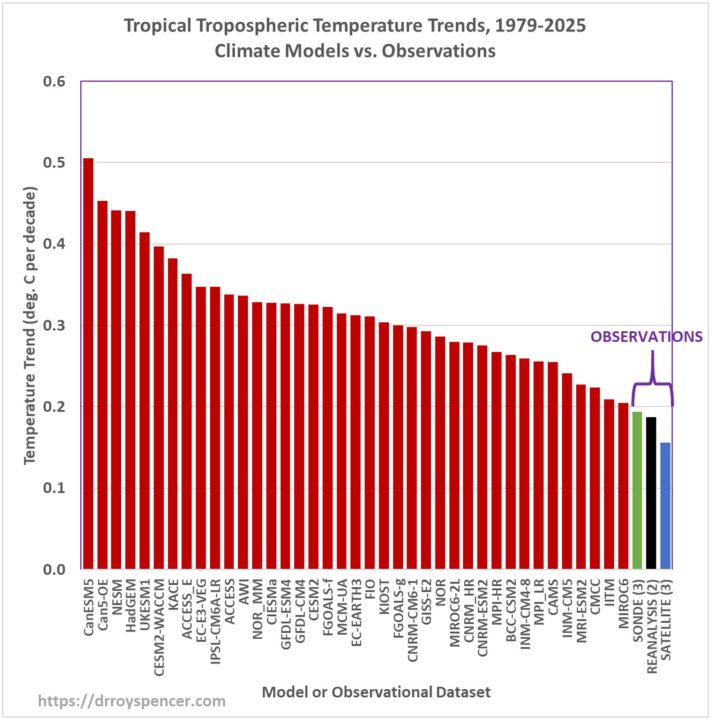

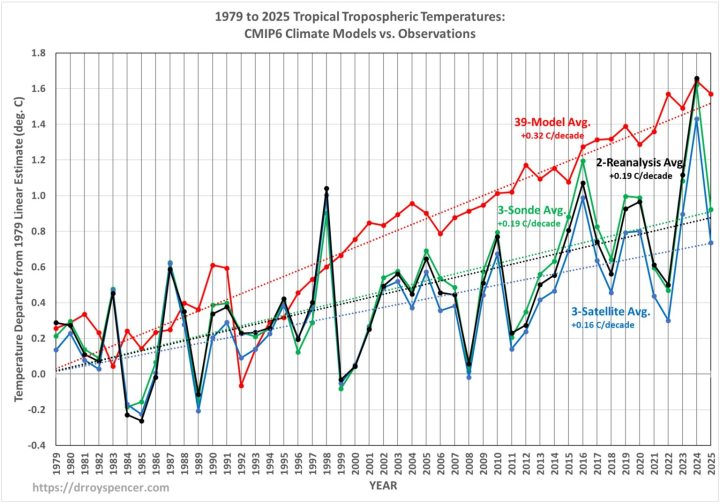

Die globalen Temperaturen sind seit der vorindustriellen Zeit um 1,6 °C gestiegen, erklärte Otto. Diese Behauptung scheint sich auf einen aktuellen Höchstwert zu stützen, der derzeit rapide sinkt, auf unzuverlässige Temperaturmessungen und offenbar auf eine zusätzliche Erhöhung, um auf Nummer sicher zu gehen. Selbst das britische Met Office – eine Hochburg der Aktivisten für die Netto-Null-Phantasterei – schätzt, dass die langfristige Erwärmung über Jahrzehnte hinweg durchschnittlich bei etwa 1,3 °C liegt. Tatsächlich bedeuten unnatürliche städtische Wärme-Verzerrungen und regelmäßige rückwirkende Erwärmungszuschläge wahrscheinlich, dass die tatsächliche Zahl eher bei 1 °C liegt. So sehr sich das Met Office auch bemüht, es kommt nicht annähernd auf 1,6 °C. Sein fantasievoller 20-Jahres-Durchschnitt von 2015 bis 2034, der einen starken El-Niño-Anstieg im Jahr 2015 herausgreift und Temperaturwerte für das nächste Jahrzehnt schätzt/erfindet, kommt nur auf eine Erwärmung von 1,4 °C.

Vielleicht kann man sich eines Tages dazu durchringen, sich mit dem beweglichen Feld der globalen Temperaturberechnung zu befassen. Viel Glück dabei – in diesem speziellen Bereich der Klimawissenschaft gibt es mehr Manipulationen als bei der „Come all ye Fiddlers Night” im Fiddlers Arms in Fiddlington-on-Sea.

Man hat in der Vergangenheit bereits Aktivisten ehrfürchtig zugehört, die Daten selektiv auswählen, um eine bestimmte Erzählung zu verbreiten. Im Jahr 2024 wurde in einer kurzen Ausgabe des World Service auf den Bericht im Daily Sceptic hingewiesen, wonach das Meereis in der Arktis habe am 8. Januar dieses Jahres den höchsten Stand seit 21 Jahren erreicht. Es wurde der Vorwurf der „selektiven Auswahl” erhoben, obwohl der Rest des Artikels die kurz- und langfristigen Trends betrachtete. Die BBC konsultierte Professor Julienne Stroeve, eine „Erdwissenschaftlerin” von der UCL, die feststellte, dass der langfristige Rückgang seit 1979 leicht zu erkennen sei. Ebenso leicht zu erkennen war die Stagnation der Meereisausdehnung in den letzten 20 Jahren. Tatsächlich war der Trend in den letzten Jahren, gemessen am Vierjahresdurchschnitt, leicht steigend. Perish berichtete, dass 1979 ein offensichtlicher zyklischer Höchststand war, mit weniger Meereis in den Jahrzehnten zuvor. All dies zu ignorieren oder herunterzuspielen, spielt einer beliebten Erzählung in die Hände, die von Al Gore bis David Attenborough von allen verbreitet wird, nämlich dass das sommerliche Meereis in den nördlichen Polarregionen bald verschwinden wird.

Falls man sich in die politisch heiklen Gewässer der Klimawissenschaft wagen will, muss man sich verbessern, alle Daten untersuchen und aufhören, denen, die offensichtlich eine Netto-Null-Fantasievorstellung propagieren wollen, einen leichten, unhinterfragten Weg zu ebnen.

Chris Morrison is the Daily Sceptic’s Environment Editor. Follow him on X.

Übersetzt von Christian Freuer für das EIKE