Helmut Kuntz

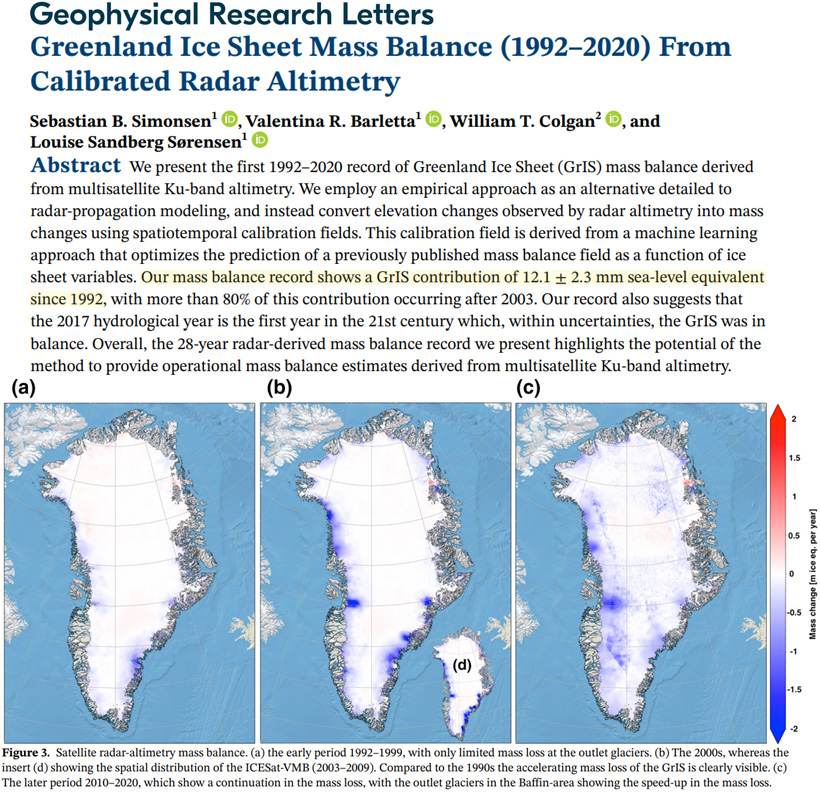

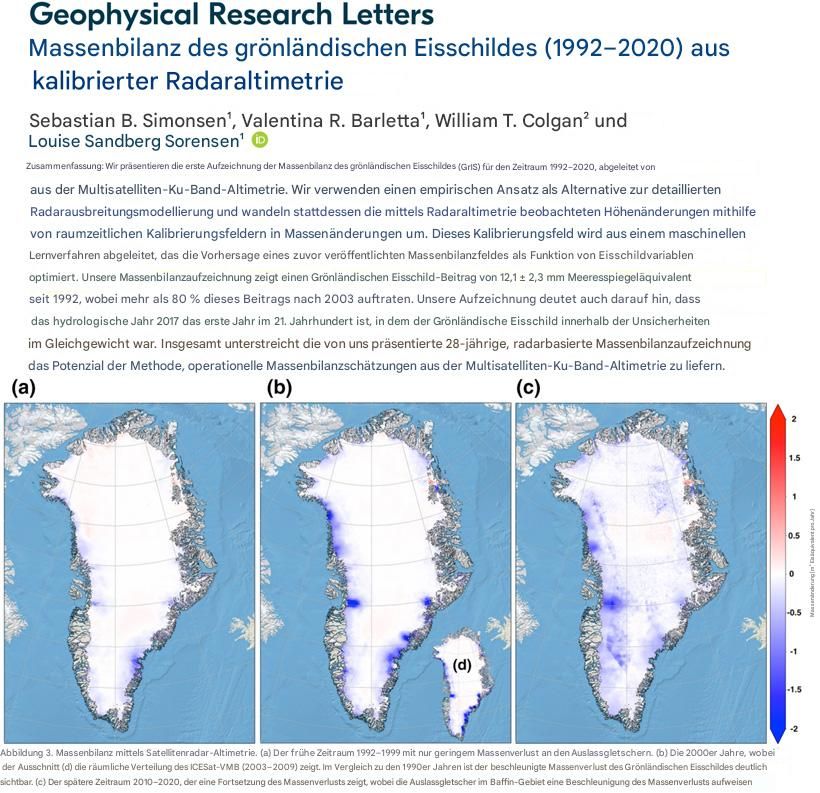

Im Januar des vergangenen Jahres ereignete sich in Kalifornien ein verheerendes Buschfeuer. Wie inzwischen unisono üblich, wurde dieses Ereignis dem zunehmenden, schlimmen Klimawandel zugeschrieben. Um zu zeigen, wie solche Zuordnungen durchgeführt werden und wie hemmungslos man die Daten dafür „zurechtbiegt“, anbei (wieder) etwas Information dazu.

Dieser Teil Kaliforniens brennt regelmässig…

…aber wegen des Klimawandels immer schlimmer:

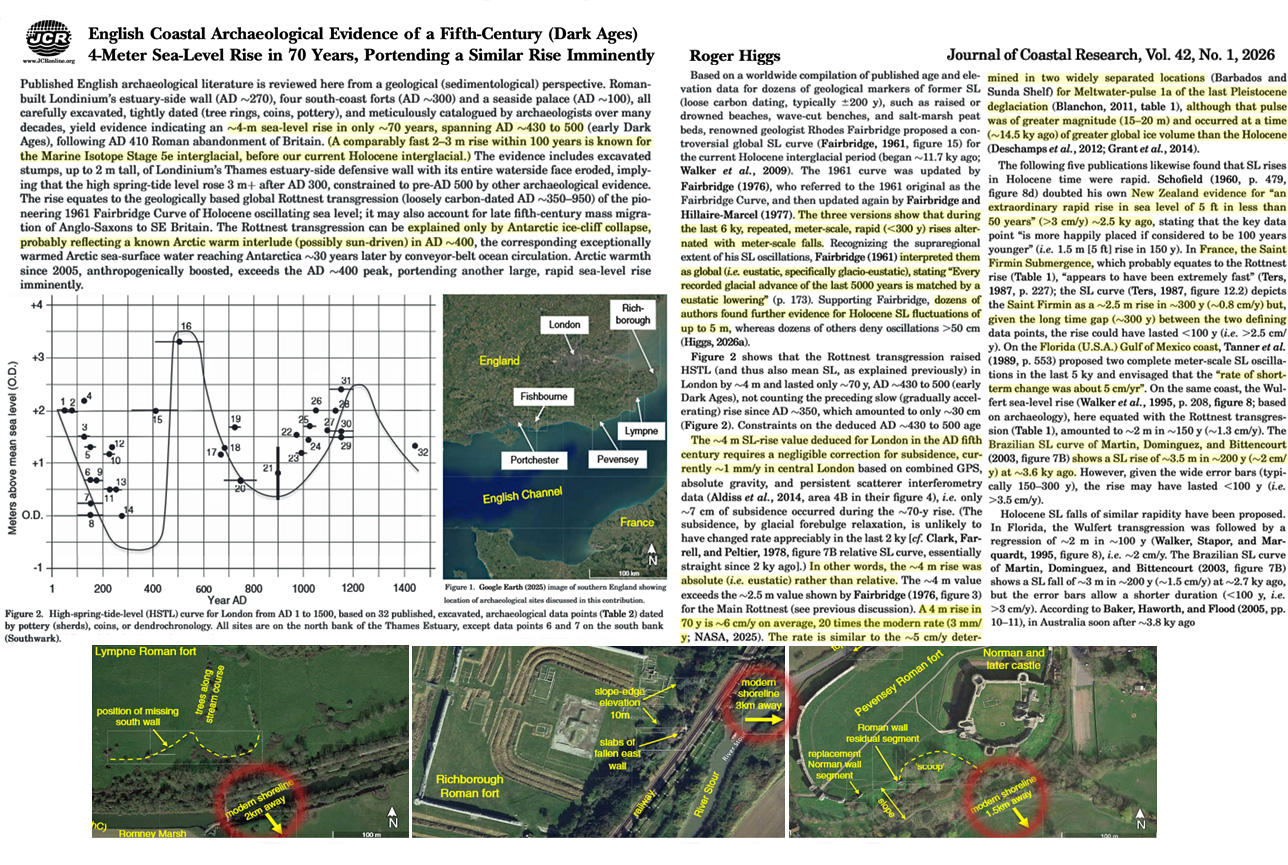

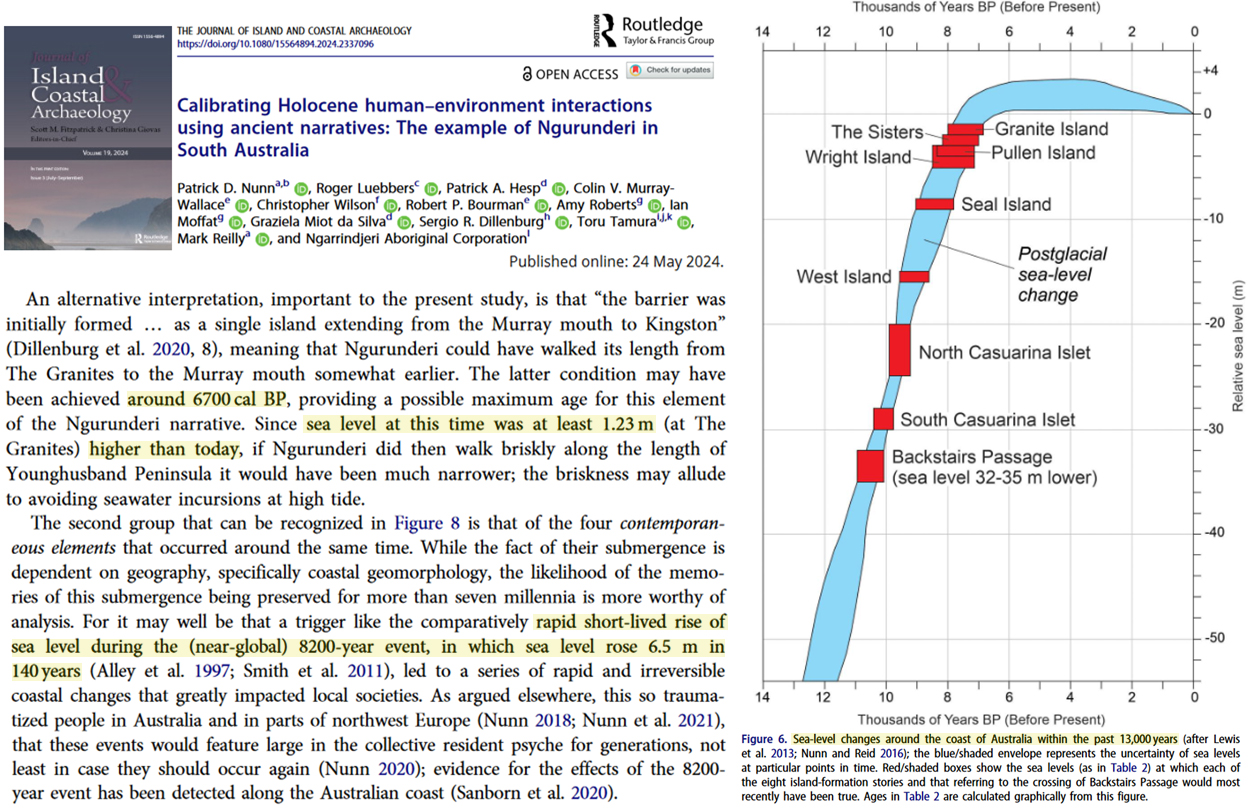

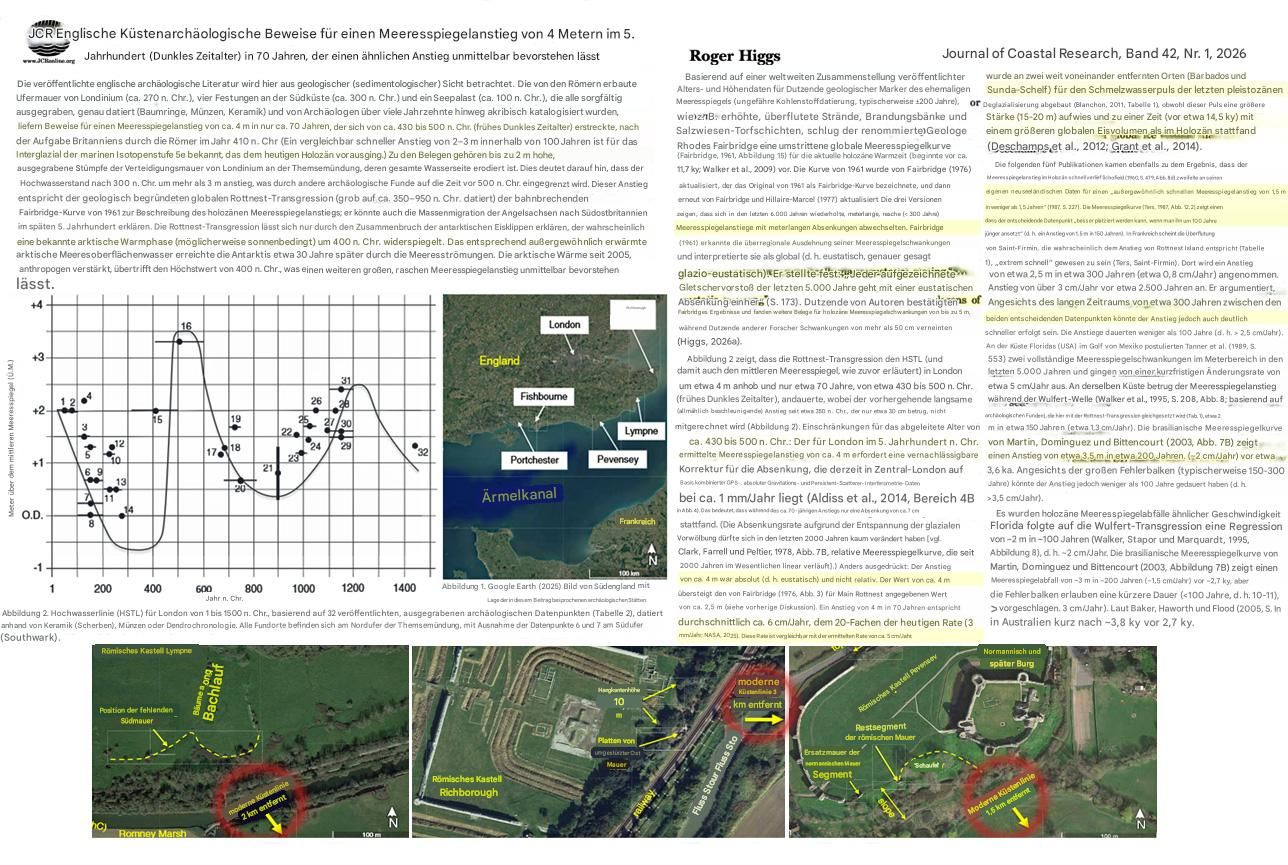

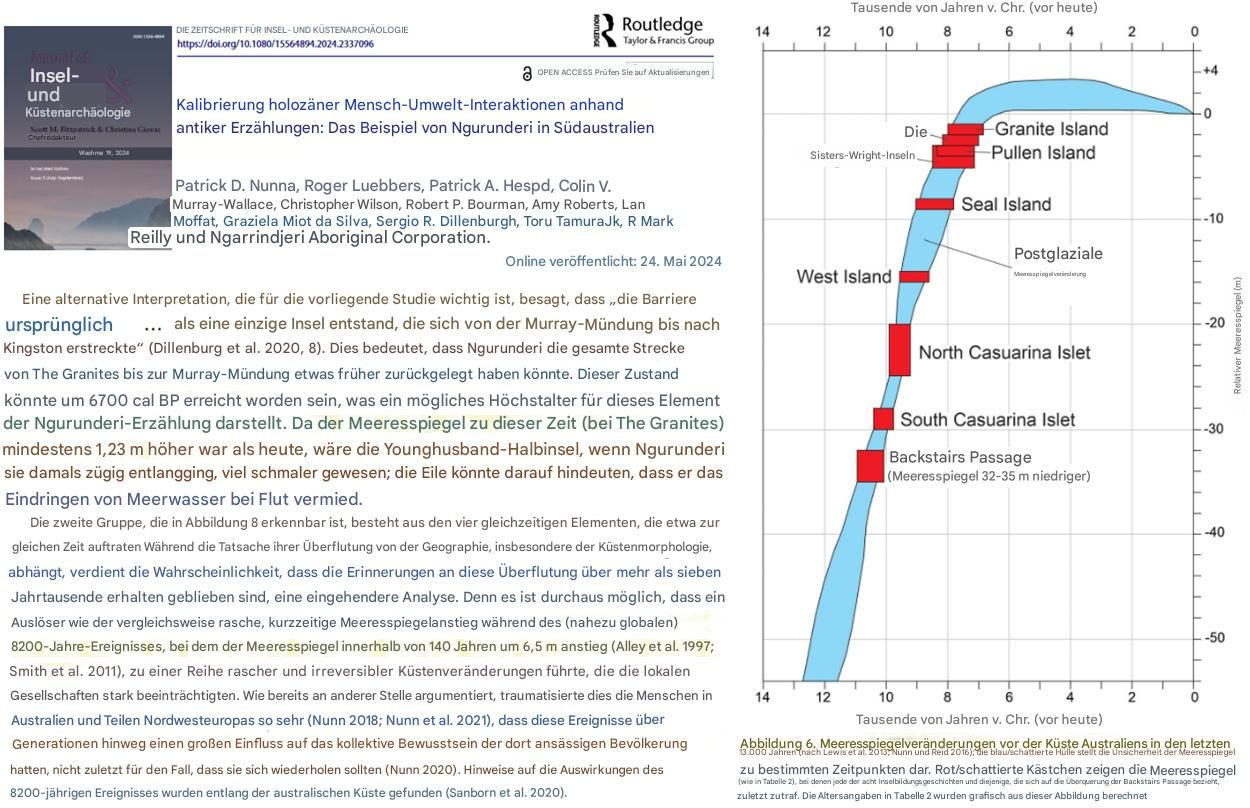

Bild 1

Bild 2

Inzwischen ist bekannt geworden, dass in Kalifornien schlimmste Behördenversäumnisse (massive Besiedlung extrem gefährdeter Zonen, bis zu leeren Löschwasserspeichern und Reduzierung der Feuerwehr, Verbot einer feuerreduzierenden Waldbewirtschaftung, Funken-schlagende (nicht abgeschaltete) Strom-Freileitungen und auch geradezu irre Brandstiftung (Abbrennen von Feuerwerkskörpern und Lagerfeuer im Buschland) vorlagen.

Eine zusätzliche Ironie der Klimageschichte ist, dass ausgerechnet das gewünschte Klima die dortigen Buschfeuer begünstigt (hat). Es hat dort die letzten Jahre verstärkt geregnet und damit die Vegetation gefördert. Sofern man diese nicht entfernt (was man dort wegen GRÜNer Vorgaben nicht darf) ist es genau dies, was die Auswirkungen von Buschfeuern zusätzlich verstärkt:

Bild 3

Bild 4

Wie aber auch bei uns, Beispiel Ahrtalflut oder die Flut in Valenzia, weisen Behörden Versäumnisse, gar so etwas wie Schuld, erst einmal vehement von sich und verweisen als „Beleg“ auf den Klimawandel.

Wie schlimm wütet der Klimawandel

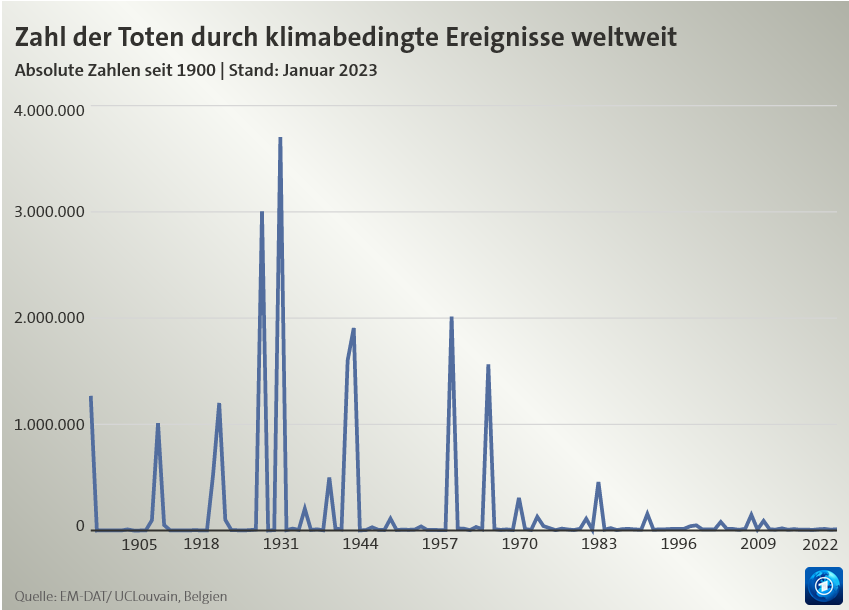

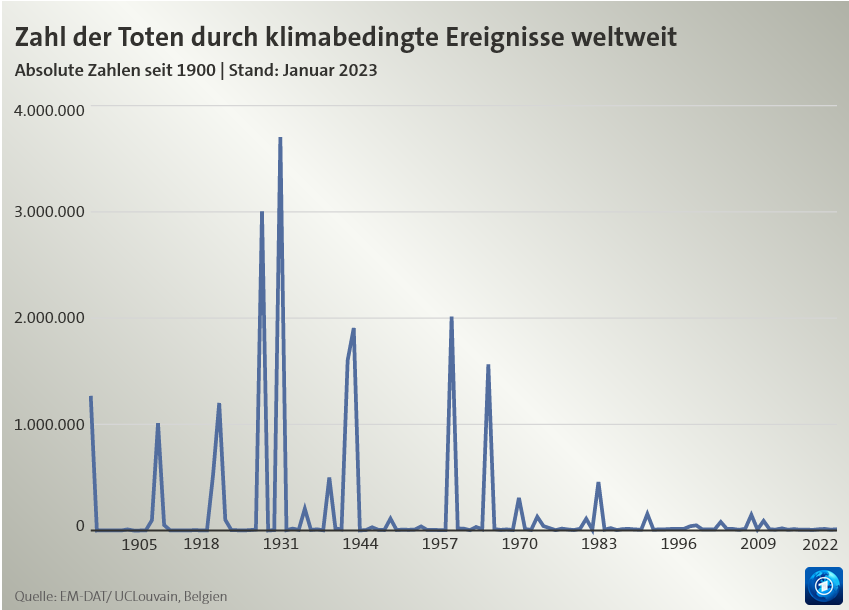

Anbei eine Grafik (Bild 5), welche das „schlimme Wüten“ des Klimawandels visualisiert.

Nicht unerwähnt soll bleiben, dass diese Grafik höchst umstritten ist, aber trotzdem allgemein verwendet wird. Bei der Kritik tut sich vor allem das Potsdamer PIK („Fließbandfertiger für Klimahysterie“) hervor, ohne jedoch alternativ eine „richtigere“ Darstellung zu liefern.

Bild 5 Anm.: Die Grafik zeigt 10jahres-Mittelwerte. Datenquelle: EM-DAT. Hinweis: Den Extremwert von 1931 verursachten Fluten in China

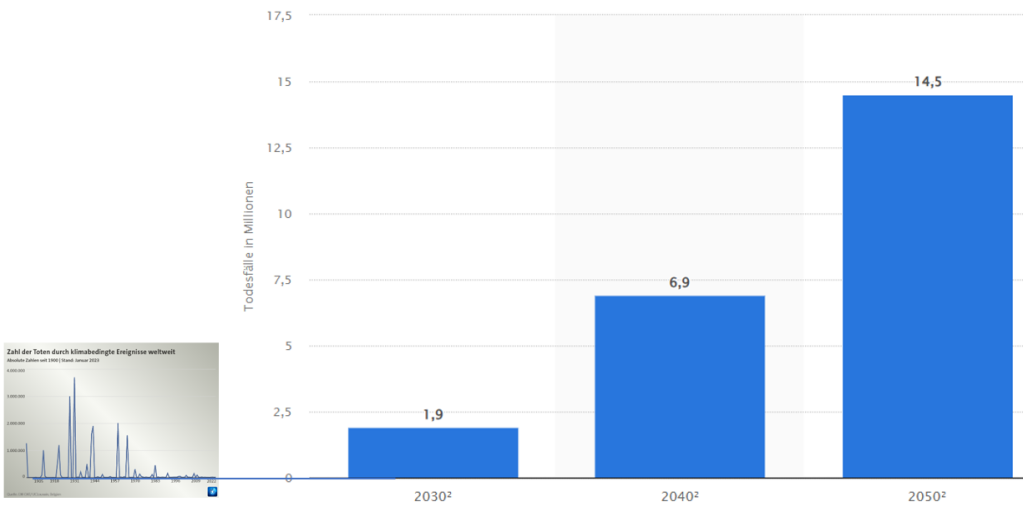

„Spasseshalber“ diese Darstellung erweitert um eine Vorschau bis zum Jahr 2050:

Bild 5.1 Vom Autor um eine Zukunftsprojektion der Klimawandelopfer im gleichen Maßstab (Quelle: statista) ergänztes Bild 5.

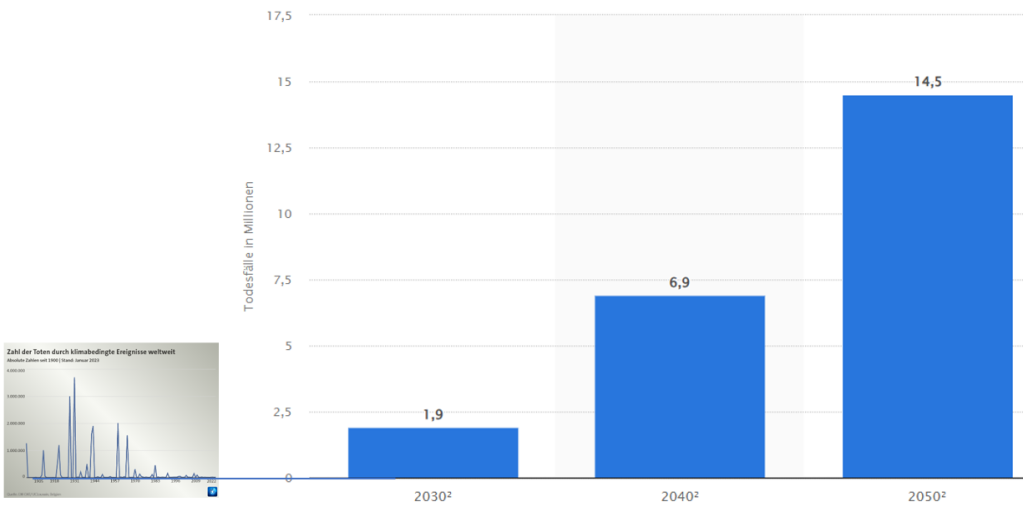

Nun zeigen die Bilder 5 und 5.1 absolute Zahlen.

Relativiert man die Absolutwerte (und glaubt den Angaben von Statista), so hat der von statista im Jahrzehnt 2050 projizierte Mortalitätswert von innerhalb einem Jahrzehnt 14,5 Millionen am „Klimawandel“ Verstorbenen weltweit einen Anteil an der sonstigen Mortalität von weniger als 2 %. Man beachte aber, dass dies ein Absolutwert ist, der auch die „Opfer“, welche ohne den Klimawandel versterben werden, beinhaltet.

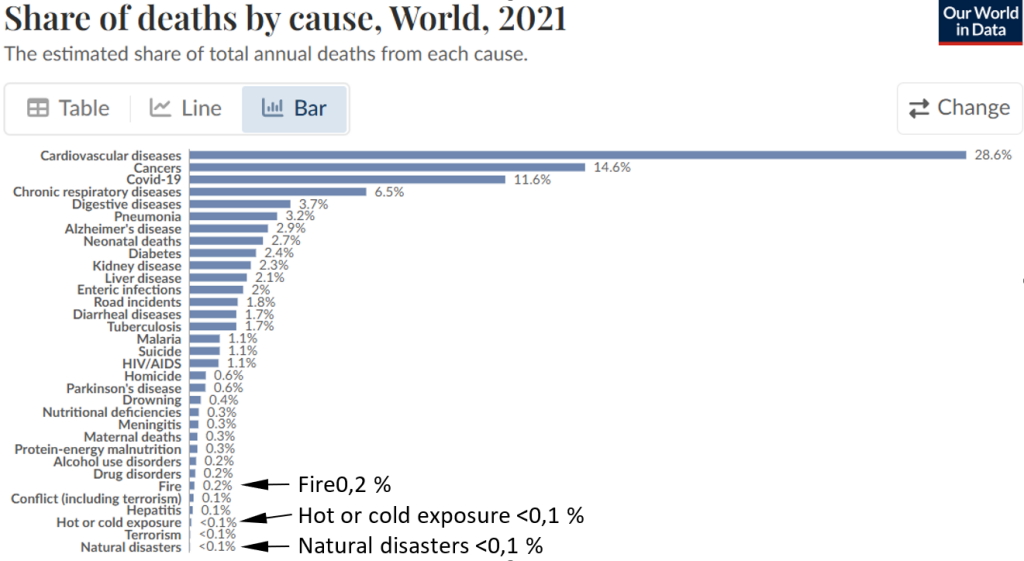

Eine andere Darstellung (Bild 5.2), allerdings auf Einzeljahre bezogen, zeigt einen „Klimamortalitätsanteil“ der im Jahr 2021 insgesamt Verstorbenen von kleiner 0,4 %. Berücksichtigt man, dass es solche Wettermortalitäten schon immer gab, also nur eine Steigerung dem ominösen Klimawandel zugeschrieben werden darf, dann kommt man bestimmt auf anteilige unter 0,2 … 0,1 % und „degradiert“ das „Klimawandelproblem“ damit auf das, was es ist, ein reines Nebenthema.

Noch niedriger werden die Mortalitätsanteile, wenn man beachtet, dass die Kältemortalität zwischen 5 … 10 Mal höher ist, als die durch Wärme, bedeutet, dass mehr Wärme insgesamt zu wesentlich weniger „Hot or cold exposure“ führt.

Bild 5.2 Anteile von Todesursachen im Jahr 2021. Vom Autor ergänzt

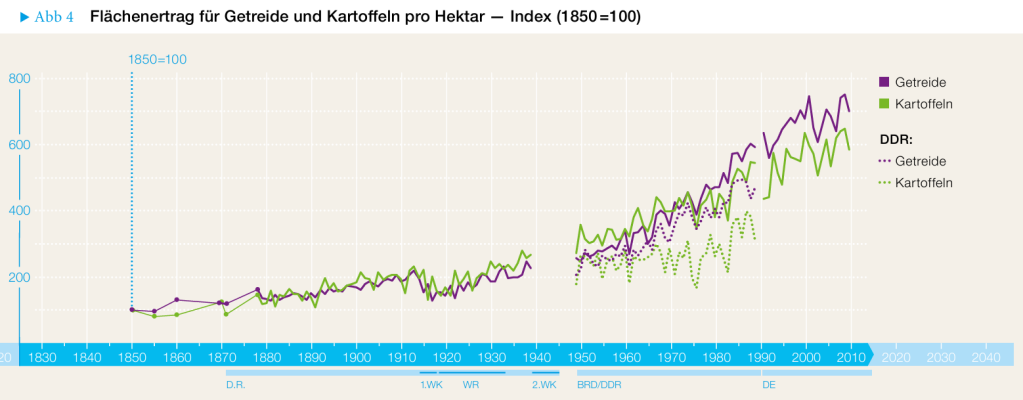

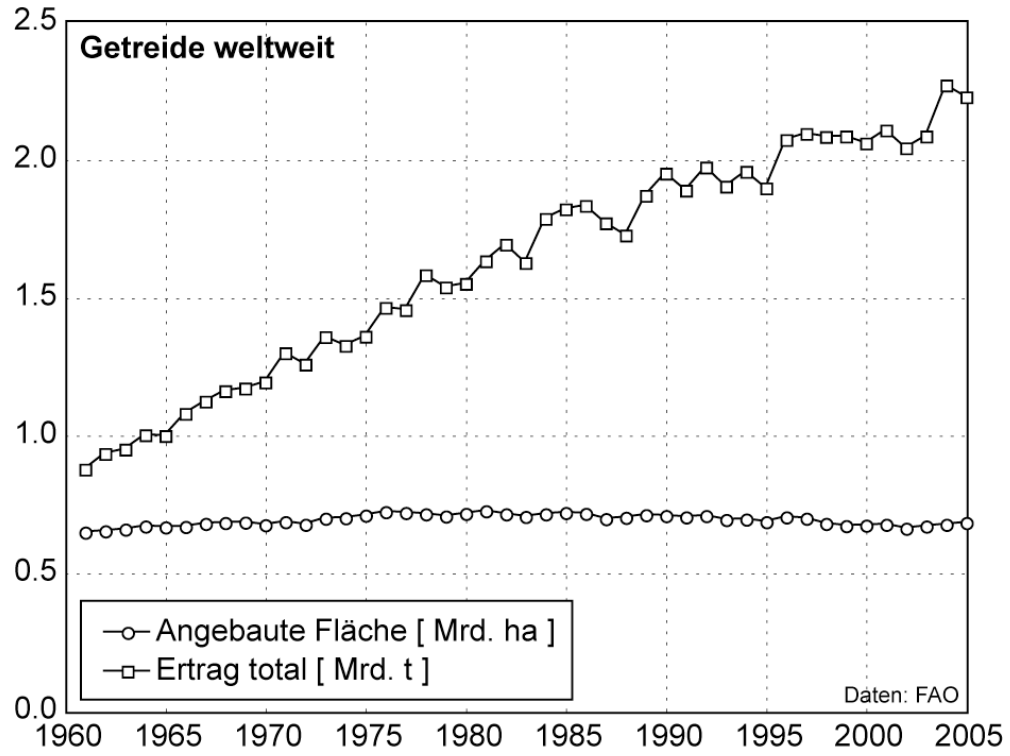

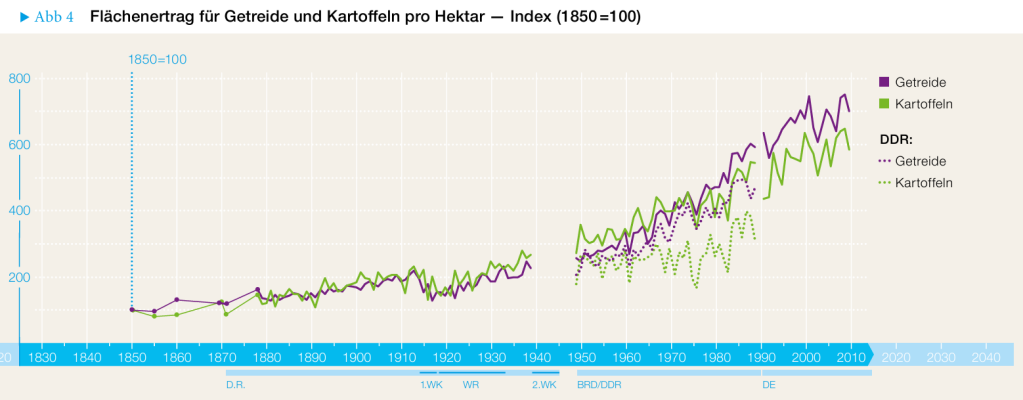

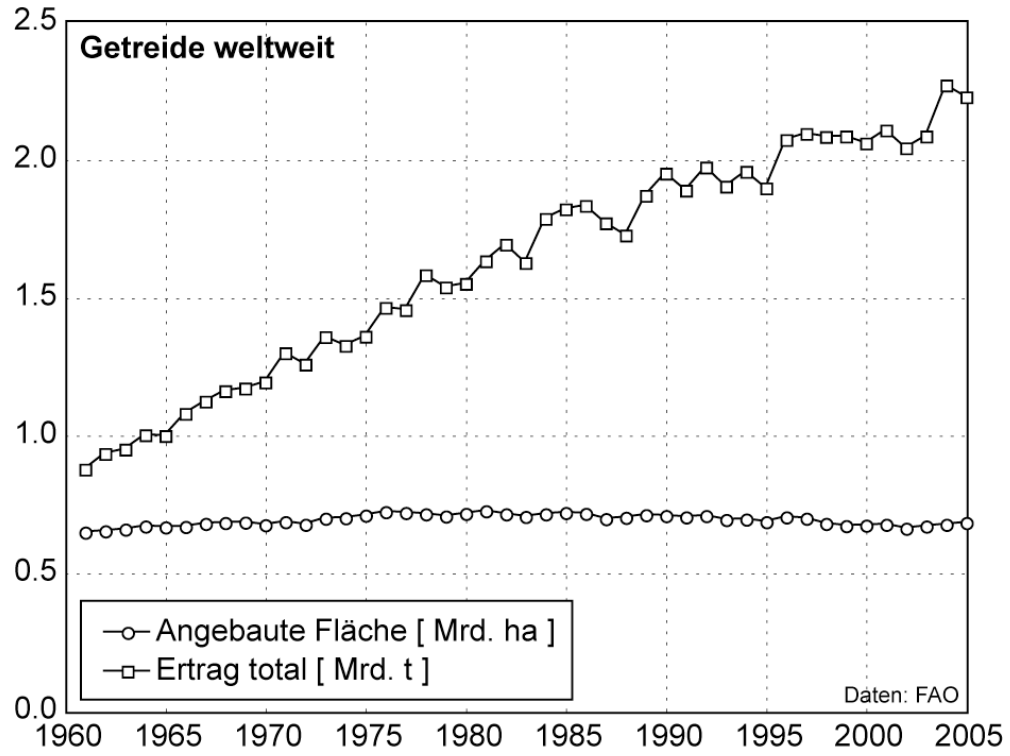

Auch für die weltweiten Ernteerträge scheint (nicht nur) der Klimawandel ein wahrer Segen zu sein.

Bild 6 Rahlf, Thomas (Ed.) (2015) : Deutschland in Daten. Zeitreihen zur Historischen Statistik, Bundeszentrale für politische Bildung, Bonn

Bild 7 Wikipedia

Bundesministerium für Land- und Forstwirtschaft, Klima- und Umweltschutz, Regionen und Wasserwirtschaft (BMLUK), Österreich: Zwischen 1963 und 2023 wuchs die Weltbevölkerung um das 2,5-fache, während sich die Erntemenge von Weizen, Reis und Mais mehr als vervierfachte.

Fazit

Man muss wirklich lange suchen, um einen signifikanten, negativen Einfluss des Klimawandels zu finden. Deshalb findet auch das IPCC keinen wirklichen, sondern vermutet ihn.

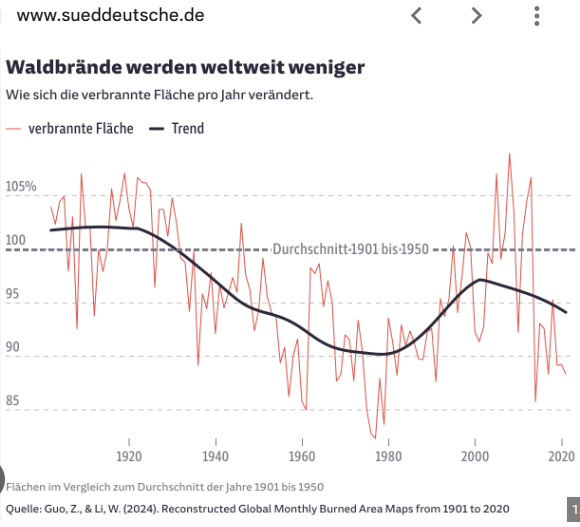

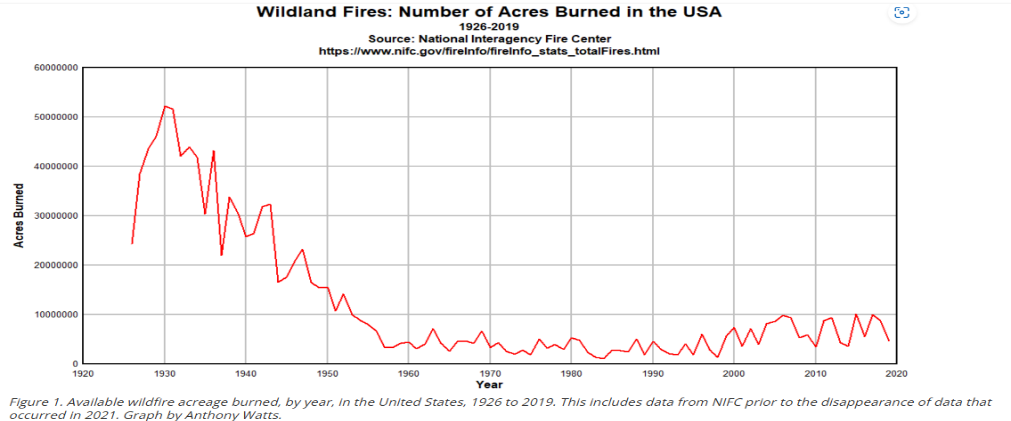

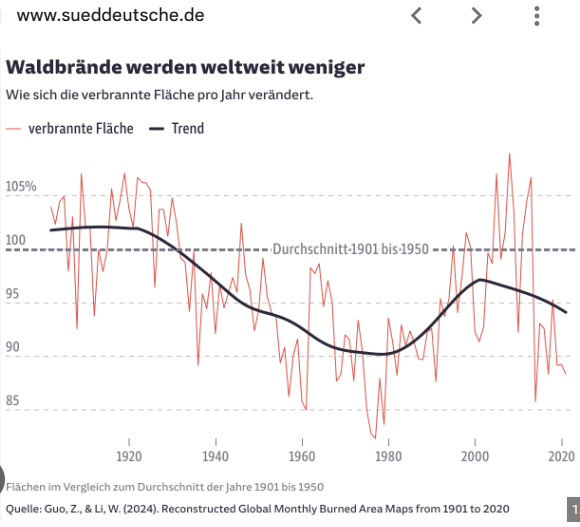

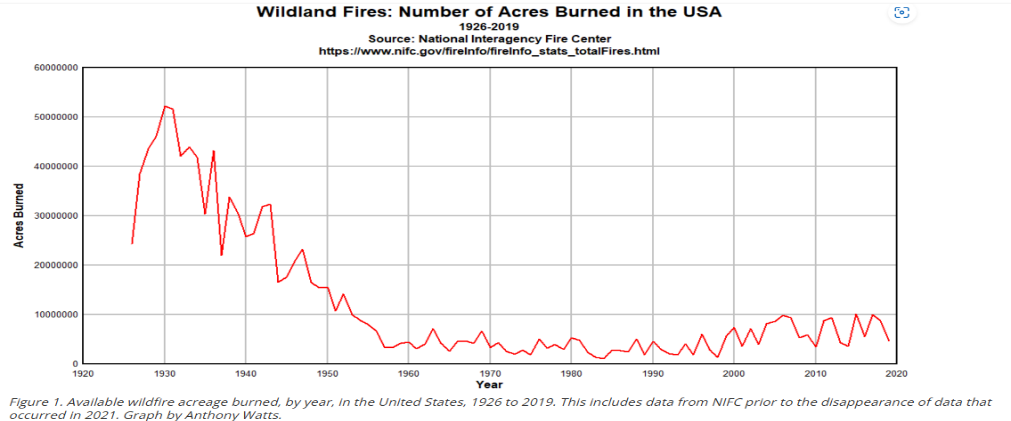

Waldbrände in den USA

Vorab: Die SZ veröffentlichte einen Artikel mit einer Grafik zu Waldbränden weltweit. Leider ist der Artikel dazu hinter einer Bezahlschranke:

Bild 8 SZ, globale Waldbrand-Flächengrafik von 1900 – 2020

Bild 9

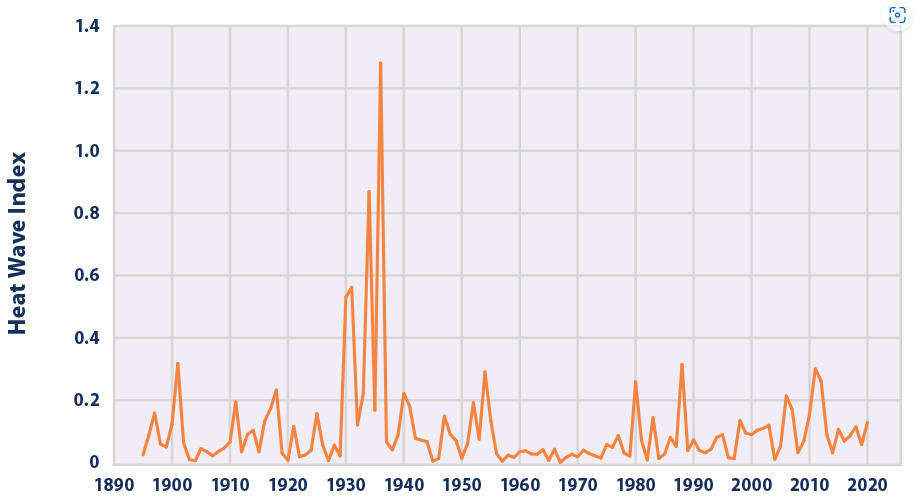

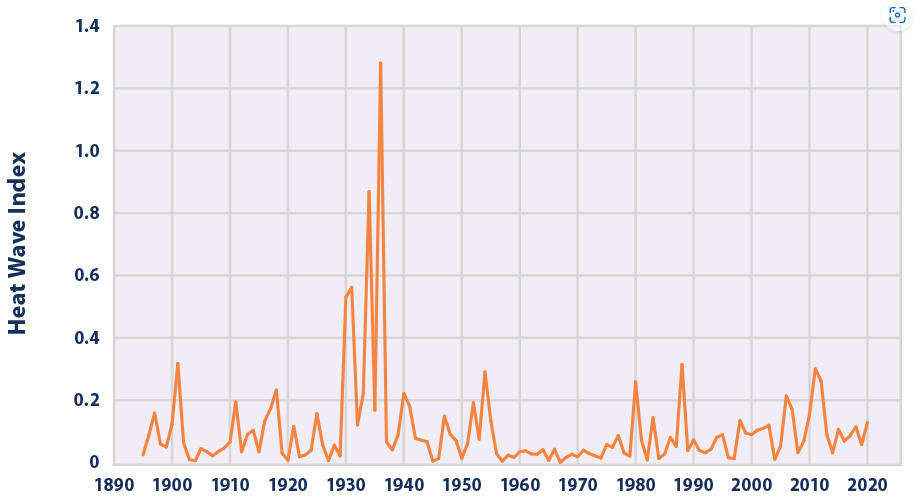

Bild 10 Annual values of the U.S. Heat Wave Index, from 1895 to 2020. These data cover the contiguous 48 states.

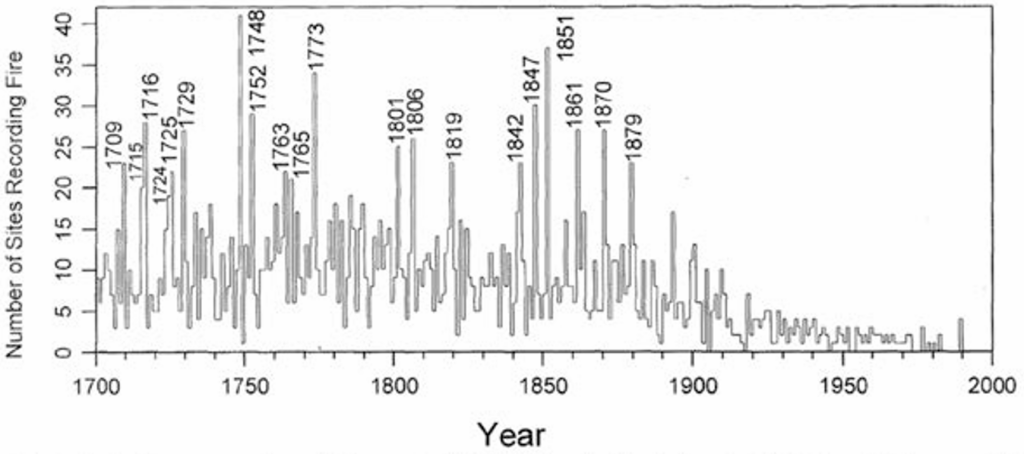

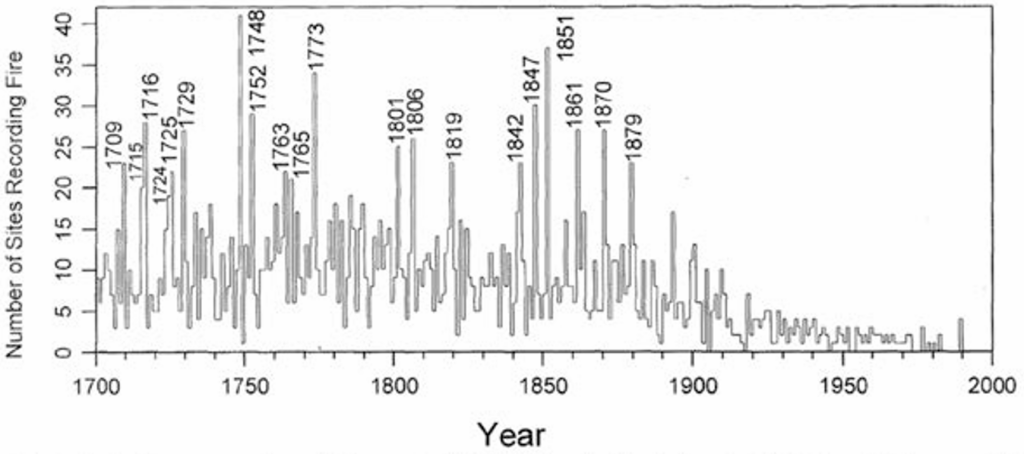

Bild 11 Historical Fire Regime Patterns in the Southwestern United States [4]

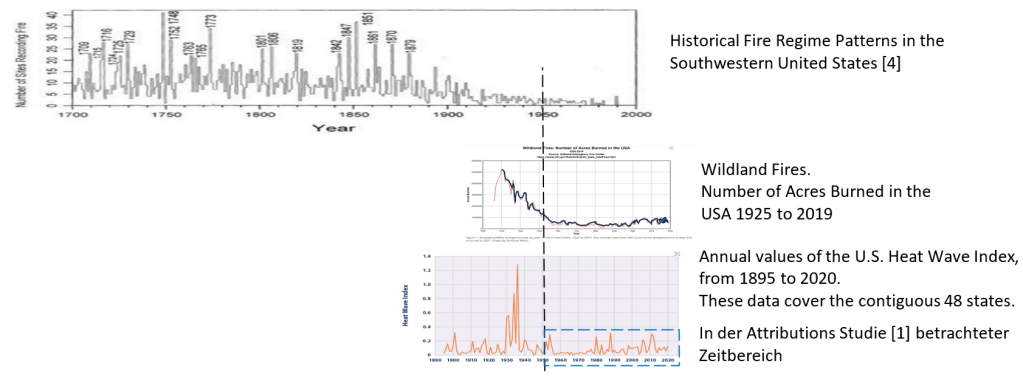

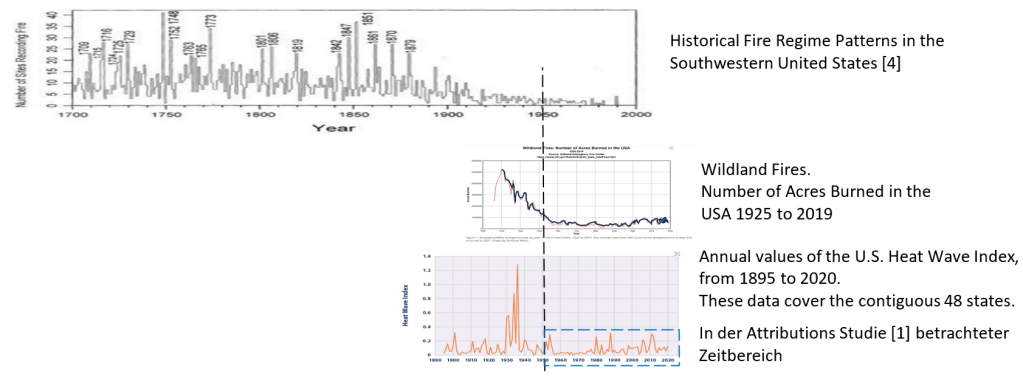

Die Grafiken zu den USA nun zusammengefasst, um einen zeitlichen Verlaufsüberblick zu erhalten:

Bild 12 Vom Autor erstellte Zusammenfassung der vorherigen Bilder zur Gesamtdarstellung der Wildfeuerthematik in den USA im längeren, historischen Kontext.

Welche Temperatur ist beeinflussend?

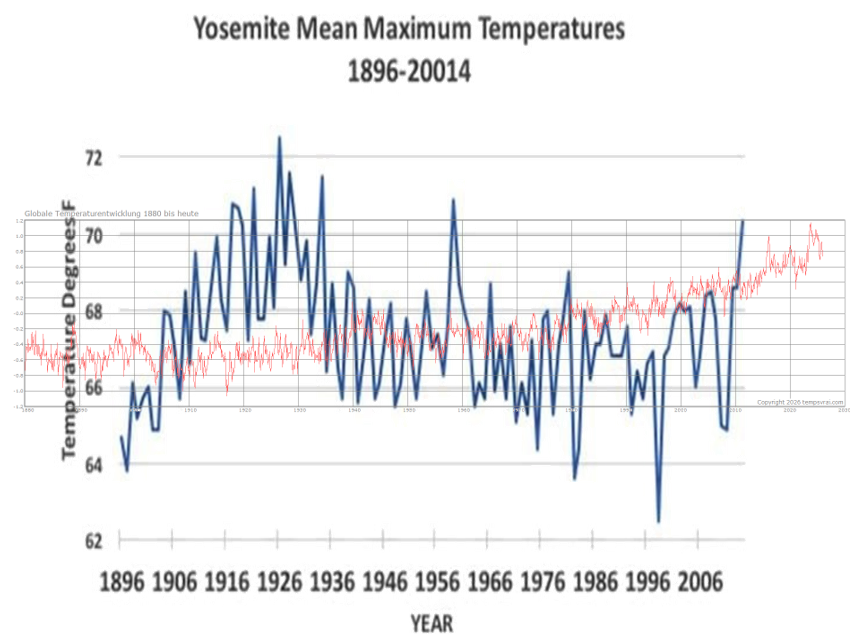

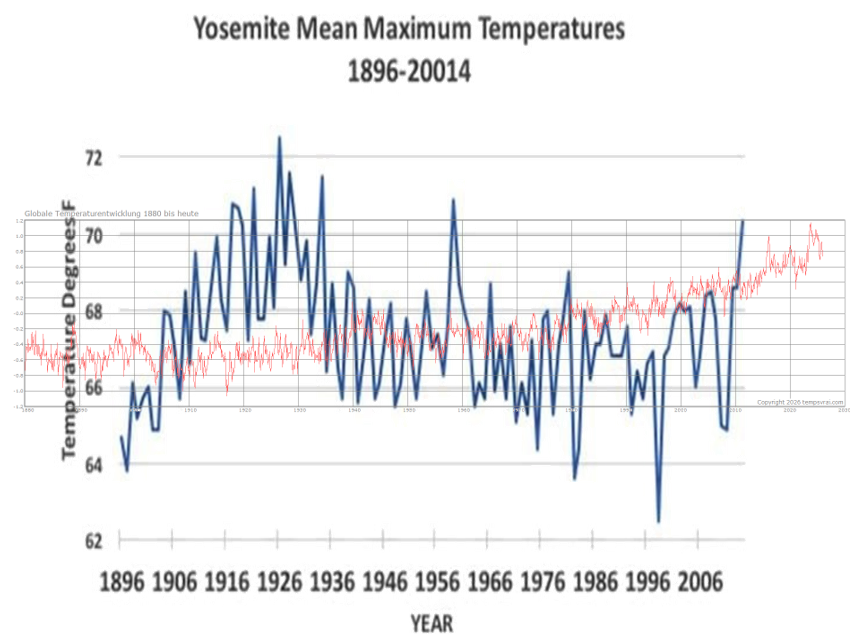

In der Attributionsstudie [1] wird in den Berechnungen pauschal die weltweite Globaltemperatur angezogen. Nun sind die Wildfeuer in Los Angeles aber ein doch recht lokal begrenztes Ereignis. Wie weit die lokale Temperatur von der globalen abweichen kann, zeigt der vergleichende Temperaturverlauf im Yosemite-Nationalpark.

Man muss sich beim Bild 13 fragen, ob die sture Verwendung der Globaltemperatur nicht einen (mehr als) erheblichen Fehler zur Folge haben könnte:

Bild 13 Vom Autor (im gleichen Maßstab) übereinandergelegter Temperaturverlauf der Globaltemperatur (rot) und der lokalen vom Yosemite-Nationalpark [4] (blau)

Attributionsstudie zum Wildfeuer im Jan.2025 in Los Angeles

Inzwischen erscheinen nach größeren Extremwetterereignissen öfters schon kurz danach Studien, die „Belegen“, dass der ominöse Klimawandel daran seinen schlimmen Einfluss zeigte. Eine solche „Belegstudie“ (Attributinsstudie) wollen wir uns diesmal wieder ansehen.

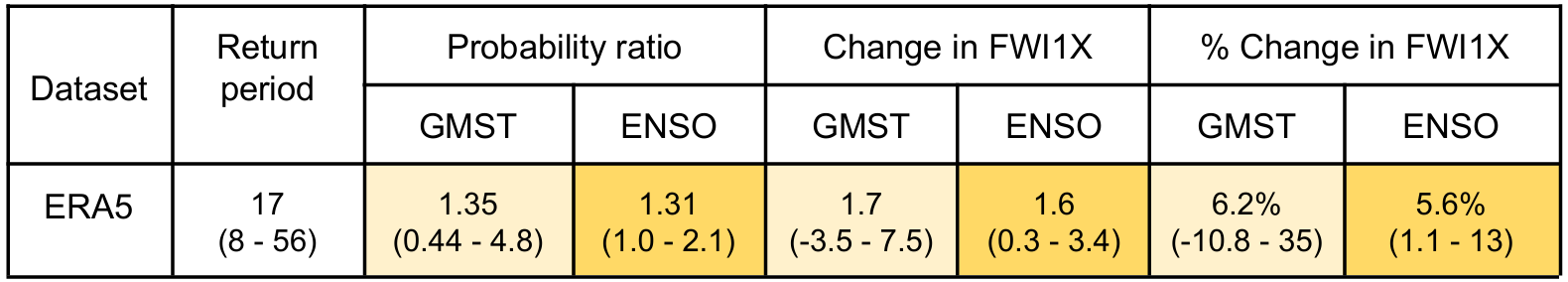

Die Attributionsstudie [1]: Climate change increased the likelihood of wildfire disaster in highly exposed Los Angeles area Report finalised: January 28th 2025, ermittelte bezüglich dem letzjährigen Brandereignis die folgenden Aussagen:

(deepl-Übersetzung) … Betrachtet man die Wetterbeobachtungen, so ist unter den heutigen Klimabedingungen mit einer globalen Erwärmung von 1,3 °C gegenüber dem vorindustriellen Niveau davon auszugehen, dass die extremen Bedingungen des Fire Weather Index (FWI), die die Brände in Los Angeles ausgelöst haben, durchschnittlich einmal in 17 Jahren auftreten werden.

Im Vergleich zu einem um 1,3 °C kühleren Klima bedeutet dies eine Erhöhung der Wahrscheinlichkeit um etwa 35 % und eine Zunahme der Intensität des FWI um etwa 6 %.

Dieser Trend ist jedoch nicht linear, da die Bedingungen für einen hohen FWI in den letzten Jahrzehnten schneller zugenommen haben.

Sichtung dieser Attributionsstudie

Begriffe:

FWI: Fire Weather Index

FWI1X: Peak daily January FWI (Fire Weather Index)

OND: Zeitraum von Oktober bis Dezember

LOESS smoother: nicht-parametrisches statistisches Verfahren zur Glättung von Datenreihen in Streudiagrammen, um Trends und komplexe Beziehungen ohne starre Modellannahmen sichtbar zu machen.

Attributionsstudien lassen sich nur bewerten, wenn Information über die Urdaten und dem zur Auswertung angezogenen Zeitraum vorliegen. Bei dieser Studie ist das der Fall.

Beobachtete Trends

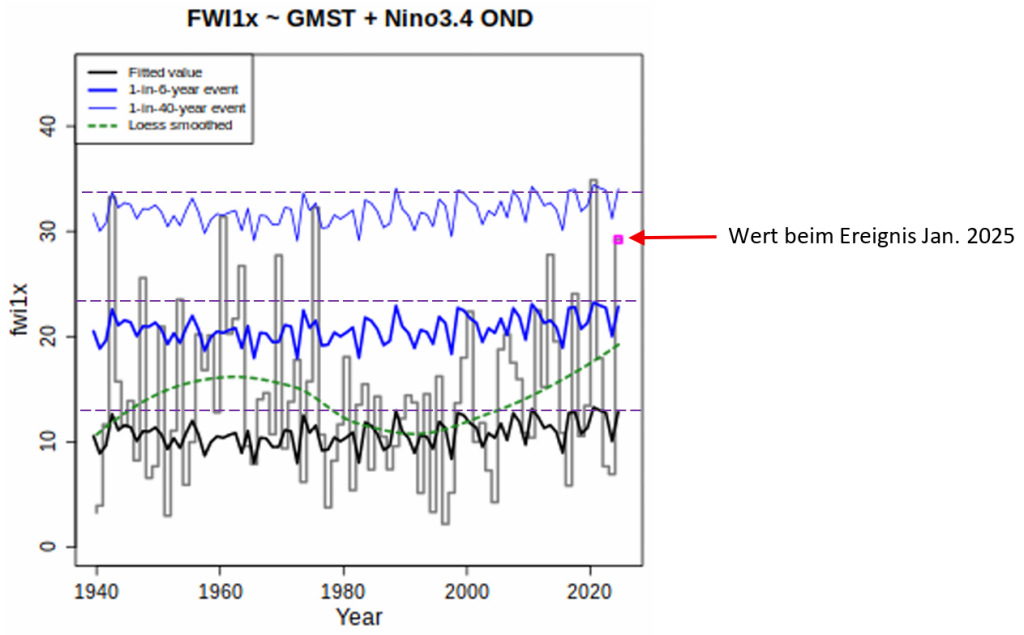

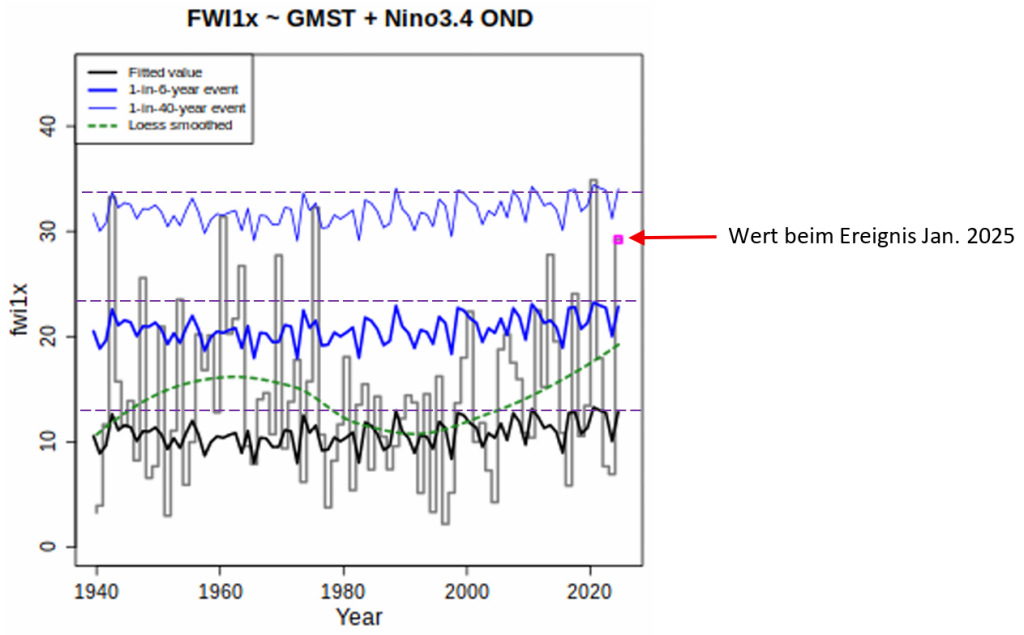

Das folgende Bild 14 zeigt den (rücksimulierten) Verlauf des FWI1X (Peak daily January FWI (Fire Weather Index)) von 1940 bis zum Ereignis im Januar 2025. Erkennbar tritt ein Ereigniswert wie letztes Jahr öfter auf.

Man beachte, dass die Attributionsstudie zur Auswertung nur den Zeitraum von 1950 bis Jan, 2025 betrachtet. Im Bild 12 (und den vorhergehenden Einzelbildern) kann man überdeutlich sehen, dass die Einschränkung auf diesen Zeitraum mit Sicherheit wenig, bis keine wirkliche Aussage bezüglich eines „Klimawandeleinflusses“ zulässt. Die Studienautoren hat das nicht gestört.

Bild 14 [1] Figure 3.1 Teilbild. Verlauf des FWI1x über die Zeit. Mit Ergänzungen durch den Autor

Anhand der Daten von Bild 14 und dem Verlauf der Globaltemperatur berechnet die Studie nun den Temperatureinfluss auf den Fire-Index FWI1x.

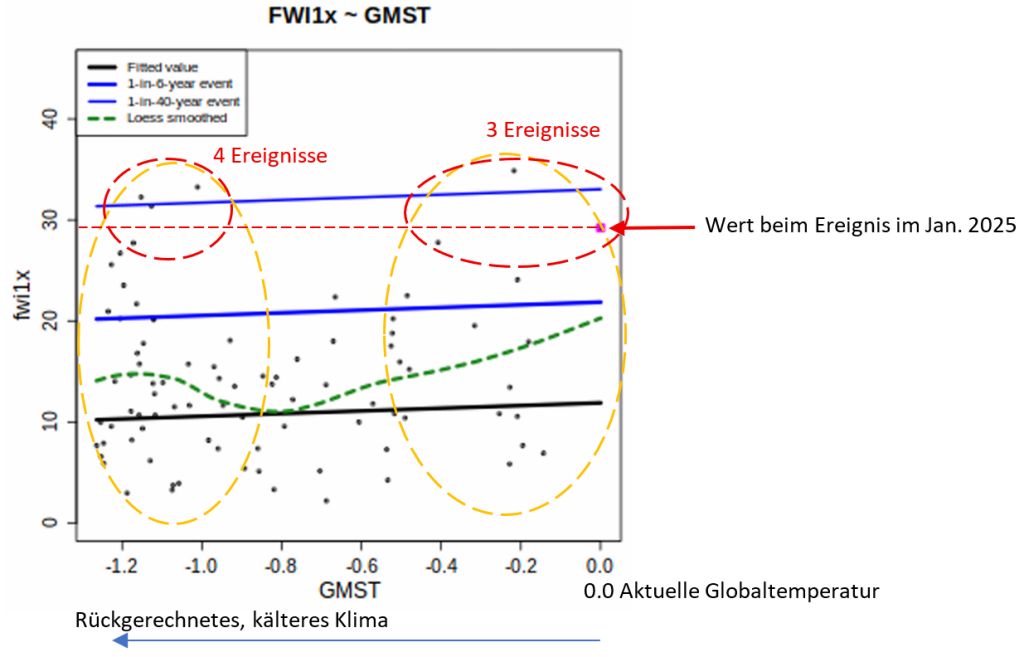

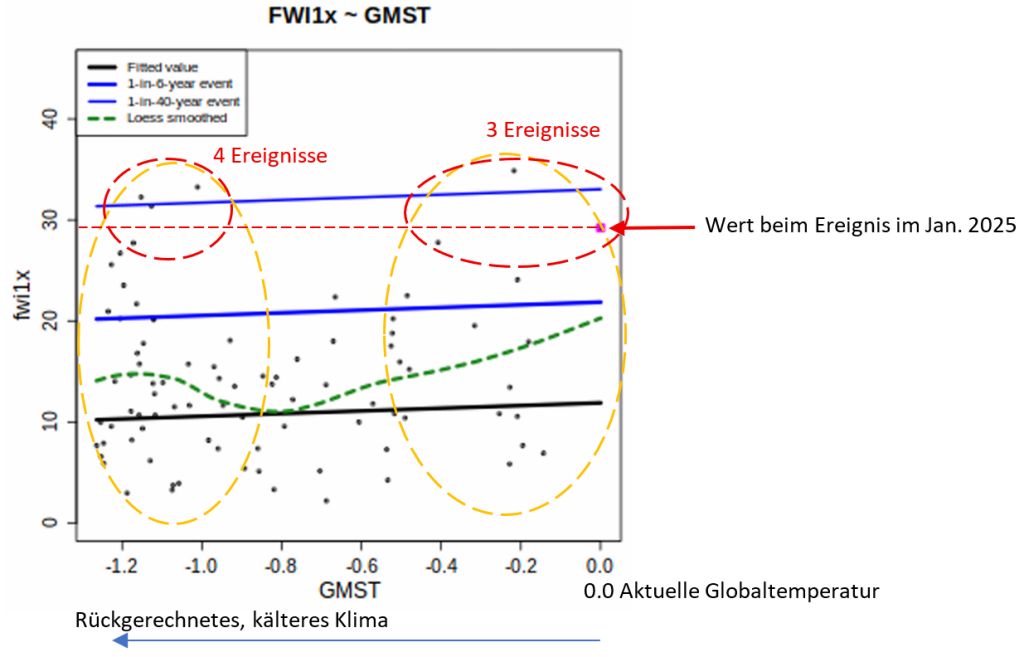

Nun das Bild 15. Es zeigt die Abhängigkeit des Feuerindex von der Globaltemperatur, dargestellt durch Ereigniswerte.

Es benötigt (mehr als) sehr viel Phantasie und vor allem eine vollkommen hemmungslos angewandte Statistik, um aus den zwei (vom Autor) gekennzeichneten „Datenhaufen“ einen den Fireindex verstärkenden Einfluss durch höhere Temperatur herauszulesen. Der Studie gelingt das problemlos.

Bild 15 [1] Figure 3.1 Teilbild. Abhängigkeit des FWI1x von der Globaltemperatur. Mit Ergänzungen durch den Autor

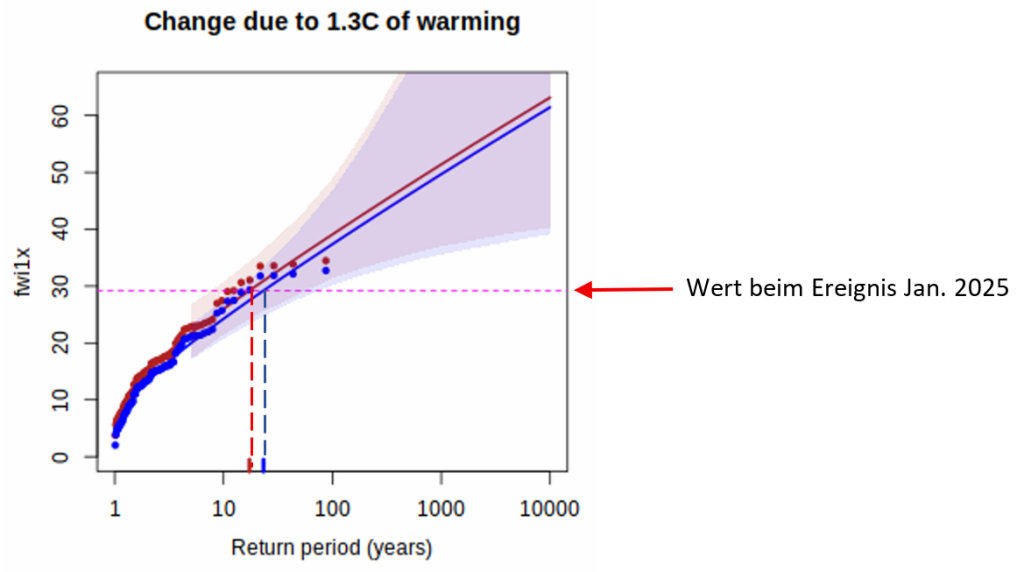

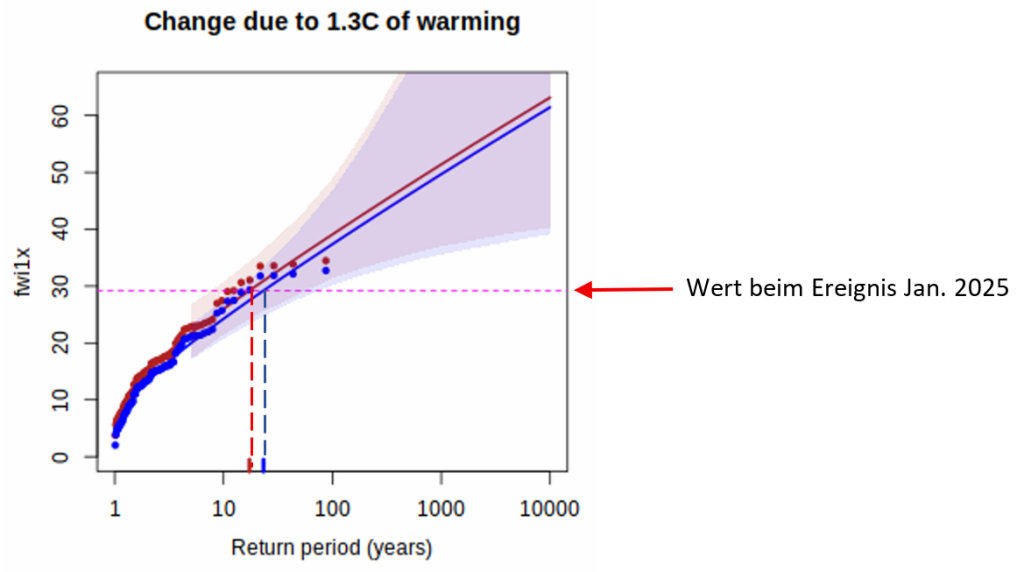

Das Ergebnis als Grafik nun in Bild 16.

Auch bei dieser Grafik würde man fragen, ob überhaupt ein statistisch signifikanter Unterschied zwischen den (stur berechneten) zwei Mittelwertverläufen besteht und warum ausgerechnet um den Ereigniswert die Urdaten so weit vom Mittelwert abweichen.

Bild 16 [1] Figure 3.2 Teilbild. Vom Autor ergänzt

Erklärung zu Bild 16 [1] (deepl-Übersetzung): Abbildung 3.2: Erwartete Returnlevel in FWI1X über der Untersuchungsregion im Klima von 2025 (rote Linien) und in einem kontrafaktischem Klima (blaue Linie), geschätzt anhand des statistischen Modells. Die schattierten Bereiche stellen 95 %-Konfidenzintervalle dar, die mittels Bootstrapping-Verfahren ermittelt wurden. Die rosa Linie zeigt den Spitzenwert von FWI im Januar 2025. Die roten und blauen Markierungen auf der x-Achse geben die geschätzte Wiederkehrhäufigkeit für den 8. Januar im Klima von 2025 und im kontrafaktischen Klima an.

(a) Das kontrafaktische Klima ist 1,3 °C kühler als 2025, hat jedoch den mittleren ENSO-Zustand von Oktober bis Dezember 2024;

(b) das kontrafaktische Klima hat die GMST von 2025 und einen neutralen ENSO-Zustand (OND Niño3.4 ist auf Null festgelegt).

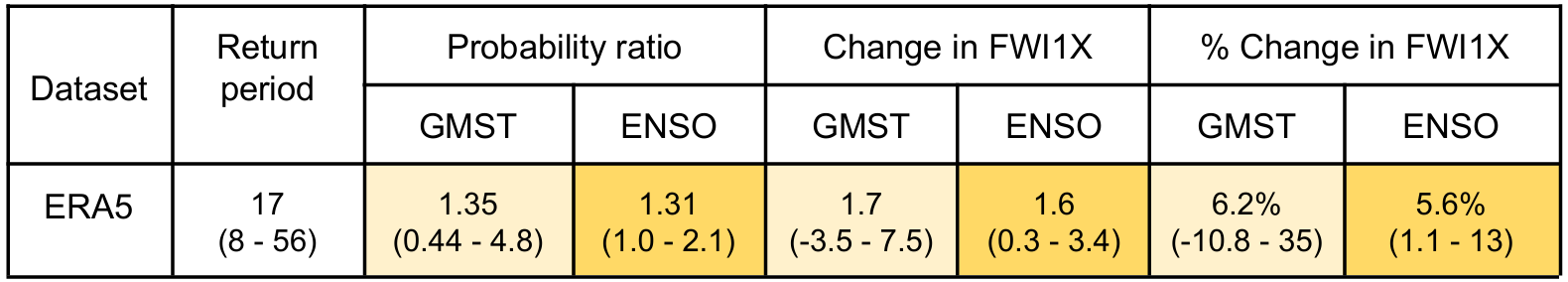

Die Daten aus den Grafiken (wie von Bild 16) sind dann in einer Tabelle (Bild 17) zusammengefasst:

(deepl-Übersetzung) [1]: Der beobachtete maximale tägliche FWI zwischen dem 1. und 15. Januar 2025 (die zum Zeitpunkt der Erstellung dieses Dokuments verfügbaren Daten) trat am 8. Januar auf. Die geschätzte Wiederkehrperiode sowie die Veränderungen in der Intensität und Wahrscheinlichkeit dieses Ereignisses sind in Tabelle 3.1 zusammengefasst.

Der FWI-Wert vom 8. Januar 2025 war ungewöhnlich, aber nicht beispiellos, mit einer geschätzten Wiederkehrperiode von 17 Jahren unter den aktuellen klimatischen Bedingungen und unter den aktuellen ENSO-Bedingungen. Dem Modell zufolge haben sowohl die globale Erwärmung als auch der vorangegangene ENSO-Zustand die Intensität des FWI1X im Januar um 5–6 % erhöht und die Wahrscheinlichkeit, ähnlich extreme FWI1X-Werte zu beobachten, um 30–35 % erhöht, obwohl die Unsicherheit hinsichtlich des Beitrags der globalen Erwärmung etwas höher ist. Die Trends bei GMST und ENSO sind statistisch unabhängig (mit einem Pearson-Korrelationskoeffizienten von -0,06), sodass sich diese Effekte gegenseitig verstärken: Ähnlich extreme FWI1X-Werte treten nun mit einer um 75 % höheren Wahrscheinlichkeit auf als in einer neutralen ENSO-Phase und in einem vorindustriellen Klima und sind um etwa 12 % intensiver

Bild 17 [1] Tabelle 3.1: Zusammenfassung der Ergebnisse des angepassten Modells für FWI1X. Wiederkehrperiode von 2025 FWI1X-Maximum im Klima von 2025; Wahrscheinlichkeitsverhältnis, absolute Veränderung von FWI1X und prozentuale Veränderung von FWI1X im Zusammenhang mit einer globalen Erwärmung um 1,3 °C (GMST) und mit La Niña-Bedingungen im OND 2024 (detrended Niño-Index von -1,16) im Vergleich zu neutralen Bedingungen. Hellorange zeigt einen bestmöglichen Anstieg von FWI1X an, während dunkelorange einen statistisch signifikanten Anstieg von FWI1X anzeigt.

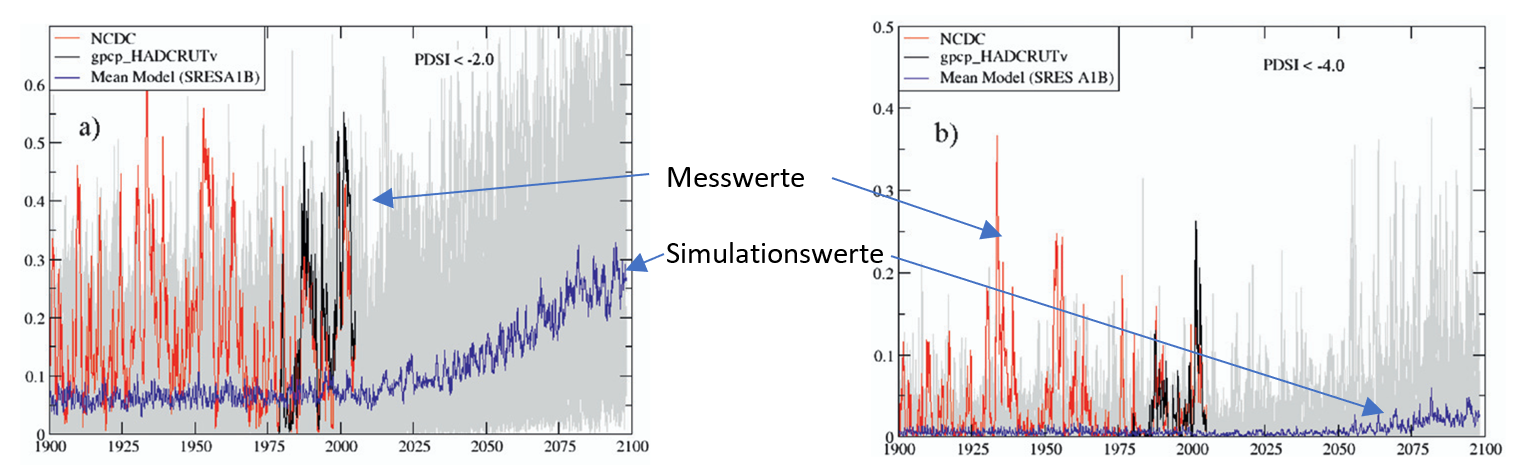

Gemessene Wirklichkeit und Simulationen

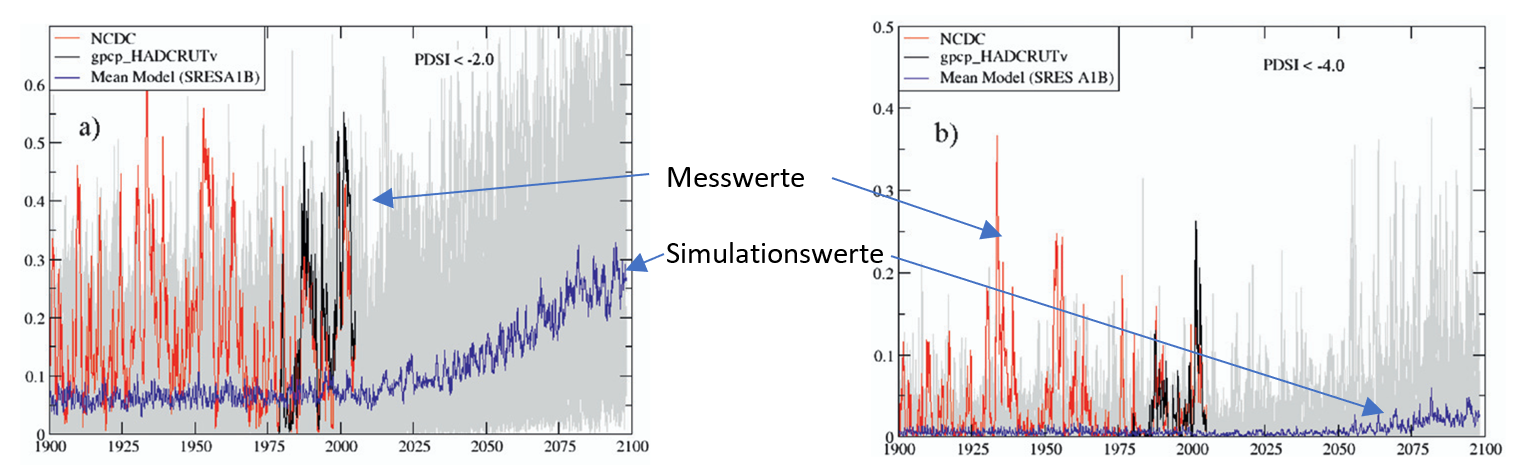

In [5] ist eine Grafik hinterlegt welche zeigt, wie extrem die gemessene Wirklichkeit von Klimasimulationen abweichen kann. Leider werden auf solcher Basis die politischen Entscheidungen getroffen:

Bild 18 Vergleich der gemessenen Trockenheit und der klimasimulierten. Vom Autor ergänzt

Erklärung zu Bild 18 [4]: FIG. 2. (a) Area fraction of the continental United States and Mexico experiencing drought conditions (PDSI ,22) calculated from observations and raw model output. The light gray curves are individual model realizations. (b) As in (a) except for extreme drought conditions (PDSI ,24).

Fazit

Jeder Leser möge sich nun selbst ein Bild darüber machen, was von solchen Studien zu halten ist. Der Autor hat für EIKE inzwischen mehrere gesichtet und kam fast immer zu einem ähnlichen Ergebnis.

Das wundert (zumindest den Autor) auch nicht.

Sieht man die oft ellenlange Liste der Studienbeteiligten durch (hier 25 Autoren), fällt auf, dass fast immer auch eine Friederike Otto, Centre for Environmental Policy, Imperial College, London, UK, gelistet ist.

Frau Prof. Dr. Friederike Otto arbeitet am Grantham Institute Climate Change and the Environment des Imperial College London und ist Gründerin der World Weather Attribution Initiative (WWA) und ist derzeit wohl weltweit die Leitfigur und Treiberin für Attributionsstudien.

Allerdings ist sie keinesfalls neutral, sondern eine ausgewiesene Klimaaktivistin. Das muss man akzeptieren, denn von der Klimahysterie hängt ihre Reputation ab.

Dürre(n) in Deutschland

Im Frühjahr letzten Jahres erlebten Teile von Norddeutschland eine extreme Dürre. Selbstverständlich wurde auch diese von „Klimaexperten“ sofort dem Klimawandel zugeschrieben:

Bild 19 Meldung des NDR

Bild 20 Meldung des Spiegel

Dazu soll allerdings der DWD einmal gelobt werden.

Während der DWD mit seiner Ahrtal-Attributionsstudie damals eine reine Gefälligkeitsstudie ablieferte (um Merkels damals vor Ort spontan getätigte Aussage pflichtschuldigst zu bestätigen) [Link] EIKE, 19.07.2022: Wenn historisch belegte Fluten statistisch gar nicht vorgekommen sein können, wird es das Ergebnis einer Attributionsstudie sein, hat der DWD zur extremen Frühjahrstrockenheit 2025 in Norddeutschland nun eine weitere Attributionsstudie erstellt: DWD Attributionsstudie zum Niederschlagsdefizit in Norddeutschland im Frühjahr 2025

Und in dieser kommt der DWD zur Schlussfolgerung: … Die Ergebnisse zeigen keine signifikante Änderung der Wahrscheinlichkeit und der Intensität vergleichbarer Trockenperioden durch die bisherige globale Erwärmung um 1,3 °C. Auch bei einer zukünftigen Erwärmung auf eine 2 °C Erwärmung (0,7 °C wärmer als aktuell) zeigen die Berechnungen keine signifikante Änderung in der Wahrscheinlichkeit und der Intensität einer solchen Frühjahrstrockenheit. Der Einfluss des Klimawandels auf die ausbleibenden Niederschläge lässt sich daher mit der vorliegenden Methodik nicht quantifizieren.

Leider fand der Autor keine Aussagen der letztes Frühjahr bezüglich des Klimawandeleinflusses so sicheren Experten zur nun gegenteiligen DWD-Feststellung.

Aber es findet sich ja auch keine Entschuldigung des Prof. Lesch bezüglich seiner Aussage vom Jahr 2019: „Sie müssen sich nicht mal mehr warm anziehen im Winter, so warm wird’s.“, wobei eine Aussage von ihm noch schlimmer ist: „Der Klimawandel ist ausgeforscht“.

Quellen

[1] Climate change increased the likelihood of wildfire disaster in highly exposed Los Angeles area Report finalised: January 28th 2025

[2] Waldbrände in Kalifornien und Südeuropa – eine Folge des Klimawandels? – EIKE – Europäisches Institut für Klima & Energie

[3] DWD Attributionsstudie zum Niederschlagsdefizit in Norddeutschland im Frühjahr 2025

[4] Range Magazine winter 2017/2018, Jim Steele: Wildfires Separating Demagoguery from the Science