Dezemberrückblick 2016, Hochwinterausblick 2017

1. Die langfristige Entwicklung der Dezembertemperaturen und der „CO2- bedingte Klimawandel“

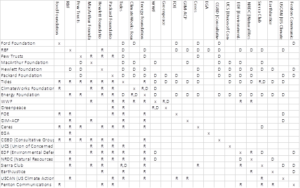

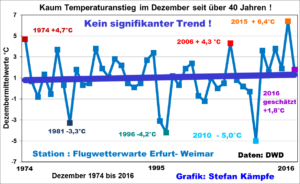

Der 2015er, frühlingshafte Dezember mit ersten Frühblühern wurde oft als Vorbote der „Klimaerwärmung“ gedeutet. Doch sehr milde Dezember gab es auch vor mehr als 40 Jahren schon, beispielsweise 1974. Betrachtet man den Temperaturverlauf seit jenem Dezember in Erfurt-Weimar (offizielle Station des Deutschen Wetterdienstes DWD), so erlebt man eine Überraschung:

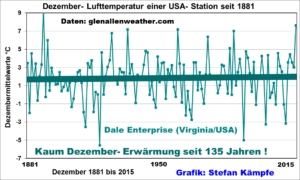

Den geringen (nicht signifikanten) Temperaturanstieg erkennt man kaum, und das, obwohl der 2015er Dezember deutlich wärmer als der 1974er ausfiel. Zumindest im letzten Monat des Jahres fand also der „CO2- bedingte Klimawandel“ bislang nicht statt, denn die Erfurter Werte sind nicht wärmeinselbereinigt (am Flughafen Erfurt- Weimar nahmen Verkehr und bebaute Flächen seit den 1970er Jahren zu, was zumindest leicht erwärmend wirkte und vermutlich neben einer geringfügigen Zunahme der Tage mit Südwestlagen und einer erhöhten Sonnenscheindauer um etwa 17 Stunden seit 1974 die Ursache der Mini- Dezember- Erwärmung ist). Ein nahezu identisches Bild zeigt sich übrigens in Zentralengland, auch dort blieben die Dezembertemperaturen seit 1974 nahezu unverändert. Nun mögen Kritiker bemängeln, es habe sich aber seit 1881, dem Beginn vertrauenswürdiger Messungen in Deutschland, deutlich erwärmt. Das ist korrekt und soll keinesfalls verschwiegen werden, doch jenseits des Atlantiks finden sich Stationen, welche sich schon seit 1881 so gut wie gar nicht erwärmten; ein Beispiel von der US- Ostküste möge das belegen:

2. Besonderheiten der Dezemberwitterung 2016- Die Praxis widerlegt die Theorie der CO2- bedingten Erwärmung

Beim täglichen Blick auf das Barometer fiel der fast stets deutlich zu hohe Luftdruck auf. Wahrscheinlich gab es einen neuen Rekord des Dezember- Luftdruckmittelwertes, was aber erst nach Vorliegen aller Werte endgültig feststehen wird. In Potsdam wurde der bislang höchste Dezembermittelwert 1972 mit 1013,35 hPa (in Barometerhöhe, nicht auf NN reduziert) gemessen. Aber der hohe Luftdruck, der zwischen West-, Mittel- und Südosteuropa pendelte, ging mit fehlender Kaltluftzufuhr, meist schwachem Wind, gebietsweise viel Sonne und zu wenigen Niederschlagstagen einher; trotzdem gab es einige beachtlich kalte Nächte. Die Luftmasse, meist eine im Winter recht milde maritime Subpolarluft (mP), wandelte sich direkt über Mitteleuropa bodennah in gealterte Subpolarluft (xPs oder die trockenere cPs) um, während in der Höhe Warmluftadvektion herrschte, welche den Höhenkeil und das riesige Bodenhoch immer wieder aufbaute. In den klaren, windschwachen Nächten kühlte die Luft bodennah trotz der hohen CO2- Konzentration (im Mittel schon über 400 ppm) und der Höhen- Warmluft stark aus. Zeitweise entstand eine kräftige Inversion (Temperaturumkehr) zwischen dem Thüringer Becken oder dem Werratal (dort sammelte sich die schwere Kaltluft mit teilweise zweistelligen Minusgraden) und den Mittelgebirgsgipfeln mit Temperaturen um 0°C. Die folgende Abbildung zeigt die Wetterlage am Morgen des 05.12.2016:

Das umfangreiche, kräftige Hochdruckgebiet über Südosteuropa reichte bis nach Mitteleuropa. Das Luftdruckgefälle und folglich auch der Wind waren über Mitteleuropa nur sehr schwach (großer Abstand der Isobaren). Die nächste Abbildung mit wenigen Temperaturmeldungen in °C illustriert die enormen Temperaturunterschiede über Mitteldeutschland am Morgen des 5. Dezember, welche allein durch die starke nächtliche Ausstrahlung entstanden waren:

Am 20. Dezember entstand dann erneut ein umfangreiches, mit Nebel gefülltes Kaltluftreservoir im Thüringer Becken und dem südlichen Sachsen- Anhalt. In der Weimarer Mulde schien ab dem späten Vormittag bei +1°C zwar die Sonne, doch der Druck der am Ettersberg aufgestauten Kaltluft war so groß, dass Nebel noch nach 13 Uhr die nördlichen Ortsteile Weimar- Waldstadt und Schöndorf zeitweise einhüllte, sich beim Absinken mit nordöstlichem Wind Richtung Ilmtal auflösend (ganz schwacher Nordföhn). Aber kaum wurde die Sonne schwächer, überflutete der gefrierende Nebel (Zeichen ww49 nach WMO- Schlüssel) ab 14.45 Uhr den gesamten Großraum Erfurt/Weimar und verschwand erst in der zweiten Nachthälfte aus dem Ilmtal. Dieses Beispiel verdeutlicht, wie dominant Sonnenscheindauer, Bewölkungs- und Windverhältnisse die Temperaturen beeinflussen. Weil mehrfach Vorstöße milderer Luft aus SW bis NW, darunter das berüchtigte „Weihnachtstauwetter“, diese markanten Abkühlungsphasen unterbrachen, wenngleich viel schwächer als 2015, fiel der Dezember 2016 insgesamt etwas zu mild aus.

3. Allen Unkenrufen zum Trotz- das arktische Meereis wuchs im Dezember zeitweise stark

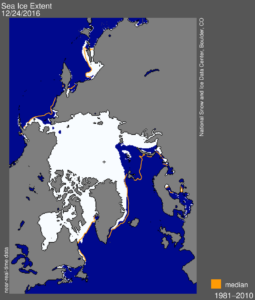

Im Spätherbst (Oktober/November) nahm das arktische Meereis die bislang geringste Fläche seit der Einführung der satellitengestützten Überwachung im Jahre 1979 ein. Das rief sogleich die Alarmisten und Katastrophisten auf den Plan. So schrieb das links- grüne Kampfblatt „DIE ZEIT“ am 8. Dezember unter der Rubrik Wissen: „Das Eis schwindet. Das ist kein ästhetisches, sondern ein existenzielles Problem.“ Leider übersahen die ZEIT- Redakteure einige Fakten. Erstens ist der Zeitraum seit 1979 sehr gering; sein Beginn fällt mit der Abkühlungsphase der 1970er zusammen. Auch in früheren Zeiten, für die aber nur sehr ungenaue Daten vorliegen, wich das Eis stark zurück, so in den 1930er Jahren. Und seit Mitte November dehnte sich die Eisfläche zeitweise stark aus, was auch die folgende Abbildung verdeutlicht (Quelle http://nsidc.org/arcticseaicenews/ ):

Die Eisbedeckung wies in der letzten Dezemberdekade einige Besonderheiten auf. Während eine ungewöhnlich große eisfreie „Kerbe“ bis weit in das Seegebiet nördlich von Westsibirien reichte, war die Eisbedeckung in allen anderen Gebieten fast normal. Dieser Umstand ist vermutlich den in diesem Spätherbst/Frühwinter rekordverdächtig hohen AMO- Werten geschuldet. Über die letzten Golfstrom- Ausläufer gelangt das (noch!) zu warme Atlantikwasser weit nach Nordosten. Von einem „katastrophalen“ Eisschwund kann keine Rede sein. Diese frühwinterliche Ausdehnung des Meereises ist eine mögliche Ursache für die Häufung der Westlagen in dieser Jahreszeit; sicher hat sie auch diesmal das Auftreten des schon immer sehr häufigen „Weihnachtstauwetters“ begünstigt. Auffällig umfangreich war auch die Schneedecke Eurasiens schon Ende November; sie hatte mit 24,03 Millionen Km² den bisherigen 1993er Novemberrekord (24,13 Mio. Km²) nur knapp verfehlt; für Dezember liegen noch keine Werte vor.

4. Ausblick in den Januar- was die mittelfristigen Modelle vorhersehen

Die Ensemble- Vorhersagekarte des NOAA (USA- Wetterdienst) vom 26.12. für den 10.01.2017 zeigte eine diffuse Hochdruckzone von den Azoren über Mittel- bis nach Osteuropa und tiefen Luftdruck westlich von Island (Quelle: NOAA). Sollte das so eintreten (noch sehr unsicher), so wäre es in Deutschland weder extrem mild, noch extrem kalt:

Bei den Modellen entstehen in derart langen Vorhersagezeiträumen aber oft Differenzen der einzelnen, gerechneten Läufe, ganz oben das amerikanische GFS von 26.12., 00 UTC, Mitte ENS, unten ECMWF, jeweils für den 05. Januar 2017, 00 UTC, berechnet (Quelle: http://www.wetterzentrale.de/topkarten/ ). Während GFS und ENS eher antizyklonales Westwetter vorhersahen, berechnete das ECMWF einen Trog über Mitteleuropa mit einem Mittelmeer- Tief, was starke Schneefälle in Ost- und Süddeutschland auslösen könnte:

Die Unsicherheit bleibt also groß, doch deutet sich wohl ein Januar an, der etwas kälter und vor allem niederschlagsreicher als der Dezember ausfallen könnte.

5. Die Nordatlantische Oszillation (NAO), die AMO, die QBO, der Polarwirbel, die markante Kaltwasserinsel im zentralen Nordatlantik und die Sonnenaktivität

Die NAO „drehte“ nach Mitte Dezember wieder auffallend markant in den Positivmodus, was mildes Westwetter förderte und so das „Weihnachtstauwetter“ begünstigt hat. Die AMO- Werte blieben auch im November ungewöhnlich hoch. AMO- Warmphasen erhöhen die Wahrscheinlichkeit für einen kalten Winter leicht, weil diese Konstellation kalte, nordöstliche Strömungen („Wintermonsun“) begünstigen könnte. Und die QBO (Windverhältnisse in der unteren Stratosphäre der Tropen, die etwa alle 2,2 Jahre zwischen West und Ost wechseln) dreht momentan in der unteren Stratosphäre in die Westwindphase, was eher milde Winter bevorteilt. Ein Polarwirbelsplitting, welches die Westdrift schwächen und kalte Nord- bis Ostlagen über Europa fördern könnte, kündigte sich in den Modellvorhersagen des französischen Wetterdienstes, welche gut 2 Wochen in die Zukunft reichen, bislang noch nicht eindeutig an.

Die lange Zeit auffällig beständige „Kaltwasserinsel“ im zentralen Nordatlantik zwischen Großbritannien/Westeuropa und den USA war auch im Dezember 2016 meist gut erkennbar. Im Dezember 2016 nahm die Sonnenaktivität weiter ab; zeitweise war die Sonne völlig fleckenlos, was nach eigenen Untersuchungen meridionale Strömungsmuster, darunter besonders Nord- und Ostlagen, im Hochwinter 2017 etwas wahrscheinlicher werden lässt.

6. Analogfälle (ähnliche Witterung wie 2016)

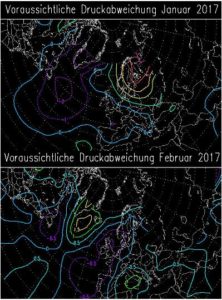

Die wahrscheinliche (trotzdem sehr unsichere) Luftdruckverteilung über Europa (Quelle: langfristwetter.com) sieht für die Hochwintermonate nun doch etwas anders aus, als noch im November erwartet:

Im Januar 2017 (oberes Bild) nur noch eine leicht geschwächte Westwind- Zirkulation (positive Luftdruck- Anomalien in hpa auf Meeresspiegelniveau, gelbe und rötliche Linien über Nordosteuropa und zu tiefer Luftdruck blau- violett auf dem zentralen Nordatlantik). Das kann zumindest gelegentlich Kälte in Mitteleuropa begünstigen. Im Februar (unteres Bild) soll nun etwas zu tiefer Luftdruck über West- und Nordwesteuropa herrschen. Einem Dezember mit auffallend zu hohem Luftdruck über Mitteleuropa folgten in der Vergangenheit häufiger normale bis milde, als zu kalte Januare. Einzelne, sehr milde oder zu kalte Phasen sind jedoch nicht ausgeschlossen.

7. Die „Siebenschläfer- Regel“ des Winters

Neben der im Novemberbericht bei EIKE ausführlich erläuterten „2- K- Septemberregel“ (der Winter und auch der Hochwinter fallen mit sehr hoher Wahrscheinlichkeit zu mild aus, wenn der vorangehende September in Deutschland um mindestens 2 Kelvin zu warm war), gibt es für die Abschätzung der Hochwinterwitterung noch weitere Regeln, so etwa „War der Dezember gelind, bleibt auch der Winterrest ein Kind.“ Oder „Bricht gar ein Spatz im Dezember- Eis ein, wird ein milder Januar sein.“ Bei Verknüpfung der Dezember- und Septemberregel gilt folgende Aussage: „Waren September und Dezember insgesamt zu mild, so erhöht das die Wahrscheinlichkeit für einen zu milden Januar deutlich“.

Am wichtigsten ist aber die sogenannte „Dreikönigs- Regel“: „War bis Dreikönige (06.01.) kein richtiger Winter, so folgt meist auch kein strenger mehr dahinter.“ Sie funktioniert ähnlich wie die Siebenschläfer- Regel. Kurz nach dem Sonnenhöchst- und Tiefststand hat sich die Atmosphäre meist für ein bestimmtes Strömungsmuster entschieden. Die markanten Keile und Tröge sowie der unser Wetter steuernde Strahlstrom haben eine bestimmte Position eingenommen und behalten diese dann meist für weitere 2 bis etwa 7 Wochen mit nur leichten Variationen bei („Persistenz“). Freilich lässt auch diese Regel Ausnahmen zu, und der „Entscheidungszeitraum“ reicht etwa vom 20.12. bis fast Mitte Januar. Einem Dezember mit auffallend hohem Luftdruck folgten bislang häufiger zu milde als zu kalte Januare. Weil sich der hohe Luftdruck und die milde Witterung auch bis zum Jahreswechsel 2016/17 noch hielten, könnte auch der Januar zeitweise ähnlich verlaufen; gelegentliche Kälteeinbrüche oder zumindest endlich zeitweise Schnee bis ins Flachland bleiben trotzdem möglich. In den Wintern 2011/12 und 2012/13 folgte milden Dezembern sogar noch entweder ein sehr kalter Februar (2012) oder 2013 ein bis in den April dauernder schneereicher Winter, der erst nach dem 10. Januar so richtig begann. Näheres und Interessantes zur Problematik der großräumigen Zirkulationsverhältnisse und deren Auswirkungen auf die winterlichen Temperaturverhältnisse finden Sie im Beitrag von Hans-Dieter Schmidt vom 23.12.2016 unter http://www.eike-klima-energie.eu/2016/12/23/extreme-kaelte-in-teilen-der-usa-dauerhoch-in-mitteleuropa/ . Fasst man alle Prognosesignale zusammen, so kündigt sich am wahrscheinlichsten ein wechselhafter, eher unspektakulärer Januar 2017 an, der weder extrem mild noch extrem kalt ausfällt, eher nasskalt, und einen Wechsel von zyklonalen und antizyklonalen Phasen aufweist.

8. Die Langfrist- Vorhersagen: Viele Institute korrigierten ihre Prognosen vom November 2016

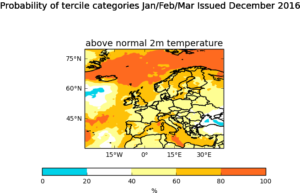

Der britische Wetterdienst (UKMO) sieht nun eine leicht erhöhte Wahrscheinlichkeit für einen milden Winter in ganz Deutschland, allerdings unter Einbeziehung des März:

Anmerkung: Hier wird nur die erste UKMO- Karte gezeigt. Es gibt zwei weitere, eine mit der Probability (Wahrscheinlichkeit) für einen normalen Winter und eine für einen zu kalten. Die aktuellen Karten jederzeit unter http://www.metoffice.gov.uk/research/climate/seasonal-to-decadal/gpc-outlooks/glob-seas-prob

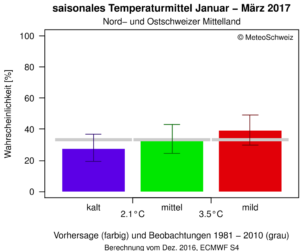

Meteo Schweiz bezieht nun ebenfalls den März ein und erhöht dabei die Wahrscheinlichkeitsaussage für einen milden Winter:

LARS THIEME (langfristwetter.com) sagt in seiner Dezemberausgabe nun einen zu milden Januar und einen normalen Februar vorher.

Das IRI bleibt bei seiner Novemberprognose eines mit leicht erhöhter Wahrscheinlichkeit zu milden Winters.

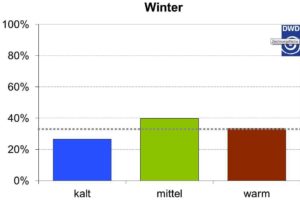

Der DWD (Offenbach) sieht nun eine deutlich erhöhte Wahrscheinlichkeit für einen normalen Winter:

Die NASA (US- Weltraumbehörde) schwenkt komplett um und kündigt nun einen zu kalten Januar und einen etwas zu kalten Februar an (hier wird nur der Januar gezeigt, Europa liegt ganz links oben in der Karte):

Und das CFSv2- Modell des NOAA (Wetterdienst der USA, folgende 2 Abbildungen, Eingabezeitraum 16. bis 25.12.2016): Januar (oben) eher normal, nur in Teilen des Alpenraumes etwas zu mild und in Südosteuropa zu kalt; Februar (unten) überall viel zu mild. Die vorhergesagten Temperaturabweichungen beziehen sich auf die Mittelwerte der Periode 1981 bis 2010. Die fast täglich aktualisierten, aber leider oft falschen Prognosen unter http://www.cpc.ncep.noaa.gov/products/people/wwang/cfsv2fcst/ (Europe T2m, ganz unten in der Menütabelle; E3 ist der aktuellste Eingabezeitraum):

Die Mehrzahl dieser Langfristprognosen deutet also weiterhin einen normalen bis etwas zu milden Hochwinter 2017 an.

Fazit: Die Prognosesignale sowie die Vorhersagen der Wetterdienste und Institute bleiben sehr widersprüchlich. Es deuten sich aber zumindest einige merklich kältere Phasen im Hochwinter 2017 an, besonders im Januar, zeitweise auch mit nördlichen Strömungsanteilen eher nasskalt; doch insgesamt fällt dieser mit erhöhter Wahrscheinlichkeit normal bis etwas zu mild aus, wenngleich etwas weniger, als in den Vorjahren. Zumindest in den Mittelgebirgen (über 600 Meter) könnte ab Anfang Januar für längere Zeit gut Wintersport möglich sein und auch im Tiefland öfter mal Frost und Schnee herrschen. Geschätzte Januar-Monatsmitteltemperatur 2017 für Erfurt-Bindersleben (Mittel 1981- 2010 minus 0,3°C) -1,5 bis +2,5°C (etwas zu kalt bis deutlich zu mild). Für Feb. 2017 lässt sich noch kein Temperaturbereich schätzen, doch ist ein zu milder Februar momentan noch wahrscheinlicher, als ein zu kalter.

Eine Bewertung der ursprünglichen Winterprognosen (Stand November) erfolgt im Laufe des Monats März.

Zusammengestellt von Stefan Kämpfe, unabhängiger Klimaforscher, am 27.12. 2016