Zahlen lügen nicht: Deutschlands Energiewende hatte Null Auswirkungen auf Emissionen – bestenfalls

Man hört regelmäßig Kommentare des Inhalts, dass die USA dasjenige Land sind, welches am meisten von Klima-Kontrarians betroffen ist und dass diese Debatte in anderen Teilen der Welt (vor allem in Europa) gar nicht existiert. Dort herrscht Konsens hinsichtlich der Notwendigkeit zu handeln, usw. Ein deutscher Staatsbürger dazu:

Unter den 97% der Wissenschaftler, die bzgl. der Grundlagen übereinstimmen, sind viele konservative Wissenschaftler. Dass es da ein Problem gibt, ist keine parteiische Angelegenheit. Wie man es löst, ist Sache der Politik. Das Pariser Klima-Abkommen wurde von fast 200 Ländern unterzeichnet und folglich von vielen konservativen Regierungen. Sie akzeptieren, dass Klimawandel ein reales Problem ist. Europäische konservative Parteien mögen weniger aktiv sein, leugnen aber nicht, dass es ein Problem gibt. In Europa leugnen nur ,Trumpische‘ rassistische Parteien dieses Problem. Dass die Klima-„Debatte“ zumeist ein amerikanisches Problem ist zeigt, dass es bei dem Problem nicht um konservativ vs. liberal geht, dass es nicht um das Fehlen wissenschaftlicher Beweise geht und dass es kein Problem der Kommunikation von Wissenschaft ist. Das Problem ist der korrumpierende Einfluss des Geldes in der US-Politik und den US-Medien.

Ich nehme ihn beim Wort.

Deutschland ist das Land mit dem stärksten Konsens um die Notwendigkeit, ,etwas‘ zu tun bzgl. Klimawandel. Keine andere Nation hat einen Plan eingesetzt, der so ambitioniert ist wie die Energiewende [hoch interessant, was Wikipedia Englisch zum deutschen Terminus ,Energiewende‘ schreibt. Anm. d. Übers.] Das Programm begann im Jahre 2000 und setzte eine Objektive bis zum Jahr 2050 – obwohl bizarrerweise, wie es üblich ist bei diesen ,Programmen‘ und ,Roadmaps‘, die Objektive in Gestalt absoluter Treibhausgas-Emissionen angegeben wird anstatt in Emissions-Intensität der Wirtschaft. Das Problem ist einfach zu erfassen:

a) Falls Emissionen im Jahre 2050 höher sind als geplant, werden Befürworter behaupten, dass es dazu kam, weil das ökonomische Wachstum stärker als erwartet war. Mit anderen Worten: Befürworter könnten behaupten, Klimapolitik sei erfolgreich gewesen, weil die Emissionen geringer waren als ohne ein solches Programm. Natürlich haben Befürworter von Emissionskürzungen nie klargestellt, wie viel ökonomisches Wachstum sie überhaupt erwarten, so dass diese Behauptung in keinem Falle falsifizierbar ist.

b) Falls die Emissionen bis 2050 gleich oder geringer sind als im Plan vorgesehen, werden deren Befürworter das Programm als erfolgreich darstellen – obwohl die Abnahme der Emissionen in Wirklichkeit ökonomischen Krisen und/oder einem Rückgang der Bevölkerung geschuldet sein kann.

Ich möchte nicht wiederholend klingen, aber die einzige sinnvolle Maßzahl ist die Emissions-Intensität des BIP und hier im Einzelnen, wie stark diese Intensität pro Jahr abnimmt. In diesem Beitrag werde ich eine positive Zahl zeigen, d. h. wie viel mehr BIP-Dollars pro Tonne CO2-Emissionen wir bekommen durch Verbrennung, sind doch Emissionen von Methan, Ozon, N20 und CO2 durch Landverbrauch höchst unsicher.

Wie auch immer, kommen wir zurück zur Energiewende. Wir sind jetzt zu einem Drittel mit dem Programm durch. Falls er also irgendwelche Auswirkungen haben sollte, müssten wir jetzt sehen, dass…:

a)…die Rate der Dekarbonisierung in Deutschland höher ist als im Zeitraum zuvor.

b)…die Rate höher ist als in anderen Ländern, welche sich vermutlich nicht so sehr um Klima-Maßnahmen kümmern. Im Vergleich zu den USA könnte dieser Unterschied erheblich sein.

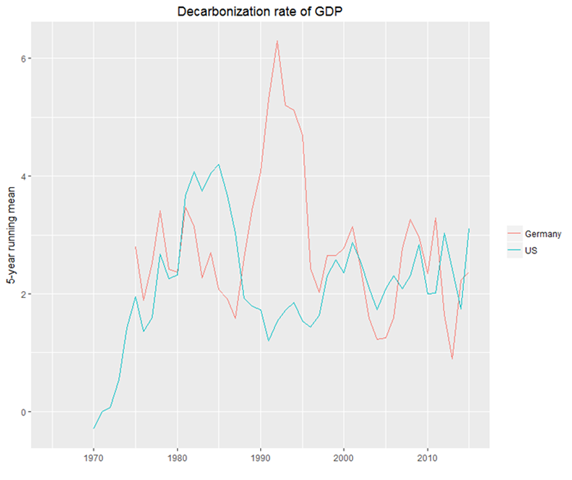

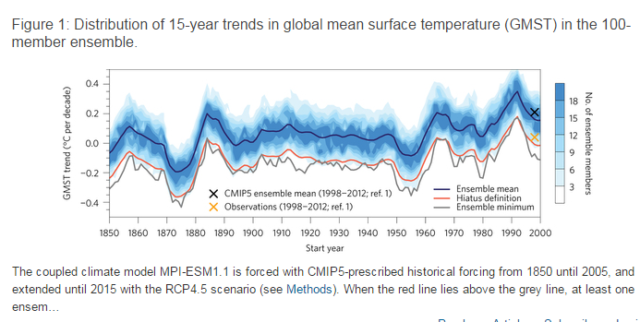

Die folgende Graphik zeigt die Dekarbonisierung in den USA seit 1966, liegen doch Emissionsdaten erst seit 1965 vor. Wir können Gleiches für Deutschland seit dem Jahr 1971 sehen mit Beginn von Datenreihen des BIP des Landes – zumindest auf der Website der Weltbank:

Hoppla: Die Rate der Abnahme in Deutschland ist nicht nur die Gleiche wie in den USA, sondern liegt niedriger als vorher!

Genauer: das Mittel der Jahre 2000 bis 2015 beträgt für Deutschland 2,06% und für die USA 2,26%. Von 1971 bis 1999 liegt das Mittel in Deutschland bei 3,13%. Aber diese Zahlen werden aufgebläht durch sehr starke Zunahme während der Jahre 1989 bis 1992, als in der ehemals kommunistische Ökonomie Ostdeutschlands die meisten CO2-intensiven Betriebe außer Betrieb gingen (was kaum Auswirkungen auf das BIP hatte). Lässt man diese vier Jahre außen vor, liegt das Vor-Energiewende-Mittel von Deutschland immer noch bei 2,58% oder ein wenig höher als im Jahre 2000 – obwohl man erwähnen muss, dass den Zahlen der siebziger Jahre durch hohe Ölpreise ,nachgeholfen‘ worden ist.

Ich denke, das Beste, was man sagen kann ist, dass die Dekarbonisierungs-Rate von Deutschland etwa die Gleiche ist wie zuvor.

Um es ganz klar zu sagen: eine höhere Rate der Dekarbonisierung ist das Minimum, was man von einer Klimapolitik erwarten muss. Sie ist notwendig, aber nicht ausreichend, weil es jener Politik immer noch möglich ist, so viel zu kosten, wie es die Reduktion von Emissionen nicht wert ist. Man sollte nicht automatisch eine höhere Dekarbonisierungsrate für besser halten als eine niedrigere. Mit anderen Worten, man muss die Kosteneffektivität berücksichtigen – wie es mit allen Dingen der Fall ist, für die wir Geld ausgeben.

In Deutschland gibt es keinen Grund, über die Kosteneffektivität der Klimapolitik zu debattieren, weil deren Effektivität im besten Falle Null ist.

Befürworter von Emissionskürzungen folgen ihren eigenen Ansichten und nicht ihren eigenen Fakten. Falls jemand geltend machen will, dass Klimapolitik tatsächlich erfolgreich war, ob nun in Deutschland oder weltweit, muss Fehler in den Zahlen finden, welche die Weltbank und BP verbreiten. Falls die Daten bzgl. Verbrennung fossiler Treibstoffe signifikant falsch wären, wäre das eine dicke Schlagzeile. Falls die Daten des deutschen BIP-Wachstums (oder das der Welt) signifikant falsch wären, wäre das eine gewaltige Nachricht.

Folglich ist es sehr einfach zu beweisen, dass die Klimapolitik erfolgreich war: man weise die Zahlen als falsch nach.

Man könnte einen Nobelpreis gewinnen.

Link: https://wattsupwiththat.com/2017/05/02/numbers-dont-lie-germanys-energiewende-has-had-zero-impact-on-emissions-at-best/

Übersetzt von Chris Frey EIKE