Das potentielle Auftreten eines natürlichen oder eines vom Menschen induzierten physikalischen Ereignisses, Trends oder physikalischer Auswirkungen, welches zu Todesfällen, Verletzungen oder anderen gesundheitlichen Beeinträchtigungen führt, ebenso wie zu Verlusten an Eigentum, Infrastruktur, Lebensspanne, Dienstleistungen, Ökosystemen und Umwelt-Ressourcen. In diesem Report bezieht sich der Begriff Gefahr üblicherweise auf klimabezogene physikalische Ereignisse oder Trends oder deren Auswirkungen.

Schädigen Menschen die Umwelt? [Ja! – vor allem mit der Errichtung von Windrädern! Anm. d. Übers.]. Falls wir mal annehmen, dass die Menschen den größten Teil der gegenwärtigen globalen Erwärmung verursachen – ist diese Erwärmung gefährlich? Falls wir der Umwelt gefährlich sind – sollten wir unsere Bevölkerung auf irgendeine Art und Weise limitieren? Falls globale Erwärmung potentiell gefährlich ist und wir annehmen, dass menschliche CO2-Emissionen der Grund dafür sind – würden wir nicht besser fahren, uns an die vom Menschen verursachte globale Erwärmung anzupassen und weiterhin fossile Treibstoffe verbrennen – oder müssen wir den Verbrauch fossiler Treibstoffe beenden, um Emissionen zu begrenzen? Um all das wird es in diesen Beiträgen gehen.

In diesem Beitrag werden wir uns die extremeren Behauptungen vornehmen. Einige behaupten, dass Menschen gefährlich sind, dass wir zu viele Nachkommen zeugen, dass wir zu viele Ressourcen verbrauchen, dass wir eine existenzielle Bedrohung für uns selbst und den Rest der Welt sind. Bevor wir also in die Ökonomie und die Gefahren eines Klimawandels einsteigen, wollen wir über diese so genannten „existentiellen“ Bedrohungen sprechen.

Kann globale Erwärmung die Erde zerstören?

Eine allgemein vorgebrachte Hypothese ist, dass globale Erwärmung eine existenzielle Bedrohung für die Menschen und die Erde als Ganzes darstellt. Oftmals wird hierbei angeführt, dass die Erde so werden wird wie die Venus mit einer Temperatur an der Oberfläche von 464°C (oder 250°C, wie Stephen Hawking einmal fälschlich annahm) und bar jeden Lebens. James Hansen nannte dies einmal den Runaway-Treibhauseffekt. Die Wahrheit ist, dass weder die Venus noch die Erde einen „Runaway“ durchlaufen. Außerdem gibt es auf der Erde Ozeane, auf der Venus dagegen fast gar kein Wasser. 99,9% der Wärmekapazität und der thermischen Energie der Erde ist in unseren Ozeanen gespeichert. Weniger als 0,1% der thermischen Energie der Erde ist in der Atmosphäre gespeichert. Die Oberfläche der Erde hat fünf mal mehr thermische Energie gespeichert als die Oberfläche der Venus (hier). Die Temperatur an der Erdoberfläche ist niedriger, weil sich fast die gesamte thermische Energie in den Ozeanen befindet und diese eine enorme Wärmekapazität aufweisen. Die Ozeane der Erde allein speichern viel mehr thermische Energie als die gesamte Oberfläche der Venus bei einer Temperatur von 464°C. Falls unsere Ozeane weiter bestehen bleiben, ist es unmöglich, dass unser Planet eine gefährliche Temperatur erreicht. Sie müssten vollständig verdampfen und der Wasserdampf in den Weltraum entweichen. Kein Treibhausgas kann dies jemals bewirken.

Gedankenexperiment: Falls sich unsere Atmosphäre auf irgendeine Weise auf 1000°C erhitzen sollte, keine thermische Energie in den Weltraum entweicht und alles davon in die Ozeane transferiert wird, würde die Wassertemperatur der Ozeane um ein Grad steigen. Dies ist der einfachste Weg, den Puffer-Effekt der Ozeane bzgl. Temperatur zu erklären, den ich mir vorstellen kann. Eine weitere, vollständigere Beschreibung, wie tropische Ozeane die Oberflächentemperatur der Erde auf maximal 30°C limitieren findet sich bei Newell and Dopplick, 1979 oder bei der Diskussion hier. Atmosphärische Temperaturen, vor allem die Temperatur an der Erdoberfläche (üblicherweise gemessen in einer Höhe von 2 Metern) haben nur sehr wenig Einfluss auf das langzeitliche Klima (im Zeitmaßstab von Jahrzehnten oder länger). Versuche, die mittlere Temperatur an der Erdoberfläche zu messen (HADCRUT Datenbasis, GISTEMP, etc.) sind nützlich, leben wir doch schließlich hier; aber deren Verwendung, um Auswirkungen auf oder Stärke des globalen Klimawandels zu messen, ist so, als ob man die Auswirkungen einer Bombenexplosion mittels Kräuselung auf der Oberfläche einer Teetasse in einem Raum in einer Entfernung von 100 km misst. Die Kräuselung mag mit der Explosion zusammenhängen, aber man befände sich viel zu weit vom Ort des Geschehens entfernt, um genau zu sein. Die Ozeane bedecken 70% der Erdoberfläche und enthalten fast die gesamte thermische Energie; also sollten wir uns auf die Ozeane konzentrieren.

Die Ozeane sind der Schlüssel

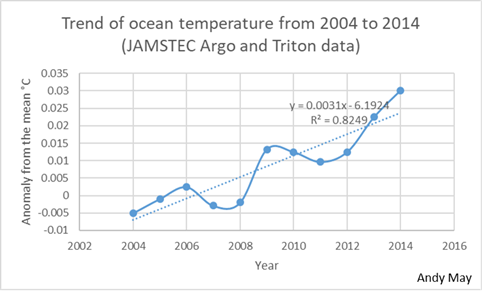

Die Temperatur der Ozeane steigt in der Tat. Aber globale Daten liegen erst seit dem Jahr 2004 vor und auch nur bis zu einer Tiefe von 2000 Metern. Die mittlere Tiefe der Ozeane beträgt aber 3688 Meter. Falls wir annehmen, dass die Temperatur in einer Tiefe von 3688 Metern etwa 0°C beträgt, was angesichts einer mittleren Temperatur in einer Tiefe von 2000 Metern von 2,4°C nicht unvernünftig ist, dann erleben wir gegenwärtig eine Erwärmung der Ozeane pro Jahr bis in diese Tiefe von 0,0031°C. Falls sich dies fortsetzt (das wird es nicht), würde es 1000 Jahre dauern, die Temperatur der Erde an der Oberfläche um 3°C steigen zu lassen, was kaum alarmierend ist. Mehr dazu hier.

In zukünftigen Beiträgen wird es um den Vergleich der ökonomischen Kosten gehen zwischen einer Abschwächung der Erwärmung via Reduktion oder Eliminierung fossiler Treibstoffe einerseits und Anpassung an die Erwärmung andererseits. In diesem Beitrag werden wir die Einflüsse des Menschen auf die Umwelt allgemein behandeln. Menschen sind Teil der Natur, dabei spielt es keine Rolle, ob wir aus natürlichen Prozessen hervorgegangen sind oder durch eine überirdische Macht kreiert worden sind – in jedem Falle sind wir Teil der Natur. Deepak Chopra hat die „Gaia-Hypothese“ untersucht, und er fragt sich, ob wir ein Krebsgeschwür auf der Erde sind. David Attenborough hat uns als eine Plage auf der Erde angesehen. In diesem Beitrag befassen wir uns mit diesem Gedanken. Wir müssen den Gedanken erörtern, dass der Mensch eine existentielle Bedrohung des Menschen ist, bevor wir uns mit der Ökonomie der globalen Erwärmung befassen. Vieles in dieser Diskussion hängt von Standpunkten ab. Übernehmen wir den humanistischen Standpunkt, dass unsere Maßnahmen der Menschheit helfen sollten? Oder steht ganz oben auf einer Art metaphysischer „Gaia“ eine gottähnliche Kreatur, unter der sich die Menschheit unterzuordnen hat, um Gaia zu dienen? Wir sind dieser Gaia-Kreatur noch nicht begegnet und bevorzugen inbrünstig den humanistischen Standpunkt. Wir werden unsere Argumente aus der Sicht von Humanisten vorbringen.

Ökonomisches Wachstum, Wohlstand, Gesundheit und die Umwelt

Im Allgemeinen müssen wir unseren Mythos der Ökonomie mit der Beeinträchtigung der Umwelt konfrontieren. Wir haben uns daran gewöhnt zu glauben, dass wir vor einer unausweichlichen Wahl stehen zwischen höherem ökonomischen Wohlstand und einer grüneren Umgebung. Aber überraschenderweise, was mit diesem ganzen Buch dokumentiert wird, resultiert die Umweltentwicklung oftmals aus der ökonomischen Entwicklung – nur wenn wir ausreichend Reichtum anhäufen, können wir uns den relativen Luxus leisten, uns um die Umwelt zu kümmern. Auf diesem allgemeinsten Niveau geht diese Schlussfolgerung eindeutig aus Abbildung 2 hervor, in welcher sich zeigt, dass ein höheres Einkommen allgemein korreliert mit größerer umweltlicher Nachhaltigkeit“. – Björn Lomborg, The Skeptical Environmentalist: Measuring the Real State of the World (pp. 32-33).

Abbildung 2: (Datenquellen: Environmental Performance Index: NASA, GDP in PPP$: World Bank)

Abbildung 2 ist eine aktualisierte Version einer Abbildung in The Skeptical Environmentalist, wir haben die NASA-Messungen der Umweltqualität (EPI) für das Jahr 2016 geplottet im Vergleich zum BIP der meisten Länder in der Welt. Einige Länder sind namentlich genannt. Der Environmental Productivity Index (EPI) der NASA SEDAC ist auf der Y-Achse geplottet und das purchase-power-parity dollar (PPP$) BIP für jedes Land auf der X-Achse. Der Plot zeigt Punkte für 164 Länder, aus vielen Ländern standen keine Daten zur Verfügung, und Luxemburg wurde ausgenommen wegen des sehr hohen BIP pro Person von 102.831 Dollar, EPI = 86,6; das ist etwa das Gleiche wie in der Schweiz). Eine logarithmische Linie kleinster Quadrate durch die Daten zeigt eine Steigung von R² = 0,7; obwohl es viele andere Faktoren gibt, die bei allen geplotteten Ländern sowohl BIP als auch EPI beeinflussen. Allgemein hatte Lomborg in seinem Buch aus dem Jahr 2001 also recht: die wohlhabenderen Länder neigen dazu, eine höhere Umweltqualität aufzuweisen. Man kann sich davon auch überzeugen durch Betrachtung von Entwicklungsländern und entwickelten Ländern auf der ganzen Welt. Geht das BIP pro Person erst einmal über 2000 Dollar PPPS$ pro Person hinaus, wird es zu einem Faktor bzgl. Umweltqualität, bis es sich in den hohen Achtzigern verflacht bei etwa 50.000 PPS$ pro Person.

Krankheiten und Gesundheit

„Im Oktober 1998 veröffentlichte Prof. David Pimentel von der Cornell University als Leitautor einen Artikel zum Thema [übersetzt] „Ökologie zunehmender Krankheit“ [Ecology of increasing disease] in dem begutachteten Journal BioScience. Die grundlegende Prämisse der Studie lautet, dass es bei zunehmender Bevölkerung zu zunehmender Umweltverschlechterung kommt, zu verstärkter Verschmutzung und als Konsequenz mehr Krankheiten“. – Lomborg, Bjørn. The Skeptical Environmentalist: Measuring the Real State of the World (S. 22).

In einer Studie aus dem Jahr 2007 setzten Pimentel, et al. noch eins drauf:

Die Weltgesundheitsorganisation WHO und andere Organisationen berichten, dass die Verbreitung menschlicher Krankheiten über das vorige Jahrzehnt hinweg rapide zugenommen hat. Bevölkerungswachstum und die Verschmutzung von Wasser, Luft und Boden tragen weltweit zu der steigenden Zahl von Krankheitsfällen bei. Gegenwärtig schätzt man den Anteil der Todesfälle weltweit durch Umweltverschlechterung auf 40%. Die Ökologie zunehmender Krankheiten setzt sich aus komplexen Faktoren zusammen, darunter Bevölkerungswachstum, Umweltverschlechterung und die gegenwärtige Unterernährung von etwa 3,7 Milliarden Menschen auf der Welt.

Die in dem Zitat erwähnten „40% der weltweiten Todesfälle“ stammen aus Pimentels Studie aus dem Jahr 1998 und beziehen sich auf das Lomborg-Zitat zuvor. Lomborg hat über Pimentel 1998 viel zu sagen. Erstens, die „40% der weltweiten Todesfälle“ wird in der Studie an keiner Stelle erklärt, ebensowenig wie die Gesamtzahl der Todesfälle oder die Zahl aufgrund von Verschmutzung im Artikel spezifiziert wird. Weiter unten in dem Artikel ändert sich die Ursache von „Verschmutzung“ zu „Verschmutzung, Tabak und Mangelernährung“. In einem späteren Interview erklärte er, dass mit ,Rauchen‘ auch das Verbrennen von Holz in Wohnungen in der Dritten Welt gemeint ist, wodurch pro Jahr etwa 4 Millionen Menschen sterben, Rauchen fordert 3 Milionen Todesfälle pro Jahr. Mangelernährung kostet 6 bis 14 Millionen Menschenleben. Die WHO schätzt, dass die Luftverschmutzung außerhalb von Häusern etwa einer halben Million Menschen pro Jahr den Tod bringt, was etwa 12% der Anzahl der innerhalb von Wohnungen auftretenden Verschmutzungs-Todesfälle ausmacht. Pimentel et al. haben also in beiden Studien eine sehr kleine Zahl von Todesfällen mit Bezug auf Verschmutzung genannt, haben Rauchen, Mangelernährung und Menschen, die zu Hause am offenen Feuer mit Holz ihr Essen kochen oder heizen einbezogen – und versucht zu behaupten, dass all diese Menschen wegen der Umweltverschmutzung gestorben seien. Wer waren die Begutachter?

Die Haupt-Behauptung der Studie lautet, dass Krankheiten zunehmen, aber das ist auch falsch:

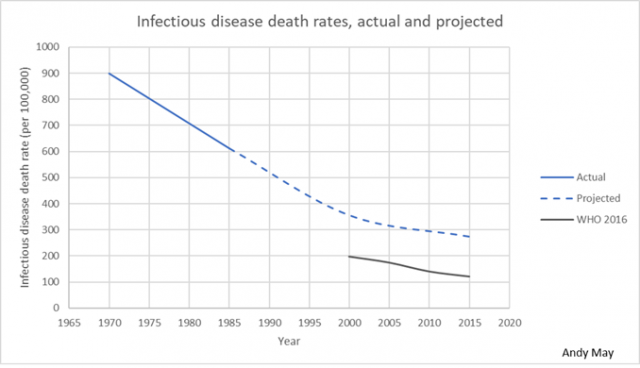

Die Behauptungen hinsichtlich zunehmender Infektionskrankheiten ist absolut falsch, wie man Abbildung 3 entnehmen kann. Infektionskrankheiten haben seit 1970 abgenommen, obwohl Beweise nur aus einigen Ländern vorliegen … Genauso kann man davon ausgehen, dass Infektionskrankheiten auch in Zukunft weiter zurückgehen, zumindest bis zum Jahr 2020. Selbst in absoluten Zahlen wird erwartet, dass die Anzahl von Todesfällen durch Infektionskrankheiten von 9,3 auf 6,5 Millionen sinken wird. – Lomborg, Bjørn. The Skeptical Environmentalist: Measuring the Real State of the World (S. 26).

Die in Abbildung 3 gezeigten Daten werden auch gestützt durch Murray and Lopez, 1996 und Murray and Lopez, 1997. Die blaue Kurve in Abbildung 3 stammt von Daten, die von Bulato zusammengestellt und 1993 veröffentlicht worden waren. Die dunkelgraue Kurve stammt von von Daten, die aus 186 Ländern von der WHO zusammengestellt und im Dezember 2016 veröffentlicht worden sind. Bulato hat den Trend richtig erfasst, war aber etwas zu pessimistisch. In Wirklichkeit sank die Rate von Infektionskrankheiten schneller als von ihm projiziert. Also hatte Lomborg in seinem Buch auch in diesem Punkt recht:

Schaut man auf Trends, zieht Pimentel frohgemut kurzfristige Beschreibungen heran. Er betrachtet die Infektionskrankheit mit den meisten Todesfällen, Tuberkulose, und behauptet, dass Todesfälle aufgrund dieser Krankheit von 2,5 Millionen im Jahre 1990 auf 3 Millionen im Jahre 1995 gestiegen seien, und er erwähnt die Erwartung für das Jahr 2000 von 3,5 Millionen Todesfällen. Allerdings betrugt die tatsächliche Anzahl von Todesfällen durch Tuberkulose im Jahre 1999 1,669 Millionen, und die von Pimentel am häufigsten genannte Quelle bei der WHO schätzt fast stabil 2 Millionen Todesfälle während der neunziger Jahre. – Lomborg, Bjørn. The Skeptical Environmentalist: Measuring the Real State of the World (S. 22-23).

Den WHO-Statistiken zufolge gab es im Jahr 2000 1.667.000 Tuberkulose-Todesfälle, im Jahr 2015 waren es 1.373.000 Todesfälle. Das entspricht einem Rückgang von 18% innerhalb von 15 Jahren:

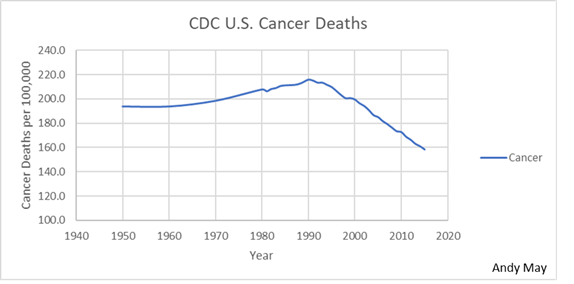

Auch versucht Pimentel mit Verweis auf die Gefahren von Chemikalien und Pestiziden eine Verbindung herzustellen, indem er darauf hinweist, dass „Todesfälle in den USA in Verbindung mit Krebs von 331.000 im Jahre 1970 auf etwa 521.000 im Jahre 1992 zugenommen haben“. Allerdings ignoriert er auch hier eine zunehmende (24 Prozent) und eine alternde Bevölkerung (was den Ausbruch von Krebs wahrscheinlicher macht). Die altersangepasste Todesrate durch Krebs in den USA lag tatsächlich 1996 niedriger als 1970, trotz gestiegener Fälle von Krebstoten durch Rauchen. Eine Adjustierung bzgl. Rauchen ergibt eine seit 1970 stetig um 17 Prozent sinkende Todesrate“. – Lomborg, Bjørn. The Skeptical Environmentalist: Measuring the Real State of the World (S. 23).

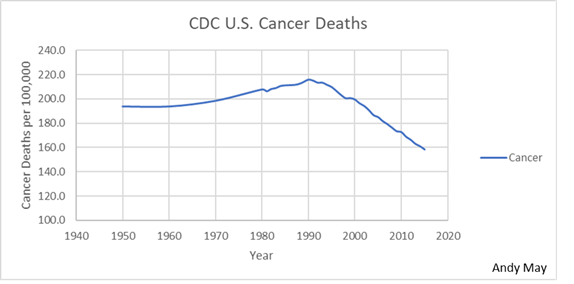

In Wirklichkeit ist die Todesrate durch Krebs von 1972 bis 1990 der CDC zufolge tatsächlich gestiegen, doch gab es nach 1990 einen dramatischen Rückgang, wie man in Abbildung 4 erkennt. Die in Abbildung 4 gezeigten Zahlen sind vom CDC altersangepasst:

Abbildung 4: Altersangepasste Todesrate durch Krebs. Daten von CDC.

In diesem Fall liegt Pimentel richtig mit der von ihm angeführten Zunahme der Krebstoten von 1970 bis 1992, selbst nach Adjustierung bzgl. Alter und Bevölkerung. Allerdings hat auch Lomborg recht mit seiner Aussage, dass die adjustierte Krebs-Todesrate im Jahre 1996 niedriger lag als 1970. Heute liegt sie viel niedriger.

Im Jahre 2002 kam die WHO zu dem Ergebnis, dass es den Einfluss von Treibhausgas-Emissionen auf Gesundheit und Krankheiten aufgrund der aktuellen Datenlage nicht ausmachen könne: „Das Klima zeigt eine natürliche Variabilität, und dessen Auswirkungen auf die Gesundheit werden von vielen anderen bestimmenden Faktoren beeinflusst. Es gibt gegenwärtig nur unzureichende langfristige Daten hoher Qualität bzgl. Klima-empfindlicher Krankheiten, so dass eine direkte Messung der Auswirkungen auf die Gesundheit durch den anthropogenen Klimawandel nicht möglich ist, vor allem in den verwundbarsten Bevölkerungen. – Pielke Jr., Roger. The Climate Fix: What Scientists and Politicians Won’t Tell You About Global Warming (S. 176-177).

Die spekulativen Zahlen der WHO bildeten die Grundlage für Schätzungen, welche in einem Report des Global Humanitarian Forum GHF aus dem Jahr 2009 auftauchten. Diese Nicht-Regierungs-Organisation wird betrieben durch den ehemaligen UN-Generalsekretär Kofi Annan. Die GHF folgert, dass der durch Treibhausgase getriebene Klimawandel gegenwärtig verantwortlich ist für 154.000 Todesfälle pro Jahr infolge Mangelernährung, 94.000 Todesfälle pro Jahr durch Diarrhoe und 54.000 Todesfälle durch Malaria. Diese Zahlen werden dann addiert zu Todesfällen durch Wetterereignisse (welche im Verlauf des vorigen Jahrhunderts dramatisch abgenommen haben), und man kommt auf eine Zahl von 315.000 Menschen, die pro Jahr infolge des vom Menschen verursachten Klimawandels sterben sollen. Schaut man genauer auf die Zahlen bzgl. der Gesundheit, zeigt sich, dass die im WHO-Report von 2002 genannten Zahlen genau zwei mal auftauchen. Die WHO sagt dazu, dass die Schätzungen „nicht mit der empirischen Wissenschaft übereinstimmen“. Mit anderen Worten, die Zahlen scheinen lediglich eine grobe Schätzung aufgrund früherer Spekulationen zu sein. „Analysen“ wie diese sind es, die einigen Bereichen der Klimawissenschaft böse Namen anhängen und eine ungesunde Politisierung der Forschung zeigen, nur um vorgegebenen Ursachen zu genügen. – Pielke Jr., Roger. The Climate Fix: What Scientists and Politicians Won’t Tell You About Global Warming (S. 177).

Hinsichtlich der gesundheitlichen Auswirkungen der globalen Erwärmung liest man im 5. Zustandsbericht des IPCC, geschrieben von der Arbeitsgruppe II:

Bis zur Mitte dieses Jahrhunderts wird der projizierte Klimawandel die menschliche Gesundheit hauptsächlich durch Verschärfung der Gesundheitsprobleme beeinträchtigen, die es heute schon gibt (sehr hohes Vertrauen). Während des 21. Jahrhunderts wird erwartet, dass der Klimawandel zur Zunahme gesundheitlicher Probleme in vielen Gebieten führen wird, besonders in Entwicklungsländern mit niedrigem Einkommen als im Vergleich einer Grundlinie ohne Klimawandel (hohes Vertrauen). Beispiele enthalten eine größere Wahrscheinlichkeit von Verletzungen, Krankheiten und Todesfällen infolge intensiverer Hitzewellen und Brände (sehr hohes Vertrauen), eine zunehmende Wahrscheinlichkeit von Mangelernährung aufgrund geringerer Erzeugung von Nahrungsmitteln in armen Gebieten (hohes Vertrauen), Risiken durch verloren gehende Kapazität von Arbeitsplätzen sowie verringerte Arbeitsproduktivität in anfälligen Völkern und zunehmende Risiken durch Krankheiten durch verdorbene Nahrungsmittel und verschmutztes Wasser (sehr hohes Vertrauen) und Vektor-Krankheiten [?] (mittleres Vertrauen). Gesundheitliche Auswirkungen werden reduziert, aber nicht eliminiert werden, in Völkern, welche von einer rapiden sozialen und ökonomischen Entwicklung profitieren (hohes Vertrauen).

Eine raffinierte Wortwahl lässt dieses Zitat zumeist wahrhaftig klingen, ist jedoch sehr irreführend. Wie wir sehen werden, kann globale Erwärmung zu einer höheren Anzahl von Hitze-bezogenen Todesfällen führen, aber Todesfälle mit Bezug auf Kälte dürften diese Zunahme weit übersteigen. Dies liegt einfach daran, dass weltweit viel mehr Menschen durch Kälte als durch Hitze sterben. Oben wurde bereits gezeigt, dass Infektionskrankheiten und Krebs abnehmen. Außerdem nimmt auch Mangel- und Unterernährung mit rapider Rate ab. Folglich müssen die Modelle, die für diese Projektionen herangezogen worden waren, validiert werden. Wie schon oft in den IPCC-Berichten gesehen wird über alles und jedes berichtet, sofern es den Klimawandel negativ darstellt, während alle und jede Positiva ignoriert werden, egal wie gut diese dokumentiert sind.

Lebenserwartung

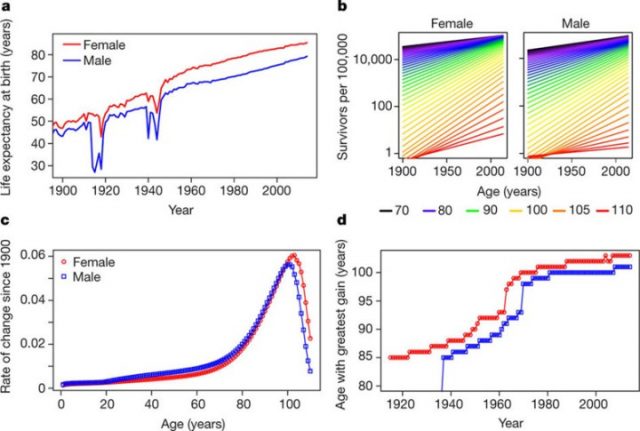

Da 100% von uns Menschen irgendwann an irgendetwas sterben, ist die Ermittlung der mittleren Lebensspanne vielleicht eine bessere Maßgabe für die menschliche Gesundheit. Diese beträgt gegenwärtig global 71,5 Jahre. Dong, et al., 2016, Nature, zufolge nimmt die Lebenserwartung global zu, siehe Abbildung 5. The Lancet (Landrigan, et al., 2017) zufolge ist die Umweltverschmutzung ursächlich für 16% der weltweiten Todesfälle oder neun Millionen weltweit, die vorzeitig sterben. 92% dieser vorzeitigen Sterbefälle treten in Ländern mit niedrigem oder mittlerem Einkommen auf.

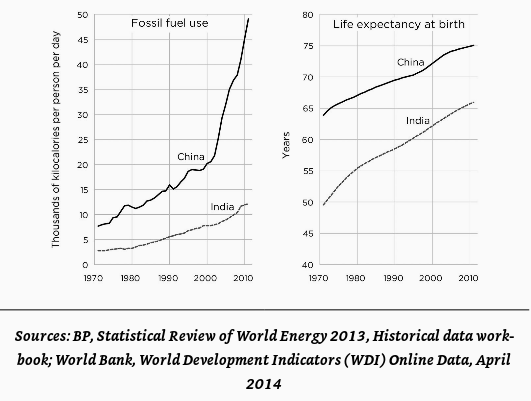

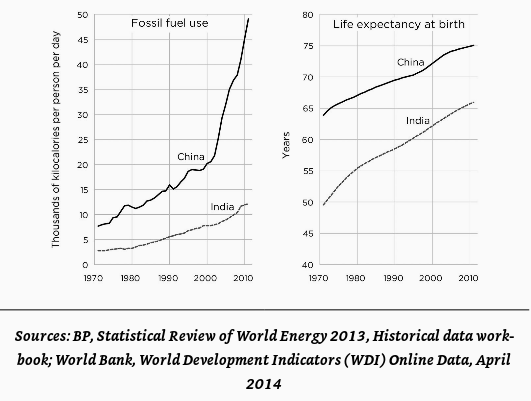

Es gibt außerdem eine Korrelation zwischen dem Verbrauch fossiler Treibstoffe einerseits und der Lebenserwartung in der entwickelten Welt andererseits, wie aus Abbildung 6 hervorgeht:

Abbildung 6 (Aus Epstein hier.)

Die Menschen leben nicht nur länger, sondern auch viel besser:

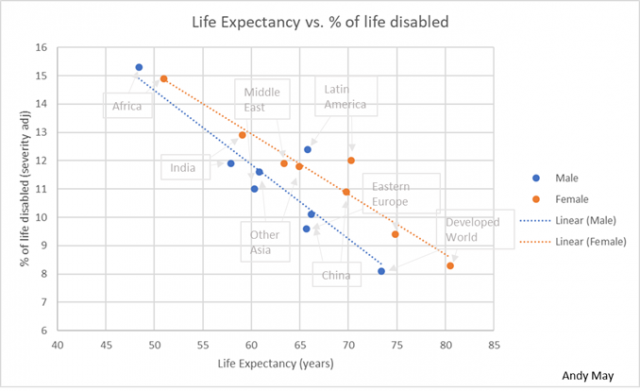

Das ist alles gut und schön, sagen Pessimisten, aber was ist mit der Lebensqualität im Alter? Sicher, die Menschen leben länger, aber nur, indem ihren Leben Leiden und Behinderungen durch alle möglichen Krankheiten hinzugefügt werden. Dem ist aber nicht so. Einer amerikanischen Studie zufolge sank die Rate körperlicher Behinderungen bei Menschen über 65 Jahren zwischen 1982 und 1999 von 26,2% auf 19,7% – das ist ein doppelt so starker Rückgang wie die Sterberate. Chronische Krankheiten vor dem Tod verkürzen sich kaum, wenn überhaupt, anstatt sich zu verlängern, trotz besser Diagnose und mehr Behandlungen – die ,Kompression der Sterblichkeit‘ lautet der technische Terminus. Die Menschen leben nicht nur länger, ihr Sterben zieht sich auch nicht mehr so lange hin. – Ridley, Matt. The Rational Optimist: How Prosperity Evolves (P.S.) (S. 18).

Wir leben länger, aber wurde uns lediglich mehr Zeit gegeben, in welcher wir krank sind? Die Antwort ist zwingend: Absolut nein! Wir sind allgemein während der letzten Jahrhunderte viel gesünder geworden. – Lomborg, Bjørn. The Skeptical Environmentalist: Measuring the Real State of the World (S. 54-55).

In Abbildung 7 erkennt man, dass die Lebenserwartung in der entwickelten Welt bei der Geburt so hoch wie nie zuvor ist, während die Prozentzahl derjenigen, die mit Behinderungen sterben, so gering wie nie zuvor war. Die Daten stammen von Murray and Lopez 1997, Tabelle 4. Die Behinderungen, aufgetragen auf der Y-Achse, sind nach Schwere der Behinderungen adjustiert. Mit steigendem Wohlstand und mehr Energieverbrauch leben die Menschen nicht nur länger, sondern sind auch gesünder. Der Gedanke, dass die Menschen in vorindustrieller Zeit glücklich, gesund und in Einklang mit der Natur lebten, ist Unsinn, wie von dem Historiker Lawrence Stone von der Princeton University erklärt (hier):

Die fast totale Ignoranz sowohl persönlicher als auch der öffentlichen Hygiene bedeutete, dass verdorbene Lebensmittel und verunreinigtes Wasser eine konstante Gefahr waren … Die Folge dieser primitiven sanitären Bedingungen waren ständige Ausbrüche bakterieller Mageninfektionen, die schlimmste von allen Dysenterie. Diese Krankheit forderte viele Opfer beiderlei Geschlechts und jeden Alters innerhalb weniger Stunden oder Tage. Magenkrankheiten der einen oder anderen Art waren chronisch infolge einer schlecht ausgewogenen Diät der Reichen sowie der Verbrauch verdorbener und unzureichender Nahrung bei den Armen. Die Vorherrschaft von Darmwürmern … waren ein langsamer, lästiger und lähmender Prozess, welcher in größtem Umfang zu menschlichem Elend und schlechter Gesundheit führte … In vielen sumpfigen Gebieten ohne Drainage waren wiederkehrende Malaria-Schübe allgemein verbreitet … und vielleicht noch herzzerbrechender war die langsame, unerbittliche, zerstörerische Kraft der Tuberkulose … Für Frauen war die Geburt von Kindern ein äußerst gefährliches Unterfangen … und schließlich gab es da noch die fortwährende Bedrohung durch Todesfälle durch einen Unfall aus Fahrlässigkeit, Unvorsichtigkeit oder in Gesellschaft mit Tieren wie Pferden – welche sich zumindest genauso gefährlich wie Autos erwiesen haben – oder Elementen wie Wasser … – Lomborg, Bjørn. The Skeptical Environmentalist: Measuring the Real State of the World (S. 55).

Die Technologie zur Kontrolle von Luft- und Wasserverschmutzung ist vorhanden und breitet sich rapide auf arme Länder aus. In den USA, wo diese Technologie seit Jahrzehnten zur Anwendung gekommen war, ist die Luftverschmutzung der EPA zufolge seit dem Jahr 1970 um 70% gesunken. Weniger als die Hälfte aller Menschen hatte im Jahre 1990 Zugang zu sauberem Wasser, heute sind es der BP Statistical Review of World Energy 2013 zufolge 65%.

Man beachte, dass es noch im Jahre 1990 weniger als die halbe Welt über „verbesserte sanitäre Einrichtungen“ verfügte. Die Zunahme auf zwei Drittel innerhalb nur weniger Jahrzehnte ist eine wunderbare Leistung. – Epstein, Alex. The Moral Case for Fossil Fuels (p. 148). Penguin Publishing Group. Kindle Edition.

Und:

Die Reichen sind reicher geworden, aber den Armen ist es sogar noch besser ergangen. Die Armen in den Entwicklungsländern haben ihren Verbrauch von 1980 bis 2000 doppelt so schnell erhöht wie die Welt als Ganzes. – Ridley, Matt. The Rational Optimist: How Prosperity Evolves (S. 15).

Und:

Acht von zehn amerikanischen Haushalten verfügten im Jahre 1955 über fließendes Wasser Zentralheizung, elektrisches Licht, Waschmaschinen und Kühlschränke. Im Jahre 1900 hatte fast niemand diesen Luxus. – Ridley, Matt. The Rational Optimist: How Prosperity Evolves (P.S.) (S. 16).

Und:

Heute haben 99% aller als ,arm‘ klassifizierten Amerikaner Strom, fließendes Wasser, Toilettenspülung und einen Kühlschrank; 95% haben einen Fernseher, 88% ein Telefon, 71% ein Auto und 70% Air Condition. – Ridley, Matt. The Rational Optimist: How Prosperity Evolves (S. 16-17).

In mancher Hinsicht geht es den Armen in den USA heute besser als König Ludwig XIV in Frankreich im Jahre 1700, dem reichsten Mann seiner Tage.

Verschlechtert sich die Umwelt?

Irgendwo vielleicht, aber:

In Europa und Amerika werden Flüsse, Seen und die Luft stetig sauberer. In der Themse finden sich weniger Abwässer und mehr Fische. Wasserschlangen im Eriesee, die in den sechziger Jahren am Rande des Aussterbens standen, gibt es heute wieder zuhauf. Weißkopf-Seeadler erlebten einen Boom. In Pasadena gibt es kaum noch Smog. Die Eier von Vögeln in Schweden sind um 75% weniger verunreinigt als in den sechziger Jahren. Kohlenmonoxid-Emissionen in Amerika sind innerhalb von 25 Jahren um 75% gesunken. Heute emittiert ein Auto bei voller Geschwindigkeit weniger Schadstoffe als ein parkendes Auto im Jahre 1970 durch Lecks. – Ridley, Matt. The Rational Optimist: How Prosperity Evolves (S. 17).

Wohlstand

Die Menschen leben heute länger und besser als vor 100 Jahren. Bequemlichkeiten wie künstliches Licht sind heute viel billiger:

Man überlege einmal, wie viel künstliches Licht man mit einer Arbeitsstunde erhalten kann. Die Menge hat sich von 24 Lumen-Stunden im Jahre 1750 (Sesam-Öllampen) auf 186 im Jahre 1800 (Wachskerzen), auf 4400 im Jahre 1880 (Petroleum-Lampen) auf 531.000 im Jahre 1950 (Glühbirnen) und auf 8,4 Millionen Lumen-Stunden heute erhöht. Anders ausgedrückt, eine Arbeitsstunde heute erschafft Licht im Wert von 300 Tagen, im Jahre 1800 waren es zehn Minuten. – Ridley, Matt. The Rational Optimist: How Prosperity Evolves (P.S.) (S. 20-21).

Mitte des 19. Jahrhunderts kostete eine Kutschfahrt von Paris nach Bordeaux etwa einen Monatslohn, heute fährt man für 10 Euro mit der Eisenbahn. Im Jahre 1840 kostete die Fahrt einer vierköpfigen Familie von St. Louis in Missouri nach Oregon City 23.373 Dollar (auf heute umgerechnet) und dauerte 4,5 Monate. Heute kostet die Autofahrt lediglich 1052 Dollar, und die vierstündige Reise mit dem Flugzeug lediglich 1016 Dollar.

Wir profitieren von dem, was Matt Ridley die Multiplikation der Arbeit nennt. Jeder von uns arbeitet in einem Job und erzeugt eine Sache; aber wir kaufen Güter aus allen Teilen der Welt, an deren Fertigung tausende Menschen beteiligt waren. Wir können dies tun wegen der fossilen Treibstoffe, einem modernen Transportwesen und einem Win-Win-Kapitalismus, wobei sowohl der Käufer als auch der Verkäufer von jeder Transaktion profitiert.

Und dann diese Story:

Kelly Cobb von der Drexel University machte sich daran, einen Herrenanzug ausschließlich aus Rohstoffen herzustellen, die aus einem Umkreis von 100 Meilen um ihre Wohnung stammen. Man brauchte 20 Kunsthandwerker, die insgesamt 500 Arbeitsstunden damit zubrachten, und selbst dann mussten sie noch 8% der Materialien von außerhalb des 100-Meilen-Kreises heranschaffen. Falls sie ein weiteres Jahr gearbeitet hätten, hätten sie wohl alles innerhalb des Radius‘ von 100 Meilen herstellen können, argumentiert Cobb. – Ridley, Matt. The Rational Optimist: How Prosperity Evolves (P.S.) (S. 35).

500 Arbeitsstunden erfahrener Handwerker, um einen Anzug herzustellen! In den USA würden sich die Arbeitskosten allein auf über 5000 Dollar belaufen. Man vergleiche eine heute in Paris lebende Frau mit König Ludwig XIV, dem 498 Sklaven zum Zubereiten jeder Mahlzeit zur Verfügung standen:

Man stelle sich einmal eine heute in Paris lebende Frau im Alter von 35 Jahren mit mittlerem Einkommen, einem arbeitenden Ehemann und zwei Kindern vor. Sie wäre weit weg von Armut, aber sie wäre relativ gesehen unermesslich ärmer als König Ludwig. War er seinerzeit der reichste Mann der Welt in der reichsten Stadt der Welt, hat die Frau heute keine Sklaven, keinen Palast, keine Kutsche, kein Königreich. Der mühsame Weg nach Hause in der überfüllten U-Bahn, das Besorgen einer Mahlzeit für vier Personen – da könnte man denken, dass das Arrangieren von Mahlzeiten für König Ludwig völlig unerreichbar ist. Und dann überlege man sich Folgendes: Der Überfluss, der einem beim Betreten eines jeden Supermarktes entgegenschlägt, marginalisiert alles, was König Ludwig je erfahren hat (und vermutlich ist auch die Gefahr von Salmonellen viel geringer). Man kann frische, tiefgefrorene, konservierte, geräucherte oder vorbereitete Mahlzeiten kaufen, bestehend aus Rind- und Schweinefleisch, Geflügel, Fisch und Anderes aus dem Meer, Eiern, Kartoffeln, Gemüse, Obst, vielen Arten von Salat, diversen Pflanzenölen und Gewürzen … Man wird keinen Koch haben, aber man kann sich mit einem Wimpernschlag entscheiden, welches der zahlreichen Restaurants mit Nahrung aus aller Herren Länder man aufsuchen will – in jedem davon ist ein erfahrenes Team von Köchen der Familie zu Diensten in viel weniger als einer Stunde. Man denke daran: Niemals zuvor in dieser Generation war eine durchschnittliche Person in der Lage, sich jemand anders leisten zu können für die Zubereitung seiner Mahlzeiten. – Ridley, Matt. The Rational Optimist: How Prosperity Evolves (S. 36-37).

Ludwig XIV, der Sonnenkönig, hatte 498 Sklaven zur Verfügung, die seine Mahlzeiten zubereiteten – aber dennoch war er nicht so reich wie die moderne Pariser Hausfrau. Diese hat die Produkte tausender Arbeiter zur Hand in jedem Lebensmittelladen oder Restaurant.

Insgesamt geht es der Menschheit heute weit besser als jemals zuvor. Mittels fossiler Treibstoffe, modernem Transportwesen und Kommunikations-Technologien haben wir ein weltweites Handelssystem errichtet, welches es gestattet, uns die Arbeit tausender Menschen auf der ganzen Welt zunutze zu machen. Dies hat Armut drastisch reduziert. Richtig ist auch, dass wohlhabendere Länder weniger Umweltverschmutzung haben mit saubererer Luft und saubererem Wasser als weniger entwickelte Länder. Das ist so, obwohl reichere Länder mehr fossile Treibstoffe verbrennen.

Schlusfolgerungen

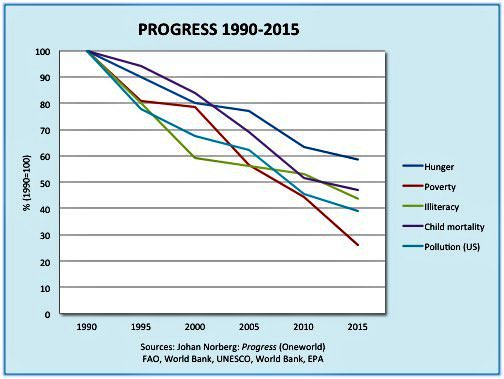

Alles in allem muss gesagt werden, dass der Gesundheitszustand der Menschheit sich während der letzten paar hundert Jahre drastisch verbessert hat. Wir leben im Durchschnitt doppelt so lange wie noch vor 100 Jahren, und die Verbesserung gibt es sowohl in den industrialisierten als auch in den Entwicklungsländern. Die Kindersterblichkeit ist in allen Ländern, reichen und armen, um weit über 50% gesunken. – Lomborg, Bjørn. The Skeptical Environmentalist: Measuring the Real State of the World (S. 58-59).

…es gab eine Zunahme der Pro-Kopf-Produktivität in Amerika um das 36-fache seit dem Jahr 1789 und eine ähnliche Zunahme in UK seit 1756 um das 20-fache. Im Jahre 2000 produzierte die US-Wirtschaft Güter und Dienstleistungen für einen durchschnittlichen Amerikaner im Wert von 36.200 Dollar. Am Ende des 18. Jahrhunderts waren es für jeden Amerikaner lediglich 996 Doller (nach heutigem Wert). Für einen durchschnittlichen Briten waren es 15.700 Pfund im Jahre 2000 verglichen mit lediglich 792 Pfund (nach heutigem Wert) im Jahre 1756. – Lomborg, Bjørn. The Skeptical Environmentalist: Measuring the Real State of the World (S. 70).

In Folgebeiträgen wird es um Kosten und Vorteile von globaler Erwärmung gehen. Aber bevor wir in die Globale-Erwärmung-Ökonomie einsteigen, sollte ich mich mit den extremeren Behauptungen bzgl. eines „gefährlichen Klimawandels“ befassen.

In diesem Beitrag habe ich versucht, die allgemein von Umweltaktivisten hinaus posaunten Hypothesen zu diskreditieren. Die erste dieser Hypothesen lautet, dass der Mensch eine existentielle Bedrohung des Menschen und der Erde, oder „Gaia“ ist. Verursacht unsere wachsende Bevölkerung mehr Infektionskrankheiten? Die klare Antwort lautet nein. Schädigt unser ökonomisches Wachstum die Umwelt. Eindeutig nicht, vielmehr erlaubt es uns unser Wohlstand, uns besser als je zuvor um unsere Umwelt zu kümmern. Macht unsere wachsende Bevölkerung und die längere Lebenserwartung uns kränker? Eindeutig nicht, wir leben heute sowohl länger als auch besser. Geht es der Umwelt mit der Zeit immer schlechter? Nein, das Gegenteil ist der Fall. Je wohlhabender wir sind, umso besser geht es der Umwelt.

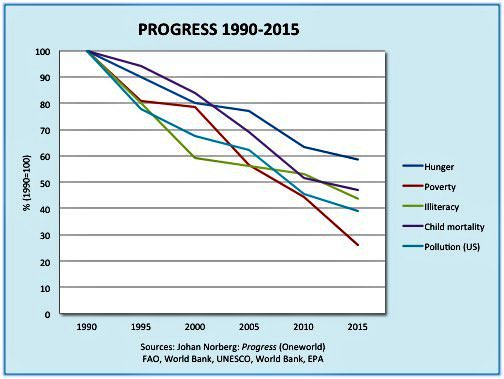

Man betrachte Abbildung 8:

Abbildung 8 (Quelle: Dina Pomeranz, siehe den Beitrag von Anthony Watts hier, auf Deutsch beim EIKE hier)

Eindeutig: Umwelt und menschliches Wohlergehen verbessern sich, wenn wir immer wohlhabender werden.

Die zweite Hypothese lautet, dass die globale Erwärmung das Potential hat, die Erde in einen Planeten ähnlich der Venus zu verwandeln. Das ist eindeutig physikalisch unmöglich, falls es auf der Erde Ozeane gibt. Und egal, wie stark Treibhausgase zunehmen, die Ozeane werden immer da sein. Die mittlere Wassertemperatur der Ozeane liegt zwischen 4°C und 5°C, und die Ozeane enthalten 99,9% der Wärmekapazität an der Erdoberfläche, so dass die Erwärmung der Oberfläche stark limitiert ist.

Die dritte Hypothese lautet, dass die Menschheit uns selbst zum Aussterben bringt. Beuten die Menschen die Ressourcen der Erde restlos aus? Nein, tun sie nicht! Die Produktion und Erholung natürlicher Ressourcen, von Ackerland und Nahrungsmitteln nehmen stärker zu als wir sie verbrauchen. Und das wird in absehbarer Zukunft auch so bleiben.

Streng genommen muss ich keinen dieser dummen Gedanken widerlegen, sind diese doch allesamt sehr spekulativ, und es gibt keinerlei Daten, die auch nur einen davon stützen. Es gibt lediglich nicht validierte Computermodelle. Aber wir hören bekannte Akademiker (einschließlich Stephen Hawking!) und Politiker [und Medien! Anm. d. Übers.] diesen Unsinn ständig wiederholen. Dieser Beitrag ist ein Versuch, etwas Realität in den Nebel wilder Spekulationen zu bringen.

Die Menschen übernehmen kein sicheres Klima und machen es gefährlich; wir übernehmen ein gefährliches Klima und machen es sicher“. – Epstein, Alex. The Moral Case for Fossil Fuels (p. 126).

Wir leben in einer Zeit nahezu unbegrenzten Wohlstandes. Die Armutsrate ist auf ein unvorstellbar niedriges Niveau gesunken. Dies ist eine Zeit, wenn die Definition von Armut in den USA so hoch angesetzt ist, dass ein heutiger armer Mensch in den USA von jeder wohlhabenden Person vor dem 2. Weltkrieg beneidet worden wäre. Die Ungleichheit in der Welt liegt auf dem niedrigsten Niveau jemals und nimmt mit rapider Rate weiter ab. In elender Armut geborene Menschen können heute Doktoren und Anwälte werden. Warum es immer noch Untergangspropheten gibt, die das Ende der Welt prophezeien, entzieht sich meinem Verständnis.

Link: https://wattsupwiththat.com/2017/12/09/do-humans-harm-the-environment/

Übersetzt von Chris Frey EIKE