Der Autor nimmt diesen „Klimawandel-FlashCrash“ (wieder) zum Anlass, anhand einer Sichtung zu zeigen, wie viel Wahrheitsgehalt in der Information stecken könnte, alternativ, ob sie einfach unter die Rubrik „Volksverdummung“ gehört.

Wenn sich unsere Medien mit „Information“ geradezu überschlagen

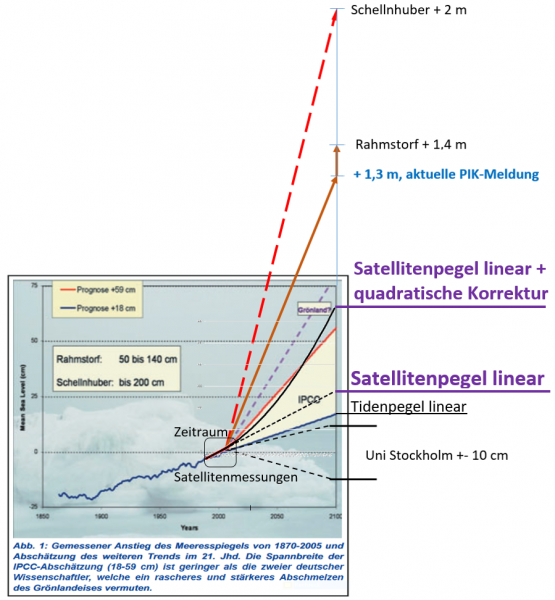

Anbei eine kleine Listung zum Zeigen, wie sich eine (passende) Meldung schlagartig und sprichwörtlich flächendeckend über Deutschland „ergießt“. Es ging um eine Meerespegel-Studie [14], welche „belegt“, das die Satellitendaten bisher falsch ausgewertet wurden und die „richtige“ Auswertung, zusammen mit der Einberechnung bisher unterschätzter, sonstiger Klimaeinflüsse zu einem zusätzlichen, quadratischen Anstiegszuwachs führen würde und damit die höchsten IPCC-Pegelszenarien bestätigt:

Bayerischer Rundfunk 13.02.2018 : Steigende Pegel Wenn der Meeresspiegel steigt und Inseln versinken

Weil der Klimawandel das Eis der Polarregionen schmelzen lässt, steigt der Meeresspiegel. Und das immer schneller. Die Folgen sind verheerend.

tagesschau.de: Satellitenmessungen: Meeresspiegel steigt schneller als gedacht …

welt.de: Klimawandel: Meeresspiegel steigt schneller als gedacht

tagesspiegel.de: Erderwärmung: Wie stark steigt der Meeresspiegel?

zeit.de: Meeresspiegel: Er steigt und steigt und steigt

spiegel.de: Meeresspiegel steigt immer schneller

rtlnext.rtl.de: Der Meeresspiegel steigt drastischer an als angenommen

klimaretter.info/forschung: Meeresspiegel steigt immer schneller

Und nur eine einsame Stimme* kritisch referiert

*natürlich neben EIKE und kaltesonne, welche aber keine politischen Tagesbeiträge anbieten.

Achgut.com 17.02.2018: Höchste Pegelstände in der Volkserziehung

… der Beitrag war 2:25 Minuten lang. Soviel Zeit wird in der 19:00 Uhr Nachrichtensendung nur den wichtigsten Weltereignissen zur Verfügung gestellt. Weder Petra Gerster noch die Autorin des Beitrags, Christine Elsner, geben auch nur den geringsten Hinweis, wer diese „neuen Erkenntnisse“ veröffentlicht hat.

Die Kernaussage des Beitrags: Die Meeresspiegel steigen schneller als angenommen. Diesen neuen Studien zufolge steigt der Meeresspiegel bis zum Ende des Jahrhunderts um 65 cm an, das wäre doppelt soviel, wie bisher berechnet. Doch der 65 cm Anstieg – manchmal sind es sogar 75 cm – ist eine uralte Behauptung aus der Alarmküche von Steven Nerem, der in der University of Colorado die Sea Level Research Group anführt. Mit seinem Vortrag, der genau diese Behauptung zum Inhalt hat, tourt er seit Jahren durch die Welt. Das Problem von Steven Nerem: Die Messungen des Meeresspiegels ergeben nicht die geringsten Hinweise, die seine Behauptungen rechtfertigen. Er stützt sich auf Computermodelle, Hochrechnungen und Berechnungen, nicht auf konkrete Messungen …

Die Studie

Rezensionen darüber – zum Beispiel bei WUWT wurden auf EIKE bereits in Übersetzungen publiziert:

Einmal direkt über die Studie:

[12] EIKE 13.01.2018: Meeresspiegel – steigen und fallen: Wie man einen Anstieg aus Nichts erzeugt

Sowie ergänzend dazu:

[1] EIKE 13.01.2018: Meeresspiegel – steigen und fallen: Wie man einen Anstieg aus Nichts erzeugt

[2] EIKE 18.02.2018: Meeresspiegel: Steigen und Fallen – Teil 4a – ein sogar noch stärkerer Anstieg aus Nichts

EIKE 19.02.2018: Die immer neu aufsteigenden und untergehenden Inseln wie zum Beispiel Tuvalu

Worum es in der neuen Studie ging, könnte einigen „haften“ geblieben sein, was das Besondere daran ist, vielleicht weniger. Deshalb anbei eine Wiederholung.

Die Kernaussage der neuen Studie lautet: [1] … Nerems Team berechnete, dass die Rate des Meeresspiegel-Anstiegs von 1,8 mm pro Jahr im Jahre 1993 auf etwa 3,9 mm pro Jahr heute gestiegen ist als eine Folge der globalen Erwärmung.

… Falls sich der Meeresspiegel-Anstieg mit der gegenwärtigen Rate weiter beschleunigt, sagt Nerem, würden die Ozeane der Welt im Laufe dieses Jahrhunderts um etwa 75 cm steigen. Das liegt auf einer Linie mit den Projektionen des IPCC aus dem Jahr 2013.

Vorspann: Satellitendaten sind nicht „in Stein gemeißelt“, sondern das Ergebnis laufender Anpassungen

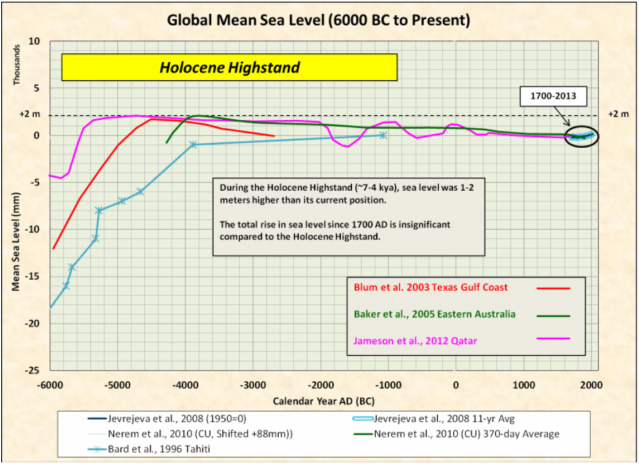

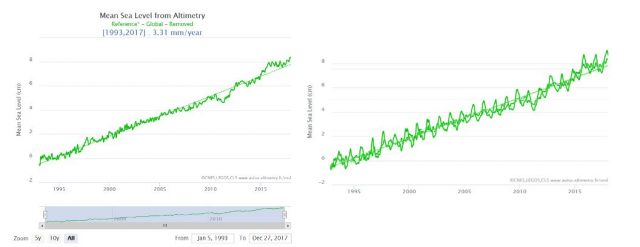

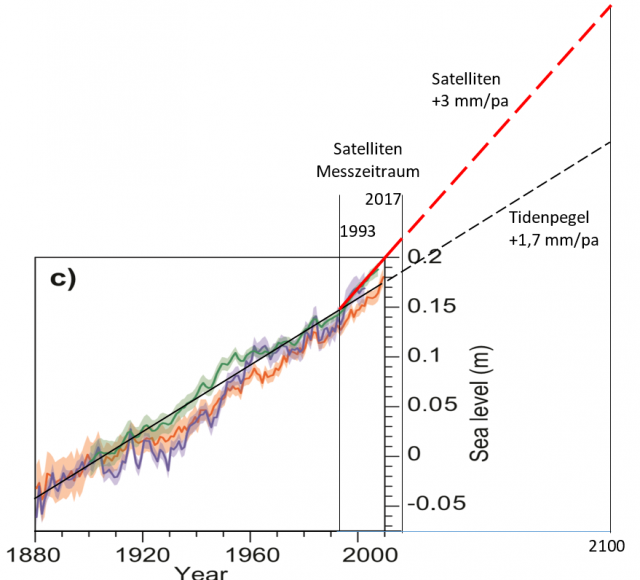

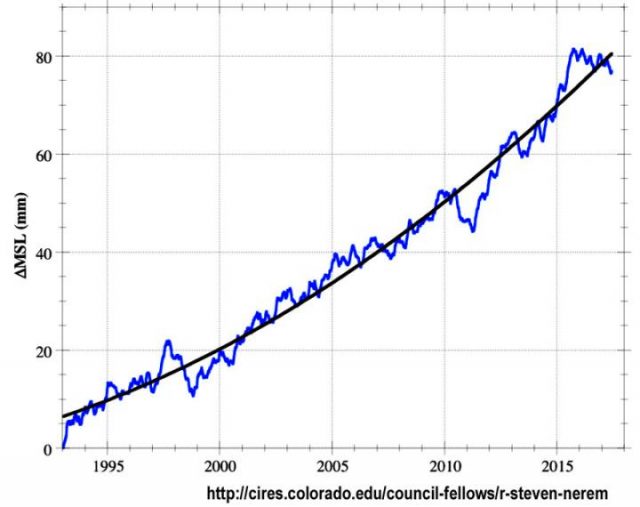

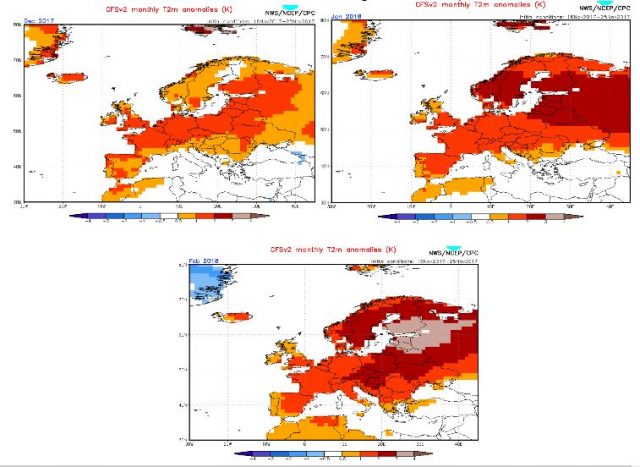

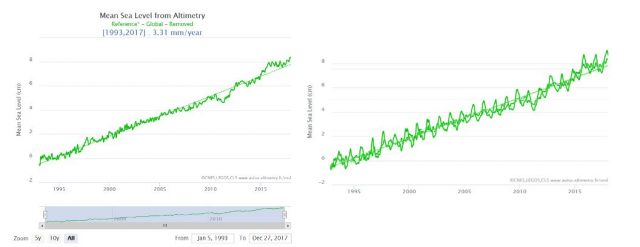

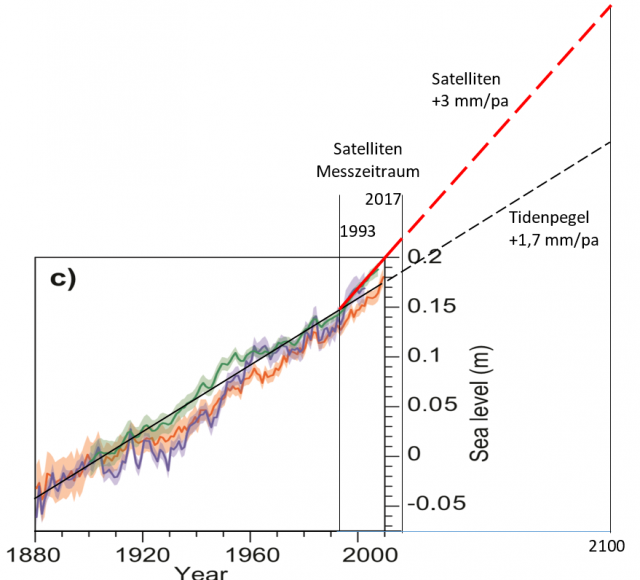

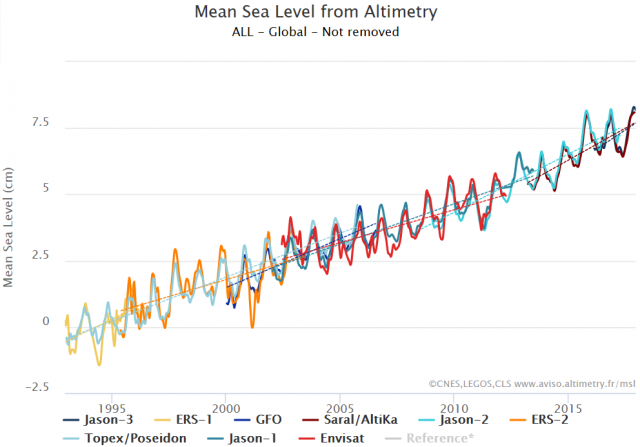

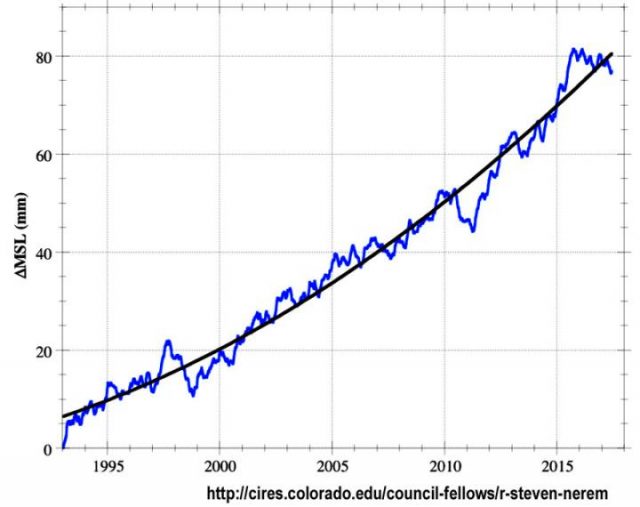

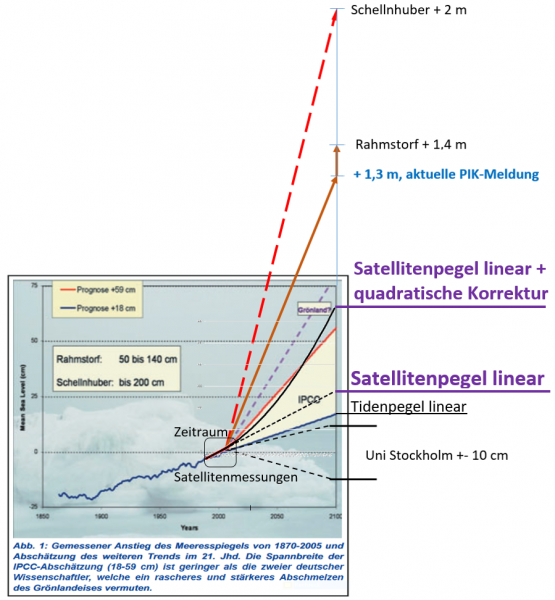

Die Satellitendaten des Meerespegels zeigen seit Messbeginn offiziell einen linearen Anstieg (je nach Quelle) zwischen 2,9 … 3,31 mm/Jahr (Bild 1). Das Bild 1 zeigt einmal den Mittelwert mit der Regressionsgeraden und dann die gleiche Kurve, zusätzlich mit den Schwankungen im Jahresverlauf.

Bild 1 Satellitenpegel ohne / mit Saisonsignal. Quelle: AVISO+ Mean Sea Level product and image interactive selection, Quelle

Korrektur(vorschlag) zu einem geringeren Pegelanstieg im Jahr 2015

Vor drei Jahren gab es eine Studie, welche diesen Anstieg für zu hoch hielt und aufgrund von Messfehlern der Satelliten einen reduzierten Anstieg von 2,6 … 2,9 mm/Jahr ermittelte:

Nature 11 May 2015: Unabated global mean sea-level rise over the satellite altimeter era

The rate of global mean sea-level (GMSL) rise has been suggested to be lower for the past decade compared with the preceding decade as a result of natural variability1, with an average rate of rise since 1993 of +3.2 ± 0.4 mm yr−1 (refs 2, 3). However, satellite-based GMSL estimates do not include an allowance for potential instrumental drifts (bias drift4,5). Here, we report improved bias drift estimates for individual altimeter missions from a refined estimation approach that incorporates new Global Positioning System (GPS) estimates of vertical land movement (VLM). In contrast to previous results (for example, refs 6, 7), we identify significant non-zero systematic drifts that are satellite-specific, most notably affecting the first 6 years of the GMSL record. Applying the bias drift corrections has two implications. First, the GMSL rate (1993 to mid-2014) is systematically reduced to between +2.6 ± 0.4 mm yr−1 and +2.9 ± 0.4 mm yr−1, depending on the choice of VLM applied …

Weil man den Pegel vor Ort nicht genau genug messen kann, misst man aus 800 … 1450 km Entfernung „genauer“

Dazu muss man berücksichtigen, dass die Messsatelliten zur Ermittlung der Meerespegel in 800 … 1400 km Höhe kreisen. Behauptet wird, aus dieser Entfernung könne man Meereshöhen-Differenzen von Zehntel Millimetern ermitteln. Wenn vergleichsweise der Stadtrat von Venedig den Pegelstand am Markusdom genau erfahren möchte, würde er dazu in Hamburg anrufen (1290 km), damit von dort aus mittels Radar genauer als vor Ort gemessen werde.

Man kann es nicht. Aber das Signal lässt sich so hoch auflösen.

An Ungenauigkeit bleiben Driften der Messgeräte, Änderungen der Wellengeschwindigkeit des Radarsignals und die Bestimmung der Satellitenhöhe, die sich laufend durch die „Schwerkraftbuckel“ und „Herunterfallen“ der Satellitenbahnen verändert. Diese Fehler versucht man mit „Algorithmen“ und Kalibrierungen so weit möglich richtigzustellen.

Würden diese Adjustierungen mittels gut begründeter und vor allem im Detail veröffentlichter Verfahren erfolgen, hätten sie einen Vorteil gegenüber den Tidenpegelmessungen. Denn (auch) diese sind nicht frei von Messfehlern und Nachjustierungen, bis hin zum Datenbetrug verändern.

Anbei Beispiele dazu:

EIKE 13.08.2017: Manila versinkt durch Wasserentnahme im austrocknenden Untergrund. Der (reiche) Westen mit seinem CO2 soll daran schuld sein – und zahlen

EIKE 08.08.2017: Meerespegelanstieg: Europa kann nicht alle (vor Klimawandel-Desinformation) schützen T2 (2)

EIKE 17.07.2016: Wie man den Meerespegel-Verlauf in die richtige Richtung dreht Aus dem Lehrbuch für (Klima-)Statistikbetrug

Man würde sich deshalb schon wünschen, eine von solchen „Interpretationsunterschieden“ befreite, neutrale Messstelle zu haben.

Bisher ungelöst: Warum steigt der Satellitenpegel doppelt so schnell wie der Tidenpegel?

Komischer Weise verlaufen Tidenpegel und durch Satelliten gemessene nicht gleich. Die Satelliten zeigen den doppelten Anstiegswert. Die (überzeugende) Erklärung dieses Rätsels hat noch niemand gefunden (oder der Autor hat es übersehen).

Ein bekannter – kritisch eingestellter – Pegelforscher hat dazu eine Meinung:

Nils-AxelMörner August 2017: [7] [13] Sea Level Manipulation

Abstract: … Global tide gauge data sets may vary between +1.7 mm/yr to +0.25 mm/yr depending upon the choice of stations … A general stability has been defined in sites like the Maldives, Goa, Bangladesh and Fiji.

In contrast to all those observations, satellite altimetry claim there is a global mean rise in sea level of about

3.0 mm/yr. In this paper, it is claimed that the satellite altimetry values have been “manipulated”. In this

situation, it is recommended that we return to the observational facts, which provides global sea level records

varying between ±0.0 and +1.0 mm/yr; i.e. values that pose no problems in coastal protection.

Bild 2 Vergleich Satellitenpegel mit Tidenpegel. Vom Autor zusammengestellt. Quellenbild Tidenpegel: IPCC WG1 AR5 Figure 13.3 c) Yearly average global mean sea level (GMSL) reconstructed from tide gauges by three different approaches. Orange from Church and White (2011), blue from Jevrejeva et al. (2008), green from Ray and Douglas (2011) (see Section 3.7)

Eine Korrektur folgt der anderen

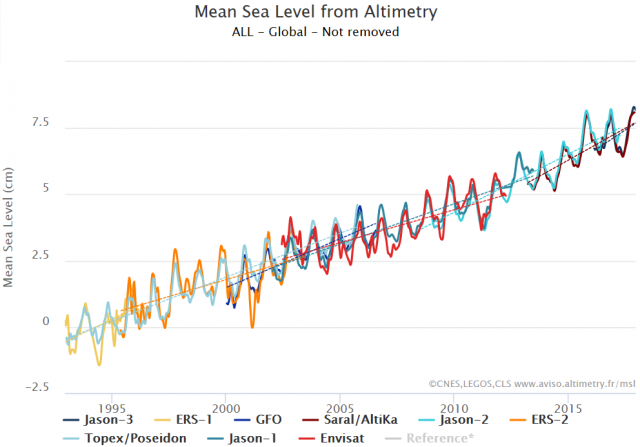

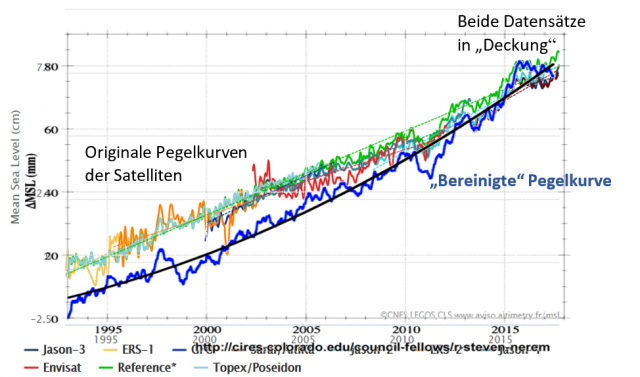

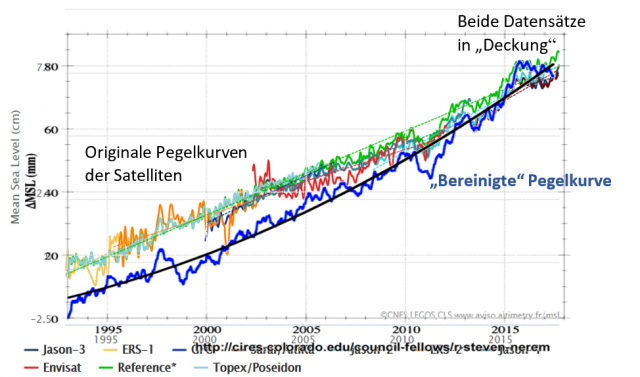

Wie bereits ausgeführt: Auch bei den Satellitendaten sind Adjustierungen und Korrekturen üblich und werden teils ohne Publizierung nachvollziehbarer Datenangaben vorgenommen. Einen Grund sieht man im folgenden Bild 3, welches die „Zusammenstückelung“ des Gesamtverlaufes aus den abweichenden Messkurven verschiedener Satelliten (-Generationen) zeigt.

Dabei sind nicht nur die Satellitenkurven selbst abweichend. Auch die Messgenauigkeit der verschiedenen Satelliten ist unterschiedlich und die angewendeten Adjustierungen (zur Ermittlung des „richtigen“ Messwertes) angeblich teils so fehlerbehaftet, dass sie auch rückwirkend verändert werden. Was dabei nicht so deutlich gesagt wird: Ob die neuen Korrekturen dann die „wirklich richtigen“ sind, weiß niemand.

Als Folge ändern sich auch die Satellitendaten regelmäßig und nachträglich.

Bild 3 Zusammensetzung der Satellitenkurve aus den Einzelmessungen der Satelliten. Quelle: AVISO+ Mean Sea Level product and image interactive selection

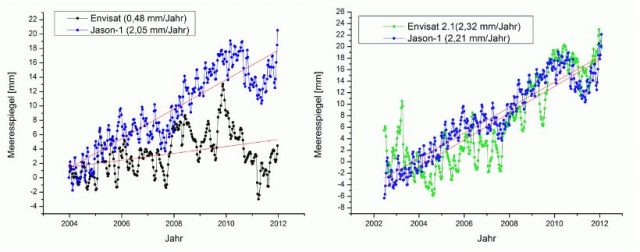

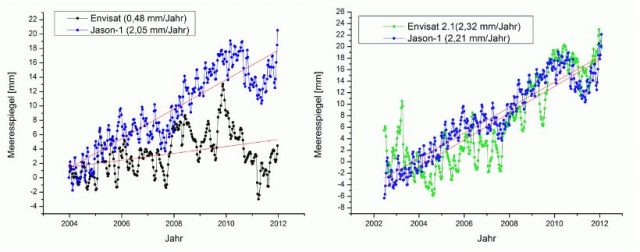

Was nicht zusammenpasst, wird angeglichen – und nicht als falsch verworfen

EIKE 13.04.2015, K. E. Puls: [6] Neue Meeres-Spiegel-Studie zeigt: Satelliten-Daten überhöht

... Der von Envisat gemessenen Anstieg des Meeresspiegels betrug im Zeitraum von Ende 2003 bis Ende 2011 lediglich 0,48 mm/Jahr, was 4,8 cm in 100 Jahren entsprechen würde. Die Messungen des Jason-1 Satelliten haben für den gleichen Zeitraum einen Anstieg von 2,05 mm pro Jahr gefunden. … Um diesem Umstand zu begegnen wurden bei der ESA bereits im letzten Jahr Methoden diskutiert, wie man die Envisat Daten rechnerisch an die Ergebnisse der Messungen der Jason Satelliten angleichen kann. Diese Anpassung wurde jetzt beim Umstellen auf die neueste Version der Envisat Daten (Version 2.1) offensichtlich vorgenommen. Aus dem bisherigen minimalen Anstieg von 0,48 mm/Jahr wurde dadurch quasi über Nacht ein Anstieg von 2,32 mm/Jahr. Wer nach einer Begründung für diese Maßnahme sucht, der wird auf der Aviso-Homepage unter “Processing and corrections” fündig. Dort heißt es: ’sign of instrumental correction (PTR) corrected via external CLS input (impact of +2 mm/year drift)‘ Man hat also einen Abgleich an externen Daten vorgenommen. Es findet sich allerdings kein Wort dazu, was für Daten das sind oder welcher Umstand diesen radikalen Eingriff notwendig gemacht hätte.“

Bild 4 [7] Satelliten-Pegeldifferenzen vor und nach einer Adjustierung

In aller Regel wird der Anstieg immer höher

Zwar wird seit ca. 20 Jahren „ganz genau“ das Klima der nächsten Jahrhunderte simuliert und die Programme mit „ganz genauen“ Daten kalibriert. Trotzdem finden Forscher immer neue Parameter, die „bislang deutlich unterschätzt wurden“ und teils erhebliche Datenänderungen bewirken. So ist es beispielhaft in den Meldungen zur aktuellen Pegelstudie zu lesen:

Hannoversche Allgemeine 27.01.2016: Klimaschock Meeresspiegel steigt doppelt so schnell an

Deutsche Klimaforscher schlagen Alarm. Der weltweite Anstieg der Meeresspiegel durch die Klimaerwärmung ist bislang deutlich unterschätzt worden. Das könnte auch für Deutschlands Küstenregionen schwere Folgen haben.

… Der Anstieg des Meeresspiegels ist vermutlich doppelt so hoch wie gedacht, heißt es in einer aktuellen Studie des Instituts für Geodäsie und Geoinformation an der Universität Bonn, die jetzt in der US-Fachzeitschrift „Proceedings of the National Academy of Sciences“ veröffentlicht wurde. Ein Irrtum, der für die Küstenregionen in Deutschland schwere Folgen haben könnte. Die Gefahr von Sturmfluten wächst.

Bislang gingen Forscher davon aus, dass die Meeresspiegel aufgrund der Ausdehnung des wärmer werdenden Wassers jährlich zwischen 0,7 und einem Millimeter ansteigen würden. Bei erneuter Prüfung der Satellitendaten aus den Jahren 2002 bis 2014 habe sich aber ergeben, dass sie sogar um 1,4 Millimeter pro Jahr ansteigen werden – doppelt so stark wie bisher vermutet. Dieser Faktor sei bislang deutlich unterschätzt worden, erläuterte Professor Jürgen Kusche, Ko-Autor der Studie.

Zufügung: Im Artikel erzählt der Leitautor dieser Studie als „Beleg“:

… Während das Meer auf den Philippinen mit 15 Millimetern im Jahr fünfmal so stark wie der weltweite Durchschnitt ansteige …

Dazu erlaubt sich der Autor den Hinweis, dass genau dies (bei den Philippinen steige der Pegel überproportional) nicht richtig ist, wie man leicht anhand der Tidenpegel-Auswertungen dieser Gegend zeigen kann[15] und es die zuständige Behörde inzwischen auch teilweise korrigierte [16]. Die Philippinen sind stark vulkanisch geprägt, haben also starke Land-Hebungen und Senkungen. Zudem liegen Küstenstädte auf Sumpfmarschen und versinken durch die extreme Populationszunahme und in Folge massiven Grundwasserentnahmen buchstäglich in den Untergrund. Am schlimmsten betroffen davon ist wohl Manila:

EIKE 13.08.2017: [15] Manila versinkt durch Wasserentnahme im austrocknenden Untergrund. Der (reiche) Westen mit seinem CO2 soll daran schuld sein – und zahlen

In Indonesien ist es teils noch schlimmer. Der Klimawandel-Pegelanstieg ist dort natürlich auch eine gemeldete Bedrohung „ … könne in 200 bis 2.000 Jahren akut werden … “, es wird (in Österreich) aber wenigstens zugegeben, dass das selbst verursachte Problem des Versinkens viel größer und dazu akut ist:

news@ORF.at: Boden unter der Stadt ausgehölt

Die indonesische Millionenmetropole Jakarta schaut in eine ungewisse Zukunft. Der durch den Klimawandel steigende Meeresspiegel ist eine Bedrohung, eine weitere ist ebenfalls menschengemacht: Die Stadt versinkt…. Meeresspiegel steigt, Stadt sinkt ab.

Das Problem mit dem steigenden Meeresspiegel hat Jakarta mit Millionenmetropolen in Asien wie Mumbai, Schanghai, Hongkong und anderen gemeinsam, wie es vor einiger Zeit in einer Studie des Instituts Climate Central hieß. Das Problem könne in 200 bis 2.000 Jahren akut werden, hieß es zum zeitlichen Horizont…. Es habe sich herausgestellt, dass der Klimawandel nicht der einzige Grund für das Problem ist. „Das Problem, hat sich gezeigt, ist das Sinken der Stadt selbst.“

„Verschluckt von der Erde“

Faktisch sinke Jakarta schneller als jede andere Metropole auf der Welt, rascher als der Meeresspiegel steige – „so surreal schnell, dass Flüsse manchmal flussaufwärts fließen“, normale Regenfälle Stadtviertel in Sümpfe verwandelten und Gebäude langsam im Boden verschwänden, .. Die Hauptursache des Problems seien illegale Brunnengrabungen, so die Zeitung. Diese würden grundwasserführende Schichten im Boden, auf denen die Stadt steht, „Tropfen für Tropfen austrocknen“, ähnlich wie wenn man die Luft aus einem großen Polster unter ihr lasse. Etwa 40 Prozent Jakartas lägen mittlerweile unter Meeresspiegelniveau. Einzelne Teile der Stadt nahe der Küste seien über vier Meter abgesunken.

Eigentlich nicht vorstellbar, dass ein dazu forschender Professor dies nicht weiß.

Was steht in der neuen Studie

Wurde gerade erst vor zwei Jahren bereits auf einen „doppelt so schnell“ steigenden Pegel korrigiert (vorheriger Absatz), weil die jüngeren Satellitendaten „ein Irrtum“ waren, sagt die neue Studie, dass die alten Satellitendaten ebenfalls (immer noch) falsch waren und nun (wieder) korrigiert werden müssen.

R. Steven Nerem, der leitende Verfasser der neuen Studie

Eine gute Übersicht zum Verfasser und seiner „wissenschaftlichen Neutralität“ gab es auf WUWT (Übersetzung): [12] Also, Erstes zuerst – wer ist R. Steven Nerem?

Steve Nerem ist ein Alarm-Evangelist* des Meeresspiegel-Anstiegs – es gibt keine andere angemessene Beschreibung. Ich zweifle nicht daran, dass er wirklich an seine Causa glaubt, ist er doch im vorigen Jahr durch die Welt gereist mit immer dem gleichen Vortrag – immer mit identischem Abstract – in San Francisco (Dec 2016), Bologna (Feb 2017), New York (July 2017), Miami (Oct 2017) und New Orleans (Dec 2017). Nerem ist einer der Ko-Autoren des infamen Kommentars im Journal Global and Planetary Change, worin er versucht die Studie aus dem Jahr 2004 von Nils-Axel Mörner im gleichen Journal zu widerlegen. Im 3. Teil von SEA LEVEL: Rise and Fall schrieb ich über den Austausch Mörner/Nerem/Mörner.

… Steve Nerem war auch Ko-Autor des schreiend alarmistischen Artikels in der Washington Post im Mai 2016 mit dem Titel „10 things you should know about sea level rise and how bad it could be”, in welchem gesagt wird dass „Wissenschaftler schätzen, dass wenn sich die Welt um 4 bis 5°C erwärmt, was für das Ende des Jahrhunderts projiziert wird, wenn wir keine Maßnahmen gegen den Klimawandel ergreifen, alles Eis wahrscheinlich schmelzen wird. Das würde einen Meeresspiegel-Anstieg um 70 Meter bewirken“.

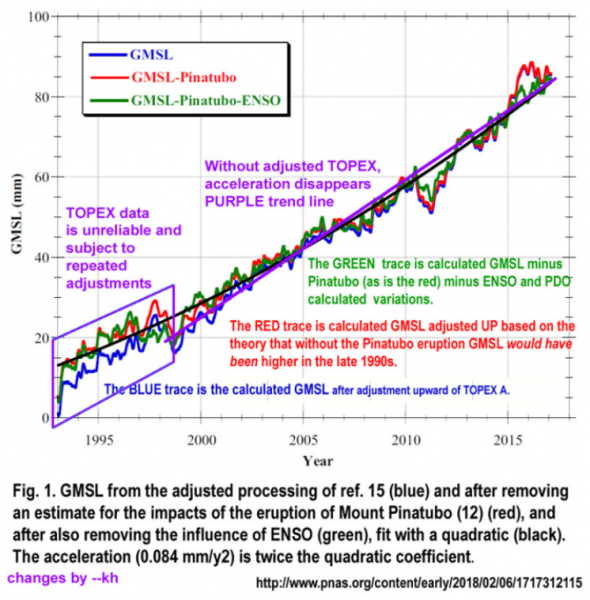

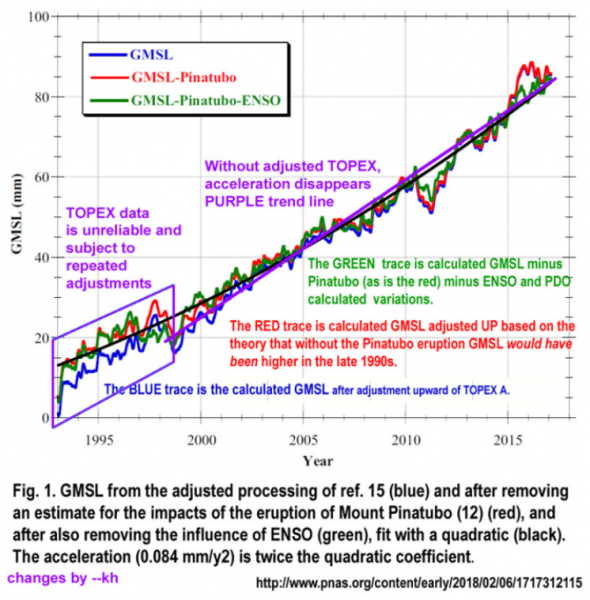

So wurden die neuen, alarmistischen Werte in der Studie [14] ermittelt

Wie die vorhergehenden Beispiele zeigten, sind regelmäßige „neu-Findungen“ der „wahren“ Satelliten-Pegeldaten nichts Neues, sondern gehören zum AGW-Klimawandel-Alltag.

Die Autoren der neuen Studie sagen nun:

-A: Dass man seit 1993 die Satellitendaten falsch korrigiert hat,

-B: zusätzlich der Meerespegel durch Naturereignisse wie den Pinatubo-Ausbruch, die ENSO-Zirkulation und El Ninos „gedrückt“ wurde (was bisher nicht richtig berücksichtigt wurde) und in Wirklichkeit deshalb ein stärkerer Pegelanstieg „gewesen“ wäre.

SPON 12.02.2018: [5] ... Ergebnis: Die ersten Jahre der Satellitenmessungen hatten zu hohe Werte ergeben, das Messgerät war anscheinend falsch eingestellt; die Werte haben die Forscher nun nach unten korrigiert. Entsprechend größer fiel der Meeresspiegelanstieg in den folgenden Jahren aus … So seien zahlreiche Effekte, die nichts mit dem Klimawandel zu tun haben, herausgerechnet worden.

Wenn man alle diese Fehler nun (endlich) richtig korrigiert – wovon die Studienautoren ausgehen:

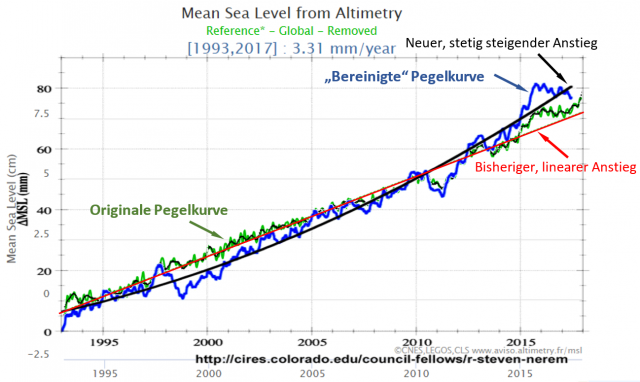

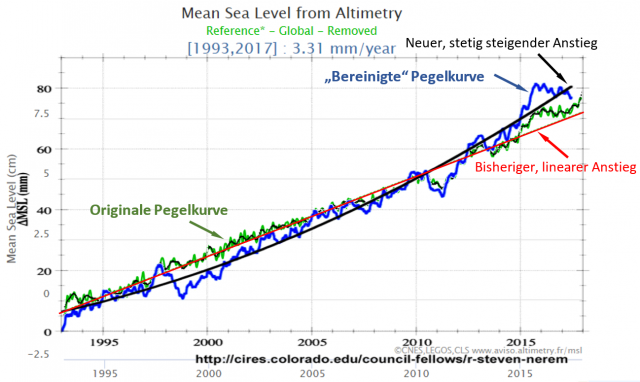

Bild 5 [2] Verschiedene Korrekturen der Studie

Bild 6 „Wirklicher“ Pegelverlauf laut der neuen Studie. Quelle: Homepage R. Steven Nerem

Bild 7 Pegelverlauf der Satellitenmessungen (grün, von Bild 1) und „berechneter“ Pegelverlauf der Studie (blau, von Bild 6) auf den Anfangswert normiert. Bilder vom Autor übereinander kopiert.

Bild 8 Darstellung von Bild 6 mit den original-Pegelkurven der Satelliten (Bild 3) auf den Endwert normiert

Das ist so, als wenn man die Temperaturentwicklung von März bis August misst und dann für die kommenden 10 Jahre extrapoliert. Hilfe, wir werden verbrennen!

Auf WUWT wurde genau dies wie folgt rezensiert und zeigt den Unterschied einer Pseudoinformation bei SPON und der Seite „Klimaretter.Info“, unserer Beraterin der Berliner Politikkaste, zu der einer informativen Seite (Übersetzung EIKE): [12] WUWT: … Wie haben sie das gemacht?

Offenbar ganz einfach. Im jüngsten Zeitraum der Meeresspiegel-Aufzeichnungen via Satelliten gibt es einfach keinen Spielraum mehr für größere Änderungen – es ist schwierig, die Daten zu ändern oder zu adjustieren – das Adjustierungs-Budget ist bereits ausgeschöpft. Bringt man trotzdem welche an, geht das einfach schief – also (nicht lachen!) haben sie erneut die Vergangenheit adjustiert.

Wir sehen hier (Anmerkung: Bild Im Originalartikel), dass er mittels einer Reihe von Adjustierungen das linke Ende der Graphik, die TOPEX Altimeter A-Daten, um etwa 3 bis 5 mm angehoben und die Altimeter-B-Daten geringfügig verändert hat. Das Anheben des linken Endes der Graphik – also im Zeitraum 1993 bis 1999 – gestattet es ihm, die Trendlinie mit einer Steigung von 3,0 mm pro Jahr auf eine solche mit 3,8 mm pro Jahr zu ändern.

Nachdem Nerem diese Art der Adjustierung durchgeführt hatte, benutzte er die gleichen adjustierten Daten, um einen gekrümmten Beschleunigungstrend zu zeichnen, welcher seiner Behauptung nach 3,9 mm pro Jahr zeigt.

Fünf Millimeter der maximalen Änderung jedweden Datenpunktes in der Aktualisierung! Die schreckliche, zu befürchtende Beschleunigung des Meeresspiegel-Anstiegs (SLR) ergibt sich ausschließlich aus zweifelhaften Korrekturen allein der TOPEX Altimeter A-Daten – ganze 5 mm bei sechs Jahren „schlechter Daten“ von 1993 bis 1999. Falls diese Daten wirklich schlecht sind, hätte man sie aussondern müssen, anstatt sie so zu frisieren, dass sie zu einem vorbestimmten Narrativ passen.

Anmerkung: In diesem (Teil-)Artikel fehlt die Information, dass zusätzlich zu den Satellitendaten-Adjustierungen auch „Umweltkorrekturen“ durchgeführt wurden.

kaltesonne 23.02.2018: Vor kurzem rauschte es kräftig im medialen Blätterwald. Ein Forscherteam behauptete, der Meeresspiegelanstieg würde sich immer weiter beschleunigen. Potsdam stand Kopf. Die fünfte Jahreszeit war angebrochen. Im Internet bestellten einige Zeitgenossen bereits Tickets für die Arche Noah vor, um auf Nummer sicher zu gehen.

Au weia. Offensichtlich hat die Welt die Kunst des Lesens verloren, und damit ist das Lesen der Originalfachpublikation gemeint. Dabei hätte schon der Abstract gereicht:

Climate-change–driven accelerated sea-level rise detected in the altimeter era

Using a 25-y time series of precision satellite altimeter data from TOPEX/Poseidon, Jason-1, Jason-2, and Jason-3, we estimate the climate-change–driven acceleration of global mean sea level over the last 25 y to be 0.084 ± 0.025 mm/y2. Coupled with the average climate-change–driven rate of sea level rise over these same 25 y of 2.9 mm/y, simple extrapolation of the quadratic implies global mean sea level could rise 65 ± 12 cm by 2100 compared with 2005, roughly in agreement with the Intergovernmental Panel on Climate Change (IPCC) 5th Assessment Report (AR5) model projections.

Eine simple Trendextrapolation eines quadratischen Trends. Science at it’s best!? Dabei wissen wir, dass Ozeanzyklen mit einer Periodenlänge von 60 Jahren hier eine maßgebliche Rolle spielen. Dafür sind die Satellitendatenreihen aber viel zu kurz. Das ist so ein bisschen, als wenn man die Temperaturentwicklung von März bis August misst und dann für die kommenden 10 Jahre extrapoliert. Hilfe, wir werden verbrennen!

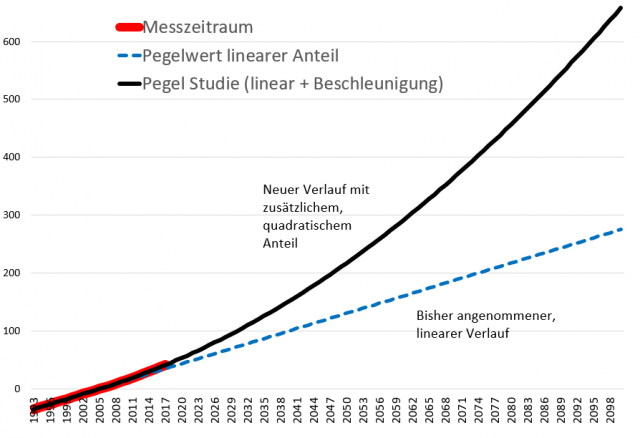

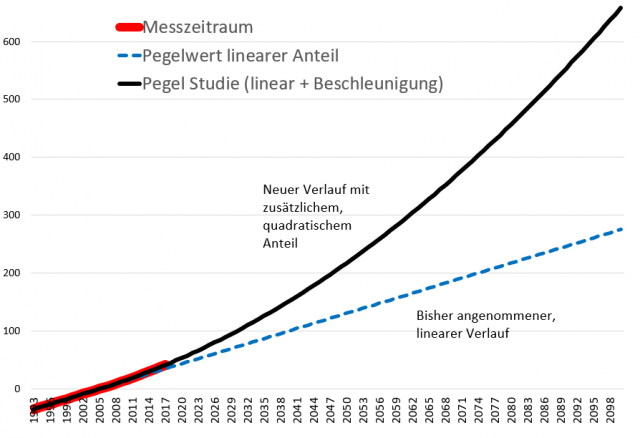

Das lässt sich (angeblich) bis zum Jahr 2100 mit einer nicht zyklischen Funktion hochrechnen

Studie: [8] … Ihren Satellitenmessungen und Berechnungen nach könnte der Anstieg im Jahr 2100 bereits zehn Millimeter pro Jahr betragen. Der Durchschnittspegel an den Küsten könnte dann um 65 Zentimeter höher liegen als im Jahr 2005 …

… Das Team um Nerem errechnete eine Beschleunigung des globalen Meeresspiegelanstiegs um 0,08 Millimeter pro Jahr zum Quadrat. Der jährliche Anstieg, der derzeit bei etwa 3 Millimetern liegt, erhöht sich demnach jedes Jahr um einen immer größeren Wert.

Bild 9 Verlauf des „bereinigten“ Satellitenpegels (schwarze, dicke Linie) bis zum Jahr 2100 laut Studie [14]. Grafik vom Autor mit den Daten der Studie berechnet

Projektionsvarianten zum Jahr 2100

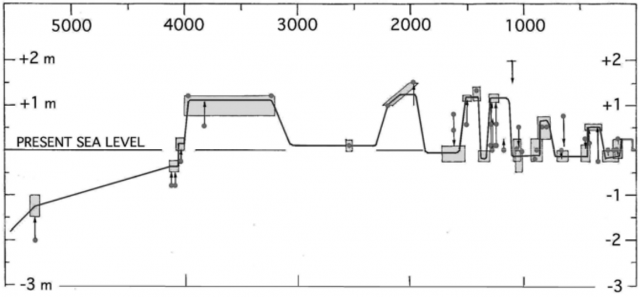

Nach so vielen Zahlenwerten muss man immer die Projektionen zum Jahr 2100 im Schaubild betrachten. Man beachte dabei: Es handelt sich immer um den gleichen Ozean unserer Erde. Man braucht gar nicht zu rechnen, um ein Gefühl für den wahrscheinlichsten Pegelbereich zu bekommen.

Wer meint, die +2 m des mit Wissenschafts- und Ehrenpreisen überhäuften Herrn Schellnhuber wären eventuell doch leicht übertrieben: Auf phoenix kam am 09.02.2018 der Film „Bengalisches Fieber, eine Reise durch Bangladesch“. Im Film erzählte der Sprecher, dass der Meerespegel dort im Jahr 2.100 +4 m betragen werde.

Bild 10 [11] Pegel-Zukunfts-Projektionen verschiedenster Quellen. Eingetragen sind die Satellitendaten aus der Studie [14]. Skalierungen ungefähr maßstabsgetreu vom Autor zusammengestellt

Damit endet der erste Teil. Im zweiten Teil werden die Aussagen von Klima- und Pegelexperten zu dieser “bahnbrechenden” Studie “beleuchtet”.

Quellen

[1] EIKE 13.01.2018: Meeresspiegel – steigen und fallen: Wie man einen Anstieg aus Nichts erzeugt

[2] EIKE 18.02.2018: Meeresspiegel: Steigen und Fallen – Teil 4a – ein sogar noch stärkerer Anstieg aus Nichts

[3] EIKE 19.02.2018: Die immer neu aufsteigenden und untergehenden Inseln wie zum Beispiel Tuvalu

[4] kaltesonne 14. Juli 2014: Wie verlässlich sind Satellitenmessungen des Meeresspiegels? Küstenpegel zeigen viel geringeren Anstieg als Messungen aus dem All

[5] SPON 12.02.2018: Satellitenmessungen Meeresspiegel steigt immer schneller

[6] EIKE 13.04.2015, K. E. Puls: Neue Meeres-Spiegel-Studie zeigt: Satelliten-Daten überhöht

[7] ScienceScepticalBlog 13. April 2012: Was nicht passt wird passend gemacht – ESA korrigiert Daten zum Meeresspiegel

[8] Bayerischer Rundfunk 13.02.2018: Wenn der Meeresspiegel steigt und Inseln versinken

[9] EIKE 07.04.2016: Der Verlauf des Meeresspiegels im Holozän und seit 2.000 Jahren

[10] BR IQ-Podcastbeitrag mit dem Interview zur jüngsten Satellitenstudie

[11] PIC 2007, Wilfried Endlicher, Friedlich-Wilhelm Gerstengrabe: Der Klimawandel

[12] EIKE 13.01.2018: Meeresspiegel – steigen und fallen: Wie man einen Anstieg aus Nichts erzeugt

[13] Nils-AxelMörner August 2017: Sea Level Manipulation; Intern. J. Engineering Science Invention, ISSN (Online): 2319 – 6734, ISSN (Print): 2319 – 6726

[14] R. S. Nerem at. al.: Climate-change–driven accelerated sea-level rise detected in the altimeter era

Studie: 3 Seiten, 33 Quellenverweise

[15] EIKE 13.08.2017: Manila versinkt durch Wasserentnahme im austrocknenden Untergrund. Der (reiche) Westen mit seinem CO2 soll daran schuld sein – und zahlen

[16] EIKE 30.12.2017: Ohne den Klimawandel hätte das gleiche Wetter nicht so schlimme Folgen…

[17] kaltesonne 14. Juli 2014: Wie verlässlich sind Satellitenmessungen des Meeresspiegels? Küstenpegel zeigen viel geringeren Anstieg als Messungen aus dem All