Ich habe ein paar grundlegende Fragen zur auf Klimamodellen basierenden Wissenschaft, und zwar Folgende:

● Warum finanzieren die Steuerzahler auf Klimamodellen basierende Forschungen, wenn diese Modelle gar nicht das Klima der Erde simulieren?

● Warum finanzieren die Steuerzahler auf Klimamodellen basierende Forschungen, wenn jede neue Generation von Klimamodellen die gleichen grundlegenden Antworten liefert?

● Redundanz: Warum finanzieren die Steuerzahler 5 Klimamodelle in den USA?

● Warum liefern Klimamodelle nicht die Antworten, die wir brauchen?

●● Beispiel: Warum hat der Konsens regionaler Klimamodelle Timing, Ausmaß und Dauer der Dürre in Kalifornien nicht vorhergesagt?

Ich habe diese Bedenken im Folgenden ausgeführt und erläutert.

Anmerkung: Ich habe mit diesem Brief bereits vor einigen Monaten angefangen, und zwar nach der Ankündigung, dass Sie diesen Komitees vorstehen werden. Zwei von Ihnen bewerben sich jetzt um die Präsidentschaft. Selbst damit im Hinterkopf hoffe ich, dass Sie und ihre Büros diese Fragen beantworten.

Warum finanzieren die Steuerzahler auf Klimamodellen basierende Forschungen, wenn diese Modelle gar nicht das Klima der Erde simulieren?

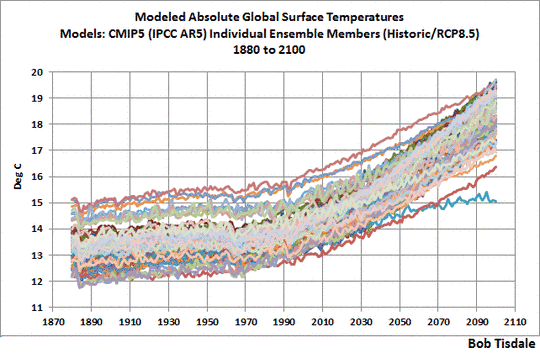

Das IPCC verlässt sich auf Klimamodelle, um die globale Erwärmung und den Klimawandel Emissionen anthropogener Treibhausgase zuzuordnen und für die Simulation des zukünftigen Klimas auf der Grundlage von Schätzungen zukünftiger Emissionen. Aber die Klimamodelle simulieren das Klima der Erde nicht so, wie es derzeit ist, wie es in der Vergangenheit war oder in Zukunft sein könnte. Die Gemeinschaft der Klimawissenschaft weiß das sehr wohl, aber nur wenige Personen außerhalb dieser geschlossenen Gruppe haben auch nur die geringste Ahnung davon, dass die Klimamodelle das Erdklima gar nicht simulieren.

Dr. Kevin Trenberth vom National Center for Atmospheric Research (NCAR) war vor über 7 Jahren sehr offen hinsichtlich dieser simplen Fakten, und es gab keine Weiterentwicklungen seitdem beim Prozess der Klimamodellierung. In Dr. Trenberths Artikel aus dem Jahr 2007 mit dem Titel Predictions of Climate auf dem Blog Nature.com wurden viele kritische Schwächen der Klimamodelle angesprochen, die vom IPCC für die Simulation des Erdklimas in Vergangenheit und Zukunft verwendet worden waren. Dr. Trenberths Artikel war angefüllt mit bemerkenswerten Äußerungen, wie z. B.:

…kein einziger Klimastatus in den Modellen korrespondiert auch nur entfernt mit dem gegenwärtig beobachteten Klima.

Im Besonderen haben der Zustand der Ozeane, Meereis und Bodenfeuchtigkeit keine Beziehung zu den beobachteten Zuständen zu irgendeiner Zeit der jüngeren Vergangenheit in irgendeinem der IPCC-Klimamodelle.

Außerdem kann der Klimastatus zu Beginn der Simulation in vielen der Modelle signifikant vom realen Klima abweichen, was den Weg frei macht für Modellfehler.

Das sind aussagekräftige Feststellungen. Falls Sie Dr. Trenberths Beitrag vollständig lesen würden, werden sie erkennen, dass jene Zitate sich wie ein roter Faden durch den übrigen Text ziehen. Gelegentlich warf Trenberth ein, was man tun könne, damit das Dogma der globalen Erwärmung die kritischen Aspekte abschwächt.

Eines von Dr. Trenberths Statements ragt als Selbstbetrug heraus:

Das gegenwärtige Projektionsverfahren funktioniert bis zu dem Grad, wie es der Fall ist, weil Differenzen von Lauf zu Lauf sowie der Haupt-Modellbias und systematische Fehler sich gegenseitig aufheben. Dies legt Linearität nahe.

Sieben Jahre später, mit der Verlangsamung der Erwärmung und der fehlenden Wärme in den Ozeanen weiß jeder, dass das „gegenwärtige Projektionsverfahren“ nicht funktioniert. Die Gemeinschaft der Klimawissenschaft wusste von Anfang an, dass das Erdklima chaotisch und nichtlinear ist. Tatsächlich hat das IPCC bereits in seinem Dritten Zustandsbericht unter der Überschrift Balancing the need for finer scales and the need for ensembles festgestellt (Fettdruck von mir):

Alles in allem muss eine Strategie berücksichtigen, was möglich ist. Bei der Klimaforschung und -modellierung müssen wir erkennen, dass wir es mit einem gekoppelten, nichtlinearen chaotischen System zu tun haben und dass daher eine langfristige Prognose des zukünftigen Klimazustandes nicht möglich ist.

Auf der gleichen Website fährt das IPCC dann fort, dieses Statement als Begründung für große Ensembles von Modellen heranzieht in der unlogischen Annahme, dass eine Sammlung falscher Modelle richtige Antworten erbringt.

Es war nur eine Frage der Zeit, bis das „gegenwärtige Projektionsverfahren“ des IPCC scheitert. Und es hat nicht lange gedauert. Falls das „gegenwärtige Projektionsverfahren“ funktioniert hätte, müsste sich die klimawissenschaftliche Gemeinschaft jetzt nicht damit herumschlagen, die Verlangsamung der Erwärmung und die fehlende Wärme in den Ozeanen mit einer Entschuldigung nach der anderen zu erklären.

Schauen wir noch, was Dr. Trenberth zur Stützung der oben zitierten Stichworte geschrieben hat:

Keines der vom IPCC benutzten Modelle wurde auf den beobachteten Status initialisiert, und keiner der Klimazustände in den Modellen korrespondiert auch nur entfernt mit dem gegenwärtig beobachteten Klima. Insbesondere der Zustand der Ozeane, Meereis und Bodenfeuchtigkeit haben keine Beziehung zum beobachteten Zustand zu irgendeinem Zeitpunkt der jüngeren Vergangenheit in irgendeinem der IPCC-Modelle. Weder gibt es eine El Niño-Sequenz noch irgendeine Pazifische dekadische Oszillation, welche die jüngere Vergangenheit spiegeln; und doch sind es diese grundlegenden Faktoren der Variabilität, die die Anrainerstaaten des Pazifik und darüber hinaus beeinflussen. Die Atlantische Multidekadische Oszillation, die von der thermohalinen Zirkulation abhängig sein kann und folglich von von den Meeresströmen im Atlantik, wurde nicht mit dem heutigen Zustand abgeglichen, obwohl dies eine wichtige Komponente atlantischer Hurrikane ist und zweifellos Auswirkungen auf die Vorhersage der nächsten Dekade von Brasilien bis nach Europa hat. Außerdem kann der Klimastatus zum Startpunkt vieler der Klimamodelle signifikant vom realen Klimastatus derzeit abweichen, was zu Modellfehlern führt. Ich postuliere, dass es unmöglich ist, regionale Klimaänderungen angemessen vorhersagen zu können, solange die Modelle nicht initialisiert werden.

Es kommt nicht überraschend, dass auf natürliche Weise stattfindende und von Sonnenlicht angetriebene El Niño- und La Niña-Ereignisse sowie längerzeitliche Zustände der natürlichen Variabilität wie die AMO und die PDO jetzt dafür herhalten müssen, die globale Erwärmung zu unterdrücken. Andererseits wird fast nie angesprochen, dass:

● jene Zustände der natürlichen Variabilität die globale Erwärmung auch verstärken können, und

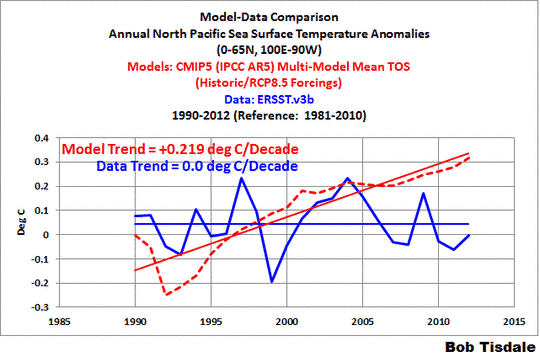

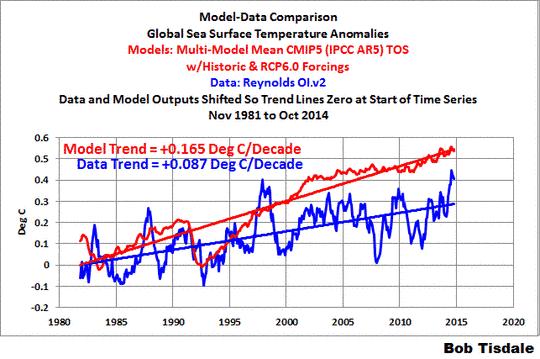

● die Klimamodell-Projektionen des zukünftigen Klimas nur mit der auf natürliche Weise erfolgten Erwärmung von Mitte der siebziger Jahre bis zur Jahrhundertwende einhergehen.

Beide diese Faktoren zeigen, dass Klimamodellprojektionen einer zukünftigen globalen Erwärmung zwei mal zu hoch ausfallen.

Weil die Klimamodelle Zustände der natürlichen Variabilität nicht simulieren können, die die globale Erwärmung verstärken oder abschwächen, ist das Verlassen auf diese Modelle, wie sie heute existieren, für das Studium der globalen Erwärmung und des Klimawandels ähnlich wie bei Physikern, die sich auf Computermodelle des menschlichen Körpers verlassen, die nicht Atmung, Verdauung, Kreislauf usw. simulieren können.

Einfach gesagt, Klimamodelle sind eine virtuelle Realität. Sie sind nicht realer als die mit Computern erzeugten Bilder von King Kong oder Dinosauriern oder Aliens in Kinofilmen.

Schauen wir noch ein mal darauf, was die Klimawissenschaftler uns mit ihren Klimamodell-Projektionen in Wirklichkeit sagen: (1) Falls Emissionen anthropogener Treibhausgase wie in zahlreichen Zukunftsszenarien projiziert zunehmen, und (2) falls das Erdklima auf diese Zunahme anthropogener Treibhausgase reagiert, wie es von den Klimamodellen simuliert wird, dann (3) könnte sich das Klima wie simuliert ändern, aber (4) die klimawissenschaftliche Gemeinde weiß sehr genau, dass das Erdklima NICHT auf jene Zunahmen reagiert, wie es die Klimamodelle projizieren.

Da fragt man sich, warum sie diese Mühen auf sich nehmen … wohl nur, um die Wünsche der politischen Gebilde zu erfüllen, die die Klimawissenschaft finanzieren.

Anmerkung: In einem Postscriptum zu diesem Brief habe ich ein paar Beispiele angeführt mit Vergleichen von Modellen mit Daten aus meinen früheren Blogbeiträgen. Sie zeigen, wie schlecht die Klimamodelle die Temperaturen, Niederschlag und Meereis simulieren.

Warum finanzieren die Steuerzahler auf Klimamodellen basierende Forschungen, wenn jede neue Generation von Klimamodellen die gleichen grundlegenden Antworten liefert?

Die vom IPCC praktizierte, auf Klimamodellen basierende Forschung zeitigt die gleichen grundlegenden Antworten wie bereits vor über zwei Jahrzehnten. Vom Ersten IPCC-Zustandsbericht aus dem Jahr 1990 bis zum Fünften Zustandsbericht 2013 gab es kaum Änderungen von auf Klimamodellen basierenden Projektionen der Temperaturen, verursacht durch vermeintliche zukünftige Zunahmen der Emissionen anthropogener Treibhausgase (hauptsächlich Kohlendioxid). Als zusätzliche Beispiele haben uns alle fünf Zustandsberichte fundamental auch gesagt:

1) Der Meeresspiegel wird weiter steigen, unabhängig davon, ob wir unsere Emissionen von Treibhausgasen reduzieren oder nicht … und es gibt immer noch große Unsicherheits-Bandbreiten von Best-Case-Szenarien, die sich mit Worst-Case-Szenarien überlagern.

2) Gletscher und Eisschilde werden schmelzen, was zum Anstieg des Meeresspiegels beiträgt … aber das ist lediglich eine Fortsetzung des Schmelzprozesses, der seit dem Ende der letzten Eiszeit im Gange ist, als die Temperaturen auf ein Niveau gestiegen sind, bei dem Inlandseis schmilzt. Gletscher und Eisschilde werden weiterhin schmelzen, bis die Temperaturen wieder fallen und wir der nächsten Eiszeit entgegen gehen. Und das fortgesetzte Abschmelzen der Gletscher und Eisschilde wird natürlich zu weiteren Anstiegen des Meeresspiegels beitragen.

3) In einigen Regionen der Erde wird es Dürren, in anderen Überschwemmungen geben … aber selbst die gegenwärtigen „hypermodernen“ Klimamodelle können uns nicht sagen, wo und wann diese Überschwemmungen und Dürren auftreten, weil sie immer noch nicht die jährlichen, dekadischen und multidekadischen Variationen simulieren können in gekoppelten Ozean-Atmosphäre-Prozessen, die den globalen Niederschlag steuern. Hierzu mehr in einem späteren Abschnitt.

Die USA haben während der letzten zwei Jahrzehnte Milliarden Dollar in die auf Klimamodellen basierende Wissenschaft gesteckt. Und doch sagen uns die Berichte immer das Gleiche, wieder und immer wieder: Temperaturen und Meeresspiegel werden steigen, etc. Sie liefern nichts neues von Wert und haben das auch noch nie getan.

Redundanz: Warum finanzieren die Steuerzahler 5 Klimamodelle in den USA?

Von den 26 Klimamodell-Gruppen der Welt, die Modellergebnisse für den 5. IPCC-Zustandsbericht des IPCC liefern, stammen 5 aus den USA:

Das CMIP5-Klimamodellvergleichsprojekt findet sich hier.

● NASA Goddard Institute for Space Studies (GISS)

● NASA Global Modeling and Assimilation Office (GMAO)

● National Center for Atmospheric Research (NCAR)

● NOAA Geophysical Fluid Dynamics Laboratory (GFDL)

● National Science Foundation, Department of Energy, National Center for Atmospheric Research (NSF-DOE-NCAR)

Keines der Modelle simuliert das Klima so, wie es jetzt ist. Brauchen die USA 5 Klimamodelle und den damit verbundenen Mitarbeiterstab für Modelle, die das Klima auf einem virtuellen Planeten simulieren, der wenig Ähnlichkeit mit dem hat, den wir bewohnen?

Warum liefern Klimamodelle nicht die Antworten, die wir brauchen?

Nach vielen Jahrzehnten der Bemühungen, das Klima zu modellieren, hat die klimawissenschaftliche Gemeinschaft keine Modelle bilden können, die in der Lage sind, die Antworten zu liefern, die wir brauchen und die wir verdienen. Dafür gibt es einen ganz einfachen Grund: Den Schwerpunkt der klimawissenschaftlichen Gemeinschaft bei der Klimaforschung.

Unter Führung des IPCC und der politischen Körperschaften, die die Klimawissenschaft finanzieren, lag der Schwerpunkt der Klimaforschung immer auf der vom Menschen verursachten globalen Erwärmung oder des Klimawandels, niemals aber auf der natürlichen Variabilität. Dabei sind es auf natürliche Weise ablaufende gekoppelte Ozean-Atmosphäre-Prozesse, die bestimmen, wann und wo Temperatur und Niederschlagsmenge zunehmen und wo nicht.

Wir müssen uns immer vor Augen führen, dass das IPCC eine politische Institution ist und nicht eine wissenschaftliche. Die einzige Aufgabe dieser Institution ist es, wissenschaftliche Studien zu bewerten, die eine politische Agenda stützen. Nicht mehr und nicht weniger.

Die Website mit der Historie des IPCC beginnt mit den Worten (Fettdruck von mir):

Das IPCC wurde im Jahre 1988 ins Leben gerufen. Es wurde gebildet von der WMO und dem United Nations Environment Program (UNEP), um Zustandsbeschreibungen auf der Grundlage verfügbarer wissenschaftlicher Informationen zu erstellen über alle Aspekte des Klimawandels und deren Auswirkungen, mit einer Meinungsbildung, um realistische Gegenmaßnahmen einzuleiten. Die ureigene Aufgabe des IPCC, wie sie in der Resolution der UN-Vollversammlung 43/53 vom 6. Dezember 1988 umrissen worden war ist es, unter Berücksichtigung des Wissens um die Wissenschaft des Klimawandels umfassende Berichte und Empfehlungen zu erstellen; über die sozialen und ökonomischen Auswirkungen des Klimawandels und mögliche Gegenmaßnahmen sowie Elemente, die Eingang finden könnten in ein mögliches zukünftiges internationales Klimaabkommen.

Folglich wurde das IPCC gegründet, um Berichte zu schreiben. Keine Frage, dass es sich dabei um sehr detaillierte Berichte handelt, so beladen, dass nur sehr wenige Personen sie in Gänze lesen würden. Die meisten Menschen lesen nur die Summaries for Policmakers … auf deren Inhalte sich die Politiker nach jeweils wochenlangen Diskussionen einigen müssen [und deren Wortlaut, wie man inzwischen weiß, auf politischen Druck hin häufig vom Wortlaut in den Originalberichten abweichen. Anm. d. Übers.].

Wie aus obigem Zitat hervorgeht, ist die Sprache der IPCC-Berichte darauf ausgerichtet, ein internationales Klimawandel-Abkommen zu stützen.

Dieser Vertrag ist bekannt unter der Bezeichnung United Nations Framework Convention on Climate Change (UNFCCC). Er wurde im Jahre 1992 unterzeichnet, ein Jahr nach dem ersten IPCC-Zustandsbericht. Dieses Timing ist sehr seltsam, weil die Ergebnisse jenes ersten Berichtes nicht aufschlussreich waren, konnte doch die klimawissenschaftliche Gemeinde darin nicht unterscheiden zwischen natürlichen und anthropogenen Beiträgen. Dies brachte die UN in eine prekäre Lage. Man hatte ein Abkommen zur Stelle, die Emissionen von Treibhausgasen zu reduzieren, jedoch ohne wissenschaftliche Unterstützung. Folglich musste jeder folgende politisch motivierte Bericht unbedingt die Sicherheit des IPCC zunehmen lassen, dass Treibhausgase der primäre Treiber der globalen Erwärmung waren. Anderenfalls wäre das UNFCCC tot.

Ein paar Klarstellungen:

Eine Ausgabe des UNFCCC findet sich hier. Unter der Überschrift von Artikel 2 – Objektive identifiziert das UNFCCC sein Ziel, die Emissionen von Treibhausgasen zu begrenzen (Fettdruck von mir):

Die ultimative Objektive dieser Konvention und jedwedes damit zusammenhängende legale Instrument, das die Konferenz der Teilnehmer übernehmen könnten, ist es, in Übereinstimmung mit den relevanten Provisionen der Konvention die Treibhausgaskonzentrationen in der Atmosphäre auf einem Niveau festzuschreiben, dass gefährliche anthropogene Interferenzen mit dem Klimasystem verhindert.

Weil es die Objektive des UNFCCC-Vertrages war, die Emissionen menschlicher Treibhausgase zu begrenzen, und weil es das Ziel des IPCC war, Berichte zu erstellen, die diesen Vertrag stützen, kann man mit Fug und recht sagen, dass es die einzige Rolle des IPCC war, wissenschaftliche Berichte zu schreiben, die eine politisch motivierte Vorgabe zur Begrenzung von Treibhausgasemissionen stützen. Ich habe das Wort Vorgabe aus einem ganz bestimmten Grund unterstrichen: Weil die Klimamodelle das Klima immer noch nicht so simulieren, wie es ist, hat das IPCC niemals wirklich glaubhaft gemacht, dass eine Notwendigkeit zur Begrenzung der Emissionen besteht.

Weiter unten auf der Website mit der IPCC-Historie stellt man fest (Fettdruck von mir):

Die heutige Rolle des IPCC ist definiert in den Prinzipien, der die Arbeit des IPCC zu folgen hat (hier) … nämlich auf einer umfassenden, objektiven, offenen und transparenten Grundlage die wissenschaftlichen, technischen und sozio-ökonomischen Informationen einzuschätzen, die relevant sind für das Verständnis der wissenschaflichen Basis für das Risiko eines von DEN MENSCHEN VERURSACHTEN Klimawandels, deren potentielle Auswirkungen und Optionen für Anpassung an und Abschwächung desselben.

Die Tatsache, dass das IPCC all seine Bemühungen auf das „Verständnis der wissenschaftlichen Basis der Risiken einer vom Menschen verursachten Klimaänderung“ konzentriert hat, ist sehr wichtig. Das IPCC hat niemals wirklich versucht zu untersuchen, ob nicht auch natürliche Faktoren Hauptursache für den größten Teil der Erwärmung während des vorigen Jahrhunderts sein könnten. Jahrzehnte lang haben sie Tomaten auf den Augen gehabt, die ihre Sicht auf alles andere außer den möglichen Auswirkungen von Kohlendioxid verhindert haben. Die Rolle des IPCC war es stets, Berichte zu erstellen, die die Reduktion von Treibhausgasemissionen stützen, die bei der Verbrennung fossiler Treibstoffe anfallen. Als Folge davon fließt das gesamte Forschungsgeld genau dorthin. Die Entscheidung, nur die vom Menschen induzierte globale Erwärmung zu studieren, ist eine politische und keine wissenschaftliche Entscheidung.

Als Folge dieser politischen Entscheidung gibt es kaum wissenschaftliche Forschungen, die versuchen zu bestimmen, wie viel der erfolgten Erwärmung natürlichen Faktoren geschuldet ist. Wir wissen, dass dies eine Tatsache ist, weil die gegenwärtige Generation von Klimamodellen – die komplexesten Klimamodelle bisher – immer noch nicht aus natürlichen Gründen auftretende Ozean-Atmosphäre-Prozesse simulieren können, die dafür sorgen, dass sich die Erdoberfläche (und die Ozeane bis zu einer bestimmten Tiefe) Jahrzehnte lang erwärmen oder abkühlen können.

Beispiel: Warum hat der Konsens regionaler Klimamodelle Timing, Ausmaß und Dauer der Dürre in Kalifornien nicht vorhergesagt?

Klimamodellierer gehen seit einer Reihe von Jahren in eine andere Richtung: regionale Klimamodelle. Siehe hier zu die NASA-Website Regional Climate Models Evaluation System. Natürlich versuchen sie auf dieser Website , ein rosiges Bild zu zeichnen ohne in größerem Umfang offen zu sein hinsichtlich der Unsicherheiten, die durch natürlich auftretende chaotische Faktoren ins Spiel kommen.

Wir haben uns daran gewöhnt, große Unsicherheits-Bandbreiten der globalen Klimamodelle zu erkennen. Mit kürzerfristigen regionalen Klimamodellen werden diese Unsicherheiten sogar noch größer, weil Ozean-Atmosphäre-Prozesse, die über die Möglichkeiten der Klimamodelle hinausgehen, eine so große Bandbreite von Einflüssen auf das regionale Klima haben.

Unabhängig davon, ob es nun regionale oder globale Klimamodelle sind – Klimamodelle im Allgemeinen sind immer noch nicht in der Lage, gekoppelte Ozean-Atmosphäre-Prozesse zu simulieren, die jährliche, vieljährige, dekadische und multidekadische Änderungen von Temperatur und Niederschlag bestimmen, global und regional. Wie oben erwähnt hat Dr. Trenberth festgestellt, dass Klimamodelle keinerlei natürliche Faktoren der Klimavariabilität enthalten: El Niño/La Niña, PDO und AMO. Es gibt viele andere Modi der natürlichen Variabilität, die jenseits der Möglichkeiten von Klimamodellen liegen, und diese Faktoren haben ebenfalls starke Auswirkungen auf das regionale Klima im Kurzfristzeitraum.

Jetzt möchte ich einen Punkt klarstellen. Ich habe oben geschrieben, dass Klimamodelle immer noch keine Modi der natürlichen Variabilität enthalten. Das heißt nicht, dass sie ein Feature ausschließen, das sie einfach aus einem Menü wählen und dem nächsten Modelllauf hinzufügen können. Die Modelle können diese nicht angemessen simulieren. Es gibt zahlreiche begutachtete Studien, die dieses Scheitern dokumentieren.

Selbst die grundlegendsten Beziehungen zwischen den Passatwinden und der Wassertemperatur im tropischen Pazifik (wo die El Niño-Ereignisse stattfinden) liegen jenseits der Möglichkeiten der Klimamodelle. (Seit dieser Entdeckung in den sechziger Jahren nennt man diese Beziehung die Bjerkness-Rückkopplung. Die Studie aus dem Jahr 2012 von Bellenger et al. ENSO representation in climate models: from CMIP3 to CMIP5 bestätigt diese traurige Tatsache).

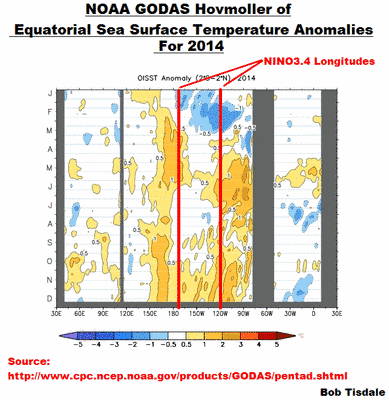

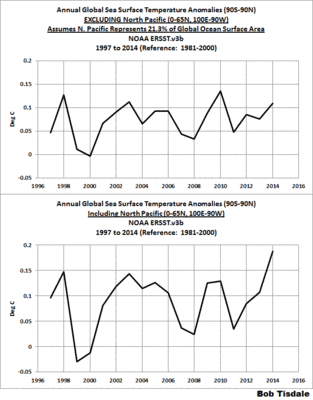

Warum hat uns ein Konsens regionaler Klimamodelle nicht gesagt, dass in Kalifornien den Daten zufolge seit 25 Jahren (von 1986 bis 2011) keinerlei Erwärmung mehr aufgetreten ist (hier)? Warum haben sie uns nicht gesagt, dass sich vor ein paar Jahren nordwestlich von Kalifornien über dem östlichen Nordpazifik ein stabiles Hochdruckgebiet gebildet hat … das bis heute Bestand hat? Dass ein Gebiet mit warmem Wasser sich ebenfalls in jenem Gebiet der Nordpazifik bildet … ein Gebiet mit so hohen Wassertemperaturen, dass sie der dominante Grund sind für die rekordhohen globalen Temperaturen im Jahre 2014 (hier)? Dass die Hochdruckzone (jetzt bekannt unter der Bezeichnung „the Blob“) im nordöstlichen Nordpazifik Ursache für die jüngsten rekordhohen Temperaturen in Kalifornien war, zusammen mit einer unter dem Durchschnitt liegenden Niederschlagsmenge? Dass das „lächerlich beständige Hochdruckgebiet“ und „the Blob“ rekordniedrige Temperaturen im Nordosten [der USA] während des vergangenen Winters zur Folge hatte?

(Siehe Bond et al. 2015 Causes and Impacts of the 2014 Warm Anomaly in the NE Pacific und Hartmann (2015) Pacific sea surface temperature and the winter of 2014 sowie deren Presseerklärung ‘Warm blob’ in Pacific Ocean linked to weird weather across the U.S. Auch hier: Johnstone and Mantua (2014) Atmospheric controls on northeast Pacific temperature variability and change, 1900–2012.)

Es gibt einen ganz einfachen Grund, warum uns regionale Klimamodelle nicht gesagt haben, dass es zu all dem kommen würde. Klimamodelle sagen nicht das Wetter vorher, und die die Dürre und die hohen Temperaturen in Kalifornien treibenden Faktoren sind Wetterereignisse … beständige zwar, aber nichtsdestotrotz Wetterereignisse. Andererseits haben Wettermodelle nur begrenzten Wert für ein paar Tage im Voraus…im besten Falle eine Woche im Voraus.

Gibt es regionale Klimamodelle, die zuverlässig vorhersagen können:

●Wie lange die Dürre in Kalifornien noch andauert?

●Wann es erneut zu einer Dürre kommen könnte?

●welche Gebiete des Landes als Nächstens von einer Dürren heimgesucht werden?

Nein!

Werden es kurzfristige regionale Klimamodelle in Zukunft irgendwann etwas bringen?

Nicht, solange sie nicht gekoppelte Ozean-Atmosphäre-Prozesse im Pazifik und dem Nordatlantik vorhersagen können nebst den damit verbundenen und sogar noch chaotischeren Luftdruck-Phänomenen wie dem Nordpazifik-Index, der Nordatlantischen Oszillation und der Arktischen Oszillation usw.

Nehmen wir weiter Kalifornien als Beispiel. Bis die regionalen Klimamodelle chaotische Ozean-Atmosphäre-Prozesse auf Jahre im Voraus vorhersagen können in Gebieten, die von Kalifornien weit entfernt sind, können diese Modelle uns lediglich sagen, was in Kalifornien passieren könnte, falls La Niña-Ereignisse dominieren oder auftreten könnten, falls es eine Verschiebung der damit verbundenen PDO oder des Nordpazifik-Index‘ oder der Arktischen Oszillation gibt. Mit all diesen „es könnte passieren“ sind große Bandbreiten von Unsicherheiten verbunden infolge deren Verstärkungseffekte. Die Unsicherheiten sind so groß, dass sie kaum für die zukünftige Planung verwendet werden können.

Und dann wird es, wie wir jüngst erleben mussten, total unerwartete Ereignisse geben wie die „lächerlich beständige Hochdruckzone“ und „the Blob“, um diese Vorhersagen zunichte zu machen.

Klimamodelle sind nicht einmal nahe daran, die Fragen beantworten zu können, die Antworten brauchen, und es ist unwahrscheinlich, dass sie diese Fähigkeiten aufweisen, bis sie irgendwann Chaos vorhersagen können … Jahre und Jahrzehnte in der Zukunft. Die Wahrscheinlichkeit dafür ist einfach Null.

Zum Schluss

Unter Führung des IPCC und der diesen finanzierenden politischen Institutionen hat sich die Klimawissenschaft allein auf die Stützung internationaler Verträge konzentriert, die Emissionen anthropogener Treibhausgase zu begrenzen. Die Klimamodellierung ist durch diesen Brennpunkt behindert worden, was uns Modelle hinterlassen hat, die keine Beziehung haben zu der Welt, in der wir leben. Es ist an der Zeit, diesen Brennpunkt zu verlagern, um es den Klimamodellierern zu ermöglichen, den wirklichen Beitrag der natürlichen Variabilität zu globaler Erwärmung und Klimawandel zu untersuchen, ohne befürchten zu müssen, dass die Finanzquellen dafür versiegen. Falls wir in der Lage sein wollen, uns an den Klimawandel anzupassen, egal ob vom Menschen verursacht oder natürlichen Ursprungs, braucht die Klimawissenschaft einen viel besserten Zugriff darauf, wie das Klima der Erde tatsächlich funktioniert und nicht, wie es in den Modellen funktioniert.

Ich hoffe, dass Sie und Ihre Büros in der Lage sein werden, sich dieser und anderer Fragen anzunehmen während Ihrer Zeit als Vorsitzende der Komitees und Subkomitees mit Bezug zur Klimawissenschaft.

Falls Sie irgendwelche Fragen haben oder irgendwelche weiteren Informationen brauchen, dann schreiben Sie oder Ihre Mitarbeiter bitte einen Kommentar zu irgendeinem Beitrag auf meinem Blog ClimateObservations.

Sincerely,

Bob Tisdale

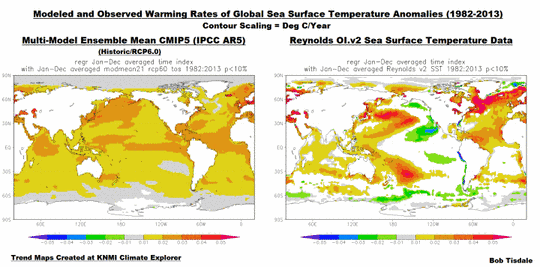

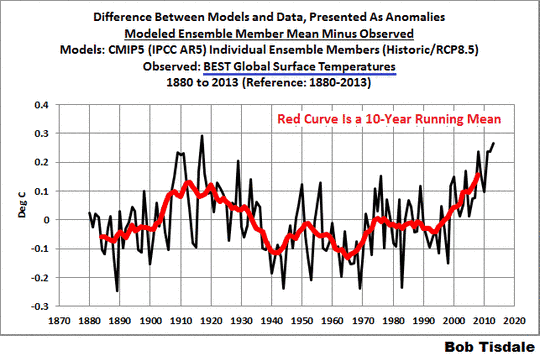

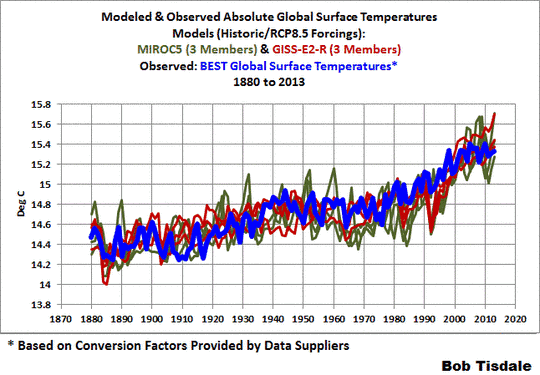

P. S. Folgende Beiträge sind eine Sammlung, die illustriert, wie schlecht Klimamodelle Temperatur Niederschlag und Meereis simulieren:

Satellite-Era Sea Surface Temperatures as anomalies

Satellite-Era Sea Surface Temperatures in absolute form

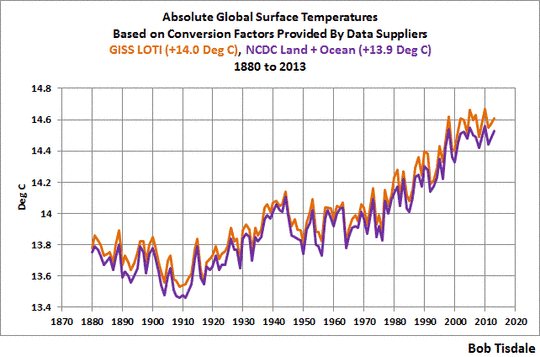

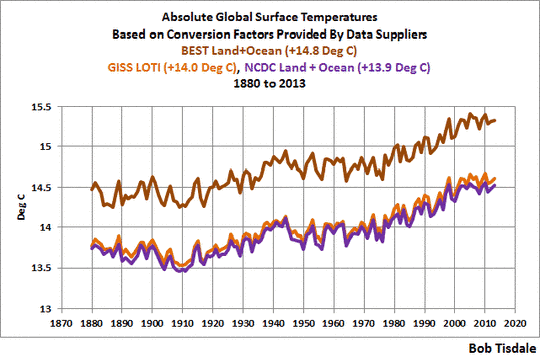

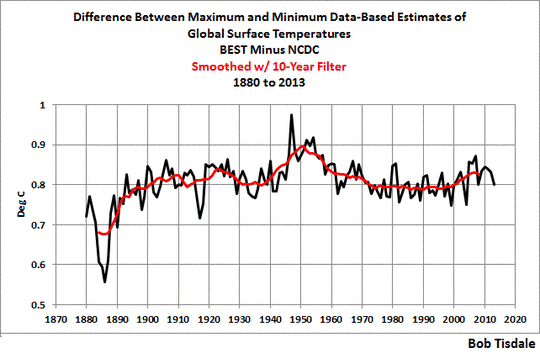

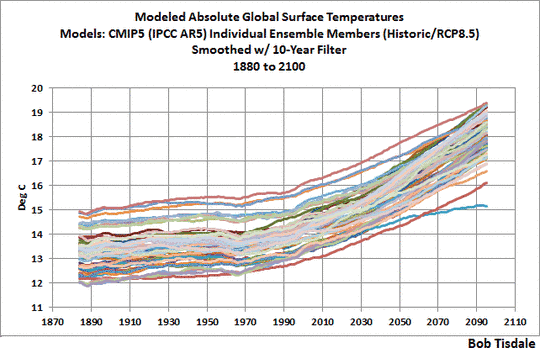

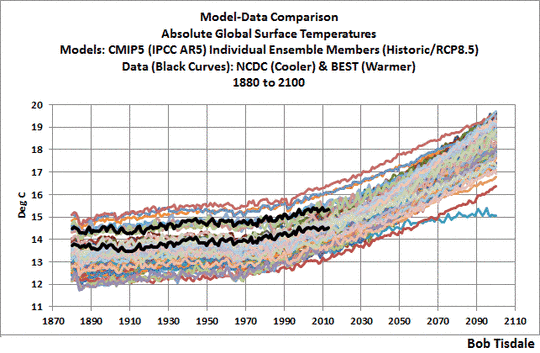

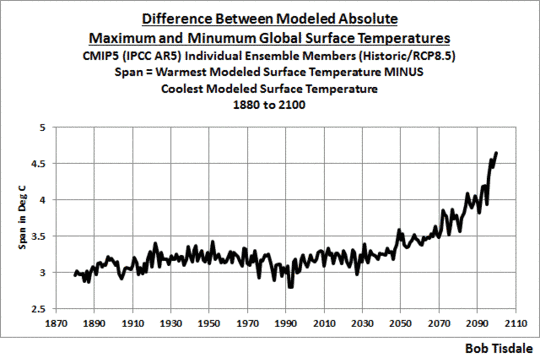

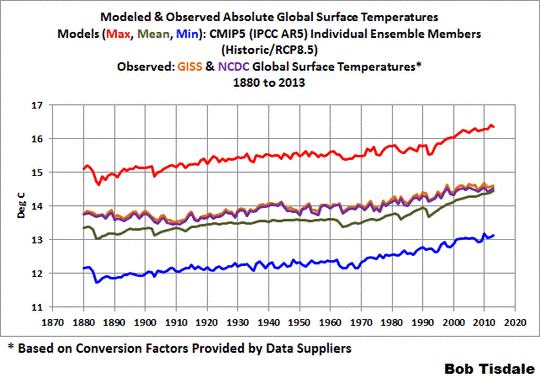

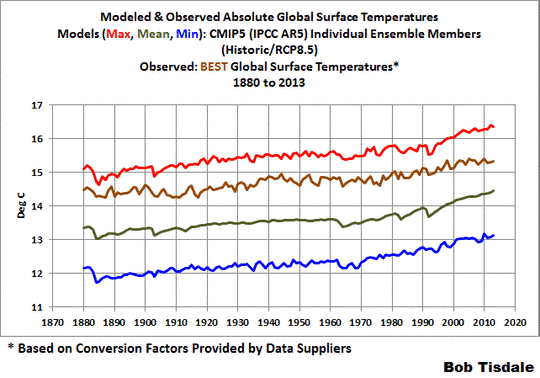

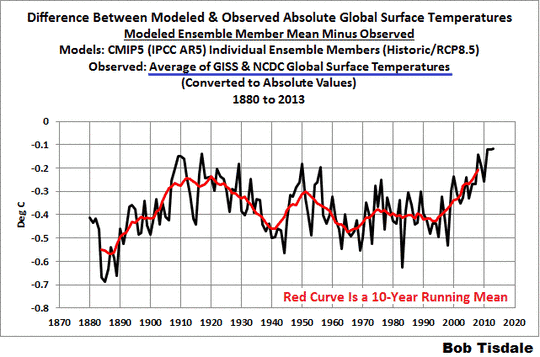

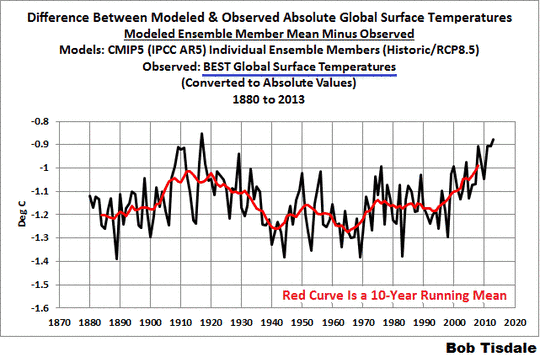

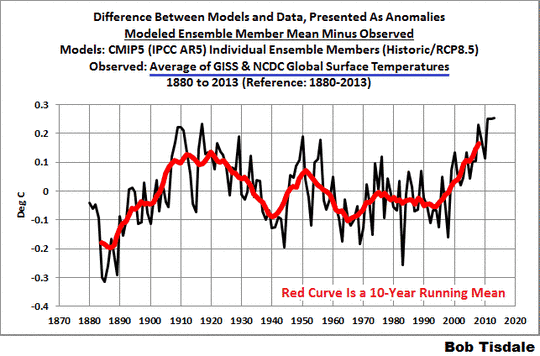

Global Surface Temperatures (Land+Ocean) Since 1880 as anomalies

Global Surface Temperatures (Land+Ocean) Since 1880 in absolute form

Global Precipitation

Global Land Precipitation & Global Ocean Precipitation

Sea Ice

Wie ich schon früher wiederholt gesagt habe, Klimamodelle lassen gegenwärtig keine andere Aussage zu als zu illustrieren, wie schlecht sie sind.

Link: http://wattsupwiththat.com/2015/04/14/open-letter-to-u-s-senators-ted-cruz-james-inhofe-and-marco-rubio/

Übersetzt von Chris Frey EIKE