Über die schwer fassbare globale mittlere Temperatur – ein Vergleich Modell ? Daten

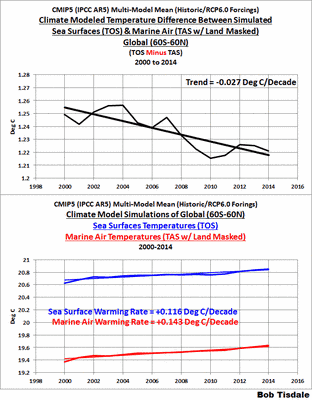

Abbildung 1

Selten werden Modellergebnisse bzw. Vergleiche zwischen Modellen und Messungen in absoluten Zahlen angegeben. Diese werden in diesem Beitrag präsentiert nach einer Diskussion der Schätzungen der absoluten mittleren Temperatur der Erde von Daten-Lieferanten: GISS, NCDC und BEST. Danach wenden wir uns den Anomalien zu.

Die folgenden Illustrationen und der größte Teil des Textes wurden für mein demnächst erscheinendes Buch aufbereitet. Ich habe die Nummerierung der Abbildungen für diesen Beitrag geändert und die Einführung neu geschrieben. Diese Präsentation offeriert eine gänzlich unterschiedliche Perspektive bzgl. der Differenzen zwischen modellierten und gemessenen globalen Temperaturen. Man wird es begrüßen … aber Einige werden es absolut nicht begrüßen.

Dieses Kapitel erscheint weiter unten in dem Buch, nach den einleitenden Abschnitten über 1) die Grundlagen von globaler Erwärmung und Klimawandel, 2)der Übersicht über Klimamodelle, 3)den einführenden Diskussionen über die atmosphärische und ozeanische Zirkulation und natürlichen Zustände der Variabilität und 4) den detaillierten Beschreibungen der Datensätze. Es wird eines von vielen Kapiteln sein, in denen es um den Vergleich Modelle ↔ Daten geht.

Die Diskussion über die schwer fassbare globale mittlere Temperatur beim GISS

Einige werden den Ursprung der Überschrift dieses Kapitels bereits kennen. Sie stammt von der GISS Surface Temperature Analysis Q&A webpage The Elusive Absolute Surface Air Temperature (SAT). Im Einleitungstext zu der Website heißt es:

Bei der GISTEMP-Analyse geht es nur um Temperaturanomalien, nicht um die absolute Temperatur. Temperaturanomalien werden berechnet relativ zum Referenzzeitraum 1951 bis 1980. Der Grund, Anomalien anstatt absoluter Temperaturen zu betrachten ist, dass die absolute Temperatur schon auf kurze Distanzen markant variiert, während monatliche oder jährliche Temperaturanomalien repräsentativ für ein viel größeres Gebiet sind. Tatsächlich haben wir gezeigt (Hansen und Lebedeff 1987), dass Temperaturanomalien stark korreliert sind mit Distanzen bis zu 1000 km.

Auf der Grundlage der Ergebnisse von Hansen und Lebedeff (1987) in ihrer Studie Global trends of measured surface air temperature erzeugte GISS einen Datensatz mit Temperaturanomalien auf dem Festland anstelle von Daten der Wassertemperatur. Das heißt, GISS hat die Festlandstemperaturen einfach auf die Ozeane hinaus ausgedehnt. GISS hat diesen älteren Datensatz ersetzt durch den GISS Land-Ocean Temperature Index, welcher Wassertemperaturdaten für die meisten Gebiete der Ozeane heranzieht. Dieser Index ist ihr primäres Produkt. Sie extrapolieren immer noch mit 1200 km, um Festlands- und Ozeangebiete ohne gemessene Daten zu füllen.

Aber zurück zur GISS Q&A-Website: Nach Beantwortung einiger Zwischenfragen schließt GISS mit (Fettdruck von mir):

Frage: Was mache ich, wenn ich Absolut-Temperaturen anstatt Anomalien brauche?

Antwort: In 99,9% aller Fälle wird man feststellen, dass Anomalien genau das sind, was man braucht, nicht absolute Temperaturen. In den restlichen Fällen muss man sich eine der verfügbaren Klimatologien heraussuchen und die Anomalien dazu addieren (unter Berücksichtigung einer geeigneten Basisperiode). Für das globale Mittel erzeugen die Modelle, denen man am meisten vertraut, einen Wert von ungefähr 14°C, aber genauso kann der Wert zwischen 13°C und 15°C liegen. Regional und vor allem lokal ist die Lage sogar noch schlimmer.

Mit anderen Worten, GISS stellt sein Verständnis der globalen Temperaturen auf die Grundlage von Klimamodellen, besonders von denen, denen „man am meisten vertraut“. Und sie sagen, dass die mittlere globale Temperatur auf der Grundlage dieser Klimamodelle während des Referenzzeitraumes von 1951 bis 1980 (ihre Klimatologie) grob etwa 14°C ±0,6°C beträgt.

Der Wert von 14°C auf jener GISS-Website deckt sich mit dem Wert, der unten auf der GISS-Website Land-Surface Air Temperature Anomalies Only (Meteorological Station Data, dTs) genannt wird. Dieser geht auf Hansen und Lebedeff (1987) zurück. Ganz unten auf der Website schreibt GISS:

Die Best Estimate des absoluten globalen Mittels von 1951 bis 1980 beträgt 14,0°C. Man addiere dies also zu der Temperaturänderung, falls man eine Absolut-Skala benutzen möchte (diese Anmerkung gilt nur für globale Jahresmittel, Januar bis Dezember und Dezember bis November).

Das ist die gleiche Adjustierung der absoluten Temperaturen, wie sie GISS für ihren Land-Ocean-Temperature-Index verlangt. Siehe am Ende der Daten-Website hier.

ANMERKUNG: Einige Leute könnten denken, dass es seltsam ist, dass man beim GISS für beide Datensätze den gleichen Adjustierungs-Faktor verwendet. Einer der GISS-Datensätze (GISS dTs) weitet Lufttemperaturen von küstennahen Gebieten und Inseln auf die Ozeane bis zu einer Entfernung von 1200 km aus, während der andere GISS-Datensatz (GISS LOTI) Wassertemperaturdaten für die meisten der globalen Ozeane enthält. Mit den LOTI-Daten ersetzt GISS Daten der Wassertemperatur mit Daten der Festlandstemperatur nur in den polaren Ozeanen, wo immer Meereis lag. Falls wir annehmen, dass die küstennahen und von Inseln stammenden Landtemperaturen ähnlich sind den Lufttemperaturen über dem Meer, dann beträgt der Bias lediglich 0,2°C, vielleicht etwas mehr. Die mittlere absolute globale Wassertemperatur ICOADS beträgt während der letzten 30 Jahre (1984 bis 2013) 19,5°C, während deren absolute globale Wassertemperatur 19,3°C beträgt. Der Grund für „vielleicht etwas mehr“ ist, dass Lufttemperaturmessungen auf Schiffen auch durch den „Wärmeinseleffekt“ beeinflusst werden können, und die ICOADS-Daten sind in dieser Hinsicht nicht korrigiert worden. (Ende der Anmerkung).

Die NCDC-Schätzung ist ähnlich, obwohl anders abgeleitet

NCDC gibt ebenfalls eine Schätzung der absoluten globalen Mitteltemperatur an; siehe hier. Unter der Überschrift ,Globale Höhepunkte‘ schreiben sie (Fettdruck von mir)

Das Jahr 2013 zieht mit dem Jahr 2003 gleich als das viertwärmste Jahr global seit Beginn von Aufzeichnungen im Jahre 1880. Die kombinierte jährliche globale Festlands- und Ozean-Temperatur lag um 0,62°C über dem Mittel des 20. Jahrhunderts von etwa 13,9°C.

Und nicht rein zufällig stimmen jene 13,9°C vom NCDC (gewonnen aus Daten von … werden wir gleich sehen), mit dem GISS-Wert von 14,0°C weitgehend überein. Dies könnte zeigen, dass die GISS-Modelle, denen man „am meisten vertraut“, an den datenbasierten Wert angepasst wurden.

Die Quelle jener 13,9°C-Schätzung der globalen Temperatur wird auf der NOAA Global Surface Temperature Anomalies-Website genannt, speziell unter der Überschrift Global Longterm Mean Land and Sea Surface Temperatures, welche im Jahre 2000 erstellt wurde, so dass sie jetzt 14 Jahre alt ist [der Beitrag datiert bereits aus dem Jahr 2014; Anm. d. Übers.]. Während dieser 14 Jahre haben sich Daten drastisch verändert. Man wird auf jener Website auch bemerkt haben, dass die Mittelwerte der absoluten Temperatur für den Zeitraum 1880 bis 2000 gelten und dass NCDC die gleichen 13,9°C als Absolutwert für das 20. Jahrhundert verwenden. Das ist kein Thema, sondern Haarspalterei. Es gibt nur eine Differenz von 0,03°C zwischen den mittleren Anomalien jener beiden Zeiträume.

Genau wie GISS beschreibt NOAA das Problem bei der Abschätzung einer absoluten globalen Mitteltemperatur:

Absolute Schätzungen der globalen Mitteltemperatur sind aus einer ganzen Reihe von Gründen schwierig anzustellen. Da einige Regionen der Welt kaum Temperatur-Messstationen aufweisen (z. B. die Sahara), muss über große datenarme Gebiete interpoliert werden. In Bergregionen stammen die meisten Messungen aus Tälern, wo die Menschen wohnen, so dass man die Auswirkungen der Seehöhe eines Gebietes beim Mittel dieser Region berücksichtigen muss, ebenso wie andere Faktoren, die die Temperatur beeinflussen. Als Konsequenz sind die Schätzungen unten – wenngleich auch als die besten betrachtet, die derzeit zur Verfügung stehen – immer noch Approximationen, die Hypothesen reflektieren, die inhärent bei der Interpolation und der Datenaufbereitung vorhanden sind. Zeitreihen monatlicher Temperaturaufzeichnungen sind öfter als Abweichungen von einer Referenzperiode angegeben (z. B. 1961 bis 1990 oder 1880 bis 2000), weil diese Aufzeichnungen leichter interpretiert werden können und einige Probleme umgangen werden, die mit der Schätzung absoluter Temperaturen in großen Gebieten auftreten.

Es scheint, dass der NCDC-Wert auf beobachtungsgestützten Daten beruht, obschon auf älteren Daten, während der GISS-Wert eines anderen Zeitraumes auf der Grundlage von Klimamodellen sehr ähnlich ist.

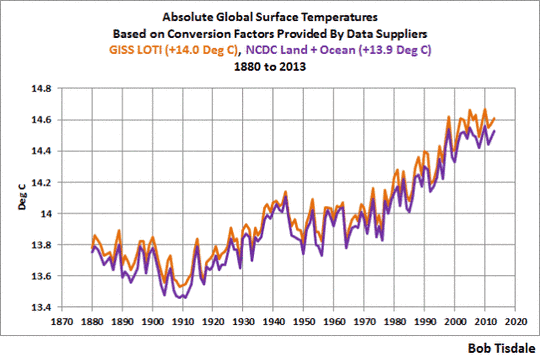

Vergleiche zwischen GISS- und NCDC-Daten in absoluter Form

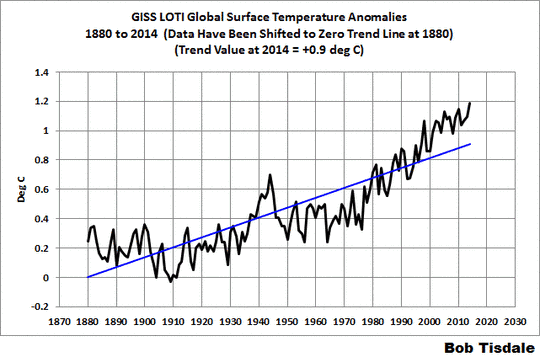

NCDC Global Land + Ocean Surface Temperature-Daten sind verfügbar mittels eines Klicks auf den Link oben auf der NCDC-Website Global Surface Temperature Anomalies. Und die GISS LOTI-Daten stehen hier.

Unter Verwendung der oben beschriebenen Faktoren zeigt Abbildung 2 die jährlichen globalen Mitteltemperaturen von GISS und NCDC in absoluter Form, und zwar vom Beginn im Jahre 1880 bis zum letzten vollen Jahr vor diesem Beitrag 2013. Die GISS-Daten sind ein bisschen wärmer als die NCDC-Daten, im Mittel um etwa 0,065°C. Aber alles in allem folgen sie einander. Und das sollten sie auch. Sie verwenden den gleichen Wassertemperatur-Datensatz (ERSST.v.3b von NOAA), und die meisten Lufttemperaturen auf dem Festland sind die gleichen (aus der GHCN-Datenbasis der NOAA). GISS und NCDC füllen lediglich die Datenlücken unterschiedlich aus (vor allem im arktischen und dem subantarktischen Ozean), und GISS verwendet ein paar Datensätze mehr, um Regionen abzudecken, aus denen kaum GHCN-Daten vorliegen.

Abbildung 2

Es ergibt sich der beste globale Festlands-+Wassertemperatur-Datensatz mit einem unterschiedlichen Faktor.

Das sind die BEST-Daten (Berkeley Earth Surface Temperature), welche ein Erzeugnis von Berkeley Earth sind. Die ihre Temperaturdaten stützende Studie stammt von Rohde et al. 2013 mit dem Titel A New Estimate of the Average Earth Surface Land Temperature Spanning 1753 to 2011. Darin wird man erkennen, dass man die BEST-Lufttemperaturen auf dem Festland in absoluter Form dargestellt hat. Siehe Abbildung 1 in jener Studie (hier nicht gezeigt).

Deren Klimatologie (Referenz-Temperaturen zur Bildung von Anomalien) wurde in der Verfahrens-Studie von Rhode et al. (2013) Berkeley Earth Temperature Process präsentiert mit dem Anhang hier. Unter der Überschrift Climatology schreiben Rhode et al. in ihrer „Verfahrens“-Studie:

Die globale Festlands-Mitteltemperatur von 1900 bis 2000 beträgt 9,35°C ±1,45°C, was grob übereinstimmend ist mit der Schätzung von 8,5°C durch Peterson (29). Diese große Unsicherheit in der Normalisierung ist nicht in den schattierten Bändern enthalten, die wir über unsere Tavg-Plots gelegt haben, weil sie nur die absolute Skala beeinflusst und für Relativ-Vergleiche keine Bedeutung hat. Außerdem ist der größte Teil dieser Unsicherheit der Präsenz von nur drei GHCN-Sites im Inneren der Antarktis geschuldet, was den Algorithmus dazu bringt, die Absolut-Normalisierung für den größten Teil der Antarktis als poorly constrained anzusehen. Vorangegangene Arbeiten mit vollständigeren Daten aus der Antarktis und anderswo zeigen, dass zusätzliche Daten diese Normalisierungs-Unsicherheit um eine Größenordnung reduzieren können, ohne den zugrunde liegenden Algorithmus zu ändern. Der Berkeley Average-Analyse-Prozess ist in gewisser Weise eindeutig, erzeugt er doch eine globale Klimatologie und eine Schätzung der globalen mittleren Temperatur als Teil seiner natürlichen Operationen.

Es ist interessant, dass der Mittelungsprozess der Temperatur bei Berkeley sie mit einer Schätzung der globalen mittleren Festlands-Temperaturen in absoluter Form ausstattet, während man bei GISS und NCDC geschrieben hat, dass eben diese Schätzung sehr schwierig ist.

Der Bezug auf Peterson in der Studie von Rhode et al. stammt von Peterson et al. 2011 mit dem Titel Observed Changes in Surface Atmospheric Energy over Land. Die 8,5°C von Peterson et al. als absolute Festlands-Lufttemperaturen ist der gleiche Wert, der gelistet ist in der Tabelle unter der Überschrift Global Long-term Mean Land and Sea Surface Temperatures auf den NOAA Global Surface Temperature Anomalies-Websites.

Berkeley Earth hat auch Daten veröffentlicht für zwei globale Land-+Ozean-Temperaturprodukte. Die Existenz von Meereis ist der Grund, dass es zwei sind. Festlands-Temperaturdaten enthalten offensichtlich keine Ozeanoberflächen-Temperaturdaten, wo sich Meereis befindet, und Wassertemperaturdaten enthalten nicht die Lufttemperaturen über polarem Meereis, wo und wann sich dieses befindet. Von den 361,9 Millionen km² der Gesamtfläche der globalen Ozeane bedeckt polares Meereis nur im Mittel etwa 18,1 Millionen km² jährlich im Zeitraum 2000 bis 2013. Während polares Meereis nur etwa 5% der globalen Ozeane und nur etwa 3,5% der Oberfläche des Globus‘ überdeckt, ist die klimawissenschaftliche Gemeinde bestrebt, dort die Lufttemperatur zu berechnen. Dies gilt besonders für die Arktis, wo der natürlich auftretende Prozess der polaren Verstärkung zu übertriebenen Erwärmungsraten führt in Zeiten, in denen sich die Nordhemisphäre erwärmt (und sich auch mit verstärkten Raten abkühlt, wenn sich die Nordhemisphäre abkühlt).

Während dies geschrieben wird, gibt es keine stützende Studie für die Land- und Wassertemperaturdaten von BEST, die verfügbar sind auf der Berkeley Earth Papers-Website, und es wird nichts dazu gezeigt auf ihrer Posters-Website. Es gibt jedoch eine einführende Diskussion auf der BEST-Datenseite über ihr Kombinations-Produkt. Die BEST-Land- und Wassertemperaturdaten sind zusammengeführt mit einer modifizierten Version von HadSST3-Wassertemperaturdaten, welche man mittels eines statistischen Verfahrens namens Kriging aufgefüllt hatte.

Die jährlichen Berkeley-Anomalien der Land-+Wassertemperaturen sind hier und die monatlichen Daten hier. Ihre Begründung der Präsentation der beiden Land-+Wassertemperatur-Produkte stützt meine Ausführungen oben. Berkeley Earth schreibt:

Zwei Versionen dieses Mittels werden gezeigt. Diese unterscheiden sich dahingehend, wie sie mit von Meereis bedeckten Gebieten umgehen. In der ersten Version werden Temperaturanomalien bei der Gegenwart von Meereis extrapoliert von Anomalien der Festlandstemperatur. In der zweiten Version werden Temperaturanomalien bei der Gegenwart von Meereis extrapoliert aus Anomalien der Wassertemperatur (normalerweise gemessen im offenen Wasser an der Peripherie des Meereises). Für die meisten Ozeangebiete gilt, dass die Wassertemperaturen ähnlich der Lufttemperaturen darüber sind; allerdings können Lufttemperaturen über Meereis substantiell von der Wassertemperatur unter dem Eis abweichen. Die Lufttemperatur-Version dieses Mittels zeigt größere Änderungen in jüngster Zeit, teilweise weil Änderungen der Wassertemperatur durch den Gefrierpunkt von Meerwasser beeinflusst werden. Wir glauben, dass die Verwendung von Lufttemperaturen über Meereis ein natürlicheres Mittel darstellt zur Beschreibung von Änderungen der Temperaturen auf der Erde.

Der Gebrauch von Lufttemperaturen über Meereis kann eine realistischere Repräsentation arktischer Temperaturen während der Wintermonate anbieten, wenn das Meereis sich an den Landmassen auftürmt und wenn jene Landmassen mit Schnee bedeckt sind und Eis und Festland ähnliche Albedos aufweisen. Allerdings kann die Albedo von Meereis während der Sommermonate anders sein als die Albedo von Landmassen (Schnee schmilzt und legt die Landoberfläche um die Temperatur-Sensoren frei, und die Albedo von Landoberflächen ist eine ganz andere als die von Meereis). Der offene Ozean trennt außerdem Festland und Meereis an vielen Stellen, was das Problem weiter kompliziert. Dem ist nicht so einfach abzuhelfen.

Berkeley Earth listet auch die geschätzten absoluten Oberflächen-Temperaturen während ihres Referenzzeitraumes für beide Produkte:

Geschätzte globale Mitteltemperatur I von Januar 1951 bis Dezember 1980

● mittels Lufttemperatur über Meereis: 14.774 ±0.046

● mittels Wassertemperatur unter Meereis: 15.313 ±0.046

Die geschätzte absolute globale Mitteltemperatur unter Verwendung der Lufttemperatur über Meereis ist um 0,5°C kälter als die Daten unter Verwendung der Wassertemperaturdaten unter dem Meereis. Die später in diesem Beitrag präsentierten Modelle zeigen Lufttemperaturen, darum werden wir die Berkeley-Daten verwenden, die die Lufttemperatur über Meereis zeigen. Dies stimmt auch mit den Verfahren bzgl. der GISS LOTI-Daten überein.

Der von Berkeley Earth verwendete Wassertemperatur-Datensatz (HadSST3) existiert nur in Anomalie-Form. Und ohne stützende Studie gibt es keine Dokumentation darüber, wie Berkeley Earths diese Anomalien in absolute Werte konvertiert hat. Die Quelle ICOADS-Daten sowie die HadISST und ERSST.v3b-Endprodukte werden in absoluter Form gezeigt, so dass vermutlich eine davon als Referenz herangezogen worden war.

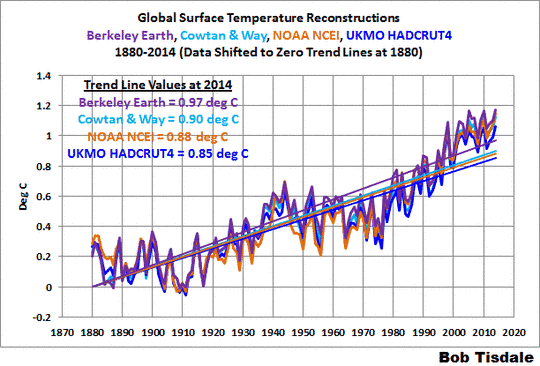

Vergleich der Daten von BEST, GISS und NCDC in absoluter Form

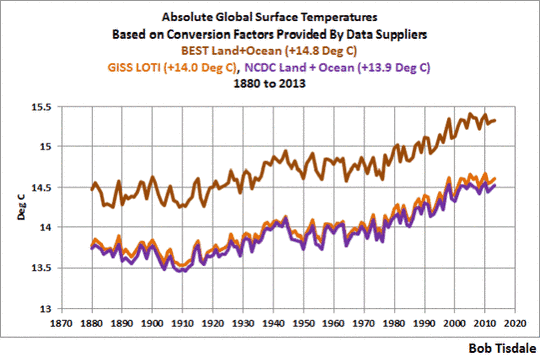

Die jährlichen globalen Mitteltemperaturen der drei Institutionen in absoluter Form vom Anfangsjahr 1880 bis zum letzten vollständigen Jahr 2013 zeigt Abbildung 3. Die BEST-Daten sind wärmer als die anderen beiden, aber der Kurvenverlauf ist ähnlich, wie man es auch erwarten würde.

Abbildung 3

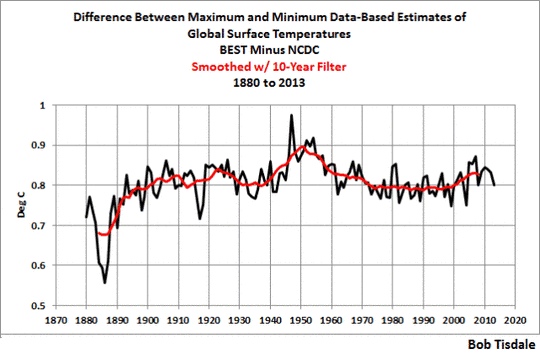

In Abbildung 4 habe ich den kältesten Datensatz (NCDC) vom wärmsten Datensatz (BEST) subtrahiert. Die Differenz wurde außerdem mit einem zehnjährigen gleitenden Mittel geglättet (rote Kurve). Zumeist sind die BEST-Daten in absoluten Werten um etwa 0,8°C wärmer als die NCDC-Schätzung. Der 1940 beginnende Buckel, der um 1950 seinen Spitzenwert erreicht, sollte den Adjustierungen geschuldet sein, die UKMO an den HadSST3-Daten vorgenommen hatte, nicht aber an die Daten von NOAA ERSST.v3b, die sowohl von GISS als auch von NCDC herangezogen worden waren. Diese Diskussionen werden in einem anderen Kapitel geführt. Ich habe den Verdacht, dass die geringere Differenz zu Beginn der Datenreihe auch mit der Handhabung der Wassertemperaturdaten zusammenhängt, aber es gibt keine Möglichkeit, dies ohne Zugang zu den von BEST modifizierten HadSST3-Daten sicher zu sagen. Der jüngste Aufwärts-Tick sollte dem Unterschied geschuldet sein, wie BEST und NCDC mit den Daten aus dem Arktischen Ozean umgehen. Berkeley Earth extrapoliert Festlands-Temperaturdaten einfach hinaus auf die Ozeane, während NCDC Wassertemperaturdaten im Arktischen Ozean außen vor lassen, sofern dort Meereis liegt, und man extrapoliert landbasierte Daten nicht auf Flächen über Eis zu jenen Zeiten.

Abbildung 4

Und jetzt zu den Modellen:

Simulationen der absoluten Lufttemperatur seit 1880 seitens des Klimamodells CMIP5

Wie in diesem Buch schon an verschiedenen Stellen erwähnt, werden die Ergebnisse der Klimamodelle, die vom IPCC für ihren 5. Zustandsbericht herangezogen worden waren, im Climate Model Intercomparison Project Phase 5 archive gespeichert, und diese Ergebnisse sind öffentlich verfügbar und aufbereitet zum Download in leicht nutzbaren Formaten via KNMI Climate Explorer. Die Ergebnisse von CMIP5 der Lufttemperatur auf dem KNMI Climate Explorer stehen auf der Monthly CMIP5 scenario runs-Website und werden als „TAS“ bezeichnet.

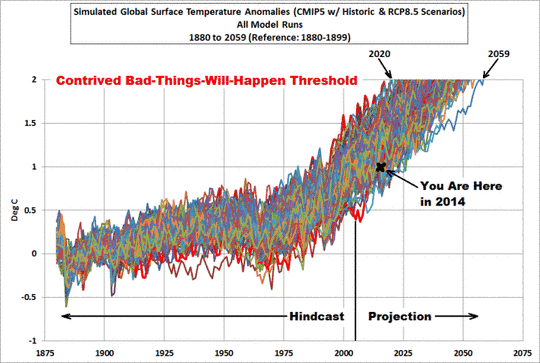

Die Modellergebnisse auf dem KNMI Climate Explorer sind für die historischen Antriebe verfügbar mit Übergängen zu den unterschiedlichen RCP-Zukunfts-Szenarien. Hier zeigen wir das historische und das Worst-Case-Zukunfts-Szenario RCP8.5. Wir verwenden das Worst-Case-Szenario allein als Referenz, wie hoch die Temperaturen den Modellen zufolge steigen könnten, falls die Emissionen von Treibhausgasen wie projiziert unter diesem Szenario erfolgen. Die Verwendung des Worst-Case-Szenarios wird kaum Auswirkungen auf den Vergleich zwischen Modell und Daten von 1880 bis 2013 haben. Wie man sich erinnert, beginnen die Zukunftsszenarien in den meisten Modellen nach 2005, bei anderen später, und deswegen gibt es nur sehr geringe Unterschiede zwischen den Modellergebnisse für die unterschiedlichen Modell-Szenarien während der ersten paar Jahre. Außerdem habe ich die Outputs separat heruntergeladen für alle Modelle individuell sowie deren Ensemble-Mitgliedern. Es gibt insgesamt 81 Ensemble-Mitglieder von 39 Klimamodellen.

Anmerkung: Die Modellergebnisse sind verfügbar in absoluter Form in Grad Celsius, darum habe ich sie nicht auf irgendeine Weise adjustiert.

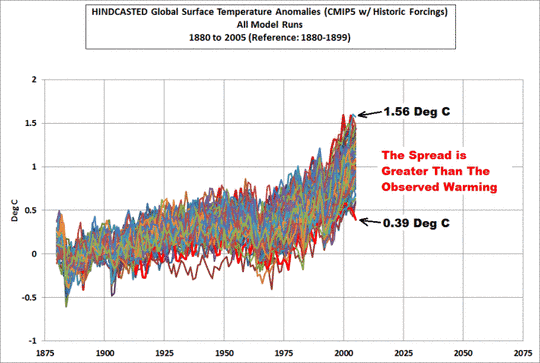

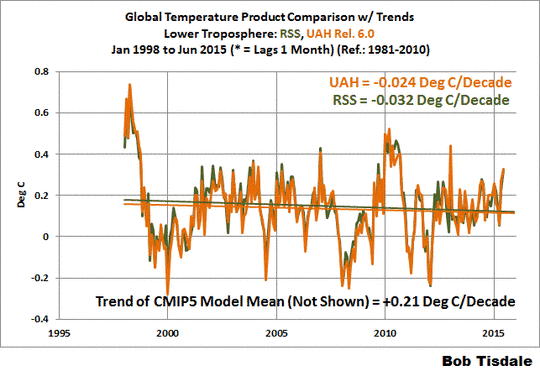

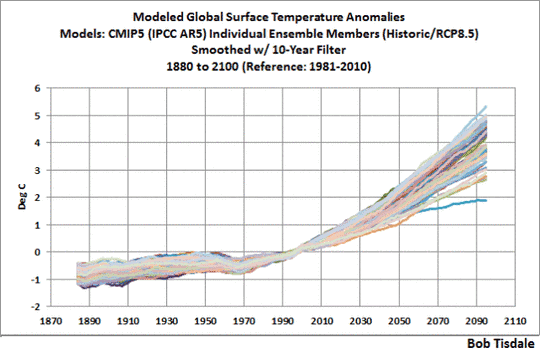

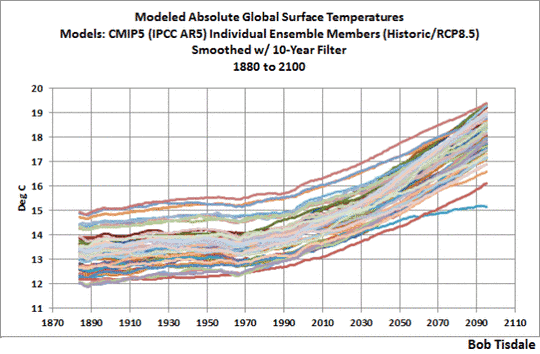

Hiermit als Hintergrund ist Abbildung 5 eine Spaghetti-Graphik, die die archivierten Ergebnisse der CMIP5-Klimamodell-Simulationen zeigt der globalen Lufttemperatur von 1880 bis 2100 mit historischen und RCP8.5-Antrieben. Eine größere Version dieser Graphik mit einer Auflistung aller Ensemble-Mitglieder steht hier.

Abbildung 5

Welchen Wert die globale mittlere Temperatur derzeit auch immer haben mag oder in der Vergangenheit hatte oder in Zukunft haben wird – die im 5. IPCC-Zustandsbericht verwendeten Modelle haben ihn mit Sicherheit umgeben [surrounded].

Einige könnten nun argumentieren, dass absolute Temperaturwerte unwichtig sind – dass wir uns viel eher mit Vergangenheit und Zukunft der Erwärmungsraten befassen sollten. Wir können dieses Argument auf zwei Wegen widerlegen: Erstens haben wir bereits in den Kapiteln CMC-1 und -2 gesehen, dass Klimamodelle bei der Simulation der Temperaturen von 1880 bis in die achtziger Jahre und dann wieder von den achtziger Jahren bis heute sehr schlecht abgeschnitten haben. Außerdem werden wir später das Scheitern der Modelle noch sehr viel detaillierter ausführen. Zweitens, absolute Temperaturwerte sind aus einem anderen Grund wichtig. Natürliche und verstärkte Treibhauseffekte hängen ab von der Infrarotstrahlung, die von der Erdoberfläche emittiert wird, und die Menge der von unserem Planeten in den Weltraum emittierten Infrarotstrahlung ist eine Funktion der absoluten Temperatur und nicht von Anomalien.

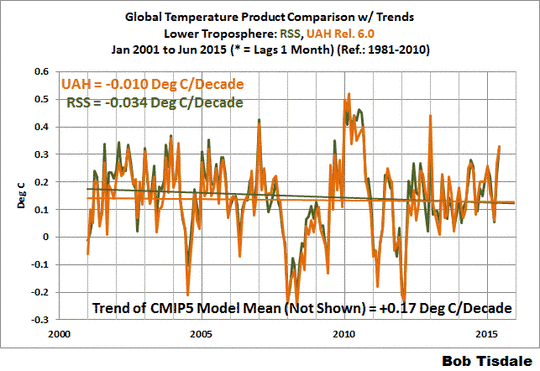

Wie in Abbildung 5 oben gezeigt beginnt die Mehrheit der Modelle mit Absolutwerten der globalen mittleren Temperatur, die eine Bandbreite von 12,2°C bis etwa 14,0°C aufweisen. Aber unter Einschluss der Ausreißer reicht die Bandbreite von 12,0°C bis 15,0°C. Die Bandbreite der modellierten globalen Mitteltemperatur ist einfacher erkennbar, falls wir die Modellergebnisse mit 10-Jahre-Filtern glätten. Siehe Abbildung 6.

Abbildung 6

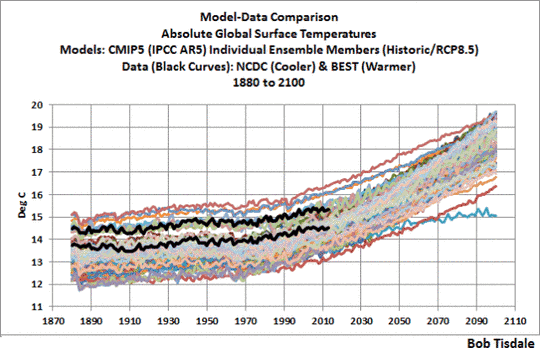

Wir könnten diese Bandbreite enger machen mittels Entfernen der Ausreißer, aber ein Problem hiervon ist, dass die Warm-Ausreißer relativ nahe der jüngeren (besseren?) Schätzung der absoluten Temperatur der Erde von Berkeley Earth liegen. Siehe Abbildung 7, in der wir zu den jährlichen, nicht geglätteten Ergebnissen zurückkehren.

Abbildung 7

Das andere Problem bei der Entfernung der Ausreißer ist, dass das IPCC eine politische und keine wissenschaftliche Institution ist. Als Folge hiervon werden in dieser politischen Institution Modelle anderer Agenturen aus der ganzen Welt verwendet, selbst solche, die noch schlechtere Ergebnisse liefern als die auch schon schlechten Ergebnisse der anderen Modelle, was die gesamte Gruppe hinabzieht.

Mit diesen beiden Dingen im Hinterkopf werden wir alle Modelle in dieser Präsentation beibehalten, selbst die offensichtlichen Ausreißer.

Betrachtet man noch einmal die große Bandbreite der Modellsimulationen der globalen mittleren Temperatur in Abbildung 5 oben, scheint es eine Spannweite von mindestens 3°C zwischen dem kältesten und dem wärmsten zu geben. Schauen wir mal, ob sich das bestätigt.

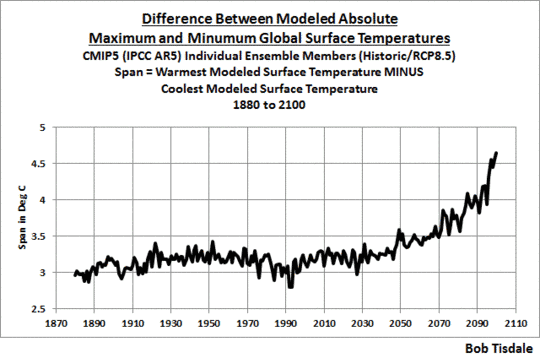

In Abbildung 8 habe ich die kälteste modellierte globale mittlere Temperatur von der wärmsten in jedem Jahr subtrahiert, und zwar von 1880 bis 2100. Für den größten Teil des Zeitraumes zwischen 1880 und 2030 ist die Spannweite zwischen dem kältesten und dem wärmsten größer als 3°C.

Abbildung 8

Diese Spannbreite hilft uns, etwas zu beleuchten, was wir schon einige Male angesprochen haben: die Verwendung vom Multi-Modell Ensemble-Member Modellmittel, also das Mittel aller Läufe von allen Klimamodellen. Es gibt nur eine globale mittlere Temperatur, und deren Schätzungen variieren. Es gibt offensichtlich bessere und schlechtere Simulationen davon, wie immer er beschaffen ist. Liefert uns die Mittelung der Modellsimulationen eine gute Antwort? Nein!

Aber das Mittel, das Multi-Modell-Mittel, liefert uns doch etwas von Wert. Es zeigt uns den Konsens, das Gruppendenken, hinter den modellierten globalen mittleren Temperaturwerten und wie diese Werte variieren, falls (großes falls) sie auf die Antriebe reagieren, die auch in den Klimamodellen stecken. Und wie wir sehen werden, reagieren die gemessenen Temperaturen nicht auf jene Antriebe, wie sie von den Modellen simuliert werden.

Vergleiche Modell ↔ Daten

Wegen der Differenzen zwischen den neuesten (BEST) und den älteren (NCDC und GISS) Schätzungen der absoluten globalen Mitteltemperatur werden sie separat präsentiert. Und weil die GISS- und die NCDC-Daten einander so ähnlich sind, verwenden wir deren Mittelwert. Und schließlich werden wir für die Vergleiche nicht alle Ensemble-Member als Spaghetti-Graphik zeigen. Wir zeigen das Maximum, das Mittel und die Minima.

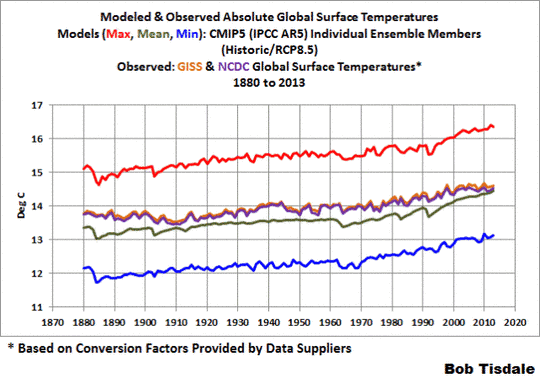

Mit diesen Bedingungen vergleicht Abbildung 9 das Mittel der GISS und NCDC-Schätzungen der absoluten mittleren globalen Temperaturen mit dem Maximum, dem Mittel und dem Minimum der modellierten Temperaturen. Das Modellmittel liegt nahe den GISS- und NCDC-Schätzungen der absoluten globalen Mitteltemperaturen, wobei das Modellmittel etwa 0,37°C kälter ist als die Daten im Zeitraum 1880 bis 2013.

Abbildung 9

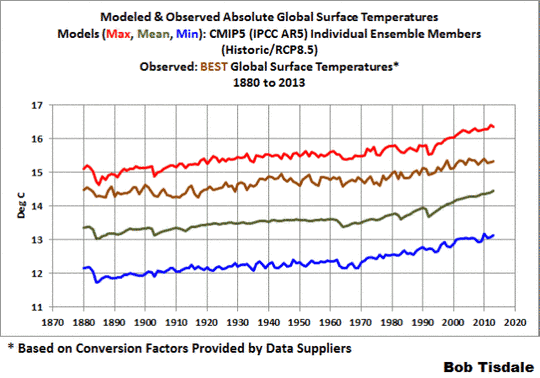

In Abbildung 10 wird die BEST-Schätzung (neuer = besser?) der absoluten mittleren globalen Temperaturen von 1880 bis 2013 verglichen mit Maximum, Mittel und Minimum der modellierten Temperaturen. In diesem Falle liegt die BEST-Schätzung näher dem Maximum und weiter vom Modellmittel entfernt als bei den Schätzungen von GISS und NCDC. Das Modellmittel zeigt sich etwa 1,14°C kälter als die BEST-Schätzung für den Zeitraum 1880 bis 2013.

Abbildung 10

Differenz Modell ↔ Daten

In den nächsten beiden Graphiken subtrahieren wir die datenbasierten Schätzungen der absoluten globalen mittleren Temperatur der Erde vom Modellmittel der CMIP5-Simulationen. Man berücksichtige dies bei der Betrachtung der nächsten beiden Graphiken: Falls das Mittel der Modelle die dekadischen und multidekadischen Schwankungen der Temperatur auf der Erde angemessen simulieren würde und lediglich einfach den absoluten Wert verfehlt haben, wäre die Differenz zwischen Modellen und Daten eine flache horizontale Linie, die sich aus der Differenz ergibt.

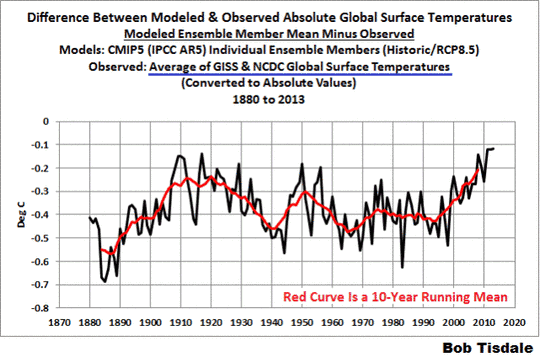

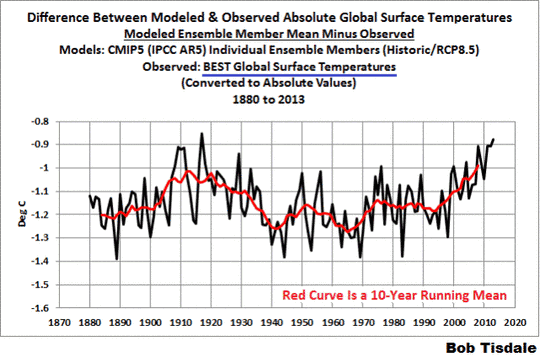

Abbildung 11 zeigt die Differenz zwischen dem Modellmittel der Simulationen der Temperaturen auf der Erde und den GISS- und NCDC-Schätzungen, wobei die Daten von den Modellen subtrahiert werden. In der folgenden Diskussion geht es um das 10-Jahre-Mittel […keys off the 10-year average], welches ebenfalls in rot eingezeichnet ist.

Abbildung 11

Die größte Differenz zwischen Modellen und Daten zeigt sich in den achtziger Jahren des 19. Jahrhunderts. Die Differenz nimmt drastisch ab von den achtziger Jahren bis zu den Zehner-Jahren des 20. Jahrhunderts. Der Grund: Die Modelle simulieren nicht angemessen die beobachtete Abkühlung, zu der es zu jener Zeit gekommen war. Die Differenz Modell ↔ Daten wächst dann wieder von 1910 bis etwa 1940. Dies zeigt, dass sie nicht nur jene Abkühlung, sondern auch die Erwärmung von 1910 bis 1940 nicht angemessen simulieren konnten. Die Differenz verläuft zyklisch bis zu den neunziger Jahren, nach welchem Zeitpunkt die Differenz wieder graduell zunimmt. Und von 1990 bis heute ist die Differenz infolge des Stillstands auf den niedrigsten Wert seit 1880 gesunken.

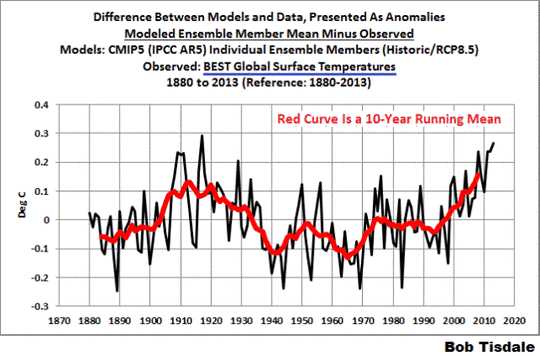

Abbildung 12 zeigt die Differenz zwischen der BEST-Schätzung der Temperatur der Erde und dem Modellmittel der Simulationen. Die Kurve ist ähnlich der oben gezeigten Kurve für die GISS- und NCDC-Daten. Die BEST-Daten zeigen von Ende des 19. Jahrhunderts bis zu den Zehnerjahren des 20. Jahrhunderts geringere Abkühlung, und als Folge davon zeigt sich eine kleinere Abnahme der Temperaturdifferenz zwischen Modellen und Daten. Aber es gibt immer noch eine große Zunahme der Differenz von den Zehnerjahren bis etwa 1940, als die Modelle nicht imstande waren, die damals stattfindende Erwärmung angemessen zu simulieren. Und natürlich hat der jüngste Stillstand eine erneute Abnahme der Temperaturdifferenz verursacht.

Abbildung 12

Zusammenfassung dieses Kapitels

Es gibt eine Spannbreite von etwa 0,8°C bei den Schätzungen der absoluten globalen Mitteltemperatur, wobei die höhere Schätzung von einer Schätzung aus jüngerer Zeit stammt, die auf einer aktuelleren Datenbasis der globalen Temperaturen beruht. Mit anderen Worten, die BEST-Schätzung scheint wahrscheinlicher zu sein als die veralteten GISS- und NCDC-Werte.

In den Klimamodellsimulationen der absoluten globalen Temperaturen gibt es eine erheblich größere Spannbreite, die im Mittel etwa 3,15°C von 1880 bis 2013 ausmacht. Um das ins Verhältnis zu stellen: Mit Beginn in den neunziger Jahren haben Politiker suggeriert, dass wir die Steigerung der globalen Temperaturen auf 2,0°C begrenzen. Eine andere Möglichkeit, jene 3,15°C-Modellspannbreite ins Verhältnis zu setzen ist es, dass das IPCC in seinem 4. Zustandsbericht im Grunde behauptet, dass die gesamte globale Erwärmung von 1975 bis 2005 durch anthropogene Treibhausgase verursacht worden ist. Diese Behauptung beruhte auf Klimamodell-Ergebnissen, die die natürliche Variabilität nicht simulieren können, und darum war die Behauptung bedeutungslos. Unabhängig davon sind die globalen Temperaturen zwischen 1975 und 2005 nur um etwa 0,55°C gestiegen, jedenfalls dem Mittel der linearen Trends in den BEST-, GISS- und NCDC-Daten zufolge.

Und die Differenz zwischen der modellierten und der gemessenen absoluten globalen Mitteltemperatur war lediglich eine weitere Möglichkeit zu zeigen, wie schlecht globale Temperaturen in den jüngsten und besten Klimamodellen simuliert wurden, die das IPCC für seinen 5. Zustandsbericht herangezogen hatte.

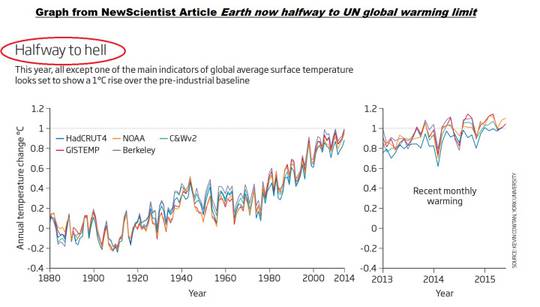

Aber

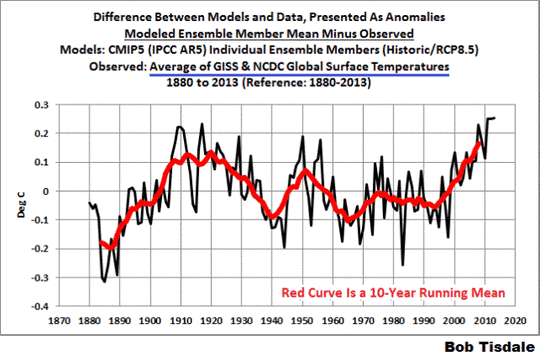

Manchmal erfahren wir etwas Anderes, wenn wir Daten als Anomalien präsentieren. In den Abbildungen 13 und 14 habe ich die Modelle↔Daten-Differenz durch ihre jeweiligen Mittel von 1880 bis 2013 ersetzt. Dies konvertiert die absoluten Differenzen in Anomalien. Wir benutzen den vollen Datensatz als eine Referenz um sicherzustellen, dass wir die Ergebnisse nicht durch eine entsprechende Auswahl der Zeiträume verzerren. Mit anderen Worten, niemand kann uns vorwerfen, dass wir bzgl. der Referenzjahre Rosinenpickerei betrieben hätten. Die 10-Jahre-Mittelkurven (rot) helfen, die Auswirkungen des jüngsten Stillstandes ins Verhältnis zu setzen.

Man vergesse nicht, falls die Modelle die dekadischen und multidekadischen Variationen der Temperaturen auf der Erde angemessen simulieren, wäre die Differenz eine gerade Linie, und in den folgenden beiden Fällen wäre jene gerade Linie eine Null-Anomalie.

Für das Mittel der GISS- und NCDC-Daten (Abbildung 13) gilt, dass die Divergenz zwischen Modellen und Daten infolge des jüngsten Stillstandes heute die größte (schlechteste) seit etwa 1890 ist.

Abbildung 13

Und betrachtet man die Differenz zwischen den Modellsimulationen der globalen mittleren Temperatur und den BEST-Daten (Abbildung 14) als Folge des Stillstandes, ist die Modell-Performance während des jüngsten Zehn-Jahre-Zeitraumes die schlechteste jemals bei der Simulation der globalen Temperaturen.

Abbildung 14

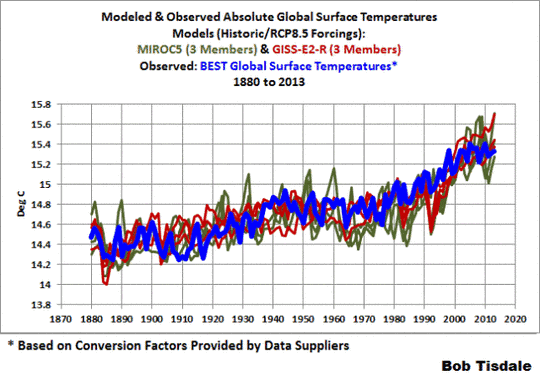

Falls man noch einmal zurück zu Abbildung 7 geht, wird man feststellen, dass es eine kleine Untermenge von Modellläufen gibt, die die Berkeley Earth-Schätzung der absoluten globalen Mitteltemperatur unterstreicht. Sie liegen so eng beieinander, dass es sehr wahrscheinlich zu sein scheint, dass jene Modelle an jene Temperaturen angepasst worden sind.

Nun kann ich mir vorstellen, dass man daran interessiert ist, um welche Modelle es sich dabei handelt. Siehe Abbildung 15. Es handelt sich um die 3 Ensemble-Member des MIROC5-Modells von der International Centre for Earth Simulation (ICES Foundation) und die 3 Ensemble-Member des GISS ModelE2 with Russell Ocean (GISS-E2-R).

Abbildung 15

Das bedeutet nicht, dass die Modelle MIROC5 und GISS-E2-R irgendwie besser sind als alle anderen Modelle. Soweit ich weiß, können diese beiden immer noch nicht die gekoppelten Ozean-Atmosphäre-Prozesse simulieren, die zu einer Erwärmung der globalen Temperaturen über multidekadische Zeiträume führen oder die diese Erwärmung stoppen können, wie AMO und ENSO. Wie oben erwähnt zeigt ihre größere Nähe zu den aktualisierten Schätzungen der absoluten Temperatur auf der Erde, dass jene beiden Modelle an diese angepasst worden sind. GISS sollte in Betracht ziehen, ihre Schätzung von 14,0°C der absoluten globalen Temperatur für ihre Referenzperiode zu aktualisieren.

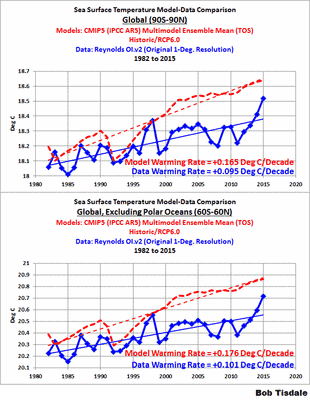

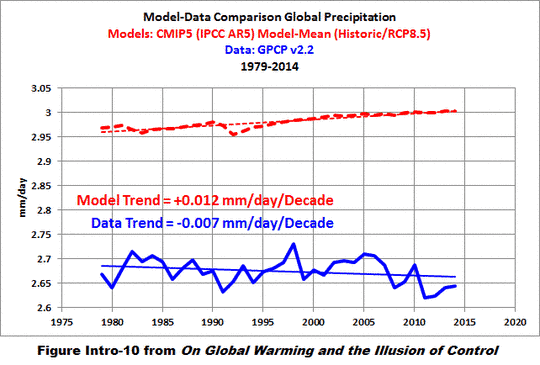

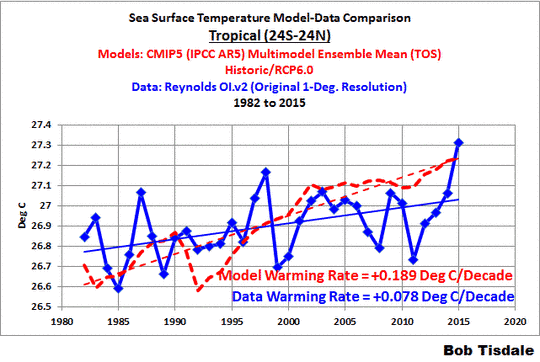

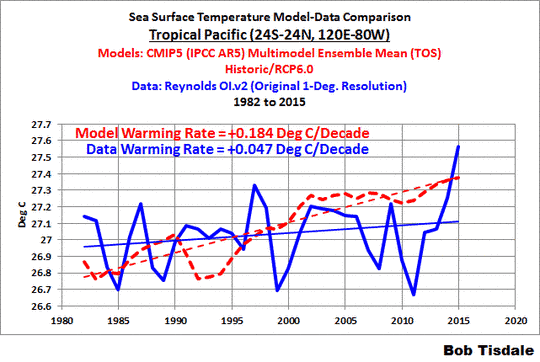

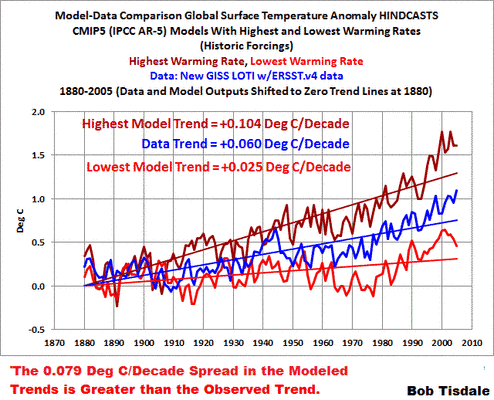

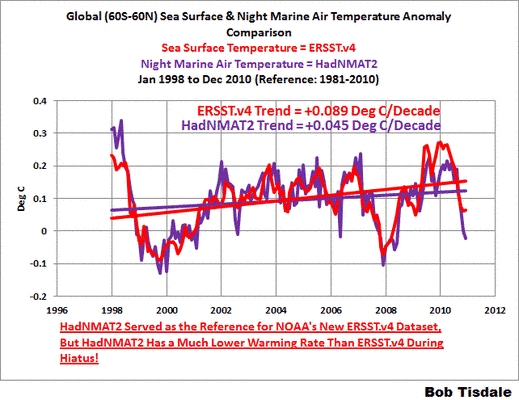

Schließlich haben wir während der letzten paar Jahre auf zahlreichen Wegen gezeigt, wie schlecht die Modelle abgeschnitten haben. Darunter waren:

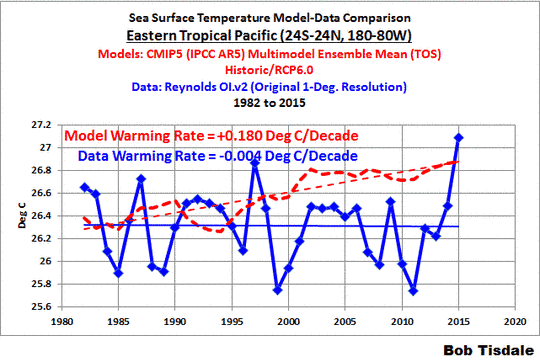

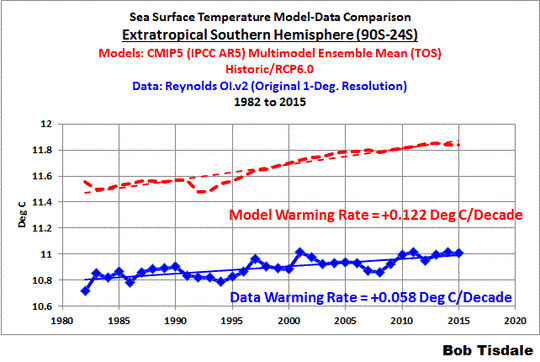

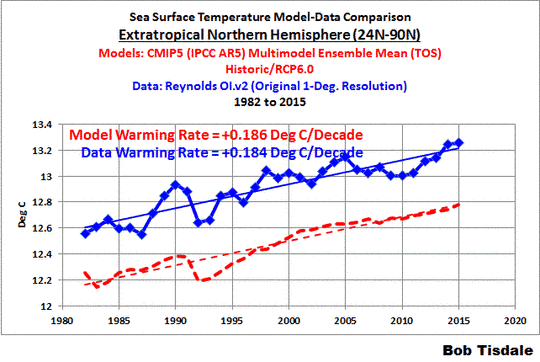

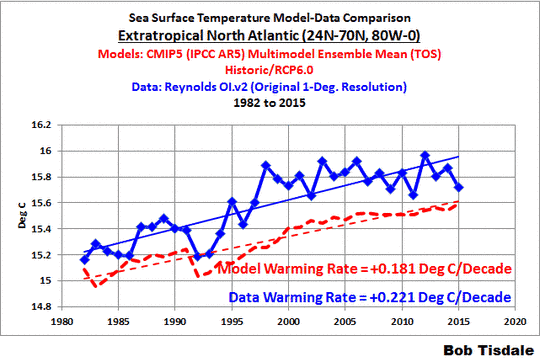

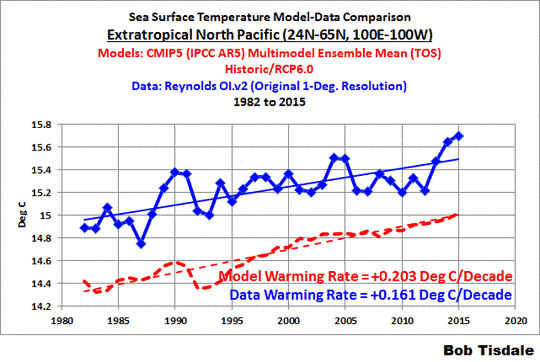

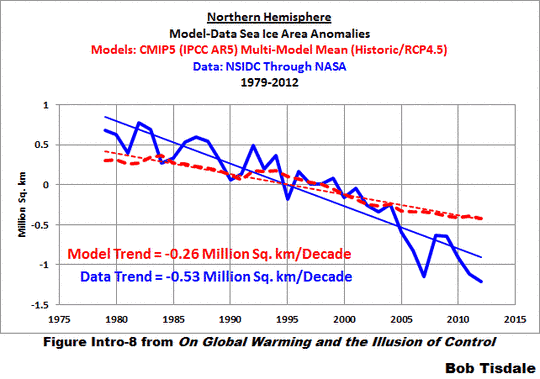

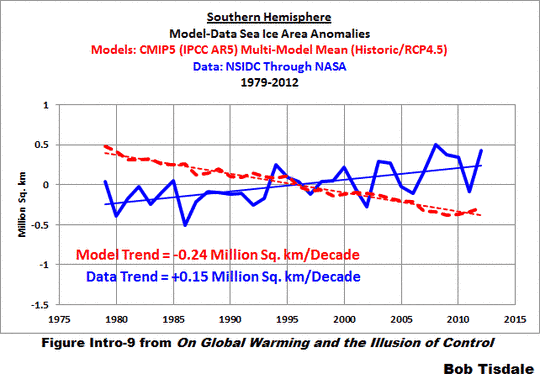

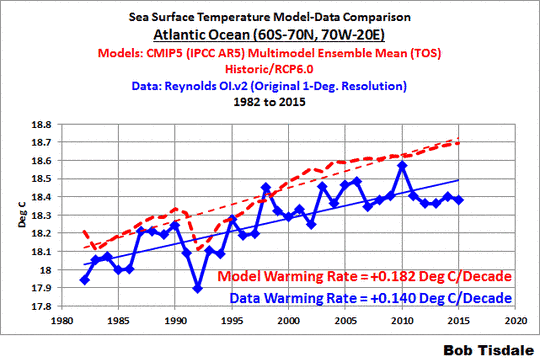

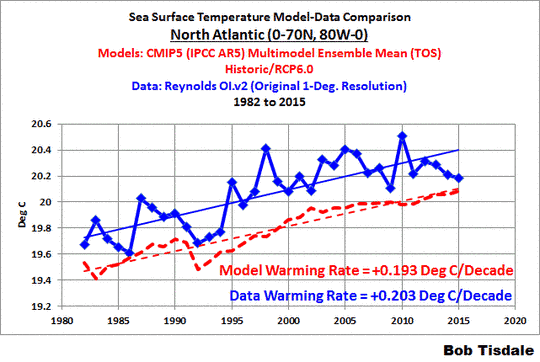

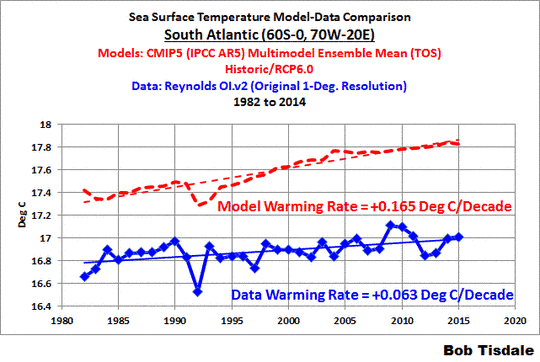

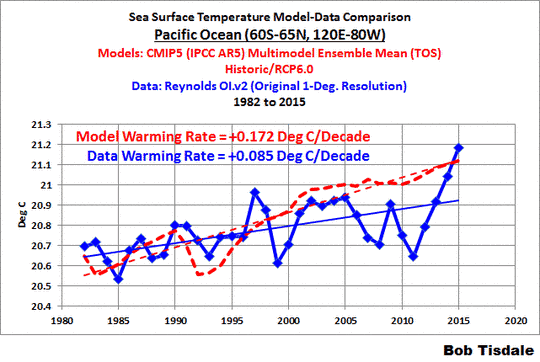

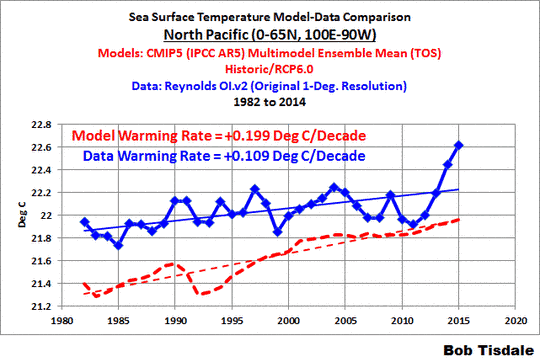

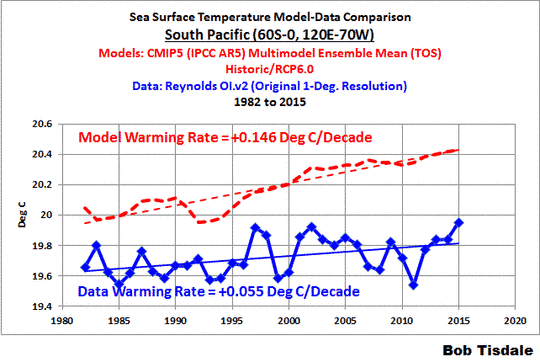

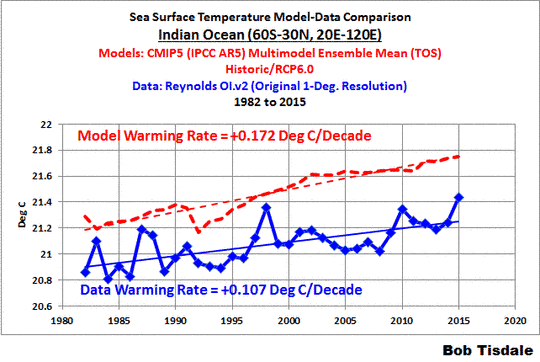

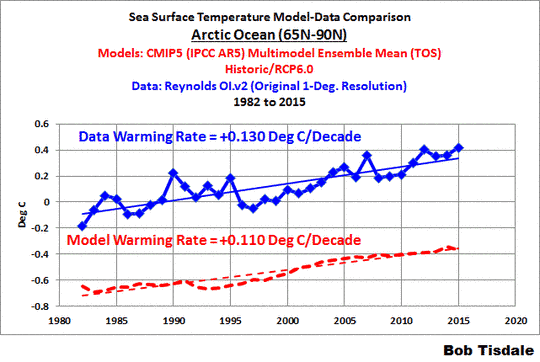

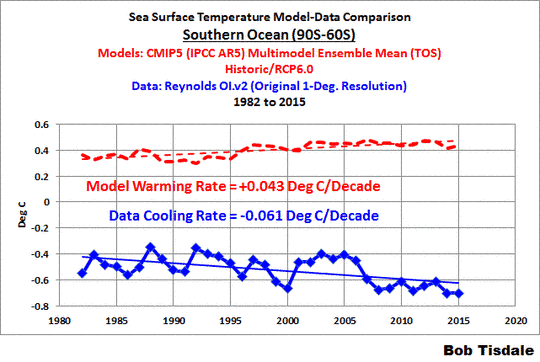

Satellite-Era Sea Surface Temperatures

Global Surface Temperatures (Land+Ocean) Since 1880

Global Land Precipitation & Global Ocean Precipitation

Alle diese Beiträge waren auch bei WattsUpWithThat gepostet.

Übersetzt von Chris Frey EIKE