Michael Mann und Stefan Rahmstorf behaupten: Golfstrom schwächt sich ab wegen Eisschmelze in Grönland – außer dass die Realität etwas ganz anderes sagt

In einer begutachteten Studie von H. Thomas Rossby, die bei WUWT vorgestellt worden war, sagt der Autor: „Ein URI-Ozeanograph weist Behauptungen zurück, denen zufolge der Klimawandel den Golfstrom verlangsamt“ (hier). Weiter heißt es in der von den Geophysical Research Letters veröffentlichten Studie:

Das ADCP misst Strömungen mit sehr hoher Genauigkeit. Folglich erhalten wir durch wiederholte Messungen, die wir Jahr für Jahr durchführen, ein aussagekräftiges Tool, mit dem wir die Stärke der Strömung überwachen können. Es gibt Variationen der Strömungsgeschwindigkeit mit der Zeit, die natürlichen Ursprungs sind – und ja doch, diese müssen wir noch besser verstehen – aber wir finden absolut keine Beweise, die zeigen, dass sich der Golfstrom verlangsamt“.

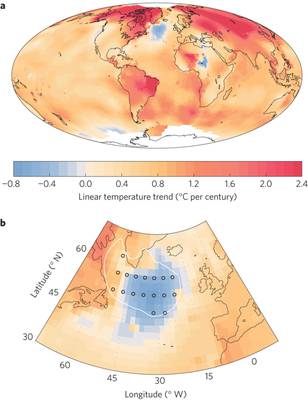

Natürlich listen Rahmstorf und Mann die Studie in ihren Literaturhinweisen nicht (hier). Auch verwenden sie offensichtlich nicht die „sehr genauen“ ADCP-Daten. Stattdessen verwenden sie ein Modell zusammen mit Proxys, Rekonstruktionen und die stark interpolierten GISS-Daten, um zu der von ihnen gewünschten Schlussfolgerung zu kommen. Es ist daher keine Überraschung, dass sie in ihrer Studie Phantomen nachjagen. Sie behaupten (in der Abbildung 1 ihrer Studie), dass dieser ,Cold Spot‘ südlich von Grönland dem Schmelzwasser von Grönland geschuldet ist und Beweis für eine verlangsamte Zirkulation ist:

Ihre Bildunterschrift lautet: Lineare Trends der Temperatur seit dem Jahre 1901. Auf der Grundlage der Temperaturdaten von NASA GISS zeigen wir oben (a) eine globale Karte (Hammer-Projektion) von 1901 bis 2013; weiße Flächen stehen für unzureichende Daten. (b), die gleiche Analyse für den nordatlantischen Sektor von 1901 bis 2000. Zusätzlich zu den beobachteten Temperaturtrends zeigt (b) auch die Gitterpunkte (schwarze Kreise) der Region des subpolaren Wirbels [?], für den Zeitreihen in den Abbildungen 3 und 5 gezeigt werden, ebenso wie das 2°C-Modellmittel der Abkühlung aus einem Klimamodell-Vergleich 1, in dem die Modelle Gegenstand einer stark reduzierten AMOC sind, induziert durch eine Süßwasser-Anomalie im Nordatlantik. Die geographische Ausdehnung der vom Modell prophezeiten Temperatur-Reaktion auf eine AMOC-Reduktion passt gut zu dem Gebiet mit der beobachteten Abkühlung im 20.Jahrhundert. Die Modelle werden stärker angetrieben, und die Abkühlung erstreckt sich weiter westwärts als Folge der zum Erliegen kommenden Konvektion in der Labrador-See, was in der realen Welt bisher höchstens kurz einmal vorgekommen ist. (Man beachte, dass das zweite Abkühlungsgebiet in Zentralafrika in einer Region mir nur geringer Datenabdeckung liegt und daher auch ein Artefakt von Daten-Inhomogenitäten sein kann).

Ich finde es interessant, dass sie anmerken „… dass das zweite Abkühlungsgebiet in Zentralafrika in einer Region mir nur geringer Datenabdeckung liegt und daher auch ein Artefakt von Daten-Inhomogenitäten sein kann“. Und doch ist jenes Abkühlungsgebiet südlich von Grönland frei von derartigen Problemen im gleichen GISS-Datensatz.

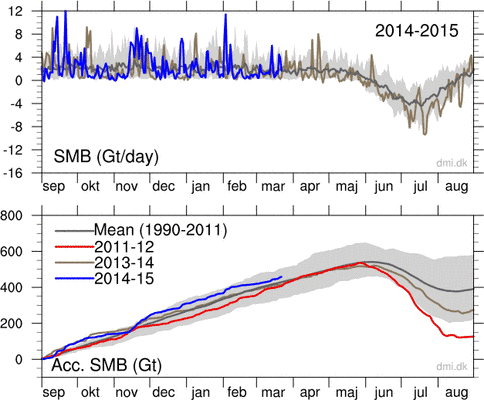

Und dann gibt es da noch ein weiteres Problem: Die Eismasse Grönlands scheint derzeit zuzunehmen über das Mittel der Jahre 1990 bis 2011 hinaus:

Quelle: http://www.dmi.dk/uploads/tx_dmidatastore/webservice/b/m/s/d/e/accumulatedsmb.png

aus: http://www.dmi.dk/en/groenland/maalinger/greenland-ice-sheet-surface-mass-budget/

Vielleicht ist das eine neue Mann’sche Wissenschaft, in der globale Erwärmung Abkühlung verursacht und Schmelzen eine stärkere Eis-Akkumulation.

Unter der Voraussetzung, dass Rahmstorf denkt, „Day After Tomorrow“ war einfach toll war, fragt man sich natürlich, ob seine Studie nicht eine Ausschmückung seiner Film-Begutachtung ist:

(Von Wikipedia): Allerdings war Stefan Rahmstorf vom PIK, Experte für thermohaline Ozean-Zirkulation und deren Auswirkungen auf das Klima beeindruckt, wie gut Drehbuchautor Jeffrey Nachmanoff über die Wissenschaft und die Politik des globalen Klimawandels informiert war nach der Unterhaltung mit ihm bei der Vorstellung des Films in Berlin. Er stellte fest: „Eindeutig ist dies ein Katastrophenfilm und keine wissenschaftliche Dokumentation; die Filmmacher haben tief in die Trickkiste gegriffen. Aber der Film bietet eine Gelegenheit zu erklären, dass Einiges des Hintergrundes zutreffend ist: Die Menschen ändern tatsächlich zunehmend das Klima, und dies ist ein ziemlich gefährliches Experiment einschließlich des Risikos abrupter und unvorhergesehener Änderungen. Schließlich ist unser Wissen über das Klimasystem immer noch ziemlich begrenzt, und wir werden möglicherweise noch einige Überraschungen erleben, wenn sich unser Experiment mit der Atmosphäre entfaltet. Glücklicherweise ist es extrem unwahrscheinlich, dass wir während der nächsten Jahrzehnte eine umfassende Änderung der Ozean-Zirkulation erleben werden (wäre das doch der Fall, wäre ich genauso überrascht wie Jack Hall). Zumindest die meisten Wissenschaftler glauben, dass dieses Risiko erst zum Ende dieses Jahrhunderts deutlich steigt. Und die Konsequenzen wären sicherlich nicht so dramatisch wie der im Film ausgesuchte ,Super-Sturm‘. Nichtsdestotrotz ist eine grundlegende Änderung der Ozean-Zirkulation ein Risiko mit ernsten und teilweise unvorhersagbaren Konsequenzen, welches wir vermeiden sollten. Und selbst ohne Ereignisse wie eine Änderung der Ozean-Zirkulation ist der Klimawandel ernst genug, um Maßnahmen zu fordern. Ich denke, es wäre ein Fehler und dem Film nicht gerecht werden, falls die Wissenschaftler diesen einfach als Unsinn abtun. Für das, was er ist, nämlich ein Kassenschlager, der die Produktionskosten in Höhe von 120 Millionen Dollar wieder einspielen muss, ist er wahrscheinlich so gut wie es nur geht. Ich bin sicher, dass die Leute den Film nicht mit der Realität verwechseln, sie sind ja nicht dumm – sie werden wissen, dass er reine Fiktion ist. Aber ich hoffe, dass deren Interesse am Thema geweckt wird und dass sie aufmerksamer werden, wenn der echte Klimawandel und die Klimapolitik zukünftig diskutiert werden“. Quelle: http://www.pik-potsdam.de/~stefan/tdat_review.html

Aber…

Im Jahre 2008 hat Yahoo!Movies den Film The Day After Tomorrow als einen der Top Ten wissenschaftlich unsinnigen Filme gelistet. Der Film wurde dafür kritisiert, verschiedene meteorologische Phänomene zeitlich auf einige Stunden zusammengefasst zu haben, die in Wirklichkeit im Zeitmaßstab von vielen Jahrzehnten oder Jahrhunderten ablaufen.

Aktualisierung: Ich habe die Abbildungen 5 und 6 aus der Studie von Mann und Rahmstorf hinzugefügt:

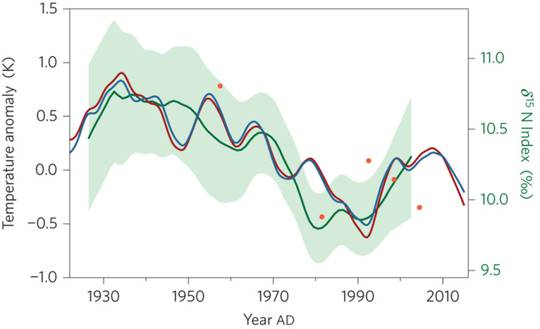

Abbildung 5: Eine Zusammenstellung verschiedener Indikatoren der Zirkulation im Atlantik. Die blaue Kurve zeigt unseren temperatur-basierten AMOC-Index, der auch in (b) eingezeichnet ist. Die dunkelrote Kurve zeigt den gleichen Index auf der Grundlage der NASA GISS-Temperaturdaten (Skala links). Die grüne Kurve mit der Fehlerbandbreite zeigt Proxydaten aus Korallen (Skala rechts). Die Daten sind dekadisch geglättet. Orangene Punkte zeigen die Datenanalysen hydrographischer Querschnitte entlang 25°N auf dem Atlantik, wobei eine Änderung um 1 K des AMOC-Index‘ mit einer Änderung um 2,3 Sv [?] des AMOC-Transportes korrespondiert entsprechend der Modellsimulation. Andere Schätzungen ozeanographischer Daten zeigen ebenfalls eine relativ starke AMOC in den fünfziger und sechziger Jahren, die in den siebziger und achtziger Jahren schwächer und in den neunziger Jahren wieder stärker wurde.

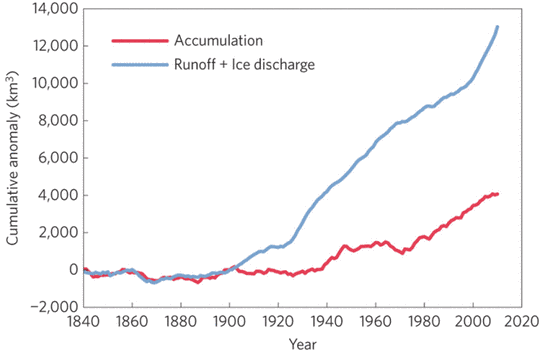

Abbildung 6: Massenbalance des Eisschildes von Grönland. Daten von Box und Colgan (2010). Kumulative Anomalie relativ zum Mittel von 1840 bis 1900, einer vorindustriellen Periode, während der sich der grönländische Eisschild etwa im Gleichgewicht befand.

Wenn aktuelle Messdaten des Golfstromes vorliegen (die von Rossby 2014 zitierten ADCP-Daten), warum benutzen Mann und Rahmstorf dann Proxys? Und warum versuchen sie zu erklären, dass die Temperatur ein Indikator ist, wenn man tatsächlich aktuelle Daten der Strömungsgeschwindigkeit hat? Diese Beschränktheit macht einen fassungslos.

Und außerdem – man betrachte noch einmal Abbildung 6. Sie behaupten, dass sich [die Einleitung von Süßwasser] erneut verstärkt, was wie Manns sprichwörtlicher „Hockeyschläger“ aussieht, und dies basiert auf den Daten von Box und Colgan 2010, in ihrer Referenzliste an 33. Stelle gelistet. Sie machen Daten bis zurück zum Jahre 1850 geltend, was ein ziemliches Kunststück ist, gibt es doch – soweit ich weiß – keine umfassenden Daten bzgl. des Grönland-Eises vor dem Internationalen Geophysikalischen Jahr 1958 wie z. B. hier:

Bauer, A., Baussart, M., Carbonnell, M., Kasser, P., Perroud, P. and Renaud, A. 1968. Missions aériennes de reconnaissance au Groenland 1957-1958. Observations aériennes et terrestres, exploitation des photographies aeriennes, determination des vitesses des glaciers vělant dans Disko Bugt et Umanak Fjord. Meddelser om Grønland 173(3), 116 pp.

Und außerdem beginnen Studien von Jason Box nur mit Daten ab 1958:

Rignot, E., J.E. Box, E. Burgess, and E. Hanna (2008), Mass balance of the Greenland ice sheet from 1958 to 2007, Geophys. Res. Lett.,35,L20502, doi:10.1029/2008GL035417

Es zeigt sich, dass Box und Colgan (2010) eine Rekonstruktion ist und keine aktuellen Messdaten verwendet.

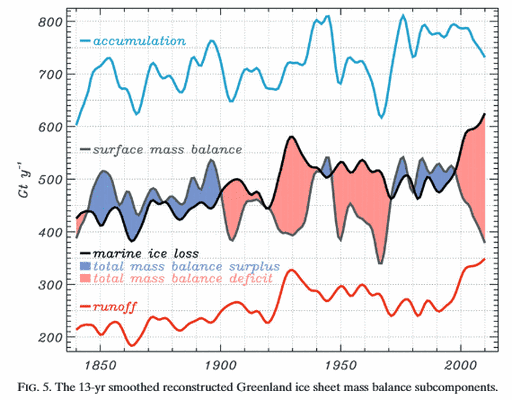

Noch merkwürdiger ist allerdings Folgendes: schaut man sich die Abbildung 5 in deren Studie an (PDF hier), zeigen der Massenbilanz-Verlust und die Akkumulation nicht die Form eines „Hockeyschlägers“.

Man fragt sich, ob Mann seine „spezielle Mann’sche Mathematik“ (hier), so wie er es bei seinem „Hockeyschläger“ getan hat, nicht auch auf die von Box und Colgan (2010) rekonstruierten Daten angewendet hat, um die große Divergenz zwischen Akkumulation und Verlust zu bekommen, die man in Abbildung 6 von Mann und Rahmstorf erkennt.

Noch wichtiger allerdings ist jedoch, dass die Daten von Box und Colgan (2010) keine aktuellen Messdaten sind, sondern eine Rekonstruktion, die auf einigen wenigen Daten und einigen Abschätzungen basiert:

Unserer Rekonstruktion zufolge war TMB positiv über 39% des Zeitraumes von 1840 bis 2010 (siehe Gebiete mit einer positiven Massenbilanz in Abbildung 5). Die positiven Phasen der Massenbilanz im Zeitmaßstab von Jahrzehnten korrespondieren mit Phasen geringen Schmelzens und geringer Wasserabflüsse. Zum Beispiel korrespondiert im Zeitraum 1970 bis 1985 eine Phase mit positiver Massenbilanz mit einer Phase verstärkter Abkühlung durch Sulfate (Wild et al. 2009). Besonders ausgeprägt zeigt sich dies entlang der Küste von Westgrönland (Rozanov et al 2002, Box et al. 2009). Massenbilanz-Überschüsse können sich auch in Jahren mit hoher Akkumulation ergeben, gelegentlich selbst bei relativ hohen Abflüssen (z. B. 1996).

Die rekonstruierten TMB-Werte werden verglichen 1.) mit jenen der Oberflächen-Massenbilanz in Teil II minus der LM-Daten von Rignot et al. 2008) für 20 Stichproben aus dem Zeitraum 1958 bis 2009 und 2.) mit den unabhängigen GRACE-Daten des Zeitraumes 2003 bis 2010 nach Wahr et al. 2006 (Abbildung 6). Wir finden RMS-Fehler von 31 Gtyr [?] für Datensatz 1 und 69 Gtyr im Vergleich mit Datensatz 2.

Fazit: Es gibt definitiv keine aktuellen Daten vor dem Jahr 1958. Die Studie von Mann und Rahmstorf führt die Leser in die Irre, indem sie diese Tatsache nicht eindeutig hervorhebt.

Der Physiker Robert G. Brown von der Duke University kommentiert:

Meinen sie das ernst? Sie fanden „starke Beweise“ dafür, dass eine solche Verlangsamung stattfindet, obwohl der direkte Beweis, nämlich die gemessene Geschwindigkeit des Golfstromes selbst nichts dergleichen zeigt?

Die hier involvierte kognitive Dissonanz ist unfasslich.

Tatsächlich! Mann und Rahmstorf scheuen die Realität und greifen auf Modelle und Rekonstruktionen zurück. Sie leben in einer inzestuösen Welt, die sie selbst erschaffen haben.

Übersetzt von Chris Frey EIKE

Anmerkung des Übersetzers: Im Original fügt Watts hier die ganze Presseerklärung von Rahmstorf & Co. an. Ich habe das nicht mitübersetzt, da war mir die Zeit doch zu schade, so viel Spaß ich bei der Übersetzerei auch habe.