Dr. Ray Bradleys erstaunliches Photo! Wie man Kurven manipuliert!

Hier findet man die Website von Dr. Raymond S. Bradley, der wie folgt beschrieben wird:

Herausragender Universitätsprofessor im Fachbereich Geowissenschaften und Direktor des Climate System Research Center (http://www.paleoclimate.org).

Leser können sich vielleicht auch an Dr. Bradley erinnern, war er doch Ko-Autor von Dr. Michael Mann in der berühmten MBH98-Studie, in der der umstrittene „Hockeyschläger“ erzeugt wurde.

Dr. Bradley wurde auch vor Kurzem bekannt durch seine Plagiatsvorwürfe (accusations of plagiarism) hinsichtlich des Wegman-Berichtes an den Kongress von Dr. Edward Wegman von der George Mason Universität, in dem die statistischen Methoden der Studie MBH98 kritisiert wurden.

Rechts sehen Sie Dr. Bradleys Photo von seiner UMass-Website:

Bemerken Sie darin etwas Interessantes? Hier sind einige Hinweise:

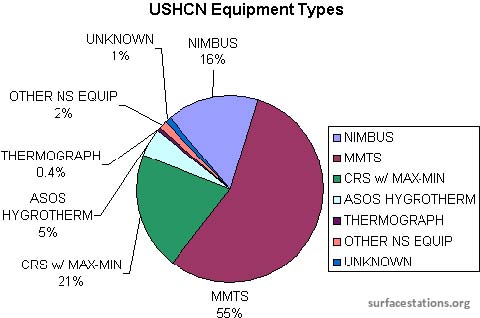

Seine Graphik des CO2-Verlaufs mit dem Titel “Treibhausgasaufzeichnungen aus dem Eisbohrkern von Wostok“ zeigt einen Wert von etwa 360 ppm für das CO2 am „Zeitpunkt 0“ der Gegenwart. Das Photo muss alt sein, da der gegenwärtige Wert in der Atmosphäre gemessen auf dem Mauna Loa etwa bei 390 ppm liegt.

Gut, es ist also ein altes Photo, aber wo liegt das Problem?

Diejenigen, denen die CO2-Daten aus dem Eisbohrkern von Wostok nicht bekannt sind, können die offiziellen Daten auf den FTP-Servern der NOAA hier finden:

CDIAC (Carbon Dioxide Information and Analysis Center)

ftp://cdiac.ornl.gov/pub/trends/co2/vostok.icecore.co2

NCDC (National Climatic Data Center)

ftp://ftp.ncdc.noaa.gov/pub/data/paleo/icecore/antarctica/vostok/co2nat.txt

NASA Goddard bietet ebenfalls Zugang zu den offiziellen Wostok-Daten: http://gcmd.nasa.gov/records/GCMD_CDIAC_CO2_VOSTOK_ICECORE.html

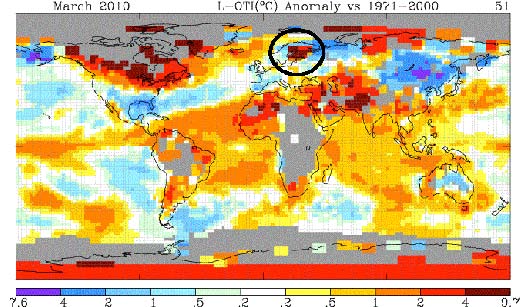

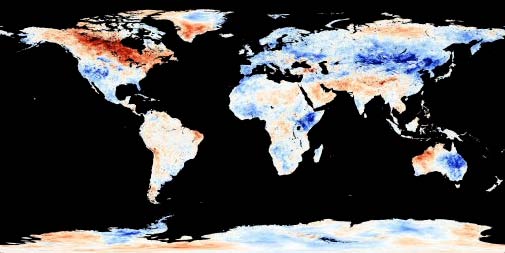

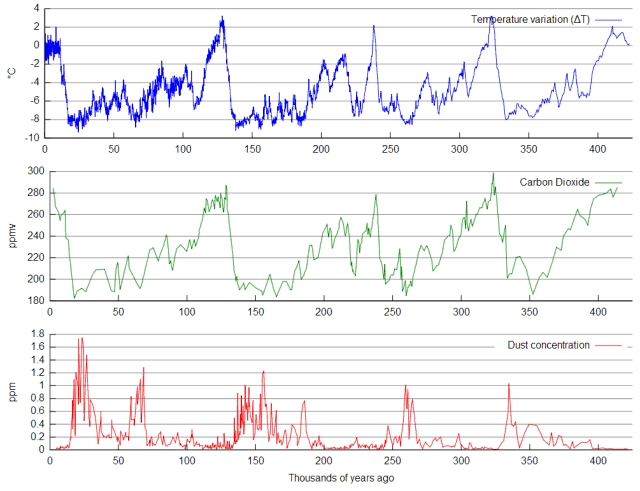

…und sie zeigen diesen hilfreichen Graphen mit der umgekehrten Zeitachse der Graphik von Dr. Bradley. Der heutige Tag findet sich also links:

Das ist merkwürdig, die CO2-Daten von Wostok zum gegenwärtigen Zeitpunkt werden mit 280 ppm angegeben, also deutlich niedriger als die 360 ppm in Dr. Bradleys Graphik. Seltsam, aber jene Website der NASA zum Eiskern aus Wostok zeigt das jüngste Update bei:

Also muss das ganz neu sein, oder?

Also lassen Sie uns ein paar andere Quellen studieren, mit Werten, die vielleicht näher an den Werten von Dr. Bradley liegen. Sicherlich gibt es irgendwo einige Updates zu den Wostok-Daten, die ich übersehen habe.

Wie sieht es bei Wikipedia aus, wo alles immer auf den neuesten Stand gebracht wird? Selbst wenn William Connelly da nicht mehr seine Finger im Spiel hat, wurden die Daten im vergangenen Jahr oder so aktualisiert? Hier sieht man den Graphen aus Wikipedia:

Der Verlauf des CO2 (grün), der Temperatur (blau) und der Staubkonzentration (rot), abgeleitet aus dem Wostok-Eisbohrkern, wie er bei Petit et al. 1999 gezeigt wird. Höhere Werte der Staubkonzentration werden trockenen, kalten Perioden zugeordnet.

Quelle: http://en.wikipedia.org/wiki/File:Vostok_Petit_data.svg

Das ist komisch, die CO2-Daten zeigen hier etwas über 280 ppm CO2 in dem Eiskern. Aber sie beziehen sich auf jener Site auf Petit et al. 1999. Hmmm, ich machte mich daran, diese Studie zu suchen, und tatsächlich fand ich sie als PDF hier: http://www.daycreek.com/dc/images/1999.pdf und habe das Papier hier abgelegt Vostok_nature_1999, um zu verhindern, die Website mit Downloads zu überladen. Der Titel dieser Studie von 1999 lautet [der Zeitschrift] Nature zufolge:

Klimatische und atmosphärische Geschichte der letzten 420 000 Jahre aus dem Wostok-Eisbohrkern, Antarktis

J. R. Petit*, J. Jouzel†, D. Raynaud*, N. I. Barkov‡, J.-M. Barnola*, I. Basile*,M. Bender§, J. Chappellaz*,M. Davisk, G. Delaygue†, M. Delmotte*, V. M. Kotlyakov¶, M. Legrand*, V. Y. Lipenkov‡, C. Lorius*, L. Pe´ pin*, C. Ritz*, E. Saltzmank & M. Stievenard†

Oh, o.k., dies erklärt, dass der Anteil des CO2 im Jahre 1999 bei 360 ppm gelegen haben muss und dass der Wert von Dr. Bradley daher stammt. Man betrachte nun die Daten vom Mauna Loa aus dem Jahre 1999 hier: ftp://ftp.cmdl.noaa.gov/ccg/co2/trends/co2_mm_mlo.txt.

Die Werte für 1999 lauten folgendermaßen:

1999 3 1999.208 369.46 369.46 367.90 26

1999 4 1999.292 370.77 370.77 368.19 30

1999 5 1999.375 370.66 370.66 367.84 29

1999 6 1999.458 370.10 370.10 367.87 30

1999 7 1999.542 369.10 369.10 368.42 30

1999 8 1999.625 366.70 366.70 368.21 30

1999 9 1999.708 364.61 364.61 367.95 29

1999 10 1999.792 365.17 365.17 368.41 31

1999 11 1999.875 366.51 366.51 368.58 29

1999 12 1999.958 367.85 367.85 368.58 29

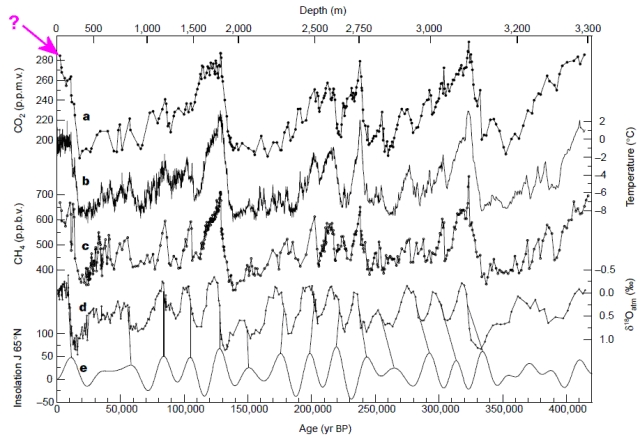

Also erklärt das alles? Der Anteil des CO2 in der Atmosphäre lag 1999 um 360 ppm, so wie es in dem alten Photo von Dr. Bradley zu erkennen ist. Also müsste die Studie von Petit et al. den gleichen Wert zeigen, oder? Hier folgt die Graphik:

Oh, ist das seltsam! Sie zeigt nur etwa 280 ppm CO2 zum “gegenwärtigen” Zeitpunkt 1999, dem Zeitpunkt also, zu dem die Graphik veröffentlicht wurde.

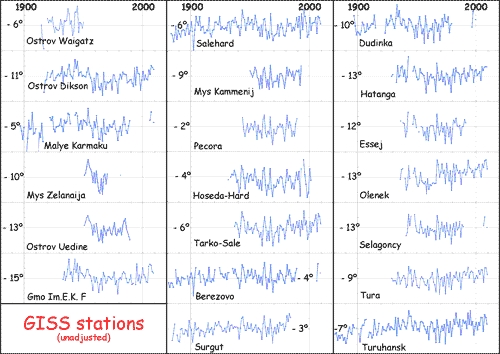

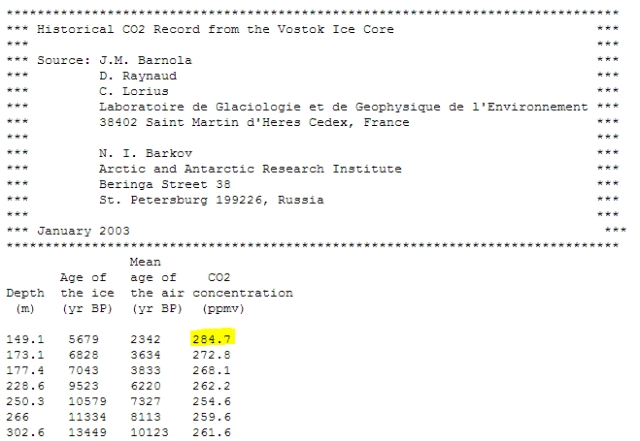

Nun ja, die archivierten NOAA-Daten auf ihrem FTP-Server müssen aktualisiert sein und etwa 360 ppm irgendwo in dem Datensatz zeigen, oder? Also suchte ich auch danach, um sicher zu sein. Die jüngsten Daten findet man hier: ftp://cdiac.ornl.gov/pub/trends/co2/vostok.icecore.co2

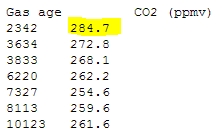

Hmmm, die jüngsten Daten stammen von vor 2342 Jahren und zeigen 284,7 ppm. Das kann aber nicht stimmen, weil der renommierte Dr. Bradley Daten um 360 ppm zeigt. Außerdem sind die Namen der Ko-Autoren des Beitrages über die Analyse der Daten aus dem Wostok-Eisbohrkern von 1999 in Nature aufgeführt. Sicher gibt es doch dazu ein Update, oder?

Vielleicht ist es ein anderer Datensatz von NOAA, den er benutzt hat? Zu finden hier: ftp://ftp.ncdc.noaa.gov/pub/data/paleo/icecore/antarctica/vostok/co2nat.txt

Nun, das passt zu den CDIAC-Daten, aber es zeigt sich immer noch kein Wert um 360 ppm CO2 in den jüngsten Daten.

Nun ja, wie kann das sein?

Die Antwort scheint zu sein, dass es keine neuen Daten aus dem Wostok-Eisbohrkern gibt. Er hat geendet, und in den offiziellen Datenspeichern gibt es keine neuen Daten. Der letzte Wert des CO2-Anteils aus dem Eiskern zeigt 284,7 ppm.

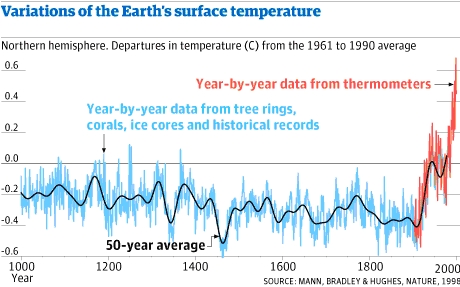

Wie kommt dann Dr. Bradley zu einem Wert um 360 ppm? Ganz einfach, ich denke, er benutzt den gleichen Trick, den er und seine Ko-Autoren bei der Erstellung des berüchtigten MBH98-Papiers entwickelt hatten und mit dem sie die Hockeyschlägerkurve aus Instrumentenablesungen und paläoklimatischen Daten zusammen setzten:

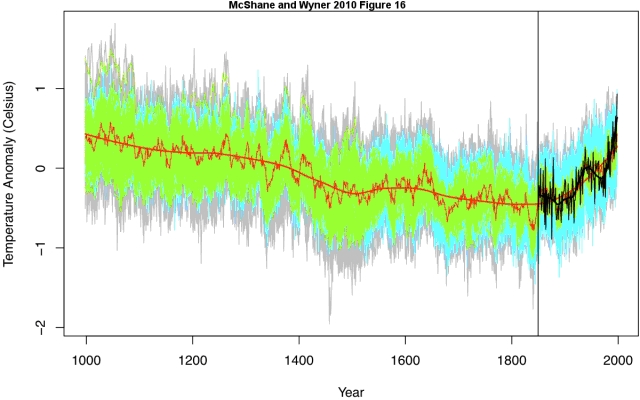

Die Graphik oben stammt aus Fred Pearce’s Feb 2010 article in the Guardian und zeigt die mit Instrumenten ermittelten Daten, wie sie den Daten des Eisbohrkerns einfach angefügt wurden.

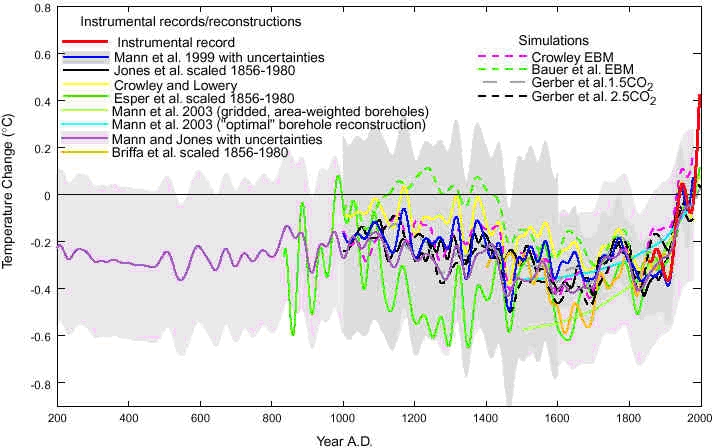

Und hier sieht man eine spätere Version aus dem Jahre 2003 mit der gleichen Aufspaltung zwischen Instrumenten- und Paläodaten (Abbildung 1 aus Mann et al., EOS forum 2003):

Quelle: http://www.ncdc.noaa.gov/paleo/pubs/mann2003b/mann2003b.html

Es ist also ziemlich offensichtlich, dass Dr. Bradley (oder wer auch immer diese Graphik entwarf) einfach die Daten aus dem Eisbohrkern am Ende entfernt und durch Instrumentendaten ersetzt hat. Oder, wie es Joe Romm ausdrückt, er hat das Ganze „aufgepeppt“.

Das einzige Problem, dass sich jedoch ergibt, wenn er die Graphik unter dem Titel: Treibhausgaskonzentrationen aus dem Wostok-Eisbohrkern wie unten gezeigt präsentiert…:

…ist, dass sie meiner Ansich nach falsch ist! Dies gilt auch für die rote Linie des Methans, aber das steht auf einem anderen Blatt.

Das Problem: Wenn man Bodendaten der Temperatur aus der Antarktis nimmt und sie mit den Bodendaten der Temperatur von Hawaii verbindet und dieses Konstrukt dann als die gesamte historische Aufzeichnung aus Antarktika präsentiert, würden unsere Freunde einen echten „Knüller“ landen.

Oder, wenn man die Wirtschaftsdaten einer schlecht gehenden Firma „A” mit den viel besseren Daten einer Firma „B“ verbindet und daraus einen Gesamtverlauf der Firma „A“ konstruiert und diesen den Aktionären vorlegt, würde die Securities and Exchange Commission (SEC) einen echten Knüller haben, wenn sie das herausfinden, oder nicht? Manch einer wandert für so etwas ins Gefängnis.

Aber was wollen Sie, das ist Klimawissenschaft!

Ein riesiges Dankeschön an den Leser Brian M. der mich per e-mail auf diesen Vorgang hingewiesen hatte.

Zusatz: Ich sollte erwähnen, dass ich keinen Beweis habe, ob diese Graphik irgendwo in irgendeiner wissenschaftlichen Veröffentlichung oder Präsentation von Dr. Bradley gezeigt wurde. Ich weise lediglich darauf hin, dass dieses Photo, das gestellt erscheint, nicht zu den aktuellen Daten aus Wostok passt. Man sollte nichts über diesen Vorgang hinaus extrapolieren, bis die nächsten Beweise präsentiert werden.

Übersetzt und mit einer Einführung versehen von Chris Frey für EIKE