Dies war in der AGU Pressemitteilung (American Geophysikal Union) zu lesen. Etwa zu der Zeit, als diese Geschichte veröffentlicht wurde, präsentiere ich es beim AGU Herbst Treffen 2015 in San Francisco. Hier sind die Details:

Die neue Studie von NOAA US Climate network zeigt einen niedrigeren 30-jahres-Temperatur-Trend wenn hochwertige Temperaturstationen berücksichtigt werden, die von Urbanisierung ungestört aufzeichnen.

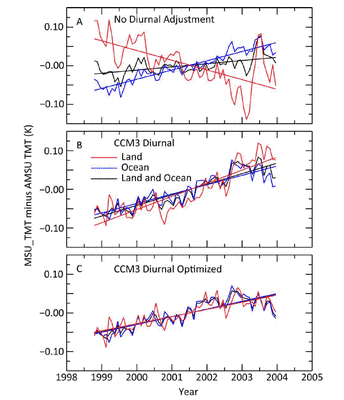

Abbildung 4 – Vergleich der 30 Jahre Trends für Klasse 1,2 konformen USHCN Stationen mit nicht-konformen, Klasse 3,4,5 USHCN Stationen NOAA gegenüber justierten V2.5 USHCN Daten in den kontinentalen USA.

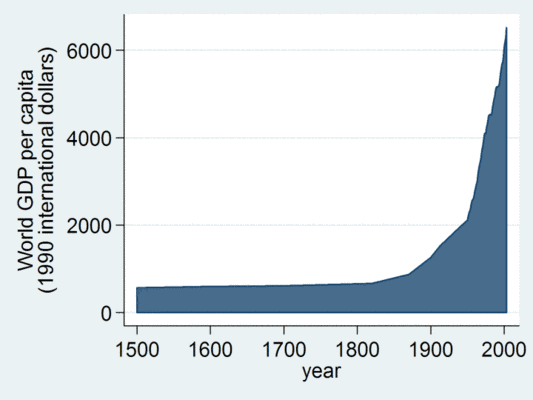

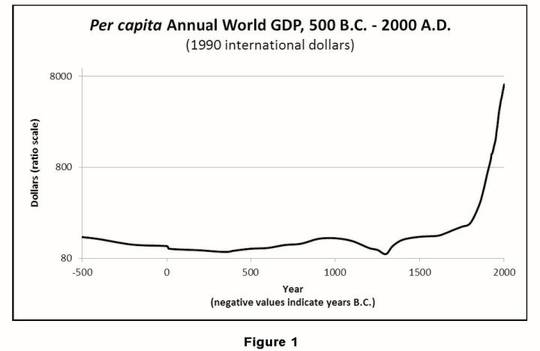

SAN FRANCISCO, CA – eine neue Studie über die Aufzeichnung der Oberflächentemperatur, präsentiert zur 2015 Herbsttagung der American Geophysical Union, legt nahe, dass die 30-Jahres-Trends der Temperaturen für die Continental United States (CONUS) [US Staaten ohne Hawai und ohne Alaska], die seit 1979 nur etwa zwei Drittel so angestiegen sind wie offizielle NOAA Temperaturtrends.

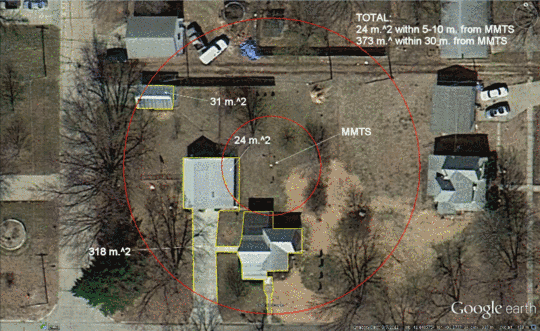

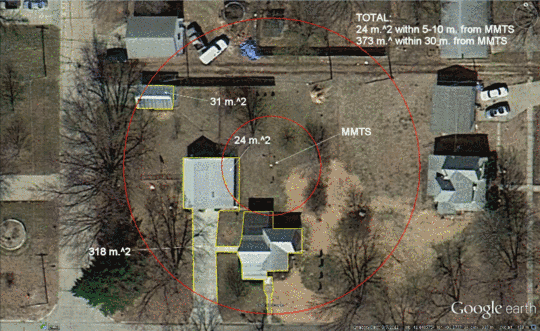

Durch Verwendung des NOAA US Historischen Klimatologie Netzwerkes, das 1218 Wetterstationen in der CONUS umfasst, waren die Forscher in der Lage, eine Teilmenge von 410 „ungestörten" Stationen, die nicht verändert wurden zu identifizieren (Veränderungen der Ausrüstung oder Veränderungen in der Zeit von Beobachtungen) und damit keine "Anpassungen" erfordern, um ihre Temperatur Aufzeichnungen für diese Probleme zu berücksichtigen. Die Studie konzentriert sich auf die Suche nach Unterschieden in den Trends zwischen gut gelegenen und schlecht gelegenen Wetterstationen auf der Grundlage einer WMO zugelassenen metrischen Leroy (2010)1 für die Klassifizierung und Bewertung der Qualität der Messungen, basierend auf Nähe zu künstlichen Wärmequellen und Wärmesenken, welche die Temperatur Messung beeinflussen. Ein Beispiel ist in Abbildung 2 dargestellt und zeigt die NOAA USHCN Temperaturfühler für Ardmore, OK. [Oklahoma]

Die im Anschluss an eine Ausarbeitung der von den Autoren in 2010 veröffentlichten Analyse der Auswirkungen der Exposition Station auf dem US Historische Klimatologie Netzwerk Temperaturen und Temperatur Trends kommt zu dem Schluss:

Schätzungen des Temperaturtrends variieren je nach Ort der Klassifizierung, führen bei schlechter Standortwahl zu einer Überschätzung der Mindesttemperatur Trends und einer Unterschätzung der maximalen Temperaturtrends, was insbesondere einen wesentlichen Unterschied der Einschätzung der Reichweite von Trends der täglichen Temperatur ausmacht.

AGU Tagung, Präsentationsvorlage A43G-0396 am Donnerstag den 17. Dezember 2015: Comparison of Temperature Trends Using an Unperturbed Subset of The U.S. Historical Climatology Network

Eine Teilmenge von 410-Station des US Historische Klimatologie Netzwerks (Version 2.5) Stationen wurden identifiziert, die keine Änderungen in der Zeit der Beobachtung oder der Verlegung der Station in der Zeit von 1979 bis 2008 erlebt hatten. Diese Stationen sind eingestuft auf der Basis der Nähe zu künstlicher Flächen, Gebäuden und anderen derartigen Objekten mit unnatürlicher thermischer Masse, nach Leitlinien, eingeführt durch Leroy (2010)1.

Die geschätzten USA Temperaturtrends, gefunden bei den relativ wenigen Stationen in den Klassen mit minimalen künstlichen Einflüssen, sind kollektiv etwa 2/3 so viel wie geschätzte USA Trends in den Klassen mit mehr künstlichen Einflüssen.

Die Trendunterschiede sind für minimale Temperaturen am größten und sind statistisch signifikant, auch auf regionaler Ebene und über verschiedene Arten der Messgeräte und dem Grad der Urbanisierung. Die Anpassungen der Homogenität durch das Nationale Center für Umwelt Information (früher das Nationale Klima Daten Center) reduzieren diese Unterschiede erheblich, aber sie produzieren Trends, die mehr im Einklang mit den Stationen mit höheren künstlichen Einflüssen sind. Trend Unterschiede wurden in der 1999- 2008 Subperiode mit relativ konstanten Temperaturen nicht gefunden, was darauf hindeutet, dass die beobachteten Unterschiede durch einen physikalische Mechanismus verursacht werden, der direkt oder indirekt von sich ändernden Temperaturen verursacht wird.

Bild 1 – USHCN Temperatur Sensor an einer Straßenecke in Ardmore, OK, in vollem Sichtschatten mehrerer Hitzequellen.

Bild 2 –Analyse der künstlichen Oberflächen innerhalb von 10 und 30-Meter-Radien an der Ashland, NE USHCN Station (COOP # 250375) mit Google Earth-Tools. Der Temperatursensor der NOAA ist als MMTS markiert

Tabelle 1 – Auflistung der Stationstypen, die einen 30 Jahre Trend für zulässige Klasse 1 & 2 USHCN Stationen zeigen, zu schlecht platzierten, nicht konformen, Klassen 3,4, und 5 USHCN Stationen im CONUS, verglichen zu offiziellen NOAA justierten und homogenisierten USHCN Daten.

Abbildung 3 – Tmittel Vergleiche von gut gelegenen (konform Klasse 1 & 2) USHCN Stationen gegenüber schlecht gelegen USHCN Stationen (nicht konform, Klassen 3,4, und 5) durch CONUS und der Region offiziellen NOAA justierten USHCN Daten (V2.5) für den gesamten (konformen und nicht konformen) USHCN Datensatz.

Die wichtigsten Ergebnisse:

1. Umfassende und detaillierte Auswertung der Stations Metadaten, Vor-Ort-Station Fotografie, Satelliten- und Luftbild, Google Earth Bilder auf Straßenniveau, und Betreuer Interviews haben eine gut verteilte 410 Stationen Untermenge der 1218 Stationen des USHCN Netzwerk ergeben, die ungestört durch die Zeit der Beobachtung, Station versetzt oder Einstufungsänderungen sind und einen vollständigen oder weitgehend abgeschlossen 30-Jahres-Datensatz haben. Es muss betont werden, dass die vom der USHCN Datensatz aussortierten, veränderten Stationen sehr deutlich niedrigere Trends zeigen, als die in die Stichprobe einbezogenen, sowohl für gut und schlecht gelegene Stations Sets.

2. Grundeinstellungen am Mikropegel (der unmittelbaren Umgebung des Sensors) der ungestörten Teilmenge der USHCN Stationen hat eine signifikante Wirkung auf den Trend der Durchschnittstemperatur (Tmean). Gut platzierte Stationen zeigen eine signifikant geringere Erwärmung von 1979 – 2008. Diese Unterschiede sind in Tmean signifikant und am häufigsten in den Mindesttemperaturdaten zu finden (Tmin). (Abbildung 3 und Tabelle 1)

3. Die Grundeinstellung der Ausrüstung (CRS v. MMTS Stationen) der ungestörten Teilmenge von USHCN Stationen hat eine signifikante Wirkung auf den Trend der Durchschnittstemperatur (Tmean) wenn CRS Stationen mit MMTS Stationen verglichen werden. MMTS Stationen zeigen eine signifikant geringere Erwärmung als CRS Stationen von 1979 – 2008 (Tabelle 1) Diese Unterschiede sind signifikant in Tmean (sogar auch nach der Anpassung nach oben für die MMTS) und am häufigsten in den Maximaltemperaturdaten zu finden (Tmax).

4. Der 30-jährige Tmean Temperaturtrend der ungestörten, gut gelegenen Stationen ist deutlich niedriger als der Tmean Temperaturtrend von NOAA / NCDC offiziellen justierten und homogenisierten Aufzeichnungen der Oberflächentemperaturen für alle 1218 USHCN Stationen.

5. Wir glauben, die NOAA / NCDC Homogenisierung bewirkt, dass gut gelegene Stationen nach oben korrigiert werden, um sich den Trends von schlecht gelegenen Stationen anzupassen.

6. Die Daten legen nahe, dass die Divergenz zwischen gut und schlecht gelegenen Stationen schrittweise erfolgt und nicht das Ergebnis von Fälschungen wegen schlechter Metadaten ist.

Die Studie ist von Anthony Watts und Evan Jones von surfacestations.org Autor, John Nielsen-Gammon der Texas A & M, John R. Christy von der Universität von Alabama in Huntsville und repräsentiert jahrelange Arbeit mit der Untersuchung der Qualität des Temperaturmesssystems der Vereinigten Staaten.

Leit-Autor Anthony Watts, sagte zur Studie: "Die Mehrheit der Wetterstationen der NOAA um das Temperatursignal zum Klimawandel zu erfassen, wurde durch künstliche Oberflächen wie Beton, Asphalt und Wärmequellen sowie Abluft von Klimaanlagen beeinträchtigt. Diese Studie zeigt eindeutig, dass dieses den Temperatur-Trend beeinflusst und die NOAA Verfahren dieses Problem nicht korrigieren, was zu einem überhöhten Temperaturtrend führt." Er schlägt vor, dass der Trend der US Temperatur korrigiert werden müsse. "Wir sehen auch Beweise für diese gleiche Art von Standortproblemen auf der ganzen Welt an vielen anderen offiziellen Wetterstationen, was darauf hindeutet, dass die gleiche Verzerrung nach oben im Trend sich auch selbst in der globalen Temperaturaufzeichnung manifestiert ".

Die komplette AGU Präsentation kann hier runtergeladen werden: https://goo.gl/7NcvT2

[1] Leroy, M. (2010): Siting Classification for Surface Observing Stations on Land, Climate, and Upper-air Observations JMA/WMO Workshop on Quality Management in Surface, Tokyo, Japan, 27-30 July 2010

Leroy, M. (2010): Standort Klassifizierung für Oberflächen-Beobachtungsstationen an Land, Klima, und höheren Luftschichten JMA / WMO Workshop über Qualitätsmanagement in der Oberfläche

[2] Fall et al. (2010) Analysis of the impacts of station exposure on the U.S. Historical Climatology Network temperatures and temperature trends https://pielkeclimatesci.files.wordpress.com/2011/07/r-367.pdf

Fall et a.. Analyse der Auswirkungen der Station Exposition auf das US Historische Klimatologie Netzwerk für Temperaturen und Temperatur Trends

Erschienen auf WUWT am 17. Dezember 2015

Übersetzt von Andreas Demmig

http://wattsupwiththat.com/2015/12/17/press-release-agu15-the-quality-of-temperature-station-siting-matters-for-temperature-trends/

Abstrakt ID und Titel: 76932: Comparison of Temperature Trends Using an Unperturbed Subset of The U.S. Historical Climatology Network

Final Paper Number: A43G-0396

Präsentationstyp: Poster

Tagungsdatum und Zeit: Donnerstag, 17. Dezember 2015; 13:40 – 18:00 PST

Tagungsnummer und Titel: A43G: Tropospheric Chemistry-Climate-Biosphere Interactions III Posters

Ort: Moscone South; Poster Hall

Full presentation here: https://goo.gl/7NcvT2

Einige Nebenbemerkungen des Autors Anthony Watts:

Dieses Werk ist eine Fortsetzung des Projekts über Bodenstationen, das im Jahr 2007 begann. Unsere erste Veröffentlichung, Fall et al. in 2010 und unsere früheres Konzeptpapier im Jahr 2012. Die Veröffentlichung des Konzeptentwurfs im Jahre 2012 bot uns wertvolles Feedback von Kritikern, und wir haben dieses in unsere Bemühungen einbezogen. Selbst der Input von offen feindseligen Fachleuten, wie Victor Venema, waren sehr nützlich und ich danke ihm dafür.

Viele der berechtigten Kritiken unserer Entwurfs von 2012 drehten sich um die Anpassungen der "Time of Observation (TOBs)“ [Zeit der Beobachtung], die auf einen Mischmasch von Stationen mit Problemen im USHCN angewendet werden. Unsere Sicht ist, dass versucht werden sollte, Stationen mit zwielichtigen Aufzeichnungen aufzubewahren. Das Justieren der Daten ist ein sinnloses Unterfangen. Wir haben uns einfach nur versucht, alle Stationen, die KEINE Anpassungen benötigen herauszufinden und zu verwenden, damit umgehen wir das hoch argumentative Problem vollständig. Glücklicherweise gab es genug davon in den USHCN, 410 von 1218 Stationen.

Es sei darauf hingewiesen, dass die Untergruppe der Class1/2 Stationen (die besten Stationen wir in CONUS lokalisiert haben) als analog zum Climate Reference Network (CNR) [Klimareferenznetzwerk] anzusehen sind, da diese Stationen relativ gut in CONUS verteilt sind und wie die CRN, keine Anpassungen in ihrer Aufzeichnungen erfordern. Die CRN besteht aus 114 in betreuten Stationen in den angrenzenden Vereinigten Staaten, unsere Zahlen von Stationen in Größe und Verteilung sind ähnlich. Dies sollte zum CRN beachtet werden:

Eine der wichtigsten Schlussfolgerungen der Konferenz von 1997 zum World Climate Research Programm war, dass die globale Kapazität das Klimasystem der Erde zu beobachten unzureichend ist und sich weltweit verschlechtert und "ohne Aktion, diesen Rückgang umzukehren und die Entwicklung des GCOS [Global Climate Observing System] zu verbessern, die Fähigkeit den Klimawandel und Veränderungen im Laufe der nächsten 25 Jahre zu erkennen sogar weniger als im vergangenen Vierteljahrhundert sein wird." (National Research Council [NRC] 1999).

Obwohl die Vereinigten Staaten als Marktführer in der Klimaforschung gelten, sind langfristige US-Klimastationen mit Herausforderungen konfrontiert durch mit Änderungen an Instrumenten und Website, die Auswirkungen auf die Kontinuität der Beobachtungen über die Zeit haben. Schon geringe Verzerrungen kann die Erklärung der dekadischen Klimavariabilität und des Klimawandels ändern, so dass ein erheblicher Aufwand erforderlich ist, um nicht-klima Diskontinuitäten zu identifizieren und die Stationsaufzeichnungen zu korrigieren (ein Prozess namens Homogenisierung).

Quelle:https://www.ncdc.noaa.gov/crn/why.html

Die CRN hat ein Jahrzehnt von Daten und sie zeigen eine Pause im CONUS. Unsere Untergruppe der Justierung freier ungestörter Stationen umspannt mehr als 30 Jahre. Wir finden es lohnt sich ein Blick auf diese Daten zu werfen und die Daten zu ignorieren, die Mengen an statistischer Spachtelmasse benötigten, bevor sie verwendbar sind. Denn das ist, was sie aussagen, ist der Grund warum die CRN erstellt wurde.

Wir erlauben nur eine und nur einmalige Anpassung der Daten, und dies ist nur, weil es auf physikalischen Beobachtungen beruht und es wird wirklich gebraucht. Wir verwenden die MMTS Anpassung wie in Menne et al festgestellt für 2009 und 2010 für das MMTS Gehäuse gegenüber der alten Holzkiste [Cotton Region Shelter (CRS)], die eine warme Verzerrung vor allem wegen Farbe und Wartungsprobleme hat. Das MMTS Kiemen Schild ist ein Superior-Belichtungssystem, das die Beeinflussung von tagsüber kurzwelliger und nachts langwelliger Wärmestrahlung verhindert. Die CRS erfordert jährlichen Anstrich und das wird oft vernachlässigt, was zu einer Exposition führt, die wie folgt aussehen:

Siehe unten zum Vergleich der Beiden:

Einige fragen sich vielleicht, warum wir einen 1979-2008 Vergleich anführen, wenn es 2015 ist? Der Grund dafür ist, dass dieses Menne et al. 2009 und 2010 entspricht, Berichte durch NOAA / NCDC ins Leben gerufen, um ihre Anpassungsverfahren gegen die Kritikpunkte zu USCHN zu verteidigen, die ich über die Qualität der Aufzeichnung der Oberflächentemperaturen gestartet hatte, wie in diesem Buch von 2009: Is the U.S. Surface Temperature Record Reliable? [Sind die US-Oberflächentemperatur Aufzeichnungen zuverlässig?] Dieser verursachte bei NOAA / NCDC eine helle Aufregung und sie antworteten mit einem übereilten und durch einen Ghostwriter geschriebenen Flyer, den sie verteilten. In unserer Abhandlung, erweitern wir die Vergleiche auf den aktuellen Datenbestand des USHCN sowie den 1979-2008 Vergleich.

Wir sind im Begriff, dies in einer angesehenen Zeitschrift zu veröffentlichen. Nein, ich will nicht sagen welche, weil wir keine Versuche von Druck auf Redaktionen zum Unterlassen von Veröffentlichungen brauchen, wie wir es in den Climategate-E-Mails gesehen haben. Ähnlich wie "Ich will keine dieser Abhandlungen in einem der nächsten IPCC-Berichte sehen. Kevin und ich werden sie schon irgendwie heraushalten – auch wenn wir, neu zu definieren haben, was Peer-Reviewed-Literatur ist" und " Ich werde die Zeitschrift anmailen um ihnen zu sagen, dass ich nichts mehr mit ihnen zu tun habe, bis sie diesen unangenehmen Redakteur los sind".

Wenn der Zeitschriftenartikel veröffentlicht wird, werden wir alle Daten, Code und Methoden zur Verfügung stellen, so dass die Studie völlig replizierbar ist. Wir glauben, das ist sehr wichtig, auch wenn es skrupellosen Typen erlaubt, "kreative" Angriffe über Veröffentlichungen in Zeitschriften, Blog-Posts und Kommentaren zu starten. Wenn die Daten und die Abhandlung zur Verfügung stehen, werden wir reale und fundierte Kritik willkommen heißen.

Es sei darauf hingewiesen, dass viele der USHCN Stationen die wir ausgeschlossen haben, weil die Mess-Stationen versetzt wurden, die Ausrüstung oder Zeitpunkte der Messung verändert, etc., hatten niedrigere Trends die unsere Schlussfolgerungen gestärkt hätten.

Der "Galerie" Server des 2007er Oberflächen-Projektes, der einzelne Wetterstationen und Angaben zum Standort zeigt, ist derzeit offline, vor allem, weil es noch regelmäßig angegriffen wird und das betrifft mein Büronetzwerk. Ich bin dabei, ihn auf Cloud-Hosting zu verlegen, um dieses Problem zu lösen. Ich frage dafür um etwas Hilfe von meinen Lesern.

Wir denken, dass diese Studie wird sich gut behaupten. Wir waren sehr sorgfältig, sehr langsam und akribisch. Ich gebe zu, der Entwurf der Ausarbeitung vom Juli 2012 wurde vor allem angegriffen, weil ich glaubte, dass Dr. Richard Muller von BEST vor dem Kongress in der nächsten Woche die Daten, die ich zur Verfügung gestellt hatte – die er aber nur für Publikationen verwendet wissen wollte – als politisches Instrument nutzen wollte. Glücklicherweise nahm er nicht an diesem Panel teil. Aber das Feedback, das wir von dieser Anstrengung bekamen, war von unschätzbarem Wert. Wir hoffen, dass diese Vorabversion auch heute wertvolle Kritik erzeugen wird.

Die Menschen fragen sich vielleicht, ob dieses Projekt von einer Regierung, Unternehmen, Organisation oder Einzel finanziert wurde: Nein, war es nicht. Das war alles freie Zeit und ohne Bezahlung von allen Beteiligten durchgeführt. Das ist ein weiterer Grund, warum wir uns viel Zeit gelassen haben, es gab kein "muss produziert werden" von einer Finanzierungsforderung.

Dr. John Nielsen-Gammon, der staatliche Klimatologe von Texas, analysierte all die statistische Signifikanz und seine Meinung wird in der Einführung reflektiert.

Dr. Nielsen-Gammon war einer unserer ärgsten Kritiker von Anfang an, er reproduzierte unabhängig von uns die Bewertungen der Stationen mit Hilfe seiner Schüler und kreierte seine eigene Reihe von Tests an den Daten und Methoden. Seine Aussage ist erwähnenswert:

Die Trendunterschiede sind am größten für minimale Temperaturen und sind sogar auf regionaler Ebene statistisch signifikant und über verschiedene Arten von Messausrüstungen und dem Grad der Urbanisierung.

Die p-Werte von Dr. Nielsen-Gammon statistischer Signifikanz-Analyse liegen weit unter 0,05 (bei einem Konfidenzniveau von 95%), und viele Vergleiche sind unter 0,01 (99% Konfidenzniveau). Er ist mit seinen Erkenntnissen nun bei uns, nachdem er sich vergewissert hat, dass wir in der Tat eine Grundwahrheit gefunden haben. Wenn jemand seinen Beitrag zu dieser Studie bezweifelt, sollten Sie seine Publikationsliste ansehen.

Richtlinien für Kommentare:

Zum Zeitpunkt dieser Beitrag online geht, werde ich an AGU präsentieren, also bin ich nicht in der Lage, auf Anfragen gleich zu reagieren. Dies gilt auch für Evan Jones… [Aussage an die jetzige Vergangenheit der AGU Konferenz angepasst; A.D.]

Dies ist ein technischer Grund, so dass diejenigen, die einfach boshafte Bemerkungen über Leugner schreien möchten, „Koch Brothers“ [US Milliardäre] und Exxon [Kommentatoren] hier nicht willkommen sind. Das Gleiche gilt für Leute, die einfach nur Anschuldigungen verbreiten wollen ohne sie nachzuweisen (insbesondere unter Verwendung von falschen Namen / E-Mails, wir haben ein paar). Moderatoren sollten proaktive Umsicht verwenden, um Unkraut sowie Geröll auszusortieren. Wahrhaftige Kommentare und / oder Fragen sind willkommen.

Danke an alle die geholfen haben, diese Studie und Präsentation möglich zu machen.