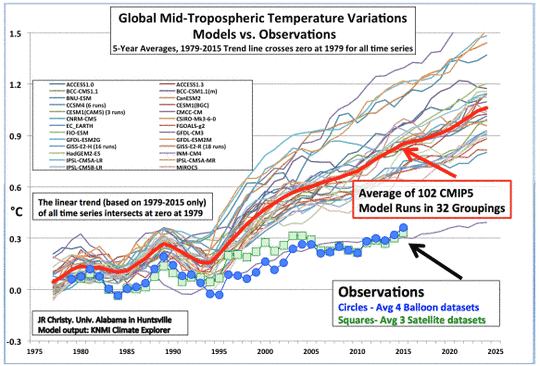

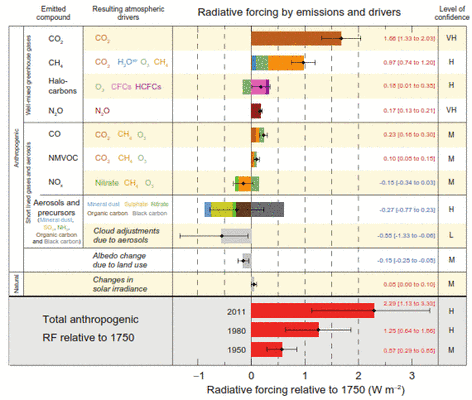

Epstein legt hier eine sehr gut geschriebene Diskussion der Debatte um den Klimawandel vor. Er zerschlägt den 97%-Mythos, erklärt, dass der CO2-Treibhauseffekt logarithmisch mit der Konzentration abnimmt und zeigt, dass die Klima-Computermodelle, die den menschlichen Einfluss auf das Klima berechnen sollen, noch nie überhaupt etwas erfolgreich vorhergesagt haben. Er zeigt auch, dass Extremwetter jedweder Art im Zuge der globalen Erwärmung nicht zugenommen hat und dass die Gefahren von Extremwetter heutzutage geringer sind als zu jeder anderen Zeit der menschlichen Geschichte – im Wesentlichen fossilen Treibstoffen geschuldet. Er bespricht die Pionier-Forschungen von Craig Idso, die beweisen, dass ein zunehmender CO2-Gehalt als starker Dünger für viele Pflanzen agiert. Aber die Leser dieser Rezension kennen diese Fakten. Darum werden wir uns auf seine Diskussion der Verdienste fossiler Treibstoffe konzentrieren. Er kann gut schreiben und hat Superman-Power, ein überzeugendes logisches Argument darzulegen. Er hätte Daniel Webster und Clarence Darrow in den Schatten gestellt. Ich empfehle das Buch dringend zur Lektüre.

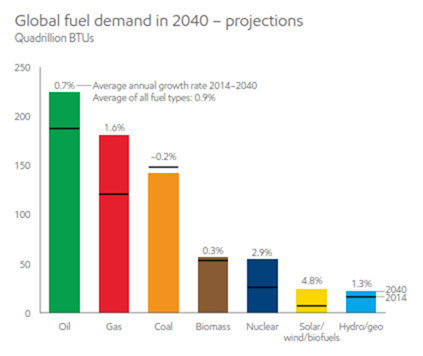

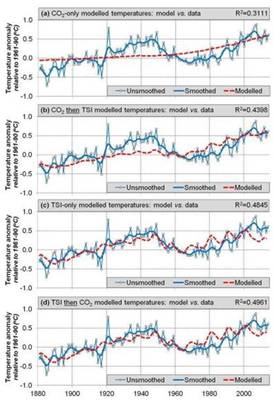

Dem Bericht 2016 von ExxonMobil zufolge erzeugten im Jahre 2014 fossile Treibstoffe 82% der Energie in der Welt. Fossile Treibstoffe haben über 80% der in den USA verbrauchten Energie in über 100 Jahren erzeugt. Das schreibt jedenfalls die EIA. Sie prophezeit, dass im Jahre 2040 fossile Treibstoffe immer noch 78% der Weltenergie erzeugen werden. Der Ölverbrauch wird mit einer jährlichen Rate von 0,7%, Erdgas mit einer solchen von 1,6% zunehmen. Der Kohleverbrauch wird allmählich abnehmen. Und trotzdem glauben Viele in der Gesellschaft immer noch, dass fossile Treibstoffe schlecht sind für uns und für die Welt.

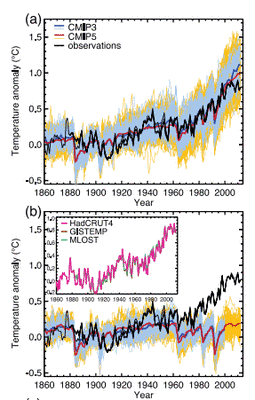

Abbildung 1: Energiebedarf der Jahre 2014 bzw. 2040

Das Buch stellt diesen Gedanken, dass fossile Treibstoffe eine negative Auswirkung auf die Gesellschaft haben, zur Disposition. Es handelt sich um eine faszinierende, mit Fakten angefüllte und gut begründete Diskussion über den Einfluss, den fossile Treibstoffe auf unsere Welt gehabt hatten, seit sie im großen Maßstab vor über 120 Jahren zum Zuge kamen. Heute leben 7 Milliarden Menschen auf der Erde, und wir sind besser ernährt, leben besser und länger als fast jeder der 900 Millionen Menschen, die im Jahre 1800 lebten. Es ist der Erinnerung wert, dass die mittlere Lebenserwartung im Jahre 1800 in UK 39 Jahre betragen hatte (hier). Epstein begründet das so:

„Wir übernehmen nicht eine sichere Umgebung und machen sie gefährlich; wir übernehmen eine gefährliche Umgebung und machen sie wesentlich sicherer“.

Was ist also mit all jenen, die gegen fossile Treibstoffe argumentieren? Fossile Treibstoffe sind zum größten Teil für die Lebensqualität verantwortlich, an der wir uns heute erfreuen, sowie für die Nahrung, die wir konsumieren, die rapide fallende Armut, unsere längere Lebenserwartung, geringere Kindersterblichkeit und viel andere humanitäre Vorteile. Wie kann sich jemand hinstellen und verlangen, fossile Treibstoffe zu verbannen, falls er das menschliche Leben achtet? Es scheint, als ob man „reine Natur“ über menschliches Leben stellt. Abbildung 2 zeigt das erwartete Ergebnis:

Abbildung 2

Im Buch von McKibben The End of Nature argumentiert der Autor, dass wir eine „bescheidenere [humbler] Welt“ brauchen und dass „das Glück des Menschen zweitrangig sein (sollte)“. In einer Rezension aus dem Jahr 1989 seitens der Los Angeles Times wird der Mensch als Krebsgeschwür und Plage für die Erde bezeichnet. Der Autor David Graber fährt fort:

McKibben ist Biozentriker [biocentrist ?], und ich auch. Wir sind nicht am Nutzen einer bestimmten Spezies interessiert oder an einem frei fließenden Fluss oder einem Ökosystem für die Menschheit. Sie haben inhärent Wert, mehr Wert – für mich – als eine andere Person oder eine Milliarde Personen. Menschliches Glück, und mit Sicherheit die menschliche Fruchtbarkeit sind weniger wichtig als ein ursprünglicher und gesunder Planet“.

Mann! Wir könnten gezwungen sein, ihn dem Verfassungsschutz zu melden. Dies ist das genaue Gegenteil der Prämisse von Epstein, der zufolge die Menschlichkeit an erster Stelle zu stehen hat. Folglich ist es für eine effektive Debatte um den Verbrauch fossiler Treibstoffe wichtig, dass die Debattierenden ihre Prioritäten benennen. Kommt die Menschheit an erster Stelle? Oder kommt an erster Stelle die Verringerung des menschlichen Einflusses auf die Umwelt? Es zeigt sich, dass diese Auswahl einen gewaltigen Unterschied ausmacht.

Das Buch führt aus, dass selbst wenn fossile Treibstoffe keinen Abfall hinterlassen würden und auch kein CO2, und selbst wenn sie sogar billiger wären und ewig verfügbar sein würden, würde die „grüne“ Bewegung immer noch gegen sie kämpfen. Die grüne Bewegung tritt nicht einfach für eine vom Menschen unberührte Umgebung ein, sie ist gegen jeden menschlichen Fortschritt. In den achtziger Jahren dachte man, dass die kontrollierte Fusion von Wasserstoff zu Helium schon um die Ecke schaute. Das war verschmutzungsfreie Energie. Was hatten die Umweltführer dazu zu sagen?

Jeremy Rifkin: „Es wäre das Schlimmste, was unserem Planeten widerfahren könnte“. Unerschöpfliche Energie verleiht dem Menschen eine unbegrenzte Fähigkeit, die Ressourcen des Planeten auszubeuten und ihn aus seinem zerbrechlichen Gleichgewicht zu bringen.

Paul Ehrlich: Die Entwicklung der Kernfusion für Menschen wäre so, „als ob man einem verrückten Kind ein Maschinengewehr in die Hand drücken würde“.

Amory Lovins: „Es wäre kaum weniger als katastrophal für uns, eine Quelle sauberer, billiger und reichlich verfügbarer Energie zu entdecken wegen dem, was wir damit anrichten könnten“.

Dieses „verrückte Kind“ wäre eine unerschöpfliche, saubere Energiequelle. Es scheint oft so, als ob radikale Umweltaktivisten denken, dass jeder andere ein „verrücktes Kind“ ist. Prinz Philipp, ehemals Chef des World Wildlife Fund, wollte als ein tödlicher Virus wiedergeboren werden (hier), um der Überbevölkerung Einhalt zu gebieten.

Luft, Wasser und Land so sauber wie möglich zu halten ist vorteilhaft für Mensch und Umwelt. Aber fossile Treibstoffe können unsere Umwelt sauber halten und tun das auch. Man frage irgendjemanden in London (oder auch New York) im Jahre 1894, als man durch die Ausscheidungen von Menschen und Pferden in den Straßen zu jener Zeit waten musste. Durch fossile Treibstoffe angetriebene Autos wurden als gewaltiger Vorteil für die Umwelt angesehen. Bis zum Jahr 1912 hatten sie die Pferde weitgehend ersetzt, und London wurde zu einer viel saubereren Stadt. Automobile und Kohlekraftwerke emittieren in der Tat Toxine und verursachen Luftverschmutzung, aber infolge moderner Technologie ist die Luft in den USA jetzt viel sauberer (hier) als im Jahre 1970, jedenfalls der EPA zufolge. Und dies trotz der Tatsache, dass wir heute viel mehr Kohle und Benzin verbrennen als damals. Die Eliminierung fossiler Treibstoffe würde unzählige Todesopfer, Hunger und Krankheit mit sich bringen. Ihre Eliminierung wird der Umwelt nicht helfen. Als Menschen müssen wir unsere Umwelt modifizieren, um gesund, länger und mit guter Qualität zu leben. Wir müssen sicherstellen, dabei sehr sorgfältig vorzugehen, aber das bedeutet in keiner Weise, dass wir den Verbrauch minimieren müssen. Epstein schreibt dazu:

„Die Beziehung zwischen Energie und Umwelt wird normalerweise in negativer Weise betrachtet; wie können wir die Energie verbrauchen, die „die Umwelt am wenigsten beeinflusst“? Aber wir müssen vorsichtig sein; falls wir uns auf den menschlichen Wertestandard berufen, müssen wir einen Einfluss auf unsere Umwelt haben. Mit der Transformation der Umwelt überleben wir … falls wir uns auf humane Standards berufen, sollten wir nur über Auswirkungen des Energieverbrauchs nachdenken, die unserer Umwelt aus menschlicher Perspektive schaden …“

Er fährt fort:

„Aber wir sollten auch im Auge behalten, dass Energie uns größere Fähigkeiten verleiht, unsere Umwelt zu verbessern, sie gesünder und sicherer für die Menschen zu machen … die natürliche Umgebung ist nicht von Natur aus eine gesunde, sichere Sache; weshalb die Menschen in der Historie auch nur eine Lebenserwartung von etwa 30 Jahren hatten“.

Und schließlich:

„Werden wir gezwungen, uns auf Solar, Wind und Biotreibstoffe zu verlassen, wäre dies ein Horror schlimmer als wir uns vorstellen können, fußt doch eine Zivilisation auf billiger, reichlicher und zuverlässiger Energie. Ohne diese würden Maschinen ausfallen, die Produktivität zerstört und die Ressourcen verschwinden“.

Man überlege, wie es Mr. Epstein tut, dass ein normaler Mensch mindestens 1800 Kilokalorien Energie pro Tag verbrennt. Die Bandbreite reicht von etwa 1800 bis zu 8000 Kilokalorien, je nach Art der Aktivität (sehr intensive Aktivitäten können bis zu 12.000 Kilokalorien an einem Tag verbrennen). Wenn wir von „Kalorien“ von Nahrung sprechen, reden wir in Wirklichkeit von Kilokalorien Energie. Eine 100-Watt-Glühlampe verbraucht 2000 Kilokalorien Energie, falls man sie 32 Stunden lang brennen lässt. Im Jahre 2011 betrug der jährliche Energieverbrauch eines normalen Menschen (der EIA zufolge) 216.095 Kilokalorien (dies kommt der von Epstein genannten Zahl von 186.000 Kilokalorien ziemlich nahe). Darin enthalten sind Benzin, Strom und andere externe Energiequellen. Dieser Energiewert entspricht 27 bis 120 Menschen. Folglich vertritt Epstein diesen Standpunkt:

In der Vergangenheit, vor Erfindungen moderner Energietechnologie, bestand der Hauptweg zur Lösung des Problems der menschlichen Schwäche darin, andere zu Dienern oder Sklaven zu machen – was bedeutete, dass nur einige im Wohlstand leben konnten auf große Kosten anderer. Aber mit Maschinen-Energie und Maschinen als Diener muss niemand mehr leiden …“.

Wir alle stammen von Sklaven ab, die Römer, Engländer, Wikinger, Griechen, Chinesen, Inder, Indianer – jede Kultur in der Vergangenheit beschäftigte Sklaven. Tatsächlich verschwand die Sklaverei erst, nachdem der Mensch gelernt hatte, Maschinen zu bauen, die fossile Treibstoffe verbrauchen. Eines von Epsteins Schlagworten lautet „Energie ist Fähigkeit“.

Milton Freeman, der berühmte Ökonom, schrieb einmal:

„Industrieller Fortschritt, mechanische Verbesserungen, alle die großen Wunder der modernen Ära haben für die Wohlhabenden wenig gebracht. Die Reichen im antiken Griechenland hätte kaum wenn überhaupt von moderner Klempnerei profitiert – rennende Sklaven ersetzten fließendes Wasser. Fernsehen und Radio – die Patrizier Roms konnten sich an führenden Musikern und Schauspielern in ihren Häusern erfreuen; konnten führende Künstler als heimisches Faktotum beschäftigen. Sofort tragbare Kleidung, Supermärkte – all diese und viele andere moderne Entwicklungen hätten kaum etwas zur Verbesserung des Lebens dieser Herrschaften beigetragen. Sie hätten die Verbesserungen bzgl. Transportwesen und Medizin begrüßt, aber für alle anderen haben die großen Errungenschaften des westlichen Kapitalismus‘ primär zum Vorteil normaler Menschen geführt. Diese Errungenschaften haben den Massen Bequemlichkeiten und Annehmlichkeiten gebracht, die zuvor exklusiv den Reichen und Mächtigen vorbehalten waren“.

Folglich profitieren die Armen und die Mittelklasse am meisten von fossilen Treibstoffen. Ist es da ein Wunder, dass die Hauptakteure, fossile Treibstoffe zu eliminieren, die Reichen sind wie Al Gore (2 Herrschaftshäuser, 200 Millionen Dollar), John Kerry (5 Herrschaftshäuser) und Leonardo DiCaprio (ebenfalls 5 Herrschaftshäuser)?

Es gibt heute 7 Milliarden Menschen auf der Welt. 1,3 Milliarden davon haben keinen Strom, drei Milliarden weitere keinen ausreichenden Zugang zu Strom. Hätte jedermann Zugang zu Strom, wie es heute für jeden Amerikaner selbstverständlich ist, müsste man viermal so viel Strom erzeugen wie heute. Wenn man bedenkt, dass 82% unserer Energie von fossilen Treibstoffen stammen – wie in aller Welt kann man dann die Versorgung der Welt mit Strom vervierfachen nur mit schwankenden Wind und Solar?

Egal ob der Klimawandel nun vom Menschen verursacht ist oder nicht, er kann gefährlich sein. Schon immer haben Dürre, extreme Temperaturen, Waldbrände und Stürme viele Todesopfer gefordert. Aber während der letzten acht Jahre sind Todesfälle mit Bezug auf das Klima weltweit um 98% zurückgegangen. Außerdem zeigen die Daten, dass es eine dramatische Differenz gibt zwischen den Verbrauchern schwerer und leichter fossiler Treibstoffe [between the heavy fossil fuel users and the light fossil fuels users] Man ist in einem industrialisierten Land viel sicherer als in einem Entwicklungsland. Zum Beispiel gab es der EM-DAT International Disaster Database zufolge im vorigen Jahrzehnt in den USA Null Todesfälle durch Dürre.

Historisch gesehen steht Dürre an erster Stelle der Ursachen für Todesfälle bzgl. Wetter. Weltweit sind diese um 99.98% während der letzten 80 Jahre zurückgegangen, aus vielen, mit Energie zusammen hängenden Gründen. Maßnahmen zur Bekämpfung von Dürrefolgen, mehr Nahrungsmittel infolge moderner, fossil betriebener Landwirtschaft, bessere Erschließung von Wasser und Werken zur Wasserbehandlung, alle betrieben mit fossilen Treibstoffen, machten Dürren zu einer geringeren Bedrohung. Epstein drückt es in Kapitel 5 so aus:

„Die öffentliche Klimadiskussion ist rückwärts gerichtet. Sie betrachtet den Menschen als eine destruktive Kraft für das Klima; als etwas, das das Klima gefährlich macht, weil wir fossile Treibstoffe verbrauchen. Tatsächlich ist das genau Gegenteil die Wahrheit: wir übernehmen kein sicheres Klima und machen es gefährlich, sondern wir übernehmen ein gefährliches Klima und machen es sicher. Hochenergie-Zivilisation, nicht das Klima, ist der Treiber der Lebensfähigkeit. Egal wie oder was – Klima wird immer auf natürliche Weise gefährlich sein – und die Schlüsselfrage wird immer lauten, ob wir die Anpassungsfähigkeit haben, damit umzugehen …“.

Epstein argumentiert, dass der Gedanke, wir würden in einem idealen und empfindlichen Klima leben, das wir im Begriff sind durcheinanderzubringen, dumm ist:

„Die erhabene Version des Gedankens, das unser Klima von Natur aus sicher oder ideal ist sagt, dass weil der Mensch in der gegenwärtigen Klimaperiode aufgeblüht ist, also in der 10.000 Jahre langen nacheiszeitlichen Periode, bekannt unter der Bezeichnung Holozän, dies das einzige globale Klima ist, in dem wir leben können, und falls es ein Risiko gibt, dass fossile Treibstoffe die „natürlichen“ Temperatur-Höhepunkte jener letzten 10.000 Jahre brechen würden, müssten wir sie eliminieren. ,Genau wie wir‘, sagt Bill McKibben, ,sind unsere Ernten angepasst an das Holozän, die 11.000 Jahre stabilen Klimas, die wir jetzt verlassen … in den Staub‘. Dieses Argument reflektiert nicht die Realität. Erstens, das Holozän ist eine Abstraktion und nicht ein „Klima“, in dem irgendjemand lebt; es ist die Zusammenfassung eines Klimasystems, das eine unglaubliche Vielfalt von Klimaten enthält, in dem Individuen leben und gelebt haben. Und in der Praxis können wir ziemlich gut in jedem dieser Klimate leben, falls wir industrialisiert sind, und in so ziemlich keinem davon, falls wir es nicht sind. Das offene Geheimnis unserer Beziehung zu Klima ist, wie gut wir in verschiedenen Klimaten leben, dank Technologie“.

Wetter- und Klimaänderungen sind für uns von Bedeutung, aber viel weniger als vor dem Zeitalter fossiler Treibstoffe. Zu heiß – man gehe in ein Haus mit Air Condition. Zu kalt – man gehe in ein mit Erdgas beheiztes Haus. Fossile Treibstoffe fehlen – dann viel Glück. Mutter Natur ist keine wirkliche Mutter, wir sind ihr völlig egal. Um ein gutes Leben zu haben, müssen wir unsere Umwelt verändern, und dafür brauchen wir Energie.

Ich möchte schließen mit einem Zitat aus Atlas Shrugged von Ayn Rand, welches Epstein in seinem Buch erwähnt. Mitten in einem schweren Gewitter unterhält sich Hank Reardon mit dem Industriellen Francisco d’Anconia in der Sicherheit von d’Anconias Haus. Sie schauen durch das Fenster dem Gewitter zu:

„Man stand hier und schaute dem Gewitter zu mit dem größten Stolz, den man nur empfinden kann – weil man in der Lage ist, Sommerblumen und halbnackte Frauen im Haus zu haben in einer Nacht wie dieser – in einer Demonstration unseres Sieges über den Sturm. Und wären wir nicht hier, wären wir hilflos der Gnade des Gewitters ausgeliefert“.

Wollen Sie zurück zur Natur? Ist es das Ziel, Ihren Einfluss auf die Umwelt zu minimieren, oder ist es Ihr Ziel, die Umwelt zu verbessern? Epstein zeigt, dass wir nicht die Minimierung unseres Einflusses mit der Verbesserung der Umwelt verschmelzen sollten. Der Mensch ist nicht so total verderbt und böse (hier), wie es uns die Umweltaktivisten und Calvinisten glauben machen wollen; wir können die Umwelt verbessern und gute Arbeit leisten. Der Grundsatz lautet: falls wir menschliches Leben wertschätzen, werden wir fossile Treibstoffe wertschätzen und das, was sie uns zu tun in die Lage versetzt haben.

Falls man das Buch erwerben will – es ist verfügbar bei Amazon. (siehe Bild oben rechts!)

Link: https://wattsupwiththat.com/2016/08/12/the-moral-case-for-fossil-fuels/

Übersetzt von Chris Frey EIKE